Campioni casuali

Giovanni Marchetti, DISIA, Firenze

2017

1 / 31

Introduzione

• Il calcolo delle probabilità si occupa di misura di incertezza

degli eventi e delle quantità aleatorie che si osservano negli

esperimenti.

• Per esempio se l’esperimento è il lancio di una puntina da

disegno il risultato è una variabile aleatoria X con modalità:

• x = 0 se cade con la punta all’insù

• x = 1 se cade con la punta in giù.

• Possiamo interpretarla come una variabile di Bernoulli con

Pr(X = 0) = 1 − π e Pr(X = 1) = π

• Per il calcolo delle probabilità non è essenziale conoscere π, ma

solo sapere che 0 < π < 1.

• Tuttavia possiamo domandarci: quanto vale π?

2 / 31

Stima di una probabilità

• I due esiti non sono equiprobabili

• Cerchiamo di determinarla empiricamente. Ad esempio

lanciamo la puntina 100 volte e vediamo cosa succede.

1

2

3

4

5

6

7

8

9

10

0

1

0

0

0

1

1

1

1

1

1

1

0

1

1

0

0

1

1

0

0

1

1

0

1

1

0

1

1

0

1

1

0

0

1

1

0

0

0

0

1

1

1

1

1

1

0

1

1

0

1

0

1

1

0

0

0

1

1

0

1

1

0

1

1

0

1

1

1

1

1

1

0

1

1

0

0

1

1

0

1

0

1

0

1

0

1

1

1

1

0

1

0

0

1

1

1

1

1

0

3 / 31

Dai dati a una stima

• I risultati ci permettono di stimare π con la proporzione di

risultati a favore di X = 1, cioè

π̂ =

62

#{X = 1}

=

= .62.

100

100

• I risultati dell’esperimento del lancio di una puntina sono affetti

da una variabilità intrinseca e la probabilità di successo π non

si conosce. Tuttavia, π può essere stimata dai dati.

• Alla fine dell’esperimento ci facciamo l’idea che

Pr(X = 0) < Pr(X = 1). Quindi l’analisi statistica permette

di dare un senso concreto alla teoria delle probabilità.

4 / 31

Un altro esempio

• Ogni individuo adulto sano ha una sua temperatura corporea

X.

• La temperatura nella popolazione degli adulti sani ha una sua

variabilità e quindi ci saranno delle differenze tra una misura e

l’altra in un gruppo di individui.

• Nella popolazione le temperature X sono quantità aleatorie e

X può essere descritta come una variabile aleatoria continua

con una certa funzione di densità f (x).

• Qual è la temperatura normale che potremmo identificare con il

valore atteso µ = E(X)? Il calcolo delle probabilità non ci può

fornire la risposta. Per saperlo dobbiamo ricorrere a dei dati

osservati sulla temperatura corporea.

5 / 31

Dati sulla temeperatura

I dati seguenti riguardano le temperature corporee in gradi Celsius di

65 individui sani scelti casualmente.

1

2

3

4

5

6

7

8

9

10

11

12

13

1

35.7

35.9

36.1

36.1

36.2

36.2

36.2

36.2

36.3

36.3

36.3

36.3

36.3

2

36.4

36.4

36.4

36.4

36.4

36.5

36.6

36.6

36.6

36.6

36.6

36.6

36.7

3

36.7

36.7

36.7

36.7

36.7

36.7

36.7

36.8

36.8

36.8

36.8

36.8

36.8

4

36.9

36.9

36.9

36.9

36.9

36.9

37.0

37.0

37.0

37.0

37.0

37.0

37.1

5

37.1

37.1

37.1

37.1

37.2

37.2

37.2

37.2

37.3

37.3

37.4

37.4

37.5

6 / 31

Istogramma

0.0 0.2 0.4 0.6 0.8 1.0

Densità

Ecco la distribuzione dei dati osservati mediante un istogramma.

35.5

36.0

36.5

37.0

37.5

38.0

Temperatura corporea

• La temperatura X si pensa come una variabile aleatoria

generale avente un valore atteso µ varianza σ 2 finiti da stimare

tramite i dati.

7 / 31

Intervalli di stima

• È intuitivo stimare µ con la media aritmetica dei dati

x̄ =

n

1X

xi = 36.73.

n i=1

• Un metodo più sofisticato è basato sulla costruzione di

intervallo di confidenza che in questo caso ci fornirebbe un

intervallo

(36.63, 36.82)

con un livello di confidenza approssimato del 95%.

• Il punto centrale dell’intervallo è x̄ = 36.73 è la media

aritmetica campionaria.

• L’ampiezza dell’intervallo è una misura della incertezza

associata alla stima.

8 / 31

Popolazioni e campioni

• La teoria della probabilità dunque permette di descrivere

precisamente quelle che in statistica sono chiamate popolazioni.

• Poiché una popolazione completa si conosce raramente è

necessario raccogliere dati su un campione casuale (x1 , . . . , xn )

di n osservazioni dalla popolazione.

• Si dice inferenza statistica il processo con cui si apprende

dall’esperienza nel senso che si imparano le proprietà dell’intera

popolazione dai dati campionari.

• La teoria della probabilità invece procede nel senso opposto

perché permette di dedurre da una popolazione conosciuta

esattamente le proprietà di un campione casuale (x1 , . . . , xn ).

9 / 31

Che fa la Statistica insomma?

• Distinguere il segnale presente nei dati dal rumore che

necessariamente l’aleatorietà produce.

• Questa operazione non è intuitiva e la teoria statistica fornisce i

metodi ottimali per operare la distinzione, perché si occupa

• dei metodi generali per la raccolta dei dati;

• dei metodi per analizzare e riassumere i dati raccolti

• dei metodi per valutare l’accuratezza degli indici forniti.

10 / 31

Valutazione dell’errore e campioni casuali

• La teoria statistica spiega che l’unico modo per risalire alle

informazioni su caratteristiche della popolazione fornendo una

misura dell’errore è quello di estrarre un campione casuale.

• Il campione casuale permette di valutare in modo oggettivo

l’incertezza associata allo studio parziale della popolazione

• Se i dati fossero raccolti in modo accidentale non avremmo

modo di estendere le conclusioni all’intera popolazione in modo

scientifico.

11 / 31

Tipi di popolazione

• Molto spesso si ha a che fare con popolazioni infinite e teoriche.

• La popolazione è rappresentabile mediante una variabile

aleatoria X teorica definita dalla sua legge di probabilità F (x)

• Esiste anche il caso delle popolazioni finite e concrete. Queste

sono costituite da un insieme finito di unità statistiche

W = {W1 , . . . , WN } con una identificazione delle unità.

12 / 31

Popolazioni finite

• Esempio: l’insieme di tutte le scuole in California con almeno

0.0000 0.0010 0.0020 0.0030

100 studenti, in un dato anno.

0

1000

2000

3000

4000

Numero iscritti

13 / 31

Un campione casuale

• Un campione da una popolazione finita è un sottoinsieme di n

unità {w1 , . . . , wn } ⊂ W.

• In un campione casuale le unità sono selezionate casualmente.

Gli elementi del campione sono chiamati unità campionarie.

• Una volta estratto il campione casuale {w1 , . . . , wn } di unità si

sceglie una variabile da studiare e si denota con xi la

realizzazione del carattere o dei caratteri oggetto di studio

sull’unità wi .

14 / 31

Campione con reimmissione

• Si distinguono i campioni con e senza reimmissione.

• In un campione con reimmissione si selezionano

indipendentemente n interi j1 , j2 , . . . jn ognuno dei quali può

assumere i valori 1, 2, . . . , N con probabilità 1/N .

• Quindi si definiscono le unità campionarie ponendo

w1 = Wj1 , w2 = Wj2 , . . . , wn = Wjn

In questo tipo di campionamento è possibile che una unità

compaia più volte nel campione.

15 / 31

Campione senza reimmissione

• In un campione senza reimmissione

• Passo 1. si seleziona un intero j1 da 1, 2, . . . , N con probabilità

1/N

• Passo 2. si seleziona un intero j2 dai rimanenti N − 1 interi con

probabilità 1/(N − 1), etc.

• Passo n. si seleziona un intero jn dai rimanenti N − n + 1 interi

con probabilità 1/(N − n + 1);

• quindi si definiscono le unità campionarie usando gli indici

ottenuti.

• In questo tipo di campionamento non è possibile che una unità

compaia più volte nel campione.

16 / 31

Differenze

• Nel campionamento con reimmissione le osservazioni sono

indipendenti e identicamente distribuite, mentre nel

campionamento senza ripetizione le osservazioni non sono

indipendenti.

• Nel seguito ci occuperemo prevalentemente di campioni con le

stesse caratteristiche dei campioni casuali con reimmissione.

Queste caratteristiche definiscono i cosiddetti campioni iid

17 / 31

Definizione di campione iid

• Si dice che x1 , . . . , xn è un un campione casuale iid se i dati

sono realizzazioni di variabili aleatorie X1 , . . . , Xn

identicamente distribuite e indipendenti (iid) ovvero se

• tutte le Xi hanno la stessa funzione di ripartizione F (x) e

• la loro distribuzione congiunta si fattorizza:

Pr(X1 ≤ x1 · · · Xn ≤ xn ) =

n

Y

F (xi ) per ogni (x1 , . . . , xn ) ∈ Rn .

i=1

• Si può parlare di un campione iid (x1 , . . . , xn ) estratto da una

popolazione infinita descritta da una variabile aleatoria X con

funzione di ripartizione F (x). In tal caso useremo talvolta la

notazione

F → (x1 , . . . , xn ).

18 / 31

Simulazione di campioni

Possiamo farci un idea dell’aspetto di un campione casuale iid

facendo ricorso ai generatori di numeri aleatori.

19 / 31

Generatori di numeri aleatori

• I generatori sono algoritmi che producono un flusso di

realizzazioni di variabili U1 , U2 , U3 , . . . che si comportano come

variabili iid da una variabile uniforme U (0, 1).

• Questi algoritmi in realtà producono numeri pseudo-aleatori

perché applicano un generatore deterministico e quindi i

risultati sono esattamente predicibili conoscendo l’algoritmo.

20 / 31

Generatori lineari congruenziali

• I generatori lineari congruenziali sono definiti dalla formula

Xi+1 = (aXi +b) mod M,

Ui = Xi /M

i = 0, 1, 2, 3, . . .

dove M un intero, e a, b ∈ {0, 1, . . . , M − 1}.

• Il flusso di numeri pseudo-aleatori parte da un intero iniziale X0

detto seme. Il generatore è deterministico e la successione è

ciclica e di periodo ≤ M .

• I valori di a, b ed M sono scelti opportunamente in modo da

massimizzare il periodo e da ottenere le caratteristiche volute.

21 / 31

Osservazioni

• Per definire un buon generatore è essenziale non solo che gli Ui

siano uniformemente distribuiti, ma che risultino anche

mutuamente indipendenti.

• Il generatore Mersenne twister, usato come generatore

standard in R, ha un periodo 219937 − 1 (che è un numero

decimale con 6002 cifre) e garantisce le proprietà di

indipendenza per un numero elevato di dimensioni.

22 / 31

Esempio

Il generatore di numeri aleatori uniformi in R è runif. Ad esempio

per generare dei punti (ui , vi ) distribuiti indipendentemente ed

uniformemente nel quadrato unitario si danno le istruzioni

set.seed(1000)

u = runif(300); v = runif(300)

in cui set.seed è una funzione che stabilisce il seme.

23 / 31

0.0

0.2

0.4

v

0.6

0.8

1.0

Risultato

0.0

0.2

0.4

0.6

0.8

1.0

u

24 / 31

Estrazione di campioni casuali

• Volendo generare un campione casuale con reimmissione da un

insieme di interi {1, . . . , N } in R si può usare la funzione

sample.

• Ad esempio per estrarre con reimmissione un campione di 25

scuole dalla popolazione finita vista prima si usano le istruzioni

set.seed(123)

x = sample(6194, size = 25, replace = TRUE)

df = data.frame(matrix(x, 5, 5))

dimnames(df) = list(1:5, 1:5); df

1

2

3

4

5

1

1782

4883

2534

5470

5826

2

283

3272

5528

3416

2829

3

5927

2808

4197

3547

638

4

5574

1525

261

2032

5913

5

5510

4292

3968

6159

4062

25 / 31

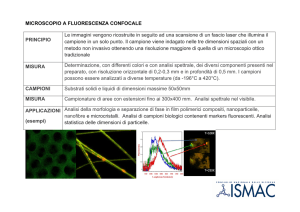

Simulazioni di campioni da variabili aleatorie non uniformi

I principali sono

• Il metodo di inversione

• Il metodo di trasformazione di variabile.

26 / 31

Metodo di inversione

• Il metodo di inversione usa una proprietà della funzione

quantile cioè dell’inversa della funzione di ripartizione F .

• Esempio: simulare un campione dalla popolazione X ∼ F dove

F è una funzione di ripartizione della Esponenziale di varianza

σ2

F (x) = 1 − e−x/σ , x ≥ 0, σ > 0

che ha funzione quantile

Q(p) = F −1 (p) = −σ log(1 − p)

0 ≤ p < 1.

• Il metodo di inversione consiste

• nel generare probabilità uniformi pi ∼ U (0, 1)

• calcolare xi = Q(pi ).

27 / 31

Regola generale

Se pi ∼iid U (0, 1), allora xi = Q(pi ) ∼iid F.

Dimostrazione. Definiamo Z = Q(U ) dove U ∼ U (0, 1). Quindi

Pr(Z ≤ t) = Pr(Q(U ) ≤ t) = Pr(U ≤ F (t)) = F (t)

poiché U ha distribuzione uniforme. Quindi la funzione di

ripartizione di Z è F e dunque Z = X.

28 / 31

Funzioni quantili non in forma chiusa

• In certi casi l’inversa va ottenuta per via numerica.

• Esempio: per simulare una normale standard Z ∼ N (0, 1) che

ha funzione di ripartizione

Z z

Φ(z) =

−∞

1

2

√ e−u /2 du

2π

si deve ottenere l’inversa Φ−1 risolvendo numericamente

l’equazione Φ(z) = u.

• Nota. Il metodo di inversione richiede un aggiustamento nel

caso in cui la funzione di ripartizione F (x) non sia monotona

crescente e quindi non si possa invertire. In tal caso si utilizza

un’inversa generalizzata della funzione di ripartizione.

29 / 31

Metodo di trasformazione

• Supponiamo di saper simulare una variabile X ottenendo un

campione x1 , . . . , xn e di voler simulare una variabile aleatoria

Y che è una trasformata di X, cioè Y = g(X) con g(x) una

funzione reale.

• Allora possiamo simulare Y semplicemente trasformando i

valori simulati di X

(y1 , . . . , yn ) = (g(x1 ), . . . g(xn )).

• Infatti l’indipendenza viene preservata dopo una trasformazione

e l’identica distribuzione è garantita dalle classiche regole di

trasformazione tra variabili aleatorie.

• Si veda ad esempio Wikipedia.

30 / 31

Esempi di trasformazioni utili

• Se U ∼ U (0, 1) allora X = a + (b − a)U ∼ U (a, b).

• Metodo di Box-Müller: se U1 e U2 sono due variabili uniformi

su [0, 1] e indipendenti, allora

Z1 =

p

Z2 =

p

−2 log U1 cos(2πU2 )

−2 log U1 sin(2πU2 )

sono due variabili normali standard indipendenti.

• Se Z ∼ N (0, 1), µ + σZ ∼ N (µ, σ).

• Se Z1 , . . . , Zn , Zn+1 è una successione di variabili aleatorie

P

normali standard indipendenti, V = ni=1 Zi2 ha una

distribuzione gamma Ga(n/2, 2), detta chi quadrato con n

gradi di libertà.

p

• Inoltre T = Zn+1 / V /n ∼ tn ha una distribuzione detta t di

Student con n gradi di libertà.

31 / 31