Interpolazione

Dopo aver raccolto una certa popolazione di dati statistici relativi ad un certo fenomeno

da analizzare, dopo averli rappresentati graficamente ed aver sintetizzato tramite

opportuni indici (di posizione, di dispersione, di forma) i dati di un carattere quantitativo,

è possibile utilizzare delle tecniche per semplificare, attraverso l’uso di opportune

funzioni matematiche, l’informazione contenuta nei dati statistici.

Per far questo è necessario verificare se esiste un modello matematico che segua

l’evoluzione del fenomeno.

I dati rilevati potrebbero essere disturbati da un elemento “perturbatore” la cui influenza

deve essere ridotta il più possibile. Oppure i dati potrebbero presentare delle “lacune”. Il

procedimento che si utilizza per colmare queste lacune è detto INTERPOLAZIONE. Se il

processo avviene al di fuori del campo di rilevazione si parla di ESTRAPOLAZIONE. Si

parla infine di PEREQUAZIONE se si tratta di “aggiustare” i dati rilevati per “depurarli”

dagli elementi perturbatori. In generale questi tre problemi si affrontano mediante le

medesime tecniche e, in generale, ci si riferisce ad essi semplicemente con il termine

INTERPOLAZIONE.

Interpolazione Analitica

Consiste nel ricercare una funzione matematica “modello” che rappresenti nel modo

migliore la distribuzione del fenomeno osservato.

1

Interpolazione

Si parla, con evidenza di termini, di :

Interpolazione matematica o interpolazione per punti

e

Interpolazione statistica o interpolazione fra punti

Si assume che si abbia a che fare con due variabili aleatorie, che chiameremo X ed Y, e

che si debba cercare una funzione Y=f(X) ,detta funzione interpolante o curva di

regressione di Y su X , che approssimi nel “miglior” modo possibile i dati rilevati.

E’ chiaro che deve essere esplicitato il criterio di ottimo per la scelta della curva di

regressione.

In generale la funzione interpolante dipenderà da alcuni parametri (che ne determinano

le caratteristiche analitiche, ad es. il coefficiente angolare e l’intercetta all’origine per

una retta) la determinazione dei quali avviene attraverso il criterio di ottimo che viene

2

utilizzato.

Funzioni Interpolanti

E’ utile a volte stabilire a priori quali siano i tipi di funzioni interpolanti da utilizzare:

y = a + bx

k

y=

x

retta

y = ax 2 + bx + c

parabola

iperbole

Fasi dell’interpolazione (Regressione)

A) Scelta della funzione interpolatrice

B) Determinazione dei parametri

I. Metodo dei minimi quadrati

II. [ Metodo dei momenti ]

C) Determinazione del grado di accostamento

Si consideri inoltre il fatto che ci si occuperà solo di regressioni lineari. Con ciò si

intendono regressioni operate solo con funzioni che dipendono linearmente DAI

PARAMETRI (non dalla variabile)!

3

Regressione Lineare. Retta.

Metodo dei minimi quadrati

Si assumano i dati statistici rilevati per le variabili statistiche X ed Y

secondo il seguente schema :

Si voglia determinare la retta di regressione di Y su X (ed

eventualmente di X su Y) secondo il metodo dei minimi quadrati:

Scriviamo:

y = a + bx

x = a'+b' y

Si consideri al seguente funzione:

X

Y

x1

x2

...

xn

y1

y2

...

yn

F (a, b) = ∑ [ yi − (a + bxi )]

2

i

In essa compaiono i quadrati delle differenze tra i valori rilevati yi ed i valori teorici del

modello di regressione (a+bxi): il metodo dei minimi quadrati richiede che la funzione

F(a,b) sia minima e che questa condizione costituisca il criterio di ottimo per la

determinazione dei parametri a e b.

F (a, b) = Minima

a ,b

4

Regressione Lineare. Retta.

Metodo dei minimi quadrati

Il minimo è determinato dal seguente sistema di equazioni:

∂F (a, b)

∂a = 0

∂F (a, b) = 0

∂b

2

∂ ∑ [ yi − a − bxi ]

∂F (a, b)

i

=

= 2∑ [ yi − a − bxi ](−1) = 0

∂a

∂a

i

2

∂

[

y

−

a

−

bx

]

∑i i

i

∂

F

(

a

,

b

)

= 2∑ [ yi − a − bxi ](− xi ) = 0

=

∂b

∂b

i

∑ [ yi − a − bxi ] = 0

i

∑ [ yi − a − bxi ](− xi ) = 0

i

a = y − b x

xy − b x 2

a =

x

∑ yi − na − b∑ xi = n y − na − bn x = 0

i

i

2

2

− ∑ yi xi + a ∑ xi + b∑ x i = −n xy + an x + bn x = 0

i

i

i

xy − b x 2

= y − bx

x

()

xy − b x = y x − b x

2

2

5

Regressione Lineare. Retta.

Metodo dei minimi quadrati

()

xy − b x = y x − b x

2

2

(

( ))

bx − x

2

2

*

= xy − y x b = b =

xy − y x

()

x − x

2

2

=

Cov( x, y )

Var ( x)

a = a * = y − b* x

Se facessi la regressione di X su Y otterrei :

x = a'+b' y

b'* =

xy − y x

()

y − y

2

2

=

Cov( x, y )

Var ( y )

a'* = x − b'* y

6

Regressione Lineare. Retta.

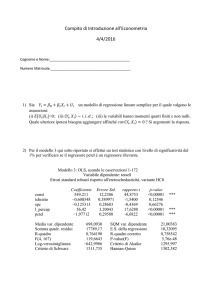

Metodo dei minimi quadrati: calcolo esplicito

ed esempio con excel

x_i

5

6

3

8,5

9,5

y_i

2

4

1,4

5

6

s_x_i

-1

0

-3

2,5

3,5

s_y_i

-1,5

0,5

-2,1

1,5

2,5

s_x_i*s_y_i

1,5

0

6,3

3,75

8,75

s_x_i^2

1

0

9

6,25

12,25

s_y_i^2

2,25

0,25

4,41

2,25

6,25

4

2,6

-2

-0,9

1,8

4

0,81

totali

36

21

0

0

22,1

32,5

16,22

m(x)

6

m(y)

3,5

y=a+bx

a=

-0,58intercetta

-0,58

b=

0,68pendenza

0,68

r2=

x=a'+b'y

a'=

1,231196intercetta

1,231196

b'=

1,362515pendenza

1,362515

0,92651

7

Regressione Lineare. Retta.

Metodo dei minimi quadrati: calcolo esplicito

ed esempio con excel

y su x

7

x_i

3

4

5

6

8,5

9,5

y_i

1,4

2,6

2

4

5

6

y = 0,68x - 0,58

R² = 0,9265

6

5

4

y_i

3

Lineare (y_i)

2

1

0

0

2

4

6

x_i

3

4

5

6

8,5

9,5

10

x su y

y = 1,3625x + 1,2312

R² = 0,9265

y_i

1,4

2,6

2

4

5

6

8

10

9

8

7

6

5

4

3

2

1

0

x_i

Lineare (x_i)

8

0

2

4

6

8

Relazione con il coefficiente di Bravais

Bravais-Pearson

Si chiama coefficiente di correlazione lineare r tra le grandezza X ed Y la media

geometrica dei coefficienti angolari delle rette di regressione di Y su X e di X su Y:

r = ± b* ⋅ b'*

r = ± b* ⋅ b'* ⇒ r =

σ XY

σ XσY

Dove il segno ± è scelto a seconda del segno

(concorde) dei coefficienti. Ne segue:

Che è l’indice di Bravais - Pearson

Ricordiamo che:

Per r=+1 si parla di correlazione perfetta diretta

Per r=-1 si parla di correlazione perfetta indiretta

Per r=0 si parla di correlazione nulla

Come indice per indicare la bontà della

regressione si usa, solitamente, l’indice r2

2

σ

r 2 = b* ⋅ b'* ⇒ r 2 = 2 XY 2

σ XσY

9

Regressione Lineare e variabili standardizzate

xy − y x

Cov( x, y )

b=b =

=

2

2

Var ( x)

x − x

*

y = a + bx

()

a = a * = y − b* x

y = a * + b * x = y − b* x + b * x = y + b * ( x − x )

σ XY

σY

y − y = b ( x − x) = 2 ( x − x) = r

( x − x)

σX

σX

*

y− y

σY

=r

( x − x)

YST = rX ST

σX

Variabili standardizzate

Dalla regressione di X su Y otterrei:

x = a'+b' y

b' =

*

xy − y x

()

y − y

2

2

Cov( x, y)

=

Var ( y)

a'* = x − b'* y

X ST = rYST

10

Regressione Lineare e variabili standardizzate

y = a + bx

YST = rX ST

Variabili standardizzate

x = a'+b' y

X ST = rYST

Nel piano cartesiano (X_ST, Y_ST) le rette sopra indicate hanno coefficienti angolari r

ed 1/r e dunque sono simmetriche rispetto alla bisettrice I-III quadrante o II-IV a

seconda del segno di r.

Al tendere di r a +1 o -1 esse tendono a coincidere con la bisettrice (casi di

correlazione perfetta diretta per r=+1 o correlazione perfetta indiretta per r=-1)

11

Scomposizione della varianza e grado di

accostamento

Valutiamo il grado di accostamento e quindi la bontà della regressione andando a

considerare le differenze tra i valori teorici dettati dalla regressione che chiameremo

yi* ed i valori misurati (sperimentali) yi . Valgono le seguenti definizioni:

Def. Errore Standard

ES =

∑ (y − y )

* 2

i

i

i

n

Def. Varianza di Regressione (di Interpolazione) Lineare

Def. Varianza Residua

Var ( R) =

∑ (y − y )

i

i

n

* 2

i

Var ( L) =

∑ (y

*

i

−y

i

n

= ( ES )

2

12

)

2

Scomposizione della varianza e grado di

accostamento

Per queste grandezze vale il seguente teorema :

Teo. (di Scomposizione della Varianza)

Var (Y ) = Var ( L) + Var ( R)

In più vale il teorema:

Teo.

Var ( L)

Var ( R)

r =

= 1−

Var (Y )

Var (Y )

2

Possiamo interpretare il risultato dei precedenti teoremi affermando che più r2 si

avvicina ad 1 più la Varianza residua ( e quindi l’errore attribuibile alla regressione) è

piccolo e quindi migliore è la regressione.

13

Scomposizione della varianza e grado di

accostamento

∑ (y − y )

2

Var (Y ) =

i

i

n

Var ( R) =

Var ( L) =

∑ (y

*

i

−y

∑ (y − y )

i

* 2

i

i

n

)

2

i

n

14

Scomposizione della varianza e grado di

accostamento: dimostrazioni

*

(

y

−

y

∑ i i)=0

a)

i

*

*

*

*

*

(

y

−

a

−

b

x

)

=

(

y

−

y

+

b

x

−

b

x

)

=

(

y

−

y

)

−

b

∑ i

∑ i

∑ i

∑ ( xi − x) = 0

i

i

i

i

i

i

*

(

y

−

y

∑ i i ) xi = 0

b)

i

*

*

*

*

*

(

y

−

a

−

b

x

)

x

=

(

y

−

y

+

b

x

−

b

x

)

=

(

y

−

y

)

x

−

b

∑ i

∑ i

∑ i

∑ ( xi − x)xi =

i

i

i

i

i

i

i

i

2

= ∑ ( yi − y )xi − b ∑ ( xi − x)xi = ∑ yi xi − y ∑ xi − b ∑ xi − x∑ xi =

i

i

i

i

i

i

*

*

(

( ) ) = n Cov( X , Y ) − b n Var( X ) = 0

= n xy − n y x − b n x − x

*

essendo

b* =

2

2

Cov( X , Y )

Var ( X )

2

* 2

15

Scomposizione della varianza e grado di

accostamento: dimostrazioni

*

*

(

y

−

y

)

y

∑ i i i =0

c)

i

(

)

= a ∑ y + b ∑ x y − n(a )

*

*

*

*

(

y

−

a

−

b

x

)

a

+

b

xi =

∑ i

i

i

*

* 2

*

i

i

i

* *

( ) − a b n x − a b n x − (b ) n x

y + nb xy − n(a ) − 2na b x − n(b ) x =

*

*

* 2

2

* 2

* *

* 2

*

* 2

* *

(

* 2

* *

2

=

2

)

( )x =

− (x ) ) = nb [cov( X , Y ) − b Var ( X )] =

2

= n( y − b x) y + nb xy − n y − b x − 2n( y − b x)b x − n b

*

*

( ) (x

= nb ( xy − x y ) − n b

*

= a*n y + b*n xy

i

= a n y + b n xy − n a

*

= na

i

( ) nx

− a b nx − a b nx − b

* *

* 2

2

*

2

*

*

Cov( X , Y )

= nb Cov( X , Y ) −

Var ( X ) = 0

Var ( X )

*

* 2

2

*

*

16

Scomposizione della varianza e grado di

accostamento: dimostrazioni

∑ (y − y )(y

d)

*

i

i

*

i

)

−y =0

Tenendo conto dei punti a) e c) :

i

∑ (y − y )(y

*

i

i

*

i

)

i

)

* 2

i

i

i

i

*

i

−y

)

2

i

*

−y

))

2

=

i

(

= ∑ yi − y

i

*

i

∑ (y − y ) = ∑ ((y − y ) + (y

2

)

i

∑ (y − y ) = ∑ ( y − y ) + ∑ (y

i

(

i

2

e)

f)

(

− y = ∑ yi − yi* yi* − y ∑ yi − yi* = 0

)

* 2

(

+ 2∑ yi − y

i

*

)(y

*

)

(

)

(

− y + ∑ y − y = ∑ yi − y

*

2

i

i

) + ∑ (y

* 2

*

−y

)

2

i

Var (Y ) = Var ( L) + Var ( R)

17

Scomposizione della varianza e grado di

accostamento: dimostrazioni

Var ( L)

Var ( R)

r =

= 1−

Var (Y )

Var (Y )

g)

2

( )

2

2

Cov

(

X

,

Y

)

Cov

( X , Y ) Var ( X )

*

r2 =

b

=

=

Var ( X ) ⋅Var (Y )

Var 2 ( X ) Var (Y )

=

*

*

2

(

b

x

−

b

x

)

∑ i

i

nVar(Y )

=

*

*

*

*

2

(

a

+

b

x

−

(

a

+

b

x

))

∑

i

i

2

2

(

x

−

x

)

∑ i

i

nVar (Y )

=

*

2

(

y

−

y

)

∑ i

Var ( L)

=

=

nVar (Y )

Var (Y )

i

nVar (Y )

18

Tabelle a doppia entrata

Facendo riferimento alla solita tabella, scriviamo:

r

b = b* =

Cov( X , Y )

=

Var ( X )

c

∑∑ x y n

i

i =1 j =1

r

∑x n

2

i i0

i =1

r

Cov( X , Y )

b' = b' =

=

Var (Y )

*

j ij

− nx ⋅ y

()

−n x

2

y1

y2

....

yj

x1

x2

n11

n21

n12 .... n1 j

n22 .... n2 j

....

xi

....

yc

Tot

.... n1c

.... n2 c

n10

n20

....

ni1

.... .... .... .... ....

ni 2 .... nij .... nic

....

ni 0

....

xr

....

nr1

.... .... .... .... ....

nr 2 .... nrj .... nrc

....

nr 0

Tot

n01

n02 .... n0 j

.... n0 c

r

X=

c

∑∑ x y n

i =1 j =1

r

i

j ij

− nx ⋅ y

()

2

y

∑ i ni 0 − n y

i =1

2

∑ x ⋅n

i

i =1

n

Con

c

∑y

Y=

i0

j =1

j

n

⋅ n0 j

19

n

Tabelle a doppia entrata

Parametri di Regressione:

b* =

Cov( X , Y )

Var ( X )

a * = y − b* x

b'* =

Cov( X , Y )

Var (Y )

a'* = x − b'* y

Rette di Regressione:

y = a * + b* x

x = a'* +b'* y

20

![2 [6] Una compagnia di assicurazione ritiene che gli assicurati](http://s1.studylibit.com/store/data/002416903_1-3377a891909164cbe7bb266e8421813f-300x300.png)