1

Regressione logistica

Come in tutti i modelli regressivi, ci sono dei fattori X1 ; :::; Xp misurabili, ed un

output Y anch’esso misurabile, tutti relativamente ad un insieme di individui.

Tuttavia, nella regressione logistica l’output Y è dicotomico: 0 o 1, mentre i

predittori assumono valori reali generici, come nella regressione lineare multipla

tradizionale.

Si pensa che, dati i valori dei predittori, l’output Y 2 f0; 1g sia casuale ma

con legge univocamente determinata dai predittori. Inoltre, il modo di dipendere

dai predittori non è qualsiasi ma avviene solo attraverso una loro combinazione

a¢ ne, detta predittore lineare

= a1 X1 + ::: + ap Xp + b:

Mettiamo a confronto regressione logistica (RLog) e regressione lineare multipla (RLM) tradizionale, per spiegare meglio il modello RLog. Nella RLM, dati

i valori x1 ; :::; xp dei predittori, noti i coe¢ cienti a1 ; :::; ap ; b, l’output è una v.a.

gaussiana Y di media = (media uguale al predittore lineare) e varianza 2 ,

quindi rappresentabile nella forma

Y = a1 x1 + ::: + ap xp + b + "

con " N 0; 2 . Invece, nella RLog, dati i valori x1 ; :::; xp dei predittori, noti

i coe¢ cienti a1 ; :::; ap ; b, l’output è una v.a. di Bernoulli Y , di parametro p che

dipende da attraverso una certa funzione.

Pensiamo ad un esempio: supponiamo che gli individui siano le nazioni europee e che, per una certa nazione, sia Y = 1 se la nazione migliora la propria

condizione economica (Y = 0 altrimenti) durante l’anno 2011. I predittori

potrebbero essere gli investimenti in ricerca, e così via del 2010. Noti i valori

dei predittori, la casualità non è certo esaurita, quindi Y resta aleatorio, ma

la sua legge è ora determinata, nota. La legge, trattandosi di una Bernoulli, è

riassunta nel numero p. Nel modello RLog si suppone che la probabilità p di

miglioramento sia nota quando sono noti i predittori. Inoltre si suppone che p

dipenda dai predittori solo attraverso la loro combinazione a¢ ne .

Un altro esempio: gli individui sono esemplari di complessi sistemi meccanici

o elettronici, Y = 1 se il sistema funziona per un anno, i predittori possono essere

valori misurati di caratteristiche meccaniche ecc. di sottoparti, del materiale ecc.

Essendo p una probabilità, non possiamo pensare che la relazione tra p ed

sia del tipo p = , cioè

p = a1 x1 + ::: + ap xp + b

altrimenti otterremmo per p valori anche esterni a [0; 1]. Si deve adottare un

modello del tipo

g (p) = a1 x1 + ::: + ap xp + b

dove g è una funzione de…nita in [0; 1] a valori reali, invertibile. In modo che sia

p=g

1

(a1 x1 + ::: + ap xp + b) :

1

Una scelta molto comune è la funzione detta logit

g (p) = log

p

1

p

:

Per p ! 0 essa tende a 1, mentre per p ! 1 tende a +1; ed è strettamente

crescente, oltre che regolare. La sua funzione inversa è

g

[Infatti log

exp ( ), p =

Y

p

=

1 p

exp( )

1+exp( ) .]

,

p

1 p

1

( )=

exp ( )

1 + exp ( )

= exp ( ), p = (1

p) exp ( ), p (1 + exp ( )) =

In de…nitiva, il modello è

B (1; p) con p =

exp ( )

dove

1 + exp ( )

= a1 x1 + ::: + ap xp + b:

Quando i coe¢ cienti a1 ; :::; ap ; b sono divenuti noti, preso un nuovo individuo,

calcolati i valori dei suoi predittori x1 ; :::; xp , si calcola la probabilità p relativa

a quell’individuo (probabilità di questo o quell’accadimento, dipende dal problema). Se p è molto elevata, siamo abbastanza sicuri che per quell’individuo sarà

Y = 1, mentre se è molto bassa, conteremo che sia Y = 0; nel mezzo ovviamente

c’è molta indecisione sul valore di Y di quell’individuo, pur valendo comunque

che se p > 1=2 è più probabile Y = 1 e viceversa.

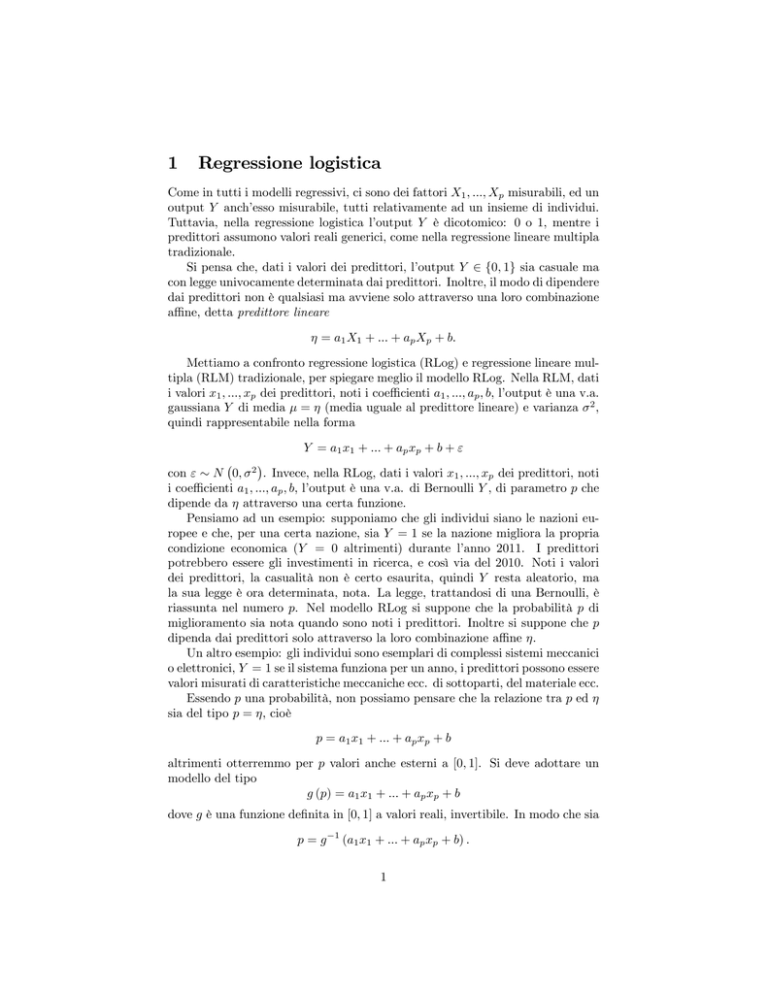

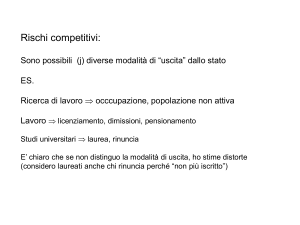

Nella teoria generale dei modelli lineari generalizzati, il numero = a1 x1 +

::: + ap xp + b viene detto predittore lineare, la funzione g 1 viene detta link

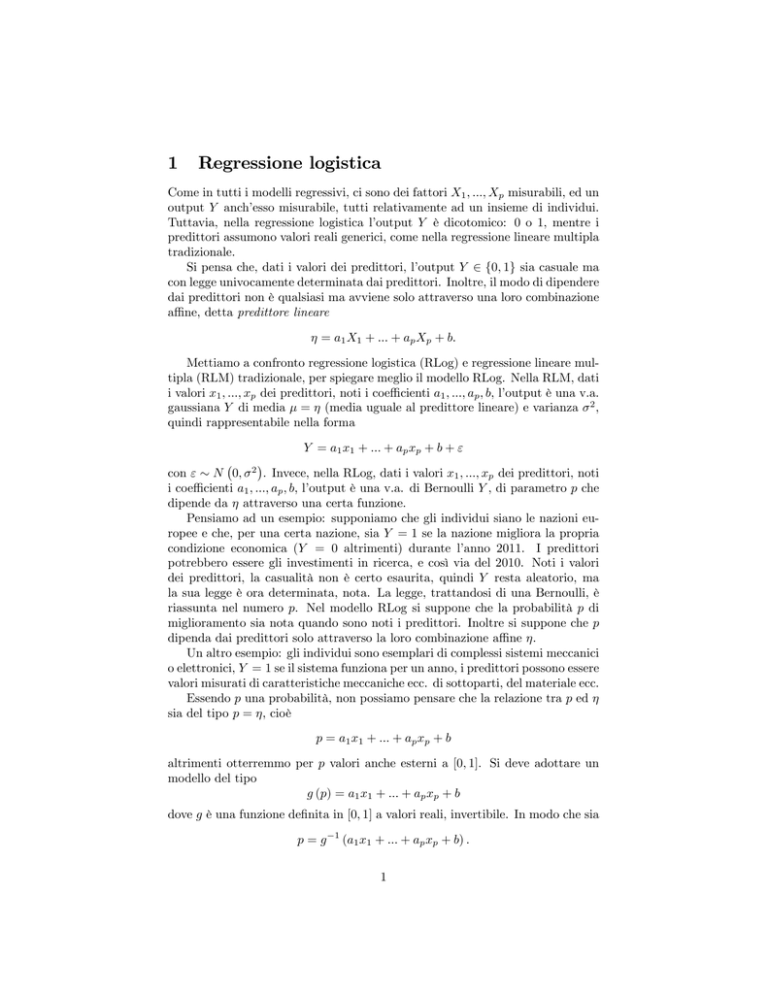

function e la funzione g viene detta mean function. Nella regressione logistica,

la link function è la funzione logistica, rappresentata in …gura.

y

1.0

0.8

0.6

0.4

0.2

-5

-4

-3

-2

-1

0

Funzione logistica

1

2

3

4

5

x

exp( )

1+exp( ) .

Resta il problema di trovare i coe¢ cienti. Si devono avere n individui di cui

si conoscano i valori dei predittori Xi e di Y . Si usa il metodo della massima

2

verosimiglianza. Noti i valori x1 ; :::; xp dei predittori di un individuo, abbiamo

detto che Y è B (1; p), con p = g 1 ( ), = a1 x1 + ::: + ap xp + b. Quindi

P (Y = 1) = p, P (Y = 0) = 1 p. Se indichiamo uno dei due numeri 0 o 1 con

y, si può scrivere in una sola formula

P (Y = y) = py (1

1 y

p)

:

Supponiamo come abbiamo detto che, per un individuo noto, sia noto anche il

1 y

valore di Y , che chiamiamo con y. Il numero py (1 p)

è la verosimiglianza

relativa a quell’individuo. In astratto, la verosimiglianza è funzione di molte

grandezze: x1 ; :::; xp , y, a1 ; :::; ap ; b. Trattandosi di un individuo con x1 ; :::; xp ,

y noti, ben precisi, la verosimiglianza è funzione di a1 ; :::; ap ; b. Se poi consid(i)

(i)

eriamo gli n individui indipendenti, ed indichiamo con x1 ; :::; xp , y (i) i loro

valori noti, vale

P Y (1) = y (1) ; :::; Y (n) = y (n) =

n

Y

p(i)

y (i)

1

p(i)

1 y (i)

i=1

dove

p(i) = g

1

(i)

;

(i)

(i)

= a1 x1 + ::: + ap xp(i) + b:

Questa è la verosimiglianza del campione sperimentale, funzione di a1 ; :::; ap ; b.

Il metodo di massima verosimiglianza consiste nel cercare i valori di a1 ; :::; ap ; b

n

Y

y (i)

1 y (i)

p(i)

1 p(i)

. Tecche rendono massima la verosimiglianza, cioè

i=1

nicamente, conviene massimizzare il logaritmo della verosimiglianza (è equivalente), cioè

n

X

y (i) log p(i) + 1 y (i) log 1 p(i) :

i=1

Il software esegue la massimizzazione con un procedimento iterativo.

1.1

Classi…cazione

Il metodo della regressione logistica serve ad esempio per e¤ettuare una classi…cazione non perentoria. L’output Y può assumere due valori, che per comodità

espositiva chiamiamo A e B. Assume A con probabilità p.

A partire da un set di dati, cioè di individui di cui si conoscano sia i predittori sia la classe, A o B, a cui appartengono, si calcolano i coe¢ cienti del

modello. Poi, esaminando nuovi individui che vogliamo classi…care sulla base

della sola conoscenza dei predittori, calcoliamo il numero p di un individuo, ed

assegnamolo alla classe che ha probabilità maggiore (A se p > 1=2). Eseguita

così è una classi…cazione perentoria, ma è corredata dal numero p stesso, che

fornisce un’indicazione del grado di sicurezza che abbiamo, nella classi…cazione

appena eseguita.

3

2

Modelli lineari generalizzati

Sono una generalizzazione del modello base, gaussiano,

Y = a1 X1 + ::: + ap Xp + b + "

e di quello bernoulliano (detto modello binomiale, in questo contensto) appena

visto

Y

B (1; p) con p =

exp ( )

dove

1 + exp ( )

= a1 x1 + ::: + ap xp + b:

In generale, si ipotizza che l’output Y abbia distribuzione di una certa classe,

ad esempio appunto gaussiana, Bernoulli, Poisson, ecc., e si ipotizza che un suo

parametro fondamentale , di solito la media ( per la gaussiana, p per la

Bernoulli, per la Poisson) sia legato ai fattori attraverso una formula del tipo

=g

1

( )

dove

= a1 x1 + ::: + ap xp + b

è chiamiato predittore lineare. Chiamiamo link function la funzione g. Nella regressione logistica si prende come g la funzione logit. Nella regressione tradizionale,

g è l’identità.

Il comando di R che esegue la regressione per i modelli lineari generalizzati

è glm.

4