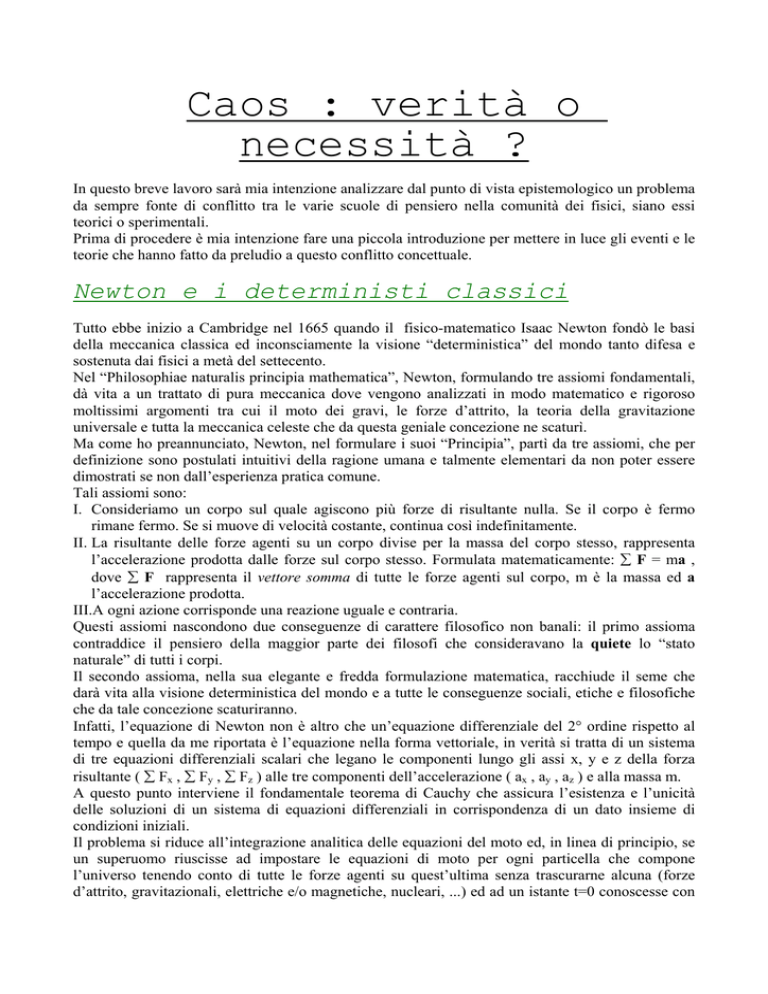

Caos : verità o

necessità ?

In questo breve lavoro sarà mia intenzione analizzare dal punto di vista epistemologico un problema

da sempre fonte di conflitto tra le varie scuole di pensiero nella comunità dei fisici, siano essi

teorici o sperimentali.

Prima di procedere è mia intenzione fare una piccola introduzione per mettere in luce gli eventi e le

teorie che hanno fatto da preludio a questo conflitto concettuale.

Newton e i deterministi classici

Tutto ebbe inizio a Cambridge nel 1665 quando il fisico-matematico Isaac Newton fondò le basi

della meccanica classica ed inconsciamente la visione “deterministica” del mondo tanto difesa e

sostenuta dai fisici a metà del settecento.

Nel “Philosophiae naturalis principia mathematica”, Newton, formulando tre assiomi fondamentali,

dà vita a un trattato di pura meccanica dove vengono analizzati in modo matematico e rigoroso

moltissimi argomenti tra cui il moto dei gravi, le forze d’attrito, la teoria della gravitazione

universale e tutta la meccanica celeste che da questa geniale concezione ne scaturì.

Ma come ho preannunciato, Newton, nel formulare i suoi “Principia”, partì da tre assiomi, che per

definizione sono postulati intuitivi della ragione umana e talmente elementari da non poter essere

dimostrati se non dall’esperienza pratica comune.

Tali assiomi sono:

I. Consideriamo un corpo sul quale agiscono più forze di risultante nulla. Se il corpo è fermo

rimane fermo. Se si muove di velocità costante, continua così indefinitamente.

II. La risultante delle forze agenti su un corpo divise per la massa del corpo stesso, rappresenta

l’accelerazione prodotta dalle forze sul corpo stesso. Formulata matematicamente: ∑ F = ma ,

dove ∑ F rappresenta il vettore somma di tutte le forze agenti sul corpo, m è la massa ed a

l’accelerazione prodotta.

III.A ogni azione corrisponde una reazione uguale e contraria.

Questi assiomi nascondono due conseguenze di carattere filosofico non banali: il primo assioma

contraddice il pensiero della maggior parte dei filosofi che consideravano la quiete lo “stato

naturale” di tutti i corpi.

Il secondo assioma, nella sua elegante e fredda formulazione matematica, racchiude il seme che

darà vita alla visione deterministica del mondo e a tutte le conseguenze sociali, etiche e filosofiche

che da tale concezione scaturiranno.

Infatti, l’equazione di Newton non è altro che un’equazione differenziale del 2° ordine rispetto al

tempo e quella da me riportata è l’equazione nella forma vettoriale, in verità si tratta di un sistema

di tre equazioni differenziali scalari che legano le componenti lungo gli assi x, y e z della forza

risultante ( ∑ Fx , ∑ Fy , ∑ Fz ) alle tre componenti dell’accelerazione ( ax , ay , az ) e alla massa m.

A questo punto interviene il fondamentale teorema di Cauchy che assicura l’esistenza e l’unicità

delle soluzioni di un sistema di equazioni differenziali in corrispondenza di un dato insieme di

condizioni iniziali.

Il problema si riduce all’integrazione analitica delle equazioni del moto ed, in linea di principio, se

un superuomo riuscisse ad impostare le equazioni di moto per ogni particella che compone

l’universo tenendo conto di tutte le forze agenti su quest’ultima senza trascurarne alcuna (forze

d’attrito, gravitazionali, elettriche e/o magnetiche, nucleari, ...) ed ad un istante t=0 conoscesse con

infinita precisione posizione e velocità di ogni particella costituente il sistema, il teorema di

esistenza e unicità delle soluzioni garantirebbe una conoscenza del futuro senza alcuna ambiguità.

E’ evidente che ciò uccide ogni idea di libero arbitrio, coscienza delle azioni e decisioni; il concetto

di evento casuale o aleatorio perde di significato e in una filosofia strettamente deterministica la

presenza nell’Universo di un Dio onnipresente risulta del tutto obsoleta.

L’atteggiamento deterministico influenzò anche il ‘700 e lo sviluppo della meccanica celeste e della

dinamica dei sistemi elastici portò alla formulazione di una teoria dinamica ben precisa.

Si arrivò a una riformulazione dell’equazione del moto di Newton da parte del fisico-matematico

francese Lagrange il quale introdusse la ben nota funzione “lagrangiana” per descrivere le

interazioni tra i componenti elementari che formano il sistema fisico studiato.

Il formalismo lagrangiano fu introdotto per risolvere due problemi legati alle equazioni di Newton:

il problema dell’espressione delle equazioni in un sistema di coordinate arbitrario e il problema

dell’eliminazione delle reazioni vincolari nei sistemi vincolati.

Matematicamente la lagrangiana è definita dalla funzione L=T-V cioè la differenza di energia

cinetica T ed energia potenziale V. La funzione di Lagrange deve pensarsi espressa come funzione

delle coordinate q = (q1 ... qN) di un generico sistema di riferimento (in sostituzione delle coordinate

cartesiane ortogonali imposte dal formalismo newtoniano) e delle velocità generalizzate q=(q1 ...

qN).

Quindi L=L(q,q) e le equazioni del moto nel nuovo formalismo hanno la seguente forma:

d/dt(∂L/∂qi) = ∂L/∂qi

(1)

con i = 1, ..., N.

Si noti che un sistema con N gradi di libertà è descritto da un sistema di N equazioni differenziali

del 2° ordine che, grazie al teorema di Cauchy, ammette una e una sola soluzione una volta

assegnate le condizioni iniziali del sistema.

E’ del tutto equivalente la scelta dei due formalismi per descrivere un sistema fisico con l’unica

differenza che il formalismo lagrangiano non vincola all’uso di coordinate cartesiane ortogonali non

sempre convenienti per descrivere la dinamica di un sistema.

Matematicamente parlando, sia con Newton sia con Lagrange si ha a che fare con un sistema di

equazioni differenziali del 2° ordine.

L’ideale sarebbe avere equazioni del 1° ordine, indubbiamente più facili da trattare e da risolvere.

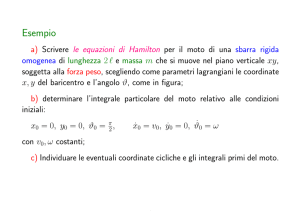

Il problema fu risolto dal fisico-matematico Hamilton che trovò il modo, nel descrivere un sistema

fisico con N gradi di libertà, di passare da un sistema di N equazioni del secondo ordine ad un

sistema di 2N equazioni del primo ordine.

Richiamando le equazioni di Lagrange ( 1 ), Hamilton introdusse delle nuove variabili p1 ... pN dette

momenti coniugati alle coordinate generalizzate q1 ... qN mediante la seguente definizione:

pi = ∂L(q,q,t)/∂qi

con i = 1 ... N

sicchè le equazioni di Lagrange assumono la forma:

pi = ∂L(q,q,t)/∂qi

con i = 1 ... N

Esiste un fondamentale teorema che lega il formalismo Hamiltoniano al formalismo Lagrangiano:

Si consideri la lagrangiana L = L(q,q,t) con determinante hessiano non nullo: det(∂ 2L /∂qi∂qh ) ≠ 0.

Allora il sistema:

p=∂L/∂q

(2)

p=∂L/∂q

è equivalente al sistema:

q=∂H/∂p (3)

p = -∂ H / ∂ q ( 3 )

dove H = H (p,q,t) è la funzione definita da:

H (p,q,t) = [ p· q - L(q,q,t)]q = q( p,q,t )

essendo la funzione q(p,q,t) definita per inversione della ( 2 ).

Inoltre si ha:

∂ H / ∂ t = -∂ L / ∂ t

La funzione H si dice funzione di Hamilton o hamiltoniana del sistema, e le equazioni ( 3 ) si

dicono equazioni canoniche o di Hamilton.

Il teorema stabilisce dunque l’equivalenza tra le equazioni di Lagrange e le equazioni di Hamilton,

nel caso di determinante hessiano non nullo.

La funzione hamiltoniana di un sistema meccanico è strettamente connessa con l’energia; in un

sistema meccanico naturale l’hamiltoniana H ha l’espressione

H = T2 - T0 + V

dove T2 e T0 sono i termini dell’energia cinetica T, rispettivamente di ordine due e zero nelle

velocità q , riespressi in funzione di p,q,t ; in particolare, nel caso indipendente dal tempo, si ha:

H=T+V

Quindi, nel caso indipendente dal tempo, l’hamiltoniana coincide con l’energia totale del sistema,

ovviamente espressa in funzione delle coordinate libere e dei momenti coniugati.

Il risultato ottenuto da Hamilton insegna una via pratica molto semplice per costruire l’hamiltoniana

nel caso indipendente dal tempo: basta scrivere l’energia totale T + V , con la sola avvertenza di

esprimere T in termini di p anziché di q .

Perciò, nel formalismo hamiltoniano, un sistema con N gradi di libertà è caratterizzato da N coppie

di coordinate generalizzate (q1 ... qN) e momenti (p1 ... pN) , le quali soddisfano le equazioni del

moto canoniche :

pi = -∂H/∂qi ; qi = ∂H/∂pi con i = 1, ... ,N

dove H = H(p1 ... pN q1 ... qN) è l’hamiltoniana del sistema.

Anche in questo caso si tratta di risolvere un sistema di 2N equazioni del 1° ordine che per via del

teorema di Cauchy ammette un’unica soluzione analitica una volta fissati in modo univoco e

infinitamente preciso le condizioni iniziali del moto.

Per concludere, tutti e tre i diversi (ma solo nella forma) formalismi conducono inesorabilmente ad

un determinismo ASSOLUTO.

Successivamente, a fine ‘800, Maxwell, proponendo il suo trattato sull’elettromagnetismo

introdusse il concetto di campo e tale concetto fu usato in seguito da Einstein con le forze

gravitazionali nella teoria della relatività generale.

Ma il concetto di campo e la critica delle azioni a distanza hanno portato a sostituire i sistemi finiti

di equazioni differenziali ordinarie, con equazioni alle derivate parziali, ma le assunzioni di base

sono rimaste totalmente inalterate, infatti, anche le equazioni alle derivate parziali, se pur molto più

complesse di quelle ordinarie, sono in linea di principio risolvibili analiticamente e ammettono

soluzione unica una volta fissati dati iniziali ed al contorno.

Riassumendo, i cardini base su cui si poggia l’intero formalismo classico (sia matematicamente, sia

filosoficamente) si possono schematizzare in tre punti:

a) Riduzionismo. Le proprietà globali sono univocamente determinate dalle interazioni tra

componenti e pertanto la fisica macroscopica è completamente deducibile dalla fisica delle

interazioni fondamentali.

b) Determinismo. La situazione iniziale determina univocamente il futuro.

c) Reversibilità del tempo. Se si inverte il segno del tempo, le soluzioni risultanti sono altrettanto

“legittime”: non esiste a livello microfisico una freccia del tempo e quella che compare in alcuni

modelli macrofisici (es. modello della diffusione) è un “artificio” introdotto dalle

approssimazioni adottate.

Prima di proseguire vorrei ricordare che il principio del “riduzionismo” fu magistralmente

enunciato da Cartesio quando la scoperta di una imprevista complessità del mondo microscopico

mise in crisi i principi metodologici fondamentali della fisica in generale.

Tale principio fonda sulla convinzione che il mondo microscopico sia più semplice di quello

macroscopico e di fronte ad eventuali discrepanze tra teoria e dati sperimentali, la prescrizione

aurea consiste nel cercare un livello più profondo di realtà, più fondamentale e più semplice.

Si tratta di un principio molto potente: quando è possibile applicarlo con successo, esso fornisce la

chiave per un nuovo livello di interpretazione dei fenomeni e consente un approfondimento delle

conoscenze. Il microscopico costituisce dunque la frontiera della conoscenza stessa e tale pensiero è

fortemente diffuso e operante anche ai giorni nostri (basti pensare alle ricerche a livello di particelle

elementari) .

Dopo questa breve introduzione sui formalismi classici, sembrerebbe che lo studio della natura e

dei suoi molteplici fenomeni si riduca all’impostazione delle equazioni del moto, scegliendo il

formalismo ed il sistema di riferimento più comodi a noi, e una volta definiti i dati iniziali e/o le

condizioni al contorno, trovare una tecnica matematica per integrarle.

Sfortunatamente le cose non sono così semplici ! Per dimostrare come questo tipo di approccio sia

impossibile da realizzarsi in situazioni reali, valga come esempio lo studio del moto di un gas

all’interno di un recipiente.

Supponiamo di avere nel recipiente una mole di gas i.e. ∼1023 atomi .

Ora, usando il formalismo hamiltoniano, dovrei introdurre ∼1023 coordinate generalizzate qi ed

altrettanti momenti coniugati pi e una volta sviluppata l’hamiltoniana H che tenga conto di tutte le

energie cinetiche e di tutti i potenziali di interazione delle particelle l’una con l’altra e con le pareti

del recipiente (anch’esso formato da un numero N di atomi) , otterrei un sistema di ∼2*1023

equazioni canoniche del moto. Fatto ciò, dovrei ad un istante arbitrario t=0 misurare

contemporaneamente e con infinita precisione tutte le posizioni e tutti i momenti delle ∼1023

particelle contenute nel sistema studiato. Infine, forte del teorema di Cauchy e delle tecniche

analitiche per l’integrazione delle equazioni differenziali, risolvo il mio super-sistema che

ammetterà soluzione unica una volta imposti i dati iniziali precedentemente misurati. A questo

punto, tenendo presente l’assunzione della reversibilità del tempo, il futuro ed il passato del sistema

si rivelerà ai miei occhi senza dubbio alcuno ed a qualunque tempo t potrò conoscere posizione e

velocità di ogni particella con infinita precisione.

PROBLEMA: impostare e risolvere analiticamente un sistema di ∼1023 equazioni differenziali non

disaccoppiate (e soprattutto misurare contemporaneamente ∼1023 posizioni e momenti ) è cosa

UMANAMENTE IMPOSSIBILE!!!

Statistica, probabilità ed ... entropia

!!!

A questo punto, nella seconda metà del 1800, entra in scena il concetto di “processo stocastico”

(fortemente sostenuto dai fisici termodinamici) e tale concetto fu l’annuncio di una rivoluzione

concettuale, dapprima fortemente criticata ma poi accettata, che condusse ad una descrizione

probabilistica dei fenomeni fisici.

Infatti, in quegl’anni, la termodinamica si presentava come un livello di descrizione della realtà del

tutto avulsa dalla struttura microscopica : le sue variabili (es.temperatura, pressione, entropia, ...)

non erano desunte dalla dinamica delle particelle.

Grazie a fisici come Maxwell, Boltzmann e Gibbs, la meccanica statistica ha tentato di correlare

due livelli di descrizione della realtà, costruendo i concetti di temperatura, pressione, entropia come

proprietà di insieme della materia .

La logica fortemente deterministica viene parzialmente abbandonata ed un problema del tutto

intrattabile come il moto di una mole di gas dentro un recipiente, viene agevolmente trattato se si

accettano i principi e le variabili introdotte dalla meccanica statistica.

In questa logica, un concetto come “velocità di una particella ad un certo istante”, viene sostituito

dai più pratici : distribuzione statistica e valor medio delle velocità , inoltre, fanno la loro comparsa

variabili come temperatura e pressione : la prima legata all’energia cinetica media delle particelle

(e quindi alla loro velocità media) , la seconda legata alla quantità di moto media scambiata tra il

gas e le pareti del recipiente durante le collisioni.

Storicamente il problema della determinazione della distribuzione delle velocità di un gas composto

da un gran numero di molecole fu risolto da Maxwell.

La distribuzione maxwelliana delle velocità per un gas di N molecole di massa m a temperatura T è:

n(v) = 4πN(m/2πkT)3/2v2exp[-mv2/2kT]

In questa equazione n(v) è il numero di molecole per intervallo unitario di velocità che hanno

velocità comprese tra v e v+dv ; oppure si può dire che n(v)dv è il numero di molecole del gas che

hanno velocità compresa tra v e v+dv.

Si noti che, per un dato gas, la distribuzione delle velocità dipende solo dalla temperatura .

Successivamente, Maxwell e Boltzmann diedero una descrizione alternativa del moto delle

molecole ponendo l’attenzione sulla distribuzione delle energie, anziché delle velocità.

Analizzarono la distribuzione n(E), nella quale n(E)dE rappresenta il numero di molecole con

energia compresa tra E ed E+dE.

Come precedentemente anticipato, il problema fu risolto per la prima volta da Maxwell, ricavando

la cosiddetta distribuzione di Maxwell-Boltzmann nel caso particolare in cui le molecole possiedano

solo energia cinetica traslazionale (si è trascurata l’energia cinetica rotazionale e vibrazionale delle

molecole) :

n(E) = {2NE1/2exp[-E/kT]}/π1/2(kT)3/2

Avendo fatto l’ipotesi che le molecole del gas abbiano solo energia cinetica traslazionale, questa

distribuzione si applica soltanto a un gas monoatomico. Nel caso di gas con molecole più

complesse, all’interno dell’equazione compariranno altri fattori .

La bellezza delle due equazioni sta nel fatto che non c’è differenza se si contano le molecole per la

loro velocità o per la loro energia cinetica ; finché i limiti inferiore e superiore degli intervalli delle

velocità corrispondono a quelli delle energie cinetiche, tra quei limiti contiamo lo stesso numero di

molecole i.e. il numero di molecole con energia compresa tra E ed E+dE è lo stesso del numero di

molecole con velocità fra v e v+dv.

Matematicamente ciò si esprime:

n(E)dE = n(v)dv

La meccanica statistica e gli studi sulla termodinamica misero fortemente in crisi tutto il

formalismo deterministico, soprattutto quando venne enunciata la seconda legge della

termodinamica per studiare i processi reversibili ed irreversibili.

Questa legge tratta la variabile termodinamica: entropia e non è deducibile dagli assiomi di

Newton.

Il secondo principio dice sostanzialmente che ogni processo fisico, affinché avvenga, comporta un

aumento di entropia nell’universo; per esempio, se si ha a che fare con una “macchina termica”, il

secondo principio impone che non è possibile in un processo ciclico, convertire interamente calore

in lavoro senza che avvenga una qualche variazione dell’ambiente (questa enunciazione del

secondo principio, chiamata anche formulazione di Kelvin-Planck, stabilisce che non esiste una

macchina termica ideale ), analogamente, se si ha a che fare con un “frigorifero” il secondo

principio pone il vincolo : non è possibile un processo ciclico nel quale il calore fluisca da un

corpo ad un altro a temperatura maggiore, senza che null’altro accada (questo rappresenta

l’enunciato di Clausius e in sostanza dice che non esistono frigoriferi perfetti ).

Come vedremo, tutto ruota attorno ai concetti di trasformazione reversibile ed irreversibile.

Ricordo che si dice reversibile una trasformazione nella quale si può invertire il verso del processo

variando di una quantità infinitesima le condizioni dell’ambiente circostante (per esempio si pensi

ad un gas reale dentro un cilindro che passa dallo stato iniziale i (caratterizzato dalla pressione pi ,

dal volume Vi e dalla temperatura Ti ) allo stato finale f (caratterizzato da pf ,Vf e Tf ). La

trasformazione può essere irreversibile ponendo improvvisamente un peso sul pistone, oppure

reversibile aggiungendo sul pistone pochi grani di sabbia per volta).

Una trasformazione reversibile è dunque caratterizzata dal fatto che il sistema è sempre in uno stato

che si discosta poco da quello di equilibrio e quindi, nell’esempio del gas nel cilindro, aumentando

infinitamente il numero di passi intermedi e diminuendo, in corrispondenza, le dimensioni di ogni

passo (granelli di sabbia infinitamente piccoli e leggeri) , si arriva ad un processo ideale nel quale il

sistema attraversa una successione continua di stati di equilibrio che si possono rappresentare con

una linea continua sul piano pV.

Ma una trasformazione rigorosamente reversibile è una semplice ed utile astrazione !!!

Definendo la variabile di stato entropia S mediante il differenziale esatto:

dS = dQ/T

la variazione di entropia tra due stati i e f in una trasformazione reversibile è:

∆S = Sf - Si = ∫dS = ∫dQ/T

dove l’integrale è calcolato lungo un qualsiasi percorso reversibile che collega i due stati.

In natura non esistono trasformazioni reversibili; sono sempre presenti attrito e dispersioni di calore

incontrollabili, per cui difficilmente si può suddividere una trasformazione reale in una sequenza di

trasformazioni infinitesime. Ogni trasformazione reale è quindi irreversibile !!!

Utilizzando il concetto di entropia il secondo principio della termodinamica è così enunciato: in

qualsiasi trasformazione termodinamica che evolva tra due stati di equilibrio, l’entropia

dell’insieme costituito dal sistema più l’ambiente circostante può solo restare costante o

aumentare. Non può esistere in natura nessuna trasformazione nella quale diminuisca l’entropia

totale del sistema + l’ambiente circostante.

A questo punto entra in crisi la terza assunzione del formalismo deterministico i.e. la reversibilità

del tempo : è la variazione di entropia che indica perché un sistema evolve nel tempo in un verso

piuttosto che in un altro. I sistemi evolvono nel tempo sempre in modo tale da far aumentare

l’entropia totale del sistema+ambiente circostante.

Se si osserva un processo nel quale l’entropia del sistema diminuisce, si può essere sicuri che la

variazione d’entropia dell’ambiente circostante è positiva e sufficiente a rendere positiva anche la

variazione totale di entropia.

Ma intuitivamente, cos’è l’entropia ?

Si è visto che tutte le grandezze termodinamiche macroscopiche hanno una corrispondente

grandezza microscopica (per es. temperatura ↔ energia cinetica molecolare media).

LA GRANDEZZA MICROSCOPICA ASSOCIATA ALL’ENTROPIA È LA PROBABILITÀ RELATIVA DEI DIVERSI

MODI DI ORDINARE LE MOLECOLE DEL SISTEMA.

Se si pensa a situazioni comuni come l’espansione libera di un gas o la conduzione del calore tra

due corpi a differenti temperature una volta posti a contatto o, più semplicemente, la diffusione di

una zolletta di zucchero in una tazza di caffè, il sistema passa spontaneamente da uno stato di bassa

probabilità ad uno di alta probabilità.

Esiste una relazione, introdotta da Boltzmann, tra probabilità ed entropia :

S = k lnP

dove k è la costante di Boltzmann, S l’entropia del sistema e P il numero delle diverse

configurazioni molecolari che corrispondono allo stesso stato macroscopico.

L’entropia si può anche pensare come misura dell’aumento del disordine del sistema. Il termine

“disordine” non ha una definizione matematica precisa, ma è qualitativamente correlato al concetto

di probabilità. Quindi l’aumento di entropia nelle trasformazioni reali può essere visto come un

aumento del livello di disordine del sistema.

I processi naturali tendono a rendere l’universo più disordinato !!!

Qui è doveroso fare una precisazione: avendo a che fare con delle probabilità, una frase del tipo,

“tale evento non si verificherà mai !” , è logicamente sbagliata.

Infatti, in linea di principio c’è sempre la possibilità che, per una fluttuazione statistica, si possa

giungere spontaneamente ad uno stato finale del sistema con entropia minore di quella dello stato

iniziale. Per sistemi macroscopici, la probabilità che l’entropia decresca realmente in una

trasformazione spontanea è notevolmente piccola ma NON NULLA !!!

Per esempio, la probabilità che tutte le molecole d’aria di una stanza migrino spontaneamente da

una parte, lasciando il vuoto dall’altra, è esponenzialmente piccola ma non nulla (si noti che,

sebbene la situazione risulti paradossale, energia del sistema si conserva e quindi, siamo in accordo

con il primo principio della termodinamica), perciò, osservando il sistema per un tempo INFINITO

tale situazione deve verificarsi !!!

Poincarè,

Lorenz

deterministico’’

e

il

‘‘caos

Dopo la termodinamica ed il diffondersi della meccanica statistica, all’inizio del ‘900, un problema

intravisto e sviluppato dal fisico-matematico francese Poincaré, minacciò al cuore stesso

dell’ipotesi deterministica.

L’ipotesi deterministica “forte” è significativa a patto di conoscere con infinita precisione posizioni

e velocità. Tale conoscenza è ovviamente impossibile ma, in linea di principio, la precisione delle

osservazioni può essere sempre migliorata, non esistendo per essa, in meccanica classica, limiti

teorici. Poincaré dimostrò che in molti casi, i sistemi di equazioni differenziali possono dare origine

a soluzioni molto diverse tra loro in corrispondenza di condizioni iniziali estremamente vicine .

Studiando il “problema gravitazionale a tre corpi”, Poincaré incontrò delle “instabilità asintotiche”

i.e. se nello spazio delle fasi, al tempo t = 0 scegliamo due punti rappresentativi arbitrariamente

vicini tra loro, e chiamo ε la loro distanza, può accadere (per un insieme non nullo di parametri

fisici) che la separazione tra le traiettorie che emergono dai due punti aumenti esponenzialmente

come εexp[λt] (λ>0). Ciò vuol dire che se fissiamo una risoluzione δ del nostro apparato di misura,

per ogni ε* esisterà un t* tale che : ε* exp[λt*]>δ.

Per t>t* si avranno due traiettorie distinte per la stessa condizione “iniziale”. Il teorema di unicità

vale se partiamo da un punto ideale (ε = 0), ma ciò non ha significato in fisica.

Ma allora, se basta una modifica arbitrariamente piccola delle condizioni iniziali per avere a che

fare con un’evoluzione diversa, e diversa in modo imprevedibile, allora l’impossibilità di effettuare

misure infinitamente precise implica una impossibilità sostanziale di fare previsioni !!!

La portata epistemologica di tutto ciò è rivoluzionaria, perché di colpo entrano in crisi il

riduzionismo (il problema a tre corpi non è deducibile per estrapolazione da quello a due corpi) e il

determinismo (la predicibilità è limitata nel tempo). Anche la reversibilità entra in crisi, nonostante

le equazioni mantengano un’invarianza formale per inversione temporale, infatti, l’evoluzione da t

= 0 a t =t* a partire da una certa condizione iniziale è affetta dall’incertezza legata a λ>0. Se inverto

il tempo, le condizioni a t = t* sono a loro volta troncate, per cui anche il problema inverso

presenterà una direzione espandente e si arriverà, a t = 0, ad un punto finale NON COINCIDENTE con

quello da cui si era partiti nel problema diretto.

E’ importante sottolineare il fatto che questa critica ai dogmi del formalismo classico ha origine

nell’ambito di una teoria dinamica, sulla base dell’esistenza di direzioni instabili e della

impossibilità di una definizione assolutamente precisa delle condizioni iniziali (nessuna ipotesi

termodinamica e/o statistica è stata invocata).

Questa rivoluzione sfuggì ai contemporanei di Poincaré, e le conseguenze non furono sviluppate .

In quel periodo la ricerca fisica era interessata ad altri problemi come per esempio la radioattività,

la struttura atomica legata alla regolarità degli spettri atomici, ecc.

Ma negli anni ‘60, grazie alla disponibilità di potenti elaboratori elettronici e la spinta di problemi

pratici (es. la stabilità delle orbite dei satelliti o l’affidabilità delle previsioni meteorologiche) hanno

portato in auge questa linea di tendenza.

Famoso è il lavoro nel 1963 di E.N.Lorenz che, studiando un modello di instabilità idrodinamica a

tre equazioni non lineari accoppiate, riscoprì la non periodicità del flusso che scaturisce da tale

modello.

Infatti, sono sufficienti tre equazioni differenziali per avere una dipendenza critica dalle condizioni

iniziali con comparsa di un “attrattore strano” (o “attrattore caotico”) i.e. una sorta di “matassa” di

traiettorie che non ha dimensione intera.

Lorenz battezzò questo fatto “effetto farfalla”, osservando che è sufficiente lo sbatter d’ali di una

farfalla in Cina perché, dopo un certo tempo, ciò provochi un’incertezza nelle condizioni

meteorologiche in California .

Gli studi e le teorie di Lorenz nel campo della meteorologia e dei fenomeni “turbolenti” sono strati i

precursori di una nuova fisica, che si sviluppò dagli anni ‘60 fino ai giorni nostri soprattutto grazie

al forte sviluppo dell’informatica e dei calcolatori elettronici, per lo studio di sistemi complessi per

mezzo di equazioni puramente deterministiche.

Nasce il concetto di caos deterministico e vengono ripresi tutti i concetti e teoremi fisicomatematici riguardanti attrattori, cicli limite, biforcazioni nello spazio delle fasi, ecc. e soprattutto,

grazie a B.B.Mandelbrot, si sviluppa la teoria della geometria frattale e le sue applicazioni nei

modelli naturali.

La necessità di tali teorie nasce dalla necessità di spiegare qualitativamente e quantitativamente

l’esistenza in natura di fenomeni di auto-organizzazione come, per esempio, la comparsa di

strutture regolari in un fluido prossimo all’ebollizione se l’azione di un gradiente termico prodotto e

mantenuto dall’esterno è mantenuto sotto ben precise condizioni sperimentali.

Queste correnti di convezione all’interno del fluido che avvengono secondo tali strutture regolari

sono chiamati “rulli” (o “celle”) di Bénard.

Tutto ciò segnala la presenza di un elevato grado di cooperazione molecolare e questa cooperazione

può essere creata o distrutta semplicemente per effetto dalla modifica del valore di un parametro

che di per sé possiede un limitato contenuto informativo (nel nostro caso il gradiente esterno di

temperatura).

Si tratta quindi di una risposta specifica del sistema ad una variazione ambientale resa possibile

dall’interazione NON LINEARE tra i sottosistemi .

Questi effetti cooperativi danno origine ad equazioni non lineari che ammettono in generale

molteplici soluzioni asintotiche (stati stazionari, soluzioni periodiche, soluzioni “caotiche”); la

variazione dei parametri di controllo può alterare le proprietà di stabilità delle soluzioni stesse,

inducendo transizioni tra l’una e l’altra.

Si è arrivati al punto nevralgico del discorso !!!

Se nei sistemi complessi basta una minima variazione delle condizioni iniziali per avere un insieme

di traiettorie completamente differenti, passando addirittura da una condizione di stabilità ad una

d’instabilità, la linea di demarcazione tra una filosofia deterministica ed una probabilistica della

natura diviene pericolosamente sottile ed ambigua .

Un esempio su tutti è dato dal “ritratto di fase” di un pendolo con forzante periodica descritto

dall’equazione di moto:

x + ω2sinx = CcosΩt

Il moto del pendolo è retto da un’equazione non lineare che studiata con tecniche numeriche

conduce a risultati qualitativi sulla dinamica molto interessanti .

Per studiare numericamente la dinamica del pendolo con forzante, bisogna introdurre quella che

viene chiamata mappa di Poincaré i.e. una mappa Φ che contiene tutte le informazioni sulla

dinamica del sistema.

Infatti, poiché nell’equazione del moto compare esplicitamente il tempo, lo spazio adeguato nel

quale pensare immersa l’orbita sarà uno spazio tridimensionale xvt e solo in tale spazio un dato

iniziale individua univocamente un’orbita. Data la periodicità del termine forzante, i punti (x,v,t) e

(x,v,t’) danno luogo alla stessa orbita (e si possono identificare) se t e t’ differiscono per un

multiplo intero del periodo τ = 2π/Ω . Ci si può ridurre allo spazio bidimensionale xv a patto di

effettuare le osservazioni a tempi discreti tk = kτ con k∈Z. In questo modo ad ogni orbita resta

associata su tal piano, che chiameremo Π , una successione discreta di punti (xk ,vk ) con k∈Z ed

avendo posto

xk = x(kτ) e vk = v(kτ). La dinamica definisce una mappa Φ : Π→Π tale che (xk+1 ,vk+1) = Φ(xk ,vk)

; Φ associa al generico punto iniziale (x,v)∈Π (o dato al tempo t = kτ ) il suo evoluto al tempo τ

(ovvero al tempo t = (k+1)τ ).

Di seguito saranno riportati alcuni ritratti della mappa Φ per un pendolo forzato con Ω = √2ω e

differenti valori dell’ampiezza della forzante C.

Nel caso limite C = 0 la forzante non esiste e la mappa si riduce al consueto ritratto di fase del

pendolo con l’unica differenza che le orbite continue sono sostituite da successioni discrete di punti.

Per valori di C ≠ 0 la situazione cambia: per C = 0.05 e 0.1 si ha la formazione, in prossimità delle

separatrici, di una regione bidimensionale, detta regione caotica, invasa dalle orbite in modo

irregolare, a prima vista CASUALE, mentre, per dati iniziali sufficientemente lontani dalla

separatrice, non si ha nessun cambiamento rilevante; i punti appartenenti ad una medesima orbita

sono ancora allineati in curve come se vi fosse ancora una costante del moto, a dispetto del fatto

che il sistema non è autonomo e dunque l’energia non si conserva.

La regione caotica cresce al crescere di C fino a divenire preponderante.

La situazione si fa molto complicata !!! All’interno della regione caotica esistono piccole “isole” di

moti ordinati e la regione ordinata racchiude piccolissime regioni caotiche sparse tra una curva e

l’altra. Le figure mostrano la situazione per C = 1.0 e 1.5 .

In tale situazione è difficile dire se vi sia nel sistema una costante del moto. Sembra che essa ci sia

o non ci sia a seconda del dato iniziale e per dirla in termini più rigorosi: nel piano Π , per C non

troppo grandi, vi è un’abbondanza di curve invarianti (i.e. moti ordinati su un’orbita ben precisa e

con periodo costante) che tuttavia non costituiscono una foliazione continua del piano .

A questo punto la situazione sembra quasi contraddittoria: si è partiti da equazioni del moto

deterministiche per descrivere un evento di tipo “causale” e si è arrivati invece ad osservare anche

moti “casuali” confinati dentro una regione, battezzata caotica ,dalla quale non possono uscire .

Sembra che ordine e caos convivano reciprocamente l’uno affianco all’altro, suddividendosi il

“territorio” nel modo imposto dalle equazioni che descrivono il sistema i.e. DETERMINISTICO !!!

Questo risultato fu predetto a inizio ‘900 da Poincaré dallo studio del problema gravitazionale a tre

corpi: già considerando il problema “ristretto circolare piano” i.e. lo studio del moto di un punto

soggetto all’azione gravitazionale di due primari che ruotano nel piano con periodo T attorno al

comune baricentro (soluzione del classico problema dei due corpi), definendo l’integrale di Jacobi

come C = -2H (essendo H l’hamiltoniana della massa prova soggetta a forze gravitazionali,

centrifughe e di Coriolis) e tenendo presente l’esistenza di cinque punti d’equilibrio (punti

Lagrangiani), queste orbite presentano un carattere altamente caotico e possono compiere

qualunque successione di giri attorno ai due primari una volta scelti gli opportuni dati iniziali.

Risolvendo le equazioni numericamente si vede che per energie c∈[c1 ,c2],con c1= C(L1) e c2=

C(L2), le curve di Hill che delimitano la zona del moto (in modo che in ogni momento

T+V=E=cost.) assumono la forma di un “otto” con il lobo più grande centrato attorno al primario

più massiccio ed il lobo più piccolo centrato attorno al primario di minor massa.

Ora, questa zona è suddivisa in una regione ordinata e in una regione caotica: le due regioni

ordinate si localizzano in prossimità dei due primari ed in questa regione la massa di prova si

muove indefinitamente attorno al proprio primario con orbite ordinate e invarianti; mentre la

regione caotica riempie il rimanente spazio ed in questa zona sono possibili dei trasferimenti della

massa prova da un primario all’altro e tali orbite non possono entrare nella zona di moto ordinato (e

viceversa).

Per quanto riguarda i trasferimenti da un primario all’altro, esiste uno straordinario teorema che

asserisce: data una successione infinita di numeri interi K1 ,K2 ,K3 , ... rappresentanti, in alterno,

orbite attorno al primo e secondo primario, per c∈[c1 ,c2] , ∃! quaterna di dati iniziali X0,Y0,X0,Y0

tale che la successione prestabilita si verifichi rigorosamente.

Per spiegare invece l’esistenza della regione invariante costituita da orbite ordinate, si pone un

“vincolo dinamico” che è aggiuntivo rispetto al vincolo di conservazione dell’energia. Si tratta di

uno “pseudo-integrale” il quale NON È PRESENTE IN TUTTO LO SPAZIO DELLE FASI, MA SOLTANTO IN

UNA REGIONE IL CUI BORDO (confine di stocasticità) DIPENDE DAL VALORE DEGLI INTEGRALI

“CLASSICI” (i.e. dell’energia e del momento angolare).

Si osservi che Poincaré previde tutto ciò agli inizi del 1900 utilizzando solamente carta, penna e

brillante immaginazione !!!

Dopo questa breve discussione sul “problema a tre corpi” e sulla “dinamica del pendolo forzato”,

possiamo tranquillamente affermare che: I SISTEMI HAMILTONIANI SONO PORTATORI DI CAOS !!!

Lo spazio delle fasi di un arbitrario sistema dinamico hamiltoniano contiene regioni dove il moto è

accompagnato da un “miscuglio” di traiettorie nello spazio delle fasi.

La coesistenza di regioni di dinamica stabile e di caos nello spazio delle fasi è una delle scoperte

più forti e importanti mai fatte .

Si apre ai nostri occhi un nuovo campo della fisica che, utilizzando semplici modelli matematici,

cerca di riprodurre tipici comportamenti complessi di molti problemi fisici naturali.

Questi modelli matematici semplici vengono chiamate “mappe” (in inglese: “map”) e le più

gettonate per descrivere la dinamica di molti problemi fisici sono:

• Standard Map (o Kicked Rotator)

• Web-Map (o Kicked Oscillator)

Per esempio l’hamiltoniana di un sistema che può essere descritto mediante lo “standard map” è

espressa come:

H = ½ I 2 - Kcosθ ∑n∈ℵ δ(t/T - n)

Questa definisce un sistema con un’hamiltoniana imperturbata H0 = ½ I 2, la quale subisce una

periodica sequenza di “calci” (δ-pulsazioni) con periodo T = 2π/ν . L’hamiltoniana soprascritta

descrive dal punto di vista fisico il moto di una particella in un pacchetto d’onda periodico con un

infinito numero di armoniche di ugual ampiezza.

Le equazioni del moto che derivano da tale hamiltoniana hanno la forma:

I = - Ksinθ ∑n∈ℵ δ(t/T - n)

θ=I

Tra due δ-funzioni, I = cost. e θ = It + cost. Ad ogni “calcio”, rappresentato dalla δ-funzione, la

variabile θ rimane continua e l’azione I cambia di un valore - Ksinθ .

Tutto può essere ottenuto integrando le equazioni del moto rispetto al tempo nelle vicinanze di una

δ-funzione e se assumiamo che ( I, θ) sono i valori delle variabili appena prima dell’n-esimo calcio,

e che ( I ,θ ) sono i valori delle variabili prima dell’(n+1)-esimo calcio, segue che la mappa

derivante dalle equazioni del moto sarà:

I = I - Ksinθ

θ=θ+I

Per K = 0 non c’è perturbazione e la mappa si riduce banalmente a:

In = cost. = I0

θn = θ0 + nI0

Per K ≠ 0 le cose cambiano notevolmente. E’ stato riportato il ritratto di fase (con riduzione al toro)

dello standard map con K = 0.5 e relativo ingrandimento in prossimità del punto di sella.

Si noti la complessità e la varietà dei tipi di traiettorie; le strette zone con traiettorie caotiche sono

chiamate “strati stocastici”, dentro tali strati stocastici ci sono “isole” con nette ed invarianti

traiettorie, sub-isole e più piccoli strati stocastici e così via, con una topologia che si ripete

all’infinito in ogni zona infinitesima.

La Web-Map è un risultato delle considerazioni fatte su moto di una particella sotto l’influenza di

un campo magnetico costante e di un pacchetto d’onda elettrostatico che si propaga

perpendicolarmente al campo magnetico.

L’hamiltoniana del sistema è:

H = ½ (p2 + ω2x2) - (ωK/ T )cosx ∑n∈ℵ δ( t / T - n)

dove ω è la frequenza giroscopica e K il parametro adimensionale proporzionale all’ampiezza della

perturbazione.

Da questa hamiltoniana seguono la seguente equazione del moto:

x + ω2x = - (ωK/ T )cosx ∑n∈ℵ δ( t / T - n)

Essa descrive un oscillatore lineare affetto da una periodica sequenza di “calci”.

Quest’ultimo modello può essere ridotto allo standard map usando le sole trasformazioni singolari:

ω→0, K→∞ e ωK = cost.

Tra due calci adiacenti, la soluzione dell’equazione del moto soddisfa l’equazione del moto libero:

x + ω2x = 0

Introducendo le variabili adimensionali: u = x/ω ; v = -x e α = ωT , si ottiene la seguente mappa:

un+1 = (un + Ksinvn )cosα + vn sinα

vn+1 = -(un + Ksinvn )sinα + vn cosα

La mappa ottenuta è chiamata : Web-map.

Questa mappa ha un’importanza pratica enorme. Infatti, se consideriamo il caso in cui esiste una

risonanza tra la sequenza di “calci” e la frequenza di oscillazione ω, ponendo tale condizione come:

α = ωT = 2π / q , q∈ℵ ,

la web-map può essere considerata un generatore dinamico delle q-fold symmetry per le condizioni

di risonanza.

Questa simmetrie saranno di tipo cristallino per q∈{qc} = {1,2,3,4,6} e di tipo quasi-cristallino per

q∉{qc}. Le illustrazioni riportate sotto, dimostrano l’esistenza di un “tessuto stocastico” e della

corrispondente simmetria nello spazio delle fasi.

La rete di canali che formano tale “web stocastica” provvedono al trasporto di particelle lungo la

rete stessa. Il “tessuti stocastico” può essere finito o infinito !!!

Le illustrazioni rappresentano, in ordine, la web stocastica per : q = 4, K = 1.5 (elemento della web

+ ingrandimento della parte centrale) ; q = 6, K = 1.2 (elemento delle web) e q = 3, K = 1.7

(elemento della web).

Il discorso riguardo la web-map può essere ulteriormente approfondito.

Infatti, studiando il problema da un punto di vista più generale, si arriva a concludere che una

dinamica di tipo caotico (e quindi un moto complesso) è generata da interazioni di risonanza.

Si consideri una generica hamiltoniana in variabili azione-angolo:

H = H0( I ) + εV( I, θ, t )

dove ε<<1 è un parametro adimensionale di perturbazione molto piccolo e V è periodica nel tempo

con periodo T = 2π/ν. Essendo V periodica, può essere espressa in doppia serie di Fourier in θ e t:

V( I, θ, t ) = ½ iε∑k,lVk,l(I)exp[i(kθ - lνt)] + c.c.

dove c.c. rappresenta il termine complesso coniugato.

Utilizzando queste due ultime equazioni, le equazioni canoniche del moto possono essere

trasformate in:

I = -ε∂V/∂θ = -½∑k,l kVk,l(I)exp[i(kθ - lνt)] + c.c.

θ = ∂H/∂I = dH0/dI + ε∂ V( I, θ, t )/∂I = ω(I) + ½ε∑k,l{∂Vk,l(I)/∂I}exp[i(kθ - lνt)] + c.c.

dove si è introdotta la frequenza di oscillazione per il moto imperturbato:

ω(I) = dH0/dI

La condizione di risonanza implica che la seguente condizione sia soddisfatta:

kω(I) - lν = 0

dove k ed l sono numeri interi. Si arriva a concludere che per ogni I0 fissato, esiste un terzetto k0, l0

ed ω0 tale che la relazione di risonanza sia rispettata.

Come regola, i valori (k0,l0 ; I0) possono essere trovati in abbondanza e questo è dovuto alla forte

non linearità del sistema i.e. alla dipendenza di ω(I) da I.

Ora, come si è detto in precedenza, le perturbazioni cambiano la topologia dello spazio delle fasi

del sistema e le perturbazioni risonanti creano catene di isole e aumentano il numero di punti

ellittici ed iperbolici nello spazio delle fasi.

Infatti, per una risonanza di ordine k0, c’è una “catena di isole” con k0 celle separatrici, k0 punti

singolari iperbolici e k0 celle ellittiche.

LA TOPOLOGIA DELLO SPAZIO DELLE FASI VIENE MODIFICATA NELLE VICINANZE DEL VALORE DI

RISONANZA I0 .

Per avere un’idea di tutto ciò sono riportate di seguito due ritratti di fase in condizioni di risonanza

non lineare.

Nella figura k0 = l0 = 1 ; la curva tratteggiata rappresenta la traiettoria imperturbata con I = I0 ,

mentre la linea più spessa è una nuova separatrice dovuta alla risonanza.

Questa figura rappresenta un’altra versione della risonanza non lineare per k0 = 6 ed l0 = 1.

Grazie a questi concetti è ora semplice descrivere i ritratti di fase dello standard map: dentro il

“cappio” di una separatrice, esiste un insieme di nette curve invarianti alle quali non corrisponde

nessuna condizione di risonanza. C’è anche una catena di isole che corrisponde ad un alto valore di

risonanza l0. Questa catena di risonanza confina il punto ellittico centrale benché ci siano molte che

non lo fanno. Ogni catena di isole è separata da curve invarianti ma quando il caos si manifesta

(ved. ingrandimento), le isole di risonanza persistono nello “strato stocastico” ma non sono più

separate da curve invarianti.

Analizzando le figure dello standard map si introduce il parametro Kc = ∆Ι/δΙ , dove ∆Ι è la

massima ampiezza di una catena di isole e δΙ è la distanza tra due catene adiacenti.

Se Kc<< 1, le catene di isole sono ben separate l’una dalle altre da uno strato di curve invarianti.

Se Kc ≥ 1 ci sarà l’insorgere di caos causato dalla distorsione delle separatrici da parte del termine

perturbativo e dentro le catene si formerà uno “strato stocastico”.

La sovrapposizione tra catene di isole risonanti come criterio per creare dinamiche caotiche fu

scoperto e dimostrato dal matematico russo Chirikov.

LO SPLITTING DELLE SEPARATRICI (es. pendolo con forzante) E FORMAZIONE DELLO “STRATO

STOCASTICO” (es. web-map e standard map) SONO UN TIPICO “SEME” DI CAOS NEI SISTEMI

HAMILTONIANI .

Quindi, si può vedere la rete delle separatrici come uno “scheletro” per l’apparizione di caos !!!

Riassumendo, durante la fase di caos, la parte dello spazio delle fasi che ha dinamica caotica è

chiamato “mare stocastico”; dentro il “mare” esistono isole di stabilità (che influenzano l’intera

dinamica nello spazio delle fasi !!!) ed una traiettoria caotica non può entrare nell’isola e

analogamente, ad una traiettoria regolare è vietato fuggire da un’isola di stabilità.

Generalmente, NEI SISTEMI TIPICI, IL CAOS NON ESISTE SENZA LA PRESENZA DI ISOLE.

Lo studio delle isole risulta un argomento molto vasto ed importante che merita sicuramente un

breve approfondimento.

Da subito si nota che un set di isole possiede una complessa struttura topologica la quale può

essere modificata agendo sui “parametri di controllo” (in particolare, per alcuni valori di tali

parametri, un’isola può o collassare oppure nascere).

Uno di questi parametri di controllo è sicuramente il sopracitato Kc , e in particolare, esiste una

particolare classe di isole, chiamate “Blincking Islands”, le quali collassano SOLO per uno speciale

valore K = Kc ed hanno una differente orientazione per K> Kc e K< Kc .

Queste particolari isole rivelano due importanti caratteristiche:

• la locale simmetria del terzo ordine

• la presenza di “cicatrici” i.e. regioni con “traiettorie stagnanti” che possono influenzare le

proprietà di trasporto delle particelle.

A titolo di esempio riporto il collasso e la riapparizione di una “blincking island” per lo standard

map la quale presenta un valore critico Kc = 6.96264...

Nella figura a sinistra, l’isola è soggetta a K = 6.962640 i.e. prima della biforcazione; nella figura

centrale siamo prossimi alla biforcazione (K = 6.962643) con l’apparizione delle “cicatrici”

sopracitate; infine, nelle figura a destra, K = 6.962650 i.e. dopo la biforcazione. E’ da notare che

durante la transizione da sinistra a destra, l’isola ha subito una rotazione pari a π .

Esistono poi altri tipi di isole che rivelano proprietà interessanti e curiose al variare dei parametri di

controllo, ma la trattazione approfondita dell’argomento non è scopo di questo lavoro, per cui si

invita, chi ne fosse interessato, la consultazione di testi specifici di cui la letteratura scientifica ne è

largamente fornita.

Un’occhio di riguardo nello studio della topologia di un’isola è sicuramente il suo contorno (o

boundary). Tale zona è una zona singolare che rivela una struttura topologica molto complessa.

Vicino al contorno di un’isola si verificano dei fenomeni di “trapping” i.e. se una ipotetica

particella, durante il suo moto nello spazio delle fasi, penetra in questo strato di confine, può

rimanere confinata in questa zona per un tempo estremamente lungo che dipende direttamente dalla

profondità della sua penetrazione. L’ “appiccicosità” del contorno di un’isola è spiegabile solo

studiando la sua complessa topologia. Questa topologia è ancora legata al parametro di controllo K

e grazie a tale parametro, nel contorno di un’isola, si viene a creare una sequenza di isole di

differenti generazioni che formano una struttura gerarchica auto-similare quando viene scelto uno

speciale valore per il parametro di controllo K ; piccole variazioni di K cambieranno in numeri di

isole nel contorno.

Questa struttura è molto importante nella comprensione del trasporto caotico nel “mare stocastico”.

La struttura gerarchica delle isole nella singular zone può spiegare l’origine dell’ “appiccicosità”

del contorno nei confronti delle traiettorie in esso localizzate.

Per darne un’idea visiva, si sono riportate le strutture auto-similari per la web-map con

K=6.349972.

In ordine, la prima figura rappresenta lo spazio delle fasi con le isole; la seconda è l’ingrandimento

della parte in fondo a destra della prima figura; la terza è l’ingrandimento dell’isola in alto a destra

della seconda figura; infine, la quarta figura è l’ingrandimento dell’isola in basso a sinistra della

terza rappresentazione.

Si noti la struttura auto-similare che va ripetendosi ad ogni successivo ingrandimento.

E’ questa struttura, che emerge solo dopo un preciso studio numerico del problema, a conferire al

confine di un’isola quell’appiccicosità responsabile dell’ “intrappolamento del moto” di una

particella ed i conseguenti problemi della sua diffusione nel “mare stocastico”.

Per concludere questo breve accenno qualitativo sul caos deterministico, vorrei richiamare ed

approfondire alcuni concetti introdotti precedentemente riguardo le q-fold symmetry ed il “web

skeleton”.

Si apre un vasto capitolo che lega in modo paradossale ed affascinante il CAOS e le SIMMETRIE

DELLE NATURA.

Possiamo schematicamente riassumere i concetti precedentemente espressi in una serie di punti:

⇒ le proprietà topologiche dello spazio delle fasi sono definite da un set di punti singolari e di

curve

⇒ queste proprietà sono imposte da un’Hamiltoniana imperturbata ed una perturbazione

⇒ la simmetria della mappa di Poincaré è il risultato di una complessa interazione reciproca tra le

simmetrie dell’Hamiltoniana imperturbata e la perturbazione

⇒ i sottili “filamenti” (canali) di dinamica caotica sono chiamati “stochastic web”. Questi creano

una rete usando simmetrie o quasi-simmetrie

⇒ la web-map introdotta precedentemente “piastrella” lo spazio delle fasi con una simmetria di tipo

“cristallo” o “quasi-cristallo” (a seconda della condizione di risonanza)

⇒ la “piastrellatura” è caratterizzata da un web skeleton . La web-map è generatrice della

piastrellatura q-fold symmetric di ordine arbitrario q. L’effettiva Hamiltoniana per ottenere lo

web skeleton è.

Hq (u,v) = ∑j=1...q cos( r·ej )

con r = (u,v) e ej = (cos 2πj /q , sin 2πj /q)

La piastrellatura periodica corrisponde a q = 1,2,3,4,6. Il resto sono aperiodiche e sono

equivalenti alla struttura bidimensionale quasi-cristallina.

Si può dimostrare che si possono ottenere delle non banali simmetrie dalla dinamica e in questo

modo uno mostra come le simmetrie possono essere modificate usando metodi dinamici.

Tutto ciò suggerisce una nuova ed unica opportunità per lo studio di una complessa simmetria

(come per esempio quella quasi-cristallina) utilizzando metodi di dinamica Hamiltoniana.

Per avere un’idea del cambio di simmetria che si ottiene agendo su un parametro di controllo di un

sistema dinamico, si è riportata la mappa corrispondente a q = 3 con un certo valore del parametro

critico Kα . Per K< Kα si ha una piastrellatura esagonale, mentre per K> Kα si ha una piastrellatura

rettangolare .

Se vengono ignorati certi dettagli, gli esagoni sono modificati a divenire rettangoli e c’è un

corrispondente cambio nella simmetria della stochastic web, la quale ora occupa una zona molta

stretta tra i rettangoli.

Possiamo formulare la seguente asserzione: la web-map Mq definita come

un+1 = (un + Ksinvn )cos2π/q + vn sin2π/q

vn+1 = -(un + Ksinvn )sin2π/q + vn sin2π/q

è considerato un generatore dinamico di “piastrellatura del piano” il quale ha una simmetria di tipo

cristallino se q∈{qc} o di tipo quasi-cristallino se q∉{qc}.

Inoltre, è da notare che il ritratto di fase giacente dentro una “piastrella” (o “cella”) della web può

avere una simmetria completamente differente da quella della web stessa, in particolare, può non

avere nessuna particolare simmetria.

... in conclusione

In questa breve cavalcata storico-fisico-matamatica ho voluto astenermi dal dare pareri personali al

fine di non influenzare possibili lettori.

Non ho trattato il problema della fisica quantistica che nella sua logica di base vede il probabilismo

con proprietà intrinseca della natura. Infatti, tutti hanno in testa il famoso “principio di

indeterminazione”, postulato da Heisenberg e cuore della meccanica quantistica stessa.

Questo postulato, banalmente asserisce che “in qualunque esperimento, comunque preciso, è

impossibile misurare simultaneamente e con precisione assoluta la posizione e l’impulso di una

particella. Più precisamente, detto ∆x l’errore nella misura della componente x della posizione e

∆px l’errore nella misura della componente px dell’impulso:

∆x∆px ≥ h/2 “

in altre parole: con maggior precisione misuro la posizione di una particella e maggior incertezza

avrò sul suo impulso (e viceversa); nel limite di misurare con precisione assoluta la posizione di

una particella (i.e. ∆x = 0), il suo impulso sarà completamente indeterminato (i.e. ∆px = ∞) (e

viceversa).

E’ palese che questa logica va contro il senso comune della meccanica classica che vedeva l’errore

sulla misura dovuto ai nostri strumenti, comunque migliorabili, in linea di principio, a “strumenti

perfetti” i.e. privi di errore !!!

Quindi, le due differenti filosofie possono essere così formulate:

NELLA MECCANICA CLASSICA LA STATISTICA E LA PROBABILITÀ SONO INTRODOTTI PER SOPPERIRE

ALLA NOSTRA IGNORANZA ED IMPRECISIONE NELLA MISURA E BISOGNA SEMPRE TENERE PRESENTE

CHE LA NATURA NON SBAGLIA: ESSA NON GIOCA, NON SCEGLIE; MENTRE NELLA MECCANICA

QUANTISTICA LA PROBABILITÀ ED IL CASO SONO PROPRIETÀ INTRINSECHE DELLA NATURA CIOÈ ESSA

GIOCA E SCEGLIE !!!

Altro grande risultato ottenuto nella seconda metà del 1900, fu la formulazione e la dimostrazione

del famoso “teorema KAM”.

Tale teorema fu enunciato dal matematico russo Kolmogorov nel 1953 al “Congresso

Internazionale dei Matematici” e fu successivamente dimostrato nel 1962 da Vladimir Arnol’d

dell’Université de Paris-Dauphine e da Jurgen Moser del Politecnico federale di Zurigo.

Il “teorema KAM” nacque successivamente agli studi di grandi fisico-matematici sulla stabilità del

Sistema Solare.

Storicamente, nel XIX secolo, Lagrange, Laplace e Poisson tentarono di dimostrare la stabilità del

Sistema Solare, ma i loro studi davano qualche assicurazione per l’immediato avvenire (circa due o

trecentomila anni) e non dicevano nulla sul suo destino ultimo.

SI ERA COSÌ POSTO IL “PROBLEMA DEGLI N CORPI” !!!

Nel Sistema Solare, il caso più bizzarro è quello della coppia Giove-Saturno, i cui tempi di

rivoluzione sono in rapporto 2/5 : nel tempo che Saturno impiega per compiere due rivoluzioni

intorno al Sole, Giove ne effettua cinque.

Periodicamente i due pianeti si ritrovano nella stessa posizione relativa, e ci si aspetterebbe che le

perturbazioni dovute alla loro mutua attrazione si accumulassero ed amplificassero le modificazioni

delle orbite; inoltre, i movimenti dei pianeti non sono modificati dall’attrito, e nulla ne ammortizza

la perturbazione.

Nel 1885 il re di Svezia indisse un premio per una scoperta matematica importante e Weierstrass

suggerì che fosse posto come tema il “problema degli n corpi”.

Il premio fu conferito ad Henry Poincaré, il quale provò che nel problema degli n corpi NON CI SONO

LEGGI DI CONSERVAZIONE A PARTE QUELLA GIÀ CONOSCIUTE i.e. conservazione dell’energia,

momento angolare e quantità di moto.

Ora, un sistema è integrabile se possiede leggi di conservazione a sufficienza .

Se un sistema integrabile è affetto da una perturbazione, questa distrugge certe leggi di

conservazione; il nuovo sistema risulta così non integrabile e le orbite, da stabili, risulteranno

caotiche ed imprevedibili.

Poincaré arrivò alla conclusione che nel Sistema Solare non esistono orbite stabili (dovute alla

mancanza di leggi di conservazione “supplementari”) e che quindi tale sistema è da ritenersi

sostanzialmente instabile !!!

Tale conclusione parve ragionevole alla comunità dei matematici; nondimeno, era FALSA !!!

A questo punto entra in scena il “teorema KAM” : non solo le orbite stabili possono esistere in

assenza di leggi di conservazione, ma, in certe condizioni, le orbite sono stabili per la maggior

parte.

Il “teorema KAM” afferma che, per perturbazioni sufficientemente piccole, una maggioranza di

orbite è stabile : esse non sono più periodiche, ma quasi-periodiche e non si allontanano mai troppo

dalle orbite periodiche del sistema imperturbato; altre orbite sono caotiche ed imprevedibili; altre

ancora (e sono queste, probabilmente, che spiegano la stabilità di Saturno e di Giove) sono

imprigionate per sempre su “isole di stabilità” in un oceano di caos.

Ormai la paradossalità della situazione è palese agli occhi di tutti: i deterministi “puri” vedono la

loro fisica come l’unica e vera possibile ed usano i concetti di statistica e probabilità solo per

sopperire l’impossibilità di trattare un problema a molti corpi (es. moto del gas in una stanza) ma,

d’altro canto, senza l’aiuto della meccanica statistica e probabilità, una scienza come la

termodinamica (e di conseguenza tutte le applicazioni pratiche da essa derivate) non sarebbe nata e

sviluppata.

Analogamente, la meccanica quantistica privata dei concetti di probabilità ed indeterminazione

nella misura delle osservabili non avrebbe senso. Sebbene tale teoria risulti poco intuitiva e quasi

“campata per aria”, le conferme sperimentali a suo favore sono innumerevoli e tanto per fare un

esempio, si ricordi che la meccanica quantistica relativistica elaborata da Dirac, previde l’esistenza

dell’antimateria (positrone) e la proprietà di spin nelle particelle (prontamente verificata nel famoso

esperimento di Stern e Gerlach). Infine, il teorema KAM è l’ennesima minaccia alle fondamenta del

determinismo assoluto, anche perché nasce da una situazione puramente meccanica (classica) come

il “problema degli n corpi”.

Ma la validità e l’affidabilità di una teoria basata su equazioni alle derivate parziali, risolvibili

analiticamente e con soluzione unica per il teorema di Cauchy, è dura da soppiantare e inoltre, a

difesa di questa già solida roccaforte, si schiera la teoria della relatività generale di Einstein, fondata

sul concetto di campo (in senso classico) ed ampiamente verificata sperimentalmente (es.

deflessione della luce in un campo gravitazionale e precessione dell’orbita di Mercurio).

Come se non bastasse, quando si cerca di unificare la meccanica quantistica e la teoria della

relatività generale in un’unica superteoria, queste due più belle ed affascinanti teorie della fisica

moderna fanno letteralmente “a pugni”, infatti, la prima ha una visione DISCRETA del mondo, la

seconda una visione CONTINUA ... a questo punto le discrepanze logico-concettuali sono evidenti ed

incolmabili !!!

Ma allora, cosa bisogna fare ? Qual è la teoria giusta per descrivere la Natura ? Esisterà mai una

teoria “generalizzata” che tenga conto degli aspetti quantistici quanto di quelli “continui” tipo

gravitazionale ?

La situazione non è così allarmante come possa sembrare !!!

Tutte le teorie sono valide per descrivere e predire i fenomeni naturali ma ad ogni teoria il relativo

campo di applicazione.

Una teoria fisica non è altro che una costruzione logico-matematica di teoremi ed equazioni derivati

da assiomi posti all’inizio della trattazione.

Se un assioma viene modificato, tutti i risultati cambieranno ma, se la “metamorfosi” è logica e

rigorosa, allora quest’ultimi risultati sono validi quanto i primi; solo l’evidenza sperimentale

promuoverà un modello piuttosto che un altro .

Per capire tutto ciò basti pensare all’evoluzione della geometria, nata con Euclide, che pose come

V° postulato la condizione che: data una retta ed un punto esterno ad essa, allora esiste una ed una

sola retta parallela alla retta data e passante per il punto esterno.

Se si cambia quest’ultimo assioma e si pone la condizione (di per se poco intuitiva !) che per il

punto esterno passino INFINITE o NESSUNA retta parallela alla retta data, allora ottengo

rispettivamente la geometria di Lobacevskij (o iperbolica) e la geometria di Riemann (o

sferica).Tutte e tre le diverse geometrie sono logicamente consistenti dal punto di vista matematico

ma la fisica ha favorito la geometria Euclidea perché sembrava meglio rappresentare la “geometria

della Natura”; ho usato il condizionale perché la teoria della relatività generale ha dimostrato che la

geometria Euclidea non è in grado di rappresentare la “geometria naturale” salvo come

approssimazione, infatti, la geometria dello spazio-tempo viene distorta in prossimità di un oggetto

molto massivo (es. stelle ordinarie, stelle di neutroni, buchi neri) ma tale “distorsione” non è

percettibile nelle nostre condizioni di vita quotidiana ed ecco perché i fisici pre-relativisti,

consideravano la geometria Euclidea come la “vera” geometria e consideravano le altre come

affascinanti (ma inutili !) “speculazioni della ragione umana”.

Ma una teoria fisica è un elaborato della mente umana, l’uomo è di per se imperfetto e quindi, di

conseguenza, qualsiasi teoria risulterà imperfetta ... qualche imprecisione o qualche paradosso deve

esserci !!! Queste imprecisioni saranno poi lo spunto per apportare modifiche alla teoria (o

costruirne una nuova!) ed arrivare così ad una maggior comprensione della Natura e degli

esperimenti; ma la “nuova” teoria sarà anch’essa un’approssimazione e sicuramente si arriverà ad

un risultato sperimentale o ad una inconsistenza logica nei risultati predetti che imporrà una nuova

“revisione” dell’attuale teoria, e così via ... per dirla in parole povere: la Natura è come un numero

irrazionale (es.√2) ma a noi è concesso usare solo numeri razionali per rappresentarla !!!

LA PERFEZIONE E L’IDEALITÀ NON SONO CONCESSI ALLA RAGIONE UMANA !!!

Siamo nella stessa situazione che descrisse Macchiavelli ne “Il Principe” : nei rapporti tra popolo e

sovrano, si è come un pittore che per dare l’idea della maestosità e magnificenza di una montagna

deve porsi a valle ma deve salire su quella vetta se vuol dipingere un tramonto sull’ampia vallata,

così, per sapere se si è buoni sovrani bisogna esser popolo ma per dirigere ed organizzare un popolo

bisogna essere sovrani.

Questo paragone può essere adattato anche alla fisica ed alle sue teorie.

Alla comunità dei fisici spetta la parte del popolo soggetto alle leggi della Natura (i.e. il sovrano) e

l’unica cosa che può fare è cercare di intuire e capire i suoi meccanismi e la sue regole ma con

l’idea base che mai arriverà a conoscere le sue carte in quanto questo richiederebbe al fisico di

esser Natura ... ma ciò è ovviamente impensabile !!!

Con questo non voglio fare propaganda alla questione che lassù ci sia un Dio o un’Entità

Soprannaturale, se ci sia un Dio Onnipotente o il Nulla assoluto non posso (e non voglio) dirlo, so

solo che noi siamo “popolo” e “popolo” rimarremo .

L’umiltà che si deve avere nei confronti della Natura è qualcosa di essenziale, in modo da evitare

paradossi metafisici e/o manie di onnipotenza.

Celebre è il racconto di San Agostino riguardo all’umiltà che la ragione umana deve avere nei

confronti della Natura o, se si e credenti, di un ipotetico Dio. Egli raccontò che una notte sognò di

camminare da solo su una spiaggia e mentre camminava ragionava di Dio e dei Dogmi della Fede.

Durante il suo cammino incontrò un bambino che versava acqua di mare, raccolta in un piccolo

secchio, in una buca scavata nella sabbia.

Si fermò ad osservare il continuo “andar al mare e versar acqua nella buca” del bambino fino a che,

colto da curiosità, gli si avvicinò e gli domandò cosa stesse facendo. Il bimbo rispose che voleva

mettere tutta l’acqua del mare in quella buca che lui stesso aveva scavato. Al sentire questo, San

Agostino, sorridendo, disse al fanciullo che era un progetto impossibile da fare ed era matto se

credeva nella sua realizzabilità. Il bambino lo guardò e rispose: “Ah, io sarei il matto ? E tu allora,

che vuoi comprendere i Misteri di Dio ? ”.

Con queste premesse possiamo dare una risposta alla domanda che da il titolo a questo lavoro ?

Assolutamente no !!! Ognuno avrà una visione soggettiva del Mondo e delle sue leggi: c’è chi si

schiererà alla difesa del determinismo assoluto e chi, contrariamente, vedrà nell’indeterminazione e

nella caoticità l’unica scelta possibile, ma forse nessuna di queste ideologie è e sarà quella scelta

dalla natura ... sempre che non abbia scelto entrambi questi aspetti e si diverta sadicamente a veder

noi, stupidi presuntuosi, sbatter la testa di qua e di là alla ricerca di una spiegazione “logica” che

forse non c’è. Comunque, questi “conflitti ideologici” sono fonte di ispirazione e stimoli per

affrontare nuove ricerche ed evitare così di adagiarsi in un ozioso autocompiacimento.

La mia speranza è che si arrivi un giorno alla formulazione di una super-teoria che possa spiegare

ogni fenomeno naturale senza dubbi ed ambiguità; sebbene non possa negare il fatto di essere

affascinato sia da una visione “continua” che da una “discreta” del Mondo e che pertanto, dal mio

punto di vista, una teoria come la relatività generale (visione continua) e una come la meccanica

quantistica (visione discreta) possono tranquillamente esistere perché sono l’una il completamento

dell’altra ... una fisica moderna senza relatività generale (o senza meccanica quantistica) sarebbe

paragonabile ad una chitarra a cui hanno tolto la 1°, la 3° e la 5° corda: ogni accordo, melodia o

composizione risulterebbero labili, “vuoti” ... totalmente privi di significato.

La stessa metafora può essere estesa al dilemma : determinismo o caos, e vedere così le due

filosofie come l’una il completamento dell’altra ... estremamente differenti ma entrambe

indispensabili per cercare di capire il Mondo ed i suoi meccanismi, e dare così un senso a quella

farsa chiamata VITA !

Bibliografia

•

•

•

•

•

•

•

•

•

J. Gleick - Caos

G. M. Zaslavsky - Weak chaos and quasi-regular patterns

G. M. Zaslavsky - Physics of caos in Hamiltonian systems

R. Serra , G. Zanarini - Tra ordine e caos

D. Ruelle - Caso e caos

G. Benettin , L. Galgani , A. Giorgilli - Appunti di meccanica razionale (edizioni CUSL)

G. Benettin - Introduzione ai sistemi dinamici (appunti corso fisica-matematica a.a.1995/96)

D. Halliday , R. Resnick , K. S. Krane - Fisica I (4° edizione)

Articoli a tema tratti da “Le scienze”