John von Neumann: una biografia

Ruggero Bergaglio, Cristina Marchiol, Rosanna

Giannantonio,

Tesi per i Corsi di Storia ed Epistemologia della Scienza I e II

Indice generale

Bibliografia dei tre saggi

Prima parte, redatta da Ruggero Bergaglio:

Giovinezza e formazione nei primi del ’900 in

Ungheria e Germania

1.1 Il contesto storico

1

1.3 Considerazioni sulla cultura e la fisica ungherese

1.4 John von Neumann: la giovinezza e la formazione

1.5 Il modello di ricerca in matematica e in fisica matematica

1.6 Hilbert e il metodo assiomatico

1.7 La fisica quantistica e la crisi del determinismo

Seconda parte, redatta da Cristina Marchiol: John

von Neumann – Negli Stati Uniti, tra guerra e

computer

2.1 L’emigrazione negli Stati Uniti

2.2 La ricerca universitaria

2.3 L’inizio della ricerca militare

2.4 Il calcolo automatico

2.5 I primi calcolatori

2.6 L’esperto di fiducia degli organismi militari e governativi

2.7 Altre armi per la guerra preventiva

2.8 La Big Science

1

2.9 La guerra fredda

2.10 Un difficile equilibrio

2.11 La democrazia liberale e l’elite scientifica

Terza parte, redatta da Rosanna Giannantonio: Teoria

dei Giochi, Calcolatore elettronico e Teoria

degli Automi

3.1 I primi contributi per un’economia matematica

3.2 L’incontro con Morgenstern e la Teoria dei Giochi

3.3 I primi studi sull’analogia fra il funzionamento del cervello e gli apparati di calcolo

automatico

3.4 L’incontro con Goldstine

3.5 Il first draft

3.6 I primi calcolatori

3.8 I risultati nel campo della ricerca meteorologica

3.9 Gli Automi Cellulari

3.10 Fu ucciso dalle radiazioni

3.11 Conclusioni (di Rosanna Giannantonio)

Scheda biografica di John von Neumann

Bibliografia generale delle tre parti della biografia di John von Neumann

2

John von Neumann: una biografia

Ruggero Bergaglio

Giovinezza e formazione nei primi del ’900 in Ungheria e Germania

1.1 Il contesto storico

Nei primi anni del Novecento, l’Ungheria era un paese straordinariamente dinamico e promettente e, al tempo stesso,

assai instabile e dal futuro incerto.

Dal 1867, quando Francesco Giuseppe I era salito al trono, il paese centro-europeo aveva attraversato un periodo di

tranquillità e sviluppo. L’economia, pur conservando un carattere prevalentemente agricolo, era stata sensibilmente

influenzata dal rilevante sviluppo industriale e l’Ungheria aveva assunto i connotati di un paese europeo moderno.

Sebbene la politica estera e militare fosse decisa a Vienna, era l’aristocrazia nobiliare a reggerne i destini, impartendo

ordini da Budapest. Questa classe dirigente mostrava un grande dinamismo e non sembrava preoccuparsi delle tensioni

sociali che erano conseguenza del contrasto fra la persistente arretratezza del mondo contadino e l’impetuoso sviluppo

dell’industria, del formarsi di un proletariato industriale e dei problemi di convivenza di numerose minoranze nazionali,

per lo più di origine slava (croati, rumeni, slovacchi, serbi).

Anche all’interno della classe dirigente si facevano sentire le contraddizioni frutto di uno sviluppo economico e sociale

accelerato. Essa era sufficientemente moderna ed evoluta da mostrarsi disponibile ad accogliere coloro che

possedevano capacità e spirito competitivo e a integrarli nel tessuto dell’aristocrazia nobiliare (tale, ad esempio, fu il

caso del padre di von Neumann), ma, d’altro canto, era fortemente influenzata da idee politiche conservatrici.

Budapest, il centro politico e culturale dell’Ungheria, era il simbolo della vitalità e delle contraddizioni di un paese

proiettato impetuosamente verso il futuro, ma oppresso dal presentimento di un’incombente catastrofe. All’inizio del

secolo, una buona parte della popolazione di Budapest era costituita da famiglie ebree: molte di queste, inizialmente

dedite ad attività agricole nelle povere aree rurali, si erano successivamente stabilite nella capitale, partecipando

attivamente allo sviluppo economico del paese e migliorando la propria posizione sociale.

La prima guerra mondiale e la disfatta dell’Impero Austro-Ungarico significarono per l’Ungheria una catastrofe di

proporzioni enormi e, per la minoranza ebraica, la fine di una condizione favorevole. Il florido stato centro-europeo perse

gran parte del suo territorio e più di tre milioni di ungheresi passarono sotto la sovranità di tre nuovi stati: la

Cecoslovacchia, la Romania e la Iugoslavia. Carlo IV abdicò nell’ottobre del 1918. All’inizio del 1919, il potere passò

nelle mani dei comunisti di Béla Kun. La Repubblica Sovietica Ungherese durò soltanto cinque mesi. Dopo l’invasione

del territorio ungherese da parte dell’esercito rumeno, il potere fu preso da un movimento controrivoluzionario guidato da

Miklòs Horthy. Il regime di Horthy scatenò una violenta repressione e adottò misure antisemite, pur risparmiando i

banchieri e gli industriali ebrei che considerava utili per la ricostruzione del paese. Fra le varie misure, va ricordata

l’introduzione di una quota di ammissione all’università: gli ebrei non potevano eccedere il 5 per cento degli studenti

universitari.

La matematica ebbe uno sviluppo fondamentale in Ungheria, fin dagli ultimi decenni dell’Ottocento, in connessione con

lo sviluppo tecnico e industriale del paese. I piani di studio delle scuole secondarie tecniche dedicavano uno spazio

crescente a questa materia e grande impegno in tal senso profusero anche gli ambienti universitari.

Un contributo importante, in questa direzione, fu la formazione di una comunità nazionale di matematici dotata di

istituzioni autonome, sul modello del rinnovamento del mondo scientifico europeo nella seconda metà dell’Ottocento.

Prima di allora, in tutto il vecchio continente erano state le Accademie i principali centri propulsori di tali studi. Da quel

periodo in poi le singole discipline scientifiche, e in particolare la matematica, si erano organizzate in forma autonoma,

sia creando società scientifiche - come la London Mathemarical Society (1865) la Société Mathématique de France

(1873) e la Deutsche Mathematiker Vereinigung (1890) -, sia promuovendo pubblicazioni periodiche specificamente

dedicate alla matematica.

In Ungheria, la prima associazione di matematici fu fondata nel 1891 (Società Matematica e Fisica di Ungheria). Nello

stesso periodo iniziarono le pubblicazioni della rivista «Mathematikai és Physikai Lapok» (Rivista di matematica e fisica)

e, nel 1893, di quella in tedesco «Mathematische und Naturwissenschaftliche Berichte aus Ungarn», che permise il

sorgere di un’intensa collaborazione con i matematici di altri paesi, superando l’ostacolo rappresentato dalla lingua

ungherese.

In quegli anni iniziava la carriera di due matematici, Lipót Fejér e Frigyes Riesz, la cui attività sarebbe stata uno dei

capisaldi della ricerca ungherese nella prima metà del secolo. Entrambi erano ebrei: la scelta della matematica da parte

3

di molti ebrei era dovuta, almeno in parte, al carattere autonomo e ideologicamente «neutrale» di questa disciplina. La

professione ideale, per chi non aveva ancora acquisito una piena parità di diritti civili ed era un potenziale emigrato,

doveva risultare universalista, internazionale e apolitica; nulla più delle discipline scientifiche si avvicinava a tale modello,

in special modo la matematica.

La matematica ungherese era assai aperta alle nuove tendenze che si affermavano in questa disciplina agli inizi del

Novecento. Accanto agli studi di analisi classica e funzionale, nel paese, conobbe importanti sviluppi la cosiddetta

«matematica discreta» e «finita». La ricerca in tale ambito aveva una lunga tradizione storica: essa era stata tuttavia

oscurata, a partire dal Seicento, dalla supremazia del calcolo infinitesimale di Newton e Leibniz, con un particolare

interesse per la «matematica del continuo», ovvero i problemi di carattere infinito e in particolare quelli in cui l’infinità ha

la proprietà di essere «continua». Agli inizi del Novecento, in relazione con la crescente influenza dell’approccio

algebrico e lo sviluppo della teoria degli insiemi, la matematica discreta e quella finita conobbero una rinascita nella

quale il lavoro ungherese svolse un ruolo importante.

Questo brillante panorama fu oscurato dalla disfatta austro-ungarica nella Grande Guerra, che pesò negativamente sul

florido ambiente scientifico, come su ogni aspetto della vita del paese.

Gli eventi politici del periodo successivo aggravarono pesantemente la situazione. Negli Anni Venti iniziò un’emigrazione

progressiva dall’Ungheria sia di scienziati maturi, sia di molti giovani di talento desiderosi di completare i propri studi, tutti

ormai consapevoli che a Budapest non vi erano più prospettive. I punti di destinazione erano soprattutto i centri più

importanti della cultura germanica come Zurigo, Berlino e Göttingen, essi rappresentavano una concreta prospettiva

d’integrazione del paese nelle correnti moderne e avanzate dell’Europa occidentale.

Successivamente, negli Anni Trenta, molti di questi scienziati emigrarono negli Stati Uniti, dapprima per la difficoltà di

ottenere posti di docente in Germania, vista l’enorme inflazione di giovani ricercatori, e subito dopo a causa dell’ascesa

del nazionalsocialismo hitleriano.

Molte giovani promesse ungheresi avevano già abbandonato il paese quando la situazione peggiorò ulteriormente: nel

1932 era stato nominato primo ministro Gyula Gömbös, fascista e antisemita dichiarato. Il suggello finale a questo

drammatico periodo fu dato dall’ingresso delle truppe tedesche in Ungheria, nel 1944. Il regime collaborazionista sorto in

quel tempo decretò la deportazione in massa degli ebrei ungheresi. Il sopraggiungere della Seconda Guerra Mondiale

spense la vita stimolante e allegra di Budapest, ricca di avventure intellettuali, portando in cambio soltanto un’onda di

persecuzioni e di morte che fu poi perpetuata dal regime comunista installatosi dopo la fine della guerra.

1.3 Considerazioni sulla cultura e la fisica ungherese

La straordinaria fioritura intellettuale che ebbe luogo in Ungheria agli inizi del Novecento è almeno in parte ascrivibile al

senso di incertezza e di timore del futuro. Lo stesso von Neumann individuò questo aspetto come centrale nella sua

esperienza. In un contesto così fragile e insicuro, assumevano un’importanza primaria la lotta per il successo nell’ambito

professionale e sociale, la propensione a impegnarsi nella vita pubblica.

Si manifestava, inoltre, uno stato psicologico che potrebbe essere descritto come un sentirsi perpetuamente pronti a

partire dal proprio paese per evitare la catastrofe, e quindi la propensione a vivere come «cittadini del mondo». Tale

atteggiamento aiutò molti ungheresi a inserirsi facilmente nella realtà di altri paesi, e, in ambito scientifico, a comportarsi

secondo le tendenze più moderne e avanzate, tese a vedere la ricerca come un’impresa internazionale.

Dal punto di vista della cultura e della scienza Budapest divenne una delle capitali più ricche e vivaci, non solo in ambito

europeo, ma mondiale, in cui la componente ebraica ebbe un ruolo di primo piano. Possiamo citare a supporto di tale

affermazione alcuni nomi di grandi fisici ungheresi, divenuti famosi a livello internazionale: come Tódor Kármán (che

cambiò il nome in Theodore von Kármán dopo l’emigrazione negli Stati Uniti), Ede (poi Edward) Teller, Jenö Pál (noto

come Eugene P. Wigner), Leo Szilard e Dénes (Denis) Gabor.

1.4 John von Neumann: la giovinezza e la formazione

John von Neumann nacque a Budapest il 28 dicembre 1903. Il suo nome in ungherese era János Neumann. Egli era il

primogenito di Miksa e Margit Neumann, membri della comunità ebraica della capitale. La madre, Margit, veniva da una

famiglia agiata: il nonno Jakab Kann era di umili origini, ma si era arricchito nel commercio di attrezzature agricole. Miksa

Neumann era un avvocato che, alla nascita del primo figlio, lavorava da qualche tempo come direttore di una delle

principali banche ungheresi. Nel 1907 nacque il secondo figlio, Mihály, e nel 1911 il terzo, Miklós. La posizione della

famiglia Neumann era simile a quella di tante altre famiglie di ebrei ricchi e colti della capitale: tanto promettente quanto

instabile.

János Neumann ricevette un’ottima istruzione: studiò con precettori privati fino all’età di dieci anni e poi seguì gli studi

secondari nel Ginnasio Luterano, uno dei migliori centri d’insegnamento della capitale, che disponeva di docenti di alto

4

livello e consentiva una formazione religiosa differenziata, per cui János studiò lingua e letteratura ebraica con un

rabbino. Fin dai primi mesi di studio nel Ginnasio, si manifestarono le capacità matematiche straordinarie del giovane. Il

suo professore consigliò alla famiglia di fornire allo studente una formazione complementare e si consultò con alcuni

professori universitari per trovare un precettore privato per János. Il primo fu Gabor Szegö e, quando questi lasciò

Budapest, il suo posto fu preso da Mihály Fekete. Entrambi erano membri del gruppo di Fejér.

Furono soprattutto gli studi con Fekete a dare risultati significativi: ancor prima di completare il Ginnasio, János scrisse in

collaborazione con Fekete un articolo, in cui veniva generalizzato un risultato di Fejér sulle radici dei polinomi di Čebičev,

pubblicato nel 1922 sulla rivista dell’Unione dei matematici tedeschi «Jahresbericht der Deutsche Matematische

Vereinigung».

La formazione di János Neumann, in realtà, non fu orientata fin dall’inizio in senso rigidamente matematico, con

l’esclusione dell’interesse per altri temi. Al contrario, gli anni della sua formazione risultano pieni di stimoli e i brillanti

professori del Ginnasio luterano lo fecero avvicinare a molti temi filosofici e scientifici. Il giovane era un lettore

instancabile. Di grande importanza fu anche il ruolo della famiglia e, in particolare, del padre, che lo interessava alla sua

attività economica, evidenziandone i successi e i rischi.

I primi segni che le condizioni favorevoli alla realizzazione del miracolo ungherese stavano svanendo si manifestarono

fin dalla prima giovinezza di János. L’anno del suo ingresso nel Ginnasio Luterano fu proprio quello in cui cominciò la

Prima Guerra Mondiale, che coincise con l’inizio della catastrofe per il paese. Il fallimento del progetto politico del conte

Károlyi, cui seguì l’avvento della Repubblica Sovietica di Béla Kun indusse la famiglia Neumann a rifugiarsi in Austria e

poi sulla costa adriatica. Dopo cinque mesi, i Neumann rientrarono a Budapest, trovando una situazione inquietante a

causa della forte ondata di repressione attuata dal regime di Horthy. L’ondata di antisemitismo che si accompagnò a

questi sviluppi era anche motivata dal pretesto che lo stesso Béla Kun era un intellettuale giudeo. Tuttavia, la relativa

tolleranza di Horthy nei confronti dell’élite industriale e finanziaria ebraica permise alla famiglia Neumann di proseguire

senza troppi problemi la sua esistenza. Nel 1921, János superò i rigorosi controlli di fedeltà al regime e poté seguire gli

studi di matematica all’Università di Budapest, entro la quota di ammissione fissata dal Parlamento per gli studenti ebrei.

Tuttavia, le prospettive future non apparivano rosee e, negli Anni Venti, la vita di János cominciò ad allontanarsi dalle

vicende del suo paese. Egli iniziò dapprima una fase intensa di formazione in Germania, frequentando l’Università di

Budapest soltanto in occasione degli esami. Fra il 1921 e il 1923 von Neumann seguì vari corsi all’università di Berlino,

che era allora il centro universitario più famoso della Germania: assistette alle lezioni di chimica di Fritz Haber, di

meccanica statistica di Albert Einstein ed entrò in contatto con il matematico Erhard Schmidt. In quel periodo egli divise

la sua formazione culturale e scientifica in un incessante peregrinare fra Budapest, Vienna e Berlino.

Fra il 1923 e il 1925 seguì le lezioni di ingegneria chimica al Politecnico di Zurigo, una delle istituzioni di insegnamento

tecnico superiore più prestigiose nell’Europa dell’epoca. Lo fece soprattutto per dare soddisfazione a suo padre, che lo

spingeva verso gli studi direttamente applicati. È indubbio che alcuni degli interessi di von Neumann per temi non

strettamente matematici maturarono in tale periodo: non soltanto la passione per la tecnologia e l’ingegneria, ma anche

quella per l’economia teorica e per altri aspetti delle applicazioni della matematica. Tuttavia in lui maturava sempre di più

l’idea che la matematica dovesse essere lo strumento principale e il linguaggio privilegiato.

The most vitally characteristic fact about mathematics is, in my opinion, its quite peculiar relationship to the natural

science, or more generally, to any science which interprets experience on a higher than purely desciptive level.

[J. VON NEUMANN, The Works of the Mind, The University of Chicago Press 1947]

Nell’estate e nell’autunno del 1925, von Neumann, visitò per la prima volta Göttingen, dove conobbe personalmente il

grande David Hilbert, che si rivelò subito l’interlocutore ideale dei suoi interessi per la logica matematica, l’assiomatica e

la teoria degli insiemi. Quella città era all’epoca il centro più importante della ricerca scientifica mondiale, così il nuovo

ambiente ebbe un ruolo cruciale per la vita scientifica e professionale di von Neumann: segnò la fine della sua fase

giovanile e l’ingresso nella piena maturità.

1.5 Il modello di ricerca in matematica e in fisica matematica

Agli inizi del Novecento, la tradizionale competizione fra la scienza fisico-matematica francese e tedesca, dopo un

periodo di supremazia della prima, appariva risolta a favore della seconda. Indubbiamente, la matematica e la fisicomatematica francese potevano contare su un genio universale come Remi Poincaré. Tuttavia, Poincaré era un

personaggio abbastanza isolato. Per quanto grande fosse la sua influenza nel mondo scientifico nazionale e

internazionale, egli sviluppava i suoi progetti e le sue concezioni in solitudine e, difatti, non aveva allievi che ne

seguissero le orme. Personalità come Felix Klein e David Hilbert non raggiunsero la prolificità scientifica e l’acume di

Poincaré, ma lasciarono tracce assai più profonde e durevoli nello sviluppo della scienza, costruendo una scuola vasta e

strutturata, così da determinare le caratteristiche di un modo di fare scienza che avrebbe influenzato tutto il secolo.

Un aspetto fondamentale consisteva nella concezione dell’attività scientifica come un’impresa collettiva e non più

soltanto la somma delle opere di singoli personaggi più o meno isolati. Di qui la centralità delle scuole scientifiche.

Il giovane von Neumann partecipò sia alle discussioni promosse dal Circolo di Vienna sui fondamenti della matematica,

sia a numerose sessioni del Mathematische Kolloquium, nell’ambito del quale maturò e trasmise alcuni fondamentali

5

contributi alla matematizzazione dell’economia. Vienna, oltre a Berlino e Zurigo, rappresentò uno dei centri scientifici e

culturali che più contribuirono alla sua formazione, ma fu Göttingen l’ambito in cui si concretizzarono le sue prime grandi

realizzazioni scientifiche.

Questa città esprimeva al massimo livello le nuove caratteristiche della scienza tedesca sopra citate: la ricerca scientifica

era intesa come progetto coerente attorno a temi ben definiti, perseguito da una comunità di studio fortemente integrata

e coesa. Così l’organizzazione della ricerca anticipava alcuni degli aspetti caratteristici della scienza contemporanea, in

particolare la coscienza di promuovere un’attività internazionale e di valore universale.

Il matematico Felix Klein, che conquistò una posizione di primo piano in ambito tedesco, per le sue brillanti ricerche, fu

una figura di riferimento nella scuola di Göttingen e nel 1885, conseguì la cattedra in quella università. Essa allora era

una piccolo ateneo, non paragonabile per dimensioni e importanza a Berlino, anche se tra gli insegnanti aveva

annoverato grandi matematici come Gauss e Riemann. In quegli anni, abbandonate la ricerca di prima linea, si dedicava

sempre di più al ruolo suo di organizzatore. Verso la metà degli Anni Novanta, Klein maturò il progetto di aggregare

nell’Università di Göttingen un gruppo di matematici capaci di ridare lustro a quel centro. Il nucleo culturale del progetto

doveva essere il rapporto fra matematica e fisica e l’approccio geometrico nello studio di ogni sorta di problemi. Per

realizzare questo progetto egli perseguì una politica aggressiva di espansione delle cattedre di matematica.

Una delle più brillanti «reclute» di Klein fu David Hilbert, che condivideva con lui una concezione ampia della matematica

e la fiducia nel valore delle idee unificanti contro la specializzazione, oltre alla convinzione della necessità di assumere

un atteggiamento di apertura internazionale nella ricerca. Sotto la guida di Klein e Hilbert, la scuola matematica di

Göttingen divenne un importante fenomeno culturale, caratteristico della Repubblica di Weimar. Nel periodo fra le due

guerre mondiali, in particolare dopo la morte di Klein, nel 1925, l’influsso di Hilbert divenne dominante. Il gruppo si

separò progressivamente dal resto dei membri della Facoltà di Filosofia, cui apparteneva formalmente, che era dominata

da posizioni conservatrici e nazionaliste tipiche di certi settori della docenza universitaria tedesca. L’apertura

internazionale fu all’origine del modo in cui la ricerca scientifica è intesa ancora oggi e fece di Göttingen un centro di

attrazione di studiosi delle più diverse provenienze, fra cui numerosi ebrei.

La comunicazione diretta fra ricercatori nei seminari e nelle riunioni scientifiche aveva un ruolo di grande importanza,

assieme all’attività di pubblicazione di libri e di articoli sulle riviste. Crebbe così non soltanto il numero dei Privatdozenten

di matematica, ma anche quello degli allievi e vennero organizzati corsi di aggiornamento per i professori di ginnasio. I

mezzi materiali a disposizione della comunità scientifica erano straordinari, fra essi vi era una splendida collezione di

modelli e strumenti e una ricca biblioteca organizzata con il sistema del libero accesso, al fine di stimolare i contatti

informali fra gli studiosi.

Questo dinamismo era stato ispirato dalla visione di Klein secondo cui la matematica andava pensata in un contesto

scientifico ampio e unitario, assieme alle scienze naturali e anche alla tecnologia. Il rapporto con il mondo dell’ingegneria

e della produzione era assai concreto, poiché lo stesso Klein aveva stabilito relazioni con l’industria tedesca, che

avevano determinato un appoggio crescente da parte degli industriali alle infrastrutture scientifiche e avevano posto in

essere il primo esempio di sostegno privato alla ricerca tecnico-scientifica. Per questi motivi, la figura di Klein aveva

assunto un grande rilievo sulla scena politica ed economica tedesca. Tuttavia, agli inizi del secolo, l’enfasi posta da Klein

sui rapporti fra matematica pura e ricerca aveva ceduto il passo a una concezione della matematica di carattere

fortemente astratto, che divenne l’aspetto più caratteristico del contributo di Göttingen alla storia della disciplina.

Agli inizi del Novecento, la matematica conosceva una frammentazione e una specializzazione crescenti. Probabilmente,

proprio l'approccio astratto e assiomatico, che slegava la matematica dall'antico riferimento unitario empirico, aveva

portato a questi sviluppi. Di fronte alla frantumazione che le nuove tendenze sembravano introdurre nella ricerca, Hilbert

proponeva proprio il metodo assiomatico come punto di partenza per un processo di riunificazione capace di mettere in

luce l'intima struttura unitaria della matematica. In tal senso, Hilbert rappresenta una delle ultime grandi figure

scientifiche (al pari di Einstein) ispirate da una visione unitaria della scienza e capaci di dominarne l'insieme con un unico

sguardo.

Questo era l'ambiente e il contesto culturale con cui entrò in contatto il giovane von Neumann nel 1925. Per quanto

stimolanti fossero state altre esperienze e, in particolare, quella di Zurigo, il clima di Göttingen risultò subito in perfetta

sintonia con le aspirazioni del giovane. Tre aspetti del suo pensiero erano già marcatamente evidenti fin dal periodo

ungherese: la matematica intesa come strumento logico di portata universale; l'interesse per i nuovi approcci astratti

della disciplina e, in particolare, per la teoria degli insiemi; la passione per le applicazioni e la convinzione che in esse la

matematica dovesse avere un ruolo centrale. Queste tre aspirazioni trovavano una risposta perfetta nello stile di

Göttingen e nella visione assiomatica hilbertiana. Il giovane von Neumann si inserì immediatamente nel gruppo di studio

e sviluppò i temi di ricerca della assiomatizzazione della teoria degli insiemi e del problema dei fondamenti.

Per un giovane aspirante alla carriera accademica, tuttavia, in Germania c’erano poche prospettive, la carriera

universitaria era lunga, difficile e, inizialmente, poco o per nulla remunerata. Alla fine degli Anni Venti, in Germania, la

competizione per ottenere un posto di Professore Ordinario era durissima. Per queste ragioni, nel 1929, von Neumann

accettò il posto di Professore Invitato di fisica matematica, presso l’Università di Princeton. Von Neumann aveva 26 anni,

suo padre era morto da poco e la responsabilità della famiglia ricadeva su di lui. Prima di partire per Princeton egli si

sposò con Mariette Kövesi - ungherese di religione cattolica, figlia di un medico di Budapest, amico di famiglia - e, in

questa circostanza, si convertì al cattolicesimo. Ebbe così inizio la fase statunitense della vita di von Neumann, anche

se, fino al 1933, egli continuò sistematicamente a recarsi in Germania. In quell’anno, Adolf Hitler fu nominato Cancelliere

del Reich ed ebbe inizio un’ondata di destituzioni e dimissioni di professori universitari, che pose fine alla brillante

6

esperienza di Göttingen e segnò il distacco di von Neumann dall’Europa.

1.6 Hilbert e il metodo assiomatico

Nei suoi Fondamenti della geometria del 1899, Hilbert aveva ridotto il problema della coerenza della geometria a quello

della coerenza dell’insieme dei numeri reali, cioè, dei numeri che vengono associati agli infiniti punti di una retta

.

I numeri reali erano stati studiati assiomaticamente e si era dimostrato che la coerenza della loro teoria è una

conseguenza della coerenza dell’aritmetica, ovvero del sistema di assiomi che definiscono l’insieme dei numeri interi

naturali: 0, 1, 2, 3, …. Tale sistema di assiomi era stato proposto dal matematico italiano Giuseppe Peano. Si fondava

sul postulato dell’esistenza di un «primo numero» (lo zero), su quello dell’esistenza del «successivo» di ogni numero e

sul cosiddetto «principio d’induzione», secondo cui, se un insieme di numeri contiene lo zero e se, contenendo un

numero, contiene anche il suo «successivo», allora contiene tutti i numeri naturali. Le ricerche matematiche sviluppate

verso la fine dell’Ottocento conducevano alla conclusione che la chiave di una fondazione soddisfacente dell’intera

matematica risiedeva nella coerenza dell’insieme dei numeri naturali, quelli legati all’operazione elementare del contare.

Hilbert, invece, non era di tale avviso.

Tuttavia, già due anni dopo iniziò la scoperta di una serie di paradossi o contraddizioni della teoria degli insiemi, che

aprirono una crisi profonda. Il più famoso di questi era il paradosso scoperto da Russell nel 1902: se si ammette la

nozione di insieme degli «insiemi che non contengono se stessi come elementi», si vede che tale insieme è e non è

elemento di se stesso. Infatti, se non lo è, in quanto insieme di tutti gli insiemi che non contengono se stessi come

elementi, lo è; e se lo è, in quanto contiene soltanto insiemi che non contengono se stessi come elementi, non lo è.

Hilbert iniziò a occuparsi in prima persona di questo argomento nel 1904, poi lo lasciò da parte, concentrandosi sullo

studio di questioni di analisi e di fisica matematica. Comunque, il tema era divenuto centrale nell’ambiente dei sostenitori

del metodo assiomatico hilbertiano, la cui strategia era la ricerca di un’assiomatica della teoria degli insiemi che,

eliminando le imprecisioni del linguaggio non formalizzato utilizzato da Cantor, rendesse impossibile l’emergere di

antinomie.

Questa tematica aveva appassionato il giovane von Neumann fin dai suoi primi studi matematici. Non dobbiamo

dimenticare il lavoro pubblicato nel 1925, che riguardava l’assiomatizzazione della teoria degli insiemi; e la tesi dottorale

presentata in Ungheria da von Neumann, su la costruzione assiomatica della teoria degli insiemi.

L’assiomatizzazione da lui proposta per la teoria degli insiemi introduceva la distinzione fra «classi» e «insiemi». L’idea

chiave era di considerare un nuovo gruppo di enti, le classi, la cui caratteristica è quella di non poter essere contenuti in

altri insiemi o classi, mentre gli insiemi sono particolari classi che possono essere elementi di una classe. Con questa

distinzione era possibile eliminare antinomie come quella di Russell.

Il lavoro di von Neumann e gli sviluppi che egli ne diede dopo il 1925 si inserivano in modo spontaneo nel programma di

ricerca hilbertiano ed era altrettanto naturale che von Neumann divenisse uno dei più accesi adepti dell’approccio

assiomatico della scuola hilbertiana.

Negli anni successivi, il giovane matematico ungherese, affascinato da altri temi di ricerca, distolse la sua attenzione

dalle questioni di logica matematica, senza per questo disinteressarsi del programma di Hilbert. Difatti, nel settembre del

1930, egli partecipò a un Congresso sull’Epistemologia delle scienze esatte che si tenne a Königsberg, sotto gli auspici

dell’Associazione Ernst Mach e della Società per le scienze empiriche di Berlino, su iniziativa di alcuni esponenti del

Circolo di Vienna. Nel corso di questo stesso Congresso: Kurt Gödel annunciò un risultato (il corollario del teorema noto

oggi come teorema di incompletezza di Gödel) che, nella versione definitiva, completa di tutte le dimostrazioni e le

implicazioni, sarebbe stato pubblicato l’anno seguente. Il risultato di Gödel dimostrava l’impossibilità di conseguire una

dimostrazione completa della coerenza dell’aritmetica nel contesto delle regole stabilite per la metamatematica e

comportava una sconfitta senza appello del programma hilbertiano.

In realtà, nel corso del Congresso di Königsberg nessuno degli illustri partecipanti si rese subito conto della portata e

delle implicazioni del risultato annunciato da Gödel, con la sola eccezione di von Neumann, il quale, dopo la discussione,

si incontrò con Gödel per farsi spiegare meglio la sua intuizione e l’approfondì al termine del Congresso. Dopo meno di

due mesi scriveva a Gödel annunciando di aver dimostrato l’indimostrabilità della coerenza dell’aritmetica, come

conseguenza del teorema di incompletezza. Gödel gli rispose di aver ottenuto nel frattempo lo stesso risultato e gli inviò

copia del lavoro già presentato per la pubblicazione.

Von Neumann, successivamente a tale episodio, abbandonò definitivamente le ricerche di logica matematica, ma non

l’idea che la logica dovesse avere un ruolo fondamentale nella prassi matematica. Per un verso il risultato di Gödel fu

sentito da lui come un’autentica disfatta, che influenzò la sua visione dei limiti del rigore matematico. D’altro lato, però,

egli continuò a credere fermamente nel valore della pratica matematica fondata su un approccio logico-formale. Sotto

questo profilo, la fiducia nel valore del metodo assiomatico, liberato dai vincoli del programma formalista hilbertiano,

divenne un caposaldo del pensiero matematico di von Neumann, il quale si propose, in tal modo, come uno dei principali

attori di una ricostruzione «pragmatica» della fiducia dei matematici nel valore della loro disciplina.

7

1.7 La fisica quantistica e la crisi del determinismo

All’inizio del Novecento si verificò uno straordinario sviluppo di ricerche nel campo della fisica, che condusse a un

radicale cambiamento delle convinzioni fondamentali dei fisici e a una profonda crisi della fisica matematica classica. Si

parla di solito di tre «rivoluzioni» avvenute nella fisica nei primi decenni del secolo: l’emergere della teoria della relatività

ristretta e poi generale, la sostituzione su scala macroscopica della teoria newtoniana con queste ultime e l’emergere

delle teorie quantistiche, che proponevano una spiegazione dei fenomeni della fisica atomica. Questi sviluppi segnarono

gli inizi della cosiddetta «fisica teorica» e portarono a una svolta negli strumenti di analisi matematica del mondo fisico.

Molti studiosi si cimentarono nell’impresa di conseguire una trattazione matematica adeguata delle nuove teorie fisiche.

Nel caso della relatività einsteiniana, era disponibile una branca matematica già sviluppata nell’ambito della geometria

differenziale: il calcolo differenziale assoluto. Le maggiori difficoltà si presentarono nella trattazione matematica della

meccanica quantistica; questo fu uno dei principali temi di ricerca nell’ambiente di Göttingen.

Il problema teorico che si poneva era di fornire una spiegazione dei dati sperimentali disponibili circa la struttura e la

dinamica degli atomi. Nel primo ventennio del secolo si era accumulata una gran massa di dati sperimentali - in parte

derivanti dagli studi sulla radiazione - che apparivano in contraddizione con le leggi newtoniane del moto o con le

formulazioni matematiche equivalenti, come quella «variazionale» data da William R. Hamilton. Se, ad esempio, l’atomo

era formato da un nucleo pesante e da un gruppo di elettroni attorno a esso, secondo il modello di Ernest Rutherford,

perché l’elettrone non perdeva energia e non cadeva sul nucleo, come sembravano prevedere le leggi del moto? In altre

parole, il modello risultava in disaccordo con la teoria elettrodinamica classica secondo la quale ogni variazione di

velocità e direzione del moto di una carica elettrica (l’elettrone) è accompagnata dall’emissione di onde

elettromagnetiche. Gli elettroni, dunque, dovrebbero continuamente irradiare energia elettromagnetica con una

frequenza pari a quella del loro moto di rivoluzione attorno al nucleo. La conseguente perdita di energia cinetica e

potenziale porterebbe l’elettrone ad avvicinarsi sempre di più al nucleo secondo una traiettoria a spirale sino a

precipitare sul nucleo stesso.

Fra il 1925 e il 1926, furono presentati quasi contemporaneamente due schemi esplicativi. Uno di essi fu formulato a

Göttingen da Werner Heisenberg, Max Born e Pascual Jordan. In modo puramente algebrico, generalizzando le variabili

di base che la formulazione hamiltoniana della meccanica classica associa a una particella, la posizione e il momento di

un elettrone venivano rappresentati da matrici infinite, ovvero da oggetti matematici aventi la proprietà secondo cui il loro

prodotto non è commutativo e per questa via si ottenevano generalizzazioni appropriate delle equazioni di Hamilton.

Lo schema esplicativo fornito da Ernst Schrödinger, invece, rispondeva soprattutto a considerazioni fisiche e si basava

sulla constatazione di una «natura» duale delle particelle subatomiche, viste al contempo come onde e corpuscoli: in

effetti, i dispositivi sperimentali mettevano in evidenza talora un comportamento ondulatorio, talora un comportamento

corpuscolare delle particelle. Niels Bohr, direttore dell’Istituto di fisica di Copenaghen, aveva inquadrato tale fenomeno in

un «principio di complementarità», che egli considerava estensibile a tutti i campi della realtà, inclusa la biologia e la

psicologia, e che indicava i limiti stessi delle conoscenze. Secondo questo principio, le particelle elementari presentano

due aspetti complementari, ognuno dei quali spiega soltanto una parte dei processi subatomici. Una manifestazione di

questo aspetto era l’esistenza di variabili complementari, come la posizione e il momento di una particella, che non

possono essere determinate contemporaneamente (il cosiddetto «principio di indeterminazione» di Heisenberg). Nella

«meccanica ondulatoria» di Schrödinger, a ogni elettrone veniva associata un’equazione differenziale (o «equazione

d’onda»), la cui risoluzione, nel caso dell’atomo di idrogeno, permetteva di ottenere le lunghezze d’onda rilevabili

sperimentalmente. Schrödinger aveva dimostrato inoltre che, a partire dalla sua equazione, era possibile ottenere la

matrice di Heisenberg, indicando così la sostanziale equivalenza delle due descrizioni. Tuttavia, sussisteva una

divergenza fondamentale fra il punto di vista di Heisenberg e Bohr (quest’ultimo proponeva un’interpretazione statistica

della meccanica quantistica) e quello di Schrödinger, sostenuto da Einstein, che difendeva la necessità di ristabilire una

descrizione deterministica della realtà.

Un problema importante era la determinazione di una formulazione matematica adeguata sia alla meccanica ondulatoria,

sia alla meccanica matriciale e una teoria astratta, che era stata sviluppata senza connessione con queste

problematiche fisiche - la teoria degli spazi funzionali di Hilbert - si mostrò la più adeguata allo scopo.

Nell’ambito della meccanica quantistica, Heisenberg aveva già descritto alcune grandezze del sistema fisico mediante

matrici infinite. L’idea chiave dell’applicazione degli spazi di Hilbert fu di rappresentare lo stato di un atomo mediante un

vettore di uno spazio di Hilbert - assegnato da un numero infinito di coordinate, ognuna delle quali è un numero

complesso - mentre le grandezze fisiche osservabili, come la posizione, il momento o l’energia, erano descritte mediante

operatori lineari di tipo particolare (hermitiani o autoaggiunti). Nel caso dell’operatore rappresentativo dell’energia, gli

autovalori dell’operatore indicavano i livelli energetici di un elettrone e gli autovettori corrispondenti mostravano i rispettivi

stati quantici stazionari del sistema. La constatazione fisica fondamentale in meccanica quantistica, secondo cui una

misura perturba il sistema e i risultati delle misure successive di due grandezze osservabili dipendono dal loro ordine

temporale, corrisponde, in questa rappresentazione matematica, al fatto che gli operatori non commutano: in tal modo, il

principio di indeterminazione di Heisenberg (ovvero la precisione con cui possono essere determinate la posizione e la

quantità di moto di una particella sono interdipendenti tra loro: ) veniva associato a una proprietà matematica. Quest’idea

fu presentata per la prima volta da Paul A. Dirac e Pascual Jordan nel 1927.

L’assiomatizzazione della meccanica quantistica era un problema centrale per Hilbert e per l’ambiente di Göttingen.

8

Occuparsi di questo tema significava mettersi sulla cresta dell’onda. Von Neumann, all’inizio, collaborò direttamente con

Hilbert, pubblicando, nel 1927, un lavoro sui fondamenti della meccanica quantistica, in cui si sosteneva la necessità di

separare l’interpretazione fisica dal formalismo matematico, se si voleva conseguire una vera comprensione della teoria.

Successivamente, decise di migliorare i risultati ottenuti, utilizzando una formulazione assiomatica del concetto di spazio

di Hilbert astratto. In due lavori pubblicati nel 1929 e nel 1930 sulla rivista «Mathematische Annalen», egli presentò la

teoria generale degli operatori lineari hermitiani su uno spazio di Hilbert qualsiasi (detta teoria spettrale).

Alla fine degli Anni Venti e agli inizi del decennio successivo, pubblicò molti studi sulla meccanica quantistica, alcuni dei

quali in collaborazione con Wigner, e si interessò agli aspetti fisici della teoria, come il concetto di misura, uno dei punti

più ostici da affrontare. La meccanica classica era basata sull’idea che, in ogni osservazione sperimentale, l’errore

dovuto alle perturbazioni prodotte dallo strumento di misura sull’oggetto osservato possa essere sempre corretto:

ammettendo, quindi, di essere in grado di costruire strumenti capaci di garantire una lettura oggettiva e indipendente

dall’osservatore. Questo presupposto di base era ormai in discussione: Bohr e Heisenberg avevano messo in evidenza

l’impossibilità di conseguire una descrizione oggettiva della realtà fisica. Secondo il loro punto di vista, l’osservatore

umano consegue una lettura oggettiva dei segnali dello strumento, ma essa si riferisce alla combinazione dell’oggetto

con lo strumento. Pertanto, ogni previsione circa lo stato futuro dell’atomo non può che essere di tipo statistico.

Questa perdita della certezza, analoga a quella verificatasi in matematica, fu affrontata da alcuni fisici fedeli al

determinismo, come Einstein, sostenendo l’esistenza di «parametri nascosti» che, una volta determinati, avrebbero

eliminato l’incertezza.

Von Neumann, invece, ricorse all’approccio assiomatico per eliminare la fonte delle difficoltà interpretative ed evitare la

rottura con la concezione classica della fisica. Da un lato, egli introdusse, come proposizione interna alla teoria, il

carattere assolutamente naturale della meccanica quantistica, ovvero l’impossibilità dell’esistenza di teorie equivalenti

con «parametri nascosti»; d’altro lato, sviluppò una teoria della misurazione formalizzata in termini puramente

matematici.

Per conseguire questo obbiettivo, von Neumann proponeva un’audace rottura con la distinzione tradizionale tra

osservatore e strumento di misura: a suo parere, essa era arbitraria, perché ogni osservazione è necessariamente

soggettiva. La sua teoria della misura permetteva di ottenere una descrizione dello stato del sistema osservato e dello

strumento di misura. La presa di coscienza da parte dell’osservatore del risultato dell’osservazione modifica questo stato

e soltanto così si spiega il processo di misura.

La formulazione assiomatica di von Neumann fu considerata, in seguito, come l’esposizione canonica dei principi della

meccanica quantistica e il suo prestigio si consolidò quando la sua trattazione matematica si mostrò capace di includere

sviluppi come la meccanica quantistica relativistica e, almeno in parte, la teoria quantistica del campo.

By and large it is uniformly true that in mathematics there is a time lapse between a mathematical discovery and the

moment it becomes useful; and that this lapse of time can be anything from 30 to 100 years, in some cases even more

[… ].

[J. VON NEUMANN, Collected Works Vol. VI. Theory of Games, Astrophysics, Hydrodynamics and

Meteorology, Pergamon Press 1961]

L’influenza della formalizzazione di von Neumann sulla pratica della ricerca fu più limitata e i fisici utilizzarono

prevalentemente la presentazione di Dirac. In effetti, negli anni successivi, la sintesi fra fisica teorica e matematica, che

era sembrata così solida si attenuò, dando progressivamente luogo a una profonda separazione delle due discipline. Lo

stesso von Neumann abbandonò questi studi, concentrandosi sullo sviluppo puramente matematico della teoria degli

operatori negli spazi di Hilbert.

Con le ricerche del periodo di Göttingen, von Neumann contribuì, come pochi altri, a ridare forza all’idea che la

conoscenza scientifica consegue conoscenze oggettive, nella misura in cui fa ricorso all’uso sistematico della

matematica, che sola è capace di dare senso all’idea di legge scientifica. Ormai erano trascorsi i tempi della fiducia

nell’oggettività assoluta della scienza. La scienza non era più quella di Newton e di Galileo, pervasa dall’idea di poter

svelare le leggi universali che reggono il mondo fisico, essa era ormai la scienza dei modelli:

The sciences do not try to explain, they hardly even try to interpret, they mainly make models. By a model is meant a

mathematical construct which, with the addition of certain verbal interpretations, describes observed phenomena. The

*

justification of such a mathematical construct is solely and precisely that it is expected to work. ( )

[J. VON NEUMANN, Method in the physical sciences, 1961]

La definizione di scienza di von Neumann è, tuttavia, riduttiva poiché ritiene che gli unici modelli in grado di interpretare

la realtà siano quelli matematici. Questa concezione di scienza esclude, pertanto, ambiti come le scienze naturali o la

biologia hanno sviluppato alcune teorie che interpretano determinati fatti senza fare ricorso a modelli matematici. La

scienza razionalista, ovvero la scienza intesa come processo, in contrapposizione alla scienza tradizionale di stampo

positivista ed empirista, prevede un approccio di ricerca ed analisi continua dei fatti basata sulla cosiddetta “innovazione

concettuale”. Essa procede “tra incertezza ed insuccessi e si risolve in un sapere ipotetico, contingente e storicamente

determinato”.

9

2.1 L’emigrazione negli Stati Uniti

Nel settembre del 1928, von Neumann partecipò, come membro della delegazione tedesca, al Congresso internazionale

dei matematici di Bologna. Al Congresso conobbe Oswald Veblen (1880-1960), importante esponente della comunità

scientifica statunitense. Quest’incontro mutò il corso della vita di von Neumann, allontanandolo progressivamente

dall’Europa.

Veblen era professore all’Università di Princeton, dove era stato assunto nel 1905. Oltre all’attività scientifica, egli

svolgeva un’intensa attività organizzativa e istituzionale nel suo paese. Uno dei principali obiettivi di Veblen era di

elevare al massimo grado, il livello della ricerca e dell’insegnamento universitario della matematica negli Stati Uniti. Fin

quasi alla fine dell’Ottocento il livello delle università statunitensi era più basso delle università europee. La maggior

parte dei professori svolgeva una gran mole di attività didattica. La ricerca e la pubblicazione non erano considerate né

un obbligo né un merito. Nel 1888 fu fondata la Società matematica di New York, il cui scopo era mettere in contatto

persone interessate alla matematica e appartenenti agli ambienti più disparati: professori universitari e delle scuole

secondarie, economisti, ingegneri. Qualche anno dopo, quest’istituzione prese il nome di “Società matematica

americana” (AMS, American Mathematical Society).

L’Università di Princeton poteva contare su un buon numero di ottimi professori di matematica, ma ancora agli inizi degli

anni venti era soprattutto un centro di insegnamento che non prevedeva l’attività di ricerca. Nel biennio 1923-24, Veblen,

come presidente della “Società matematica americana” (AMS), s’impegnò per ottenere finanziamenti governativi per le

pubblicazioni e le attività della Società. Uno dei suoi obiettivi era fondare a Princeton un istituto di ricerca in cui potessero

lavorare matematici di alto livello, riproducendo il modello organizzativo di Goettingen, in Germania, dove von Neumann

stava lavorando.

Alla fine degli anni venti, quando von Neumann conobbe Veblen, la fase economica era in crescita. Grazie a varie

donazioni, l’università di Princeton iniziò la costruzione di un edificio per il Dipartimento di Matematica e si istituirono

alcune cattedre. Veblen propose di utilizzare i fondi ancora disponibili per invitare professori stranieri: il suo candidato fu

von Neumann e congiuntamente fu invitato anche il suo compatriota e amico di infanzia Eugene Wigner (1902-1995;

premio Nobel per la fisica nel 1963). Successivamente furono invitati altri professori europei, tra cui Albert Einstein

(1879-1955; premio Nobel nel 1921).

Il nuovo edificio fu completato nel 1931: la biblioteca, le aule, gli studi e le sale comuni offrivano le migliori condizioni per

lo studio, la ricerca e gli scambi informali fra professori ed allievi. A Princeton si ricreò l’ambiente cosmopolita e

appassionante che von Neumann aveva conosciuto a Goettingen. Una generosa donazione del 1930 permise di istituire

a Princeton l’”Istituto di studi avanzati” (IAS, Institute of Advanced Studies) e Veblen fu eletto primo professore.

Mentre i centri della scienza tedesca e di altri paesi europei venivano decimati dall’epurazione nazista, a Princeton si

creò l’ambiente ideale per la ricerca matematica. L’istituto divenne, infatti, il primo centro mondiale della ricerca e

dell’istruzione superiore.

Molti furono gli scienziati europei che contribuirono a tutto ciò. Nell’aprile del 1933 iniziarono le di destituzioni di

professori universitari in Germania per motivi razziali e politici. Questa fuga di scienziati si aggravò nel 1938, con

l’invasione dell’Austria e della Cecoslovacchia da parte della Germania, la promulgazione delle leggi razziali in Italia e

poi con lo scoppio della guerra mondiale. I luoghi di accoglienza furono la Gran Bretagna, gli Stati Uniti ed alcuni paesi

dell’America Latina. Negli Stati Uniti in particolare, la legge di immigrazione esentava i professori universitari dalle quote

fisse di immigrazione, facilitando l’ingresso di coloro che erano stati invitati da un’istituzione del paese. I professori

stranieri furono aiutati in modo da favorire l’eccellenza scientifica, cercando di evitare che i rifugiati occupassero il posto

del personale docente del posto, ed evitare reazioni nazionalistiche xenofobe e antisemite. I professori stranieri potevano

concentrarsi sulla ricerca, svolgendo soltanto corsi di perfezionamento. Ciò suscitò in realtà anche invidie poiché i

ricercatori non dovevano sostenere i pesanti carichi di insegnamento delle università americane.

Veblen, in questo contesto, fu una delle figure chiave nell’organizzazione dell’emigrazione dei matematici dall’Europa.

Per quanto riguarda l’immigrazione ebraica, il filosofo ebreo esiliato Ignaz Maybaum (1897-1976) ricordava: “La Shoah ci

ha gettato senza pietà in un nuovo mondo, dove sono inefficaci sia le formule del XIX secolo sia lo stesso Shulchan Aruk

[il codice classico del diritto ebraico]. Dobbiamo ancora ricominciare”. La parola d’ordine di un’intera generazione fu,

infatti “ricominciare”, non solo come distacco negativo dal passato antisemita, ma anche come risposta alle promesse di

libertà della società americana. Questa posizione, diffusa tra gli immigrati ebrei negli Stati Uniti, ci può aiutare a

comprendere l’intensa collaborazione di von Neumann con le forze armate che descriveremo nei prossimi paragrafi ed in

particolare la sua posizione riguardo agli armamenti nucleari.

2.2 La ricerca universitaria

A Princeton, nel 1930, von Neumann tenne il suo primo corso sulla statistica quantistica come professore invitato.

Nell’anno seguente tenne corsi di fisica matematica e di idrodinamica. Nel 1933 fu nominato professore dell’”Istituto di

studi avanzati” (IAS) e ciò gli garantì una posizione tranquilla e sicura. Avrebbe, infatti, ricoperto tale posizione fino alla

sua morte, nel 1957.

10

Era il professore più giovane ed era spesso scambiato per uno studente. Stupiva matematici e fisici per la velocità con

cui risolveva problemi complessi. Nell’ambiente universitario si raccontava che “i matematici dimostrano quello che

possono, von Neumann dimostra quello che vuole”.

Tenne quindi corsi sulla teoria della misura, sulla teoria degli operatori e sulla teoria dei reticoli. Durante questo periodo

di insegnamento, von Neumann non interruppe i suoi rapporti con l’Europa, dove continuò a recarsi tutte le estati, fino al

1938. Si recava anche sistematicamente in Ungheria, dove ancora risiedeva la famiglia. Nel 1935 nacque negli Stati

Uniti, la sua unica figlia, Marina, attualmente professore di “Business Administration and Public Policy” presso

l’Università del Michigan. Due anni dopo divorziò dalla prima moglie, Marietta Koevesi. Nell’autunno del 1938 fece il suo

ultimo viaggio in Europa prima dello scoppio della guerra. Durante tale viaggio, organizzò il suo matrimonio con Klàra

Dàn, figlia di un’agiata famiglia ebrea di Budapest. Durante tale occasione si convertì al cattolicesimo. Subito dopo il

matrimonio, i due partirono per gli Stati Uniti.

Gli anni di Princeton, fino al 1938, furono per von Neumann un periodo di intenso lavoro scientifico in cui applicò il suo

rigore matematico all’idrodinamica, alla balistica, alla meteorologia, alla teoria dei giochi, alla statistica ed alla meccanica

quantistica. I suoi primi lavori in inglese apparvero nel 1932 sulla rivista dell’Accademia nazionale delle scienze degli

Stati Uniti.

L’elevato numero di temi cui abbiamo in parte accennato, fu affrontata da von Neumann in modo frenetico. Il suo

prestigio negli anni precedenti la guerra mondiale era ormai grande. Era metodico nello stile di lavoro e dotato di grande

capacità di concentrazione. È rimasto famoso per la straordinaria velocità nella soluzione dei più svariati problemi;

svolgeva un ruolo cruciale la sua capacita di formularli teoricamente nel modo da identificare gli aspetti rilevanti. Per lui il

lavoro matematico era un autentico piacere. A tal proposito, affermò: “Se la gente non crede che la matematica sia

semplice è solo perché non ha compreso quanto sia complicata la vita”.

La sua capacità intellettuale e il suo potere di astrazione si accompagnavano ad un carattere di uomo pratico e

mondano. Si caratterizzava per l’entusiasmo, la curiosità intellettuale e l’atteggiamento estremamente razionalista.

Il periodo tranquillo di Princeton, dedicato soprattutto alla ricerca scientifica, si concluse nel 1938. In tutta l’Europa gli

sviluppi della situazione politica colpivano l’attività degli scienziati. Lo scoppio della guerra e il successivo intervento degli

Stati Uniti interruppero il corso tranquillo della vita accademica di Princeton e produssero una svolta nella vita e nelle

attività scientifiche di von Neumann.

Dopo questo periodo di diversificati interessi, gli ambiti di ricerca più noti di von Neumann diventarono: lo sviluppo delle

armi nucleari e l’invenzione dei moderni computer digitali.

2.3 L’inizio della ricerca militare

Von Neumann ottenne la nazionalità americana nel 1937. Subito dopo Veblen fece da tramite per una proposta di

collaborazione con le forze armate. Il Laboratorio di ricerca balistica del Dipartimento di equipaggiamento e armamento

dell’Esercito, situato ad Aberdeen (Maryland), era in fase di riorganizzazione, a causa della situazione prebellica in

Europea. Nel laboratorio di Aberdeen, egli ebbe contatto diretto con le esigenze della scienza applicata e stabilì i primi

rapporti con le istituzioni militari.

La gratitudine di rifugiato e la simpatia per un paese che lo aveva accolto in modo così generoso, furono i motivi di base

della sua disponibilità a collaborare con la ricerca militare. Inoltre egli aveva già dimostrato un grande interesse per le

applicazioni della matematica ai contesti più diversi. I problemi di balistica e lo studio delle onde d’urto erano legati a

questioni di fisica matematica che sollevavano la sua curiosità al di là degli aspetti pratici.

In quegli anni, von Neumann non trascurò la ricerca scientifica in senso stretto. Tuttavia, dall’inizio della guerra in Europa

e soprattutto dopo l’entrata in guerra degli Stati Uniti, nel dicembre 1941, le ricerche militari assorbirono sempre di più il

suo tempo. Stava diventando un protagonista di spicco di un nuovo periodo storico, in cui i luoghi della ricerca non erano

più soltanto i laboratori pubblici (università, centri di ricerca statali a carattere civile), ma anche i laboratori di ricerca

militari e quelli industriali (privati).

Nel 1940, von Neumann fu nominato membro del nuovo “Comitato di consulenza scientifica” del Laboratorio di

Aberdeen, e nel corso dello stesso anno, consulente di balistica in un comitato per la preparazione alla guerra creato nel

1939 dalla “Società matematica americana” (AMS) e dalla “Associazione matematica dell’America” (MAA, Mathematical

Association of America).

Il primo organismo civile istituito allo scopo di offrire un’assistenza scientifica sistematica alle forze armate fu il “Comitato

di ricerche per la difesa nazionale” (NDRC, National Defence Research Commettee); il comitato organizzava il lavoro di

scienziati e ingegneri su temi come la guerra sottomarina, il radar, le contromisure elettroniche, gli esplosivi, i razzi. Nel

1941, von Neumann iniziò a collaborare con il comitato per lo studio delle onde di detonazione, al fine di perfezionare la

preparazione delle cariche esplosive e di dirigere e concentrare l’effetto della detonazione. L’anno successivo egli iniziò

a lavorare nel settore della guerra di mine per la Marina. Questo lavoro lo condusse prima a Washington e poi in

Inghilterra, dove soggiornò fra il gennaio e il luglio del 1943. Nei laboratori inglesi si occupò di questioni di dinamica dei

gas, importanti in artiglieria. In questo contesto iniziò a interessarsi per la prima volta alle applicazioni delle tecniche di

11

calcolo automatico.

2.4 Il calcolo automatico

Durante gli anni trenta e agli inizi degli anni quaranta, un numero crescente di matematici statunitensi aveva iniziato ad

occuparsi calcolo automatico, non soltanto in ambito militare, ma anche in relazione ai problemi di elaborazione

dell’informazione nell’amministrazione del paese e nella gestione delle imprese. I problemi di elaborazione

dell’informazione demografica per i censimenti della popolazione, e quelli legati alla contabilità e ad altri aspetti di

gestione delle imprese private, furono la chiave del successo commerciale della International Business Machines (IBM,

nome adottato nel 1924). I suoi sistemi di trattamento automatico dei dati (schede perforate) furono uno strumento

importante nella realizzazione pratica della politica razziale antiebraica del governo della Germania nazista. L’IBM

avrebbe svolto un ruolo importante negli sviluppi ulteriori delle tecnologie informatiche. In quegli anni, la maggior parte

dei calcoli era realizzata da operatori detti “calcolisti” o “calcolatori” – o “calcolatrici”, poiché in molti casi si trattava di

donne - con l’aiuto di semplici macchine di calcolo. Per quanto riguarda lo sviluppo del calcolo automatico, in quegli anni

erano partiti vari progetti con lo scopo di realizzare macchine rapide e potenti capaci di sostituire gli operatori umani:

erano comunque sforzi isolati di scarsa importanza economica e scientifica. Ne sono degli esempi le progettazioni di

calcolatrici elettromeccaniche da parete di Howard Aiken nell’Università di Harvard e di George R. Stibitz, nei laboratori

della Bell Telephone; un altro esempio è la progettazione di una calcolatrice elettronica da parte di John Atanasoff,

nell’Università dello Iowa.

Le esigenze belliche spinsero il governo a rivolgersi a questi pionieri per sperimentare le nuove macchine: si apriva così

una rivoluzionaria fase dello sviluppo del calcolo, nel quale von Neumann avrebbe svolto un ruolo decisivo. Aveva,

infatti, colto l’importanza delle possibili applicazioni dei computer alla matematica applicata per quanto riguarda specifici

problemi, mentre molti vedevano il computer solo come uno strumento per fare i calcoli in un modo più veloce. Il

riconoscimento dei suoi contributi avvenne soltanto qualche anno dopo la morte, forse a causa delle sue posizioni in

campo militare. Infatti, nel 1943, iniziò a collaborare come consulente con il “Laboratorio scientifico di Los Alamos”

(Nuovo Messico), dove si sviluppava in segreto il “Progetto Manhattan” (Manhattan Engineering District Project), diretto

dal fisico americano Robert Oppenheimer (1904 - 1967). Von Neumann continuò a lavorare principalmente nel suo

ufficio all’”Accademia Nazionale di Scienze” di Washington, D.C., ma visitando occasionalmente Los Alamos. Al

“Progetto Manhattan” collaborava il fisico italiano, Enrico Fermi (1901-1954, premio Nobel nel 1938). Si era rifugiato negli

Stati Uniti per salvare la moglie dal razzismo fascista. Oltre ad essere un grande fisico (pochi mesi prima dell’arrivo di

von Neumann aveva realizzato la prima “pila” atomica), era un grande organizzatore, contrariamente ad Oppenheimer.

L’obiettivo del “Progetto Manhattan” era la costruzione della bomba atomica che avrebbe dovuto imprimere una svolta

strategica all’andamento della guerra. Von Neumann era stato chiamato come consulente di idrodinamica, ma i suoi

contributi andarono ben oltre questo campo. Grazie ai suoi precedenti studi sugli esplosivi, suggerì di applicare la tecnica

di implosione per la detonazione della bomba. La simulazione dell’implosione era fondamentale per capire il

comportamento di questa possibile nuova arma, però richiedeva calcoli lunghi e complicati. All’inizio, i “computer” erano

delle persone (incluse le mogli di alcuni scienziati) che usavano calcolatrici da tavolo, ma alla fine del 1943 si cominciò a

far uso di una macchina IBM a schede perforate. Von Neumann volle apprendere personalmente l’uso della macchina. I

calcoli rimanevano però lenti e richiedevano verifiche manuali. Von Neumann, grazie alla sua enorme rete di contatti in

tutto il paese ed all’estero (ad esempio Alan Turing che aveva studiato sotto la sua supervisione a Princeton dal 1936 al

1938), seguiva le continue novità nell’ambito dell’automatizzazione del calcolo e dava consigli per migliorare le

apparecchiature disponibili a Los Alamos. Alla fine della guerra, gli scienziati di Los Alamos usavano i primi computer

elettronici.

2.5 I primi calcolatori

Dagli inizi del 1944 von Neumann era anche responsabile di un contratto di ricerca dell’”Istituto di studi avanzati” (IAS) di

Princeton. Il progetto principale aveva come obiettivo la soluzione di problemi matematici complessi di natura militare;

allo IAS in particolare, fu affidato lo studio di metodi numerici per risolvere i problemi di onde d’urto. Negli ultimi mesi

della guerra questo progetto si estese alla ricerca di metodi per i cosiddetti “calcolatori ad alta velocità”. Sul

“Memorandum sul programma del computer ad alta velocità” pubblicato l’8 novembre 1945, von Neumann evidenziò un

progetto che andava oltre la costruzione del computer: “Dovranno essere fatte delle ulteriori ricerche in parallelo con lo

sviluppo e la costruzione della macchina. Comunque, il lavoro principale dovrà essere fatto quando la macchina sarà

completa e disponibile, usando la macchina stessa come strumento di sperimentazione”.

Von Neumann conosceva tutti i progetti in corso, in particolare quello di George Stibitz (computer con relay

elettromeccanici) e del calcolatore “Mark I” (ASCC) di Howard Aiken, costruito con l’aiuto dell’IBM e poi donato

all’Università di Harvard. “Mark I” fu completato nel 1944 e cominciò a funzionare a pieno ritmo per la marina militare.

Il progetto più importante, ma segreto, era quello di una macchina elettronica in costruzione presso la Scuola Moore di

Ingegneria elettrica dell’Università di Filadelfia, in Pennsylvania; che avrebbe segnato il passaggio definitivo dai

calcolatori ai moderni elaboratori elettronici. Si trattava dell’ENIAC (Electronic Numerator, Integrator, Analyser and

Computer), un progetto iniziato nel 1943 dal Laboratorio di Aberdeen per affrontare i complessi calcoli balistici richiesti

per le tavole di tiro. Quando von Neumann visitò per la prima volta la Scuola Moore, il progetto ENIAC era in fase

12

avanzata. Nel giro di quindici giorni, il progetto del calcolatore fu modificato per permettere la memorizzazione interna del

programma. La programmazione, che fino a quel momento richiedeva una manipolazione diretta ed esterna dei

collegamenti, era così ridotta ad un'operazione dello stesso tipo dell'inserimento dei dati; l'ENIAC diventava la prima

realizzazione della macchina universale inventata da Alan Turing nel 1936: in altre parole, un computer programmabile

nel senso moderno del termine.

Nel frattempo un nuovo modello di computer, l'EDVAC (Electronic Discrete Variable Computer), era in cantiere, e von

Neumann ne assunse la direzione. Proseguì dopo la guerra la sua collaborazione nella realizzazione del calcolatore

EDVAC, delle sue copie in giro per il mondo e in altri sviluppi della tecnologia informatica.

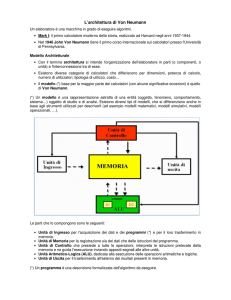

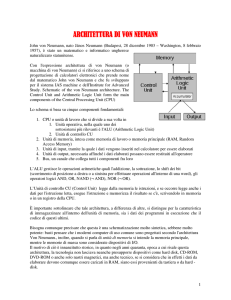

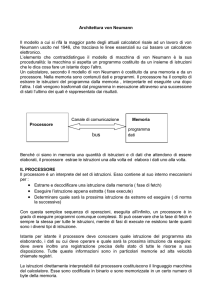

All'”Istituto di studi avanzati” di Princeton, in particolare, egli si dedicò alla progettazione di un nuovo calcolatore,

producendo una serie di lavori che portarono alla definizione di quella che oggi è nota come architettura von Neumann:

in particolare, la distinzione tra memoria primaria (ROM) e secondaria (RAM), e lo stile di programmazione mediante

diagrammi di flusso. Questa macchina fu inaugurata solo nel 1952, con una serie di calcoli per la bomba all'idrogeno, e

fu smantellata nel 1957 a causa dell'opposizione dei membri dell'Istituto, che decisero da allora di bandire ogni

laboratorio sperimentale.

Molti dei lavori di von Neumann non furono pubblicati perché coperti da segreto militare. Nel 1946 fu nominato, in un

contesto non strettamente militare, presidente del “Comitato del calcolo ad alta velocità” del “Comitato nazionale di

ricerca”. Parte dei suoi sforzi era volta all’organizzazione scientifica dell’informatica e delle tecnologie connesse, anche

se, a suo parere, non erano ancora maturi i tempi per fondare una società scientifica che si dedicasse sullo sviluppo dei

calcolatori veloci. Continuò comunque a sviluppare le sinergie tra le potenzialità dei computer e le necessità di soluzioni

computazionali di problemi nucleari.

2.6 L’esperto di fiducia degli organismi militari e governativi

La bomba atomica fu sperimentata con successo nel luglio del 1945, nel deserto del Nuovo Messico. Il nuovo presidente

americano Harry Truman (Roosevelt era morto il 12 aprile 1945) decise di impiegarla contro il Giappone. Il 6 ed il 9

agosto del 1945, le bombe atomiche esplosero sopra Hiroshima e Nagasaki, all'altezza calcolata da von Neumann

affinché esse producessero il maggior danno aggiuntivo. In entrambi i casi le conseguenze furono spaventose: i morti

furono circa 100.000 a Hiroshima e 60.000 a Nagasaki, i sopravvissuti subirono le conseguenze delle radiazioni per un

lungo periodo e le due città furono completamente distrutte. Come testimoniato da Sam Cohen che lavorava a Los

Alamos, la notizia della prima esplosione fu accolta con entusiasmo, con l’orgoglio di chi apprende che ciò che ha

costruito ha funzionato; gli scienziati e l’opinione pubblica, però, non furono informati subito del reale numero di morti

civili che erano stati provocati. La sera del 6 agosto, la BBC aveva annunciato che la bomba era stata sganciata su una

base militare giapponese, e non su una città di 290.000 civili e 43.000 soldati.

L’obiettivo del bombardamento fu raggiunto con la firma dell’armistizio del 2 settembre 1945: si concludeva il secondo

conflitto mondiale. Forse c’erano altri modi per far finire in fretta la guerra, minimizzando le perdite per gli Stati Uniti, ma

sicuramente il comitato di quattro scienziati (Fermi, Compton, Oppenheimer, Lawrence) che doveva consigliare il

governo americano sull’uso delle nuove bombe, non disponeva di tutte le informazioni per prendere una decisione simile.

L’invasione del Giappone era inevitabile, perché così era stato loro detto. Il ricorso alla consulenza di questo comitato è

un esempio dell’influenza degli scienziati sulle scelte politiche; non bisogna però dimenticare che gli scienziati, in questa

situazione, sono anche stati usati dal potere politico in quanto non erano in grado di valutare le possibile alternative al

lancio delle due bombe e molte informazioni furono loro nascoste.

La partecipazione di von Neumann al progetto di Los Alamos non si limitò agli aspetti scientifici, ma ebbe intensi rapporti

con le istanze militari che controllavano il progetto; ad esempio, fece parte del comitato che decise gli aspetti tattici

dell’uso militare della bomba e la localizzazione degli obiettivi giapponesi del bombardamento.

La posizione di von Neumann sull’utilizzo della bomba atomica a Hiroshima e Nagasaki era allineata alle posizioni del

Governo; difese gli interessi e la politica degli Stati Uniti anche nel periodo postbellico.

Il periodo nazista aveva riunito molti scienziati di varie nazionalità attorno al progetto di Los Alamos. Il bombardamento

creò divergenti opinioni nella comunità scientifica. Dopo la guerra, alcuni scienziati, come Oppenheimer, contribuirono

alla politica nucleare americana; altri, come Einstein, iniziarono una campagna pacifista per impedire un ulteriore

sviluppo delle armi atomiche. Si formò anche una Federazione di scienziati americani che si opponevano allo sviluppo

degli armamenti nucleari.

Von Neumann prese fin dall’inizio le distanze dalle iniziative dei suoi colleghi pacifisti ed evitò ogni pronunciamento

pubblico circa l’uso militare dell’energia atomica; affermava che, in quanto esperto, la sua competenza era strettamente

tecnica. Nel luglio del 1946 egli partecipò come osservatore ufficiale ai test atomici realizzati nell’atollo Bikini delle Isole

Marshall nel Pacifico meridionale.

La decisione di Truman di impiegare contro il Giappone la nuova “arma letale” aveva avuto lo scopo di abbreviare il

conflitto, ma aveva avuto anche l’obiettivo di mostrare al mondo, e soprattutto ai sovietici, la potenza militare americana.

Infatti, una volta vinto il nazismo, il nuovo nemico era l’Unione Sovietica. Mentre l’Europa era impegnata nella

ricostruzione, soltanto gli Stati Uniti e l’URSS potevano aspirare a conservare il loro ruolo di potenza mondiale. L’ideale,

almeno ufficialmente, dell'Unione Sovietica era fondato sul principio di una rivoluzione sociale che avrebbe eliminato lo

sfruttamento delle classi povere e realizzato l'uguaglianza e la giustizia sociale. Il messaggio americano era l’espansione

13

della democrazia liberale, in regime di pluralismo politico, di concorrenza economica e di ampia libertà individuale.

In questa situazione, si esprimevano le caratteristiche personali di von Neumann, il suo interesse per l’attività pubblica e

per le relazioni ad alto livello, la capacità non soltanto di dare consigli a livello scientifico-tecnico, ma anche di

collaborare alla macchina esecutiva con una prospettiva politica generale. In particolare egli dimostrava una gran

naturalezza nel rapporto con i militari, che non riusciva sempre facile ad altri scienziati. Il contributo di von Neumann fu

riconosciuto nel 1947, quando ricevette la Medaglia al merito dal Presidente degli Stati Uniti e una decorazione per il

servizio civile prestato nella Marina. In questo modo, fu consolidata la sua posizione di esperto di fiducia degli organismi

militari e governativi.

2.7 Altre armi per la guerra preventiva

Le ricerche proseguivano a Los Alamos, dove si pensava alla costruzione della bomba H o termonucleare. Von

Neumann dimostrò che era possibile fabbricarla e che sarebbe stata efficace.

Dopo il primo test atomico sovietico e l’inizio della guerra di Corea nel 1950, iniziò un’ampia discussione sulla politica

militare orientata a mantenere la supremazia statunitense. Si diffuse l’idea – sostenuta, a quante pare, dallo stesso von

Neumann – di una guerra preventiva. In un articolo pubblicato sulla rivista Life, pubblicato poco dopo la sua morte, si

scrisse che von Neumann affermò: “Se tu dici perché non una bomba domani, io dico, perché non oggi. Se tu dici alle

cinque, io dico perché non all’una”.

La sua teoria dei giochi, ed in particolare la strategia minimax, fu applicata estesamente alla problematica della guerra

preventiva, in particolare nelle analisi strategiche sviluppate dalla RAND Corporation, fondata dall’aviazione nel 1946, e

con la quale von Neumann collaborò sistematicamente dal 1948.

Il Presidente Truman decise di procedere con le ricerche per la bomba H. Von Neumann aveva sostenuto l’idea di

sviluppare un’unica bomba, mente Oppenheimer era più orientato a produrre piccole armi nucleari tattiche. Le ricerche

culminarono con il primo test realizzato nelle Isole Marshall nel 1952. Nello stesso anno, von Neumann ricoprì un posto

vacante nel “Comitato dei consulenti scientifici dell’aviazione”, mentre Oppenheimer cominciò a perdere rapidamente

influenza.

Alla fine del 1952, fu eletto Presidente il generale Eisenhower che aveva dichiarato di voler contenere lo sviluppo degli

armamenti. Paradossalmente si scelse di diminuire le armi convenzionali a favore di quelle atomiche che a minori costi

ottenevano maggiore potenza. La posizione di von Neumann all’interno dell’aviazione non è ben conosciuta, perché

molti dei verbali dei comitati cui partecipava, anche come presidente, sono ancora segreti.

Nel 1953, von Neumann divenne presidente del “Sottocomitato per le armi” e sembra che propugnasse uno sviluppo

senza intralci della tecnologia nucleare, in particolare la produzione di bombe sempre più potenti, la necessità di fare i

test atomici e il perfezionamento dei sistemi di lancio. Nello stesso anno divenne presidente del panel di scienziati sulle

armi nucleari dell’aviazione e del gruppo di valutazione dei missili strategici, conosciuto anche come “ Comitato von

Neumann”. Nel 1954, questo comitato consigliò di dare la massima priorità allo sviluppo di un missile balistico

intercontinentale, il progetto “Atlas”. Questo progetto destava perplessità e opinioni contrastanti, anche legate alle rivalità

tra Esercito che sosteneva lo sviluppo di missili a medio raggio, Marina e Aviazione, quest’ultima da poco costituita in

arma autonoma. Alla fine il progetto fu approvato ed affidato ad una compagnia privata fondata da due ex-membri del

“Comitato von Neumann”, con la quale con Neumann collaborò come consulente. Sotto la sua supervisione si studiò

problemi di traiettoria, problemi di resistenza al calore e la miniaturizzazione dei componenti. Il primo test del missile

Atlas fu realizzato nel 1958 con un lancio di 2500 miglia.

Nel 1954, von Neumann divenne membro del “Comitato tecnico di consulenza sull’energia atomica” del Dipartimento

della Difesa. Raggiunse il vertice della carriera l’anno dopo, quando fu nominato membro della “Commissione

dell’Energia Atomica” (AEC), la massima posizione ufficiale che uno scienziato potesse raggiungere nel Governo

statunitense, diventando lo scienziato con il maggiore potere politico negli Stati Uniti.

2.8 La Big Science

Nel dopoguerra, militari, uomini politici e opinione pubblica erano consapevoli che i risultati della ricerca scientifica, dal

radar alla bomba, erano stati decisivi per l’esito della guerra. Ciò dava agli scienziati un credito indiscusso. Sulla scorta

del prestigio acquisito durante la guerra, ebbero buon gioco nel chiedere risorse e finanziamenti. L’accelerazione

imposta dalle necessità belliche portò alla maturazione del fenomeno della Big Science, l’organizzazione e la

realizzazione di progetti di ricerca che impiegavano capitali su scala mai vista prima. Il “Progetto Manhattan” ne era stato

il prototipo. Dopo l’esperienza di questo progetto scientifico, la potenza di un paese sarebbe dipesa dal grado del suo

progresso scientifico.

Quest’impresa collettiva che portò tra il 1942 ed il 1945 alla costruzione dei primi ordigni nucleari, conciliava la creatività

di gruppo con la rigidità dei vincoli militari. Come illustrato nei paragrafi precedenti, il contributo degli scienziati europei fu

determinante, perché esportarono negli Stati Uniti una cultura ed una tradizione orientate all’organizzazione della

14

creatività collettiva, originata nei centri di ricerca artistica e scientifica del vecchio continente. Le peculiarità organizzative

che erano state sviluppate in questi centri e che furono replicate nel “Progetto Manhattan” furono: interdisciplinarietà,

informalità, stile di leadership carismatico-partecipativo, forte senso di appartenenza alla comunità scientifica.

Trapiantata a Los Alamos, questa cultura fu potenziata dalle enormi disponibilità finanziarie statunitensi, da una struttura

logistica protetta e pensata ad hoc, da una spinta ideologica in cui l’orgoglio scientifico e l’obiettivo patriottico si

esalteranno a vicenda.