Laboratorio di Fisica per Scienze Naturali

1 - Elementi di Statistica e di teoria degli errori

Misura di una grandezza fisica e suo errore

Tipi di misure

Le misure di una grandezza fisica possono venire classificate come:

• misure dirette: la grandezza fisica e’ misurata mediante un confronto con un'altra della stessa

specie, assunta come campione.

Esempio: misura dell’ allungamento di una molla con un regolo graduato (Esperienza 1a)

• misure indirette, la grandezza fisica e’ dedotta da una legge fisica nota y = f(x1, x2,...xm) di cui

alcune xi sono note ed alcune xj sono misurate. Da queste, sostituendone i valori nella legge data,

si ricava la misura di y;

Esempio: misura della costante di elasticità di una molla mediante la misura del periodo di

oscillazione (Esperienza 1b)

• misure con apparecchi tarati. La misura della grandezza si ottiene mediante la lettura della

posizione di un indice su una scala graduata, o di un numero su un quadrante.

Esempio: misura del coefficiente di viscosità di un fluido mediante viscosimetro tarato (Esperienza

2).

In questo caso la misura e’ diretta ma e’ necessaria una taratura spesso complessa dello

strumento

Errori di misura

Quando si effettua una misura, si commette un errore, di cui è desiderabile valutare l'entità.

Errore assoluto. La misura è sempre pensabile come la somma algebrica di un valore "vero" (non

noto) della grandezza e di un errore (errore assoluto) che può modificare il valore della grandezza in

più o in meno.

Pertanto il risultato di ogni misura sperimentale y di una grandezza fisica Y si esprime in generale

come:

y ± ∆y

• y e’ il valore più probabile della grandezza fisica Y

• ∆y e’ l’ errore assoluto di misura e rappresenta l’ incertezza della misura sul valore vero

Il valore della grandezza fisica non e’ pertanto nota, ma si assume che sia compreso nell’ intervallo

di errore.

Errore relativo

E’ il rapporto tra il modulo del rapporto tra l’ errore assoluto e il valore di misura

Errore relativo = |∆y/y|

Rappresenta in modo forse più significativo errore la accuratezza della misura, che, per essere

significativa deve avere un errore relativo <<1 .

L' accuratezza di una misura indica la vicinanza della misura al valore vero della grandezza in

esame. L 'errore assoluto o quello relativo rappresentano pertanto una misura dell'accuratezza

La precisione rappresenta invece l'accordo di una serie di misure fra loro ed è un indice della

riproducibilità di una misura. Non è riferibile ad una misura singola, ma a una serie di misure.

Misure molto precise forniscono dunque dati poco "dispersi"; viceversa una grande dispersione dei

dati indica scarsa precisione del set di misure e quindi del metodo utilizzato per la misurazione.

.

Accuratezza, precisione e sensibilita’

Misure “Vere”

Alta accuratezza

e precisione

Scarsa precisione

Alta accuratezza

Alta precisione

Scarsa accuratezza

La sensibilità di uno strumento o metodo di misura è legata al concetto di minima variazione del

valore della grandezza in esame, apprezzabile con lo strumento stesso. Per quantificare questo

concetto chiamiamo x il valore della grandezza e S il corrispondente "segnale" dato dallo

strumento (p. es: lo spostamento di un indice su una scala).

Sia poi ∆x una piccola variazione di x, a cui corrisponderà un ∆s. La sensibilità può essere definita

come S =∆s/ ∆x; ad esempio, un voltmetro può avere una sensibilità di 1 Volt/mm.

Altre volte ci si esprime invece usando l'inverso, ossia S’ =∆x/ ∆s

Errori sistematici

Nelle misure con strumenti e metodi di elevata sensibilità, se si effettuano misure ripetute si ottengono

valori tutti un po' diversi fra loro: emergono infatti errori casuali o accidentali, eventualmente

sovrapposti a errori sistematici.

Entrambi i tipi di errore influenzano ogni misura in modo non noto.

Gli errori sistematici agiscono sempre nello stesso verso e si verificano per :

Ad esempio: un regolo graduato che ha lo zero un spostato (errore sistematico costante); un'asta che

dovrebbe essere verticale non lo è perfettamente; un regolo graduato è leggermente incurvato, ecc...

Contro gli errori sistematici non si può fare altro che migliorare metodi, strumenti, teorie ed effettuare

misure della stessa grandezza con più metodi diversi, in modo da poterle confrontare criticamente.

Gli errori sistematici in generale influenzano l'accuratezza di una misura.

Errori sistematici

Gli errori accidentali o casuali sono dovuti al verificarsi di varie circostanze che, ripetendo le

misurazioni in condizioni presupposte identiche, agiscono occasionalmente ora in un verso, ora in un

altro, in modo stocastico ossia indefinibile ed imprevedibile.

Generalmente ciò che accade è che fenomeni di vario genere vengono a sovrapporsi in modo

irregolare al fenomeno in esame, influenzando i risultati della misura in maniera incontrollabile.

Esempi: differenze accidentali di temperatura fra le varie parti di uno strumento producono

deformazioni mutevoli...variazioni casuali dell'ambiente esterno, dello stato dell'aria circostante,

dell'illuminazione, ecc., errori di valutazione dello sperimentatore

Gli errori casuali hanno la caratteristica di essere irregolari e per lo più risultanti dalla somma

algebrica di molti errori elementari agenti simultaneamente, con ugual probabilità, in entrambi i versi,

positivo e negativo.

Anche se non c’ è modo di annullarli, e’ possibile minimizzarli con la ripetizione delle misurazioni

e applicando poi i risultati della teoria degli errori (che è una teoria statistico - probabilistica, adatta

appunto agli errori dovuti al caso), in modo da giungere ad affermazioni di questo tipo:

il valore della grandezza (nella unità scelta) si può ritenere compreso nell'intervallo fra x + ∆x e x - ∆x,

dove ∆x è una misura di errore.

Ad esempio:

la lunghezza di un ponte e’ l 300 ± 1 m

ovvero:

la lunghezza del ponete e’ 299 < l < 301 m

Errori casuali

Di solito questa affermazione è accompagnata dalla probabilità con cui il valore "vero" si può

pensare contenuto nell'intervallo dato (livello di fiducia).

Gli errori accidentali influenzano in generale la precisione della misura.

Nella discussione che segue non discuteremo di eventuali errori sistematici e ci occuperemo

unicamente degli errori casuali.

Con strumenti a sensibilità limitata, come certi strumenti tarati a lettura diretta (in cui si legge

sulla graduazione il valore della grandezza), può accadere che ripetendo la misura, si ottenga

sempre lo stesso valore, perché gli errori casuali sono di entità inferiore alla minima variazione

della grandezza apprezzabile con lo strumento stesso.

La variazione minima apprezzabile (ossia l'intervallo minimo leggibile sulla graduazione, che il

costruttore avrà progettato in maniera opportuna), viene assunta come errore della misura.

Concetto statistico di misura

Da quanto detto sugli errori casuali, si deduce che ogni misura (sia x) di una grandezza fisica X (ossia il

risultato di una operazione di misurazione di X) può essere considerata come una variabile casuale, che

ha una probabilità p(x) di assumere, nella data misura, il determinato valore x all’ interno di un insieme di

valori possibili.

La quantità p(x) detta distribuzione di probabilità e’ una funzione che rappresenta la probabilità che la

misura di X sia compresa tra il valore x e x+dx ed ovviamente

∫ p( x)dx = 1

x

dato che l’ integrale rappresenta la probabilità che la misura assuma un valore qualsiasi.

In generale la funzione p(x) e’ diversa a seconda della misura effettuata ed in generale non e’ nota a

priori. E’ tuttavia ragionevole assumere che la probabilità di ottenere una certa misura sia più alta in

prossimità del valore vero e ci aspettiamo pertanto che la distribuzione di probabilità abbia andamenti

come in figura:

p(x)

Distribuzione simmetrica

Distribuzione asimmetrica

Valore

vero

Figura 1 Grafico di due funzioni di distribuzione

x

Distribuzione “normale”

Di particolare importanza la distribuzione “normale” che ha l’ andamento in Figura 2 e e’ rappresentata dalla

funzione matematica :

La distribuzione ha un andamento simmetrico, un picco per x = µ

una larghezza a semi ampiezza σ e

+∞

∫ p( x)dx = 1

−∞

La “dispersione” della funzione di distribuzione e’ pertanto

proporzionale a σ.

Si può dimostrare che questa distribuzione di probabilità

rappresenta accuratamente la distribuzione degli errori casuali in

insiemi molto grandi di misure.

Figura 2 Distribuzione gaussiana

Parametri medi di insiemi di dati

Le proprietà insiemi di misura sono descrivibili in termini di parametri medi sull'insieme; i più semplici

di queste

• il valor medio della distribuzione

= ∫ x ⋅ p ( x)dx

• la varianza della distribuzione pari alla media dei quadrati degli scarti dalla media.

_

= ∫ ( x − x) 2 ⋅ p( x)dx

La quantità σx , radice quadrata della varianza è detto scarto quadratico medio o deviazione

standard.

Per una distribuzione normale,

• il valor medio della distribuzione rappresenta il

valore più probabile della variabile misurata

• lo scarto quadratico medio della distribuzione

fornisce un’ indicazione sulla probabilità che il valor

medio si trovi entro un certo scarto dal valor vero. In

particolare questa probabilità e’

• il 68% per σx

• il 95% per 2σx

• il 99% per 3σx

Media e varianza empirica

La media empirica è essa stessa una variabile casuale ed è tale che il suo valor medio coincide

col valor medio di x:

La varianza della x risulta essere

Per cui la varianza della media empirica risulta essere:

e la deviazione standard della media empirica è

pertanto

se N è grande.

Media e varianza empirica di misure ripetute

Il calcolo di questo tipo di medie richiede la conoscenza delle leggi della probabilità associate alla

variabile casuale che si misura; in particolare per calcolare valor medio e varianza occorre conoscere la

funzione p(x) che esprime la probabilità che un dato valore tra x - x+ dx si verifichi.

Nella pratica normalmente queste leggi non sono note; si pone cosi il problema di stimare empiricamente

le medie stesse, ossia determinarne dei valori plausibili mediante le informazioni di cui si dispone.

Se dall'insieme dei valori possibili di x si traggono N valori (cosa fattibile effettuando N misure xi) si può,

definire la quantità

che è detta media empirica, ed assumere come errore assoluto associato alla singola misura la

deviazione standard empirica :

sx

Assumendo che gli errori di misura seguano una distribuzione normale, si può assumere che il 68% delle

misure siano all’ interno di una deviazione standard dalla media.

Il parametro utilizzato come stima dell’ errore associato al valor medio di una misura e’ lo scarto

quadratico medio rispetto alla media, che si può dimostrare vale:

N

s_ =

x

_

∑ ( x − x)

i

1

N ( N − 1)

2

Frequenza assoluta e relativa di misure ripetute

N

sx =

_

∑ ( x − x)

i

1

N −1

2

=

N

_

∑ f ( x − x)

i

1

i

2

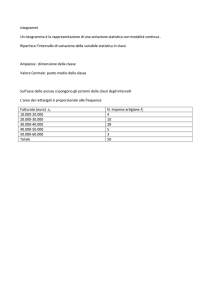

Istogramma delle frequenze di misure ripetute

Un istogramma ad intervalli e’ un grafico che rappresenta la frequenza di ripetizione di misure che

cadono nello stesso intervallo.. Ad esempio le età di un gruppo di 346 persone si distribuiscono come

mostrato in tabella, l’ istogramma delle frequenze e’ mostrato in figura

0.318

0.265

0.159

0.106

0.053

0.

Frequenze relative

0.212

Istogramma delle densità di frequenze

L’ istogramma delle densità di frequenze e’ pertanto direttamente confrontabile con una

funzione di distribuzione di probabilità normalizzata a 1

L’ istogramma della diapositiva precedente e’ un istogramma delle densita’ di

frequenze, dato che che si e’ scelto un intervallo δx = 1 (anno)

Costruzione di un istogramma

1.

Ottenuto un insieme di N misure x1, x2, ….. xN, calcolare l’ intervallo massimo di dispersione dei dati

δx = xmax – xmin

2.

Scegliere l’ intervallo dell’ istogramma ∆x (bin) dividendo l’ intervallo massimo per un numero intero

n. Come regola indicativa:

n≈2 N

per N >100

n ≈ 10 ⋅ log N

per N < 100

3. Calcolare e graficare le densità di frequenza di

ciascun intervallo Fi= fi/δx in modo da ottenere una

distribuzione sperimentale di frequenze normalizzata a 1

_

4. Calcolare il valor medio x e lo scarto quadratico

medio σx della distribuzione ed indicarlo sul grafico

_

5. Utilizzando i valori x e σx calcolare e graficare la

funzione di distribuzione normale relativa ai dati. Se i dati

sono stati correttamente normalizzati il risultato finale

dovrebbe apparire come in figura.

Costruzione di un istogramma

Si fa notare l’ approssimazione di un istogramma alla funzione di distribuzione e’ tanto migliore quanto

e’ maggiore il numero di dati (Figura 1).

Una “statistica povera” e’ in generale motivo di una scarso fit alla funzione di distribuzione (Figura 2).

Effetti come in Figura 2 possono anche suggerire la presenza di un errore sistematico nelle misure,

che provocano la dispersione dei dati in due picchi adiacenti.

Figura 1

Figura 2

Ricerca di leggi empiriche (Massima verosimiglianza)

Si consideri un fenomeno che determina una corrispondenza fra una variabile x ed una variabile y.

Se si riportano le misure (xi,yi) su un diagramma cartesiano x-y si ottiene un grafico come in Figura

1. La curva sperimentale non e’ una curva continua ma una sequenza di punti Pi (xi,yi).

Si vuole determinare una espressione analitica y= f(x) che meglio approssima i dati (best fit).

Ad esempio, nella 1a esperienza del Laboratorio il risultato della misura può essere rappresentato

dal grafico

x =

i

10

19

28

37

46

55

64

73

82

91

100

y =

i

0

0.1

0.2

0.33

0.41

0.59

0.58

0.7

0.83

0.87

1

1

0.8

0.6

yi

0.4

0.2

0

0

0

10

20

40

60

xi

80

100

100

che suggerisce una dipendenza del tipo y = a0+a1x tra le due variabili. Il problema e’ dunque di

determinare le costanti a0 e a1 per il best fit.

Ricerca di leggi empiriche (Massima verosimiglianza)

Si puo’ dimostrare che la curva che meglio approssima i dati sperimentali e quella i cui parametri a0 e a1

rendono minima la quantità :

N

S = ∑ [ y i − (a0 + a1 xi )]2

1)

i =1

Perché questo avvenga e’ necessario che

N

∂S

= ∑ 2[ yi - (a0 + a1 x)] = 0

∂a0 i =1

N

∂S

= ∑ 2[ yi - (a0 + a1 xi )]x i = 0

∂a1 i =1

N

N

i =1

i =1

Na0 + a1 ∑ xi − ∑ yi = 0

N

2)

N

a0 + a1 ∑ xi − ∑ xi yi = 0

2

i =1

i =1

che e’ un sistema di due equazioni in due incognite a0 ed a1 con soluzione:

N

N

N

N

2

y⋅

x

−

x

⋅

x

⋅

y

(

)

(

)

i

i

i

i

i

i=0

i=0

i=0

i=0

a0 :=

2

N

N

x 2 −

( N + 1) ⋅

x

i

( i)

i=0

i = 0

∑ ∑

∑ ∑

∑

∑

N

N

N

( N + 1) ⋅

x

⋅

y

−

x

⋅

y

(

)

(

)

i

i

i

i

i=0

i=0

i=0

a1 :=

2

N

N

x 2 −

( N + 1) ⋅

x

i

( i)

i=0

i = 0

∑

∑ ∑

∑

∑

3)

Ricerca di leggi empiriche (Massima verosimiglianza)

Utilizzando i dati precedenti e le 3) si ottiene:

a0 = −0.107

a1 = 0.429

e la retta di massima verosimiglianza z = a0+a1x

che e’ confrontata con i dati in figura

1.2

1.005

1

0.8

yi

0.6

zi

0.4

0.2

0

0

0

10

20

40

60

xi

80

100

100