APPUNTI E COMPLEMENTI DI STATISTICA

STATISTICA MONOVARIATA

La statistica, in quanto studio delle proprietà e caratteristiche di individui (detti anche unità statistiche) cioè

elementi di generiche popolazioni statistiche (o totalità o collettività o universi, i tre termini sono del tutto

intercambiabili) può facilmente interpretarsi come una parte della teoria degli insiemi finiti.

Diciamo subito che non tutti i diversi testi o manuali presentano la stessa terminologia e gli stessi schemi,

anche se le considerazioni e i risultati fondamentali ovviamente coincidono.

Nel caso più generale di statistica monovariata, fissato l’universo U, supponiamo di introdurre in esso una

semplice partizione: U = A1 A2 … A k dipendente da un solo indice i che varia da 1 a k.

Supponiamo cioè che l’universo sia l’unione insiemistica di di un certo numero k di sottoinsiemi A i disgiunti,

privi quindi di elementi comuni (A i A j = , i j; 1< i, j < k). Se è noto il numero N degli individui di U

( spesso non è affatto grande) e così pure il numero F i (1< i < k) di ciascuno dei suoi sottoinsiemi A i, diremo

che F1, F 2 …F k sono le frequenze assolute di A 1, … A k (e Fk / N = f k quelle relative) degli A k rispetto ad U.

Così ad es. se un’urna contiene 20 palline di cui 5 bianche, 10 rosse, 4 verdi e 1azzurra, essendo allora

U le palline dell’urna, A1 quelle bianche ecc. diremo che 5, 10, 4 e 1 sono le rispettive frequenze assolute,

mentre f 1 = 25% , f 2 = 50%, f 3 = 20% , f 4 = 5% sono le relative. Vale quindi: F1+…+ Fk = N; f 1 + … + f k = 1.

Le stesse considerazioni continuerebbero evidentemente ad essere proposte se invece del colore fosse il

peso a distinguere le 20 palline, sapendo ad es. che 5 sono di sughero, 10 di legno, 4 di vetro e 1 metallica

oppure, in base a informazioni più precise, conoscendo ad es. che cinque palline pesano 60 g, dieci 70g,

quattro 80 e l’ultima 100g o ancora – essendo com’è noto ogni misura affetta da errori casuali –

se fossimo solo in grado di affermare che le prime cinque hanno un peso compreso tra 60 g (valore incluso)

e 70 g (valore escluso), 10 tra 70 g (incluso) e 80 g (escluso), 4 tra 80 g (incluso) e 100 g (escluso) mentre

l’ultima pesa da 100 g (incluso) in su.

Come si può osservare ciascuno dei quattro esempi proposti presentano situazioni concettualmente diverse

tra loro. Se infatti nel primo caso i quattro gruppi di palline sono distinti tra loro da una caratteristica (nella

fattispecie il colore) che non permette di aggiungere ulteriori valutazioni, nel secondo è implicito che il peso

cresce progressivamente dalle prime cinque all’ultima. Nel terzo caso vengono invece proposte misure

(intensità del peso ora considerato) che forse, non apparendo così precise e sicure in un successivo riesame

della questione, vengono poi raggruppate in quattro intervalli (semiaperti) di misura, o come anche si dice

quattro diverse classi, che come illustra l’ultimo esempio non necessariamente devono avere la stessa

ampiezza (la prima e l’ultima, come nell’es., possono infatti essere addirittura illimitate, inferiormente la

prima, superiormente l’ultima). E’ quindi opportuno distinguere, come ora faremo, le diverse situazioni.

Osserviamo infine che un esame più preciso e sistematico dei problemi statistici, com’è in genere affrontato

nei testi più approfonditi, richiederebbe il passaggio - mediante opportune funzioni, cioè scale di musura o

anche soltanto di valutazione (si pensi ai voti scolastici) - dai singoli universi empirici fatti di cose concrete

(oggetti materiali, persone, animali ecc.) o anche astratte (città, nazioni, scuole, parole di una lingua ecc.),

entità comunque troppo varie e quindi tra loro non confrontabili, a un universo numerico intermedio fatto di

variabili numeriche, misure vere o anche gradi convenzionali (come nella scala Mercalli dei terremoti o nella

scala Mohr per le durezze dei minerali, al limite indicando con 1 una proprietà presente, con 0 la mancante).

Quest’ultimo universo, modello generale di tutti i singoli eterogenei insiemi prima considerati, dovrebbe

essere l’oggetto U dell’analisi statistica, chiaro esempio di un mai tramontato pitagorismo e platonismo

matematico. Di certo, a prescindere dalle diverse opinioni filosofiche di fondo, questo modo di procedere

offrirebbe indubbi vantaggi e maggiori possibilità di schematizzazione e confronto, a prezzo però di una

minore incisività di approccio e semplicità espositiva. Per queste ragioni e per gli ovvi limiti di questi pochi

ed essenziali appunti preferiamo procedere in modo meno rigoroso ma più efficace ed immediato.

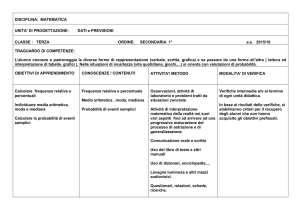

Accenniamo infine, ma molto brevemente, ad altri aspetti non meno importanti delle indagini statistiche ma

più che altro metodologici. Essi riguardano preliminarmente gli obbiettivi dell’indagine e le ipotesi che si

intendono verificare ma soprattutto risulta rilevante la distinzione tra i rilevamenti totali, eseguiti cioè

sull’intera popolazione - in genere pubblici, periodici e regolari, quali ad es. i censimenti - e quelli cosiddetti

“a campione”, aventi per oggetto solo una parte ridotta ma il più possibile significativa dell’universo da

esaminare, prevalentemente saltuari e occasionali e condotti da agenzie private (indagini di mercato o di

opinione, proiezioni elettorali ecc.), sempre più importanti e diffuse, anche perché più rapide e incisive.

Aggiungiamo ancora che lo strumento fondamentale di elaborazione dei dati successivi allla loro raccolta

(il cosidddetto “spoglio”) nel caso delle statistiche monovariate è sempre la tabella semplice, quella che

presenta cioè due colonne (o righe). Nella prima si riportano le successive modalità (o singole misure, dette

allora intensità, come nel 3° esempio) oppure le loro classi quando le misure variano con continuità; nella

seconda invece sempre e soltanto le relative loro frequenze. Le tabelle semplici vengono anche chiamate

serie statistiche quando le modalità non presentano classi, seriazioni quando le classi si presentano.

DISTRIBUZIONI CON VARIABILI CATEGORIALI: SERIE SCONNESSE DI FREQUENZE

E’ questa la situazione più semplice che può presentarsi

quando l’insieme universo U considerato è descrivibile

solo in base alle k modalità che una certa variabile ora

di tipo categoriale – cioè un certo carattere o argomento

o attributo A (i termini vanno considerati sinonimi) di natura puramente qualitativa manifesta.

Frequenze assolute

DIAGRAMMA A BARRE CATEGORIALE

12

10

8

6

Serie1

4

2

0

Bianche

Rosse

Verdi

Azzurre

Modalità (colori)

AREOGRAMMA (O DIAGRAMMA TORTA)

5%

20%

25%

Bianche

Rosse

Verdi

Azzurre

50%

SERIE SEMPLICE (SCONNESSA)

modalità

Bianche

Rosse MODA

Verdi

Azzurre

Distribuzione con

variabile di tipo

categoriale

Frequenze

5

10

4

1

Valori delle

frequenze

corrispondenti

L’es. tipico è appunto il 1° dei precedenti, quello

dell’urna con palline di diverso colore: A è in

caso il colore e k= 4 sono le modalità presentate.

Si parla allora di distribuzioni, tabelle, variabili,

serie ecc. di tipo categoriale e l’unico indice

statistico (o operatore di tendenza centrale) è la

moda, cioè la modalità che presenta la massima

frequenza, sempre che ce ne sia una sola. Se

sono due la distribuzione è detta bimodale o

multimodale se sono più di due (ma se, tutte le

modalità o quasi avessero la stessa frequenza,

più che chiamarla multimodale si dovrebbe dire

che la moda è in tal caso assente.

Nel nostro es. la moda è la modalità “ rosso”.

La presentazione dei dati complessivi consiste

semplicemente nell’elencare nelle successive

righe di una tabella a due colonne le diverse

modalità e a fianco le loro relative frequenze.

Per quanto riguarda poi la rappresentazione, in

genere si utilizzano diagrammi a barre - cioè a

colonne sconnesse essendo la collocazione delle

colonne sull’asse delle x del tutto convenzionale o anche con diagrammi circolari (aerogrammi),

i cosiddetti diagrammi “a torta”.

Si veda in proposito i due fogli del programma in

Excel (con dati e categorie già predisposti ma

sostituibili) proposto nella 1° parte di questo sito.

DISTRIBUZIONI CON VARIABILI ORDINALI: SERIE ORDINATE

Se le diverse modalità, pur rimanendo sempre soltanto di tipo qualitativo come nel 2° es., possono però

elencarsi secondo un certo ordine (crescente o decrescente non fa differenza) si parla allora di distribuzioni,

tabelle, variabili, statistiche ecc. di tipo ordinale. Come nel caso precedente si può ancora parlare di moda,

ma ora si può aggiungere un secondo possibile indice (di tendenza centrale), la mediana.

Disposte infatti gli N casi – che inizialmente supponiamo in ordine dispari - in ordine non decrescente (cioè

secondo modalità crescenti o eventualmente ripetute se ci sono casi con modalità uguali) la mediana è per

definizione la modalità che occupa la posizione centrale, cioè il posto (N –1) / 2. Se invece N è pari, come

per la moda viene a mancare l’esistenza di un’unica mediana, anche se in questo caso, a differenza della

moda, essa semplicemente si sdoppia nei due valori centrali oltretutto affiancati. Se le modalità sono di tipo

numerico (o cardinale, come chiariremo meglio tra poco) la media unica può essere recuperata convenendo

in tal caso di assumere come mediana la media aritmetica tra i due valori centrali, di posto N/2 e N/2 +1.

Nell’es. delle biglie, 20 in tutto, la 10° e la 11° partendo da quelle di sughero, sono di legno, che ora risulta

essere sia moda che mediana.

Le due informazioni si desumono facilmente dal solito diagramma a barre, ora certamente il più utile, se in

esso si riportano due serie di barre: le frequenze semplici (serie 1) e quelle cumulate (serie 2). L’altezza

massima della colonna azzurra individua la MODA, la 1° colonna che supera 10 (metà di N =20, valore pari;

se fosse N = 21 sarebbe la prima che raggiunge (N-1)/2 + 1 = 11), individua invece la MEDIANA.

DIAGRAMMA A BARRE DI SERIE ORDINATA

Modalità ordinate

frequenze frequenze

semplici cumulate

sughero

5

5

Legno MEDIANA, MODA

10

15

vetro

4

19

metallo

1

20

freq. semplici e cumulate

SERIE SEMPLICE ORDINATA

25

15

15

10

20

19

20

Serie1

10

Serie2

5

5

4

5

1

0

sughero

legno

vetro

metallo

scala ordinata (dei materiali)

Distribuzione con

variabile di tipo

ordinale

Valori delle

frequenze

corrispondenti

Si noti come nel titolo del grafico si parla di diagramma a barre (com’è in figura) o anche di istogramma.

Ciò è dovuto al fatto che, essendo ora le modalità delle variabile ordinate, quindi non più del tutto sconnesse

tra loro, il diagramma utilizzato può essere anche a colonne accostate, un istogramma appunto.

OSSERVAZIONE IMPORTANTE: a condizione che le basi di ciascun rettangolo siano di uguale larghezza –

ma ovviamente, per le variabili categoriali sconnesse così come per le ordinate non c’è motivo di procedere

in modo diverso - la frequenza è sempre proporzionale sia all’altezza sia all’area dei rettangoli. Quando

però, a causa delle diverse possibili ampiezze delle varie classi (come vedremo subito con le seriazioni), le

basi dei rettangoli non saranno più necessariamente le stesse, la doppia proporzionalità non sarà più valida

in generale e la frequenza dovrà sempre e soltanto intendersi proporzionale all’area dei rettangoli (e quindi

anche alla loro altezza solo se le basi son tutte uguali, cioè se il diagramma a barre diventa un ortogramma).

DISTRIBUZIONI CON VARIABILI CARDINALI (NUMERICHE): SERIAZIONI DI FREQUENZE

In queste distribuzioni la variabile non è più soltanto qualitativa, magari ordinata, ma è ora quantitativa, cioè

espressa da un numero, valore della suddetta variabile, che a seconda dei casi può essere solo intero (in

genere positivo) o decimale finito - eventuali valori perodici o irrazionali in statistica vengono sempre

ovviamente approssimati con decimali finiti – che sostanzialmente può intendersi come una misura di una

corrispondente grandezza. Sono quindi variabili cardinali tutte le diverse misure di grandezze geometriche:

lunghezze e distanze di varia entità e natura, ampiezze angolari, aree, volumi; scientifiche in generale, a

cominciare da quelle fisiche: tempo e durate (quindi anche età), velocità e accelerazione, massa, peso e

forze di vario tipo, temperatura e calore, energia e lavoro in generale, misure elettriche (corrente, potenziale,

resistenza ecc.), ottiche o acustiche (frequenze, intensità luminose o sonore ecc.); dati numerici di tipo

chimico- biologico (pH, durezza di un’acqua, livelli vari di glicemia, azotemia ecc) o di natura psicologica (ad

es. il QI). Altre variabili cardinali sono inoltre quelle economiche (prezzi, interessi e sconti, quotazioni di

borsa ecc.), quelle più recenti in campo informatico (bit, byte ecc.).

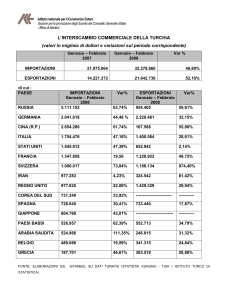

Spesso però si tratta di numeri e quantità di vario tipo inerenti dati demografici che quando non sono indicati

in percentuale (ad es.% di voti elettorali, di incremento demografico ecc.) riguardano dati che possono

essere espressi solo con numeri interi, siano essi relativi a persone (ad es. figli, fratelli di un singolo

individuo), cose (case, auto ecc.) oppure numero di dipendenti di un’impresa, ad es. di trasporti, o dei suoi

automezzi o ancora il numero di agenzie di una data banca, dei suoi clienti e così via) e quindi a rigore non

ammetterebbero quei calcoli e manipolazioni che a partire dalla semplice media aritmetica portano a risultati

in genere decimali.

Per quanto siamo ormai abituati a certe forzature statistiche (come quando si dice che ci sono in media 1,3

figli per coppia) questo non significa però che ogni variabile numerica possa considerarsi cardinale. Se ad

es. si valuta con un sondaggio tra “sommeiller” la qualità del vino prodotto in Italia a partire dal 1990 a oggi,

mentre non ci sono problemi a individuare gli anni moda e mediana in base alle preferenze espresse, non ha

invece alcun senso dire che la media degli anni è ad es. il 1998,25.

L’anno di produzione, o meglio l’annata, è in questo caso non una variabile di tipo temporale ma una

semplice etichetta che permette di fare distinzioni, sia pure in modo non soltanto categoriale ma ordinale.

Possiamo pertanto concludere affermando che una variabile numerica diventa di tipo cardinale solamente

quando permette di ricavare dalla sua distribuzione di valori oltre a moda e mediana – le cosiddette medie di

posizione o medie lasche (cioè fiacche, pigre, così chiamate proprio perché non richiedono calcoli

matematici sui dati in possesso ma soltanto conteggi sulle loro relative frequenze) - altri indici di valutazione

che ora giustamente possono chiamarsi “valori medi” o più semplicemente “medie” o più esattamente medie

algebriche (in quanto diversamente dalle precedenti chedono calcoli su dati quantitativi prima mancanti).

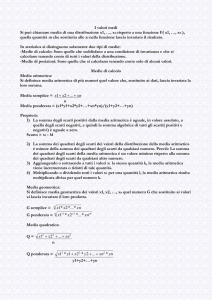

Tali medie sono tradizionalmente quattro e cioè: 1) la media aritmetica 2) la media armonica 3) la media

geometrica 4) la media quadratica. Di esse avremo modo di parlare più avanti. Per ora ci occuperemo della

più semplice, ma anche più importante e nota, nonché modello formale di tutte le altre: la media aritmetica,

media per eccellenza proprio per il suo immediato significato redistributivo ed equiparativo.

A prescindere dalle medie e più in generale dai vari indici statistici, possiamo comunque affermare che,

proprio per le loro caratteristiche numeriche, le variabili cardinali sono quelle in cui le diverse modalità del

carattere considerato – modalità dette ora valori – sono espresse da due dati statistici, cioè da due numeri:

uno è la solita frequenza (numero quindi sempre intero) associata a quel valore, l’altro è il valore stesso,

valore (in genere una misura decimale) che come dicono gli statistici – con un certo eccesso lessicale che

alla lunga rischia di creare ridondanza se non confusione – costituisce l’intensità del carattere in oggetto.

Passiamo ora ad esaminare le rappresentazioni grafiche più importanti per le seriazioni di variabili cardinali,

prima gli istogrammi e poi i diagrammi cartesiani di tipo X,Y. Riprendiamo al solito l’es. iniziale nel 4° caso.

SERIAZIONE (CON CLASSI

DI DIVERSA AMPIEZZA)

classi di

intensità

< 60

60 < p < 70

70 < p < 80

80< p <100

100<p<120

frequenze

0

5

10

4

1

Come già si è detto, nel diagramma a barre diventato ora un istogramma (cioè a rettangoli accostati) le

diverse frequenze di intensità (non singole intensità, sarebbero troppe, addirittura infinite, quando tali valori

variassero con continuità, come in genere accade) suddivise in un certo numero di classi in genere di

diversa ampiezza, risultano sempre proporzionali alle aree dei rettangoli, diventando anche proporzionali alle

loro altezze solo se tutte le ampiezze sono uguali, solo cioè quando l’istogramma è anche un ortogramma.

Tutto questo è chiaramente evidenziato nella prima figura, dove le classi di diversa ampiezza sono 6.

Se poi gli istogrammi diventano ortogrammi, oltre a presentare le altezze dei rettangoli proporzionali alle

frequenze, il diagramma presenta altre significative proprietà che subito anticipano i diagrammi cartesiani.

Unendo infatti i punti medi delle basi superiori dei successivi rettangoli dopo aver aggiunto ad essi due

rettangoli degeneri di altezza nulla (vedi figura successiva) si ottiene una poligonale detta poligono delle

frequenze che come facilmente si verifica ha la stessa area dell’istogramma iniziale.

Tale poligono equivalente può inoltre considerarsi un diagramma cartesiano in quanto associa ad ogni

valore centrale di ciascuna classe di intensità la frequenza complessiva della classe stessa. Chiaramente

poi il poligono si approssima progressivamente a una curva al decrescere della larghezza dei rettangoli.

Vediamo ora, a partire dagli istogrammi e diagrammi cartesiani connessi – proprio per la loro immediatezza

e semplicità espressiva – di avviare alcune considerazioni sul fondamentale rapporto tra statistica e calcolo

delle probabilità, rapporto ovviamente indipendente dagli strumenti

rappresentativi quali sono appunto i grafici.

Supponiamo infatti che le altezze dei vari rettangoli siano

proporzionali non semplicemente ad F1, F2, … Fk ma invece

a f1 , f2 , … fk (dove fi = Fi /N; in pratica non cambia nulla, basta

supporre di cambiare unità di misura sull’asse Y), ricordando

che f1 + f2 + … + fk = 1, l’area dell’istogramma e quindi anche del

poligono ad esso equivalente diventa 1 quale che sia n.

Ricordando che è sempre 1 la probabilità totale di più eventi tra

loro alternativi e complementari, essendo allora certo che uno e

uno soltanto di essi sempre si verifica (nei nostri es.iniziali è certo

che una pallina estratta a caso dall’urna sarà bianca o rossa o

verde oppure azzurra, non essendocene altre di diverso colore e

così pure sarà o di sughero o di legno o di vetro o di metallo),

basta ora ammettere che la probabilità p di un certo evento sia il

valore a cui tende la sua frequenza F/ N relativa quando il numero

totale n dei casi considerati tende a crescere indefinitamente

(è questa la cosidetta concezione frequentista della probabilità,

quella che meglio si presta al suo uso in statistica) per riconoscere

che le nostre diverse frequenze –quando N è un valore sufficientemente grande o comunque statisticamente

rilevante - altro non sono che valori approssimati delle corrispondenti probabilità.

L’istogramma o meglio ancora il diagramma cartesiano diventano allora il grafico della distribuzione di

probabilità di quella che cessa di essere la semplice modalità, qualitativa o quantitativa che sia, di un certo

carattere esterno (in genere del tutto empirico) e assume invece un nuovo ed autonomo significato come

modello matematico degli eventi non deterministici: la variabile casuale.

Vediamo di approfondire quanto appena detto a partire da uno dei concetti fondamentali delle variabili

cardinali, quello della media aritmetica, che diventerà in ambito probabilistico la non meno fondamentale

nozione di valor medio di una variabile casuale.

LA MEDIA ARITMETICA

L’idea di media aritmetica, una delle più semplici e spontanee (a cominciare da quella dei voti scolastici) e

strettamente connessa a quella di misura di una grandezza – specialmente quando la grandezza varia con

continuità – nasce dall’idea non meno fondamentale di errore accidentale insito nella nozione stessa di

misura, ogniqualvolta essa avvenga in forma sufficientemente precisa e accurata dal punto di vista operativo

e metodologico. L’errore accidentale, a differenza di quello sistematico, pressoché costante e sempre con gli

stessi effetti, è a sua volta riconducibile alla presenza di uno o più disturbi che modificano sia pur di poco e

in modo del tutto imprevedibile il manifestarsi di un fenomeno di per sé regolare e sistematico dando luogo

ad una ineliminabile incertezza, quella che nel piano cartesiano ci fa passare da un punto a un rettangolino.

Quali che siano le cause dell’errore accidentale o la natura dei disturbi è comunque implicita in tali nozioni la

convinzione che i loro effetti - a volte accrescendo la misura, a volte diminuendola – tendano alla lunga a

compensarsi, anche se non si può mai dire quando e come (altrimenti l’incertezza sarebbe eliminata).

Come vedremo la media aritmetica, per come viene introdotta, compensa sempre esattamente gli scarti,

cioè gli scostamenti con segno, da tutti i singoli valori a partire dai quali viene calcolata.

x1+ x2 + ….+ xN

1

N

Si definisce infatti media aritmetica di N valori x1, … xN il numero: M(x) = ------------------- = --- x i,

N

N

1

dove le variabili x1, … xN (in genere reali qualsiasi), possono essere in particolare tutte distinte o almeno in

parte coincidenti tra loro. Nel primo caso si parla di media semplice, nel secondo di media ponderata. Se ad

es. risulta x1= 2; x2 =x3 = 4; x4 = 1; x5 = x6 = x7 = 9; x8 = 0, essendo k= 5 con F1=1; F2 = 2; F3= 1; F4 = 3; F5 = 1

si avrà:

2+4+4+1+9+9+9+0

2 1 + 4 2 + 1 1 + 9 3 + 0 1

38

(1; 2; 1; 3; 1 sono risp.

M(x) = ---------------------------------------- = -------------------------------------- = ------ = 4,75 i pesi di: 2; 4; 1; 9 ; 0).

8

1+2+1+3+1

8i

x1 F1+ x2 F2+ ….+ x k Fk

Vale sempre perciò la formula: M(x) = ------------------------------ = x1 f1+ …+ x k f k ( essendo F1+ ...+ Fk = N)

F1+ F2 + …+ Fk

che coincide con quella iniziale se tutti i valori sono distinti, avendosi allora k = N e F 1= F2 = ….= FN = 1.

Osserviamo subito che alla formula statistica della media aritmetica: M(x) = x 1 f1+ …+ x k f k corrisponde,

come poi si vedrà, l’analoga formula del valor medio M(x) = x1 p1+ …+ x k p k di una variabile causale x che

presenta k possibili valori x1, …xk aventi rispettivamente probabilità p1, … pk.

E’ opportuno considerare il significato della media quando i numeri corrispondono alle coordinate di N punti

P1(x1; y1), P2(x2; y2), … PN(xN; yN), del piano cartesiano. Se sia gli xi, sia gli yi sono valori distinti, il punto di

coordinate ( M(x); M(y) ) è il baricentro geometrico G dei punti P 1, P2, … PN . Se ad es. N = 3, G è proprio il

baricentro del triangolo P1P2P3, punto di intersezione delle mediane, e ovviamente G diventa il punto medio

di P1P2 quando N =2. Se invece alcuni valori coincidono – in genere tra gli yi, come spesso accade quando i

punti P1, P2, … PN individuano una funzione – il baricentro va inteso come in fisica, dove i k pesi F1, … Fk

vengono sostituiti da k masse puntiformi posizionate in P1, P2, Pk ; se ad es. è N = 4 con P1(1,5); P2(2, 1);

P3(4,5) ; P4 (9,5) risulta G(4, 4), quindi un punto più vicino alla retta y = 5 (sulla quale sono allineati P1,P3,P4)

che non a P2 , essendo ora per le y: k=2, F1 =3; F2 = 1.

Vediamo ora le proprietà fondamentali della media aritmetica, valide in generale anche quando la statistica

non è semplicemente monovariata, quelle di linearità rispetto alla somma e al prodotto. Valgono infatti:

1) M(x+ y) = M(x) + M(y) ; 2) M(ax) = aM(x) o mettendole insieme: 3) M(ax+ by) = aM(x) + bM(y), a, bR

La loro verifica è immediata sostituendo nella definizione iniziale ogni x i con (xi+yi) o con axi. Solo così vanno

intese le due proprietà: se ogni valore di cui va calcolata la media è somma di altri due (o prodotto per una

costante), anche la media diventa la somma delle due medie separate (o prodotto per la costante).

In altre parole la prima proprietà è assicurata solo se il numero totale dei valori (contando cioè i casi ripetuti)

delle due variabili è lo stesso oppure – usando la seconda definizione M(x) = x1 f1+ …+ x k f k - solo se k non

soltanto è lo stesso ma ogni frequenza relativa fi resta invariata passando dagli xi agli yi.

La media complessiva MTOT di N valori con altri M (M N) non solo non coincide (in generale) con la somma

delle due medie separate ma neppure con la media M’ delle due medie, come risulta dall’es. seguente :

x1=1; x2 =2; x3 =3; x4 =4; y1=1; y2 =2; y3 =3; x4 =4; y5 =5 => M(x) = 2,5 ;M(y) = 3; MTOT = 2,125 ; M’=2,75.

Se invece x1, … xM ; y1, … yN sono due serie di valori numerici e vale M=N, oltre a M(x+ y) = M(x) + M(y)

x1+…+ xN + y1 +…+ yN

risulta: -------------------------------- = MTOT = ½ M(x+y) = ½ [ M(x)+M(y)] = M’ => MTOT = M’ = ½ M(x+y) .

2N

Così ad es.: x1=1; x2 =2; x3 =3; x4 =4; y1=2; y2 =3; y3 =3; x4 =4 => M(x) = 2,5 ;M(y) = 3; MTOT = M’ = 2,75.

Dalle combinazione delle due proprietà della media aritmetica deriva una sua fondamentale caratteristica.

La media aritmetica di x1, …, xN è infatti quel numero m che annulla la somma S degli scarti (xi – m):

S = (x1-m) + (x2-m) + …+ (xN -m) = 0 m = M(x) |S| è quindi minimo per m =M(x) M [x – M(x)] = 0.

Detto in modo più chiaro e preciso quanto appena scritto in formule, ciò significa che, dati comunque N valori

arbitrari x1,…, xN , esiste sempre uno e un solo valore m che annulla la somma S degli scarti (ovviamente

ognuno di essi preso con segno) da esso. Ciò significa che S in valore assoluto diventa minimo per m= M(x)

e inoltre comporta– com’è immediato verificare – che la media aritmetica non degli x1,…, xN ma dei loro

scarti dalla loro media aritmetica M(x) risulta sempre automaticamente nulla (quindi priva di interesse).

La dimostrazione è immediata ponendo nella 3) y=m (cioè y1, … yN = m) oltre che a=1 e b= -1, osservando

che la media di una costante è la costante stessa e che inoltre x 1+…+ xN = NM(x). Vale infatti:

M(x –m) = M(x) – M(m) = M(x) – m. Quindi M(x -m)=0 [e pure S = (x1-m) + …+ (xN -m)] quando m = M(x).

[x1-M(x)]+ …+ [xN -M(x)] x1+…+ xN N M(x)

Si può pure dimostrare direttamente: M(x –m) = ------------------------------ = ------------- - --------- = M(x)-M(x)= 0.

N

N

N

Le stesse considerazioni valgono poi, al solito, anche per le variabili casuali.

E’ pure interessante calcolare la media di N valori in progressione aritmetica. Se cioè x1 è il 1° termine di una

progressionearitmetica, x2 il 2° ecc. fino all’ N° - quindi di ragione d = (xN – x1) / (N-1) – valendo la formula:

SN = x1+…+ xN = (x1 + xN) N/2 segue: M(x) = (x1+…+ xN )/N =(x1 + xN)/2 cioè M(x) è pure media degli estremi.

Concludiamo il discorso sulla media aritmetica accennando brevemente ai casi in cui essa viene utilizzata,

preferendola quindi alle altre.

Questa preferenza deriva principalmente dalla sua ben nota proprietà di conservare – essa soltanto - la

somma totale dei valori, da essa equidistribuita tra tutti gli individui della popolazione: NM(x) = x1+…+ xN .

Tale proprietà continua a sussistere anche quando, utilizzando la seconda formula: M(x) = x 1 f1+ …+ x k f k ,

x1, …, xk non più necessariamente sono k valori effettivamente assunti dalla variabile ma semplicemente le

k misure centrali delle k classi di intensità di una certa variabile quantitativa x.

Per questa sua caratteristica essa viene preferibilmente usata ad es.in economia, scienze politiche e in

quelle altre discipline dove prezzi, domanda e offerta media ecc. di certi beni o consumi servono ad

individuare il fabbisogno complessivo di certi approvvigionamenti o risorse da distribuire tra gli individui di

una certa popolazione mentre invece in demografia, antropologia, medicina e biologia, psicologia,

sociologia e altre scienze in genere non esatte (ma anche in meteorologia, astronomia e astrofisica, quando

ad es. si calcola la densità media di massa o energia oppure il numero di stelle o galassie per unità di

volume) serve a individuare i valori di alcune variabili che presentano fluttuazioni statistiche non trascurabili,

così come in generale nella teoria della misura dei dati sperimentali (soprattutto in fisica, chimica ecc.) serve

a stabilire il valore delle diverse grandezze affette da un non trascurabile grado di incertezza.

CONFRONTO TRA MEDIA E MEDIANA

Passiamo a considerare gli altri tipi di media più frequentemente utilizzati con le variabili quantitative e con

esse i nuovi indici di variabilità che ora possono calcolarsi. Prima però riprendiamo in esame alcuni aspetti

numerici della mediana, adesso calcolabili e significativamente simili a quelli della media aritmetica.

Se infatti la media aritmetica di n numeri è, come si è visto, quel valore che annulla la somma degli scarti

da essa, presi in valore e segno, e come vedremo, quello che rende minima la somma dei quadrati di tali

scarti, la mediana rende invece minima la somma degli scarti semplici presi però in valore assoluto.

Indicando con Me la mediana degli N valori x1, … xN che supponiamo già disposti in ordine crescente (o non

decrescente se ci sono valori uguali) risulta cioè che SA = |x1-m| + …+ |xN –m| è minimo quando m= Me.

Per la dimostrazione ricordiamo che la mediana per valori numerici è sempre definita, coincidendo con il

valore centrale se N è dispari o con il punto medio della coppia di valori centrali quando N è pari.

Ciò premesso osserviamo che individuare la mediana di N numeri, tutti distinti o eventualmente in parte tra

loro coincidenti, equivale a determinare il punto Q per cui la somma delle distanze QP 1+ QP2+ … + QPN

risulta minima, essendo P1, P2, … PN i punti di una stessa retta aventi ascisse x1, … xN .

Se N =2 ogni punto interno al segmento P1 P2 soddisfa la condizione richiesta, essendo sempre in questo

caso QP1+ QP2 = P1P2 (mentre chiaramente per valori esterni) ma l’indeterminatezza viene risolta dal punto

medio. Se invece N = 3 vale ancora il discorso precedente relativamente a P1P2 ma in questo caso P3 è una

scelta obbligata, essendo l’unica che non aumenta il totale essendo in tal caso QP 3 la distanza nulla.

Se poi N è un qualsiasi numero pari basta considerare i successivi segmenti P1PN ; P2PN-1 ; P3PN-2 ecc.

incapsulati ciascuno dentro il precedente per convincersi che il punto medio dell’ultimo segmento – quello

interno a tutti i rimanenti - oltre ad essere il punto corrispondente alla mediana, è proprio quello che realizza

la minor distanza totale (ogni altra scelta di Q infatti la aumenta come minimo del segmento più interno); se

invece N è dispari si ragiona come per N =3 rispetto ad N=2, verificando cioè che anche in questo caso

come nel precedente ogni altra scelta comporta un aumento della distanza totale. Osservato poi come

eventuali punti ripetuti non modifichino le precedenti considerazioni (riducendosi a un punto l’ultimo

segmento incapsulato, con N pari) la dimostrazione può dirsi conclusa.

Concludiamo queste considerazioni sulla mediana ricordando che essa, in modo complementare alla media

aritmetica (o altre ancora) ci dice quale valore divide una distribuzione in due parti uguali e viene ad es.

utilizzata nelle assicurazioni per determinare la durata media della vita, ma anche in medicina e nell’industria

per determinare l’efficacia o la qualità di certi medicinali o prodotti (ad es. la durata media di copertura di un

antibiotico, la vita media di una lampadina, di un pneumatico ecc.).

Vediamo ora separatamente le diverse medie oltre a quella aritmetica (che indicheremo ancora con M(x) ma

anche più semplicemente con M): la media armonica A, la media geometrica G, la media quadratica M Q.

LE MEDIE NON ARITMETICHE

La media aritmetica, per quanto privilegiata, non è l’unica ad essere introdotta oltre ai due altri indici statistici

di tendenza – la mediana e la moda – per caratterizzare le variabili quantitative.

A seconda del tipo di variabili da affrontare e dei diversi problemi che esse propongono, vengono infatti

utilizzate in genere altre medie: la media quadratica, la media geometrica e la media armonica.

Esse non sono le uniche alternative ipotizzabili, potendosi infatti definire senza difficoltà altri tipi di media,

ad es. cubiche, logaritmiche o altre ancora. Cominciamo dalla prima, la più importante e pù usata.

MEDIA QUADRATICA

_______________

/ x1 2 + x2 2 + … xN 2

La media quadratica MQ è così definita: MQ = \ / ------------------------ per valori x1,…xN non negativi.

V

N

Essa, come subito si osserva, è la media aritmetica M(x2) dei quadrati dei valori della variabile considerata,

seguita poi – per rendere omogeneo il risultato ai dati iniziali (se ad es. i dati iniziali sono lunghezze misurate

in cm, senza la radice si avrebbe un’area, in quanto espressa in cm 2) – da un’estrazione di radice quadrata.

Essa viene usata soprattutto in fisica quando si considerano grandezze che sono utilizzate al quadrato,

come ad es. la velocità nell’energia cinetica, o più in generale si considerano grandezze vettoriali di cui

interessa solo il modulo.La media quadratica è caratterizzata da due importanti proprietà :

La 1° afferma invece che, come già per la media aritmetica, M(x – m)2 diventa minimo quando m = M(x).

La 2° dice che sempre vale: MQ > M, cioè M(x2) > [M(x)]2

Per la 1° basta considerare che Y(m) = M(x – m)2 = M(x2 – 2mx + m2) = M(x2) –2m M(x) + m2 è un trinomio

di secondo grado in m rappresentato quindi nel piano m,Y da una parabola con la concavità verso l’alto che

presenta pertanto un minimo nel suo vertice avente notoriamente m V = - [-2mM(x)] /2 = M(x).

Ciò significa appunto che M(x – m)2 diventa minimo per m = M(x) e per tale valore risulta:

M[x–M(x)]2 = M(x2) –2M(x) M(x)+ [M(x)]2 = M(x2) – [M(x)]2 (da cui M(x2) = [M(x)]2 x=M(x) x1=x2= …=xN ).

La 2° segue subito da questa formula essendo sempre M[x – M(x)]2 > 0, quindi M(x2) – [M(x)]2 MQ > M.

Possiamo pertanto affermare, come già si era detto in precedenza, che la media aritmetica M(x) di N numeri

è non soltanto quel valore che annulla la somma degli scarti da essa, presi in valore e segno (rendondone

quindi minimo il valore assoluto) ma anche quello che minimizza la somma dei quadrati di tali scarti, così

come la mediana rende invece minima la somma degli scarti semplici presi in valore assoluto.

MEDIA GEOMETRICA

_____________

La media geometrica MG è così definita: MG = x1 x2 … xN

per valori x1,…xN positivi.

N

Dalla definizione subito deriva che MG N = x1 x2 … xN . Ciò chiaramente significa che, a differenza della

media aritmetica M che conserva la somma, MG conserva il prodotto. Per questa ragione è meno usata di

quella aritmetica e viene utilizzata proprio in quelle situazioni nelle quali occorre mantenere la proprietà

suddetta, come ad es. in certi problemi di matematica finanziaria.

Per la media geometrica, al contrario di quella quadratica vale sempre: MG < M e quindi MG2 > M 2

Verifichiamo ora la proprietà solo per N =2 (la dimostrazione del caso generale verrà vista tra poco).

Per N=2 vale infatti: MG2 > M 2 x1 x2 > [(x1 + x2 ) / 2]

2

x1 x2 > (x1 + x2 ) 2 /4 )(x1 - x2 ) 2> 0 (s.v.).

MEDIA ARMONICA

1

1/x1 + 1/ x2 + … + 1/xN

N

Per essa vale: ----- = ------------------------------- MA = ----------------------------------MA

N

1/x1 + 1/ x2 + … + 1/xN

La media armonica MA può quindi definirsi come la reciproca della media aritmetica delle reciproche.

e in genere viene appunto usata quando delle variabili x i interessano i reciproci (se ad es.un ciclista percorre

una salita a 20 km/h e poi la discende a 60 km/h, la velocità media totale è 30 km/h = M A , non 40 km/h =M).

Vale ancora: MA < M, (come subito si verifica per N = 2 i calcoli coincidono con i precedenti).

Vediamo ora di considerare globalmente le diverse medie sinora esaminate, confrontandole tra loro.

Come ora dimostreremo vale sempre la seguente relazione: MA < MG < M < MQ .

Osserviamo subito che non soltanto l’inversa della media armonica è la media aritmetica delle inverse

ma pure il quadrato della media quadratica è la media aritmetica dei quadrati.

Vale cioè per entrambe (essendo prima f il quadrato e poi l’inverso) la formula generale: M[ f(x)] = f [M(x)].

Le cose sembrano andare diversamente per la media geometrica, ma se si considera il suo logaritmo (quale

che sia la base), grazie alle sue ben note proprietà (log [xy] = log x + log y; log [x k] = k logx ) risulta:

log x1 + log x2 + … + log /xN

log (MG )

= ------------------------------ . Così facendo vale ancora M[ f(x)] = f [M(x)], essendo ora: f = log.

N

Ciò premesso consideriamo la formula M[ log(x)] = log [M(x)] e supponiamo inizialmente di avere due soli

valori x1 e x2 (caso peraltro da noi già trattato per ogni tipo di media verificando ledisuguaglianze indicate).

Supponendo di considerare logaritmi in base > 1 (ad es. 2) la curva logaritmica risulta crescente.

Da MG < M, già verificata come si è detto per via algebrica quando N=2, segue quindi log M G < log M e cioè:

log x1 + log x2

x1 + x2

-------------------- < log -----------2

2

Il grafico a fianco, tenuto conto che la curva logaritmica (in base > 1)

presenta inoltre la concavità rivolta verso il basso, illustra allora

graficamente la suddetta disequazione. Il primo membro della

disequazione è infatti il punto medio sull’asse y del segmento di estremi

log x1 e log x2 mentre il secondo membro è il logaritmo del punto

medio del segmento di estremi x1 e x2 (x1 = 0,5; x2 = 2).

Ricordando che il punto medio di un segmento altro non è che il

baricentro dei suoi estremi possiamo dire più sbrigativamente che,

grazie alla curva logaritmica cresente e alla sua concavità verso il

basso, il baricentro dell’immagine (sull’asse y) di un segmento

(sull’asse x) è più bassa dell’immagine (sempre sull’asse y) del

baricentro del segmento iniziale (posto sull’asse x).

Per dimostrare che la precedentedisuguaglianza continua a valere passando ad N=3 e poi ai successivi

valori basta osservare che risulta:

x1 + x2 + x3

2 (x1 + x2)/2 + x3

x1 + x2 +… + xN

(N-1) (x1 +…+ xN-1)/(N-1) + … + xN

--------------- = -------------------- e in generale: ------------------ = -------------------------------------3

3

N

N

In base alla prima formula possiamo infatti affermare che il baricentro G3 di x1, x2 , x3 - in quanto media

pesata del baricentro G2 di x1, x2 con x3 - non è più riconducibile al punto medio della seconda corda sottesa

dalla curva ma sempre a un punto di essa (più vicino a G2) che quindi continua a portare ad un punto

sull’asse y che si mantiene comunque al di sotto dell’immagine di G 3 . Le stesse considerazioni valgono poi

chiaramente per G4 di x1, x2 , …x4 e così via fino a GN di x1, x2 , … xN che conclude il calcolo.

Resta pertanto verificata la disuguaglianza MG < M.

Per dimostrare che vale anche MA < M, tenuto conto che MA < M 1/ MA > 1/M, si procede in modo

analogo, sostituendo la curva logaritmica con l’iperbole di equazione y = f(x) =1/x , che avendo notoriamente

la concavità verso l’alto scambia il verso della disequazione da < a > , come risulta appunto in 1/ MA > 1/M.

Le stesse considerazioni valgono anche per MQ > M, sostituendo all’iperbole la parabola y = f(x) = x 2.

N

N _____________

Resta infine da dimostrare MA < MG cioè ------------------------------ < x1 x2 … xN . Posto 1/ xi = yi

1/x1 + 1/ x2 + … + 1/xN

N

y1 + y2 + … + yN

N _____________

N _____________

essa diventa: ------------------------ < 1 / y1 y2 … yN ------------------------ > y1 y2 … yN ma

y1 + y2 + … + yN

N

l’ultima disequazione altro non è che M > MG MG < M , sempre verificato, ora per le yi anziché le xi .

Osserviamo ancora che tutte le diverse medie sono chiaramente comprese tra il minimo e il massimo dei

valori: Min(xi) < MA < MG < M < MQ < Max(xi) e ogni < diventa un = (quindi tutti insieme) x1 =x2 = … xN ,

come si verifica senza difficoltà. Inoltre ciascuna delle medie considerate può definirsi, come per la media

aritmetica, attraverso le frequenze:

F1+ F2 + …+ Fk

F1x1 2 + F2x2 2 + … + FK x k 2

(F1 + … + Fk) _________________

MA = -------------------------------------- ; MG = x1 F1 x2 F2 … xN FN ; MQ = -----------------------------------F1/x1 + F2 / x2 + … + FK / x k

F1+ F2 + …+ Fk

INDICI DI VARIABILITA’

Se le diverse medie, la mediana e la moda di una distribuzione statistica costituiscono, come si è detto, gli

indici di tendenza dei suoi valori, ovviamente non possono dirci come i diversi valori si posizionano rispetto a

tali indici e più in generale se la distribuzione si presenti dispersa oppure concentrata rispetto ad essi. Per

avere tali informazioni si possono utilizzare gli scarti (già visti in precedenza) rispetto alle medie valutandone

poi, a loro volta, le medie più opportune e significative. Sappiamo già che la media degli scarti in valore e

segno dalla media aritmetica è sempre nulla. Essa non può quindi essere utilizzata.

In pratica di tutti possibili indici di variabilità (o indici di dispersione, come anche si chiamano) se ne usano

solo due ed entrambi a partire dagli scarti rispettoalla media aritmetica, la più semplice e importante.

Il primo indice di variazione è lo scarto semplice medio dalla media aritmetica, cioè la media aritmetica SM

dei valori assoluti degli scarti rispetto ad essa:

| x1 – M| + | x2 – M| + … + | xN – M|

F1 | x1 – M| + …+ Fk | x k – M|

SM = ------------------------------------------------ = ----------------------------------------- .

N

F1+ F2 + …+ Fk

Il secondo indice, quello in genere sempre usato salvo casi particolari, è invece lo scarto quadratico medio,

indicato con la lettera greca , cioè la media quadratica degli scarti dalla media aritmetica:

=

________________________________

__________________________

/ (x1 – M)2 + (x2 – M)2 + . . . + (xN – M)2

/ F1 (x1 – M)2 + . . . + Fk (xN – M)2

\ / ------------------------------------------------------ = \ / -------------------------------------------V

N

V

F1+ F2 + …+ Fk

Lo scarto quadratico medio è anche chiamato deviazione standard e come SM si annulla se e solo se

x1 – M = x2 – M = …= xN – M = 0 x1 = x2 = … = xN = M cioè la distribuzione ha valore costante.

Il valore Var(x) = X 2 è detto varianza ed è quindi la media dei quadrati degli scarti dalla media aritmetica

per cui, come già sappiamo, vale : Var(x) = M[x–M(x)]2 = M(x2) –2M(x) M(x)+ [M(x)]2 = M(x2) – [M(x)]2

Chiaramente la varianza 2 non è un valore omogeneo a quelli della distribuzione, come risulta invece .

Va però osservato che, a differenza delle diverse medie viste in precedenza, valori che possono confrontarsi

solo con quelli delle distribuzioni da cui derivano, può risultare opportuno confrontare le dispersioni di

distribuzioni diverse, anche non omogenee tra loro, ad es. quelle di peso e altezza di un gruppo di atleti.

Per fare questo occorre passare dall’indice di variabilità assoluta (o SM , ma è meno usato), valore in

genere dimensionale, ad un indice di variabilità relativa adimensionale che si ottiene semplicemente

dividendo per la media aritmetica M. Il numero puro /M è allora detto coefficiente di variabilità.

Queste considerazioni sono particolarmente significative nella teoria degli errori, quando cioè x 1, x2 , … , xN

sono le misure d’una certa grandezza x (non diversamente nota) il cui valore per definizione è la media M(x).

La variabilità o dispersione delle xi costituisce l’incertezza della misura, dovuta agli inevitabili errori casuali,

tanto più evidenti quanto maggiore è la precisione degli strumenti usati. L’errore, assoluto(E A) o relativo (ER)

che sia, esprime allora il grado di tale incertezza o variabilità e in genere si pone: EA = ; ER = /M o più

semplicemente, quando le misure sono poche (N<10): EA = ½ [Max(xi) - min(xi)] e sempre ER = EA /M.

VARIANZA E COVARIANZA: PROPRIETÀ E RELAZIONI

Vediamo ora in breve le principali caratteristiche della varianza, il che comporta la concomitante introduzione

del concetto di covarianza, pur senza troppo addentrarci in una trattazione sistematica dell’argomento che

sarà oggetto della 2° parte di questi appunti, quella dedicata alla statistica bivariata e alle variabili casuali.

Esse possono sostanzialmente riassumersi nelle tre seguenti proprietà:

1) Var (x) = X 2 = M (x2) – [M (x)]2

(da cui segue subito: Var (c) = 0, essendo M(c) = c )

2) Var (kx) = k2 Var (x)

3) Var (x + y) = Var (x) + Var (y) + 2 Cov (x,y)

(essendo Cov (x,y) la covarianza di x e y)

La 1° proprietà deriva subito dalla definizione e dalle proprietà della media aritmetica:

Var(x) = M[x–M(x)]2 = M(x2) –2M(x) M(x)+ [M(x)]2 = M(x2) – [M(x)]2

La 2° segue dalla 1°: Var(kx) = M([kx]2) – [M(kx)]2 = M(k2x2) – [kM(x)]2 = k2[ M([x]2 – (M(x))2 ) = k2 Var (x)

La 3° richiede invece qualche passaggio in più:

Var(x+y) =M(x+y)2 –[M(x+y)]2 =M(x2+2xy+y)2 -[M(x)+M(y)]2 =M(x2)+ M(y)2+2M(xy)-[M(x)]2 -[M(x)]2 –2M(x)M(y)

= M(x2) – [M(x)]2 + M(y2) – [M(y)]2 + 2 [ M(xy) – M(x)M(y) ] = Var (x) + Var (y) + 2 Cov (x,y)

avendo posto: Cov(x,y) = M(xy) – M(x)M(y) o in modo equivalente: Cov (x,y) = M { [x - M(x)] [y – M(y) ] }

in quanto: M {[x -M(x)][y –M(y) ]} = M[xy– xM(y) – y(M(x) + M(x)M(y) ] = M(xy) –M(x)M(y)-M(y)M(x)+M(x)M(y).

x1 y1 + x2 y2 + … + xN yN

F1 x1 y1 + … + F1xN yN

M(xy) è ovviamente la media dei prodotti, cioè: M(xy) = -------------------------------- = --------------------------------.

N

F1+ F2 + …+ Fk

Risulta pertanto:

Var(x + y) = Var(x) + Var(y) Cov(x,y) = 0 M(xy) = M(x)M(y) M { [x - M(x)] [y – M(y) ] } = 0 o come

meglio si chiarirà più avanti Cov(x,y) = 0 se e solo se le xi e le yi sono variabili indipendenti tra loro.

REGRESSIONE LINEARE

Supponiamo di avere un certo numero n di punti P1(x1; y1) , P(x2 y2).., Pn(xn ; yn ) del piano cartesiano quasi

allineati, cioè sufficientemente vicini ad una stessa retta da poter ritenere che debbano appartenere tutti a

una certa retta r del piano (che escluderemo sia del tipo x=c) di equazione: y = mx + q, con m e q da

determinarsi. E’ questo il caso tipico che ad es.si presenta quando i valori x i ed yi sono le successive

misure, come sempre affette da errori casuali - di due variabili x ed y tra loro correlate e supponiamo che la

y, assunta come variabile dipendente, sia legata alla variabile indipendente x da una legge di tipo lineare.

Così ad es. la x può rappresentare il tempo t (misurato in s) ed y la velocità v corrispondente (in m/s) in un

moto uniformemente accelerato di accelerazione a = m (in m/s2 ) e velocità iniziale v0 = q (in m/s) oppure

y è la misura dell’allungamento (non troppo grande, misurato in m) di una molla mentre x rappresenta la

forza F (misurata in Newton), essendo in tal caso m la cosiddetta costante elastica (in m/N) mentre q in

questo caso vale 0 essendo nullo l’allungamento (non ovviamente la molla) quando F = 0 e così via.

Il problema, una volta che si sia riconosciuta la natura lineare della funzione y = f(x)= mx + q (la curva di

equazione y = f(x) potrebbe infatti essere, a seconda dei casi, non necessariamente una retta ma una

parabola, una curva logaritmica ecc.) consiste a questo punto nel determinare il coefficiente angolare m e il

termine noto q della retta r (retta di regressione lineare) che meglio approssima tutti i punti dati. Ma come va

intesa la migliore approssimazione?

Ricordando che il punto medio xM di n punti di una stessa retta aventi ascisse x1, x2, … xn è anche il punto

che rende minima la somma dei quadrati delle distanze da esso (oltre che annullare la somma degli scarti),

procediamo in modo analogo, imponendo cioè che vada scelta la retta r che rende minima la somma dei

quadrati delle distanze da essa. Com’è facile convincersi ciò equivale ad imporre che sia anche minima la

somma dei quadrati delle distanze tra i punti dati P1, …, Pn e i corrispondenti punti Q1, …, Qn sulla retta r

aventi la stessa ascissa. Dovrà pertanto risultare minima la somma S:

S = [y1 -(m x1 + q )] 2 + [y2 - (m x2 + q )] 2 + … + [yn - (m xn + q )] 2 = (z1 – q) 2 + (z2 – q) 2 + … +(zn – q) 2

avendo chiaramente posto: zi = yi - m xi ( i = 1… n).

Ricordando a questo punto che (z1 – q) 2 + (z2 – q) 2 + … +(zn – q) 2 assume il valore minimo quando q vale la

media aritmetica zM di z1 ,…, zn , avendosi poi (com’è immediato verificare) zM = yM - m xM risulta allora che:

la retta r: y = mx + q per la quale risulta minimo S, cioè la retta avente il minimo scostamento (quadratico)

dai punti dati P1(x1; y1) , .., Pn(xn ; yn ) è tale che q = yM - m xM yM = m xM + q G (xM ; yM ) r.

La retta r richiesta deve cioè passare per il baricentro G dei punti P 1 , …, Pn che come si sa è proprio il

punto avente per coordinate le medie dei punti dati. Per avere r resta quindi ancora da determinare m.

A tale proposito svolgiamo i calcoli in S utilizzando il ben noto simbolo di sommatoria, con i che varia

sempre da 1 a n. Si ottiene facilmente:

S = yi 2 + m2 xi 2 + nq2 – 2m xi yi - 2q yi + 2mq xi

ed essendo inoltre

y1 + y2 + … + yn

x1 + x2 + … + x n

yM = m xM + q ---------------------- = m ----------------------- + q yi = m xi + nq, sostituendo:

n

n

S = yi 2 + m2 xi 2 + nq2 – 2m xi yi - 2q (m xi + nq) + 2mq xi e finalmente semplificando si avrà:

S = m2 xi 2 – 2m xi yi + yi 2 - n q2 . In questa equazione, effettuando una traslazione di assi:

{ X = x - xM

{ Y = y - yM

portando cioè l’origine in G, può essere posto q = 0, il che significa che S può essere

ridotto ad un trinomio di 2° in m i cui coefficienti dipendono solo dalle coordinate dei Pi :

S = m2 X i 2 – 2m Xi Yi + Yi 2

che notoriamente nel piano m, S corrisponde ad una parabola ad

Xi Yi (xi – xM ) (yi – yM )

asse verticale rivolta verso l’alto avente vertice nel punto di ascissa m = --------- = ------------------------ .

Xi 2 (xi – xM )2

La retta s di regressione di y rispetto a x avente per m il valore suddetto e q = yM - m xM è così individuata.

Nella 1° parte di codesto sito è presente il programma in Excel regressio con dati (e conseguente grafico

tracciato in tempo reale) modificabili a piacere.

Vediamo ora di fare alcune ulteriori considerazioni sull’argomento pur senza troppo addentrarci nella sua

trattazione teorica che sarà oggetto della 2° parte di questi appunti, quella dedicata alla statistica bivariata.

Se nello svolgimento dei calcoli dovesse risultare m = 0 (xi – xM ) (yi – yM ) = 0 e quindi l’equazione della

retta fosse del tipo y = q , ciò vorrebbe dire che la variabile y non dipende dalla variabile x. Non esiste in tal

caso dipendenza e quindi è nulla la covarianza Cov(x,y) = (xi – xM ) (yi – yM ) / N tra le due variabili. Non

può invece aversi m = in quanto non si annulla (xi – xM )2 a meno che tutti gli xi non siano uguali tra loro

e quindi uguali anche alla loro media xM .

Se invece risulta m 0 si può considerare non y dipendente da x ma viceversa x dipendente da y.

Se i punti dati sono esattamente allineati (cosa piuttosto improbabile) la retta nel piano cartesiano non

cambia e per averne la nuova equazione esplicita basta ricavare x da y: y = mx + q x = y/m – q/m.

Se i punti dati non sono esattamente allineati si trova una nuova retta s’ di regressione di x rispetto a y

di equazione y = m’x + q’ x = y/m’ – q’/m’ avente coefficiente angolare 1/m’ dato da:

1

Yi Xi (xi – xM ) (yi – yM )

------- = --------- = -------------------------- mentre risulta sempre q’ = yM – m’xM in quanto anche s’ passa per G.

m’

Yi 2

(yi – yM )2

In conclusione possiamo dire che quando i punti non sono esattamente allineati o tutti coincidenti si trovano

sempre due rette di regressione, una di y rispetto ad x, l’altra di x rispetto ad y entrambe passanti per il loro

baricentro (se la covarianza è nulla sono le due parallele agli assi) ed entrambe crescenti se la covarianza è

positiva o decrescenti se è negativa, essendo invariato il numeratore dei due loro coefficienti angolari e il

denominatore sempre positivo.

Osserviamo ancora che tutto può significativamente esprimersi mediante sole varianze e covarianza.

Ricordando che Var(x) = X 2 = (xi – xM )2 / N e quindi così pure Var(y) = Y 2 = (yi – yM )2 / N e tenuto

conto che Cov(x,y) = (xi – xM )(yi – yM ) / N, si può infatti scrivere (il simbolo XY sta per Cov(x,y) ):

XY

Cov(x,y)

m = ---------- = ------------ ;

X 2

Var(x)

XY

Cov(x,y)

1/m’ = ----------- = ------------ .

Y 2

Var(y)

I risultati appena ottenuti ci permettono di riprendere e chiarire ulteriormente la nozione di indipendenza

statistica (prima che venga introdotta quelle più rilevanti di indipendenza tra eventi e variabili casuali).

Essi infatti ci dicono che Cov(x,y) = XY è nulla se e solo se le rette di regressione sono parallele agli assi

e questo significa che le variazioni di una variabile statistica non influiscono sull’altra che si mantiene infatti

costante. E’proprio in questo senso che va intesa la nozione prima introdotta di indipendenza tra le xi e le yi .

Ci potremmo però chiedere se la nozione di indipendenza tra due variabili– e quindi anche del suo concetto

opposto, la dipendenza – sia un che di graduale, come sembrerebbe spontaneo, ritenendo cioè che il grado

di dipendenza (detta anche correlazione,quando le due variabili sono entrambe di tipo quantitativo) tra due

variabili possa variare con continuità da zero a valori positivi (se crescono o decrescono insieme) oppure

negativi (se l’una cresce quando l’altra decresce), come spesso accade di riscontrare tra diversi eventi,

siano essi legati da un rapporto di causalità oppure no.

A tale proposito è opportuno introdurre un nuovo parametro statistico, il coefficiente r di correlazione lineare

(di Bravais-Pearson) così definito:

Cov(x,y)

XY

Yi Xi

r = ------------- ----------- = ------------- = --------------------- .

Var(x) Var(y)

X · Y

Xi 2 Yi 2

Il coefficiente r, com’è immediato verificare, risulta un numero puro, cioè adimensionale, al pari di m e 1/m’

(dei quali risulta la media armonica presa con segno) e vale r = 0 Cov(x,y) = 0 le xi e le yi sono tra loro

indipendenti, risultando positivo o negativo a seconda del segno di Cov(x,y). Vale inoltre -1 < r < 1 e in

particolare r =+1 y = +ax + b (con a>0), come ora dimostreremo.

Se infatti vale y = +ax + b ciò significa che i punti P1(x1; y1) , .., Pn(xn ; yn ) risultano allineati sull’unica retta di

regessione la cui equazione è proprio y = +ax + b. Vale allora, per quanto detto prima, essendo m =m’ = +a:

XY

Cov(x,y)

XY

Cov(x,y)

Cov 2(x,y)

+ a = ---------- = ------------ ; +1/a = ------- = ------------ da cui (+a)(+1/a) = 1 = ------------------ = r2 => r = +1.

X 2

Var(x)

Y 2

Var(y)

Var(x)Var(y)

Viceversa, osservato che Cov(x,x) = Var (x) > 0, x (e quindi Cov(x,x) = Var (x) = 0 x = 0) ed inoltre

Cov(kx,y) = kCov(x,y), vale allora, per le già esaminate proprietà di Var:

Var(kx + y) = k2 Var(x) + Var(y) + 2Cov(kx,y) = k 2 Var(x) + 2kCov(x,y) + Var(y) , trinomio nel parametro k che

dovendo essere sempre > 0 richiede che il discriminante sia < 0, cioè:

Cov 2(x,y) – Var(x)Var(y) < 0 Cov 2(x,y) < Var(x)Var(y) r2 < 1 -1 < r < 1, come asserito.

Vale poi, in particolare, r = +1 Cov 2(x,y) – Var(x)Var(y) = 0 Var(kx + y) = 0 kx+y = c (costante)

y = -kx – c, cioè del tipo y = +ax + b C.D.D.

Abbiamo quindi ottenuto - grazie al coefficiente di correlazione lineare r - quanto in precedenza cercato, un

indice numerico (compreso tra –1 e 1)che misura il grado di interdipendenza (correlazione) tra due variabili

statistiche. Esso giustamente vale 0 se e solo se le due variabili sono indipendenti, cioè non correlate,

mentre diventa 1 oppure –1 se e solo se le due variabili sono perfettamente correlate (positivamente se r =1,

negativamente se r = -1) cioè legate tra loro da una funzione di primo grado corrispondente ad una retta

rispettivamente crescente o decrescente. Ovviamente un valore di r prossimo a 1 o –1 è un a condizione

necessaria ma non sufficiente per poter affermare che esiste un nesso causale tra le due grandezze

misurate dalle xi e dalle yi: se ad es. le prime sono le attuali temperature crescenti della Terra e le seconde i

numeri anch’essi in crescita dei divorzi nel mondo, un rapporto causa-effetto sarebbe quantomeno inatteso.