Capitolo 3

Probabilità condizionata e

indipendenza stocastica

3.1 Considerazioni introduttive

Abbiamo trattato, finora, soltanto di probabilità di eventi che possono risultare Veri o

Falsi. Tuttavia, il calcolo delle probabilità si occupa, per soddisfare esigenze applicative concrete, anche di eventi il cui campo di possibilità è limitato da qualche specifica

condizione. Si parla, allora, di eventi condizionati o subordinati. Per esempio, relativamente a una partita di calcio che vedrà impegnate le squadre A e B, si può scommettere

sulla vittoria di A [ricevendo una somma di denaro prestabilita se A vince e perdendo la

posta se A non vince: perde o pareggia], ma si può scommettere sulla vittoria di A nell’ipotesi che la partita si chiuda con la vittoria di una delle squadre in campo. Dunque

l’evento “vittoria di A” viene subordinato alla condizione che una delle due squadre vinca. Di conseguenza, lo scommettitore incassa se A vince, perde se vince B, mentre vede

annullata la scommessa nel caso la partita non termini con la vittoria di una delle due

squadre. Si noti la differenza rispetto alla situazione precedente della scommessa sulla

vittoria di A.

Una situazione concettualmente analoga si presenta – con riferimento al cosiddetto

processo di apprendimento dall’esperienza – quando si debba valutare la probabilità di

una certa ipotesi H subordinatamente al fatto che un determinato esperimento abbia un

certo esito, fatto espresso a sua volta da un evento E. Si tratta di valutare la probabilità

di H condizionatamente a un ipotetico incremento d’informazione espresso dall’evento

35

36CAPITOLO 3. PROBABILITÀ CONDIZIONATA E INDIPENDENZA STOCASTICA

E.

Siano E, H, con E 6= ∅, eventi contenuti in una classe C di parti di Ω che includa anche l’intersezione E ∩ H. Ciò è automaticamente soddisfatto se C è un’algebra. L’evento

“H condizionato da E” (detto anche evento “H subordinato a E”) si può rappresentare,

come nella Figura 3.1, restringendo (come accennato all’inizio del paragrafo) le possibilità all’insieme dei casi elementari che costituiscono E e, quindi, considerando successo

[rispettivamente, insuccesso] il presentarsi di un caso elementare contenuto in H ∩ E

[rispettivamente, il presentarsi di un caso elementare contenuto in E \ H].

Si usa indicare l’evento “H condizionato da E” col simbolo H|E.

Si noti che vale H|E = H ∩ E|E ovvero, il generico evento condizionato H|E si può

scrivere in forma irriducibile come H ∩ E|E.

Figura 3.1: L’evento “H condizionato da E” è vero nella zona punteggiata, falso in quella

sfumata, indeterminato nella zona bianca.

Veniamo a fare qualche osservazione preliminare sulla valutazione della probabilità

di H|E. Supponiamo che un individuo giudichi P (E) = 0, 90 la probabilità che si verifichi E e P (H|E) = 0, 60 la probabilità che si verifichi H nell’ipotesi che E sia vero.

Possiamo reinterpretare questo sistema di valutazione così: l’individuo in questione si

impegna a pagare 0,60 euro nel caso si verifichi E, per ricevere 1 euro se si verifica

H ∩ E; per vincere 0,60 euro nel caso si verifichi E si impegna a pagare 0,60 · 0,90=0,54

euro. In definitiva, pagando 0,54 euro, il nostro giocatore acquista il diritto a ricevere 1

euro se si verificano simultaneamente H ed E; quindi, 0,54 si può riguardare come una

valutazione della probabilità di H ∩ E coerente con i valori di P (H|E) e P (E). Questo

punto di vista sarebbe in accordo con quanto suggerito dalla precedente immagine geometrica. Poiché, considerare H|E significa concentrare l’attenzione ai punti contenuti

in E (zona sfumata per l’insuccesso, punteggiata per il successo), allora la probabilità di

3.2. PRINCIPIO DELLE PROBABILITÀ COMPOSTE E TEOREMA DI BAYES

37

E va vista come nuova unità di misura, ovvero: P (H|E) = P (H ∩ E)/P (E), equivalente

a 0, 60 = P (H ∩ E)/0, 90.

3.2 Principio delle probabilità composte e teorema di

Bayes

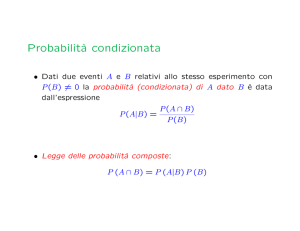

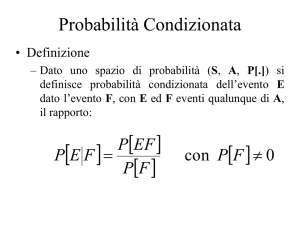

Nell’impostazione assiomatica di Kolmogorov, la probabilità di H|E [nelle condizioni

dichiarate nella sezione precedente] viene definita, coerentemente alle osservazioni già

svolte, come un numero P (H|E) che soddisfa la relazione

(3.1)

P (H|E)P (E) = P (H ∩ E)

ossia il principio delle probabilità composte. Quando P (E) 6= 0, (3.1) determina la

probabilità di P (H|E),

P (H|E) = P (H ∩ E)/P (E),

prolungando P da C a C ∪ {H|E}.

A questo punto si pone in evidenza che, per un evento E fissato in un’algebra C con

P (E) > 0, la funzione

H 7→ P (H|E)

(H ∈ C)

è una misura di probabilità su C. Infatti, (1) P (H|E) = P (H ∩ E)/P (E) > 0; (2) se H

appartiene a C e contiene E, allora P (H|E) = P (H ∩ E)/P (E) = P (E)/P (E) = 1, da cui,

in particolare P (Ω|E) = 1; (3) se A1 , A2 , . . . e ∪n>1 An appartengono a C, con gli Ai a due

a due incompatibili, allora

1

P (E ∩ (∪n>1 An ))

P (E)

1

1 X

=

P (∪n>1 (E ∩ An )) =

P (E ∩ An )

P (E)

P (E)

P (∪n>1 An |E) =

n>1

=

X

n>1

X

1

P (E ∩ An ) =

P (An |E)

P (E)

n>1

In molti casi, praticamente significativi come quello dei procedimenti di apprendimento

(l’induzione statistica ne sarebbe esempio tipico), si suppongono assegnate le probabilità:

– P (E|H) del risultato sperimentale data l’ipotesi H, P (E|H c ) del risultato sperimentale data H c ,

– P (H) dell’ipotesi (probabilità iniziale)

38CAPITOLO 3. PROBABILITÀ CONDIZIONATA E INDIPENDENZA STOCASTICA

e si procede alla determinazione di P (H|E) (probabilità finale). Allora, dalla definizione

di P (E|H), cioè

P (E|H)P (H) = P (H ∩ E),

segue

P (E|H)P (H) = P (H|E)P (E)

ovvero

P (H|E) =

P (E|H)P (H)

P (E)

se

P (E) 6= 0

(3.2)

che fornisce l’espressione più elementare del teorema di Bayes.

Infatti, con considerazioni semplici è possibile generalizzare questo teorema a partizioni numerabili di ipotesi. Si dice che la famiglia di eventi {Hn : n > 1} è una

partizione dello spazio Ω dei casi elementari se Hn 6= ∅ per ogni n, Hn ∩ Hm = ∅ se

S

n 6= m, n>1 Hn = Ω. Quindi, per ogni (misura di ) probabilità P , vale

1 = P (Ω) = P

[

n>1

Hn =

Inoltre, per ogni evento E vale

[

[

E =E∩

(E ∩ Hn )

Hn =

n>1

X

P (Hn ).

n>1

(proprietà distributiva).

n>1

Quindi, risultando gli eventi E ∩ Hn , n > 1, a due a due incompatibili, si ha [disintegrazione della probabilità di E su (Hn )n>1 ]

P (E) =

X

(3.3)

P (E ∩ Hn ).

n>1

Se in un problema sono assegnate le probabilità

– P (E|Hn ), n > 1 [n 7→ P (E|Hn ) è detta verosimiglianza delle ipotesi Hn , dato E],

– P (Hn ), n > 1 [n 7→ P (Hn ) è detta distribuzione iniziale],

si può determinare P (E) notando che (3.3) e il principio delle probabilità composte

implicano

P (E) =

X

P (E|Hn )P (Hn )

n>1

e, per il teorema “ristretto′′ di Bayes (3.2), a patto che P (E) sia strettamente positiva, si

perviene alla forma classica dello stesso teorema

P (E|Hn )P (Hn )

n>1 P (E|Hn )P (Hn )

P (Hn |E) = P

(n > 1).

(3.4)

3.2. PRINCIPIO DELLE PROBABILITÀ COMPOSTE E TEOREMA DI BAYES

3.2.1

39

Alcuni esempi

Concludiamo il paragrafo con qualche esempio nel quale si applicano i concetti e le

regole di calcolo esposti in precedenza.

Poker Si calcoli la probabilità di realizzare, in una data mano di poker, una scala reale

[la mano che comprende 10, J, Q, K, A dello stesso seme], nell’ipotesi che tutte le

mani possibili abbiano la stessa probabilità. Il numero delle mani possibili è 52

5 ;

quindi denotato con Ω l’insieme delle mani possibili e con ω la mano generica, si

ha

52

P (ω) = 1/

.

5

Indicato con R l’evento “la mano è una scala reale”, si vede che R è formato da 4

elementi di Ω e, quindi,

P (R) = 4/

52

.

5

Poniamo ora che il mazziere scopra l’ultima carta della tua mano (la quinta); valuta la probabilità di realizzare scala reale accettando la carta scoperta che, supponiamo, è l’asso di cuori. Se denotiamo con C l’evento “la quinta carta che ti si

distribuisce è l’asso di cuori”, l’evento di cui si chiede di valutare la probabilità è

l’evento condizionato R|C. Il numero delle mani con la caratteristica di avere l’asso

di cuori in quinta posizione (o una carta qualunque fissata in una data posizione)

è 51

4 e, pertanto,

51

52

P (C) =

/

4

5

e, perciò,

P (R ∩ C)

=

P (R|C) =

P (C)

51

52

P (R ∩ C)/

.

4

5

Inoltre, R ∩ C contiene un solo caso elementare: la scala reale di cuori. Pertanto,

−1

P (R ∩ C) = 52

e, di conseguenza,

5

51

13

P (R).

P (R|C) = 1/

=

5

4

40CAPITOLO 3. PROBABILITÀ CONDIZIONATA E INDIPENDENZA STOCASTICA

Probabilità di essere imbrogliati Un’industria automobilistica fabbrica uno stesso

modello in tre diversi stabilimenti: A, B, C. Si stima che A produce NA modelli, B produce NB modelli e C produce NC modelli, rispettivamente con una

frazione pA , pB , pC di difettosi. Se acquisti, presso un concessionario, un esemplare del modello, qual è la probabilità di trovarlo difettoso? Si possono formulare tre ipotesi, circa la provenienza dell’esemplare, che formano una partizione di

Ω: H1 =“l’esemplare proviene dallo stabilimento A”; H2 =“l’esemplare proviene dallo

stabilimento B”; H3 =“l’esemplare proviene dallo stabilimento C”. Indicato con D

l’evento “l’esemplare acquistato è difettoso”, si ha

P (D|H1 ) = pA ,

P (D|H2 ) = pB ,

P (D|H3 ) = pC .

Inoltre, è ragionevole valutare le P (Hi ) nel modo seguente

P (H1 ) =

NA

,

N

P (H2 ) =

NB

,

N

P (H3 ) =

NC

,

N

(N := NA + NB + NC )

Quindi,

P (D) = P (D ∩ H1 ) + P (D ∩ H2 ) + P (D ∩ H3 ) = pA

NA

NB

NC

+ pB

+ pC

.

N

N

N

Ora, nell’ipotesi che il modello acquistato sia difettoso, calcola la probabilità che

provenga, rispettivamente, da A, B, C:

NA

per i = 1

pA

N

1

1

NB

P (Hi ∩ D) =

×

P (Hi |D) =

pB

per i = 2 .

P (D)

P (D)

N

N

pC C per i = 3

N

Test clinico Si considera un test clinico ideato per rivelare una malattia rara che si

presenta in un caso su 100.000. Il test è abbastanza affidabile: per un individuo

affetto rivela la presenza della malattia con probabilità 0,95; per un individuo non

affetto segnala la malattia (sbagliando, dunque) con probabilità 0,005. Calcolare la

probabilità che un individuo, per il quale il test è positivo, sia affetto dalla malattia

in questione. Consideriamo gli eventi: M =“l’individuo è affetto dalla malattia”;

R=“il test è positivo”; dobbiamo valutare P (M |R), sapendo che P (R|M ) = 0.95,

P (R|M c ) = 0, 005, P (M ) = 0, 00001. Allora

P (R|M )P (M )

P (R|M )P (M ) + P (R|M c )P (M c )

0, 95 · 0, 00001

= 0, 0018964.

=

0, 95 · 0, 00001 + 0, 005 · 0.99999

P (M |R) =

3.2. PRINCIPIO DELLE PROBABILITÀ COMPOSTE E TEOREMA DI BAYES

41

Ancora i dadi. . . Una coppia di dadi equilibrati viene lanciata in aria. Nell’ipotesi che

la faccia presentata dal primo dado sia 3, qual è la probabilità che il punteggio

totale superi 6? Detto Ω lo spazio dei casi elementari (l’insieme delle coppie ordinate (i, j) con i=punteggio del primo dado e j=punteggio del secondo dado), si

ha |Ω| = 36. Indichiamo con E l’evento che si verifica se i = 3 e con F l’evento

{(i, j) ∈ Ω : 3 + j > 6}. La probabilità richiesta è

P (F |E) = P (F ∩ E)/P (E).

Mettendo a frutto la condizione espressa sui dadi, sarà ragionevole ritenere uguale

a 1/36 la probabilità di ogni caso elementare. Quindi: P (E) = 6/36, P (F ∩E) = 3/36

e, di conseguenza,

P (F |E) = 3/6 = 1/2.

Sesso dei figli Si considerano le famiglie con due figli. Questi ultimi, classificati in ordine di nascita e in base al sesso, danno luogo alle possibilità seguenti: {M M, M F,

F M, F F }. Nell’ipotesi che le quattro possibilità siano ugualmente probabili, si

chiede di calcolare la probabilità che i figli siano entrambi maschi, nell’ipotesi che

almeno uno sia maschio. Si ha

P (M M |M M ∨ M F ∨ F M ) =

1

1/4

= .

3/4

3

[Si badi, non 1/2] Calcolare la probabilità che i figli siano entrambi maschi nell’ipotesi che il più giovane sia maschio:

P (M M |M M ∨ M F ) =

1

1/4

= .

2/4

2

Urne Si considerano due urne contenenti palline colorate. La prima contiene 3 palline

bianche e 2 rosse, la seconda contiene 3 palline bianche e 4 rosse. Si estrae una

pallina a caso dalla prima urna e la si ripone nella seconda; quindi si estrae una

pallina a caso dalla seconda urna e si chiede di valutare che essa sia rossa. Indichiamo con R2 quest’ultimo evento, e con B1 e R1 , rispettivamente, l’estrazione

di bianca e di rossa dalla prima urna. Allora,

P (R2 ) = P (R2 ∩B1 )+P (R2 ∩R1 ) = P (R2 |B1 )P (B1 )+P (R2 |R1 )P (R1 ) =

22

43 52

+

=

.

85 85

40

42CAPITOLO 3. PROBABILITÀ CONDIZIONATA E INDIPENDENZA STOCASTICA

3.3 Correlazione fra eventi e indipendenza stocastica

Nel confronto fra P (H|E) e P (H) potrebbe presentarsi una delle circostanze seguenti:

(i)

P (H|E) > P (H),

(ii)

P (H|E) < P (H),

(iii)

P (H|E) = P (H).

La (iii) dice che assumere la verità di E non ha alcuna influenza sulla probabilità

di H; si dice allora che H non dipende stocasticamente da E. Analogamente, la (i)

[rispettivamente, la (ii)] dice che assumere la verità di E fa aumentare [rispettivamente, fa diminuire] la probabilità di H; quindi, si dice che H dipende positivamente

[rispettivemente, negativamente] da E. Ricordando le relazioni fondamentali

P (E ∩ H) = P (E|H)P (H) = P (H|E)P (E)

(3.5)

si scopre che la validità di (iii) implica

(3.6)

P (E ∩ H) = P (H)P (E)

e, se P (H) 6= 0, anche la validità di

(3.7)

P (E|H) = P (E)

(E non dipende stocasticamente da H). Da (3.6) segue (iii) quando P (E) > 0. Gli eventi

E, H si dicono (mutuamente o reciprocamente) stocasticamente indipendenti quando vale

(3.6). Questa è una delle proprietà più interessanti per gli sviluppi della teoria delle

probabilità. Si noti che si tratta di una proprietà di P , non degli eventi, a dispetto della

dizione. [N.B.: Non si confonda l’indipendenza stocastica di E ed H con la loro eventuale

incompatibilità. Gli eventi E,H possono essere indipendenti e non incompatibili, quando

P (E∩H) = P (E)P (H) con P (E∩H) > 0. Al contrario, gli eventi E ed H incompatibili con

P (E) > 0 e P (H) > 0 non possono, ovviamente, essere indipendenti, perché P (E ∩ H) =

0.]

Se E e H sono stocasticamente indipendenti, allora anche E e H c sono stocasticamente indipendenti (quindi, anche (E c , H c ) e (E c , H)). Infatti,

P (E ∩ H c ) = P (E) − P (E ∩ H)

= P (E) − P (E)P (H)

[per la (3.6)]

= P (E){1 − P (H)}

= P (E)P (H c ).

Quando si hanno n eventi E1 , . . . , En , con n > 2, essi si dicono stocasticamente indipendenti se lo sono a due a due, a tre a tre, ecc.; più precisamente, quando per ogni

3.3. CORRELAZIONE FRA EVENTI E INDIPENDENZA STOCASTICA

43

k = 2, . . . , n e per ogni sottoinsieme {j1 , . . . , jk } di {1, . . . , n} vale

P (Ej1 ∩ · · · ∩ Ejk ) = P (Ej1 ) · · · P (Ejk ).

Si dimostra facilmente che se E1 , . . . , En sono indipendenti, risultano indipendenti anche gli eventi Eic1 , . . . , Eick , Ei1 , . . . , Ein−k per ogni {i1 , . . . , ik } ⊂ {1, . . . , n} e {j1 , . . . , jn−k } =

{1, . . . , n} \ {i1 , . . . , ik }.

Come mostra il caso seguente, non basta l’indipendenza a due a due per avere, ad

esempio, quella a tre a tre. Si estrae una pallina da un’urna che ne contiene 4: una

bianca, una rossa, una verde, una bleu. Si scommette avendo diritto a scegliere due

colori, e tre individui scommettono scegliendo: il primo bianco o rosso (E1 ), il secondo

bianco o verde (E2 ), il terzo bianco o bleu (E3 ). Se la probabilità di ciascun colore è 1/4,

allora:

P (E1 ) = P (E2 ) = P (E3 ) = 1/2,

P (E1 ∩ E2 ) = P (E1 ∩ E3 ) = P (E2 ∩ E3 ) = 1/4 = P (Ei )P (Ej )

(i 6= j).

Così gli eventi E1 , E2 , E3 sono a due a due indipendenti: la probabilità che una fissata

coppia di scommettitori vinca è data dal prodotto delle probabilità che il singolo vinca.

Invece

P (E1 ∩ E2 ∩ E3 ) = 1/4 6= P (E1 )P (E2 )P (E3 ).

È interessante notare il fatto seguente:

Data la probabilità di ciascuno di n eventi indipendenti, si può determinare la probabilità di ogni altro evento che ne dipenda logicamente. (Per la nozione di dipendenza

logica, vedere Sezione 1.2 ed Esempio 1.2.2)

Infatti, si può incominciare con l’osservazione che se E1 , . . . , En sono gli n eventi dati,

allora ogni evento E che ne dipenda logicamente è unione dei costituenti Ei1 ∩ · · · ∩ Eik ∩

Ejc1 ∩· · ·∩Ejcn−k . Allora, sfruttando l’additività della probabilità e il fatto che i costituenti

sono a due a due incompatibili, si ha

P (E) =

X

P (Ei1 ∩ · · · ∩ Eik ∩ Ejc1 ∩ · · · ∩ Ejcn−k )

∗

con la somma estesa agli indici {i1 , . . . , ik } ⊂ {1, . . . , n} per cui Ei1 ∩ · · · ∩ Eik ∩ Ejc1 ∩ · · · ∩

Ejcn−k ⊂ E.

Se vale l’ipotesi di indipendenza, posto

pj = P (Ej ),

qj = P (Ejc ) = 1 − pj

(j = 1, . . . , n),

44CAPITOLO 3. PROBABILITÀ CONDIZIONATA E INDIPENDENZA STOCASTICA

si ha, in più,

P (Ei1 ∩ · · · ∩ Eik ∩ Ejc1 ∩ · · · ∩ Ejcn−k ) = pi1 · · · pik · qj1 · · · qjn−k

e anche la probabilità di E dipende soltanto dai valori di pj e qj assegnati. Ad esempio,

la probabilità che nessuno degli eventi Ei si verifichi è

ω0 = q1 · · · qn

La probabilità che se ne verifichi esattamente uno è

ω1 =

X

q1 · · · qi−1 · pi · qi+1 · · · qn = ω0

X pi

i

i

(se

qi

qi > 0 per ogni i)

come si può dedurre anche dalla formula generale (1.4) quando si assuma l’indipendenza

stocastica degli Ai .

La probabilità che se ne verifichino esattamente due è

ω2 =

X

q1 · · · qi−1 · pi · qi+1 · · · qj−1 · pj · qj+1 · · · qn

16i<j6n

X

= ω0

16i<j6n

pi pj

qi qj

(se ogni qi 6= 0)

e la probabilità che se ne verifichino esattamente k è

ωk =

X

q1 · · · qi1 −1 · pi1 · qi1 +1 · · · qik −1 · pik · qik +1 · · · qn

(3.8)

16i1 <···<ik 6n

= ω0

X

16i1 <···<ik 6n

pi1 · · · pik

qi1 · · · qik

(3.9)

se ogni qi 6= 0.

3.3.1 Ancora la distribuzione binomiale

Se gli eventi E1 , . . . , En , oltre ad essere stocasticamente indipendenti, sono ugualmente

probabili [P (Ei ) = p e qi = 1 − p per ogni i], allora la probabilità ωk che se ne verifichino

esattamente k si deduce da (3.8) come segue

ωk =

X

16i1 <···<ik 6n

k n−k

p q

n k n−k

=

p q

k

perché il numero degli addendi è uguale a quello dei sottoinsiemi, di k elementi, dell’insieme {1, . . . , n}. Confrontando questo risultato con la definizione di distribuzione

binomiale data nel Sottoparagrafo 2.2.2, si conclude che per n eventi indipendenti e con

probabilità costante p, il numero aleatorio di quelli che si verificano ha distribuzione

binomiale di parametro (n, p).

3.3. CORRELAZIONE FRA EVENTI E INDIPENDENZA STOCASTICA

3.3.2

45

Successioni di eventi indipendenti e, ancora, distribuzione

binomiale negativa

Gli eventi di una successione E1 , E2 , . . . si dicono indipendenti se, per ogni n, E1 , . . . , En

formano una n-upla di eventi stocasticamente indipendenti. Sia dunque (En )n>1 una

successione di eventi indipendenti, di probabilità costante uguale a p. Qual è la probabilità che l’n-esimo successo si verifichi in corrispondenza alla prova (n + r)-esima? Tale

probabilità è nulla se r < 0. Per r > 0, l’evento che interessa si verifica se e solo se si

verifica En+r , e fra i primi (n + r − 1) eventi se ne verificano esattamente (n − 1) [evento

che denotiamo con G(n + r − 1, n − 1)]. Allora, dall’indipendenza supposta segue che la

probabilità richiesta è P (G(n + r − 1, n − 1))P (En+r ) con P (En+r ) = p e, per il risultato

n−1 r

contenuto nel precedente sottoparagrafo, P (G(n + r − 1, n − 1)) = n+r−1

q . Quindi,

n−1 p

indicando con ξ l’istante (intero) in cui si ha l’n-esimo successo, si ottiene

n+r−1 n

P {ξ = n + r} =

p (1 − p)r

(r = 0, 1, 2, . . .)

r

ovvero, ξ ha la distribuzione binomiale negativa. Cf., ancora una volta, il Sottoparagrafo

2.2.2.

3.3.3

Indipendenza condizionata

Dati gli eventi A, B, C, si dice che A e B sono condizionatamente indipendenti dato C

se

P (A ∩ B|C) = P (A|C)P (B|C).

Più in generale, considerata la probabilità A 7→ P (A|C), con A variabile in una algebra

di eventi e C contenuto nella stessa algebra, se gli eventi H1 , . . . , Hn (appartenenti alla

stessa algebra) sono indipendenti rispetto alla distribuzione P (•|C), allora si dicono condizionatamente indipendenti dato C. Presentiamo una semplice applicazione di questo

concetto.

Testimonianza

Si considera un tribunale che sta indagando sopra un evento E [per esempio, l’eventualità che un certo delitto accaduto sia stato commesso da una certa specifica persona].

La corte si avvale della testimonianza di due individui, diciamo I e II, le cui testimonianze essa ritiene indipendenti condizionatamente sia a E sia a E c . La corte è anche

in grado di valutare la probabilità della veridicità delle due testimonianze; diciamo p1 e

46CAPITOLO 3. PROBABILITÀ CONDIZIONATA E INDIPENDENZA STOCASTICA

p2 , rispettivamente per I e II. Indicata con p la probabilità che la corte assegna a E, si

calcolino la probabilità:

– di E subordinatamente al fatto che I e II accusino l’indagato;

– di E subordinatamente al fatto che I accusi e II non accusi l’indagato.

Per rispondere, indichiamo con E1 [rispettivamente, E2 ] l’evento corrispondente alla

affermazione da parte di I [rispettivamente, II] che E è accaduto. Si tratta di calcolare

P (E|E1 ∩ E2 ) e P (E|E1 ∩ E2c ). Si ha:

P (E ∩ E1 ∩ E2 ) = P (E1 ∩ E2 |E)P (E)

= P (E1 |E)P (E2 |E)P (E)

[per l’indipendenza condizionata delle testimonianze]

= p1 · p2 · p

P (E ∩ E1 ∩ E2c ) = P (E1 ∩ E2c |E)P (E)

= P (E1 |E)P (E2c |E)P (E)

= p1 · (1 − p2 ) · p

P (E1 ∩ E2 ) = P (E1 ∩ E2 ∩ E) + P (E1 ∩ E2 ∩ E c )

= p1 · p2 · p + P (E1 ∩ E2 |E c ) · (1 − p)

= p1 · p2 · p + (1 − p1 )(1 − p2 )(1 − p)

P (E1 ∩ E2c ) = P (E1 ∩ E2c ∩ E) + P (E1 ∩ E2c ∩ E c )

= p1 · (1 − p2 ) · p + P (E1 ∩ E2c |E c )P (E c )

= p1 · (1 − p2 ) · p + (1 − p1 ) · p2 · (1 − p)

e

P (E|E1 ∩ E2 ) =

P (E|E1 ∩ E2c ) =

p1 · p2 · p

p1 · p2 · p + (1 − p1 )(1 − p2 )(1 − p)

p1 · (1 − p2 ) · p

.

p1 · (1 − p2 ) · p + (1 − p1 ) · p2 · (1 − p)

3.4 Osservazioni complementari

In molti libri di probabilità, passa sotto il nome di paradosso del progioniero il seguente

problema. Tre individui sono stati imprigionati senza processo. Tenuto presente che ci

troviamo in un paese governato da un signore spietato, il carceriere comunica loro la

notizia che questo signore ha deciso, in modo del tutto arbitrario, di liberarne uno e di

mandare a morte gli altri due. Aggiunge, inoltre, che gli è fatto divieto di rivelare a

chiunque la fine, determinata dal signore. Indicati con A, B e C i tre prigionieri, si sa

che A chiede al carceriere di indicargli – in segreto dagli altri – uno dei due condannati

3.4. OSSERVAZIONI COMPLEMENTARI

47

(diverso da A, per la regola testé richiamata), e che il carceriere gli risponde B. Si chiede

di esprimere la probabilità che A attribuisce alla propria condanna a morte.

A ben guardare, qui non ci troviamo di fronte a un problema di probabilità condizionata. Infatti, A è in possesso dell’informazione che B è condannato. Il significato di un

qualunque evento condizionato a tale eventualità (la condanna di B) sarebbe invece,

come più volte specificato, quello di un evento esaminato sotto l’ipotesi che B sia condannato quando l’ipotesi è ancora incerta. Ora, dopo che A ha avuto l’informazione del

c

carceriere, lo spazio degli eventi elementari è: {HB ∩ HA ∩ HCc , HB ∩ HA

∩ HC }, dove

HI denota che l’individuo I è condannato a morte. A questo punto, si vede che A è condannato se e solo se si verifica la prima eventualità. Quindi, la probabilità richiesta è

esattamente la probabilità di detta eventualità e, quindi, un qualunque numero compreso tra 0 e 1; fissata la valutazione α, il suo complemento a 1, 1 − α, è la probabilità

c

di HB ∩ HA

∩ HC . La probabilità richiesta è 1/2, in condizioni di simmetria.

Invece, se A intende valutare la probabilità di essere condannato nell’ipotesi che B

sia condannato [ma non gli è noto se questo sia Vero o Falso], allora deve apprestarsi a

c

c

calcolare P (HA |HB ). Lo spazio dei casi elementari è: {HB ∩HA ∩HCc , HB ∩HA

∩HC , HB

∩

HA ∩ HC } e supponiamo che essi abbiano rispettivamente probabilità p1 , p2 , p3 con

pi > 0 (i = 1, 2, 3) e p1 + p2 + p3 = 1. Si ha:

P (HA ∩ HB ) = P (HA ∩ HB ∩ HCc ) = p1

[perché HA ∩ HB ∩ HC è impossibile]

c

c

P (HB ) = P (HA ∩ HB ) + P (HA

∩ HB ) = p1 + P (HA

∩ HB ∩ HC ) = p 1 + p 2

e quindi, se p1 + p2 > 0 (p3 6= 1) otteniamo

P (HA |HB ) =

p1

p1 + p2

[=1/2 se p1 = p2 ; 2/3 se p1 = 2p2 , ecc.].

A questo punto del discorso, la situazione dovrebbe apparire paradossale solo a coloro

che, mischiando un po’ i ragionamenti, che (come si doveva) abbiamo tenuti distinti, non

sanno farsi una ragione del fatto che siano ammissibili valutazioni diverse. La risposta

è univoca, nella prima impostazione, se si fissa α e, nella seconda, se si fissano p1 e

p2 . Corrispondendo a stati di informazione diversi, non si può escludere (anzi, sarebbe

naturale attendersi) un divario fra α e p1 o 1 − α e p2 .

48CAPITOLO 3. PROBABILITÀ CONDIZIONATA E INDIPENDENZA STOCASTICA

Concludiamo con una osservazione sulla valutazione di probabilità in spazi finiti, con

casi elementari ugualmente probabili (simmetria), in relazione all’ipotesi di indipendenza stocastica. Ritorniamo al Paragrafo 1.4 (Estrazioni da un’urna) considerando la

famiglia di eventi {E1 , . . . , Em }, dove Ei è l’evento che è Vero se e solo se nella i-esima

estrazione si osserva pallina bianca (i = 1, . . . , m). Ci si sofferma sul caso in cui le

estrazioni sono con restituzione. Se gli eventi hanno probabilità costante= r/n [perché

l’urna contiene r palle bianche e n−r = s palle nere] e sono considerati come indipendenti [perché la composizione dell’urna è nota in corrispondenza a ogni estrazione], allora

possiamo applicare la formula di ωk , nel Sottoparagrafo 3.3.1, per ottenere la probabilità

che si verifichino h di detti eventi [in altre parole: si estraggono h palle bianche]:

r m−h

m

r h

1−

n

n

h

la stessa espressione trovata nel Capitolo I, sulla base di considerazioni di simmetria

e a prescindere da considerazioni di indipendenza stocastica. Lo studente mediti sul

guadagno, sul piano concettuale e dal punto di vista delle applicazioni, conseguito con

l’introduzione del concetto di indipendenza stocastica.