June 2, 2017

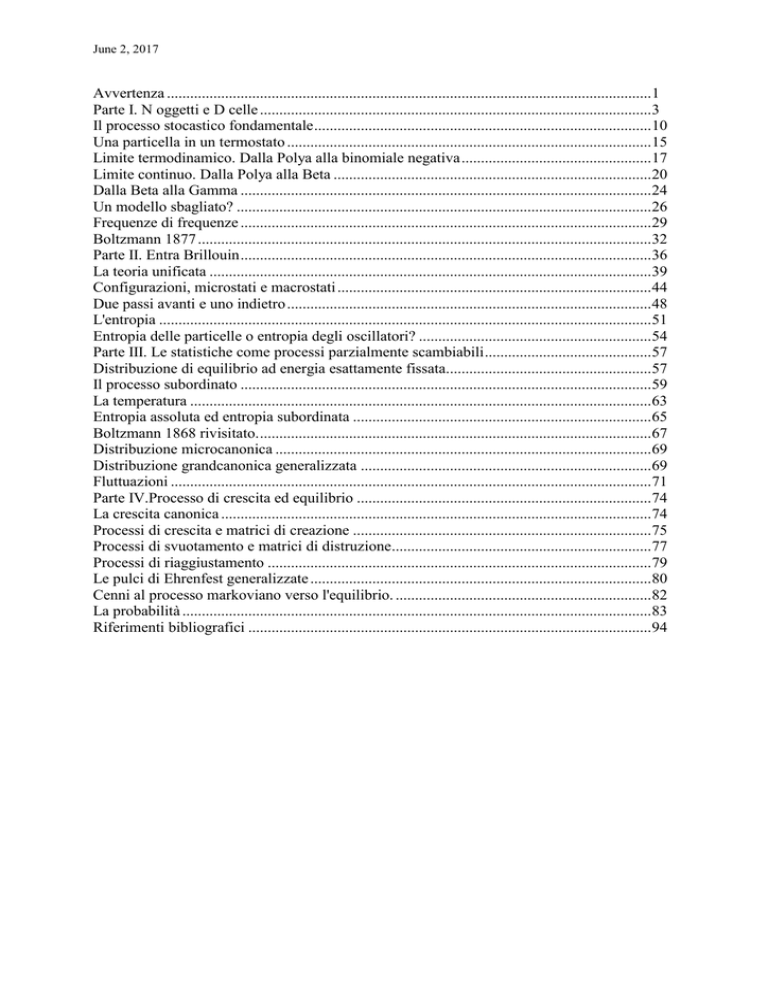

Avvertenza .............................................................................................................................1

Parte I. N oggetti e D celle .....................................................................................................3

Il processo stocastico fondamentale .......................................................................................10

Una particella in un termostato ..............................................................................................15

Limite termodinamico. Dalla Polya alla binomiale negativa .................................................17

Limite continuo. Dalla Polya alla Beta ..................................................................................20

Dalla Beta alla Gamma ..........................................................................................................24

Un modello sbagliato? ...........................................................................................................26

Frequenze di frequenze ..........................................................................................................29

Boltzmann 1877 .....................................................................................................................32

Parte II. Entra Brillouin ..........................................................................................................36

La teoria unificata ..................................................................................................................39

Configurazioni, microstati e macrostati .................................................................................44

Due passi avanti e uno indietro ..............................................................................................48

L'entropia ...............................................................................................................................51

Entropia delle particelle o entropia degli oscillatori? ............................................................54

Parte III. Le statistiche come processi parzialmente scambiabili ...........................................57

Distribuzione di equilibrio ad energia esattamente fissata.....................................................57

Il processo subordinato ..........................................................................................................59

La temperatura .......................................................................................................................63

Entropia assoluta ed entropia subordinata .............................................................................65

Boltzmann 1868 rivisitato. .....................................................................................................67

Distribuzione microcanonica .................................................................................................69

Distribuzione grandcanonica generalizzata ...........................................................................69

Fluttuazioni ............................................................................................................................71

Parte IV.Processo di crescita ed equilibrio ............................................................................74

La crescita canonica ...............................................................................................................74

Processi di crescita e matrici di creazione .............................................................................75

Processi di svuotamento e matrici di distruzione ...................................................................77

Processi di riaggiustamento ...................................................................................................79

Le pulci di Ehrenfest generalizzate ........................................................................................80

Cenni al processo markoviano verso l'equilibrio. ..................................................................82

La probabilità .........................................................................................................................83

Riferimenti bibliografici ........................................................................................................94

...........................................................................................................................

...........................................................................................................................

........................................................................................................................... Scambiabilità e

...........................................................................................................................

dell

(ovvero la caratterizzazione predittiva

delle distribuzioni della meccanica statistica)

D.Costantini, U.Garibaldi

Avvertenza

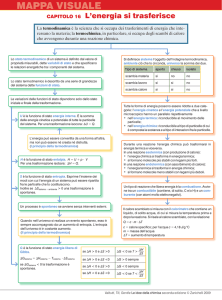

Il presente lavoro intende contribuire alla fondazione probabilistica dei metodi

elementari della meccanica statistica delle particelle identiche. A tal fine si propone

una formulazione unificata, consistente ed esatta dei risultati noti come le statistiche

di Maxwell-Boltzmann, di Bose-Einstein e di Fermi-Dirac. Per formulazione

unificata si intende una deduzione che riduca al minimo le ipotesi che differenziano i

diversi comportamenti delle particelle elementari; per formulazione consistente si

intende una deduzione che riduca al minimo l'irruzione di nozioni extraprobabilistiche nel campo proprio della trattazione statistica; per formulazione esatta

si intende una formulazione che eviti per quanto possibile approssimazioni non

essenziali, e persino dannose per chi intenda correttamente la distinzione tra

probabilità e frequenza relativa. Il primo requisito va contro l'usuale distinzione delle

possibilità elementari (o microstati), che dividono in partenza la trattazione

probabilistica dei tre casi; il secondo fa sì che nozioni quali quella di

"(in)distinguibilità" possano essere espunte dalla trattazione, e discusse in modo

adeguato; il terzo riguarda essenzialmente il metodo del macrostato più probabile, nel

merito e per le conseguenze concettuali che esso implica. Il lavoro inizia con un

excursus di tipo storico, ma non ha alcuna pretesa di completezza filologica, non

essendo la nostra analisi basata sui testi originali (con la sola eccezione di Brillouin),

ma sui lavori di Bach e degli altri storici citati. Anche i lavori di Bose e Einstein sono

stati consultati nella comoda traduzione italiana citata in bibliografia. La parte

centrale del lavoro si basa su articoli da noi pubblicati negli ultimi quattro anni, dopo

i primi tentativi di uno di noi, che risalgono ad un decennio fa. La riscoperta (da parte

di Bach) del lavoro di Brillouin ci ha stimolato in questo senso. La parte finale sull'

approccio all'equilibrio è nuova e tuttora in elaborazione, per cui non si va oltre la

presentazione ed alcuni cenni sui possibili sviluppi. Questo vale in parte anche per il

complesso dell'esposizione, che meriterebbe forse un approccio più coerentemente

deduttivo, anziché erratico e tortuoso, sulle tracce com'é del possibile percorso storico

di idee ed approcci metodologici che divengono unificati ed apprezzabili alla luce di

concezioni e metodi che solo la statistica attuale ha sviluppato in piena

consapevolezza. Un possibile merito di questa presentazione consiste nel conservare

un linguaggio il più possibile intuitivo ed aderente ai concreti problemi nel momento

in cui sorsero; con ciò non si intende sminuire l'importanza di una presentazione

sistematica della materia, che seguirà in un futuro prossimo. La riformulazione

unificata delle statistiche apre forse più problemi di quanti non ne chiuda: per

esempio, quali sono gli "elementi ultimi della realtà" che siano rilevanti per la

descrizione (statistica) di un sistema termodinamico? La possibilità di trattare in

modo formale le cosiddette "parastatistiche" ha un significato fisico?

2

Parte I. N oggetti e D celle

In un recente lavoro[1] A.Bach riprende e commenta la procedura seguita da

Boltzmann in una memoria giovanile[2] per derivare la distribuzione di Maxwell

delle velocità delle molecole, in particolare le distribuzioni marginali di v2 in due e

tre dimensioni, che si possono scrivere nella forma

f2(x) = a2 exp (-2 x)

f3(x) = a3 x exp (-3 x),

che, come é ben noto, sono due casi particolari della distribuzione

n,r(x)= Error!, con (n)= Error!

Il lavoro di Bach ha il grande merito di permettere l'accesso a quelle parti delle

fondamentali ricerche di Boltzmann che sono state scarsamente studiate, sia per la

presunta oscurità che per l'obbiettiva complessità del linguaggio. Questo approccio é

meno noto del famosissimo metodo basato sul termine "di permutabilità" Error!, che

verrà introdotto da Boltzmann solo successivamente[3], visto che il metodo che

stiamo per illustrare conduce a risultati non completamente soddisfacenti. Questo

metodo (il metodo Boltzmann '68) introduce una discretizzazione negli stati delle

particelle, e permette quindi l'uso di distribuzioni di probabilità discrete ( o elementari

nel senso di Kolmogorov): passando al limite continuo il metodo produce esattamente

un gran numero di distribuzioni, mostrando così la sua potenza.

Cominciamo la nostra analisi consideriamo tutte le possibili sistemazioni di N oggetti

indistinguibili su D celle o, in modo equivalente, le combinazioni con ripetizione di D

oggetti di classe N :

W(N,D) = ( N+D-1;N)

(1)

Ovviamente a livello combinatorio non si precisa il significato del termine

"indistinguibile" se non facendo riferimento al linguaggio comune: ma cosa si intende

per "oggetti indistinguibili" nel linguaggio fisico? Il contesto ci aiuta a precisare

rispetto a quale procedura di distinzione gli oggetti sono appunto "indistinguibili": tali

oggetti vanno sistemati su D celle, ed un modo di sistemazione sarà individuato

univocamente dal numero di oggetti sistemati su ciascuna cella. Indichiamo questa

sistemazione con la sequenza N=(N1,..,ND), che deve soddisfare la condizione

∑iNi=N. L'indistinguibilità degli N oggetti significa allora che si considera irrilevante

il nome degli Ni oggetti che stanno sulla cella i-ma, ma non il loro numero; questo

3

numero può allora essere considerato come l'attributo che definisce lo stato dell'i-ma

cella. Si pensi alla distribuzione di N banconote da £ 100.000 su D beneficiari:

chiunque risponderebbe che un distinto modo di ripartire la somma tra i D beneficiari

é proprio una sequenza o vettore1 N=(N1,..,ND), pur sapendo che le banconote sono

perfettamente individuabili dal numero di serie. Questo accade se l'attenzione é

concentrata (con una punta di invidia) sui beneficiari, per cui ciò che conta é la

disponibilità finanziaria di ciascuno; in questo caso la seconda formulazione

(combinazioni con ripetizione di D oggetti di classe N), che non menziona il concetto

di indistinguibilità, é perfettamente adeguata alla situazione. Se invece alcune

banconote fossero false, e fossimo interessati (con spirito investigativo) a sapere

quale beneficiario incautamente le possegga, useremmo come definizione di "modo

distinto" quella che assegna ad ogni banconota il nome del suo proprietario.

Affermare perciò che gli N oggetti sono indistinguibili equivale a supporre che le D

celle rappresentino quelle che in linguaggio statistico si definiscono "unità

statistiche", ciascuna delle quali può essere nello stato Ni=0,1,..,N; allora una

sequenza N=(N1,..,ND) sarà detta una "descrizione di stato" delle D celle rispetto

agli stati Ni=0,1,..,N, e cioé una descrizione della popolazione delle D celle rispetto

alla modalità "numero di oggetti contenuti".

Da quanto si é detto sopra é evidente come la stessa situazione fisica ammetta una

molteplicità di descrizioni statistiche, in cui i termini "unità statistiche", "descrizione

di stato" e "popolazione" (ovvero l'insieme delle unità statistiche) assumono di volta

in volta significati diversi. Ricordiamo che unità statistiche e modalità corrispondono

a ciò che i logici chiamano "individui" (o meglio "costanti individuali") e "proprietà"

(o meglio "predicati a un posto"), cosicché una descrizione di stato corrisponde ad

una congiunzione di enunciati atomici che attribuiscono a ciascun individuo le

proprietà di cui gode.

Se di fronte alla sistemazione degli N oggetti sulle D celle fossimo principalmente

interessati al destino degli oggetti, un descrizione di stato della popolazione degli N

oggetti sarebbe una sequenza di N valori (x1,..,xN) con xi=1,..,D. E' chiaro che questo

1E'

comodo rappresentare come un vettore a D componenti i valori delle variabili

casuali (dette appunto in statistica variabili casuali vettoriali) X=(X1,..,XD) che

rapprentano le D modalità del carattere prescelto. In quel che segue il termine

"vettore" va considerato semplicemente come sinonimo di "sequenza ordinata", e non

và pertanto confuso con la nozione di elemento di uno spazio vettoriale.

4

linguaggio é più raffinato del primo, dato che una descrizione di stato delle celle

N=(N1,..,ND) é esprimibile in termini delle descrizioni di stato degli oggetti x=

(x1,..,xN), mentre non vale il viceversa. Una descrizione di stato N delle D celle é

l'insieme delle descrizioni di stato (degli oggetti) tali che N1 oggetti stiano nella cella

1, .., ND oggetti stiano nella cella D, il cui numero é W(N)= Error!. Nel linguaggio

degli oggetti, questa descrizione viene detta "insieme (o vettore) dei numeri di

occupazione" o a volte "macrostato" dai fisici; "(vettore di) composizione",

"descrizione di struttura" o "distribuzione di frequenze" dagli statistici. E' comunque

chiaro che N, essendo la classe di equivalenza delle x rispetto alle permutazioni dei

nomi degli oggetti che lasciano invariati gli stati delle celle, non menziona i nomi dei

particolari oggetti. Lo schema prevede che ciascuna cella contenga da 0 a N oggetti,

naturalmente col vincolo ∑iNi=N.

Se adesso denotiamo con Zk il numero delle celle che contengono k oggetti

(nell'esempio precedente, il numero dei beneficiari nel livello di ricchezza o stato k),

la sequenza Z=(Z0,Z1,..,ZN) ripetto ad N=(N1,..,ND) ha lo stesso significato che

aveva quest'ultimo ripetto a x. Infatti così come Ni conta il numero di oggetti nello

stato (cella) i, allo stesso modo Zk conta il numero delle celle nello stato (numero di

oggetti contenuti) k. Quindi Z=(Z0,Z1,..,ZN) é un vettore di occupazione per le D

celle, mentre é una "frequenza di occupazione" (od "occupancy number ") per gli N

oggetti. Infatti per essi Zk é il numero di celle in cui si sono sistemati esattamente k

oggetti. Il fatto che vi siano esattamente N oggetti e D celle pone le seguenti

condizioni sui vettori x, N e Z : x(1,..,D)N; Error!=N; Error!=D; Error!=N

Se partiamo dai diversi tipi di vettori e ne consideriamo il ruolo assunto in ciascuna

delle popolazioni statistiche introdotte per descrivere con diverso grado di

accuratezza il medesimo schema fisico di N oggetti su D celle, o schema (N,D),

abbiamo la seguente tabella:

descrizioni

individui

x=(x1,..,xN)

N=(N1,..,ND)

(x{1,..,D)N) ( Error!=N)

5

Z=(Z0,Z1,.,ZN)

(Error!=D e Error!=N)

N oggetti

descrizioni di stato

numeri di occupazione

frequenze di

occupazione

D celle

descrizioni di stato

numeri di occupazione

Cioé x , che é la descrizione di stato degli oggetti, non compare nella descrizione che

assume le celle come individui; N, che é la descrizione di stato delle celle, é una

distribuzione di frequenza degli oggetti; Z, che é una distribuzione di frequenza delle

celle, é una frequenza di frequenza degli oggetti. Alternativamente, se partiamo dalle

popolazioni e dai differenti livelli di descrizione, abbiamo:

descrizioni di stato

vettori di occupazione

occupazione

N oggetti

x= (x1,..,xN)

N=(N1,..,ND)

D celle

N=(N1,..,ND) Z=(Z0,Z1,..,ZN)

....

Z=(Z0,Z1,..,ZN)

.........

frequenze di

Z=(Z0,Z1,.,ZN)

.........

in cui i puntini indicano possibili estensioni dello schema verso "individui" sempre

più astratti e "stati" sempre più generici.

Vediamo il significato di questo schema di classificazione in Boltzmann '68.

Nel caso di Boltzmann N è il numero delle frazioni di energia totale, che chiameremo

"elementi di energia", che vengono distribuiti su D molecole2. In altri termini, se

l'energia totale ED della popolazione di D molecole é suddivisa in N parti uguali =

Error!, lo stato dinamico di ciascuna molecola sarà determinato dal numero di

elementi che essa possiede, cioé N=(N1,..,ND) sarà la descrizione di stato della

popolazione di D molecole rispetto alle N+1 modalità del carattere "numero di

elementi di energia". Da un altro punto di vista (trascurato da Boltzmann), se

partiamo dagli elementi di energia, N può essere legittimamente considerato come il

2Non

intendiamo in questo lavoro soffermarci sul significato referenziale delle ipotesi

introdotte da Bolzmann allo scopo di classificare le possibilità elementari del gas e

calcolarne poi le probabilità. Per un'analisi più ravvicinata e filologicamente più

correttta rimandiamo al nostro lavoro "L.Boltzmann a la nascita della Meccanica

Statistica", in corso di pubblicazione su "Statistica".

6

vettore "numero di occupazione", cioé la descrizione che per ognuna delle D modalità

(molecole) del carattere "insieme di molecole" specifica il numero di unità statistiche

che ne godono (cioé elementi di energia che vi sono sistemati). E' chiaro che nella

procedura di Boltzmann Z=(Z0,Z1,..,ZN) descrive per ogni livello energetico il

numero di molecole che hanno quel valore. E' cioé il corrispettivo discreto della

densità continua f(E)dE , intesa come il numero delle molecole contenute

nell'elemento dE(v) dello spazio delle velocità . Forzando col senno di poi il

discorso di Boltzmann, potremmo dire che Z0 descrive il numero di molecole nello

stato fondamentale, Z1 quelle del I stato eccitato, e così via. Se chiamiamo

"oscillatore" ogni cella dello spazio risultante dalla suddivisione dell'energia in

elementi finiti, Z sarà una descrizione di stato degli oscillatori, che a tutti gli effetti

possono essere considerati a loro volta una popolazione di "terzo livello", costituita

perciò dagli N+1 oscillatori attivabili.

Fino ad ora abbiamo parlato di descrizioni più o meno raffinate connesse allo schema

fisico di accomodamento (N,D): vediamo adesso quali siano le loro relazioni. Una

descrizione di stato degli oscillatori rispetto al carattere "numero di eccitazioni degli

oscillatori", ovvero particelle, è indicata con Z=(Z0,Z1,..,ZN): essa contiene Error!

descrizioni di stato delle D particelle rispetto al carattere "numero di eccitazioni delle

particelle", ovvero elementi di energia. Ciascuna di queste descrizioni, indicate con

N, a sua volta contiene Error!descrizioni di stato x degli N elementi di energia

rispetto al carattere "particella su cui si accomoda". Il modo più semplice di definire

una distribuzione di probabilità su questo schema consiste nel definire una probabilità

Pr(x) sull' insieme Ω=(1,..,D)N di tutte le possibili descrizioni x :

1) Pr(x)≥0,

2)Error!=1,

da cui si ricava gerarchicamente, tenendo conto che N e Z sono sottoinsiemi di Ω, e

che gli insiemi {N: Error!=N} e {Z: Error!=D; Error!=N} sono partizioni di Ω:

Pr(N)=Error!,

Pr(Z)=Error!=Error!.

Se imponiamo che Pr(x) sia una funzione regolare, e cioé che il suo supporto coincida

col dominio Ω=(1,..D)N, che consiste in DN punti, saranno regolari tutte le

descrizioni N tali che Error!=N, il cui numero é Error!, e tutte le Z tali che Error!

=D e Error!=N.

7

Nel lavoro del '68 Boltzmann affronta il problema di descrivere i possibili stati

dinamici di D particelle con N eccitazioni (elementi di energia) in tutto.

Conseguentemente non si occupa della probabiltà delle descrizioni x, ma si limita a

calcolare il numero delle descrizioni di stato delle D particelle compatibili con N

assegnati elementi di energia e a definirne la probabilità:

-1

Pr(N)= (N+D-1;N) .

(2)

Questa funzione di probabilità é uniforme, per cui ogni distribuzione (nel senso di

ripartizione) dell'energia totale sulle D particelle, ritenendo distinte due distribuzioni

che differiscono per il numero di elementi su qualche ricettacolo, é posta come

equiprobabile. Questo ci autorizza a dire che Boltzmann consideri gli "elementi di

energia" come oggetti indistinguibili? Da quanto abbiamo detto é evidente che la

trattazione di Boltzmann semplicemente non li prende in considerazione, dato che la

funzione di probabilità é definita direttamente sugli stati delle particelle, ed il numero

totale degli elementi serve a considerare solo gli stati delle particelle che soddisfano

la conservazione dell'energia N. La più semplice funzione di probabilità sull'insieme

degli x compatibile conError!

la (2) é la seguente:

-1

-1

Pr(x)=Error!

.

(3)

Dato N, la probabilità di x ( probabilità di x condizionata ad N) risulta essere:

-1

(4)

Pr(x|N)=Error! ,

che afferma l'equiprobabilità di tutte le x che appartengono al medesimo N. La

probabilità elementare (3), che come abbiamogià detto non compare in Boltzmann

'68, ha però un grande valore per una ricostruzione probabilistica accurata della

meccanica statistica. Come Bach giustamente sottolinea, la (3) é alla base della

derivazione probabilistica della statistica di Bose-Einstein. Di portata ancor più

generale é la (4), che appunto afferma l'equiprobabilità di tutte le x che appartengono

al medesimo N . Se si rammenta che due distinti x che appartengono al medesimo N

differiscono solo per lo scambio di almeno due elementi tra due celle, si ha che

Pr(x1=i1,..,xN=iN)= Pr(xπ(1)=i1,..,xπ(N)=iN),

(5)

con π(1),.., π(N) indichiamo una permutazione di 1,..,N. Questo equivale a supporre

che per ogni N la legge temporale del processo stocastico x1,..,xN, cioé della

distribuzione di probabilità congiunta delle variabili casuali che lo compongono,

dipenda solo dai risultati delle N variabili e non dal loro ordine di osservazione

( dipenda cioé solo da N).

8

Questa é la definizione di scambiabilità per N variabili aleatorie[4]. La

nozione di scambiabilità ha finito per dominare la statistica bayesiana del secondo

dopoguerra, dopo che i fondamentali lavori di B.deFinetti [5] divennero noti in

America e di lì si irradiarono universalmente. Questa nozione non è altrettanto nota

tra i fisici (con la notevole eccezione del più volte citato A.Bach): da qui lo stupore

che ha accolto alcuni lavori abbastanza recenti [6], che fanno uso inconsapevole di

tale nozione.

Dalla (5) segue che le N variabili aleatorie che vi compaiono sono equidistribuite

come in un processo bernoulliano, e cioé Pr(xj=i)=Pr(xk=i); a differenza di

quest'ultimo processo, di cui costituiscono un'importante generalizzazione, esse sono

correlate, nel senso che in generale Pr(x1=i1,..,xk=ik) ≠ Pr(x1=i1)..P(xk=ik).

E' chiaro che una popolazione di N unità statistiche distribuite su D modalità

(predicati) ammette una pluralità di metodi di osservazione completa, cioé metodi che

osservano tutti gli individui una ed una sola volta: una osservazione completa

consisterà in una sequenza di N valori (i1,.., iN) che assegnano ad ogni osservazione

una modalità. E' evidente che ad ogni metodo di osservazione corrisponderà una

diversa famiglia di variabili casuali, che avranno in comune il codominio (1,..,D), ma

con distribuzione congiunta in generale diverse. Nell'interpretazione di Bach, la

deduzione della distribuzione (2) a partire dall' assunzione delle (3)-(5) equivale a

considerare la distribuzione (2) quale probabilità sulle composizioni finali del

processo stocastico in cui si osservano le sistemazioni delle N particelle in ordine

"alfabetico", intendendo con questo qualunque ordine legato a proprietà intrinseche

delle particelle. Supposto che questo segno distintivo esista, e quindi esista un nome

per ogni particella, per osservare x bisognerà attendere che le particelle siano

sistemate, e poi osservarle nell'ordine prescelto. Questo processo, o processo delle

configurazioni, verrà detto processo epistemico, perché il suo termine generico

Pr(xk+1=i|x1=i1,..,xk=ik) terrà conto del modo in cui l'informazione sullo stato delle

particelle di nome 1,..,k agisce sulla distribuzione della particella di nome k+1. E'

chiaro come sia problematica un'interpretazione fisica diretta di tale processo se le

particelle sono davvero identiche, e se ogni identificazione di tipo dinamico é

metodologicamente esclusa.

Un'interpretazione alternativa e fisicamente più convincente consiste nel considerare

un processo di osservazione completa ottenuto campionando la popolazione una volta

che gli individui sono sistemati sulle celle, estraendo "a caso" un individuo,

9

registrandone la modalità e facendolo uscire dal sistema. Stiamo prospettando con ciò

un processo di svuotamento del sistema, in cui l'uscita di una particella non modifica

lo stato delle particelle non ancora osservate. Questo processo u produce sequenze

(u1=i1,.., uN=iN) i cui indici rappresentano l'ordine di osservazione delle particelle;

essendo connesso ad uno svuotamento fisico, ogni particella viene osservata una ed

una sola volta, evitando ogni riferimento a questioni di indistinguibilità. Naturalmente

i processi x e u saranno interconnessi se dovranno descrivere la stessa popolazione; in

particolare dovranno essere uguali le probabilità di osservare una qualunque

composizione N. Mentre la supposta scambiabiltà di x, cioé l'equiprobabilità delle

sequenze subordinatamente a N, é ragionevole in assoluto perché le particelle sono

fisicamente identiche, l' ipotesi di scambiabilità del processo u riguarderà le modalità

del processo di estrazione, e sarà ragionevole quando quest'ultimo non sia influenzato

dallo stato delle particelle.

Abbandoniamo comunque la ricostruzione del lavoro di Boltzmann in termini di x

(che é la strada seguita da Bach), e tralasciamo le considerazioni su u, per presentare

una terza ricostruzione ad essa simile nella forma, ma sostanzialmente diversa per

metodo e significato.

Il processo stocastico fondamentale

Per ogni valore fissato di N e D la distribuzione (2), interpretata come la distribuzione

sui numeri di occupazione degli elementi di energia, può considerarsi come il

risultato di alcune condizioni probabilistiche sulla legge temporale del processo

stocastico N-dimensionale che descrive l'accomodamento degli N elementi di energia

sulle D molecole; queste condizioni, che adesso illustreremo, fanno sì che tale

processo sia scambiabile e invariante. Consideriamo il seguente processo di

preparazione: date D particelle nello stato di energia minima (posta

convenzionalmente uguale a zero), ad esse viene somministrata energia in quantità

elementari, fino ad un totale di N. Ad ogni passo una (ed una sola) particella accresce

la propria energia esattamente di . Questo processo può essere descritto attraverso la

probabilità di transizione P(j|M) per ogni j=1,..,D e tutti gli M regolari con

M=∑jMj=0,1,..,N-1. Quando il sistema contiene M elementi di energia e lo stato delle

particelle é M, l'(M+1)-mo passo (esperimento) è quello che aggiunge al sistema un

10

elemento di energia3. Ne segue che l'esperimento (M+1)-mo è una decomposizione

dell'evento certo ΩM+1=A1;M+1 G;M+1 , in cui Aj;M+1 è l'evento che si

verifica quando l'esperimento (M+1)-mo aumenta l'energia della j-ma particella. In

questo caso lo stato del sistema passa da

M = (M1,..,Mj,.., MD) a Mj= (M1,..., Mj+1,..,MD), e quindi il numero di occupazione

della j-ma particella passa da Mj a Mj+1.

Se Yj;M è la variabile indicatrice dell'evento Aj;M , cioé Yj;M =1 se e solo se YM=j,

il vettore casuale del M-mo esperimento è dato da (Y1;M ,....., YD;M ) e il vettore

casuale "numero di occupazione dopo m esperimenti" è

XM= ( X1;M ,....., XD;M ) = Error!, che è la somma dei vettori casuali di tutti gli

esperimenti dal primo al M-mo compreso.

Consideriamo ora una sequenza di vettori d'occupazione : {M; 0≤ M ≤ N-1},tale che

il primo termine della sequenza sia 0= (0,...,0), il secondo sia 0j, e in generale il

termine (M+1)-mo sia Mj e l'ultimo termine sia N. Diremo che una tale sequenza è

una traiettoria da 0 a N , o più semplicemente una traiettoria ad N. Una traiettoria (o

realizzazione) del processo di creazione é perciò una sequenza y=(y1,..,yN), che

precisa ad ogni passo su quale particella si accomoda ogni successivo elemento di

energia. Il numero di distinte realizzazioni é DN, e ci sono Error!traiettorie a N. Da

ciò si vede che le traiettorie y e le configurazioni x degli elementi di energia hanno

una struttura matematica identica. Mentre però una configurazione di oggetti davvero

indistinguibili non ha alcun significato empirico diretto, una realizzazione del

processo di riempimento di D contenitori può essere in principio controllata

empiricamente, se il vettore M é osservabile passo dopo passo. Chiameremo

traiettoria principale a N quella in cui i primi N1 elementi di energia si accomodano

sulla prima particella, i successivi N2 sulla seconda, e così via fino a che le ultime

ND sulla D-ma particella.

Sia ora

Pr{j | M}= Pr{Yj;M+1 =1 |M}

(7)

j

la probabilità della transizione da M a M . La (7) è una probabilità subordinata : è

cioè la probabilità dell'incremento dello stato di occupazione della j-ma particella

quando il vettore di occupazione del sistema è M. Pr{j|M}è una funzione di

3Possiamo

considerare ciascun passo del processo come un processo di creazione di

una eccitazione; allora il termine P(j|M) indica la probabilità che l' eccitazione sia

creata nello stato j dato M,

11

probabilità scambiabile quando per ogni M regolare, cioè Pr{M}>0, soddisfa le

condizioni seguenti :

C1.

Pr{j | M} ≥ 0 per ogni j=1,..,D;

C2.

Error!4,

C3.

Pr{j | M}Pr{h| Mj} = Pr{h| M}Pr{j | Mh} j ≠ h .

E' evidente da C3 che se Pr{j|M} è una funzione di probabilità scambiabile, allora

essa assegna la stessa probabilità a tutte le traiettorie a N . Infatti due distinte

traiettorie a N differiscono solo per l'ordine di occupazione delle celle. Consideriamo

la probabilità della traiettoria principale (1,.,1,1,2,2,..,2,...): essa sarà il prodotto di N

probabilità di transizione (7). Se applichiamo C3 quando M é (N1-1,0,..,0) otteniamo

che la traiettoria (1,.,1,2,1,2,..,2,...) ha la medesima probabilità della traiettoria

principale. Infatti le prime N1-1 transizioni sono le stesse, le ultime N-N1-1 sono

ancora le stesse, ed il prodotto delle due centrali ha la stessa probabilità per C3.

Procedendo in questo modo si ottiene l'equiprobabilità di tutte le traiettorie allo stesso

N.

Poichè Pr(N)=Error!, e poichè le distinte traiettorie a N sono Error!, si ottiene di

nuovo:

-1

Pr(y)=Error! Pr(N)

(3')

o, dalla definizione di probabilità condizionata,

-1

(4')

Pr(y|N)=Error!

per yN

Ora una traiettoria è una sequenza di transizioni; se si è in grado di calcolare Pr{j|M}

per ogni M si potrà quindi determinare la probabilità di una qualunque traiettoria.

Osserviamo che condizioni C1,C2, e C3 non fissano in modo univoco Pr{j|M}.

Per introdurre le altre condizioni necessarie a determinare la probabilità di transizione

passiamo attraverso la nozione di quoziente di eterorilevanza a M :

Qh;j(M) = Error!

j≠h

valida ovviamente per Pr{j | M} diverso da zero.

In termini del quoziente di eterorilevanza C3 é equivalente alla seguente:

C3'.Qh;j(M) =Qj;h(M)

Imponiamo un'ulteriore condizione, quella di invarianza del quoziente di

eterorilevanza.

4Nel

caso in cui il processo si applichi a fermioni questa relazione naturalmente varrà

per tutti i vettori regolari eccetto n=(1,1,..,1), in cui il processo si arresta.

12

C4. Qh;j(M') = Qq;f(M") = Q(M) per h ≠ j, q ≠ f, ∑jMj'=∑jMj"=M,

Se Pr{j | M} è una funzione di probabilità scambiabile che soddisfa anche C4 allora

Pr{j | M} é detta invariante.

Denotiamo con il quoziente di eterorilevanza a 0 : =Qh;j(0) = Error!, h≠j. Se vale

C4 questo parametro non dipende da j e da h, e può assumere qualsiasi valore

compreso nell'intervallo (0,Error!]. In termini delle condizioni C1-C4 si può

dimostrare il seguente teorema fondamentale[7]:

Teorema. Se Pr{j |M} è una funzione di probabilità scambiabile ed invariante,

allora vale la seguente espressione :

Pr{j | M} =P(j |Mj,M)= Error!

(9)

dove pj=Pr{j|0} e = Error!.

Per determinare completamente Pr{j|M}, che é funzione solo di Mj e M, e' necessario

fissare il valore della distribuzione iniziale p={pj} e di (oppure )In particolare si

ottiene la distribuzione (2) per =D, cioé:

C5:

=Error!= Error!,

e per p={pj} uniforme, cioé:

C6:

pj=D-1, j=1,..,D

Questa caratterizzazione della distribuzione (2), intendendo con questo termine

l'esplicitazione dell' insieme delle condizioni sulla funzione di probabilità Pr{j | M}

che regola il processo, evidenzia in modo semplice la legge cui gli elementi di energia

devono obbedire per produrre una distribuzione uniforme sui numeri di occupazione

(gli stati delle particelle). Diremo che Pr{j | M} è una "legge individuale", cioé la

distribuzione di probabilità che regola il comportamento probabilistico dell' M+1-ma

unità statistica (descritta dalla M+1-ma osservazione) condizionata all'evidenza

empirica, riassunta dalla "statistica sufficiente" M. La legge risultante Pr(N), di cui la

(2) é un esempio, viene detta "legge N-predittiva", poiché descrive la distribuzione

sulle possibili composizioni N della popolazione di N individui. La nostra

ricostruzione può perciò riassumersi nella esplicitazione delle condizioni sulla legge

individuale che riproducono una assegnata legge N-predittiva. Si dimostra facilmente

che la legge N- predittiva generata dalla (9) è la seguente:

Pr(N;,p) = Error!

(9')

che per è la distribuzione di Polya D-variata. Si vede immediatamente che la (2)

si ottiene dalla (9') ponendo pi=1 per ogni i, che è il modo più sintetico di esprimere

13

le due condizioni C5 e C6. Allora la legge individuale che soddisfa l'insieme delle

condizioni C1-C6, e conseguentemente genera la (2), é la seguente:

Pr{j | M} = Error!

(10)

[8]

in cui si riconosce immediatamente

il termine "classico" Error!ed il cosiddetto

termine di "emissione stimolata" Error!, responsabile di prevedibili correlazioni

positive tra gli "elementi di energia". Infatti all'inizio Mj=0, M= 0 e P(j|0,0)=Error!.

Se il primo oggetto si è sistemato nella cella j-ma, la probabilità che il secondo

oggetto si sistemi nella stessa cella sarà : Mj=1, M=1 e P(j|1,1)= Error!.

E' utile introdurre il quoziente di autorilevanza iniziale Qj;j(0) Error!; esso

confronta la probabilità di un secondo accomodamento in una cella già occupata con

la probabilità iniziale, e vale = Error!>1; perciò la realizzazione (y1=j,y2=j) avrà

probabilità Pr(y1=j,y2=j)= Pr(y1=j)Pr(y2=j)>pj2=D-2. Il quoziente di eterorilevanza

iniziale Error!confronta invece la probabilità di un accomodamento al secondo

tentativo in una cella ancora vuota con la probabilità iniziale, e vale = Error!<1; la

realizzazione (y1=j,y2=i) avrà probabilità Pr(y1=j,y2=i)=Pr(y1=j)Pr(y2=i)<pjpj=D-2

. Perciò al secondo passo é più probabile trovare una particella assegnata con energia

pari a 2 che due particelle assegnate con un elemento ciascuna. Entrambi i

coefficienti descriveranno la correlazione esistente tra gli insediamenti degli elementi

di energia e saranno uguali a 1 nel caso di indipendenza. Ma tralasciamo per ora il

processo fondamentale e torniamo al problema di Boltzmann.

Una particella in un termostato

Supponiamo allora che le D particelle con energia pari a N siano descritte dalla (2):

vogliamo dedurre la distribuzione di probabilità per gli stati di una fissata particella.

Se raggruppiamo le particelle in due sottoinsiemi, rispettivamente con d e D-d

particelle, e sommiamo su tutti i possibili valori n e N-n di elementi di energia per i

due sottosistemi, potremo scrivere la (1) nel modo seguente:

W(N,D)=(N+D-1;N) =Error!=

=Error!

(11)

in cui il simbolo ";" separa le variabili dai parametri che identificano i due sottostemi.

Consideriamo adesso un vettore di occupazione che assegna k elementi alla jma particella e, in modo qualsiasi, i restanti N-k sulle altre D-1 particelle.

Calcoliamo la probabilità marginale per la particella j-ma : in modo del tutto naturale

considereremo le restanti D-1 particelle raggruppate insieme come costituenti un

14

"serbatoio", o "bagno termico" in grado di scambiare eccitazioni con la particella

prescelta. Dobbiamo calcolare Pr{Nj=k} dati i parametri N e D.

{Nj=k} corrisponde alla bipartizione del sistema W(k,N-k; 1,D-1), dalla (2) con d=1

e n=k

W(k,N-k; 1,D-1)= ( N-k+D-2;N-k) ,

e allora, data l'uniformità della distribuzione (2), si avrà:

Pr{Nj=k; N,D)=Pr(k; N,D)= Error! (12)

in cui i valori dopo il segno ";" vanno intesi come parametri che caratterizzano il

sistema particella + bagno termico. Più esattamente, la (12) é la distribuzione

marginale per lo stato della particella, espressa in funzione dei valori N e D. Questi

ultimi non sono valori aleatori, su cui sia definita una probabilità. In questo caso

avrebbe senso la scrittura Pr(k| N,D), che indicherebbe l'usuale probabilità di k

condizionata agli eventi N e D.

La (12) è ancora una legge N-predittiva riconducibile alla forma (9'), che può

ricavarsi come legge temporale del processo bidimensionale seguente:

(0,N)

(1,N-1)

(0,0)

(N,0)

15

Il vettore finale del processo (k,N-k) descrive il numero k di elementi che si

sistemano sulla particella e quello N-k di elementi che si sistemano sul termostato. La

legge di composizione di questa popolazione di due "individui", la particella e il

termostato, é Pr(k,N-k; N,D), che sottointendendo i parametri può scriversi

semplicemente Pr(k), dove k é lo stato finale della particella. La legge individuale

della particella, che ne descrive l'accrescimento in energia, é una marginalizzazione

della (10), così come la (12) lo è della (2). Se con aM+1 indichiamo l'accomodamento

dell' M+1-mo elemento sulla particella, si ha Pr(aM+1|m,M-m)= Error!, mentre

Pr(bM+1|m,M-m)=1-Pr(aM+1|m,M)=Error!descrive l'accomodamento dell' M+1-mo

elemento nel termostato.

La probabilità di una realizzazione della composizione (k,N-k) vale

Error!,

ed il numero delle distinte realizzazioni di (k,N-k) é Error!, per cui :

Pr(k,N-k)= Error!=Error!,

cioé la (12).

La (12) non dipende da j, per cui le distribuzioni marginali sugli stati delle D

particelle sono eguali. Essendo fissato il numero totale di elementi N, varrà perciò per

il valor medio della (12) che D<k>=N, come é facile verificare; perciò

<k> =:=:∑kkPr(k; N,D)=Error!,

(13)

e la media dell'energia della particella é <E> = = w. Il fatto che il numero medio

di eccitazioni per particella , dove la media và intesa su tutte le realizzazioni del

processo, sia pari al numero totale di eccitazioni diviso il numero di particelle, che è

il parametro esterno Error!, segue dall'essere le distribuzioni marginali delle D

particelle tutte eguali.

Come abbiamo visto, in questa ricostruzione della (2) e della (12) gli N elementi sono

necessariamente correlati positivamente. Anche le energie delle particelle sono

correlate, poichè l' energia totale del sistema ED=Nè fissata da N. Questo secondo

tipo di correlazione, negativa, può essere indebolita quanto si vuole operando nel

modo seguente.

Limite termodinamico. Dalla Polya alla binomiale negativa

Aggiungiamo al sistema particelle ed elementi di energia in modo che, per N ∞ e

D∞, si conservi il numero di elementi per particella Error!=, e osserviamo come

16

cambia la probabilità marginale per la generica particella . Questo accrescimento del

serbatoio che conserva l'energia media delle particelle é normalmente giustificato in

fisica dal grande numero di particelle elementari che costituicono i corpi

macroscopici. Esso viene definito "limite termodinamico"

Pr(k; N,D) = Error!=

= Error!N∞,D∞,Error!=

k

k

Error! Error! = Error! =PrT(k; );

cioé

PrT(k; )= Error!

k

k=0,1,....

(14)

La (14) dipende solo da , che risulta così l'unico parametro che caratterizza le

distribuzioni nel T-limite. Osserviamo che naturalmente ∑kkPrT(k;N,D)=, cioé il

limite termodinamico conserva la media della distribuzione .

Ponendo x= Error!la (14) diventa:

P( k; x()) = (1-x) xk

k=0,1,....

(15)

Nel caso del "limite termodinamico" della distribuzione uniforme (2) si ottiene come

probabilità marginale la distribuzione geometrica5.

Scelto opportunamente lo zero dell'energia, la particella ha l'energia Ek se contiene k

elementi; la probabilità di avere l'energia Ek è perciò:

P(k) = xk (1-x) = Error!

(16)

E' intuitivamente plausibile in questa nuova situazione (di accrescimento del

serbatoio che conserva le proprietà "locali", o "intensive", della particella, in questo

caso l'energia media) che il vincolo della costanza dell'energia totale divenga

irrilevante, e che la correlazione negativa tra le energie delle diverse particelle tenda a

zero.

Infatti é già evidente dalla (16) che la particella j può assumere tutti i valori di energia

da 0 ad ∞. L'energia totale del sistema é infatti cresciuta fino all'infinito, ed é

possibile che tutta l'energia disponibile si concentri sulla particella .

5La

distribuzione geometrica è la distribuzione dei tempi di attesa del primo

insuccesso, quando lo schema di estrazione é bernoulliano. In genere è Pr {X1= h}=p

qh-1, h=1,2.. In questo caso la stessa distribuzione risulta quale limite di un processo

stocastico in cui gli incrementi sono positivamente correlati.

17

Adesso consideriamo d particelle, immerse nel serbatoio costituito dalle restanti D-d

compagne, e vogliamo calcolare Pr{N1=k1&..&Nd=kd}, dati i parametri N e D.

Se la somma di tutti i elementi k1+..+kd vale n, ogni stato n delle d particelle sarà

compatibile con le (N-n+D-d-1;N-n) possibili situazioni del termostato. Per cui di

nuovo

Pr(n; N,D)=Error!

(17)

dove n indica lo stato d-dimensionale delle d particelle. La (17) é una

generalizzazione della (12) al caso di d particelle.

Passiamo al limite termodinamico N∞, D∞, Error!= : la probabilità di un ben

preciso stato n delle d particelle diventa, in un modo del tutto analogo al caso

precedente:

Pr(n; N,D)=Error!=Error!

Error!= xn(1-x)d,

(18)

dove x= Error!, e di nuovo la probabilità dipende solo da d e Error!=.

Dato che P(n; ) é la congiunzione degli stati energetici k1,..,kd delle d particelle con

k1+..+kd=n, é evidente dalla (16) e dalla (18) che

P(n; )=P(k1,..,kd ; )= P(k1; )..P(kd; ),

cioè gli stati energetici delle d particelle diventano indipendenti.

Questo naturalmente non vale per le distribuzioni P{n; N,D}e P{k; N,D}, come si

può facilmente verificare dalla (13) e dalla (17).

Con ciò può dirsi dimostrato quanto intuitivamente appariva plausibile. Avendo a che

fare con una popolazione finita, soggetta a vincoli precisi, "deterministici", l'esistenza

del vincolo introduce una correlazione negativa "eliminabile" , che può appunto

essere eliminata considerando la popolazione data quale sottoinsieme di una

popolazione infinita che conservi i valori medi "locali". Tornando all'esempio di

Boltzmann, ci si può chiedere la probabilità che il sottosistema di d particelle abbia

energia pari ad n elementi, cioè Ed=n.

Si vede dalla (17) che la probabilità di uno stato del sottosistema dipende solo dalla

sua energia totale, per cui tutti gli stati corrispondenti allo stesso n sono

equiprobabili. Quindi la probabilità cercata sarà

Pr(n; )=(n+d-1;n) Pr(n; )=(n+d-1;n) xn(1-x)d

(19)

La (19) è la distribuzione di Pascal o binomiale negativa ed è la generalizzazione

della distribuzione geometrica .

18

Limite continuo. Dalla Polya alla Beta

Ripartiamo dalla probabilità (3) di avere k oggetti in una cella (o k elementi su una

particella), dati il numero totale N distribuito sull'insieme delle D celle.

P(k; N,D) =Error!

Aumentiamo il numero di oggetti , N »1 , tenendo fisso questa volta il numero D delle

celle. Nella sopra detta interpretazione fisica questa operazione potrà corrispondere

ad un aumento graduale dell'energia del sistema fino all'infinito se il quanto di energia

é finito. Alternativamente l' operazione può essere compensata da una diminuzione

del valore del quanto di energia , di modo che ED=N=Dw, dove w é l'energia per

particella, restino invariate. Questa seconda fu naturalmente la strada seguita da

Boltzmann, che doveva liberarsi alla fine della discontinuità "quantica" genialmente

introdotta all'inizio per poter operare in modo combinatorio sul problema.

P(k ; N,D) =Error!=

Error!D)Error!

per cui possiamo scrivere :

D-2

Pr(k; N,D) Error! = Error!B(Error!;1;D-1) ,

dove B(Error!; 1;D-1) è la distribuzione Beta : B(x ; = Error!

Questa convergenza in distribuzione può essere utilmente inquadrata alla luce del

teorema di rappresentazione di deFinetti[5]. Partiamo infatti dal nostro processo

scambiabile ed invariante caratterizzato da =D e pj=D-1 e consideriamone la

marginalizzazione su due sole celle, una contenente la j-particella e l'altra le restanti

D-1. Ad ogni passo j=1 indichi l'accomodamento sulla particella e j=2 quello sul

termostato. La probabilità iniziale sarà p1=D-1 e p2=1-D-1, ed il vettore di

occupazione N=(N1,N2) sarà funzione solo di N1=k e di N. Indichiamo questo

vettore con (k,N), e interpretiamolo come "k successi in N prove". Il teorema di

deFinetti afferma che in un processo scambiabile indefinitamente proseguibile

Pr(k,N) ammette la seguente rappresentazione:

Pr(k,N)= Error!xk (1-x)N-k f(x) dx

in cui f(x): f(x)≥0 eError!f(x) dx=1 é la densità di probabilità iniziale sul simplesso

dei possibili valori del parametro x, e Pr(k,N|x)= (N;k) xk(1-x)N-k é la probabilità di

(k,N) dato x: essa é la distribuzione binomiale di parametro x, ed esprime il fatto che

il processo é indipendente subordinatamente ad ogni valore di x. Quando Pr(k,N|x)

19

sia pensato come una funzione di x con parametri (k,N) viene detta verosimiglianza

di x.

Il teorema di deFinetti, che rende rigorose e generali le tecniche inferenziali di

ascendenza laplaciana, é il cardine della "filosofia della scambiabilità" che permea la

contemporanea visione della stima statistica. Un processo scambiabile é una mistura

di processi indipendenti: la "distributione peso" f(x) esprime l'ignoranza iniziale (in

senso laplaciano), o la probabilità soggettiva iniziale (secondo le interpretazioni

soggettivistiche) riguardo alle possibili composizioni di una popolazione infinita.

Come si può vedere a proposito di scattering di fotoni[8], f(x) può rappresentare la

frequenza relativa con cui si realizza il valore x del parametro che regola il processo.

Se il parametro fosse noto, allora f(x) si ridurrebbe a (x-x0), da cui Pr(k,N) =

Pr(k,N|x0)= = (N;k) x0k(1-x0)N-k, ed il processo sarebbe indipendente. Un secondo

significato di f(x) é il seguente: la densità iniziale può essere intesa come la

distribuzione limite cui converge (in legge) la successione della distribuzioni delle

variabili casuali frequenze relative. Mostriamolo in modo non formale.

La verosimiglianza (N;k) xk(1-x)N-k per grandi N e k tende ad una Gaussiana

(N;k) xk(1-x)N-k ≈ Error!= Error!,

che per N∞ tende alla funzione Error!, la quale concentra tutta la verosimiglianza

su x=Error!

Per cui si avrà:

Pr(k,N)= Error!xk (1-x)N-k f(x) dx Error!Error!f(x) dx= Error!f(Error!

),

cioé NPr(k,N)f(Error!).

Per grandi valori di N si ha che Pr(k; N,D) tende a zero perché il dominio della

distribuzione cresce senza limite, ma NPr(k,N) resta finito. Se passiamo alla variabile

casuale frequenza relativa u=Error!, si avrà per le densità p(k)dk=p(Error!)d(Error!

), cioé NPr(k,N)=p(u); per cui la densità della frequenza relativa (e dell'energia

relativa) sarà proprio il peso iniziale f(u).

Se il processo, oltre che scambiabile, é invariante, allora vi é una corrispondenza

biunivoca tra la densità iniziale f(x) ed i parametri e {pj} della legge individuale:

cioé f(x)=B(x;p1;(1-p1). Quindi nel nostro caso

Pr(k,N)= Error!xk (1-x)N-k B(x;1;D-1) dx

dato che =p=1=(1-p)=D-1

20

Nel -limite (i.e.D=cost, N∞) si ha dunque che la probabilità dello stato della

particella dipende solo da D.La particella assorbe comunque sempre infiniti elementi

di energia, per cui si può dare un significato fisico a tutto ciò solo mandando a zero il

valore del quanto e considerando l'energia quale limite continuo della variabile

discreta k. In tal caso basterà interpretare come la frequenza relativa Error!della

particella come la frazione dell'energia totale che le appartiene.

Lo stesso limite N∞ può essere effettuato per il sottosistema di d particelle.

Partendo dalla (17), e passando al numero totale dei quanti del sottosistema, si ha :

Pr(n; N,D)=Error!.

Per N>>D,n>>d si può scrivere:

(n+d-1;n) Error!;

(N+D-1;N) Error!;

(N-n+D-d-1;N-n) Error!;

per cui

d-1

D-d-1

Pr(n; N,D)Error!=Error! Error!

=

=Error!B(Error!;d,D-d).

Si può qui ripetere, in modo più generale, quanto espresso sopra nel caso di una sola

particella. Se passiamo alla variabile casuale "frequenza relativa del sottosistema" v=

Error!, si avrà per le densità p(n)dn=p(n(v))dn(v)=p(n(v))Error!dv; per cui la

densità della frequenza relativa (e dell'energia relativa Error!) sarà proprio

p(v)=B(v; d,D-d).

A questo punto, partendo dalle distribuzioni di probabilità del numero di occupazione

di un insieme di d individui che condividono con altri D-d individui N elementi di

energia, abbiamo studiato il sistema in due direzioni ben distinte:

a:(T-lim): abbiamo fatto crescere indefinitamente molecole ed elementi di energia, in

modo da conservare le proprietà "locali" del sistema (cioè );

b:(-lim): abbiamo fatto crescere indefinitamente il numero di elementi di energia, in

modo da conservare però il numero delle molecole. In questo secondo caso abbiamo

introdotto le variabile aleatorie E=k, Ed=n,ED=N, che per 0 restano finite.

Le distribuzioni di partenza P(n;N,D) e P(k;N,D) sono distribuzioni di Polya di

parametri (d,D-d) e (1,D-1) rispettivamente. Seguendo le due trasformazioni, si

ottiene nel primo caso:

21

PT(n;N,D)= T-limP(n;N,D)=(n+d-1;n) xn(1-x)d,

cioé una distribuzione binomiale negativa di parametri x e d, e dove x= Error!e =

Error!; nel secondo caso invece:

Error!

d-1

D-d-1

P(n;N,D)=-limP(n;N,D) Error!

,

o più correttamente per le frequenze relative v=Error!= Error!e le corrispondenti

densità:

-lim p(v;N,D)= Error!vd-1(1-v)D-d-1,

cioè una distribuzione Beta di parametri d e D-d.

Le stesse trasformazioni applicate alla distribuzione per una sola particella sono casi

particolari (d=1) delle funzioni dette.

Ma il lavoro di Boltzmann non si arresta qui: esso procede al calcolo del T-limite

della distribuzione continua B(Error!;1,D-1)=Error!

Dalla Beta alla Gamma

Partiamo adesso dall'andamento asintotico nel -limite

Pr(n;N,D) Error!

d-1

D-d-1

Error!

= Error!B(Error!; d,D-d)

(20)

Fissato un N>>1, al variare di n=0,1,..,N otteniamo la probabilità di tutti i numeri di

occupazione possibili per gli elementi di energia delle d molecole. Ricordando che

Ed=n=Error!Dw la (13) fornisce anche la distribuzione di probabilità per l'energia

del sottosistema .Per le possibili frequenze relative ud=Error!avremo:

d-1

D-d-1

NPr(n;N,D)B(Error!;d;D-d)= Error! Error!

.

Omettiamo l'indice d per l'energia del sottosistema, per non appesantire troppo la

notazione.

La densità p(Error!) =B(Error!; d,D-d) esprime la densità di probabilità che il

sottosistema abbia esattamente la frazione Error!dell'energia totale ED, che é utile

esprimere in funzione di D.

Il limite termodinamico in questo caso continuo consiste nel far crescere D in modo

che i valori medi locali si conservino. L'energia totale del sistema ED crescerà perciò

oltre ogni limite, mentre l'energia per particella resterà costante. La media di B(x;

) é <x>=Error!, per cui <u>=Error!, ed <E>=Error!ED=Dw . Consideriamo

allora

d-1

pError!=B (Error!;d;D-d)= Error!

22

D-d-1

Error!

,

e facciamone il limite per D∞, w=cost=,

L' andamento asintotico per D>>d é il seguente:

d-1

D

pError! Error! Error! ,

e passando a p(E)=Error!pError!= Error!pError!, si ha infine:

lim D∞p(E)= Error!dEd-1 e-E,

che per una singola particella produce la distribuzione esponenziale

p(E)= e-E

(20')

molto simile alla famosa distribuzione di Maxwell, con E=Error!mv2, che

Boltzmann riusciva così a derivare a partire da considerazioni puramente

probabilistiche.

Per concludere al commento del procedimento del 1868, possiamo dire che

-1

Boltzmann parte dalla distribuzione uniforme su D particelle Pr(N)= (N+D-1;N) ,

ne calcola la distribuzione marginale per una particella Pr(k; N,D)= Error!, ricava

nel limite continuo p(Error!)=B(Error!; 1,D-1) e ne fa il limite termodinamico,

ottenendo la distribuzione esponenziale p(E)= e-E. Tutto questo in circa due

pagine di eccezionale valore fisico e probabilistico. Bach definisce queste pagine un

capolavoro di calcolo delle probabilità. Ciò che é essenziale dal nostro punto di vista

é la superiorità di questo metodo (o metodo della marginalizzazione) rispetto a quelli

usati successivamente, basati su "probabilità non normalizzate" e considerazioni

combinatorie che hanno finito per dilagare nel campo della meccanica statistica6.

Partendo da uno schema finito e da una distribuzione di probabilità su tutte le

descrizioni di stato delle particelle compatibili con l'energia fissata, Boltzmann é in

grado di pervenire a distribuzioni continue il cui significato é perfettamente

ricostruibile in termini di elementi di energia e particelle. Le particelle sono

equidistribuite, come richiede l'identità fisica; esse (nel limite termodinamico) sono

indipendenti, cioé non vi é correlazione tra lo stato dell'una e quello di una qualsiasi

altra; esse sono distinguibili, dato che sono punti di localizzazione degli elementi di

energia. Il risultato finale p(E)=Ce-E é una distribuzione di probabilità per una

particella: ciò ci consente di sottolinare la distinzione tra probabilità (di una

6

Per il valore di questo contributo di Boltzmann dal punto di vista della storia del calcolo delle

probabilità rimandiamo al già citato lavoro di Bach.

23

particella) e frequenza relativa (relativa alle D particelle), fonte di innumerevoli

confusioni in meccanica statistica.

L'unico neo di questa trattazione, e certo la cosa é non banale, consiste nel fatto che il

risultato finale p(E)=Ce-E è la distribuzione di Maxwell bidimensionale, e non la

tridimensionale

p(E)=C'

Error!

Un modello sbagliato?

Che cosa significa affermare che un modello statistico é inadeguato alla

rappresentazione di un sistema fisico? Innanzitutto un modello statistico consiste

nella "costruzione" di una distribuzione di probabilità, o sulla base di analogie (in cui

di solito compaiono urne, estrazioni, eventuali reimbussolamenti,..) intese a rendere

intuitivamente accettabili le assunzioni probabilistiche, o attraverso condizioni

esplicite cui la distribuzione deve sottostare (come nel processo invariante prima

introdotto). In seconda istanza la distribuzione di probabilità deve essere posta a

confronto con l'evidenza empirica: questo secondo passo é noto in statistica col nome

di saggio di significatività. Nel caso in cui Boltzmann avesse potuto misurare

direttamente l'energia di un campione di particelle, avrebbe potuto confrontare i valori

empirici con quelli previsti dalla p(E) fornita dal modello, e considerare se la

"distanza" tra i valori empirici e quelli previsti da p(E) fosse ragionevole od

eccessiva. Come é noto questi dati empirici furono disponibili solo molti decenni

dopo la formulazione del modello. In realtà la distribuzione di Maxwell fu assunta

immediatamente sulla base del suo potere esplicativo e predittivo per la teoria

cinetica e la termodinamica dei gas diluiti, e Boltzmann si limitò a tentare di

ricavarla su basi probabilistiche. Cosicché il confronto tra la p(E) fornita dal modello

ed il risultato atteso non dovette affrontare i delicati (e tuttora non perfettamente

chiariti) problemi derivanti dal confronto tra un'ipotesi statistica ed i dati[10].

Ammettiamo in ogni modo che il modello statistico non sia soddisfacente. Le

possibili ragioni sono molte: o vi sono errori nell'apparato deduttivo (errori di

calcolo); oppure le condizioni sulla distribuzione di probabilità sono inadeguate (per

esempio non é vero che gli elementi di energia sono correlati in modo che le

descrizioni di stato delle particelle siano equiprobabili); ancora, non é lecito per

qualche ragione fisica effettuare il limite continuo (quello termodinamico sembra

24

fuori discussione); infine, il modello "N elementi di energia su D particelle" é

inadeguato perché non é in grado di descrivere correttamente le modalità del carattere

di cui gli individui godono davvero, e cioé gli stati energetici delle D particelle. Se

così fosse, il processo stocastico potrebbe essere riutilizzato con successo in uno

schema opportunamente corretto. Focalizziamo quindi l'attenzione sull'adeguatezza

del modello a rappresentare gli stati delle particelle.

Se ho 2 molecole e 4 elementi di energia, e vale la (2), sono equiprobabili i cinque

stati N rappresentati da (4,0),(3,1),..,(0,4). Gli Z corrispondenti sono:

N

(4,0) e (0,4)

(3,1) e (1,3)

(2,2)

Z

(1,0,0,0,1)

(0,1,0,1,0)

(0,0,2,0,0).

Pr(Z)

2/5

2/5

1/5

Z1=(1,0,0,0,1) é il macrostato con una particella nello stato fondamentale e l'altra nel

quarto stato eccitato, Z2=(0,1,0,1,0) ha una particella nel primo ed una nel terzo,

Z3=(0,0,2,0,0) ha le due particelle nel secondo stato eccitato. Gli stati di una

particella singola sono k=0,1,..,4, e sono equiprobabili per ciascuna particella. Questo

è immediatamente evidente, ma apriamo una parentesi che sarà utile in seguito.

La questione si può vedere in due modi. Il primo, che corrisponde al metodo della

marginalizzazione appena esposto in modo formale, è il seguente: per ricavare la

probabilità che la prima particella contenga k elementi si sommano le probabilità di

tutte le descrizioni di stato in cui il primo valore sia k. In questo caso, essendo solo

due le particelle, è banale, perchè Pr(k=0)= Pr(0,4)= 1/5,.., Pr(k=4)= Pr(4,0)= 1/5.

Il secondo modo si basa sulle descrizioni Z: è interessante soprattutto perchè sarà

usato da Boltzmann in seguito, ed è molto semplice da capire in questo caso

semplicissimo.

Se il sistema è nello stato Z=(1,0,0,0,1), vi saranno una molecola "ferma" ed una con

energia pari a 4; questo stato ha probabilità 2/5; Se il sistema è nello stato

Z=(0,1,0,1,0), vi saranno una molecola con energia pari ad 1 ed una con energia pari a

3; questo stato ha probabilità 2/5; se infine il sistema è nello stato Z=(0,0,2,0,0), vi

entrambe le molecole avranno energia pari a 2; questo stato ha probabilità 1/5.

Ciascuno stato Z non menziona le molecole, mentre la somma delle componenti di

ogni Z vale D, per cui Z/D (=Z/2 in questo caso) è formalmente una distibuzione di

25

probabilità per una particella singola. Ad esempio, Z1/2=(1/2,0,0,0,1/2) assegna

probabilità uguale ad 1/2 per essere la molecola negli stati k=0 e k=4, e probabilità

nulla per k=1,2,3. Ne deriva che la media degli Z con pesi Pr(Z) può interpretarsi

come la distribuzione di probabilità di una generica molecola sugli stati ammessi dai

vincoli. Nel nostro caso

∑i Zi Pr(Zi)= Error!+Error!+ Error!=

(1/5,..,1/5), che è la distribuzione uniforme sulla generica particella.

Tornando al discorso principale, non é questa equiprobabilità che disturba, dato che

nel limite termodinamico si trasforma nella distribuzione geometrica con media pari a

2, e nel limite continuo nell'esponenziale. Ciò che non va é che gli stati possibili di

una molecola non sono un parametro esterno al modello, ricavato da considerazioni

dinamiche, ma risultano dal meccanismo-base di accomodazione dei quanti di energia

cinetica7! Questo meccanismo prevede un numero di stati di singola particella per

livello energetico pari a 1, cioé per ogni livello k=k esiste un solo oscillatore. Ci

aspettiamo perciò nel limite continuo g(E)= Error!= costante. Se ammettiamo invece

che il numero degli stati con energia minore o uguale ad E sia proporzionale al

corrispondente volume () dello spazio si ha()=Error!

Solo nel caso bidimensionale si ha ()=Error!

Se il meccanismo fosse costituito da molecole che si accomodano direttamente su

stati con probabilità uniforme, il risultato dovrebbe dipendere dal numero degli stati,

che andrebbero inseriti nel modello come richiede la dinamica; ma qui il modello è

"elementi su molecole", per cui gli stati delle molecole e la loro probabilità sono un

risultato. Già da qui si vede che il modello "elementi su molecole" non é in grado di

soddisfare il corretto numero degli stati che la dinamica prescrive. Il fatto che il

risultato descriva correttamente un gas bidimensionale é da considerarsi casuale.

Proprio perché riteniamo che per il resto la deduzione sia corretta, possiamo

affermare che non é possibile ricostruire l'insieme delle possibilità dinamiche (gli stati

delle particelle) di un gas a partire da "elementi di energia cinetica" comunicati alle

particelle. Lo schema "N oggetti su D celle" potrà essere ancora utilizzato, a patto di

una radicale reinterpretazione del significato da attribuire ai termini.

Frequenze di frequenze

7E'

evidente come queste considerazioni siano del tutto estranee al pensiero di

Boltzmann, ma abbiano solo un valore euristico per il modello che abbiamo

introdotto.

26

L'inadeguatezza

del

modello

statistico

per

la

derivazione

di

p(E)=C

Error!

f(E)=C(D) e-E(21)

e la trasforma nella funzione a scala fN(E)=f(k) per k<E≤(k+1)in cui f(k) é il

numero di molecole nello stato k, cioé

Zk~ k e-k= k qk, (22)

essendo q=e-.

Ora il vettore Z, essendo la versione discreta di f(E), é normalizzato al numero di

molecole D: é il numero di molecole con k elementi di energia, per ogni k. Se (come

abbiamo visto nell'esempio precedente) il vettore Z si normalizza ad 1, esso può

rappresentare la probabilità che una molecola abbia esattamente k elementi di

energia,

la

quale

risulta

perciò

proporzionale

a

Error!

Questa é la probabilità di osservare lo stato k di una molecola estratta "a caso " dalle

D presenti (ad esempio facendo un foro nel recipiente, e tenendo conto dei fattori

cinematici che influenzano questo tipo di campionamento). Si noti come in questa

memoria si possa intravvedere la svolta essenziale (che si consoliderà nei lavori

seguenti): la probabilità dello stato di una molecola, piuttosto che derivarsi

marginalizzando la distribuzione congiunta delle D molecole, a sua volta deducibile9

da ipotesi sui "sottostanti" elementi di energia, si ricaverà dalle frequenze dei

"sovrastanti " macrostati (frequenze di occupazione, o numeri di occupazione sugli

stati k, o stati degli oscillatori).

8Formalmente,

la (7) e la (9) Pr{j | M}= Pr{Yj;M+1 =1 |M} possono essere

generalizzate così:

Pr{Yj;n =1 |M}=Pr{Yj;n =1 |Mj,M} = Error!

per n>M

= Error!

per n≤M

Mentre per la regione predittiva n>M é necessario postulare l'invarianza della

funzione di probabilità, nella regione n≤M la formula richiede solo la validità della

condizione di scambiabilità, ed é perciò di molto più ampia applicazione. Dato che

Mj=Error!, la formula può scriversi come riferita a

E(Yj;n |Error!), con le due forme a seconda che l'n-ma osservazione compaia o no

nell'evidenza.

9Non è il caso di Boltzmann in questo frangente, anche se in una occasione almeno

analizzò la questione.

27

Z* <----- (1872-77) <--------Pr(Z)

Pr(k) <--------(1868) <---------Pr(k1,...,kD)

Questa procedura approssimata ha ancora un senso in Boltzmann, che é teso a

ricavare la distribuzione di Maxwell per la generica molecola; non ne ha invece

quando si cerchi il valore dell'entropia, o dell'energia media del sistema, che sono

funzioni della distribuzione congiunta D-dimensionale. Questa approssimazione non

compare nei lavori di Planck, il quale, subordinatamente al fatto che N eccitazioni

siano distribuite su D oscillatori, si accontenta del fattore (N+D-1;N) ; ricompare in

Bose e nel primo lavoro di Einstein sul Gas di Bose, per poi scomparire

definitivamente nel suo secondo lavoro sull'argomento[11]. Come vedremo più

dettagliatamente in seguito, é infatti evidente che la distribuzione sugli stati Pr(N)=

-1

(N+D-1;N) contiene tutta (e sola) l'informazione necessaria per la descrizione

statistica del (sotto)sistema.

28

Boltzmann 1877

Il medesimo modello "N elementi di energia su D particelle" é riutilizzato da

Boltzmann nel 1877[3]. Boltzmann calcola il numero W(Z) di complessioni N

compatibili con una distribuzione di stato Z. Il numero di distinti N é (N+D-1;N) ,

mentre il numero di N compatibili con un Z è W(Z) = Error!. Supponendo uniforme

-1

la distribuzione Pr(N)=(N+D-1;N) , é allora nota la distribuzione

-1

Pr(Z)= Error! per tutti gli Z: Error!=D e Error!=N

di cui Boltzmann cerca il massimo condizionato ai due detti vincoli . Il risultato é

Zk*~qk, e anche p(k)=Error!~qk. Questa distribuzione geometrica troncata diviene la

geometrica nel T-limite, ed ancora la (20') nel limite continuo. Questo lavoro di

Boltzmann é importante perché mostra la sua consapevolezza circa il legame esistente

tra la correlazione degli elementi di energia e la conseguente distribuzione sugli stati

N delle molecole: se gli elementi fossero indipendenti, allora lo stato di una molecola

avrebbe una distribuzione bernoulliana, che diviene poissoniana nel T-limite e

deterministica nel limite continuo, cioé p(E)=(E-E*)10. Riguardo l'atteggiamento

generale rispetto al problema, si consolida la svolta rispetto al lavoro del '68. Nel '68

si parte da una distribuzione sugli stati delle molecole, si marginalizza su una

molecola, e si lavora in modo esatto su questa distribuzione; nel '77 si parte dalla

stessa distribuzione, si calcola la distribuzione sui macrostati Pr(Z), si cerca il

macrostato più probabile (quello di equilibrio) e si pone alla fine Pr(k)=Pr(k|Z*)=

Error!.

Proprio nella stessa memoria Boltzmann abbandona gli elementi di energia, ed

assume che lo schema (che diverrà fondamentale) (N,D) si riferisca ad N particelle su

D celle dello spazio . Qui assistiamo ad una vera e propria traslazione di simboli e

significati, che possiamo tradurre nel linguaggio a noi più familiare: un vettore N

descrive l'occupazione delle D celle (ovvero insiemi di stati di particella singola, od

10Questo

corregge parzialmente quanto detto all'inizio, circa la non menzione da parte

di Boltzmann delle descrizioni di stato degli elementi di energia, che infatti inizia con

la distribuzioni uniforme dei loro numeri di occupazione. In questa fase della sua

opera egli comunque mostra piena consapevolezza delle conseguenze delle ipotesi

implicite nel suo lavoro del '68.

29

oscillatori); una configurazione x descrive la collocazione delle N particelle sugli

oscillatori. Il numero di configurazioni compatibili con un N fissato sarà perciò N!

Error!con i vincoli Error!=N e Error!i=E, dove gi indica il numero di oscillatori

della cella i-ma ed i é l'energia associata alla i-ma cella. Notiamo che essendo

cambiato il significato dei vettori x e N, é cambiata la posizione della relazione che

fissa il valore dell'energia. Inoltre i valori di energia di ogni cella i ed il numero di

stati per ogni cella gi sono determinati dalle proprietà dello spazio , sono perciò

parametri esterni del modello.

Confrontiamo questa nuova formulazione con quella della memoria del '68:

riscriviamo perciò la probabilità uniforme delle configurazioni delle particelle (2)

nella nuova simbologia, in cui N é il numero delle particelle (il vecchio D) ed E/ é il

numero degli elementi di energia (il vecchio N), cioé

-1

Pr(x; N,E)= (E/ +N-1;E/)

(2')

dove come al solito i simboli N ed E che stanno all'evidenza non sono eventi, ma

parametri che identificano la distribuzione. Osserviamo che N ed E sono due

parametri indipendenti l'uno dall'altro.

Indichiamo con N i vecchi macrostati Z , con le condizioni Error!=N, e Error!=E/.

Osserviamo che questa impostazione tratta in modo equiprobabile tutte (e sole) le

possibilità compatibili con l'energia data, che é un parametro del modello. In

particolare la probabilità dei macrostati N é fissata con esattezza : é la vecchia Pr(Z)

di due pagine sopra, che riscriviamo così

-1

Pr(N)= Error! . Il macrostato più probabile dati i vincoli può in principio

essere calcolato esattamente: l'approssimazione di Stirling é un espediente numerico

giustificato dalla ricerca di N* nel dominio dei macrostati compatibili con E.

Questo non é più vero nelle mutate condizioni cinematiche del '77. Se imponiamo che

Pr(x) sia uniforme dati i vincoli sarà:

Pr(x; N,E) =Pr(x; N)= Error!.

(2'')

Questa distribuzione é esatta come la (2) o la (2'), ed anch'essa può essere

marginalizzata. Se vogliamo calcolare Pr(x1=jm), cioé la probabilità che la prima

particella sia su un ben preciso oscillatore della m-ma classe, dobbiamo addizionare

le probabilità di tutte le configurazioni in cui le N-1 restanti particelle sono

compatibili col macrostato (N1,..,Nm-1,..,ND). Il loro numero é

30

(N-1;N1...Nm-1 ..ND)

g1N1..gmNm-1..gDND, per cui Pr(x1=jm)=Error!gm-1, in cui il

primo termine é la probabilità di appartenere all'm-ma classe, ed il secondo la

probabilità dello stato data la classe. Mentre nella (2') vi sono due parametri

indipendenti N ed E, nella (2'') il parametro della distribuzione è il macrostato N , e

questo sia per quella congiunta che per quella marginale. A differenza del modello

precedente, non vi é più una pluralità di macrostati compatibili con un valore di E e di

N, ma in generale vi é corrispondenza 1-1 tra E ed N, cioé la funzione E(N) é in

principio invertibile. Come é possibile liberarci di N e trovare una distribuzione

marginale che dipenda solo da parametri termodinamici? In principio il metodo del

macrostato più probabile fissata l'energia nelle nuove (e corrette) condizioni

cinematiche non ha alcun senso. Per recuperarlo, é necessaria un'approssimazione di

partenza: si deve introdurre un livello di descrizione "a grana grossa", in cui più classi

di oscillatori si unifichino in f<<D strati, con g1,..,gf oscillatori con energia per

particella E1,..,Ef. Per la nuova descrizione N=(N1,...,Nf) varrà Error!=N e Error!

=E, dove lo spettro di E differisce da quello (esatto) di E, e come vedremo può

considerarsi continuo. Se si pensa di formare gli strati suddividendo lo spazio

secondo i multipli di una quantità fissata ∆, l'energia degli strati sarà Ei=i∆, e siamo

perciò ricaduti in una situazione simile al modello di Boltzmann del 1868. Vi saranno

perciò molti macrostati esatti N compatibili con E. Inoltre sarà legittimo supporre

Ni,gi >>1, e quindi trattarli come quantità continue, e sostenere l'universale validità

dell'approssimazione di Stirling. Questa descrizione é finalizzata all'introduzione

(spesso velata) di una nuova ipotesi, e cioé l'equiprobabilità delle configurazioni

compatibili con E, di cui non é facile calcolare il numero, come nel caso della (2), o

nel caso della (2'') in cui si condiziona ad N. Quindi si può calcolare Pr(N|E) a meno

di un fattore di normalizzazione; se ne può però calcolare il massimo, cioé si può

individuare la descrizione N* che la massimizza con i vincoli Error!=N e Error!=E.

Abbiamo così messo in evidenza le ipotesi generalmente nascoste nel metodo N* nel

caso di "N particelle su D classi", ponendole a confronto col metodo Z* nel caso di

"N elementi su D particelle".

Una conclusione provvisoria é la seguente: nel modello del '68 il metodo del

macrostato più probabile data l'energia é probabilisticamente sensato, anche se é

sostanzialmente inutile; nel modello del '77 il metodo non ha senso se non

introducendo fin dall' inizio approssimazioni sulle classi e sui livelli energetici. Tutto

31

questo non é ovviamente imputabile a Boltzmann, il quale non ha problemi di spettri

o di quantizzazioni che non siano arbitrari strumenti di calcolo. L'aver legato la tanto

sospirata derivazione della distribuzione di Maxwell al metodo del macrostato più

probabile ha fatto sì che il metodo esatto della distribuzione sulle possibilità

elementari, della marginalizzazione e dei limiti termodinamici venisse

sostanzialmente dimenticato. In realtà, nel cosiddetto metodo elementare della

meccanica statistica[12], il cosiddetto macrostato di equilibrio (che é una frequenza

relativa) é sufficiente per la termodinamica, sicché le nozioni genuinamente

probabilistiche di distribuzione sulle possibilità elementari e di probabilità marginale

perdono di significato.

32

Parte II. Entra Brillouin

La distribuzione di Polya D-variata , da cui Boltzmann partì per la derivazione delle

probabilità marginali e dei limiti sopra visti, é un caso particolare della famiglia di

distribuzioni

Pr,p(N)= Error!= Error!

(23)

dove p=(p1,....,pD) é una distribuzione di probabilità, é un parametro reale, ed il

simbolo x[n] sta per x(x+1)..(x+n-1). Si ottiene la distribuzione uniforme per =D e

p=(D-1,....,D-1). La famiglia Pr,p(N) si può ricavare quale probabilità delle possibili

composizioni N di un campione, ottenuto dopo N passi di un processo stocastico

scambiabile ed invariante con probabilità iniziali p e parametro di correlazione

c=D/. Questo processo fu applicato alla statistica delle particelle elementari da