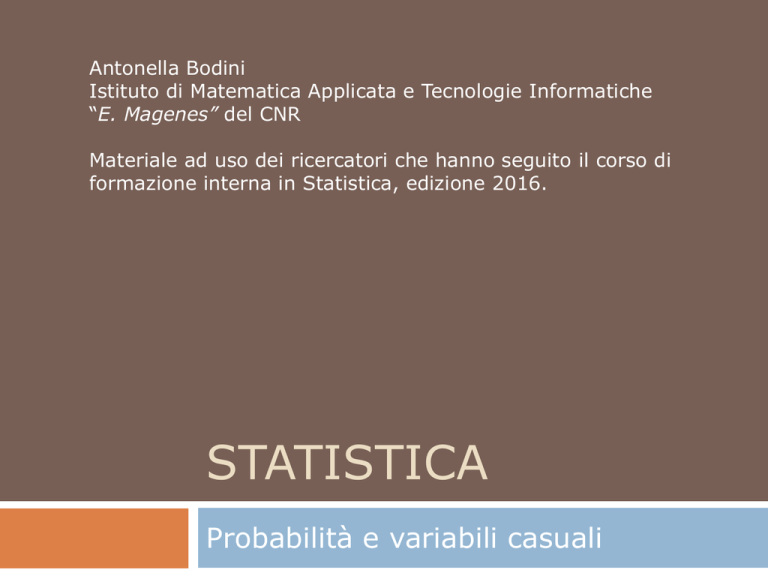

Antonella Bodini

Istituto di Matematica Applicata e Tecnologie Informatiche

“E. Magenes” del CNR

Materiale ad uso dei ricercatori che hanno seguito il corso di

formazione interna in Statistica, edizione 2016.

STATISTICA

Probabilità e variabili casuali

La definizione di probabilità

- Esperimento: qualunque procedimento che produca una

osservazione, detta esito (outcome)

- Spazio degli esiti ( ): insieme di tutti i possibili esiti,

esperimento

, di un

- Evento: sottinsieme dello spazio degli esiti (A, B, C,…)

- L’evento A si verifica quando l’esito dell’esperimento è un

elemento di A (

A).

A

La definizione di probabilità

Notazioni dall’insiemistica:

A B si verifica almeno uno dei due

A B si verificano entrambi

Ac (o A) non si verifica A

…

Eventi incompatibili

AA

A

A

B

B

La definizione (classica) di probabilità

Definizione:

una funzione reale P sugli eventi

tale che

0 P(A) qualunque sia A(*)

P( ) =1

Se A B = => P(A B)=P(A)+P(B)

Ne deriva che:

0 P(A) 1

P(Ac) = 1-P(A)

P(A B)=P(A)+P(B)-P(A B) se A

B

A

B

A

Se tutti i possibili esiti, , sono finiti

e “ugualmente possibili”, una P è

quella definita dal rapporto tra esiti

favorevoli ed esiti possibili.

Ex.: carte, dadi, ecc.

B

La definizione di probabilità

Definizione:

0 P(A) qualunque sia A(*)

P( ) =1

Se A B = => P(A B)=P(A)+P(B)

Ne deriva che:

0 P(A) 1

P(Ac) = 1-P(A)

P(A B)=P(A)+P(B)-P(A B) se A

B

B

A

AA

B

(*) In realtà, chiediamo che tutti gli

eventi che verranno considerati

formino una -algebra S, cioè:

• Se A è un evento ( S ) => Ac S

• Se Ai S

i 1 => i Ai S (l’unione numerabile di eventi è un

evento, e lo è anche l’intersezione)

La definizione di probabilità

Definizione:

0 P(A) qualunque sia A

P( ) =1

Se A B = => P(A B)=P(A)+P(B)

Ne deriva che:

0 P(A) 1

P(Ac) = 1-P(A)

P(A B)=P(A)+P(B)-P(A B) se A

B

Indipendenza

Gli eventi A e B si definiscono

(stocasticamente) indipendenti se

P(A

B)=P(A)P(B)

B

A

AA

B

La definizione di probabilità

Indipendenza

Gli eventi A e B si definiscono (stocasticamente) indipendenti se

P(A

B)=P(A)P(B)

A

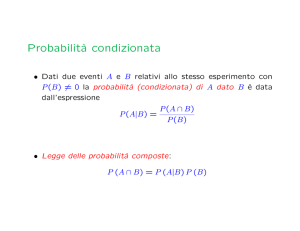

Probabilità condizionata: P(B) 0

P(A|B) = P(A B),

P(B)

P(A

B

B)=P(A|B)P(B)=P(B|A)P(A)

B=spazio

degli esiti

P(A|B) non coincide con P(B|A)

A e B sono indipendenti se e solo se P(A|B) = P(A) (e P(B|A)=P(B))

P(A1

A2 …

An)=P(A1)P(A2)…P(An)

∀ 𝑛, ∀ 𝐴1 , … , 𝐴𝑛 si ha P(A1

(successione indipendente)

A2 …

An)=P(A1)P(A2)…P(An)

La definizione di probabilità

Indipendenza

Gli eventi A e B si definiscono (stocasticamente) indipendenti se

P(A

B)=P(A)P(B)

A

Probabilità condizionata:

P(A|B) = P(A B),

P(B)

P(B)

0

Fissato B, la funzione 𝐴 → 𝑃 𝐴 𝐵 è ancora una probabilità:

P(Ac|B)=1-P(A|B)

P(A C|B)=P(A|B)+P(C|B)-P(A C|B)

P(A C|B)=P(A|B)P(C|B) se e solo se A e C sono indipendenti

condizionatamente a B

𝑃 𝐴𝐵 =

𝑃(𝐴 ∩ 𝐵)

𝑃 𝐵 𝐴 𝑃(𝐴)

=

𝑃 𝐵 ∩ 𝐴 + 𝑃(𝐵 ∩ 𝐴𝑐 ) 𝑃 𝐵 𝐴 𝑃 𝐴 + 𝑃 𝐵 𝐴𝑐 𝑃(𝐴𝑐 )

B

La definizione di probabilità

Probabilità condizionata:

P(A|B) = P(A B),

P(B)

P(B)

Teorema delle probabilità totali

H1, H2,…, Hn eventi a due a due disgiunti tali che

A S :

i

0

Hi =

P(A)=P(A H1)+ P(A H2)+ … + P(A Hn)=

=P(A|H1)P(H1)+ P(A|H2)P(H2)+…+ P(A|Hn)P(Hn)

H5

H7

H4

H2

A

H6

H1

H3

Esempi “tipici”

Gioco 1: estraiamo a caso una pallina dall’urna,

guardiamo il colore: dopo ogni estrazione,

rimettiamo la pallina estratta nell’urna.

P(R

V

3

5

5

8

8

8

V)=P(R)P(V)P(V)= × × = 0.146

indipendenza

a caso: palline

indistinguibili al

tatto, 5v + 3r

Gioco 2: estraiamo a caso una pallina dall’urna,

guardiamo il colore: dopo ogni estrazione,

mettiamo la pallina estratta fuori dall’urna.

P(R

V

V)=P(V3|V2 R1)P(V2|R1)P(R1)=

dipendenza

3 5 4

× × = 0.178

8 7 6

Es. 1-Le prove ripetute

Schema delle prove ripetute di Bernoulli.

Gioco 1: estraiamo a caso una pallina dall’urna,

guardiamo il colore: dopo ogni estrazione,

rimettiamo la pallina estratta nell’urna.

P(R)=3 8 e P(V)=1-P(R)=5 8

P(R

V

V)=

P(terza estratta sia V)=P(V)=5 8

3×5×5

75

8×8×8

512

=

=0.146

distribuzione Geometrica(p)

P(per avere la prima V servono 3 estrazioni)=P(R

R

V)=3 × 3 × 5 83

P(per avere la prima V servono 9 estrazioni)=P(RRRRRRRR V)=38 × 5 89

P(per avere la prima V servono k estrazioni) =

=P(R…R V)=3𝑘−1 × 5 8𝑘 =

k-1 volte

3

8

𝑘−1

× 58 = (1 − 𝑝)𝑘−1 × 𝑝

p = pr. successo

Es. 2-Gli esami clinici

popolazione

esaminata

test positivo

(T+)

P(T+|M)

sensibilità

ammalati

(veri T+)

falso

positivo

sani

(falsi T+)

test negativo

(T-)

falso

negativo

ammalati

(falsi T-)

P(T-|S)

specificità

sani

(veri T-)

Es. 2-Gli esami clinici

Test

Golden test

(realtà)

Malato

Sano

T+

a

b

T-

c

d

a+c

b+d

𝑎

P(T+|M) =𝑎+𝑐 , sensibilità ( )

𝑑

P(T-|S)=𝑏+𝑑 , specificità ( )

dichiarati dal

produttore del test

Es. 2-Gli esami clinici

p= P(M) prevalenza : prob. che ad un certo tempo t una

persona scelta a caso nella popolazione sia malata

Io mi sottopongo al test T con P(T+|M)=

𝑃

𝑀𝑇+

=

𝑃(𝑀 ∩ 𝑇+)

=

𝑃(𝑇+)

𝑃

𝑃

𝑆𝑇−

=

𝑃(𝑆 ∩ 𝑇−)

=

𝑃(𝑇−)

𝑃

p = 0.10

= 0.98

= 0.98

𝑃

𝑇+𝑀

𝑇−

𝑇+𝑀

𝑃 𝑀 +𝑃

e P(T-|S)=

𝑃(𝑀)

𝑇+𝑆

𝑃(𝑆)

=

𝛼𝑝

=0.116

𝛼𝑝+(1−𝛽)(1−𝑝)

𝑃 𝑇 − 𝑆 𝑃(𝑆)

𝛽(1−𝑝)

=

𝑆 𝑃 𝑆 +𝑃 𝑇 − 𝑀 𝑃(𝑀) 𝛽 1−𝑝 + 1−𝛼 𝑝

𝑃 𝑀 𝑇 + = 0.845

𝑃 𝑆 𝑇 − = 0.998

valore predittivo positivo

valore predittivo negativo

Es. 2-Gli esami clinici

p= P(M) prevalenza : prob. che ad un certo tempo t una

persona scelta a caso nella popolazione sia malata

Io mi sottopongo al test T con P(T+|M)=

e P(T-|S)=

p = 0.10

= 0.98

= 0.98

𝑃 𝑀 𝑇 + =0.845

𝑃 𝑆 𝑇 − = 0.998

p = 0.01

= 0.98

= 0.98

𝑃 𝑀 𝑇 + =0.331

𝑃 𝑆 𝑇− = 1

p = 0.10

= 0.98

= 0.99

𝑃 𝑀 𝑇 + =0.916

𝑃 𝑆 𝑇 − = 0.998

p = 0.10

= 0.98

= 0.90

𝑃 𝑀 𝑇 + =0.521

𝑃 𝑆 𝑇 − = 0.997

p = 0.10

= 0.99

= 0.98

𝑃 𝑀 𝑇 + =0.846

𝑃 𝑆 𝑇 − = 0.999

p = 0.10

= 0.80

= 0.98

𝑃 𝑀 𝑇 + =0.816

𝑃 𝑆 𝑇 − = 0.978

Es. 2-Gli esami clinici

Es. 3-Il meteo

Un semplicissimo modello probabilistico per il meteo.

Che domani piova (Rain) o non piova (Dry) dipende solo dal meteo

di oggi:

P(Rt+1|Rt)=0.60 e P(Dt+1|Dt)=0.85 (qque siano oggi e domani, t e t+1)

Domani

sono

prob.

condiz.

Matrice

transizione

M

Oggi

Rain

Dry

Rain

0.60

0.15

Dry

0.40

0.85

∗

𝑝0

1 − 𝑝0

P(R1)=P(R1|R0) P(R0)+ P(R1|D0) P(D0)=0.60 × 𝑝0 + 0.15 × 1 − 𝑝0 = 𝑀 ∗ (𝑝0 , 1 − 𝑝0 )[1]

P(R2)=P(R2|R1) P(R1)+ P(R2|D1) P(D1)=0.60 × P(R1) + 0.15 × 1 − P(R1) =

=𝑀 ∗ {𝑀 ∗ 𝑝0 , 1 − 𝑝0 1 }[1]

conoscendo la probabilità di pioggia al giorno 0 (iniziale) riesco a

calcolare P(Rt) per tutti i giorni t solo con la matrice di transizione M

Es. 3-Il meteo

Un semplicissimo modello probabilistico per il meteo.

Che domani piova (Rain) o non piova (Dry) dipende solo dal meteo

di oggi:

P(Rt+1|Rt)=0.60 e P(Dt+1|Dt)=0.85 (qque siano oggi e domani, t e t+1)

Domani

Matrice

transizione

M

Oggi

Rain

Dry

Rain

0.60

0.15

Dry

0.40

0.85

∗

𝑝0

1

1-𝑝0

0

osservo che

oggi piove

P(R1)=P(R1|R0)×1+ P(R1|D0)×0=0.60

P(R2)=P(R2|R1)×0.60+ P(R2|D1)×0.40 =0.60 × 0.60 + 0.15 × 0.40 = 0.42

=𝑀 ∗ {𝑀 ∗ 𝑝0 , 1 − 𝑝0 1 }[1]

conoscendo lo stato al giorno 0 (iniziale) riesco a calcolare P(Rt) per

tutti i giorni t solo con la matrice di transizione M

Es. 3-Il meteo

Un semplicissimo modello probabilistico per il meteo.

Che domani piova (Rain) o non piova (Dry) dipende solo dal meteo

di oggi:

P(Rt+1|Rt)=0.60 e P(Dt+1|Dt)=0.85 (qque siano oggi e domani, t e t+1)

Domani

Matrice

transizione

M

Oggi

Rain

Dry

Rain

0.60

0.15

Dry

0.40

0.85

∗

𝑝0

1

1-𝑝0

0

P(R1)=P(R1|R0)×1+ P(R1|D0)×0=0.60

P(R2)=P(R2|R1)×0.60+ P(R2|D1)×0.40 =0.60 × 0.60 + 0.15 × 0.40 = 0.42

=𝑀 ∗ {𝑀 ∗ 𝑝0 , 1 − 𝑝0 1 }[1]

P(R2R1)=P(R2|R1)×P(R1)=0.60 × 0.60 = 0.36

osservo che

oggi piove

Es. 3-Il meteo

probabilità giornaliera di pioggia

Simulazione

dal modello

Markoviano

stazionario

0.4

0.3

P(R_t)

0.5

0.6

Script3.R

pi(R)

0.27

0

20

40

60

day t

80

100

Altre impostazioni della probabilità

Frequentista: probabilità di un evento come limite della

frequenza relativa dei successi ottenuti ripetendo all’infinito

prove tutte identiche (ex: lancio della moneta).

Inconvenienti:

• la ripetizione all’infinito è solo ipotetica

• il fatto che ripetendo una prova per un gran numero di volte la

frazione di successi si stabilizzi su un certo valore richiede una

più accurata considerazione

Soggettiva: una persona assegna ad un evento una probabilità

sulla base delle sue informazioni/conoscenze (ex. dell’elezione

del Papa).

Inconvenienti:

• la consistenza delle assegnazioni

• la diversità di pr. assegnate da persone diverse allo stesso

evento (ma è davvero un inconveniente?).

Le variabili aleatorie

variabili aleatorie:

quantità di interesse

legate all’esito

dell’esperimento

𝑿

P

Le variabili aleatorie

𝑿∶

, 𝑺, P → (𝑹𝒌 , 𝑩(𝑹𝒌 ))

misurabile

(v. slide 5 per

-algebre)

W = {(i,j) : i=1,…6; j=1,…6} spazio degli esiti del lancio di due dadi

𝑋∶

,𝑆 → 𝑅

𝑃 𝑋=2 =𝑃

𝑋 𝑖, 𝑗 = 𝑖 + 𝑗

1,1

1

= 16 × 16= 36

W = {V,RV,RRV,RRRV,...}

𝑋 è il tempo del primo successo

𝑋∶

,𝑆 → 𝑅

𝑋 𝑅𝑅𝑉 = 3

𝑃 𝑋 = 3 = 𝑃 𝑅𝑅𝑉 = 3 × 3 × 5/83

𝑃 𝑋 = 𝑘 = 𝑃 𝑅𝑅 … 𝑉 = (1 − 𝑝)𝑘−1 𝑝𝑘

distribuzione (o legge) di 𝑋

La distribuzione Binomiale

𝑿∶

, 𝑺, 𝑃 → 𝒙𝟏 , 𝒙𝟐 , … , 𝒙𝒏

distribuzione o legge di

𝑋

:

𝒏 ≤ +∞

𝑃(𝑋 = 𝑥𝑖 ) per tutti i =1,…, n

𝑋 = 𝑛𝑢𝑚𝑒𝑟𝑜 𝑑𝑖 𝑟𝑜𝑠𝑠𝑒 𝑒𝑠𝑡𝑟𝑎𝑡𝑡𝑒

= RVRVV, VVRVV, ecc. ,

𝒙𝟏 , 𝒙𝟐 , … , 𝒙𝒏 = {0,1,2,3,4,5}

facciamo 5 estrazioni,

contiamo il numero di

rosse estratte.

Binomiale di parametro p : B(n,p)

𝑃(𝑋 =0)=P(VVVVV)= 5 8

5

𝑃(𝑋=1)=P(RVVVV)+P(VRVVV)+

… = 5× 5 8 4 (3 8)

𝑃(𝑋 = 𝑘)=

5 𝑘

𝑝 (1 − 𝑝)𝑛−𝑘

𝑘

Le variabili aleatorie discrete

Principali densità discrete

Uniforme discreta

Ex. il dado

equilibrato.

𝑃(𝑋 = 𝑥𝑖 ) =1/n ,

𝑖 = 1, … , 𝑛 < ∞

Bernoulli(p)

𝑃(𝑋 = 1)=p, 𝑃(𝑋 =0)=1-p

Esito di una prova

con due soli

possibili risultati

Binomiale(n,p)

𝑛 𝑘

𝑃(𝑋 = 𝑘)=

𝑝 (1 − 𝑝)𝑛−𝑘 ,

𝑘

𝑘 = 0,1, … , 𝑛

Numero di successi

in n prove

indipendenti e

identiche

(*)

𝑘−1 ,

Geometrica(p)

𝑃 𝑋 =𝑘 =𝑝 1−𝑝

Poisson( )

𝑃 𝑋 = 𝑘 = 𝑒 −𝜆 𝜆𝑘! , 𝑘 ≥ 0

(*) n=1 fornisce la Bernoulli(p)

𝑘

𝑘≥1

Tempo del primo

successo in prove

ripetute identiche

O distribuzione

degli eventi rari

Lo schema delle prove ripetute di

Bernoulli

Script4.R

Schema delle prove ripetute di Bernoulli

- Ad ogni singola prova ci sono solo due esiti possibili:

successo (1) o fallimento (0);

- In ogni prova la probabilità di successo è sempre la stessa, p;

- I risultati delle prove sono indipendenti.

𝑋𝑖 = esito della prova i-ma (0 o 1)

𝑋1 , 𝑋2 , … , 𝑋𝑛 , … successione di v.a. indipendenti tutte con la stessa legge

La Binomiale in R

0.15

0.20

0.25

Bin(10,5/8)

0.10

p

facciamo 10 estrazioni

con reimmissione e

contiamo il numero di

verdi estratte.

0.00

0.05

𝑋~𝐵𝑖𝑛𝑜𝑚(10, 5 8)

0

2

4

6

8

10

k

dbinom(k,n,p)

pbinom(k,n,p)

qbinom(q,n,p)

rbinom(N,n,p)

= P(X=k), con X Bin(n,p)

(densità)

= P(X k), con X Bin(n,p)

(f. ripartizione)

= quantile di ordine q della distribuzione Bin(n,p)

generazione casuale di N valori dalla distribuzione Bin(n,p)

La Geometrica in R

0.3

estrazioni con reimmissione fino

all’uscita della prima verde.

𝑋 = Tempo di prima uscita

0.1

0.2

𝑋~𝐺𝑒𝑜𝑚(5 8)

0.0

p

0.4

0.5

0.6

Geom(5/8)

0

2

4

6

k

dgeom(k,p)

pgeom(k,p)

qgeom(q,p)

rgeom(N,p)

8

10

num. estrazioni prima della prima

verde ← 𝑌

𝑋 = Tempo di prima uscita = 𝑌 + 1

𝑌~𝐺𝑒𝑜𝑚(5 8)

= P(Y=k) = P(X=k+1)

= P(Y k) = P(X k+1)

= quantile di ordine q della distribuzione

generazione casuale di N valori dalla distribuzione

La distribuzione di Poisson

Poisson(0.5)

Poisson(2)

0.0

0.3 0.15

0.00

0.0

0.1

0.05

0.1

0.20.10

p

p

0.2

0.3

0.4 0.20 0.5

0.25 0.6

Poisson(1)

0

2

4

6

k

8

10

0

2

5

4

6

10

8

k

Num. di incidenti ad un certo incrocio in un giorno;

Num. di telefonate ad un centralino all’ora;

Num. di bombe caduto in una delle quadrature della mappa di Londra nella WW2

10

15

La distribuzione di Poisson

Poisson(1)

0.2

0.1

p

0.2

0.0

0.1

0.0

p1

0.3

0.3

Bin(100,0.01)

0

2

4

6

k

8

10

0

2

Per n grande e p piccolo, Bin(n,p) Po(np).

rule of thumb n 100 e p 0.05 oppure n

4

6

8

10

k

100 e np

10.

Esempio

Una certa compagnia assicurativa effettua in media 4 pagamenti medici

consistenti al mese.

a) qual è la probabilità che il prossimo mese non ci siano rimborsi?

b) qual è la probabilità che il prossimo mese ci siano al massimo 2 rimborsi

c) qual è la probabilità che il prossimo mese ci siano almeno 4 rimborsi?

n = n. assicurati della compagnia

𝑛 ≥ 100

p = probabilità che un assicurato richieda un pagamento consistente in un mese

escluso il caso dell’epidemia, i clienti richiedono il pagamento consistente in

modo indipendente l’uno dall’altro.

𝑋𝑖 = 0 se assicurato i-mo non chiede rimborso, 1 se lo chiede

𝑌 = Num. di rimborsi richiesti

Schema delle prove ripetute di Bernoulli: 𝑌~𝐵𝑖𝑛 𝑛, 𝑝 con 𝐸 𝑌 = 𝑛𝑝 = 4

Risposte:

a) 𝑃 𝑌 = 0 = 0.01831564

b) 𝑃 𝑌 ≤ 2 = 0.2381033

c) 𝑃 𝑌 ≥ 4 = 1 − 𝑃 𝑌 ≤ 3 = 0.5665299

𝑌~𝑃𝑜(4)

(Ross, Esercizio 5 p. 234)

Valore atteso e varianza

𝐸 𝑋 =

𝑉𝑎𝑟 𝑋 =

𝑖=1,…,𝑛 𝑥𝑖 𝑃(𝑋

𝑉𝑎𝑟 𝑋 = 𝐸 𝑋 − 𝐸(𝑋)

= 𝑥𝑖 )

2

𝑖=1,…,𝑛(𝑥𝑖 −𝐸(𝑋)) 𝑃

𝑋 = 𝑥𝑖 =

𝑖=1,…,𝑛 𝑥𝑖

Principali densità discrete

Uniforme

discreta

𝑃(𝑋 = 𝑥𝑖 ) =1/n ,

𝑖 = 1, … , 𝑛 < ∞

Bernoulli(p)

𝑃(𝑋 = 1)=p,

𝑃(𝑋 =0)=1-p

2

2

𝑃 𝑋 = 𝑥𝑖 − 𝐸 2 𝑋 = 𝐸 𝑋 2 − 𝐸 2 𝑋

Valore atteso e Varianza

𝐸 𝑋 =𝑥

𝑉𝑎𝑟 𝑋 = 𝑛−1

𝑥𝑖 − 𝑥

𝐸 𝑋 =1×𝑝+0× 1−𝑝 =𝑝

𝑉𝑎𝑟 𝑋 = 12 × 𝑝 + 02 1 − 𝑝 − 𝑝2

= 𝑝(1 − 𝑝)

𝑃(𝑋 = 𝑘)=

𝑛 𝑘

𝑝 (1 − 𝑝)𝑛−𝑘 ,

𝑘

𝑘 = 0,1, … , 𝑛

𝐸 𝑋 = 𝑛𝑝

V𝑎𝑟 𝑋 = 𝑛𝑝(1 − 𝑝)

Geometrica(p)

𝑃 𝑋 = 𝑘 = 𝑝(1 − 𝑝)𝑘 , 𝑘 ≥ 0

𝐸 𝑋 = (1 − 𝑝) 𝑝

𝑉𝑎𝑟 𝑋 = (1 − 𝑝)/𝑝2

Poisson( )

𝑃 𝑋 = 𝑘 = 𝑒 −𝜆 𝜆𝑘! , 𝑘 ≥ 0

Binomiale(n,p)

2

𝑘

𝐸 𝑋 = 𝜆, 𝑉𝑎𝑟 𝑋 = 𝜆

Valore atteso e varianza

𝐸 𝑋 =

𝑉𝑎𝑟 𝑋 =

2

𝑖=1,…,𝑛(𝑥𝑖 −𝐸(𝑋)) 𝑃

𝑖=1,…,𝑛 𝑥𝑖 𝑃(𝑋

= 𝑥𝑖 )

𝑋 = 𝑥𝑖 = 𝐸 𝑋 − 𝐸(𝑋)

𝐸 𝑎𝑋 + 𝑏 = 𝑎𝐸 𝑋 + 𝑏

𝑉𝑎𝑟 𝑎𝑋 + 𝑏 = 𝑎2 𝑉𝑎𝑟(X)

qui

l’indipendenza

non serve!

2

= 𝐸 𝑋 2 − 𝐸2 𝑋

𝑋~𝐵𝑖𝑛 2, 𝑝

𝐸 𝑋 = 𝐸 𝑋1 + 𝑋2 = 𝑝 + 𝑝

𝑋𝑖 ~𝐵𝑒𝑟𝑛(𝑝)

𝐸 𝑋+𝑌 =𝐸 𝑋 +𝐸 𝑌

𝑉𝑎𝑟 𝑋 + 𝑌 = 𝑉𝑎𝑟 𝑋 + 𝑉𝑎𝑟 𝑌 + 𝐶𝑜𝑣(𝑋, 𝑌)

𝐶𝑜𝑣 𝑋, 𝑌 =

𝑖=1,…,𝑛(𝑥𝑖 −𝐸(𝑋))(𝑦𝑖 −𝐸(𝑌))𝑃(𝑋

se X e Y sono indipendenti

= 𝑥𝑖 , 𝑌 = 𝑦𝑖 ) = 𝐸(𝑋𝑌) − 𝐸(𝑋)𝐸(𝑌)

𝐶𝑜𝑣 𝑋, 𝑌 = 0 e 𝑉𝑎𝑟 𝑋 + 𝑌 = 𝑉𝑎𝑟 𝑋 + 𝑉𝑎𝑟 𝑌

se 𝑪𝒐𝒗 𝑿, 𝒀 = 0 non è detto che

𝑿 𝒆 𝒀 siano indipendenti

𝑋~𝐵𝑖𝑛 2, 𝑝

𝑉𝑎𝑟 𝑋 = 𝑉𝑎𝑟 𝑋1 + 𝑋2 = 2𝑝(1 − 𝑝)

Variabili indipendenti

Indipendenza tra due eventi

Gli eventi A e B si definiscono (stocasticamente) indipendenti

se P(A B)=P(A)P(B)

Indipendenza tra due variabili

Le variabili 𝑋 e 𝑌 si definiscono (stocasticamente) indipendenti

se 𝑃 𝑋 ∈ 𝐴 ∩ 𝑌 ∈ 𝐵 = 𝑃 𝑋 ∈ 𝐴 𝑃 𝑌 ∈ 𝐵 qualunque siano A e B

legge congiunta

= prodotto delle marginali

Indipendenza tra n variabili

Le variabili 𝑋1 , … , 𝑋𝑛 si definiscono (stocasticamente) indipendenti se

∀ 𝐴1 , … , 𝐴𝑛 si ha P(𝑋1 ∈ 𝐴1 ∩ ⋯ ∩ 𝑋𝑛 ∈ 𝐴𝑛 )=P(𝑋1 ∈ 𝐴1 )P(𝑋2 ∈ 𝐴2 )…P(𝑋𝑛 ∈ 𝐴𝑛 )

e per la successione (infinita) 𝑿𝟏 , … , 𝑿𝒏 , … ?

Variabili indipendenti

𝑋𝑖 = 𝑒𝑠𝑖𝑡𝑜 𝑑𝑒𝑙𝑙𝑎 𝑖 − 𝑚𝑎 𝑒𝑠𝑡𝑟𝑎𝑧𝑖𝑜𝑛𝑒: 1 = 𝑉, 0 = 𝑅

𝑃 𝑅 ∩ 𝑉 ∩ 𝑉 = 𝑃(𝑋1 = 0, 𝑋2 = 1, 𝑋3 = 1) = 𝑃(𝑋1 = 0)𝑃(𝑋2 = 1)𝑃(𝑋2 = 1)

per costruzione le variabili sono indipendenti.

per costruzione le variabili

sono dipendenti.

Variabili indipendenti

Distribuzione congiunta:

P(X=1,Y=1), ecc.

X=1

X=2

Y=1

1 3

1 3

𝟐 𝟑

Y=2

1 3

0

𝟏 𝟑

𝟐 𝟑

𝟏 𝟑

marginale di Y

stesse marginali.

X e Y sono v.a. indipendenti?

marginale di X

𝐸 𝑋 = 23+2×13=43

sì, …

no, …

𝐸 𝑌 = ??

𝑉𝑎𝑟 𝑋 = 𝐸(𝑋 2 ) − 𝐸 2 𝑋 = 23+22×13−

4 2 6 16 2

= − =

3

3 9 9

𝐶𝑜𝑣 𝑋, 𝑌 = 𝐸 𝑋𝑌 − 𝐸 𝑋 𝐸 𝑌 = 1 × 13 + 2 × 23 + 4 × 0 −

4 2

3

1

= 53 − 16

=

−

9

9

La funzione di ripartizione

𝑿∶

, 𝑺, 𝑃 → 𝒙𝟏 , 𝒙𝟐 , … , 𝒙𝒏

Script4.R

𝒏 ≤ +∞

𝑃(𝑋 = 𝑥𝑖 ) per tutti i =1,…, n è la distribuzione (o legge) di X, o densità discreta

𝑃 𝑋≤𝑥 =

𝑥𝑖 ≤ 𝑥

𝑃 𝑋 = 𝑥𝑖 è, al variare di 𝑥, la 𝐟𝐮𝐧𝐳𝐢𝐨𝐧𝐞 𝐝𝐢 𝐫𝐢𝐩𝐚𝐫𝐭𝐢𝐳𝐢𝐨𝐧𝐞 di 𝑋

Densità Bin(10,0.5)

0.8

0.6

0.0

0.00

0.2

0.4

pbinom(0:10, 10, 0.5)

0.15

0.10

0.05

SALTI

dbinom(0:10, 10, 0.5)

0.20

1.0

0.25

Ripartizione Bin(10,0.5)

0

2

4

6

0:10

8

10

0

2

4

6

0:10

8

10

La funzione di ripartizione

𝑿∶

, 𝑺, 𝑃 → 𝒙𝟏 , 𝒙𝟐 , … , 𝒙𝒏

analogia

𝒏 ≤ +∞

𝑃(𝑋 = 𝑥𝑖 ) per tutti i =1,…, n è la distribuzione (o legge) di X, o densità discreta

𝑃 𝑋≤𝑥 =

𝑥𝑖 ≤ 𝑥

𝑃 𝑋 = 𝑥𝑖 è, al variare di 𝑥, la 𝐟𝐮𝐧𝐳𝐢𝐨𝐧𝐞 𝐝𝐢 𝐫𝐢𝐩𝐚𝐫𝐭𝐢𝐳𝐢𝐨𝐧𝐞 di 𝑋

f. ripartizione N(0,1)

1.0

0.4

N(0,1)

0.0

0.0

0.2

0.1

0.4

0.2

0.6

0.3

0.8

0.8413 = 𝑃 𝑋 ≤ 1

-5

-4

-2

0

1

2

4

-4

-2

0

1

2

4

La funzione di ripartizione

𝑿∶

, 𝑺, 𝑃 → 𝒙𝟏 , 𝒙𝟐 , … , 𝒙𝒏

𝒏 ≤ +∞

(𝑥1 < 𝑥2 < ⋯ < 𝑥𝑛 )

𝑃(𝑋 = 𝑥𝑖 ) per tutti i =1,…, n è la distribuzione (o legge) di X, o densità discreta

la 𝐟𝐮𝐧𝐳𝐢𝐨𝐧𝐞 𝐝𝐢 𝐫𝐢𝐩𝐚𝐫𝐭𝐢𝐳𝐢𝐨𝐧𝐞: 𝐹 𝑥 = 𝑃 𝑋 ≤ 𝑥 =

𝑥𝑖 ≤ 𝑥

1. 0 ≤ 𝐹(𝑥) ≤ 1

1.0

Ripartizione Bin(10,0.5)

2. E’ non decrescente

𝐹 𝑥 = 1 se 𝑥 > 𝑥𝑛 per 𝑛 < +∞

0.6

0.4

0.2

4. 𝐹 𝑥 = 0 se 𝑥 < 𝑥1

pbinom(0:10, 10, 0.5)

di 𝑥𝑖 è pari a 𝑃 𝑋 = 𝑥𝑖

0.8

3. E’ continua a destra

3a. L’ampiezza del salto in corrispondenza

𝑃 𝑋 = 𝑥𝑖

0.0

lim 𝐹 𝑥𝑛 = 1 per 𝑛 = +∞

𝑛→+∞

0

2

4

6

0:10

8

10

La funzione di ripartizione

Nel caso non discreto:

𝑋∶

, 𝑆, 𝑃 → 𝑅

la distribuzione (o legge) di 𝑋 è definita univocamente dalla f. di

ripartizione, 𝐹 𝑥 = 𝑃(𝑋 ≤ 𝑥).

1. 0 ≤ 𝐹(𝑥) ≤ 1

2. E’ non decrescente

3. E’ continua a destra

3a. L’ampiezza di un salto in corrispondenza

di 𝑥𝑖 è pari a 𝑃 𝑋 = 𝑥𝑖

4. lim 𝐹 𝑥 = 0 𝑒

𝑥→−∞

lim 𝐹 𝑥 = 1

𝑥→+∞

La v.a. è (assolutamente) continua se

la sua f.r. non ha salti.

La densità è “la derivata” della f.r.

V.a. assolutamente continua

𝑏

𝑓 𝑥 ≥ 0 e integrabile

𝑃 𝑎 <𝑋 ≤𝑏 =𝐹 𝑏 −𝐹 𝑎 =

𝑓 𝑥 𝑑𝑥

𝑎

+∞

𝑓 𝑥 𝑑𝑥 = 1

𝑃 𝑋 = 𝑎 = 0 qualunque sia 𝑎

−∞

1

𝐹 1 =𝑃 𝑋≤1 =

𝒅𝒆𝒏𝒔𝒊𝒕𝒂

−∞

f. ripartizione N(0,1)

1.0

0.4

N(0,1)

0.0

0.0

0.2

0.1

0.4

0.2

0.6

0.3

0.8

0.8413

-5

-4

-2

0

1

2

4

-4

-2

0

1

2

4

Variabili “miste”

Sia X la variabile aleatoria che misura quanta pioggia cade in un

giorno in un certo pluviometro. Com’è fatta la sua f.r. ?

𝑋≥0

1

𝑃 𝑋 = 0 = 𝑝0

𝑃 𝑋 ≤ 𝑥 = 𝑃 𝑋 = 0 + 𝑃 0 < 𝑋 ≤ 𝑥 = 𝑝0 + (1 − 𝑝0 )

mistura

𝑥 +

𝑓

0

𝑓 + 𝑢 densità del tipo Gamma, o

Weibull, ecc.

0

mm

𝑢 𝑑𝑢

Sunto estremo

variabili aleatorie:

quantità di interesse

legate all’esito

dell’esperimento

𝑿

P

v.a. discreta:

𝑿∶

, 𝑺, 𝑃 → 𝒙𝟏 , 𝒙𝟐 , … , 𝒙𝒏

𝒏 ≤ +∞

densità discreta: 𝑃(𝑋 = 𝑥𝑖 ) per tutti i =1,…, n

La v.a. è (assolutamente) continua se

la sua f.ripartizione non ha salti.

La densità, f, è “la derivata” della f.r. :

𝑓 𝑥 ≥ 0 e integrabile,

+∞

𝑓 𝑥 𝑑𝑥 = 1

−∞

Sunto estremo

Principali densità discrete

Uniforme discreta

Ex. il dado

equilibrato.

𝑃(𝑋 = 𝑥𝑖 ) =1 𝑛 ,

𝑖 = 1, … , 𝑛 < ∞

Bernoulli(p)

𝑃(𝑋 = 1)=p, 𝑃(𝑋 =0)=1-p

Esito di una prova

con due soli

possibili risultati

Binomiale(n,p)

𝑛 𝑘

𝑃(𝑋 = 𝑘)=

𝑝 (1 − 𝑝)𝑛−𝑘 ,

𝑘

𝑘 = 0,1, … , 𝑛

Numero di successi

in n prove

indipendenti e

identiche

(*)

𝑝)𝑘 ,

Geometrica(p)

𝑃 𝑋 = 𝑘 = 𝑝(1 −

Poisson( )

𝑃 𝑋 = 𝑘 = 𝑒 −𝜆 𝜆𝑘! , 𝑘 ≥ 0

(*) n=1 fornisce la Bernoulli(p)

𝑘

𝑘≥0

Tempo del primo

successo in prove

ripetute identiche

O distribuzione

degli eventi rari