Antonio Manno ([email protected], www.statistica.too.it), Palermo, Italia

Modellazione statistica: approccio parametrico e non

parametrico

1.

La modellazione stocastica

Uno degli obiettivi principali che un analista si prefigge di raggiungere è

quello di poter fare previsione su una certa variabile d'interesse.

È fondamentale, al riguardo, tenere ben presente la netta differenza

esistente fra previsione e predizione: mentre prevedere significa “supporre

ciò che avverrà o come si svolgeranno in futuro gli eventi basandosi su

indizi più o meno sicuri, su induzioni, ipotesi e congetture”, predizione

vuol dire “annunciare in precedenza l'avverarsi di cose future per

ispirazione profetiche”; si comprende bene, quindi, l'impossibilità di

ottenere “previsioni certe” attraverso la previsione scientifica.

La previsione scientifica consente di poter prevedere il valore di una certa

variabile, sulla base dei valori osservati per altre variabili e/o per la stessa,

ma in periodi antecedenti.

Per raggiungere questo obiettivo è necessario considerare un modello

statistico-matematico, che rappresenti la relazione esistente fra le variabili

oggetto di studio.

Formalmente: dato un vettore d-dimensionale di variabili esplicative

x = ( x1 , x 2 ,

, x d ) t e una variabile casuale continua y, detta variabile risposta,

si ha la seguente relazione:

y = f (x) + ε

(1)

1

Antonio Manno ([email protected], www.statistica.too.it), Palermo, Italia

dove f è una funzione reale non nota, spesso non lineare, definita su un

insieme compatto D ⊂ ℜ d , ed ε è una variabile casuale non osservabile,

con valore atteso nullo.

Lo scopo dell'analista è quello di stimare la funzione f, sulla base di un

insieme finito di n osservazioni: {( x 1 , y1 ), ( x 2 , y 2 ), , ( x n , y n )} , dove la coppia

( x t , y t ) rappresenta il valore osservato del vettore x e della variabile y al

tempo t. Ovviamente, fra le componenti del vettore x t possono esserci

anche valori antecedenti della variabile yt .

In letteratura esistono diversi approcci per stimare la funzione f.

Un primo approccio è il cosiddetto “parametrico”, in cui si definisce la

forma funzionale della funzione f, dipendente da un insieme finito di

parametri da stimare; tale approccio è valido solo nel caso in cui la vera

funzione f è uguale (o approssimativamente uguale) alla funzione

parametrizzata, in caso contrario si possono ottenere risultati fuorvianti.

Un altro approccio è quello definito “non parametrico”, in cui si fanno

pochissime assunzioni sulla funzione da stimare. I metodi non parametrici

sono basati su medie locali d-dimensionali: preso un valore x 0 ∈ D , si stima

f ( x 0 ) effettuando una media ponderata delle y osservate in un intorno di.

x 0 . Tali tecniche sono difficilmente applicabili nel caso in cui d sia elevato,

a causa del problema, definito da Bellman, “maledizione della

dimensionalità”, ossia “se nel caso unidimensionale un intervallo di

variazione viene diviso in m sottointervalli e quindi richiede la stima di m

parametri, nel caso bidimensionale il campo di variazione della coppia di

variabili viene diviso in m 2 rettangoli (e quindi la stima di m 2 parametri),

nel caso generale d-dimensionale, il campo di variazione delle d variabili

viene suddiviso in m d rettangoloidi (e quindi la stima di m d parametri)”.

2

Antonio Manno ([email protected], www.statistica.too.it), Palermo, Italia

Un approccio applicabile, nel caso di elevata dimensione dello spazio dei

predittori D, è quello di considerare M funzioni non lineari parametrizzate

(dette funzioni base) e quindi di ipotizzare la funzione f

come una

combinazione lineare di tali funzioni base, ossia:

M

f ( x) = ∑ β m ⋅ φ m ( x;α m )

(2)

m =1

dove α m è un vettore di parametri che definisce completamente la funzione

φ m e β1 , β 2 ,

, β M sono i coefficienti delle funzioni base.

I vettori α m e β 1 , β 2 , , β M sono tutti parametri da stimare, sulla base di un

campione di dati.

Una curva di regressione descrive una generale relazione fra una o più

variabili esplicative x e una variabile risposta y. Condizionandosi ai valori

osservati delle variabili esplicative, il valore atteso di y è dato dalla

funzione di regressione. È molto interessante avere qualche conoscenza su

questa relazione: la forma delle funzione di regressione permette di sapere

dove è lecito aspettarsi di osservare valori più alti della y in corrispondenza

di certi valori x.

Qualora x sia unidimensionale, è possibile cercare di capire la forma

funzionale di f rappresentando in un asse cartesiano le coppie (xi , y i ) , ma

non sempre tale rappresentazione riesce a far comprendere la sottostante

relazione fra le due variabili.

Per stimare la funzione di regressione f si segue spesso il cosiddetto

approccio parametrico, nel quale si assume che la curva media f abbia

qualche forma funzionale specificata a priori. Alternativamente si può

seguire un approccio di stima non parametrica, nel quale non si fa

riferimento a nessuna forma funzionale definita a priori.

3

Antonio Manno ([email protected], www.statistica.too.it), Palermo, Italia

Nel primo approccio per analizzare la relazione di regressione, ossia quello

parametrico, si assume che la forma funzionale f sia completamente

descritta per mezzo di un insieme finito di parametri ignoti.

Nel secondo approccio, cioè non parametrico, non si specifica a priori né la

funzione f, né la distribuzione probabilistica dell’errore ε .

L’utilizzo dei due diversi approcci comporta particolari vantaggi e

svantaggi. Pearson sostiene che il prezzo da pagare per un adattamento

parametrico è la possibilità di ottenere risultati con errori di specificazione

elevati, ossia modelli altamente distorti. Fisher, invece, sostiene che la

considerazione di modelli non parametrici, fornisce risultati meno

interessanti. È comunque possibile combinare i due approcci in modo da

ottenere i vantaggi di entrambi i metodi e quindi seguire un approccio di

tipo semiparametrico.

Qualora non si abbiano informazioni a priori riguardo la curva di

regressione, l’analisi non parametrica può essere d’aiuto nel suggerire una

semplice formulazione parametrica della stessa.

2.

Approccio parametrico

Ciò che contraddistingue l’approccio di stima parametrico è il fatto che la

funzione che lega la variabile risposta con le variabili esplicative, o

predittori, è completamente specificata e dipende da un set di parametri

ignoti.

La scelta della forma funzionale proviene principalmente da considerazioni

di carattere teorico, tuttavia, solitamente queste non bastano per scegliere

un’unica forma funzionale, ma suggeriscono una classe di funzioni. Molto

spesso si cerca una forma funzionale appartenente alla classe di funzioni

4

Antonio Manno ([email protected], www.statistica.too.it), Palermo, Italia

che soddisfano i segni delle prime derivate della funzione. Per esempio, se

si vuole studiare una variabile y che ha un andamento crescente al crescere

dei valori della singola variabile esplicativa x, si deve adottare una funzione

che abbia la derivata prima sempre positiva, in accordo a quanto suggerito

dalla teoria. Purtroppo però le funzioni che soddisfano tale proprietà sono

moltissime, per cui la scelta della funzione da adottare dovrà essere fondata

su altre considerazioni.

L’utilizzo di tecniche parametriche è molto utile se ogni parametro del

modello ha un particolare significato; per esempio, considerando la

funzione del consumo keynesiana C = C 0 + cY + ε , dove C è il consumo e Y

è il reddito disponibile, il parametro c esprime l’incremento che il consumo

subisce in seguito ad un incremento unitario del reddito e rappresenta,

quindi, il noto concetto di propensione marginale al consumo.

Se invece si ipotizza una funzione di tipo moltiplicativo, linearizzabile

passando ai logaritmi, i parametri considerati esprimono un concetto molto

interessante, ossia quello di elasticità; per esempio, considerando la

funzione di produzione di Cobb-Douglas Y = aLb K c ε e passando ai

logaritmi log Y = log a + b log L + c log K + log ε , dove Y è la quantità prodotta,

L rappresenta il fattore lavoro e K il fattore capitale, il parametro b indica

l’elasticità della produzione rispetto al lavoro, mentre c indica l’elasticità

della produzione rispetto al capitale, ossia indicano l’incremento relativo

che la produzione subisce in seguito ad un incremento dell’1% del lavoro e

rispettivamente del capitale.

Non sempre, purtroppo, si riesce ad attribuire un significato ai parametri

del modello, soprattutto quando la forma funzionale definita è

particolarmente complessa.

5

Antonio Manno ([email protected], www.statistica.too.it), Palermo, Italia

Usualmente, non si sceglie a priori una sola forma funzionale che lega x e

y, ma si preferisce selezionare un insieme relativamente limitato di possibili

relazioni. Successivamente si stimano i vari modelli selezionati, sulla base

del campione di osservazioni disponibili, e quindi si sceglie il modello

giudicato “migliore”, in base ad un particolare funzione obiettivo che

misura la distanza fra valori osservati e valori previsti.

Fra le funzioni selezionate a priori conviene sempre includere un modello

di regressione lineare, poiché è un modello veloce da stimare, è possibile

attribuire un significato ai parametri e soddisfa il principio di parsimonia.

Molto spesso modelli non lineari abbastanza complessi, piuttosto difficili

da stimare, conducono a risultati simili a quelli ottenuti attraverso un

semplice modello di regressione multipla, per cui in tal caso si preferisce

adottare quest’ultimo modello, che essendo più semplice da implementare

potrà essere facilmente riutilizzato, ad esempio per prevedere futuri valori

della variabile risposta y.

Oltre alla semplicità di implementazione del modello lineare, si aggiunga

che in tale situazione sono note le forme distributive degli stimatori e di

loro particolari funzioni; inoltre la teoria inferenziale associata è quella

cosiddetta “esatta”, mentre nell’ambito della modellazione non lineare

spesso si fa riferimento a distribuzioni asintotiche, in quanto non sono note

le distribuzioni esatte, che presuppongono la presenza di campioni di

grosse dimensioni, sebbene il campione disponibile sia spesso di

dimensioni ridotte.

In molti casi, sebbene il modello iniziale non sia esattamente lineare, è

possibile linearizzarlo per mezzo di una qualche trasformazione.

È bene sottolineare che un modello si definisce lineare se la funzione è

lineare rispetto ai parametri e non rispetto le osservazioni. Il modello

moltiplicativo, come quello di Cobb-Douglas descritto in precedenza, è un

6

Antonio Manno ([email protected], www.statistica.too.it), Palermo, Italia

esempio di modello non lineare, ma linearizzabile. Il modello

1

y = expa + b non è lineare, ma è linearizzabile se si passa ai logaritmi,

x

infatti il modello log y = a + b

1

è lineare rispetto i due parametri (a,b).

x

Sebbene la relazione regressiva non sia di tipo lineare, è tuttavia possibile

adottare un modello lineare nei parametri, ma polinomiale nelle

osservazioni, che approssimi la reale funzione non lineare; quanto

affermato è una conseguenza del teorema di Taylor, in base al quale una

qualsiasi funzione continua e derivabile di ordine n è sviluppabile in un

polinomio, per cui se f è una funzione reale continua e derivabile di ordine

n, allora vale:

f ( x) = f ( x0 ) + f ' ( x0 )( x − x 0 ) +

+

1

f

n!

( n)

1

f ' ' ( x 0 )( x − x 0 ) 2 +

2

+

1

f

(n − 1)!

( n −1)

( x 0 )( x − x0 ) n−1 +

(ξ )( x − x 0 ) n .

Tale sviluppo vale anche nel caso multidimensionale, per cui in linea

teorica l’approssimazione lineare è valida anche nel caso di spazio dei

predittori multidimensionale.

Nella pratica però si hanno solamente n osservazioni, per cui un polinomio

di grado (n-1) si adatta perfettamente ai dati e non è quindi generalizzabile.

Bisogna quindi considerare un polinomio di ordine inferiore e verificare se

il suo adattamento è ritenuto soddisfacente o meno.

Qualora tale modello non sia ritenuto “buono”, allora è indispensabile

considerare una funzione non lineare, sebbene sia di più difficile

implementazione.

In generale la relazione fra le variabili y ed x, che può essere anche un

vettore, si può esplicitare nel seguente modo:

y = f (x;θ ) + ε .

7

Antonio Manno ([email protected], www.statistica.too.it), Palermo, Italia

Il vettore θ è costituito da tutti i parametri che specificano completamente

la funzione f, mentre ε è una variabile casuale sulla quale occorre

formulare alcune ipotesi distributive, al fine di considerare un algoritmo di

stima efficiente.

Disponendo di un campione di n osservazioni {(xi , y i )}in=1 provenienti dal

vettore aleatorio (x,y), la precedente relazione è valida in corrispondenza di

ogni osservazione (xi , y i ) , per cui vale:

y i = f ( x i ;θ ) + ε i

∀i = 1,2,..., n

Al fine di impiegare un algoritmo di stima efficiente è necessario formulare

alcune ipotesi sulle variabili casuali non osservabili {ε i }.

Una prima ipotesi è che la loro media sia nulla, per ogni i, da ciò ne

scaturisce che il valor medio di y condizionatamente ad x è pari a f ( x;θ ) ,

cioè:

E [y | x ] = f ( x;θ ) .

Dalla precedente equazione si comprende meglio l’importanza della forma

funzionale scelta, in quanto una funzione totalmente scorretta può condurre

a risultati totalmente fuorvianti.

Dopo aver formulato un’ipotesi sul primo momento delle variabili {ε i },

occorre formulare un’ipotesi anche sul loro momento secondo. L’ipotesi

generale, detta di eteroschedasticità, prevede che ogni variabile abbia una

propria varianza, che comunque si assume essere finita, ossia

Var (ε i ) = σ i2 < ∞ ;

molto spesso è possibile ipotizzare il caso di

omoschedasticità, ossia di uguaglianza fra le varianze, precisamente:

σ i2 = σ 2 per ogni i.

È importante anche fare ipotesi sulla dipendenza, o meno, fra le variabili

{ε i }; l’ipotesi più semplice è quella di non correlazione, ossia:

8

Antonio Manno ([email protected], www.statistica.too.it), Palermo, Italia

Cov(ε i , ε j ) = 0

∀i ≠ j .

Se l’ipotesi di non correlazione non è plausibile con i dati osservati, allora è

necessario formulare altre ipotesi, ad esempio si potrebbe pensare che le

variabili {ε i } siano un processo autoregressivo del primo ordine, per cui

considerando u n un processo stocastico white noise, con media nulla e

varianza σ u2 , si suppone:

ε i = ρε i −1 + u i .

Oltre ad ipotesi relative ai momenti, è possibile fare ipotesi sull’intera

distribuzione delle variabili casuali {ε i }; l’ipotesi formulata più spesso è

quella secondo la quale si distribuiscono normalmente, ma in generale è

possibile pensare che si distribuiscano come una normale di ordine p, la cui

densità è:

ε p

exp−

f (ε ) =

p

1

1

pσ p

p

2 p Γ1 + σ p

p

1

dove la funzione Γ è la funzione di Eulero e σ pp è lo scarto potenziato di

ordine p, ossia:

+∞

σ pp = ∫ ε

−∞

p

f (ε )dε .

A tale famiglia di distribuzioni appartengono diverse distribuzioni notevoli,

infatti:

- per p=1 si ha la distribuzione esponenziale doppia, detta anche

Laplace;

- per p=2, si ottiene la curva normale;

- per p → ∞ si ottiene una distribuzione uniforme.

Le distribuzioni appartenenti a tale famiglia sono tutte simmetriche; inoltre

la curtosi dipende dal parametro p, infatti:

9

Antonio Manno ([email protected], www.statistica.too.it), Palermo, Italia

- con un valore di p: 1<p<2 si hanno curve leptocurtiche;

- per p=2 (cioè la distribuzione Normale) si ottiene una curva

mesocurtica;

- per p>2 si hanno curve platicurtiche.

La scelta di una distribuzione diversa dalla Normale, ad esempio una

normale di ordine p, complica notevolmente gli algoritmi di stima,

soprattutto se la distribuzione considerata ha una forma funzionale piuttosto

complessa, ma ciò è dovuto al fatto che non sempre è possibile ipotizzare

che gli errori si distribuiscono normalmente.

Solitamente le osservazioni xi sono considerate come determinazioni di

variabili casuali, ma è possibile che anche tali valori siano considerati come

variabili casuali, per cui è necessario specificare la relazione esistente fra

tali osservazioni e gli errori {ε i }.

L’ipotesi più semplice prevede che le osservazioni e gli errori siano

incorrelati, per cui Cov(X i , ε i ) = 0 per ogni valore i. Talvolta però non è

lecito formulare tale ipotesi e quindi occorre specificare una particolare

dipendenza.

Nel caso di spazio multidimensionale delle variabili esplicative, la

specificazione del modello oltre la forma funzionale f, richiede anche

l’inclusione delle variabili che effettivamente influenzano la variabile

risposta y. Usualmente si sceglie un insieme molto ampio di variabili e

successivamente si seleziona un sottoinsieme di queste, sulla base di

particolari algoritmi. L’inclusione di variabili irrilevanti comporta un

aumento della varianza degli stimatori, mentre l’omissione di variabili

rilevanti determina la distorsione del modello; purtroppo la vera relazione

non è nota, per cui non si conoscono le variabili esplicative che

effettivamente influenzano y.

10

Antonio Manno ([email protected], www.statistica.too.it), Palermo, Italia

Gli algoritmi che consentono di selezionare un sottoinsieme “significativo”

di variabili esplicative sono essenzialmente di due tipi: forward selection e

backward elimination.

Nel primo tipo di algoritmo si parte da un modello con una sola variabile

esplicativa, che è quella che influenza maggiormente la y, e in ogni passo si

aggiunge nel modello la variabile il cui inserimento produce il maggiore

miglioramento del modello e si procede fin quando non si raggiunge un

livello di adattamento minimo prefissato.

Gli algoritmi di backward elimination operano nel senso opposto: si parte

dal modello con tutte le variabili esplicative presenti e in ogni passo si

elimina la variabile la cui eliminazione produce il minore peggioramento di

adattamento e si procede all’eliminazione fin quando non si raggiunge un

livello di adattamento minimo prefissato.

Esistono poi algoritmi di tipo stepwise, che combinano i due algoritmi

precedenti, allo scopo di ricercare una soluzione sub-ottimale.

L’adattamento ai dati è espresso per mezzo di una funzione obiettivo

specificata, che misura la distanza fra dati osservati e dati previsti. Si

discuterà di tale funzione in seguito, nell’ambito dei metodi di stima.

Un altro grosso problema inerente le variabili esplicative è quello che va

sotto il nome di multicollinearità, ossia la presenza di variabili esplicative

altamente correlate fra loro. La conseguenza maggiore di tale situazione è

che gli stimatori dei parametri hanno varianze elevate, per cui piccole

variazioni nei dati osservati possono produrre forti variazioni nelle stime

dei parametri.

Una possibile soluzione per ovviare a tale problema è quella di eliminare le

variabili maggiormente coinvolte in questo fenomeno: essendo altamente

correlate ad altre variabili, l’informazione che esse aggiungono al modello

è molto bassa, per cui è logico eliminarle dal modello.

11

Antonio Manno ([email protected], www.statistica.too.it), Palermo, Italia

Un’altra soluzione è quella di considerare le componenti principali

associate a tali variabili, in modo da conservare tutta l’informazione

disponibile, ma avere variabili a due a due incorrelate.

Si ricorda che se X è il generico vettore delle variabili esplicative, bisogna

prima standardizzare tale vettore, per cui si considera il nuovo vettore

Z=

X − E( X )

Var ( X )

, quindi si procede alla trasformazione C = Γ t Z , dove Γ è la

matrice degli autovettori associata alla matrice di correlazione e C è il

vettore delle componenti principali, ossia variabili a due a due incorrelate

che contengono tutta la variabilità presente in X, in modo decrescente.

Precisamente, se C j è la j-esima componente principale, allora risulta

Var (C j ) = λ j , dove λ j è il j-esimo autovalore associato alla matrice di

correlazione, ed inoltre:

∑ Var (Z ) = ∑ Var (C ) .

j

j

j

j

Quindi, dalle osservazioni {X i }in=1 si passa alle componenti principali {C i }in=1

e quindi si considera la relazione y = f (C;θ ) + ε .

L’adozione

delle

componenti

principali

comporta

una

difficoltà

interpretativa dei nuovi parametri, dovuta alla trasformazione delle variabili

effettuata.

2.1

Metodi di stima

Dato un vettore d-dimensionale di variabili esplicative x = ( x1 , x 2 , , xd ) t una

variabile casuale continua y, detta variabile risposta, si ha la seguente

relazione:

12

Antonio Manno ([email protected], www.statistica.too.it), Palermo, Italia

y = f (x ) + ε

Lo scopo dell'analista è quello di stimare la funzione f, sulla base di un

insieme finito di n osservazioni: {( x 1 , y1 ), ( x 2 , y 2 ), , ( x n , y n )} , dove la coppia

( x t , y t ) rappresenta il valore osservato del vettore x e della variabile y al

tempo t. Nell’approccio parametrico la forma funzionale f è definita a priori

ed è completamente specificata da un vettore di parametri, indicato con θ ,

per tal motivo si preferisce rappresentare la relazione nel seguente modo:

y = f (x;θ ) + ε

Il vettore θ = (θ 1 ,θ 2 , ,θ k )t contiene tutti parametri da stimare, sulla base di

un campione di dati.

Al fine di stimare i parametri del modello, si considera una funzione di

perdita Ψ da minimizzare; per cui, posto θ l'insieme di tutti i parametri del

modello, si ha che lo stimatore θˆ è quel vettore che minimizza la funzione

obiettivo:

E (θ ) =

1 n

⋅ ∑ Ψ[y t , f (x t ;θ )]

n t =1

La funzione di perdita più usata è quella che definisce il metodo dei minimi

quadrati ordinari, precisamente:

Ψ ( y t , f (x t ; θ )) = ( y t − f (x t ;θ )) .

2

È possibile considerare altre funzioni di perdita; una funzione usata spesso,

perché poco sensibile agli outliers è:

Ψ ( y t , f (x t ; θ )) = y t − f (x t ; θ ) .

Più in generale è possibile considerare una classe di stimatori denominati di

norma L p , in cui la funzione di perdita è definita come:

Ψ ( y t , f (x t ;θ )) = y t − f (x t ;θ )

p

.

13

Antonio Manno ([email protected], www.statistica.too.it), Palermo, Italia

Per p=1 e p=2 si ottengono le due funzioni di perdita considerate in

precedenza, per cui lo stimatore di norma L2 e lo stimatori dei minimi

quadrati ordinari coincidono.

I metodi descritti in precedenza danno luogo a stimatori efficienti sotto

l’ipotesi che gli errori {ε t } siano un processo white noise, per cui abbiano

media nulla, siano omoschedastici e non correlati.

Se si è in presenza di errori eteroschedastici, si preferisce impiegare il

metodo dei minimi quadrati ponderati, dove le varie componenti, che

sommate danno luogo alla funzione obiettivo dei minimi quadrati, vengono

pesate da particolari fattori, che tengono conto della diversa varianza.

Si ipotizzi ad esempio un modello di regressione lineare semplice

y t = a + bxt + ε t con errori eteroschedastici e con varianze dipendenti dalle

osservazioni xt , cioè, ad esempio:

Var (ε t ) = σ t2 = σ 2 x t2 .

Considerando il nuovo modello:

ε

yt

1

=a +b+ t

xt

xt

xt

ε

xt

esso presenta errori t omoschedastici e quindi si applica il metodo dei

1

,

x t

minimi quadrati ponderati, dove in questo caso i pesi sono pari a

per cui la funzione da minimizzare è:

n

E (a, b ) = ∑

t =1

1

xt

(yt

− a − bxt ) .

2

Più in generale, in caso di errori con matrice di varianze e covarianze V

qualsiasi, per cui non diagonale, ossia con errori correlati si preferisce il

14

Antonio Manno ([email protected], www.statistica.too.it), Palermo, Italia

metodo dei minimi quadrati generalizzati, nel quale lo stimatore θˆ è quel

vettore che minimizza la funzione:

(

)

(

)

E (θ ) = y − f (x;θ ) V −1 y − f (x;θ ) .

t

Dove il vettore y è il vettore delle n osservazioni per la variabile risposta,

ossia è dato da y = ( y1 , y2 , , yn )t ed il vettore f (x;θ ) è il vettore dei valori

attesi

di

y

f (x;θ ) = ( f (x 1 ;θ ),

per

le

n

osservazioni,

ossia

è

dato

da

, f (x n ;θ )) .

t

Un metodo di stima che in particolari ipotesi conduce a stimatori

coincidenti con quelli dei minimi quadrati è quello della massima

verosimiglianza.

Tale metodo presuppone la conoscenza della distribuzione di probabilità

del vettore aleatorio y. Se p (y;θ ) è la distribuzione congiunta del campione,

che dipende dalla distribuzione degli errori {ε t }, lo stimatore di massima

verosimiglianza θˆ

del vettore parametrico θ

è quel valore in

corrispondenza del quale la distribuzione p (y;θ ) è massima.

Se la distribuzione p (y;θ ) è regolare, allora θˆ è il punto di massimo e si

ottiene attraverso un problema di massimizzazione, per cui è quel valore

che soddisfa le equazioni:

( )

∂p y; θ

∂θ

=0

e in corrispondenza del quale la matrice Hessiana è semidefinita negativa.

Molto spesso la forma funzionale di p (y;θ ) è abbastanza complessa, altre

volte non è possibile ricavarla e in questi casi non è quindi possibile

applicare il metodo.

I vantaggi dell’uso del metodo della massima verosimiglianza scaturiscono

dalle proprietà teoriche che tale metodo possiede.

15

Antonio Manno ([email protected], www.statistica.too.it), Palermo, Italia

Sotto condizioni di regolarità, lo stimatore di massima verosimiglianza θˆ è

consistente ed asintoticamente normale, con media pari al parametro θ e

varianza pari al limite inferiore di Rao-Cramer, che è la varianza più bassa

che

uno

stimatore

non

distorto

possa

avere,

pari

all’inverso

dell’informazione attesa di Fisher I (θ ) . Per cui:

p

θˆ

→

θ

e

1

d

.

N θ ,

θˆ →

I (θ )

Inoltre, se esiste uno stimatore non distorto e pienamente efficiente, la cui

varianza è pari, cioè, al limite inferiore di Rao-Cramer, allora tale stimatore

coincide con quello di massima verosimiglianza.

Lo stimatore di massima verosimiglianza è inoltre funzione delle statistiche

sufficienti minimali, per cui sfrutta tutta l’informazione presente nel

campione in merito ai parametri da stimare e gode della proprietà di

invarianza rispetto a trasformazioni monotone, ossia se θˆ è lo stimatore di

massima verosimiglianza del parametro θ e se γ è una funzione monotona

definita sullo spazio parametrico, allora γ (θˆ ) sarà lo stimatore di massima

verosimiglianza del parametro γ (θ ) .

Per minimizzare le funzioni obiettivo E (θ ) , oppure per massimizzare

( )

p y;θ , è necessario utilizzare algoritmi di ottimizzazione iterativi, poiché

non esiste una soluzione in forma chiusa per gli stimatori, tranne nei casi

più semplici, come ad esempio nei modelli lineari.

Per evitare che il modello stimato fˆ (x ) si adatti perfettamente ai dati

osservati e quindi abbia una scarsa capacità di generalizzazione ad altri

dati, si utilizzano varie tecniche.

16

Antonio Manno ([email protected], www.statistica.too.it), Palermo, Italia

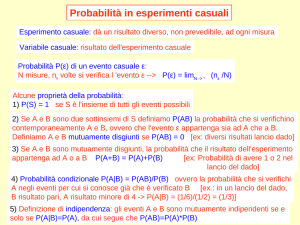

Una tecnica, usata in presenza di grandi campioni, è quella di suddividere

(casualmente) il campione in 2 sottoinsiemi; un sottoinsieme, definito

campione di addestramento (learning set), viene utilizzato per stimare i

parametri del modello ed un altro sottoinsieme, detto campione di verifica

o test (test set), consente di misurare la capacità di generalizzazione del

modello.

In pratica, ad ogni passo dell'algoritmo di ottimizzazione, si misura l'errore

del modello, ossia E (θˆ ), in entrambi i sottoinsiemi. L'errore calcolato sul

learning set tenderà a decrescere e sarà uguale a zero, nel caso di perfetto

adattamento ai dati osservati (che però implica una scarsa capacità di

generalizzazione), mentre l'errore calcolato sul test set seguirà un

andamento parabolico, ossia all'inizio tenderà a decrescere e poi, raggiunto

un minimo, inizierà ad aumentare, ciò significa che il modello inizia a

seguire eccessivamente la dinamica dei dati osservati, per cui si considera

come stima dei parametri del modello, il valore assunto dai parametri nel

passo in cui l'errore sul test set aveva raggiunto il minimo. Tale tecnica è

nota in letteratura col nome di Early stopping.

Fig. 1: Early stopping

17

Antonio Manno ([email protected], www.statistica.too.it), Palermo, Italia

Tale approccio è impraticabile in presenza di piccoli campioni; ad ogni

modo, si possono adottare tecniche di tipo cross validation.

Un altro approccio aggiunge alla funzione di errore un termine di

penalizzazione Ω , per evitare che la funzione abbia troppi salti, in modo da

adattarsi ai dati osservati; per cui si considera un nuovo funzionale

~

E (θ ) = E (θ ) + λ ⋅ Ω , da minimizzare.

λ è un parametro reale positivo, che attribuisce minore o maggiore

importanza al termine di penalizzazione, quindi è fondamentale il valore

che gli viene attribuito.

d

Un termine di penalizzazione molto usato è: Ω = ∫ ∑

i =1

∂ 2 f (x )

dx.

∂xi2

Tali approcci hanno lo scopo di raggiungere un compromesso fra bias e

varianza degli stimatori, in modo tale da poter generalizzare il modello, nel

caso in cui si considerano valori dei predittori diversi da quelli osservati e

si vuole quindi fare previsione.

2.2

Verifica del modello

Successivamente alla fase di stima del modello, occorre verificare che il

modello adattato fornisca risultati soddisfacenti. Per verificare la bontà del

modello si procede sia con specifici test sui parametri, sia con l’analisi

complessiva del modello e quindi con l’analisi dei residui. In tale fase oltre

a decidere se accettare o rifiutare il modello stimato, si ottengono

informazioni aggiuntive riguardo il modello stesso.

Il primo passo da compiere è quello di verificare la significatività dei

parametri presenti nel modello mediante opportuni test statistici, in modo

18

Antonio Manno ([email protected], www.statistica.too.it), Palermo, Italia

da eliminare quei parametri che non sono significativi e che comportano

una ridondanza del modello.

Successivamente vengono effettuati diversi test per verificare la plausibilità

delle ipotesi fatte a priori. A tal riguardo si testa l’ipotesi di

omoschedasticità degli errori, l’ipotesi di errori non autocorrelati e l’ipotesi

di normalità degli stessi.

Per ogni tipo di ipotesi esistono in letteratura diversi test attraverso i quali

se ne saggia la plausibilità. Le distribuzioni probabilistiche delle statistiche

test impiegate dipendono, ovviamente, dalla distribuzione p (y;θ ) del

campione. Se si assume di conoscere la distribuzione degli errori e quindi

del campione, allora è possibile impiegare il test ottenuto mediante il

rapporto delle verosimiglianze, dato che è possibile determinare lo

stimatore di massima verosimiglianza. Come è noto, tale test ha una

distribuzione asintotica di tipo χ 2 , in casi particolari (come nei modelli

lineari) è possibile conoscere le distribuzioni esatte di tali statistiche test,

anche nel caso di campioni di piccole dimensioni. Qualora si rifiuti una

particolare ipotesi, è necessario intervenire sul modello o direttamente sul

metodo di stima; ad esempio, rifiutando l’ipotesi che gli errori siano

omoschedastici è necessario intervenire cambiando l’algoritmo di stima,

infatti si passerà dal metodo dei minimi quadrati ordinari al metodo dei

minimi quadrati ponderati.

I residui di un modello, definiti come la differenza fra valori osservati e

valori previsti, ossia rt = y t − f (x t ;θˆ ), rappresentano un grosso strumento a

supporto della verifica di un modello.

Dall’analisi dei residui rt del modello stimato, è possibile trarre conclusioni

sulla bontà del modello stimato e delle ipotesi fatte.

19

Antonio Manno ([email protected], www.statistica.too.it), Palermo, Italia

Ad esempio, rappresentando in un asse cartesiano i punti (rt −1 , rt ) è possibile

verificare l’eventuale presenza di errori autocorrelati. Qualora i punti si

dispongano in modo casuale, ossia siano sparsi nella rappresentazione

cartesiana, si può affermare che gli errori siano non correlati.

Rappresentando, invece, i punti (xt , rt 2 ) è possibile avere un’idea riguardo la

struttura di variabilità degli errori; se tali punti non si dispongono intorno

una curva ben precisa, è lecito assumere che gli errori siano

omoschedastici, se invece tale nube di punti assume una forma ben

delineata, allora si deduce che gli errori hanno una varianza che varia in

funzione dei valori

xt

e quindi bisogna considerare l’ipotesi di

eteroschedasticità.

2.3

Utilizzo del modello

Una volta che il modello stimato ha fornito risultati soddisfacenti, è

possibile utilizzarlo per diversi scopi:

- previsione di valori futuri;

- interpretazione delle relazioni fra variabili;

- simulazione di particolari scenari, sotto particolari ipotesi.

Se il modello considerato è del tipo y t = f (x t ;θ ) + ε t con E (ε t ) = 0 , allora il

valore f (x t ;θˆ ) è il valore “calcolato” dal modello per y t , sotto tali ipotesi,

per cui è possibile prevedere valori futuri di tale variabile sfruttando la

relazione che lega y ed x, ossia la funzione f, cioè al tempo (t+1) il valore

previsto per y è dato da f (x t +1 ;θˆ ).

Un aspetto simile alla previsione è quello della simulazione: ipotizzando

particolari valori delle variabili esplicative x si vuole vedere che valore

20

Antonio Manno ([email protected], www.statistica.too.it), Palermo, Italia

assumerebbe la variabile y in tale situazione. In questo modo è possibile,

dunque, simulare particolari scenari.

Formalmente, se x 0 è una particolare determinazione del vettore

esplicativo x, in tale situazione si prevede che la variabile risposta assuma il

valore y 0 , definito come:

(

)

y 0 = f x 0 ;θˆ .

E’ chiaro che la bontà della previsione, dipende dalla bontà del modello; si

tenga presente, inoltre, che un modello è valido in un determinato arco

temporale (e spaziale), ossia sarà valido per un certo periodo di tempo, ma

non lo sarà più in un periodo successivo; è presente, cioè, un problema di

instabilità temporale, ciò implica che anche un modello valido può dar

luogo a previsioni totalmente errate, se si pretende di prevedere un

fenomeno dopo un lag temporale abbastanza elevato.

3.

Approccio non parametrico

Dato un campione di osservazioni {(xi , y i )}in=1 , la sottostante relazione fra

variabili è del tipo y i = m(xi ) + ε i . L’obiettivo dell’analista è quello di

stimare la funzione m a partire dal campione osservato, in modo da poter

conoscere la relazione che lega x ed y, sia per scopi descrittivi che per scopi

previsivi.

Se per un punto fissato x ci sono osservazioni ripetute, allora la stima di

m(x) può essere fatta usando semplicemente la media dei valori y

corrispondenti. Purtroppo, nella maggior parte dei casi pratici tale

situazione non si presenta, per cui la stima deve essere fatta seguendo altre

procedure.

21

Antonio Manno ([email protected], www.statistica.too.it), Palermo, Italia

In generale, vengono considerate procedure di media locale, ossia si stima

m(x) attraverso una media aritmetica ponderata delle osservazioni y

corrispondenti ai valori xi appartenenti ad un certo intorno del punto x di

riferimento. Per cui, considerando il punto x, il valore che la funzione m

assume in corrispondenza di tale punto viene stimata nel seguente modo:

n

mˆ (x ) = n −1 ∑ Wni ( x) y i

i =1

dove l’insieme {Wni ( x)}in=1 denota una sequenza di pesi che può dipendere

dall’intero vettore {X i }in=1 .

Lo stimatore mˆ ( x) è usualmente denominato smoother, mentre la procedura

di stima è chiamata smooth.

Nello stimatore mˆ ( x) un ruolo chiave è giocato dal sistema di pesi

{Wni ( x)}in=1 ; i valori di tale sequenza regolano l’ampiezza dell’intorno di x

impiegato per calcolare la media ponderata locale delle y. Una media locale

su un intorno troppo largo determina uno stimatore m̂ con bassa varianza,

ma distorto; dall’altra parte, una media locale calcolata su un intorno

troppo piccolo implica la presenza di uno stimatore corretto, ma con alta

variabilità.. Pertanto, si rende necessario un compromesso che bilanci il

trade-off fra i due casi.

Se si suppone che i pesi {Wni ( x)}in=1 siano positivi e che, per ogni x, la loro

somma soddisfi la relazione:

n

n −1 ∑ Wni ( x) = 1

i =1

allora mˆ ( x) è la soluzione del metodo di stima dei minimi quadrati al punto

x, se è la soluzione del seguente problema di minimizzazione:

n

2

min n −1 ∑ Wni ( x)( y i − θ ) 2 = min n −1 ∑ Wni ( x)( y i − mˆ ( x) ) .

θ

i =1

22

Antonio Manno ([email protected], www.statistica.too.it), Palermo, Italia

3.1

Principali tecniche non parametriche

Una tecnica non parametrica molto nota in letteratura è quella che va sotto

il nome di Kernel smoothing. Tale procedura descrive i pesi Wni (x) per

mezzo di una funzione di densità con un parametro di scala che aggiusta la

forma e la grandezza dei pesi in un intorno di x. Tale funzione, detta kernel

e indicata con K, deve essere continua e simmetrica e soddisfare

l’uguaglianza ∫ K (u )du = 1 .

Nel caso in cui lo spazio dei predittori sia unidimensionale, si definiscono i

pesi nel seguente modo:

Wni ( x) = K hn (x − X i ) / fˆhn ( x)

n

dove fˆh ( x) = n −1 ∑ K h (x − X i ) e K h (u ) è il kernel con fattore di scala hn ,

n

i =1

u

hn

con K h (u ) = hn−1 K

n

n

n

.

Eliminando la dipendenza di hn dall’ampiezza campionaria n, per cui

hn = h , i pesi Wni (x) definiti in precedenza, sono indicati con {Whi ( x)}i =1 per

n

indicarne la dipendenza da h, la funzione fˆh è lo stimatore kernel di

Rosenblatt-Parzen della densità marginale di X.

Definiti i pesi {Whi ( x)}in=1 si ottiene lo stimatore, detto di Nadaraya-Watson:

n

mˆ h ( x) =

n −1 ∑ K h (x − X i )Yi

n

i =1

n

−1

∑ K (x − X )

i =1

h

.

i

È possibile definire diverse funzioni kernel, ma considerazioni pratiche e

teoriche limitano la scelta. Per esempio, funzioni kernel che assumono

23

Antonio Manno ([email protected], www.statistica.too.it), Palermo, Italia

valori molto piccoli possono causare con un computer problemi

computazionali.

Una funzione comunemente usata, date le sue ottime proprietà, è la

cosiddetta funzione kernel di Epanechnikov, ossia:

K (u ) = 0,75(1 − u 2 )⋅ I ( u ≤ 1)

dove la funzione I ( u ≤ 1) vale:

1 se u ≤ 1

I ( u ≤ 1) =

0 altrimenti

Si noti che tale funzione kernel non è differenziabile per u = ±1 e per

fˆh ( x) = 0 lo smoother di tipo kernel non è definito, essendo un caso del tipo

“0/0”; in tale situazione si pone mˆ h ( x) = 0 .

Un'altra funzione kernel molto utilizzata è quella di tipo gaussiano, ossia:

K (u ) = (2π )

−

Nel

1

2

u2

exp− .

2

caso

X i = (X i1 , X i 2 ,

di

spazio

multidimensionale

dei

predittori,

ossia

, X id ) , si usa una funzione kernel multidimensionale pari al

prodotto delle singole funzioni kernel unidimensionali, ossia:

K (u1 ,

u d ) = ∏ K (u j ).

d

j =1

I pesi per lo smoother di tipo kernel sono quindi definiti come:

∏ K (x

d

Whi ( x) =

j =1

h

j

− X ij )

fˆh ( x )

.

In alcuni casi la densità f(x) è nota, per cui in tali situazioni i pesi sono

definiti nel seguente modo:

Whi(1) ( x) = K h (x − X i ) / f ( x) .

Lo smoother di tipo kernel è, sotto condizioni di regolarità, uno stimatore

consistente della funzione di regressione m.

24

Antonio Manno ([email protected], www.statistica.too.it), Palermo, Italia

Un'altra tecnica parametrica molto diffusa va sotto il nome “k-nearest

neighbor”, ossia k valori più prossimi.

Mentre la stima di tipo kernel è definita mediante una media ponderata

della variabile risposta su un intorno fissato del punto x, determinato dalla

funzione K e dalla “finestra” h, il metodo k-nearest neighbor, indicato per

semplicità con (k-NN), stima la funzione di regressione attraverso una

media ponderata in un intorno variabile: tale intorno è definito attraverso i

k punti più prossimi al valore x, considerando la distanza di tipo Euclideo.

Lo stimatore k-NN è definito nel seguente modo:

n

mˆ k ( x) = n −1 ∑ W ki ( x ) ⋅ Yi

i =1

dove {Wki ( x)}in=1 è la sequenza di pesi definita attraverso l’insieme di indici:

J x = {i : X i è una delle k osservazioni più prossime a x}.

Più precisamente, i pesi sono definiti come:

1

Wki ( x) = k

0

se

i∈Jx

altrimenti

Il parametro k regola il grado di “lisciamento” della curva stimata; esso

gioca un ruolo simile alla finestra h dello stimatore di tipo kernel: valori

elevati di k determinano uno stimatore distorto con bassa varianza,

viceversa valori bassi di k conducono a uno stimatore corretto ma

altamente variabile; quindi, anche in questo caso, è necessario cercare un

compromesso fra le due situazioni, per cui bisogna scegliere un valore k in

modo da avere uno stimatore con bassa distorsione e bassa varianza.

Nel caso limite che k=n, ossia se si considerano tutte le osservazioni

campionarie, lo stimatore k-NN è pari alla media aritmetica delle y.

Esiste anche un altro tipo di stimatori k-NN, detti stimatori dei punti più

prossimi simmetrizzati. In tal caso i punti più prossimi sono definiti in

25

Antonio Manno ([email protected], www.statistica.too.it), Palermo, Italia

termini di distanza basata sulla distribuzione empirica dei dati osservati

{X i }in=1 , indicata con

Fn ( X i ) . Se h è una “finestra” tendente a zero, lo

stimatore in questione è:

n

F ( X ) − Fn (x )

−1

mˆ k ( h ) = (nh ) ∑ K n i

⋅ Yi .

h

i =1

La scelta di h implica il solito trade-off tra stimatori corretti ma con alta

varianza e stimatori distorti con bassa varianza.

Una tecnica diffusissima è quella denominata Spline smoothing. Attraverso

tale tecnica si cerca una funzione g ( X i ) che approssima i valori Yi ; per

determinare una funzione g che si adatti bene ai dati, si minimizza

n

l’espressione

∑ (Y

i =1

i

− g (X i )) , per evitare che la funzione trovata si adatti

2

perfettamente ai dati osservati e quindi non sia generalizzabile, allora si

aggiunge un termine di penalizzazione regolato da un parametro λ , per cui

la funzione g sarà quella che minimizzerà l’espressione

S λ (g ) ,

precisamente:

n

S λ ( g ) = ∑ (Yi − g (X i )) + λ ⋅ ∫ (g ' ' ( x) ) dx .

2

2

i =1

Il problema di minimizzazione sulla classe delle funzione differenziabili

del secondo ordine su un intervallo [a,b]= [ X (1) , X ( n ) ] ha un’unica soluzione

mˆ λ ( x) che è definita cubic spline: mˆ λ ( x) è un polinomio di terzo grado

definito fra due valori successivi della X. Variando il termine di

penalizzazione, si ottengono polinomi locali di diverso grado.

Lo stimatore mˆ λ ( x) può essere espresso anche nella forma:

n

mˆ λ ( x) = n −1 ∑ Wλi ( x ) ⋅ Yi .

i =1

La forma funzionale dei pesi {Wλi (x)} è però difficile da esplicitare.

26

Antonio Manno ([email protected], www.statistica.too.it), Palermo, Italia

Esistono anche tecniche ricorsive non parametriche, caratterizzate dalla

presenza

di

coppie

di

osservazioni

(X 1 , Y1 ), (X 2 , Y2 ),

disponibili

sequenzialmente, come nel caso di serie storiche.

Con tali tecniche, si aggiorna lo stimatore per ogni nuova coppia di

osservazioni, infatti si ha:

mˆ n +1 ( x) = mˆ n ( x) + n −1 ⋅ K hn +1 (x − X n +1 ) ⋅ (Yn +1 − mˆ n ( x) ) .

Nella precedente espressione mˆ 0 = 0 e K h è una sequenza di kernel.

Revesz dimostrò che tale stimatore ha una distribuzione asintotica di tipo

normale.

Una tecnica non parametrica molto semplice è quella che prende il nome di

regressogram, nella quale la funzione m viene stimata per mezzo di una

media dei valori y associati ai valori X i appartenenti ad una determinata

classe definita a priori. Tale tecnica rappresenta un caso particolare della

stima di tipo kernel, nel caso in cui la funzione kernel sia uniforme.

Un’altra classe di stimatori non parametrici sono gli stimatori CS

(convolution smoothing), indicati con mˆ CS ( x) e definiti come:

mˆ CS ( x) = ∫ G n (t ) ⋅ K h ( x − t )dt

dove la funzione G n (t ) è l’interpolazione lineare dei dati osservati

{(X i , Yi )}in=1 e

K h è una sequenza di kernel.

È possibile esprimere tale stimatore anche come media ponderata, infatti:

n

( CS )

mˆ CS ( x) = n −1 ∑ Wni ( x)Yi

i =1

dove

Wni( CS ) ( x) = ∫ v i (t ) ⋅ K h ( x − t )dt

e vi (t ) è l’interpolazione lineare dei punti {(X j , δ ij )}nj =1 , dove δ ij è il simbolo

di Kronecker.

27

Antonio Manno ([email protected], www.statistica.too.it), Palermo, Italia

Se l’obiettivo è studiare la mediana di Y condizionatamente a X, invece che

la media condizionata, allora una sequenza di “mediane locali” della

variabile di risposta definisce lo stimatore detto mediana smoother. Tale

stimatore, che gode della proprietà di robustezza, è definito come:

mˆ ( x) = med {Yi : i ∈ J x }

dove J x è l’insieme definito in precedenza riguardo lo stimatore k-NN.

Schmerling e Peil proposero di stimare la distribuzione congiunta ignota di

(X,Y), ossia f(x,y) e quindi stimare m(x) con la formula standard della

tecnica di tipo kernel.

In particolare, la stima della densità che proposero è:

n

fˆ ( x, y ) = n −1 ∑ f XY ( x, y; X i , Yi ) ,

i =1

dove f XY ( x, y; X i , Yi ) sono densità note. La valutazione del valore atteso

condizionato sulla base di questa stima è una curva che chiamarono curva

di regressione empirica. Le scelte per f XY ( x, y; X i , Yi ) sono diverse; se per

esempio si considera:

f XY ( x, y; X i , Yi ) = K h ( x − X i ) K h ( y − Yi )

allora lo stimatore che ne deriva è:

n

mˆ h ( x) =

∑K

i =1

n

∑K

i =1

( x − X i )Yi

h

h

(x − X i )

che è lo stimatore di Nadaraya-Watson.

Si può anche considerare una distribuzione bidimensionale gaussiana.

28

Antonio Manno ([email protected], www.statistica.too.it), Palermo, Italia

3.2

Criteri di selezione della “finestra” h

Come si è osservato nella sezione precedente, la scelta dell’ampiezza h che

definisce l’intervallo del punto x le cui osservazioni y associate vengono

utilizzate per calcolare la media ponderata locale, che stima m(x), è di

basilare importanza: una finestra troppo elevata determina uno scarso

adattamento ai dati, per cui si ottiene uno stimatore distorto sebbene con

varianza bassa, dall’altra parte però, una finestra troppo piccola implica un

perfetto adattamento ai dati e quindi si ha uno stimatore corretto, ma con

un’elevata varianza. È necessario dunque trovare un valore della finestra h

che consenta di raggiungere un compromesso fra le due situazioni, in modo

da avere uno stimatore che si adatti bene ai dati, ma che presenti una

varianza non elevata, in modo da poter generalizzare i risultati ottenuti in

virtù del campione osservato e quindi poter fare previsione, oppure

estrapolare informazioni al di fuori del range di osservazione esaminato.

Al fine di selezionare un valore h che dia luogo ad un modello

generalizzabile esistono diverse procedure automatiche, che determinano il

valore h che ottimizza una qualche funzione obiettivo.

Una prima tecnica di tal natura è quella che va sotto il nome di cross

validation: si procede stimando m h (x) n volte, eliminando dal campione a

turno un’osservazione. Indicato con mˆ h, j ( X j ) lo stimatore ottenuto

considerando il campione privo della j-esima osservazione, ossia:

mˆ h, j ( X j ) = n −1 ∑ Whi ( X i )Yi

i≠ j

si considera la funzione CV, detta di cross validation:

n

[

]

CV (h) = n −1 ∑ Y j − mˆ h , j ( X j ) w( X j ) .

j =1

2

29

Antonio Manno ([email protected], www.statistica.too.it), Palermo, Italia

Il valore h selezionato sarà quello che minimizzerà la funzione CV, in

quanto essa indica l’abilità di predire Y j impiegando il campione privo

della j-esima unità X j .

Una procedura alternativa alla cross validation è quella che introduce una

funzione di penalizzazione, per evitare un eccessivo adattamento ai dati.

4.

Approccio semiparametrico

Molto spesso, per sfruttare i vantaggi sia dell’approccio parametrico che di

quello non parametrico, si considerano modelli che sono parzialmente

specificati e che sono detti semiparametrici.

Un modello semiparametrico è del tipo:

y = f ( z ; θ ) + m( x ) + ε

dove sia z che x sono variabili esplicative e θ è l’insieme di parametri da

cui dipende la funzione f, che viene completamente specificata.

Nell’equazione precedente, si nota che la parte deterministica del modello è

formata da due componenti:

1. f ( z;θ ) è la parte parametrica del modello, in quanto la funzione f è

specificata a priori e dipende da un certo insieme di parametri θ ;

2. m(x) è la parte non parametrica del modello, che verrà stimata con

una delle tecniche non parametriche descritte in precedenza.

30

Antonio Manno ([email protected], www.statistica.too.it), Palermo, Italia

Bibliografia

- Davidian M., Giltinan D.M, Nonlinear Models for Repeated

Measurement Data. Chapman & Hall

- Ryan T. P., Modern Regression Methods, Wiley

- Granger C.W., Terasvirta T. (1992), Modelling nonlinear economic

relationships. Oxford University Press

- Simonoff J.S. Smoothing Methods in Statistics. Springer

- Bowman, Azzalini Applied smoothing techniques for data analysis.

Oxford Science Publications

- Hart P.E., Non parametric smoothing and lack of fit. Springer

- Green P.J., Silverman B.W. (1994), Non parametric regression and

generalized linear models. Chapman & Hall

- Stone C.J. (1977), Consistent nonparametric regression. The Annals of

Statistics, Vol.5, No.4, 595-645

- Silverman B.W.(1985), Some Aspects of the Spline Smoothing Approach

to Non-parametric Regression Curve Fitting. Royal Statistical Society B

47, No. 1, 1-52

- Hardle W. (1989), Applied nonparametric regression. Cambridge

University Press

- Bishop C.M. (1995), Neural Networks for Pattern Recognition.

Clarendon Press, Oxford.

- Ripley B.D. (1996), Pattern Recognition and Neural Networks.

Cambridge, University Press.

- Johnston J. (1996), Econometrica. Franco Angeli

- Piccolo D. (1994), Introduzione all’analisi delle serie storiche. La

Nuova Italia Scientifica.

31