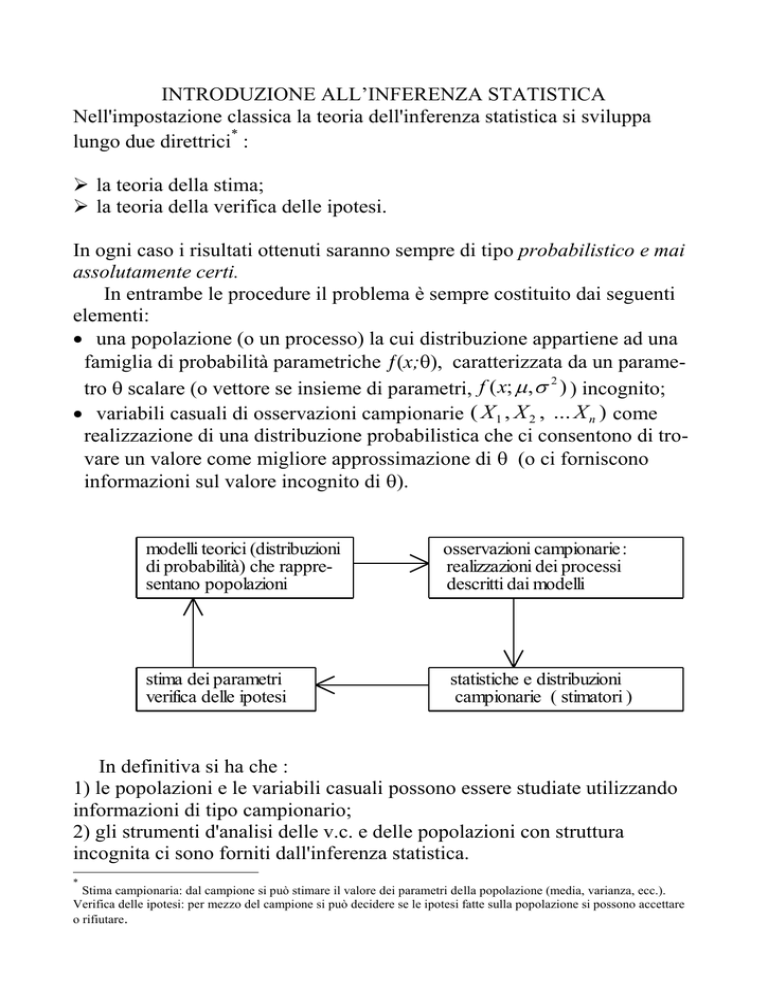

INTRODUZIONE ALL’INFERENZA STATISTICA

Nell'impostazione classica la teoria dell'inferenza statistica si sviluppa

*

lungo due direttrici :

la teoria della stima;

la teoria della verifica delle ipotesi.

In ogni caso i risultati ottenuti saranno sempre di tipo probabilistico e mai

assolutamente certi.

In entrambe le procedure il problema è sempre costituito dai seguenti

elementi:

una popolazione (o un processo) la cui distribuzione appartiene ad una

famiglia di probabilità parametriche (x;), caratterizzata da un parame2

tro scalare (o vettore se insieme di parametri, f ( x; , ) ) incognito;

variabili casuali di osservazioni campionarie ( X 1 , X 2 , ... X n ) come

realizzazione di una distribuzione probabilistica che ci consentono di trovare un valore come migliore approssimazione di (o ci forniscono

informazioni sul valore incognito di ).

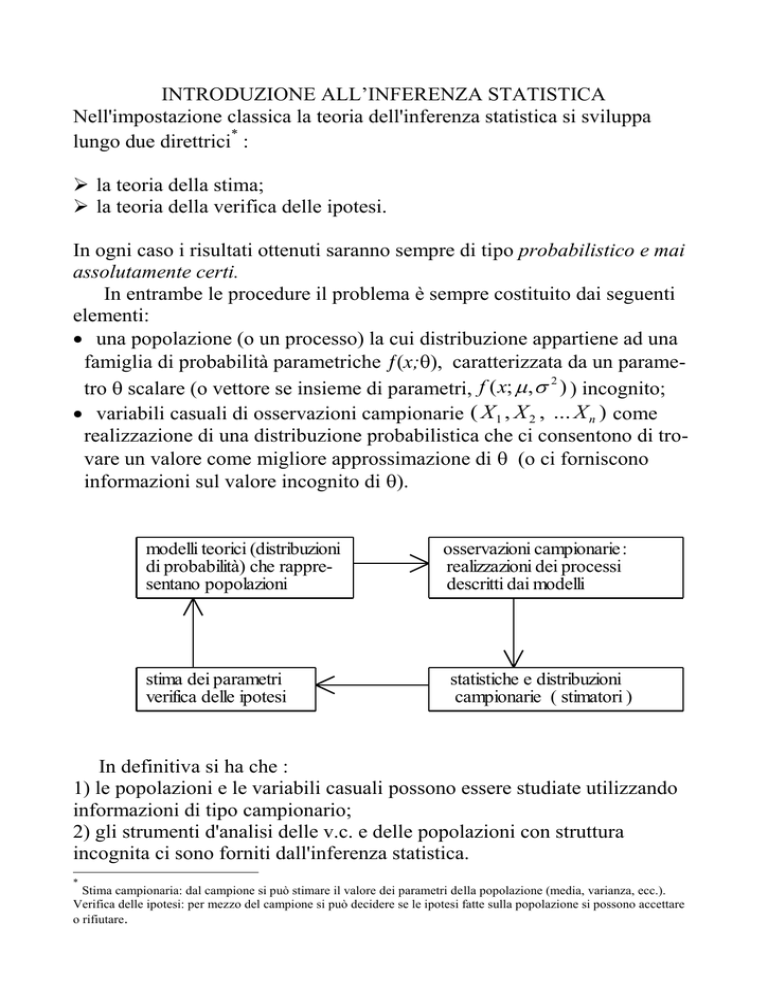

modelli teorici (distribuzioni

di probabilità) che rappresentano popolazioni

stima dei parametri

verifica delle ipotesi

osservazioni campionarie :

realizzazioni dei processi

descritti dai modelli

statistiche e distribuzioni

campionarie ( stimatori )

In definitiva si ha che :

1) le popolazioni e le variabili casuali possono essere studiate utilizzando

informazioni di tipo campionario;

2) gli strumenti d'analisi delle v.c. e delle popolazioni con struttura

incognita ci sono forniti dall'inferenza statistica.

*

Stima campionaria: dal campione si può stimare il valore dei parametri della popolazione (media, varianza, ecc.).

Verifica delle ipotesi: per mezzo del campione si può decidere se le ipotesi fatte sulla popolazione si possono accettare

o rifiutare.

Statistica campionaria (o stimatore):

T f ( X 1 , X 2 ,..., X n ) stimatore di un generico parametro ;

qualunque trasformazione dai dati a disposizione che formano il

campione casuale; essa è funzione di una realizzazione

( x1 , x2 ,..., xn ) di un campione casuale, e per questo è una

variabile casuale.

Stima: valore che assume lo stimatore (→ stime parametriche)

Le statistiche campionarie sono note come stimatori perché

attraverso esse possiamo determinare i valori (stime) dei parametri

non noti θi della popolazione.

In altri termini si è in grado di conoscere con approssimazione

più o meno “buona” i parametri non noti.

Si possono definire una pluralità di stimatori.

Esempio: la media campionaria

1

x

xi

n

è un possibile stimatore di μx ;

un altro stimatore di μx può essere la mediana campionaria

Me X ( n1) / 2 ;

oppure ancora un altro

x'

1

xi

n 1

Quale scegliere?

È necessario, quindi, definire un insieme di criteri o caratteristiche

per la scelta degli stimatori.

Le caratteristiche più importanti sono tre:

correttezza

efficienza

consistenza

Correttezza:

uno stimatore T si definisce corretto se

E(T) = θ;

se E(T) ≠ θ si dirà che T è uno stimatore distorto (bias).

Efficienza:

uno stimatore è efficiente se

Var(T) = min. , oppure se Var(T) ≤ Var(T1), dove E(T1) = θ.

Consistenza:

uno stimatore è consistente se all’aumentare della dimensione del

campione i suoi valori si avvicinano sempre di più al parametro θ

lim P( T( n ) ) 1 , oppure lim E(T ) 2 0 .

n

n

Supponiamo ora di scegliere le n unità campionarie seguendo

un’estrazione probabilistica del tipo bernoulliano (estrazione con

probabilità costante di unità indipendenti).

Allora le n unità campionarie estratte saranno v.c. indipendenti

ciascuna con propria f.d. e propri valori caratteristici.

Se, sulla base di tali valori probabilistici, determiniamo le

statistiche campionarie, ad esempio la media campionaria

x

1

n

x

i

essa, essendo una combinazione lineare di v.c. , sarà ancora una

v.c. con propria f.d. e propri valori caratteristici. E così per la

varianza :

S x2

1

( xi x ) 2

n 1

ˆ x2

1

( xi x ) 2

n

.

2

Tali media e varianza campionarie (x, s x ) allo stesso tempo

consentono di stimare i parametri μ e σ² (media e varianza)

della popolazione da cui è stato estratto il campione secondo il

predetto schema probabilistico.

Come si fa a riconoscere le f.d. delle statistiche?

Un aiuto in questa operazione viene dal teorema del limite

centrale.

Data una v.c. X, con media μ e varianza ², qualsiasi sia la

distribuzione di X, la distribuzione campionaria di X ha la stessa

2

media e varianza n

Infatti poiché le n v.c. X i che formano il campione hanno tutte la stessa

distribuzione, la stessa media e la stessa varianza si ha allora:

Xi

1 E ( X ) E ( X )... E ( X ) 1 n

x E ( X ) E i

1

2

n

;

n n

n

mentre

X 1 X 2 ... X n 1

1

2

2

2

2 Var ( X 1 X 2 ... X n ) 2 n

x Var ( X ) Var

n

n

n

n

Se la distribuzione della popolazione non è normale, oppure non si

conosce, per il teorema del limite centrale si ha che la

distribuzione della media campionaria è lo stesso normale, cioè:

qualunque sia la distribuzione della v.c. X, purché la media e la

varianza ² siano finite e le variabili casuali X i siano indipendenti

fra di loro, all'aumentare di n la media campionaria X tende a

2

distribuirsi asintoticamente normale con media e varianza n ;

Xn

Z

al tendere di n all'infinito la v.c. n n si distribuisce come

N(0, 1).

O ancora, quando la distribuzione della popolazione non è

normale, oppure non si conosce, la distribuzione della statistica

media campionaria X sarà normale per grandi campioni (n > 30),

mentre per piccoli campioni è necessario distinguere se la

popolazione è distribuita normalmente oppure no.

La varianza campionaria e la sua distribuzione

Sia s

2

(x

i

x)2

la varianza di un campione.

n

Se abbiamo X 1 , X 2 , X n vv. cc. allora la variabile casuale

varianza campionaria sarà S

2

(X

La sua media è

E ( S 2 ) s2

i

X )2

n

.

n 1 2

n

Si noti che E ( S )

Allora la v. c. varianza campionaria è uno stimatore distorto

(bias), ma asintoticamente corretto perché per n grande

2

2

E (S 2 ) 2 .

Poiché la statistica campionaria è distorta si ricorre alla varianza

campionaria corretta :

Sˆ

2

(X

i

X )2

n 1

, cioè

Sˆ 2 (n 1) ( X i X ) 2 .

ˆ 2 ) n n 1 2 2

E

(

S

Allora si ha

, cioè uno stimatore

n 1 n

corretto (unbias); mentre la varianza della varianza campionaria

4

2

2

ˆ

corretta è Var ( S ) n 1 .

2

Qualora le n vv. cc. X sono Normali la f. d. p. di Ŝ è

n 1Sˆ 2

2

n21

(Chi-quadro).

Altre statistiche campionarie (stimatori):

frequenza campionaria:

X

pq

F

Var

(

F

)

E

(

F

)

p

e

n con

n ; se n è grande

F N ( p ,

pq

)

n

differenza delle medie (confronto fra due campioni o tra due

medie): se si ipotizza che 1 2 , medie di due fenomeni X e

Y, presi due campioni n1 e n2 la standardizzata della v. c.

X Y con media E ( X Y ) 1 2 è

Z

X Y

12 n1 22 n2

N (0,1)

Metodi di stima

§ Metodo dei minimi quadrati (OLS)

Sia un campione casuale X 1 , X 2 , X n estratto da una popolazione X con parametro θ ignoto. Per ottenere una stima θ, cioè

ˆ , si minimizza la somma dei quadrati delle distanze tra le

singole osservazioni e il parametro θ:

min . : ( X i ) 2

ˆ

da cui si ottiene

X

n

i

, cioè la stima puntuale di θ;

altro es.:

sia una v. c. yi xi i con distribuzione normale la

cui media è E(Y | X ) xi , per ottenere la stima della

media E (Y | X ) si procede come segue:

min . :

y (ˆ ˆ x )

2

i

i

ˆ

da cui si ottengono ˆ e e quindi E (Y | X ) yˆ i (si vedrà meglio

nelle stime per la regressione).

§ Metodo di massima verosimiglianza (ML)

Il principio è quello di scegliere come stima di un parametro θ il

parametro della distribuzione che più verosimilmente può aver

generato il campione delle osservazioni.

Dato n vv. cc. X 1 , X 2 , X n indipendenti e con distribuzione

nota (es. Normale) la cui funzione di densità congiunta è

f ( X 1 , X 2 , X n ; ) ; allora si scrive che la funzione di

verosimiglianza è:

L( xi ; ) f ( x1 ) f ( x2 ) f ( xn ) , dove f ( x1 ), f ( x2 ), f ( xn ) sono le

funzioni di densità delle osservazioni campionarie indipendenti.

Si dimostra che ˆ massimizza la funzione L( xi ; ) ;

formalizzando si ha:

max . : L( xi ; )

f ( xi ; )

quindi ˆ sarà la stima di θ.

es.: una v. c. yi xi i con distribuzione normale

f ( yi )

1

2 2

exp( 1 2 2 ( yi ˆ ˆxi ) 2 )

la cui funzione di verosimiglianza è

L ( y i ; , , 2 )

1

2 2

exp( 1 2ˆ 2 ( yi ˆ ˆ xi ) 2 )

che deve essere massimizzata rispetto , e , ottenendo così

le stime dei tre parametri;

siano n vv. cc. X 1 , X 2 , X n , con distribuzione N(μ,σ²), si stimi

la media μ massimizzando la funzione di verosimiglianza

2

L( xi ; , 2 )

( xi ) 2

exp

2

2

2 2

; se si usano i logaritmi si ha

n

n

1

ln( L) ln( 2 ) ln( 2 )

2

2

2 2

x

̂

i

massimizzando si ottiene

n

e ˆ

2

(x )

2

i

(x )

2

i

n

.

STIMA PER INTERVALLI

La stima t è una determinazione della v. c. T (stimatore), cioè un

singolo valore della sua distribuzione la cui probabilità è nulla.

Trattandosi di una stima puntuale del parametro incognito θ è

piuttosto difficile che sia precisa, quindi si ha sempre un errore.

Sorge quindi la necessità di considerare questo errore per vedere

quanto la stima t sia vicina al parametro incognito θ e ridurre il

margine di incertezza (liberarci del divario tra stima e valore vero

del parametro).

Per fare questo bisogna quindi far riferimento alla distribuzione

dello stimatore e considerare non un solo valore, ma un gruppo di

valori, tra i quali alcuni saranno più plausibili di altri, cioè un insieme di valori che con un certo grado di probabilità contiene il

valore vero di θ.

Questo insieme di valori assume la forma di intervallo i cui

estremi sono funzione di T (→ intervallo casuale).

Dato un campione casuale ( X1 , X 2 ,..., X n ) e una statistica

campionaria la cui distribuzione sia nota, e fissato un livello di

probabilità (o fiducia) 1-α, si determinano gli estremi t1 e t2 tali

che:

P(t1 t 2 ) 1 ; con 0 ≤ α ≤ 1.

Poiché il parametro θ è una costante e gli estremi dell’intervallo t1

e t2 sono vv. cc. (variano con il variare dei campioni) si dirà:

con probabilità pari 1- α l’intervallo contiene il vero valore di θ,

oppure il (1- α)% degli intervalli contiene il vero valore di θ.

Per le distribuzioni campionarie si considereranno proprio le f.d.

2

N(0,1), la ( n 1) , la T- student, la F di Fisher.

Si sceglie un livello di probabilità abbastanza elevato per dare al

risultato atteso un interpretazione sistematica e al risultato complementare il significato di accidentalità (α = 0,05, livello di significatività).

Intervallo di confidenza per la media μ nell’ ipotesi che sia noto

σ².

Dato un campione che deriva da una popolazione (fenomeno) con

distribuzione normale (X ~>N(μ,σ²)) dove μ è non noto e σ² si

conosce, si determini l’intervallo di μ con probabilità pari ad 1- α.

Bisogna prima calcolare la media del campione mediante la media

2

campionaria sapendo che essa è X N ( , n) e che la

standardizzata è

Z

X

2 n

. Si cercano sulle tavole i valori di Z

in corrispondenza dell’α scelto (α/2), cioè ± Zα/2 e si ha:

P ( z

2

X

2

n

z 2 ) 1

che diventa

P( x z

2

n

x z

2

) 1

n

.

Se α=0.05 il valore di Zα/2=1.96 e abbiamo

P( x 1.96

n

x 1.96

) 0.95

n

che si chiama intervallo di confidenza al 95% della media

campionaria.

Esso indica, in funzione di un elemento di probabilità assegnato

( il livello di confidenza – nella fattispecie 95% ), la probabilità di

ottenere un intervallo di valori che contiene il valore “vero” e non

noto della popolazione, ripetendo il campionamento un numero di

volte sufficientemente elevato.

In altri termini: se potessimo ripetere il campionamento molte

volte, 95 volte su 100 il valore della media della popolazione sarà

contenuto entro l’intervallo di confidenza.

Ovviamente gli estremi dell’intervallo varieranno con la scelta del

livello di confidenza.

Dall’intervallo di confidenza per la media campionaria (con

varianza della popolazione supposta nota) introduciamo il

concetto più ampio di stima intervallare da contrapporre all’altro

di stima puntuale.

La stima puntuale altro non è se non la soluzione dell’algoritmo di

stima (stimatore) (vedi metodi OLS, ML).

Essa consiste di un solo valore (un punto) di stima che è uno dei

tanti (infiniti) valori che la v.c. (o qualsiasi altro stimatore di

qualsiasi altro parametro) può assumere.

Se, a partire dalla stima puntuale, possiamo avere una

valutazione probabilistica (impossibile con la stima puntuale) di

un intervallo di valori all’interno del quale è contenuto il

parametro da stimare, la portata informativa è molto maggiore e

più accurata.

Se la media di un campione di 100 elementi è x 27.5 e lo

s.q.m. del fenomeno è pari a 0.05, con α=0.05 l’intervallo è

P(27.5 1.96

0.05

27.5 1.96

0.05

100

P(27.4902 27.5098) 0.95

) 0.95

100

Nel caso in cui σ è ignoto (caso reale) non è più possibile

utilizzare come distribuzione della media campionaria la normale

standardizzata, ma bisogna ricorrere alla distribuzione T-Student

con n-1 gradi di libertà:

t n1

X

s

n

e l’intervallo diventa

P( x t

s

2

n

x t

s

2

) 1

n

Dove s è la stima dello sqm, un valore ottenuto dalle

s

osservazioni, mentre

n

è l’errore standard della stima.