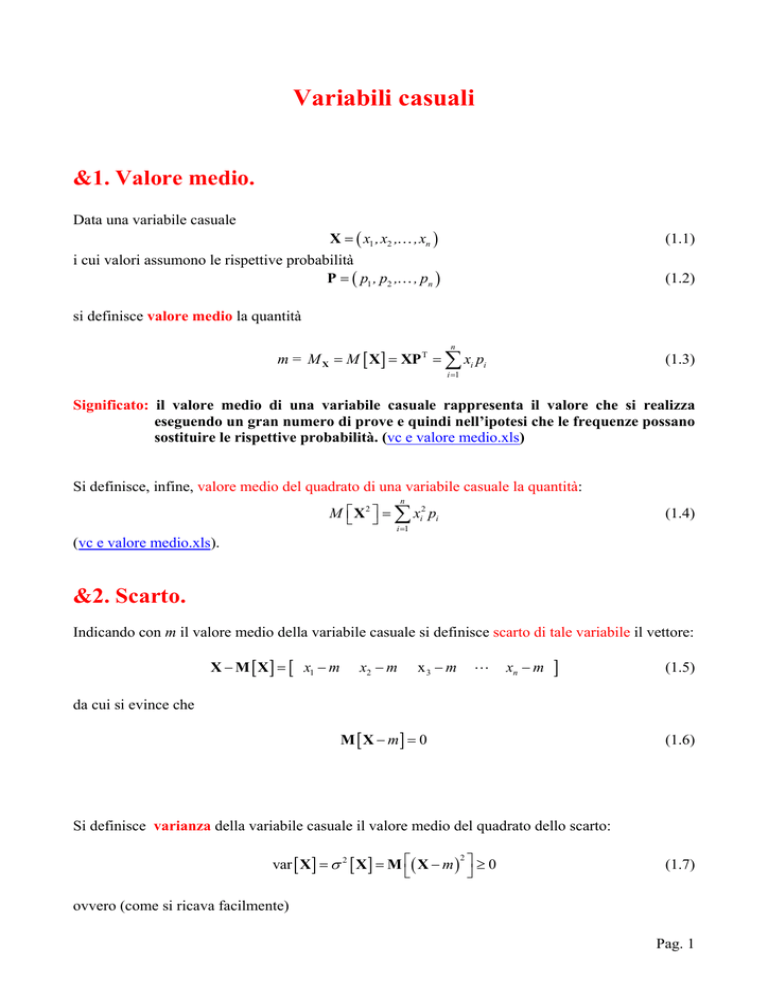

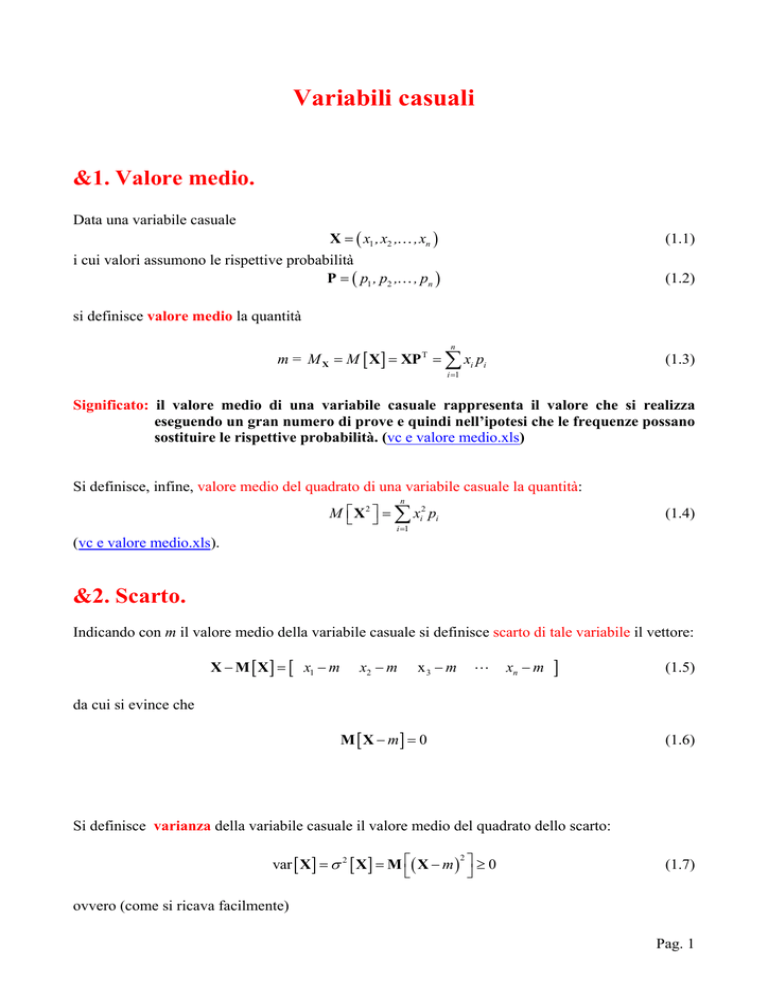

Variabili casuali

&1. Valore medio.

Data una variabile casuale

X = ( x1 ,x2 ,K ,xn )

(1.1)

i cui valori assumono le rispettive probabilità

P = ( p1 , p2 ,K , pn )

(1.2)

si definisce valore medio la quantità

n

m = M X = M [ X ] = XP T = ∑ xi pi

(1.3)

i =1

Significato: il valore medio di una variabile casuale rappresenta il valore che si realizza

eseguendo un gran numero di prove e quindi nell’ipotesi che le frequenze possano

sostituire le rispettive probabilità. (vc e valore medio.xls)

Si definisce, infine, valore medio del quadrato di una variabile casuale la quantità:

n

M ⎡⎣ X 2 ⎤⎦ = ∑ xi2 pi

(1.4)

i =1

(vc e valore medio.xls).

&2. Scarto.

Indicando con m il valore medio della variabile casuale si definisce scarto di tale variabile il vettore:

X − M [ X ] = [ x1 − m

x2 − m

x3 − m

L

xn − m

]

(1.5)

da cui si evince che

M [ X − m] = 0

(1.6)

Si definisce varianza della variabile casuale il valore medio del quadrato dello scarto:

2

var [ X ] = σ 2 [ X ] = M ⎡( X − m ) ⎤ ≥ 0

⎣

⎦

(1.7)

ovvero (come si ricava facilmente)

Pag. 1

var [ X ] = M ⎡⎣ X 2 ⎤⎦ − ( m )

2

(1.8)

Significato: la varianza misura il grado di variabilità della variabile casuale.

Indicando con a e b due costanti arbitrarie si verifica facilmente:

var [ a ] = 0

(1.9)

var [ a X ] = a 2 var [ X ]

(1.10)

var [ a + X ] = var [ X ]

(1.11)

var [ a X + b ] = a 2 var [ X ]

(1.12)

Infine si definisce scarto quadratico medio o deviazione standard la quantità:

σ [ X ] = var [ X ]

(1.13)

vc e valore medio.xls

&3. Applicazioni alla finanza.

Quando in una operazione finanziaria i flussi di cassa non possono essere considerati come somme

certe ( ad esempio, nel caso di un prestito, il rischio di insolvenza del debitore) tutta l’operazione

deve essere trattata da un punto di vista probabilistico e le somme diventano variabili aleatorie

aventi una certa probabilità di realizzarsi.

Da un punto di vista matematico il valore medio di queste somme aleatorie dà la misura della

possibilità del loro realizzo e prende il nome di valore atteso o speranza matematica.

Se p è la probabilità di ricevere una somma S e quindi 1-p la probabilità di non riceverla, allora

l’importo X ha valore atteso:

E [ X ] = Sp + 0 (1 − p ) = Sp

(1.14)

Più generalmente, se X ≡ ( X 1 , X 2 ,K , X n ) è la variabile aleatoria di probabilità p ≡ ( p1 , p2 ,K , pn )

che rappresenta un certo flusso di cassa il suo valore atteso è

n

E [ X ] = ∑ X k pk

(1.15)

k =1

Nell’ipotesi che i è il tasso di interesse periodale ed n il numero di periodi di durata dell’operazione,

il valore atteso attualizzato

n

Va ( E ) = ∑ X k pk (1 + i )

−k

(1.16)

k =1

rappresenta il valore, all’istante attuale, della operazione stessa.

Pag. 2

Nel caso di prestiti a rischio, volendo determinare l’interesse da applicare, occorre prima

determinare il valore attuale della speranza matematica utilizzando l’interesse privo di rischio con la

(1.19), e poi considerare tale valore come l’attualizzazione al tasso cercato (i* ) della somma da

dare in prestito. Per cui, se S è la somma, il periodo unitario, p la probabilità di riceverla ed i il tasso

del periodo privo di rischio, si ha:

−1

Va = Sp (1 + i )

(*)

Per cui l’equivalenza finanziaria è data da:

Va = S (1 + i *)

e quindi, dal confronto delle (*) e (**) segue:

Sp (1 + i ) = S (1 + i *)

−1

−1

−1

(**)

⇒ i* =

1+ i

−1

p

[esercizi su somme aleatorie.doc]

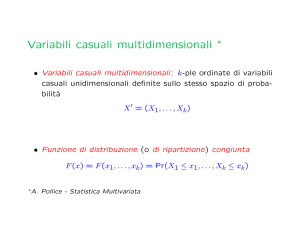

Variabili casuali doppie o bivariate

Date due variabili X e Y si possono eseguire con esse le operazioni di somma e prodotto

ottenendo così due nuove variabili:

Z = X+Y

(1.17)

ovvero

Z=X Y

(1.18)

Poiché, in ogni caso, la variabile Z è funzione di due variabili casuali essa prende il nome di

variabile casuale doppia o bivariata. Resta il problema di conoscere i valori delle probabilità da

associare ai valori che compongono il vettore Z .

Supponiamo che la variabile X assuma valori xi con probabilità pi

variabile Y valori yk con probabilità p'k

( k = 1, 2,K m ) .

( i = 1, 2,K ,n )

e la

Per determinare le probabilità pik da

assegnare alle variabili zik = xi + yk ovvero zik = xi yk occorre distinguere se le variabili X e

Y sono indipendenti o dipendenti.

Se gli eventi sono indipendenti, per il teorema della probabilità composta, segue che la probabilità

da associare alla coppia ( xi , yk ) è pik = pi p'k . Se, mediante queste operazioni, il vettore Z presenta

valori ripetuti questi devono essere considerati una sola volta assegnando ad ogni valore ripetuto

una probabilità data dalla somma delle probabilità degli eventi che hanno prodotto tale valore

Pag. 3

poiché le varie coppie ( xi , yk ) rappresentano sempre eventi fra loro incompatibili. [bivariata (eventi

indipendenti).xls].

La probabilità pi p'k assegnata al valore zik della variabile Z prende il nome di probabilità

congiunta mentre le pi e qk sono dette probabilità marginali.

Se gli eventi sono dipendenti non può assegnarsi al valore zik della variabile Z la distribuzione di

probabilità congiunta costruita con il precedente metodo (prodotto delle probabilità marginali) . In

tal caso tale distribuzione congiunta, pik , deve essere assegnata a priori prima di procedere al

calcolo (somma) della distribuzione di probabilità da assegnare ai valori ripetuti di Z . [bivariata

(eventi dipendenti).xls].

In ogni caso, in virtù del teorema della probabilità totale, essendo le coppie

incompatibili, si ha:

m

( xi , yk )

e

( yk ,xi )

pi = ∑ pi k

( i = 1, 2,K n )

(1.19)

n

( k = 1, 2,K ,m )

(1.20)

k =1

qk = ∑ pi k

i =1

Per la variabile Z possono essere calcolate le medie e gli scarti.

Cominciamo ad osservare che qualunque sia la relazione fra due variabili casuali (dipendenti o

indipendenti) si ha sempre:

M [ X + Y] = M X + M Y

(1.21)

Infatti:

n

m

n

M [ X + Y ] = ∑∑ ( xi + yk ) pi k = ∑ xi

i =1 k =1

i =1

m

m

k =1

k =1

∑ pi k +∑ yk

n

∑p

i =1

ik

che, in virtù delle (1.19) e (1.20), fornisce:

n

m

i =1

k =1

M [ X + Y ] = ∑ xi pi + ∑ yk p'k

ossia

M [ X + Y] = M X + M Y

(1.22)

Date due variabili casuali, si definisce loro covarianza la quantità:

cov [ X , Y ] = M ⎡⎣( X − M X )( Y − M Y ) ⎤⎦

(1.23)

Pag. 4

Osserviamo che la covarianza sarà positiva quando gli scarti X − M X e Y − M Y hanno lo stesso

segno con probabilità alta, mentre assumerà valori negativi quando tendono con alta probabilità ad

avere segno opposto

La (1.26) , opportunamente sviluppata, può scriversi nella forma:

cov [ X , Y ] = M [ X Y ] − M X M Y

(1.24)

cov [ X , X ] = var [ X ]

(1.25)

cov [ X , Y ] = cov [ Y , X ]

(1.26)

Dalla definizione (1.26) segue:

Inoltre, se X, Y e Z sono tre variabili casuali risulta:

cov [ aX + bY ; Z ] = a cov [ X , Z ] + b cov [ Y , Z ]

(1.27)

dimostrazione della (1.30)

Utilizzando la (1.27) risulta:

cov [ aX + bY; Z ] = M ⎡⎣( aX + bY ) Z ⎤⎦ − M [ aX + bY ] M Z =

= M [ aXZ + bYZ ] − a M X M Z − b M Y M Z =

= a M [ XZ ] + b M [ YZ ] − a M X M Z − b M Y M Z =

= a ( M [ XZ ] − M X M Z ) + b ( M [ YZ ] − M Y M Z ) =

= a cov [ X , Z ] + b cov [ Y , Z ]

c.d.d.

Dalle (1.28)-(1.30) risulta poi:

var [ aX + bY ] = cov [ aX + bY;aX + bY ] =

= a cov [ X ; aX + bY ] + b cov [ Y ; aX + bY ] =

= a 2 cov [ X ; X] + a b cov [ X ; Y ] + b a cov [ X ; Y ] + b 2 cov [ Y ; Y ]

e quindi

var [ a X + b Y ] = a 2 var [ X ] + b 2 var [ Y ] + 2 a b cov [ X ; Y ]

(1.28)

Se le due variabili casuali sono indipendenti allora la loro covarianza è nulla.

Infatti, come è stato già mostrato, se le variabili X ≡ ( xi ) (di probabilità pi ) e Y ≡ ( yk ) (di

probabilità qk ) sono indipendenti le loro probabilità marginali determinano la probabilità

congiunta; ad esempio la variabile ( xi yk ) ha probabilità zik = pi qk .

Poiché gli scarti hanno le stesse probabilità della variabile a loro relazionata segue che:

Pag. 5

n

m

cov [ X ; Y ] = ∑∑ ( xi − M X )( yk − M Y ) pi qk =

i =1 k =1

⎛ n

⎞⎛ m

⎞

= ⎜ ∑ ( xi − M X ) pi ⎟ ⎜ ∑ ( yk − M Y ) qk ⎟ = 0

⎝ i =1

⎠ ⎝ k =1

⎠

Pag. 6