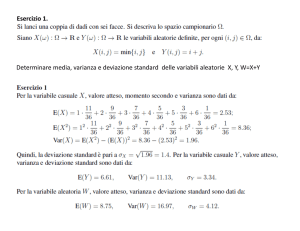

Sistemi di variabili casuali

Fin qui si sono considerate le variabili casuali ciascuna per proprio conto.

Ora consideriamo la possibilità di relazioni tra variabili.

Esempi:

- il massimo annuale della portata al colmo alla Becca e alla Miorina

- la portata media giornaliera in un certo giorno dell'anno e quella del

giorno precedente

- il totale annuo di precipitazione in una stazione pluviometrica e quello

in una stazione vicina

- il totale annuo di precipitazione in una stazione pluviometrica e quelli

in più stazioni vicine

- il deflusso annuo in una stazione di portata e quello in una stazione a

monte

- il deflusso annuo in una stazione di portata e quello in più stazioni

della stessa regione

La distribuzione di x 1 è diversa a seconda che i valori delle variabili x 2 ,

x 3 , ... siano alti, bassi oppure incogniti.

Per definire un sistema di variabili casuali è necessario stabilire una

c o r r i s p o n d e n z a tra i valori osservati; l'osservazione diventa un'entità

vettoriale.

Caso di una sola variabile (continua):

- l'osservazione si può rappresentare con un punto su una retta

orientata

- la probabilità di non superamento di un valore è la probabilità che il

punto che rappresenta l'osservazione ricada in una semiretta

- la probabilità che l'osservazione ricada in un intervallo di valori è la

probabilità che il punto che rappresenta l'osservazione ricada in un

segmento

- la densità di probabilità è la funzione che moltiplicata per dx dà la

probabilità di ricadere nell'intervallo infinitesimo

- l'integrale della densità di probabilità su una semiretta è la

probabilità di non superamento di un valore assegnato

Caso di due variabili (continue)

- l'osservazione si può rappresentare con un punto su un piano

cartesiano

- la probabilità di non superamento di una coppia di valori è la

probabilità che il punto che rappresenta l'osservazione ricada in un

quadrante

- la probabilità che un'osservazione ricada in due intervalli di valori

assegnati è la probabilità che il punto che rappresenta l'osservazione

ricada in un rettangolo

- la densità di probabilità è la funzione che moltiplicata per dx 1 dx 2 dà la

probabilità di ricadere nel rettangolo infinitesimo

- l'integrale della densità di probabilità su un quadrante è la probabilità

di non superamento di due valori assegnati

Funzioni di probabilità

Funzione di probabilità della distribuzione congiunta P ( x 1 , x 2 ) :

probabilità che contemporaneamente sussistano le disuguaglianze

x1 ≤ x1a

x2 ≤ x2a

Relazione tra densità di probabilità p(x 1 , x 2 ) e probabilità P (x 1 , x 2 ) :

x1 x2

P (x 1 , x 2 ) =

∫ ∫ p (x 1 , x 2 )d x 1 d x 2 .

-∞ -∞

Funzione di probabilità marginale di x 1 :

P (x 1a ) = Prob{x 1 ≤ x 1a }

Funzione di probabilità di x 1 condizionata a x 2 :

P (x 1 a | x 2 a ) = P r o b { x 1 ≤ x 1 a | x 2 = x 2 a }

Variabili indipendenti:

P (x 1 | x 2 ) = P (x 1 )

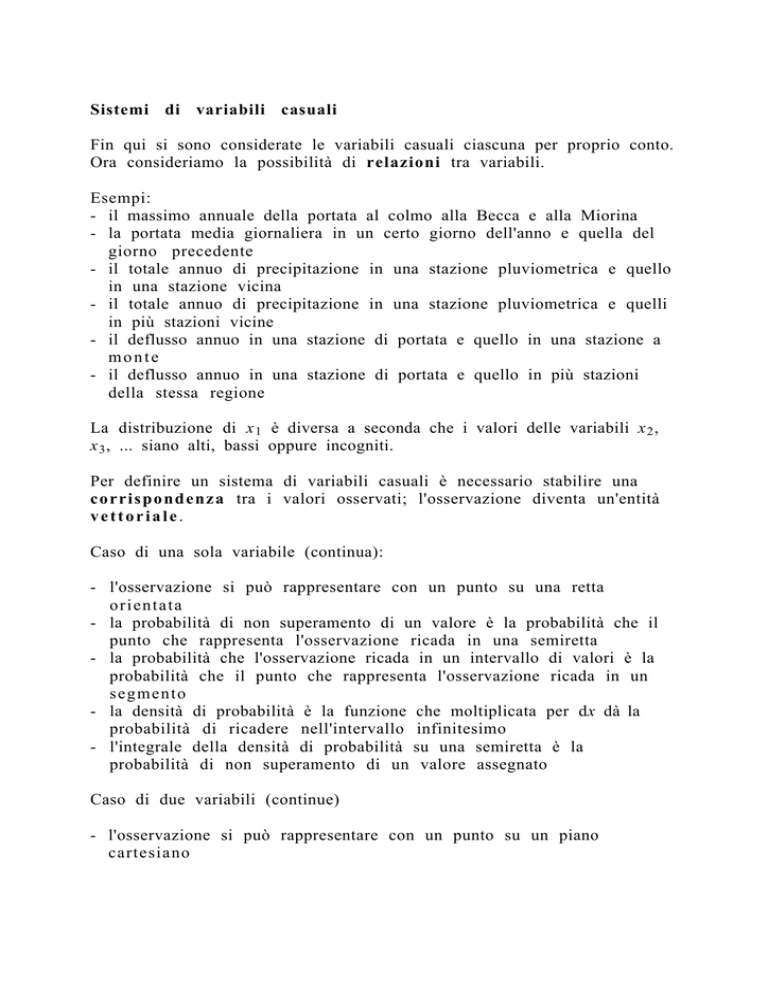

x2

dx2

x2a

dx1

0

x1a

0

x1

x2

dx2

x2a

dx1

0

0

x1a

x1

Legame tra probabilità congiunta e probabilità condizionata

L'evento per cui un'osservazione ricade nel rettangolo infinitesimo di lati

d x 1 e dx 2 è un evento composto. I due eventi elementari sono quello per

cui l'osservazione ricade nella striscia di larghezza dx 1 e quello per cui

l'osservazione ricade nella striscia di larghezza dx 2 .

La probabilità di ricadere nella striscia verticale è p(x 1a )dx 1 . La

probabilità di ricadere nel rettangolino, a condizione che si sia nella

striscia verticale, è p(x 2a |x 1a )dx 2 . Il prodotto delle due probabilità è

uguale alla probabilità incondizionata di ricadere nel rettangolino

p(x 1a )dx 1 p(x 2a |x 1a )dx 2 = p(x 1a , x 2a )dx 1 dx 2

Quindi

p (x 1 , x 2 ) = p (x 1 )p (x 2 |x 1 ) = p (x 2 )p (x 1 |x 2 )

Se x 1 , x 2 sono tra loro indipendenti:

p (x 2 |x 1 ) = p (x 2 )

p (x 1 |x 2 ) = p (x 1 )

p (x 1 , x 2 ) = p (x 1 )p (x 2 )

La variabile condizionante non è necessariamente una variabile

casuale.

Esempi:

- il massimo annuale della portata al colmo (osservato in una stazione di

una certa regione) e l'area del bacino

- l'altezza di precipitazione totale annua e la quota della stazione

I risultati si estendono ai sistemi costituiti da più di due variabili casuali.

Caso importante: la distribuzione congiunta di due variabili, marginale

rispetto a tutte le altre variabili.

Momenti

Nel caso di una sola variabile

+∞

∫ (x - x 0)rp (x ) d x

µr' ( x ) =

-∞

+∞

µ (x ) =

∫xp(x)dx

-∞

µ r(x ) =

σ 2 (x ) =

+∞

∫ [x - µ (x )] r p (x ) d x

-∞

+∞

∫ [x - µ (x )] 2 p (x ) d x

-∞

Nel caso di due variabili casuali

momento multiplo

µr' s (x 1 , x 2 ) =

+∞ +∞

∫ ∫[ x 1 - x 1 0 ] r [ x 2 - x 2 0 ] s p ( x 1 , x 2 ) d x 1 d x 2

-∞ -∞

covarianza

σ (x 1 , x 2 ) =

+∞ +∞

∫ ∫[x 1 - µ (x 1 )] [x 2 - µ (x 2 )] p (x 1 , x 2 )d x 1 d x 2

-∞ -∞

coefficiente di correlazione lineare

ρ (x 1, x 2) =

σ (x 1 , x 2 )

σ (x 1 ) σ (x 2 )

Rappresentazione

compatta delle variabili e dei parametri

(ogni osservazione è un vettore):

µ1

µ2

µ = …

…

µp

xx 1

2

…

x=

…

x p

… σ 1p

σσ 11σσ 12 …

21 22 … … σ 2p

Σ = … … … … …

… … … … …

σ p1σ p2 … … σ p p

Stime

Per la generica variabile x (che può coincidere con x 1 , x 2 , ...):

stima di µ (x)

m (x ) =

1

N

N

∑xi

i= 1

stima di σ 2 (x)

s 2 (x ) =

1

N

N

∑ [x i - m (x )]2

i= 1

Per una generica coppia di variabili x 1 , x 2 :

stima di σ (x 1 , x 2 )

s (x 1 , x 2 ) =

Il

metodo

della

1

N

N

∑ [x 1i - m (x 1)][x 2i - m (x 2) ]

1= 1

massima

verosimiglianza

Il metodo della massima verosimiglianza è un metodo di stima dei

parametri. Qui si considera solo il caso della distribuzione di una sola

variabile x, caratterizzata da s parametri.

Si considera un campione di N osservazioni estratte indipendentemente

l'una dall'altra dalla distribuzione data (che è sempre la stessa) come

una singola osservazione (vettoriale) estratta da un sistema di N

variabili casuali, tra loro indipendenti, con distribuzione marginale

identica per tutte le variabili.

La densità di probabilità della distribuzione congiunta delle N variabili è

p (x 1 , x 2 , ...,x N ; θ 1 , θ 2 , ..., θ s ) =

= p (x 1 ; θ 1 , θ 2 , ..., θ s ) p (x 2 ; θ 1 , θ 2 , ..., θ s ) ... p (x N ; θ 1 , θ , ..., θ s ) .

In corrispondenza dei valori osservati x *1 , x *2 , ..., x *N la densità di

probabilità (che prende il nome di funzione di verosimiglianza, perchè il

campione è tanto più verosimile quanto più alta è la densità di

probabilità) diventa

p (x *1 , x *2 , ..., x *N ; θ 1 , θ 2 , ..., θ s ) .

Il metodo della massima verosimiglianza consiste nell'attribuire ai

parametri θ 1 , θ 2 , ..., θ s i valori che rendono massima la funzione di

verosimiglianza. I valori si determinano risolvendo il sistema di

equazioni ottenuto uguagliando a zero le derivate parziali della funzione

di verosimiglianza calcolate rispetto ai parametri θ 1 , θ 2 , ..., θ s .