FACOLTÀ DI INGEGNERIA

CORSI DI STUDIO IN INGEGNERIA ELETTRONICA

Corso di

TEORIA DEI SEGNALI

Materiale a cura dei

Proff. Patrizio Campisi e Alessandro Neri

WEB:

http://biomedia4n6.uniroma3.it/teaching/teoria_dei_segnali.html

SERVIZI DI TELECOMUNICAZIONE

Nodo di

commutazione

rete di

telecomunicazione

Obiettivo primario di un servizio di telecomunicazione è il

trasferimento dell'informazione emessa da una sorgente agli

utilizzatori a cui essa è rivolta, nell'ambito di una particolare

applicazione.

Il trasferimento richiede l'accesso da parte degli utenti ad una rete

di telecomunicazione intesa come il complesso di mezzi che,

attraverso le risorse tecniche ed operative necessarie, consente

ai suoi utenti il trasferimento dell'informazione.

LA COMUNICAZIONE

Nello studio dei sistemi di telecomunicazione si è soliti fare

riferimento a tre entità fondamentali:

1. il MESSAGGIO, che rappresenta l’oggetto della comunicazione

2. la SORGENTE del messaggio

3. il DESTINATARIO del messaggio

DESTINATARIO

SORGENTE

destinatario di

messaggi

generatore di

messaggi

messaggio

messaggio

convertitore

segnale/messaggio

convertitore

messaggio/segnale

segnale

Canale di comunicazione

In generale nel modellare il comportamento della sorgente si

possono individuare due momenti concettualmente distinti:

1. La

formulazione

del

messaggio

da

trasmettere

e

l’individuazione del destinatario.

2. La concretizzazione del messaggio astratto in una forma fisica

adeguata affinché possa pervenire al destinatario: il SEGNALE.

FORMA D'ONDA

La descrizione più naturale di un segnale è costituita dalla

funzione matematica che descrive l'andamento della grandezza

fisica che fa da supporto al messaggio in funzione del tempo, dello

spazio o dello spazio-tempo. Tale funzione prende il nome di

forma d'onda.

Sebbene il riferimento a grandezze fisiche faccia presupporre che

il codominio della forma d'onda debba essere costituito

dall'insieme R dei numeri reali, è conveniente prendere in

considerazione funzioni complesse.

Def.: Preso un sottinsieme T ⊆ R m dello spazio euclideo a m

dimensioni, che denota l'intervallo d'interesse, si definisce

forma d'onda del segnale x(t) la funzione complessa

X :T → Cn

Nel seguito, laddove non sia esplicitamente specificato, si supporrà

m=1 e n=1.

SEGNALI TEMPO DISCRETO E TEMPO CONTINUO

Def.: Si definisce segnale tempo discreto un segnale tale che T sia

una sequenza numerabile di istanti di tempo {t 1 , t1 ,…, t N,…}.

100

80

60

40

20

0

0

2

1

4

3

5

Notazione per segnali tempo discreto:

x[k]= x(t k )

Gli istanti di tempo non devono essere necessariamente equispaziati.

Inoltre non si fa riferimento alla durata degli intervalli tra gli istanti

di tempo, cosicché non si può fare riferimento all'aspetto dinamico

del segnale (e.g. velocità di variazione di un segnale).

Def.: Si definisce segnale tempo continuo un segnale x(t) tale che T

sia un intervallo di R.

1.5

1

0.5

0

-0.5 0

-1

-1.5

1

2

3

4

5

RAPPRESENTAZIONE GEOMETRICA DEI

SEGNALI

Scopo:

individuare un modello matematico che consenta di esprimere in

modo semplice ed efficiente le trasformazioni che i segnali

subiscono nel transito attraverso i sistemi fisici.

L'insieme di tutte le forme d'onda, dotato delle operazioni di

somma e prodotto per una costante complessa gode di tutte le

proprietà che caratterizzano uno spazio vettoriale X. Infatti

i.

∀ x(t), ∀y(t) ∈X, x(t) + y(t) ∈X

ii.

l'operazione di addizione + tra forme d'onda è associativa,

commutativa e invertibile

iii. ∀α∈C, ∀ x(t)∈X, α x(t) ∈X

iv. α [x(t) + y(t)] = α x(t) + α y(t)

v.

[α + β ] x(t) = α x(t) + β x(t)

vi. α [ β x(t) ] = (α β ) x(t)

vii. 1 x(t) = x(t).

vantaggio della rappresentazione geometrica dei segnali:

possibilità di impiegare il vocabolario ed i risultati della

geometria nello studio dei problemi di comunicazione.

RAPPRESENTAZIONE GEOMETRICA DEI

SEGNALI

Esempio

Si consideri un segnale tempo discreto x[k] il cui dominio sia

costituito da un insieme finito di istanti di tempo {t 1 , t 1 ,…, t N }.

Indipendentemente da ciò che essi rappresentano, gli N numeri

complessi x[1], x[2],…, x[k],…, x[N] possono essere sempre

pensati come le coordinate di un punto nello spazio Ndimensionale.

In essenza, si sostituisce un'entità complessa, il segnale, in un

ambiente semplice con un'entità semplice, il vettore, in un

ambiente complesso.

TRANSITO ATTRAVERSO UN SISTEMA FISICO

x(t)

y(t)

S

Siano:

•

x(t): segnale d'ingresso rappresentante l'eccitazione del sistema,

•

S : blocco funzionale relativo al sistema in esame,

•

y(t): segnale d'uscita o risposta all'eccitazione x(t),

•

X : spazio vettoriale a cui appartiene x(t),

•

Y : spazio vettoriale a cui appartiene y(t).

L'azione

del

sistema

S

può

essere

modellata

come

una

trasformazione

H : X →Y

ovvero come una regola che associa ad ogni elemento x(t) di X un

unico elemento y(t) dello spazio Y.

TRASFORMAZIONI LINEARI

Def.: Una trasformazione H si dice lineare se e esolo se

H[a1 x 1 (t) + a 2 x 2 (t)] = a 1 H[x 1 (t)]+ a 2 H[x 2 (t)]

= a 1 y 1 (t)+ a 2 y 2 (t)

comunque si prendano x 1 (t) e x 2 (t) ed i due numeri complessi a 1 e

a 2 ; y 1 (t) e y2 (t) rappresentano il risultato della trasformazione

applicata rispettivamente a x 1 (t) e x 2 (t).

In generale, l'applicazione successiva della proprietà espressa

dalla definizione precedente consente di scrivere, per N finito,

N

H

ai xi (t ) =

i =1

∑

N

∑ a H [ x ( t ) ].

i

i

i =1

In generale non è detto che la precedente proprietà sussista

qualora si consideri la somma di un'infinità numerabile o non

numerabile di elementi, in quanto la proprietà di linearità non

implica di per sé la commutatività delle operazioni di

trasformazione e di serie, ovvero di somma integrale.

Quando ciò accade si dice che la trasformazione è lineare in senso

esteso.

SISTEMI LINEARI

Def.: Una trasformazione H si dice lineare in senso esteso se e e

solo se

H

∞

∑

i =1

ai xi (t ) =

∞

∑a H [x (t )]

i

i

i =1

ovvero

∫

H a ( σ ) x ( t , σ ) dσ =

∫ a ( σ ) H [ x ( t , σ ) ]dσ .

Def.: Un sistema S si dice lineare se la trasformazione H ad esso

associata è lineare in senso esteso.

Poiché in uno spazio vettoriale è sempre possibile trovare una

base tale che ciascun elemento dello spazio possa essere espresso

come combinazione lineare degli elementi che costituiscono la

base, la proprietà di linearità consente di scrivere in modo rapido

il legame che esiste tra l'ingresso e l'uscita una volta noto (ovvero

misurato) il comportamento del sistema quando al suo ingresso

vengano applicati i segnali che costituiscono la base.

SISTEMI LINEARI E PERMANENTI

La descrizione del comportamento di un sistema lineare si

semplifica ulteriormente se il suo comportamento è invariante

rispetto alle traslazioni temporali.

Def.: Un sistema S si dice permanente, o invariante rispetto

alle traslazioni temporali, o invariante nel tempo, se ad

una

traslazione

temporale

t0

dell'eccitazione

x(t)

corrisponde un'uguale traslazione della risposta y(t), ovvero

H [ x ( t − t 0 ) ] = y ( t − t 0 ),

∀t 0 ∈ T , ∀x ( t ) ∈ X

avendo posto y ( t ) = H [ x ( t ) ]

In tal caso l'adozione di particolari basi di rappresentazione i cui

elementi siano ottenibili per traslazione di una funzione

elementare w(t) consente di scrivere il generico segnale x(t) come:

x(τ ) =

∫ a ( τ ) w ( τ − τ ) dτ

Di conseguenza l'uscita corrispondente sarà pari a

y(τ ) =

∫ a ( τ ) h ( τ − τ ) dτ

essendo h(t) l'uscita corrispondente alla funzione elementare w(t).

SISTEMI LINEARI E PERMANENTI A TEMPO

DISCRETO

•

Dato un segnale reale tempo discreto con T costituito da N

istanti di tempo {t 0 , t 1 ,…, t N-1 }, siano

x[0], x[1], x[2],…, x[n],…, x[N-1]

i valori assunti dal segnale nei corrispondenti istanti di tempo e

sia

x = (x[0] x[1] x[2] … x[n] … x[N-1])T

il vettore dello spazio N-dimensionale associato al segnale.

•

Consideriamo la base dello spazio RN costituita dalle N-uple

•

ε 0 = (1 0 0 … 0 … 0)

ε 1 = (0 1 0 … 0 … 0)

…………………….

ε n = (0 0 0 … 1 … 0)

ε N-1 = (0 0 0 … 0 … 1)

Ogni elemento di tale spazio può essere espresso come

combinazione lineare dei vettori costituenti la base:

x = x[0] ε 0 +x[1] ε 1 + … +x[n] ε n +… +x[N-1] ε N-1

N −1

=

∑

n =0

x [ n ]ε n

SISTEMI LINEARI A TEMPO DISCRETO

In termini di segnali al vettore ε 0 corrisponde il segnale tempo

discreto, indicato nel seguito con u 0 [k], e noto in letteratura con il

termine di impulso a tempo discreto, che assume il valore 1 per k=0

e 0 altrove

1.5

1 per k = 0

u0 [k ] =

0 altrove

1

0.5

0

-3 -2 -1

0

1

2

3

Ogni altro elemento della base può essere ottenuto per traslazione

temporale di u 0 [k].

0.5

0

n+

1

n+

2

n+

3

u 0 [k-n]

1

n

corrispondente a ε n è pari a

1.5

n1

l'elemento

n3

esempio

n2

Ad

SISTEMI LINEARI A TEMPO DISCRETO

2

1.5

1

0.5

0

-0.5

-1

-1.5

-2

2

1.5

1

0.5

0

-0.5

-1

-1.5

-2

2

1.5

1

0.5

0

-0.5

-1

-1.5

-2

2

1.5

1

0.5

0

-0.5

-1

-1.5

-2

2

1.5

1

0.5

0

-0.5

-1

-1.5

-2

x[k] =

-1

0

1

2

3

4

x[0]u 0 [k] +

-1

0

1

2

3

4

+ x[1]u 0 [k-1] +

-1

0

1

2

3

4

+ x[2]u 0 [k-2] +

-1

0

1

2

3

4

+ x[3]u 0 [k-3]

-1

0

1

2

3

4

RISPOSTA IMPULSIVA

Dato un segnale a tempo discreto per esso vale la seguente

rappresentazione in termini di impulsi a tempo discreto

∞

x[ k ] =

∑ x [ n ]u 0 [ k − n ]

(1)

n = −∞

dato un sistema lineare e permanente a tempo discreto, sia h[k]

la risposta del sistema quando venga applicato in ingresso u 0 [k]:

S

u 0 [ k ] → h [ k ]

che prende il nome di risposta impulsiva.

Per l'invarianza nel tempo del sistema, la risposta all'impulso

u 0 [k-n] traslato in n, sarà pari a h[k] traslata della stessa

quantità, ovvero a h[k-n]:

S

u 0 [ k − n ] → h [ k − n ]

(2)

pertanto per la linearità del sistema, dalle (1) e (2) ne consegue

che l'uscita y[k] corrispondente all'ingresso x[k] varrà:

∞

y[k ] =

∑ x [ n ]h [ k − n ]

n = −∞

CONVOLUZIONE DISCRETA

L'operatore che lega l'uscita del sistema all'ingresso e alla risposta

impulsiva prende il nome di somma di convoluzione del sistema,

ovvero di convoluzione discreta e sarà indicato nel seguito con il

simbolo *

y [ k ] = x[ k ]∗ h[ k ]

∞

=

∑ x [ n ]h [ k − n ]

n = −∞

Si osservi che per calcolare la risposta di un sistema lineare e

permanente a tempo discreto ad una qualsiasi eccitazione, è

sufficiente conoscere un'unica funzione del tempo che può essere

misurata applicando in ingresso un impulso.

Ciò è essenzialmente dovuto al fatto che gli elementi della base

utilizzata per rappresentare il segnale possono essere ottenuti per

semplice traslazione di un segnale elementare.

IMPULSO MATEMATICO

L'estensione al tempo continuo delle relazioni ingresso-uscita

relative ai sistemi tempo discreto richiede come primo passo

l'individuazione dell'ente matematico corrispondente all'impulso a

tempo discreto.

Tale ente è l'impulso matematico o distribuzione di Dirac.

L'impulso matematico indicato nel seguito con u 0 (t) é

caratterizzato in modo esaustivo non da una regola di

assegnazione che determina i valori assunti dall'impulso in tutti i

punti dell'insieme di definizione, come per le funzioni ordinarie,

ma dai valori dei prodotti scalari < u 0 (t), f(t)> con tutte le funzioni

continue [Courant & Hilbert, Methods of Mathematical Physics,

Vol. II, pa. 774 e seguenti].

Def: per ogni funzione continua f(t) in un dato intervallo [a,b]

(limitato o illimitato), detto t 0 un istante arbitrario, si definisce

l'integrale esteso a [a,b] del prodotto della funzione f(t) per

l'impulso matematico u 0 (t- t 0 ), centrato in t0 , in modo tale che

esso risulti funzione continua di t0 in [a,b] e che per ogni t 0 risulti

f ( t o ) t 0 ∈[ a , b ]

f ( t ) u 0 ( t − t 0 ) dt =

t 0 ∉[ a , b ]

a

0

∫

b

IMPULSO MATEMATICO

Commento: A causa della risoluzione limitata degli strumenti, un

qualsivoglia procedimento di misura non consente di rilevare

direttamente il valore assunto da un segnale x(t) in un dato istante

(m)

t 0 ma piuttosto il valor medio del segnale x ∆t ( t 0 ) in un

intervallo di durata ∆t centrato attorno a t 0 , che, per il teorema

della media, è pari al valore che la funzione assume in punto

opportuno t' dell'intervallo di durata ∆t centrato attorno a t 0:

1 τ 0 + ∆τ / 2

(m)

x ∆τ ( τ 0 ) =

x ( τ ) dτ

∆τ τ 0 − ∆τ / 2

∫

∆τ

∆τ

τ ′ ∈ τ0 − , τ0 +

2

2

= x ( τ ′ ),

∫

τ 0 + ∆τ / 2

x ( τ ) dτ

τ 0 − ∆τ / 2

t0-∆t/2

t0

t0+∆t/2

IMPULSO MATEMATICO

Commento: Di conseguenza, dal punto di vista operativo il valore

assunto dal segnale in t 0 può essere visto come il limite a cui

tende il valor medio quando l'intervallo di osservazione diviene

infinitesimo:

(m)

x ( τ 0 ) = lim x ∆τ

∆τ →0

= lim

1

= lim

1

∫

∫

=

τ 0 + ∆τ / 2

x( τ)

∆τ →0 ∆τ τ − ∆τ / 2

0

dτ =

∞

x ( τ ) recτ ∆τ ( τ − τ 0 ) dτ =

∆τ →0 ∆τ − ∞

∞

∫

1

= lim x ( τ ) recτ ∆τ ( τ − τ 0 ) dτ

∆τ →0 − ∞ ∆τ

[ si noti che nelle precedenti espressioni le operazioni di limite e di

integrazione non possono essere scambiate].

∞ 1

∫− ∞ ∆t rect ∆t ( t ) dt = 1

IMPULSO MATEMATICO

Proprietà fondamentali:

i.

proprietà di campionamento

∞

∫− ∞ x ( τ ) u 0 ( τ − τ ) dτ

x(τ ) =

(è conseguenza diretta della definizione e della simmetria

dell'impulso matematico rispetto all'origine)

ii.

integrale dell'impulso

∞

∫− ∞ u 0 ( τ ) dτ = 1

(deriva dalla proprietà precedente ponendo x(t) =1)

iii. simmetria

u0 (t ) = u0 ( −t )

iv. cambiamento di scala

u 0 ( at ) =

v.

1

|a|

u 0 ( t ),

a≠0

moltiplicazione per l'impulso matematico

x (t )u 0 (t − t 0 ) = x (t 0 )u 0 (t − t 0 )

RISPOSTA IMPULSIVA

Dato un segnale a tempo continuo per esso vale la seguente

rappresentazione in termini di impulsi matematici

x(τ ) =

∞

∫− ∞ x ( τ ) u 0 ( τ − τ ) dτ

(1)

dato un sistema lineare e permanente a tempo discreto, sia h(t)

la risposta del sistema quando venga applicato in ingresso u 0 (k):

S

u 0 ( t ) → h ( t )

che prende il nome di risposta impulsiva.

Per l'invarianza nel tempo del sistema, la risposta all'impulso

u 0 (t-τ) traslato in τ, sarà pari a h(t) traslata della stessa quantità,

ovvero a h(t-τ):

S

u 0 ( τ − τ ) → h ( τ − τ )

(2)

pertanto per la linearità del sistema, dalle (1) e (2) ne consegue

che l'uscita y(t) corrispondente all'ingresso x(t) varrà:

y(τ ) =

∫

∞

x ( τ ) h ( τ − τ ) dτ

−∞

INTEGRALE DI CONVOLUZIONE

L'operatore che lega l'uscita del sistema all'ingresso e alla risposta

impulsiva prende il nome di integrale di convoluzione del

sistema, ovvero di convoluzione e sarà indicato nel seguito con il

simbolo *

y(τ ) = x(τ ) ∗ h(τ )

=

∫

∞

x ( τ ) h ( τ − τ ) dτ

−∞

Nel seguito si indicherà con il termine di filtro una rete due-porte

che operi una trasformazione lineare dei segnali di ingresso

un filtro viene detto idealmente realizzabile se la sua risposta

impulsiva è un segnale reale

un filtro viene detto causale (o fisicamente realizzabile) se è

idealmente realizzabile e se risulta:

h(t)=0 per t<0

CONVOLUZIONE: PROPRIETÀ

commutatività

x(t ) * h(t ) = h(t ) * x(t )

x(t)

=

h(t)

h(t)

x(t)

Prova: dalla definizione, effettuando il cambiameno di variabile x=tτ si ha:

x(t ) ∗ h(t ) =

∫

∫

∞

x ( t ) h ( t − t ) dt = −

−∞

∞

=

x ( t − x ) h ( x ) dx

−∞

= h(t ) ∗ x(t )

c.d.d.

∫

−∞

x ( t − x ) h ( x ) dx =

∞

CONVOLUZIONE: PROPRIETÀ

associatività

[x ( t ) ∗ z ( t )]∗ h ( t ) = x ( t ) ∗ [z ( t ) ∗ h ( t )]

x(t)

x(t)

z(t)

h(t)

=

z(t)*h(t)

Prova: dalla definizione, si ha:

∞

∞

x ( x ) z ( t − x ) dx h ( t − t ) dt

[x (t ) ∗ z (t )]∗ h(t ) =

− ∞ − ∞

∫ ∫

∫ ∫

[

∫

∞

∞

h [( t − x ) − ( t − x )] z ( t − x ) dt x ( x ) dx

=

− ∞ − ∞

∞

=

z ( t − x ) ∗ h ( t − x ) ] x ( x ) dx

−∞

= x (t ) ∗ [z (t ) ∗ h (t )]

c.d.d.

CONVOLUZIONE: PROPRIETÀ

distributività rispetto alla somma

x ( t ) [h1 ( t ) + h 2 ( t ) ] = x ( t ) ∗ h1 ( t ) + x ( t ) ∗ h 2 ( t )

h1(t)

x(t)

x(t)

+

h1(t)+h2(t)

=

h2(t)

Prova: dalla definizione, si ha:

x ( t ) [h1 ( t ) + h 2 ( t ) ] =

=

∫

∫

∞

x ( t − t ) [h1 ( t ) + h 2 ( t ) ] dt

−∞

∞

x ( t − t ) h1 ( t ) dt +

−∞

∫

∞

x ( t − t ) h 2 ( t ) dt

−∞

= x ( t ) ∗ h1 ( t ) + x ( t ) ∗ h 2 ( t )

c.d.d.

CONVOLUZIONE: PROPRIETÀ

1. x(t ) ∗ u0 (t ) = x(t )

2. x(t ) ∗ u0 (t − t0 ) = x(t − t0 )

3. posto

z (t ) = x(t ) ∗ y (t )

si ha

x(t − ta ) ∗ y (t − tb ) = z[t − (ta + tb )]

Infatti:

x(t − ta ) ∗ y (t − tb ) = [ x(t ) ∗ u0 (t − ta )] ∗ [ y (t ) ∗ u0 (t − tb )]

= [ x(t ) ∗ y (t )] ∗ [u0 (t − ta ) ∗ u0 (t − tb )]

= [ x(t ) ∗ y (t )] ∗ u0 [t − (ta + tb )]

STABILITÀ

Def.:Un filtro si dice stabile se il segnale di uscita risulta limitato

ovunque quando in ingresso è applicato un segnale limitato ovunque.

Teorema: Condizione necessaria e sufficiente affinché un filtro sia

stabile è che la sua risposta impulsiva sia assolutamente integrabile:

∫

∞

h ( τ ) dτ < ∞

−∞

Prova: Per dimostrare la sufficienza, si osservi che, poiché per un

ingresso x(t) limitato ovunque, per definizione, si ha che |x(t)|<M, se

la risposta impulsiva è assolutamente integrabile per l'integrale della

risposta impulsiva vale la seguente maggiorazione

∞

| y ( τ ) |=

∫

∫

x ( τ ) h ( τ − τ ) dτ ≤

−∞

≤

∫

∞

x ( τ ) h ( τ − τ ) dτ

−∞

∞

x ( τ ) h ( τ − τ ) dτ ≤ M

−∞

∫

∞

h ( τ − τ ) dτ < ∞

−∞

Per dimostrare la necessità si osservi che se il filtro è stabile, l'uscita

in t=0 deve essere limitata ovunque, ovvero

|y(t)|<N comunque si

scelga un ingresso x(t) limitato ovunque. Tale condizione deve quindi

essere valida anche per l'ingresso x(t)=- sign[h(-t)] e quindi:

y (0) =

∫

∞

− sign {h [ − ( 0 − τ )]}h ( τ ) dτ =

−∞

∫

∞

| h ( τ ) | dτ < N .

−∞

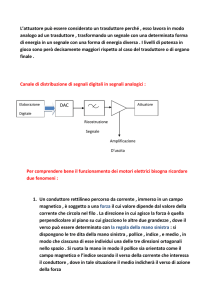

CONVOLUZIONE: INTERPRETAZIONE GRAFICA

τ

h( )

1

τ

x( )

0.5

τ

0

-6

-4

0

-2

τ

h (- )

2

4

6

1

τ

x( )

0.5

ribalta h(τ)

τ

0

-6

-4

-2

0

2

4

6

τ

h (t - )

1

trasla

τ

x( )

0.5

l'origine in t

τ

τ

x ( )h (t - )

0

-6

-4

-2

0

t

2

4

τ

6

PRODOTTO SCALARE

Def.:Un'applicazione da X°X su S é un prodotto scalare e si indica

con <x,y> se verifica le seguenti condizioni:

i.

è distributiva rispetto al primo elemento

<x+z, y> = <x, y> + <z, y>

ii.

è omogenea rispetto al primo elemento, cioè per ogni scalare λ

si ha

< λ x, y> = λ <x, y>

iii. è hermitiana

< x, y> = [<y, x>]*

dove con * si intende il complesso coniugato

iv. è strettamente positiva:

< x, x > ≥ 0,

con < x, x > = 0 se e solo se x=0.

Proprietà: Diseguaglianza di SCHWARZ

|< x, y>|2 ≤ < x, x> < y, y>

NORMA

Def.:Un'applicazione da X°X su R é una norma e si indica con ||x||

se verifica le seguenti condizioni:

i.

è strettamente positiva

||x|| ≥ 0, con ||x||=0 se e solo se x=0.

ii.

è assolutamente omogenea, cioè per ogni scalare λ si ha

||λ x|| = |λ| ||x||

iii. è subadditiva

|| x + y || = ≤ ||x|| + ||y||

Proprietà:

norma hilbertiana

|| x|| = [< x, x>]1/2

distanza tra elementi di uno spazio metrico

d(x, y) = || x- y ||

SPAZI DI HILBERT

Uno spazio vettoriale X è uno spazio di Hilbert se

i.

è dotato di prodotto scalare <x,y>

ii.

è normato mediante la norma hilbertiana

|| x|| = [< x, x>]1/2

iii. è completo, ossia ogni successione principale è convergente

(ovvero la condizione di CAUCHY è necessaria e sufficiente

per la convergenza di una successione).

SEGNALI DI ENERGIA

Def.: Dato un segnale x(t), si definisce energia totale Ex del

segnale la seguente grandezza reale (se esiste)

Ex = lim

∆T →∞

∆T / 2

∫−∆T / 2 x ( t ) x * ( t ) dt

Significato fisico: se x(t) è reale E x coincide con l'energia totale

dissipata da un resistore da 1Ω quando ai suoi capi si applica la

tensione x(t) [Volt] oppure quando esso è attraversato da una

corrente x(t) [Ampère]

Un segnale si dice di energia se la sua energia totale E x è finita ed

inoltre Ex > 0.

SEGNALI DI ENERGIA

Esercizio: Si calcoli l’energia del segnale

x(t)=A rect∆ (t)

A

essendo

rect ∆

1

(t ) =

0

per

−

∆

∆

≤t≤

2

2

altrove

- ∆/2

∆/2

In base alla definizione si ottiene direttamente

Ex = lim

∆T → ∞

∫

∆T / 2

A 2 rect ∆ ( t ) dt = A 2 ∆ .

− ∆T / 2

t

SEGNALI DI ENERGIA

L'insieme dei segnali di energia costituisce uno spazio vettoriale.

A tale scopo è sufficiente verificare che se x(t) e y(t) sono segnali

di energia, la loro somma è un segnale di energia.

lim

∆T → ∞

∫

∆T / 2

x ( t ) + y ( t ) 2 dt ≤ 2 lim

∆T → ∞

− ∆T / 2

∫

2 lim

∆T → ∞

∫

∆T / 2

x ( t ) 2 dt +

− ∆T / 2

∆T / 2

y ( t ) 2 dt < ∞

− ∆T / 2

si ricorda che

0 ≤ ( a − b )2 = a

2

+ b

e quindi

i.

2 ab ≤ a

ii.

a+b

2

2

+ b

≤ 2a

2

2

+2b

2

2

− 2 ab

SEGNALI DI POTENZA

Def.: Dato un segnale x(t), si definisce potenza totale Px del

segnale la seguente grandezza reale (se esiste)

Px = lim

∆T →∞

1

∆T

∆T / 2

∫−∆T / 2 x ( t ) x * ( t ) dt

Significato fisico: se x(t) è reale coincide con la potenza totale

dissipata da un resistore da 1Ω quando ai suoi capi si applica la

tensione x(t) [Volt], oppure quando esso è attraversato da una

corrente x(t) [Ampère]

Un segnale si dice di potenza se la sua energia totale E x è infinita

ed inoltre la sua potenza totale Px è finita e P x > 0.

SEGNALI DI POTENZA

Esercizio: Si calcoli la potenza del segnale

A

x(t)=A

t

In base alla definizione si ottiene

Px =

lim 1

∆T → ∞ ∆T

2

= A .

∫

∆T / 2

− ∆T / 2

2

A dt = lim

1

∆T → ∞ ∆T

2

A ∆T

SEGNALI DI POTENZA

Esercizio: Si calcoli la potenza del segnale

x(t)=Acos(2πf 0 t+ϕ)

A

0

-2T

-T

0

T

2T

3T

-A

Px = lim

1

∆

∆T → ∞ T

∫

∫

∆T / 2

A cos(2πf 0t + ϕ ) dt

− ∆T / 2

∆T / 2

= lim

1

∆

∆T → ∞ T

A

=

2

2

2

− ∆T / 2

2

A

dt + lim ∆1T

∆T → ∞

2

∫

∆T / 2

− ∆T / 2

2

A

cos(4πf 0t + 2ϕ )dt

2

SEGNALI DI POTENZA

L'insieme dei segnali di potenza costituisce uno spazio vettoriale.

A tale scopo è sufficiente verificare che se x(t) e y(t) sono segnali

di potenza, la loro somma è un segnale di potenza.

lim

1

∆T → ∞

∫

∆T / 2

x(t ) + y(t )

2

∆T − ∆T / 2

1

2 lim

∫

dt ≤ 2 lim

1

∆T → ∞

∆T / 2

y ( t ) 2 dt < ∞

si ricorda che

0 ≤ ( a − b )2 = a

2

+ b

e quindi

iii.

2 ab ≤ a

iv.

a+b

2

2

+ b

≤ 2a

2

2

+2b

2

2

x ( t ) 2 dt +

∆T − ∆T / 2

∆T − ∆T / 2

∆T → ∞

∫

∆T / 2

− 2 ab

PRODOTTO SCALARE PER SEGNALI DI

ENERGIA

Nello spazio vettoriale dei segnali di energia può definirsi il seguente

prodotto scalare

∆T / 2

∫ x ( t ) y * ( t ) dt

< x ( t ), y ( t ) > = lim

∆T → ∞

− ∆T / 2

tale integrale ha valore finito poichè

lim

∆T → ∞

∫

∆T / 2

x ( t ) y * ( t ) dt ≤

− ∆T / 2

1

lim

∆T → ∞

∫

lim

∆T → ∞

1

∫

∆T / 2

y ( t ) 2 dt < ∞

2 − ∆T / 2

è distributivo rispetto al primo elemento

< x ( t ) + z ( t ), y ( t ) > = lim

∆T → ∞

lim

∆T → ∞

∆T / 2

∫ x ( t ) y * ( t ) dt +

− ∆T / 2

∆T / 2

∫ z ( t ) y * ( t ) dt

− ∆T / 2

x ( t ) 2 dt +

2 − ∆T / 2

inoltre

i.

∆T / 2

PRODOTTO SCALARE PER SEGNALI DI

ENERGIA (CONT.)

ii.

è omogeneo rispetto al primo elemento, cioè ∀ scalare λ si ha

∆T / 2

λim

∆T → ∞

∫ λ x ( t ) y * ( t ) dt =λ

− ∆T / 2

∆T / 2

∫ x ( t ) y * ( t ) dt

λim

∆T → ∞

− ∆T / 2

iii. è hermitiano

lim

∆T →∞

∆T / 2

x ( t ) y * ( t ) dt

− ∆T / 2

∫

*

∆T / 2

= = lim

∆T →∞

∫ [ x ( t ) y * ( t )] * dt

− ∆T / 2

= lim

∆T →∞

∆T / 2

∫ y ( t ) x * ( t ) dt

− ∆T / 2

iv. è strettamente positivo: infatti per definizione di segnale di

energia si ha

< x(t), x(t) > = Ex >0

per ogni segnale di energia (non identicamente nullo).

Proprietà: Diseguaglianza di SCHWARZ

∆T / 2

lim

∆T → ∞

∫ x ( t ) y * ( t ) dt

− ∆T / 2

2

≤ Ex Ey

PRODOTTO SCALARE PER SEGNALI DI

POTENZA

Nello spazio vettoriale dei segnali di potenza può definirsi il

seguente prodotto scalare

1

< x ( t ), y ( t ) > = lim

∆T

∆T →∞

∫

∆T / 2

x ( t ) y * ( t ) dt

− ∆T / 2

tale integrale ha valore finito poiché

lim

∆T → ∞

1

∫

∆T / 2

x ( t ) y * ( t ) dt ≤

lim

∆T − ∆T / 2

lim

∆T → ∞

1 1

∫

∆T → ∞

1 1

∫

∆T / 2

2 ∆T − ∆T / 2

∆T / 2

y ( t ) 2 dt < ∞

2 ∆T − ∆T / 2

inoltre

v.

è distributivo rispetto al primo elemento

1

< x ( t ) + z ( t ), y ( t ) > = lim

∆T

∆T →∞

lim

∆T →∞

1

∆T

∫

∫

∆T / 2

x ( t ) y * ( t ) dt +

− ∆T / 2

∆T / 2

z ( t ) y * ( t ) dt

− ∆T / 2

x ( t ) 2 dt +

PRODOTTO SCALARE PER SEGNALI DI

POTENZA (CONT.)

vi. è omogeneo rispetto al primo elemento, cioè ∀ scalare λ si ha

λim

∫

1

∆T →∞

∆T

∆T / 2

1

λ x ( t ) y * ( t ) dt =λ λim

∆T

∆T →∞

− ∆T / 2

∫

∆T / 2

x ( t ) y * ( t ) dt

− ∆T / 2

vii. è hermitiano

lim

∆T →∞

1

∆T

*

∆T / 2

x ( t ) y * ( t ) dt = = lim

∆T →∞

− ∆T / 2

∫

1

∆T

1

= lim

∆T

∆T →∞

∫

∫

∆T / 2

[ x ( t ) y * ( t )] * dt

− ∆T / 2

∆T / 2

y ( t ) x * ( t ) dt

− ∆T / 2

viii. è strettamente positivo: infatti per definizione di segnale di

potenza si ha

< x(t), x(t) > = Px >0

per ogni segnale di potenza (non identicamente nullo).

Proprietà: Diseguaglianza di SCHWARZ

lim

1

∆T →∞ ∆T

∫

∆T / 2

x ( t ) y * ( t ) dt

− ∆T / 2

2

≤ Px P y

ORTOGONALITÀ

Def.: due elementi di uno spazio vettoriale si dicono ortogonali se

il loro prodotto scalare è nullo:

<x, y> = 0

Def.: Una base {e 1 , e 2,…, e N }.si dice ortogonale se gli elementi

che la costituiscono sono mutuamente ortogonali:

Def.: si dice inoltre che {e 1, e 2,…, eN } costituisce un sistema

ortonormale se

1 h = k

< e h , e k >= δ h , k =

0 h ≠ k

Proprietà: data una base ortogonale {e 1 , e 2,…, e N } i coefficienti

c k dello sviluppo di x sono dati dai coefficienti di Fourier

generalizzati:

ck =

< x, ek >

< ek , ek >

.

Dim.: Si osservi che moltiplicando scalarmente x per ek , per

l'ortogonalità si ha:

< x , e k >=<

∑ch eh , ek > = ∑ch < eh , ek >

h

= ck < ek , ek > .

h

INTERCORRELAZIONE

Def.1: dati due segnali x(t) e y(t), di cui almeno uno impulsivo,

prende il nome di integrale di intercorrelazione tra essi la

seguente espressione:

e xy ( τ ) = lim

∆T → ∞

∫

∆T / 2

x * ( τ ) y ( τ + τ ) dτ

− ∆T / 2

Si noti che per questa classe di segnali vale la seguente

relazione tra intercorrelazione e convoluzione

e xy ( t ) = x * ( − t ) * y ( t ) .

Def.2: dati due segnali x(t) e y(t) di potenza, prende il nome di

integrale di intercorrelazione tra essi la seguente espressione:

p xy ( τ ) = lim

∆T → ∞

1

∫

∆T / 2

x * ( τ ) y ( τ + τ ) dτ

∆T − ∆T / 2

CORRELAZIONE

per x(t)=y(t) la funzione di correlazione prende il nome di

AUTOCORRELAZIONE

Autocorrelazione per segnali di energia

e x (τ ) =

lim

∆T → ∞

∫

∆T / 2

x * ( τ ) x ( τ + τ ) dτ

− ∆T / 2

Autocorrelazione per segnali di potenza

p x (τ ) =

lim

∆T → ∞

1

∫

∆T / 2

x * ( τ ) x ( τ + τ ) dτ

∆T − ∆T / 2

PROPRIETÀ DELLA CORRELAZIONE

Valgono le seguenti proprietà

Segnali di energia

e xy ( τ ) = lim

∆T → ∞

∫

Segnali di potenza

∆T / 2

x * ( τ ) y ( τ + τ ) dτ p xy ( τ ) = lim

− ∆T / 2

∆T → ∞

1

∫

∆T / 2

x * ( τ ) y ( τ + τ ) dτ

∆T − ∆T / 2

e xy ( τ ) =< y ( τ + τ ), x ( τ ) >

p xy ( τ ) =< y ( τ + τ ), x ( τ ) >

e xx ( 0 ) = Ex

p xx ( 0 ) = P x

e yx (t ) = e ∗xy (−t )

p yx (t ) = p ∗xy (−t )

| e xy ( t ) | 2 ≤ Ex Ey

| p xy ( t ) | 2 ≤ P x P y

| e xx ( t ) |≤ Ex

| p xx ( t ) |≤ P x

TRASFORMAZIONI LINEARI ED INTERCORRELAZIONE

x1 ( t )

x2 (t )

h1 ( t )

h2 ( t )

y1 ( t )

y2 (t )

Teorema: Dati due filtri stabili con risposte impulsive h 1 (t) e h 2 (t) a

cui vengano applicati in ingresso due segnali di energia x1 (t) e x 2 (t),

sussiste la seguente relazione tra le funzioni di correlazione:

e y1 y 2 ( t ) = e x1 x 2 ( t ) ∗ e h1 h2 ( t )

Corollario: Dati due filtri stabili con risposte impulsive h1 (t) e h 2 (t)

a cui vengano applicati in ingresso due segnali di energia x 1 (t) e

x 2 (t), sussistono le seguenti relazioni tra le funzioni di correlazione:

e y1 y1 ( t ) = e x1 x1 ( t ) ∗ e h1 h1 ( t )

e y 2 y 2 ( t ) = e x 2 x 2 ( t ) ∗ e h2 h2 ( t )

e x 1 y 1 ( t ) = e x 1 x 1 ( t ) ∗ h1 ( t )

e x1 y 2 ( t ) = e x1 x 2 ( t ) ∗ h 2 ( t )

e x2 y2 ( t ) = e x2 x2 ( t ) ∗ h2 ( t )

e x 2 y 1 ( t ) = e x 1 x 2 ( t ) ∗ h1 ( t )

TRASFORMAZIONI LINEARI ED INTERCORRELAZIONE

Prova: Poiché y1 (t) e y 2 (t) sono due segnali di energia, per la loro

funzione di intercorrelazione si ha

e y1 y 2 ( t ) = y 1∗ ( − t ) ∗ y 2 ( t )

e quindi considerando che y 1 (t) e y 2 (t) sono dati dalle convoluzioni tra

x 1 (t) e x 2 (t) e le rispettive risposte impulsive, si ottiene

[

]

= [x 1∗ ( − t ) ∗ x 2 ( t ) ]∗ [h1∗ ( − t ) ∗ h 2 ( t ) ]

e y1 y 2 ( t ) = x 1∗ ( − t ) ∗ h1∗ ( − t ) ∗ [ x 2 ( t ) ∗ h 2 ( t ) ]

= e x1 x 2 ( t ) ∗ e h1 h2 ( t )

c.d.d.

Per le funzioni di intercorrelazione ingresso-uscita analogamente si

ha

e x1 y 2 ( t ) = x 1∗ ( − t ) ∗ y 2 ( t )

= x 1∗ ( − t ) ∗ [ x 2 ( t ) ∗ h 2 ( t ) ]

[

]

= x 1∗ ( − t ) ∗ x 2 ( t ) ∗ h 2 ( t )

= e x1 x 2 ( t ) ∗ h 2 ( t )

Dalla precedente, ponendo x 1 (t)=x 2 (t) e h 1 (t)=h 2 (t) si ottengono i casi

particolari relativi ad un solo filtro.

TRASFORMAZIONI LINEARI ED INTERCORRELAZIONE

x1 ( t )

x2 (t )

h1 ( t )

h2 ( t )

y1 ( t )

y2 (t )

Teorema: Dati due filtri stabili con risposte impulsive h 1 (t) e h 2 (t) a

cui vengano applicati in ingresso due segnali di potenza x1 (t) e

x 2 (t), sussiste la seguente relazione tra le funzioni di correlazione:

p y1 y 2 ( t ) = p x1 x 2 ( t ) ∗ e h1 h2 ( t )

Corollario: Dati due filtri stabili con risposte impulsive h1 (t) e h 2 (t)

a cui vengano applicati in ingresso due segnali di potenza x1 (t) e

x 2 (t), sussistono le seguenti relazioni tra le funzioni di correlazione:

p y1 y1 ( t ) = p x1 x1 ( t ) ∗ e h1 h1 ( t )

p y 2 y 2 ( t ) = p x 2 x 2 ( t ) ∗ e h2 h2 ( t )

p x 1 y 1 ( t ) = p x 1 x 1 ( t ) ∗ h1 ( t )

p x 1 y 2 ( t ) = p x1 x 2 ( t ) ∗ h 2 ( t )

p x2 y2 ( t ) = p x2 x2 ( t ) ∗ h2 ( t )

p x 2 y1 ( t ) = p x1 x 2 ( t ) ∗ h1 ( t )

TRASFORMAZIONI LINEARI ED INTERCORRELAZIONE

Prova: Poiché y 1 (t) e y 2 (t) sono due segnali di potenza, considerato

che essi dati dalle convoluzioni tra x 1 (t) e x 2(t) e le rispettive risposte

impulsive, per la loro funzione di intercorrelazione si ha

p y1 y 2 ( τ ) =

=

1

lim

∆T → ∞

∆T

∆T / 2

y 1∗ ( τ ) y 2 ( τ + τ ) dτ

− ∆T / 2

∫

∆T / 2

λim

∆T → ∞

∞

1

x 1 ( τ − λ )h1 ( λ ) dλ

∆T − ∆T / 2 − ∞

∫ ∫

∫

∗

∞

x 2 ( τ + τ − θ )h 2 ( θ ) dθ dτ

− ∞

Scambiando l'ordine di integrazione e l'operazione di limite con

l'operazione di integrazione rispetto a θ si ha

p x1 y2 (τ ) = ∫

∞

∫

+∞

−∞ −∞

∆Tλim

→∞

quindi

1

∆T

poiché

h1∗ (λ )h2 (θ )

∗

x

(

τ

λ

)

x

(

τ

τ

θ

)

d

τ

−

+

−

2

∫−∆T / 2 1

dλdθ

∆T / 2

il

termine

tra

parentesi

all'intercorrelazione tra gli ingressi segue che

quadre

è

pari

TRASFORMAZIONI LINEARI ED INTERCORRELAZIONE

∞

p x1 y 2 ( t ) =

∫ ∫

∞

h1∗ ( λ ) h 2 ( θ ) p x1 x 2 [ t − ( θ − λ )] dλ dθ

−∞ −∞

effettuando il cambiamento di variabile

µ=θ

,

ν

=

θ

−

λ

ϑ=µ

λ = µ + ν

poiché per il determinante jacobiano della trasformazione si ha:

∂θ

∂λ

∂µ

∂θ

1 1

∂µ

=

=1

∂λ

0 1

∂ν

∂ν

per la funzione di intercorrelazione si ottiene

∞

∫ ∫

∞

h1∗ ( µ + ν ) h 2 ( µ ) dµ p x x ( t − ν ) dν

p y1 y 2 ( t ) =

1 2

− ∞ − ∞

=

∫

∞

e h1 h2 ( ν ) p x1 x 2 ( t − ν ) dν =

−∞

= p x1 x 2 ( t ) ∗ e h1 h2 ( t )

c.d.d.

TRASFORMAZIONI LINEARI ED INTERCORRELAZIONE

h1′ ( t )

x1 ( t )

x2 (t )

h1 ( t )

y1′ ( t )

y1 ( t )

y2 (t )

h2 ( t )

Per il calcolo della funzione di intercorrelazione tra ingressi ed uscite

si osservi che con riferimento allo schema di figura, posto

h1′ ( t ) = u 0 ( t ) si ha

y 1′ ( t ) = x 1 ( t ) ,

e h1′ h 2 ( t ) = u 0∗ ( − t ) ∗ h 2 ( t ) = u 0 ( t ) ∗ h 2 ( t ) = h 2 ( t )

e quindi dalla precedente relazione si ha:

p x1 y 2 ( t ) ≡ p y 1′ y 2 ( t ) = p x1 x 2 ( t ) ∗ e h1′ h 2 ( t )

= p x1 x 2 ( t ) ∗ h 2 ( t )

Dalle precedenti relazioni, ponendo x 1 (t)=x 2 (t) e h 1 (t)=h 2 (t) si

ottengono, poi, i casi particolari relativi ad un solo filtro.

c.d.d.

SEGNALI PERIODICI

Def.: Dato un segnale x(t), esso si dice periodico di periodo T

se, per ogni istante t risulta

x(t + T ) = x(t )

La forma d’onda di un segnale periodico risulta completamente

definita se l’andamento di x(t) è noto in un qualsiasi intervallo di

durata T. Nel seguito si assumerà che tale intervallo sia pari a

[− T / 2, T / 2).

L’inverso di T (F=1/T) si dice frequenza fondamentale e

rappresenta il numero di periodi contenuti nell’unità di tempo.

x (t )

-T

-2,0

-T/2

0

0

T/2

T

t

SVILUPPO IN SERIE DI FOURIER PER

SEGNALI PERIODICI

Teorema di Fourier.: Dato un segnale x(t) periodico di periodo

T che risulti

i.

generalmente continuo in [− T / 2, T / 2 )

ii.

assolutamente integrabile in [− T / 2, T / 2 ),

∫

T /2

x ( τ ) dτ < +∞

−T / 2

esso può essere rappresentato come segue

+∞

∑

x(t ) =

x n e j 2 πf n t

n = −∞

con

fn = nF =

n

T

e dove i valori

xn =

1

∫

T /2

x ( t )e − j 2 πf n t dt < +∞

T −T / 2

prendono il nome di Coefficienti di Fourier del segnale x(t).

SVILUPPO IN SERIE DI FOURIER PER

SEGNALI PERIODICI (CONT.)

L’uguaglianza

+∞

x(t ) =

∑

x n e j 2 πf n t

n = −∞

va intesa come segue:

i.

in tutti i punti in cui la funzione è continua il primo e il

secondo membro coincidono

ii.

nei punti di discontinuità di prima specie la serie a secondo

membro converge alla semisomma dei limiti da destra e da

sinistra di x(t)

1

lim x ( t ) + lim x ( t )

2 t → t 0−

t → t 0+

SVILUPPO IN SERIE DI FOURIER PER

SEGNALI PERIODICI (CONT.)

Commento:

fondamentalmente il teorema afferma che la famiglia di

funzioni

s n ( t ) = e j πf n t

n = 0 , ±1, ± ,

costituisce una base per i segnali periodici di periodo T. Tale

base risulta ortonormale, cioè

m=n

m≠n

1

< sm (t ), sn (t ) >=

0

Prova: Si osservi che, dati due segnali di potenza x(t) e y(t)

*

periodici di periodo T il loro prodotto x(t)y(t) è periodico di

periodo T e il loro prodotto scalare si può calcolare come segue

< x ( t ), y ( t ) >= lim

1

∫

∆t / 2

x ( t ) y * ( t ) dt =

∆t → ∞ ∆t − ∆t / 2

NT / 2

1

*

T /2

1

*

x ( t ) y ( t ) dt = lim

N x ( t ) y ( t ) dt

= lim

N → ∞ NT − NT / 2

N → ∞ NT

−T / 2

∫

=

1

∫

T /2

x ( t ) y * ( t ) dt

T −T / 2

∫

SVILUPPO IN SERIE DI FOURIER PER

SEGNALI PERIODICI (CONT.)

Pertanto, per due elementi e j 2 πf n t , e j 2 πf m t della base si ha

<e

j 2 πf n t

,e

j 2 πf m t

=

1

>=

∫

1

∫

T /2

j 2 πf n t − j 2 πf m t

e

T −T / 2

T /2

j

2π

e T

e

dt

( n −m ) t

dt

T −T / 2

1 T /2

dt = 1

n=m

T −T / 2

T /2

2π

= j ( n −m ) t

sin ( n − m ) π

e T

=

=0 n≠m

j 2 π( n − m )

(n − m)π

−T / 2

∫

C.D.D.

SERIE DI FOURIER PER SEGNALI PERIODICI

Proprietà fondamentali:

i.

linearità

Ax ( t ) + B y ( t )

ii.

⇔

A X n + BY n

traslazione nel tempo

x(τ − τ)

⇔

X n e − j 2 π Fn τ

iii. traslazione in frequenza

x ( t )e j 2 π Fk t

iv.

X n −k

differenziazione

d

dt

v.

⇔

⇔

x(t )

j 2 πF n X n

integrazione

dato un segnale periodico x(t) è a valor medio nullo, ovvero tale

che

1

∫

T /2

x ( t ) dt = 0

T −T / 2

si ha:

t

∫

−∞

x ( t ) dt

⇔

1

j 2 πF n

X n.

SERIE DI FOURIER PER SEGNALI PERIODICI

Proprietà fondamentali (segue):

i.

Intercorrelazione

∆t / 2

p xy ( t ) = lim

1

∆t → ∞ ∆t

∫

x * ( t ) y ( t + t ) dt

⇔

P xy

= X n* Y n

n

− ∆t / 2

Prova: Dati due segnali periodici x(t) e y(t), l’intercorrelazione è

ancora un segnale periodico ed è pari a

+ ∆τ / 2

π xy ( τ ) = lim

1

∆τ → ∞ ∆τ

∫

x * ( τ ) y ( τ + τ ) dτ

− ∆τ / 2

+ ∆τ / 2

+∞

1

* − j 2 π Fn τ

= lim

X

e

n

∆τ → ∞ ∆τ

− ∆τ / 2 n = −∞

∫ ∑

+∞

=

X n* Y m e j 2 πmF τ

n = −∞ m = −∞

+∞

=

∑

X n* Y n e j 2 πnF τ

n = −∞

c.d.d.

∑

+ ∆τ / 2

+∞

∑∑

+ ∞

j 2 π Fm ( τ + τ )

Y

e

m

m = −∞

lim

1

∆τ → ∞ ∆τ

∫

e j 2 π F ( m − n ) τ dτ

− ∆τ / 2

dτ

TEOREMA DI PARSEVAL PER SEGNALI

PERIODICI.

Teorema di Parseval per segnali periodici. Dato un segnale

periodico di potenza x(t), ed indicati con X n i coefficienti della

serie di Fourier relativa, la sua potenza P x è pari a:

+∞

Px =

∑

Xn 2

n = −∞

Prova:

Poiché

la

potenza

è

pari

alla

funzione

autocorrelazione del segnale calcolata nell'origine si ha

+∞

P x = π xx ( 0 ) =

∑

n = −∞

+∞

X n 2 e j 2 π nF 0 =

∑

n = −∞

Xn 2

di

SVILUPPO IN SERIE DI FOURIER PER

SEGNALI PERIODICI (CONT.)

Esempio 1

A

Serie di Fourier del segnale x(t)=A

che risulta periodico di periodo T

t

qualunque sia T.

xn =

1

T

∫

n

− j2π t

1

T dt =

x(t )e

T /2

T

−T / 2

j2πnt

e

T

=

n

j2π

T

∫

T /2

n

− j2π t

T dt

Ae

−T / 2

T /2

−T / 2

e − jπn − e + jπn

= A −

j 2 πn

= A sin ( πn )

πn

A n = 0

=

0 n ≠ 0

Il segnale pari a costante possiede quindi un solo coefficiente

dello

sviluppo

x 0 =A,

come

d’altronde

era

confrontando il segnale stesso con lo sviluppo in serie.

evidente

SVILUPPO IN SERIE DI FOURIER PER

SEGNALI PERIODICI (CONT.)

Esempio 2

A

0

-2T

-T

0

T

2T

3T

-A

Serie di Fourier del segnale x(t)=A cos(2πf 0 t+j)

che risulta periodico di periodo T =1/ f 0 .

xn =

1

T ∫−T / 2

T /2

n

− j 2π t

T dt

x(t )e

2π

j

1 T / 2 A jj T t

e e

= ∫

T

/

2

−

T

2

A jj 1 T / 2

e

e

∫

T

/

2

−

T

2

=

+

j

A − jj 1

e

e

∫

T

/

2

−

T

2

T /2

n

− j 2π t

T dt

e

1

Acos(2πf 0 t + j )

∫

T

/

2

−

T

n

2π

− j t − j 2π t

T dt

+ e − jj e T e

=

T /2

n

2π

t − j 2π t

T e

T dt

−j

n

2π

t − j 2π t

T e

T dt

Per l’ortonormalità della famiglia di funzioni, il primo integrale

risulta diverso da zero (e pari a 1) solo per n=1, e il secondo

integrale è diverso da zero solo per n= -1. Di conseguenza si ha

A ϕϕ

2e

A − ϕϕ

xn = e

2

0

n =1

n = −1

n ≠ 1, −1

SVILUPPO IN SERIE DI FOURIER PER

SEGNALI PERIODICI (CONT.)

Esempio 3

Serie di Fourier del treno di impulsi

x(t)=Π T(t)=Σ k u0 (t-kT)

che risulta periodico di periodo T =1/ f 0 .

n

n

+∞

− j2π t

− j2π t

1 T /2

T dt =

T dt

u 0 ( t − kT )e

Xn =

x(t )e

T −T / 2

T −T / 2

k = −∞

n

T

/

2

j

t

2

−

π

1

1

T

u 0 ( t )e

dt =

=

T −T / 2

T

1 T /2

∫

∫

∫

I cofficienti di Fourier sono costanti.

∑

SVILUPPO IN SERIE DI FOURIER PER

SEGNALI PERIODICI (CONT.)

Esempio 5

Serie di Fourier del treno di impulsi rettangolari

x(t)=Σ k rect ∆ (t-kT)

che risulta periodico di periodo T =1/ f 0 .

Si ricorre alla proprietà della derivazione.

y(t ) =

d

dt

x(t ) =

+∞

+∞

k = −∞

k = −∞

n∆

∑ u 0 ( t − kT + ∆ / 2 ) − ∑ u 0 ( t − kT − ∆ / 2 )

n

1

Yn = j2π X n = e

T

T

j2π

n∆

T 2 −

1 − j2π

T 2

e

T

da cui segue:

Xn

n

1/∆

n/T

n

sin π ∆

∆

T

Xn =

n

T

π ∆

T

SVILUPPO IN SERIE DI FOURIER PER

SEGNALI PERIODICI (CONT.)

Esempio 5 (cont.)

I Approssimazione:

x 1 (t )

x (t )

t

II Approssimazione:

x 2 (t )

x (t )

t

SVILUPPO IN SERIE DI FOURIER PER

SEGNALI PERIODICI (CONT.)

Esempio 5 (cont.)

III Approssimazione:

x 3 (t )

x (t )

t

IV Approssimazione:

x 4 (t )

x (t )

t

SVILUPPO IN SERIE DI FOURIER PER

SEGNALI PERIODICI (CONT.)

Esempio 4

Autocorrelazione del treno di impulsi

x(t)= Π T(t)=Σk u 0 (t-kT)

L’autocorrelazione del treno di impulsi è un segnale periodico di

periodo T =1/ f 0 . I coefficienti dello sviluppo in serie di Fourier

sono pari al modulo quadrato dei coefficienti del treno di

impulsi (proprietà dell’intercorrelazione).

Pxx n = X n

2

=

1

T2

I cofficienti di Fourier sono costanti, e la serie converge ad un

treno di impulsi di area 1/T.

π xx (τ ) =

+∞

+∞

2 j 2π k τ

1

1

T =

u0 (τ − kT )

e

∑ T

k = −∞

T

∑

k = −∞

SVILUPPO IN SERIE DI FOURIER PER

SEGNALI PERIODICI

L’autocorrelazione di un segnale periodico y(t) di periodo T

risulta dalla sovrapposizione di infinite repliche, distanziate di

intervalli multipli del periodo T e scalate di un fattore 1/T, della

funzione di autocorrelazione della funzione generatrice g(t)

definita come

y (t )

g (t ) =

0

−

T

T

≤t≤

2

2

altrove

Prova: Poiché y (t ) = g (t ) ∗ ΠT (t ), dove

Π T(t) è il treno di

impulsi a distanza T

Π T (t ) =

+∞

∑ u0 (t − kT )

k = −∞

l’autocorrelazione di y(t) è data da (regole del transito)

1

π yy (τ ) = ε gg (τ ) ∗ πππ (τ ) = ε gg (τ ) ∗

T

1

=

T

c.d.d.

+∞

∑ε gg (τ − kT )

k = −∞

+∞

∑ u0 (τ − kT )

k = −∞

SEGNALI IMPULSIVI

Def.: Dato un segnale x(t), esso si dice impulsivo se è

assolutamente sommabile in − ∞,+∞ cioè

∞

∫−∞ x(τ ) dτ < +∞

Un segnale impulsivo ha durata finita o tende a zero con un

ordine superiore a 1. Un segnale di energia tende a zero con un

ordine superiore a 1/2. Pertanto, un segnale impulsivo, limitato

ovunque, è certamente di energia, mentre non è vero il

contrario.

TRASFORMATA DI FOURIER PER SEGNALI

IMPULSIVI

Dato un segnale impulsivo x(t), esso ammette la seguente

rappresentazione

∞

x(t ) =

∫

X ( f )e j 2πft dt

−∞

dove la funzione

∞

X(f )=

∫

x(t )e − j 2πft df

−∞

prende il nome di Trasformata di Fourier del segnale x(t), e si

indica con X ( f ) = F {x(t )}.

TRASFORMATA DI FOURIER PER SEGNALI

IMPULSIVI

L’uguaglianza

∞

x(t ) =

∫

X ( f )e j 2π ft df

−∞

va intesa come segue

i.

in tutti i punti in cui la funzione è continua il primo e il

secondo membro coincidono

ii.

nei punti di discontinuità di prima specie l’integrale a

secondo membro converge alla semisomma dei limiti da destra e

da sinistra di x(t)

1

lim x(t ) + lim x(t )

2 t →t 0−

t →t 0+

TRASFORMATA DI FOURIER PER SEGNALI

IMPULSIVI

Commento: la famiglia di funzioni parametrizzate dalla

frequenza f

s (t ; f ) = e j 2πft

costituisce una base per i segnali impulsivi.

Tale base risulta ortogonale, infatti

+∞

< s (t ; f1), s (t ; f 2 ) >=

∫

e j 2π ( f1 − f 2 )t dt = u0 ( f1 − f 2 )

−∞

X(f 0 ) rappresenta il coefficiente di x(t) rispetto alla funzione

s (t ; f 0 ) = e j 2πf 0t .

TRASFORMATA DI FOURIER PER SEGNALI

IMPULSIVI

Esempio

Trasformata del segnale x(t)=rect ∆ (t)

rect∆(t)

1

∆/2

-∆/2

t

+∞

X ( f ) = F {x(t ) } =

∫

rect∆ (t )e − j 2π f t dt

−∞

=

+∆ / 2

− j 2π f t

∫

e

−∆ / 2

= ∆ Ca (π ∆ f

dt =

+∆ / 2

e − j 2π f t

− j 2π f

=∆

−∆ / 2

)

∆

∆

∆

-1/

1/

f

sin(π ∆ f

π∆ f

)

TRASFORMATA DI FOURIER PER SEGNALI

IMPULSIVI

Esempio

Trasformata del segnale x(t)=A

A

t

X ( f ) = F {A } = F lim A rect ∆ (t ) = A lim F { rect ∆ (t ) } =

∆ → ∞

∆ →∞

= A lim ∆ Ca (π ∆ f ) = A u0 ( f )

∆ →∞

A u0(f)

f

TRASFORMATA DI FOURIER PER SEGNALI

IMPULSIVI

Esempio

Trasformata del segnale x(t)=A uo (t)

A u0(t)

t

+∞

X ( f ) = F {A u 0 (t )} = A

∫

u 0 (t )e − j 2π f 0 t dt = A

−∞

A

f

Commento:

la

rappresentazione

trasformata

integrale

qui

derivata

dell’impulso

in

base

alla

matematico,

può

ricavarsi anche come limite di una successione di rect∆ (t) di

area unitaria e base ∆→0, ovvero dalla trasformata di una

costante per la proprietà di dualità.

TRASFORMATA DI FOURIER PER SEGNALI

IMPULSIVI

Proprietà fondamentali:

i.

linearità

A X ( f ) + BY ( f )

Ax(t ) + B y (t ) ⇔

ii.

area sottesa ad una funzione

+∞

+∞

−∞

−∞

∫ x(t ) dt = X (0) , ∫ X ( f ) df = x(0)

iii. traslazione nel tempo

x(τ − τ ) ⇔

X ( f )e − j 2π fτ

Prova:

F {x(t − t )} =

+∞

+∞

−∞

−∞

∫

x(t − t )e − j 2π f t dt =

= e − j 2π ft

∫

x(t − t )e − j 2π f ( t −t )e − j 2π ft dt

+∞

∫

x(x )e − j 2π fx dx = e − j 2π ft X ( f )

−∞

La traslazione del segnale nel tempo cambia la fase ma non

l’ampiezza della trasformata di Fourier. Si noti che per τ

negativo il segnale è anticipato e la pendenza è positiva.

TRASFORMATA DI FOURIER PER SEGNALI

IMPULSIVI

Proprietà fondamentali (cont.):

iv.

traslazione in frequenza

x(t )e j 2π f 0t

⇔

X ( f − f0 )

Prova:

{

+∞

+∞

} ∫ x(t )e j2π f t e − j2π f t dt = ∫ x(t )e − j2π ( f − f )t dt

F x(t ) e j 2π f 0 t =

0

−∞

−∞

= X ( f − f0 )

La

moltiplicazione

0

(modulazione)

del

segnale

per

un

esponenziale complesso corrisponde ad una traslazione lungo

l’asse delle frequenze

TRASFORMATA DI FOURIER PER SEGNALI

IMPULSIVI

Esempio: Modulazione

x(t)

y(t)

cos(2π f0 t)

La moltiplicazione (modulazione) del segnale per un coseno a

frequenza f 0 (frequenza portante) produce in frequenza due

repliche alle frequenze f 0, -f 0

e − j 2π f 0 t + e j 2π f 0 t

=

Y ( f ) = F {x(t ) cos( 2π f 0 t )} = F x(t )

2

1

1

= X ( f − f0 ) + X ( f + f0 )

2

2

TRASFORMATA DI FOURIER PER SEGNALI

IMPULSIVI

Esempio: Modulazione e Demodulazione

X( f )

f

Y( f ) =

1

1

X ( f − f0 ) + X ( f + f0 )

2

2

1/2

Y( f )

1/2

f

-f 0

Z( f ) =

f0

1

1

1

X ( f ) + X ( f − 2 f0 ) + X ( f + 2 f0 )

2

4

4

Z( f )

1/2

1/4

1/4

f

-2 f 0

2 f0

TRASFORMATA DI FOURIER PER SEGNALI

IMPULSIVI

Esempio: Demodulazione coerente

z(t)

y(t)

cos(2π f0 t)

La moltiplicazione del segnale modulato a frequenza f 0 per un

coseno alla stessa frequenza e fase riproduce, alterato per un

fattore di scala, lo spettro del segnale originario, sommato a due

repliche alle frequenze 2f 0, -2f 0

Z ( f ) = F {y (t ) cos( 2π f 0 t )} =

1

1

1

X ( f ) + X ( f − 2 f0 ) + X ( f + 2 f0 )

2

4

4

TRASFORMATA DI FOURIER PER SEGNALI

IMPULSIVI

Trasformata di Fourier di un segnale periodico è un treno di

impulsi alle frequenze f n , di ampiezza pari ai coefficienti della

serie di Fourier del segnale.

Prova:

+∞

x(t ) =

∑

x n e j 2πf nt

n = −∞

X ( f ) = F {x(t )} =

+∞

∑ {

} ∑ xn u 0 ( f − f n )

xn F e j 2π f n t =

n = −∞

+∞

n = −∞

Un segnale periodico non è impulsivo, tuttavia la definizione –

in senso limite- della trasformata di Fourier di una costante, ne

consente la rappresentazione mediante trasformata di Fourier.

La rappresentazione mediante trasformata di Fourier consente la

trattazione unificata nel dominio della frequenza della

elaborazione di un segnale periodico e di un segnale di energia.

TRASFORMATA DI FOURIER PER SEGNALI

IMPULSIVI

Trasformata di Fourier di un segnale periodico

Esprimiamo il segnale tramite la funzione generatrice g(t) di

durata limitata al periodo T.

+∞

x(t ) =

∑ g (t − kT )

k = −∞

I coefficienti di Fourier del segnale sono proporzionali ai valori

assunti dalla trasformata di Fourier G(f) della funzione generatrice

alle frequenze multiple della fondamentale n/T.

Prova:

Xn =

1

T

T /2

T /2

−T / 2

−T / 2

∫

1

x(t )e − j 2π f n t dt =

T

∫

g (t )e − j 2π f n t dt

+∞

=

1

T

∫

1

g (t )e − j 2π f n t dt = G ( f n )

T

−∞

La trasformata di Fourier della funzione generatrice sottende lo

spettro di Fourier di ogni segnale periodico che la ammette

come generatrice.

I valori dei coefficienti, e il loro fattore di scala, dipendono dal

periodo T.

TRASFORMATA DI FOURIER PER SEGNALI

IMPULSIVI

Proprietà fondamentali (segue):

v.

Differenziazione

Dato un segnale x(t) trasformabile secondo Fourier, supposto

derivabile rispetto al tempo, con derivata ancora trasformabile

secondo Fourier, vale la seguente relazione:

d

x(t ) ⇔

dt

Prova: Sia

∞

x(t ) =

∫

j 2π f X ( f )

X ( f )e j 2π ft df

−∞

Derivando il primo e il secondo membro dell’equazione rispetto al

tempo si ha

∞

d

x(t ) =

dt

∫

X(f )

−∞

d j 2π ft

e

df =

dt

∞

∫

[ j 2π

f X ( f )]e j 2π ft df

−∞

Inoltre, essendo il segnale derivata Fourier trasformabile si ha

∞

d

x(t ) =

dt

∫

d

F x(t )e j 2π ft df

dt

−∞

Dal confronto fra le ultime due relazioni segue la tesi. c.d.d.

TRASFORMATA DI FOURIER PER SEGNALI

IMPULSIVI

Proprietà fondamentali (segue):

vi.

Integrazione (prima versione)

Sia x(t) un segnale integrabile trasformabile secondo Fourier, con

integrale ancora trasformabile secondo Fourier. Allora:

t

∫

x(t )dt

1

X(f )

j 2π f

⇔

−∞

Prova: Sia

+∞ t

− j 2π f t

+∞ t

t

e

j 2π f t

−

=

F x(t )dt =

dt =

x(t )dt e

x(t )dt d

−

2

j

π

f

− ∞

−∞ −∞

−∞ −∞

∫

∫ ∫

∫ ∫

+∞

+∞

t

t

− j 2π f t

− j 2π f t

e

d

e

= x(t )dt

−

x(t )dt

dt =

−

2

−

2

j

π

f

dt

j

π

f

−∞

−

∞

−

∞

−∞

∫

+∞

=

∫

−∞

∫

∫

1

e − j 2π f t

x(t )

dt =

X(f )

j 2π f

j 2π f

dove si è sfruttata la seguente relazione

t

t

− j 2π f t

− j 2π f t

= lim x(t )dt e

=0

lim x(t )dt e

t →−∞

t →∞

−∞

−∞

∫

∫

TRASFORMATA DI FOURIER PER SEGNALI

IMPULSIVI

Proprietà fondamentali (segue):

Commento: L’integrazione abbatte le componenti ad alta

frequenza del segnale. La differenziazione esalta le componenti

ad alta frequenza del segnale.

Ciò conferma, dal punto di vista spettrale, l’effetto temporale

per cui l’integrazione smorza le variazioni temporali del

segnale, mentre la differenziazione le accentua.

TRASFORMATA DI FOURIER PER SEGNALI

IMPULSIVI

Esempio Trasformata del gradino matematico x(t)= u -1(t)

1 t>0

u−1(t ) = 1 / 2 t = 0

0 t<0

Il gradino u -1 (t) può considerarsi come limite per α→0 della

famiglia di funzioni impulsive

e −α t

xα (t ) = 1 / 2

0

t>0

t=0

t<0

aventi la seguente trasformata di Fourier

Xα ( f ) =

=

+∞

+∞

−∞

0

∫

xα (t )e − j 2π f t dt =

∫

e −α t e − j 2π f t dt

1

α − j 2π f

=

α + j 2π f α 2 + (2π f )2

TRASFORMATA DI FOURIER PER SEGNALI

IMPULSIVI

Esempio Trasformata del gradino matematico (segue)

La trasformata di Fourier del gradino u -1 (t) è una funzione

complessa la cui parte reale (immaginaria) è ottenuta come limite

della parte reale (immaginaria) di x α(t).

X ( f ) = lim Xα ( f ) = lim

α →0

α

α →0 α 2 + (2π f )2

+ j lim

− 2π f

α →0 α 2 + (2π f )2

La parte reale di X α(f) tende ad un impulso matematico di area

1/2; la parte immaginaria vale uniformemente 0 per f=0 e tende a

1/(j2π f) per f≠0:

1

1

X ( f ) = u0 ( f ) +

2

j 2π f

TRASFORMATA DI FOURIER PER SEGNALI

IMPULSIVI

Proprietà fondamentali (segue):

vii. Integrazione (seconda versione)

Sia x(t) un segnale integrabile. L’integrale

t

y (t ) =

∫ x(t )dt

−∞

può pensarsi ottenuto come l’uscita di un filtro avente come

risposta impulsiva il gradino matematico u -1 (t), cioè

y (t ) = x(t ) ∗ u−1(t )

Ne segue che

1

1

Y ( f ) = X ( f ) ⋅ u0 ( f ) +

j 2π

2

1

1

(

)

(

)

=

+

X

u

f

X(f )

0

0

f 2

j 2π f

La proprietà di integrazione è così estesa a segnali a valor medio

non nullo (X(0)≠0).

Commento: Segnali che differiscono per una costante additiva,

pur ammettendo la stessa derivata, hanno trasformate differenti.

TRASFORMATA DI FOURIER PER SEGNALI

IMPULSIVI

Proprietà fondamentali (segue):

viii. Intercorrelazione

+∞

e xy (t ) =

∫

x* (t ) y (t + t ) dt

E xy ( f ) = X * ( f ) Y ( f )

⇔

−∞

Prova: Dati due segnali impulsivi x(t) e y(t), l’intercorrelazione è

ancora un segnale impulsivo ed è pari a

+∞

e xy (t ) =

∫

x* (t ) y (t + t ) dt

−∞

+∞ +∞

+ ∞

*

j 2π ζ (t +t )

− j 2π ft

(

)

(

)

ζ

ζ

X

f

e

df

Y

e

d

=

dt

− ∞

−∞ −∞

+∞ +∞

+∞

X * ( f )Y (ζ )e j 2π ζt e − j 2π ( f −ζ )t dt dζ df

=

−∞

−∞ −∞

∫ ∫

∫

∫∫

∫

+∞ +∞

=

=

∫∫

X * ( f )Y (ζ )e j 2π ζt d ( f − ζ )dζ df

−∞ −∞

+∞

*

∫

−∞

X ( f )Y ( f ) e j 2π ft df

TEOREMA DI PARSEVAL PER SEGNALI

IMPULSIVI.

Teorema di Parseval per segnali impulsivi. Dato un segnale

impulsivo x(t), ed indicata con X(f) la trasformata di Fourier

relativa, la sua energia E x è pari a:

+∞

Ex =

∫

X ( f ) 2 df

−∞

Prova: Poiché l’energia è pari alla funzione di autocorrelazione

del segnale calcolata nell'origine si ha

+∞

E x = e xx (0 ) =

∫

X ( f ) X * ( f ) e j 2π f 0 df =

−∞

c.d.d.

+∞

∫

−∞

2

X ( f ) df

TRASFORMATA DI FOURIER PER SEGNALI

IMPULSIVI

Proprietà fondamentali (segue):

ix.

Cambiamento di scala

f

X

α α

1

F {x(α t )} =

Prova:

F {ξ(α t )} =

+∞

+∞

−∞

−∞

∫

ξ(α t ) e − j 2π f t dt =

+∞

=

∫

f

− j 2π ξ

α 1 dξ = 1 X f

ξ(ξ ) e

α

−∞

Commento:

∫

f

− j 2π (α t )

α

ξ(α t ) e

dt

Il

cambiamento

α

di

α

scala

è

un’operazione

geometrica in cui l’asse dei tempi è espanso, compresso o

ribaltato. Ad una compressione (espansione) dell’asse dei tempi

corrisponde una espansione (compressione) dell’asse elle

frequenze.

TRASFORMATA DI FOURIER PER SEGNALI

IMPULSIVI

Proprietà fondamentali (segue):

x.

Convoluzione

+∞

∫ x(t ) y(t − t )dt

⇔

X ( f )Y( f )

−∞

Prova: Dati due segnali impulsivi x(t) e y(t), la convoluzione è

ancora un segnale impulsivo la cui trasformata di Fourier è

+∞ +∞

− j 2π f t

(

)

(

)

F {x(t ) ∗ y (t )} =

x

y

−

t

d

dt

t

t

t

e

−∞ −∞

+∞ +∞

+∞

− j 2π f t

(

)

=

−

y

t

e

dt x(t ) dt = Y ( f ) e − j 2π f t x(t ) dt =

t

−∞

−∞ −∞

= X ( f )Y( f )

∫ ∫

∫ ∫

∫

TRASFORMATA DI FOURIER PER SEGNALI

IMPULSIVI

Esempio: Relazione ingresso-uscita di un filtro

x(t)

y(t)

H( f )

y (t ) = h(t ) ∗ x(t )

Y ( f ) = H ( f )X ( f )

Prova: La relazione segue direttamente dalla proprietà di

convoluzione nel tempo.

La trasformata di Fourier della risposta impulsiva di un filtro

prende il nome di funzione di trasferimento del filtro stesso.

La funzione di trasferimento H(f) del filtro può essere valutata

imponendo un un segnale di ingresso noto X(f) non nullo

nell’intervallo di frequenza di interesse e misurando l’uscita H(f)

delfiltro:

H ( f ) = Y ( f )/ X ( f )

TRASFORMATA DI FOURIER PER SEGNALI

IMPULSIVI

Esempio: Misura della funzione di trasferimento di un filtro

x(t)

y(t)

H( f )

Y ( f ) = H ( f )X ( f )

Sia h(t ) reale (filtro idealmente realizzabile). La funzione di

trasferimento del filtro H ( f ) = M ( f ) e j j ( f ) è dunque a

simmetria coniugata, cioè H ( f ) = H * (− f ) .

In presenza di un ingresso cosinusoidale

x(t ) = A cos(2π f 0 t + ψ )

l’uscita è ancora un segnale cosinusoidale alla frequenza f 0

y (t ) = M ( f 0 ) A cos(2π f 0 t + y + ϕ ( f 0 ))

scalato di M(f 0 ) e sfasato di j(f 0 ) (ritardato di j(f 0)/(2π f 0 )).

Prova:

(

)

Y ( f ) = H ( f ) ⋅ A / 2 e + jψ u 0 ( f − f 0 ) + e − jψ u 0 ( f + f 0 )

= H ( f 0 ) A / 2 e + j ψ u 0 ( f − f 0 ) + H ( − f 0 ) A / 2 e − j ψ u0 ( f + f 0 )

TRASFORMATA DI FOURIER PER SEGNALI

IMPULSIVI

Esempio:

La misura della attenuazione introdotta da una linea telefonica

avviene mediante trasmissione di un tono di prova, cioè un

segnale cosinusoidale a frequenza f 0=800 Hz -standard europeo- o

a frequenza f 0=1000 Hz –standard USA-, ovvero ad una

successione di toni di prova all’interno della banda utile 300÷

3400 Hz.

H( f )

DTE

MODEM

-f0

=

X( f )

MODEM

Y( f )

-f0

f0

H(f )

DTE

f0

TRASFORMATA DI FOURIER PER SEGNALI

IMPULSIVI

Proprietà fondamentali (segue):

xi. Prodotto

+∞

ξ(t ) y (t ) ⇔

X ( f ) ∗Y ( f )=

∫ X (ξ − f ) Y (ξ ) dξ

−∞

Prova: Dati due segnali impulsivi x(t) e y(t), il loro prodotto è

ancora un segnale impulsivo la cui trasformata di Fourier è

+∞

F {ξ(t ) y (t )} =

∫

ξ(t ) y (t ) e − j 2π f t δt =

−∞

+∞ +∞

+∞

X (ζ )Y (ξ ) e + j 2π (ξ +ζ − f )t δt

=

−∞

−∞ −∞

∫∫

∫

+∞ +∞

=

∫ ∫ X (ζ )Y (ξ ) δ (ξ + ζ − f )δζ δξ

−∞ −∞

+∞

=

∫ X (ζ )Y ( f − ζ )δζ

−∞

δζ δξ

TRASFORMATA DI FOURIER PER SEGNALI

IMPULSIVI

Esempio: Relazione ingresso-uscita di un filtro

x(t)

y(t)

H( f )

y (t ) = h(t ) ∗ x(t )

Y ( f ) = H ( f )X ( f )

Prova: La relazione segue direttamente dalla proprietà di

convoluzione nel tempo.

La trasformata di Fourier della risposta impulsiva di un filtro

prende il nome di funzione di trasferimento del filtro stesso.

La funzione di trasferimento H(f) del filtro può essere valutata

imponendo un un segnale di ingresso noto X(f) non nullo

nell’intervallo di frequenza di interesse e misurando l’uscita H(f)

delfiltro:

H ( f ) = Y ( f )/ X ( f )

TEOREMA DI WIENER

x(t)

H( f )

y(t)

H( f )

1

f1

f2

f

Si dice Potenza di un segnale di potenza x(t), contenuta fra

f 1 e f 2 la potenza totale del segnale y(t) ottenuto applicando x(t)

in ingresso ad un filtro con funzione di trasferimento H(f) pari a

1 fra f 1 e f 2 e zero altrove:

def .

Px ( f1 , f 2 ) = Py

Si dice Energia di un segnale impulsivo x(t), contenuta fra f 1

e f 2 l’energia totale del segnale y(t) ottenuto applicando x(t) in

ingresso ad un filtro con funzione di trasferimento H(f) pari a 1

fra f 1 e f 2 e zero altrove:

def .

E x ( f1, f 2 ) = E y

TEOREMA DI WIENER

Teorema di Wiener per segnali di potenza: Dato un segnale di

potenza x(t), lo spettro di densità di potenza di x(t) è uguale alla

trasformata di Fourier della funzione di autocorrelazione

Pxx ( f ) = F {p xx (τ )}

Corollario: La potenza del segnale x(t) è uguale all’integrale da

-∞ a +∞ dello spettro di densità di potenza di x(t)

+∞

Px =

∫ Pxx ( f )

−∞

TEOREMA DI WIENER

Teorema di Wiener per segnali di potenza (segue)

Prova: Con riferimento allo schema in figura:

x(t)

H( f )

y(t)

H( f )

1

f1

f2

f

la potenza del segnale x(t) contenuta fra f 1 e f 2 è pari

all’autocorrelazione del segnale y(t) calcolata nell’origine, ovvero

all’integrale della relativa trasformata di Fourier.

Dalle regole del transito, segue:

def .

Px ( f1, f 2 ) = Py = p yy (0 ) =

+∞

=

∫

F {p xx (τ )} ⋅ H ( f ) 2 df =

−∞

c.d.d.

+∞

+∞

−∞

f2

−∞

f2

f1

f1

∫ F {p yy (τ )}df = ∫ F {pxx (τ ) ∗ e hh(τ )}df

∫ F {pxx (τ )}df = ∫ Pxx ( f )df

TEOREMA DI WIENER

Teorema di Wiener per segnali di energia: Dato un segnale di

energia x(t), lo spettro di densità di energia di x(t) è uguale alla

trasformata di Fourier della funzione di autocorrelazione,

ovvero al modulo quadrato della trasformata di Fourier di x(t).

E xx ( f ) = F {ε xx (τ )} = X ( f ) 2

Corollario: L’energia del segnale x(t) è uguale all’integrale da

-∞ a +∞ dello spettro di densità di energia di x(t)

+∞

Ex =

∫ Exx ( f )

−∞

TEOREMA DI WIENER

Teorema di Wiener per segnali di energia (segue)

Prova: Con riferimento allo schema in figura:

x(t)

H( f )

y(t)

H( f )

1

f1

f2

f

l’energia del segnale x(t) contenuta fra f1 e f2 è pari

all’autocorrelazione del segnale y(t) calcolata nell’origine, ovvero

all’integrale della relativa trasformata di Fourier.

Dalle regole del transito, segue:

def .

Ε x ( f1, f 2 ) = Ε y = e yy (0 ) =

+∞

=

∫

F {e xx (τ )} ⋅ H ( f ) 2 df =

−∞

+∞

+∞

−∞

f2

−∞

f2

f1

f1

∫ F {e yy (τ )}df = ∫ F {e xx (τ ) ∗ e hh(τ )}df

∫ F {e xx (τ )}df = ∫ Εxx ( f )df

Inoltre

{

} {

}

2

F {ε xx (τ )} = F x* (− τ ) * x(τ ) = F x* (− τ ) F {x(τ )} = X * ( f ) X ( f ) = X ( f )

c.d.d.

TRASFORMATA DI HILBERT

Def.

Dato un segnale x(t) si dice Trasformata di Hilbert di x(t)

il segnale xˆ (t ) = H {x(t )} ottenuto dal transito attraverso

il filtro con funzione di trasferimento:

j

HH ( f ) = 0

− j

f <0

f =0

f >0

ovvero con risposta impulsiva h H(t)=1/πt.

Proprietà:

1.

H {c } = 0

2. due segnali che differiscono per una costante hanno la stessa

trasformata di Hilbert.

Teorema:

Dato un segnale x(t) a valor medio nullo, la sua

trasformata di Hilbert xˆ ( t ) = H {x ( t )} costituisce una

rappresentazione di x(t) nel dominio del tempo.

Dim. Poichè H H ( f ) H H ( f ) = −1 ∀f ≠ 0 e x(t) è a valor

medio nullo,

x(t ) = − H {xˆ (t )}.

TRASFORMATA DI HILBERT

Teorema: dato un segnale reale x(t) a valor medio nullo, il segnale

e la sua trasformata di Hilbert sono ortogonali, ovvero

< xˆ ( t ), x ( t ) >= 0

Dim. Si osservi che, in virtù delle proprietà delle trasformazioni

lineari dei segnali, il prodotto scalare tra il segnale e la sua

trasformata

di

Hilbert

può

essere

scritto

come

segue

a) segnali di energia

< xˆ ( t ), x ( t ) >= e xxˆ ( 0 ) = [e xx ( t ) ∗ h H ( t ) ] t = 0

=

∞

∫− ∞

e xx ( τ )

1

π(0 − τ)

dτ ,

a) segnali di potenza

< xˆ ( t ), x ( t ) >= p xxˆ ( 0 ) = [ p xx ( t ) ∗ h H ( t ) ] t = 0

=

∞

1

∫− ∞ π xx ( τ ) π ( 0 − τ ) dτ .

Essendo il segnale reale la sua funzione di autocorrelazione è un

segnale pari, e quindi l'integrando è una funzione dispari. Di

conseguenza, il prodotto scalare è nullo, c.d.d.

TRASFORMATA DI HILBERT

Esempio. Trasformata di Hilbert di un segnale cosinusoidale

x(t)=cos(2 π f 0 t)

X(f)

A /2

A /2

-f0

jA /2

f0

f

^

X(f)

-f0

f0

-jA /2

H{x(t)}=sin(2 π f0 t)

f

SEGNALE ANALITICO

Def. Dato un segnale reale x(t), si dice Segnale analitico ad esso

associato il segnale x+(t) ottenuto dal transito attraverso un filtro

con funzione di trasferimento:

1

H a ( f ) = 1 / 2

0

Poichè H a ( f ) =

1 1

+ jH H ( f ),

2 2

x + (t ) =

Teorema:

f >0

f =0

f <0

1

1

x(t ) + jxˆ (t ) .

2

2

(1)

Dato un segnale x(t) reale a valor medio nullo, il

segnale analitico x+(t) ad esso associato costituisce una

rappresentazione di x(t) nel dominio del tempo, essendo

{ }

x(t ) = 2Re x + (t ) .

(2)

Dim. Dalla (1) segue che se x(t) è reale, anche xˆ ( t ) è reale, e quindi

il segnale analitico x+(t) è un segnale complesso la cui parte reale è

proporzionale a x(t), che pertanto può essere ricostruito tramite la

(2). Tale proprietà non sussite se x(t) è complesso.

SEGNALE ANALITICO

Oss. Il filtro analitico rimuove metà dello spettro del segnale, il

cotenuto per frequenze negative X

−

X- (f )

( f ).

X+(f )

-

+

f

Se un segnale x(t), Fourier-trasformabile, è reale, la sua Trasformata

di Fourier X(f) gode della proprietà:

X(-f)= X*(f),

ovvero

X

−

+

( f ) = X (− f

∗

) ,

f <0

Di conseguenza il cotenuto per frequenze negative X

essere ricostruito a partire dalla conoscenza

frequenze positive X

+

(f)

−

( f ) può

del contenuto per

INVILUPPO COMPLESSO

Def. Dato un segnale reale x(t), si dice inviluppo complesso ad

esso associato rispetto alla frequenza f 0 il segnale x(t ) definito

da:

x(t ) = 2 x + (t )e − j 2πf 0t

ovvero

X ( f )= 2 X

+

( f + f0 )

Poichè, in generale, X ( f ) non gode di proprietà di simmetria

rispetto all’origine, x(t ) è complesso

Posto

x(t ) = xc (t ) + jxs (t )

i segnali xc (t ) e xs (t ) prendono il nome di componenti

analogiche di bassa frequenza del segnale rispetto alla

frequenza f 0. In particolare, si definisce

xc (t ) : componente analogica di bassa frequenza in fase

xs (t ) : componente analogica di bassa frequenza in quadratura.

SEGNALE ANALITICO E INVILUPPO

COMPLESSO: INTERPRETAZIONE SPETTRALE

X (f )

-f o

fo

f