ANTONELLA CORRADINI

EPISTEMOLOGIA

DELLE SCIENZE UMANE

Un’introduzione al corso

ANTONELLA CORRADINI

EPISTEMOLOGIA

DELLE SCIENZE UMANE

Un’introduzione al corso

Milano 2005

© 2005-2013

EDUCatt - Ente per il Diritto allo Studio Universitario dell’Università Cattolica

Largo Gemelli 1, 20123 Milano - tel. 02.7234.22.35 - fax 02.80.53.215

e-mail: [email protected] (produzione); [email protected] (distribuzione)

web: www.educatt.it/libri

ISBN edizione cartacea: 978-88-8311-372-7

ISBN edizione elettronica: 978-88-6780-025-4

L’edizione cartacea di questo volume è stata stampata nel mese di settembre 2013

presso la Litografia Solari – Peschiera Borromeo (Milano); l’edizione elettronica è

disponibile gratuitamente nell’area web EDUCatt dedicata al progetto FreeBook,

all’indirizzo www.educatt.it/libri/freebook

INDICE

PREMESSA ..........................................................................................5

1 TEORIE............................................................................................6

1.1 Struttura generale delle teorie....................................................6

1.2 Simmetria vs. asimmetria tra spiegazione e

giustificazione .........................................................................10

1.3 Conseguenze della asimmetria del nuovo metodo ..................18

Parte antologica ............................................................19

2 SPIEGAZIONE E PREVISIONE ..................................................31

2.1 La spiegazione secondo il modello deterministico..................32

2.2 La spiegazione probabilistica ..................................................33

2.2.1 Due nozioni di probabilità .............................................34

2.2.2 Probabilità epistemica vs. probabilità ontica .................35

2.2.3 Che cosa spiego con il modello I-S?..............................35

2.3 Spiegazione e previsione .........................................................37

Parte antologica ............................................................38

3 GIUSTIFICAZIONE......................................................................63

3.1 Neo-Positivismo ......................................................................63

3.1.1 Neo-Positivismo: prima fase..........................................63

3.1.2 Neo-Positivismo (seconda e terza fase) .........................64

3.2 Falsificazionismo popperiano .................................................67

3.2.1 Critica all’induttivismo..................................................67

3.2.2 Razionalismo .................................................................68

3.2.3 Falsificazione .................................................................69

3.2.4 Corroborazione e previsione razionale ..........................71

3.3 Epistemologia post-popperiana ...............................................74

3.3.1 T. Kuhn ..........................................................................75

3.3.2 P.K. Feyerabend.............................................................79

3

3.4 Riflessioni critiche sull’epistemologia contemporanea...............82

3.4.1 Una chiave di lettura dell’epistemologia

contemporanea basata sul rapporto tra teoria e fatti

empirici ..........................................................................85

3.4.1.1 Carico teorico dei concetti osservativi...............86

3.4.1.2 Carattere olistico della giustificazione...............88

3.4.1.3 Tesi della sottodeterminazione empirica

delle teorie......................................................................90

3.4.1.4 Argomento della spiegazione migliore ..............91

Parte antologica ............................................................92

4 DINAMICA DELLA SCIENZA..................................................125

4.1 Il Neo-Positivismo.................................................................125

4.2 Il Falsificazionismo ...............................................................126

4.3 L’epistemologia post-popperiana ..........................................126

Parte antologica ..........................................................128

5 REALISMO E ANTIREALISMO NELLA SCIENZA ..............131

5.1 Che cos’è il realismo scientifico ...........................................131

5.2 Teoria della verosimilitudine in Popper ................................133

5.3 Il realismo circa gli inosservabili ..........................................135

Parte antologica ..........................................................136

6 SPIEGAZIONE E COMPRENSIONE ........................................153

6.1 La nascita del dibattito nell’Ottocento ..................................153

6.1.1 Il Positivismo ...............................................................154

6.1.2 Lo Storicismo...............................................................155

6.2 Prospettive contemporanee....................................................157

6.2.1 Neo-Positivismo: tesi dell’unità del metodo

scientifico.....................................................................157

6.2.2 Popper ..........................................................................159

6.2.3 Wittgenstein e la psicologia.........................................162

6.2.4 G.H. von WRIGHT ........................................................162

Parte antologica ..........................................................165

4

PREMESSA

La presente dispensa è destinata agli studenti del corso di

Epistemologia delle Scienze Umane, attivato presso il corso di laurea

in Scienze e Tecniche Psicologiche della Facoltà di Psicologia.

Essa concerne gli argomenti delle prime due parti del corso,

riguardanti rispettivamente l’epistemologia generale e l’epistemologia

delle scienze umane.

Nel redigere la dispensa, si è privilegiato il criterio dell’essenzialità

e della sinteticità della trattazione, affidando alla ricca parte antologica

le esemplificazioni e la contestualizzazione degli argomenti. La parte

antologica offre inoltre agli studenti l’opportunità di venire a

conoscenza del dibattito epistemologico contemporaneo dalla viva

voce dei suoi protagonisti.

5

1

TEORIE

1.1 Struttura generale delle teorie: T = <L,U>

T= Teoria = linguaggio che parla di un universo oggettuale

U = Universo oggettuale o ambito o dominio di realtà: insieme di

oggetti provvisti di proprietà e relazioni

L = Linguaggio = insieme di proposizioni che parlano delle

proprietà e delle relazioni tra gli oggetti costituenti il dominio

oggettuale relativo

6

ESEMPI:

FISICA

LINGUAGGIO

OGGETTI

(1) Enunciati che descrivono i

fenomeni fisici (movimento di corpi:

le parabole degli oggetti che cadono);

Corpi dotati di

specifiche

proprietà/relazioni

come la massa, il

movimento e la velocità

(2) Enunciati che descrivono le

regolarità dei fenomeni fisici (Leggi)

MATEMATICA

(ARITMETICA)

(1) Enunciati dell’aritmetica: 1 + 2 = 3, Enti astratti

5 < 7; (2) Legge aritmetica: la somma (i numeri naturali, 0, 1,

è commutativa: a + b = b + a

2, 3, …)

TEORIA DEL

COMPORTAMENTO

PSICOPATOLOGICO

TEORIA

DELL’EVOLUZIONE

(1) Enunciati che

descrivono i

comportamenti

psicopatologici; (2) Leggi

che presiedono ai

meccanismi di difesa e che,

perciò, spiegano tali

comportamenti

(1) Enunciati relativi alla

differenziazione delle

specie viventi (collocazione

temporale delle specie

animali viventi, loro

nascita, loro estinzione…);

(2) Leggi che descrivono i

meccanismi di evoluzione

delle specie viventi

7

Comportamenti

psicopatologici (amnesie,

lapsus, fobie, …)

Le specie viventi

TEORIE COME SISTEMI ORGANIZZATI DI ENUNCIATI

T = <Assiomi di T, nesso di conseguenza logica (

)>

Teorema = Conseguenza logica degli assiomi

ASSIOMI

⇓

Teorema

Conseguenza logica

Se gli assiomi sono veri

allora

è vero il teorema

ESEMPIO DELLA GEOMETRIA:

ASSIOMI

Assioma delle parallele:

Per un punto esterno ad una

retta data passa una e una

sola retta ad essa parallela...

⇓

TEOREMA

La somma degli angoli

interni di un triangolo è di

180°

Se è vero l’assioma delle

parallele

Conseguenza logica

8

allora

è vero il teorema della

somma del triangolo

DUE ASPETTI DEL NESSO DI CONSEGUENZA LOGICA:

(1) Momento esplicativo (SPIEGAZIONE)

(2) Momento giustificativo (GIUSTIFICAZIONE)

OGGETTO

SPIEGAZIONE: riguarda un

EVENTO = accadere o sussistere di un fatto

GIUSTIFICAZIONE: riguarda una

CREDENZA (CONVINZIONE)

SPIEGARE UN EVENTO

significa

GIUSTIFICARE UNA

CREDENZA

significa

TROVARE LA CAUSA DI TALE EVENTO

= O FATTO

TROVARE LA RAGIONE PER CUI VA

= RITENUTA VERA TALE CREDENZA

ESEMPIO:

SPIEGARE IL

FATTO CHE

PIOVERÀ

significa

GIUSTIFICARE

LA CREDENZA

CHE PIOVERÀ

significa

TROVARE LA

= CAUSA DI TALE

FATTO

È IN ATTO UN ABBASSAMENTO

DELLA TEMPERATURA E IL

CIELO È NUVOLOSO

TROVARE LA

RAGIONE PER

= CUI VA

RITENUTA VERA

TALE

CREDENZA

RICONDURRE LA CREDENZA

CHE PIOVERÀ

ALL’ABBASSAMENTO DELLA

COLONNA DI MERCURIO

9

1.2 Simmetria vs. asimmetria tra spiegazione e giustificazione

Nella scienza antica (aristotelica) si dava una simmetria tra

spiegazione e giustificazione, che si può evidenziare nei seguenti due

schemi.

SIMMETRIA DEL MODELLO ARISTOTELICO NELLE

SCIENZE MATEMATICHE

ASSIOMI EVIDENTI

(risultato della intuizione delle essenze)

Es. Assiomi della geometria

Piano (aletico) della

spiegazione

Piano (epistemico) della

giustificazione

(È in gioco la verità)

(È in gioco il grado di

certezza)

⇓

Conseguenza logica

I principi primi spiegano il

risultato

⇓

I principi primi

conferiscono certezza al

risultato

dato disciplinare

(possibilmente non

evidente)

Es. Somma angoli

triangolo = 180°

10

SIMMETRIA DEL MODELLO ARISTOTELICO NELLE

SCIENZE EMPIRICHE

ASSIOMI

EVIDENTI

(risultato della intuizione delle essenze)

Es. Gli oggetti empirici tendono verso il loro luogo naturale

Piano (aletico) della

spiegazione

Il luogo naturale degli

oggetti materiali (pesanti)

è la terra

(È in gioco la verità)

Piano (epistemico) della

giustificazione

(È in gioco il grado di

certezza)

⇓

Lasciati liberi,gli oggetti

materiali tendono a cadere

verso la terra (in basso)

⇓

I principi primi spiegano il

dato

Questa pietra è materiale

ed è lasciata libera

I principi primi

conferiscono certezza alla

conoscenza

del dato

dato disciplinare

Es. Questa pietra cade

verso il basso

11

La nuova scienza empirica galileiana si caratterizza per

l’asimmetria tra spiegazione e giustificazione, se non nelle scienze

formali, per lo meno in riferimento alle scienze empiriche.

TEORIE MATEMATICHE

ASSIOMI

Piano (aletico) della

spiegazione (È in gioco la

verità)

∼

∼

∼

Piano (epistemico) della

giustificazione (È in gioco

il grado di certezza)

⇓

∼

conseguenza logica

∼

⇓

Gli assiomi spiegano il

teorema

∼

∼

∼

Gli assiomi conferiscono

certezza al teorema

teorema

Nell’ambito delle scienze formali come la matematica, si riscontra

una simmetria del rapporto tra spiegazione e giustificazione. In altri

termini, gli assiomi non solo spiegano il teorema (cioè ne assicurano

la verità), ma oltre a ciò giustificano la credenza nella sua correttezza.

12

ASIMMETRIA DEL RAPPORTO TRA SPIEGAZIONE E

GIUSTIFICAZIONE NELLE SCIENZE EMPIRICHE

Leggi

Piano (aletico) della

spiegazione

(È in gioco la verità)

⇓

Gli assiomi

spiegano il dato

∼

∼

∼

∼

conseguenza

logica

∼

∼

∼

∼

Piano (epistemico) della

giustificazione

(È in gioco il grado di

certezza)

⇑

Il dato conferma le ipotesi

Il dato

(Base empirica)

Nelle scienze empiriche, a differenza delle matematiche, si ha

un’asimmetria del rapporto tra spiegazione e giustificazione. In altri

termini, le leggi generali spiegano il dato, ma è poi il dato a

giustificare le leggi da cui viene dedotto.

Approfondiamo la struttura delle teorie empiriche.

13

TEORIE EMPIRICHE

1. Componenti:

(a) Base empirica (osservativa) = insieme di proposizioni che

risultano vere in base all’esperienza = insieme delle proposizioni

osservative vere = insieme delle proposizioni che descrivono fatti

empirici = insieme delle proposizioni sperimentali

(b) Parte teorica = leggi della teoria

2. Linguaggio L

L = VO + VT

VO = termini riguardanti entità osservabili, riguardo ai quali cioè è

possibile decidere mediante osservazione (sperimentazione) se

convengono o meno a un oggetto empirico. Esempio: termini

riguardanti la lettura di strumenti di misurazione, mutamenti di colore,

comportamenti esteriori…

14

VT = termini che riguardano inosservabili. Esempio: peso specifico

(x) = p(x)/v(x); molecola, elettrone, quark, …

Ragione della distinzione tra i vocabolari:

Quando si fa scienza non ci si accontenta di una descrizione del

fenomeno osservabile, bensì si ricerca una spiegazione di ciò che lo fa

accadere: la scienza mira a comprendere la costituzione e le cause

sottostanti e inosservabili dei fenomeni palesi (Kosso, Parte antologica).

3. Relazioni tra le parti

T = < LEGGI,

, Base empirica >

ESEMPIO DELLA FISICA:

Legge della gravitazione

universale

⇓

Se è vera la legge della

gravitazione universale

Conseguenza logica

Questa mela cade verso il

basso

allora

si verifica che questa mela

cade verso il basso

15

ESEMPIO DELLA METAPSICOLOGIA FREUDIANA:

Se si danno le leggi che

presiedono ai meccanismi

di difesa

Leggi dei meccanismi di

difesa

Es: Meccanismo di

formazione reattiva:

attitudine contraria ai

propri reali sentimenti

suscitata dall’angoscia

generata da tali sentimenti

⇓

Es: Se sono vere le leggi

che presiedono al

meccanismo della

formazione reattiva

Conseguenza logica

Omofobia

allora

si verifica il

comportamento omofobico

In conclusione, si può dire che nella scienza galileliana ha luogo

una asimmetria tra il fondamento aletico e il fondamento epistemico

delle scienze empiriche.

Ciò che spiega

(fondamento aletico)

IPOTESI

Ciò che è giustificato

Piano (aletico) della

spiegazione

⇓

Conseguenza

logica

Piano (epistemico) della

giustificazione

⇑

Ciò che è spiegato

Base empirica

Ciò che giustifica

(fondamento epistemico)

16

DIVERSITÀ TRA IL MODELLO ARISTOTELICO E IL

MODELLO GALILEIANO DI SCIENZA:

MODELLO ARISTOTELICO

– Per Aristotele, scienza e filosofia non sono due attività distinte;

– La scienza ha una struttura assiomatica, dimostrativa, deduttiva;

– Tramite gli assiomi cogliamo l’essenza dei fenomeni, la loro natura

profonda;

– La conoscenza dell’essenza è una conoscenza certa, evidente, ossia

autogiustificantesi;

– Tale conoscenza è irrevedibile, non modificabile o falsificabile;

⇓

– Struttura aprioristica del sapere scientifico, l’esperienza gioca un

ruolo trascurabile.

MODELLO GALILEIANO

– Formulazione di un criterio di demarcazione tra scienza e filosofia;

– Passaggio dal metodo deduttivo al metodo ipotetico-deduttivo

⇓

– La conoscenza scientifica è per sua natura sempre revedibile,

modificabile, falsificabile.

17

1.3 Conseguenze della asimmetria del nuovo metodo

– Il carattere ipotetico delle teorie: “I concetti di teoria, ipotesi e

legge descrivono lati diversi delle affermazioni scientifiche e non si

escludono l’un l’altro” (Kosso, parte antologica).

– distinzione tra contesto della scoperta e contesto della

giustificazione

Contesto oggettivo della spiegazione e della

giustificazione

Contesto della spiegazione:

Contesto della

giustificazione:

Logica deduttiva

Logica deduttiva

+

Logica induttiva (almeno

per i neo-positivisti)

18

Contesto soggettivo della

scoperta

Psicologia

PARTE ANTOLOGICA

P. KOSSO, Leggere il libro della natura

Bologna 1995, pp. 15-33

Ciò che le teorie non sono

… Cominciamo a tentar di chiarire il concetto di scienza

discutendo l’uso di un termine scientificio chiave: quello di «teoria».

Spesso, sia gli addetti alla scienza sia i non addetti … usano il

concetto in modo vagamente peggiorativo come quando si dice: «ma

è solo una teoria!» Questo fa subito pensare a una situazione di

distacco dalla realtà e di mancanza di dimostrazione, a un’assenza di

buoni motivi per credere a un’affermazione la quale, appunto, è solo

una teoria … Potrebbe anche darsi che ci siano buone ragioni per non

credere ad affermazioni puramente teoriche …

Ironia vuole che i maggiori risultati della scienza … sono tutti

qualificabili come teorie. Pensiamo un attimo. I risultati della

scienza? Per esempio è riuscita a capire il fenomeno della

gravitazione universale, cioè che tutti gli oggetti dotati di massa,

siano essi sulla terra e negli alti cieli, si attraggono fortemente l’un

l’altro. Ciò descrive un ampio assortimento di eventi, dalla caduta

intorno a noi di cose prive di sostegno ai movimenti dei pianeti e

delle stelle, all’espansione dell’intero universo. Se si vuole essere

commentatori della scienza moderni e informati, ci si deve insomma

riferire alla teoria generale della relatività.

Colla sua applicazione alle difficoltà del nostro confronto col

mondo, la scienza ha anche un impatto pratico. Essa ha spiegato i

meccanismi invisibili della trasmissione delle malattie. Chi non crede

alla teoria dei germi? … Se invece si vuol sapere dove, quando e

perché avvengono i terremoti, e si vuole una risposta scientifica, si

consulterà la teoria degli strati tettonici. E così via.

Quando non si parla più di teorie, si è smesso di parlare di scienza.

Così, se essere scientifico, nella misura in cui si occupa

dell’approccio metodologico alla verità sul mondo, è una cosa buona

19

e se le teorie sono il prodotto primario dell’impresa scientifica, allora

non può essere che, proprio perché le teorie sono teorie, esse sono

improbabili o comunque bisognose di dimostrazione scientifica,

qualunque cosa ciò voglia dire. Essere teorico non è niente di cui ci si

debba vergognare.

È forse qualcosa di cui si debba andare orgogliosi? Se «teoria» non

è un termine di biasimo, è forse un termine di lode, indicativo di una

descrizione credibile ed esauriente di qualche aspetto del mondo? No,

almeno se prestiamo attenzione a come il concetto viene usato nella

scienza. Consideriamo due comuni riferimenti al concetto di teoria, la

teoria del calorico e la teoria cinetica. Entrambe sono descrizioni del

fenomeno del calore anche se esse descrivono il meccanismo

soggiacente in modi molto differenti. La teoria del calorico dice che il

calore è una sostanza (detta, appunto, calorico), in particolare un

fluido sottile che penetra dentro e fuori le cose rendendole,

rispettivamente, più calde e più fredde. Essere caldo è come essere

bagnato; solo che il fluido è diverso: calorico invece di acqua. La

teoria cinetica, al contrario, afferma che il calore non è un tipo

speciale di sostanza bensì un tipo speciale di attività delle molecole

delle sostanze calde. In una patata non si insinua niente che la renda

calda: semplicemente, le molecole che la costituiscono vibrano più

veloci. Non c’è alcuno scambio di materia e, in realtà, non esiste

niente che sia il calorico. È chiaro che queste due teorie, come

descrizioni accettabili del calore, sono tra loro in competizione. È

probabile che una sia più vera dell’altra, ma nessuna è più teorica

dell’altra. La probabilità di essere vera non è valutata sulla base di

come ciascuna sia teorica. I criteri non sono nemmeno coincidenti.

Per essere chiari, ha senso parlare di teorie vere così come ha senso

parlare di teorie false. L’essere teorico è irrilevante rispetto all’essere

vero.

È irrilevante anche rispetto alla distinzione tra l’essere ben

dimostrato e l’essere nuovo e ipotetico. La teoria speciale della

relatività, col suo modo di riguardare il moto, la massa, l’energia e le

loro interazioni nello spazio e nel tempo, ha superato molti test

scientifici con un punteggio altissimo. È una teoria assodata. La si

confronti con la teoria delle superstringhe, una proposta relativamente

nuova sulla struttura dello spazio, del tempo e di tutto ciò che c’è in

loro. Si tratta di una descrizione del mondo interessantissima ma non

controllata, ed è, appunto, una teoria. La questione non è tanto che

20

queste due teorie sono in competizione tra loro (in effetti non lo

sono), quanto che esse, sebbene differiscano in maniera significativa

rispetto all’essere controllate o meno, stanno entrambe,

comodamente, entro il concetto di teoria.

Forse, se «teoria» non è elogiativo nel senso dell’essere probabile

che sia vera, è però il riconoscimento, fatto sulla base della struttura

stessa di un’affermazione, che quanto essa dice è una descrizione

esauriente, completa, di una data parte del mondo. Per confezionare la

descrizione, diciamo, di un elettrone, o di uno strato tettonico, ci

possono volere svariati concetti interrelati ed è solo il pacco intero

delle affermazioni, dei modelli e, perfino, dei procedimenti

sperimentali a valere come teoria scientifica. Talvolta, in effetti, le

teorie vengono considerate come entità complesse, sfaccettate ma è

difficile dire esattamente cosa vi debba essere incluso per avere una

teoria completa e per avere quindi un’unità di valutazione scientifica

che sia adeguata in questo senso. E non è neanche necessario. Visto

che il progetto è valutare la giustificazione delle affermazioni

scientifiche, è meglio attenersi alla possibilità che l’essere giustificato

o meno spetti alle parti di queste entità sfacettate, cioè alle singole

affermazioni. Si vuole con ciò difendere l’interesse per quei concetti

di teoria secondo i quali una teoria può anche essere un’affermazione

singola, addirittura isolata, difendendo con ciò la legittimità di

locuzioni del tipo «la teoria secondo la quale i raggi cosmici nascono

da reazioni nucleari nello spazio esterno».

Questo significa che si possono avere teorie sia generali sia

speciali, teorie esaurienti oppure selettive … Si può avere una teoria

generale della nascita della civiltà o una teoria del significato

effettivo di Stonehenge. Si può avere la teoria che i dinosauri furono

sterminati da catastrofici cambiamenti climatici. Si può avere la teoria

che è il tizio della porta accanto quello che ci ruba il giornale la

domenica.

Per riassumere, nessuno di questi aspetti, ossia probabilità di

essere vera, generalità o comprensività, delimita esattamente il

concetto di ciò che è una teoria … Dire di qualcosa che è una teoria

non è né un credito né un discredito. In termini di credibilità, possono

esservi teorie sia buone sia cattive ma esse restano ciò nonostante

teorie. Un modo per decidere se una certa affermazione autorizzi a

credere a essa ci vuole di certo ma non serve rilevare semplicemente

21

che è una teoria. Si ha bisogno dell’informazione ulteriore che si tratti

di una buona teoria.

Fin qui si è parlato di … cosa non significa «teoria» ma il concetto

ha di sicuro dei limiti. Che significa, allora, «teoria?» …

Cosa sono le teorie

Rispondendo a questa domanda conviene prestare attenzione

all’osservazione, fatta prima, secondo la quale i prodotti primari

dell’impresa scientifica sono le teorie. Qual è dunque lo scopo della

scienza? In cosa consiste tale produzione? Ma la scienza mira, più in

generale, a dar conto di ciò che accade dietro i fenomeni della nostra

esperienza. Descrivendo oggetti ed eventi che non sono palesi, essa

tenta di dar senso a quegli avvenimenti del mondo che invece lo sono.

La scienza mira a comprendere la costituzione e le cause sottostanti

dei fenomeni palesi e a dare, in tal modo, senso al mondo fenomenico

in cui abitiamo … Questa capacità ha bisogno della comprensione

delle cause, ossia di quei meccanismi non visti che determinano gli

eventi della nostra esperienza …

La scienza non vuole semplicemente descrivere, in maniera

accurata e metodica, il mondo osservabile, non vuole essere solo una

descrizione raffinata ed esatta dei fenomeni, la migliore

raffigurazione possibile degli oggetti palesi con tanto di programma

puntuale del loro andare e venire. Certamente, nella scienza, questo

tipo di ritratto preciso e dettagliato del mondo palese è uno strumento

necessario per la scoperta e il controllo. Scoperta e controllo di che?

Di teorie. Le osservazioni precise servono a mostrare come la scienza

descrive il mondo in quegli ambiti del reale che sono troppo piccoli,

troppo distanti o troppo lontani nel passato per poterne fare

esperienza.

Se, per esempio, la scienza viene applicata ai fenomeni della

pioggia acida e delle foreste e dei laghi che muiono, il risultato è

qualcosa di più di una lista dettagliata degli effetti. In questo caso si

vuole sapere esattamente cosa sta accadendo, ed è questo ciò che

esattamente si ottiene. Un rapporto scientifico è utile e interessante

nella misura in cui descrive i costituenti non visti del problema, gli

acidi e i loro componenti chimici, e gli eventi fondamentali della loro

produzione e della loro unione nell’atmosfera. È questa descrizione di

ciò che accade al di là dell’immediatamente palese che costituisce il

22

prodotto della scienza, ed è questo il motivo per cui, se vogliamo

comprendere e ricevere aiuto, ci rivolgiamo alla scienza …

Le più fondamentali tra le dimostrazioni scientifiche che si fanno

in classe, come quelle attraverso le quali si vuole insegnare cosa

accade nella scienza, sono di questo tipo. La mia preferita prevede lo

strofinamento di un palloncino sui capelli di qualcuno per poi far

toccare al palloncino la parete. Il palloncino si attacca. Si comincia a

fare scienza quando ci si chiede: qui che sta succedendo? Ma non si

vuole una descrizione del fenomeno osservabile, bensì una

spiegazione di ciò che lo fa accadere. C’è la questione della

costituzione di base del palloncino, dei capelli e della parete, c’è la

questione dell’evento dello strofinio che fa sì che il palloncino si

attacchi. Forse, quando il palloncino è strofinato sui capelli, si gratta

via una sottile pellicina di gomma vecchia e secca e si espone la

gomma fresca e appiccicosa che sta sotto, e per questo resta attaccato

alla parete. O, forse, l’azione più importante si svolge a una scala

ancora più piccola, e lo strofinio gratta via dai capelli microparticelle

di carica elettrica per cui il palloncino diventa elettricamente carico e

quindi passibile di attrazione da parte delle particelle cariche della

parete. È questo tipo di descrizione dei fattori che sono responsabili

dei fenomeni e che non si percepiscono, è questo genere di resoconto

del mondo da dietro le quinte, ciò che costituisce la realizzazione

della scienza …

Volendo comprendere la struttura della scienza e i suoi metodi di

giustificazione, è utile distinguere due generi di affermazioni circa gli

oggetti e gli eventi non osservabili …

Un tipo di teoria sarà quello fatto solo di affermazioni sugli

inosservabili, cioè di descrizioni degli abitanti e delle attività del

mondo inosservabile senza alcuna menzione del loro impatto su

quello osservabile. Per esempio, molte delle affermazioni che si

trovano nella descrizione che i fisici danno delle particelle elementari

non hanno alcun contatto con il mondo dell’esperienza. Tutti i barioni

(per esempio i protoni) sono fatti di quark. Questo definisce due

generi di entità inosservabili e la loro relazione di composizione. Ora,

delle particelle, ne sappiamo ancora di più in base all’affermazione

che le forze di interazione tra di esse, ad esempio quelle occorrenti

nelle collisioni, sono causate dallo scambio di particelle ulteriori, le

cosiddette particelle virtuali. Si tratta di una descrizione del

micromondo interessante e forse addirittura esatta ma, a questo

23

livello, il mondo su cui la descrizione dà informazioni è isolato

rispetto a quello della nostra esperienza. Lo stesso vale per le

descrizioni di un passato lontano, per le ricostruzioni dell’aspetto di

edifici e ceramiche, e del comportamento politico ed economico.

Tutte le affermazioni di questo tipo descrivono solamente ciò di cui

chi descrive non può avere esperienza.

L’altro tipo di affermazione teorica è quello che serve a rompere

questo isolamento. Ci vogliono, a questo scopo, affermazioni

concernenti le interazioni tra i non osservabili e gli osservabili.

Appartengono a questa seconda categoria le descrizioni di quegli

eventi del passato che hanno influenzato i tratti salienti delle tracce

ritrovate nel presente, siano esse testi superstiti, resti archeologici o

evolute pratiche sociali. Altri esempi includono le descrizioni

dell’impatto causale del micromondo sul macromondo (e viceversa).

Un tale tipo di asserzione colma la lacuna tra ciò che esperiamo,

l’immagine manifesta del mondo, e ciò che non possiamo esperire ma

a cui siamo interessati, l’immagine scientifica. Chiaramente,

affermazioni teoriche di questa sorta saranno di fondamentale

importanza per la comprensione del materiale probatorio scientifico e

del processo di controllo.

Esempi di tali asserzioni sono facilmente localizzabili nelle attività

sperimentali degli scienziati. Una particella carica, come un protone,

quando passa accanto a degli atomi li ionizzerà e, in un vapore

supersaturo come quello che si ottiene in una camera a nebbia, attorno

agli ioni si formeranno delle bolle visibili. In tal modo la

microparticella lascia il suo segno nel mondo dell’esperienza e,

quindi, si possono avere informazioni su certi aspetti del suo

comportamento. Dato che i buchi neri attraggono gravitazionalmente

la luce, essi faranno curvare i raggi luminosi proprio come fa una

lente e causeranno un’immagine visibilmente alterata delle stelle e

delle galassie che si trovano vicine alla loro posizione nel cielo. Ciò

che non si può vedere ha un’influenza notevole su ciò che invece si

può. Un vaso di ceramica, usato, rotto e gettato via nell’antica Grecia,

finisce inavvertitamente nel recinto degli animali tra il letame;

assieme al letame i pezzi vengono sparpagliati nei campi solo per

essere poi recuperati ed esaminati da un archeologo moderno che ha

una teoria secondo la quale i cocci provenivano non da un vaso usato

qui nel campo bensì da uno usato là nella fattoria.

24

Queste sono le teorie che forniscono immagini … le teorie di

questo tipo assicurano che ciò che viene esperito, la traccia nella

camera a nebbia o il coccio di vaso, è un’immagine informativa del

suo precedessore causale, cioè della particella o del vaso …

La nostra situazione rispetto al mondo inosservabile delle

immagini scientifiche è quella che ci vede, in quanto percipienti, a

uno dei due capi della catena causale. All’altro capo sta l’oggetto che

ci interessa. Il vaso antico, attraverso una successione di interazioni

causali comprendenti il riutilizzo culturale e l’erosione, produce un

coccio in un campo, e tutto ciò che l’archeologo vede è l’ultimo

passo, il coccio. Un protone causa ionizzazione, bolle e una traccia di

vapore, e tutto ciò che il fisico vede è la traccia. Se il coccio o la

traccia devono essere materiale probatorio di qualcosa, ci deve essere

una teoria che descrive l’altro capo della catena causale come pure i

passaggi intermedi. Così, entrambi i tipi di teoria, sia quello

concernente soltanto gli inosservabili … sia quello concernente la

relazione tra gli inosservabili e gli osservabili … sono usati per

ricostruire la catena interattiva che va dall’oggetto dell’interesse

scientifico all’immagine manifesta.

Ipotesi e leggi

… Come si è sottolineato prima, alcune teorie scientifiche sono

state controllate in maniera esauriente e altre no. Le prime sono

passate attraverso quello che costituisce la risposta al problema della

giustificazione. Le altre, cioè quelle che non ci sono passate o sono

ancora alle fasi preliminari del controllo, sono ipotesi. Dire di

qualcosa che è un’ipotesi significa riferire circa il suo status di

giustificazione, qualificandola come non controllata o controllata solo

minimamente.

… È chiaro che questo aspetto delle affermazioni scientifiche va

per gradi. Si vedrà subito che la giustificazione si accumula senza mai

raggiungere lo stadio della certezza. Per questo motivo, nella

descrizione della scienza, è preferibile usare l’aggettivo «ipotetico»

piuttosto che il nome «ipotesi» e pensare non a una dicotomia tra ciò

che è e ciò che non è un’ipotesi ma a una misura della maggiore o

minore ipoteticità di un’affermazione. La scienza, in quanto impresa

responsabile verso il pubblico, vuole che i suoi prodotti, qualora siano

provvisori e non controllati, portino come avvertimento l’etichetta di

«ipotetico». È un etichetta che non si stacca in un colpo solo ma si

25

toglie un po’ alla volta. Lo status di ipoteticità di una teoria cambia e

ciò indica che tale status non è una caratteristica intrinseca che

descriva ciò di cui la teoria tratta o ciò che essa dice o la forma in cui

lo dice: l’essere ipotetico è un riflesso della relazione storica che la

teoria ha con le attività (o inattività) della comunità scientifica. Non è

semplicemente guardandola che, di un’affermazione teorica, si può

capire se è ipotetica. Bisogna proprio che ce lo dicano esplicitamente.

… C’è un’altra importante variazione fra le teorie: il loro grado di

generalità. Alcune teorie sono più generali e quindi più interessanti di

altre. Le teorie possono essere generali nella misura in cui ignorano

fattori quali la localizzazione spaziale (si applica ovunque), il tempo

(vale sempre) o altri aspetti che siano irrilevanti per il processo

descritto. Esse fanno questo specificando quali fattori sono rilevanti

per quel particolare comportamento. Ad esempio, è vero che tutti gli

oggetti privi di sostegni e molto vicini alla superficie terrestre,

cadendo, aumentano di velocità. Questa cresce a un ritmo di 9,8 metri

al secondo per ogni secondo in cui essi si trovano in caduta libera.

Ciò vale a prescindere dal colore dell’oggetto, da come è stato fatto,

da dove lo si è comprato, dal momento del giorno in cui lo si è fatto

cadere e così via. Questi aspetti non sono pertinenti. Ciò che invece è

pertinente è che l’oggetto abbia una massa (sebbene quanta ne abbia

non lo sia), che sia privo di sostegni e che sia vicino alla superficie

della terra. La teoria generalizza su tutti gli oggetti che abbiano queste

proprietà.

Ancora migliore, almeno nel senso di più generale, è

l’affermazione che tutti gli oggetti dotati di massa, ovunque essi

siano, si attraggono con una forza che è direttamente proporzionale al

prodotto delle loro masse e inversamente proporzionale al quadrato

della distanza di separazione. Questa affermazione copre una più

ampia classe di oggetti ed eventi, e specifica un minor numero di

proprietà pertinenti necessarie per l’appartenenza a tale classe. Il suo

contributo alla nostra comprensione del mondo è che essa identifica la

proprietà delle cose (devono avere una certa massa) che è pertinente

al fenomeno (la loro forza di attrazione e il moto risultante). Queste

teorie, che generalizzano e descrivono generi di cose, sono leggi. Si

parla della legge di caduta dei gravi, essa stessa un capitolo della

legge di gravità. Vi sono tantissimi altri esempi. Per farne ancora uno,

prendiamo la legge di Coulomb che afferma che ogni oggetto

elettricamente carico esercita una forza su ogni altro oggetto

26

elettricamente carico. Il genere pertinente di cosa qui è tutto ciò che è

elettricamente carico e viene collegato al fenomeno della forza.

Diversamente dalla caratteristica di essere ipotetico, dovremmo

poter dire se una teoria è legisimile o non lo è, semplicemente

guardando il modo in cui è presentata. Essa (forse anche solo

implicitamente) deve avere la forma di una generalizzazione: tutti gli

A sono B. Questo uso del termine «legge» è, in un certo senso, molto

simile a quello fatto nella società. Quando si dice che questa è la

legge s’intende che essa vale per tutti. Chiaramente, vi sono molte

discrepanze tra le leggi della natura e le leggi della società. Queste

ultime sono la convenzione di un gruppo più o meno numeroso di

persone e possono essere infrante o modificate a piacere. Di contro, le

leggi della natura vogliono riflettere i modi in cui funziona il mondo,

i quali, più che imposti, vengono scoperti e sono in massima parte

inviolabili.

Si dovrebbe poter riconoscere le asserzioni legisimili per via della

loro generalità, ma non è così semplice. Come si distinguono le vere

leggi dalle generalizzazioni puramente accidentali? Si considerino gli

esempi seguenti. Il rame puro conduce elettricità. Si tratta di una

legge di natura, una generalizzazione implicita concernente tutti i

campioni di rame, che associa un genere di cosa (il rame) a un certo

comportamento (condurre elettricità). Ma ecco un’altra

generalizzazione che non è una legge: nessun campione di rame puro

supera i cento milioni di chili di massa. È chiaramente generale

perché descrive tutti i campioni di rame e afferma che sono sotto i

cento milioni di chili. Ma questa caratteristica della massa è un

attributo accidentale del rame perché, per quanto ne sappiamo, non

c’è niente, nella sua natura, che ponga limiti alla grandezza dei

campioni.

Si consideri anche la generalizzazione secondo la quale ognuno, in

questa stanza, ha più di dieci anni. Neanche questa è una legge. Essa

identifica un certo genere di oggetti (le persone nella stanza), ma non

è un genere naturale. Non ci sono caratteristiche esclusive di questo

gruppo che siano importanti per come funziona il mondo, e non c’è

alcuna connessione causale tra l’essere nella stanza e l’avere più di

dieci anni come c’è invece tra l’essere elettricamente carico e

l’esercitare una forza su altre cariche. Le cariche elettriche causano la

forza, ma l’essere in questa stanza non causa il fatto che avete un’età.

La generalizzazione sulle età delle persone nella stanza è molto

27

probabile che sia solo un’associazione accidentale. Non è una legge.

Se fosse una legge essa dovrebbe consentirmi di fare predizioni del

tipo: «la prossima persona che entra nella stanza avrà più di dieci

anni». Una tale predizione, tuttavia, non è autorizzata perché l’avere

più di dieci anni era solo una caratteristica circostanziale delle

persone che attualmente sono in questa stanza. La legge di

conduttività del rame, al contrario, autorizza la predizione che il

prossimo pezzo di rame condurrà elettricità. Le leggi sostengono la

predizione; le generalizzazioni accidentali no.

Così, non si può valutare se un’affermazione è una legge

semplicemente controllandone la forma. Dipenderà anche da altre

cose che si sanno della situazione, cioè da altre teorie. Bisogna

immaginarsi in anticipo ciò che è probabile che sia pertinente al

fenomeno in questione. In tal modo la fisica atomica, e quella dello

stato solido, indicano che la struttura atomica, cioè l’identità di un

elemento come il rame, è un probabile fattore della conduttività

elettrica, ma niente associa la natura del rame a una limitazione della

massa di un campione. Nello stesso modo, niente della mia

comprensione della stanza dice che aver più di dieci anni è pertinente

allo starci dentro. La determinazione dell’essere legisimile, come è

stata usata negli esempi precedenti e in generale, si usa nella

descrizione della scienza, è sempre sensibile al contesto teorico in cui

la decisione è presa.

La caratteristica di essere legisimile è, almeno, relativamente

stabile nel tempo. È un’etichetta che non si presume di togliere. Una

volta che è legge, è legge per sempre, o quasi. In effetti, ciò che è

stato valutato legge può cambiare quando cambia la descrizione

teorica accettata del mondo. Se cambiano le teorie di sfondo, quello

che una volta poteva essere stato valutato come una associazione

accidentale potrebbe ora essere inteso come una connessione

pertinente, di tipo legge. Ai tempi di Aristotele, ad esempio,

generalizzare sui modi delle cose nel cielo e sulla terra voleva dire

raggruppare due generi distinti di fenomeni e ogni similarità tra i due

era vista come accidentale e non pertinente alla comprensione del

moto. Dovevano esserci due insiemi di leggi, quelle del moto celeste

e quelle del moto terrestre. Ma da Newton in poi, e dalla scoperta che

ciò che è pertinente al moto non è la distinzione celeste/terrestre ma

semplicemente la proprietà della massa, ha perfettamente senso

generalizzare su tutti gli oggetti in movimento e riguardare tali

28

generalizzazioni come descriventi leggi della natura. Chiaramente, la

lezione che se ne ricava è che, per spiegare un’associazione, si deve

ricorrere alla nozione di accidente solo come ultima risorsa. Ma

quello che qui è importante è proprio rendersi conto che nella scienza

il concetto di legge è descrittivo della generalità e della portata di

un’affermazione, ma non dello status di questa quanto a

dimostrazione. Una legge non è un genere di affermazione

indubitabile, irreprensibile, ultima parola in ogni disputa. Come ogni

altra affermazione interessante della scienza, anche le leggi devono

rispondere alla domanda della giustificazione.

Teorie ipotetiche, leggi ipotetiche

I tre concetti discussi finora, teoria, ipotesi e legge, descrivono lati

diversi delle affermazioni scientifiche e non si escludono l’un l’altro.

Essi rappresentano aspetti diversi delle affermazioni, proprio come

grandezza, colore e forma rappresentano aspetti diversi di un oggetto

fisico e, benché non abbia senso descrivere qualcosa come grande e

piccolo o come quadrato e rotondo, ha invece perfettamente senso

descriverlo come grande e rotondo. Nello stesso modo, non c’è niente

di sciocco o di insensato nel parlare di una legge o di una teoria

ipotetica. Non è una trasgressione della logica del linguaggio.

Ecco in effetti un buon esempio di legge ipotetica, cioè di una

teoria (affermazione su eventi che non sono palesi all’esperienza) che

è sia legisimile (generalizzazione su un genere naturale di oggetto) sia

ipotetica (non ben controllata): si tratta della censura cosmica. La

teoria generale della relatività descrive la curvatura dello spaziotempo come associata alle forze gravitazionali: tanto più appuntita è

la curvatura, tanto maggiore è la forza. Ai punti, chiamati singolarità,

dove la curvatura è così appuntita che lo spazio-tempo, di fatto, si

accartoccia, la forza è talmente elevata da spezzare le particelle

elementari e da perpetuare eventi incompatibili con le nostre teorie

del mondo normale. Secondo la teoria, una siffatta singolarità può

occorrere in natura, ma potrebbe essere circondata da un orizzonte di

eventi, uno scudo causale a senso unico che impedisce sia che noi

vediamo queste alterazioni dell’ordine naturale, sia che esse abbiano

qualche effetto sul mondo al di fuori. Tale è la situazione del buco

nero. È anche possibile, almeno secondo la teoria generale della

relatività, che vi siano singolarità prive di orizzonte degli eventi,

singolarità nude. Così, i cosmologi hanno pensato bene di aggiungere,

29

all’attuale descrizione dell’universo, un’ulteriore affermazione: tutte

le singolarità sono in effetti circondate da orizzonti degli eventi. Il

principio della censura cosmica consiste, appunto, in questo orrore

per la nudità, ma per ora è solo un suggerimento e ciò che, a questo

stadio, viene richiesto non è la credenza istantanea ma un

suggerimento ulteriore su come lo si possa controllare. È, in altre

parole, una teoria ipotetica legisimile.

… il punto, in questa discussione di teorie, leggi e ipotesi, è

duplice. In primo luogo si ha che i tre concetti sono ortogonali:

descrivono aspetti diversi delle affermazioni fatte dagli scienziati.

Un’idea non deve affatto esser promossa dal grado di ipotesi a quello

di teoria e poi ancora a quello di legge. Le leggi, quando si elaborano,

sono ipotetiche e sono, ciò nondimeno (non di più) leggi via via che il

controllo fa sbiadire l’etichetta di ipotetico. E, al tempo stesso, sono

teorie.

In secondo luogo, si ha che «teoria» almeno come è usato qui, è un

termine amplissimo. Non è né elogiativo né peggiorativo. Dato che

tantissime cose sono teorie, è chiaro che procurarsele, cioè scoprirle o

crearle, è relativamente facile. Il difficile è giustificarle e, benché in

giro ve ne possano essere un mucchio, non tutte sono teorie buone:

non tutte autorizzano la nostra credenza.

30

2

SPIEGAZIONE E PREVISIONE

Nel 1° capitolo abbiamo esaminato:

I concetti di teoria, ipotesi, legge

L’aspetto esplicativo e giustificativo del nesso di conseguenza logica

⇓

La dialettica tra questi due aspetti nel confronto tra scienze formali e

scienze empiriche; tra scienza antica e scienza moderna

Nel 2° capitolo esamineremo:

I concetti della spiegazione e della previsione:

1. Spiegazione deterministica

2. Spiegazione probabilistica, ovvero induttivo-statistica

3. Spiegazione e previsione: la tesi di identità

31

2.1 La spiegazione secondo il modello deterministico (covering

law model = modello di copertura) di Hempel

MODELLO ND (NOMOLOGICO-DEDUTTIVO) DI HEMPEL

ESEMPIO:

Legge universale

Condizione

rilevante

Altre condizioni

rilevanti

Conclusione

Se un ago calamitato si trova nelle vicinanze di un conduttore

elettrico percorso da una corrente elettrica, allora l’ago

calamitato subisce uno spostamento

Questo oggetto è un ago calamitato

Si trova nelle vicinanze di un conduttore elettrico e attraverso di

esso passa della corrente elettrica

Dunque questo oggetto subisce uno spostamento

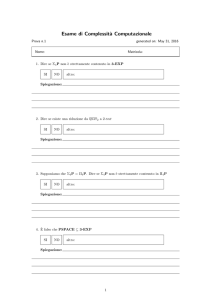

FORMA LOGICA DELL’ESEMPIO:

∀x(Ax → Bx)

Aa

Ba

Legge universale

Condizione rilevante

Conclusione

(explanandum)

SCHEMA GENERALE

Leggi/principi generali

L1 … Ln

Condizioni (particolari)

C1 … Cm

Conclusione

(conseguenza logica)

A

Explanans

Explanandum

32

CONDIZIONI DI ADEGUATEZZA PER LA SPIEGAZIONE

NOMOLOGICO-DEDUTTIVA

Hempel indica quattro condizioni di adeguatezza della spiegazione

N-D, suddivise in logiche ed empiriche.

Condizioni logiche:

C1 L’explanandum deve essere una conseguenza logica

dell’explanans.

C2 L’explanans deve contenere leggi generali, che devono essere

essenziali per la derivazione dell’explanandum.

C3 L’explanans deve avere contenuto empirico, ossia deve essere,

almeno in linea di principio, controllabile empiricamente

Condizione empirica:

C4 Gli enunciati contenuti nell’explanans devono essere veri.

2.2 La spiegazione probabilistica

Con il tempo Hempel si rende conto che non tutte le spiegazioni

scientifiche possono seguire lo schema nomologico deduttivo. Ciò

vale in particolare per le teorie che usano leggi probabilistiche, come

ad esempio la fisica quantistica o la genetica. Ciò lo indusse a

formulare schemi esplicativi non deduttivi, come ad esempio il

modello induttivo statistico.

MODELLO IS (INDUTTIVO-STATISTICO) DI HEMPEL

Legge statistica

Condizione

Conclusione induttiva (non

conseguenza logica

deduttiva)

∀x(al 90%)(Ix → Ax)

(Il 90% degli adulti appartenenti a società industrializzate

sono alfabetizzati)

Ig

(Giovanni è un adulto appartenente a una società

industrializzata)

Ag

Giovanni è alfabetizzato

33

La doppia linea tra le premesse e la conclusione sta a indicare che

non si tratta di un nesso di conseguenza logica. Vale piuttosto che

l’explanans deve rendere l’explanandum altamente probabile,

condizione soddisfatta nell’esempio appena citato, in cui la probabilità

che Giovanni sia alfabetizzato è del 90%. Quanto la spiegazione sia

solida dipende dall’elevatezza della probabilità formulata nella legge

dell’explanans.

In che misura cambiano le condizioni di adeguatezza di I-S rispetto

al modello N-D? C2 e C3 e C4 rimangono inalterate; in C1 al

requisito della conseguenza logica subentra quello della probabilità

induttiva.

La diversità tra N-D e I-S emerge con maggiore chiarezza se

esaminiamo le principali nozioni filosofiche di probabilità.

2.2.1 Due nozioni di probabilità

1. Probabilità soggettiva: la probabilità coincide con il grado di

credenza o di aspettativa.

“La probabilità che domani piova è pari a 0,7” significa secondo

questa interpretazione:

“Il grado in cui una persona X crede (è convinta), sulla base dei dati

metereologici, che domani piova, è pari a 0,7”.

p(a,b) = r significa “il grado di aspettativa di a a partire da b è r”.

2. Probabilità frequentistica o propensionale (entrambe oggettive): la

probabilità coincide con la misura della propensione o frequenza a

verificarsi di un evento.

⇓

A. Frequenza: la probabilità p(a,b) è data dalla frequenza dell’evento

a nella sequenza di eventi b, ove la sequenza b è definita dalle

condizioni che la generano. I lanci di una moneta, ad esempio, che

costituiscono la sequenza degli esiti di testa o croce, sono definiti

dalla condizione di essere lanci eseguiti con una moneta non

truccata, su una superficie piana, in una situazione non turbolenta…

34

B. Propensione: la probabilità è data dalla propensione (disposizione,

tendenza) a verificarsi di un evento in una situazione definita da

determinate condizioni.

In questo caso la probabilità è una proprietà nascosta, che tuttavia

può diventare in certi casi manifesta come frequenza dell’evento nelle

condizioni date.

2.2.2 Probabilità epistemica vs. probabilità ontica

Probabilità epistemica: si dà perché non conosciamo tutte le

condizioni sotto le quali si verificano gli eventi. Questi di per sé sono

determinati, ovvero collegati da una catena di causa ed effetto. Se

fossimo Dio potremmo conoscere ogni nesso di causa ed effetto e

quindi, conoscendo esattamente le condizioni di un evento, potremmo

determinare con un grado assoluto di certezza anche il verificarsi

dell’effetto. In tal modo non ci sarebbe spazio per eventi casuali o

parzialmente casuali.

Probabilità ontica: l’indeterminazione è nella realtà, non dipende

dalla nostra ignoranza.

Si verificano eventi che accadono almeno parzialmente per caso.

SCHEMA RIASSUNTIVO

Probabilità soggettiva

Probabilità oggettiva:

frequentistica

Probabilità oggettiva:

propensionale

Probabilità epistemica

sì

sì

no

Probabilità ontica

no

sì

sì

La probabilità soggettiva è epistemica e non ontica.

La probabilità propensionale è ontica e non epistemica.

La probabilità frequentistica può essere sia l’una sia l’altra.

2.2.3 Che cosa spiego con il modello I-S?

1. Modello I-S con interpretazione soggettiva della probabilità:

35

Spiego l’aspettativa di un soggetto razionale, pari al 90%, che

Giovanni sia alfabetizzato, non spiego il fatto che Giovanni è

alfabetizzato.

2. Modello I-S con interpretazione propensionale della probabilità:

Spiego la propensione di Giovanni – presente al 90% – ad essere

alfabetizzato, non spiego il fatto che Giovanni è alfabetizzato.

3. Modello I-S con interpretazione frequentistica della probabilità:

Spiego la distribuzione statistica dei soggetti alfabetizzati nel

campione (di cui Giovanni è un elemento generico), non il fatto che

Giovanni è alfabetizzato.

Giovanni ha un elevata probabilità di cadere nella classe degli

adulti alfabetizzati, ma nulla di più. Non si può escludere che

Giovanni appartenga al gruppo dei non alfabetizzati.

Spiegare con una legge statistica che Giovanni è alfabetizzato

non è equivalente a spiegare che Giovanni è alfabetizzato: questo

non lo posso spiegare.

⇓

Diversità con il modello N-D

“Ho sostenuto la tesi per cui è sbagliato rivolgersi alla fisica delle

particelle per spiegare un singolo microevento, come, per esempio, la

disintegrazione di un atomo di radon o la riflessione di un fotone: se è

vero che il fotone è andato in una direzione piuttosto che in un’altra

per puro caso, allora, il fatto che il fotone abbia preso una direzione

piuttosto che un’altra è un evento che non può essere spiegato. Ciò che

possiamo spiegare, grazie all’aiuto di una teoria indeterministica sulle

particelle, è perché esisteva una certa probabilità oggettiva che il

fotone prendesse la direzione che poi ha preso (J. Watkins, Science

and Scepticism, p. 246).

36

2.3 Spiegazione e previsione

“Secondo Hempel spiegazione e previsione sono due possibili usi

dello schema nomologico-deduttivo: se conosciamo le leggi e le

condizioni iniziali saremo in grado, deduttivamente, di predire

l’evento. Se viceversa conosciamo già il verificarsi dell’evento ma

vogliamo spiegarlo, dovremo cercare delle leggi e constatare il

verificarsi di condizioni iniziali tali che insieme ci permettano di

dedurre l’evento” (M. Alai, Filosofia della scienza nel Novecento, p.

26).

La tesi appena formulata viene denominata “Tesi di identità

strutturale” o “Tesi di simmetria” e, secondo Hempel, vale sia per le

spiegazioni N-D sia per quelle I-S.

Si è tuttavia obiettato che:

(i) NON SEMPRE LA SPIEGAZIONE È PREVISIONE:

Esempio: teoria dell’evoluzione

(ii) NON SEMPRE LA PREVISIONE È ANCHE SPIEGAZIONE:

Esempio: Si può prevedere il moto delle stelle o la successione

giorno/notte senza saperli spiegare

37

PARTE ANTOLOGICA

C.G. HEMPEL, Aspetti della spiegazione scientifica

Milano 1986, pp. 23-26; 55-59; 70-74

La spiegazione nomologico-deduttiva

Fondamenti: la spiegazione nomologico-deduttiva e il concetto di legge

Nel suo libro, How We Think, John Dewey descrive un fenomeno

osservato un giorno mentre lavava i piatti. Dopo aver tolto alcuni

bicchieri di vetro dalla schiuma dell’acqua calda insaponata e averli

capovolti su un piatto, egli osservò che dagli orli dei bicchieri

fuoriuscivano delle bolle di sapone che aumentavano un po’ di

volume, si arrestavano e quindi si ritraevano nei bicchieri. Perché

accadeva ciò? Dewey delinea la seguente spiegazione: trasferendo i

bicchieri sul piatto, egli aveva racchiuso in essi dell’aria fredda; l’aria

era stata gradualmente riscaldata dal vetro, che inizialmente aveva la

temperatura della schiuma dell’acqua calda insaponata. Ciò aveva

prodotto un aumento del volume dell’aria racchiusa entro i bicchieri e

quindi un’espansione del sottile strato di sapone formatosi tra il piatto

e gli orli dei bicchieri. Il vetro si era, però, gradualmente raffreddato e

così pure l’aria nei bicchieri, per cui le bolle di sapone si erano

ritratte.

Si può considerare la spiegazione qui delineata come

un’argomentazione secondo cui ci si doveva aspettare il fenomeno da

spiegare, il fenomeno explanandum, in virtù di certi fatti esplicativi.

Questi si distinguono in due gruppi (I) fatti particolari e (II) uniformità

esprimibili mediante leggi generali. Il primo gruppo include fatti quali: i

bicchieri erano stati immersi nella schiuma a una temperatura

considerevolmente più elevata di quella dell’aria circostante; erano stati

messi, capovolti, su un piatto sul quale si era formata una poltiglia

d’acqua insaponata che aveva creato un sottile strato di sapone fra il piatto

e gli orli dei bicchieri, e così via. Il secondo gruppo è espresso dalle leggi

sui gas e da altre leggi concernenti la trasmissione di calore fra due corpi

a temperature diverse, il comportamento elastico delle bolle di sapone, e

38

così via. Sebbene alcune di queste leggi siano soltanto accennate

mediante locuzioni come «il riscaldamento dell’aria racchiusa ha prodotto

un aumento della sua pressione», e altre non siano nemmeno menzionate

in questa maniera indiretta, esse sono chiaramente presupposte

nell’affermazione che certe fasi del processo ne hanno prodotte altre

come loro effetti. Se immaginiamo di enunciare in maniera completa le

varie assunzioni esplicative, esplicite o tacite, si può allora considerare la

spiegazione come un argomento deduttivo della forma seguente:

C1, C2, …, Ck

(N-D)

L1, L2, …, Lr

__________

E

Qui, C1, C2, …, Ck sono enunciati descriventi i fatti particolari

addotti; L1, L2, …, Lr sono le leggi generali sulle quali si basa la

spiegazione. Insieme, si dice che questi enunciati formano

l’explanans S, dove si può considerare alternativamente S come

l’insieme degli enunciati esplicativi oppure come la loro

congiunzione. La conclusione E dell’argomento è un enunciato

descrivente il fenomeno-explanandum; chiamo E l’enunciatoexplanandum o asserto-explanandum; la parola «explanandum» da

sola viene impiegata per designare o il fenomeno-explanandum o

l’enunciato-explanandum; risulterà dal contesto quale dei due viene

designato.

Il tipo di spiegazione la cui struttura logica è indicata dallo schema

(N-D) viene chiamata spiegazione nomologico-deduttiva o

spiegazione N-D per brevità; in quanto essa effettua la sussunzione

deduttiva dell’explanandum sotto principi aventi carattere di leggi

generali. In tal modo, la spiegazione N-D risponde alla domanda

«Perché si è verificato il fenomeno-explanandum?» mostrando che il

fenomeno è derivato da certe particolari circostanze, specificate in C1,

C2 …, Ck, in conformità con le leggi L1, L2, …, Lr. Indicando ciò,

l’argomento mostra che, date le particolari circostanze e le leggi in

questione, ci si doveva aspettare il verificarsi del fenomeno ed è in

questo senso che la spiegazione ci mette in grado di comprendere

perché il fenomeno si è verificato.

39

In una spiegazione N-D l’explanandum è, dunque, una

conseguenza logica dell’explanans. Inoltre, il fatto di essere basata su

leggi generali è un requisito essenziale per la spiegazione N-D; è in

virtù di tali leggi che i fatti particolari menzionati nell’explanans

acquistano una rilevanza esplicativa nei confronti del fenomenoexplanandum. Così, nel caso delle bolle di sapone di Dewey, il

graduale riscaldarsi dell’aria fredda rinchiusa entro i bicchieri caldi

costituirebbe un antecedente meramente accidentale, anziché un

fattore esplicativo dello sviluppo delle bolle, se non ci fossero le leggi

sui gas a connettere i due eventi. Ma che dire nel caso in cui

l’enunciato-explanandum E di un argomento della forma (N-D) è una

conseguenza logica dei soli enunciati C1, C2, …, Ck? È certo, allora,

che non si richiede alcuna legge empirica per dedurre E

dall’explanans, e che qualsiasi legge inclusa in quest’ultimo risulta

una premessa gratuita, dispensabile; in questo caso, però, l’argomento

non varrebbe come spiegazione. Ad esempio, è chiaro che

l’argomento:

Le bolle di sapone si sono dapprima dilatate e sono poi rientrate

----------------------------------------------------------------------------Le bolle di sapone dapprima si sono dilatate

sebbene valido dal punto di vista deduttivo, non può valere come

spiegazione del perché le bolle si sono dapprima dilatate. La stessa

osservazione vale in tutti gli altri casi di questo tipo. Una spiegazione

N-D deve contenere nel suo explanans alcune leggi generali che sono

necessarie per la deduzione dell’explanandum – la cui obliterazione

invaliderebbe cioè l’argomento.

Se l’explanans di un dato argomento N-D è vero, se, cioè, la

congiunzione dei suoi enunciati costitutivi è vera, diciamo che la

spiegazione è vera; una spiegazione vera ha, naturalmente, anche un

explanandum vero. Diciamo, poi, che una spiegazione N-D è più o

meno fortemente sostenuta o confermata dall’evidenza data a seconda

che il suo explanans sia più o meno fortemente confermato da tale

evidenza … Intendiamo, infine, per spiegazione N-D potenziale

qualsiasi argomento avente il carattere di una spiegazione N-D tranne

che per il fatto che non è necessario che gli enunciati che

costituiscono il suo explanans siano veri. In una spiegazione

potenziale N-D, perciò, L1, L2, …, Lr, sono quelli che Goodman

40

chiama enunciati legisimili, cioè enunciati che sono simili a leggi

tranne che per il fatto di poter essere falsi. Enunciati di questo genere

verranno detti anche nomici o nomologici. Usiamo la nozione di

spiegazione potenziale, ad esempio, quando ci domandiamo se una

legge o una teoria non ancora controllata potrebbe fornire una

spiegazione di qualche fenomeno empirico, o quando diciamo che la

teoria del flogisto, sebbene sia ora respinta, offriva una spiegazione di

certi caratteri della combustione. A rigore, soltanto gli enunciati

legisimili veri possono valere come leggi – nessuno sarebbe disposto

a parlare di leggi di natura false. Ma, per comodità, userò talvolta il

termine «legge» senza per questo implicare che l’enunciato in

questione è vero, come ho in effetti già fatto nell’enunciato

precedente …

La spiegazione come previsione potenziale È presumibile che,

essendo basata essenzialmente su leggi e principi teorici, la

spiegazione N-D manifesti una stretta affinità con la previsione

scientifica; infatti, leggi e principi teorici, enunciando asserzioni

generali, comprendono casi non ancora esaminati e contengono

implicazioni definite per essi.

L’affinità in questione è vividamente illustrata nella quarta

giornata dei Discorsi e Dimostrazioni Matematiche intorno a Due

Nuove Scienze. In quest’opera, Galileo formula le leggi sul moto dei

proiettili e ne deduce il corollario che, se si sparano i proiettili dal

medesimo punto con velocità iniziale uguale ma con angolazioni

diverse, la gittata massima viene raggiunta quando l’angolazione è di

45°. Galileo fa allora osservare a Sagredo: «Già sapevo io, per fede

prestata alle relazioni di più bombardieri, che di tutti i tiri di volata

dell’artiglieria, o del mortaro, il massimo, cioè quello che in maggior

lontananza caccia la palla, era il fatto all’elevazione di mezo angolo

retto, che essi dicono del sesto punto della squadra; ma l’intender la

cagione onde ciò avvenga, supera d’infinito intervallo la semplice

notizia auta dalle altrui attestazioni, ed anco da molte replicate

esperienze».

Il ragionamento che fornisce questa comprensione si può

esprimere facilmente nella forma N-D; essa consiste in una deduzione

del corollario, effettuata con mezzi logici e matematici, da un insieme

di premesse contenente (I) le leggi fondamentali della teoria del moto

dei proiettili di Galileo e (II) enunciati particolari – che specificano

che tutti i missili considerati vengono sparati dal medesimo punto con

41

uguale velocità iniziale. È chiaro, dunque, che si spiega e quindi si

comprende in questo caso il fenomeno osservato dagli artiglieri

mostrando che il suo verificarsi era prevedibile nelle circostanze

specificate in considerazione di certe leggi generali incluse nella

teoria di Galileo. E lo stesso Galileo richiama con evidente orgoglio

l’attenzione sulle previsioni che si possono ottenere, in modo analogo,

deducendole dalle sue leggi; queste ultime implicano «quello che

forse per l’esperienza non è stato osservato: e questo è, che degli altri

tiri, quelli sono tra di loro eguali, le elevazioni de i quali superano o

mancano per angoli eguali dalla semiretta». In tal modo, 1a

spiegazione fornita dalla teoria di Galileo «apre l’intelletto a

‘ntendere ed assicurarci d’altri effetti senza bisogno di ricorrere alle

esperienze», ossia mediante la sussunzione deduttiva sotto le leggi

sulle quali si basa la spiegazione.

Il controllo delle previsioni così derivate dalle leggi generali o dai

principi teorici addotti in una spiegazione è un modo rilevante di

controllare tali generalizzazioni «di copertura», e un esito favorevole

può conferire loro un forte sostegno. Consideriamo, ad esempio, la

spiegazione data da Torricelli di un fatto che aveva lasciato perplesso

il suo maestro Galileo, e cioè che una pompa che aspira acqua da un

pozzo non solleva l’acqua a più di 13 metri circa sulla superficie del

pozzo. Per rendere ragione di questo fenomeno, Torricelli avanzò

l’idea che l’aria sopra l’acqua ha un peso e, quindi, esercita una

pressione sull’acqua nel pozzo, spingendola in alto nel cilindro della

pompa quando il pistone è sollevato, perché non c’è aria all’interno a

bilanciare la pressione esterna. Secondo tale supposizione, l’acqua

può innalzarsi soltanto fino al punto in cui la sua pressione sulla

superficie del pozzo eguaglia la pressione dell’aria esterna su tale

superficie, e quest’ultima è perciò uguale a quella di una colonna

d’acqua alta approssimativamente 13 metri.

La forza esplicativa di questo resoconto deriva dalla concezione

che la terra è circondata da un «mare d’aria», concezione conforme

alle leggi fondamentali che governano l’equilibrio dei liquidi nei vasi

comunicanti. E poiché la spiegazione di Torricelli presupponeva tali

leggi generali, produsse previsioni relative a fenomeni non ancora

esaminati. Una di queste era che, se l’acqua fosse stata sostituita con

mercurio, il cui peso specifico è all’incirca 14 volte quello dell’acqua,

l’aria avrebbe dovuto controbilanciare una colonna di all’incirca m.

13/14, o di lunghezza un po’ inferiore ai m. 0,928. Questa previsione

42

fu confermata da Torricelli con il classico esperimento che porta il

suo nome. Inoltre, la spiegazione proposta implica che, a altitudini

crescenti sul livello del mare, la lunghezza della colonna di mercurio

sostenuta dalla pressione dell’aria dovrebbe diminuire in quanto

diminuisce il peso dell’aria che la controbilancia. Un’accurata

verifica di questa previsione fu effettuata su suggerimento di Pascal

soltanto alcuni anni dopo che Torricelli aveva presentato la sua

spiegazione: il cognato di Pascal portò un barometro a mercurio

(ossia, in sostanza, una colonna di mercurio controbilanciata dalla

pressione dell’aria) sulla cima del Puy-de-Dòme, misurando la

lunghezza della colonna a diverse altitudini nel corso della salita e

della discesa; le registrazioni risultarono meravigliosamente conformi

alla previsione.

Le inferenze mediante le quali si ottengono tali previsioni hanno

ancora una forma nomologico-deduttiva: le premesse includono le

leggi esplicative in questione (nel nostro ultimo esempio, l’ipotesi di

Torricelli in particolare) e certi enunciati su fatti particolari (ad

esempio, che un barometro avente una struttura così e così viene

portato sulla cima di una montagna). Designiamo gli argomenti

predittivi della forma (N-D) come previsioni N-D. Nella scienza

empirica, molti argomenti predittivi sono di questo tipo. Tra gli

esempi più evidenti vi sono le previsioni, basate sui principi della

meccanica celeste e dell’ottica, concernenti le posizioni relative del

Sole, della Luna e dei pianeti in un dato istante, e le eclissi solari e

lunari …

Siccome nella spiegazione N-D, completamente enunciata, di un

particolare evento l’explanans implica logicamente l’explanandum,

possiamo dire che l’argomento esplicativo avrebbe potuto essere

impiegato come previsione deduttiva dell’evento-explanandum se le

leggi e i fatti particolari addotti nel suo explanans fossero stati noti e

fossero stati presi in considerazione in un tempo anteriore

appropriato. In questo senso, una spiegazione N-D è una previsione

N-D potenziale.

Questa tesi era già stata formulata in un articolo scritto da

Oppenheim e da me, dove aggiungevamo che la spiegazione

scientifica (nomologico-deduttiva) differisce dalla previsione

scientifica non nella struttura logica, ma per certi aspetti pragmatici.

Nel primo caso, è noto che l’evento descritto nella conclusione si è

verificato, e vengono ricercate appropriate asserzioni di leggi generali

43

e di fatti particolari che rendano ragione di esso; nel secondo, tali

asserzioni sono date e l’asserto circa l’evento in questione è da esse

derivato in un tempo anteriore a quello del suo presunto verificarsi.

Questa concezione, talvolta denominata tesi dell’identità strutturale

(o della simmetria) di spiegazione e previsione, è stata recentemente

messa in discussione …

La spiegazione statistica

Leggi di forma statistica. Passiamo ora ad esaminare le

spiegazioni basate su asserti nomologici di un tipo che non abbiamo

ancora considerato, le quali hanno finito per giocare un ruolo di

crescente rilievo nella scienza empirica. Le indicherò qui come leggi

o principi teorici di forma statistico-probabilistica, o, per brevità,

come leggi statistiche.

La maggior parte della nostra analisi verterà sull’uso esplicativo di

leggi statistiche di un tipo molto semplice, che chiameremo leggi di

forma statistica fondamentale. Si tratta di asserti affermanti che la

probabilità statistica che un evento di tipo F sia anche di tipo G è r;

ossia, per brevità:

p (G, F)= r

Questo enunciato asserisce, grosso modo, che a lungo andare la

percentuale di esempi di F che sono anche esempi di G è approssimativamente r …

Per esempio, l’asserto affermante che il lancio di un dado lievemente

irregolare (evento di tipo F) fa uscire un asso (evento di tipo G) con una

probabilità di 15, cioè nel 15 per cento circa di tutti i casi a lungo andare,

ha questa forma statistica fondamentale. E così pure la legge che il tempo

di dimezzamento del radon è di 3,8.2 giorni, cioè che la probabilità

statistica che un atomo di radon si disintegri durante un qualsiasi periodo

dato di 3,82 giorni è 1/2, il che significa, grosso modo, che pressoché la

metà degli atomi presenti in un campione di radon contenente un gran

numero di atomi decade entro 3,82 giorni.

Le leggi di forma statistica fondamentale possono considerarsi come

controparti meno rigorose delle leggi di forma condizionale universale

(x) (Fx ⊃ Gx)

44

asserenti che qualsiasi esempio di F è un esempio di G, quale: «Ogni

gas si espande quando viene riscaldato a pressione costante». In

realtà, i due tipi di legge condividono un’importante proprietà che è

sintomatica del loro carattere nomologico: entrambe fanno

affermazioni generali circa una classe di casi che si potrebbe

considerare potenzialmente infinita. Come abbiamo precedentemente

osservato, un asserto che è logicamente equivalente a una

congiunzione finita di enunciati singolari e che, in questo senso, fa

un’affermazione relativa solo a una classe finita di casi, non si

considera una legge ed è sprovvisto della forza esplicativa di un

asserto nomologico. Gli enunciati legisimili, sia veri che falsi, non

sono soltanto dei compendi opportunamente connessi di insiemi finiti

di dati relativi a casi particolari.

Ad esempio, la legge che i gas si espandono quando vengono

riscaldati a pressione costante non equivale all’enunciato che in tutti gli

esempi finora osservati, o forse in tutti gli esempi finora occorsi, un

aumento della temperatura di un gas a pressione costante è stato

accompagnato da un aumento di volume. Essa asserisce, piuttosto, che un

aumento di volume è associato col riscaldamento di un gas a pressione

costante in qualsiasi caso, passato, presente o futuro, indipendentemente

dal fatto che lo si sia effettivamente osservato o meno. Essa implica anche

condizionali controfattuali e condizionali congiuntivi affermanti che se

una certa quantità di gas fosse stata riscaldata o dovesse essere riscaldata

a pressione costante sarebbe aumentato, o aumenterebbe, anche il suo

volume.

Analogamente, le leggi probabilistiche della genetica e del

decadimento radioattivo non equivalgono a resoconti descrittivi delle

frequenze con le quali si constata che alcuni tipi di fenomeni

occorrono entro una classe finita di casi osservati: esse affermano

certe modalità peculiari, ossia probabilistiche, di connessione tra

classi potenzialmente infinite di occorrenze. In una legge statistica di

forma fondamentale, in quanto distinta da una descrizione statistica

che specifica le frequenze relative in qualche insieme finito, non si

assume che la «classe di riferimento» F sia finita. In effetti, potremmo

dire che una legge della forma «p (G, F) = r» si riferisce non solo a

tutti gli esempi effettivi di F, ma, per così dire, alla classe di tutti i

suoi esempi potenziali. Supponiamo, ad esempio, di avere un

tetraedro regolare omogeneo le cui facce siano contrassegnate da «I»,

«II», «III», «IV». Potremmo allora asserire che la probabilità di

45

ottenere un III, cioè la probabilità che il tetraedro si posi su quella

faccia dopo esser stato lanciato da una scatola di dadi, è 1/4. Ma

benché questa asserzione dica qualcosa sulla frequenza con la quale si

ottiene un III come risultato del lancio del tetraedro, non la si può

interpretare come se specificasse semplicemente quella frequenza per

la classe di tutti i lanci che sono stati di fatto effettuati con il

tetraedro. Potremmo, infatti, continuare a mantenere la nostra ipotesi

anche se venissimo informati del fatto che il tetraedro è stato