B. Chiandotto

Statistica per le decisioni

Calcolo delle Probabilità

Versione 2006

CAP. 2 – CALCOLO DELLE PROBABILITA’

2.1 Alcuni concetti base

Il calcolo delle probabilità, nato nel contesto dei giochi d’azzardo, si è sviluppato

teoricamente fino ad assumere un ruolo particolarmente rilevante nell’analisi dei fenomeni collettivi

diventando presupposto essenziale della teoria delle decisioni e della statistica. La teoria delle

probabilità è una disciplina matematica astratta e altamente formalizzata pur conservando il suo

originale e rilevante contenuto empirico; per questa sua particolare natura l’esposizione,

necessariamente sommaria, dei suoi contenuti risulta facilitata dall’introduzione di definizioni

esplicite relative agli aspetti e concetti che ne costituiscono il corpo.

Definizione 1: Si dice esperimento casuale, ogni operazione o attività (fenomeno) il cui risultato

(la cui manifestazione) non può essere previsto con certezza.

Risulta chiaro che il termine esperimento va qui inteso in senso lato, comprendendo in esso,

sia il caso del lancio di un dado, sia il caso dell'estrazione di una pallina da un'urna, sia il caso della

rilevazione dei pesi dei coscritti alla leva, sia quello dell’esito di una operazione chirurgica, sia il

caso della sperimentazione di un nuovo farmaco, sia quello del controllo dei pezzi prodotti da un

certo macchinario ecc.

Definizione 2: Si dice spazio campionario di un esperimento casuale, l'insieme Ω di tutti i

possibili risultati, esaustivi e mutualmente escludentesi, dell'esperimento stesso.

Se l'esperimento casuale consiste nel lancio di una moneta a due facce, lo spazio campionario

è dato da

Ω = {T, C} = {ω1 , ω 2 }

dove T = ω1 è il punto campionario testa e C = ω 2 è il punto campionario croce.

In questo esempio si è assunto (come si fa di solito) che gli unici risultati possibili siano T e

C, e che quindi la moneta non possa rimanere in equilibrio sul bordo. Se invece si ipotizza che

anche questo risultato sia possibile, allora lo spazio campionario di questo esperimento casuale è

Ω = {T, C, B}= {ω1 , ω 2 , ω 3 }

1

B. Chiandotto

Statistica per le decisioni

Calcolo delle Probabilità

Versione 2006

dove B è il punto campionario “moneta in equilibrio sul bordo”.

Una situazione analoga al lancio della moneta si ha nel caso in cui l'esperimento casuale sia

l’esito di una operazione di finanziamento di una banca ad una impresa cliente, i cui risultati

possibili sono la restituzione o meno del finanziamento concesso da parte dell’impresa. In tal caso

infatti lo spazio campionario Ω è dato da

Ω = {R, NR}= {ω1 , ω 2 }

dove R è il punto campionario finanziamento restituito e NR il punto campionario finanziamento

non restituito.

Se l'esperimento si svolge attraverso il controllo dei pezzi prodotti da un certo macchinario

avendo come finalità l'accertamento della bontà o difettosità del pezzo prodotto, lo spazio

campionario Ω sarà composto dai soli due elementi (punti campionari) ω 1 e ω 2 , dove ω 1

rappresenta il pezzo difettoso ed ω 2 il pezzo non difettoso.

Se l'esperimento casuale consiste nell'estrazione di un numero al lotto, lo spazio campionario

è dato da

Ω = {1, 2, …, 90}= {ω1 , ω 2 ,....., ω 90 }

costituito, come è ovvio, da tutti i numeri interi da 1 a 90.

Se l'esperimento consiste nell'estrazione di una pallina da un'urna che ne contiene n identiche

a meno del numero progressivo, da 1 a n, sopra impresso, lo spazio campionario resta definito da

Ω =(ω1 ,ω2 ,...,ωi ,...,ωn )

dove ω i (i=1, 2,...,n) sta ad indicare il punto campionario costituito dalla estrazione della pallina

contrassegnata con il numero i .

Se l’esperimento casuale consiste nel contare il numero di accessi ad un certo sito internet i

oppure nel contare il numero massimo di battiti cardiaci durante un test di sforzo, lo spazio

campionario è dato da

Ω = {0, 1, 2, …}= {ω1 , ω 2 ,.....}.

cioè da tutti i numeri interi non negativi, dato che il numero di difetti è un numero intero e non è

possibile stabilire a priori il numero massimo.

Se l'esperimento casuale consiste nel test di durata di un pneumatico, lo spazio campionario è

costituito da

Ω = {0 - +∞},

2

B. Chiandotto

Statistica per le decisioni

Calcolo delle Probabilità

Versione 2006

cioè da numeri reali non negativi, dato che la durata è un numero che non può essere negativo (il

tempo, come segnalato nel primo capitolo, viene espresso con una scala di rapporto); si segnala in

proposito che l’estremo superiore pari a +∞ sta ad indicare che non è possibile stabilire la durata

massima che, ovviamente, non potrà essere infinita.

Riepilogando, allora, lo spazio campionario è l’insieme dei risultati possibili dell’esperimento

campionario considerato.

Dagli esempi riportati risulta che lo spazio campionario può essere costituito da un numero

finito di punti campionari (come nel caso del lancio della moneta, dei pezzi buoni/difettosi, delle

palline estratte da un’urna), oppure da un’infinità numerabile di punti campionari (come nel caso

del numero di accessi ad un sito internet), o infine da un’infinità non numerabile di punti

campionari (come nel caso del test di durata di un pneumatico).

Definizione 3: Se lo spazio campionario è costituito da un numero finito o da un’infinità

numerabile di punti campionari, si dice evento ogni sottoinsieme E dello spazio

campionario Ω. Se lo spazio campionario è costituito da un’infinità non numerabile

di punti, non tutti i possibili sottoinsiemi di Ω sono eventi; in questa sede verranno,

comunque, considerati soltanto i cosidetti sottoinsiemi ammissibili di Ω, cioè i

sottoinsiemi che hanno natura di eventi.

Ogni evento sarà pertanto costituito da un insieme di punti campionari. Se, ad esempio, si fa

riferimento al caso dell'estrazione di una pallina da un'urna che ne contiene n, si può pensare di

suddividere l'intero spazio campionario in due sottospazi Ω1 ed Ω2 contenenti, rispettivamente, i

punti campionari: a) presentarsi di una pallina contrassegnata da un numero dispari; b) presentarsi

di una pallina contrassegnata con un numero pari.

L'evento

E = ( ω : ωi per i pari o dispari) = (ω1 , ω 2 ,...,ω i ,..., ω n ) = Ω

coincide con l'intero spazio e rappresenta l'evento certo; l'evento cioè che certamente si realizzerà

in quanto effettuando l'estrazione è certo che si presenterà una pallina o contrassegnata con un

numero dispari o contrassegnata con un numero pari.

L'evento

E = ( ω : ω i per i pari e dispari)

3

B. Chiandotto

Statistica per le decisioni

Calcolo delle Probabilità

Versione 2006

è un evento che non contiene punti campionari; infatti ogni pallina è contrassegnata o da un

numero dispari o da un numero pari e non esiste pallina contrassegnata da un numero che è dispari e

pari allo stesso tempo.

L'evento così definito viene detto evento impossibile (si tratta dell'evento che non si potrà

mai realizzare) e denotato con il simbolo φ .

Gli eventi

Ei = (ωi) , per i = 1,2,…,n, vengono detti eventi elementari in quanto costituiti

da un solo punto campionario.

Sugli eventi si può introdurre un'algebra, cioè un insieme di operazioni che soddisfano certe

proprietà e che generano, come risultato delle operazioni stesse, ancora degli eventi, cioè elementi

che appartengono all’insieme B sui quali è stata introdotta l’algebra e si parla di sistema chiuso

rispetto alle operazioni introdotte. Se il sistema è chiuso rispetto ad un numero finito di operazioni,

si parla di algebra di Boole o, più semplicemente, di algebra o campo, se il sistema è chiuso rispetto

ad un’infità numerabile di operazioni, si parla di algebra di Boole completa o, più semplicemente, di

σ-algebra o σ-campo.

L’insieme B, che può anche essere definito come spazio degli eventi, è un insieme chiuso

rispetto alle operazioni di negazione e di intersezione (e quindi anche rispetto all’unione e alla

differenza che possono essere derivate dalle precedenti).

Il lettore a conoscenza dei rudimenti della teoria degli insiemi noterà come quanto esposto in

queste note, riguardo agli eventi, non rappresenta alcunché di nuovo o di diverso rispetto al già

conosciuto; in effetti gli eventi possono essere interpretati come insiemi, o meglio, come

sottoinsiemi di un insieme dato rappresentato dallo spazio campionario Ω. Si ha così che l'evento

certo Ω (coincidente con l'intero spazio campionario) non rappresenta altro che l'insieme universale,

mentre l'evento impossibile ø corrisponderà all'insieme vuoto.

4

B. Chiandotto

Statistica per le decisioni

Calcolo delle Probabilità

Versione 2006

2.2 Algebra degli eventi

Le operazioni proprie della teoria degli insiemi sono quella di prodotto o intersezione (∩),

quella di somma o unione (∪), quella di complementazione o negazione E e quella di differenza

(-); si tratta delle stesse operazioni che, oltre al concetto di inclusione, verranno qui considerate in

quanto costituenti parte essenziale dell'algebra degli eventi.

Si dice che un evento E1 è incluso nell'evento E2, e si scrive E1 ⊆ E2 se ogni punto

campionario appartenente ad E1 appartiene anche ad E2. Due eventi E1 ed E2 sono, quindi, uguali se

e solo se (sse) contemporaneamente

E1 ⊆ E2

E1 ⊇ E2

ed

in questo caso i due eventi saranno costituiti dagli stessi punti campionari.

Si definisce come negazione (complementazione nella teoria degli insiemi) di un evento E, e

si scrive E , l'evento che si realizza quando non si realizza E. L'evento E sarà pertanto, costituito

da tutti i punti campionari di Ω che non appartengono ad E.

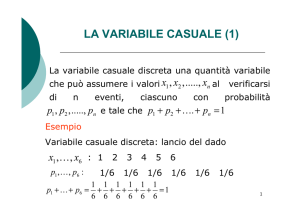

Nella figura sottostante vengono proposti graficamente (facendo ricorso ai cosidetti

diagrammi di Venn) il concetto di evento incluso e di evento negato.

Ω

E1

E2

E2

Fig. 4 - Diagrammi di Venn per l’inclusione e la negazione dove il quadrato rappresenta l’intero

spazio campionario Ω e E1 ⊂ E2 .

L'intersezione tra due eventi E1 ed E2 è l'evento E3 = E1 ∩ E2 che si realizza quando si

realizzano entrambi gli eventi E1 ed E2 e che resta definito dai punti campionari che appartengono

sia ad E1 sia ad E2.

5

B. Chiandotto

Statistica per le decisioni

Calcolo delle Probabilità

Versione 2006

L'unione tra due eventi E1 ed E2 è l'evento E4 = E1 ∪ E2 che resta definito da tutti i punti

campionari che appartengono ad E1 o ad E2 o ad entrambi gli eventi E1 ed E2 .

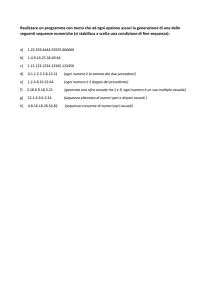

La rappresentazione grafica tramite i diagrammi di Venn delle due operazioni (intersezione ed

unione) è riportata nella figura sottostante

Ω

Ω

E3

E1

E2

E1

E2

E4

Fig. 5 - Diagrammi di Venn per l’intersezione e l’unione dove il tratteggio vuole evidenziare

rispettivamente, l’evento E3 , nella prima figura e l’evento E4 nella seconda figura.

La differenza fra due eventi E1 ed E2 l'evento E5 = E1- E2 che risulta costituito dai punti

campionari che appartengono ad E1 ma non a E2.

Si noti che una volta introdotte le operazioni di negazione ed intersezione (operazioni base

dell’algebra di Boole) si potrebbe fare a meno d'introdurre le due ulteriori operazioni di unione e di

differenza non essendo queste ultime operazioni concettualmente nuove; infatti:

E1 ∪ E 2 = (E1 ∩ E 2 )

E1 − E 2 = (E1 ∩ E 2 )

La relazione E1 ∪ E 2 = (E1 ∩ E 2 ) e la relazione duale E1 ∩ E 2 = (E1 ∪ E 2 ) non sono altro che

la formulazione tramite la simbologia relativa alla teoria degli insiemi delle leggi di de Morgan, già

incontrate nel precedente capitolo.

L'introduzione di queste due ultime operazioni è giustificata dalla semplificazione, sia formale

sia operativa, che esse comportano.

Due eventi E1 e E2 si dicono incompatibili se la loro intersezione dà luogo all'evento

impossibile

6

B. Chiandotto

Statistica per le decisioni

Calcolo delle Probabilità

Versione 2006

E1 ∩ E2 = φ

si tratta di eventi che non hanno elementi (punti campionari) comuni.

A questo punto risulta facile verificare le relazioni seguenti, dove il simbolo ⇒ rappresenta la

relazione di implicazione (dalla prima relazione deriva necessariamente - è implicata - la seconda

relazione):

E1 ⊂ E2 => E1 ∩ E2 = E1

E1 ⊂ E2 => E1 ∪ E2 = E2

φ =Ω

Ω= φ

φ ⊂E⊂Ω

E∩ φ = φ

E∩Ω=E

E∪ φ =E

E∪Ω=Ω

E∩ E =φ

E∪ E =Ω

E1 ⊂ (E1 ∪ E2)

(E1 ∩ E2) ⊂ E1

E2 ⊂ (E1 ∪ E2)

(E1 ∩ E2) ⊂ E2

Un ulteriore e rilevante concetto è quello di condizionamento degli eventi. L'evento E1/E2 (e

si legge l'evento E1 condizionato dall'evento E2 o, più semplicemente, l'evento E1 dato E2) va

analizzato presupponendo già verificato l'evento condizionante E2. Il condizionamento degli eventi

si risolve, praticamente, in una sorta di ridefinizione dello spazio campionario che da Ω si

trasforma nell'evento condizionante, o, ancora meglio, è l'evento condizionante che assume la

natura di spazio campionario di riferimento.

7

B. Chiandotto

Statistica per le decisioni

Calcolo delle Probabilità

Versione 2006

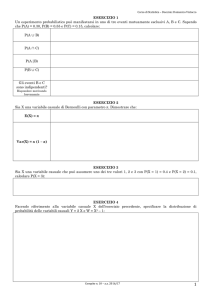

Ω

E1

E2

Fig. 6 - Ridefinizione degli spazi per eventi condizionati

Se si considera l'evento condizionato E1/E2 non solo E2 si trasforma in Ω ma anche l'evento

E1 si trasforma nell'evento E1 ∩ E2, in quanto, sapendo che l'evento E2 si è verificato perdono di

rilevanza tutti i punti campionari che pur appartenendo ad E1 non appartengono ad E2.

Le operazioni di unione e di intersezione possono, naturalmente, essere applicate anche a k

(>2) eventi. L'intersezione fra k eventi E1,E2,….,Ek fornisce come risultato l'evento E

k

E = E 1 ∩ E 2 ∩ ... ∩ E k = ∩ E i

i =1

che contiene tutti i punti campionari ω i comuni ai k eventi E1,E2,….,Ek; mentre, l'unione tra gli

stessi k eventi dà come risultato l'evento E

E = E1 ∪ E2 ∪ ... Ek =

k

∪ Ei

i=1

che contiene tutti i punti campionari ωi che appartengono ad almeno uno degli eventi Ei.

Le operazioni di unione e di intersezione soddisfano la proprietà associativa e quella

distributiva

E1 ∩ E2 ∩ E3 = (E1 ∩ E2) ∩ E3 = E1 ∩ (E2 ∩ E3)

E1 ∪ E2 ∪ E3 = (E1 ∪ E2) ∪ E3 = E1 ∪ (E2 ∪ E3)

E1 ∩ (E2 ∪ E3) = (E1 ∩ E2) ∪ (E1 ∩ E3)

E1 ∪ (E2 ∩ E3) = (E1 ∪ E2) ∩ (E1 ∪ E3)

Le due ultime proprietà (distributive) per k eventi danno

8

B. Chiandotto

Statistica per le decisioni

Calcolo delle Probabilità

Versione 2006

k

E ∩ (E1 ∪ E2 ∪...∪ Ek) = E ∩ ( ∪ Ei) =

i=1

k

k

∪ (E ∩ Ei)

i=1

E ∪ (E1 ∩ E2 ∩...∩ Ek) = E ∪ ( ∩ Ei ) =

i=1

k

∩

i=1

(E ∪ Ei)

Relativamente agli esperimenti casuali più semplici non s'incontrano, usualmente, difficoltà

nell'individuazione e nella successiva enumerazione dei punti campionari che ne costituiscono i

possibili risultati. In esperimenti più complessi possono risultare di notevole ausilio alcune formule

combinatorie (richiamate sinteticamente nell’Appendice 1 al capitolo) che facilitano notevolmente

l'enumerazione dei punti campionari, cioè l'esatta definizione dello spazio campionario.

9

B. Chiandotto

Statistica per le decisioni

Calcolo delle Probabilità

Versione 2006

2.3 Concetto di Probabilità

Definizione 4: Si dice probabilità di un evento, la funzione a valori reali P(E), definita sulla

classe dei sottoinsiemi ammissibili (eventi) dello spazio campionario che soddisfa

specifiche proprietà.

I concetti (primitivi) prova o esperimento casuale, evento e probabilità introdotti sono legati

fra loro dalla seguente frase: "l'esperimento genera l'evento con una certa probabilità". Dove,

naturalmente, la probabilità va intesa come misura applicata agli eventi quando viene condotto un

esperimento casuale.

I tre concetti primitivi sono posti a base della definizione assiomatica di probabilità. Si

tratta di una definizione che non ha sollevato obiezioni sostanziali da parte degli studiosi dopo la

sua formulazione da parte di Kolmogorov. Si tratta infatti di una definizione che si preoccupa di

precisare e chiarire soltanto i contenuti sintattici sui quali è più facile trovare l'accordo. Ma se da un

lato il cosiddetto approccio assiomatico-formale alla probabilità presenta indubbi vantaggi, sia in

termini di accettabilità che di sviluppo della teoria, dall'altro lato il considerare i soli aspetti formali

esclude ogni operatività della definizione stessa in quanto non consente la derivazione numerica

della probabilità nei singoli casi concreti.

Quando si vuol far ricorso alla probabilità per risolvere problemi reali si dovrà, quindi, fare

necessariamente ricorso ad altre definizioni nelle quali l'aspetto semantico viene privilegiato.

Prima di trattare della definizione assiomatica di probabilità conviene, pertanto, introdurre

altre definizioni. Tra le innumerevoli definizioni proposte in letteratura, in questa sede se ne

presentano soltanto tre: la definizione classica, quella frequentista o statistica e la definizione

soggettiva. Si tratta delle tre definizioni non assiomatiche della probabilità più note ed alle quali si

fa più spesso riferimento in pratica; tutte e tre le definizioni soddisfano ai postulati posti a base della

definizione assiomatica di probabilità.

2.3.1 Definizione classica (a priori) della probabilità

La probabilità P(E) di un evento E è data dal rapporto tra il numero n E dei casi favorevoli al

verificarsi dell'evento e il numero n dei casi possibili, purché tutti i casi siano egualmente possibili

10

B. Chiandotto

Statistica per le decisioni

Calcolo delle Probabilità

Versione 2006

P( E ) =

n E numerodeicasi favorevoli

=

n

numerodeicasi possibili

Esempio 2.1

L’azienda Lance Clothiers produce un’ampia varietà di vestiti da uomo, tra cui camicie. Una

volta prodotte, le camicie vengono ripiegate e impacchettate automaticamente da 10 macchine

designate appositamente a tale scopo e, una volta raccolto il risultato di ciascuna macchina in

cartoni, vengono spedite cliente. A seguito di un’ispezione di routine si scopre che una di queste 10

macchine non è messa a punto adeguatamente e, conseguentemente, crea degli strappi in ogni

camicia sottoposta al processo di ripiegatura e impacchettamento. Appena prima di questa

ispezione, è stata inviata, a 100 clienti diversi, una spedizione di 100 pacchi di camicie tra cui 10

provenienti dal macchinario difettoso. Qual è la probabilità

che un cliente riceva il pacco

contenente le camicie difettose?

Poiché ciascun cliente riceverà uno dei 100 pacchi di camicie spediti, lo spazio campionario

dell’esperimento è costituito da 100 elementi (n=100); inoltre, poiché 10 di questi pacchi

contengono le camicie difettose (nE), allora, per la definizione classica di probabilità:

P( E ) =

nE

10

=

= 0,10 ,

n 100

dove con E si indica l’evento “pacco contenente camicie difettose”.

Alla definizione classica di probabilità sono state rivolte critiche di varia natura. La prima

critica è di ordine logico e riguarda la circolarità della definizione: affermare che tutti i casi sono

ugualmente possibili significa dire che sono ugualmente probabili (non si può definire un concetto

utilizzando lo stesso concetto).

Altre due critiche riguardano l’operatività della definizione; una volta superato lo scoglio

logico, non sono affatto rare le situazioni reali nelle quali non è possibile procedere

all’enumerazione dei casi favorevoli e dei casi possibili, inoltre, anche nelle situazioni in cui si può

effettuare una tale enumerazione, non è infrequente la circostanza in cui non tutti i casi sono

ugualmente possibili.

Per superare gli inconvenienti operativi cui si andrebbe incontro se si volesse far ricorso alla

definizione classica di probabilità quando le situazioni non lo consentono, è stata introdotta una

diversa definizione di probabilità.

11

B. Chiandotto

Statistica per le decisioni

Calcolo delle Probabilità

Versione 2006

2.3.2 Definizione frequentista o statistica (a posteriori) della probabilità

La probabilità di un evento ripetibile E è data dal rapporto tra il numero n E delle volte in cui

l'evento si è verificato ed il numero delle prove (effettuate tutte nelle stesse condizioni) quando il

numero delle prove stesse tende ad infinito

nE

n→∞ n

P(E) = lim

La probabilità secondo questa definizione può essere, pertanto, intesa come una sorta di

idealizzazione della frequenza relativa. Taluni autori ritengono, infatti, che probabilità e frequenza

relativa non siano altro che l'aspetto teorico e quello empirico di uno stesso concetto ed interpretano

la frequenza relativa di un evento come misura approssimata (per n finito) della probabilità.

Anche alla definizione frequentista sono state rivolte critiche di varia natura quale quella

relativa al limite irraggiungibile (+∞) imposto al numero delle prove, ma ad una tale critica si

risponde accettando la frequenza relativa di un numero finito (ma sufficientemente elevato) di prove

come misura approssimata della probabilità. Molto più problematica è la risposta alla critica relativa

alla ripetibilità delle prove (esperimento) in situazioni invariate e, soprattutto, quella che fa

riferimento alle situazioni reali, e non sono affatto infrequenti, nelle quali non è possibile procedere

all’effettuazione di alcuna prova.

Esempio 2.2

La Metric Systems produce circuiti elettronici integrati. Occasionalmente, il processo

produce un circuito difettoso e, saltuariamente, il responsabile per il controllo della qualità

seleziona casualmente 500 circuiti dalla linea di produzione e li ispeziona attentamente.

Nell’ultima ispezione sono stati riscontrati 15 circuiti difettosi (su un totale di 500 ispezionati).

Qual è la probabilità che il processo produca un circuito difettoso?

La selezione casuale di un circuito dalla linea di produzione corrisponde ad una singola

prova di un esperimento, quindi, 500 selezioni rappresentano 500 prove, cioè n = 500. Si Indichi

con E l’evento “produzione di un circuito difettoso”. Poiché E si è manifestato 15 volte, la

probabilità che il processo produca un circuito difettoso, sulla base della definizione frequentista, è

approssimata dalla frequenza relativa di E nelle 500 prove:

P( E ) =

nE

15

=

= 0,03

500

n

12

B. Chiandotto

Statistica per le decisioni

Calcolo delle Probabilità

Versione 2006

Una definizione che supera le critiche, sia di ordine logico che operativo, rivolte alla

definizione classica e alla definizione frequentista di probabilità è la definizione sotto riportata.

2.3.3 Definizione soggettiva della probabilità

La probabilità P(E) di un evento E viene definita come il grado di fiducia che un individuo

razionale attribuisce al verificarsi di un evento. La misura (soggettiva) di probabilità si deriva

ponendo l'individuo (razionale) di fronte ad un'operazione di scommessa chiedendo quanto è

disposto a puntare per ricevere 1 nel caso in cui l'evento in questione si realizzi. Si deve sottolineare

che questa affermazione vale solo nel caso di individui con funzione di utilità lineare; ma sulla

funzione di utilità si avrà modo di tornare nel capitolo sucessivo.

Anche alla definizione soggettiva di probabilità sono state rivolte critiche. La prima riguarda

proprio la soggettività insita nella stessa definizione, la seconda è relativa alla difficoltà di

traduzione in un valore numerico significativo del grado di fiducia.

Alla prima critica si risponde osservando che qualunque probabilità deve essere intesa in

senso condizionato, cioè condizionatamente allo stato di informazione dell’individuo (razionale);

pertanto, anche se apparentemente due individui diversi attribuiscono una diversa misura di

probabilità ad uno stesso evento, gli stessi individui si riferiscono a due diversi eventi essendo

diverso lo stato di informazione su cui basano l’esplicitazione del proprio grado di fiducia.

Alla seconda critica si risponde che, nonostante alcune difficoltà operative, alla misura di

probabilità si perviene, come già sottolineato, attraverso l’attivazione di un processo relativamente

semplice (almeno sul piano concettuale) che è quello di porre l’individuo di fronte ad una

operazione di scommessa.

Le tre definizioni introdotte, cui si può far ricorso per addivenire ad una valutazione numerica

della probabilità, non sono necessarie per lo sviluppo del calcolo delle probabilità bastando a tal

fine la definizione assiomatica, ed a questa definizione si farà riferimento negli sviluppi teorici che

seguono. Alle tre definizioni non assiomatiche si farà, di volta in volta, riferimento nelle

esemplificazioni delle argomentazioni teoriche.

2.3.4 Definizione assiomatica di probabilità

Gli assiomi o postulati di base del Calcolo delle probabilità sono sei: il primo riguarda il

concetto primitivo di evento, gli altri cinque il concetto primitivo di probabilità.

13

B. Chiandotto

Statistica per le decisioni

Calcolo delle Probabilità

Versione 2006

Assioma 1 -

Gli eventi formano un’algebra di Boole completa.

Assioma 2 -

La misura di probabilità di un evento P(E) è unica.

Assioma 3 -

La misura della probabilità di un evento è sempre non negativa

P(E) ≥ 0

Assioma 4 -

La probabilità dell’evento certo è uguale a 1

P(Ω) = 1

Assioma 5 -

Se due eventi E1 ed E2 sono incompatibili, cioè se la loro intersezione è

l’evento impossibile, allora la probabilità della loro unione è uguale alla somma delle probabilità dei

singoli eventi (principio delle probabilità totali per eventi incompatibili)

P(E1 ∪ E2) = P(E1) + P(E2)

Assioma 6 -

per E1 ∩ E2 = φ

La probabilità dell’evento condizionato E1/E2 è pari alla probabilità

dell’intersezione dei due eventi rapportata alla probabilità dell’evento condizionante supposta

maggiore di 0

P(E1/E2) =

P(E 1 ∩ E 2 )

P(E 2 )

per P(E2) > 0

L’ultima relazione può essere riscritta (principio delle probabilità composte) come:

P(E1 ∩ E2) = P(E2) • P(E1/E2) = P(E2∩E1) = P(E1) • P(E2/E1)

In realtà, sapendo che si è realizzato un certo evento E1, non è detto che questo modifichi

necessariamente la probabilità di realizzarsi di un altro evento E2, può accadere cioè che

P(E1 / E2) = P(E1)

in tal caso si avrà anche (principio delle probabilità composte per eventi indipendenti)

P(E1 ∩ E2) = P(E1) P(E2)

ed i due eventi E1 ed E2 si dicono indipendenti statisticamente (o indipendenti stocasticamente,

o indipendenti in probabilità).

Più in generale, k eventi E1, E2, ... , Ek si dicono statisticamente (o stocasticamente o

probabilisticamente) indipendenti se

14

B. Chiandotto

Statistica per le decisioni

Calcolo delle Probabilità

Versione 2006

P(E i1 ∩ E i2 ∩...∩ E ik ) = P(Ei1 ) ⋅ P(Ei2 ) ⋅ ...⋅ P(Eik )

per ogni sottoinsieme di eventi Ei1 ,Ei2 ,

,Eis per s = 2, 3, 4, ... ,k . Ad esempio i tre eventi E1, E2 ed

E3 sono statisticamente indipendenti se valgono le relazioni

P(E1 ∩ E2) = P(E1) • P(E2)

P(E1∩ E3) = P(E1) • P(E3)

P(E2∩ E3) = P(E2) • P(E3)

P(E1∩ E2∩ E3) = P(E1) • P(E2) • P(E3)

Si deve sottolineare in proposito che le prime tre relazioni (indipendenze doppie) non

implicano la quarta (indipendenza tripla). Così come la quarta relazione non implica le prime tre.

Avendo definito la probabilità come funzione da applicare agli eventi dove, come precisato,

l'evento è un qualunque sottoinsieme dello spazio campionario Ω, cioè un elemento dell’insieme B

(Algebra di Boole completa costruita su Ω), risulta facile dimostrare le relazioni (teoremi)

seguenti:

P(E) ≤ 1

P( E ) = 1 − P(E)

P( φ ) = 0

E1 ⊂ E2 => P(E1) < P(E2)

P(E1 ∪ E2) = P(E1) + P(E2) - P(E1 ∩ E2)

L'ultima relazione, detta anche (impropriamente) principio delle probabilità totali, per k

eventi diventa

k

⎞

⎛ k

k +1

P⎜⎜ ∪ E i ⎟⎟ = Σ P(Ei ) − Σ i Σ j P (Ei ∩ E j ) + Σ i Σ j Σ h P (Ei ∩ E j ∩ E h ) + … + (− 1) ∩ Ei

i =1

⎝ i =1 ⎠

e si riduce al postulato delle probabilità totali (Assioma 5)

⎞

⎛ k

P⎜⎜ ∪ Ei ⎟⎟ =

⎝ i =1 ⎠

quando i k eventi Ei sono tra loro incompatibili.

15

k

∑ P(E )

i =1

i

B. Chiandotto

Statistica per le decisioni

Calcolo delle Probabilità

Versione 2006

La probabilità per eventi condizionati o, più semplicemente, la probabilità condizionata

P(E1/E2) soddisfa ai primi cinque assiomi; infatti gli eventi condizionati formano un’algebra di

Boole, inoltre

P(E1/E) ≥ 0

P(E/E) = 1

P(E1 ∪ E2 ∪ .../E) = P(E1/E) + P(E2/E) +....

se gli eventi E1, E2,... sono incompatibili.

Inoltre

E1 ⊂ E2 => P(E1/E) ≤ P(E2/E)

P( E1 /E) = 1 - P(E1/E)

P(E1 ∪ E2/E) = P(E1/E) + P(E2/E) - P(E1 ∩ E2/E)

Il principio delle probabilità composte può riguardare anche un numero qualsiasi di eventi

E1, E2, E3,..., si avrà allora

P(E1 ∩ E2 ∩ E3 ∩...) = P(E1).P(E2/E1).P(E3/E1 ∩ E2) ...

Esempio 2.3

La società IMA produce componenti meccaniche in grande quantità per un cliente. Siccome i

limiti di tolleranza specificati dal cliente sono piuttosto severi, la produzione di queste componenti

è stata affidata a due macchinisti esperti, A e B. Al termine di ogni giornata tutte le parti prodotte

sono ispezionate e classificate come “buone” (G - good) o “difettose” (D).

La seguente tabella riporta i dati relativi alla produzione di ieri:

Macchinista

Condizioni

A

B

Totale

G

80

88

168

D

20

12

32

Totale

100

100

200

16

B. Chiandotto

Statistica per le decisioni

Calcolo delle Probabilità

Versione 2006

Quindi le parti sono state classificate in base alla condizione (buona / difettosa) e in base al

macchinista preposto al processo produttivo.

I)

Si determinino le seguenti probabilità: P(A), dove A è l’evento “parte prodotta dal

macchinista A”; P(B), dove B è l’evento “parte prodotta dal macchinista B”; P(G),

dove G è l’evento “parte prodotta secondo le specifiche di tolleranza del cliente”;

P(D), dove D è l’evento “parte difettosa”.

P ( A) = 100 / 200 = 0,50

P(B) = 100 / 200 = 0 ,50

P(G) = 168 / 200 = 0 ,84

P(D) = 32 / 200 = 0 ,16

II)

Si determinino le probabilità congiunte dei vari eventi:

P ( A ∩ G ) = 80 / 200 = 0,40

P ( A ∩ D) = 20 / 200 = 0,10

P ( B ∩ G ) = 88 / 200 = 0,44

P ( B ∩ D) = 12 / 200 = 0,06

III)

Si determinino le probabilità condizionate dei vari eventi:

P (G A) =

P ( A ∩ G ) 0,40

=

= 0,80

P( A)

0,50

P (A D ) =

P ( A ∩ D ) 0,10

=

= 0,625

P( D )

0,16

P (D A) =

P( A ∩ D ) 0,10

=

= 0,20

P( A)

0,50

P (B G ) =

P (B ∩ G ) 0,44

=

= 0,524

P (G )

0,84

P (G B ) =

P (B ∩ G ) 0,44

=

= 0,88

P( B )

0,50

P (G D ) =

P(D ∩ G ) 0,00

=

= 0,00

P( D)

0,16

IV)

Infine, si cerchi di capire se la condizione (buona / difettosa) di una parte prodotta è

indipendente dal macchinista che la produce.

Se esiste indipendenza tra queste categorie, allora gli eventi “la parte è buona” e “la parte è

stata prodotta da A” sono statisticamente indipendenti. E’, dunque, necessario valutare la

relazione che sussiste tra P (G ∩ A) e P(G ) ⋅ P( A) .

17

B. Chiandotto

Statistica per le decisioni

Calcolo delle Probabilità

Versione 2006

Dai precedenti calcoli risulta

P (G ∩ A) = 80 / 200 = 0,40

P (G ) = 168 / 200 = 0,84

P ( A) = 100 / 200 = 0,50

P (G ) ⋅ P( A) = 0,84 ⋅ 0,50 = 0,42

Siccome P (G ∩ A) ≠ P(G ) ⋅ P( A) ⇒ A e G non sono statisticamente indipendenti, quindi il

macchinista preposto al processo di produzione influenza la condizione buona o difettosa della

parte prodotta.

Alla stessa conclusione si perviene considerando le relazioni tra P ( A G ) e P( A) , dal

momento che

P( A G ) = 80 / 100 = 0,80 e

P( A) = 100 / 200 = 0,50

⇒ P( A G ) ≠ P ( A)

Dai dati riportati in tabella e dai precedenti calcoli possono essere verificate anche le

seguenti ulteriori relazioni:

P ( A D ) ≠ P ( A)

P( B G ) ≠ P( B)

P( D B) ≠ P( B)

che confermano la dipendenza statistica tra operatore preposto al processo produttivo e risultato

dello stesso.

Esempio 2.4

L’azienda Sigma fornisce materiali per la costruzione di case e attualmente ha un contratto

con uno dei suoi clienti per evadere un ordine entro il 31 luglio. Al momento sussiste una certa

incertezza in merito al fatto che l’azienda riesca a rispettare il termine imposto dal contratto,

poiché non sa se riceverà le materie prime necessarie dal suo fornitore entro la metà di luglio.

Considerando che adesso siamo al 1° luglio, come può essere stimata l’incertezza in questa

situazione?

Sia A l’evento che la Sigma riesca a rispettare la scadenza contrattuale del 31 luglio e B

l’evento che riceva le materie prime entro il 15 luglio dal fornitore. All’inizio di luglio l’azienda

stima che la probabilità di ottenere le materie prime in tempo è pari a P(B) = 2/3; inoltre, se le

materie prime sono consegnate per tempo, allora la probabilità di terminare i lavori per la fine del

mese è stimata in P(A/B) = ¾. Quindi, applicando il principio delle probabilità composte, si ottiene

18

B. Chiandotto

Statistica per le decisioni

Calcolo delle Probabilità

Versione 2006

P ( A ∩ B) = P( A B) P( B) = 3 / 4 ⋅ 2 / 3 = 0,50

Esiste, quindi, una probabilità del 50% che l’azienda Sigma ottenga le materie prime in

tempo e riesca a consegnare il materiale al cliente per la fine di luglio.

Può essere interessante procedere al calcolo di ulteriori probabilità. Indichiamo con

B l’evento che le materie prime non arrivino in tempo; quindi, P( B ) = 1-2/3 =1/3. Supponendo

che la probabilità di terminare i lavori entro il 31 luglio, dato che i fornitori non hanno consegnato

entro il 15 le materie prime necessarie sia stimata in P(A/ B ) = 1/5. Di conseguenza, applicando di

nuovo il principio delle probabilità composte, si ottiene

P ( A ∩ B ) = P( A B ) P( B ) = 1 / 5 ⋅ 1 / 3 = 0,0667 ,

cioè la probabilità che il materiale non arrivi in tempo, ma i lavori siano ugualmente ultimati per

la scadenza contrattuale è pari al 6,67%.

A questo punto, al management dell’azienda può essere utile conoscere la probabilità di

terminare i lavori entro il 31 luglio, indipendentemente dal fatto che le materie prime siano

consegnate entro la metà del mese. Poiché B e B sono due eventi incompatibili (o si verifica l’uno o

si verifica l’altro), allora per il principio delle probabilità totali per eventi incompatibili, otteniamo

P( A) = P( A ∩ B ) + P( A ∩ B ) = 0,50 + 0,0667 = 0,5667

Quindi, c’è una probabilità del 56,67% che la società Sigma riesca a rispettare i termini di

esecuzione del contratto.

19

B. Chiandotto

Statistica per le decisioni

Calcolo delle Probabilità

Versione 2006

2.4 Teorema di Bayes

Il teorema di Bayes rappresenta, come già accennato nel primo capitolo, un elemento teorico

fondamentale per la Teoria statistica delle decisioni. Esso consente, infatti, al soggetto decisore di

revisionare le informazioni a priori che lo stesso possiede sul fenomeno oggetto di studio attraverso

le ulteriori informazioni acquisite tramite esperimenti campionari, in modo da ottenere informazioni

(a posteriori) più complete e, quindi, più utili per il processo decisionale.

Si consideri una partizione dello spazio campionario Ω in k eventi E1, E2, ... , Ei, ... , Ek; i

k

eventi sono necessari ed incompatibili, tali cioè da rispettare le condizioni Ei ∩ Ej = φ per i ≠ j = 1,

k

2, ...,k e

∪E

i

= Ω. Se E è un evento appartenente ad Ω si ha

i =1

k

k

E = E ∩ Ω = E ∩ ( ∪ Ei ) =

∪

i =1

(E ∩ Ei)

i =1

e, per l'incompatibilità degli eventi Ei, anche

k

P(E) = P [ ∪ (E ∩ Ei)] =

i =1

k

∑

P(E ∩ Ei).

i =1

Inoltre, valendo le relazioni

P(E ∩ Ej) = P(Ej)P(E/ Ej) = P(Ej ∩ E) = P(E) P(Ej /E)

si avrà

P(Ej /E) =

P(E j )P(E/E j )

P(E)

=

P( E j ) ⋅ P( E / E j )

k

∑ P( E ) ⋅ P( E / E )

i =1

i

i

che viene detta formula di Bayes ed assume una rilevanza particolare quando i k eventi Ei possono

essere interpretati come possibili “cause” dell'evento E. In tale contesto, P(Ej /E) viene detta

probabilità a posteriori della causa Ej; mentre, P(Ej) rappresenta la probabilità a priori della

stessa causa e P(E/ Ej) è detta probabilità probativa o verosimiglianza dell'evento E.

20

B. Chiandotto

Statistica per le decisioni

Calcolo delle Probabilità

Versione 2006

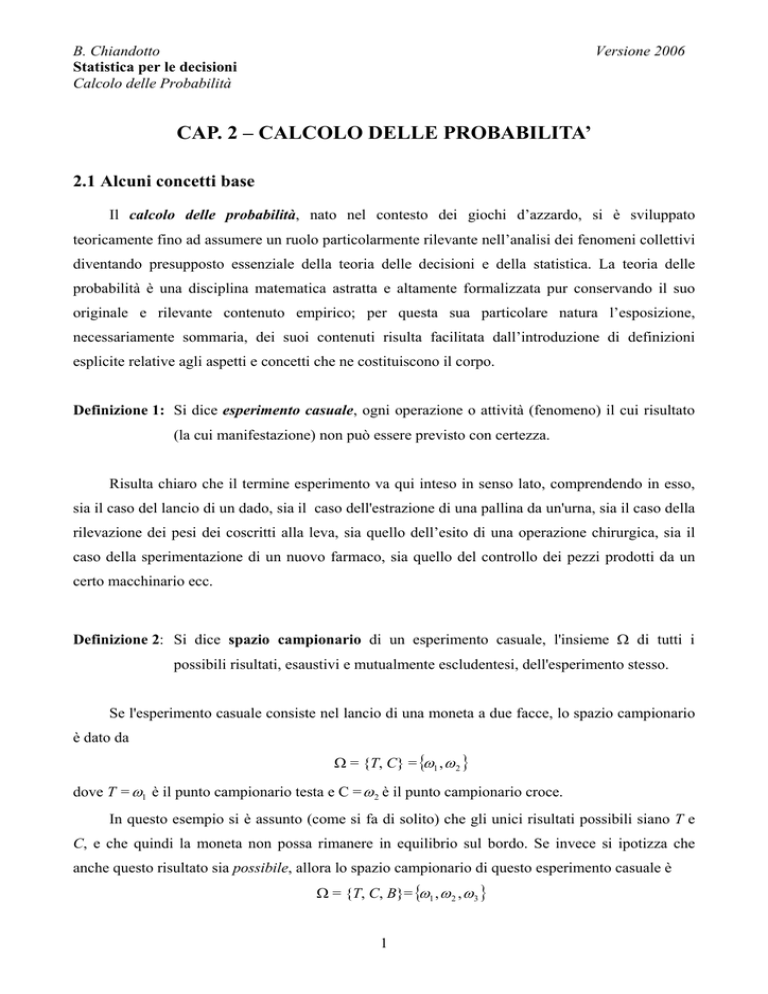

E1

E3

Ω

E4

E2

E

E5

Fig. 7 - Partizione dello spazio campionario Ω in cinque eventi E1, E2, E3, E4 ed E5

La formula di Bayes esprime in maniera molto semplice il processo di apprendimento

dall'esperienza in contesti non deterministici.

Della realtà si possiede una conoscenza probabilistica, che viene espressa in termini di

probabilità (a priori) P(Ej), queste probabilità si trasformano, al verificarsi dell'evento E

(acquisizione di ulteriori informazioni), nelle probabilità (a posteriori) P(Ej /E).

Le probabilità condizionate si usano, quindi, per riassegnare le probabilità agli eventi una

volta che siano state acquisite ulteriori informazioni relative ad una realizzazione parziale di un

esperimento casuale.

Si consideri il caso in cui un soggetto debba assumere una decisione d’investimento di breve

periodo; si supponga, inoltre, che gli eventi E1, E2,…., Ek rappresentino tutti i possibili stati tra loro

incompatibili che il mercato finanziario può assumere nell’arco di una settimana. Si supponga,

infine, che il soggetto decisore non conosca la quotazione odierna X del MIB30. Se il soggetto è

impossibilitato a procurarsi il valore odierno del MIB30, allora egli sceglierà l’investimento più

opportuno sulla base delle sole informazioni a priori che possiede relativamente agli eventi E1,

E2,…., Ek, vale a dire le probabilità soggettive P(E1), P(E2), …, P(Ek), che dipenderanno

dall’andamento degli ultimi giorni del MIB30, nonché da altre considerazioni soggettive

sull’andamento economico e sociale del sistema.

Se, invece, il decisore ha la possibilità di procurarsi ulteriori informazioni su X (ad esempio

collegandosi via Internet con la Borsa Valori di Milano), può sfruttare questa informazione

aggiuntiva per riaggiornare, sulla base della formula di Bayes, le probabilità a priori che egli aveva

attribuito agli eventi E1, E2,…., Ek, ottenendo così le probabilità a posteriori P( Ei X ) .

Esempio 2.5

Da un controllo di qualità effettuato sul processo produttivo dell’azienda Alfa risulta che il

40% delle parti difettose prodotte è dovuto a errori meccanici, mentre il restante 60% è dovuto ad

21

B. Chiandotto

Statistica per le decisioni

Calcolo delle Probabilità

Versione 2006

errori umani. Si sa, inoltre, che i difetti causati da errori meccanici possono essere rilevati, in

occasione di un’ispezione di qualità, con un tasso di accuratezza del 90%, tasso che scende al 50%

per i difetti risultanti da errori umani. Si supponga che a seguito di un’ispezione di qualità sia stato

trovato un pezzo difettoso. Qual è la probabilità che tale difetto sia stato causato da un errore

meccanico?

Se si assume che:

P(Em) = 0,40 è la probabilità (a priori) che una parte difettosa sia causata da un errore

meccanico;

P(Eu) = 0,60 è la probabilità (a priori) che una parte difettosa sia causata da errore umano;

P(D/Em) = 0,90 è la probabilità di presenza di una parte difettosa causata da errore

meccanico;

P(D/Eu) = 0,50 è la probabilità di presenza di una parte difettosa causata da errore umano;

P(Em/D) = ? la probabilità che la parte difettosa rilevata al controllo sia stata provocata da

errore meccanico.

Applicando il Teorema di Bayes si ha:

P (E m D ) =

P( E m ) ⋅ P( D E m )

P( E m ∩ D)

0,40 ⋅ 0,90

=

=

= 0,55

P( D)

P(E m ) ⋅ P (D E m ) + P(Eu ) ⋅ P (D Eu ) 0,40 ⋅ 0,90 + 0,60 ⋅ 0,50

Quindi, la probabilità che il pezzo difettoso sia stato causato da errore meccanico è pari al

55%. Di conseguenza, la probabilità che un pezzo difettoso sia stato causato da errore umano è

pari al 45% (=1- 0,55).

La seguente tabella mostra le fasi dell’applicazione del Teorema di Bayes:

Causa

Ei

Prob. a priori

P(Ei)

Prob.

Prob. congiunte

Prob.a

condizionate

P(Ei) (D/Ei)

posteriori

P(D/Ei)

P(Ei/D)

Meccanica m

0,40

0,90

0,36

0,55

Umana u

0,60

0,50

0,30

0,45

Totale

1,00

0,66*

1,00

* Probabilità marginale

Esempio 2.6

Attualmente un’azienda che produce parti elettroniche dispone di 4 macchinari: A1, A2, A3,

A4, ognuno con una capacità produttiva di 10.000 pezzi a settimana. In linea generale, si può

ritenere che quanto più un macchinario è nuovo tanto più basso è il numero di parti difettose che lo

22

B. Chiandotto

Statistica per le decisioni

Calcolo delle Probabilità

Versione 2006

stesso produce. Un controllo effettuato dall’azienda rivela i seguenti tassi di parti difettose prodotte

da ciascuna macchina: 0% per A1 poiché è nuova; 1% per A2 che è stata acquistata un anno fa; 5%

per A3 che è stata acquistata due anni fa; 10% per A4 che è operativa già da tre anni. Al termine

del quarto anno di attività ogni macchinario viene rimpiazzato con uno nuovo. Per effettuare un

controllo aggiuntivo, il responsabile della produzione seleziona casualmente un pezzo già pronto

per la spedizione al cliente. Tale pezzo risulta difettoso: qual è la probabilità che il pezzo estratto

casualmente sia stato prodotto dalla macchina A2, dato che risulta essere difettoso?

Si ponga:

P(D) = probabilità che sia osservata una parte difettosa

P(Ai) = probabilità che una parte sia prodotta dal macchinario i-esimo

P(D/Ai) = probabilità condizionata che sia selezionata casualmente una parte difettosa, dato

che è stata prodotta dal macchinario i-esimo.

In base ai dati del problema risulta:

P(D/A1) =0,00

P(D/A2) = 0,01

P(D/A3) = 0,05

P(D/A4) = 0,10

Inoltre, poiché ciascuna macchina produce lo stesso numero di parti elettroniche, la

probabilità a priori che il campione estratto provenga da una delle 4 macchine è sempre uguale al

25%, cioè:

P(A1) = P(A2) = P(A3) = P(A4) = 0,25

Quindi,

P( D ) = P ( A1 ) ⋅ P( D A1 ) + P( A2 ) ⋅ P (D A2 ) + P ( A3 ) ⋅ P (D A3 ) + P ( A4 ) ⋅ P (D A4 ) =

= 0,25 ⋅ 0,00 + 0,25 ⋅ 0,01 + 0,25 ⋅ 0,05 + 0,25 ⋅ 0,10 = 0,040

A questo punto si può applicare il Teorema di Bayes per determinare la probabilità a

posteriori che il campione estratto provenga dal macchinario A2, essendo noto che è difettoso:

P (A2 D ) =

P( A2 )P(D A2 )

P (D )

=

0,25 ⋅ 0,01

= 0,0625 = 6,25%

0,04

La seguente tabella mostra il dettaglio dei passaggi svolti:

23

B. Chiandotto

Statistica per le decisioni

Calcolo delle Probabilità

Versione 2006

Causa

Prob.a priori

Prob.condizionate

Prob.congiunte

Prob.a posteriori

Ai

P(Ai)

P(D/Ai)

P(Ai) P(D/Ai)

P(Ai/D)

A1

0,25

0,00

0,0000

0,0000

A2

0,25

0,01

0,0025

0,0625

A3

0,25

0,05

0,0125

0,3125

A4

0,25

0,10

0,0250

0,6250

Totali

1,00

0,0400*

1,0000

* Probabilità marginale

E’ interessante confrontare l’elenco delle probabilità a priori con quello delle probabilità a

posteriori, per valutare l’effetto provocato dall’impiego dell’informazione aggiuntiva (dato

campionario) sul risultato del problema. Effettivamente si possono notare delle differenze notevoli:

dopo che la probabilità a priori è stata modificata dall’informazione campionaria, la probabilità

che una parte difettosa venga prodotta dalla macchina A4 cresce notevolmente dal 25% al 62,5%,

mentre la probabilità che una parte difettosa provenga dalla macchina A1 scende dal 25% allo 0%.

Fatto questo del tutto ragionevole se si tiene conto della circostanzac che il numero di difetti

dipende dall’età del macchinario.

Dopo la sommaria indicazione delle operazioni proprie del calcolo delle probabilità e dopo

aver precisato che la tripletta (Ω, B, P(.)) [dove: Ω è lo spazio campionario (cioè l’insieme di tutti i

punti campionari ω1 , ω 2 ,... possibili risultati di un esperimento casuale), B è l’algebra di Boole

completa costruita su Ω e P(.) è una funzione definita su B che gode di particolari proprietà], viene

detta spazio di probabilità o spazio probabilistico, si può procedere all'introduzione di due

ulteriori concetti che possono essere ritenuti fondamentali nello sviluppo sia del calcolo delle

probabilità sia della statistica. Il primo concetto è quello di "variabile casuale", il secondo è quello

di "funzione di distribuzione".

24

B. Chiandotto

Statistica per le decisioni

Calcolo delle Probabilità

Versione 2006

2.5 Variabili casuali

Definizione 5: Si dice variabile casuale, una funzione X (.) a valori reali definita sullo spazio

campionario Ω; cioè ogni funzione che, soddisfacendo ad opportune condizioni

(tali da preservare la struttura di B), associa ad ogni punto dello spazio campionario

un numero reale.

In termini più rigorosi, la funzione univoca X( ω ) definita su Ω è una variabile casuale (o

variabile stocastica, o variabile aleatoria o numero aleatorio) se vale la relazione A =

{ω ∈ Ω / X(ω ) ≤ x}∈ B

cioè se l’insieme A, costituito da tutti gli eventi elementari ω per i quali il

valore assunto dalla funzione X( ω ) è minore od uguale ad un numero reale qualsiasi x, è un

elemento di B, cioè un evento appartenente all’algebra.

Le variabili casuali si distinguono in:

a) discrete, se il rango della funzione è costituito da un numero finito o da un'infinità

numerabile di numeri reali;

b) continue, se il rango della funzione è costituito da un insieme continuo (e quindi non

numerabile) di numeri reali.

Definizione 6: Si dice funzione di distribuzione (o funzione di ripartizione, o funzione delle

probabilità cumulate) della variabile casuale X, la funzione F(x) definita dalla

relazione

F(x) = P (X ≤ x)

dove: x rappresenta un numero reale qualunque; P (X ≤ x) misura la probabilità con

cui la variabile casuale X può assumere un valore inferiore od uguale al numero

reale x.

La funzione di distribuzione non rappresenta altro che la probabilità dell’evento A definito in

precedenza; infatti:

P(A) = P[ω ∈ Ω / X (ω ) ≤ x ] = P[X (ω ) ≤ x ] = P( X ≤ x ) .

Se con x1, x2,...,xk, si indicano le possibili determinazioni distinte, ordinate in modo crescente,

di una certa variabile casuale discreta X e con p1, p2,...,pk, le probabilità rispettive, si avrà

25

B. Chiandotto

Statistica per le decisioni

Calcolo delle Probabilità

Versione 2006

F(xi) = P(X ≤ xi) =

dove

i

∑

i

P(X = xj) =

j=1

∑

j=1

pj

pj = P(X = xj).

La funzione f(xi) che deriva dalla relazione f(xi) = F(xi) - F(xi-1) viene detta funzione di

massa di probabilità e, ovviamente, fornisce la probabilità che l’entità variabile X ha di assumere

la specifica determinazione xi ; infatti

F(xi) - F(xi-1) = P (X ≤ xi) - P (X ≤ xi-1) = P(X = xi)

per i = 1, 2, ... , k .

Nel caso in cui la variabile X sia continua, e la F(x) sia una funzione assolutamente continua

(si supporrà, da ora in poi e per tutte le F(x) che tale condizione sia soddisfatta), esisterà la derivata

f(x) =

d F ( x)

dx

Si ricorda in proposito che le funzioni assolutamente continue sono funzioni continue e

derivabili (quasi ovunque).

La funzione f(x) così definita viene detta funzione di densità di probabilità o più

semplicemente funzione di densità. Si avrà quindi anche

∫

X

−∞

f(y) dy = F(x); inoltre

f(x) dx = dF(x)= P{x ≤ X ≤ x + dx}

rappresenta la probabilità con cui una variabile casuale continua X assume valori all'interno

dell'intervallino infinitesimo x − x+dx.

Va rilevato che le funzioni di distribuzione, e quindi le corrispondenti (corrispondenza

biunivoca) funzioni di massa di probabilità, nel discreto, di densità di probabilità, nel continuo, che

identificano completamente le variabili casuali cui si riferiscono, sono caratterizzate da specifici

valori (entità di riferimento) dette parametri. Per evidenziare tale fatto, si usa la notazione

F(x; θ1;θ2,...,θµ) ; f(x; θ1;θ2,...,θµ)

dove i simboli θ1;θ2,...,θµ indicano i parametri caratteristici della funzione (modello probabilistico).

Ripercorrendo il processo che ha portato alla definizione della funzione di distribuzione, della

funzione di massa e di densità di probabilità, risulta immediata l’individuazione delle proprietà che

tali funzioni soddisfano.

26

B. Chiandotto

Statistica per le decisioni

Calcolo delle Probabilità

Versione 2006

Si supponga che la variabile casuale discreta X possa assumere le determinazioni x1, x2,..., xi,

... , xk, (dove: xi< xi+1 e k può anche tendere al valore +∞) e che la variabile casuale continua X

risulti definita nell’intervallo dell’asse reale a⎯b (dove: a < b, a può tendere al valore -∞ e b

tendere al valore +∞), allora la funzione di distribuzione F(x):

1.

assume valori nell’intervallo unitario

0 ≤ F(x) ≤ 1

2.

il limite sinistro assume valore zero

lim F(x) = 0

x →−∞

3.

il limite destro assume valore uno

lim F(x) = 1

x →+∞

4.

è monotona non decrescente

5.

è continua a destra nel caso discreto (i punti di discontinuità si collocano in

corrispondenza dei valori x1, x2,..., assunti dalla variabile) ed è assolutamente continua (continua e

derivabile quasi ovunque) nel caso continuo.

La funzione di massa di probabilità f(xi) , essendo una probabilità gode delle proprietà già

considerate relativamente a tale entità, inoltre

k

∑ f(x ) = 1.

i =1

i

La funzione di densità f(x) soddisfa le condizioni

f(x) ≥ 0

∫

b

a

f ( x)dx = 1

Da quanto è stato detto, risulta che una variabile casuale rimane individuata completamente

dalla sua funzione di distribuzione (o di massa o di densità di probabilità) e che essa rappresenta

una formalizzazione astratta (modello) dell'insieme delle possibili manifestazioni di un certo

fenomeno avente natura aleatoria.

27

B. Chiandotto

Statistica per le decisioni

Calcolo delle Probabilità

Versione 2006

2.6 Valore atteso e momenti di variabili casuali

Per particolari esigenze scientifiche ed operative si può essere interessati all’effettuazione di

una rappresentazione sintetica delle manifestazioni di un certo fenomeno mediante indici

caratteristici. Può, cioè, risultare conveniente, o sufficiente, descrivere una variabile casuale con

degli indici caratteristici, anziché procedere ad una sua rappresentazione completa mediante la

funzione di distribuzione, la funzione di massa o la funzione di densità di probabilità.

Un modo di pervenire alla sintesi di una variabile casuale X è quello di procedere al calcolo

del valore atteso E(.) di particolari trasformazioni Y = g(X) della variabile casuale stessa. In questa

sede si considerano solo le trasformazioni che portano alla definizione di una nuova variabile

casuale Y; se, ad es., X è una v.c. continua con funzione di densità f(x), anche Y =g(X) è una

variabile casuale, discreta o continua, la cui funzione di densità f(y) o di massa di probabilità f(yi)

potrà essere derivata attraverso appropriate trasformazioni della funzione di densità f(x).

Definizione 7: Si definisce valore atteso di una trasformazione g(X) di una variabile casuale X ,

con funzione di distribuzione F(x) , la quantità definita dalla relazione

k

E [g ( X )] = ∑ g ( xi ) f ( xi )

nel discreto

E [g ( X )] = ∫ g ( x ) f (x )dx

nel continuo

i =1

dove f ( xi ) è la funzione di massa di probabilità della variabile casuale discreta X che assume il

valore xi con probabilità f ( xi ) , per i = 1, 2, ..., k ; mentre f ( x ) è la funzione di densità di

probabilità della variabile casuale continua X , definita nell’intervallo a⎯b.

Si può osservare come l’operatore valore atteso non richieda la derivazione della funzione di

densità o di massa di probabilità della variabile casuale trasformata Y = g(X) e goda della proprietà

di linearità; infatti, per qualunque variabile X, con funzione f(xi) nel discreto, f(x) nel continuo, date

due costanti a , b e due trasformazioni g1 (X) e g2(X) ancora variabili casuali

E{ag1 ( X ) + bg 2 ( X )} = a E [g1 ( X )] + b E [g 2 ( X )]

come si può verificare facilmente osservando le relazioni sotto riportate

28

B. Chiandotto

Statistica per le decisioni

Calcolo delle Probabilità

Versione 2006

k

E{ag1 ( X ) + bg 2 ( X )} = ∑ [ag1 ( xi ) + bg 2 ( xi )] f ( xi ) =

i =1

k

k

i =1

i =1

= a ∑ g1 ( xi ) f ( xi ) + b∑ g 2 ( xi ) f ( xi ) = a E [g1 ( X )] + b E [g 2 ( X )]

nel discreto e

b

E [ag1 ( X ) + bg 2 ( X )] = ∫ [ag 1 ( x) + bg 2 ( x)] f ( x)dx =

a

= a ∫ g1 ( x) f ( x)dx + b ∫ g 2 ( x) f ( x)dx = a E [g1 ( X )] + b E [g 2 ( X )]

b

b

a

a

nel continuo.

Esempio 2.7

Una compagnia d’investimenti sta considerando se investire in un progetto di estrazione

mineraria in Canada oppure in una spedizione di trivellazione del petrolio in Alaska. Un’analisi

preliminare mostra che l’investimento nel progetto di estrazione mineraria genererà un profitto

netto di 1.000.000$, nell’ipotesi in cui venga trovato l’oro; altrimenti la compagnia perderà

800.000$. D’altra parte, la compagnia otterrà un profitto netto di 1.500.000$ o una perdita di

1.000.000$ nell’affare petrolifero, a seconda che venga scoperto o meno il petrolio. Supponendo

che un geologo abbia stimato una probabilità del 70% che sia scoperto l’oro e una probabilità del

50% che sia scoperto il petrolio e assumendo che entrambi i progetti richiedono lo stesso

ammontare di capitale iniziale e che solo uno dei due progetti può essere intrapreso, qual è

l’investimento più conveniente per la compagnia?

In questo caso si assume che il criterio di scelta della compagnia sia il maggior valore atteso

in termini monetari, cioè la compagnia troverà più conveniente l’investimento che presenta il più

alto valore atteso.

Il valore atteso dei due progetti è dato, in base alla precedente definizione, da:

-

Progetto di estrazione mineraria X:

1

E ( X ) = ∑ xi ⋅ p( xi ) = x0 p( x0 ) + x1 p ( x1 ) = 1.000.000 ⋅ 0,70 − 800.000 ⋅ 0,30 = 460.000$ ,

i =0

dove con xi si indica il risultato dell’evento “successo” (x0) o “insuccesso” (x1) del progetto e con

p(xi) le rispettive probabilità. La seguente tabella riassume quanto detto:

29

B. Chiandotto

Statistica per le decisioni

Calcolo delle Probabilità

-

Versione 2006

Evento

Probabilità P(xi)

Risultato xi

Valore Atteso

Successo

0,70

1.000.000

700.000

Insuccesso

0,30

-800.000

-240.000

Valore Atteso del progetto “estrazione mineraria”

460.000

Progettazione di trivellazione petrolifera Y:

1

E (Y ) = ∑ y i ⋅ p( yi ) = y 0 p( y 0 ) + y1 p ( y1 ) = 1.500.000 ⋅ 0,50 − 1.000.000 ⋅ 0,50 = 250.000$ ,

i =0

dove con yi si indica il risultato dell’evento “successo” (y0) e “insuccesso” (y1) del progetto e con

p(yi) le relative probabilità. La seguente tabella riassume quanto detto:

Evento

Probabilità P(yi)

Risultato yi

Valore Atteso

Successo

0,50

1.500.000

750.000

Insuccesso

0,50

-1.000.000

-500.000

Valore Atteso del progetto “trivellazione petrolifera”

250.000

In conclusione, poiché il progetto relativo all’estrazione mineraria presenta un profitto atteso

maggiore, la decisione ottima per la compagnia d’investimento è investire in tale affare piuttosto

che in quello relativo alla trivellazione petrolifera.

Esempio 2.8

L’azienda Gamma sta pensando di acquistare un nuovo macchinario, che dovrebbe

consentire una notevole riduzione dei costi di produzione rispetto al macchinario attualmente

impiegato. La nuova macchina costa 10.000 euro e ci si attende un risparmio di circa 0,50

euro/ora; quindi. Il risparmio complessivo R è dato da R = −10.000 + 0,50 X , dove X indica il

numero di ore-macchina impiegate. Il management non conosce ancora l’ammontare esatto di ore

durante le quali il macchinario sarà in funzione, dunque esprime la sua incertezza in termini della

seguente distribuzione di probabilità

30

B. Chiandotto

Statistica per le decisioni

Calcolo delle Probabilità

Versione 2006

Ore d’uso

Probabilità

10.000

0,10

20.000

0,30

30.000

0,50

40.000

0,10

In base ai dati a disposizione, è conveniente per l’azienda acquistare il macchinario?

Il management dovrebbe decidere per l’acquisto del nuovo macchinario nell’ipotesi in cui il

risparmio atteso dello stesso sia positivo:

E ( R) = E (−10.000 + 0,50 X ) = E (−10.000) + E (0,50 X )

= −10.000 + 0,50 E ( X )

[

= −10.000 + 0,50 ∑ P( X i ) X i

]

= −10.000 + 0,50(0,10 ⋅ 10.000 + 0,30 ⋅ 20.000 + 0,50 ⋅ 30.000 + 0,10 ⋅ 40.000)

= −10.000 + 13.000 = 3.000

Poiché il risparmio atteso assume un valore positivo di 3.000 euro, l’azienda dovrebbe

acquistare il nuovo macchinario.

Finora abbiamo considerato il caso più semplice in cui g(X) = X: in questo caso particolare,

come sarà puntualizzato in seguito, il valore atteso viene anche detto momento primo rispetto

all’origine o media aritmetica della v.c. X.

Momenti rispetto all’origine

Ponendo g(X) = Xr per r = 0, 1, 2 , ... si ha

⎧ k r

⎪ ∑ x i f ( xi ) nel discreto

µ r = E [g ( X )] = E ( X r ) = ⎨ i =1

b

⎪ x r f ( x)dx nel continuo

∫

⎩a

che viene detto momento r-esimo rispetto all’origine o momento di ordine r rispetto all’origine.

Da rilevare che il momento di ordine 0

⎧ k

⎪ ∑ f ( xi )= 1 nel discreto

µ 0 = E ( X 0 ) = ⎨ i =1

b

⎪ f ( x)dx = 1 nel continuo

∫

⎩a

31

B. Chiandotto

Statistica per le decisioni

Calcolo delle Probabilità

Versione 2006

è assolutamente non significativo risultando, almeno nelle condizioni qui prefigurate, sempre

uguale ad uno per qualunque variabile casuale.

Particolare rilevanza assume il momento di ordine uno.

⎧k

⎪∑ xi f ( xi )

µ = µ1 = E [g ( X )] = E ( X ) = ⎨ i =1

b

⎪ xf ( x)dx

∫

⎩a

che viene detto anche media aritmetica della variabile casuale ed è l’indice sintetico (indice

caratteristico) più utilizzato per mettere in evidenza quanto c’è di tipico nella variabile casuale. Altri

momenti di un certo rilievo sono il momento secondo µ 2 , il momento terzo µ 3 ed il momento

quarto µ 4 che evidenziano, come si avrà modo di sottolineare nelle righe successive, la loro

rilevanza in contesti diversi di sintesi delle variabili casuali.

Esempio 2.9

Indicando con X la domanda per una particolare marca di detersivo in un supermercato e

con f(x) la rispettiva probabilità secondo il seguente schema

X

0

1

2

3

4

5

6

7

f(x)

0,05

0,10

0,15

0,25

0,20

0,10

0,10

0,05

Si determini la domanda media.

E ( X ) = ∑ x ⋅ f ( x ) = 0 + 1 ⋅ 0,10 + 2 ⋅ 0,15 + 3 ⋅ 0,25 + 4 ⋅ 0,20 + 5 ⋅ 0,10 + 6 ⋅ 0,10 + 7 ⋅ 0,05 = 3,40

x

Momenti rispetto alla media o momenti centrali

Ponendo g(X) = ( X − µ ) r , per r = 0, 1, ... , dove µ = µ1 = E ( X ) è il momento primo

rispetto all’origine (media aritmetica) della variabile casuale X , si avrà

⎧ k

r

⎪ ∑ ( xi − µ ) f ( xi )

r

µ r = E [g ( X )] = E ( X − µ ) = ⎨ i =1

b

⎪ ( x − µ ) r f ( x)dx

∫

⎩a

[

]

nel discreto

nel continuo

che viene detto momento centrale r-esimo o momento di ordine r rispetto alla media (aritmetica).

Oltre al momento di ordine zero, non presenta alcuna rilevanza anche il momento di ordine

uno; infatti

32

B. Chiandotto

Statistica per le decisioni

Calcolo delle Probabilità

Versione 2006

µ 1 = E [g ( X )] = E [( X − µ )] = E ( X ) − E ( µ ) = µ − µ = 0

dove non si è più proceduto, essendo fatto ormai acquisito, alla esplicitazione del valore atteso in

termini di sommatoria o di integrale.

La trasformazione g(X) = ( X − µ ) si risolve con una traslazione dell’origine nel punto medio.

La variabile casuale trasformata si indica usualmente con il simbolo S x = ( X − µ ) e viene detta

variabile casuale scarto. Qualunque variabile casuale scarto ha, pertanto, il momento primo

sempre uguale a zero; cioè la media aritmetica di una qualunque variabile casuale scarto è uguale a

zero.

Il momento centrale di ordine due

µ 2 = E [g ( X )] = E [( X − µ ) 2 ] =

= E ( X 2 + µ 2 − 2µX ) = E ( X 2 ) + E ( µ 2 ) − 2µE ( X ) =

= µ 2 + µ 2 − 2µ 2 = µ 2 − µ 2 = σ 2

viene denominato varianza ed assume una rilevanza tutta particolare in quanto è l’indice più

utilizzato per sintetizzare la variabilità di una variabile casuale. Da sottolineare che il momento

centrale di ordine due µ 2 , cioè la varianza σ 2 , è uguale al momento secondo rispetto all’origine

(µ 2 ) meno il quadrato del momento primo rispetto all’origine (µ 2 )

σ 2 = µ 2 − µ12

Essendo la media

(aritmetica) e la varianza gli indici caratteristici più utilizzati per

sintetizzare in un solo valore, rispettivamente, la tipicità e la variabilità di una variabile casuale, si

incontrano spesso situazioni in cui interessa valutare l’effetto sulla media e sulla varianza di

particolari trasformazioni di variabili casuali. Interessa, ad esempio, in molti contesti di ricerca

procedere ad una trasformazione lineare (cambiamento del sistema di riferimento che si risolve

nella traslazione dell’origine e nel cambiamento dell’unità di misura con cui è espressa la variabile)

della variabile X

Y = a + bX

Se con µ x e σ x2 si indicano rispettivamente la media e la varianza della variabile casuale X ,

la media e la varianza della variabile casuale trasformata Y risultano dalla relazione

33

B. Chiandotto

Statistica per le decisioni

Calcolo delle Probabilità

Versione 2006

µ y = E (Y ) = E (a + bX ) = a + bµ x

cioè, la media di una trasformazione lineare di una variabile casuale è uguale alla trasformazione

lineare della media della variabile casuale originaria.

σ y2 = E [(Y − µ y ) 2 ] = E [(a + bX − a − bµ x ) 2 ] =

[

]

[

]

= E (bX − bµ x ) 2 = b 2 E ( X − µ x ) 2 = b 2σ x2

cioè, la varianza di una trasformazione lineare di una variabile casuale è pari alla varianza della

variabile casuale originaria moltiplicata per il quadrato del coefficiente angolare della

trasformazione.

Momenti standardizzati

⎛X −µ⎞

Ponendo g(X) = ⎜

⎟

⎝ σ ⎠

r

dove: µ è il momento primo (media aritmetica) della variabile casuale X e σ la radice quadrata

positiva della sua varianza σ 2 , si ha

⎧ k ⎛ xi − µ ⎞ r

⎜

⎟ f ( xi ) nel discreto

⎡⎛ X − µ ⎞ r ⎤ ⎪⎪∑

σ ⎠

i =1 ⎝

per r = 1, 2, ...

=

µ r = E [g ( X )] = E ⎢⎜

⎟ ⎥ ⎨

r

σ

b

⎝

⎠

−

x

µ

⎛

⎞

⎣⎢

⎦⎥ ⎪ ⎜

f ( x)dx nel continuo

⎪⎩∫a ⎝ σ ⎟⎠

che viene detto momento standardizzato r-esimo o momento standardizzato di ordine r .

La trasformazione (lineare), standardizzazione

Zx =

X −µ

σ

=−

µ 1

+ X

σ σ

è particolarmente rilevante in quanto, oltre a procedere alla traslazione nel punto medio, si utilizza

come nuova unità di misura il valore assunto dall’indice caratteristico di variabilità σ che prende il

nome di scostamento quadratico medio.

(

)

(

)

Oltre ai momenti standardizzati di ordine zero µ 0 = 1 e di ordine uno µ 1 = 0 anche il

momento standardizzato di ordine due è del tutto irrilevante; infatti

34

B. Chiandotto

Statistica per le decisioni

Calcolo delle Probabilità

Versione 2006

[

]

⎡⎛ X − µ ⎞ 2 ⎤

1

1

2

2

⎟ ⎥ = 2 E (X − µ ) = 2 ⋅σ = 1

σ

⎢⎣⎝ σ ⎠ ⎥⎦ σ

µ 2 = E ⎢⎜

cioè, per qualunque variabile casuale il secondo momento standardizzato è uguale a uno.

Particolare rilevanza assumono, invece, il momento terzo standardizzato

[

]

⎡⎛ X − µ ⎞ 3 ⎤ E ( X − µ )3

µ

µ 3 = E ⎢⎜

= 33 = γ 1

⎟ ⎥=

3

σ

σ

⎣⎢⎝ σ ⎠ ⎦⎥

che misura la simmetria (rispetto al valore centrale) delle distribuzioni, ed il momento quarto

standardizzato

[

]

⎡⎛ X − µ ⎞ 4 ⎤ E ( X − µ )4

µ

µ 4 = E ⎢⎜

= 44 = γ 2

⎟ ⎥=

4

σ

σ

⎣⎢⎝ σ ⎠ ⎦⎥

che misura la curtosi (appiattimento rispetto alla distribuzione normale che verrà analizzata nelle

pagine successive) della distribuzione.

Sui due indici di simmetria ( γ 1 ) e di curtosi (γ 2 ) si avrà modo di tornare successivamente,

dopo aver parlato della variabile casuale normale, mentre risulta conveniente definire altri due

indici caratteristici molto usati per sintetizzare gli aspetti di tipicità delle variabili casuali.

Il primo indice caratteristico che si considera è la moda di una variabile casuale. Si definisce

come moda ( M o ) di una distribuzione il valore della modalità cui corrisponde la probabilità (nel

caso discreto) o la densità di probabilità (nel caso continuo) più elevata.

Quando il massimo non è unico si parla di distribuzioni plurimodali; concetto questo che può

essere esteso anche a situazioni in cui si considerano non solo il massimo assoluto (della probabilità

o della densità di probabilità) ma anche i massimi relativi (massimi locali).

Il secondo indice caratteristico che serve ad evidenziare la tipicità delle variabili casuali è la

mediana. Si definisce come mediana ( M e ) di una variabile casuale continua il valore centrale della

distribuzione stessa; cioè il valore della modalità rispetto al quale si registra una probabilità pari a

0,50 di valori inferiori e pari a 0,50 di valori superiori.

Si può aver interesse alla individuazione di altri valori (segnaletici) particolari. Se la variabile

casuale è continua, il valore che è preceduto dal 25% dei casi e seguito dal 75% dei casi (Q1 ) e

quello preceduto dal 75% dei casi e seguito dal 25% dei casi (Q3 ) . I valori Q 1 e Q 3 vengono detti,

35

B. Chiandotto

Statistica per le decisioni

Calcolo delle Probabilità

Versione 2006

rispettivamente, primo e terzo quartile; ovviamente il secondo quartile Q2 è uguale alla Mediana.

In generale il p-esimo quantile, con 0 < p < 1 , è il valore, usualmente indicato con Qx(p), che

soddisfa la relazione P[ X ≤ Qx(p) ] = p.

Per le variabili casuali continue è possibile operare la suddivisione con una proporzione esatta

p di casi a sinistra ed una proporzione (1-p) esatta di casi a destra di Qx(p), mentre ciò non è

sempre possibile per le variabili casuali discrete. Infatti, per le variabili casuali discrete la massa di

probabilità del punto x = Qx(p) può essere diversa da zero, pertanto, la proporzione di valori a

sinistra di Qx(p) può essere ≤ p e la proporzione di valori a destra di Qx(p) può essere ≤ (1-p) .

Può accadere, cioè, che non esista alcun valore x per il quale F(x) = p, il quantile viene comunque

facilmente individuato in corrispondenza del valore Qx(p) nel quale si riscontra il salto della

funzione di distribuzione (da un valore inferiore a p ad un valore superiore a p ). Inoltre, sempre

per le variabili casuali discrete può accadere che la relazione F(x) = p valga per un intervallo di

valori di x, in questo caso il quantile si ottiene calcolando la semisomma degli estremi

dell’intervallo.

Momenti standardizzati

Ponendo

g ( X ) = X ( X − 1)( X − 2 ) ⋅ ⋅ ⋅ ⋅( X − r + 1)

si ottengono i momenti fattoriali di ordine r:

µ (r ) = E [g ( X )] = E [ X ( X − 1) (X - 2) ⋅ ⋅ ⋅ ⋅( X − r + 1)] .

Tra i momenti fattoriali ed i momenti rispetto all’origine valgono le relazioni sotto riportate;

relazioni che consentono di derivare i momenti rispetto all’origine (in qualche caso di difficile

computo) dai momenti fattoriali.

µ ( ) = µ1

1

µ ( 2 ) = µ 2 − µ1

µ (3 ) = µ 3 − 3 µ 2 + 2 µ1

⋅⋅⋅⋅⋅⋅⋅

Funzione Generatrice dei Momenti

Ponendo g(X) = etX , per ogni valore di t compreso nell’intervallo –h<t<h con h>0, si ha

( )

k

m( x ) (t ) = E e tx = ∑ e txi ⋅ f ( xi ) , se X è una v.c. discreta;

i =1

36

B. Chiandotto

Statistica per le decisioni

Calcolo delle Probabilità

Versione 2006

+∞

( )= ∫e

m x (t ) = E e

tx

tx

⋅ f ( x)dx , se X è una v.c. continua.

−∞

che viene detta funzione generatrice dei momenti (trasformata di Laplace) della v.c. X.

La funzione generatrice dei momenti, quando esiste, gode di importanti proprietà, tra questa

una delle più rilevanti è quella di consentire il computo immediato dei momenti rispetto all’origine;

infatti, se si sviluppa in serie etX

e tX = 1 + Xt +

X 2 t 2 X 3t 3

+

+ ⋅⋅⋅⋅

2!

3!

si ha:

( )

1

1

1

1

⎡

⎤

m x (t ) = E e tX = E ⎢1 + Xt + ( Xt ) 2 + ( Xt ) 3 + ......⎥ = 1 + µ1t + µ 2 t 2 + µ 3 .t 3 + ......

2!

3!

2!

3!

⎣

⎦

da cui

µr =

dr

m x (t )

dt r

t =0

per r = 1,2,….

Cioè, se si calcola la derivata r-esima della funzione generatrice dei momenti nel punto t = 0

si ottiene il momento r-esimo rispetto all’origine.

Ragionando in modo analogo, si possono definire la funzione generatrice dei momenti centrali

e la funzione generatrice dei momenti standardizzati.

La proprietà più rilevante della funzione generatrice dei momenti è l’univocità; cioè, essendo

in corrispondenza biunivoca con la funzione di distribuzione (e quindi con la funzione di massa o di

densità di probabilità) quella di identificare in modo univoco la v.c. di riferimento.

Una ulteriore importante proprietà è quella della conservazione del limite. Sia, X1, X2,…., Xn

una successione di v.c. con funzione di distribuzione F(xn) e funzione generatrice dei momenti

m xn (t ) ; allora, se

lim F ( x n ) = F ( x *)

n → +∞

si dimostra che

lim m xn (t ) = m x* (t )

n → +∞

Inoltre se m x (t ) è la funzione generatrice dei momenti della v.c. X, allora m y (bt ) è la

funzione generatrice dei momenti della v.c. Y = a + b X .

37

B. Chiandotto

Statistica per le decisioni

Calcolo delle Probabilità

Versione 2006

Esempio 2.10

Sia X una variabile casuale continua definita nell’intervallo con funzione di densità di

probabilità f ( x ) = λe − λx ( v.c. di tipo esponenziale1) si ha:

∞

λ

m(t ) = E ( e tX ) = ∫ e tx λe −λx dx =

λ −t

0

per t<λ

I momenti rispetto all’origine sono dati da:

m' (t ) =

m' ' (t ) =

λ

1

dm(t )

, quindi m' (0) = E ( X ) =

=

2

λ

dt

(λ − t )

2λ

2

dm' (t )

, quindi m' ' (0) = E ( X ) 2 = 2

=

3

λ

dt

(λ − t )

Mentre il secondo momento centrale (varianza) è data da

σ 2 = µ 2 − µ12 =

2

λ

2

−

1

λ

2

=

1

λ2

Funzione Generatrice dei Momenti Fattoriali

Ponendo g(X) = tX , dove t assume valori in un intorno di 1, si ha

( )

k

m( x ) (t ) = E t X = ∑ t xi ⋅ f ( xi ) , se X è una v.c. discreta;

i =1

+∞

( )= ∫t

m( x ) (t ) = E t

X

x

⋅ f ( x)dx , se X è una v.c. continua.

−∞

che viene detta funzione generatrice dei momenti fattoriali della v.c. X.

La derivata r-esima di questa funzione, quando esiste, nel punto t = 1 genera il momento

fattoriale di ordine r .

µ (r ) =

dr

m( x ) (t ) / t =1 = E [X (X - 1)(X - 2) ⋅ ⋅ ⋅ ⋅ ⋅ ( X − r + 1)]

dt r

Funzione Caratteristica

Trattando della funzione generatrice dei momenti è stata a più riprese aggiunta la

precisazione: “se esiste”; in effetti tale funzione potrebbe non esistere sia per v.c. discrete che

possono assumere una infinità numerabile di valori diversi sia per v.c. continue non essendo

convergente la somma di infiniti termini o l’integrale.

1

Una trattazione più puntuale della distribuzione esponenziale verrà proposta nelle pagine successive.

38

B. Chiandotto

Statistica per le decisioni

Calcolo delle Probabilità

Versione 2006

Se si pone g(X) = eitX , per ogni valore di t compreso nell’intervallo –h< t <h con h > 0 e

i = − 1 è l’unità immaginaria, la funzione sotto definita esiste sempre

( )

∞

m x (i t ) = E e itX = ∑ e itx f ( xi ) nel caso discreto

i =1

+∞

( ) ∫ e f (x ) dx

m x (i t ) = E e itX =

itx

nel caso continuo

−∞

infatti, se si considera, ad esempio il caso continuo si ha

∞

∞

−∞

-∞

( ) = E (cos t x + i sen t x ) = ∫ cos t x f (x ) dx + i ∫

m x (i t) = E e

itX

sen t x f ( x ) dx

essendo cos t x e sen t x assolutamente limitate, l’integrale sopra scritto è assolutamente

convergente (si può quindi calcolare) per qualunque valore di t compreso tra − ∞ e + ∞ .

La funzione sopra introdotta viene detta funzione caratteristica (trasformata di Fourier) della

v.c. X e gode di tutte le proprietà della funzione generatrice dei momenti ma, rispetto a quest’ultima

funzione, ha l’ulteriore proprietà di esistere sempre.

39

B. Chiandotto

Statistica per le decisioni

Calcolo delle Probabilità

Versione 2006

2.7 Variabili casuali discrete

Alcuni modelli probabilistici (tipi specifici di variabili casuali) si sono dimostrati

particolarmente utili in vari campi della ricerca applicata. Tra questi, ne vengono presentati alcuni,

tra quelli più comunemente usati, facendo riferimento al tipo di distribuzione ad essi associata.

2.7.1 Distribuzione Binomiale