caricato da

common.user19224

IndipendenzaVA

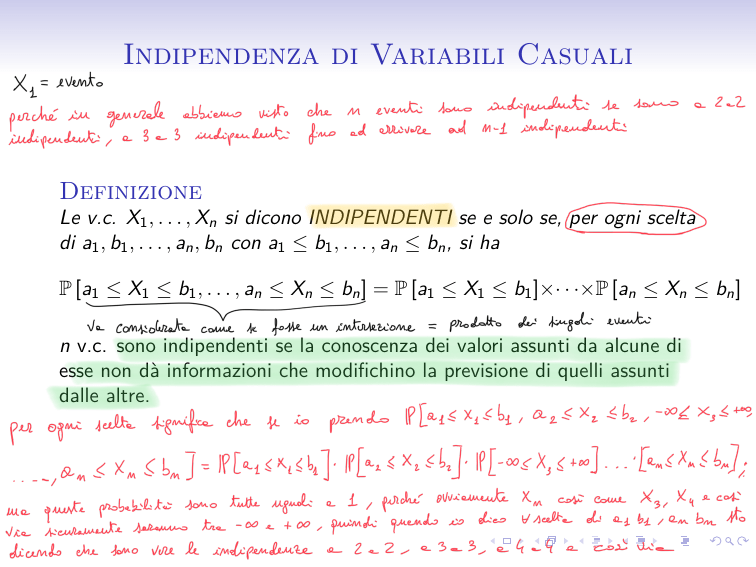

Indipendenza di Variabili Casuali

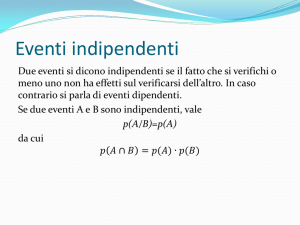

Definizione

Le v.c. X1 , . . . , Xn si dicono INDIPENDENTI se e solo se, per ogni scelta

di a1 , b1 , . . . , an , bn con a1 ≤ b1 , . . . , an ≤ bn , si ha

P [a1 ≤ X1 ≤ b1 , . . . , an ≤ Xn ≤ bn ] = P [a1 ≤ X1 ≤ b1 ]×· · ·×P [an ≤ Xn ≤ bn ]

n v.c. sono indipendenti se la conoscenza dei valori assunti da alcune di

esse non dà informazioni che modifichino la previsione di quelli assunti

dalle altre.

n=2

P [a1 ≤ X1 ≤ b1 , a2 ≤ X2 ≤ b2 ] = P [a1 ≤ X1 ≤ b1 ] P [a2 ≤ X2 ≤ b2 ]

che non significa altro che i due eventi {a1 ≤ X1 ≤ b1 } e {a2 ≤ X2 ≤ b2 }

sono indipendenti per ogni scelta di a1 ≤ b1 , a2 ≤ b2 .

Osservazione

Nel caso discreto, scegliendo a1 = b1 = x1 , . . . , an = bn = xn si ha

P [X1 = x1 . . . , Xn = xn ] = P [X1 = x1 ] × · · · × P [Xn = xn ]

ESEMPIO

Da un’urna contenente 6 palline numerate da 1 a 6, se ne estraggono 2

con rimpiazzo. Indichiamo con X1 il risultato della prima estrazione e con

X2 il risultato della seconda estrazione.

S = {(i, j) : i = 1, . . . , 6, j = 1, . . . , 6}

Le variabili casuali X1 e X2 prendono entrambe i valori interi da 1 a 6

ognuno con probabilità 1/6 perchè i valori sono equiprobabili.

(

1

per z = 1, 2, 3, 4, 5, 6

P[X1 = z] = P[X2 = z] = 6

0 altrimenti

(

P[X1 = ī, X2 = j̄] =

1

36

0

per (ī, j̄) ∈ S

altrimenti

Proposizione

Se X e Y sono variabili casuali indipendenti ed hanno speranza

matematica finita, allora anche il prodotto XY ha speranza matematica

finita e si ha

E[XY ] = E[X ]E[Y ]