caricato da

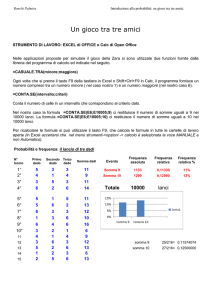

common.user13213

Analisi Statistica Dati: Variabili Discrete e Continue

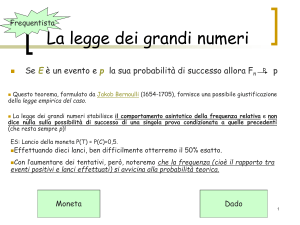

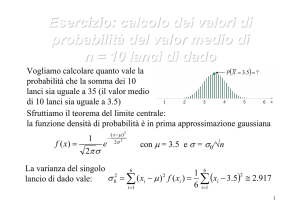

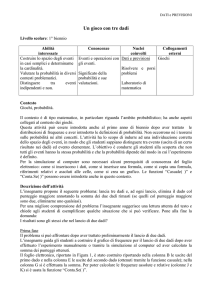

Prof. Luca Lozzi Dipartimento di Scienze fisiche e chimiche Università degli Studi dell’Aquila Mail: [email protected]; [email protected] Web page: http://www.dsfc.univaq.it/lozzi/ Versione 13/01/2021 1 Introduzione all’analisi statistica dei dati Quando si fanno esperimenti, non solo di fisica, si possono avere diverse situazioni per quanto riguarda i dati sperimentali raccolti: a) Dati su una grandezza con dipendenza temporale o spaziale b) Dati raccolti su un numero di individui che costituiscono un sottoinsieme (campione) di un insieme più grande (popolazione) c) Dati su una grandezza che varia in modo casuale e che non è possibile misurare con maggiore precisione d) Dati sulla misura di una grandezza ben definita ma i cui valori possono esser etra loro diversi. Il caso a) si riferisce al caso in cui la grandezza stessa dipende dal tempo o dalla posizione. Esempi sono la dipendenza temporale della temperatura di un oggetto che si raffredda con il tempo (come quella osservata durante l’esercitazione di laboratorio), o l’attenuazione con il tempo dell’ampiezza di oscillazione di un pendolo semplice (esperienza di laboratorio), o la dipendenza con l’altezza dal livello del mare della pressione atmosferica o della temperatura di ebollizione dell’acqua. Il caso b) si riferisce in generale a dati che riguardano tipicamente esperimenti di biologia, psicologia, medicina ecc. in cui si osserva un campione di “individui” (cioè un numero limitato di casi) rispetto alla totalità dei casi 2 osservabili (popolazione). Esempio la conta del numero di batteri che si sviluppano in una cultura, il numero di persone con occhi neri in una città, ecc. Il caso c) fa riferimento a misure in cui una grandezza ha un valore teoricamente ben definito ma che è molto difficile da determinare a causa della natura stessa della misura. Esempio tipico è il decadimento di una sostanza radioattiva con l’emissione di particelle, il processo è ben noto così come la probabilità di emissione ma dato il gran numero di particelle coinvolte il numero di particelle emesse fluttua nel tempo. Il caso d) è quello che ci interessa maggiormente in questo momento, e riguarda il caso di misure che sono influenzate da un numero imprecisato di piccoli effetti che non possono essere controllati e modificano le condizioni di misura per cui la misura stessa non è completamente riproducibile. In questo caso la sensibilità dello strumento utilizzato è inferiore alla riproducibilità della misura stessa. Esempio: se misuriamo la lunghezza di una matita con un righello la cui sensibilità è di 1 cm è ovvio che tutte le misure, comunque le facciamo, daranno lo stesso risultato. Viceversa se usiamo un calibro ventesimale (sensibilità 0,05 mm) la misura può dipendere da come posizioniamo il calibro, da quanto stringiamo i becchi ecc. e quindi potremmo ottenere valori diversi. E’ quest’ultimo caso quello che vogliamo esaminare in questo momento. 3 Quindi parliamo di risultati di misure di una grandezza affette da errori o incertezze casuali (random, stocastiche, aleatorie) dovuti a tante cause che non si riescono a controllare. Quindi questi risultati li possiamo considerare come delle variabili e l’insieme dei costituisce un campionamento, cioè un insieme di dati che possono far parte di una popolazione. Le variabili casuali possono essere discrete o continue. Sono discrete se i valori che possono assumere sono numeri naturali (interi, 𝑥𝑥 ∈ 𝑁𝑁) e adimensionale. Esempi sono il lancio di un dado, di una moneta, ecc. Le variabili sono di natura continua se sono il risultato di una misura e si ottiene pertanto un numero reale (𝑥𝑥 ∈ 𝑅𝑅) con un certo numero di cifre significative alcune delle quali possono cambiare a causa delle fluttuazioni durante la misura. Variabili discrete Esempio: lanciamo un dado N volte e otteniamo: 1, 3, 5, 2, 3, 2, 2, 4, 5, 6, 3, 1, 1, 5, 4, ………3 Quindi abbiamo un campione finito di dati (N) e possiamo determinare il numero di volte di uscita delle varie facce. 4 Indichiamo con k il risultato del lancio (quindi k=1, 2, 3, 4, 5, 6), con nk il numero di volte che esce il k-esimo valore e quindi definire la frequenza, fk come: 𝑛𝑛𝑘𝑘 𝑁𝑁 cioè il rapporto tra il numero di volte che è uscito il k-esimo risultato e il totale del campione. Ovviamente 𝑓𝑓𝑘𝑘 = 𝑓𝑓𝑘𝑘 ≤ 1 Dividere il numero dei risultati positivi, nk, per il numero totale dei risultati (N, o campione) è un processo molto utilizzato in fisica ed è chiamato normalizzazione, e serve per confrontare i risultati con i dati di altri sperimentatori. A volte la frequenza è data in percentuale: 𝑛𝑛𝑘𝑘 × 100 𝑁𝑁 Il campione N è una parte della popolazione, che può essere finita (es. su 1.000 persone quante hanno gli occhi 𝑓𝑓𝑘𝑘 (%) = azzurri) o infinita (il lancio di un dado, in cui in teoria potremmo avere un numero infinito di lanci). A volte si usa il simbolo di variabile xk per distinguere il risultato dai possibili risultati, es. se il risultato può essere 0 o 1, si indicherà k=1, x1=0 e k=2, x2=1. 5 Dalla definizione di frequenza è ovvio che, se indichiamo con p il numero dei possibili risultati (k=1, 2, …p), avremo: 𝑝𝑝 𝑝𝑝 𝑝𝑝 𝑘𝑘=1 𝑘𝑘=1 𝑘𝑘=1 𝑛𝑛𝑘𝑘 1 1 � 𝑓𝑓𝑘𝑘 = � = � 𝑛𝑛𝑘𝑘 = 𝑁𝑁 = 1 𝑁𝑁 𝑁𝑁 𝑁𝑁 Nel lancio dei dadi p=6, nel lancio di una moneta p=2, nel caso del colore degli occhi (possibili: neri, marroni, verdi, azzurri, indefinito) p=5, ecc… Possiamo definire anche la funzione cumulativa (o di ripartizione): 𝑘𝑘 𝐹𝐹𝑘𝑘 = � 𝑓𝑓𝑙𝑙 𝑐𝑐𝑐𝑐𝑐𝑐 𝑘𝑘 ≤ 𝑝𝑝 𝑙𝑙=1 Ovviamente: 𝑝𝑝 𝑝𝑝 𝑙𝑙=1 𝑙𝑙=1 𝑝𝑝𝑝𝑝𝑝𝑝 𝑘𝑘 = 𝑝𝑝, 𝐹𝐹𝑝𝑝 = � 𝑓𝑓𝑙𝑙 = � Altre proprietà della funzione cumulativa: 𝑛𝑛𝑙𝑙 =1 𝑁𝑁 lim 𝐹𝐹𝑘𝑘 = 1 𝑘𝑘→∞ cioè qualunque sia il valore di p, quando k tende all’infinito vuol dire che comunque si raggiunge il valore limite di 1. E’ una successione non decrescente (si sommano sempre termini positivi, per definizione). 6 Esempio: lancio di un dado 20 volte k=1, 2, 3, 4, 5, 6 xk= 1, 2, 2, 1, 2, 6, 1, 3, 3, 1, 2, 3, 6, 2, 5, 6, 6, 5, 1, 6 N=20 𝑘𝑘 1 1 5 𝑛𝑛𝑘𝑘 𝑓𝑓𝑘𝑘 = 𝑁𝑁 2 2 5 0,25 0,50 3 3 3 0,15 0,65 4 4 0 0 0,65 5 5 2 0,10 0,75 6 6 5 0,25 1,00 k xk nk 0,25 𝐹𝐹𝑘𝑘 = � 𝑓𝑓𝑙𝑙 𝑙𝑙=1 0,25 7 Per rappresentare questi dati discreti si usano gli istogrammi a barre “strette” (o a segmenti verticali) Lancio di 1 dado: frequenze 6 0.3 5 0.25 4 0.2 3 0.15 fk nk Lancio di 1 dado: numero uscite per intervallo 2 0.1 1 0.05 0 0 1 2 3 k 4 5 6 1 2 3 k 4 5 6 Lancio di 1 dado: cumulativa 1.2 1 0.8 Fk 0.6 0.4 0.2 0 0 1 2 3 4 k 5 6 7 8 8 Come si vede la funzione cumulativa è una funzione a gradino. Notare che F(k)=0 a sinistra del primo intervallo. Esempio: uscita di 20 numeri casuali da 0-6 k=1, 2, 3, 4, 5, 6, 7 xk= 4, 6, 4, 4, 6, 6, 2, 2, 5, 4, 2, 2, 0, 2, 0, 2, 4, 6, 3, 1 N=20 𝑘𝑘 1 0 2 𝑛𝑛𝑘𝑘 𝑓𝑓𝑘𝑘 = 𝑁𝑁 0,10 0,10 2 1 1 0,05 0,15 3 2 6 0,30 0,45 4 3 1 0,05 0,50 5 4 5 0,25 0,75 6 5 1 0,05 0,80 7 6 4 0,20 1,00 k xk nk 𝐹𝐹𝑘𝑘 = � 𝑓𝑓𝑙𝑙 𝑙𝑙=1 9 Numeri casuali: frequenze Numeri casuali: numero uscite per intervallo 0.35 7 0.3 6 0.25 5 0.2 fk nk 4 3 0.15 2 0.1 1 0.05 0 1 2 3 4 k 5 6 0 7 1 2 3 4 5 6 7 k Numeri casuali: cumulativa 1.2 1 0.8 Fk 0.6 0.4 0.2 0 0 1 2 3 4 k 5 6 7 8 9 10 Variabili continue Se i valori misurati della grandezza assumono valori continui (es. misuriamo la massa di un oggetto e otteniamo sempre valori diversi di massa) la procedura è leggermente diversa. Per prima cosa si divide l’intervallo complessivo dei valori possibili di x in “intervallini” contigui (o classi, bins in inglese) identificati da un indice (es. j) in modo da contare il numero dei valori nj ottenuti nel singolo intervallo Ij: 𝑥𝑥𝑗𝑗 ≤ 𝑥𝑥 < 𝑥𝑥𝑗𝑗+1 Notare che uno degli estremi dell’intervallo è incluso l’altro estremo è escluso, questo vuol dire che se un valore cade su una estremità dell’intervallo questo valore è assegnato ad un solo intervallo (o il precedente o il seguente, a seconda se usiamo 𝑥𝑥𝑗𝑗 ≤ 𝑥𝑥 < 𝑥𝑥𝑗𝑗+1 𝑜𝑜𝑜𝑜𝑜𝑜𝑜𝑜𝑜𝑜𝑜𝑜 𝑥𝑥𝑗𝑗 < 𝑥𝑥 ≤ 𝑥𝑥𝑗𝑗+1 ), se entrambi gli estremi fossero inclusi un dato che cade su un estremo sarebbe contato 2 volte. L’ampiezza dell’intervallo è definito come: ∆𝑥𝑥𝑗𝑗 = 𝑥𝑥𝑗𝑗+1 − 𝑥𝑥𝑗𝑗 Da notare che gli intervalli sono: 11 ∆𝑥𝑥1 = 𝑥𝑥2 − 𝑥𝑥1 , ∆𝑥𝑥2 = 𝑥𝑥3 − 𝑥𝑥2 , ∆𝑥𝑥3 = 𝑥𝑥4 − 𝑥𝑥3 cioè l’indice dell’intervallo è individuato dall’estremo sinistro (con l’indice minore), in modo tale che il primo intervallo coincida con il primo valore ecc. (ovviamente se il primo dato ha indice zero, x0, anche il primo intervallo ha indice zero, ∆𝑥𝑥0 = 𝑥𝑥1 − 𝑥𝑥0 ). Gli intervalli Δx non necessariamente devono essere uguali (anche se quando possibili è meglio…), pertanto si definisce anche la densità di frequenza: 𝜑𝜑𝑗𝑗 = 𝑓𝑓𝑗𝑗 ∆𝑥𝑥𝑗𝑗 Questa grandezza ha le dimensioni dell’inverso dell’intervallo Δx (che potrebbe essere un tempo, un massa, ecc.. dipende dalla grandezza x): �𝜑𝜑𝑗𝑗 � = [𝑥𝑥 ]−1 Anche in questo caso definiamo la funzione cumulativa, essendo p=numero di intervalli: 𝑘𝑘 Anche in questo caso valgono le regole: 𝐹𝐹𝑘𝑘 = � 𝑓𝑓𝑙𝑙 𝑐𝑐𝑐𝑐𝑐𝑐 𝑘𝑘 ≤ 𝑝𝑝 𝑙𝑙=1 12 𝑝𝑝 𝑝𝑝 𝑘𝑘=1 𝑘𝑘=1 � 𝑓𝑓𝑘𝑘 = � 𝑝𝑝 𝑛𝑛𝑘𝑘 1 1 = � 𝑛𝑛𝑘𝑘 = 𝑁𝑁 = 1 𝑁𝑁 𝑁𝑁 𝑁𝑁 lim 𝐹𝐹𝑘𝑘 = 1 𝑘𝑘→∞ 𝑘𝑘=1 Quindi in questo caso abbiamo le seguenti informazioni: j Ij nj fj Fj Δxj φj 0 (𝑥𝑥1 , 𝑥𝑥0 ] n0 f0 F 0= f 0 n1 f1 F1= f0+f1 ∆𝑥𝑥0 = 𝑥𝑥1 − 𝑥𝑥0 𝑓𝑓0 �∆𝑥𝑥 0 (𝑥𝑥3 , 𝑥𝑥2 ] n2 f2 F2= f0+f1+f2 ∆𝑥𝑥2 = 𝑥𝑥3 − 𝑥𝑥2 𝑓𝑓2 �∆𝑥𝑥 2 1 2 ….. (𝑥𝑥2 , 𝑥𝑥1 ] ∆𝑥𝑥1 = 𝑥𝑥2 − 𝑥𝑥1 𝑓𝑓1 �∆𝑥𝑥 1 Con (𝑥𝑥1 , 𝑥𝑥0 ] si intende: 𝑥𝑥1 < 𝑥𝑥 ≤ 𝑥𝑥0 cioè l’estremo x1 NON è compreso nell’intervallo mentre l’estremo x0 è compreso nell’intervallo. L’indice j può partire anche da 1. 13 Per rappresentare questi dati si usano gli istogrammi a colonne di altezza φj e di larghezza Δxj (a volte si usa anche indicare fj se gli intervalli sono tutti di uguale ampiezza Δx). L’area di ogni colonna vale: 𝑎𝑎𝑗𝑗 = 𝜑𝜑𝑗𝑗 ∆𝑥𝑥𝑗𝑗 = 𝑓𝑓𝑗𝑗 Quindi per ogni intervallo l’altezza della colonna indica la densità di frequenza e l’area la frequenza. L’area totale delle colonne: 𝑝𝑝 𝑝𝑝 𝑝𝑝 𝑗𝑗=1 𝑗𝑗=1 𝑗𝑗=1 𝐴𝐴 = � 𝑎𝑎𝑗𝑗 = � 𝜑𝜑𝑗𝑗 ∆𝑥𝑥𝑗𝑗 = � 𝑓𝑓𝑗𝑗 = 1 Quindi anche l’area totale è normalizzata, cioè vale 1. Da notare quindi che in questo caso la normalizzazione riguarda l’area dei rettangoli mentre nel caso della distribuzione discreta riguarda le altezze dei rettangoli. Questa rappresentazione concorda con l’idea che stiamo rappresentando dati formalmente continui all’interno dell’intervallo scelto, e questi hanno una costante densità di frequenza φj. 14 In questo caso la funzione cumulativa di frequenza F(x) può essere calcolata per ogni valore intermedio all’intervallo ed è continua all’interno degli intervalli ed è una spezzata quando si passa da un intervallo ad un altro, collegando i punti di coordinate (xj+1, Fj). Esempio: altezza di studenti (N=20) {xi} ≡ {1.54, 1.53, 1.65, 1.48, 1.55, 1.63, 1.49, 1.52, 1.65, 1,68 1.51, 1.55, 1.57, 1.49, 1.57, 1.62, 1.45, 1.53, 1.57, 1.60} Ordinati (crescendo): 1.45, 1.48, 1.49, 1.49, 1.51, 1.52, 1.53, 1.53, 1.54, 1.55, 1.55, 1.57, 1.57, 1.57, 1.60, 1.62, 1.63, 1.65, 1.65, 1.68 limiti classi (x1, x2] 1.35-1.40 1.40-1.45 1.45-1.50 1.50-1.55 1.55-1.60 1.60-1.65 1.65-1.70 1.70-1.75 estremo sx limite, xj 1.35 1.40 1.45 1.50 1.55 1.60 1.65 1.70 j nj fj Fj Δxj=xj+1-xj ϕj=fj/Δxj ϕjΔxj 0 1 2 3 4 5 6 7 0 1 3 7 4 4 1 0 0.00 0.05 0.15 0.35 0.20 0.20 0.05 0.00 0.00 0.05 0.20 0.55 0.75 0.95 1.00 1.00 0.05 0.05 0.05 0.05 0.05 0.05 0.05 0.05 0 1 3 7 4 4 1 0 0.00 0.05 0.15 0.35 0.20 0.20 0.05 0.00 15 0.4 8 Frequenze Densità di frequenze 7 0.3 6 ϕ 0.2 4 3 0.1 2 1 0.0 1.35 1.40 1.45 1.50 1.55 1.60 1.65 0 1.35 1.70 X(m) 1.40 1.45 1.50 1.55 1.60 1.65 1.70 X(m) Densità di frequenze 8 7 6 5 ϕ f 5 4 3 2 1 0 1.35-1.40 1.40-1.45 1.45-1.50 1.50-1.55 1.55-1.60 1.60-1.65 1.65-1.70 1.70-1.75 x (m) 16 Nel caso di utilizzo di intervalli con ampiezza diversa: limiti classi (x1, x2] 1.35-1.40 1.40-1.50 1.50-1.55 1.55-1.60 1.60-1.70 1.70-1.80 Totali estremo sx limite, xj 1.35 1.40 1.50 1.55 1.60 1.70 j nj 0 1 2 3 4 5 fj 0 4 7 4 5 0 20 0 0.20 0.35 0.20 0.25 0.00 1.00 0 0.20 0.55 0.75 1.00 1.00 8 8 7 7 6 6 5 5 4 4 ϕ ϕ Densità di frequenze: intervalli con diversa ampiezza 3 3 2 2 1 1 0 1.35-1.40 1.40-1.50 1.50-1.55 1.55-1.60 x (m) 1.60-1.70 1.70-1.80 Δxj=xj+1-xj Fj 0 ϕj=fj/Δxj 0.05 0.1 0.05 0.05 0.1 0.1 0 2 7 4 2.5 0 ϕjΔxj 0 0.20 0.35 0.20 0.25 0.00 1.00 Densità di frequenze: intervalli con stessa ampiezza 1.35-1.40 1.40-1.45 1.45-1.50 1.50-1.55 1.55-1.60 1.60-1.65 1.65-1.70 1.70-1.75 x (m) 17 In linea di principio la rappresentazione dei dati è tanto più fedele alla realtà quanto più l’intervallo Δx è piccolo, soprattutto per N molto grande. Ma è anche vero che se Δx→0 anche le frequenze, per N grande, tendono a 0 e si perde l’informazione generale sulla distribuzione dei dati. Nel limite Δx→0 (per N→ grande) possiamo pensare che la densità di frequenza φj diventa una funzione continua f(x), tale che: 𝑝𝑝 𝐴𝐴 = � 𝜑𝜑𝑗𝑗 ∆𝑥𝑥𝑗𝑗 = 1 → 𝑗𝑗=1 +∞ � 𝑓𝑓(𝑥𝑥 )𝑑𝑑𝑑𝑑 = 1 −∞ I limiti dell’integrale indicano che stiamo includendo tutti i dati ottenuti, come la sommatoria è fatta su tutti gli intervalli contenenti i dati. Quindi abbiamo la normalizzazione di una funzione continua. Da notare che questo è un passaggio simile a quello che vedrete quando si passerà dal concetto di frequenza (termine che indica dati sperimentali) al concetto di probabilità (dato teorico). 18 Se limitiamo la sommatoria ad un intervallo ristretto, cioè parliamo delle frequenze di uscita di alcuni dati negli intervalli indicati dai limiti p1 e p2, allora il passaggio al continuo: 𝑝𝑝2 𝑏𝑏 � 𝜑𝜑𝑗𝑗 ∆𝑥𝑥𝑗𝑗 → � 𝑓𝑓(𝑥𝑥 )𝑑𝑑𝑑𝑑 𝑗𝑗=𝑝𝑝1 𝑎𝑎 Quindi l’integrale tra a e b (i limiti nel continuo che corrispondono agli indici p1 e p2 che identificano gli intervalli j coinvolti) indica la frequenza di uscita dei dati tra a e b. Analogamente possiamo trattare la funzione cumulativa. Nel caso discreto abbiamo: 𝑘𝑘 𝐹𝐹𝑘𝑘 = � 𝑓𝑓𝑙𝑙 𝑐𝑐𝑐𝑐𝑐𝑐 𝑘𝑘 ≤ 𝑝𝑝 𝑙𝑙=1 Passando a variabili continue, per Δx→0 (N→ grande): 𝑥𝑥 𝐹𝐹 (𝑥𝑥 ) → � 𝑓𝑓 (𝑥𝑥′)𝑑𝑑𝑑𝑑′ −∞ 19 Inoltre, dalla definizione di probabilità (che si vedrà in seguito) si dimostra che: 𝐹𝐹𝑗𝑗+1 − 𝐹𝐹𝑗𝑗 = 𝜑𝜑𝑗𝑗 ∆𝑥𝑥𝑗𝑗 = 𝑓𝑓𝑗𝑗 Pertanto: 𝐹𝐹𝑗𝑗+1 − 𝐹𝐹𝑗𝑗 = 𝜑𝜑𝑗𝑗 ∆𝑥𝑥𝑗𝑗 → 𝜑𝜑𝑗𝑗 = 𝐹𝐹𝑗𝑗+1 − 𝐹𝐹𝑗𝑗 𝐹𝐹 (𝑥𝑥 + ∆𝑥𝑥 ) − 𝐹𝐹(𝑥𝑥) = ∆𝑥𝑥𝑗𝑗 ∆𝑥𝑥 nel limite di Δx→0 𝑑𝑑𝑑𝑑 = 𝑓𝑓(𝑥𝑥) 𝑑𝑑𝑑𝑑 Quindi, all’interno della singola classe, dove la funzione cumulativa è continua, la sua derivata (costante) corrisponde alla densità di frequenza (continua). 20 Funzione cumulativa: - la spezzata (rossa) collega i punti di coordinate (xj+1, Fj), ovvero (x1, F0), (x2, F1), (x3, F2),.. ed è una funzione continua all’interno di ogni singolo intervallo e indica che, poiché usando un istogramma con classi che cumulano in ogni singolo intervallo tutti i dati in esso contenuti, la densità di frequenza è costante in quell’intervallo. - La curva a tratti rappresenta la funzione cumulativa Funzione cumulativa 1.2 1 F 0.8 0.6 0.4 0.2 0 1.35 1.40 1.45 1.50 1.55 1.60 1.65 1.70 1.75 x (m) 21 Frequenza e probabilità Abbiamo definito la frequenza con una definizione sperimentale: 𝑛𝑛𝑘𝑘 𝑓𝑓𝑘𝑘 = 𝑁𝑁 essendo N il numero delle prove fatte (o dimensione del campione) e nk il numero delle volte che si ottiene il risultato k (o xk). Dal punto di vista teorico invece possiamo definire la probabilità pk che si ottenga il risultato k come: 𝑝𝑝𝑘𝑘 = 𝑛𝑛𝑛𝑛𝑛𝑛𝑛𝑛𝑛𝑛𝑛𝑛 𝑑𝑑𝑑𝑑 𝑐𝑐𝑐𝑐𝑐𝑐𝑐𝑐 𝑓𝑓𝑓𝑓𝑓𝑓𝑓𝑓𝑓𝑓𝑓𝑓𝑓𝑓𝑓𝑓𝑓𝑓𝑓𝑓 𝑛𝑛𝑛𝑛𝑛𝑛𝑛𝑛𝑛𝑛𝑛𝑛 𝑑𝑑𝑑𝑑 𝑐𝑐𝑐𝑐𝑐𝑐𝑐𝑐 𝑝𝑝𝑝𝑝𝑝𝑝𝑝𝑝𝑝𝑝𝑝𝑝𝑝𝑝𝑝𝑝𝑝𝑝 Questo vale se tutti i casi favorevoli sono equiprobabili. Esempio il lancio del dado. Abbiamo 6 possibili risultati, k= 1, 2, 3, 4, 5, 6, tutti equiprobabili (è sempre vero ???), in questo caso possiamo dire che: 𝑝𝑝𝑘𝑘 = 1 6 per ogni k A volte, come abbiamo già detto, si indica con k l’indice dell’evento e con xk il valore dell’evento, in questo caso abbiamo che: 22 1 𝑝𝑝𝑝𝑝𝑝𝑝 𝑜𝑜𝑜𝑜𝑜𝑜𝑜𝑜 𝑥𝑥𝑘𝑘 = 1, 2, 3, 4, 5, 6 6 Altro esempio semplice è il lancio di una moneta, in questo caso abbiamo solo 2 possibilità, k=1, 2: 𝑝𝑝𝑘𝑘 = 1 𝑝𝑝𝑝𝑝𝑝𝑝 𝑜𝑜𝑜𝑜𝑜𝑜𝑜𝑜 𝑥𝑥𝑘𝑘 = 𝑡𝑡𝑡𝑡𝑡𝑡𝑡𝑡𝑡𝑡, 𝑐𝑐𝑐𝑐𝑐𝑐𝑐𝑐𝑐𝑐 𝑝𝑝𝑝𝑝𝑝𝑝 𝑘𝑘 = 1, 2 (𝑜𝑜 𝑣𝑣𝑣𝑣𝑣𝑣𝑣𝑣𝑣𝑣𝑣𝑣𝑣𝑣𝑣𝑣𝑣𝑣 … ) 2 Esistono ovviamente casi in cui definire la probabilità del singolo evento è più difficile, per esempio: determinare 𝑝𝑝𝑘𝑘 = la probabilità che 3 figli di una coppia siano dello stesso sesso. In questo caso possiamo avere i seguenti casi: MMM, MMF, MFM, FMM, MFF, FMF, FFM, FFF (F= femmina, M=maschio). Quindi abbiamo 8 casi possibili e di questi solo 2 (MMM e FFF) presentano i figli dello stesso sesso. Pertanto abbiamo: 𝑝𝑝𝑘𝑘 = 2 1 = 𝑐𝑐𝑐𝑐𝑐𝑐 𝑘𝑘 = 1 (𝑡𝑡𝑡𝑡𝑡𝑡𝑡𝑡𝑡𝑡 𝑑𝑑𝑑𝑑𝑑𝑑𝑑𝑑𝑑𝑑 𝑠𝑠𝑠𝑠𝑠𝑠𝑠𝑠𝑠𝑠𝑠𝑠 𝑠𝑠𝑠𝑠𝑠𝑠𝑠𝑠𝑠𝑠) 8 4 Di conseguenza avremo i casi in cui non sono tutti dello stesso sesso: 𝑝𝑝𝑘𝑘 = 6 3 = 𝑐𝑐𝑐𝑐𝑐𝑐 𝑘𝑘 = 2 (𝑛𝑛𝑛𝑛𝑛𝑛 𝑡𝑡𝑡𝑡𝑡𝑡𝑡𝑡𝑡𝑡 𝑑𝑑𝑑𝑑𝑑𝑑𝑑𝑑𝑑𝑑 𝑠𝑠𝑠𝑠𝑠𝑠𝑠𝑠𝑠𝑠𝑠𝑠 𝑠𝑠𝑠𝑠𝑠𝑠𝑠𝑠𝑠𝑠) 8 4 Anche in questo caso si presume che la nascita di un maschio o di una femmina siano equiprobabili. 23 Esistono anche altre definizioni di probabilità che esulano da quanto interessa in questo corso, come la probabilità che domani piova o che il cavallo Pippo vinca la gara di Agnano….(con questo nome forse poche…). In questi casi la probabilità può essere valutata in base a conoscenze preliminari, quali le condizioni metereologiche o la salute del cavallo Pippo e dei suoi avversari, ecc.. Dal punto di vista sperimentale ci si può aspettare che la frequenza (sperimentale) fk tenda alla probabilità (teorica) pk se il numero delle prove N tende ad un numero grande (o la dimensione del campione tende alla popolazione, se questa è finita). Quindi spesso si trova che: 𝑛𝑛𝑘𝑘 𝑁𝑁→∞ 𝑁𝑁 𝑝𝑝𝑘𝑘 = lim 𝑓𝑓𝑘𝑘 = lim 𝑁𝑁→∞ Questo non è matematicamente corretto perché essendo fk una successione, la definizione di sopra vorrebbe dire che per ogni ε >0 esiste un numero M naturale tale che per N>M si ha: �𝑓𝑓𝑘𝑘 𝑁𝑁 − 𝑝𝑝𝑘𝑘 � < ε dove 𝑛𝑛𝑘𝑘 𝑁𝑁 Questo sperimentalmente non è detto che avvenga (lanciando il dado 1.000 volte ci si aspetta che la frequenza 𝑓𝑓𝑘𝑘 𝑁𝑁 = sia di circa 1/6, ma non è detto….), anche se il limite si usa spesso come evidenza sperimentale. 24 L’insieme delle pk, cioè l’insieme delle probabilità, costituisce la distribuzione di probabilità della variabile casuale xk associata all’indice k. Questa distribuzione caratterizza la popolazione rispetto all’esperimento. Ricordiamo che durante l’esperimento noi osserviamo un campione della popolazione. La popolazione può essere finita (numero degli individui, degli esemplari, ecc…) o infinita (lanci dei dadi, numero di misure della massa di un oggetto, ecc...), in ogni caso noi facciamo sempre un numero N di osservazioni (il campione), quasi sempre inferiore alla popolazione. Ci sono alcuni parametri che servono a caratterizzare sia la distribuzione delle frequenze (dato sperimentale) che delle probabilità (valore teorico), i più importanti sono chiamati indici di posizione e di dispersione. 25 Indice di posizione Come indice di posizione, che in qualche modo rappresenta dove si trova la distribuzione dei dati sperimentali, possiamo pensare a diverse definizioni: - Centro dell’intervallo dei dati sperimentali (𝑥𝑥𝑐𝑐 = 𝑥𝑥𝑚𝑚𝑚𝑚𝑚𝑚 +𝑥𝑥𝑚𝑚𝑚𝑚𝑚𝑚 2 ): è il valore che abbiamo usato per indicare il dato sperimentale che meglio rappresentava tutti i dati ottenuti. Questo valore non dà alcuna informazione su come sono distribuiti i dati intermedi; - Mediana: è il valore della variabile x che divide a metà il campione, cioè per cui la metà dei valori sono più piccoli di questa e metà più grandi, o, usando la definizione di frequenza cumulativa F(x), si ha che per x=xmediana F(xmediana)=0,5; - Moda: valore della variabile per cui la distribuzione di frequenze ha il valore massimo (possono esserci più massimi, in questo caso la distribuzione si dice multimodale); - Media aritmetica: avendo N dati sperimentali: 𝑁𝑁 1 𝑥𝑥̅ = � 𝑥𝑥𝑗𝑗 𝑁𝑁 𝑗𝑗=1 26 Queste definizioni si possono generalizzare introducendo la grandezza: 𝑁𝑁 𝑓𝑓𝑛𝑛 (𝑎𝑎) = ��𝑥𝑥𝑗𝑗 − 𝑎𝑎� 𝑗𝑗=1 𝑛𝑛 dove a indica il valore della variabile x che rappresenta la distribuzione delle frequenze in esame. La presenza del valore assoluto garantisce che sono tutti termini positivi (necessario nel caso di n dispari). Per valori di a > di ogni xj la fn(a) è crescente al crescere di a, mentre per a< di ogni xj la fn(a) è crescente per valori di a decrescenti Es. supponiamo xj (min)= 1 e xj (max)= 2: 𝑛𝑛 - per a=3, 4, 5…. �𝑥𝑥𝑗𝑗 − 𝑎𝑎� = 1𝑛𝑛 , 2𝑛𝑛 , 3𝑛𝑛 … . (𝑒𝑒𝑒𝑒. 𝑛𝑛 = 1: 1, 2, 3 … ; 𝑛𝑛 = 2: 1, 4, 9 … ; 𝑛𝑛 = 3: 1, 8, 27 … ) 𝑛𝑛 - 𝑝𝑝𝑝𝑝𝑝𝑝 𝑎𝑎 =< 𝑥𝑥𝑗𝑗 (𝑑𝑑𝑑𝑑 𝑞𝑞𝑞𝑞𝑞𝑞𝑞𝑞𝑞𝑞𝑞𝑞 𝑥𝑥𝑗𝑗 (𝑚𝑚𝑚𝑚𝑚𝑚)), 𝑒𝑒𝑒𝑒. : 𝑎𝑎 = 0.2, 0.5, 0.8 … → �𝑥𝑥𝑗𝑗 − 𝑎𝑎� = |1 − 0.2|𝑛𝑛 = 0.8𝑛𝑛 , |1 − 0.5|𝑛𝑛 = 0.5𝑛𝑛 , |1 − 0.8|𝑛𝑛 = 0.2𝑛𝑛 … . (𝑒𝑒𝑒𝑒. 𝑛𝑛 = 1: 0.8, 0.5, 0.2 … ; 𝑛𝑛 = 2: 0.64, 0.25, 0.04 … ; 𝑛𝑛 = 3: 0.512, 0.125, 0.008 … ) Quindi esisterà un valore di a in cui la funzione fn(a) assume un valore minimo, per qualunque valore di n. Cerchiamo pertanto, per diversi valori di n, per quale valore di a si ha il minimo della funzione fn(a). 27 Partiamo dal caso n=2 (in questo caso il valore assoluto si può eliminare): 𝑁𝑁 Derivando la funzione rispetto ad a: 2 𝑁𝑁 𝑓𝑓2 (𝑎𝑎) = ��𝑥𝑥𝑗𝑗 − 𝑎𝑎� = ��𝑥𝑥𝑗𝑗 − 𝑎𝑎� 𝑗𝑗=1 𝑗𝑗=1 2 𝑁𝑁 𝑁𝑁 𝑁𝑁 𝑁𝑁 𝑁𝑁 𝑁𝑁 𝑗𝑗=1 𝑗𝑗=1 𝑗𝑗=1 𝑗𝑗=1 𝑗𝑗=1 𝑗𝑗=1 𝑑𝑑𝑓𝑓2 (𝑎𝑎) = � 2(−1)�𝑥𝑥𝑗𝑗 − 𝑎𝑎� = −2 ��𝑥𝑥𝑗𝑗 − 𝑎𝑎� = −2 �� 𝑥𝑥𝑗𝑗 − � 𝑎𝑎� = −2 �� 𝑥𝑥𝑗𝑗 − 𝑎𝑎 � 1� 𝑑𝑑𝑑𝑑 𝑁𝑁 = −2 �� 𝑥𝑥𝑗𝑗 − 𝑎𝑎𝑎𝑎� 𝑗𝑗=1 Minimizzando rispetto ad a: 𝑁𝑁 𝑁𝑁 𝑗𝑗=1 𝑗𝑗=1 𝑑𝑑𝑓𝑓2 (𝑎𝑎) = 0 → −2 �� 𝑥𝑥𝑗𝑗 − 𝑎𝑎𝑎𝑎� = 0 → � 𝑥𝑥𝑗𝑗 − 𝑎𝑎𝑎𝑎 = 0 𝑑𝑑𝑑𝑑 𝑁𝑁 𝑁𝑁 𝑗𝑗=1 𝑗𝑗=1 1 � 𝑥𝑥𝑗𝑗 = 𝑥𝑥̅ � 𝑥𝑥𝑗𝑗 = 𝑎𝑎𝑎𝑎 → 𝑎𝑎 = 𝑁𝑁 Questo valore di a è chiamato media aritmetica 28 Quindi per n=2 abbiamo la media aritmetica del campione. Possiamo definire anche la media attraverso le frequenze fj nel caso di variabili discrete (indicando con p il numero di gruppi che presentano gli stessi dati): 𝑁𝑁 𝑝𝑝 𝑝𝑝 𝑝𝑝 𝑗𝑗=1 𝑗𝑗=1 𝑗𝑗=1 𝑗𝑗=1 𝑛𝑛𝑗𝑗 1 1 𝑥𝑥̅ = � 𝑥𝑥𝑗𝑗 = � 𝑛𝑛𝑗𝑗 𝑥𝑥𝑗𝑗 = � 𝑥𝑥𝑗𝑗 = � 𝑓𝑓𝑗𝑗 𝑥𝑥𝑗𝑗 𝑁𝑁 𝑁𝑁 𝑁𝑁 Nel caso di variabili continue, non avendo le frequenze, possiamo pensare di usare gli intervalli Δxj e la densità di frequenza ϕj nell’intervallo j-esimo (o j-esimo bin): 𝑥𝑥̅ = 𝑁𝑁 𝑝𝑝 𝑗𝑗=1 𝑗𝑗=1 1 � 𝑥𝑥𝑗𝑗 ≈ � 𝑥𝑥𝑗𝑗 𝜑𝜑𝑗𝑗 ∆𝑥𝑥𝑗𝑗 𝑁𝑁 Dove il simbolo ≈ indica che non sono esattamente uguali (xj in questo caso rappresenta il valore centrale dell’intervallo j-esimo). 29 Vediamo il caso di n=1. In questo caso abbiamo: 𝑁𝑁 1 𝑁𝑁 𝑓𝑓1 (𝑎𝑎) = ��𝑥𝑥𝑗𝑗 − 𝑎𝑎� = ��𝑥𝑥𝑗𝑗 − 𝑎𝑎� = � �𝑎𝑎 − 𝑥𝑥𝑗𝑗 � + � �𝑥𝑥𝑗𝑗 − 𝑎𝑎� 𝑗𝑗=1 In questo modo i termini sono tutti positivi. 𝑗𝑗=1 𝑥𝑥𝑗𝑗 <𝑎𝑎 𝑥𝑥𝑗𝑗 >𝑎𝑎 Derivando rispetto ad a: 𝑑𝑑𝑓𝑓1 (𝑎𝑎) = � 1 + � (−1) = 𝑁𝑁<𝑎𝑎 − 𝑁𝑁>𝑎𝑎 𝑑𝑑𝑑𝑑 𝑥𝑥𝑗𝑗 <𝑎𝑎 𝑥𝑥𝑗𝑗 >𝑎𝑎 Dove N<a e N>a indicano il numero di dati con x<a o x> a. Il minimo si ha per: 𝑑𝑑𝑓𝑓1 (𝑎𝑎) = 𝑁𝑁<𝑎𝑎 − 𝑁𝑁>𝑎𝑎 = 0 → 𝑁𝑁<𝑎𝑎 = 𝑁𝑁>𝑎𝑎 𝑑𝑑𝑑𝑑 Questo valore di a è chiamata mediana, xm. Se il numero di dati è pari la mediana cade tra due dati del campione, se il numero dei dati è dispari la mediana cade nel valore centrale del campione. 30 Vediamo il caso di n=0. 𝑁𝑁 0 𝑓𝑓0 (𝑎𝑎) = ��𝑥𝑥𝑗𝑗 − 𝑎𝑎� = 𝑗𝑗=1 𝑁𝑁 � 𝑗𝑗=1, 𝑥𝑥𝑗𝑗 ≠𝑎𝑎 1 = (𝑁𝑁 − 𝑛𝑛𝑎𝑎 ) Cioè sarà uguale al numero dei dati (N) meno il numero dei dati uguali ad a (per xj=a, xj-a=0). Questa funzione ha un minimo quando na è massimo, cioè al massimo della frequenza, quindi alla frequenza per cui l’istogramma ha il valore massimo. Questo valore è chiamato moda della distribuzione e si può utilizzare anche nel caso di distribuzione continua. Vediamo il caso di n=∞. In questo caso il contributo maggiore alla sommatoria si avrà quando si considerano i valori di x che sono più lontani da a (quindi xmax e xmin, cioè il valore massimo e il valore minimo tra i dati sperimentali), e considerando i valori positivi (valore assoluto delle differenze): 𝑁𝑁 𝑓𝑓𝑛𝑛 (𝑎𝑎) = ��𝑥𝑥𝑗𝑗 − 𝑎𝑎� 𝑗𝑗=1 𝑛𝑛 𝑁𝑁 𝑛𝑛 → lim 𝑓𝑓𝑛𝑛 (𝑎𝑎) = lim ��𝑥𝑥𝑗𝑗 − 𝑎𝑎� ≅ lim [(𝑎𝑎 − 𝑥𝑥𝑚𝑚𝑚𝑚𝑚𝑚 )𝑛𝑛 + (𝑥𝑥𝑚𝑚𝑚𝑚𝑚𝑚 − 𝑎𝑎)𝑛𝑛 ] 𝑛𝑛→∞ 𝑛𝑛→∞ 𝑗𝑗=1 𝑛𝑛→∞ Il minimo si ha quando il maggiore dei due termini ha il valore minimo, e questo si ha quando a corrisponde al punto medio tra i due estremi, cioè quando le due differenze sono uguali. 31 Es. xmin=4, xmax=28, n=5: 𝑎𝑎 = 10 → 𝑎𝑎 − 𝑥𝑥𝑚𝑚𝑚𝑚𝑚𝑚 = 10 − 4 = 6, 𝑎𝑎 = 12 → 𝑎𝑎 − 𝑥𝑥𝑚𝑚𝑚𝑚𝑚𝑚 = 12 − 4 = 8, 𝑎𝑎 = 14 → 𝑎𝑎 − 𝑥𝑥𝑚𝑚𝑚𝑚𝑚𝑚 = 14 − 4 = 10, 𝑥𝑥𝑚𝑚𝑚𝑚𝑚𝑚 − 𝑎𝑎 = 28 − 10 = 18 → 65 + 185 = 1.897.344 𝑥𝑥𝑚𝑚𝑚𝑚𝑚𝑚 − 𝑎𝑎 = 28 − 12 = 16 → 85 + 165 = 1.081.344 𝑥𝑥𝑚𝑚𝑚𝑚𝑚𝑚 − 𝑎𝑎 = 28 − 14 = 14 → 105 + 145 = 637.824 𝑥𝑥𝑚𝑚𝑚𝑚𝑚𝑚 − 𝑎𝑎 = 28 − 16 = 12 → 125 + 125 = 497.664 𝑎𝑎 = 16 → 𝑎𝑎 − 𝑥𝑥𝑚𝑚𝑚𝑚𝑚𝑚 = 16 − 4 = 12, 𝑥𝑥𝑚𝑚𝑚𝑚𝑚𝑚 − 𝑎𝑎 = 28 − 18 = 10 → 145 + 105 = 637.824 𝑎𝑎 = 18 → 𝑎𝑎 − 𝑥𝑥𝑚𝑚𝑚𝑚𝑚𝑚 = 18 − 4 = 14, ecc. Pertanto: 𝑎𝑎 − 𝑥𝑥𝑚𝑚𝑚𝑚𝑚𝑚 = 𝑥𝑥𝑚𝑚𝑚𝑚𝑚𝑚 − 𝑎𝑎 𝑎𝑎 = 𝑥𝑥𝑚𝑚𝑚𝑚𝑚𝑚 + 𝑥𝑥𝑚𝑚𝑚𝑚𝑚𝑚 ≡ 𝑥𝑥𝑐𝑐 2 I 4 termini (media aritmetica, mediana, moda e valore centrale) sono generalmente diversi, ma sono uguali nel caso di una distribuzione di frequenze simmetrica. 32 Indice di dispersione L’indice di dispersione deve dare indicazioni su come sono dispersi i dati, cioè quanto sono distanti tra loro i dati sperimentali. La funzione: 𝑁𝑁 𝑓𝑓𝑛𝑛 (𝑎𝑎) = ��𝑥𝑥𝑗𝑗 − 𝑎𝑎� 𝑗𝑗=1 𝑛𝑛 dà effettivamente una indicazione sulla dispersione dei dati, essendo la somma degli scarti (anche se elevati alla n-esima potenza). Questa funzione però: - aumenta al crescere di N (aumentano i termini della sommatoria); - non ha le dimensioni di x (avendo le dimensioni di xn). Pertanto se utilizziamo la funzione: 1� 𝑛𝑛 1 𝑠𝑠𝑛𝑛 = � 𝑓𝑓𝑛𝑛 (𝑎𝑎)� 𝑁𝑁 𝑁𝑁 1� 𝑛𝑛 1 𝑛𝑛 = � ��𝑥𝑥𝑗𝑗 − 𝑎𝑎� � 𝑁𝑁 𝑗𝑗=1 otteniamo una funzione con le stesse dimensioni di x e che non cresce con N. 33 Per n=1: 1 𝑠𝑠1 = � 𝑓𝑓1 (𝑎𝑎)� 𝑁𝑁 1� 1 1� 1 𝑁𝑁 1 1 = � ��𝑥𝑥𝑗𝑗 − 𝑥𝑥𝑚𝑚 � � 𝑁𝑁 𝑗𝑗=1 S1 è chiamato lo scarto medio del campione 𝑁𝑁 1 = ��𝑥𝑥𝑗𝑗 − 𝑥𝑥𝑚𝑚 � 𝑁𝑁 𝑗𝑗=1 Per n=2: 1 𝑠𝑠2 = � 𝑓𝑓2 (𝑎𝑎)� 𝑁𝑁 1� 2 𝑁𝑁 𝑁𝑁 𝑗𝑗=1 𝑗𝑗=1 1 1 2 2 = � ��𝑥𝑥𝑗𝑗 − 𝑥𝑥̅ � = � ��𝑥𝑥𝑗𝑗 − 𝑥𝑥̅ � 𝑁𝑁 𝑁𝑁 che corrisponde allo scarto quadratico medio, ed è anche chiamato deviazione standard del campione (nell’ultimo passaggio è stato eliminato il valore assoluto perché superfluo). Anche in questo caso utilizzando le frequenze (con p numero di gruppi): 𝑁𝑁 𝑝𝑝 𝑝𝑝 𝑗𝑗=1 𝑗𝑗=1 𝑗𝑗=1 𝑝𝑝 𝑛𝑛𝑗𝑗 1 1 2 2 2 𝑠𝑠2 = � ��𝑥𝑥𝑗𝑗 − 𝑥𝑥̅ � = � � 𝑛𝑛𝑗𝑗 �𝑥𝑥𝑗𝑗 − 𝑥𝑥̅ � = �� �𝑥𝑥𝑗𝑗 − 𝑥𝑥̅ � = �� 𝑓𝑓𝑗𝑗 �𝑥𝑥𝑗𝑗 − 𝑥𝑥̅ � 𝑁𝑁 𝑁𝑁 𝑁𝑁 2 𝑗𝑗=1 34 Per n=∞: 1 𝑠𝑠∞ = lim � � 𝑛𝑛→∞ 𝑁𝑁 1� 𝑛𝑛 [(𝑥𝑥𝑐𝑐 − 𝑥𝑥𝑚𝑚𝑚𝑚𝑚𝑚 )𝑛𝑛 + (𝑥𝑥𝑚𝑚𝑚𝑚𝑚𝑚 − 𝑥𝑥𝑐𝑐 )𝑛𝑛 ] 1 = lim � � 𝑛𝑛→∞ 𝑁𝑁 1 = lim � � 𝑛𝑛→∞ 𝑁𝑁 1 = lim � � 𝑛𝑛→∞ 𝑁𝑁 2 = lim � � 𝑛𝑛→∞ 𝑁𝑁 2 1� 𝑛𝑛 essendo lim � � 𝑛𝑛→∞ 𝑁𝑁 1� 𝑛𝑛 1� 𝑛𝑛 1� 𝑛𝑛 1� 𝑛𝑛 1� 𝑛𝑛 𝑛𝑛 𝑥𝑥𝑚𝑚𝑚𝑚𝑚𝑚 + 𝑥𝑥𝑚𝑚𝑚𝑚𝑚𝑚 𝑥𝑥𝑚𝑚𝑚𝑚𝑚𝑚 + 𝑥𝑥𝑚𝑚𝑚𝑚𝑚𝑚 𝑛𝑛 �� − 𝑥𝑥𝑚𝑚𝑚𝑚𝑚𝑚 � + �𝑥𝑥𝑚𝑚𝑚𝑚𝑚𝑚 − � � 2 2 1� 𝑛𝑛 𝑥𝑥𝑚𝑚𝑚𝑚𝑚𝑚 + 𝑥𝑥𝑚𝑚𝑚𝑚𝑚𝑚 − 2𝑥𝑥𝑚𝑚𝑚𝑚𝑚𝑚 𝑛𝑛 2𝑥𝑥𝑚𝑚𝑚𝑚𝑚𝑚 −𝑥𝑥𝑚𝑚𝑚𝑚𝑚𝑚 − 𝑥𝑥𝑚𝑚𝑚𝑚𝑚𝑚 𝑛𝑛 �� � + � � � 2 2 1� 𝑛𝑛 𝑥𝑥𝑚𝑚𝑚𝑚𝑚𝑚 − 𝑥𝑥𝑚𝑚𝑖𝑖𝑖𝑖 𝑛𝑛 𝑥𝑥𝑚𝑚𝑚𝑚𝑚𝑚 − 𝑥𝑥𝑚𝑚𝑚𝑚𝑚𝑚 𝑛𝑛 �� � + � � � 2 2 1� 𝑛𝑛 𝑥𝑥 𝑚𝑚𝑚𝑚𝑚𝑚 − 𝑥𝑥𝑚𝑚𝑚𝑚𝑚𝑚 𝑥𝑥𝑚𝑚𝑚𝑚𝑚𝑚 − 𝑥𝑥𝑚𝑚𝑚𝑚𝑚𝑚 2 = lim � � 𝑛𝑛→∞ 𝑁𝑁 2 2 1� 𝑛𝑛 1 = lim � � 𝑛𝑛→∞ 𝑁𝑁 = 1� 𝑛𝑛 𝑥𝑥𝑚𝑚𝑚𝑚𝑚𝑚 − 𝑥𝑥𝑚𝑚𝑚𝑚𝑚𝑚 2 1� 𝑛𝑛 𝑥𝑥𝑚𝑚𝑚𝑚𝑚𝑚 − 𝑥𝑥𝑚𝑚𝑚𝑚𝑚𝑚 𝑛𝑛 �2 � � � 2 2 0 = lim � � = 1 𝑛𝑛→∞ 𝑁𝑁 Pertanto abbiamo la semidispersione massima: 𝑠𝑠∞ = 𝑥𝑥𝑚𝑚𝑚𝑚𝑚𝑚 − 𝑥𝑥𝑚𝑚𝑚𝑚𝑚𝑚 2 35 Esempio: dati sull’altezza dei ragazzi (p. 15) Densità di frequenze 8 7 6 5 ϕ Altezza (m) 1.45 1.48 1.49 1.49 1.51 1.52 1.53 1.53 1.54 1.55 1.55 1.57 1.57 1.57 1.60 1.62 1.63 1.65 1.65 1.68 4 3 2 1 0 1.35-1.40 1.40-1.45 1.45-1.50 1.50-1.55 1.55-1.60 1.60-1.65 1.65-1.70 1.70-1.75 x (m) n Indice di posizione Indice di dispersione 0 Moda: 1,52 1 Mediana: 1,55 Scarto medio: 0,05 2 Media: 1,56 Scarto quadratico medio: 0,06 ∞ Centrale:1,57 Semidispersione massima 0,12 36 Da notare che se per i diversi valori di n usiamo l’indice di dispersione per indicare una sorta di “incertezza” abbiamo: per n=1, i valori sono compresi tra 1,50 e 1,60 (contenuti 11 dati su 20); per n=2, i valori sono compresi tra 1,50 e 1,62 (contenuti 12 dati su 20); per n=∞, i valori sono compresi tra 1,45 e 1,69 (contenuti 20 dati su 20); 37 Distribuzioni di probabilità Abbiamo già introdotto il concetto di probabilità pk: 𝑝𝑝𝑘𝑘 = 𝑛𝑛𝑛𝑛𝑛𝑛𝑛𝑛𝑛𝑛𝑛𝑛 𝑑𝑑𝑑𝑑 𝑐𝑐𝑐𝑐𝑐𝑐𝑐𝑐 𝑓𝑓𝑓𝑓𝑓𝑓𝑓𝑓𝑓𝑓𝑓𝑓𝑓𝑓𝑓𝑓𝑓𝑓𝑓𝑓 𝑛𝑛𝑛𝑛𝑛𝑛𝑛𝑛𝑛𝑛𝑛𝑛 𝑑𝑑𝑑𝑑 𝑐𝑐𝑐𝑐𝑐𝑐𝑐𝑐 𝑝𝑝𝑝𝑝𝑝𝑝𝑝𝑝𝑝𝑝𝑝𝑝𝑝𝑝𝑝𝑝𝑝𝑝 e il collegamento con la frequenza (sperimentale) fk: 𝑛𝑛𝑘𝑘 𝑁𝑁→∞ 𝑁𝑁 𝑝𝑝𝑘𝑘 = lim 𝑓𝑓𝑘𝑘 = lim 𝑁𝑁→∞ Anche se abbiamo detto che questo limite non è completamente corretto dal punto di vista matematico. L’insieme delle pk, cioè l’insieme delle probabilità, costituisce la distribuzione di probabilità della variabile casuale xk associata all’indice k. Questa distribuzione caratterizza la popolazione rispetto all’esperimento. 38 Un esempio tipico, come abbiamo già detto, è il lancio di un dado. Se l’uscita dei sei numeri (xk=1, 2, 3, 4, 5, 6) è equiprobabile (dado non truccato!) la probabilità pk=1/6 per tutte le facce, con la condizione: 𝑝𝑝 � 𝑝𝑝𝑘𝑘 = 1 𝑘𝑘=1 Di seguito il confronto tra un esperimento (100 lanci di un dado) e la teoria. Nel grafico di sinistra è riportato il numero di uscite delle varie facce; nel grafico di destra il confronto tra la frequenza di uscita delle varie facce e la probabilità. 25 Frequenze/probabilità Numero uscite Frequenze Dado: 100 lanci 20 15 10 5 0 Dado 0.25 1 2 3 xk 4 5 6 Probabilità 0.20 0.15 0.10 0.05 0.00 1 2 3 xk 4 5 6 39 Il confronto tra esperimento (frequenze) e teoria (probabilità) mostra nonostante i 100 lanci una certa differenza. Negli istogrammi di seguito si mostra l’evoluzione delle uscite e delle frequenze al crescere del numero dei lanci. 40 0.25 Dadi: 200 lanci Frequenze/Probabilità 35 Uscite 30 25 Frequenze Probabilità 0.2 0.15 20 15 10 0.1 0.05 5 0 Dadi: 200 lanci 1 2 3 Xk 4 5 0 6 140 1 2 0.25 Frequenze/Probabilità 100 Xk 4 5 6 Dadi: 1.000 lanci Dadi: 1.000 lanci 120 3 Frequenze Probabilità 0.2 0.15 Uscite 80 60 40 0.1 0.05 20 0 0 1 2 3 Xk 4 5 6 1 2 3 Xk 4 5 40 6 L’andamento delle probabilità pk del lancio del dado è un esempio di distribuzione di probabilità, in questo caso una distribuzione uniforme. Un esempio di distribuzione non uniforme, sempre nel caso del lancio dei dati, è quella riguardante il risultato della somma dei valori ottenuti nel lancio contemporaneo di 2 dadi. La tabella di seguito mostra i possibili risultati (teoria). Dado 2 1 2 3 4 5 6 1 2 3 4 5 6 7 2 3 4 5 6 7 8 3 4 5 6 7 8 9 4 5 6 7 8 9 10 5 6 7 8 9 10 11 6 7 8 9 10 11 12 Dado 1 41 Abbiamo 36 risultati possibili (6x6, essendo 6 le facce di ogni dado), e questi vanno da 2 (1+1) a 12 (6+6). Questi casi estremi si possono avere per una sola combinazione. Altri risultati con più combinazioni (es. 1+4=5, 2+3=5, 3+2=5, 4+1=5). Quindi, se indichiamo con A e B il risultato del lancio di ogni singolo dado (variabili casuali) abbiamo: - risultati statisticamente indipendenti (il risultato A non influenza il risultato B e viceversa) - pA=pB=1/6 - k=1,2, …11 risultati diversi possibili - xk=A+B= 2, 3, …12 possibili risultati La probabilità di ogni singola combinazione k, Pk, è data dalla somma dei possibili casi favorevoli: 𝑃𝑃𝑘𝑘 = � 𝑝𝑝𝑘𝑘1 𝑞𝑞𝑘𝑘−𝑘𝑘1 𝑘𝑘1 Dove: 1 - 𝑝𝑝𝑘𝑘1 = 𝑞𝑞𝑘𝑘1 = (per ogni k1 =1, 2, 3, 4, 5, 6 e analogamente per k2=1, 2, 3, 4, 5, 6) sono le probabilità delle 6 variabili A e B - 𝑘𝑘 = 𝑘𝑘1 + 𝑘𝑘2 = 2, 3, … 12 42 Poiché 𝑝𝑝𝑘𝑘1 = 𝑞𝑞𝑘𝑘1 = 1 6 abbiamo che: 1 1 1 1 𝑃𝑃𝑘𝑘 = � 𝑝𝑝𝑘𝑘1 𝑞𝑞𝑘𝑘−𝑘𝑘1 = � × = � = �1 6 6 36 36 𝑘𝑘1 𝑘𝑘1 𝑘𝑘1 𝑘𝑘1 dove la sommatoria è estesa a quanti valori di k1 che soddisfano la relazione 𝑘𝑘 = 𝑘𝑘1 + 𝑘𝑘2 . Esempio: - k=5, k1=1, 2, 3, 4 (perché le possibilità sono 1+4, 2+3, 3+2, 4+1, in rosso nella tabella) quindi: 𝑃𝑃5 = 1 1 4 1 �1 = × (1 + 1 + 1 + 1) = = = 0,11 36 36 36 9 𝑘𝑘1 - k=10, k1=4, 5, 6 (perché le possibilità sono 4+6, 5+5, 6+4, in blu nella tabella) quindi: 𝑃𝑃10 = 1 1 3 1 �1 = × (1 + 1 + 1) = = = 0,083 36 36 36 12 𝑘𝑘1 43 Se calcoliamo tutte le probabilità abbiamo la seguente tabella k Xk �1 𝑘𝑘1 1 𝑃𝑃𝑘𝑘 = 1 �1 36 1 2 0,028 2 3 2 0,056 3 4 3 0,083 4 5 4 0,11 5 6 5 0,14 6 7 6 0,17 7 8 5 0,14 8 9 4 0,11 9 10 3 0,083 10 11 2 0,056 11 12 1 0,028 𝑘𝑘1 44 Di seguito i risultati per 100 lanci di 2 dadi, sia come numero di uscite (in alto) che in termini di frequenze confrontate con le probabilità calcolate di sopra (in basso). Somma di 2 dadi 25 15 10 5 0 2 3 4 5 6 7 Xk 8 9 10 11 12 Somma di 2 dadi 0.25 Frequenze Probabilità Frequenze/probabilità Uscite 20 0.2 0.15 0.1 0.05 0 1 2 3 4 5 6 xk 7 8 9 10 11 45 Se aumentiamo il numero dei lanci (500 somme di 1.000 lanci): Somma 2 dadi: 500 lanci 90 80 70 50 40 30 20 10 0 2 3 4 5 6 7 8 9 10 Xk 11 12 Somma di 2 dadi: 500 lanci 0.18 Frequenze 0.16 Frequenze/probabilità Uscite 60 Probabilità 0.14 0.12 0.1 0.08 0.06 0.04 0.02 0 1 2 3 4 5 6 xk 7 8 9 10 11 46 Analogamente a come abbiamo introdotto per dati sperimentali delle grandezze per caratterizzare le distribuzioni dei dati (media, mediana, scarto quadratico medio o deviazione standard) introduciamo dei parametri per caratterizzare le distribuzioni di probabilità. Per generalizzare introduciamo un operatore chiamato valore di aspettazione indicato come: 𝐸𝐸 {… } = � … 𝑝𝑝𝑘𝑘 𝑘𝑘 dove i …. indicano una operazione matematica che interessa le variabili casuali xk. Esempio: 𝐸𝐸 {𝑥𝑥 } = � 𝑥𝑥𝑘𝑘 𝑝𝑝𝑘𝑘 𝑘𝑘 indica la sommatoria dei prodotti tra le variabili casuali e le probabilità. 47 Alcune proprietà di questo operatore (per operatore si intende un ente che agendo su una funzione, un numero…ne modifica la forma, il valore…): - Se a=costante: 𝐸𝐸 {𝑎𝑎} = � 𝑎𝑎𝑝𝑝𝑘𝑘 = 𝑎𝑎 � 𝑝𝑝𝑘𝑘 = 𝑎𝑎 𝑘𝑘 𝑒𝑒𝑒𝑒𝑒𝑒𝑒𝑒𝑒𝑒𝑒𝑒𝑒𝑒 � 𝑝𝑝𝑘𝑘 = 1 𝑘𝑘 𝑘𝑘 - 𝐸𝐸 {𝑥𝑥 + 𝑦𝑦} = ∑𝑘𝑘(𝑥𝑥𝑘𝑘 + 𝑦𝑦𝑘𝑘 )𝑝𝑝𝑘𝑘 = ∑𝑘𝑘 𝑥𝑥𝑘𝑘 𝑝𝑝𝑘𝑘 + ∑𝑘𝑘 𝑦𝑦𝑘𝑘 𝑝𝑝𝑘𝑘 = 𝐸𝐸 {𝑥𝑥 } + 𝐸𝐸 {𝑦𝑦} - Se a= costante: 𝐸𝐸 {𝑎𝑎𝑎𝑎 } = � 𝑎𝑎𝑥𝑥𝑘𝑘 𝑝𝑝𝑘𝑘 = 𝑎𝑎 � 𝑥𝑥𝑘𝑘 𝑝𝑝𝑘𝑘 = 𝑎𝑎𝑎𝑎 {𝑥𝑥 } 𝑘𝑘 𝑘𝑘 48 Il caso indicato come esempio di operatore: 𝐸𝐸 {𝑥𝑥 } = � 𝑥𝑥𝑘𝑘 𝑝𝑝𝑘𝑘 = 𝜇𝜇 𝑘𝑘 è chiamato media della distribuzione di probabilità e ricorda la media aritmetica della distribuzione delle frequenze (o valore medio): 𝑁𝑁 𝑝𝑝 𝑗𝑗=1 𝑗𝑗=1 1 𝑥𝑥̅ = � 𝑥𝑥𝑗𝑗 = � 𝑓𝑓𝑗𝑗 𝑥𝑥𝑗𝑗 𝑁𝑁 Ricordiamo che quest’ultima media si riferisce ad un campione N di dati sperimentali (campione di dimensione N) ed è anche detta media campionaria. 49 Un altro operatore utilizzato per descrivere una distribuzione è: 𝐸𝐸 {(𝑥𝑥 − 𝜇𝜇 )2 } = �(𝑥𝑥𝑘𝑘 − 𝜇𝜇 )2 𝑝𝑝𝑘𝑘 Utilizzando le proprietà mostrate sopra abbiamo: 𝑘𝑘 𝐸𝐸 {(𝑥𝑥 − 𝜇𝜇 )2 } = �(𝑥𝑥𝑘𝑘 − 𝜇𝜇 )2 𝑝𝑝𝑘𝑘 = �(𝑥𝑥𝑘𝑘 2 + 𝜇𝜇 2 − 2𝑥𝑥𝑘𝑘 𝜇𝜇 )𝑝𝑝𝑘𝑘 = � 𝑥𝑥𝑘𝑘 2 𝑝𝑝𝑘𝑘 + � 𝜇𝜇 2 𝑝𝑝𝑘𝑘 − � 2𝑥𝑥𝑘𝑘 𝜇𝜇𝑝𝑝𝑘𝑘 = 𝑘𝑘 𝑘𝑘 𝑘𝑘 𝑘𝑘 𝑘𝑘 � 𝑥𝑥𝑘𝑘 2 𝑝𝑝𝑘𝑘 + 𝜇𝜇 2 � 𝑝𝑝𝑘𝑘 − 2𝜇𝜇 � 𝑥𝑥𝑘𝑘 𝑝𝑝𝑘𝑘 = � 𝑥𝑥𝑘𝑘 2 𝑝𝑝𝑘𝑘 + 𝜇𝜇 2 − 2𝜇𝜇 2 = � 𝑥𝑥𝑘𝑘 2 𝑝𝑝𝑘𝑘 − 𝜇𝜇 2 = 𝐸𝐸 {𝑥𝑥 2 } − 𝜇𝜇 2 𝑘𝑘 𝑘𝑘 𝑘𝑘 𝑘𝑘 𝑘𝑘 dove abbiamo usato: � 𝑝𝑝𝑘𝑘 = 1 𝑒𝑒 � 𝑥𝑥𝑘𝑘 𝑝𝑝𝑘𝑘 = 𝜇𝜇 𝑘𝑘 L’operatore 𝑘𝑘 𝜎𝜎 2 = 𝐸𝐸 {(𝑥𝑥 − 𝜇𝜇 )2 } = 𝐸𝐸 {𝑥𝑥 2 } − 𝜇𝜇 2 è chiamata varianza della distribuzione. 50 La radice quadrata: 𝜎𝜎 = �𝜎𝜎 2 è chiamata deviazione standard (da non confondere con lo scarto quadratico medio o deviazione standard campionaria che, come sempre, si riferisce a dati sperimentali). La deviazione standard dà una indicazione della dispersione (o larghezza) della distribuzione. Per esempio nel caso del lancio di un dado, abbiamo: 6 6 6 𝑘𝑘=1 𝑘𝑘=1 𝑘𝑘=1 1 1 1 21 𝐸𝐸 {𝑥𝑥 } = 𝜇𝜇 = � 𝑥𝑥𝑘𝑘 𝑝𝑝𝑘𝑘 = � 𝑥𝑥𝑘𝑘 𝑝𝑝𝑘𝑘 = � 𝑥𝑥𝑘𝑘 = � 𝑥𝑥𝑘𝑘 = (1 + 2 + 3 + 4 + 5 + 6) = = 3,5 6 6 6 6 𝑘𝑘 6 6 𝑘𝑘=1 𝑘𝑘=1 1 1 𝜎𝜎 2 = 𝐸𝐸 {(𝑥𝑥 − 𝜇𝜇 )2 } = 𝐸𝐸 {𝑥𝑥 2 } − 𝜇𝜇 2 = � 𝑥𝑥𝑘𝑘 2 𝑝𝑝𝑘𝑘 − 𝜇𝜇 2 = � 𝑥𝑥𝑘𝑘 2 − 𝜇𝜇 2 = � 𝑥𝑥𝑘𝑘 2 − 𝜇𝜇 2 = 6 6 𝑘𝑘 1 1 91 = (12 + 22 + 32 + 42 + 52 + 62 ) − 3,52 = (1 + 4 + 9 + 16 + 25 + 36) − 12,25 = − 12,25 = 2,92 6 6 6 51 Pertanto: 𝜎𝜎 = �𝜎𝜎 2 = �2,92 = 1,71 Quindi la distribuzione piatta del lancio di un dado è caratterizzata da: 𝜇𝜇 = 3,5 𝑒𝑒 𝜎𝜎 = 1,71 Anche in questo caso non tutte le variabili casuali sono contenute in 𝜇𝜇 ± 𝜎𝜎 (1.79-5.21). Se confrontiamo questi parametri probabilistici con i dati sperimentali sopra riportati abbiamo: 𝑁𝑁 𝑝𝑝 𝑗𝑗=1 𝑗𝑗=1 1 𝑥𝑥̅ = � 𝑥𝑥𝑗𝑗 = � 𝑓𝑓𝑗𝑗 𝑥𝑥𝑗𝑗 𝑁𝑁 𝑁𝑁 𝑝𝑝 1 2 2 𝑠𝑠2 = � ��𝑥𝑥𝑗𝑗 − 𝑥𝑥̅ � = �� 𝑓𝑓𝑗𝑗 �𝑥𝑥𝑗𝑗 − 𝑥𝑥̅ � 𝑁𝑁 𝑗𝑗=1 𝑗𝑗=1 52 100 lanci 200 lanci 300 lanci 500 lanci 1.000 lanci 𝑥𝑥𝑘𝑘 Uscite Freq. Uscite Freq. Uscite Freq. Uscite Freq. Uscite Freq. 1 18 0,180 35 0,175 52 0,173 87 0,174 169 0,169 2 14 0,140 26 0,130 51 0,170 77 0,154 171 0,171 3 19 0,190 35 0,175 41 0,137 76 0,152 165 0,165 4 18 0,180 39 0,195 45 0,150 84 0,168 162 0,162 5 15 0,150 32 0,160 44 0,147 76 0,152 159 0,159 6 16 0,160 33 0,165 67 0,223 100 0,200 174 0,174 100 1,000 200 1,000 300 1,000 500 1,000 1.000 1,000 Totali 100 lanci 𝑥𝑥̅ 3,460 1,694 200 lanci 3,530 1,708 300 lanci 3,597 1,804 500 lanci 3,570 1,761 1.000 lanci 3,493 1,723 Lancio di 1 dado 𝑠𝑠2 μ σ 3,5 1,71 53