LEZIONE 2.3

corso di statistica

Francesco Lagona

Università Roma Tre

LEZIONE 2.3 – p. 1/10

un esperimento composto

T

C

•

P (R) =? probabilità marginale, non immediata da calcolare

•

P (R|T ) =

1

:

4

probabilità condizionata: immediata da calcolare

•

P (R|C) =

1

:

2

probabilità condizionata: immediata da calcolare

•

dati due eventi A e B (con P (B) > 0), la probabilità condizionata

P (A|B) =

P (A ∩ B)

P (B)

indica la probabilità di A, dato che si è verificato l’evento B

LEZIONE 2.3 – p. 2/10

la definizione di probabilità condizionata

• insieme di eventi equiprobabili: Ω = {ω1 . . . ω8 } =

{(T, R), (T, B), (T, B), (T, B), (C, R), (C, R), (C, B), (C, B)}

R

1/8

2/8

3/8

T

C

• P (R|T ) =

1

4

=

P (R∩T )

P (T )

=

1/8

1/2

• P (R|C) =

1

2

=

P (R∩C)

P (C)

=

2/8

1/2

B

3/8

2/8

5/8

1/2

1/2

LEZIONE 2.3 – p. 3/10

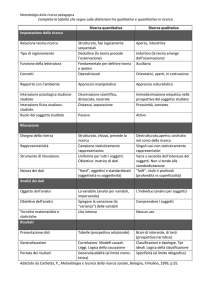

probabilità condizionata

• può essere usata per calcolare le probabilità congiunte:

P (A ∩ B)

P (A|B) =

⇒ P (A ∩ B) = P (A|B)P (B)

P (B)

◦ ad esempio: P (R ∩ C) = P (R|C)P (C) =

11

22

=

1

4

• può essere usata per calcolare le probabilità marginali

◦ ad esempio:

P (R) = P (R ∩ C) + P (R ∩ T ) = P (R|C)P (C) +

1/4+2/4

(R|T )

=

= 3/8 = 0.375

P (R|T )P (T ) = P (R|C)+P

2

2

◦ ad esempio:

P (B) = P (B ∩ C) + P (B ∩ T ) = P (B|T )P (T ) +

P (B|C)P (C) =

P (B|T )+P (B|C)

2

=

3/4+2/4

2

= 5/8 = 0.625

LEZIONE 2.3 – p. 4/10

eventi indipendenti

• due eventi A e B si dicono indipendenti se

P (A|B) = P (A)

ovvero, ricordando che P (A ∩ B) = P (A|B)P (B), se

P (A ∩ B) = P (A)P (B)

• nota 1: la definizione generalizza quella di indipendenza tra

variabili statistiche

• nota 2: due eventi (non impossibili) indipendenti non sono

mai incompatibili:

0 = P (A ∩ B) = P (A)P (B)

LEZIONE 2.3 – p. 5/10

una variazione dell’esperimento

{1,2}

{3,4,5,6}

2

1

P (R) = 1/3 + 2/3 =

4

4

3

2

P (B) = 1/3 + 2/3 =

4

4

1

2

+2

4

4

5

/3 =

= 0.42

12

2

3

+2

4

4

7

/3 =

= 0.58

12

LEZIONE 2.3 – p. 6/10

un’altra variazione

S

S

P B

P P

B B

P B

• se P (S) = p, allora Prob(P ) = p × 3/4 + (1 − p) × 1/4

• ad esempio: se p = 0.1, allora

Prob(P )

= 0.1 × 3/4 + 0.9 × 1/4 = 0.3

LEZIONE 2.3 – p. 7/10

teorema di Bayes

P (S ∩ P )

P (P |S)P (S)

P (S|P ) =

=

P (P )

P (P |S)P (S) + P (P |S̄)P (S̄)

• se P (S) = p

P (P |S)p

P (S|P ) =

P (P |S)p + P (P |S̄)(1 − p)

• ad esempio, se p = 0.1

3/4 × 0.1

0.075

P (S|P ) =

=

= 0.25

0.3

0.3

LEZIONE 2.3 – p. 8/10

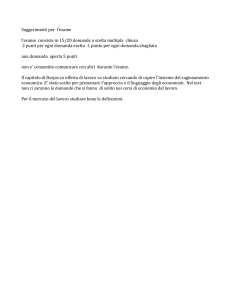

0.6

P(non ha studiato | bocciato)

0.4

P(ha studiato | promosso)

0.0

0.2

probabilità a posteriori

0.8

1.0

probabilità a posteriori e a priori

0.0

0.2

0.4

0.6

0.8

1.0

probabilità a priori

•

P (S|P ): probabilità a posteriori

•

p = P (S): probabilità a priori

P (S|P ) =

•

P (P |S)p

P (P |S)p + P (P |S̄)(1 − p)

nota 1: P (S|P ) + P (S̄|B) 6= 1

LEZIONE 2.3 – p. 9/10

1.0

la probabilità di commettere un errore

0.4

0.6

P(studiato | bocciato)

0.0

0.2

probabilità a posteriori

0.8

P(non ha studiato | promosso)

0.0

0.2

0.4

0.6

0.8

1.0

P(S): probabilità a priori

• P(non ha studiato | promosso)=1-P(ha studiato|promosso)

• P(ha studiato | bocciato)= 1 -P(non ha studiato | bocciato)

LEZIONE 2.3 – p. 10/10