St tt

Struttura

della

d ll materia

t i

Bibliografia

J.D. Jackson Classical Electrodynamics

Nardelli Chimica generale

M. Born Atomic Physics

A.Bohm Quantum Mechanics

P.E. Hodgson, E. Gadioli, E. Gadioli Erba Introductory

Nuclear Physics

M Di Ventra

M.

Ventra, S.Evoy,

S Evoy J.

J R.

R Heflin Jr.

Jr Introduction to

Nanoscale Science and Technology

E. L. Wolf nanophysics

p y

and Nanotechology

gy

Materiale dal sito dell’ MIT

…………

Le teorie, i p

principi

p g

generali, i modi

di descrivere la struttura della

materia si sono sviluppati ed

approfonditi nel corso degli ultimi

quattro secoli

secoli, spesso in modo non

lineare.

I concetto stessi di “materia”

materia ,

“spazio” e “tempo” sono stati

esaminati

i ti e dib

dibattuti

tt ti llungamente

t

da fisici e filosofi.

Nell’ esperienza

p

comune lo spazio

p

ed il

tempo sono visti come modi in cui il

mondo reale esiste,

esiste mentre la materia è

la sua sostanza.

Nelle teorie fisiche lo spazio

spazio, il tempo e

la materia possono essere interpretati

come rappresentazioni mentali

introdotte per descrivere i fenomeni

osservati.i

I metodi elaborati già da Galilei

Galilei,

Descartes, Hobbes per descrivere

gli eventi osservati impongono di

evitare le osservazioni legate a

qualità del fenomeno (impressioni

soggettive), per costruire, invece,

procedure che portino a risultati

quantitativi.

Un esperimento o “processo di misura” è una

sequenza di operazioni

i i condotte

d tt iin modo

d

controllato e tale da potere essere riprodotto

o replicato,

li t ffornendo

d glili stessi

t

i risultati

i lt ti entro

t

l’ errore sperimentale.

L’ esame dei dati e la loro interpretazione,

per via induttiva o deduttiva

deduttiva, permette di

ottenere informazioni sul fenomeno

osservato, che portano alla costruzione di

una teoria, cioè di una spiegazione degli

eventi fondamentali, la quale deve essere

verificabile e falsificabile.

Storicamente, si sono suddivise le

proprietà dell’ oggetto da esaminare o

“sistema”

sistema in quelle che meglio ne

descrivono le caratteristiche

macroscopiche ed in grandezze

legate alla natura dell’ oggetto (analisi

chimica)

hi i ) o all modo

d iin cuii lla struttura

t tt

possa combinarsi con altri oggetti

formando un sistema differente

(sintesi chimica).

Il sistema

i t

può

ò essere sottoposto

tt

t a

misurazioni che non ne alterano lo

stato: valutazione di densità,

volume, massa, conducibilità

elettrica o termica, …

L’ oggetto

gg

p

può subire anche

trasformazioni del suo stato,

provocate da cambiamenti

opportuni dell’ intorno.

Le trasformazioni fisiche modificano qualche

caratteristica,, ma non la composizione

p

del

sistema, cioè la sua identità chimica: le

trasformazioni di stato ne sono un esempio.

Le trasformazioni o reazioni chimiche inducono

cambiamenti della composizione del sistema: si

possono identificare oggetti iniziali, o “reagenti”,

che, per mescolamento fra loro o per variazioni di

t

temperatura,

t

pressione,

i

… cambiano

bi

lla lloro

natura macroscopica, diventando sistemi

differenti,, chiamati “prodotti”.

p

Una reazione

chimica può manifestarsi all’ osservatore con la

formazione di precipitati, cambiamenti di colore,

variazioni della temperatura

temperatura, formazione di

aeriformi.

Le caratteristiche misurabili del

sistema possono essere proprietà

fisiche,, ricavabili senza modificare

fisiche

la composizione del sistema

(colore densità temperatura di

(colore,

solidificazione, …), oppure

proprietà

i tà chimiche,

chimiche

hi i h , rappresentate

t t

da q

quelle g

grandezze legate

g

alla

capacità del materiale di subire

reazioni chimiche

chimiche, come la scarsa

reattività del platino con l’

ossigeno.

ossigeno

S t

Sostanza

(pura)

(

)

Un materiale è una sostanza pura qualora le

trasformazioni o i metodi fisici non riescano a separarlo

in p

porzioni aventi p

proprietà

p

differenti fra loro.

Da un punto di vista macroscopo una sostanza chimica

è un materiale di composizione definita ed uniforme,

caratterizzata ed identificabile da proprietà fisiche quali

la densità, il punto di fusione o ebollizione, l’ indice di

rifrazione, … .

P ti diverse

Parti

di

di una sostanza

t

pura manifestano

if t

lle

stesse proprietà, quando sono esaminati nelle stesse

condizioni.

Le sostanze pure possono essere classificate in

elementi e composti.

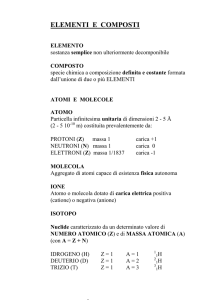

Elementi e composti

p

chimici

(visuale macroscopica)

macroscopica)

Un elemento chimico è una sostanza pura

che non può essere decomposta in

sostanze ancora più semplici con mezzi

fisici e chimici comuni.

Un composto chimico è una sostanza pura

formata da due o più elementi chimici. Una

reazione chimica ((decomposizione

p

)p

può

separare il composto in sostanze più

semplici, rappresentate dagli elementi

chimici che lo costituiscono.

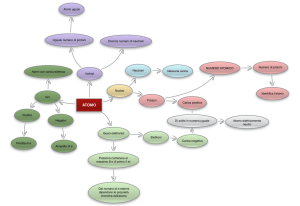

Atomi

L’ idea che una sostanza fosse formata da

L

oggetti di dimensioni microscopiche, rispetto

all’ osservatore, fu dedotta inizialmente

osservando che le trasformazioni

chimiche ed il comportamento degli

aeriformi

if

i di

dimostravano regolarità

l i à che

h

potevano essere tradotte in vere e proprie

leggi,, interpretabili in modo semplice

leggi

ammettendo che la materia fosse

composta da unità di dimensioni troppo

piccole per potere essere visualizzate

direttamente.

Leggi sperimentali

In una reazione chimica la massa di un

sistema chiuso si conserva ((legge

legge

gg di

Lavoisier))

Lavoisier

Le sostanze pure si possono suddividere in

elementi

l

ti e composti

ti e, nella

ll fformazione

i

di

un composto a partire dagli elementi, si

verifica che le proporzioni in massa degli

elementi che lo generano sono definite e

costanti ed indipendenti dalla genesi del

composto

t e dalla

d ll maniera

i

iin cuii è stato

t t

ottenuto (legge

(legge di Proust o delle

proporzioni definite)

definite)

Quando due elementi possono

combinarsi in rapporti in massa

diff

differenti,

ti le

l quantità

tità in

i massa

dell’ uno che si combinano con

una quantità fissa dell’ altro

stanno fra loro in rapporti di

numeri interi e semplici (legge di

Dalton o delle proporzioni

multiple))

multiple

Reazioni chimiche di

aeriformi

Quando due g

gas si combinano, i loro

volumi stanno fra loro in rapporto

semplice e

e, se il prodotto della

reazione è gassoso, anche il suo

volume sta in rapporto semplice con i

volume dei gas reagenti, alla stessa

pressione

i

e temperatura (l

(legge di

Gay

Gayy-Lussac).

)

Ipotesi di Dalton

Le leggi precedenti indussero Dalton,

nell 1808

1808, a proporre cinque

i

iipotesi

t i

che riguardano la struttura della

materia e spiegano in modo semplice i

fenomeni osservati.

Tutta la materia è composta da atomi indivisibili. Un

atomo è una particella estremamente piccola

piccola, che

mantiene la sua identità nel corso di una

trasformazione chimica.

Un elemento chimico è una forma di materia

costituita da atomi uguali, aventi, cioè, le stesse

proprietà fra le quali la massa

proprietà,

massa.

Elementi chimici diversi sono formati da atomi

differenti, con massa diversa

Gli atomi sono indistruttibili e mantengono la loro

identità nel corso delle trasformazioni.

La

L fformazione

i

di un composto,

t a partire

ti d

daglili

elementi che lo realizzano, si ha mediante

combinazione degli

g atomi degli

g elementi differenti,,

in rapporti espressi da numeri interi.

La teoria proposta da Dalton afferma

che deve esistere un limite

inferiore alla suddivisione della

materia e tale soglia è l’ atomo e

che deve essere possibile contare

questi oggetti microscopici che

formano le sostanze.

sostanze I postulati

introdotti da Dalton permettono di

comprendere la legge sulla

conservazione della massa in una

trasformazione chimica (gli atomi si

conservano) e le leggi di Proust e

Dalton sulle proporzioni definite

definite.

Le ipotesi di Dalton sulla struttura della

materia

t i furono

f

modificate

difi t nell corso d

deii

secoli successivi, come sarà esaminato

nel seguito, ma l’ assunto fondamentale

che la materia sia formata da oggetti

distinti, gli atomi, è alla base della Chimica

e della Fisica moderna

moderna.

Secondo Dalton g

gli atomi erano

caratterizzati dalle loro masse, che,

però dovevano essere estremamente

però,

piccole (rispetto al grammo) e, per

questo,

t la

l scelta

lt più

iù conveniente

i t d

dall

punto di vista sperimentale fu quella di

considerare una massa atomica

pp

fra la

relativa,, definita dal rapporto

relativa

massa dell’ atomo di un elemento e

quella dell’

dell atomo di un altro elemento

preso come riferimento.

Le masse atomiche relative,, però,

p ,

non potevano essere dedotte solo in

base alle leggi delle combinazioni

combinazioni,

poiché esse forniscono solo rapporti

i massa o iin peso e d

in

da ttalili d

dati

ti sii

può ottenere la massa di

combinazione di un elemento, ma

non conoscendo il numero di atomi

coinvolti, non è possibile ricavare la

massa atomica relativa

relativa.

Ipotesi di Avogadro

Avogadro,

g

, nei p

primi decenni del 1800,, p

prese in

esame le proprietà dei gas ed il loro

comportamento durante trasformazioni chimiche.

Avogadro scelse di esaminare quello che riteneva

un sistema semplice: già all’ epoca un gas era

descritto come un insieme di particelle

microscopiche in movimento e tanto lontane fra

loro da permettere ad Avogadro di ipotizzare,

almeno

l

iin prima

i

approssimazione,

i

i

che

h il volume

l

di

un gas, a temperatura e pressione costanti,

dipendesse solo dal numero delle particelle

presentiti iin esso e non dalla

d ll lloro natura

t

.

Avogadro, inoltre, ammise che le

particelle

ti ll microscopiche

i

i h presenti

ti iin

gas quali idrogeno, ossigeno, azoto

non fossero

f

atomi

t i isolati,

i l ti ma

molecole,, cioè gruppi di atomi legati

molecole

f di lloro almeno

fra

l

per iintervalli

t

lli di

tempo sufficienti a determinarne la

struttura.

Con tali ipotesi Avogadro riuscì a

spiegare la legge di GayGay-Lussac e ad

enunciare quella che era una

congettura ed ora è una legge

legge.

Legge di Avogadro

“ Volumi eguali di sostanze gassose, a eguale

temperatura e pressione, rappresentano lo stesso

numero di molecole, in modo che le densità dei

diversi gas sono la misura delle masse delle

loro molecole e i rapporti dei volumi nelle

combinazioni fra gas altro non sono che i rapporti

fra i numeri di molecole che si combinano per

formare molecole composte “.

Si consideri, ad esempio, la reazione di

formazione dell’ acqua sotto forma di

vapore a partire da idrogeno ed

ossigeno allo stato aeriforme.

Sperimentalmente

p

si osserva che,, nelle

stesse condizioni di temperatura e

pressione sono necessari due volumi di

pressione,

idrogeno ed uno di ossigeno e si

f

formano

due

d volumi

l i di vapore d’ acqua.

acqua.

Se la reazione avesse come reagenti atomi

i l ti ((rappresentati

isolati

t ti dai

d i simboli

i b li H ed

d O)

O),

allora la trasformazione dovrebbe essere

descritta dall’

dall equazione chimica seguente

seguente,

sapendo che una molecola di acqua è

formata da due atomi di idrogeno ed uno di

ossigeno):

2H + O → H2O

La conservazione della massa e del numero di

atomi implica che si debba formare un numero

di molecole di acqua uguale a quello degli atomi

di ossigeno

g

e, dalla legge

gg di Avogadro,

g

lo stesso

volume, mentre i dati sperimentali indicano un

volume doppio.

Secondo le ipotesi di Avogadro,

g

invece, i reagenti sono formati da

molecole biatomiche ( H2 ed O2 ) e l’l

equazione chimica diviene

2H2 +O

O2 → 2H2O

che prevede, correttamente, la

f

formazione

i

di due

d molecole

l l di acqua (e

(

di due volumi) a partire da due

molecole (e volumi) di idrogeno e da

una molecola ( e volume)) di ossigeno.

g

La legge di Avogadro permette di ottenere in

modo diretto la massa atomica o molecolare

(somma delle masse atomiche) per sostanze

allo stato aeriforme,, poiché,

p

, alla stessa

temperatura e pressione, il rapporto fra le

masse di volumi uguali di due gas è anche il

rapporto fra le masse delle molecole,

molecole, visto che

i due gas contengono lo stesso numero di

molecole .

Le teorie sviluppate da Avogadro

permisero di determinare le masse

atomiche relative e le formule molecolari,,

come fu sottolineato ( metà del 1800) da

Cannizzaro secondo cui un elemento può

Cannizzaro,

fornire solo un numero intero di atomi per

formare una molecola di un composto ed è

per questo che le differenti quantità in

massa con cui un elemento si rintraccia

nelle masse molecolari dei suoi diversi

composti devono essere uguali o multipli

interi della massa atomica.

atomica

Con le p

procedure indicate da Cannizzaro fu

possibile ricavare la massa atomica degli elementi

che formano composti gassosi e l’ atomo di

idrogeno fu scelto come riferimento, scegliendo di

attribuire ad esso massa atomica 1,000u (u è l’

unità di massa atomica)

atomica).

Vista la difficoltà sperimentale di manipolare singoli

atomi,

t i sii d

decise

i di ffare riferimento a quantità

q antità

che corrispondessero a numeri uguali di

atomi

t i dei

d i differenti

diff

ti elementi.

l

ti

Si introdusse, così, il concetto di grammoatomo e di

grammomolecola

l

l ((mole),

l ) che

h rappresenta

t lla massa

in grammi numericamente uguale alla massa

atomica

t i o molecolare

l

l

espressa iin u.

Il g

grammoatomo di ciascun elemento deve

contenere lo stesso numero di atomi e tale

numero è detto “numero di Avogadro”

g

ed è p

pari

a 6,022·

6,022· 1023 mol-1 .

La massa atomica dell’

dell idrogeno, ad esempio, è

pari ad 1,000 u e per ottenere 1,0 g di idrogeno

saranno necessari 6,022

6,022·· 1023 atomi di idrogeno.

Il gas “idrogeno” è formato da molecole

biatomiche la massa della singola molecola

biatomiche,

sarà 2,0u ed una grammomolecola o mole

corrisponderà ad una massa di 2

2,0

0 g e conterrà

6,022·· 1023 molecole .

6,022

Nei decenni successivi furono utilizzati altri

metodi, quali la regola di Dulong e Petit,

secondo cui

cui, a temperature prossime a

quella ambiente, il prodotto del calore

specifico

ifi per lla massa di una mole

l di un

solido elementare o di un composto è

uguale, approssimativamente, a 6 cal K-1

mol-1 .

Altri metodi si basavano sulla analogia di

formule per sostanze chimicamente simili

simili,

oppure sulla periodicità delle proprietà

degli elementi.

Agli inizi del ventesimo secolo fu messa a

punto una tecnica molto affinata per

d t

determinare

i

lla massa di atomi

t i o molecole,

l

l

la spettrometria di massa.

Anche l’ atomo preso come riferimento per

l’unità

l unità di massa atomica fu modificato e

e,

attualmente 1,000 u ( che non è un’ unità

d lS

del

S.I.)

I ) è parii ad

d un d

dodicesimo

di

i

d

della

ll

massa a riposo di un atomo di 12C nel suo

stato fondamentale.

Elettricità, magnetismo,

g

teorie della

luce e struttura atomica

Nella prima metà del 1800 si riteneva che l’

atomo fosse una p

particella indivisibile, che i

fenomeni elettrici e magnetici (quali la

possibilità di formare materiali con carica

p

elettrica positiva o negativa o di produrre

campi

p magnetici

g

da cariche elettriche in

movimento in conduttori) non dipendessero

dagli atomi

dag

ato stessi

stess e che

c e la

a luce

uce non

o fosse

osse

legata al magnetismo o all’ elettricità.

Negli ultimi decenni del 1800 la descrizione

della luce subì una serie di cambiamenti assai

profondi.

I fenomeni

f

i di riflessione,

ifl

i

rifrazione,

if i

diff

diffusione

i

e,

soprattutto, dell’ interferenza e della

diffrazione avevano portato i fisici a ritenere

che la luce potesse essere interpretata come

un fenomeno ondulatorio ma Maxwell fu in

grado di costruire una teoria dell’

elettromagnetismo in cui la luce era

interpretata

p

come una sovrapposizione

pp

di

campi magnetici ed elettrici concatenati che si

propagano

p

p g

nello spazio

p

come onde

sinusoidali.

Questa descrizione della luce, però, non era in

grado

d di spiegare

i

i ffenomenii llegati

ti all’

ll’

irraggiamento da parte della materia.

Un oggetto cavo le cui pareti siano mantenute ad

una certa temperatura emette energia sotto forma

di luce.

Kirckhhoff elaborò un teorema secondo cui il

rapporto fra la potenza emessa (energia luminosa

emessa nell’ unità di tempo) e quella assorbita

( frazione dell’ energia luminosa incidente

assorbita) da un oggetto dipende solo dalla

temperatura del sistema.

Un oggetto che assorba tutta l’ energia della luce

incidente è detto “corpo nero” e la luce emessa da

questo è detta “radiazione del corpo nero”.

Un dispositivo sperimentale che simuli un

corpo nero può

ò essere una sfera

f

cava,

rivestita internamente di nero di platino e

con una apertura

t

minuscola.

i

l T

Tutta

tt la

l lluce

che entra dall’ apertura è riflessa più volte

d ll pareti

dalle

ti fifino ad

d essere assorbita

bit

completamente dalle pareti.

La luce che è emessa all’ interno e che può

emergere

g

dall’ apertura

p

èq

quella

caratteristica del corpo nero.

Stefan dimostrò che la potenza totale emessa

è proporzionale alla temperatura dell’

oggetto elevata alla quarta potenza

potenza.

Wien provò che l’ energia emessa per unità di

volume ((densità di energia)

g ) non è uguale

g

a tutte le

frequenze della luce emessa, che esiste una

frequenza

q

della luce che corrisponde

p

ad un

massimo di energia emessa, che il prodotto della

temperatura

p

p

per la lunghezza

g

d’ onda

corrispondente al massimo di emissione è

costante ( tale massimo dipende

p

dalla temperatura

p

dell’ oggetto) .

La dimostrazione di tali leggi per via

t

termodinamica

di

i interpreta

i t

t la

l luce

l

come un motore

t

che può mettere in movimento uno specchio

virtuale, a causa del fenomeno della pressione

della luce.

La p

pressione della luce è associata al momento

che luce porta con sé: secondo Maxwell la luce,

nella sua propagazione, trasporta energia, la cui

densità u ed il cui flusso di energia S sono

correlati alla “densità del momento

elettromagnetico” g nel modo seguente

g = S·

S·1/c2

Applicando il primo ed il secondo principio della

termodinamica al trasferimento di energia allo

specchio si dimostra la legge di Stefan.

Il trasferimento del momento della luce allo

specchio (virtuale) provoca un moto dello

specchio che

specchio,

che, al contempo

contempo, riflette la luce e

diviene una sorgente luminosa in

movimento.

i

t U

Un osservatore

t

a riposo

i

rispetto

i

tt

allo specchio rileva che la frequenza della

luce è modificata per effetto Doppler e tale

fenomeno p

porta ad ottenere la legge

gg di

Wien, senza ricavare, però, una funzione

che descriva l’l andamento della densità di

energia in funzione della frequenza alle

diverse temperature

temperature.

Ammettendo che la luce sia emessa da un oggetto

che oscilli ad una determinata frequenza (un

oscillatore armonico) e che l’ energia irraggiata sia

quella di un dipolo oscillante, si ottiene la legge di

Rayleigh e Jeans, secondo la quale la densità di

energia cresce con il quadrato della frequenza e,

per frequenze elevate, tende all’ infinito, in netto

contrasto con i dati sperimentali (“catastrofe nell’

ultravioletto”).

Planck, nel tentativo di risolvere tale problema,

ipotizzò

p

che l’ energia

g degli

g oscillatori p

potesse

essere pari ad un valore ε0 o ad un multiplo intero di

ε0 .

Planck (fine 1800),

1800) dunque

dunque, giunse alla

conclusione che gli oggetti materiali ad

una certa temperatura sono in grado di

emettere energia sotto forma di luce,

ma tale

t l energia

i non è ceduta

d t iin modo

d

“continuo”,, bensì in “pacchetti

p

di

energia” ε0 o “quanti”, la cui energia è

direttamente proporzionale alla

frequenza della luce emessa.

emessa.

ε0 = h ν

ε0 è l’ energia del singolo quanto di

luce

h è la

l costante

t t di Planck

Pl

k

34 J s

h = 6,62

6 62 ·10-34

ν è la

a frequenza

eque a de

della

a luce

uce

Einstein si spinse oltre ed avanzò l’ ipotesi che la

quantizzazione dell’

dell energia non fosse legata solo

ai processi di emissione ed assorbimento, ma

fosse una caratteristica della luce stessa

stessa.

In questa teoria la luce è descritta come un insieme

di oggetti,

tti i ““quanti

ti di lluce”” o “f

“fotoni”,aventi

t i”

ti energia

i

hν, i quali si propagano nello spazio alla velocità

d ll lluce.

della

Tale teoria è in grado di spiegare fenomeni quale l’

effetto fotoelettrico, non interpretabile con una

teoria ondulatoria della luce.

Nella seconda metà del 1800 anche la

descrizione della materia subì

cambiamenti

bi

ti che

h permisero

i

di

associare l’ atomo ai fenomeni

elettromagnetici ed a comprendere

come l’l atomo stesso avesse una sua

struttura.

Intorno alla metà del 1800 g

gli studi condotti da

Faraday sull’ effetto del passaggio di cariche

elettriche in soluzioni liquide dimostrarono

che esiste una corrispondenza tra la massa di

una sostanza

t

che

h reagisce

i

iin un processo

elettrolitico e la quantità di corrente che passa

nel circuito e che la quantità di elettricità

per ottenere un equivalente

q

(quantità

(q

richiesta p

in grammi di una sostanza che, in una

reazione equivale ad una mole di atomi di

reazione,

idrogeno) è sempre la stessa.

G J Stoney (intorno al 1874) interpretò questi

G.J.Stoney

dati sperimentali ammettendo che, se una

quantità fissa di elettricità reagisce con un

numero fisso di atomi, allora anche l’

elettricità deve avere una natura

p

e definì tali p

particelle

corpuscolare

“elettroni”.

Helmholtz (1883) contribuì a chiarire

ulteriormente gli aspetti particellari della

corrente

t elettrica.

l tt i

Nella seconda metà del 1800 una lunga serie

di studi (Pluecher, Hitthorf, Crookes,

Geissler Thomson ed altri) sul passaggio di

Geissler,

corrente in gas rarefatti si rivelarono

fondamentali per comprendere la struttura

atomica.

U gas iin condizioni

Un

di i i normalili è uno scarso

conduttore elettrico, ma in condizioni di

b

bassa

d

densità

ità ed

d iin presenza di un iintenso

t

campo elettrico, permette il passaggio di

corrente elettrica

l i e manifesta

if

emissione

i i

di

luce a frequenze che dipendono dalla natura

del gas.

Negli esperimenti in esame, un aeriforme, alla

pressione di qualche migliaio di Pa (qualche

centesimo di atm)) è chiuso in un tubo di vetro

ai cui capi sono posti due elettrodi (catodo

negativo ed anodo positivo,

positivo spesso a

geometria planare o cilindrica).

Quando la differenza di potenziale sui due

elettrodi è di qualche migliaio di Volt, si

osserva che nel circuito in cui è inserito il

passa corrente elettrica e si ha

tubo p

emissione di luce nella zona fra i due

elettrodi Diminuendo la densità del gas

elettrodi.

gas, l’l

emissione di luce avviene solo in fasce ben

definite alternate da zone prive di

definite,

luminosità e non si ha più l’ emissione

intorno all’ elettrodo negativo o catodo

((spazio

p

oscuro di Crookes).

)

Quando la pressione del g

gas è ridotta ad un

centinaio di Pa, non si ha più l’ emissione di

luce, ma si osserva una fluorescenza sulle

pareti di vetro dal lato opposto al catodo

(raggi catodici).

catodici

catodici)).

)

Se un oggetto è posto fra il catodo e la parete

del vetro fluorescente, si osserva un’ ombra

proiettata

p

o ettata sulla

su a parte

pa te fluorescente.

uo esce te

L’ azione di un campo elettrico esterno

ottenuto ponendo entro il dispositivo un

placche,, in modo che i raggi

gg

condensatore a p

catodici passino fra le armature del

condensatore provoca una deflessione

condensatore,

(spostamento) della zona fluorescente verso

la placca a potenziale elettrico più alto

alto.

L’ azione di un campo magnetico esterno,

ottenuto mediante due bobine e trasversale

rispetto alla traiettoria dei raggi catodici,

induce uno spostamento della regione

fluorescente.

Tali fenomeni furono interpretati nel modo seguente: i

raggi catodici sono formati da particelle con carica

negativa che si spostano rapidamente (frazioni della

velocità della luce) ed in modo rettilineo entro il

dispositivo: sono gli elettroni

elettroni..

Quando la densità del gas è più alta (e provoca una

pressione di qualche centesimo di atm) gli atomi o le

molecole del gas formano particelle con carica

elettrica a causa del campo elettrico intenso che

elettrica,

separa dagli atomi (non più indivisibili) particelle

con carica

i negativa,

ti

glili elettroni,

l tt i d

dall resto

t d

dell’

ll’ atomo.

t

Secondo tale interpretazione, dovuta a Thomson,

gli

atomi sono oggetti globalmente privi di

carica elettrica (neutri) solo perché al loro

interno deve essere presente una sorta di

matrice carica positivamente in cui sono

immersi gli elettroni. La carica positiva

globale della matrice deve essere

g

compensata da quella degli elettroni.

Nel caso in cui un elettrone si separi

p dall’ atomo,,

questo assume una carica positiva.

La luminosità è attribuita al processo di ricombinazione fra l’

elettrone e l’ atomo carico positivamente.

(I fenomeni che avvengono all’ interno del tubo, però

attualmente richiedono una descrizione molto più

complessa.)

Nel corso di esperimenti

p

in p

presenza di campo

p

elettrici e magnetici esterni fu possibile

determinare il rapporto carica/massa degli

elettroni..

elettroni

Una particella con carica elettrica che si

muova entro un campo magnetico subisce

una forza fH, che è perpendicolare sia alla

direzione del campo magnetico, sia a quella

d ll traiettoria

della

i

i e, secondo

d lla llegge di

Lorentz, fH = e(v

e((v x H)).

Nel caso in cui il vettore velocità sia perpendicolare ad H, la

traiettoria della particella coincide con una circonferenza

che giace su un piano perpendicolare ad H, la forza di

Lorentz (in modulo H

H··e·v) è diretta verso il centro della

circonferenza e deve essere uguale alla forza centrifuga

mv2/r (Hev = mv2/r).

Applicando un campo elettrico perpendicolare a quello

magnetico , si possono trovare le condizioni in cui la forza

elettrica eE

eE e q

quella magnetica

g

siano uguali

g

in modulo e

con verso opposto: in tale caso la regione luminescente

non si sposta e vale eE = eHv = mv2/r.

Conoscendo E ed H e misurando r è possibile determinare

e/m = 1840 F ((F è la costante di Faraday),

y) si

ricava che la carica elettrica dell’ elettrone è

negativa e che e/m è indipendente dal tipo di tubo

utilizzato.

utilizzato

La carica dell’ elettrone fu misurata, nel

corso dei primi anni del 1900 da diversi

ricercatori, ma l’ esperimento più conosciuto

è quello ideato da R. Millikan: un

condensatore ad armatura piane è caricato,

in modo da ottenere un campo elettrico di

intensità uniforme e nota e direzione

perpendicolare alle piastre. Nella regione fra

le p

piastre si mantiene una p

pressione

sufficientemente bassa e l’ apparato è

p minimizzare

immerso in un termostato,, per

eventuali correnti convettive.

Il condensatore è interfacciato con una

camera di nebulizzazione necessaria per

ottenere piccolissime gocce sferiche di olio

olio,

alcune delle quali con carica elettrica q

positiva

iti o negativa.

ti

T

Talili gocce possono

entrare nel campo elettrico del

condensatore attraverso un foro nell’

p

del condensatore,, sono

armatura superiore

illuminate lateralmente ed appaiono come

punti luminosi attraverso un microscopio

ottico.

Su ciascuna g

goccia agiscono

g

la forza g

gravitazionale

e quella elettrica, che hanno versi opposti.

Quando le due forze hanno risultante nulla la goccia

appare in quiete e vale: qE = mg. La massa m

della goccia può essere determinata attraverso la

densità (m/V) ed il volume V della goccia pari a

4/3 π r3. Il raggio di una goccia può essere

ricavato misurando la velocità di caduta dell’ olio in

assenza del campo elettrico. La viscosità del

mezzo rende la velocità costante e si può

applicare la legge di Stokes v = mg/6π

mg/6πξr, dove ξ è

il coefficiente di viscosità del mezzo.

Le misure ottenute dimostrarono che la

carica

i elettrica

l tt i su ciascuna

i

goccia

i è

sempre

p un multiplo

p intero di una carica

elementare fissa, pari a 1,60·10

1,60·10-19 C,

associata alla carica dell’

dell elettrone.

elettrone

Contemporaneamente ai raggi catodici

catodici, Goldstein

riuscì ad ottenere fasci di particelle con carica

positiva i raggi anodici

positiva,

anodici,, ottenuti dalla collisione di

elettroni con atomi o molecole di gas molto

rarefatti presenti nei tubi

tubi, mentre Roegten

dimostrò l’ esistenza di altri raggi, i raggi X,

X,

ottenuti dall’

dall interazione dei raggi catodici con il

vetro del tubo o con un opportuno bersaglio

(anticatodo) I raggi anodici si dimostrarono atomi

(anticatodo).

o molecole con carica positiva, mentre i raggi X

furono identificati come luce a frequenza

elevatissima, dell’ ordine dei 1019 Hz.

Negli ultimi anni del 1800 si studiarono non

gg ottenuti artificialmente, ma,

solo raggi

anche, raggi “naturali”, prodotti da sostanze

dette “radioattive”

radioattive , in eventi che coinvolgono

trasformazioni spontanee di atomi di queste

sostanze in altri atomi (Becquerel,

(Becquerel i Curie

Curie,

Rutherford, Soddy ed altri).

I fenomeni legati alla radioattività danno luogo a tre

di

diverse

““radiazioni”:

di i i” i raggii alfa,

alfa

lf , il cuii

comportamento in campi elettrici e magnetici

permette

tt di classificarli

l

ifi li come particelle

ti ll con carica

i

positiva e con un rapporto carica/massa

corrispondente

i

d t all’

ll’ atomo

t

di elio

li con d

due cariche

i h

positive.

I raggi beta,

beta, identificati come elettroni, con velocità

maggiore di quella dei raggi catodici.

I raggi gamma,

gamma, che non subiscono deflessioni in

campi

p elettrici e magnetici

g

e sono descritti come

radiazione di altissima frequenza, superiore a

quella dei raggi

q

gg X.

Agli inizi del 1900 alcune particelle con

carica elettrica erano ben caratterizzate e

furono utilizzate,, accanto alla luce,, per

p

sondare la struttura atomica, applicando,

inizialmente le leggi fisiche elaborate per

inizialmente,

descrivere gli oggetti macroscopici.

Le discrepanze fra i risultati sperimentali e le

previsioni teoriche obbligarono i fisici a

modificare profondamente le teorie

teorie, con la

costruzione di strutture fisico matematiche

che

h prendono

d

il nome di “fi

“fisica

i quantistica”.

ti ti ”

La teoria atomica elaborata da J.J.Thomson,

J.J.Thomson,

descrive gli atomi come una struttura

compatta sferica a carica positiva in cui si

trovano immersi gli elettroni

elettroni, sottoposti alla

forza elettrica attrattiva centrale della carica

positiva ed a quella repulsiva degli altri

elettroni.

In questa teoria è possibile che gli elettroni

siano perturbati o da luce incidente o da

collisioni con altri atomi o molecole e che

essi emettano luce monocromatica a

seguito di oscillazioni armoniche entro la

matrice positiva.

p

Le frequenze calcolate con la teoria di

J J Thomson

J.J.

Thomson, però

però, non spiegano in

modo adeguato gli spettri di emissione

e di assorbimento di gas monoatomici.

Per spettro

p

di assorbimento/emissione si

intende la luce assorbita/emessa dagli

atomi separata in funzione della

atomi,

frequenza.

Bohr, sulla base della teoria della luce avanzata da

Ei t i riuscì

Einstein,

i

ì a fornire

f i un’’ interpretazione

i t

t i

delle

d ll

caratteristiche degli spettri di assorbimento e di

emissione della luce da parte di atomi allo stato

aeriforme, ammettendo che gli atomi possano

trovarsi solo in alcuni stati, caratterizzati da

energie definite, E0, E1, E2, …(quantizzazione dell’

energia

g atomica).

) E0 corrisponde

p

allo stato di

minima energia, detto “stato fondamentale”

L’ assorbimento dell’ energia

g hν

hν associata alla luce

può aversi solo se corrisponde alla differenza di

energia fra due stati dell’ atomo:

hν1 = E1-E0 hν2 = E2-E0 …

L’ ipotesi di J. J. Thomson sulla

struttura atomica

atomica, inoltre

inoltre, era in netto

contrasto con i risultati sperimentali

derivanti dall’ interazione di particelle

cariche con atomi

atomi.

Il g

gruppo

pp di ricerca di Lenard ideò ed eseguì

g

esperimenti di collisione fra atomi e fasci di

elettroni ((i raggi

gg catodici),

), verificando che g

gli

atomi erano “trasparenti” per gli elettroni (e

ciò era in netto contrasto con la teoria

atomica di Thomson).

La conoscenza dei raggi alfa permise a gruppi

di ricerca

i

come quello

ll guidato

id t d

da R

Rutherford

th f d

di progettare e realizzare una serie di lavori

che

h rivoluzionarono

i l i

lla d

descrizione

i i

d

della

ll

struttura atomica.

Il g

gruppo di Rutherford dal 1910 al 1930, circa,

progettò e realizzò eventi di collisione fra

atomi e fasci di particelle alfa (con carica

positiva), emesse con alta energia (qualche

MeV,

MeV circa 10-13J) e molto più massicce

degli elettroni, tanto da non subire modifiche

apprezzabili

bili d

della

ll ttraiettoria

i tt i a causa d

deglili

elettroni atomici.

Il bersaglio era rappresentato da fogli molto

sottili (circa 10-4 mm) di metalli

metalli.

La sorgente di raggi α era costituita da un

tubo a pareti molto sottili contenente radon.

Lo scopo degli esperimenti era quello di rilevare ciò

che accadeva nell’ impatto fra le particelle alfa e

gli atomi bersaglio, disponendo rilevatori dei raggi

α (inizialmente lastre fotografiche) intorno alla

lamina metallica, al fine di misurare le particelle

alfa diffuse in funzione dell’ angolo di deflessione.

I dati sperimentali dimostrarono che la maggior parte

delle particelle (più del 90%) dopo l’l impatto

modificava la sua traiettoria di angoli compresi fra

0° e 60°

60°, ma il dato più incredibile fu che un certo

numero di particelle subiva deflessioni anche di

140°°-180

140

180°°.

Rutherford e gli altri del suo gruppo (Geiger, Marsden, …)

furono indotti ad ipotizzare che la massa atomica fosse

concentrata in una regione centrale (nucleo) di dimensioni

piccolissime, rispetto a quelle dell’ atomo, mentre il resto

d l volume

del

l

atomico

t i era privo

i di masse di

distribuite

t ib it (“

(“vuoto”).

t ”)

In questo modo le particelle α potevano subire una

modificazione rilevante della loro traiettoria solo per

collisione con il nucleo.

Dall’ analisi delle modalità con cui le particelle alfa erano

diffuse (legge di distribuzione in funzione dell’ angolo di

deflessione), si ricavò che la forza all’ origine della

diffusione era quella di Coulomb

Coulomb,

f = k 2Ze2/r2

(2e rappresenta la carica della particella α, Ze la carica del

nucleo atomico, e rappresenta il valore assoluto della

carica

i di un elettrone)

l tt

) e ttale

l fforza era di titipo repulsivo,

l i

indicando che il nucleo ha carica positiva come le particelle

p

proiettile.

Gli esperimenti dimostrarono, inoltre, che il numero Z era

i t

intero,

intero

, dipendeva

di

d

dal

d l titipo di metallo

t ll b

bersaglio

li e coincideva

i id

con il numero che era stato assegnato a tale elemento

nella numerazione p

progressiva

g

della Tavola degli

g Elementi

(numero atomico).

L’ osservazione che Z fosse un numero intero suggerì che nel

nucleo

l ffossero presentiti particelle,

ti ll ciascuna

i

con carica

i

elettrica esattamente uguale, in valore assoluto, a quella di

un elettrone,, ma con segno

g p

positivo: i p

protoni.

Tale ipotesi era stata già avanzata (Prout) per spiegare il

fatto che ciascun elemento chimico ha una massa atomica

con valore

l

iintero

t

iin u oppure consiste

i t di un miscuglio

i

li di

atomi con proprietà chimiche uguali, ma con massa

atomica diversa ed espressa,

p

, ciascuna con un numero

intero: gli isotopi.

isotopi.

La condizione di neutralità elettrica di un

atomo impone che il numero di cariche

positive nel nucleo

nucleo, Ze

Ze, coincida con il

numero di elettroni, che devono trovarsi

nella regione attorno al nucleo stesso.

Dall’

Dall analisi dello schema di diffusione delle

particelle alfa fu possibile determinare

anche le dimensioni lineari del nucleo

atomico, stimate interno a 10-15 m, mentre le

di

dimensioni

i i lilinearii di un atomo

t

sono d

dell’

ll’

ordine di 10-10 m.

Mosely,

y, nel secondo decennio del 1900,, riuscì

a correlare la frequenza ν di emissione di

raggi X da parte di atomi di vari elementi

chimici (perturbati attraverso processi di

collisione

lli i

o per assorbimento

bi

t di lluce)) con il

numero atomico Z:

ν = 3/4R0(Z

(Z--S)2

R0 è la costante di Rydberg

S è la costante di schermatura della carica

nucleare da parte degli elettroni più vicini al

nucleo.

Negli anni intorno al 1930 Bothe e Becker

osservarono che il bombardamento di nuclei di

berillio con particelle alfa produceva l’ emissione di

particelle ritenute inizialmente raggi

p

gg g

gamma.

Altri esperimenti condotti da Curie e Joliot

dimostrarono che le particelle emesse dovevano

essere di altro

lt genere e Ch

Chadwick

d i k riuscì

i

ì a ffornire

i

un’ interpretazione coerente dei dati sperimentali,

ammettendo che le particelle emesse fossero

oggetti neutri, i neutroni, che dovevano trovarsi

entro il nucleo atomico.

Il nucleo atomico, dunque, consiste di un insieme di

Z protoni e (A(A-Z) neutroni. A è il numero di massa

atomica ed è pari alla somma dei nucleoni

nucleoni, cioè

della somma di protoni e neutroni nel nucleo

atomico ((un nucleone è un p

protone o un

neutrone).

Intorno al 1930 H. Yukawa per spiegare l’ evidenza

sperimentale

p

che i nuclei,, formati da protoni

p

e

neutroni, sono stabili, avanzò l’ ipotesi che esista

una interazione,, molto più

p intensa di q

quella

repulsiva coulombiana tra le cariche elettriche dei

protoni: l’ interazione forte.

p

Tale forza deve avere un raggio d’

d azione di qualche

fm (10-15 m sono le dimensioni del nucleo), deve

agire tra protoni

protoni-protoni,

protoni protoni

protoni-neutroni

neutroni e

neutroni-neutroni in uguale modo ed è attrattiva

per valori di qualche fm e repulsiva per distanze

inferiori a 10−1 fm.

La teoria di Yukawa descrive l’ interazione fra

nucleoni come uno scambio tra neutrone e

protone di un tipo di particella

particella, identificata

prima come un mesone e, successivamente

con un pione.

i

La teoria ipotizza

p

che la interazione fra i

nucleoni sia dovuta allo scambio di quanti

(pioni) che sono i messaggeri della forza

(pioni),

forza, di

cui i nucleoni sono le “sorgenti”.

Per analogia con il campo elettrostatico, è possibile

descrivere l’l interazione forte nel modo seguente:

Si consideri un nucleone come la sorgente delle particelle

messaggere di Yukawa ed un altro nucleone “sonda”

vicino.

vicino

Si può pensare che il nucleone sorgente della forza

nucleare generi un potenziale V (r) = -g

g2 e-r/a·1/r

1/r

g è considerata come la carica nucleare, in analogia

con la carica elettrica

e che il nucleone sonda abbia un'energia potenziale

derivante dall'interazione della carica forte g di un

nucleone

l

con il campo U(

U(r)) generato

t d

dall'altro

ll' lt

nucleone:

V(r) = gU(r)

ammettendo che il nucleone sorgente sia nell'origine di un

sistema di riferimento e l'altro in r.

Yukawa,ammette che neutroni e protoni abbiano

comportamenti

t

ti equivalenti

i l ti riguardo

i

d all’interazione

ll’i t

i

forte.

H i

Heisenberg

b

avanzò

ò l’ iipotesi,

t i allora,

ll

che

h id

due di

diversii

nucleoni siano due differenti stati di un nucleone

N e che siano distinguibili per il diverso valore di

una caratteristica, definita “spin isotopico forte” I.

Neutroni e protoni, dunque, sono due stati degeneri

per l’interazione

l interazione forte e l’interazione

l interazione forte è

indipendente dalla carica elettrica.

Attualmente la Teoria Standard prevede che l’l

Attualmente,

interazione forte coinvolga i quark, particelle che

formano protoni e neutroni.

Intorno al 1930,dunque,

1930 dunque si stabilizza una

descrizione dell’ atomo come una struttura

che consiste di un nucleo in cui si trova più

del 99.9% della massa atomica ed in cui si

hanno Z cariche positive (i protoni) e

particelle prive di carica elettrica, i neutroni,

mentre le particelle con carica negativa

negativa, gli

elettroni, sono confinati in regioni attorno al

n cleo (gli orbitali atomici),

nucleo

atomici) i q

quali

ali

determinano il volume atomico

L’ identità chimica di un elemento è legata al

numero atomico Z, cioè al numero di protoni

nel nucleo.

Acceleratori di particelle

Dopo

p il lavoro del g

gruppo

pp di Rutherford,, in

cui si utilizzarono particelle alfa (nuclei di

4He)) prodotte

p

dalla disintegrazione

g

spontanea di nuclei radioattivi, gli

sperimentatori

p

compresero

p

che si

sarebbero potute ottenere altre

informazioni sulla struttura del nucleo

utilizzando fasci ben collimati di particelle

cariche con energie cinetiche molto

superiori a quelle delle particelle

radioattive.

radioattive

Gli acceleratori di particelle sono

strumenti p

progettati

g

e costruiti p

per

ottenere fasci di particelle cariche quali

elettroni protoni

elettroni,

protoni, ioni

pesanti,antiparticelle o particelle

i t bili come i mesonii K ed

instabili

d i pioni

i io

fasci di neutroni da inviare come

proiettili su bersagli fissi o da preparare

produrre collisioni ad alta

in modo da p

energia (10n MeV)

Andamento

A

d

t delle

d ll

energie ottenibili

nei diversi tipi di

acceleratori

Gli esperimenti condotti nei primi decenni del 1900 tendevano

a dimostrare con esperimenti diretti l’ esistenza di oggetti

microscopici che si propagano a velocità elevate (frazioni

della velocità della luce),

) anche

h mediante

di t l’ uso di rilevatori

il

t i che

h

rendono visibili le tracce delle particelle stesse (camere a

nebbia sviluppate da Wilson), avvalorando l’l ipotesi che la

materia sia costituita da particelle.

Contemporaneamente lavori condotti da Davisson e Germer

sulla riflessione di fasci di elettroni da parte di metalli

dimostrarono che gli elettroni subivano fenomeni di

diffrazione provocata dal reticolo cristallino, proprio come i

raggi X negli esperimenti di Laue, mentre lavori di G.P.

Th

Thomson,

Rupp

R

ed

d altri

lt i evidenziarono

id

i

che

h fasci

f

i di elettroni

l tt i

che passano attraverso lamine sottili di metalli ed altri

materiali manifestano fenomeni di diffrazione.

De Broglie, intorno al 1925, aveva avanzato l’

i t i che

ipotesi

h il d

dualismo

li

ttra il comportamento

t

t

ondulatorio e quello corpuscolare associati

alla

ll lluce potesse

t

essere esteso

t

anche

h alla

ll

materia.

Ad una particella della materia deve essere

connessa un’ onda materiale,, la cui

lunghezza d’ onda λ è legata al momento

p= mv)) dalla relazione:

lineare p ( p

p=h/λ

ottenuta dalla teoria della relatività

relatività, secondo

cui il momento e l’ energia sono componenti

di un

n vettore

ettore a q

quattro

attro dimensioni

dimensioni.

Nei decenni successivi si osservò il fenomeno della

diffrazione anche per fasci di neutroni lenti e fasci di

molecole o di atomi ( H2 ed He).

I dati sperimentali dimostrano

dimostrano, dunque,

dunque che il comportamento

ondulatorio è associabile ad oggetti microscopici anche

complessi, quali atomi e molecole.

L’ ipotesi di De Broglie suggerì a E. Schroedinger una teoria,

la “meccanica ondulatoria”, in cui le particelle sono

interpretate come “pacchetti

pacchetti d

d’ onda

onda”, la cui evoluzione è

descritta da una funzione, detta “funzione d’ onda”.

Tale rappresentazione si dimostrò equivalente ad un’

un altra,

elaborata nello stesso periodo da Heisenberg, nella quale

le grandezze fisiche sono associate a matrici.

I lavori

l

i ffondamentali

d

t li di S

Schroedinger,

h di

H

Heisenberg

i

b

e di B

Born,

Jordan, von Neumann e molti altri permisero la costruzione

di un apparato teorico conosciuto come “meccanica

meccanica

quantistica” il cui formalismo fu generalizzato da Dirac.

Meccanica quantistica

I fenomeni

f

i legati

l

ti aii sistemi

i t i atomici

t i i manifestano

if t

un

carattere di discontinuità:

Planck per primo fu indotto a pensare che l’l

emissione di luce da parte di un corpo nero

avvenisse in modo discreto,, attraverso quanti

q

di

energia e riuscì a definire la curva sperimentale

che descrive l’ andamento della densità dell’

energia emessa in funzione della luce solo

ammettendo che l’ energia di ciascun quanto

fosse hν,

con h = 6,55∙10-34 J s (attualmente h = 6,625 ∙10-34

J s ).

Il carattere discontinuo dei fenomeni microscopici

appare molto

lt chiaramente

hi

t nell’

ll’ effetto

ff tt ffotoelettrico,

t l tt i

in cui un metallo sottoposto a luce di frequenza

variabile

i bil emette

tt elettroni

l tt i ma solo

l se la

l ffrequenza

della luce incidente è superiore ad un valore di

soglia.

li

Gli spettri di assorbimento e di emissione di gas

monoatomici evidenziano il carattere discreto

anche delle proprietà atomiche.

La luce è assorbita o emessa da un atomo solo a

certe frequenze

q

caratteristiche e ciò si p

può

spiegare ammettendo che l’ energia degli elettroni

nell’ atomo sia quantizzata.

q

Molte grandezze quantizzate e le equazioni

della meccanica quantistica contengono h in

modo implicito o esplicito.

Una particella può avere un momento ed una

posizione misurabili entrambi con precisione

voluta se h/2π è trascurabile

trascurabile.

Gli esperimenti sulla diffusione di elettroni, atomi o

molecole

l

l di

dimostrano

t

che

h lle particelle

ti ll su scala

l

atomica non possono essere descritte come

oggetti localizzati

localizzati, ma come enti con proprietà

ondulatorie.

Ad ogni particella è possibile correlare un campo

che ha caratteristiche di onde.

Schroedinger generalizza tali idee ed associa ad un

sistema quantistico (elettrone, protone, …) una

funzione, detta “funzione

funzione d’

d onda

onda” Ψ(r,t) di cui è

possibile calcolare l’ evoluzione nel tempo

attraverso regole

g

di corrispondenza

p

fra le leggi

gg

della meccanica classica e quella quantistica.

Ψ(r,t)

( , ) permette

p

di ottenere i valori attesi delle

grandezze fisiche del sistema ed il suo

significato è di tipo statistico.

statistico

Il valore di Ψ2(r,t) fornisce la probabilità di

trovare la particella in una regione

infinitesima attorno ad r.

Le teorie quantistiche non consentono di

avere informazioni dettagliate sul singolo

oggetto, ma forniscono informazioni sul

comportamento medio

di di un gran numero di

quegli

g oggetti

gg

microscopici.

Nel processo di misurazione su scala atomica non è

possibile controllare gli eventi, separando l’ ente

da esaminare dallo strumento, che, nel

rilevamento, perturba il sistema in modo non

prevedibile.

Nella determinazione contemporanea di proprietà

fisiche p , x correlate fra loro, (quale momento e

posizione) si ha un’

posizione),

un incertezza ∆x e ∆p sulle

grandezze , il cui prodotto è maggiore o uguale ad

h/2π

h/2

π

∆x · ∆p ≥ h/2 π

(principio di indeterminazione di Heisenberg)

Heisenberg)

Per descrivere un sistema microscopico è

necessario utilizzare un sistema di leggi e

principi differenti da quelli sviluppati per

descrivere il mondo macroscopico.

Esiste un principio “di

di stratificazione

stratificazione” ,

secondo cui la materia è pensabile come

costituita da livelli

livelli.

Stratificazione di oggetti

macroscopici

Le proprietà di uno strato sono

determinate solo da quelle dello

strato immediatamente al di sotto

di questo.

La meccanica classica si occupa di descrivere

oggetti macroscopici le cui dimensioni sono

dell’ ordine di grandezza dell’ osservatore o

maggiori mentre su scala atomica le leggi

maggiori,

sono quelle della meccanica quantistica.

Un sistema fisico può essere esaminato su

più piani di osservazione.

Un sistema macroscopico

A livello macroscopico A livello microscopico

(dimensioni lineari

È formato da un numero

intorno al m)

enorme (1023) di oggetti le

cui dimensioni lineari sono

È descritto mediante poche

inferiori al nm (10-9m):

grandezze fisiche

glili atomi.

Meccaniche

M

i h (P

P, V

V,

durezza, resilienza,…)

Per descrivere lo stato di tutti

Elettriche ((momento di

gli ato

g

atomi sa

sarebbe

ebbe

dipolo elettrico, o

necessario conoscere la

magnetico,…)

posizione e la velocità di

questi ed in intervalli di

Termodinamiche

tempo più brevi delle

(composizione,

variazioni che gli atomi

temperatura, energia

compiono

compiono.

termica …))

termica,

L’ iintervallo

t

ll di ttempo necessario

i nell

processo macroscopico di misura è, nella

maggior

i parte

t d

deii casi,i molto

lt più

iù ampio

i di

quelli tipici dei moti relativi all’ atomo

( 10-15 s).

Come conseguenza:

La misura macroscopica è sensibile ad una

sorta di valore medio delle coordinate

atomiche

Solo

S l alcune

l

variabili

i bili atomiche

t i h

“sopravvivono” ed assumono un significato

macroscopico.

Una sostanza pura o un miscuglio di più sostanze

pure sono oggetti macroscopici formati, di solito, da un

numero estremamente elevato di specie

microscopiche: si ricordi che una mole contiene 6*1023

unità e che una mole di acqua corrisponde ad una

massa di 18 g.

Ciascuna unità è influenzata dalla presenza di quelle

che le sono più vicine e si instaurano forze di tipo

elettrico (talora magnetico) fra gli atomi o le molecole

o gli ioni e tali interazioni (azioni reciproche)

rappresentano le forze coesive

coesive, che permettono al

sistema di esistere in “modi” diversi, detti “stati fisici

della materia”

materia o “stati

stati di aggregazione”

aggregazione .

E’ opportuno sottolineare che un sistema

formato da un numero molto grande di atomi o

molecole o gruppi ionici possiede alcune

proprietà “intrinseche”

intrinseche che dipendono proprio

dalla presenza di tantissime unità che

interagiscono fra loro.

I cambiamenti di stato o transizioni di stato

corrispondono ad una variazione delle proprietà

intrinseche, a causa di una alterazione della

temperatura, della pressione,…,che provocano

una modificazione delle distanze, della efficacia

delle forze coesive fra le particelle e del tipo di

“

“organizzazione”

i

i

”d

delle

ll unità,

ità ma non modificano

difi

la composizione della sostanza in esame o le

caratteristiche degli atomi /molecole/ioni di

segno opposto, che la formano.

Le proprietà intrinseche sono:

La viscosità,

viscosità, definibile come la capacità dell’

dell oggetto (sistema) di opporsi

alle forze esterne a cui venga sottoposto. In altri termini, è una misura

della resistenza al flusso, se la sostanza è sottoposta ad una tensione.

Più la sostanza è rigida più mantiene la sua forma sotto sforzo.

Volume molare, rappresentato dal volume che occupa una mole di

sostanza pura, in un determinato stato della materia

materi

Compressibilità,, grandezza che indica quanto varia il volume se la

Compressibilità

sostanza è compressa

compressa.

Espansione termica,

termica, indica la variazione di volume provocata da una

variazione di temperatura specificata.

Tensione superficiale,

superficiale, indica la resistenza della superficie di un liquido ad

aumentare la sua area.

Diffusione , fenomeno che permette a due o più sostanze diverse di

diffondere reciprocamente

reciprocamente, provocando un mescolamento; il coefficiente

di diffusione è una grandezza che misura la velocità di diffusione nel

mescolamento.

Tensione di vapore

p

di un solido o di un liquido

q

è la p

pressione esercitata

dalle unità della sostanza che, ad una determinata temperatura, sono

riuscite a passare allo stato aeriforme.

I sistemi macroscopici sono caratterizzati da

un numero rilevante di atomi (≈

(≈ 1023 ), al

contrario i microsistemi, le mesofasi ed i

nanosistemi sono formati da un numero di

atomi che va dalle centinaia nelle

nanostrutture a qualche milione nei

microsistemi.

Le nanotecnologie rappresentano la capacità di

osservare misurare e manipolare la materia su

osservare,

scala atomica e molecolare.

molecolare.

1 nanometro (nm) è un miliardesimo di metro e

corrisponde a circa 10 volte la dimensione lineare

dell’atomo dell’idrogeno mentre le dimensioni di una

macromolecola quale una proteina semplice sono

intorno a 10 nm.

Le nanotecnologie si occupano di strutture con

dimensioni comprese

p

tra 1 e 100 nanometri e sono

“nanoprodotti” quei materiali o dispositivi nei quali

vi è almeno un componente con dimensioni inferiori

a 100 nm.

La definizione data nel 2000 nell’ambito della

National Nanotechnology Initiative (NNI) USA:

“Nanotechnology is the understanding and

control of matter at dimensions of roughly 1 to

100 nanometres

nanometres, where unique phenomena

enable novel applications...

applications... At this level, the

physical, chemical, and biological properties of

materials differ in fundamental and valuable

ways from the properties of individual atoms

and molecules or bulk matter”

matter .

Nanostrutture

La materia ha una struttura discreta, formata da

atomi, le cui dimensioni lineari (≈

(≈ 10-10 m)

rappresentano una sorta di limite inferiore alle

dimensioni di un manufatto.

Si osservi che nelle trasformazioni chimiche gli atomi

si assemblano in modo spontaneo e formano

aggregati (molecole), ma disporre nella geometria

voluta

o u a 100

00 molecole

o eco e ad ese

esempio

pod

di CO2,

2

attualmente non è realizzabile.

Anche le macromolecole di interesse biologico

g

(proteine, DNA, RNA,…) si formano

spontaneamente e le più piccole strutture

viventi, quali cellule di batteri, rappresentano

nanostrutture che si replicano

replicano.

La sintesi proteica, inoltre, è un esempio di

costruzione di una macromolecola che

avviene assemblando piccoli aggregati di

atomi.

t i

Le leggi fisiche che governano i nanosistemi sono

quelle della meccanica quantistica

quantistica.

Proprietà microscopiche quali la distanza

interatomica, la densità di massa, l’ energia di

coesione, la funzione lavoro di un metallo paiono

rimanere gli stessi anche nel cambiamento di

scala da 10-3 m a 10-8 m.

Alcune p

proprietà,

p

, invece,, evidenziano cambiamenti

notevoli nel passaggio dalla dimensione

macroscopica

p

aq

quella nanometrica.

Esistono due metodologie per ottenere una

nanostruttura: nella procedura “top

“top--down” si

procede a modellare la superficie di un

materiale, in modo da ottenere una

nanostruttura bidimensionale, mantenendo

inalterate le caratteristiche del substrato.

Nella procedura “bottom

“bottom--up” si utilizzano

atomi o aggregati (cluster) di atomi composti

da qualche unità a qualche migliaio e si

assemblano

bl

tali

t li unità,

ità per fformare

nanostrutture quali strati monoatomici,

nanocristalli, … .

Sperimentalmente

p

è molto complesso

p

costruire

dispositivi con forma e funzioni specifiche

assemblando i singoli atomi

atomi.

Non si hanno metodi codificati per costruire un

qualsiasi dispositivo che abbia dimensioni

inferiori a 10-4 m, ad eccezione delle tecniche

di fotolitografia

fotolitografia, che permettono di realizzare

circuiti elettronici su scala dei micrometri,

sebbene

bb

questii siano

i

strutture bidi

bidimensionali.

i

li

La fotolitografia è una tecnica che permette di

modellare circuiti elettronici con dimensioni

p , sono divenute sempre

p p

più

che,, nel tempo,

piccole. La progressione segue la legge

empirica di Moore

Moore,, che sintetizza l’l

economia di scala realizzata quando la

stessa funzionalità si ottiene con dispositivi

sempre più piccoli.

La

a fotolitografia

o o og a a u

utilizzata

a a pe

per ccircuiti

cu microelettronici

c oe e o c impiega

p ega

luce ultravioletta, mentre la realizzazione di nanodispositivi

richiede lo sviluppo di tecniche di modellamento diverse,

denominate “nanolitografie

“nanolitografie

nanolitografie””, che appartengono al metodo

“top--bottom

“top

bottom”.

”.

Esistono alcuni metodi efficaci, ma il più comune utilizza

materiali quasi sempre polimerici (resist) disposti sul

materiale da modellare. L’ irraggiamento del resist con

fotoni ad altissima energia o con fasci di particelle ben

collimati (ioni o elettroni) produce modificazioni della

struttura polimerica, a causa della formazione di legami fra

le catene polimeriche (cross(cross-linking) o di rottura di legami

entro le catene. Tali danni inducono un abbassamento o

un innalzamento della solubilità del polimero irraggiato

(resist negativi e positivi, rispettivamente).

L’ azione sul resist può essere condotta per

L

scrittura diretta,

diretta, punto dopo punto con un

f

fascio

i di iionii o elettroni,o

l tt i nella

ll modalità

d lità iin

parallelo, in cui si trasferisce il modello di

una maschera con le caratteristiche volute

sulla

su

a supe

superficie

c e de

del resist

es st mediante

ed a te

proiezione con un sistema ottico,oppure

allineando la maschera per contatto o per

vicinanza con la superficie del resist.

Il materiale

materiale, dopo l’l irraggiamento con luce

UV, raggi X ( o fasci elettronici con

microscopi

i

i elettronici

l tt i i a scansione)

i

)è

sottoposto a trattamenti chimici che

rimuovono il resist esposto, nel caso di un

es st negativo,

egat o, mentre

e t e nel

e caso de

del resist

es st

resist

positivo è il polimero a permanere dopo lo

sviluppo mentre il substrato è rimosso dal

sviluppo,

trattamento chimico.

Nella litografia con fasci di ioni focalizzati,

focalizzati, gli

ioni ad alta energia sono indirizzati e

scanditi sulla superficie bersaglio e possono

spazzare via gli atomi superficiali (litografia

per sottrazione),

sottrazione) oppure

oppure, per

decomposizione di un vapore organico con il

fascio ionico

ionico, si ha la deposizione di uno

strato di atomi (litografia addittiva).

Il fascio ionico

ionico, inoltre

inoltre, può provocare una

modificazione della struttura molecolare del

resist operando in modo eq

resist,

equivalente

i alente alla

radiazione elettromagnetica ad alta energia

ed

d all ffascio

i elettronico.

l tt i

Le tecniche di nanolitografia hanno limiti legati, fra l’

altro alle dimensioni del fascio incidente ed al

altro,

fatto che si possono modellare strutture

bidimensionali (superfici), non tridimensionali.

I metodi “bottom“bottom-up” che si basano sull’

aggregazione molecolare spontanea possono

essere più versatili

versatili. Con tali tecniche si

costruiscono unità molecolari che si assemblino in

modo da formare strutture di forme desiderate.

Il punto critico è legato alla necessità di progettare

adeguatamente i blocchi molecolari, in modo che

l schema

lo

h

di montaggio

t

i sia

i iincorporato

t nelle

ll

caratteristiche chimiche e fisiche delle unità,

pilotando l’l aggregazione mediante la struttura dei

blocchi singoli.

Evoluzione dell’ elettricità e del

magnetismo negli ultimi quattro secoli

Elettricità, magnetismo

g

e struttura

della materia

Sin dall

dall’’ antichità si conoscevano le

proprietà di alcuni materiali come la

magnetite, sostanza in grado di attirare

frammenti di ferro

ferro, si sapeva che l’l ambra

o il vetro, strofinati, attiravano frammenti di

opportune sostanze e che

che, avvicinando

alla magnetite piccole barre di ferro,

queste

t acquistavano

i t

le

l stesse

t

proprietà

i tà

della magnetite, cioè “si magnetizzavano”

Nel 1300 Petrus Peregrinus

g

de Maricourt,,

che aveva costruito bussole (compassi

magnetici) utilizzando aghi magnetizzati

appoggiati alla superficie di un liquido,

riuscì

i

ì a costruire

t i piccole

i

l sfere

f

magnetizzate ed a dimostrare che aghi

magnetizzati si orientavano sempre in

g

Tracciando le linee

modo longitudinale.

individuate dalla direzione degli aghi,

Petrus Peregrinus dimostrò che esse si

intersecavano in due punti opposti della

sfera definiti “poli magnetici” .

sfera,

Solo dal 1600 si intrapresero lavori sistematici

suii ffenomenii elettrici

l tt i i e magnetici.

ti i

Willi

William

Gilb

Gilbertt ffu uno d

deii primi

i i studiosi

t di i ad

d

ideare ed eseguire esperimenti, raccolti nell’

opera “De

De magnete, Magneticisique Corporibus”

Corporibus

(Sul Magnetismo).

Gilbert creò i termini “forza elettrica”, “polo

magnetico” ed “attrazione elettrica” per spiegare

il comportamento dei materiali studiati e si

interessò ai fenomeni magnetici, approfondendo

le conoscenze sviluppate nei secoli precedenti,

ampliando il numero di materiali elettrizzabili ed

identificando solo azioni attrattive nei fenomeni

elettrici.

elettrici

Otto von Guericke (nel 1600) , Charles Francois Du Fay,

e Stephen

St h Gray

G

(primi

(primi

i id

decennii d

dell 1700)

1700) ebbero

bb

modo

d

di conoscere il lavoro di Gilbert e di proseguire nella

ricerca.

Von Guericke si occupò di meccanica e pneumatica,

dimostrando per primo la presenza della pressione

atmosferica

t

f i e costruendo

t

d dispositivi

di

iti i per produrre

d

il

“vuoto” e la prima rudimentale macchina a strofinio per

avere elettricità statica.

Gray dimostrò che le carica elettrica poteva distribuirsi da

alcuni materiali, ( “conduttori”), mentre ciò non accadeva

per altri

lt i (i

(isolanti)

l ti)

Du Fay dimostrò che l’ elettricità poteva essere solo di

due tipi,

tipi classificati come “vetroso”

vetroso e “resinoso”

resinoso e che

oggetti con la stessa carica tendevano a respingersi,

mentre oggetti con carica diversa subivano attrazione.

Gli eventi sperimentali raccolti ed esaminati sino alla metà del 1700

possono essere sintetizzati nel modo seguente:

Esistono materiali come vetro, resine naturali, … che, per strofinio

con panni di lana, manifestano la capacità di attrarre oggetti di

piccola massa

massa, come sfere di sambuco del diametro dell’

dell ordine dei

centimetri appese a fili di seta in una sorta di pendolo. Il materiale,

allora, è detto “elettrizzato” o “carico di elettricità”.

può trasmettere da un corpo

p ad

La condizione di elettrizzazione si p

un altro per contatto diretto.

Se la sferetta di sambuco è elettrizzata per contatto con una resina

elettrizzata e ad essa si avvicinano materiali diversi elettrizzati per

strofinio,

t fi i sii osserva che

h il piccolo

i

l pendolo

d l è attratto

tt tt d

da alcuni

l

i ed

dè

respinto da altri. Questi eventi portano a concludere che esistano

solo due stati di elettrizzazione, quello vetroso e quello resinoso. Se

la stessa procedura si applica utilizzando il vetro per elettrizzare la

sfera di sambuco, allora si verifica che tutti i materiali che prima

erano attratti dal sambuco, ora sono respinti e quelli prima

allontanati ora sono attratti dalla sfera. Ciò porta a concludere che

oggetti

tti con llo stesso

t

titipo di elettrizzazione

l tt i

i

ttendono

d

a subire

bi fforze

elettriche repulsive e quelli con tipo di elettrizzazione diverso sono

sottoposti a forze elettriche attrattive.

Elettrizzando la sfera di sambuco per contatto con una

resina elettrizzata per strofinio con un panno di lana e

avvicinando

i i

d questo

t ultimo

lti

alla

ll sfera,

f

sii osserva che

h sii

hanno forze elettriche attrattive fra i due materiali.

Eseguendo anche altri esperimenti con sostanze

di

diverse,

sii giunge

i

alla

ll conclusione

l i

che

h nell processo di

strofinio un materiale assume quella che appare come

una proprietà della materia chiamata carica elettrica

vetrosa e resinosa.

Un materiale metallico inserito su un supporto quale

vetro o resine e strofinato con un panno di lana si

elettrizza e tale stato scompare se l’ oggetto è toccato da

un altro metallo o da una persona. Se il metallo è tenuto

in mano non si ha elettrizzazione alcuna per strofinio

strofinio.

Queste osservazioni dimostrano che esistono oggetti in

cui lo stato di elettrizzazione si disperde attraverso il

materiale stesso e

e, per questo

questo, tali sostanze sono

definite “conduttori

“conduttori elettrici”,

elettrici”, mentre altre non

evidenziano tale fenomeno e sono dette “isolanti

“isolanti

elettrici””.

elettrici

Pieter van Musschenbroek ed Ewald Christian Von

Kleist in modo q

quasi contemporaneo

p

((metà del

1700), costruirono il primo dispositivo in grado di

accumulare grandi quantità di elettricità

(condensatore

condensatore):

): la bottiglia di Leyden

Leyden, utilizzata

anche per studiare le caratteristiche della

conducibilità elettrica,, mentre William Watson

avanzò l’ ipotesi che le cariche elettriche si

conservassero.

H

Henry

C

Cavendish,

di h iintorno

t

all 1750

1750, sii iinteressò

t

òa

misure della capacità di sostanze diverse di

disperdere la carica elettrica

elettrica, trasportandola nel