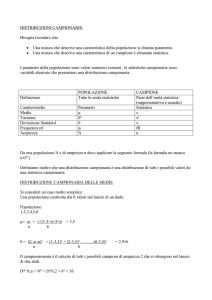

DISTRIBUZIONE CAMPIONARIA

Si definisce popolazione qualsiasi insieme di elementi simili tra loro per una o più

caratteristiche che rappresentano l’oggetto dello studio.

Può essere finita, ovvero costituita da un numero finito di unità (comunque molto grande)

o infinita trattiamo come popolazioni anche insiemi che non sono enumerabili e che si

realizzeranno anche nel futuro.

Si definisce campione un sottoinsieme della popolazione, ovvero una raccolta finita di

elementi estratti da una popolazione. Scopo dell’estrazione: ottenere informazioni sulla

popolazione

Pertanto il campione deve essere rappresentativo della popolazione da cui viene estratto

(‘non viziato’).

Per corrispondere a queste esigenze il campione viene individuato con un campionamento

casuale.

Campionamento ed inferenza sono due processi simmetrici, l’inferenza permette di dire

qualcosa sulla popolazione a partire dai dati ottenuti sul campione.

o Definiamo statistica campionaria la statistica calcolata per le osservazioni che

compongono il campione (T).

In generale, le statistiche campionarie sono definite in modo tale da essere degli

stimatori non distorti dell’omologo parametro della popolazione (θ*).

*= teta, indica un qualsiasi parametro

Con le lettere greche indichiamo i parametri della popolazione (che non conosciamo), con

l’alfabeto latino indichiamo i parametri del campione (noti)

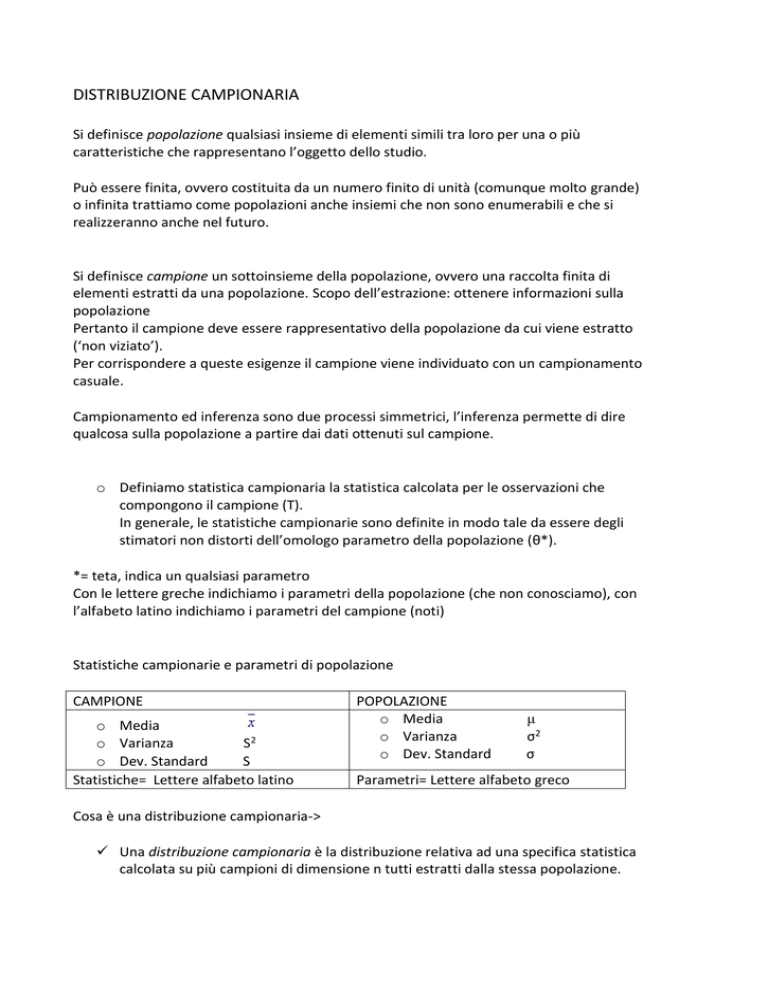

Statistiche campionarie e parametri di popolazione

CAMPIONE

o Media

o Varianza

S2

o Dev. Standard

S

Statistiche= Lettere alfabeto latino

POPOLAZIONE

o Media

o Varianza

o Dev. Standard

μ

σ2

σ

Parametri= Lettere alfabeto greco

Cosa è una distribuzione campionaria->

Una distribuzione campionaria è la distribuzione relativa ad una specifica statistica

calcolata su più campioni di dimensione n tutti estratti dalla stessa popolazione.

La funzione campionaria è una funzione di probabilità il cui dominio è costituito dai

valori di una statistica (es media) e il codominio è costituito dalle probabilità che i

valori della statistica hanno di verificarsi.

Per costruire una distribuzione campionaria occorre:

1. Estrarre dalla stessa popolazione dei campioni con lo stesso numero di casi (n)

2. Le estrazioni devono essere casuali e indipendenti.

3. In questo modo, le determinazioni (osservazioni) campionarie (x1, x2, ..xn) sono

variabili indipendenti, ed hanno la stessa funzione di probabilità della popolazione

di origine, ovvero sono identicamente distribuite (variabili IID: indipendenti,

identicamente distribuite)

4. Sui campioni così estratti si procede a calcolare la statistica della quale si vuole

definire la distribuzione campionaria

Siano X1 ,X2 , …, Xn delle prove indipendenti di un processo aleatorio con valore atteso

E(Xi)= e varianza V(Xi )= σ2.

Si definisca la somma delle variabili aleatorie Xi come: Sn =X1 +X2 +…+Xi

Dato che X1 ,X2 , …, Xn sono variabili aleatorie indipendenti, ciascuna delle quali definita

con media μ e varianza σ2, il valore atteso e la varianza di Sn diventano:

E(Sn )= E(X1 +X2 +…+Xi )=E(X1 )+E(X2 ) +…+E(Xi )= n μ

V(Sn )=V(X1 +X2 +…+Xi )= V(X1 )+V(X2 ) +…+V(Xi )=n σ2

Teorema centrale del limite-> Se si estraggono ripetuti campioni casuali di dimensione n da

un qualsiasi universo (qualunque sia la sua forma) con media μ e varianza σ2,

all’aumentare della dimensione n del campione, la distribuzione della media campionaria

sarà normale e avrà come media μ e come varianza σ2/n

Quindi al crescere della grandezza del campione, la distribuzione campionaria della media

tende ad una distribuzione nomale.

La deviazione standard della media campionaria si definisce errore standard e rappresenta

un indice di precisione della media stimata su un campione.

La stima fornita dal singolo campione è affetta da incertezza, a causa dell'errore casuale

del campionamento.

L’errore standard è una misura dell’incertezza di una statistica misurata su un campione

(ad esempio la media). L’errore standard rappresenta l’errore che noi commettiamo se

consideriamo ad esempio la media calcolata su un campione come la media vera della

popolazione.

La variabilità delle medie campionarie (ES) è minore della variabilità della popolazione (σ),

ed è tanto minore, tanto maggiore è la numerosità campionaria.

NB: deviazione standard è diversa dall’errore standard

La deviazione standard è una misura di variabilità fra individui

L’errore standard è una misura di incertezza della stima.

VARIANZA CAMPIONARIA

Anche la statistica s (deviazione standard o scarto quadratico medio) ha una sua

distribuzione campionaria, ovvero gli scarti quadratici medi dei campioni si distribuiscono

attorno al vero scarto quadratico medio della popolazione, proprio come le medie dei

campioni si distribuiscono attorno alla media della popolazione.

NB: S2 è una stima sistematicamente errata di σ2.

La media della distribuzione campionaria di S2 per campioni casuali, non è σ2 ma piuttosto

[(n-1/n) σ2]

Non si verifica l’eguaglianza perfetta tra valore atteso della varianza campionaria e il suo

omologo nella popolazione: i due valori risultano connessi come segue:

Pertanto se definiamo la varianza campionaria corretta come:

Avremo come conseguenza che

Il valore atteso della varianza campionaria (calcolata con n-1) è la varianza della

popolazione, in altre parole la varianza campionaria (calcolata con n-1) è una stima non

distorta della varianza della popolazione.

In sintesi:

La distribuzione campionaria delle medie permette di fare inferenza sulla media della

popolazione quando si conosce 1 solo campione di dimensioni n.

Ha le seguenti proprietà:

1.

la media della distribuzione campionaria delle medie è uguale alla media μ della

popolazione.

2.

La deviazione standard della distribuzione campionaria delle medie è funzione della

numerosità n del campione e della deviazione standard (σ) della popolazione. Tale

quantità si chiama Errore standard (ES): σ /√N . Se non conosciamo σ della popolazione,

può essere stimato a partire dai dati del campione, e l’ES diventa: s/√N-1

3.

La distribuzione campionaria è approssimativamente normale, indipendentemente

dalla distribuzione della popolazione, posto che n sia sufficientemente grande.

Distribuzioni campionarie e distribuzioni di probabilità->

Per associare una probabilità ad una media campionaria (n≥30) se conosciamo δ della

popolazione facciamo riferimento alle tavole della normale standardizzata.

La standardizzazione sarà fatta usando i parametri di tale distribuzione campionaria:

Quando il campione è piccolo e/o non conosciamo la varianza della popolazione possiamo

stimarla attraverso quella del campione, ma per associare un valore di probabilità al

risultato ottenuto in un campione bisogna utilizzare la distribuzione t di Student al posto

della normale standardizzata.

La distribuzione t di Student (William Gosset 1876-1937)

Possiede le stesse caratteristiche della distribuzione normale, ma ha una forma più

schiacciata che esprime una variabilità maggiore intorno alla media.

La variabilità della media e lo schiacciamento della curva dipendono dall’ampiezza

campionaria, ovvero tanto più i campioni sono piccoli, maggiore sarà la variabilità e tanto

più schiacciata risulterà la curva.

Il valore di t dipende dalla numerosità campionaria, quindi non esiste una sola

distribuzione t, ma ne esistono tante in funzione dei gradi di libertà, dati dalla quantità n-1.

I gradi di libertà esprimono i valori liberi di variare poste alcune restrizioni.

Ad esempio: se sappiamo che la somma di una serie di 4 punteggi ottenuti da 4 soggetti è

60, possiamo stabilire i valori di tali punteggi in base al vincolo dato dalla somma: una volta

scelti 3 valori automaticamente possiamo ottenere il quarto punteggio, infatti se poniamo i

primi 3 valori pari a 15, anche il quarto sarà uguale a 15 se vogliamo rispettare il vincolo

della somma uguale a 60.

Se i gdl sono quei valori liberi di variare, poste certe restrizioni, allora se abbiamo un

campione di numerosità n, i gdl saranno sempre un valore in meno rispetto ad n:

Gdl=n-1

LA DISTRIBUZIONE CAMPIONARIA DELLE MEDIE

La distribuzione campionaria delle medie permette di fare inferenza sulla media della

popolazione a partire dai dati di 1 solo campione.

Ha le seguenti proprietà:

o La media della distribuzione campionaria delle medie è uguale alla media μ della

popolazione.

o La deviazione standard della distribuzione campionaria delle medie è funzione della

numerosità n del campione e della deviazione standard (σ) della popolazione. Tale

quantità si chiama Errore standard (ES): σ / √N

o È approssimativamente normale, posto che n sia sufficientemente grande (n>=30).

Il percorso dell’inferenza statistica si svolge seguendo le seguenti fasi:

1.

estrazione di un campione della popolazione

2.

calcolo delle statistiche campionarie, cioè dei valori corrispondenti ai dati contenuti

nel campione

3.

stima dei parametri nella popolazione in base ai risultati forniti dal campione.

Distinguiamo tra

θ = (teta) PARAMETRO -> valore reale, fisso riferito a una popolazione che però

non possiamo conoscere, è ignoto; è uno dei valori che governa la variabile

all’interno della popolazione

T = STIMATORE del parametro θ; (T)-> funzione delle determinazioni campionarie

T= f(Xi) è anche detto riassunto campionario

t = uno dei valori possibili di T, estratto dal campione selezionato

per indicare che il valore trovato (t) è una stima del parametro θ, si mette il simbolo ^

sopra il simbolo del parametro

STIMA PUNTUALE

Si definisce stimatore una funzione dei valori osservati sul campione impiegata per

eseguire la stima di un parametro fisso ed ignoto.

Si definisce stima, invece il valore restituito dalla funzione sulle determinazioni di un

effettivo campione

Con una stima puntuale si mira a calcolare sul nostro campione (uno degli infiniti campioni

possibili)

Proprietà degli estimatori

Correttezza: uno stimatore si definisce corretto se il suo valore atteso corrisponde

al valore del parametro nella popolazione E(T)= θ

=> E(T)- θ = 0

Ad esempio E(

)= μ

La distorsione di uno stimatore B (Bias) si definisce:

E(T)- θ = Bias

Stimatore assolutamente corretto = E(T)- θ = 0

Stimatore asintoticamente corretto se la distorsione tende a zero quando n tende a

infinito = n-> ∞ Bias-> 0

Stimatore distorto = Bias ≠ 0

In termini di correttezza la mediana è uno stimatore corretto tanto quanto la media

Efficienza: uno stimatore si definisce efficiente se, a parità di altre condizioni, la sua

varianza risulta minore. => 1/ σT

La stima dell’errore standard (per popolazioni finite) è:

L’efficienza relativa di uno stimatore corretto T rispetto a un altro stimatore

corretto T ’ è dato dal rapporto tra le loro precisioni:

1/ σT

1

σT1

σT1

------- = ----- * ------ = ------ > 1

1/ σT1

σT

1

σT

σT è più efficiente di σT1 se il loro rapporto è >1

La media è uno stimatore più efficiente della mediana

Precisione: uno stimatore è tanto più preciso quanto minore è la dispersione della

distribuzione campionaria.

Questa caratteristica ci fornisce una stima dell’accuratezza dello stimatore, e è

misurata attraverso l’errore standard (SE)

Consistenza: uno stimatore viene definito consistente se all’aumentare della

numerosità campionaria aumenta anche la probabilità che il valore della stima sia

uguale al valore del parametro nella popolazione.

Una misura della consistenza è l’errore quadratico medio (MSE): MSE=E(T-θ)2

dove T è un generico stimatore del parametro θ

L’MSE risulta scomponibile in due parti: la varianza dello stimatore dovuta

all’errore casuale (imprecisione) e il quadrato della distorsione: σ2(T)+B2(T).

Si dice che T è consistente se l’MSE tende a 0 quando n tende a infinito

L’individuazione della funzione dei dati campionari che permette di avere una stima dei

parametri è detta naturale => vi è un reciproco tra T calcolato sul campione e θ della

popolazione di riferimento

Un esempio di un estimatore naturale è la media e la varianza

μ=

σ2 = S2

se non è possibile individuare un estimatore diretto si utilizzano degli algoritimi detti

“metodi di stima” per calcolare la stima del parametro

due di questi metodi sono:

- il metodo dei minimi quadrati (MMQ)

- il metodo della massima verosimiglianza (ML)

Con il metodo dei minimi quadrati (MMQ) si stima il parametro mediante quel valore che

rende minima la somma delle distanze al quadrato tra le osservazioni e il parametro

stesso.

Ad esempio: se vogliamo stimare la vera lunghezza di un oggetto, sulla base di n

misurazioni (xi ) affette da errore casuale, la stima del parametro è quel valore che

minimizza la seguente espressione:

Massima verosimiglianza (ML) (Fisher) è legato all’idea che le reali caratteristiche della

popolazione generano con diversi livelli di probabilità distribuzioni campionarie diverse.

Il metodo di stima della massima verosimiglianza funziona al contrario: dato un certo

campione si cerca di stimare quei parametri che con un grado di probabilità più elevato

possono aver generato il campione osservato.

Vado a considerare come stima di μ il valore che rende massima la probabilità di osservare

quel valore => probabilità di un evento composto indipendente

P(x1 x2 x3) = P(x1)*P(x2)*P(x3)

Cerca quel valere che rende massima la probabilità di aver ottenuto il campione dato

NB: Oltre alla stima puntuale deve essere sempre anche indicato l’errore standard della

stima σT (indica quanto la stima si discosta dal parametro)

Più l’essore standard è piccolo più la stima è buona

STIMA INTERVALLARE

Nella stima puntuale non possiamo aspettarci che la nostra stima T coincida con il

parametro vero θ, ma è più lecito chiedersi qual è il grado di approssimazione che

possiamo aspettarci.

Negli anni 30 Neyman propose di fare una stima intervallare ovvero individuare un

intervallo “I” entro il quale il parametro ignoto si trova con un certo grado di probabilità.

Non stimiamo più il valore esatto del parametro, ma un intervallo di valori che, con un

certo grado di probabilità o fiducia, conterrà il vero valore della popolazione.

Di solito non conosciamo la media della popolazione e vogliamo stimarla a partire dai dati

ottenuti su un campione.

Possiamo ad esempio utilizzare la media nel campione (xmedio ) per stimare la media della

popolazione (μ). Ma con questo metodo non sappiamo quanto xmedio sia vicina a μ.

Pertanto spesso si preferisce stimare un intervallo di valori entro i quali si ritiene sia

compreso il parametro in esame con un certo grado di “confidenza”.

Questo range di valori si chiama intervallo di confidenza

La procedura di stima intervallare richiede che sia verificato almeno uno dei seguenti prerequisiti:

La variabile si distribuisca normalmente

Il campione sia sufficientemente ampio (n>=30) per cui grazie al tlc, la forma della

distribuzione della variabile nella popolazione è indifferente

Si definisce intervallo di confidenza un range di valori costruito intorno alla stima

campionaria, all’interno dei quale, con un certo grado di probabilità sarà contenuto il vero

valore del parametro della popolazione

Quindi la stima di θ (^) è dato da :

t ± valc σT

valc : valore critico, dipende dal livello di confidenza (1-α) dove α vale di solito 0,1 o 0,5 (1 o

5%); il valore critico dipende dal tipo di distribuzione della variabile. Se si tratta di una

distribuzione normale utilizziamo lo z critico

σT :errore standard del parametro. Se parliamo dell’errore standard della media (σx medio)

è uguale a σ/√n

più σ è piccolo più l’intervallo per zc è piccolo

ad esempio il procedimento di stima di μ avviene mediante la media campionaria X medio ;

poiché questa di distribuisce normalmente con media μ e errore standard σ/√n, la

probabilità di ottenere un valore Xmedio che non si discosti da μ ±zc volte l’errore standard è

data da:

In una distribuzione normale standardizzata il 95% dei valori è compreso tra -1.96 e +1.96

-1.96 < Z < +1.96

Dunque un IC al 95% per la media (μ) è dato da: (Xmedio -1.96* σ/√n ; Xmedio +1.96* σ/√n)

Un intervallo di confidenza al 95% è un intervallo in cui in 95 casi su 100 cadrà il vero

valore della media della popolazione

Quindi: Siamo confidenti al 95% che la media μ della popolazione è compresa

nell’intervallo (Xmedio -1.96* σ/√n ; Xmedio +1.96* σ/√n)

I limiti dell’ intervallo (L1 , L2 ) sono detti limiti di fiducia o di confidenza;

più è ampio l’intervallo maggiore sarà la probabilità che contenga il vero valore della

popolazione.

L’ampiezza dell’intervallo di confidenza dipende dal livello di probabilità (o di confidenza)

che è fissato a priori dal ricercatore.

Il livello di probabilità è definito dall’espressione 1-α, dove α è detto livello di

significatività. I valori più usati di α sono 0.05 e 0.01 cui corrispondono intervalli di

confidenza o fiducia del 95 e 99%

Trade-off tra sicurezza e precisione: + è ampio l’intervallo di confidenza maggiore è

l’imprecisione della stima.

A parità di livello si significatività la precisione della stima intervallare migliora al crescere

della numerosità del campione.

Fissando a priori il livello di accuratezza desiderato calcoliamo quanto deve essere grande

il campione per ottenere una stima con quel livello di accuratezza.

Poniamo di voler costruire un campione casuale semplice che ci fornisca una stima della

media della popolazione con un errore e= ± 0.1, rispetto al parametro reale, con un livello

di fiducia prescelto (ad es.) del 95%.

Ovvero, se estraiamo infiniti campioni, 95 volte su 100 gli IC ottenuti sono compresi in un

range non superiore a 0.2.

In una distribuzione normale il 95% delle osservazioni ricade nell’intervallo ±1.96 σ/√n,

perciò l’ES moltiplicato per 1.96 deve darci la precisione voluta (0.2 nel nostro caso).

Distribuzioni campionarie e distribuzioni di probabilità ->

Per associare una probabilità ad una media campionaria calcolata su un campione con

n>30 facciamo riferimento alle tavole della normale standardizzata, poiché la distribuzione

campionaria delle medie è normale per il tlc.

La standardizzazione della media sarà fatta in riferimento ai parametri di tale distribuzione

campionaria che possono essere calcolati conoscendo quelli della popolazione. Si ricava z

attraverso la seguente formula:

Se non si conosce la varianza della popolazione

Θ2 ignoto

È necessario fare una stima della varianza => Θ2= S2

S2

∑(xi - )2

S2 = --- = -------------n

n

S2 è una variabile aleatoria, dobbiamo definire quali caratteristiche ha la varianza

campionaria => distribuzione di probabilità

Il valore atteso della varianza è :

Non è uno stimatore assolutamente corretto { E(S2)≠ σ2}

Se il campione è infinitamente grande il rapporto tra (n-1) e n è praticamente 1

E(S2)n -> ∞ = σ2

Si dice quindi che è uno stimatore asintoticamente corretto

Per usare un estimatore assolutamente corretto usiamo la varianza corretta

:

E( ) = σ2

La varianza corretta è uno estimatore assoluto di σ2

Riassumendo possiamo di che

n

n

1

∑ (xi -

= ---- S2 = ---- * ---- ∑ (xi n-1

n-1

n

∑ (xi -

)2

)2

)2 = ------------n-1

sommatoria degli xi - al quadrato fratto n-1

= -------------------n-1

La varianza di una varianza è funzione dl momento centrale di quart’ordine del fenomeno

x, della varianza alla seconda e dell’ampiezza del campione

VAR (

) = funzione ( μ4, σ4, n)

La distribuzione di probabilità di

chi quadrato χ2

è una variabile continua, che però va da 0 a + ∞

χ2 = Σnz2

il chi quadrato corrisponde alla sommatoria di n variabili normali standardizzate prese al

quadrato.

χ2 = [(n-1)/ σ2]

χ2 è una variabile aleatoria avente la distribuzione χ2(chi quadro)di parametro ν=n−1.

Il valore ν (nu) prende il nome di grado di libertà.

E(χ2)= ν

Il valore atteso di χ2 è pari al valore di ν, ovvero dei gradi di libertà

ν -> è il numero di variabili aleatorie indipendenti sommate tra loro. Se le variabili sono

tutte indipendenti allora ν = n . in questo caso i gradi di libertà sono pari a n-1

ν= n-1 (vincolo dovuto al fatto che usiamo le variabili aleatorie

)

χ2 = Σnz2 = Σ [(xi – μ)/ σ]2

[(n-1)/ σ2]

= [(n-1)/ σ2] * [1/(n-1)* Σ(xi- )2] = (1/ σ2) * [Σ(xi- )2] = Σ [(xi –

)/ σ]2

-> espressione che coincide con quella teorica del χ2

si distribuisce come una chi quadrato con gradi di libertà n-1

˄

˄

μ=

Stima di μ è uguale alla

media del campione

σx =

σ/ √n

σ della media del campione

di calcola facendo il rapporto

tra σ e la radice della

numerosità del campione

σ=

˄

S / √n

varianza

corretta

La

stima

di σ è

uguale

S / √n-1

varianza non

corretta

Standardizzazione:

˄

σ viene però sostituito con S

˄

il fatto che S sia una stima di σ fa sì che la sua distribuzione di probabilità non sia più

normale, ma sia una t di student

z

t = --------√χ2/ ν

Pur partendo da una distribuzione normale (z) la media standardizzata si distribuisce come

un t di student.

I suoi gradi di libertà sono n-1

Il valore critico va cercato nelle tavole della t di student => si usa il t critico (t c)

˄

μ=

˄

± tc * σx

La t ha code più ampie di una distribuzione normale, ma per ν>30 => t ≈ NOR (0,1)

Per gradi di libertà superiori a 30 la t di student approssima una distribuzione normale

standardizzata

t è una distribuzione usata per campioni piccoli

Bisogna distinguere due situazioni:

1. Campione piccolo e varianza della popolazione nota

La procedura di stima è identica al caso in cui N>30: si usa comunque la

distribuzione normale standardizzata.

2. Campione piccolo e varianza della popolazione ignota

Quando il campione è piccolo e non conosciamo la varianza della popolazione

possiamo stimarla attraverso quella del campione, ma per costruire gli IC bisogna

utilizzare la distribuzione t di Student al posto della normale standardizzata

La distribuzione t di student possiede le stesse caratteristiche della distribuzione normale,

ma ha una forma più schiacciata che esprime una variabilità maggiore intorno alla media.

La variabilità della media e lo schiacciamento della curva dipendono dall’ampiezza

campionaria, ovvero tanto più i campioni sono piccoli, maggiore sarà la variabilità e tanto

più schiacciata risulterà la curva.

Il valore di t dipende dalla numerosità campionaria, quindi non esiste una sola

distribuzione t, ma ne esistono tante in funzione dei gradi di libertà, dati dalla quantità n-1.

I gradi di libertà esprimono i valori liberi di variare poste alcune restrizioni.

Se i gdl sono quei valori liberi di variare, poste certe restrizioni, allora se abbiamo un

campione di numerosità n, i gdl saranno sempre un valore in meno rispetto ad n: Gdl=n-1

La t di student è una famiglia di variabili aleatorie, cambiano in base ai gradi di libertà

La dicitura “ipotesi mono o bidirezionale” presente sulle tavole ha a che fare col lavore

delle code della distribuzione

Bidirezionale = α va spaccato a metà, nelle due code (ogni coda vale α/2)

Monodirezionale = α sta tutta su una coda

NB: la media campionaria standardizzata con σ stimato, si distribuisce come una t di

student solo se la popolazione si distribuisce normalmente ( non è un problema se la

popolazione è grande, ma lo è se la popolazione è piccola)

PROCEDURA DI VERIFICA DI IPOTESI

(terza misura inferenziale, assieme alla stima puntuale e alla stima intervallare)

ipotesi: affermazione relativa a un fenomeno che può essere controllata empiricamente

verificare un’ipotesi significa controllare attraverso i dati di un campione la plausibilità

dell’ipotesi stessa (è sinonimo di testare)

le procedure di verifica prendono il nome di test di verifica di ipotesi

l’ipotesi di verifica che interessa il ricercatore prende il nome di H1 (è detta ipotesi di

ricerca o ipotesi alternativa); ma quella che verrà concretamente testata è l’ipotesi nulla,

detta H0 (ipotesi contraria a H1)

si va a valutare se H0 è compatibile o meno coi dati del campione; a tale fine viene

calcolata la statistica test. Si mira a verificare se H0 è incompatibile coi dati al fine di

rinforzare l’ipotesi del ricercatore

-

se H0 è compatibile coi dati => accettiamo H0

se H0 è incompatibile coi dati => rifiutiamo H0

si che H0 venga rifiutata o accettata non possiamo di re che la nostra ipotesi (H1) è vera,

dopo Popper il metodo scientifico ha adottato una logica falsificazionista. Per falsificare

un’affermazione è sufficiente un solo caso contrario.

Dal momento che lavoriamo su un campione della popolazione otterremo delle

affermazioni probabilistiche.

Per effettuare un Test di verifica di ipotesi occorre:

1. creare un SISTEMA DI IPOTESI ovvero espletare H0 e H1

{H0

H1

2. associare al sistema di ipotesi una STATISTICA TEST che permette di decidere se

accettare o meno H0

3. stabilisco il valore di α*

4. della statistica test dobbiamo conoscere la distribuzione campionaria => calcolo

della DISTRIBUZIONE CAMPIONARIA STANDARDIZZATA

5. andiamo a calcolare il valore della statistica test e lo posizioniamo in base alla sua

distribuzione campionaria => osservo se H0 è visino o meno al valore atteso

se ad esempio la nostra statistica test si distribuisce normalmente avremo una

distribuzione normale standardizzata => NOR (0,1)

assumendo H0 vero, osservo dove si posiziona il suo valore (calcolato con la statistica test);

se cade vicino al valore atteso della distribuzione (alla sua media quindi a 0), H0 è

compatibile con i dati, se invece cade lontano dal valore atteso H0 sarà incompatibile

*è necessario però decidere un valore di z soglia, che porta a decidere quando posso

accettare o rifiutare H0; tale valore viene deciso dal ricercatore e prende il nome di valore

soglia, o valore critico (se si tratta di una distribuzione normale avremo una z critico -> zc)

il valore di zc è scelto in base a α (= livello di significatività)

[1-α = livello di confidenza]

α -> probabilità di errore, corrisponde alla probabilità di osservare un valore si z in

modulo (senza segno ±) maggiore dello zc

α P( z > │zc│)

solitamente a α si associano valori pari a 0,05 o 0,01

per α= 0,05 => zc= ±1,96 (la probabilità di osservare una valore in modulo superiore a 1,96

è pari al 5%)

per α= 0,01 => zc= ±2,58 (la probabilità di osservare una valore in modulo superiore a 2,58

è pari al 1%)

dopo aver individuato la statistica test scelgo il valore di α per individuare il valore critico;

calcolo il valore sul campione e confronto il valore del campione (z) con il valore critico (z c)

se il valore del campione è superiore al valore critico => rifiuto H0

in base al valore di α individuiamo la regione della distribuzione campionaria che porta a

accettare o rifiutare l’ipotesi nulla

NB: se la statistica test si distribuisce come

una normale => zc

- una t di Student => tc

- una chi quadrato => Χ2c

i valori critici delle varie distribuzioni si ricavano dalle loro tavole

1° TEST DI VERIFICA DI IPOTESI

ipotesi:

{ H0 : μ=μ0

H1 : μ≠μ0

Dove μ0 costituisce un certo valore di riferimento (un numero)

Statistica test -> media campionaria ( )

standardizzata ->

dove μ corrisponde alla media delle medie e σ/√n corrisponde all’errore standard della

media

NB: la media standardizzata si distribuisce come una normale standardizzata

Vado poi a individuare i valori critici per α (calcolo lo zc) e poi calcolo il valore di

calcolato)

(-> z

Prendendo per vera l’ipotesi H0 vado a sostituire alla formula μ con μ0 (si tratta di un

numero reale)

In base al risultato valuto se accettare o meno H0

Se σ è ignoto allora lo devo stimare con => la media campionaria si distribuisce

come una t di Student (utilizziamo quindi anziché lo zc il tc

-----------------------------------------------------------------------------------------------------------------------Esempio

Per

= 107,3

Sx = 14

n= 47

{ H0 : μ=100

H1 : μ≠100

μ0= 100

si tratta di un’ipotesi bidirezionale -> i valori che possono portare a un rifiuto di H0

possono essere posizionati su entrambe le code della distribuzione (valori sia positivi

che negativi) => il valore critico viene individuato in corrispondenza di α/2

se si fosse trattata invece di un’ipotesi monodirezionale (μ>100 oppu21 μ<100) i valori

che possono portare a un rifiuto di H0 di trovano solo in una delle due code (in quella

positiva o negativa) => il valore critico viene individuato in corrispondenza di α

individuiamo la statistica test adatta => media standardizzata

dato che σ è ignoto lo stimiamo con

quando usiamo la distribuzione si distribuisce come una t di Student, ma quando la

numerosità del campione è maggiore di 30 approssima una normale

NB= H0 è sempre un’ipotesi semplice, che coinvolge un solo valore numerico, mentre

spesso H1 è un’ipotesi composta, che prevede un intervallo di valori

-μ

-μ

107,3 – 100

7,3

7,3

Zx = -------- = ------------- = ---------------- = --------- = ------ = 3,54

/ √n

S /√n-1

14/ √47-1

14 √46

2,06

dal momento che tra i dati non abbiamo la varianza corretta (

della varianza non corretta

) utilizziamo la formula

Assunto -> quello che testiamo (ad esempio l’intelligenza) si distribuisce normalmente=>

vale la stessa distinzione che vale per la stima intervallare

α = probabilità di errore, di rifiutare un’ipotesi vera

ma si può commettere un altro tipo di errore, ovvero accettare un’ipotesi alternativa falsa.

Questo tipo di errore è detto di secondo tipo (β)

Vera

H0

Falsa

H0

Accettarla

OK

NO

(errore β)

Rifiutarla

NO

(errore α)

OK

α e β stanno in relazione inversa tra loro => α tra 0,5 e 0,1 permette di avere un β

accettabile

α viene scelto dal ricercatore

β non viene scelto dal ricercatore

2° TEST DI VERIFICA DI IPOTESI (confronto tra due popolazioni)

date due popolazioni andiamo a confrontare le loro medie

NB: lavorando con campioni delle popolazioni le loro due medie ( ) posso avere valori

diversi, anche se le medie delle due popolazioni (μ) sono uguali = si tratta di fluttuazioni

del campione

[differenza tra tre o più medie -> Analisi della varianza : ANOVA]

TEST DELLA DIFFERENZA TRA DUE MEDIE PER CAMPIONI DIPENDENTI

I due campioni sono tra loro dipendenti, ad esempio misuriamo una variabile in due

tempio diversi (t0 e t1)

Se le due medie sono uguali, allora la media delle differenze tra le sue risposte in ogni

soggetto della popolazione sarà pari a 0. se indichiamo questo parametro con il simbolo

μD, l’ipotesi nulla sarà μD=0.

Per verificare che vi sia una differenze significativa tra le medie sarà quindi sufficiente

confrontare

D,

la media delle differenze riscontrata nel campione con μD.

si applica quindi lo stesso procedimento visto nel test della media per una popolazione

TEST DELLA DIFFERENZA TRA DUE MEDIE PER CAMPIONI INDIPENDENTI

I campioni sono selezionati come se si trattasse di estrarre delle palline da due urne => i

campioni tra loro sono indipendenti (campionamento CSR)

Diamo per assunto il fatto che il fenomeno si distribuisca normalmente in entrambe le

popolazioni

POP1 NOR (μ1 ,σ21)

POP2 NOR (μ2 ,σ22)

-> media e varianza delle due popolazioni normali standardizzate

n1 n2 -> numerosità dei due campioni

(

1,

S 21) ; (

2,

S22) -> media e varianza dei due campioni

ipotesi di ricerca:

{ H1 : μ1 ≠ μ2 ->nelle due pop. le medie sono diverse; ipotesi composta da infiniti valori

H0 : μ1 = μ2 -> è un’ipotesi semplice, un solo valore

{ H1 : μ1 ≠ μ2 μ1 - μ2 ≠ 0

H0 : μ1 = μ2 μ1 - μ2 = 0

Se i due valori devono solo essere diversi (μ1 - μ2 ≠ 0 ) allora parliamo di ipotesi

bidirezionale; se invece l’ipotesi era formulata diversamente ( μ1 < μ2 o μ1 > μ2 ) si

trattava di un’ipotesi monodirezinale

All’ipotesi di ricerca è associata una statistica test => differenza tra le medie campionarie

1- 2

Differenza tra due medie in termini di variabile aleatoria

E( ) = μ

VAR ( ) = σ2x = σ2/n

Se la POP1 è normale => (μ1 ,σ21)

Se la POP2 è normale => (μ2 ,σ22)

anche la v.a 1 NOR (μX1-X2 , σ2X1-X2)

μX1-X2 = E (

1-

2)

2

si distribuisce normalmente e i suoi parametri sono:

= μ1 – μ2

σ2X1-X2 = σ21/n1 + σ22/n2

σX1-X2 = √(σ21/n1 + σ22/n2 )

il valore atteso della differenza tra

due medie è uguale alla

differenza tra le medie della

popolazione

la varianza della differenza tra

medie è uguale alla somma delle

varianze delle due medie

anche la differenza tra medie può essere calcolata con una stima puntuale o una

intervallare

statistica test (con rispettiva distribuzione campionaria) =>

normale standardizzata

1-

2

( 1- 2) – (μ1 - μ2)

------------------------√(σ21/n1 + σ22/n2 )

NB: se non si conosce μ difficilmente si conosce σ => è necessario stimare σ

OMOSCEDASTICITA’ e ETEROSCHEDASTICITA’

Gli σ delle due popolazioni possono essere tra loro

uguali (σ1 = σ2), in questi casi si parla di omoschedasticità

se invece σ1 ≠ σ2 si parla di eteroschedasticità

in base a questo cambia il modo di stimare σ

se σ1 = σ2 = σ viene stimata un’unica quantità

se σ1 ≠ σ2 i due omega vanno stimati separatamente

ETEROSCHEDASTICITA’

Ciascun σ verrà stimato con la sua stima campionaria

Se σ1 ≠ σ2

˄

˄

2

σ 1 = S21 varianza corretta del primo campione

˄

˄

σ22 = S22 varianza corretta del secondo campione

si procede poi come in tutti i test di verifica di ipotesi => scegliamo il valore di α

se α=0,01= valc

si individua sulla distribuzione campionaria della statistica i valori critici della statistica che

porta a accettare o rifiutare H0

calcolo il valore della statistica test sui dati campionari e lo confronto col valc

se il modulo del valore calcolato (val) è minore del modulo del valc (più vicino al suo valore

atteso) => accettiamo H0

│val │< │valc│ => accettiamo H0

│val │> │valc│=> rifiutiamo H0

NB: α costituisce la probabilità di commettere un errore del I tipo

Test a 1 coda

α -> ricavata dalla distribuzione di H0

β -> ricavata dalla distribuzione di uno dei tantissimi valori possibili di H1

Esempio:

G1 attaccamento sicuro

n1 = 72

G2 attaccamento non sicuro

n2 = 83

1

= 5,55

2

= 3,80

1

= 2,23

2

= 2,47

N= 155

La differenza tra le due medie campionarie è dovuta al caso o è dovuta a una differenza

sistematica tra le due popolazioni?

{H0 μ1 = μ2

H1 μ1 > μ2

μ1 - μ2 = 0

μ1 - μ2 > 0

α = 0,01

utilizzando la tavola della distribuzione normale (campione >30) ricaviamo il valore dello Z c

trattandosi di un’ipotesi monodirezionale α si distribuisce solo su una delle due code

dal momento che le tavole riportano i valori per metà della distribuzione campionaria (0,5)

sottraiamo a 0,5 il valore di α (0,01) e ricaviamo il valore di zc = 2,33

( 1- 2) – (μ1 - μ2)

Z = ------------------------√(σ21/n1 + σ22/n2 )

(5,55- 3,80) – 0*

Z = ----------------------------√ (2,232/72 + 2,472/83)

Z = 175/ 0,38 = 4,63

* se H0 è vera allora μ1 - μ2 = 0

dal momento che il valore di zc è 2,33

Z > Zc => rifiutiamo H0

valori inferiori allo zc avrebbero portato all’accettazione di H0

con un livello di significatività dell’1% la differenza tra le due medie è risultata

statisticamente significativa

OMOSCHEDASTICITA’

Vogliamo testare l’ipotesi nulla a proposito delle varianze incognite 12 e 22 di due popolazioni

normali.

Disponendo di due campioni indipendenti di dimensione n1 e n2 , con varianze stimate s12 e s22 ,

vogliamo verificare, al livello di significatività , l’ipotesi nulla H 0 : 12 22 omoschedasticità

H1 : 12 22

H1 : 12 22

H1 : 12 22 .

contro le ipotesi alternative

Se l’ipotesi nulla è vera (le varianze delle due popolazioni sono uguali) il rapporto tra le due stime

2

e 22 (varianze corrette del campione) dovrebbe assumere un valore non eccessivamente

distante da 1.

1

Se l’ipotesi nulla di uguaglianza fra varianze è vera, il rapporto tre le due stime ( F= 21 / 22 ) è

distribuito secondo una funzione nota come v.a. F di Fisher-Snedecor con n1 1 e n2 1 gradi di

libertà.

La statistica da utilizzare per il test è

F

in cui supponiamo per convenzione S12 S 22

S12

S 22

(*)

per comodità il rapporto viene sempre fatto ponendo al numeratore la varianza più grande

Questo perché le due variabili

2

2

(n1 1) S1

( n2 1) S 2

e

si distribuiscono come due v.a. chi quadrato con n1 1 e n2 1 gradi di

12

22

libertà.

Se quindi rapportiamo le variabili ai loro rispettivi gradi di libertà otteniamo

F

(n1 1) S12 /( n1 1) 12 S12 22

=

(n2 1) S 22 /( n2 1) 22 S 22 12

che è la (*) se l’ipotesi nulla di omoschedasticità è vera.

Si tratterà allora di individuare quei valori di F che lasciano alle code della distribuzione i valori che

complessivamente hanno una probabilità α di verificarsi.

A seconda che l’ipotesi alternativa sia uni o bidirezionale s farà riferimento a un livello di

significatività pari a α o α/2