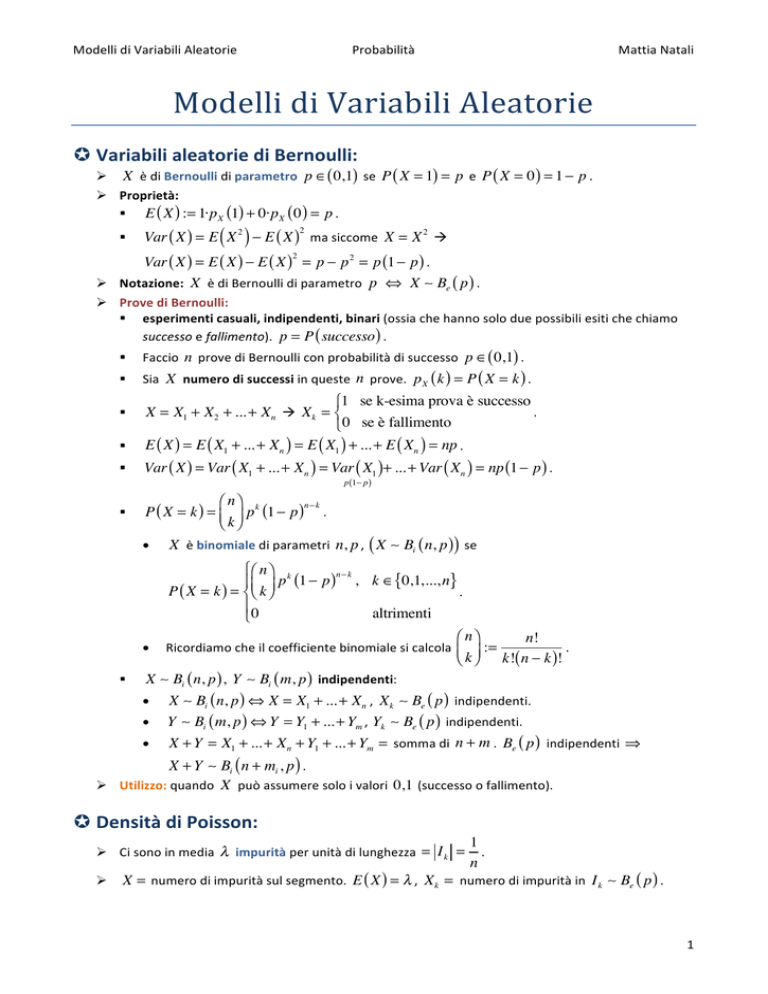

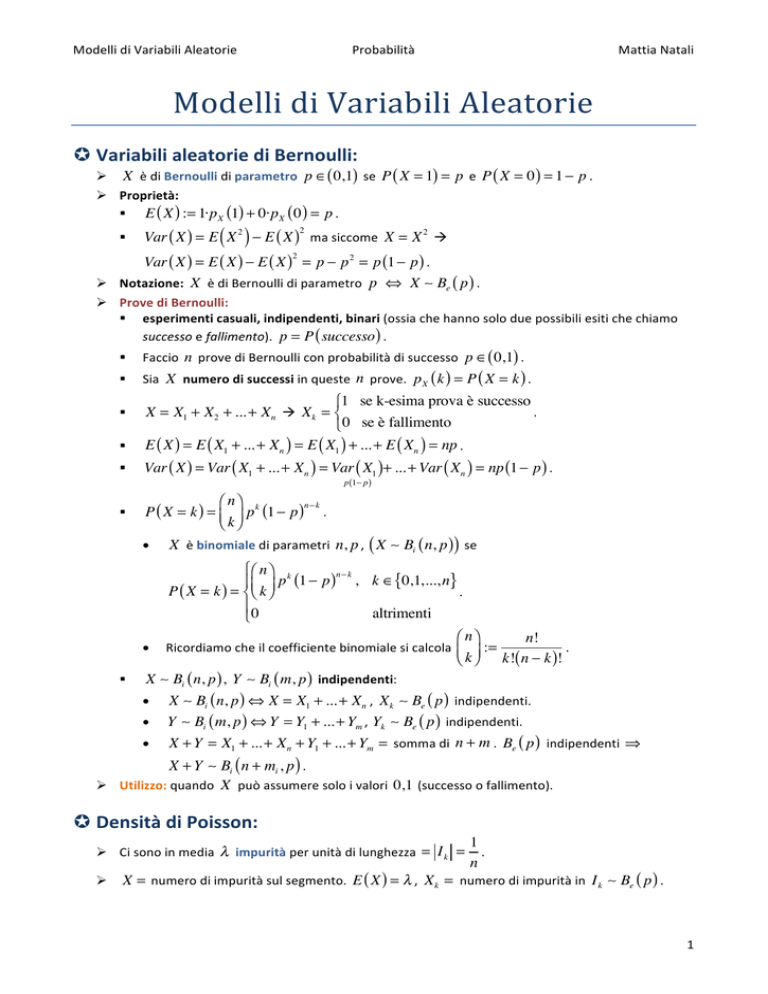

Modelli di Variabili Aleatorie Probabilità Mattia Natali Modelli di Variabili Aleatorie µ Variabili aleatorie di Bernoulli: Ø X è di Bernoulli di parametro p ∈( 0,1) se P ( X = 1) = p e P ( X = 0 ) = 1 − p . Ø Proprietà: § E ( X ) := 1·p X (1) + 0·p X ( 0 ) = p . §

( )

Var ( X ) = E X 2 − E ( X ) ma siccome X = X 2 à 2

Var ( X ) = E ( X ) − E ( X ) = p − p 2 = p (1 − p ) . Ø Notazione: X è di Bernoulli di parametro p ⇔ X Be ( p ) . 2

Ø Prove di Bernoulli: § esperimenti casuali, indipendenti, binari (ossia che hanno solo due possibili esiti che chiamo successo e fallimento). p = P ( successo ) . §

§

§

§

Faccio n prove di Bernoulli con probabilità di successo p ∈( 0,1) . Sia X numero di successi in queste n prove. p X ( k ) = P ( X = k ) . ⎧1 se k-esima prova è successo

. X = X1 + X2 + ... + Xn à X k = ⎨

⎩0 se è fallimento

E ( X ) = E ( X1 + ... + Xn ) = E ( X1 ) + ... + E ( Xn ) = np . §

Var ( X ) = Var ( X1 + ... + Xn ) = Var ( X1 )+ ... + Var ( Xn ) = np (1 − p ) . §

⎛ n⎞

n− k

P ( X = k ) = ⎜ ⎟ p k (1 − p ) . ⎝ k⎠

p (1− p )

X è binomiale di parametri n, p , ( X Bi ( n, p )) se •

•

§

X

•

•

•

⎧⎛ n ⎞ k

n− k

⎪⎜ ⎟ p (1 − p ) , k ∈{0,1,..., n}

P ( X = k ) = ⎨⎝ k ⎠

. ⎪0

altrimenti

⎩

⎛ n⎞

n!

Ricordiamo che il coefficiente binomiale si calcola ⎜ ⎟ :=

. ⎝ k ⎠ k!( n − k )!

Bi ( n, p ) , Y Bi ( m, p ) indipendenti: X Bi ( n, p ) ⇔ X = X1 + ... + Xn , X k Be ( p ) indipendenti. Y Bi ( m, p ) ⇔ Y = Y1 + ... + Ym , Yk Be ( p ) indipendenti. X + Y = X1 + ... + Xn + Y1 + ... + Ym = somma di n + m . Be ( p ) indipendenti ⇒ X + Y Bi ( n + mi , p ) . Ø Utilizzo: quando X può assumere solo i valori 0,1 (successo o fallimento). µ Densità di Poisson: Ø Ci sono in media λ impurità per unità di lunghezza = I k =

Ø

1

. n

X = numero di impurità sul segmento. E ( X ) = λ , X k = numero di impurità in I k Be ( p ) . 1 Modelli di Variabili Aleatorie Probabilità Mattia Natali Ø

⎛ λ⎞

X = X1 + ... + Xn , E ( X ) = E ( X1 ) + ... + E ( Xn ) = np . X Bi ⎜ n, ⎟ . ⎝ n⎠

Ø

⎛ n⎞ ⎛ λ ⎞ ⎛

λ⎞

P ( X = k ) = ⎜ ⎟ ⎜ ⎟ ⎜1 − ⎟

⎝ k⎠ ⎝ n ⎠ ⎝

n⎠

k

n− k

n!

λk ⎛

λ⎞ ⎛

λ⎞

1 − ⎟ ⎜1 − ⎟

k ⎜

k!( n − k )! n ⎝

n⎠ ⎝

n⎠

n

=

con n→+∞

=e − λ

n ( n − 1) ...( n − k + 1) ⎛

λ⎞

=

⎜⎝ 1 − ⎟⎠

k

n

n

→1

−k

→1

−k

= 1

λk ⎛ λ ⎞

λ k −λ

e . ⎜ 1 − ⎟⎠ →

k! ⎝

n

k!

n

Ø Definizione: X è una variabile aleatoria di Poisson di parametro λ > 0 se ⎧ λ k −λ

⎪ e , k ∈{0,1, 2,...}

P ( X = k ) = ⎨ k!

. ⎪0

altrimenti

⎩

Ø Legge del filo: § La variabile aleatoria di Poisson può essere utilizzata come approssimazione di una binomiale ⎧n 1 prove di Bernoulli

. ⎩p 1 probabilità di successo

di parametri ( n, p ) quando ⎨

⎛ λ⎞

Poisson ( λ ) ≅ Bi ⎜ n, ⎟ = Bi ( n, p ) ≅ Poisson ( np ) . ⎝ n⎠

§

Ø Proprietà: § X Po(λ ) ⇒ E ( X ) = Var ( X ) = λ . X Po ( λ ) ,Y Po ( µ ) ⇒ X + Y Po ( λ + µ ) . §

Ø Utilizzo: è un’ottima approssimazione di una binomiale di parametri ( n, p ) , quando n è molto grande e p molto piccolo ponendo λ = np . In altri termini, il totale dei “successi” in un gran numero n di ripetizioni indipendenti di un esperimento che ha una piccola probabilità di riuscita p

, è una variabile aleatoria con distribuzione approssimativamente di Poisson, con media λ = np . µ Variabile aleatoria Geometrica: Ø Successione di prove di Bernoulli con p = P ( successo ) e X = numero di prove necessarie per vedere il primo successo. § P ( X = k ) con k ∈{1, 2,...} . •

P ( X = 1) = P ( I prova = "successo") = p . •

⎛ I prova = "insuccesso"⎞

P ( X = 2) = P ⎜

= p (1 − p ) . ⎝ II prova = "succeso" ⎟⎠

P ( X = k ) = p (1 − p )

k − 1 insuccessi. •

k −1

perché prima del successo della k -­‐esima prova ci sono stati ⎧⎪ p (1 − p )k −1

Ø Definizione: X Geom ( p ) se P ( X = k ) = ⎨

0

⎪⎩

Ø 1 =

+∞

∑ P ( X = k ) = ∑ p (1 − p )

k =1

k

+∞

à k −1

k ∈{1, 2,...}

. altrimenti

, sia q := 1 − p ⇔ p = 1 − q con 0 < q < 1 à +∞

∑q

k =1

k −1

=

1

1− q

1

∑ q = 1 − q . k=0

2 Modelli di Variabili Aleatorie Probabilità +∞

tX

tk

Ø m X ( t ) = E ⎡⎣ e ⎤⎦ = ∑ e (1 − p )

⇔ t < − ln (1 − p ) Ø

Ø

Ø

k −1

i =1

+∞

p = ∑e

t ( k −1)

k=0

(1 − p )

Mattia Natali k

p = pe

+∞

t

∑ ⎡⎣ e (1 − p )⎤⎦

t

k =1

k

= et (1 − p ) < 1

q

+∞

k

p

p

pet ∑ ⎡⎣ et (1 − p ) ⎤⎦ = pet

= −t

. Perché è una serie geometrica. t

1 − e (1 − p ) e − (1 − p )

k =1

q

m X ( 0 ) = 1 . m′X ( t ) =

§

( )

p e−t

⎡⎣ e−t − (1 − p ) ⎤⎦

1

m′X ( 0 ) = = E ( X ) . p

2

= mX (t )

e−t

1

= mX (t )

. −t

t

e − (1 − p )

1 − e (1 − p )

⎡⎣1 − et (1 − p ) ⎤⎦ − ⎡⎣ −et (1 − p ) ⎤⎦

Ø m ′′X ( t ) = m ′X ( t )

. 2

⎡⎣1 − et (1 − p ) ⎤⎦

1

p +1− p

2− p

p

=

= E X 2 . § m ′′X ( 0 ) =

2

2

p

p

2 − p 1 1− p 1 1

2

2

− 2 = 2 = 2 − . § Var ( X ) = E X − E ( X ) =

p2

p

p

p

p

( )

( )

Ø

X Geom ( p ) , P ( X > k ) = P ( le prime k prove sono insuccessi) = (1 − p ) ...(1 − p ) = (1 − p ) k

k volte

⇒ P ( X ≤ k ) = 1 − (1 − p ) . k

Ø Proprietà di assenza di memoria: § P ( X > k + h | X > h ) = P ( X > k ) . §

Dimostrazione: •

P ( X > k + h | X > h) =

P ( X > k + h & X > h ) P ( X > k + h ) (1 − p )

=

=

= P ( X > h)

P ( X > h)

(1 − p )h

k+h

= (1 − p ) = P ( X > k ) . k

§

P ( a < X ≤ b | X > h ) = P ( a − h < X ≤ b − h ) . Ø Utilizzo: è utile quando vogliamo sapere la probabilità che la k -­‐esima ripetizione sia il primo successo. µ Variabile aleatoria ipergeometrica: Ø Definizione: una variabile aleatoria X si dice ipergeometrica di parametri N, M e n se ha massa ⎛ N⎞ ⎛ M ⎞

⎜⎝ i ⎟⎠ ⎜⎝ n − i ⎟⎠

di probabilità P ( X = i ) =

con i = 0,1,..., n . ⎛N + M⎞

⎜⎝ n

⎟⎠

Ø Utilizzo: possiamo capirlo tramite un esempio. Una scatola contiene N batterie accettabili e M difettose. Si estraggono senza rimessa e in maniera casuale n batterie. Denotiamo con X il numero di batterie accettabili contenute nel campione estratto. 3 Modelli di Variabili Aleatorie Probabilità Mattia Natali µ Variabili aleatoria uniforme: Ø Se noi prendessimo un segmento lungo 1 e un intervallo che va da a a b ivi contenuto, se x è scelto casuale significa che la probabilità che x ∈[ a,b ] dipende soltanto dalla lunghezza del segmento e non dalla sua posizione. ⎧⎪ 1

Ø L’insieme U è uniforme in [ 0,1] se la sua densità è fU ( u ) := ⎨

§

§

§

u ∈[ 0,1]

⎪⎩ 0 altrimenti

P (U ∈[ u,u + du ]) = du con u ∈[ 0,1] . . P ( a < U ≤ b ) = b − a . 0 < a < b < 1 P ( a + h < U ≤ b + h ) = b − a con 0 < a + h < b + h < 1 . Ø Definizione generale: una variabile aleatoria continua si dice uniforme sull’intervallo [α , β ] , se ha ⎧ 1

se α ≤ x ≤ β

⎪

funzione di densità data da f ( x ) = ⎨ β − α

. ⎪ 0

altrimenti

⎩

Ø U U [ 0,1] . I passi successivi quindi sono riferiti ad un intervallo ampio 1 . §

§

§

Ø

Ø

Ø

Ø

Ø

Ø

Ø

E (U ) =

∫

+∞

−∞

( ) ∫

E U2 =

uf ( u ) du =

+∞

−∞

∫

1

0

u 2 f ( u ) du =

U U [ 0,1] , FU ( u ) =

∫

+∞

−∞

u du =

∫

1

0

u2

2

u 2 du =

=

0,1

u3

3

1

. 2

=

0,1

1

1 1 4−3 1

⇒ Var (U ) = − =

=

. 3

3 4

12

12

⎧ 0 x<0

⎪

fU ( x ) dx = ⎨ x 0 ≤ x < 1 . ⎪ 1 x ≥1

⎩

(b − a )U + a = X con b > a . § U = 1 à ( b − a )1 + a = b . § U = 0 à ( b − a ) 0 + a = a . X ~ U [ a,b ] , X = ( b − a )U + a , U ~ U [ 0,1] . b−a

a+b

+a=

. 2

2

2

b − a)

(

2

Var ( X ) = Var ⎡⎣( b − a )U + a ⎤⎦ = ( b − a ) Var (U ) =

. 12

x − a⎞

⎛

⎛ x − a⎞

FX ( x ) = P ( X ≤ x ) = P (( b − a ) ,U + a ≤ x ) = P ⎜ U ≤

= FU ⎜

. ⎟

⎝

⎝ b − a ⎟⎠

b − a⎠

d

⎛ x − a⎞

⎛ x − a⎞ 1

⎛ x − a⎞ 1

FX′ ( x ) =

FU ⎜

= FU′ ⎜

= fU ⎜

. ⎟

⎟

⎝ b − a⎠ b − a

⎝ b − a ⎟⎠ b − a

dx ⎝ b − a ⎠

⎧ 1

x−a

0<

<1

⎪

fX ( x ) = ⎨ b − a

. b−a

⎪ 0

altrimenti

⎩

x−a

< 1 ⇔ 0 < x − a < b − a ⇔ a < x < b . § 0 <

b−a

E ( X ) = E ⎡⎣( b − a )U + a ⎤⎦ = ( b − a ) E (U ) + a =

4 Modelli di Variabili Aleatorie Ø

Probabilità ⎧

⎪

⎪

=⎨

⎪

⎪

⎩

⎛ x − a⎞

FX ( x ) = FU ⎜

⎝ b − a ⎟⎠

Mattia Natali x<a

x−a

0<

< 1 ⇔ a < x < b . b−a

x≥b

0

x−a

b−a

1

Ø Utilizzo: quando la variabile aleatoria ha le stesse probabilità di cadere vicino a un qualunque punto dell’intervallo. µ Variabili aleatorie normali o gaussiane: 2

1 − z2

e . 2π

Ø Definizione: z è normale standard se la sua densità fZ ( z ) :=

§

∫

+∞

−∞

fZ ( z ) dz = 1 ⇔ 2π =

∫

+∞

−∞

e

−

z2

2

dz . 2

§

§

Ø

1 − s2

∫−∞ 2π e ds := Φ ( z ) := P ( Z ≤ z ) . Φ ( −z ) = 1 − Φ ( z ) . z

mZ ( t ) = E ⎡⎣ e ⎤⎦ =

tZ

∫

+∞

−∞

2

e

1 − z2

e dz =

2π

tZ

sostituisco u = z − t , du = dz à m ( z ) = e

§

§

§

1

2π

∫

t2

2

1

2π

mZ ( 0 ) = 1 . +∞

−∞

e

∫

−

(

)

1 2

t2

z − 2tz +t 2 +

2

2

+∞

−∞

e

−

u2

2

2

dz =

1 t2

e

2π

∫

+∞

−∞

e

−

( z −t )2

2

dz

t2

2

du = e . =1

t2

2

mZ′ ( t ) = te = tmZ ( t ) . • mZ′ ( 0 ) = 0 . mZ′′ ( t ) = mZ ( t ) + tmZ′ ( t ) . ( )

mZ′′ ( 0 ) = mZ ( 0 ) + 0 = 1 ⇒ E ( Z ) = 0 , E Z 2 = 1 = Var ( Z ) . •

Ø Definizione: X variabile aleatoria con E ( X ) = 0 , Var ( X ) = 1 ⇒ X è standard. Ø Definizione: X variabile aleatoria è normale se: X = aZ + b , a > 0 , b ∈ , Z è normale standard. Se Z è normale standard ⇔ −Z è normale standard. (

(

Ø Def: X è normale con media µ e varianza σ 2 X ~ N µ, σ

standard Z ~ N ( 0,1) . Ø

(

)) se X = σ Z + µ , Z normale X ~ N µ, σ 2 , Y = α X + β ∈N (, ) con a ≠ 0 . (

) ⇔ X = σ Z + µ , Z ~ N ( 0,1)

§

Dimostrazione: X ~ N µ, σ

§

⇒ Y = α X + β = α (σ Z + µ ) + β = (ασ ) Z + αµ + β . E (Y ) = E (α X + β ) = α E ( X ) + β = αµ + β . §

Ø

)

2

2

Var (Y ) = Var (α X + β ) = α 2Var ( X ) . (

)

X ~ N µ, σ 2 , calcoliamo la funzione di ripartizione e densità. 5 Modelli di Variabili Aleatorie §

Probabilità Mattia Natali ⎛

Con X = σ Z + µ , FX ( x ) = P ( X ≤ x ) = P (σ Z + µ ≤ x ) = P ⎜ Z ≤

⎝

x − µ⎞

⎛ x − µ⎞

⎟⎠ = Φ ⎜⎝

⎟ à σ

σ ⎠

⎛ x − µ⎞

FX = Φ ⎜

. ⎝ σ ⎟⎠

§

§

P ( a < X < b ) = FX ( b ) − FX ( a ) per le variabili aleatorie continue. ⎛ b − µ⎞

⎛ a − µ⎞

P (a < X < b) = Φ ⎜

− Φ⎜

. ⎟

⎝ σ ⎠

⎝ σ ⎟⎠

d ⎛ x − µ⎞

⎛ x − µ⎞ 1

⎛ x − µ⎞ 1

f X ( x ) = FX′ ( x ) = Φ ⎜

= Φ′ ⎜

= fZ ⎜

=

⎟

⎟

⎝ σ ⎠σ

⎝ σ ⎟⎠ σ

dx ⎝ σ ⎠

1

=

2πσ 2

e

⎡ ( x − µ )2 ⎤

⎢−

⎥

⎢⎣ 2 σ 2 ⎥⎦

⎡ 1 ⎛ x−µ⎞2 ⎤

⎟ ⎥

σ ⎠ ⎥⎦

1 ⎢⎢⎣− 2 ⎜⎝

e

2π

1

=

σ

. X−µ

~ N ( 0,1) . σ

µ⎞ 1

⎛ X − µ⎞ E(X) − µ

⎛ X − µ⎞

⎛1

=

= 0 , Var ⎜

= V − ⎜ X − ⎟ = 2 Var ( X ) = 1 . § E ⎜

⎟

⎟

⎝ σ ⎠

⎝ σ ⎠

⎝σ

σ

σ⎠ σ

Ø Teorema: X1 , X 2 ,..., X n normali indipendenti ⇒ X1 + ... + X n è normale. Ø

(

)

X ~ N µ, σ 2 , §

(

Dimostrazione: X ~ N µ, σ

X = σ Z + µ , Z ~ N ( 0,1) . 2

) . m (t ) = E ( e ) ma siccome è normale sappiamo che ∃ tX

X

m X ( t ) = E ⎡⎣ et (σ Z + µ ) ⎤⎦ = E ⎡⎣ e(tσ ) Z et µ ⎤⎦ = et µ E ⎡⎢ e(tσ ) z ⎤⎥ = et µ mZ ( tσ ) = et µ e

⎣

⎦

t′

mX = e

•

⎡ t 2σ 2

⎤

+t µ ⎥

⎢

⎢⎣ 2

⎦⎥

( t σ )2

2

=e

⎡ t 2σ 2

⎤

+t µ ⎥

⎢

⎢⎣ 2

⎦⎥

à . ⎧ t 2σ 12

⎫

⎧ t 2σ 2n

⎫

m X1 +...+ Xn = m X1 ( t ) ...m Xn ( t ) = exp ⎨

+ t µ1 ⎬ ...exp ⎨

+ t µn ⎬ =

⎩ 2

⎭

⎩ 2

⎭

⎧ 2 n

⎫

n

⎧ n ⎛ t 2σ 2k

⎞⎫

⎧t2

⎫

⎪t

⎪

2

2

exp ⎨∑ ⎜

+ t µ k ⎟ ⎬ = exp ⎨ ∑ σ k + t ∑ µ k ⎬ = exp ⎨ (σ ′ ) + t µ ′ ⎬

⎠ ⎪⎭

⎪⎩ k =1 ⎝ 2

k =1

⎩2

⎭

⎪ 2 k =1 2

⎪

µ'

(σ ′ )

⎩

⎭

n

⎛ n

⎞

⇒ X1 + ... + Xn ~ N ⎜ ∑ µ k , ∑ σ 2k ⎟ . ⎝ k =1

⎠

k =1

Ø Utilizzo: questo tipo di variabile aleatoria è molto importante e utilizzata grazie al teorema del limite centrale che tratterremo più avanti. µ Esponenziali: (

)

⎧λ e− λ x x > 0

. 0

altrimenti

⎩

Ø Def: X è esponenziale di parametro λ > 0 X ~ € ( λ ) se f X ( x ) = ⎨

x<0

⎧⎪0

Ø FX ( x ) = ∫ f X ( s ) ds = ⎨ x − λ s

. − λs x

−λx

−∞

x≥0

⎪⎩ ∫0 λ e ds = ⎡⎣ −e ⎤⎦ 0 = 1 − e

x

6 Modelli di Variabili Aleatorie Probabilità Mattia Natali Ø Funzione generatrice dei momenti: ( )= ∫

mX (t ) = E e

=

tX

+∞

−∞

e f X ( x ) dx =

tx

+∞

λ

( λ − t ) e− (λ −t ) x dx . ∫

0

λ

−

t

(

)

∫

+∞

0

e λe

tx

−λx

+∞

ds = λ ∫ e

λ'

− ( λ −t ) x

0

dx con λ > t à =1

λ

mX (t ) =

. λ−t

1

− λ ( −1)

λ

à m ′X ( 0 ) = = E ( X ) . m 'X (t ) =

2 =

2

λ

(λ − t ) (λ − t )

2λ 2

− λ ( λ − t ) ( −1)

2λ

2

à m ′′X ( 0 ) = 3 = 2 = E ( X ) . m′′X ( t ) =

=

4

3

λ

λ

(λ − t )

(λ − t )

2

1

1

Var ( X ) = 2 − 2 = 2 . λ

λ

λ

§

§

§

§

Ø Assenza di memoria: § X ~ € ( λ ) ⇒ P ( X > t + s | X > t ) = P ( X > s ) . Dimostrazione: P ( X > t + s | X > t ) =

§

=

P ( X > t + s & X > t ) P ( X > t + s)

=

=

P(X > t)

P(X > t)

1 − FX ( t + s ) e− λ (t + s )

= − λt = e− λ s = P ( X > s ) , ricorda che 1 − FX ( t )

e

P ( X > z ) = e− λ x ⇒ FX ( x ) = 1 − e− λ x . ⎛ λ⎞

Ø cX ~ € ⎜ ⎟ . ⎝ c⎠

µ Variabili aleatorie di tipo Γ : ⎧ λ α α −1 − λ x

x e

⎪

Ø Definizione: X è Γ (α , λ ) se f X ( X ) = ⎨ Γ (α )

⎪0

⎩

x>0

. altrimenti

Ø Nota: Γ (α ) serve a far sì che la densità faccia uno in ( −∞, +∞ ) : ∫

+∞

−∞

f X ( x ) dx = 1 =

+∞

λ α +∞ α −1 − λ x

x e dx ⇒ Γ (α ) = λ α ∫ xα −1e− λ x dx facciamo il cambiamento ∫

0

Γ (α ) 0

di variabili y = λ x , dy = λ dx à λ

Ø

Γ (α ) :=

∫

+∞

0

∫

+∞

0

⎛ y⎞

⎜⎝ ⎟⎠

λ

∫

+∞

0

Osservazione: Γ (1, λ ) = € ( λ ) . §

Per mezzo dell’integrazione per parti:

+∞

∫

= ( a − 1) ∫

0

+∞

yα −1e− y dy = −e− y yα −1 0 + ∫

+∞

0

+∞

0

§

dy λ α

e

=

λ λα

−y

∫

+∞

0

yα −1e− y dy = Γ (α ) . e− x dx = 1 . §

Γ (α ) =

α −1

xα −1e− x dx . Ø Gamma di Eulero: Γ (1) =

α

(α − 1) y(α −1)−1e− y dy =

y(α −1) −1e− y dy = (α − 1) Γ (α − 1) à Γ (α ) = (α − 1) Γ (α − 1) . Γ ( n ) = ( n − 1) Γ ( n − 1) = ( n − 1) ( n − 2 ) Γ ( n − 2 ) ....Γ (1) = ( n − 1)! . 7 Modelli di Variabili Aleatorie Ø

Probabilità Mattia Natali X ~ Γ ( a, λ ) . Funzione generatrice dei momenti: §

λ α +∞ α −1 − λ x tx

λ α +∞ α −1 − ( λ −t ) x

λ α ( λ − t ) +∞ α −1 − ( λ −t )

x

e

e

dx

=

x

e

dx

=

x e

dx =

0

Γ (α ) ∫0

Γ (α ) ∫0

(α ) ∫

( λ − t )α Γ

α

( )

E etX =

=1

=

α

λ

. ( λ − t )α

α

§

⎛ λ ⎞

mX (t ) = ⎜

. ⎝ λ − t ⎟⎠

•

⎛ λ ⎞

m′X ( t ) = α ⎜

⎝ λ − t ⎟⎠

α −1

⎡ − λ ( −1) ⎤

α

αλ α

. ⎢

2 ⎥ =

α +1 à m ′X ( 0 ) =

λ

⎢⎣ ( λ − t ) ⎥⎦ ( λ − t )

αλ α (α + 1) ( λ − t ) (1)

α (α + 1)

• m ′′X ( t ) = −

à m ′′X ( 0 ) =

. 2α + 2

λ2

(λ − t )

α

§ E ( X ) = ; λ

α (α + 1)

§ E ( X 2 ) =

; λ2

α (α + 1) α 2 α

− 2 = 2 . § Var ( X ) =

λ2

λ

λ

Ø Proprietà: X ~ Γ (α , λ ) ,Y ~ Γ ( β , λ ) indipendenti ⇒ X + Y ~ Γ (α + β , λ ) . α

α

§

§

β

⎛ λ ⎞ ⎛ λ ⎞

⎛ λ ⎞

=⎜

Dimostrazione: m X +Y ( t ) = m X ( t ) mY ( t ) = ⎜

⎟

⎜

⎟

⎝ λ −t⎠ ⎝ λ −t⎠

⎝ λ − t ⎟⎠

⇒ X + Y ~ Γ (α + β , λ ) . α +β

Utilità: • Capire X,Y ~ € ( λ ) indipendenti. X ~ € ( λ ) = Γ (1, λ )

à X + Y ~ Γ ( 2, λ ) . Y ~ € ( λ ) = Γ (1, λ )

♦ In generale: X1 ,..., X n ~ € ( λ ) à X1 + X 2 + ... + X n ~ Γ ( n, λ ) . ♦

µ Distribuzioni Chi-­‐quadro: Ø

⎛ n 1⎞

Z12 + ... + Z n2 ~ Γ ⎜ , ⎟ = χ 2 ( n ) chi-­‐quadro con n gradi di libertà. ⎝ 2 2⎠

§

§

§

⎛ n 1⎞

X ~ χ 2 ( n ) ⇔ X ~ Γ ⎜ , ⎟ . ⎝ 2 2⎠

n

E [ X ] = 2 = n . 1

2

n

Var ( X ) = 2 2 = 2n . ⎛ 1⎞

⎜⎝ ⎟⎠

2

8 Modelli di Variabili Aleatorie Probabilità n

x

−1 −

⎧1

1

2

2

x

e

⎪ n

⎪

⎛ n⎞

X ~ χ 2 ( n ) , f X ( x ) = ⎨ 2 2 Γ ⎜ ⎟

⎝ 2⎠

⎪

⎪⎩0

X ~ χ 2 ( n ) ,Y ~ χ 2 ( m ) indipendenti à §

§

Mattia Natali x>0

. altrimenti

X + Y = X12 + ... + Xn2 + Y 12 + ... + Ym2 ⇒ X + Y ~ χ 2 ( n + m ) . Ø Se X è una chi-­‐quadro con n gradi di libertà e α è un reale compreso tra 0 e 1 , si definisce la 2

2

quantità χ α ,n tramite l’equazione seguente: P ( X ≥ χ α ,n ) = α . µ Distribuzioni t: Ø Se Z e Cn sono variabili aleatorie indipendenti, la prima normale standard e la seconda chi-­‐

quadro con n gradi di libertà, allora la variabile aleatoria Tn definita come Tn :=

Z

si dice Cn n

avere distribuzione t con n gradi di libertà à Tn ~ t n . Tale variabile aleatorie viene definita spesso t di Student. fT ( t ) =

§

⎛ n + 1⎞

Γ⎜

⎝ 2 ⎟⎠

⎛

t ⎞

⎛ n⎞

Γ ⎜ ⎟ nπ ⎜ 1 + ⎟

⎝ 2⎠

n⎠

⎝

2

n +1

2

con t a n gradi di libertà. E [Tn ] = 0 con n ≥ 2 . n

§ Var (Tn ) =

con n ≥ 3 . n−2

Ø Se Tn ~ tα ,n con α ∈( 0,1) à P (Tn ≥ tα ,n ) = α . §

§

T è simmetrica à P (Tn ≥ −tα ,n ) = 1 − α . µ Teoremi e Teorie: Ø Teoria dell’affidabilità: § T = istante di rottura. T > t ⇔ all’istante t il sistema funziona. § P (T > t ) = 1 − FT ( t ) = funzione di sopravvivenza. §

§

fT ( t )

. 1 − FT ( t )

P (T ∈(t,t + dt] & T > t ) P (T ∈(t,t + dt])

f ( t ) dt

P (T ∈(t,t + dt] | T > t ) =

=

T

= λT ( t ) dt

P (T > t )

1 − FT ( t )

1 − FT ( t )

Def: intensità di rischio o tasso di guasto. λT ( t ) :=

§

§

T > 0 λT ( t ) ⇒ fT ( t ) è nota. f (t )

d

λT ( t ) := T

= − ln (1 − FT ( t )) integrando il tutto à 1 − FT ( t )

dt

t

t d

λ

s

ds

=

−

(

)

T

∫0

∫0 ds ln (1 − FT ( s )) ds = − ⎡⎣ ln (1 − FT (t )) − ln (1 − FT ( 0 ))⎤⎦ , 9 Modelli di Variabili Aleatorie ∫

t

0

Probabilità Mattia Natali = 0

t

− λT ( s ) ds

. λT ( s ) ds = ln (1 − FT ( 0 )) − ln (1 − FT ( t )) ⇒ 1 − FT ( t ) = e ∫0

{

}

FT ( t ) = 1 − exp − ∫ λT ( s ) ds . Ricorda che: fT ( t ) = −

§

§

t

0

{

λT ( t ) = λ ⇔ T ~ € ( λ ) à FT ( t ) = 1 − exp − ∫ λ ds = 1 − e− λt . t

0

λT ⇒ P (T > t + s | T > s ) ≤ P (T < t ) , ( significa non decrescente). P (T > t + s & T > s ) P (T > t + s ) 1 − FT ( t + s )

• P (T > t + s | T > s ) =

=

=

=

P (T > s )

P (T > s )

1 − FT ( s )

{ λ (u ) du} = exp {− ( ∫

=

exp {− ∫ λ ( u ) du}

exp − ∫

t+s

T

0

s

0

•

•

t+s

0

λT ( u ) du − ∫ λT ( u ) du

s

0

T

§

}

d

(1 − FT (t )) . dt

{

)} = exp {− ( ∫

t+s

s

λT ( u ) du

)}

}

P (T > t ) = 1 − FT ( t ) = exp − ∫ λT ( u ) du . t

0

Facendo i grafici vediamo che P (T > t + s | T > s ) ≤ P (T < t ) effettivamente è vera. T è Weibull ⇔ λT ( t ) = αβ t β −1 . Ø Teorema del limite centrale: § X1 , X 2 ,... variabili aleatorie indipendenti, tutte con la stessa formula di ripartizione, E ( X1 ) = E ( X2 ) = ... = µ , Var ( X1 ) = Var ( X2 ) = ... = σ 2 . §

1 n

∑ Xk = Xn media campionaria. n k =1

•

E ( Xn ) = µ . •

Var ( Xn ) =

•

σ2

. n

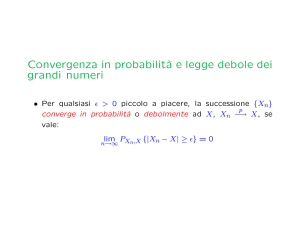

P Xn − µ > ε → 0 (legge dei grandi numeri). (

)

n→∞

§

σ2

σ

• Var ( X n − µ ) = Var ( X n ) =

. X n µ ± k Var ( X n ) = µ ±

. n

n

σ

Xn − µ

. n

Teorema limite centrale: X1 , X 2 ,.. variabili aleatorie indipendenti con la stessa formula di X −µ

2

n . ripartizione E ( X1 ) = E ( X 2 ) = ... = µ , Var ( X1 ) = Var ( X 2 ) = ... = σ ⇒ n

σ

2

z

⎛ Xn − µ

⎞

1 − u2

lim P ⎜

n ≤ z⎟ = Φ ( z ) = ∫

e du . −∞

n→+∞

⎝ σ

⎠

2π

§

Zn =

§

⎛ σ2 ⎞

Xn − µ

Zσ

n ≈ N ( 0,1) . Xn = n + µ , Xn ≈ N ⎜ µ, ⎟ . σ

⎝ n ⎠

n

n 1

10 Modelli di Variabili Aleatorie §

Probabilità Mattia Natali n

1 n

⎛ n

⎞

⎛ Z nσ

⎞

+ µ ⎟ = σ nZ n + nµ à E ⎜ ∑ X k ⎟ = nµ , nXn = n ∑ X k = ∑ X k à n ⎜

⎝ n

⎠

⎝ k =1 ⎠

n k =1

k =1

≈ N ( 0,1)

⎛ n

⎞

Var ⎜ ∑ X k ⎟ = nσ 2 . ⎝ k =1 ⎠

11