UNIVERSITA’ POLITECNICA DELLE MARCHE

FACOLTA’ DI INGEGNERIA

Corso di Laurea Triennale in Ingegneria Biomedica

BRAIN COMPUTER INTERACTION:

ACQUISIZIONE DI SEGNALI CEREBRALI E

IMPLEMENTAZIONE DEL METODO ICA

Relatore:

Prof. Aldo Franco Dragoni

Anno Accademico 2009-2010

Tesi di Laurea di:

Annachiara Celso

Dove c'è una grande volontà non possono esserci grandi difficoltà.

(Niccolò Machiavelli)

Alla mia famiglia e ai miei amici.

Senza di voi, non sarei mai arrivata a questo punto.

INDICE

Introduzione

I.

pag. 1

Brain Computer Interaction: innovazione nel rapporto

uomo-computer

pag. 1

II.

Cosa sono le neuroscienze

pag. 3

III.

Struttura e obiettivi della tesi

pag. 4

Capitolo 1: Cenni di Neurofisiologia

1.1.

1.2.

Il Sistema Nervoso Centrale

pag. 6

1.1.1. L’unità fondamentale: il Neurone

pag. 6

1.1.2. La sinapsi

pag. 8

1.1.3. Potenziale di riposo e potenziale d’azione

pag. 8

1.1.4. Struttura del Sistema Nervoso Centrale

pag. 10

1.1.5. La corteccia cerebrale e le funzioni dei lobi

pag. 13

Il Sistema Nervoso Periferico

pag. 15

Capitolo 2: Modalità di rilievo dell’attività cerebrale

2.1.

2.2.

pag. 5

pag. 17

La Brain Imaging

pag. 17

2.1.1.

SPECT e PET

pag. 18

2.1.2.

Dalla risonanza magnetica alla fMRI

pag. 20

2.1.3.

La Magnetoencefalografia

pag. 22

2.1.4.

NIRS

pag. 23

L’Elettroencefalografia

pag. 24

2.2.1.

Il Tracciato

pag. 27

2.2.2.

I Potenziali Evocati

pag. 28

i

Capitolo 3: I Sistemi BCI

pag. 32

3.1.

Definizione di BCI

pag. 32

3.2.

Scelta del sistema di rilievo

pag. 34

3.3.

Struttura di una BCI

pag. 35

3.3.1.

Acquisizione dei segnali EEG

pag. 36

3.3.2.

Pre-processamento del segnale

pag. 38

3.3.3.

Analisi, classificazione e traduzione

pag. 39

Capitolo 4: I Potenziali Evento-Correlati

pag. 41

4.1.

Le componenti ERP

pag. 43

4.2.

Analisi dei dati ERPs

pag. 46

4.3.

Artefatti

pag. 48

4.3.1.

Artefatti extra-fisiologici

pag. 49

4.3.2.

Artefatti fisiologici

pag. 50

Capitolo 5: Metodo ICA e Algoritmi per l’Analisi delle

Componenti Indipendenti

pag. 55

5.1.

Il metodo ICA

pag. 55

5.2.

Algoritmi per l’analisi delle componenti indipendenti

pag. 57

5.2.1.

L’Infomax

pag. 57

5.2.2.

Il FastICA

pag. 59

5.2.3.

Analisi e implementazione del software per

il trattamento dei dati elettroencefalografici

pag. 63

Conclusioni

pag. 68

Elenco delle figure

pag. 70

Bibliografia

pag. 72

Webgrafia

pag. 74

ii

INTRODUZIONE

I.

Brain Computer Interaction: innovazione

nel rapporto uomo-computer

Per Brain Computer Interaction si intende un settore della ricerca volto alla costruzione

di interfacce in grado di collegare direttamente il cervello umano ad un dispositivo

elettronico come un computer.

Diversamente dai tradizionali dispositivi di input come mouse e tastiere, queste

interfacce permettono a persone affette da gravi disabilità motorie di interagire con un

pc senza comandi muscolari, ma attraverso l’uso di onde cerebrali.

In sostanza, una BCI o Brain Computer Interface è una soluzione per acquisire ed

elaborare comandi impartiti direttamente dal cervello, per mezzo di strumenti

computerizzati. Dopo una fase di classificazione real-time, i segnali vengono

riconosciuti, distinti e associati a comandi per controllare strumenti ed interagire

attivamente.

La Neurofisiologia e gli sviluppi riguardanti la struttura del cervello umano e le

funzionalità che questo possiede, hanno portato allo sviluppo, negli ultimi decenni, di

ricerche finalizzate al raggiungimento di interfacce uomo-computer sempre più

avveniristiche.

Esistono odiernamente delle interfacce che consentono di controllare il dispositivo

elettronico mediante la voce, il movimento degli occhi, delle palpebre o addirittura della

lingua. Ovviamente, però, queste si basano su movimenti muscolari che, seppur minimi,

possono essere problematici o addirittura impossibili per persone con gravi paralisi. La

possibilità di controllo mediante impulsi cerebrali ha fatto sì che la ricerca si dirigesse

verso periferiche che non richiedano il movimento da parte dell’utente.

Tutto questo è stato possibile grazie agli sviluppi che le tecniche di rilevazione

dell’attività cerebrale hanno avuto negli ultimi decenni e grazie anche all’elaborazione

di algoritmi sempre più efficienti per la decodifica dei segnali biologici.

1

A differenza infatti di dispositivi che richiedono un movimento muscolare (ad esempio

l’occhio, un dito), una Brain Computer Interface interviene laddove una disabilità, una

compromissione del canale nervoso o l’amputazione di un arto impediscano l’uso del

sistema motorio. Da sempre si è fantasticato su come arrivare ad un’interazione diretta

tra cervello e computer capace di interpretarne l’attività.

Nelle BCI vengono fatti tentativi con vari tipi di segnali elettrici cerebrali, ognuno con

vantaggi e svantaggi. Le difficoltà sono notevoli considerando la quantità di dati da

elaborare velocemente e la diversità che caratterizza ogni cervello. Ciò rende

indispensabile un addestramento del paziente ed un adattamento del software per ogni

singolo individuo.

Una BCI è in grado di registrare i segnali provenienti dal cervello, di convogliarli

all’esterno e di trasformarli in comandi che il computer interpreta e utilizza per produrre

in output una determinata funzione che può essere anche fisica. I segnali generati

nell’area corticale sono acquisiti dall’esterno del cranio tramite appositi sensori ed

elaborati con algoritmi che trasformano le modulazioni volontarie o involontarie delle

onde cerebrali, in comandi per un software o un dispositivo permettendo a questo di

realizzare un determinato compito.

La modalità di interazione mediante una BCI è ben lontana dalla lettura del pensiero ma

è una rilevazione di una volontà. Il presupposto su cui si basa tale tecnologia è che, in

individui con funzioni cerebrali integre, gli impulsi neurali vengono comunque generati

anche se non vengono poi trasmessi alla zona corporea.

Giacché una BCI può donare al cervello un nuovo canale di controllo e di

comunicazione che non prevede l'uso dell'apparato muscolare, le sue applicazioni si

stanno muovendo a maggior ragione nell’ambito della disabilità. Numerose patologie

come la sclerosi laterale amiotrofica, la distrofia muscolare, la paralisi cerebrale

possono del tutto invalidare il funzionamento dei canali attraverso i quali il cervello

controlla il movimento.

Grazie a questi dispositivi, pazienti il cui sistema nervoso periferico è gravemente

compromesso possono trovare un miglioramento della loro qualità della vita.

Pensando al futuro, le applicazioni offerte da un’interfaccia BCI sono pressoché infinite.

Ovviamente riguardo questa branca della ricerca rimangono aperte questioni relative

2

all’etica, alla metodologia, alle soluzioni ingegneristiche e ai costi per permettere un uso

in larga scala delle interfacce.

La sfida più importante sarà sicuramente quella di rendere il loro utilizzo il più naturale

e intuitivo possibile.

II. Cosa sono le neuroscienze

Le neuroscienze sono una disciplina di frontiera che negli ultimi trent’anni ha accolto

contributi da settori molto diversi tra loro: dalla neurofisiologia alla biologia

molecolare, dalla psicologia sperimentale alla filosofia. Con il passare del tempo, ciò ha

portato alla visione di esiti interessanti e clamorosi, spesso imprevedibili. Gli studi di

neuroscienze si basano sul fatto che ogni comportamento è espressione di una funzione

del cervello.

Alla base di fenomeni cognitivi e affettivi come pensiero, memoria, linguaggio,

emozioni, ci sono quindi attività elettriche e chimiche. Lesioni di specifiche aree

cerebrali determinano disturbi di tali funzioni. Circa cento anni fa dall’incontro di

discipline come biochimica, fisiologia, neuroanatomia, psicologia, istologia, è emerso

sempre più lo stretto rapporto che lega il cervello al comportamento umano.

A partire dagli studi di Galvani sull’attività elettrica dei neuroni, passando poi alle

trasmissioni chimiche scoperte da Claude Bernard e grazie anche agli studi di Darwin,

dimostrare una stretta correlazione tra aree cerebrali e funzioni superiori divenne

sempre più inevitabile.

Nei primi anni del ‘900 nacquero due diverse correnti contrastanti: la teoria dei campi

cerebrali associati e la teoria del connessionismo cellulare. La prima corrente affermava

che non era possibile stabilire una localizzazione precisa delle aree deputate a

determinate funzioni; qualsiasi area corticale era ritenuta in grado di svolgere qualsiasi

compito. La seconda, invece, sosteneva che ciascuna manifestazione comportamentale

fosse conseguenza dell’azione di specifiche regioni cerebrali delimitate da circuiti

nervosi definiti. Odiernamente si è a conoscenza che ogni zona del cervello è deputata a

3

svolgere le proprie funzioni. Queste, però, seguono più vie nervose in modo tale da

evitarne una completa compromissione in caso di lesioni di una zona.

II. Struttura e Obiettivi della tesi

L’obiettivo di questa tesi è quello di addentrarsi nei principi che regolano lo sviluppo

che la ricerca sulla Brain Computer Interaction sta avendo negli ultimi anni, a partire

dalle basi di neurofisiologia. A tal proposito, una prima parte è dedicata alla descrizione

anatomo-fisiologica del sistema nervoso umano. Una seconda sezione approfondisce,

invece, quali sono le più importanti tecniche di rilievo non invasive dell’attività

cerebrale, vista come punto di partenza per lo svolgimento di funzioni superiori.

Ciascuna metodica di rilievo può far parte di una Brain Computer Interface e dunque un

capitolo, oltre alla descrizione del percorso del segnale all’interno dell’interfaccia, è

dedicato al confronto tra le varie tecniche, ponendo in evidenza il perché la ricerca si

stia direzionando verso il perfezionamento dell’uso elettroencefalografico.

Gli ultimi due capitoli focalizzano l’attenzione sull’analisi qualitativa e quantitativa del

tracciato EEG, introducendo il concetto di potenziale evento correlato. Indice di

interesse per l’introduzione di input per algoritmi di decisione, gli ERPS (Event Related

Potentials) sono però immersi nell’EEG di fondo e necessitano per questo di

processamenti per la loro estrazione, oltre che di rimozione di eventuali artefatti.

Altro obiettivo della tesi è quello di studiare e analizzare un metodo valido per il

trattamento dei segnali elettroencefalografici utili alla Brain Computer Interaction:

l’Analisi delle Componenti Indipendenti (Independent Components Analysis, ICA).

Per questo motivo, dopo la descrizione della procedura sfruttata da tale metodica,

vengono esposte le linee guida dei due principali algoritmi che la implementano:

l’Infomax e il FastICA. A proposito di quest’ultimo, nell’ultimo paragrafo viene

riportato un codice sorgente in linguaggio C volto alla comprensione pratica di come

questo algoritmo agisce sul segnale elettroencefalografico.

4

CAPITOLO 1

Cenni di Neurofisiologia

Il fine che le neuroscienze si prefiggono è quello di capire le attività mentali, i

meccanismi mediante cui riusciamo ad avere percezioni, ci muoviamo e ricordiamo.

Una delle più rinomate frontiere della scienza è quella della comprensione delle basi

biologiche della conoscenza dei processi mentali che ci consentono di agire, di

percepire, di apprendere o di ricordare.

Figura 1: Schema a blocchi del sistema nervoso

Il sistema nervoso umano è composto da due differenti elementi capaci l’uno di

elaborare i dati e l’altro di trasmettere informazioni.

Questo comprende il sistema nervoso centrale, che consta di encefalo e midollo spinale,

e il sistema nervoso periferico, costituito dai gangli e dai nervi periferici, che sono

disposti al di fuori del cervello e del midollo spinale.

Il sistema nervoso centrale e quello periferico, sebbene siano anatomicamente distinti,

sono reciprocamente connessi ed interagiscono tra di loro nello svolgimento delle

rispettive funzioni. Il primo elabora e interpreta i segnali somatici e viscerali che

5

arrivano dalle varie parti del corpo fornendo loro una risposta; il secondo, costituito da

nervi motori o sensitivi, ha il compito di trasmettere i segnali a muscoli, ghiandole o

organi bersaglio, da e verso il sistema nervoso centrale.

Il sistema nervoso centrale è una struttura bilaterale. E’ essenzialmente simmetrica,

formata da sei parti principali: il midollo spinale, il bulbo, il ponte (con il cervelletto), il

mesencefalo, il diencefalo e gli emisferi cerebrali. L’assegnamento di specifiche

funzioni a specifiche aree, è stato possibile grazie ad una moltitudine di tecniche

sperimentali.

Andiamo ad analizzare in dettaglio le componenti del sistema.

1.1. Il Sistema Nervoso Centrale

Il Sistema Nervoso Centrale è composto da un insieme di tessuti specializzati deputati

alla ricezione e al riconoscimento di stimoli provenienti sia dall’interno che dall’esterno

del corpo, e all’elaborazione di risposte.

I tessuti specifici sono formati da due diversi tipi di cellule. Le cellule della glia offrono

essenzialmente una funzione di supporto. I neuroni rappresentano l’unità fondamentale

del sistema nervoso centrale.

1.1.1. L’unità fondamentale: il Neurone

Il sistema nervoso umano è caratterizzato da una serie di cellule, dette neuroni,

organizzate in reti che percorrono tutto il corpo. Questi circuiti inviano messaggi da una

parte all’altra del corpo sottoforma di segnali elettrici.

La peculiarità di queste particolari cellule è la capacità di ricevere stimoli e di condurre

impulsi provenienti dai nervi trasmettendo così informazioni ad altre parti del corpo.

6

Figura 2: Anatomo-fisiologia di un neurone

I neuroni possono essere definiti come l’unità costitutiva del sistema nervoso periferico

e di quello centrale. Oltre ad avere il compito di processare l’informazione, hanno la

peculiarità fondamentale di possedere proprietà elettriche di tipo attivo. Queste

proprietà consentono la propagazione di un segnale elettrico senza attenuazione.

I neuroni sono in grado di generare, analizzare e propagare i segnali elettrici frutto del

linguaggio proprio del cervello. Pur avendo molteplici forme, tutte sono riconducibili a

degli elementi base (figura 2). Centralmente, il neurone presenta un corpo cellulare

detto soma o pirenoforo. Qui sono localizzati nucleo e organuli che espletano le

funzioni cellulari.

A partire dal corpo cellulare hanno origine due prolungamenti citoplasmatici

responsabili delle proprietà di eccitabilità e conducibilità del neurone. Da uno dei due

poli origina l’albero dendritico; esso consente al neurone di ricevere i segnali dai

neuroni afferenti e di propagarlo in direzione del soma.

Proprio a seconda della complessità dell’albero dendritico, i neuroni trovano

differenziazione nella morfologia e nel numero di segnali che possono essere ricevuti. Il

polo opposto è caratterizzato dalla presenza dell’assone, o neurite, che trasmette il

segnale verso altri neuroni. L’estremità dell’assone si ramifica e ciascun ramo termina

con un bottone sinaptico o terminazione sinaptica. Mediante queste terminazioni

avviene il contatto del neurone con i dentriti o i corpi dei neuroni adiacenti definendo

così il circuito neuronale.

7

Gli assoni dei neuroni che compongono il sistema nervoso periferico sono ricoperti da

un involucro protettivo o guaina mielinica costituita da una lunga catena di cellule di

Schwann. Con questo metodo viene garantita la propagazione degli impulsi lungo

l’assone la cui velocità raggiunge i 100 m/s. I meccanismi di polarizzazione e

depolarizzazione della membrana permettono la generazione degli impulsi elettrici.

1.1.2. La sinapsi

La sinapsi è la zona di contatto attraverso la

quale i neuroni comunicano tra loro.

Esistono due tipi di sinapsi: le sinapsi elettriche e

quelle chimiche.

Le sinapsi elettriche collegano direttamente un

neurone ad un altro, ossia esiste un canale (o gap)

tra il citoplasma delle due cellule. Per merito di

questo canale il percorso per la corrente elettrica

che fluisce tra due neuroni è a bassissima

resistenza,

così

che

la

trasmissione

è

estremamente veloce. Esse si trovano per

Figura 3: Struttura di una sinapsi

esempio nei neuroni piramidali della corteccia,

nel tessuto cardiaco e all’interno della retina.

Sono invece molto rare nelle cellule del sistema nervoso centrale (SNC) dell’uomo

adulto. Nelle sinapsi chimiche, invece, lo scambio di informazioni avviene tramite il

rilascio di agenti chimici, detti neurotrasmettitori, dal terminale presinaptico alle

ramificazioni dell’assone.

1.1.3. Potenziale di riposo e potenziale d’azione

La cellula nervosa contiene, ed è immersa, in un fluido costituito da acqua e sali, per la

maggior parte ionizzati. In particolare, nella soluzione si trovano ioni di diversa polarità

quali Cloro, Potassio, Sodio , Calcio.

8

In condizioni di riposo, tra l'esterno e l'interno della cellula esiste una differenza di

potenziale di 70 mV con l'esterno positivo rispetto all'interno. L'impulso nervoso si

origina nella parte dell'assone prossima al corpo cellulare e consiste in una variazione

transitoria del potenziale di membrana di riposo.

La membrana del neurone non è continua ma è costituita da un doppio strato di

fosfolipidi contenente milioni di passaggi formati da proteine, attraverso i quali gli ioni

possono attraversare il doppio strato.

La carica e la differenza di potenziale a cavallo della membrana dipendono istante per

istante dalle concentrazioni di ioni intra ed extra-cellulari. Gli ioni maggiormente

interessati alla propagazione dei potenziali d'azione sono Na+ e K+ . In condizioni di

riposo, la corrente ionica totale è nulla e le concentrazioni di Na+ e K+ sono:

•

Na+ intracellulare « Na+ extracellulare

•

K+ intracellulare » K+ extracellulare

Questo gradiente di concentrazione è mantenuto da un meccanismo di trasporto attivo

chiamato pompa sodio-potassio, a spese di una grossa energia metabolica. La pompa

sodio-potassio, a riposo, espelle la maggior parte degli ioni Na+ e porta all'interno della

cellula ioni K+ . Tutti i segnali elettrici sono la conseguenza di variazioni del potenziale

di membrana a riposo dovute a flussi di corrente attraverso la membrana. Dette

variazioni possono essere utilizzate per generare messaggi nervosi. In particolar modo,

quando il potenziale di membrana di una cellula nervosa si riduce di 10 mV, si genera

un potenziale d’azione che transitoriamente annulla il potenziale di membrana e ne

inverte la polarità (figura 4).

Quando il neurone è a riposo, molti canali per il Potassio, ma non tutti, sono aperti e

gran parte dei canali per il Sodio è chiusa. Durante l'impulso si aprono improvvisamente

moltissimi canali per il Sodio in un breve tratto di fibra nervosa, cosicché quella parte è

interessata da un forte ingresso dello ione Na+ nella cellula.

Si verifica così la depolarizzazione della membrana, vale a dire un aumento di carica

positiva all'interno del neurone. I canali per il Sodio poi si richiudono, mentre si aprono

quelli per il Potassio in numero maggiore di quando la cellula è a riposo.

9

Figura 4: Potenziale d'Azione

Tutta la sequenza dura all'incirca un millisecondo. I canali del Sodio, una volta aperti,

tendono spontaneamente a richiudersi, anche se la depolarizzazione viene mantenuta, e

poi sono incapaci di riaprirsi per qualche millesimo di secondo; i canali del Potassio

rimangono aperti per tutta la durata della depolarizzazione.

Per un dato livello di depolarizzazione, il numero di ioni Na+ che entra è inizialmente

maggiore del numero degli ioni K+ che esce, la membrana diventa negativa all'esterno

rispetto all'interno. Poco dopo il flusso uscente di ioni K+ predomina e il potenziale di

membrana viene ripristinato.

1.1.4. Struttura del Sistema Nervoso Centrale

Il sistema nervoso centrale (SNC) è costituito dall'encefalo, racchiuso nella scatola

cranica, e dal midollo spinale, contenuto invece nel canale vertebrale.

1) IL MIDOLLO SPINALE

Nell’organismo il midollo spinale va a costituire la zona di elaborazione centrale e di

collegamento ricevendo gli impulsi sensoriali e inviando segnali motori di risposta.

Figura 5: Midollo spinale sezionato trasversalmente

10

Situato all’interno del canale vertebrale e di forma cilindrica, occupa la prima parte del

cosiddetto rachide (dalla base del cranio alla seconda vertebra lombare).

Nel senso della lunghezza, esso è suddiviso in segmenti corrispondenti alle vertebre

cervicali, toraciche, lombari, sacrali e coccigee. Da ciascun segmento si diparte da ambo

i lati un nervo spinale. Immaginando di sezionare il midollo trasversalmente (figura 5)

sarebbe visibile un foro: il canale centrale. Si noterebbe, inoltre, che vi sono territori

ben delimitati e in rapporto fra loro, rispettivamente la sostanza grigia e la sostanza

bianca. La sostanza grigia è costituita dai corpi delle cellule nervose a differenza della

sostanza bianca composta dagli assoni.

Il midollo spinale è atto a ricevere le fibre nervose afferenti dalla periferia, e a proiettare

le fibre efferenti verso gli organi periferici.

Le fibre afferenti possono essere somatiche, qualora trasportino gli impulsi dalla

superficie corporea al sistema nervoso centrale, o viscerali, qualora provengano da

organi interni.

Le fibre nervose efferenti trasmettono gli impulsi di risposta del SNC agli organi

periferici quali muscolo o ghiandole.

I neuroni che innervano i muscoli sono denominati motoneuroni e i loro corpi sono

localizzati nelle corna anteriori del midollo spinale. Quest’ultimo inoltre è rivestito da

delle guaine dette meningi.

2) L’ENCEFALO

Le strutture principali che compongono l’encefalo umano sono il tronco encefalico, il

cervelletto e il cervello propriamente detto.

Figura 6: Encefalo in sezione sagittale

11

•

Il tronco encefalico

Il tronco encefalico può essere considerato come il proseguimento del midollo

spinale ed è caratterizzato da tre differenti regioni: il bulbo, il ponte e il

mesencefalo. Le funzioni da esso svolte sono le seguenti: consente il transito di tutti

i fasci di fibre che collegano cervello e midollo spinale; ospita i nuclei dei nervi

cranici; controlla funzioni fondamentali come l’attività cardiaca, la respirazione, lo

stato di coscienza ecc.

Andando nel dettaglio si può dire che nel bulbo sono situati i neuroni che

controllano respirazione, cuore e apparato gastrointestinale, mentre il ponte è

fondamentale per il controllo dell’espressione facciale.

Per quanto riguarda il mesencefalo, invece, esso ospita nuclei coinvolti nei

meccanismi di visione e udito, ma anche strutture fondamentali per il controllo dei

movimenti

•

Il cervelletto

Posteriormente al ponte, alla base del cervello, è situato il cervelletto, prima

porzione del sistema nervoso a specializzarsi nel controllo dei movimenti. Grazie ai

collegamenti con tutte le regioni cerebrali (retina, corteccia, tronco encefalico), esso

è deputato all’apprendimento motorio e alla coordinazione dei movimenti.

•

Il cervello

Il cervello è costituito da sostanza bianca circondata esternamente da un involucro di

sostanza grigia, la corteccia cerebrale. La morfologia è molto complessa e le

dimensioni sono notevoli. Costituito da una massa ovoidale convessa, il cervello

umano è diviso in due emisferi. La superficie rugosa ha la particolarità di essere

caratterizzata da numerosi solchi o circonvoluzioni.

All’interno di questo complesso organo si evidenziano due porzioni distinte: il

diencefalo e il telencefalo. Il diencefalo è costituito dal talamo responsabile della

modulazione della coscienza dell’individuo, dall’epitalamo contenente l’epifisi, e

12

dall’ipotalamo. Quest’ultimo, oltre a garantire l’omeostasi corporea, regola

l’appetito, il bilancio idrico, la pressione arteriosa, la temperatura, la frequenza

cardiaca.

Per sistema limbico inoltre si intende una serie di strutture poste centralmente

all’encefalo responsabili di risposte conscie e inconscie. Il cervello può essere

suddiviso in quattro regioni denominate lobo frontale, lobo temporale, lobo parietale

e lobo occipitale.

1.1.5. La corteccia cerebrale e le funzioni dei lobi

Le funzioni cerebrali sono localizzate principalmente nella corteccia che ricopre gli

emisferi cerebrali. In ciascuno dei due emisferi la sovrastante corteccia è suddivisa in 4

lobi anatomici distinti: frontale, parietale, occipitale e temporale. Questi lobi possiedono

funzioni specializzate.

Il lobo frontale è deputato, in gran parte, alla programmazione delle azioni di controllo

del movimento. Quello parietale alla percezione di sensazioni somatiche e alla

rappresentazione della propria immagine corporea. Il lobo occipitale è connesso con la

visione mentre quello temporale con l’udito e con alcuni aspetti della memoria,

dell’apprendimento e del comportamento emotivo.

Ciascun lobo possiede una serie di circonvoluzioni o ripiegamenti caratteristici.

Figura 7: Lobi cerebrali

13

Le peculiarità nell’organizzazione della corteccia cerebrale sono essenzialmente due. In

primo luogo ciascun emisfero è correlato con i processi sensitivi della parte opposta del

corpo; le vie nervose afferenti che entrano nel midollo spinale dal lato destro del corpo,

infatti, passano nella parte sinistra prima di arrivare alla corteccia cerebrale. In altre

parole, le aree motrici di un emisfero controllano i movimenti della metà opposta del

corpo. In secondo luogo, i due emisferi, pur essendo complementari e strutturati

similmente, non sono completamente simmetrici e ciò comporta delle differenze dal

punto di vista funzionale. La divisione in solo quattro lobi, tuttavia, non risulta

sufficiente per definire tutte le aree e le specifiche funzioni che un individuo può

svolgere.

Pur essendo stati proposti diversi tipi di suddivisione della corteccia cerebrale, la

classificazione più accreditata è quella di Brodmann che ha individuato ben 52 diverse

aree all’interno della corteccia. Ognuna è stata conseguentemente trovata la specifica

funzionalità. Lesioni di determinate aree, però, non compromettono totalmente lo

svolgimento di una attività. Le funzioni di alto livello sono, infatti, delocalizzate e

conferiscono al cervello una notevole plasticità.

Figura 8: Aree di Brodmann

14

1.2. Il Sistema Nervoso Periferico

Il sistema nervoso periferico è composto dai nervi periferici la cui funzione è quella di

collegare il cervello e il midollo spinale con muscoli, organi di senso o appartenenti ai

sistemi circolatorio, escretore, respiratorio o digerente. I nervi periferici ospitano i gli

assoni dei neuroni sensoriali e di quelli motori. I primi trasmettono al SNC i segnali

provenienti da tutto il corpo, mentre i secondi trasmettono la risposta del sistema

nervoso centrale agli organi bersaglio o ai muscoli.

La porzione motoria del sistema nervoso periferico può essere suddivisa in due parti: il

sistema nervoso somatico e il sistema nervoso autonomo.

I neuroni del sistema nervoso somatico stabiliscono sinapsi con i muscoli scheletrici e

controllano il movimento volontario. I loro corpi cellulari si trovano nella sostanza

grigia del midollo spinale, e i loro assoni raggiungono direttamente i muscoli

controllati.

I neuroni del sistema nervoso autonomo controllano invece le risposte involontarie e

stabiliscono sinapsi con il cuore, i muscoli lisci e le ghiandole; è controllato sia dal

midollo allungato sia dall'ipotalamo. Un’ulteriore suddivisione è quella che scompone il

sistema nervoso autonomo in sistema nervoso simpatico e sistema nervoso

parasimpatico.

Il sistema nervoso simpatico agisce sugli organi interni in modo da preparare

l'organismo ad affrontare un'attività dispendiosa da un punto di vista energetico: battito

cardiaco, irrorazione dei muscoli, dilatazione delle pupille, espansione delle vie aeree

per un maggiore afflusso di ossigeno.

Il sistema nervoso parasimpatico è invece associato ad attività caratteristiche dei

momenti di ozio, come ad esempio la fase digestiva postprandiale. Inoltre gli assoni

parasimpatici si trovano nei nervi che hanno origine dall'encefalo e dalla base del

midollo spinale.

Al contrario, gli assoni simpatici si trovano nei nervi che hanno origine dalle sezioni

mediana e inferiore del midollo spinale.

15

In entrambi i sistemi, simpatico e parasimpatico, si trovano neuroni che trasmettono

messaggi in sequenza dal sistema nervoso centrale a ciascun organo bersaglio, ma le

sinapsi che stabiliscono sono localizzate in sedi diverse.

Nel sistema nervoso simpatico la sinapsi è localizzata nei gangli vicini al midollo

spinale, mentre nel sistema nervoso parasimpatico la sinapsi è localizzata nei gangli più

piccoli situati intorno o in prossimità di ciascun organo bersaglio.

16

CAPITOLO 2

Modalità di rilievo dell’attività cerebrale

Il cervello, nella sua complessità e macchinosità ha da sempre affascinato l’uomo.

Ippocrate di Kos (V secolo a.c.) scrisse: “..e dal cervello e soltanto dal cervello

prendono origine i nostri piaceri, la gioia, il riso, il gesto, come pure la tristezza, il

dolore, la depressione, le lacrime. Attraverso il cervello pensiamo, vediamo, ascoltiamo

e distinguiamo il bello dal brutto, il male dal bene...”.

Gli sviluppi ottenuti nel campo della ricerca riguardante la rilevazione della attività

cerebrale, hanno consentito di evidenziare la sempre più stretta relazione tra specifiche

funzioni e determinate aree del cervello.

Il connubio tra la neuroanatomia, in grado di descrivere i vari elementi dell’encefalo, e

la neurofisiologia, che analizza il comportamento delle singole aree, ha dato risultati il

più delle volte sorprendenti e avveniristici.

Tutto questo, insieme alla neuro ingegneria, ha permesso di elaborare sistemi di

rilevazione dei dati cerebrali utili alla visualizzazione e all’interpretazione degli stessi.

2.1. La Brain Imaging

Lo sviluppo di tecniche neuroradiologiche nel campo di Neuroimaging o Brain Imaging

sempre più avanzate, ha consentito di conoscere meglio la neurofisiologia del sistema

nervoso e le patologie cerebrali.

Per Functional neuroimaging (Neuroimaging Funzionale) si intende l’utilizzo di

tecniche di neuroimaging il cui obiettivo è quello di stimare il metabolismo cerebrale

per consentire l’analisi e lo studio della correlazione tra specifiche aree cerebrali e

determinate funzioni.

17

Queste metodiche, a partire proprio dalle variazioni emodinamiche frutto dell’attività

nervosa, sono in grado di individuare le aree attivate nel cervello. Infatti, maggiore è

l’attività funzionale di un dato tessuto cerebrale, maggiore è il suo metabolismo. Come

risultato si avrà un aumento di richieste energetiche in termini di ossigeno e glucosio.

Le cellule nervose, e in particolare i neuroni, sono caratterizzate da una necessità

continua di apporto di energia che, come è noto, all’interno del corpo umano, è fornito

dal sangue. In tal modo, le aree deputate in un determinato istante allo svolgimento di

una funzione, saranno contraddistinte da un aumento localizzato di flusso ematico che

consente un maggior apporto di ossigeno e glucosio. Le immagini ottenute con le

metodiche di Neuroimaging hanno la peculiarità di essere in vivo e non invasive,

rappresentando così un rilevante passo avanti. Le tecniche a cui si fa maggior

riferimento sono la "single photon emission computerized tomography" (SPECT), la

"positron emission tomography" (PET), la "functional magnetic resonance imaging"

(fMRI) e la "magnetoencephalography" (MEG).

2.1.1.

SPECT e PET

La tomografia ad emissione di singolo fotone (Single Photon Emission Computerized

Tomography, SPECT) e la tomografia ad emissione di positroni (Positron Emission

Tomography, PET) sono due tecniche diagnostiche tomografiche che permettono di

ottenere, in vivo e in modo non invasivo, mappe di distribuzione di un tracciante

radioattivo in specifiche aree dell’organismo. Le metodiche PET e SPECT si traducono,

quindi, in una somministrazione, il più delle volte endovenosa, di un tracciante

radioattivo, nella successiva rilevazione delle radiazioni, e nella traduzione in immagini

tomografiche. Pur avendo molte analogie, la PET e la SPECT differiscono per i sistemi

di rilevazione delle radiazioni e per i traccianti radioattivi usati nell’esame.

Per quanto riguarda la PET (Tomografia ad Emissione di Positroni), oltre ad essere

molto costosa, è presente solo in centri specializzati. Il principio su cui si basa è

l’utilizzo di un composto radioattivo come tracciante e la visualizzazione del

decadimento delle molecole che lo costituiscono. Tale decadimento, infatti, provoca la

liberazione di positroni e cioè elettroni positivi. A loro volta, i positroni sono soggetti a

scontro che da luogo alla propagazione di radiazioni elettromagnetiche gamma. Le

18

radiazioni, dopo essere state registrate ed elaborate elettronicamente, vengono usate per

la formazione di immagini che permettono la localizzazione delle aree da cui hanno

origine. La PET, dunque, consente di individuare la regione cerebrale caratterizzata da

un accumumo di radiotracciante. Con l’uso ad esempio di glucosio radioattivo, è

possibile determinare le zone cerebrali con un metabolismo particolarmente attivo in un

determinato istante. Questo accade durante l’esecuzione di un compito o in casi di

epilessia o tumori.

La PET, per esami di attività cerebrale, viene sempre più sostituita dalla fMRI o

risonanza magnetica funzionale, caratterizzata da un risoluzione temporo-spaziale

maggiore e in cui non è necessario l’uso di sostanze radioattive

La PET mantiene una importanza sostanziale per lo studio scientifico del legame di certi

farmaci a determinati tipi di recettori cerebrali.

Figura 9: Tipica immagine PET

La SPECT (ovvero tomografia computerizzata a emissione di fotoni singoli) è una

tecnologia simile alla PET ma più semplice, in quanto pur utilizzando anch’essa

composti radioattivi, questi emettono in modo diretto le radiazioni elettromagnetiche

gamma. Può essere impiegata per visualizzare una riduzione dell'attività cerebrale

causata da malattie neurodegenerative e per confermare la loro diagnosi. Può anche

19

aiutare a evidenziare processi di neurodegenerazione focali come le demenze frontotemporali. Non è richiesta comunque nella diagnosi di routine, perché nella maggior

parte dei casi (malattia di Alzheimer e demenze cerebrovascolari) non aumenta la

precisione diagnostica.

2.1.2.

Dalla Risonanza Magnetica alla fMRI

La risonanza magnetica è uno degli esami radiologici odiernamente più rilevanti in

neurologia. Esso utilizza campi magnetici ed è quindi una tecnica totalmente innocua

che assicura, inoltre, una buona risoluzione delle strutture cerebrali e spinali.

La RM è eseguita facendo uso o meno di iniezioni endovenose di mezzi di contrasto che

a differenza di quelli utilizzati nelle TAC, comportano pochi rischi per il paziente.

Questo mezzo di contrasto permette la visualizzazione di processi infiammatori o di

tessuti molto vascolarizzati (es. tumori).

Figura 10: Encefalo in Risonanza Magnetica

Uno degli sviluppi più importanti della RM è la risonanza magnetica funzionale che,

pur non avendo impieghi clinici, risulta molto utile negli studi scientifici. Mediante la

fMRI, infatti, si è in grado di determinare la distribuzione delle singole funzioni

cerebrali (linguaggio, musicalità, comportamenti e immaginazione)

20

La fMRI è una tecnica che sfrutta le proprietà magnetiche dei nuclei degli atomi

costituenti la materia e il nostro corpo. I segnali di risonanza delle molecole

magnetizzabili sono rilevati grazie all’aiuto di campi magnetici e onde radio. Quando

eseguiamo un compito, ad esempio la lettura di una parola, il movimento di una mano o

il riconoscimento di una immagine, alcune aree cerebrali specifiche vengono chiamate

allo svolgimento di quella funzione. In termini di attività, quelle aree sono anche

caratterizzate, durante l’espletamento del compito, da un maggiore consumo di

ossigeno. Come risulato, si ha una variazione del rapporto tra ossiemoglobina e de

ossiemoglobina nelle regioni attivate. Questa variazione può essere rilevata dal segnale

di risonanza magnetica e usata per la formazione di immagini molto utili. Queste aree,

dal punto di vista del segnale di risonanza, sono caratterizzate dal cosiddetto effetto

BOLD (Blood Oxygenation Level Dependent). L’esame consiste nel posizionamento

della testa del soggetto in una bobina a radiofrequenza e nell’esposizione a campi

magnetici e onde radio che non vengono percepiti dal paziente. L’azione delle onde

radio sui tessuti provoca l’oscillamento delle molecole, che risuonando, sono in grado di

emettere segnali.

I segnali emessi vengono rilevati e successivamente analizzati da un computer. Le

immagini di attivazione che vediamo non sono delle foto istantanee perchè la fMRI, a

differenza della risonanza magnetica su cui si basa, produce immagini indirette rispetto

a ciò che accade nel cervello. Sono frutto di un’elaborazione di dati statistica e

rappresentano un effetto secondario dell´attività neuronale che è molto più rapida. Sono

delle mappe della distribuzione di questo effetto su tutto il cervello. Per consentire

l’elaborazione statistica è importante che il paziente in esame ripeta lo stesso compito

più volte, in modo tale da permettere la traduzione dei dati in una mappatura delle

funzionalità cerebrali.

21

2.1.3.

La Magnetoencefalografia

La MEG (Magnetoencefalografia) è una tecnica che misura i deboli campi magnetici

prodotti dall’attività del cervello umano. Questi campi sono il risultato dell’attività

sincrona di migliaia di neuroni. Dalla distribuzione dei campi è possibile risalire alla

regione cerebrale attivata.

Per esempio, dopo stimolazione di vari punti della pelle è possibile calcolare le aree in

cui sono proiettati questi punti nella corteccia cerebrale .

Permette quindi di ottenere in modo non invasivo una mappa funzionale del cervello di

un individuo.

Figura 11: Esame MEG ed elmetto con sensori SQUID

La magnetoencefalografia prevede l’uso di un elmetto contenente da 150 a 300 sensori,

denominato SQUID, come quello che si può vedere in figura. Gli SQUID permettono di

convertire l’energia magnetica in impulsi elettrici, di sicuro più facili sia da registrare

che da analizzare. Le registrazioni MEG vengono poi sovrapposte a immagini

tridimensionali ottenute con la RMN. Oltretutto, i risultati magnetoencefalografici,

22

possono essere combinati con i risultati ottenuti con la risonanza magnetica. Questa

combinazione consente di raccogliere in modo simultaneo una quantità di informazioni

sull’attività e sull’anatomia del cervello altrimenti inimmaginabili.

2.1.4.

NIRS

La spettroscopia ottica nel vicino infrarosso (NIRS ovvero near infrared spectroscopy) è

la tecnica introdotta più di recente nell’ambito degli studi non invasivi del cervello.

Nell’intervallo spettrale da 600 nm a 1000 nm, la radiazione ottica può infatti penetrare

nei tessuti biologici per alcuni centimetri sfruttando il basso assorbimento dei principali

cromofori endogeni. Per effetto delle microscopiche discontinuità nell’indice di

rifrazione dei tessuti biologici causate dalla presenza di un numero elevato di strutture

con dimensioni e forme differenti, la radiazione ottica NIR subisce molteplici eventi di

diffusione che non solo determinano la ridistribuzione della luce nel tessuto in un ampio

volume, ma causano anche la riemissione dei fotoni in prossimità dei bordi geometrici

del tessuto, permettendo così un’indagine non invasiva del mezzo attraversato.

Nell’ambito delle tecniche NIRS, la tecnica nota come spettroscopia di riflettanza

utilizza una coppia di fibre poste ad una distanza di alcuni centimetri per sondare in

modo non invasivo le proprietà ottiche di un tessuto biologico. L’analisi spettrale della

luce riemessa consente infine di determinare la concentrazione dei costituenti in vivo. In

particolare, la tecnica NIRS può ottenere informazioni sull’emodinamica e sul

metabolismo ossidativo nei muscoli e nel cervello sfruttando le differenti proprietà

ottiche di HHb e O Hb.

I sistemi NIRS per il monitoraggio funzionale non invasivo dell’attività cerebrale

devono essere compatti, veloci (tempo di acquisizione minore di 1 s e dotati di capacità

di acquisizione multipla. Sin dalle prime applicazioni della tecnica fNIRS, sono stati

sviluppati tre approcci fondamentali: spettroscopia in continua (continous wave fNIRS,

fNIRS-CW), nel dominio delle frequenze (frequency domain fNIRS, fNIRSFD) e

risolta nel tempo (time-resolved fNIRS, fNIRS-TR). Nei sistemi fNIRS-CW si inietta

nel tessuto una luce con potenza costante (fornita da una lampada, da un LED o un

laser) e si rivela la diminuzione di ampiezza della luce incidente. Nei sistemi fNIRS-FD

23

si utilizzano sorgenti di luce modulata in ampiezza e si registra la diminuzione di

ampiezza e lo sfasamento della luce riemessa.

Infine, nei sistemi fNIRS-TR si investe il tessuto con impulsi laser ultracorti e si registra

la distribuzione temporale dei fotoni diffusi. Grazie al costo relativamente modesto, alla

semplicità e alla solidità generale, i sistemi fNIRS-CW sono stati ampiamente impiegati

non solo in ricerca di base, ma anche in applicazioni precliniche portando allo sviluppo

di strumenti commerciali.

Più recentemente, sono stati usati con efficacia anche prototipi e strumenti fNIRS-FD.

Il vantaggio potenziale dei sistemi fNIRS-TR è la possibilità di ottenere maggiori

informazioni sul mapping funzionale del cervello umano in virtù della discriminazione

tra i coefficienti di assorbimento e scattering del tessuto cerebrale (cosa non possibile

con la tecnica fNIRS-CW e difficile con la fNIRS-FD), di una maggiore profondità di

penetrazione e di una migliore risoluzione spaziale rispetto alle altre tecniche ottiche.

La tecnica fNIRS può quindi rivelarsi un'interessante alternativa alla tecnica fMRI o

PET in quanto può essere utilizzata in un ambiente naturale, presso il letto del paziente,

su soggetti non collaborativi (es. bambini) e per compiti che richiedono un compito

motorio esplicito.

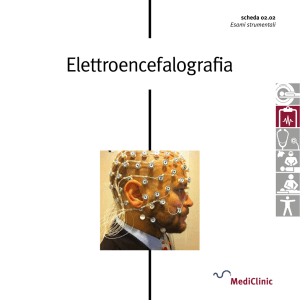

2.2. L’Elettroencefalografia

L’elettroencefalografia è una tecnica di rilievo dell’attività cerebrale che prevede la

registrazione dell’attività elettrica di superficie della corteccia, conseguenza dell’attività

sincrona di migliaia di neuroni. Il rilievo di tale attività avviene attraverso degli elettrodi

in argento rivestiti da AgCl e quindi costituisce una metodica non invasiva. Gli elettrodi

vengono posizionati a contatto della pelle nel cranio, ma, in genere, per ottenere una

maggiore facilità di utilizzo, vengono pre-posizionati su delle apposite cuffie secondo

determinati schemi.

I potenziali caratteristici di un EEG, frutto dell’attività dei neuroni, vanno dai 10 ai 150

µV. L’informazione principale di tali potenziali è la frequenza che varia nel range 0,440 Hz.

24

Le frequenze vengono divise in cinque bande associate a differenti stati mentali.

•

Delta: la frequenza varia nel range 1-3 Hz. Rilevabili nelle zone temporoparietali

dei bambini, sono spesso presenti in individui adulti sottoposti a stress

emozionale.

•

Theta: la frequenza varia nel range 4-7 Hz. Sono indice di sonno profono

dell’individuo. Presentano un’ampiezza oscillante tra 1 e 200 µV.

•

Alpha: occupano la banda 8-12 Hz. Hanno un’ampiezza che si aggira intorno ai

50 µV e sono rilevabili in zona occipitale. Corrispondono a una condizione di

veglia con occhi chiusi o ad uno stato di riposo.

•

Beta: la frequenza varia da 13 a 30 Hz. Si classificano in due diverse tipologie. Il

tipo 1 somiglia all’onda alpha successiva ad una apertura oculare mentre il tipo 2

è corrispondente ad un’attività intensa del SNC conseguente all’assunzione di

droghe.

•

Gamma: occupano il range 37-42 Hz e sono associate alla risoluzione dei

problemi e ad altre elevate attività mentali

Figura 12: Bande Beta ed Alpha: differenze in ampiezza

25

Ovviamente questi segnali devono essere letti da un dispositivo elettronico e

successivamente interpretati. La conduzione elettrica di questi segnali verso il

dispositivo di lettura avviene tramite gli elettrodi. Lo schema di posizionamento più

usato è il sistema 10-20.

Figura 13: Schema di posizionamento 10-20

Ciascun elettrodo è segnalato da una sigla che identifica la regione della corteccia su cui

è posizionato (Fp=Fronto-parietale, F=Frontale, C=Centrale, P=Parietale, T=Temporale

e O=Occipitale) e uno dei due emisferi (dispari=emisfero sinistro, pari=emisfero

destro).

Le registrazioni elettroencefalografiche fanno ricorso ad una coppia di elettrodi;

ciascuna coppia costituisce uno specifico canale per il dispositivo di lettura

corrispondente alla differenza di potenziale tra i due elettrodi.

Di consuetudine viene utilizzato un terzo elettrodo per collegare del soggetto della

registrazione a terra; questo per evitare l’effetto dannoso che possibili scariche elettriche

provenienti dall'apparecchiatura, possono avere sul corpo del soggetto.

26

2.2.1.

Il Tracciato

Come precedentemente detto, l’EEG rileva l’attività cerebrale di tipo elettrico attraverso

degli elettrodi superficiali posti sul cranio. Il cambiamento fluttuante e continuo di tale

attività provoca, tra i vari elettrodi, delle piccole differenze di potenziale che vengono

registrate nel corso del tempo. In tal modo si ottiene un tipico tracciato EEG.

Ogni elettrodo utilizzato per l’esame è indice dell’attività della zona cerebrale più vicina

e questo consente all’EEG di fornire informazioni anche sulla localizzazione. In caso di

stimolazione sensoriale o di attività psichica, i suoi risultati appaiono evidenti

all’interno del tracciato.

Figura 14: Differenze tra le bande a seconda delle condizioni dell'individuo

ed effetti sull'EEG dell'apertura degli occhi

27

Già lo stesso Hans Berger, primo studioso, agli inizi del ‘900 dell’elettroencefalografia,

notò come la sola apertura degli occhi causasse una variazione della banda alpha. Il

proseguire degli studì dimostrò, negli anni ‘70, che queste variazioni della banda alpha,

denominate ritmi µ, sono presenti sopra l’area motoria in preparazione ad un

movimento volontario (de sincronizzazione alpha).

Oltre questo, parve evidente come questo processo fosse seguito da oscillazioni della

banda beta (sincronizzazione beta). Questi due fenomeni possono, quindi essere visti

come l’inizio e la fine di un movimento da parte del soggetto. Studi recenti hanno

dimostrato come anche la sola immaginazione di tale movimento, produca questi effetti

misurabili con un EEG. Proprio su questo si basa la ricerca volta allo sviluppo delle

Brain- Computer Interface.

2.2.2. Potenziali evocati

I potenziali evocati si definiscono come la risposta cerebrale ad uno stimolo sensoriale.

Generalmente, data la bassa ampiezza, questa risposta si confonde con l'attività

elettroencefalografica di fondo. Tuttavia, se si fa la media delle risposte ad un numero

congruo di stimoli uguali, è possibile far emergere la risposta direttamente

corrispondente a quel dato stimolo. L’obiettivo di tale tipo di stimolazione è quello di

verificare la funzionalità della specifica via sensoriale analizzata.

Figura 15: Modalità di rilievo di un Potenziale Evocato

28

Esistono quindi specifici test per le varie modalità sensoriali:

Potenziali Evocati Somatosensoriali (PESS): consistono nella stimolazione

con piccole scosse elettriche del tronco nervoso. Viene utilizzato un nervo al

polso per gli arti superiori, o alla caviglia (per gli arti inferiori).

Successivamente si registra l'impulso sensitivo lungo il decorso del nervo.

Potenziali Evocati Motori: vengono eseguiti stimolando la corteccia cerebrale

o il midollo spinale con un magnete. Lo stimolo provoca una risposta motoria

che viene registrata a livello dei muscoli degli arti superiori ed inferiori con

elettrodi di superficie. Consente di valutare la funzionalità delle vie motorie.

Potenziali Evocati Acustici (PEA o BAERS): vengono eseguiti facendo

ascoltare dei toni puri da un lato e mascherando la parte opposta con rumore

bianco. Permettono di esplorare le vie acustiche nel loro percorso lungo il tronco

dell'encefalo.

Potenziali Evocati Visivi (PEV): consistono nel far fissare al soggetto uno

schermo che alterna ritmicamente un'immagine. Si registra la risposta dalle

regioni occipitali con elettrodi di superficie.

Figura 16: Rilievo di un PEV

29

Potenziali Evocati Evento-Correlati (ERPs): consistono nel far riconoscere al

soggetto degli stimoli acustici o visivi infrequenti che vengono intercalati ad

altri stimoli molto più frequenti ma con caratteristiche diverse e registrando una

specifica risposta di riconoscimento che si genera a livello cerebrale.

Figura 17: Differenza di scala tra EEG ed ERP

Le risposte elettriche relativamente piccole a eventi specifici possono essere osservate,

ad esempio, estraendo la media dei tracciati EEG su una serie di prove, ovvero facendo

ricorso alla tecnica dell’averaging. Le ampie oscillazioni di fondo dell’EEG rendono

possibile rilevare con una singola prova la risposta evocata dallo stimolo sensoriale.

Calcolando la media di molteplici successioni di stimoli uguali, il rumore di fondo

dell’EEG viene eliminato e resta soltanto il potenziale evento-correlato (ERP). Si noti in

figura 17 la differenza di scala tra le onde dell’EEG e le onde dell’ERP.

30

Figura 18: Potenziale Evocato Uditivo che evidenzia un'onda P300

In figura 18 possiamo osservare un potenziale evocato uditivo che evidenzia un’onda

P300. L’attribuzione di un significato da parte del soggetto, determina la comparsa

dell’onda o click che avvisa dell’arrivo di uno stimolo.

Convenzionalmente le onde elettroencefalografiche positive sono delle deflessioni verso

il basso.

31

CAPITOLO 3

I Sistemi BCI

Una delle direzioni più importanti che lo sviluppo tecnologico sta seguendo è quello di

fornire alle persone diversamente abili la possibilità di conquistare una maggiore qualità

della vita. Tutto ciò impiegando dispositivi di tipo elettronico che consentono una vera e

propria interazione con il mondo esterno.

Le possibilità di comunicazione offerte da una BCI consentono di interagire con il

mondo circostante anche a persone impossibilitate ad effettuare movimenti di alcun

tipo; questo a patto che il soggetto venga istruito e che sia presente un feedback

prodotto da un monitor.

In un’epoca in cui l’interazione con l’ambiente digitale che ci circonda è sempre più

complessa e frequente, il coinvolgimento sempre più diretto e attivo dell’utente è

auspicato dall’evoluzione di un nuovo progetto, ovvero la connessione tra la mente

stessa e il computer.

Di seguito verrà spiegato più in dettaglio cosa si intende per Brain-Computer Interface.

3.1. Definizione di BCI

Una Brain Computer Interface o BCI è definibile come un protocollo di comunicazione

tra sistema nervoso centrale e un dispositivo, il cui obiettivo è quello di creare una

connessione immediata tra cervello e computer.

In tal modo si offre una nuova modalità di comunicazione che non prevede l’uso

dell’apparato muscolare. Una BCI converte i comandi provenienti dal cervello in azioni

effettuabili all’interno di un computer.

32

Attualmente è già possibile controllare, sfruttando questi principi, delle protesi articolari

utilizzando rilevatori per elettroencefalogrammi. Un qualsiasi dispositivo che monitora

e registra le attività cerebrali può essere parte di una BCI.

Un algoritmo è conseguentemente deputato alla traduzione dei dati rilevati in un

linguaggio comprensibile alle macchine.

Questo principio rappresenta una notevole opportunità per persone con ridotte capacità

motorie; esso è in grado, infatti di offrire canali di comunicazione che non dipendono

dai normali canali di uscita del cervello come nervi periferici e muscoli. I segnali

cerebrali saranno utilizzati per muovere un braccio robotizzato o una neuroprotesi.

Tutto quello che una BCI esegue, è rilevare determinati pattern dal cervello,

discriminare una volontaria modifica di questi e tradurla in una specifica azione.

Ovviamente questo dispositivo ha bisogno di un’affidabile strumento per il rilievo

dell’attività mentale dell’uomo; queste possono richiedere l’uso di procedure invasive

(inserimento di elettrodi nel cervello), o essere sofisticate tecniche di brain imaging. Per

progettare una BCI è necessario valutare, tra tutte le modalità descritte nel capitolo 2,

quale sia la più adatta.

Figura 19: Scopo di una BCI

33

3.2. Scelta del sistema di rilievo

Con il termine Brain Imaging, abbiamo detto che si intendono tutte le tecniche di analisi

cerebrale nelle sue componenti funzionali e strutturali. Le immagini sono ottenute in

modo non invasivo e con tali metodi sono stati raggiunti sviluppi importanti per la

prevenzione e la diagnosi di patologie neurologiche e psichiatriche.

I dispositivi MEG e fMRI sono molto voluminosi e costosi e limitano le loro

applicazioni in ambienti specializzati. I NIRS hanno dimensioni più ridotte e sono meno

costosi e si basano, come già detto, sulla risposta dinamica del flusso sanguigno

cerebrale. Questo rende il processo di analisi più lungo e non adatto ad applicazioni in

tempo reale, prerequisito essenziale per costituire una BCI.

Tra i parametri descrittivi di una immagine, infatti, è importante ricordare la risoluzione

spaziale e quella temporale.

Per risoluzione spaziale, si intende la possibilità di distinguere oggetti piccoli e

ravvicinati (ad esempio un sistema di barre nere alternate a spazi chiari). Questo tipo di

risoluzione viene normalmente espressa nel dominio della frequenza spaziale (cl/mm).

Si definisce risoluzione spaziale di un sistema d’imaging, il massimo numero di coppie

di linee per unità di distanza che possono essere contate correttamente.

La risoluzione temporale di una tecnica di immagine, invece, indica quante immagini

possono essere acquisite nell’intervallo di tempo ed è ovviamente dipendente dal tempo

richiesto per l’acquisizione di una singola immagine.

PET, SPECT e fMRI sono tecniche caratterizzate da un’elevata risoluzione spaziale, ma

hanno l’inconveniente di avere una bassa risoluzione temporale.

Questo non accade con EEG e MEG, caratterizzate da elevata risoluzione temporale che

permette di seguire l’evoluzione dei processi nervosi. Tali processi costituiscono la base

per un’analisi dell’informazione sensoriale o della nascita di un programma motorio.

Queste tecniche consentirebbero, inoltre, di avere apparecchiature meno ingombranti.

I segnali MEG hanno il vantaggio di non essere influenzati dalle proprietà dielettriche e

resistive dei tessuti e non hanno bisogno di un potenziale di riferimento elettrico.

Questo lascerebbe pensare che sia il sistema più adatto per costruire una BCI. In verità

questo presenta diversi limiti. Primo tra tutti il numero eccessivamente basso di siti di

registrazione simultanea. In secondo luogo il notevole impegno in termini di tempo e di

34

strutture hardware e software di cui la mappatura delle sorgenti dei campi magnetici

necessita. In ultimo l’alto costo delle attuali tecnologie di registrazione.

Seppur il segnale elettroencefalografico sia di difficile analisi poiché i fenomeni di

interesse sono completamente immersi nell’EEG di fondo, la sua non invasività, la

facile reperibilità e il suo semplice utilizzo hanno fatto sì che le ricerche si dirigessero

verso l’analisi e l’approfondimento di questa tecnica di acquisizione. L’obiettivo è

quello di riconoscere lo stato mentale del soggetto tramite il segnale EEG; questo

garantirebbe la costruzione di un dispositivo portatile utilizzabile come Brain-Computer

Interface. Quest’ultima può sottoporre i dati EEG a una serie di processamenti che ne

estraggono degli indici qualitativi. La loro variazione nel tempo è usata come input per

algoritmi di decisione frutto dello stato mentale del soggetto.

Ovviamente l’EEG deve essere sensibile all’immaginazione di atti motori, deve cioè

poter variare durante un compito immaginativo rispetto a una situazione di riposo. Una

BCI basata su una attività endogena e cioè su attività elettroencefalografica generata

internamente al soggetto, consente all’utente, dopo un periodo di addestramento, la

generazione autonoma di pattern per la comunicazione e il dialogo.

Rilevante ai fini della comunicazione corretta, è l’utilizzo di un feedback per consentire

al soggetto di modulare il proprio EEG facendo ricorso al canale visivo. L’utente non fa

altro che imparare a modificare le composizioni elettriche della sua attività cerebrale.

L’interazione diretta necessita l’acquisizione e l’analisi dei segnali in tempo reale così

da permetere un’istantanea interpretazione.

Analizziamo ora la struttura di una Brain- Computer Interface.

3.3. Struttura di una BCI

Per comprendere come una BCI si sviluppi, è molto utile fare riferimento ad uno

schema a blocchi (figura 20). La prima parte è costituita da un sistema di acquisizione

che permette di registrare l’attività cerebrale del soggetto. In secondo luogo, i segnali

devono essere pre-elaborati in modo tale da eliminare gli artefatti costituiti dall’attività

oculare o muscolare. Successivamente, mediante l’analisi e la traduzione, vengono

estratte le caratteristiche rilevanti ai fini dell’invio di comandi e controlli.

35

Acquisizione dei

segnali

Preelaborazione

dei segnali

Analisi e

classificazione

Traduzione

DISPOSITIVO

CONTROLLATO

UTENTE

Figura 20:: Schema a blocchi del percorso del segnale in una BCI

Ovviamente per capire l’importanza di ciascuno step, è utile considerarli singolarmente.

Come precedentemente affermato, il metodo di rilievo più adatto per la costruzione di

una BCI è quello della elettroencefalografia; scomponiamo

scomponiamo il percorso del segnale

acquisito proprio con tale tecnica.

tecnica

3.3.1.

Acquisizione dei segnali EEG

Il sistema

stema di acquisizione di una BCI ne determina sicuramente la qualità. Nel capitolo

precedente

abbiamo

ampiamente

descritto

i

principi

sui

quali

si

basa

l’elettroencefalografia.

I segnali EEG, tuttavia, necessitano di molteplici operazioni prima di poter essere

tradotti in comandi o controlli per il dispositivo. Prima tra tutti, è l’amplificazione dei

segnali stessi. I deboli segnali elettrici provenienti dagli elettrodi, devono essere

amplificati per poter essere letti con una risoluzione maggiore. In questa operazione

viene utilizzato

to un amplificatore per strumentazione realizzato sulla base di un semplice

amplificatore differenziale. Esso è un tipo di amplificatore capace di fornire in uscita

un segnale pari alla differenza dei segnali ai suoi due ingressi. È caratterizzato da una

elevata precisione e una bassa tolleranza agli errori. Il suo massimo impiego è la

misurazione di segnali di debole entità. La caratteristica fondamentale di questo tipo di

amplificatore è la capacità di eliminare l’effetto di disturbo comune ai due ingressi.

ingres Ciò

permette di migliorare le qualità del segnale amplificato,

amplificato eliminando le interferenze

36

elettromagnetiche comuni ai due ingressi. Questo tipo di insensibilità alla componente

di segnale comune presente contemporaneamente ai due ingressi, è denominata rapporto

di reiezione in modo comune o CMRR, inversamente proporzionale all'amplificazione

in modo comune. Una minore amplificazione di modo comune è un fattore positivo

poiché correlato all’amplificazione delle interferenze trasportate, quindi un rapporto di

reiezione del modo comune alto è una caratteristica positiva per un amplificatore.

Il secondo step dell’acquisizione dei segnali EEG, si identifica in un primo filtraggio

passa alto (AC-coupler o accoppiatore in alternata) che elimina l’eventuale componente

continua presente nel segnale di polarizzazione degli elettrodi. Tale componente, se

successivamente amplificata, causerebbe la saturazione degli amplificatori.

Nei moderni EEG è presente il DRL o Driven Right Leg, realizzato da un integratore

invertente, che permette di isolare il paziente da scariche di corrente pericolose se

collegato direttamente a massa.

Il range di frequenze indesiderate maggiori di quelle elettroencefalografiche vengono

eliminate con un filtraggio passa basso conseguente alla prima amplificazione del

segnale, che consente di eliminare anche gli effetti di aliasing durante il

campionamento. Questo è l’ultimo step che il segnale percorre prima dell’elaborazione.

Il campionamento viene effettuato facendo ricorso ad un convertitore analogicodigitale; il segnale viene quantizzato in una serie di bit interpretabili da un dispositivo

elettronico.

Ovviamente bisogna evitare effetti indesiderati di campionamento, rispettando la regola

che impone una frequenza di campionamento minimo due volte superiore della

larghezza di banda del segnale da campionare (come noto, nel caso di un segnale EEG

la larghezza di banda è di circa 40Hz).

La qualità del segnale digitalizzato dipende in principal modo dalla risoluzione di

quantizzazione, cioè dal numero di bit utilizzati per rappresentare un valore di tensione,

e dalla frequenza di campionamento. Maggiore è la quantizzazione e migliore è la

risoluzione.

Dopo il campionamento, il segnale viene trasmesso ad un computer o ad un dispositivo

hardware/software per l'elaborazione.

37

3.3.2.

Preprocessamento del segnale

Dopo l’acquisizione, il nostro segnale può subire una elaborazione iniziale. In questa

fase verranno identificati ed eliminati particolari tipi di interferenze e artefatti di origine

cardiaca, oculare o muscolare. Questi ultimi verrebbero sicuramente individuati

all’interno del tracciato elettroencefalografico da personale specializzato, ma ciò

impedirebbe una loro eliminazione in tempo reale. L’artefatto più rilevante, è stato

dimostrato essere quello derivante dal movimento oculare e dal battito delle palpebre.

Figura 21: Tracciato privo di artefatti

Figura 22: Tracciato con artefatto oculare

38

L’aumento di potenziale provocato tra cornea e retina è di circa 100 mV; ciò comporta

notevoli scostamenti in ampiezza e in frequenza che impediscono una normale lettura

del traccia EEG.

Come vedremo più approfonditamente nei capitoli 4 e 5, esistono vari metodi per la

rimozione di questi disturbi alla lettura. Questi si classificano in procedure di reiezione e

di sottrazione. Le prime consistono nello scartare parte del tracciato EEG contaminato

dagli artefatti, in base a individuazioni automatiche o visuali. Le seconde interpretano il

tracciato EEG come sintesi del segnale elettroencefalografico vero e proprio, e dei

segnali generati da fonti di disturbo; un elettrooculogramma consente il rilievo del

segnale relativo al movimento oculare che, tramite sottrazione, viene eliminato.

Tuttavia, nuovi metodi basati sulla Blind Source Separation, o separazione cieca delle

sorgenti, consentono, giustappunto, la separazione delle attività cerebrali da quelle

oculari o muscolari nelle registrazioni EEG.

3.3.3.

Analisi, classificazione e traduzione

Questo step del percorso del segnale è deputato all’analisi e all’estrazione delle

caratteristiche di interesse. Nelle rilevazioni dell'attività cerebrale nella banda µ nella

corteccia sensomotoria, vengono adottate tecniche di trasformazione del segnale nel

dominio delle frequenze, utilizzando, ad esempio, la trasformata di Fourier. La

trasformata di Fourier permette di rappresentare un segnale tempovariante come

sommatoria di sinusoidi a frequenze differenti con le relative fasi e ampiezze.

Le Brain Computer Interface fanno ricorso a trasformate nel dominio discreto del

tempo. Ciò permette di avere una rappresentazione frequenza/ampiezza del segnale

elettroencefalografico. Questa trasformata consente di ottenere, inoltre, lo spettro del

segnale e cioè una sua rappresentazione bidimensionale.

Un segnale può essere quindi analizzato in ampiezza a seconda della frequenza di

interesse; nel caso delle onde µ, le frequenze d'interesse variano da 8 a 13 Hz con un

picco a 9,1 Hz. Con una sessione di training, un soggetto ha la possibilità di controllare

l'ampiezza di questo intervallo di frequenze, ed è quindi in grado di utilizzare

quest'abilità per il controllo unidimensionale di un dispositivo (il cursore del mouse è il

dispositivo maggiormente utilizzato inizialmente).

39

Esiste, oltretutto, la possibilità di controllare dispositivi bidimensionali, misurando le

differenze tra i due emisferi. Controllando le onde che arrivano da uno o dall'altro

emisfero c'è la possibilità di muovere un dispositivo in 2 dimensioni migliorando

notevolmente l'uso pratico in un sistema BCI. Questi rilievi necessitano dell’utilizzo di

filtri spaziali in grado di determinare la posizione dell’attività cerebrale. Le

caratteristiche estratte sono soggette a traduzione in modo tale da inviare controlli al

cursore di un mouse come anche ad una protesi artificiale.

40

CAPITOLO 4

I potenziali Evento-Correlati

Come abbiamo approfondito nel capitolo 2, il tracciato elettroencefalografico può essere

visto come une rilevazione dell’attività elettrica cerebrale di tipo spontaneo e cioè non

associata ad un particolare evento. Si è anche visto che è possibile rilevare un’attività

cerebrale in risposta ad un determinato stimolo facendo riferimento ai potenziali

evocati. Per ciascuna stimolazione sensoriale, infatti, il cervello risponde con onde

rilevabili dal tracciato EEG. Studi sperimentali hanno provato che un dato potenziale

compare dopo intervalli all’incirca costanti dallo stimolo. L’ampiezza di tale risposta è,

tuttavia, di entità troppo ridotta rispetto all’attività rilevata dall’intero tracciato

elettroencefalografico. Diventa perciò indispensabile elidere le oscillazioni casuali e

indipendenti dalla zona di interesse. Dal tracciato si estrae quindi la risposta media di

una serie di risposte singole in modo tale da cancellare le variazioni di potenziale che

non sono sincronizzate con lo stimolo e da sommare quelle sincronizzate a condizione

che siano in fase. Dopo una serie di operazioni è possibile evidenziare questa onda

evocata media all’interno dell’intera attività rilevata. Questa sarà rappresentata da un

picco con polarità positiva o negativa.

Come già descritto in precedenza, i potenziali evocati possono essere stimolo-correlati o

evento-correlati. I primi dipendono esclusivamente dalle caratteristiche dello stimolo

agente sul soggetto, mentre i secondi sono legati al contesto psicologico del soggetto.

Questi potenziali sono delle vere e proprie modificazioni elettriche conseguenti ad un

determinato stimolo esterno. Nei potenziali evocati stimolo-correlati, queste

modificazioni sono delle risposte obbligate. I potenziali evento-correlati, a differenza

dei precedenti, sono dipendenti dal contenuto informativo dello stimolo. Essi

compaiono solo se il soggetto è attento allo stimolo o se è attribuito un significato.

41

Le neuroscienze cognitive hanno approfondito, proprio per questo motivo, gli studi su

questa tipologia di potenziali in quanto esse ambiscono, come già sappiamo, a correlare

le funzioni cognitive con le corrispondenti attività cerebrali.

Gli ERPs consistono quindi in delle variazioni dell’EEG. Le oscillazioni di potenziale e

le forme d’onda con deflessioni positive e negative, vengono definite componenti EEG.

La distribuzione dei campi superficiali dipende dall’area corticale attivata. La sede delle

componenti consente di determinare quale area corticale sia attiva in seguito ad una data

stimolazione. I potenziali evento correlati

sono, quindi,

manifestazioni nervose

correlate a stadi specifici della trasmissione e dell’elaborazione dell’informazione.

La problematica della localizzazione delle fonti , e quindi la localizzazione del tessuto

cerebrale attivo, è molto ostica dal punto di vista operativo. Certamente l’integrazione

dell’EEG con altri metodi di visualizzazione funzionale può ridurre notevolmente tale

problema, acuendone però degli altri. In modo molto generale, un ERP è un’attività

neuronale generata quando viene eseguita una determinata funzione. Lo studio degli

ERPs permette di rendere evidente la correlazione tra i segnali registrati e gli stimoli

basandosi sulla variazione del segnale elettrofisiologico che avviene come conseguenza

dello stimolo.

Gli ERPs possono, inoltre, essere considerati come degli indicatori di particolari

condizioni psico-fisiologiche.

Andiamo a descriverne i parametri fondamentali. La latenza indica la distanza, in

termini temporali, tra il momento di applicazione dello stimolo e la comparsa del

potenziale evento correlato. La topografia, invece, indica la posizione sulla superficie

cranica dove la componente è rilevabile con ampiezza maggiore. L’ampiezza, infine,

rappresenta la deflessione della componente rispetto alla condizione di base.

Lo studio dei potenziali evento-correlati impone di tener conto di diversi aspetti onde

ottenere segnali che rispecchino realmente l’attività cerebrale. Riassumiamo i vari

aspetti.

1. Distinguere i picchi dalle componenti

2. Osservando una sola onda, è impossibile valutare la latenza di un picco

3. Diverse ampiezze di picchi o latenze non corrispondono a una diversità di

dimensioni delle componenti o a una loro differente tempistica.

42

L’aspetto principale del loro studio è comprendere come le diverse componenti siano

collegate alle varie funzioni cerebrali.

4.1. Le componenti ERP

Figura 23. Principali componenti ERPs

P1: si trova approssimativamente 50 ms dopo l’inizio dello stimolo uditivo, dopo 100

ms se lo stimolo è di tipo visivo. Questa componente è interpretata, dal punto di vista

funzionale, come un indicatore di attenzione allo stimolo sensoriale.

Per quanto riguarda uno stimolo uditivo, è rilevata con un’ampiezza maggiore nelle

regioni frontali. La stimolazione uditiva provoca la registrazione di tale componente

nelle regioni occipitali.

N1: si presenta dopo 100 ms dall’inizio dello stimolo visivo e ha la sua massima

ampiezza nelle zone frontali. La N1 visiva è più ampia nella regione occipitale e si

riduce quando gli stimoli sono presentati a brevi intervalli temporali.

43

P2: varia poco da individuo a individuo ed è individuata tramite diversi task cognitivi

come quelli di attenzione selettiva e memoria a breve termine. La P2 uditiva è

caratterizzata da un’ampiezza maggiore nelle regioni frontali e tale ampiezza aumenta

all’aumentare dell’intensità dello stimolo. La corteccia uditiva è stata stimata essere la

principale sorgente di questa componente che nel caso di una stimolazione visiva ha una

latenza di 150 ms.

N2: varia molto da individuo a individuo. Un possibile significato psicologico può

essere la cognizione dello stimolo o la selezione di un particolare target. La sorgente di

questa componente è localizzata nella corteccia sopratemporale e nel caso di stimoli

uditivi l’ampiezza aumenta in regione preoccipitale.

Sia per i task visivi che uditivi, la N2 è rilevabile più facilmente dagli elettrodi

frontocentrali.

MNM: è caratterizzata da una latenza che va dai 100 ai 250 ms. E’ più ampia in zona

frontocentrale. Per stimolazioni uditive, è conseguenza di una variazione tonale,

frequenziale o di intensità. In caso di stimolazione uditiva, è un indice di rifiuto

automatico rispetto a stimoli inusuali o di scarsa rilevanza che differiscono per qualche

fattore, come ad esempio la frequenza, dalla sequenza di stimoli standard.

Figura 24: ERPs di origine uditiva

44

N400: È caratterizzata da una latenza di 400 ms ed è correlata a task di comprensione

sia uditiva che visiva oltre ad essere un indice di incongruenza semantica. Il paziente è

sottoposto alla visione di frasi in cui l’ultima parola è semanticamente scorrelata

rispetto alle altre. E’ una componente rilevabile anche quando vengono fatte visionare

immagini incongruenti rispetto al significato della frase o quando in essa sono presenti

errori.

Figura 25: Evidenza di una componente N400

P600: Presenta interpretazioni legate sia alla memoria che al linguaggio. Per la

relazione con la memoria è soggetta ad una latenza di 400 ms e la zona temporoparietale

sinistra rappresenta la sorgente in cui si rileva con maggior ampiezza.

P300: La P300 e’ una componente ERP endogena (si osserva anche in assenza di

stimolo) che compare in risposta a stimoli rilevanti ma rari. E’ senza dubbio quella più

studiata. Ha una latenza di 300 ms ed è localizzata in zona parietale. Per la sua

visualizzazione, è necessario che il soggetto sia concentrato sullo stimolo poiché è

dipendente dall’attenzione.

45

L’ampiezza della P300 e’ maggiore quanto e’ minore la probabilità di comparsa dello

stimolo. Inoltre, la sua latenza e’ funzione del tempo necessario per analizzare lo

stimolo.

La P300 rifletterebbe il cambiamento o l’ aggiornamento del modello interno con cui il

soggetto svolge il compito e interagisce con gli stimoli esterni. E’ più frequente in

corrispondenza delle regioni parietali, centrali e frontali.

Descriviamo di seguito una procedura per individuare la componente P300.

Al soggetto viene fatto visionare lo schermo del computer in cui compare una matrice

6x6 di caratteri alfabetici. Successivamente viene chiesto all’utente di selezionare una

particolare lettera utilizzata come target. Le righe e le colonne della matrice vengono

fatte lampeggiare in modo sequenziale in modo tale che il soggetto possa contare quante