4 - TRASFORMAZIONI DI VARIABILI CASUALI

4.3

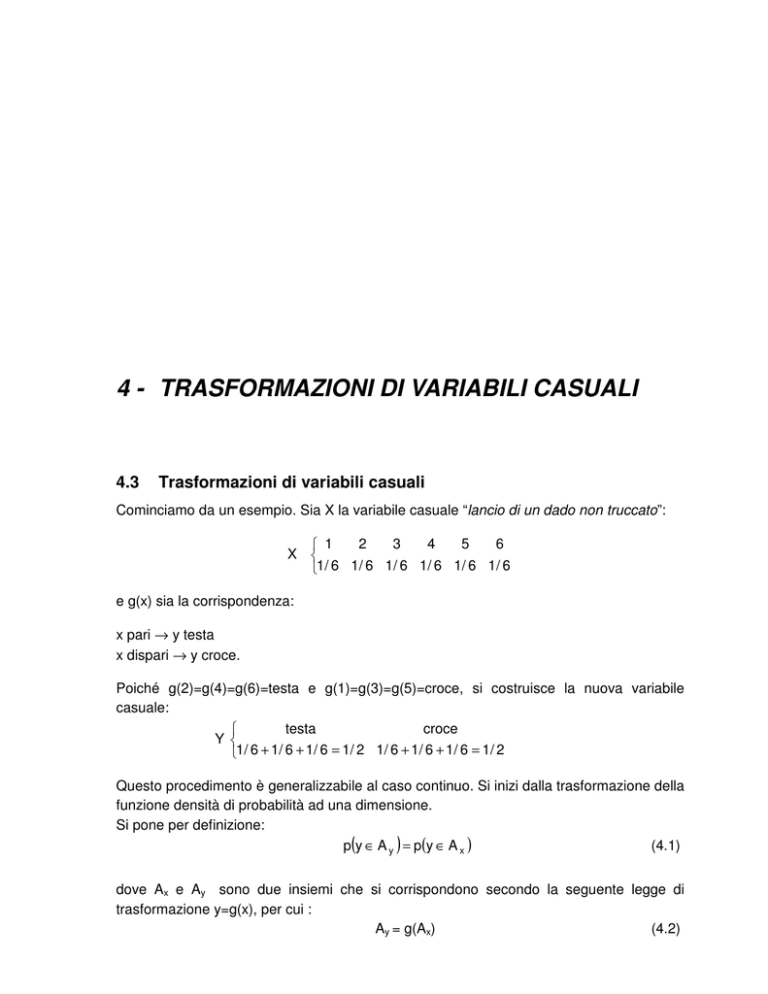

Trasformazioni di variabili casuali

Cominciamo da un esempio. Sia X la variabile casuale “lancio di un dado non truccato”:

2

3

4

5

6

1

X

1/ 6 1/ 6 1/ 6 1/ 6 1/ 6 1/ 6

e g(x) sia la corrispondenza:

x pari → y testa

x dispari → y croce.

Poiché g(2)=g(4)=g(6)=testa e g(1)=g(3)=g(5)=croce, si costruisce la nuova variabile

casuale:

testa

croce

Y

1/ 6 + 1/ 6 + 1/ 6 = 1/ 2 1/ 6 + 1/ 6 + 1/ 6 = 1/ 2

Questo procedimento è generalizzabile al caso continuo. Si inizi dalla trasformazione della

funzione densità di probabilità ad una dimensione.

Si pone per definizione:

(4.1)

p(y ∈ A y ) = p(y ∈ A x )

dove Ax e Ay sono due insiemi che si corrispondono secondo la seguente legge di

trasformazione y=g(x), per cui :

Ay = g(Ax)

(4.2)

4 – Trasformazioni di variabili casuali

___________________________________________________________________________________________

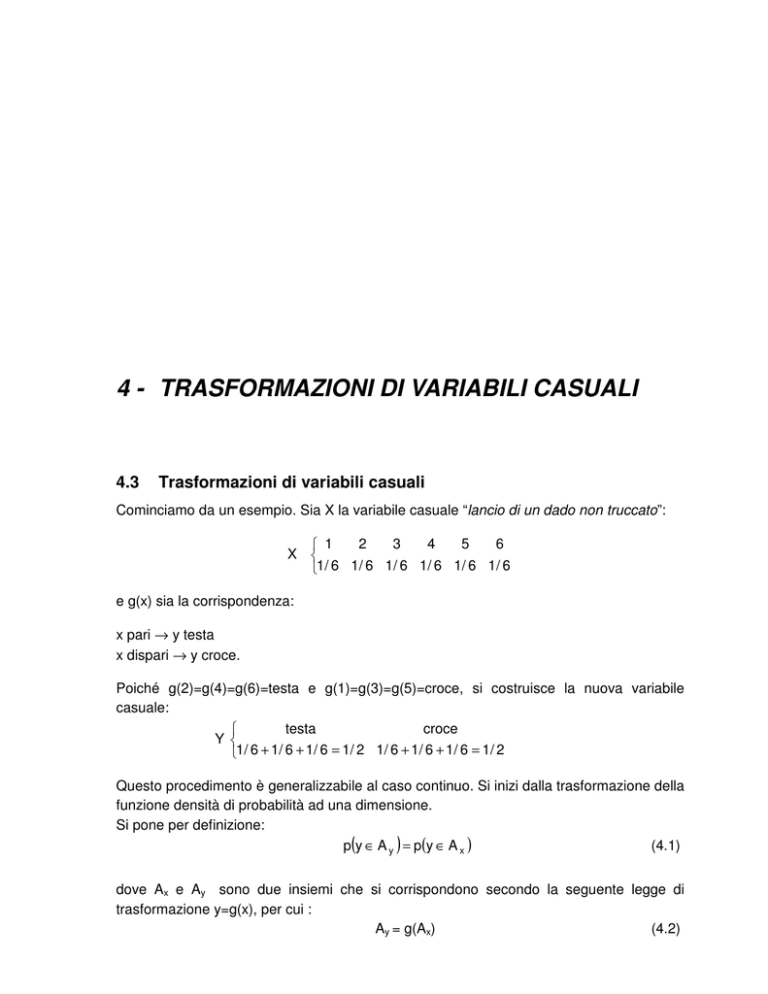

Si osservi la figura seguente e si ipotizzi la funzione di trasformazione monotona

crescente oltre che differenziabile:

Figura 1 – Trasformazione di densità di probabilità in conseguenza della trasformazione y=g(x) sulla v.c.

p(y ∈ dy) = p(x ∈ dx)

(4.3)

e quindi si ottiene:

f y ( y )dy = f x ( x )dx .

(4.4)

Per l’ipotesi di differenziabilità della funzione di trasformazione, si può scrivere:

dy = g' ( x )dx

(4.5)

e, conseguentemente, si ottiene:

f y ( y )g' ( x )dx = f x ( x )dx

fy (y) =

fx (x)

.

g' ( x )

(4.6)

Se la funzione è decrescente, la formula diventa:

fy (y) = fx (x)

dx

dy

(4.7)

4 – Trasformazioni di variabili casuali

___________________________________________________________________________________________

Esempio 1

Sia data una variabile casuale con funzione densità di probabilità:

f (x) = e −x

( x ≥ 0)

Si cerca la funzione densità di probabilità f(y) di una nuova variabile casuale

y, ottenuta dalla precedente secondo la relazione y = x con y ≥ 0 .

Si applica la formula appena studiata:

fy (y) =

fx (x)

.

g' ( x )

2

Poiché se y = x , allora x = y2, la densità di probabilità f(x) diventa f ( x ) = e − y ,

mentre g' ( x ) =

1

2 x

diventa

1

, sicché:

2y

f y ( y ) = 2 y e −y

2

y ≥0.

Nella figura che segue si può osservare la rappresentazione grafica di f x ( x ) = e − x

e di f y ( y ) = 2 y e − y

2

.

73

4 – Trasformazioni di variabili casuali

___________________________________________________________________________________________

4.3

Teorema della media

Si consideri la funzione di trasformazione e la relazione che definisce la trasformazione

delle funzioni di densità di probabilità, e si applichi la definizione di media:

b

d

a

c

y = E[y ]=∫ y f y ( y )dy = ∫ g( x )

fx ( x)

g' ( x ) dx = E[g( x )] ≠ g( x )

g' ( x )

(4.8)

Tale diseguaglianza è valida sempre eccetto che nel caso lineare.

Corollario1

L’operazione della media è un’operazione lineare.

Infatti se:

y = ax + b

(4.9)

allora:

d

b

y = ∫ yf y ( y )dy = ∫ (ax + b )

c

a

b

b

fx ( x)

a dx = a ∫ xf x ( x ) dx + b ∫ f x ( x )dx = ax + b.

a

a

a

(4.10)

Tale relazione dimostra che la media è un’operazione lineare, cioè la media della variabile

casuale trasformata y è pari alla funzione della media della variabile casuale originaria x.

Corollario 2

Sotto determinate ipotesi, si può linearizzare la funzione ed ottenere una formula

approssimata∗:

(4.11)

y ≅ g( x )

Infatti:

(4.12)

y = g( x ) + g' ( x )( x − x ) + θ( x )

d

b

c

a

y = ∫ yf y ( y )dy = ∫ (g( x ) + g' ( x )( x − x ))

b

b

fx (x)

g' ( x )dx =

g' ( x )

b

b

= ∫ g( x )f x ( x )dx + ∫ g' ( x )( x − x )f x ( x )dx = g( x ) ∫ f x ( x )dx +g' ( x ) ∫ ( x − x )f x ( x )dx = g( x )

a

a

a

a

(4.13)

b

b

in quanto ∫ f x ( x )dx = 1 (condizione di normalizzazione) e inoltre ∫ ( x − x )f x ( x )dx = 0 , poiché

a

a

la media degli scarti rispetto alla media vale zero.

Le ipotesi adottate sono che la funzione densità di probabilità sia concentrata in un

determinato intervallo, per esempio nell’intervallo a÷b intorno alla media, e che in quel

intervallo, la funzione g(x) abbia un andamento regolare.

∗

per ragioni di semplicità di scrittura la media viene qui indicata con y invece che con µ

y

4 – Trasformazioni di variabili casuali

___________________________________________________________________________________________

4.3

Legge di propagazione della varianza

Si considerino le relazioni di trasformazione lineare e linearizzata:

y = ax + b

(4.14)

y = g( x ) + g' ( x )( x − x ) + θ( x )

(4.15)

Si utilizzi la relazione linearizzata:

d

b

b

fx ( x)

2

2

g' ( x )dx = [g' ( x )] ∫ ( x − x ) 2 f x ( x )dx = [g' ( x )] σ 2x

g' ( x )

c

a

a

(4.16)

Utilizzando l’espressione lineare si ottiene ovviamente:

σ 2y = ∫ ( y − y ) 2 f y ( y )dy = ∫ (g( x ) 2 + g' ( x )( x − x )) 2

σ2y=a2 σ2x.

(4.17)

Esempio 2

Data la variabile casuale discreta:

1

− 2 −1 0

X=

1/ 6 1/ 6 1 3 1 3

e la nuova variabile casuale y = 1 − x 2 , si valuti se si può applicare la formula

approssimata per la media.

In primo luogo si costruisca la nuova variabile casuale y:

X

-2

-1

0

1

Y

-3

0

1

0

La nuova distribuzione di probabilità è:

0

1

− 3

Y=

1/ 6 (1/ 6 + 1 3) 1 3

Si calcola ora la media di X:

µ x = −2 ⋅

1

1 1

1

− 1⋅ + = − .

6

6 3

6

75

4 – Trasformazioni di variabili casuali

___________________________________________________________________________________________

Si calcola la media utilizzando la distribuzione di Y:

µy = −

3 1

1

+ =−

6 3

6

Si utilizzi il teorema dell media:

µ x = E x {g( x )} = (1 − 4) ⋅

1

1

1

1

1

+ (1 − 1) ⋅ + (1 − 0) ⋅ + (1 − 1) ⋅ = −

6

6

3

3

6

Il valore, come previsto dal teorema, corrisponde a quello esatto, ottenuto

dall’applicazione dell’operatore E alla funzione y, E(y).

Si calcola infine µ x con l’uso della formula approssimata:

µ y ≈ g(µ x ) = 1 − µ 2x = 1 −

1 35

=

36 36

Il valore, in questo caso, non corrisponde a quello calcolato in precedenza. Si

osserva infatti che la funzione g(x) non è variabile lentamente nell’intervallo di

definizione delle x, quindi non esistono neppure le condizioni per la

linearizzazione intorno a µ x .

4.4

Legge di propagazione della covarianza

Si opera una generalizzazione del risultato precedente, supponendo sia data una

trasformazione del tipo:

Y=G(X),

(4.18)

in cui G indica un vettore di trasformazioni ed Y un vettore di trasformate:

y 1 = g1( x 1...x m )

y 2 = g 2 ( x 1...x m )

Y=

.....

.......

y m = gm ( x 1...x m )

(4.19)

e in cui, per ipotesi, la dimensione di X sia uguale a quella di Y e inoltre la trasformazione

sia tale che il determinante dello Jacobiano sia diverso da zero (trasformazione regolare).

4 – Trasformazioni di variabili casuali

___________________________________________________________________________________________

Nel caso di trasformazioni regolari è definibile la trasformazione inversa X=G-1 (Y); inoltre

per il Teorema di Conservazione delle Probabilità Elementari:

f (y ) dVy = f (x ) dVx .

(4.20)

Si sa inoltre che, come nel caso monodimensionale, se y=g(x), allora dy = g' ( x )dx e cioè

a dx corrisponde un elemento infinitesimo dy=dy/dx dx, così nel caso a n dimensioni, a

dVy corrisponde il prodotto tra il determinante jacobiano e dVx, per noti teoremi di Analisi,

sicché:

dVy = det J(x ) dVx

f (y ) =

(4.21)

f (x )

.

det [J(x )]

Ci si chiede come sia distribuito il vettore Y, conoscendo la distribuzione del vettore X.

Sussiste il Teorema della Media per variabili causali a n dimensioni:

E[Y ] = E[G(X )].

(4.22)

Oltre alla media, si possono definire i momenti di una variabile casuale a n dimensioni, si

possono definire i momenti centrali, cioè quelli rispetto alla variabile scarto, e tra i vari

momenti sono importanti quelli del secondo ordine:

[(

)]

)(

c ik = E x i − µ xi x i − µ xi .

(4.23)

I coefficienti vengono detti coefficienti di covarianza. Ovviamente si può utilizzare

l’espressione matriciale:

{[(

)(

C xx = [c ik ] = E x i − µ xi x k − µ xk

)]} = E[(x − µ x )(x − µ x )T ]

(4.24)

in cui C è la cosiddetta matrice di varianza covarianza.

Si introduca il vettore dei residui:

Vy = Y − Y .

(4.25)

Si ipotizza che il sistema delle trasformazioni sia linearizzabile:

( ) ( ) (X − X) + θ(X) ≅ G(X) + J(X) (X − X)

VY = G(X ) + J(X ) (X − X ) − G(X ) = J(X ) (X − X )

Y =G X +J X

( )

in cui J X indica la matrice jacobiana calcolata con i valori medi del vettore X.

77

(4.26)

(4.27)

4 – Trasformazioni di variabili casuali

___________________________________________________________________________________________

Applicando l’operatore E, ai singoli elementi del vettore residui, si può ottenere la matrice

di varianza covarianza:

[ ( ) (X − X) (X − X) J(X) ] =

= J(X ) E[(X − X ) (X − X ) ] J(X ) = J(X ) E[V V ] J(X )

[

]

T

C yy = E Vy VyT = E J X

T

T

T

X

( )

T

X

T

=

(4.28)

T

( )

= J X C XX J X

Se il sistema di trasformazione è lineare, si ottiene:

Y = AX + B

JX =A

( )

T

J(X ) = A T

C YY = AC XX A T

(4.29)

Si abbia, a titolo di esempio, la seguente trasformazione:

u = ax + by

v = cx + dy

che in forma matriciale corrisponde a:

u a b x

v = c d y .

Risulta allora Y=AX, in cui:

σ2

C XX = x

σ xy

σ xy

a b

a c

A=

AT =

2

σ y

c d

b d

e quindi:

2

a b σ x

C yy =

c d σ xy

σ xy

σ 2y

2

a c a b aσ x + bσ xy

=

b d c d aσ + bσ 2

xy

y

a 2 σ 2x + 2abσ xy + b 2 σ 2y

=

2

acσ xy + adσ xy + bcσ xy + bdσ y

cσ 2x + dσ xy

=

cσ xy + dσ 2y

acσ 2x + adσ xy + bcσ xy + bdσ 2y σ u2

=

c 2 σ 2x + 2cdσ xy + d2 σ 2y

σ uv

σ uv

.

σ 2v

Ponendo a = 1 e b = ±1, e considerando solamente per esempio la varianza di u, si

ottiene la legge di propagazione per la somma e la differenza:

σ u2 = σ 2x ± 2σ xy + σ 2y .

(4.30)

4 – Trasformazioni di variabili casuali

___________________________________________________________________________________________

Si osservi ora la covarianza tra le variabili u e v:

σ uv = acσ 2x + (ad + bc )σ xy + bdσ 2y .

(4.31)

La covarianza è diversa da zero, anche qualora la σ xy sia uguale a zero: ciò significa che

anche operando esperimenti indipendenti che forniscono x ed y, non è detto che i risultati

ottenuti da essi tramite certe leggi risultino indipendenti, a meno che non si utilizzino

trasformazioni ortogonali che conservino le indipendenze.

Spesso è importante propagare la varianza di una sola osservazione, determinata

indirettamente con svariate misure indirette: si tratta della cosiddetta Legge di

propagazione degli errori.

Esempio 3

Di un punto P sono misurate la distanza dall’origine d e l’anomalia θ.

y

P

d

θ

O

x

Le misure sono indipendenti e valgono:

d= 1km±1mm

θ=π/6±2.10-6 rad.

Si vogliono determinare la media e la matrice di varianza-covarianza delle

coordinate del punto P, x ed y.

Indichiamo con:

x

d

Y=

, X= .

y

θ

La matrice di varianza-covarianza delle misure è, per ipotesi:

C xx =

σ 2d

0

0

σ 2θ

=

79

1

0

.

0 4.10 −2

4 – Trasformazioni di variabili casuali

___________________________________________________________________________________________

La relazione tra X ed Y vale:

Y = G( X) =

d cos θ

.

d sin θ

Dato che la X è concentrata intorno alla media, si può usare il corollario del

Teorema della Media:

Y = G( X) =

d cos θ

d sin θ

=

866025 mm

500000 mm

.

Inoltre si calcoli lo Jacobiano di Y rispetto a X:

Ιµ =

cos θ − d sin θ 0,866 − 10 6 ⋅ 0,500

=

sin θ d cos θ

0,500 10 6 ⋅ 0,866

e si applichi la Legge di Propagazione della Covarianza:

C yy =

=

σ 2X

σ XY

0

0,866

0,500

σ XY 0,866 − 10 6 ⋅ 0,500 1

=

=

−12

6

2

6

− 10 ⋅ 0,500 10 6 ⋅ 0,866

σY

0,500 10 ⋅ 0,866 0 4.10

1,750 − 1,299

.

− 1,299 3,250

Si noti che la covarianza di d e θ è nulla, mentre la covarianza tra X ed Y è

diversa da zero: anche se per ipotesi le misure sono stocasticamente

indipendenti, ciò non è vero per le coordinate del punto P, come era facile da

immaginare.