QUANTIZZAZIONE, COMPLEMENTARITA’, PROBABILITA’: QUANDO DIO GIOCA A DADI

FISICA

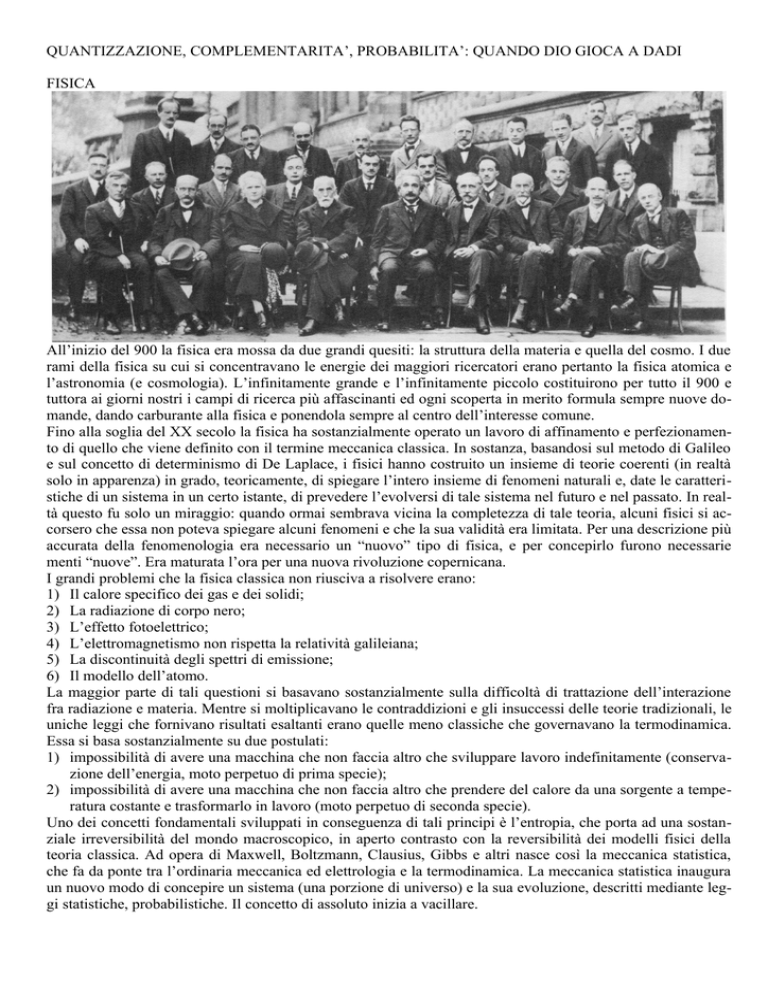

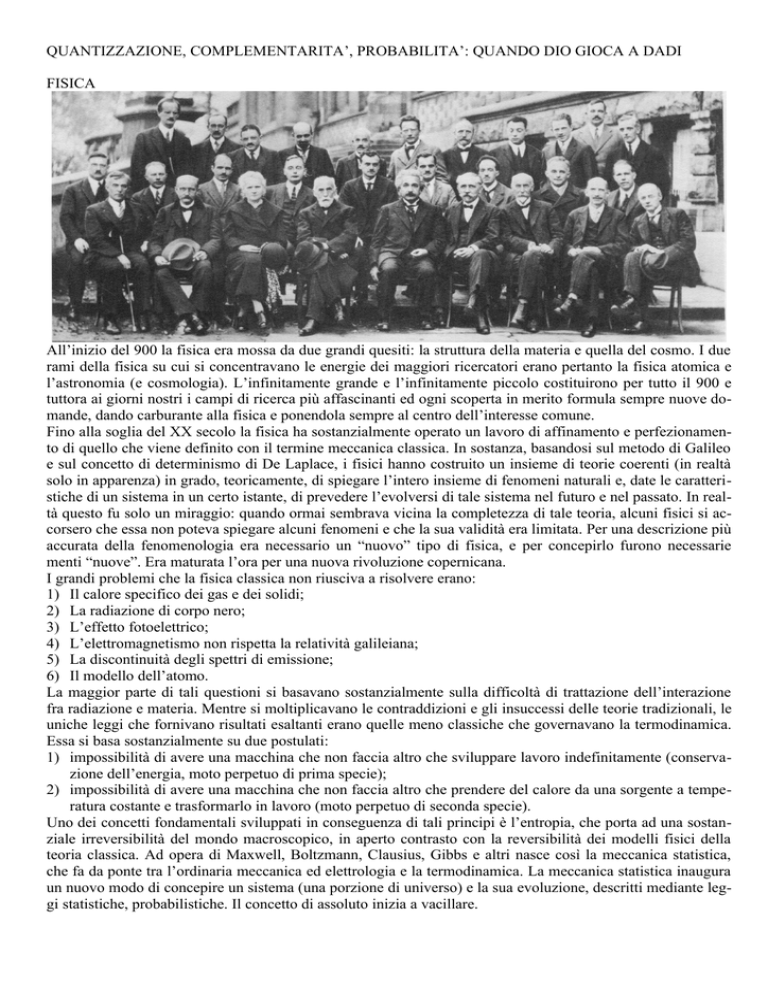

All’inizio del 900 la fisica era mossa da due grandi quesiti: la struttura della materia e quella del cosmo. I due

rami della fisica su cui si concentravano le energie dei maggiori ricercatori erano pertanto la fisica atomica e

l’astronomia (e cosmologia). L’infinitamente grande e l’infinitamente piccolo costituirono per tutto il 900 e

tuttora ai giorni nostri i campi di ricerca più affascinanti ed ogni scoperta in merito formula sempre nuove domande, dando carburante alla fisica e ponendola sempre al centro dell’interesse comune.

Fino alla soglia del XX secolo la fisica ha sostanzialmente operato un lavoro di affinamento e perfezionamento di quello che viene definito con il termine meccanica classica. In sostanza, basandosi sul metodo di Galileo

e sul concetto di determinismo di De Laplace, i fisici hanno costruito un insieme di teorie coerenti (in realtà

solo in apparenza) in grado, teoricamente, di spiegare l’intero insieme di fenomeni naturali e, date le caratteristiche di un sistema in un certo istante, di prevedere l’evolversi di tale sistema nel futuro e nel passato. In realtà questo fu solo un miraggio: quando ormai sembrava vicina la completezza di tale teoria, alcuni fisici si accorsero che essa non poteva spiegare alcuni fenomeni e che la sua validità era limitata. Per una descrizione più

accurata della fenomenologia era necessario un “nuovo” tipo di fisica, e per concepirlo furono necessarie

menti “nuove”. Era maturata l’ora per una nuova rivoluzione copernicana.

I grandi problemi che la fisica classica non riusciva a risolvere erano:

1) Il calore specifico dei gas e dei solidi;

2) La radiazione di corpo nero;

3) L’effetto fotoelettrico;

4) L’elettromagnetismo non rispetta la relatività galileiana;

5) La discontinuità degli spettri di emissione;

6) Il modello dell’atomo.

La maggior parte di tali questioni si basavano sostanzialmente sulla difficoltà di trattazione dell’interazione

fra radiazione e materia. Mentre si moltiplicavano le contraddizioni e gli insuccessi delle teorie tradizionali, le

uniche leggi che fornivano risultati esaltanti erano quelle meno classiche che governavano la termodinamica.

Essa si basa sostanzialmente su due postulati:

1) impossibilità di avere una macchina che non faccia altro che sviluppare lavoro indefinitamente (conservazione dell’energia, moto perpetuo di prima specie);

2) impossibilità di avere una macchina che non faccia altro che prendere del calore da una sorgente a temperatura costante e trasformarlo in lavoro (moto perpetuo di seconda specie).

Uno dei concetti fondamentali sviluppati in conseguenza di tali principi è l’entropia, che porta ad una sostanziale irreversibilità del mondo macroscopico, in aperto contrasto con la reversibilità dei modelli fisici della

teoria classica. Ad opera di Maxwell, Boltzmann, Clausius, Gibbs e altri nasce così la meccanica statistica,

che fa da ponte tra l’ordinaria meccanica ed elettrologia e la termodinamica. La meccanica statistica inaugura

un nuovo modo di concepire un sistema (una porzione di universo) e la sua evoluzione, descritti mediante leggi statistiche, probabilistiche. Il concetto di assoluto inizia a vacillare.

Planck: la teoria dei quanta

Verso la fine dell’anno 1900 (a pochi giorni dall’inizio del XX sec.) Max Planck pubblica

sugli “Annalen der Physik” un articolo che risolve il problema 2: la radiazione di corpo

nero.

8π 2 hυ

u = 3 υ hυ

1)

c

kT

e − 1

planckiana

L’equazione descrive la distribuzione di energia nella radiazione di corpo nero in funzione della frequenza ν e

della temperatura T e il grafico è la celebre planckiana. Il termine messo in risalto tra parentesi è l’energia media di un oscillatore e la presenza dell’esponenziale denota il carattere probabilistico dell’equazione. Nell’equazione compaiono le due costanti fondamentali della fisica: c (velocità della luce=2x108 m/s) e h (costante

detta di Planck=6,63x10-34 Js). Einstein decreterà che la prima costituisce il limite macroscopico della fisica in

quanto velocità massima raggiungibile e Heisenberg identificherà nella seconda il limite microscopico della

risoluzione fisica con il principio di indeterminazione.

2)

La 2 sancisce la nascita della fisica quantistica. ε è l’energia di un oscillatore che risulta quantizzata, in quanto

multiplo esatto (n è un numero naturale) del prodotto hν. Due oscillatori si scambiano pacchetti di energia discreti, definiti da hν, il quanto d’azione di Planck. Planck si rende conto della portata estremamente rivoluzionaria della sua scoperta e lottò con tutto se stesso per conciliare le sue teorie con quelle classiche, senza risultati. La sua indole ancora ancorata al vecchio modo di pensare unita alla sua genialità lo hanno portato ad essere un “rivoluzionario controvoglia”.

Einstein: cadono gli assoluti kantiani di spazio e tempo

Nel 1905 Albert Einstein scrive tre articoli, uno più geniale e importante dell’altro, risolvendo alcuni tra i più importanti grattacapi della fisica:

1) “Movimento di particelle sospese in liquidi in quiete, richiesto dalla teoria molecolare del calore”. In questo articolo il fisico tedesco descrive il moto browniano

ammettendo la natura discreta della materia. In pratica Einstein riesce qui a dimostrare in maniera definitiva che la materia è composta di atomi.

2) “Un punto di vista euristico relativo alla generazione e trasformazione della luce”.

Qui viene trattato il fenomeno dell’effetto fotoelettrico, dando spiegazione al problema 3. Supponendo una descrizione corpuscolare per la luce, l’energia di un fotone (“particella” di

luce) risulta hν. Per una certa frequenza essa sarà sufficiente a fare in modo che l’elettrone che l’assorbe sfugga all’attrazione del nucleo. La portata rivoluzionaria sta nel fatto di trattare la luce come composta di corpuscoli, quando ormai era assodata una descrizione ondulatoria. Gli effetti di interferenza e

diffrazione della luce erano prove inconfutabili a favore di quest’ultima, la quale presentava il fianco

per una sola ma fondamentale considerazione: se la luce è un’onda deve propagarsi in un mezzo: l’etere, ma cos’è e com’è l’etere??? Tale domanda non avrà mai risposta perché l’etere non esiste proprio perché la natura è sia onda che particella ed entrambe le teorie sono corrette e complementari,

come vedremo in seguito.

3) “Elettrodinamica dei corpi in movimento”. In questo articolo Einstein presenta la Teoria della Relatività Speciale e risolve il problema 4. Essa si basa su due postulati: 1) Per due sistemi di riferimento

inerziali tutte le leggi fisiche sono assolutamente identiche e non è possibile distinguere un sistema di

riferimento assoluto; 2) La velocità della luce nello spazio vuoto è sempre la stessa, indipendentemente dal moto della sorgente che la genera e dell’osservatore che la riceve. Da questi due postulati il giovane impiegato all’ufficio brevetti di Berna riscrisse la cinematica e tutte le altre leggi fisiche mediante

le

trasformazioni

di

Einstein-Lorentz

e

le

leggi

che

ne

derivano:

ε = nhυ

x' E =

t 'E =

xE − Vt E

1− V 2

t E − VxE

1− V 2

Non risulta rispettato il principio di contemporaneità e cadono i concetti di spazio e tempo assoluti in

favore di una nuova entità fisica quadridimensionale: lo spazio-tempo. L’invariante risulta essere l’intervallo spazio-tempo: ∆ s 2 = ∆ t 2 − ∆ x 2 = ∆ t ' 2 − ∆ x ' 2 = ∆ s ' 2 . Le lunghezze si contraggono:

L0 =

M =

L

1− V

M0

1− V 2

2

e i tempi si dilatano: T ' = T 1 − V 2 . Anche la massa si trasforma analogamente:

. La relatività einsteiniana ridescrive anche il concetto tradizionale di energia:

E=mc2+1/2mv2, rivelando che la massa è energia condensata e che una massa piccolissima contiene al

suo interno una quantità di energia spaventosa.

Nel 1916 Einstein pubblicherà la Teoria della Relatività Generalizzata, che completa la descrizione dei fenomeni in sistemi di riferimento accelerati. Lo spazio-tempo quadridimensionale risulta non euclideo, bensì curvato in presenza di corpi massivi. Il fisico riassume così la sua teoria: “la massa insegna allo spazio come incurvarsi e lo spazio insegna alla massa come muoversi”.

L’atomo di Bohr: il primo modello quantistico

Una volta assodata l’esistenza dell’atomo, l’attenzione di molti fisici si focalizzò sull’analisi della struttura

atomica. I modelli si susseguirono in rapida successione:

Il modello di Bohr (1913) fu di portata rivoluzionaria: accanto all’ipotesi “classica” di

eguagliare la forza centripeta che il nucleo esercita sull’elettrone alla forza elettrostatica di

Coulomb che sussiste tra le due cariche, Bohr pensò che il momento angolare (e quindi

l’orbita dell’elettrone, fosse quantizzata e più precisamente un multiplo intero di h/2π. Se le

orbite sono quantizzate significa che l’elettrone può muoversi su dei binari definiti, a ciascuno del quale corrisponderà un’energia ben definita, cioè quantizzata. Dalle due ipotesi,

con calcoli elementari, Bohr arriva a scrivere le seguenti equazioni:

h 2ε o 2

r=

n

π me 2

3)

En = −

4)

e4m 1

⋅ 2

2

8ε 0 h 2 n

Nella 3 è evidente la quantizzazione del raggio e quindi dell’orbita dell’elettrone, che Bohr ipotizza circolare.

Esso infatti dipende dal quadrato di n, un numero intero positivo, che verrà in seguito definito come primo numero quantico. L’energia, come evidenziato nella 4, è anch’essa quantizzata, e dipende dal reciproco del quadrato di n. Tale formulazione spiega l’equazione che Balmer aveva trovato empiricamente, in grado di localizzare le righe in emissione dello spettro dell’idrogeno. Il modello di Bohr venne definito come il primo modello quantistico per l’atomo, ma la sua validità si limita all’atomo di idrogeno, in quanto nel caso di più elettroni

non tiene conto delle interazioni di spin, di spin-orbita e del residuo coloumbiano.

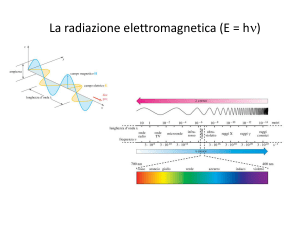

La natura duale della luce

Nel frattempo la teoria dei quanta di Planck e la descrizione della luce avevano posto di fronte ai fisici notevoli problemi. Einstein nel 1905 spiega l’effetto fotoelettrico supponendo che la luce sia composta di elementi

discreti che chiama fotoni, che possiedono un’energia data dalla formula di Planck ε=hν. Nel 1923 Compton

spiega quello che verrà poi chiamato effetto Compton, assumendo l’ipotesi che la luce sia composta di fotoni,

pseudoparticelle dotate di quantità di moto p=hν/c. La luce si trova così ad essere descritta da due teorie in

netta antitesi, ma entrambe corrette ed entrambe in grado di spiegare parte della fenomenologia della luce:

1) La teoria ondulatoria vede la luce come un’onda, radiazione elettromagnetica, con λν=c e c=1/ ε 0 µ 0 .

Essa spiega perfettamente i fenomeni di diffrazione e interferenza della luce.

2) La teoria corpuscolare prevede un modello di luce composta di fotoni, una sorta di particella di data

energia e data quantità di moto. Questa teoria spiega l’effetto fotoelettrico e l’effetto Compton.

Le due teorie sono complementari e Einstein stesso riconosce che assumendo la luce sia come particella che

come onda il grave problema dell’etere (l’enigmatico mezzo che permea tutto lo spazio e che non presenta alcun attrito in cui si muoverebbe la luce in quanto onda) viene a cadere: una descrizione particellare della luce

non necessita del mezzo di propagazione. Per Einstein “lo spazio fisico e l’etere non sono che due espressioni

diverse di una sola e medesima cosa; i campi sono stati fisici dello spazio. In realtà se non si attribuisce all’etere nessuno stato particolare di moto non c’è alcuna ragione di farlo figurare accanto allo spazio come un’entità di natura speciale” (“Come io vedo il mondo”). La luce si comporta quindi da onda in certe situazioni e da

corpuscolo in certe altre. A scegliere quale comportamento deve assumere la luce è lo scienziato: a seconda di

come viene impostato l’esperimento la luce si comporterà ora da onda ora da fascio di particelle. La posizione

dello scienziato cambia radicalmente: egli non è più l’osservatore esterno che vede oggettivamente lo svolgersi di un fenomeno e lo studia, ma parte integrante dell’esperimento, interagendo con il sistema che deve studiare, perturbandolo, e di questo si deve tener conto nelle ipotesi e nelle conclusioni.

De Broglie: l’estensione del dualismo

Il passo successivo fu compiuto dal giovane fisico francese Louis De Broglie. Egli, nel

1923, osservò che, se dalle considerazioni di Compton, un fotone ha quantità di moto

p=

λ =

h

, allora una particella di massa m dovrebbe essere dotata di una lunghezza d’onda:

λ

h

mv

5)

Tale equazione gli valse il Premio Nobel e segna il passo fondamentale verso la formazione di una meccanica

quantistica. Il procedimento di De Broglie è geniale: Einstein e Compton erano partiti dal continuo arrivando

al discreto, egli parte dal discreto e ritrova il continuo. Ogni oggetto ha una doppia natura: ondulatoria e corpuscolare. Il dualismo della luce viene ora esteso ad ogni entità fisica. L’applicazione immediata è lo studio

dell’orbita dell’elettrone e applicando la 5 ad un modello di onda stazionaria si ottiene immediatamente la seconda ipotesi di Bohr, cioè la quantizzazione del momento angolare. Questa è un’evidente conferma di entrambe le teorie.

Heisenberg, Dirac, Schrödinger: la meccanica quantistica

Il fisico tedesco Werner Heisenberg cercò di trovare una relazione tra la faccia ondulatoria

e quella corpuscolare della natura impiegando un nuovo tipo di matematica altamente complessa, detta matematica delle matrici. Dai suoi conti risulta l’equazione:

pq − qp =

h

2π i

6), e più precisamente:

∑ pmr q rn − qmr prn =

r

h

δ ( m, n)

2

π

i

dove q e p non sono numeri ordinari, bensì matrici che rappresentano rispettivamente una

coordinata spaziale q e il suo momento coniugato p. δ(m,n) è il simbolo di Kronecker che

vale 1 se m=n e 0 se m≠n. Classicamente, per un punto in una dimensione, q =x,

p=mx=mv. Le quantità classiche che sono numeri e non matrici commutano e mxx-xmx=0, invece le quantità

che corrispondono a x e mx nella matematica di Heisenberg sono matrici non commutative. Heisenberg costruisce così una nuova meccanica: chiamata Matrizenmechanik o Quantenmechanik.

La stessa questione venne affrontata nel 1925 dal matematico Paul Dirac, che formulò una

nuova matematica, equivalente a quella di Heisenberg ma diversa, con un carattere più generale.

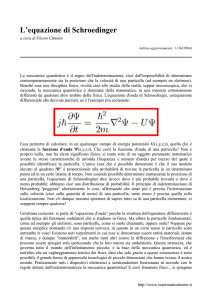

Al contempo un terzo personaggio, Erwin Schrödinger, si stava occupando

di strane equazioni come:

8π 2 m

[ E − U ( x, y, z )]ψ ( x, y, z ) = 0

∇ ψ ( x, y , z ) +

h2

2

7)

Questa è la celebre equazione d’onda di Schrödinger per il caso indipendente dal tempo, nella quale ∇

2

è l’operatore di Laplace

∂2

∂2

∂2

+

+

, ψ(x,y,z) è un enigmatico scalare, E è

∂ x2 ∂ y2 ∂ z 2

l’energia del sistema, e U(x,y,z) è il potenziale che descrive il sistema. L’elegante equazione si rivela molto

più semplice da trattare delle matrici di Heisenberg e, fondamentalmente per questo motivo, riscosse più successo. La caratteristica più interessante di tale uguaglianza consiste nel fattore |ψ2| che venne interpretato in

seguito come una densità di probabilità. Dalla soluzione dell’equazione, al variare dei numeri quantici n (principale), l (azimutale), m (magnetico), s (spin), vengono a delinearsi nuvole di probabilità di diverse forme che

rappresentano le zone in cui si ha la probabilità del 90% di trovare l’elettrone caratterizzato dai dati numeri

quantici. Tali nuvole prendono il nome di orbitali. Nel 1926 Schrödinger propone il modello atomico ad orbitali, tanto rivoluzionario quanto efficiente nel descrivere i fenomeni atomici quali l’assorbimento ed emissione

di fotoni e le righe degli spettri. L’elettrone viene descritto come un’onda, come una nube elettronica e non è

più localizzabile, bensì abbiamo una certa probabilità di trovarlo in una certa zona. Se tentiamo di localizzarlo, andiamo ad indagarlo in quanto particella, quindi perde la sua natura ondulatoria e ci apparirà come corpuscolo. La descrizione probabilistica sembra in questo momento funzionare meglio di quella deterministica,

come già aveva dimostrato la termodinamica e come si stava osservando nei decadimenti radioattivi degli atomi.

Heisenberg dalla 6 ricava la relazione di indeterminazione (o di incertezza), che può ergersi a simbolo del

nuovo paradigma della fisica, in quanto sintetizza un nuovo modo di concepire la natura, di porsi dinnanzi ad

essa e di indagarla:

∆ p∆ q ≥

h

2π

8)

Il prodotto dell’errore nella determinazione della quantità di moto per l’errore nella misurazione della posizione è sempre maggiore o uguale ad una quantità definita dalla metà del rapporto tra la costante di Planck e π.

Ciò significa che se si cerca di misurare su uno stesso corpuscolo e contemporaneamente una coordinata e il

momento a lei coniugato si rimane sempre con una incertezza data dalla 8. Se si indaga la natura corpuscolare

di una particella, quella ondulatoria scompare, e viceversa. I due aspetti della natura sono come due facce della stessa medaglia, che non è possibile vedere entrambe contemporaneamente. Ecco che h assume un valore

filosofico ed epistemologico ponendosi come limite al mondo microscopico.

Heisenberg identifica anche un’altra coppia di variabili coniugate: l’incertezza nella determinazione dell’energia e del tempo:

9)

Tale equazione spiega che per determinare lo stato energetico di un sistema occorre un determinato tempo e le

sue implicazioni in fisica atomica e in cosmologia sono straordinarie. Per brevissimi periodi di tempo il principio di conservazione dell’energia può essere violato. Questa asserzione è una delle basi delle moderne teorie

sulle interazioni ed è fondamentale per spiegare la fenomenologia quantistica.

∆ E∆ t ≥ h

FILOSOFIA

L’introduzione dei concetti di quantizzazione, complementarietà e probabilità diedero adito a non poche controversie tanto nel mondo della fisica quanto in quello della filosofia, che ormai era chiamata in causa direttamente.

Le nuove teorie abbracciarono un campo di applicabilità più ampio e inglobarono le vecchie teorie come casi

limite. La rivoluzione scientifica non si sviluppò soltanto da un punto di vista quantitativo delle conoscenze,

ma anche da quello qualitativo: il modo di fare scienza utilizzato fino ad allora poteva essere considerato ancora valido alla luce delle nuove acquisizioni teoriche? La domanda è retorica. Tutti gli scienziati, in primo

luogo i più eminenti, dovettero indossare la toga di filosofo e riesaminare gli strumenti della scienza che nei

secoli precedenti sembravano assodati. Ritornarono così straordinariamente attuali i problemi concernenti la

logica, il linguaggio, la realtà, l’epistemologia, l’etica. Lo scienziato è nuovamente filosofo.

Per costruire una teoria scientifica, perché questa venga verificata, diffusa, discussa, accettata o rifiutata è necessario un sistema di regole che permettano l’elaborazione di un discorso coerente, coeso, comprensibile. In

fisica l’espressione matematica della teoria va accompagnata dall’enunciato, scritto in un linguaggio corrente.

Ciò è importante sia perché la teoria diviene comunicabile e comprensibile alla comunità scientifica, sia perché lo scienziato stesso prende coscienza del risultato raggiunto. Le regole che sino al XX secolo regolavano

il linguaggio erano quelle descritte nella logica di Aristotele. Le nuove teorie, soprattutto la nuova meccanica

statistica, e i dati sperimentali imposero la necessità di modificare la logica tradizionale. In quest’impresa si

cimentarono Birkhoff, von Neumann e von Weizsäcker. Se chiudiamo un gatto in una scatola chiusa e inseriamo nella scatola un apparecchio tale che dopo un’ora vi sia il 50% delle possibilità che questo congegno uccida il gatto, Aristotele ci dice che in capo a un’ora una sola delle due proposizioni è vera: “il gatto è vivo”,”il

gatto non è vivo” (tertium non datur). Schrödinger propone una funzione d’onda del sistema in cui il gatto

vivo e il gatto morto sono miscelati in egual proporzione (paradosso del gatto di Schrödinger). Von Weizsäcker introdusse il concetto di “grado di verità”: per le due affermazioni “il gatto è vivo” e “il gatto non è vivo”

abbiamo un numero complesso come misura del suo grado di verità. Se il numero è 1 l’affermazione è vera, se

è 0 allora è falsa. Questi due casi limite corrispondono alla logica aristotelica che è così compresa nella nuova

logica. Sono possibili altri valori, il valore assoluto del numero complesso dà la probabilità della verità dell’affermazione e la somma delle due probabilità riferentesi alle due alternative deve dare 1. Ciò appare assurdo solo in apparenza, poiché si accorda perfettamente con i dati sperimentali a livello atomico. Viene a definirsi inoltre il concetto di “complementarità” che Heisenberg definisce così: “ogni affermazione che non è

identica all’una o all’altra delle due affermazioni alternative (“il gatto è vivo”,”il gatto non è vivo”) è chiamata complementare a queste affermazioni”(da “Fisica e filosofia”).

Einstein spiega così il concetto di verità: “una proposizione è corretta se, entro un certo sistema logico, viene

dedotta secondo regole logiche accettate. La verità contenuta in un sistema corrisponde alla certezza e alla

completezza con cui è possibile coordinarlo con la totalità dell'esperienza. Una proposizione corretta ripete la

sua “verità” da quella contenuta nel sistema a cui appartiene” (Autobiografia scientifica). Qualche perplessità

in più subentra nel tentativo di dare una definizione del concetto di realtà. Con la meccanica classica, conoscendo i parametri di un sistema in un dato istante, era possibile prevederne l’evoluzione sia precedente che

successiva all’istante dato. La meccanica statistica ne contesta la premessa: noi non possiamo conoscere esattamente tutti i parametri di un sistema ad un certo istante. Le leggi naturali, formulate in termini matematici,

non determinano il verificarsi di un fenomeno, ma la probabilità con cui esso

può verificarsi. Le equazioni d’onda di Schrödinger “possono essere interpretate come una formulazione quantitativa del concetto aristotelico di dynamis,

di possibilità”, come fa notare Heisenberg. Quindi il grado di possibilità che

un evento si verifichi possiede in sé una specie di verità. Il determinismo non

è più valido su scala generale, l’universo dell’infinitamente piccolo trascende

ogni cognizione a cui siamo abituati nella nostra scala umana. Così l’antitesi

tra l’idealismo di Platone e il materialismo di Democrito non vede prevalere

né l’uno né l’altro. De Broglie dimostra che ogni particella è dotata di un

pacchetto d’onda e noi possiamo osservare uno solo dei due aspetti (onda o

corpuscolo) alla volta, a seconda di come costruiamo l’esperienza, una sorta

di armonia degli opposti di Eraclito. Se vogliamo conoscere la sua velocità

dovremo analizzare l’aspetto ondulatorio, se invece ci interessa la posizione è

la natura particellare a dover essere indagata. E i due aspetti non possono essere studiati contemporaneamente come sottolinea il principio d’indetermina-

zione di Heisenberg: ΔxΔq≥h/2π (dove Δx è l’incertezza nella determinazione della posizione e Δq quella nella determinazione della quantità di moto). Il concetto di atomo di Democrito vive nella natura di particella,

quello di idea di Platone nella natura di onda descrivibile come un’equazione matematica. Alle domande: ma

si tratta di una particella o di un’onda? Quale delle due rappresentazioni è reale?, la risposta è che i due stati

sono complementari ed entrambi reali, e ciò non consiste in una contraddizione secondo la nuova logica. Bohr

si esprime così riguardo il concetto di complementarità: “E’ possibile riguardare l’informazione ottenuta circa

il comportamento di un sistema atomico sotto certe condizioni sperimentali come complementare, secondo

una terminologia spesso usata in fisica atomica, rispetto a ogni altra informazione sullo stesso sistema, ottenuta con un dispositivo escludente il verificarsi delle predette condizioni. Benché queste diverse informazioni

non possano venire combinate in una sola descrizione per mezzo di concetti ordinari, esse costituiscono aspetti ugualmente essenziali della conoscenza che di quel sistema si può avere in quel campo.” (Bohr, “I quanti e

la vita, Filosofia naturale e culture umane”). Bohr estende il concetto di complementarità in una prospettiva

gnoseologica generale: esso sarebbe, ad esempio, esplicativo dell’associazione psicologica tra pensieri e sensazioni, della compresenza di un atteggiamento gnoseologica meccanicistico e di uno finalistico, addirittura

applicabile ad un modello di culture umane complementari le une alle altre in un quadro armonico di varietà

specifiche.

Un elemento di continuità tra fisica classica e moderna può essere rintracciato nell’egual importanza rivestita

da elaborazione teorica e verifica sperimentale.

Nel proliferare di nuove teorie, molte si rivelano errate, altre inservibili, inutili, molte altre descrivevano solo

fenomeni particolari. In questo groviglio Einstein nella sua “Autobiografia scientifica” cercò di mettere chiarezza descrivendo in due punti come deve essere una teoria scientifica:

1) “La teoria non deve contraddire i fatti empirici”, quindi i fondamenti teorici vanno confermati per

mezzo dell’esperimento.

2) E’ preferibile che vi sia una “naturalezza o semplicità logica delle premesse (ossia dei concetti fondamentali e delle corrispondenti relazioni reciproche poste a base di essi)”. “Inoltre fra teorie le cui premesse siano ugualmente semplici, deve essere considerata superiore quella che definisce più nettamente le qualità dei sistemi in astratto (cioè, che contiene le affermazioni più precise)”.

Karl Raimund Popper propone il principio della falsificabilità: partendo da un metodo ipotetico-deduttivo sostiene che da ipotesi teoriche scientifiche si devono poter dedurre conseguenze sperimentalmente falsificabili.

In altre parole, una teoria per essere scientifica deve essere falsificabile. Il “fallibilismo” ammette che la certezza non si dà mai, nell’ambito della conoscenza scientifica, in modo assoluto e completo, proprio per la possibilità di falsificare una teoria, e quindi di superarla. La scienza, procedendo per prove ed errori (congetture:

anticipazioni non giustificabili, e confutazioni: controlli critici), progredisce e Popper individua un criterio per

riconoscere la validità e il potenziale carattere progressivo di una teoria scientifica: esso risiede nella maggior

quantità di contenuto empirico e di controllabilità presente in una teoria. Di conseguenza il contenuto empirico di una teoria aumenta con l’aumentare della sua improbabilità, soltanto una teoria altamente improbabile

merita di essere sottoposta a controlli e può condurre al progresso della scienza. La verità scientifica diviene

un’idea regolativa in senso kantiano, necessaria a indirizzare la ricerca, ma in definitiva irraggiungibile: se falsifichiamo una teoria siamo certi di non aver raggiunto la verità, ma non saremo mai certi di averla raggiunta.

L’idea regolativa di verità consente di parlare sensatamente di errori e di discussione critica nella ricerca degli

errori. L’idea di verità non è dunque vaga e metafisica, e non possiamo fare a meno di considerare la possibilità di un’approssimazione migliore alla verità, ovvero di un grado crescente di “verosimiglianza”.

La teoria va verificata attraverso l’esperimento. L’analisi dell’infinitamente piccolo modificò le modalità dell’esperienza e il ruolo stesso dello scienziato. A seconda di come viene impostato l’esperimento possiamo osservare gli effetti della natura ondulatoria o di quella di particella. Lo scienziato riveste un ruolo fondamentale, non può più considerarsi un osservatore esterno che, dall’alto, analizza oggettivamente un fenomeno. Ora

lo scienziato si cala nell’esperienza, ne è parte e i suoi strumenti interagiscono sensibilmente con il sistema in

analisi. Nelle teorie classiche l’interazione tra oggetto osservato e soggetto osservante veniva considerata trascurabile o controllabile. Nelle osservazioni a livello atomico tale ammissione non si può fare poiché ogni interazione può produrre variazioni parzialmente incontrollabili e relativamente grandi. “La scienza non sta più

come spettatrice davanti alla natura, ma riconosce se stessa come parte di quel mutuo interscambio tra uomo e

natura. Il metodo scientifico che procede isolando, spiegando e ordinando i fenomeni diviene consapevole dei

limiti che gli derivano dal fatto che il suo intervento modifica e trasforma il suo oggetto, dal fatto cioè che il

metodo non può più separarsi dall'oggetto. L'immagine scientifica dell'universo cessa quindi di essere una

vera e propria immagine della natura.”(Heisenberg “Natura e fisica moderna”).

STORIA DELL’ARTE

Cubismo

Picasso e Braque, i maggiori esponenti del Cubismo, partono dall’esperienza di Cezanne, sintetizzata nella sua asserzione: “In natura tutto è modellato secondo tre moduli

fondamentali: la sfera, il cono, il cilindro. Bisogna imparare a dipingere queste semplicissime figure, poi si potrà

fare tutto ciò che si vuole”. Si tenta di esprimere la realtà

non come appare, ma nel modo in cui la mente ne percepisce l’apparenza: alla realtà-vista si sostituiscono la realtà-pensata e la realtà-creata. I Cubisti cercano di realizzare una rappresentazione non più riferita a ciò che dell’oggetto si vede, ma rivolta a cogliere ciò che dell’oggetto si

conosce. Ogni dato informativo è compresente, simultaneamente, al momento della visione. La tridimensionalità

viene resa con l’espediente compositivo della moltiplicazione dei punti di vista (la donna in basso a destra ne Les

demoiselles d’Avignon di Picasso mostra la schiena ma il

volto è ritratto frontalmente; in Natura morta con “le jour”

di Braque di ogni oggetto sono rappresentati fronte e retro). Il colore, ridotto a pochi accordi (il bianco, il nero, le

terre), ben lontano dalle tradizionali piacevolezze

naturalistiche, diventa un fatto puramente mentale. Il poeta Apollinaire nota che “i pittori sono stati portati naturalmente e, per così dire, intuitivamente, a preoccuparsi di nuove misure possibili

dello spazio che, nel linguaggio figurativo dei moderni, si indicano tutte insieme brevemente con il

termine di quarta dimensione. […] Dal punto di

vista plastico, la quarta dimensione rappresenta

l’immensità dello spazio, che si eterna in tutte le

dimensioni in un momento determinato.” Il Cubismo rifiuta ogni illusorietà spaziale: ogni distinzione tra oggetto e spazio in cui esso è collocato

viene a cadere, come pure mutano all’interno dell’oggetto stesso i rapporti tra le parti. Nelle Demoiselles Picasso non solo dipinge lo spazio tra le

figure con solidi spigolosi blu, ma gli spigoli di tali geometrie compenetrano le figure, costruendo una sintesi

tra spazio e oggetto. Lo spazio e l’oggetto si influenzano a vicenda (Teoria della relatività). Le figure tendono

ad essere descritte come composizioni di forme geometriche astratte, componendole e ricomponendole. Così

come la scienza cambia paradigma per descrivere la natura, l’arte si dà nuove regole per andare oltre la limitante visione dell’occhio umano. I cubisti capiscono che il “davanti” e il “dietro” sono due parti integranti di

un oggetto, due facce che l’uomo non può vedere contemporaneamente, e tentano di sopperire con la loro arte

a tale mancanza. Essi vogliono rappresentare la realtà e il “dietro” è importante tanto quanto il “davanti”,

quindi anch’esso va rappresentato. Allo stesso modo lo scienziato si troverà davanti al problema: onda o corpuscolo? E la risposta era già contenuta nelle opere cubiste: entrambi, e la descrizione reale è quella che tiene

in considerazione entrambe le trattazioni.

Astrattismo

L’arte astratta rifiuta la rappresentazione di immagini riconoscibili e punta all’astrazione per giungere alla forma pura. Paul Klee, grande esponente

dell’Astrattismo, afferma che “l’arte non rappresenta il visibile, ma rende visibile ciò che non

sempre lo è”. Kandinskij parte non più da figure

esteriori oggettive, bensì da emozioni e sensazioni

interne. Nel 1910 dipinge il Primo acquarello

astratto. L’artista adotta lo sguardo vergine del

bambino, svincolandosi da ogni possibile condizionamento visivo. Ma dietro quello che può sembrare uno scarabocchio infantile si cela una grammatica spirituale e simbolista del colore e delle

forme ben studiata e codificata. Kandinskj commenta così l’opera: “ Lotta di toni, perdita di equilibrio, caduta dei principi, inattesi colpi di tamburo, grandi interrogativi, tensioni apparentemente senza scopo, impeti e nostalgie apparentemente laceranti, catene e legami spezzati, contrasti e contraddizioni: questa è la nostra armonia. Su questa armonia si fonda la

composizione: un rapporto di colori e di linee indipendenti, che nascono dalla necessità interiore e vivono nella totalità del quadro”.”Lo spirito nuovo”, afferma Mondrian, altro celebre artista astratto, ”distrugge la forma

delimitata nell’espressione estetica, e ricostruisce un’apparenza equivalente del soggettivo e dell’oggettivo,

del contenuto e del contenente: una dualità equilibrata dell’universale e dell’individuale e con questa dualità

nella pluralità crea il rapporto puramente estetico”. Il confronto è immediato con il dualismo in fisica e con il

nuovo rapporto natura-osservatore..

Punte nell’arco, dipinto del 1927, è il quadro più rappresentativo del periodo di insegnamento al Bauhaus. Kandinskij

aveva pubblicato il saggio Punto, linea, superficie e aveva

fissato i termini della teoria dell'astrattismo. Aveva individuato nella linea lo strumento della sua ricerca pittorica che

prolunga e rende più chiaro il gesto del braccio che li manovra.

Con il suo lavoro aveva sostituito il concetto di campo con

quello di spazio (Einstein: il campo gravitazionale è una

deformazione dello spazio-tempo). Il campo è per Kandinskij una porzione di infinito determinata dall'interazione

delle forze agenti simultaneamente, ed il suo insieme forma

un sistema dinamico. Un campo siffatto non è più una rappresentazione ma un frammento reale di arte.

Questi temi sono evidenti nel dipinto in questione. Lo sfondo nero è il campo principale in cui agiscono altri campi.

Le figure sovrapponendosi formano altre figure in un rincorrersi di nuove possibilità compositive: protagonista del

dipinto è il movimento delle punte che allude ad un ordine.

I colori sono vivi e intensi e ricordano i contatti avuti in

gioventù con la decorazione popolare del nord della Russia,

così come il titolo che ricorda le battute di caccia delle popolazioni nordiche, e recupera il patrimonio mitologico della cultura russa. La composizione è semplice e nella geometria ricorda un arco teso che sta per scoccare la freccia, ma questa semplicità compositiva sottende un

movimento che si manifesta nell'azione del lancio del dardo. Kandinskij inserisce la quarta dimensione: il

tempo, che prende forma dalla reiterazione delle figure geometriche che compongono l’arco: l’occhio descrive un percorso dall’alto verso il basso, dai colori caldi a quelli freddi, impiegando un certo tempo che dipende

dalla durata del periodo necessario affinché un colore-forma percepito dall’occhio si traduca in sensazione

psicologica.

Le figure nascono da sistemi di forme astratte, ideali, così come Schrödinger, proprio in quegli anni, proponeva un’equazione astratta, puramente matematica, che però al suo interno conteneva la chiave per l’interpretazione

degli orbitali elettronici. Mai come in questo periodo troviamo la scienza

nell’arte e l’arte nella scienza.

Bibliografia:

1) M. E. Bergamaschini, P. Marazzini, L. Mazzoni: L’indagine del mondo fisico, vol F;

2) Emilio Segrè: Personaggi e scoperte della fisica contemporanea;

3) W. Heisenberg & al.: Discussione sulla fisica moderna;

4) W. Heisenberg: Fisica e filosofia;

5) Albert Eintein, Come io vedo il mondo;

6) S. W. Hawking: Dal big bang ai buchi neri;

7) L. Tornatore, G. Polizzi, E. Ruffaldi: Filosofia. Testi e argomenti, vol 4;

8) Aa vv: Lezioni di arte, vol 3, Electa-Bruno Mondadori;

9) http://www.filosofico.net;

10) http://www.geocities.com/capecanaveral/hangar/6929/index.html;

11) L. Pirandello: Così è, se vi pare.

12) Albert Eintein: Autobiografia scientifica;