Computazione per l’interazione naturale:

fondamenti probabilistici (2)

Corso di Interazione uomo-macchina II

Prof. Giuseppe Boccignone

Dipartimento di Scienze dell’Informazione

Università di Milano

[email protected]

http://homes.dsi.unimi.it/~boccignone/l

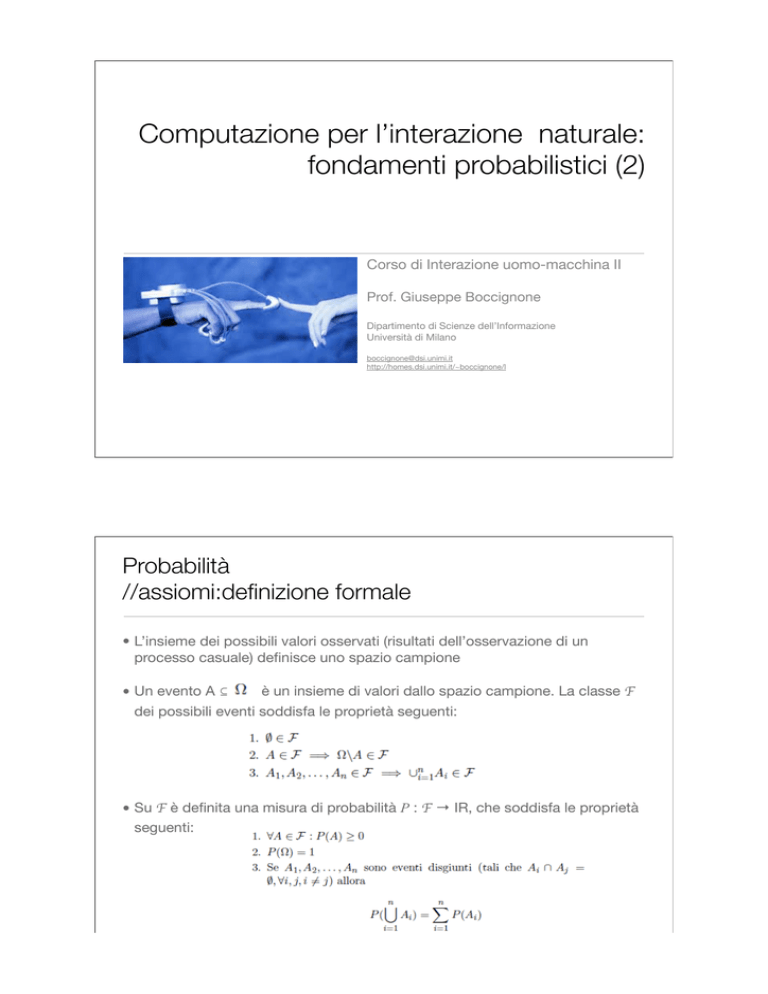

Probabilità

//assiomi:definizione formale

• L’insieme dei possibili valori osservati (risultati dell’osservazione di un

processo casuale) definisce uno spazio campione

è un insieme di valori dallo spazio campione. La classe F

• Un evento A !

dei possibili eventi soddisfa le proprietà seguenti:

• Su F è definita una misura di probabilità P : F ! IR, che soddisfa le proprietà

seguenti:

Probabilità condizionata

• Sia B un evento a probabilità non nulla (P(B) > 0). La probabilità condizionata

di un evento A dato B è definita come

• Se P(A"B) = P(A)P(B), e quindi P(A | B) = P(A), allora i due eventi sono detti

indipendenti.

Variabili aleatorie

• Una variabile casuale (o random) è una funzione

• Se, dato

può assumere soltanto valori interi, allora X è una

variabile casuale discreta, altrimenti viene detta continua.

• Una distribuzione (cumulativa) di probabilità è una funzione

• tale che FX(x) = P(X ! x). Per tale funzione valgono le seguenti

Distribuzione di probabilità

• Se X può assumere un insieme finito di possibili valori, è possibile definire la

distribuzione (di massa) di probabilità

• tale che pX(x) = P(X = x). Valgono:

Densità di probabilità

• Se X è continua e FX è derivabile ovunque, possiamo definire la densità di

probabilità

• Dalla definizione di derivata:

• Altre proprietà

Valore atteso

generica

• X variabile casuale discreta con distribuzione pX(x), g :

funzione, allora g(X) è variabile casuale e possiamo definire il suo valore atteso

come:

• X variabile casuale continua

Valore atteso: proprietà

Varianza

• La varianza di una variabile casuale X

• Vale allora:

• Inoltre

Distribuzioni utili

Distribuzioni discrete

//Bernoulli

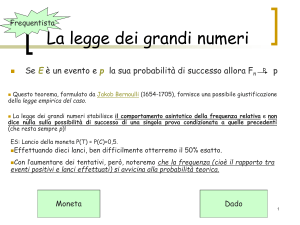

• Probabilità che, data una moneta

con probabilità di “testa” uguale a

p, un suo lancio abbia “testa”

come esito.

=

• Media

• Varianza

Distribuzioni discrete

//Binomiale

• probabilità che, data una moneta

con probabilità di “testa” uguale a

p, n suoi lanci indipendenti diano

x volte “testa” come esito.

• Media

• Varianza

n=10,

p=0.25

Distribuzioni discrete

//Poisson

• probabilità che, dato un evento

che può avvenire in media

lambda volte per unità di tempo,

l’evento compaia x volte nell’unità

di tempo.

• Media

• Varianza

Distribuzioni continue

//Uniforme

• probabilità costante tra a e b, 0

altrove.

• Media

• Varianza

lambda = 2;

x = poissrnd(lambda,1,1000);

hist(x)

Distribuzioni continue

//Esponenziale

• probabilità che l’intervallo tra due

eventi successivi in un processo

di Poisson con parametro

abbia lunghezza x

• Media

• Varianza

Distribuzioni continue

//Normale o Gaussiana

• Media

• Varianza

Distribuzioni continue

//Normale o Gaussiana

• Media

• Varianza

>>

>>

>>

>>

>>

mu=0;

sigma=2;

x=-10:0.1:10;

y = normpdf(x,mu,sigma);

plot(x,y)

Distribuzioni continue

//Normale o Gaussiana

• Media

• Varianza

>>

>>

>>

>>

mu=0;

sigma=2;

x = normrnd(mu,sigma,1,100000);

hist(x)

Distribuzioni continue

//Beta

• Usata come a priori sul parametro della

Binomiale

• dove

è la funzione Gamma

• Media

• Varianza

Distribuzione Beta

in funzione degli iperparametri a,b

Distribuzioni continue

//Gamma

• Usata come a priori sulla varianza della

Normale o sulla Poisson

• dove

è la funzione Gamma

• Media

• Varianza

Distribuzione Gamma

in funzione degli iperparametri a,b

Estensione a due variabili casuali

//distribuzioni cumulative congiunte e marginali

• Date due variabili casuali continue X, Y , la distribuzione di probabilità

cumulativa congiunta è definita come

• Valgono le seguenti

• Data la distribuzione cumulativa di probabilità congiunta FXY (x, y) le

distribuzioni cumulative marginali di probabilità FX e FY sono definite come

Estensione a due variabili casuali

//distribuzioni di probabilità congiunte e marginali

• Date due variabili casuali discrete X, Y

• valgono le seguenti

• Data la distribuzione di probabilità pXY (x, y) le distribuzioni marginali di

probabilità pX e pY sono definite come

Estensione a due variabili casuali

//densità di probabilità congiunte e marginali

• Se FXY (x, y) è dovunque derivabile rispetto sia a x che a y, allora la densità di

probabilità congiunta è definita come

• vale

• Data la densità di probabilità cumulativa fXY (x, y) le densità marginali di

probabilità fX e fY sono definite come

Estensione a due variabili casuali

//probabilità condizionate

• Date due variabili casuali X, Y discrete , la probabilità condizionata di X

rispetto a Y è definita come

• X, Y continue

Estensione a due variabili casuali

//Teorema di Bayes

• X, Y discrete

• X, Y continue

Estensione a due variabili casuali

//indipendenza

• Due variabili casuali sono indipendenti se

• ovvero

Estensione a due variabili casuali

//valore atteso

• Date due variabili casuali X, Y discrete e una funzione

il valore atteso di g è

• X, Y continue

• Valgono le seguenti

Estensione a due variabili casuali

//covarianze

• Date due variabili casuali X, Y , la loro covarianza è definita

• come nel caso della varianza:

• Valgono inoltre:

Estensione a n variabili casuali

• Date n variabili causali X1,X2, . . . ,Xn

• valgono

• Per ogni Xi è definita la marginale

Estensione a n variabili casuali

//caso discreto

• Date n variabili casuali discrete, la distribuzione di probabilità congiunta

• per la quale valgono:

• La distribuzione di probabilità marginale è

Estensione a n variabili casuali

//caso continuo

• Se la F è derivabile, la densità di probabilità congiunta è definita

• quindi

• La densità marginale di probabilità è

Estensione a n variabili casuali

//regola del prodotto

• Dalla definizione di probabilità condizionate:

Estensione a n variabili casuali

//valore atteso

• Date una distribuzione f(x1, x2, . . . , xn) e una funzione

Estensione a n variabili casuali

//covarianza

• Dato un insieme X1,X2, . . . ,Xn di variabili casuali, è possibile definire il

vettore aleatorio

• Anche una funzione

è rappresentabile come vettore

Estensione a n variabili casuali

//covarianza

• Dato il vettore

che, per ogni coppia i, j

la sua matrice di covarianza è la matrice n x n tale

• ovvero:

Estensione a n variabili casuali

//covarianza

•

è matrice simmetrica:

• per definizione di covarianza

•

è definita positiva:

• per qualunque vettore z:

• ma

Estensione a n variabili casuali

//il caso Gaussiano

• Un vettore aleatorio

e matrice di covarianza

ha una distribuzione normale di media

di dimensione n x n

forma quadratica di x

Estensione a n variabili casuali

//il caso Gaussiano

• I contorni di densità costante sono determinati dalla matrice di covarianza

• Per esempio in 2D

Forma generale

Forma diagonale

(allineata con gli assi)

Forma isotropa

(matrice identità)

Distribuzione Normale multivariata:

//il caso multivariato

• Consideriamo il caso della matrice di covarianza diagonale

• allora

• ovvero

Distribuzione multivariata =

prodotto di n distribuzioni

gaussiane univariate, ognuna

relativa ad una coordinata xi

Distribuzione Normale multivariata:

//il caso multivariato: geometria della Gaussiana

•

•

soddisfa l’equazione agli autovettori

reale e simmetrica: i suoi autovalori i sono tutti reali e possiamo scegliere

un insieme di autovettori ortonormali

• Sostituendo all’interno della forma quadratica

• Indicando con

la proiezione di

lungo la direzione di ui

Distribuzione Normale multivariata:

//medie e covarianze

• Valgono le seguenti come nel caso univariato

Distribuzione Normale multivariata:

//somma di variabili gaussiane indipendenti

• Siano

• La somma

è ancora distribuita normalmente

• Si noti che la distribuzione di z = x + y è cosa diversa dalla somma delle

distribuzioni di x e y (che in generale non è gaussiana).

Distribuzione Normale multivariata:

//congiunta, marginale e condizionata di v.a.g.

• Sia

con

• La distribuzione di x è la congiunta

Distribuzione Normale multivariata:

//congiunta, marginale e condizionata di v.a.g.

• La distribuzione di x è la congiunta

• Marginali:

• Condizionate

Distribuzione Normale multivariata:

//congiunta, marginale e condizionata di v.a.g.

• La distribuzione di x è la congiunta

• Marginali:

• Condizionate

Distribuzione Normale multivariata:

//formula di Bayes

• Siano

• La probabilità a posteriori vale:

• Inoltre:

Distribuzioni discrete multivariate

//Bernoulli generalizzata e Multinomiale

• E’ la generalizzazione a più eventi (e.g., lancio di dadi) della bernoulliana

• Variabile discreta che prende 1 di K valori (Bernoulli, K=2)

• Rappresentazione 1-of-K:

• Sia p(xk=1) =

• allora:

Distribuzioni discrete multivariate

//Bernoulli generalizzata e Multinomiale

• E’ la generalizzazione a più eventi (e.g., lancio di dadi) della binomiale

• Variabile discreta che prende 1 di K valori (binomiale, K=2)

Distribuzioni discrete multivariate

//Distribuzione di Dirichlet

• Generalizza la distribuzione Beta

• Molto usata come distribuzione a priori sui parametri

della Multinomiale

• Per K=3

Statistica Bayesiana

• La base è sempre il teorema di Bayes

• Definizione di distribuzione coniugata:

Distribuzioni e coniugate

Statistica Bayesiana

//metodologia generale

• Obiettivo: predire un dato x sulla base di n osservazioni

S = {x1, . . . , xn}

• Tre step:

• Specifica del modello h con parametri di tuning

generazione dei dati in S

• Inferenza (learning dei parametri)

• Predizione

per la

Modello o

ipotesi h

Statistica Bayesiana

//stime puntuali

• Rinunciando ad un approccio completamente Bayesiano, si possono ottenere

stime puntuali dei parametri

• Stima Maximum A Posteriori (MAP)

• Stima di massima verosimiglianza (Maximum Likelihood, ML)

Esempio: stima di massima verosimiglianza

• Insieme di campioni x1, . . . , xn da distribuzione Gaussiana di parametri

ignoti (identicamente distribuiti)

• Campioni estratti indipendentemente:

• allora

• oppure usando la log-verosimiglianza

Esempio: stima di massima verosimiglianza

//

della Gaussiana

• Se

con covarianza nota e media da stimare

• per il singolo campione

• derivando il secondo termine rispetto a

(il primo è costante rispetto a teta)

• per tutti i campioni

• ponendo uguale a 0

media empirica

Esempio: stima di massima verosimiglianza

// Parametri della Gaussiana

• Se

con covarianza e media da stimare

• per il singolo campione

• derivando il secondo termine rispetto a

prima

e

ripetendo il procedimento di

media empirica

covarianza empirica

Esempio: stima di massima verosimiglianza

// lancio di moneta

• Per un singolo lancio uso Bernoulli

1 se il lancio ha dato

“testa” come esito

0 altrimenti

• Likelihood per N lanci indipendenti

• Stima ML

=0

• Quindi se dopo N=3 lanci osservo S = {C, C, C} allora

=0

:-(

Esempio: stima Bayesiana

// lancio di moneta

• Nel setting ML (frequentistico) in realtà con N piccolo ottengo conclusioni

fuorvianti (la moneta è sicuramente truccata: darà sempre CCCCCCC....)

• Approccio Bayesiano:

funzione di

likelihood:

distribuzione

di Bernoulli

a posteriori:

distribuzione Beta

a priori coniugata di

Bernoulli:

distribuzione Beta

Esempio: stima Bayesiana

// lancio di moneta

• Approccio Bayesiano:

funzione di

likelihood:

distribuzione

di Bernoulli

a posteriori:

distribuzione Beta

a priori coniugata di

Bernoulli:

distribuzione Beta

a priori coniugata di

Bernoulli:

distribuzione Beta

funzione di

likelihood:

distribuzione

di Bernoulli

a posteriori:

distribuzione Beta

Esempio: stima Bayesiana

// lancio di moneta

• Approccio Bayesiano:

funzione di

likelihood:

distribuzione

di Bernoulli

a posteriori:

distribuzione Beta

a posteriori:

distribuzione Beta

• Uso come stima il valore atteso della Beta

a priori coniugata di

Bernoulli:

distribuzione Beta

Esempio: stima Bayesiana

// lancio di moneta

• Uso come stima il valore atteso della Beta

• Anche se uso un a priori uniforme

• Quindi se dopo N=3 lanci osservo S = {C, C, C} allora

= 0.2

;-)

Esempio: stima Bayesiana

// lancio di moneta

• Non a caso abbiamo utilizzato come stima il valore atteso della Beta

• Implicitamente abbiamo usato lo Step 3: predizione Bayesiana:

• Nel nostro esempio

Esempio: stima Bayesiana

// lancio di moneta

• Qual è la relazione con la stima di massima verosimiglianza?

• Per infiniti lanci

• ovvero:

• Infatti per T e N >>

e

Esempio: stima Bayesiana

// lancio di moneta

• Posso usare la formula di Bayes in modo ricorsivo (sequenziale)

• ad ogni lancio, osservo T o C e uso come a priori la posteriori (Beta) del lancio

precedente, quindi effettuo la predizione

• S={C,C,C}

osservo

inferenza

predìco

aggiorno la mia

credenza a priori

• S={C,C,C,T}

osservo

inferenza

predìco

aggiorno la mia

credenza a priori

Esempio: stima Bayesiana

// lancio di moneta

• Nel nostro modello h possiamo calcolare in forma chiusa anche la

verosimiglianza marginale o evidenza (dei dati)

• Ricordando che

• Usando Bayes

Esempio: stima Bayesiana di modelli

// lancio di moneta

• Abbiamo supposto di avere un modello M = h

• Cosa succede se avessimo due modelli possibili?

Esempio: stima Bayesiana di modelli

// lancio di moneta

• Si supponga di avere K possibili modelli M1, . . . ,MK per i dati osservati S

• Sia p(S|Mi) la distribuzione dei dati generati dal modello Mi (l’evidenza)

• Possiamo allora valutare la plausibilità del modello....con Bayes!!

preferenza iniziale del

modello

Esempio: stima Bayesiana di modelli

// lancio di moneta

• Definizioni

prior odds ratio

fattore di Bayes

rapporto degli odds a

posteriori

(posterior odds ratio)

Esempio: stima Bayesiana di modelli

// lancio di moneta

• Supponiamo che la moneta sia lanciata N = 250 volte, con T = 141 esiti Testa

e N " T = 109 esiti Croce.

• Vogliamo capire se la moneta è truccata (biased). Ipotizziamo due modelli

Modello M1

la moneta è truccata, il

parametro è aleatorio

Modello M0

la moneta non è

truccata, non ci sono

parametri da stimare

Esempio: stima Bayesiana di modelli

// lancio di moneta

• Supponiamo che la moneta sia lanciata N = 250 volte, con T = 141 esiti Testa

e N " T = 109 esiti Croce.

Modello M1

la moneta è truccata, il

parametro è aleatorio

Modello M0

la moneta non è

truccata, non ci sono

parametri da stimare

Esempio: stima Bayesiana di modelli

// lancio di moneta

• Supponiamo che la moneta sia lanciata N = 250 volte, con T = 141 esiti Testa

e N " T = 109 esiti Croce.

Esempio: stima Bayesiana di modelli

// lancio di moneta

Esempio: stima Bayesiana di modelli

// lancio di moneta (da MacKay)

Stima Bayesiana di modelli

// Il rasoio di Occam

!"#$%&"'()*+,"-.%(/"012(

Entia non sunt

-.#/0$#"12&%/31&45650&75&

multiplicanda

praeter

8'3"159&:"1,'/1&45*533"12;<&

necessitatem

Modello semplice

ma spiega pochi dati

Modello intermedio

!"##"$%&'(&)*+,$%&

Modello che spiega molti dati

ma troppo complesso

Stima Bayesiana di modelli

// Il rasoio di Occam

• Posso approssimare:

• Se assumiamo inoltre che la distribuzione a priori sia uniforme all’interno di un

largo intervallo

Stima Bayesiana di modelli

// Il rasoio di Occam

probabilità di osservare

il training set se il

parametro

del modello Mi assume

il valore più probabile

quantità che cresce al diminuire di

ovvero quanto più la distribuzione a

posteriori di è concentrata sul valore

derivato dall’osservazionedi S,

e quindi quanto più esso va a

modellare in modo preciso gli elementi

nel training set