Il punto su

n. 1 / 2015

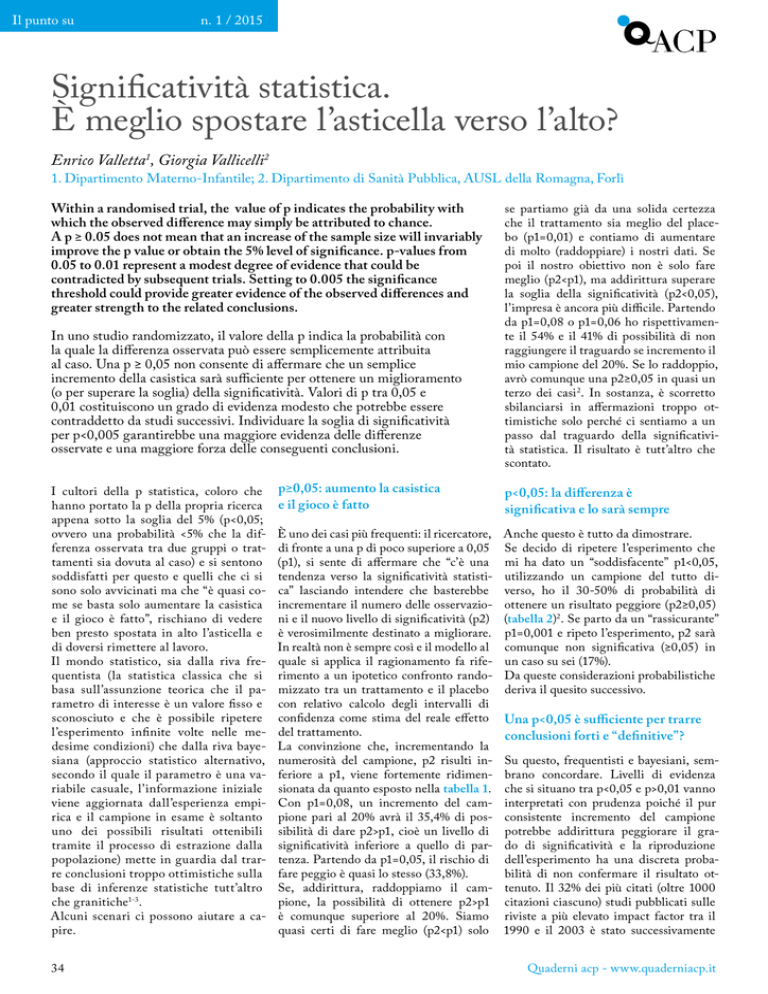

Significatività statistica.

È meglio spostare l’asticella verso l’alto?

Enrico Valletta1, Giorgia Vallicelli2

1. Dipartimento Materno-Infantile; 2. Dipartimento di Sanità Pubblica, AUSL della Romagna, Forlì

Within a randomised trial, the value of p indicates the probability with

which the observed difference may simply be attributed to chance.

A p ≥ 0.05 does not mean that an increase of the sample size will invariably

improve the p value or obtain the 5% level of significance. p-values from

0.05 to 0.01 represent a modest degree of evidence that could be

contradicted by subsequent trials. Setting to 0.005 the significance

threshold could provide greater evidence of the observed differences and

greater strength to the related conclusions.

In uno studio randomizzato, il valore della p indica la probabilità con

la quale la differenza osservata può essere semplicemente attribuita

al caso. Una p ≥ 0,05 non consente di affermare che un semplice

incremento della casistica sarà sufficiente per ottenere un miglioramento

(o per superare la soglia) della significatività. Valori di p tra 0,05 e

0,01 costituiscono un grado di evidenza modesto che potrebbe essere

contraddetto da studi successivi. Individuare la soglia di significatività

per p<0,005 garantirebbe una maggiore evidenza delle differenze

osservate e una maggiore forza delle conseguenti conclusioni.

I cultori della p statistica, coloro che

hanno portato la p della propria ricerca

appena sotto la soglia del 5% (p<0,05;

ovvero una probabilità <5% che la differenza osservata tra due gruppi o trattamenti sia dovuta al caso) e si sentono

soddisfatti per questo e quelli che ci si

sono solo avvicinati ma che “è quasi come se basta solo aumentare la casistica

e il gioco è fatto”, rischiano di vedere

ben presto spostata in alto l’asticella e

di doversi rimettere al lavoro.

Il mondo statistico, sia dalla riva frequentista (la statistica classica che si

basa sull’assunzione teorica che il parametro di interesse è un valore fisso e

sconosciuto e che è possibile ripetere

l’esperimento infinite volte nelle medesime condizioni) che dalla riva bayesiana (approccio statistico alternativo,

secondo il quale il parametro è una variabile casuale, l’informazione iniziale

viene aggiornata dall’esperienza empirica e il campione in esame è soltanto

uno dei possibili risultati ottenibili

tramite il processo di estrazione dalla

popolazione) mette in guardia dal trarre conclusioni troppo ottimistiche sulla

base di inferenze statistiche tutt’altro

che granitiche1-3.

Alcuni scenari ci possono aiutare a capire.

34

se partiamo già da una solida certezza

che il trattamento sia meglio del placebo (p1=0,01) e contiamo di aumentare

di molto (raddoppiare) i nostri dati. Se

poi il nostro obiettivo non è solo fare

meglio (p2<p1), ma addirittura superare

la soglia della significatività (p2<0,05),

l’impresa è ancora più difficile. Partendo

da p1=0,08 o p1=0,06 ho rispettivamente il 54% e il 41% di possibilità di non

raggiungere il traguardo se incremento il

mio campione del 20%. Se lo raddoppio,

avrò comunque una p2≥0,05 in quasi un

terzo dei casi 2. In sostanza, è scorretto

sbilanciarsi in affermazioni troppo ottimistiche solo perché ci sentiamo a un

passo dal traguardo della significatività statistica. Il risultato è tutt’altro che

scontato.

p≥0,05: aumento la casistica

e il gioco è fatto

p<0,05: la differenza è

significativa e lo sarà sempre

È uno dei casi più frequenti: il ricercatore,

di fronte a una p di poco superiore a 0,05

(p1), si sente di affermare che “c’è una

tendenza verso la significatività statistica” lasciando intendere che basterebbe

incrementare il numero delle osservazioni e il nuovo livello di significatività (p2)

è verosimilmente destinato a migliorare.

In realtà non è sempre così e il modello al

quale si applica il ragionamento fa riferimento a un ipotetico confronto randomizzato tra un trattamento e il placebo

con relativo calcolo degli intervalli di

confidenza come stima del reale effetto

del trattamento.

La convinzione che, incrementando la

numerosità del campione, p2 risulti inferiore a p1, viene fortemente ridimensionata da quanto esposto nella tabella 1.

Con p1=0,08, un incremento del campione pari al 20% avrà il 35,4% di possibilità di dare p2>p1, cioè un livello di

significatività inferiore a quello di partenza. Partendo da p1=0,05, il rischio di

fare peggio è quasi lo stesso (33,8%).

Se, addirittura, raddoppiamo il campione, la possibilità di ottenere p2>p1

è comunque superiore al 20%. Siamo

quasi certi di fare meglio (p2<p1) solo

Anche questo è tutto da dimostrare.

Se decido di ripetere l’esperimento che

mi ha dato un “soddisfacente” p1<0,05,

utilizzando un campione del tutto diverso, ho il 30-50% di probabilità di

ottenere un risultato peggiore (p2≥0,05)

(tabella 2)2. Se parto da un “rassicurante”

p1=0,001 e ripeto l’esperimento, p2 sarà

comunque non significativa (≥0,05) in

un caso su sei (17%).

Da queste considerazioni probabilistiche

deriva il quesito successivo.

Una p<0,05 è sufficiente per trarre

conclusioni forti e “definitive”?

Su questo, frequentisti e bayesiani, sembrano concordare. Livelli di evidenza

che si situano tra p<0,05 e p>0,01 vanno

interpretati con prudenza poiché il pur

consistente incremento del campione

potrebbe addirittura peggiorare il grado di significatività e la riproduzione

dell’esperimento ha una discreta probabilità di non confermare il risultato ottenuto. Il 32% dei più citati (oltre 1000

citazioni ciascuno) studi pubblicati sulle

riviste a più elevato impact factor tra il

1990 e il 2003 è stato successivamente

Quaderni acp - www.quaderniacp.it

n. 1 / 2015

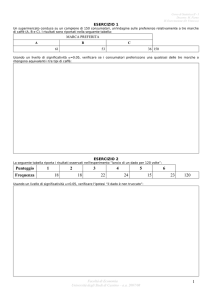

tabella 1

Probabilità (%) che p2 possa risultare meno significativa dopo incremento della

numerosità dei casi, partendo da livelli diversi di p1*

Valore di p1 (test a due code)

Incremento % della numerosità

dei casi

0,01

0,05

0,08

0,1

100

14,3

20,8

23,4

24,8

50

20,6

26,7

28,9

30,1

20

29,1

33,8

35,4

36,3

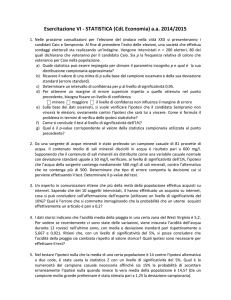

tabella 2

Percentuale di volte nelle quali ci si può attendere un risultato non significativo

(test a due code, alfa=0,05) se ripetiamo l’esperimento con la medesima

numerosità e lo analizziamo indipendentemente dal primo*

Valore attuale di p (p1)

Percentuale di volte

0,001

17,3

0,01

33,2

0,05

50,0

Il punto su

calcolata solo perché ci accorgiamo di

avere raggiunto una “striminzita” p<0,05.

Meglio verificare fino in fondo l’ipotesi e

puntare un po’ più in alto.

Se poi volessimo lanciarci in mare aperto, è bene ricordare che “la probabilità

a posteriori dell’ipotesi nulla dipende

dalla probabilità a priori che assegniamo

all’ipotesi nulla stessa” (un po’ come per

i test diagnostici) e che Barack Obama

si è trovato a misurare le probabilità di

successo di un’azione per catturare Bin

Laden senza l’aiuto di una p (più o meno

significativa) ma solo valutando, bayesianamente, le modificazioni dell’ipotesi

nulla sulla base di informazioni pervenute in momenti successivi5,6.

Corrispondenza

[email protected]

*modificate da voce bibliografica2

contraddetto o ha visto ridimensionata

la portata delle osservazioni da ricerche

successive4. È verosimile che in alcuni

casi la non riproducibilità dello studio sia

stata la semplice conseguenza dell’avere

utilizzato una soglia di significatività

statistica che non garantiva un’evidenza

sufficientemente forte rispetto all’effetto

osservato3.

Il suggerimento che ne deriva è di portare il livello di significatività statistica

convenzionale da p<0,05 a p<0,005 e

quello di alta significatività a p<0,001.

Per mettere in evidenza, con una potenza dell’80%, una variazione del 30% con

una significatività <0,005 occorrerebbe

“semplicemente” raddoppiare la numerosità del campione (es: da 69 a 130)3. Uno

sforzo rilevante ma non impossibile e

che avrebbe un’importante contropar-

tita in termini di “certezza” dell’effetto

osservato. Anche secondo l’approccio

bayesiano, una scelta di questo tipo porterebbe a una consistente riduzione della

probabilità di incorrere in un falso risultato positivo3.

In sintesi e come già detto, una p<0,05

significa che ho meno del 5% delle possibilità che la differenza osservata tra i due

trattamenti sia dovuta al caso. È tanto?

È poco? Dipende anche da quanto è rilevante il cambiamento (di terapia, di intervento, di strategia) che viene proposto

in virtù di questo risultato. Certamente,

meno dello 0,5% (p<0,005) è un’altra cosa e farebbe sentire più sicuri sulla reale

consistenza dell’effetto osservato.

Un motivo in più per non interrompere,

prima del termine, un trial ben disegnato e con una numerosità campionaria ben

1. Agabiti N, Davoli M, Fusco D, et al. Comparative evaluation of ealth services outcomes.

Epidemiol Prev 2001;35:1-80.

2. Wood J, Freemantle N, King M, Nazareth

I. Trap of trends to statistical significance:

likelihood fo near significant P value becoming more significant with extra data. BMJ

2014;348:g2215.

3. Johnson VE. Revised standards for statistical evidence. PNAS 2013;110:19313-17.

4. Ioannidis JPA. Contradicted and initially

stronger effects in highly cited clinical research. JAMA 2005;294:218-28.

5. Catelan D, Biggeri A, Barbone F. Multiple

testing and subgroup analysis (what’s wrong

in always searching for significant results).

Epidemiol Prev 2011;35:150-4.

6. Woodward B. Death of Osama bin Laden:

Phone call pointed U.S. to compound - and to

‘the pacer’. The Washington Post 2011, May 7.

Milano, S. Ambrogio 2014:

Civica Benemerenza a ACP Milano e Provincia

Il consiglio comunale di Milano ha insignito ACP Milano e Provincia di un attestato di Civica Benemerenza, nella rosa dei

prescelti per l’Ambrogino 2014, per l’attività di assistenza e coordinamento svolta a partire dal mese di luglio 2014 nell’ambito

dell’“emergenza Siria” in Stazione Centrale.

La consegna a Milano, il 7 dicembre, festa di S. Ambrogio, durante la cerimonia delle Civiche Benemerenze 2014 al Teatro

Dal Verme.

Quaderni acp - www.quaderniacp.it

35