Statistica Sociale e Criminale

(12 CFU)

A.A. 2015/2016

CdL Sociologia e Criminologia

Simone Di Zio

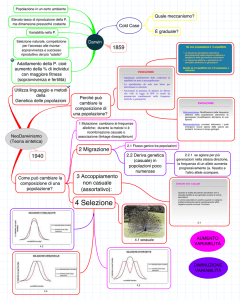

Dove siamo…

MODULO 3. L’Inferenza statistica

3.1 Probabilità e variabili casuali

3.2 Le tecniche di campionamento

3.3 Inferenza da “Esperimento statistico”

3.4 Inferenza da “Popolazioni finite”

Raggruppamenti che si possono formare associando due o più elementi di un insieme

o di insiemi diversi.

Disposizioni semplici: gli elementi di A sono presenti soltanto una volta in ogni

raggruppamento.

Disposizioni con ripetizione: in uno o più raggruppamenti gli elementi di A sono

presenti più di una volta.

Facce di un dado 𝑨 = {1,2,3,4,5,6}

I numeri di due cifre che si possono formare

lanciando due volte il dado e affiancando i

due risultati sono:

11

21

31

41

51

61

12

22

32

42

52

62

13

23

33

43

53

63

14

24

34

44

54

64

15

25

35

45

55

65

16

26

36

46

56

66

Disposizioni con ripetizione

Disposizioni con ripetizione di 𝑛 = 6 elementi

di classe 𝑘 = 2.

Si hanno 36 coppie, cioè 𝟔𝟐 .

Le disposizioni con ripetizione di 𝒏 elementi

di classe 𝒌 sono dati da 𝑛𝑘 .

Se togliamo tutti i raggruppamenti con

elementi ripetuti (11, 22, ...), che si trovano

sulla diagonale principale, si ottengono le

disposizioni semplici di classe 𝒌 = 𝟐.

Il numero delle disposizioni semplici di 𝑛

elementi di classe 𝑘 è dato da:

11

21

31

41

51

61

12

22

32

42

52

62

13

23

33

43

53

63

14

24

34

44

54

64

15

25

35

45

55

65

Disposizioni semplici

12

21

31

41

51

61

32

42

52

62

13 14

23 24

34

43

53 54

63 64

15

25

35

45

65

𝐷𝑛,𝑘 = 𝑛(𝑛 − 1)(𝑛 − 2)(𝑛 − 3) … (𝑛 − (𝑘 − 1))

Nell’esempio 𝑛 = 6 e (𝑛 − (𝑘 − 1)) = 5 per cui

16

26

36

46

56

66

𝑫𝟔,𝟐 = 𝟔 ∙ 𝟓 = 𝟑𝟎

16

26

36

46

56

Le permutazioni 𝑃𝑛 si hanno quando dato un insieme A di 𝑛 elementi i raggruppamenti

sono costituiti da 𝑛 elementi che differiscono fra loro solamente per l’ordine.

𝑃𝑛 = 𝑛!

Permutazioni di tre elementi (a), (b) e (c):

𝑃3 = 3! = 3 ∙ 2 ∙ 1 = 6.

{𝑎, 𝑏, 𝑐 }

{𝑎, 𝑐, 𝑏}

{𝑏, 𝑎, 𝑐 }

{𝑏, 𝑐, 𝑎}

{𝑐, 𝑎, 𝑏}

{𝑐, 𝑏, 𝑎}

Combinazioni di 𝒏 elementi di classe 𝒌 (𝐶𝑛,𝑘 ) i raggruppamenti di 𝑘 elementi tali che

ogni raggruppamento differisca dagli altri per la natura degli elementi.

Combinazioni

Per le combinazioni non interessa l’ordine, per

cui il gruppo {2,1} equivale al gruppo {1,2}.

21

31

41

51

61

In numero queste coppie sono 15

Le combinazioni si ottengono da:

𝐶𝑛,𝑘

Nell’esempio: 𝐶6,2 =

32

42

52

62

43

53

63

𝐷𝑛,𝑘 𝑛(𝑛 − 1)(𝑛 − 2) … (𝑛 − (𝑘 − 1))

=

=

𝑃𝑛

𝑘!

𝐷6,2

𝑃6

=

𝑛(𝑛−1)(𝑛−2)…(𝑛−(𝑘−1))

𝑘!

=

30

2

= 15

54

64

65

Misurare una

lunghezza

Metro

Misurare il peso

Misurare la

temperatura

Misurare il

verificarsi di un

evento

Bilancia

Termometro

Probabilità

Misura del grado di incertezza che riguarda il verificarsi di un evento.

I concetti base della teoria della probabilità sono:

la prova;

l’evento (indicato con 𝐸);

la probabilità (indicata con 𝑃).

“In una data prova 𝑖, l’evento 𝐸 si verifica con probabilità 𝑃(𝐸 )”.

nel lancio di un dado,

la faccia 3

si presenta con probabilità 1⁄6”.

PROVA

EVENTO E=3

PROBABILITA’ 𝑃(𝐸 ) = 1⁄6

Quindi la prova (detta anche esperimento aleatorio), non è altro che un esperimento

con due o più possibili risultati e in cui c’è un grado di incertezza sull’esito.

𝜔𝑖 – è il possibile esito di una prova

𝐸 – può essere scomposto in due o più eventi elementari.

Evento elementare

Evento non elementare

Prova: “lancio di un dado”

Eventi elementari sono le facce del dado

{𝜔1 = 1, 𝜔2 = 2, 𝜔3 = 3, 𝜔4 = 4, 𝜔5 = 5, 𝜔6 = 6}.

Evento non elementare: “esce un numero dispari”

si verifica ogni volta che si ha {1} o {3} o {5}.

𝐸 = {𝜔1 = 1, 𝜔2 = 3, 𝜔3 = 5}

Struttura matematica con operazioni e regole per operare con gli eventi.

Le tre operazioni fondamentali dell’algebra di Boole:

̅ . L’evento 𝐴̅ (detto anche evento

1. Negazione di un evento 𝐴, indicata con 𝑨

complementare) si verifica quando non si verifica 𝐴.

Ad esempio se nel lancio di un dado l’evento 𝐴 è “faccia 1 o faccia 2”, allora l’evento

complementare 𝐴̅ si verifica con le facce 3, 4, 5 o 6.

2. Intersezione di due eventi 𝐴 e 𝐵, che si indica con 𝑨 ∩ 𝑩. Dati gli eventi 𝐴 e 𝐵,

l’evento 𝐴 ∩ 𝐵 si verifica quando si verificano entrambi gli eventi.

3. Unione fra due eventi 𝐴 e 𝐵, che si indica con 𝑨 ∪ 𝑩. Dati gli eventi 𝐴 e 𝐵,

l’evento 𝐴 ∪ 𝐵 si verifica quando almeno uno dei due si verifica. Cioè deve

verificarsi o l’evento 𝐴, o l’evento 𝐵, o entrambi.

Dato un mazzo di carte napoletane, definiamo i seguenti eventi:

A. Estrazione di una carta di denari;

B. Estrazione di un asso;

𝐴̅ sono le trenta carte di coppe, bastoni e spade.

𝐵̅ contiene 36 carte, tutte quelle che non sono un asso.

𝐴 ∩ 𝐵 è rappresentata dall’asso di denari (1𝑑).

𝐴 ∪ 𝐵 è rappresentato da tutte le carte contenute nei due ovali. Si verifica quando “esce

una carta di denari” o “un asso”, quindi nell’evento unione vi sono 13 carte, cioè 13

eventi elementari.

L’insieme di tutti i possibili eventi elementari (𝜔𝑖 ) di un esperimento.

In genere si indica con Ω.

Lancio di due monete.

𝑇 = Testa

𝐶 = Croce

Lo spazio campionario è dato da: Ω = {(𝑇𝑇), (𝑇𝐶 ), (𝐶𝑇), (𝐶𝐶 )}.

Evento impossibile: un evento che non potrà mai verificarsi, come la faccia 7 su

un dado a sei facce. La probabilità di un evento impossibile è pari a 0;

Evento certo: evento che si verifica sempre, perché include tutti i risultati possibili

dell’esperimento. La probabilità di un evento certo è pari a 1.

La probabilità è una funzione che associa ad ogni evento 𝐸 un numero reale fra 0 e 1,

numero che si indica con 𝑃(𝐸 ).

Postulato 1: 𝑃(𝐴) ≥ 0.

La probabilità è sempre un numero maggiore o uguale a zero. È pari a zero solo

nel caso particolare in cui 𝐴 sia un evento impossibile;

Postulato 2: 𝑃(Ω) = 1.

La probabilità che si verifichi uno qualunque degli eventi dello spazio campionario

è pari a uno (evento certo);

Postulato 3: Se 𝐴 ∩ 𝐵 = ∅ allora 𝑃(𝐴 ∪ 𝐵) = 𝑃(𝐴) + 𝑃(𝐵).

Nel caso in cui due eventi siano incompatibili, la probabilità dell’unione è data

dalla somma delle probabilità dei due eventi (principio delle probabilità totali).

Delle probabilità totali per eventi compatibili

𝐴∩𝐵

In una prova, dati due eventi 𝐴 e 𝐵 si ha che:

A

𝑃 (𝐴 ∪ 𝐵 ) = 𝑃 (𝐴 ) + 𝑃 (𝐵 ) − 𝑃 (𝐴 ∩ 𝐵 )

𝐵

Se invece gli eventi sono incompatibili (𝐴 ∩ 𝐵 = ∅) allora si ha

𝑃 (𝐴 ∪ 𝐵 ) = 𝑃 (𝐴 ) + 𝑃 (𝐵 )

A

𝐵

.

Vale nel caso in cui gli eventi elementari sono tutti noti e sono in numero finito.

(es. giochi di azzardo)

Definizione: la probabilità è data dal rapporto fra il numero di casi favorevoli

all’evento e il numero di casi possibili, a condizione che questi ultimi siano tutti

egualmente possibili.

𝑁𝐹

𝑃 (𝐸 ) =

𝑁𝑃

𝑁𝑃 = 2

𝑁𝐹 1

𝑃(𝑇𝑒𝑠𝑡𝑎) =

=

𝑁𝑃 2

𝑁𝑃 = 6

Se volessimo calcolare la probabilità di 𝐴 =“esce un numero pari”

dobbiamo contare il numero di eventi elementari favorevoli ad 𝐴

Si tratta delle tre facce contrassegnate dai numeri 2, 4 e 6.

Quindi 𝑁𝐹 = 3.

Ne deriva che

𝑁𝐹 3 1

𝑃 (𝐴 ) =

= =

𝑁𝑃 6 2

𝑁𝐹

Probabilità di un evento (𝐴) sapendo che si è già verificato un altro evento (𝐵) a cui 𝐴

è legato.

Definiamo due eventi:

A: esce la faccia 3;

B: esce un numero dispari.

Le probabilità di questi due eventi sono

𝑁𝐹

1

𝑃(𝐴) = 𝑁𝑃 = 6

𝑁𝐹

3

1

𝑃(𝐵) = 𝑁𝑃 = 6 = 2

: sapendo che si è verificato 𝐵 (è uscita una faccia dispari) qual è la

probabilità di 𝐴 alla luce di questa informazione?

Questa probabilità si chiama probabilità condizionata, e si indica con il simbolo

𝑃(𝐴|𝐵)

Se 𝐵 si è verificato, le facce possibili sono 1, 3 e 5. 𝑁𝑃 = 3

A questo punto la probabilità di 𝐴 si è modificata, perché ora 𝑁𝐹 = 1

per cui:

𝑁𝐹 1

𝑃(𝐴|𝐵) =

=

𝑁𝑃 3

Avere informazioni sul fatto che 𝐵 sia verificato significa che esso diventa il nuovo

spazio campionario.

I casi favorevoli ad 𝐴 sono solo quelli inclusi in 𝐵, ossia (𝐴 ∩ 𝐵).

Pertanto si definisce probabilità condizionata:

𝑃 (𝐴 ∩ 𝐵 )

𝑃(𝐴|𝐵) =

𝑃 (𝐵 )

L’evento che si scrive dopo la linea verticale | è l’evento condizionante.

Da questa formula:

𝑃 (𝐴 ∩ 𝐵 )

𝑃(𝐴|𝐵) =

𝑃 (𝐵 )

si ricava la formula base del principio delle probabilità composte:

𝑃(𝐴 ∩ 𝐵) = 𝑃(𝐵) ∙ 𝑃(𝐴|𝐵)

Si dice che due eventi 𝑨 e 𝑩 sono stocasticamente indipendenti se il verificarsi di

uno di essi non influenza la probabilità del verificarsi dell’altro.

Se la probabilità di 𝐴 non dipende dal verificarsi di 𝐵, i due eventi sono indipendenti e

possiamo scrivere:

𝑃(𝐴|𝐵) = 𝑃(𝐴)

Se due eventi sono stocasticamente indipendenti valgono entrambe le seguenti:

𝑃(𝐴|𝐵) = 𝑃(𝐴)

𝑃(𝐵|𝐴) = 𝑃(𝐵)

Sapendo che:

𝑃 (𝐴 ∩ 𝐵 )

𝑃(𝐴|𝐵) =

𝑃 (𝐵 )

Ne deriva che la probabilità dell’intersezione è pari a:

𝑷(𝑨 ∩ 𝑩) = 𝑷(𝑨) ∙ 𝑷(𝑩)

QUINDI: due eventi A e B si dicono stocasticamente indipendenti se e solo se:

𝑃(𝐴 ∩ 𝐵) = 𝑃(𝐴) ∙ 𝑃(𝐵)

Mazzo di 40 carte napoletane. Si estrae una sola carta e si definiscono due eventi:

Evento A: “esce un asso”;

Evento B: “esce una carta di bastoni”.

Dati:

4

1

𝑃(𝐴) = 40 = 10

10

𝑃(𝐵) = 40

probabilità di estrarre un asso

probabilità di estrarre una carta di bastoni

1

𝑃(𝐴 ∩ 𝐵) = 40

probabilità di estrarre l’asso di bastoni

Vogliamo la probabilità condizionata 𝑃(𝐴|𝐵) cioè la probabilità di avere un asso

sapendo che è uscita una carta di bastoni.

Applichiamo la formula della probabilità condizionata:

1

𝑃(𝐴 ∩ 𝐵) 40

1

𝑃(𝐴|𝐵) =

=

=

10

(

)

𝑃 𝐵

10

40

Questa equivale alla 𝑃(𝐴) quindi i due eventi 𝐴 e 𝐵 sono stocasticamente indipendenti.

Popolazione: 10% degli individui è affetta da diabete.

Il test ematico:

- falsi negativi, il 10% delle volte (test negativo - soggetto malato)

- falsi positivi, il 20% delle volte (test positivo - soggetto sano)

La domanda è: se un individuo risulta positivo al test qual è la probabilità che sia

effettivamente diabetico?

Gli eventi in gioco sono:

𝐴1 : l’individuo è diabetico;

𝐴0 : l’individuo è sano;

𝐵1 : il test è risultato positivo;

𝐵0 : il test è risultato negativo;

La domanda può essere formalizzata con le probabilità condizionate:

𝑃(𝐴1 |𝐵1 )

In generale date un numero 𝑘 di cause 𝐴𝑖 (per 𝑖 = 1,2, … , 𝑘) e dato un evento 𝐵 che

può essere generato da una di quelle cause, la probabilità 𝑃(𝐴𝑖 |𝐵) è detta probabilità

a posteriori

: dato un insieme esclusivo ed esaustivo di eventi 𝐴1 , 𝐴2 , … , 𝐴𝑘 ed un

evento 𝐵 si ha:

𝑃(𝐴𝑖 ) ∙ 𝑃(𝐵|𝐴𝑖 )

𝑃(𝐴𝑖 |𝐵) =

𝑃(𝐴1 ) ∙ 𝑃(𝐵|𝐴1 ) + 𝑃(𝐴2 ) ∙ 𝑃(𝐵|𝐴2 ) + ⋯ + 𝑃(𝐴𝑘 ) ∙ 𝑃(𝐵|𝐴𝑘 )

Gli elementi importanti di questa formula sono:

Le probabilità 𝑃(𝐴𝑖 ): probabilità a priori

Le probabilità 𝑷(𝑩|𝑨𝒊 ): probabilità condizionate, o verosimiglianze

Le probabilità 𝑃(𝐴𝑖 |𝐵), che sono le probabilità a posteriori. Si tratta delle

probabilità degli eventi 𝐴𝑖 (le cause) sapendo che si è verificato l’evento 𝐵

(l’effetto).

𝐴1 : l’individuo è diabetico;

𝐴0 : l’individuo è sano;

𝐵1 : il test è risultato positivo;

𝐵0 : il test è risultato negativo;

Verosimiglianza 𝑃(𝐵1 |𝐴1 ) - probabilità che il test sia positivo sapendo che l’individuo

è malato

Probabilità a posteriori 𝑃(𝐴1 |𝐵1 ) - probabilità che un individuo sia malato sapendo che

il test è risultato positivo.

Concetti molto diversi che non vanno confusi.

Quando ci sono più cause (𝐴1 , 𝐴2 , … , 𝐴𝑘 ) che possono determinare un evento 𝐵, il

teorema di Bayes fornisce una formula per calcolare la probabilità a posteriori, cioè

la probabilità che una determinata causa (𝐴𝑖 ) fra le 𝑘 possibili abbia agito sapendo che

l’evento 𝐵 si è verificato.

Nel nostro

, il fatto che il test sia

positivo (l’effetto osservato 𝐵1 ) può

dipendere sia dalla causa che l’individuo è

effettivamente malato (evento 𝐴1 ) e sia

dal fatto che si è verificato un falso

positivo (evento 𝐴0 ), cioè l’individuo è

sano.

𝑃(𝐴1 |𝐵1 )

𝐵1

Individuo Malato

0,10

𝐴1

Falso Positivo

0,20

𝐴0

Supponiamo di avere i seguenti dati:

𝑃(𝐴1 )=0.1

prob. di avere un individuo diabetico;

𝑃(𝐴0 ) = 0.9

prob. di avere un individuo sano;

𝑃(𝐵1 |𝐴0 ) = 0.2

prob. di un falso positivo;

𝑃(𝐵0 |𝐴1 ) = 0.1

prob. di un falso negativo;

𝑃(𝐵1 |𝐴1 ) = 0.9

prob. di avere test positivo sapendo che il soggetto è diabetico.

La nostra domanda è:

𝑃(𝐴1 |𝐵1 ) =?

Prob. che un individuo positivo al test sia effettivamente diabetico?

𝑃(𝐴1 )=0.1

prob. di avere un individuo diabetico;

𝑃(𝐴0 ) = 0.9

prob. di avere un individuo sano;

𝑃(𝐵1 |𝐴0 ) = 0.2

prob. di un falso positivo;

𝑃(𝐵0 |𝐴1 ) = 0.1

prob. di un falso negativo;

𝑃(𝐵1 |𝐴1 ) = 0.9

prob. di avere test positivo sapendo che il soggetto è diabetico.

Applicando il teorema di Bayes abbiamo:

𝑃(𝐴1 ) ∙ 𝑃(𝐵1 |𝐴1 )

0.1 ∙ 0.9

𝑃(𝐴1 |𝐵1 ) =

=

= 0.33

𝑃(𝐴1 ) ∙ 𝑃(𝐵1 |𝐴1 ) + 𝑃(𝐴0 ) ∙ 𝑃(𝐵1 |𝐴0 ) 0.1 ∙ 0.9 + 0.9 ∙ 0.2

Definizione classica:

la probabilità è data dal rapporto fra il numero di casi favorevoli all’evento e il

numero di casi possibili, a condizione che questi ultimi siano tutti egualmente

possibili.

Definizione frequentista:

la probabilità di un evento è il limite cui tende la

frequenza relativa dell'evento al crescere del

numero degli esperimenti.

Per conoscere la probabilità di un evento

dobbiamo ricorrere all’esperienza, nel senso che

su un numero elevato di prove si riscontra una

certa regolarità. Formalmente si ha:

𝑛𝐴

𝑃(𝐴) = lim

𝑛→∞ 𝑛

Prob. di morte di una data popolazione;

prob. di incidenti automobilistici; prob. di

incidenti sul lavoro.

𝑛𝐴 è il numero di volte che, su n prove, l’evento 𝐴 si è verificato.

L’approccio classico e quello frequentista rientrano nel campo della probabilità

oggettiva, per distinguerla da un altro approccio, noto come impostazione soggettiva.

La probabilità 𝑃(𝐸 ) di un evento 𝐸 è la

misura del grado di fiducia che un

individuo coerente attribuisce al

verificarsi dell’evento 𝐸.

Quindi le probabilità di uno stesso

evento possono anche essere diverse se

fornite da soggetti diversi.

Ricapitolando:

Abbiamo parlato di prove ed eventi

Abbiamo indicato con il 𝜔𝑖 l’evento elementare

L’insieme di tutti i possibili eventi di una prova si chiama spazio campionario (Ω)

𝑇e𝐶

“1d”, “2d”

𝐴, 𝐵, 𝐶.

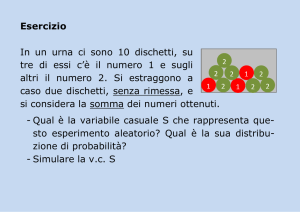

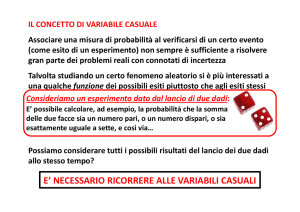

E’ giunto il momento di indicare gli eventi con dei numeri reali.

Da questa riflessione nasce l’importante concetto di variabile casuale

Una variabile casuale 𝑋 è una funzione definita sullo spazio campionario Ω che

associa ad ogni suo elemento 𝜔𝑖 un numero reale.

Si tratta di associare un numero reale ad ogni evento elementare di una prova.

I valori della variabile casuale saranno pertanto indicati con 𝑋1 , 𝑋2 , … 𝑋𝑛 .

Lancio di una moneta. Possiamo assegnare 1 all’evento 𝜔1 = 𝑇 e 2 all’evento 𝜔2 = 𝐶

(Figura 1.3).

Prova:

Lancio di due dadi

Evento:

S = somma dei punteggi delle due facce

X = numeri da 2 a 12 (in altre parole, i valori che S può assumere sono 11)

Eventi di 𝛀

1-1

1-2

1-3

1-4

1-5

1-6

2-6

3-6

4-6

5-6

6-6

2-1

2-2

2-3

2-4

2-5

3-5

4-5

5-5

6-5

3-1

3-2

3-3

3-4

4-4

5-4

6-4

4-1

4-2

4-3

5-3

6-3

5-1

5-2

6-2

6-1

Valori di X

𝑋1 = 2

𝑋2 = 3

𝑋3 = 4

𝑋4 = 5

𝑋5 = 6

𝑋6 = 7

𝑋7 = 8

𝑋8 = 9

𝑋9 = 10

𝑋10 = 11

𝑋11 = 12

Quindi è il modo in cui definiamo la variabile casuale che determina gli eventi

elementari e, di conseguenza, lo spazio campionario.

Variabile Casuale

DISCRETA

CONTINUA

Può assumere un insieme discreto

(finito o numerabile) di numeri

reali. Gli esempi delle carte, dei

dadi e delle monete sono tutti

esempi di variabili casuali discrete.

Vi ricorda

qualcosa?

𝑿

𝒙𝟏

𝒙𝟐

…

𝒙𝒊

…

𝒙𝒌

..

..

..

..

..

..

..

..

Può può assumere tutti gli

infiniti valori compresi in un

intervallo di numeri reali.

Per indicare una variabile casuale si

adopera una lettera maiuscola, es. 𝑋.

Per indicare un suo valore, ovvero una sua

determinazione, si usa la corrispondente

lettera minuscola.

Così 𝑥𝑖 è il generico (i-esimo) valore della

variabile casuale 𝑋.

Il passaggio ulteriore è associare le probabilità ai valori della variabile causale.

Lancio di una moneta

𝑿

𝟏

𝟐

𝒑𝒊

0,5

0,5

1,0

Vi ricorda

qualcosa?

Prova:

Evento:

𝑿

2

3

4

5

6

7

8

9

10

11

12

Totale

Lancio di due dadi

S = somma dei punteggi delle due facce

𝑷( 𝒙 )

1⁄36

2⁄36

3⁄36

4⁄36

5⁄36

6⁄36

5⁄36

4⁄36

3⁄36

2⁄36

1⁄36

1

Questa è una

Distribuzione di probabilità

1

𝑃(𝑋 = 2) = 𝑃(1,1) =

36

1

1

2

𝑃(𝑋 = 3) = 𝑃[(1,2) ∪ (2,1)] =

+

=

36 36 36

1-1

1-2

1-3

1-4

1-5

1-6

2-6

3-6

4-6

5-6

6-6

2-1

2-2

2-3

2-4

2-5

3-5

4-5

5-5

6-5

3-1

3-2

3-3

3-4

4-4

5-4

6-4

4-1

4-2

4-3

5-3

6-3

5-1

5-2

6-2

6-1

𝑋1 = 2

𝑋2 = 3

𝑋3 = 4

𝑋4 = 5

𝑋5 = 6

𝑋6 = 7

𝑋7 = 8

𝑋8 = 9

𝑋9 = 10

𝑋10 = 11

𝑋11 = 12

Ricorda: secondo il principio delle probabilità totali la

probabilità dell’evento unione di due eventi elementari è pari

alla somma delle probabilità dei due eventi elementari:

𝑃(𝐴 ∪ 𝐵) = 𝑃(𝐴) + 𝑃(𝐵).

𝑋

𝑥1

𝑥2

…

𝑥𝑖

…

𝑥𝑘

Totale

𝑃(𝑥𝑖 )

𝑝(𝑥1 )

𝑝(𝑥2 )

…

𝑝(𝑥𝑖 )

…

𝑝(𝑥𝑘 )

1

Così come la distribuzione di frequenza associa una frequenza ad ogni valore di una

variabile statistica, la distribuzione di probabilità associa una probabilità ad ogni

valore di una variabile casuale.

Per una distribuzione di probabilità è utile sapere la probabilità che la variabile casuale

assuma un valore minore o uguale a un certo 𝑥𝑖 . A tal fine si calcolano le probabilità

cumulate, che indichiamo con 𝑃(𝑋 ≤ 𝑥𝑖 ).

Data una variabile casuale discreta 𝑋, la funzione che associa ai valori 𝑥 le probabilità

cumulate 𝑃(𝑋 ≤ 𝑥 ) si chiama funzione di ripartizione:

𝐹 (𝑥 ) = 𝑃 (𝑋 ≤ 𝑥 ) = ∑ 𝑃 (𝑋 = 𝑠 )

𝑠≤𝑥

Funzione di ripartizione nel caso del lancio di due dadi

𝑿

2

3

4

5

6

7

8

9

10

11

12

𝑭(𝒙)

1⁄36

3⁄36

6⁄36

10⁄36

15⁄36

21⁄36

26⁄36

30⁄36

33⁄36

35⁄36

1

Grafico della Funzione di probabilità della

v.c. X “somma dei punteggi di due dadi”

Grafico della Funzione di Ripartizione

della v.c. X “somma dei punteggi di due

dadi”

1.20

0.18

0.16

1.00

0.14

0.80

0.10

F(X)

P(X)

0.12

0.08

0.60

0.40

0.06

0.04

0.20

0.02

0.00

0.00

2

3

4

5

6

7

X

8

9

10

11

12

2

3

4

5

6

7

X

8

9

10

11

12

La variabile casuale continua può assumere tutti gli infiniti valori compresi in un

intervallo di numeri reali.

Non è possibile, e non avrebbe senso, associare una probabilità ad ognuno degli infiniti

valori della v.c.

Quindi, si associa una probabilità a degli intervalli di valori che la v.c. può assumere.

A tal fine si introduce in concetto di funzione di densità, che è l’analogo della la

funzione di probabilità per le variabili casuali discrete.

Si chiama funzione di densità della variabile casuale continua 𝑋 la

funzione matematica 𝑓(𝑥) per cui, dato un certo intervallo di valori di 𝑋,

l’area sottostante alla funzione è uguale alla probabilità che 𝑋 assuma un

valore all’interno di quell’intervallo.

Se gli estremi dell’intervallo dei valori di 𝑋 li indichiamo con le lettere minuscole 𝑎 e

𝑏, la funzione di densità soddisfa la seguente relazione:

𝑏

𝑃(𝑎 ≤ 𝑋 ≤ 𝑏) = ∫ 𝑓 (𝑥 )𝑑𝑥

𝑎

Definiamo una v.c. con valori nell’intervallo [0; 20] e probabilità definite dalla

seguente funzione di densità:

0

𝑝𝑒𝑟 𝑥 ∉ [0; 20]

𝑓 (𝑥 ) = {

0.05 𝑝𝑒𝑟 𝑥 ∈ [0; 20]

Verifichiamo che sia effettivamente una funzione di densità

Di fatti si tratta di una funzione di densità perché l’area sottesa alla curva è pari a 1, ed

è facile verificarlo.

È un rettangolo con base 20 e altezza 0.05, quindi l’area è proprio 20 ∙ 0.05 = 1.

Grafico della Funzione di Densità costante

Ora, se volessimo conoscere la probabilità che questa v.c. assume nell’intervallo

[10; 15], basta calcolare la corrispondente area che risulta essere 5 ∙ 0.05 = 0.25.

0.06

0.05

f(X)

0.04

0.03

0.25

0.02

0.01

0

0

10

15

X

In termini formali abbiamo:

15

∫ 𝑓 (𝑥 )𝑑𝑥 = 0.25

10

20

Data una variabile casuale continua 𝑋, la funzione che associa ai valori 𝑥 le

probabilità cumulate 𝑃(𝑋 ≤ 𝑥 ) si chiama funzione di ripartizione e si indica con:

𝑥

𝐹 (𝑥 ) = 𝑃(𝑋 ≤ 𝑥 ) = ∫ 𝑓(𝑡)𝑑𝑡

−∞

Segue la proprietà che l’area totale sottesa alla curva, cioè per valori che vanno da meno

infinito a più infinito (−∞; +∞), è sempre pari a 1:

+∞

∫

−∞

𝑓 (𝑥 )𝑑𝑥 = 1

Come per le distribuzioni di frequenza, esistono indici di sintesi e variabilità per le

distribuzioni di probabilità.

Una descrizione sintetica di una distribuzione di probabilità può essere fatta

sostanzialmente tramite il valore atteso e la varianza.

Il valore atteso di una variabile casuale è il valore medio che essa può assumere in un

numero elevato di prove. Si indica con 𝑬(𝑿) ed è definito in maniera diversa a seconda

se si ha una v.c. discreta o continua.

Per una variabile casuale discreta

𝐸 (𝑋) = ∑𝑖 𝑥𝑖 𝑃(𝑥𝑖 )

Per una variabile casuale continua

𝐸 (𝑋) = ∫−∞ 𝑥𝑓(𝑥 )𝑑𝑥

+∞

Valore atteso della variabile casuale 𝑋 “somma dei punteggi di due dadi”

𝑿

2

3

4

5

6

7

8

9

10

11

12

𝑷(𝒙)

1⁄36

2⁄36

3⁄36

4⁄36

5⁄36

6⁄36

5⁄36

4⁄36

3⁄36

2⁄36

1⁄36

𝑥𝑖 𝑃(𝑥𝑖 )

2 ∙ 1⁄36

3 ∙ 2⁄36

4 ∙ 3⁄36

5 ∙ 4⁄36

6 ∙ 5⁄36

7 ∙ 6⁄36

8 ∙ 5⁄36

9 ∙ 4⁄36

10 ∙ 3⁄36

11 ∙ 2⁄36

12 ∙ 1⁄36

0.028

0.056

0.083

0.111

0.139

0.167

0.139

0.111

0.083

0.056

0.028

7.000

𝐸 (𝑋) = ∑ 𝑥𝑖 𝑃(𝑥𝑖 )

𝑖

𝐸 (𝑋) = 7.

La variabilità di una v.c. viene misurata tramite la varianza e si indica con il simbolo

𝑉𝑎𝑟(𝑋).

Per una variabile casuale discreta

𝑉𝑎𝑟(𝑋) = ∑𝑖[𝑥𝑖 − 𝐸 (𝑋)]2 𝑃(𝑥𝑖 )

Per una variabile casuale continua

𝑉𝑎𝑟(𝑋) = ∫−∞ [𝑥 − 𝐸 (𝑋)]2 𝑓(𝑥 )𝑑𝑥

+∞

Per le distribuzioni di frequenza si ha una somma di quadrati degli scarti fra

il valore della variabile e la sua media aritmetica, tutto ponderato con le frequenze.

Per le distribuzioni di probabilità abbiamo una somma di quadrati degli scarti fra

il valore della variabile e il suo valore atteso, tutto ponderato con le probabilità.

La radice quadrata della varianza si chiama scostamento quadratico medio o

deviazione standard: 𝐷𝑆(𝑋) = √𝑉𝑎𝑟(𝑋).

Vi sono alcune variabili casuali che nella pratica sono molto utilizzate.

Per esse sono note diverse caratteristiche e proprietà, fra cui il valore

atteso e la varianza.

Si distinguono in due grosse categorie:

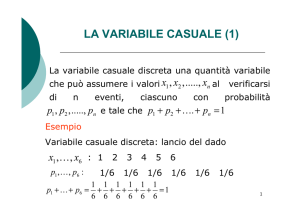

La variabile casuale Uniforme discreta può assumere valori interi in un dato

intervallo, e ogni valore presenta la stessa probabilità. Se 𝑛 è il numero dei possibili

valori la funzione di probabilità è data da:

1

𝑃 (𝑋 ) =

𝑛

0.12

0.10

0.08

P(X)

estrazione di una carta da un mazzo

di dieci carte numerate da 1 a 10.

𝑛 = 10. da cui 𝑃(𝑋) = 1⁄10,

0.06

0.04

0.02

0.00

1

2

3

4

5

6

X

7

8

9

10

Lo schema in cui si inserisce la variabile casuale di Bernoulli è quello di una prova il

cui esito è dicotomico, ovvero con sole due possibilità, del tipo sì/no, vero/falso

eccetera.

Si assegna valore 1 se l’evento si è verificato (sì, vero, superato ecc.) e 0 altrimenti (no,

falso, non superato ecc.).

La v.c. di Bernoulli assume valore 1 con probabilità 𝜋 e valore 0 con probabilità 1 − 𝜋

e ha la seguente funzione di probabilità

𝑃(𝑋) = 𝜋 𝑥 (1 − 𝜋)1−𝑥

Il valore atteso è:

𝐸 (𝑋 ) = 𝜋

La varianza è:

𝑉𝑎𝑟(𝑋) = 𝜋(1 − 𝜋)

Si parte da 𝑛 variabili casuali di Bernoulli, indipendenti e aventi stessa distribuzione

(cioè stesso parametro 𝜋). Se ne fa la somma.

Otteniamo una variabile casuale Binomiale.

Lancio 𝑛 volte una moneta,

1 evento Testa

0 evento Croce.

Ogni singolo lancio rientra nello schema Bernoulliano, con probabilità 𝜋 = 1⁄2.

Indichiamo la sequenza delle 𝑛 prove con 𝑋1 , 𝑋2 , 𝑋3 , … , 𝑋𝑛 ,

𝑋1 è il risultato della 1° prova (che può essere 0 o 1)

𝑋2 è il risultato della 2°prova (sempre con possibili valori, 0 o 1)

…

𝑋𝑛 è il risultato della n° prova (sempre con possibili valori, 0 o 1)

Ora definiamo una nuova variabile casuale come somma delle precedenti:

𝑋 = 𝑋1 + 𝑋2 + ⋯ + 𝑋𝑛 .

Essa può assumere valori da 0 a n.

Se lancio tre volte una moneta, il valore cha abbiamo indicato come successo (Testa)

può presentarsi

0 volte (0T e 4C)

1 volta (1T e 3C)

2 volte (2T e 3C)

3 volte (3T e 1C)

4 volte (4T e 0C)

La variabile casuale 𝑋 esprime il numero di successi in 𝒏 prove indipendenti.

La funzione di probabilità che deriva da questo schema si chiama funzione di

probabilità Binomiale, i cui parametri caratteristici sono 𝑛 e 𝜋.

La variabile casuale Binomiale - che si indica con 𝑋~𝐵𝑖𝑛𝑜𝑚𝑖𝑎𝑙𝑒(𝜋; 𝑛) – rappresenta

il numero di successi che si hanno in 𝑛 prove di tipo Bernoulliano indipendenti e con

parametro costante 𝜋. La funzione di probabilità Binomiale è data da:

𝑛 𝑥

(

)

𝑃 𝑋 = ( ) 𝜋 (1 − 𝜋)1−𝑥

𝑥

Per 𝑥 = 0,1,2 … , 𝑛 e 0 ≤ 𝜋 ≤ 1.

Il valore atteso è dato da:

𝐸 (𝑋) = 𝑛𝜋

La varianza è data da:

𝑉𝑎𝑟(𝑋) = 𝑛𝜋(1 − 𝜋)

Situazione: numero di eventi che si possono verificare in un dato intervallo di tempo.

(automobili che transitano a un casello autostradale in un giorno, numero di terremoti che si

verificano in una regione in un anno, numero di incidenti stradali lungo un’autostrada in un mese.)

Una variabile casuale di Poisson - che si indica con 𝑋~𝑃𝑜𝑖𝑠𝑠𝑜𝑛(𝜆) - assume

qualunque valore intero 𝑥 ≥ 0. La funzione di probabilità della Poisson è data da:

𝜆𝑥 −𝜆

𝑃 (𝑋 ) = 𝑒

𝑥!

La v.c. assume valori del tipo 𝑥 = 0,1,2, …

L’unico parametro che caratterizza questa distribuzione è lambda (𝜆).

Il valore atteso è dato da:

𝐸 (𝑋 ) = 𝜆

La varianza è data da:

𝑉𝑎𝑟(𝑋) = 𝜆

La v.c. Uniforme è una variabile casuale che segue la stessa logica della v.c. uniforme

discreta, ma in questo caso i parametri che definiscono la funzione di densità sono gli

estremi dell’intervallo.

Un variabile casuale Uniforme continua 𝑋, indicata con 𝑋~𝑈(𝑎, 𝑏) assume valori

reali in un intervallo limitato [𝑎; 𝑏]. La funzione di densità è la seguente:

1

𝑓 (𝑥 ) = {𝑏 − 𝑎

0

Il valore atteso è dato da:

La varianza è data da:

𝐸 (𝑋 ) =

𝑝𝑒𝑟 𝑎 ≤ 𝑥 ≤ 𝑏

𝑎𝑙𝑡𝑟𝑜𝑣𝑒

𝑎+𝑏

2

𝑉𝑎𝑟(𝑋) =

(𝑏−𝑎)2

12

La distribuzione Normale è la più nota e utilizzata nell’inferenza statistica

Una variabile casuale Normale 𝑋, indicata con 𝑋~𝑁(𝜇, 𝜎 2 ), è una variabile casuale

continua che assume valori su tutto l’asse reale, cioè da −∞ a +∞.

La sua funzione di densità è la seguente:

𝑓 (𝑥 ) =

1

𝜎√2𝜋

1 𝑥−𝜇 2

− (

)

𝑒 2 𝜎

I due parametri che la caratterizzano, 𝜇 e 𝜎 2 , possono assumere valori −∞ < 𝜇 < +∞

e 𝜎 2 > 0.

Il valore atteso è dato da:

𝐸 (𝑋 ) = 𝜇

La varianza è data da:

𝑉𝑎𝑟(𝑋) = 𝜎 2

Il valore della media 𝝁 determina, graficamente, la posizione orizzontale della curva.

Il parametro 𝜎 2 determina la dispersione della distribuzione e graficamente

rappresenta il grado di appiattimento della curva.

0.18

0.2

0.16

0.14

0.15

0.12

0.1

0.1

0.08

0.06

0.05

0.04

0.02

0

0

1

5

9

13

17

21

25

29

33

37

Curve con stessa varianza e diverse medie

41

45

49

1

5

9

13

17

21

25

29

33

37

Curve con stessa media e diverse varianze

41

45

49

Un caso particolare si ha quando la media è 𝜇 = 0 e la varianza 𝜎 2 = 1.

Questa variabile casuale si chiama variabile casuale Normale Standardizzata, e si

indica con 𝑍~𝑁(0,1).

La sua funzione di densità risulta pertanto essere la seguente:

𝑓 (𝑧 ) =

1

√2𝜋

𝑧2

𝑒− 2

0.45

0.4

0.35

0.3

P

0.25

0.2

0.15

0.1

0.05

0

-3.5

-3.0

-2.5

-2.0

-1.5

-1.0

-0.5

0.0

0.5

1.0

1.5

2.0

2.5

3.0

3.5

Z