INTRODUZIONE AL CORSO DI COMUNICAZIONI RADIOMOBILI

1. Trasmissioni digitali passa-banda

Nelle comunicazioni digitali la sorgente informativa (voce, immagini, video, dati, ecc.) viene

convertita in numeri e successivamente in sequenze binarie di "0" e "1".

Il problema fondamentale delle trasmissioni digitali è che, a causa della natura del canale di

comunicazione, che può essere schematizzato come un sistema lineare passa banda, il segnale

contenente l'informazione deve essere modulato, ovvero convertito da sequenza binaria in forma

d'onda continua con contenuto spettrale concentrato intorno ad una frequenza centrale (es. 900 MHz

per il sistema GSM).

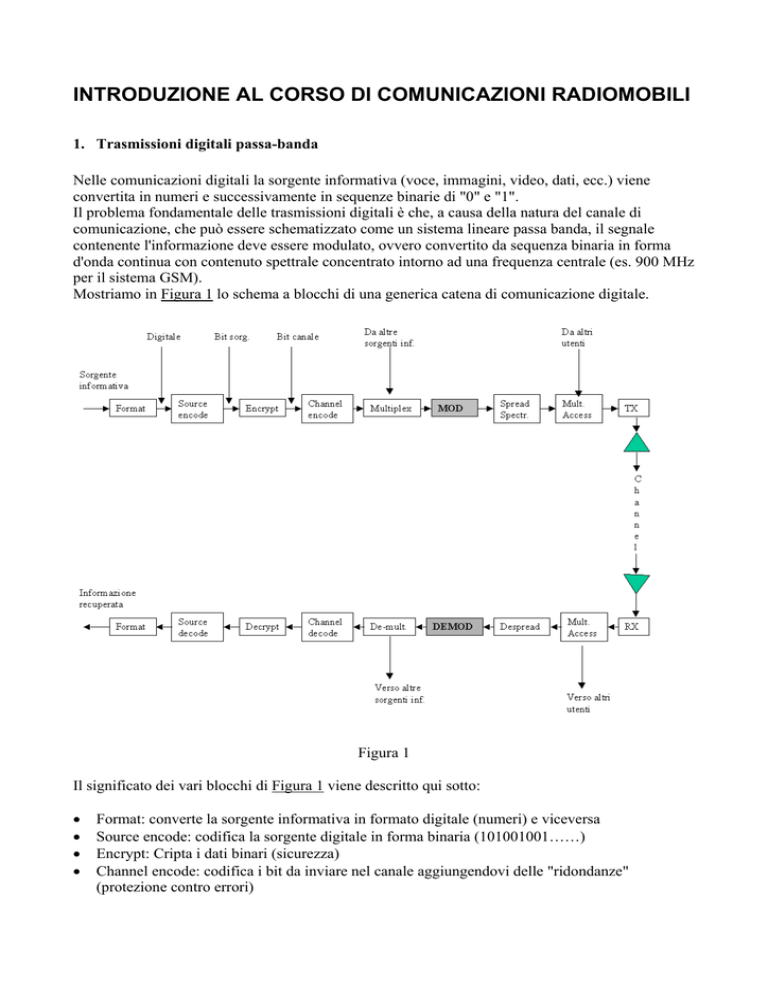

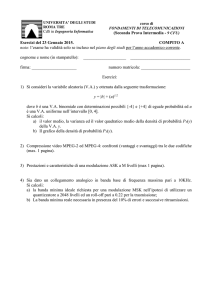

Mostriamo in Figura 1 lo schema a blocchi di una generica catena di comunicazione digitale.

Figura 1

Il significato dei vari blocchi di Figura 1 viene descritto qui sotto:

•

•

•

•

Format: converte la sorgente informativa in formato digitale (numeri) e viceversa

Source encode: codifica la sorgente digitale in forma binaria (101001001……)

Encrypt: Cripta i dati binari (sicurezza)

Channel encode: codifica i bit da inviare nel canale aggiungendovi delle "ridondanze"

(protezione contro errori)

•

•

•

•

•

•

•

•

•

•

•

•

•

Multiplex: unisce vari flussi informativi provenienti da sorgenti diverse (es., voce e dati) per

produrre un unico flusso

MOD: Trasforma il flusso digitale in una forma d'onda continua con contenuto spettrale

centrato rispetto ad una portante

Spread Spectr.: Effettua un (eventuale) allargamento di spettro per proteggere il segnale da

interferenze di altri utenti

Mult. Access: unisce/separa le varie forme d'onda provenienti da tutti gli utenti che vogliono

contemporaneamente trasmettere nel canale

TX: Amplifica il segnale e lo invia all'antenne trasmittente (se si tratta di una comunicazione

radio)

Channel: Canale di comunicazione

RX: Seleziona il segnale ricevuto dall'antenna ricevente sintonizzandosi nella banda opportuna e

lo amplifica

Despread.: Effettua un (eventuale) restringimento di spettro per recuperare il segnale originario

DEMOD: Trasforma la forma d'onda continua nel flusso digitale originario

De-Multi.: separa i vari flussi informativi provenienti da sorgenti diverse (es., voce e dati)

Channel decode: decodifica i bit ricevuti dal demodulatore togliendo le "ridondanze" ed

(eventualmente) correggendo gli errori

Decrypt: De-Cripta i dati binari

Source decode: decodifica la sorgente in forma binaria (101001001……) riproducendo la

sorgente digitale originaria

1.

Modulazione di dati numerici

Nella modulazione digitale il segnale binario viene convertito in un segnale a radio-frequenza,

centrato intorno ad una frequenza centrale che denomineremo f c. Un segnale a radio-frequenza

possiede due gradi di libertà: ampiezza e fase. La modulazione viene realizzata variando queste due

quantità in accordo con la sequenza di bit informativi da trasmettere. I requisiti di una buona

modulazione digitale sono: larghezza di banda del segnale a radio-frequenza minore possibile,

probabilità di errore (sul bit) minore possibile e facilità di realizzazione dei circuiti di modulazione

e di demodulazione.

Un segnale modulato può essere espresso come:

s (t ) = A( t ) cos[2πf c t + ϕ (t )]

(1)

dove A(t) e ϕ(t) sono l'ampiezza e la fase della portante a radio-frequenza definita come:

s0 (t ) = cos (2πf c t )

(2)

Spesso conviene riferirsi alla rappresentazione equivalente passa-basso del segnale modulato. Per

ottenerla si osserva che la (1) può essere riscritta come:

[

]

[

s ( t ) = Re A( t ) e j [2πf c t +ϕ ( t ) ] = Re s b ( t ) e j 2πf c t

]

(3)

jϕ ( t )

dove s b (t ) = A(t ) e

è il segnale complesso equivalente passa-basso. In base a questa nuova

rappresentazione, il segnale modulato può essere espresso come:

s (t ) = x (t ) cos (2π f c t ) − y (t ) sin (2π f c t )

dove

x (t ) = A(t ) cos [ϕ (t ) ] e

y (t ) = A(t ) sin [ϕ (t ) ]

(4)

(5)

sono le componenti in fase e quadratura del segnale passa-basso equivalente.

Dalle espressioni precedenti non è possibile distinguere un segnale modulato digitale da uno

analogico. La differenza sta nell’espressione assunta dalle forme A(t) e ϕ(t), o equivalentemente da

x(t) e y(t):

nel caso analogico queste sono funzioni che, in qualche modo, devono essere messe in relazione

con il segnale originario (che è una funzione continua del tempo, ad esempio la voce, che può

assumere un numero infinito di valori in un certo intervallo);

nel caso digitale queste sono funzioni che, in qualche modo, devono essere messe in relazione con

un segnale che varia solo in certi istanti (tempi di arrivo dei simboli informativi) e che può

assumere un numero finito di valori (2 se la modulazione è binaria, maggiore di due se vengono

modulati più bit per volta).

Soffermandoci in particolare sul caso digitale, si ha in accordo con lo schema di Figura 1 che in

ingresso al blocco modulatore arriva un flusso di bit. Il blocco modulatore può essere suddiviso in

due blocchi come mostrato in Figura 2.

Figura 2

Il blocco Mappatore digitale prende in ingresso un certo numero k di bit in ogni intervallo Ts, che

chiameremo tempo di simbolo. Sulla base della configurazione dei k bit viene costruito il segnale

nel generico intervallo [nTs, (n+1)Ts] come mostrato in figura. Con riferimento all’esempio di

Figura 2, si ha in particolare che il segnale trasmesso nell’intervallo [nTs, (n+1)Ts] sarà:

s (t ) = A4 (t ) cos [2π f c t + ϕ 4 (t ) ]

Si noti che un modulatore così costruito è in grado di trasmettere M=k bit ogni tempo Ts.

(6)

1.1. Modulazioni di fase

Nelle modulazioni di fase la fase del segnale assume uno fra M=2k valori fissi in ogni intervallo

[nTs, (n+1)Ts]. In particolare, se indichiamo con m la codifica in base 10 della configurazione di bit

in ingresso (ad esempio se i bit sono 011, m=3) abbiamo che la fase trasmessa è

2πm

ϕ=

+ ϕ0

M

dove ϕ0 è una qualsiasi fase compresa fra 0 e 2π.

Poiché per quanto detto prima, m può assumere uno dei possibili valori 0,1,…,M-1, si ha che la fase

trasmessa nell’intervallo [nTs, (n+1)Ts] può assumere uno dei possibili valori

2π

2π

2π

ϕ = 0, ,2 × , K , ( M − 1) ×

+ ϕ0

M

M

M

Queste modulazioni sono dette M - Phase Shift Keying (M-PSK), dove il simbolo M indica il

numero di simboli trasportati in ogni intervallo di lunghezza Ts.

Se rappresentiamo nel piano complesso i numeri cos(ϕ)+j sin(ϕ) si ottengono le costellazioni per le

modulazioni di fase più comuni mostrate in Figura 3.

Figura 3

Si osservi che la fase ϕ0 vale 0 per il caso 2-PSK e 8-PSK e vale π/4 nel caso 4-PSK.

Definiamo ora l’impulso in banda base g(t), di durata Ts, che viene utilizzato dal modulatore per

trasmettere un simbolo informativo. In Figura 4 viene mostrato un esempio di impulso g(t).

Figura 4

Nonostante che, come mostrato in figura, un impulso reale g(t) non potrà mai essere esattamente

zero al di fuori dell’intervallo [0, Ts], noi assumeremo che g(t) sia esattamente zero al di fuori

dell’intervallo [0, Ts], ovvero g(t- nTs,) ) sia esattamente zero al di fuori dell’intervallo [nTs,

(n+1)Ts]. In particolare, per semplicità assumeremo che g(t) sia una funzione rettangolo, ovvero che

valga 1 in [0, Ts] e 0 al di fuori, come mostrato in Figura 5.

Figura 5

Si fa notare in questa fase che la funzione in Figura 5 non è fisicamente realizzabile (fronti di salita

e discesa ripidissimi che richiederebbero una banda infinita) e che, qualora lo fosse, sarebbe

certamente distorta dal canale

1.1.1. Modulazione 2-PSK

Nella modulazione 2-PSK il segnale trasmesso nell’intervallo [nTs, (n+1)Ts] assume la forma:

s (t ) = a n g (t − nTs ) cos (2πf c t ) nTs ≤ t ≤ ( n + 1)Ts

dove an prende i valori +A, o –A (volt) in corrispondenza del segnale digitale da trasmettere (1 o 0).

Assumendo che il modulatore lavori da un tempo -∞ ad un tempo +∞ Il segnale modulato può

essere espresso come:

s (t ) = x (t ) cos (2πf c t ) =

+∞

∑ a n g (t − nTs ) cos(2πf c t )

n = −∞

Si osservi che, per quanto riguarda la fase ϕ(t) del segnale, essa vale 0 quando viene trasmesso un 1

e π quando viene trasmesso uno 0, in accordo con la costellazione mostrata in Figura 3. Lo schema

del modulatore 2-PSK è mostrato in Figura 6.

Figura 6

In Figura 7 mostriamo un esempio di modulazione 2-PSK, in cui si è scelto Ts = 1 s, fc = 10 Hz.

Figura 7

1.1.2. Modulazione 4-PSK

Nella modulazione 4-PSK il segnale trasmesso nell’intervallo [nTs, (n+1)Ts] assume la forma:

s (t ) = a n g (t − nTs ) cos (2πf c t ) + bn g (t − nTs ) sin (2πf c t ) nTs ≤ t ≤ ( n + 1)Ts

(7)

dove an e bn sono la coppia di bit informativi modulati nell’intervallo [nTs, (n+1)Ts] che prendono i

valori +A, o –A (volt) in corrispondenza del segnale digitale da trasmettere (1 o 0).

Assumendo che il modulatore lavori da un tempo -∞ ad un tempo +∞ Il segnale modulato può

essere espresso come:

s (t ) = x (t ) cos (2πf c t ) − y (t ) cos (2πf c t ) =

+∞

∑ a n g (t − nTs ) cos(2πf c t ) +bn g (t − nTs ) sin (2πf c t )

(8)

n = −∞

Ricorrendo alla rappresentazione complessa del segnale possiamo anche scrivere:

⎧ +∞

⎫

s (t ) = Re ⎨ ∑ (a n − jbn )g (t − nT s )e j 2πf ct ⎬

⎩ n = −∞

⎭

(9)

Si osserva dalla (9) che, per quanto riguarda la fase ϕ(t) del segnale, essa può assumere i 4 valori

±π/4, ±3π/4 a seconda dei simboli informativi an e bn, in accordo con la costellazione mostrata in

Figura 3. Lo schema del modulatore 4-PSK è mostrato in Figura 8.

Figura 8

In Figura 9 mostriamo un esempio di modulazione 4-PSK, in cui si è scelto Ts = 1 s, fc = 10 Hz.

Figura 9

1.2.

Modulazioni di frequenza (M-FSK)

In un generico segnale modulato che ha espressione descritta nell’equazione (1) si definisce la

frequenza istantanea f(t) come

1 d ϕ (t )

(16)

2π dt

Nelle modulazioni di fase tale frequenza è sempre uguale a fc durante ogni generico intervallo [nTs,

(n+1)Ts], poiché la fase è costante in tale intervallo (derivata nulla).

Nelle modulazioni di frequenza, invece, la frequenza del segnale assume uno fra M=2k valori fissi in

ogni intervallo [nTs, (n+1)Ts]. Il valore assunto dipende dalla sequenza di k bit che si vogliono

inviare nel suddetto intervallo. Le modulazioni digitali di frequenza vengono dette M-Frequency

Shift Keying.

In particolare, indichiamo con mn la codifica in base 10 della configurazione di bit in ingresso

nell’intervallo [nTs, (n+1)Ts] (ad esempio se i bit sono 011, mn=3). Indichiamo poi con qn la

codifica Non ritorno a Zero (NRZ) di mn, ovvero qn = 2mn-(M-1). Si noti che la quantità qn può

assumere uno degli M possibili valori ±1, ±3, …., ±M-1. Allora abbiamo che la frequenza del

segnale modulato in frequenza nell’intervallo [nTs, (n+1)Ts] è

h

(17)

f = f c + qn

2Ts

dove h è una costante che viene denominata “indice di modulazione” e Ts è il tempo di simbolo.

Per chiarire meglio, se prendiamo ad esempio il caso M = 4, si avrà l’assegnazione delle frequenze

ai vari simboli informativi riportata in Figura 17.

f (t ) = f c +

Figura 17

Il segnale M-FSK nel generico intervallo [nTs, (n+1)Ts] può essere espresso come:

⎛

hπ ⎞

s (t ) = A cos ⎜⎜ 2π f c t + q n

t ⎟⎟

T

⎝

s ⎠

(19)

Se infatti, come controprova, andiamo a valutare la frequenza istantanea definita in (16) del segnale

(19) abbiamo che essa è uguale, nel generico intervallo [nTs, (n+1)Ts], all’espressione data dalla

(17).

Di particolare interesse sono le modulazioni M-FSK ortogonali. Esse sono quelle modulazioni in

cui è verificato:

ρ l ,m =

(n +1)Ts

∫

nTs

⎛

⎛

hπ ⎞

hπ ⎞

cos ⎜⎜ 2π f c t + q l

t ⎟⎟ × cos ⎜⎜ 2π f c t + q m

t ⎟⎟ dt = 0

T

T

s ⎠

s ⎠

⎝

⎝

(20)

per qualunque coppia di simboli ql, qm diversi fra loro. Si può facilmente dimostrare che per valori

della frequenza della portante fc molto maggiori di 1/Ts (come avviene usualmente) la condizione di

ortogonalità è verificata per valori dell’indice di modulazione multipli di 1 / 2, ovvero per h = k / 2,

con k intero qualsiasi.

Un modulatore M-FSK viene costruito semplicemente avendo a disposizione M diversi oscillatori

che generano segnali alle frequenze date dalla (17). Il segnale s(t) viene costruito scegliendo in ogni

intervallo uno dei possibili segnali degli oscillatori, sulla base del simbolo informativo in ingresso

al modulatore. Uno schema del modulatore M-FSK viene mostrato in Figura 18 per il caso M = 4.

Figura 18

In Figura 19 mostriamo un esempio di modulazione 4-FSK, in cui si è scelto Ts = 1 s, fc = 10 Hz ed

indice di modulazione h = 2.

Figura 19

Dove in ordinata al primo grafico di Figura 19 abbiamo indicato con il termine p(t) il segnale

digitale dato da:

p (t ) =

+∞

∑ q n g (t − nTs )

n = −∞

dove g(t) è l’impulso in banda base mostrato in Figura 5.

(21)

2.

Occupazioni spettrali delle modulazioni digitali

Uno dei parametri più importanti che caratterizzano un segnale modulato digitale, che ha

un’espressione tipo quella mostrata in (1), è la sua occupazione di banda. Qualunque sia il tipo di

modulazione prescelto, il contenuto spettrale del segnale modulato si “dispone” intorno alla

frequenza della portante fc assumendo un aspetto di tipo quello mostrato in Figura 31.

Figura 31

Con f si sono indicate le frequenze, mentre con S(f) si è indicato il contenuto spettrale del segnale

modulato in funzione di f. Meno è larga l’occupazione in banda del segnale, più è alto il numero di

segnali che possono essere trasmessi contemporaneamente (ognuno utilizzando una portante

diversa). Ad esempio, nel sistema GSM la banda totale a disposizione è di 25 MHz, mentre la banda

occupata dal segnale è di 200 KHz: in questo caso è possibile trasmettere contemporaneamente 125

segnali diversi. Perciò, il parametro occupazione di banda, è un parametro che caratterizza

l’efficienza di un certo tipo di modulazione rispetto ad un’altra.

Per analizzare il contenuto spettrale delle diverse modulazioni numeriche considerate, si

considerino per semplicità le modulazioni cosiddette lineari, quelle cioè in cui il segnale modulato

può essere espresso nella generica forma:

s (t ) =

+∞

∑ α n g (t − nTs ) cos(2πf c t ) −β n g (t − nTs ) sin(2πf c t )

n = −∞

dove αn e βn sono dei numeri reali in qualche modo legati al simbolo digitale trasmesso

nell’intervallo [nTs, (n+1)Ts], e g(t) è l’impulso in banda base associato alla trasmissione del

simbolo. L’espressione (50) viene spesso rappresentata nella forma equivalente complessa:

(50)

⎧ +∞

⎫

s (t ) = Re ⎨ ∑ I n g (t − nTs )e j 2πfct ⎬

⎩n = −∞

⎭

(51)

dove In = αn + jβn è un numero complesso in qualche modo legato al simbolo digitale trasmesso

nell’intervallo [nTs, (n+1)Ts]. Si noti che in questa categoria di modulazioni rientrano le

modulazioni di fase (si veda ad esempio Equazione (9)) ma non le modulazioni di frequenza.

L’occupazione spettrale di questa ampia classe di modulazioni dipende sia dalle caratteristiche della

sequenza digitale In = αn + jβn, sia dalla forma dell’impulso g(t). Assumiamo ad esempio che i

simboli informativi complessi In siano tutti uguali, ad esempio uguali ad 1, e che l’impulso in banda

base sia un rettangolo. In questo caso, il segnale trasmesso diventa una riga spettrale che ha

occupazione di frequenza nulla. Ovviamente questo è un caso limite che non ha molto senso, poiché

trasmettere tutti simboli uguali equivale a non trasmettere nessuna informazione utile (quantità di

informazione trasferita nulla). Il caso limite opposto è quello in cui i simboli informativi In siano

indipendenti da simbolo a simbolo. Senza voler entrare nel dettaglio della definizione di

indipendenza statistica, basterà in questa sede definire questo concetto come il fatto che la

conoscenza dei simboli precedenti non permette in alcun modo di prevedere quale sarà il simbolo

futuro. In questo caso, si ha la massima occupazione di banda del segnale e la massima quantità di

informazione trasferita. Anche questo è ovviamente un caso limite che, tuttavia, può essere preso

come caso di riferimento poiché fornisce il caso limite peggiorativo (per quanto riguarda

l’occupazione di banda).

Nell’ipotesi di indipendenza fra i simboli informativi, si può dimostrare che l’occupazione spettrale

del segnale S(f) è data da:

S ( f ) = G( f − fc )

2

(52)

dove G(f) è la trasformata di Fourier dell’impulso in banda base g(t). Ovviamente, la trasformata di

Fourier di g(t) dipenderà dalla larghezza dell’impulso: al diminuire della larghezza di g(t) aumenta

la larghezza della sua trasformata di Fourier. Poiché la larghezza dell’impulso dipende in primo

luogo dalla larghezza dell’intervallo temporale Ts, avremo che al diminuire di Ts aumenta la banda

occupata dal segnale. In altri termini, se vogliamo trasmettere più simboli al secondo (Ts minore)

dobbiamo usare più banda. Perciò il prodotto fra la banda W occupata ed il tempo di simbolo è una

costante: tanto minore è questa costante, tanto migliore è la modulazione.

Il parametro che caratterizza l’efficienza di una modulazione dal punto di vista della sua

occupazione spettrale, da ora in avanti definita Efficienza Spettrale (ES), è il numero di bit per

tempo di simbolo, k, diviso il prodotto del tempo di simbolo Ts per la banda W, ovvero

EE=

k

TsW

(53)

Il rapporto fra il tempo di simbolo Ts ed il numero di bit per tempo di simbolo k, fornisce il tempo di

bit (tempo necessario per trasportare un bit) che chiameremo Tb. L’inverso del tempo di bit, che

chiameremo Rb = 1/ Tb, fornisce il numero di bit inviati al secondo (è una misura della velocità di

trasmissione). L’espressione (53) può ora essere riscritta come:

EE=

Rb

W

(54)

L’efficienza spettrale mi dice dunque quanti bit al secondo vengono trasmessi per ogni Hertz di

banda: se la banda ad esempio è 100 KHz ed EE = 0.5, si riescono a trasmettere 50 Kbit/s.

Considerando ora la classe delle modulazioni M-PSK che utilizzano un impulso rettangolare in

banda base (si veda Figura 5). In questo caso la (52) assume la forma indicata in Figura 32 dove si è

supposto Ts = 1s e fc = 10 Hz.

Figura 32

Per questo tipo di impulsi dunque, si può assumere la larghezza di banda uguale a 2 volte l’inverso

del tempo di simbolo (in Figura 32 uguale a 2 Hz), ovvero WTs = 2.

Ovviamente, le cose possono migliorare utilizzando impulsi più larghi di Ts. Tuttavia questa scelta

può comportare l’inconveniente di introdurre interferenza fra i simboli trasmessi. L’impulso che

permette la minore occupazione di banda senza introdurre interferenza fra i simboli, insieme al

contenuto spettrale per Ts = 1s e fc = 10 Hz, è mostrato Figura 33. In questo caso, il prodotto WTs =

1.

Figura 33

I casi di Figura 33 e di Figura 33 sono dei casi limite; nella realtà l’impulso in banda base sarà tale

che 1 < WTs < 2.

Per quanto riguarda il valore dell’efficienza spettrale avremo nei due casi limite:

Modulazione

2-PSK

4-PSK

M-PSK

EE1

0.5

1

0.5log2(M)

EE2

1

2

log2(M)

dove EE1 e EE1 rappresentano i casi di Figura 32 e di Figura 33, rispettivamente.

Rimane da analizzare il caso delle modulazioni M-FSK. In questo caso il segnale modulato può essere

(approssimativamente) visto in frequenza come una sequenza di portanti a frequenza data dalla (17).

Ovviamente anche qui varrà la considerazione fatta prima sulla natura della sequenza informativa. Se

infatti i qn della (17) sono tutti uguali, il segnale si riduce ad una sola riga spettrale. Assumeremo

quindi di essere nel caso di simboli indipendenti. In questo caso, l’occupazione in banda sarà

ovviamente proporzionale alla massima distanza fra le frequenze utilizzate. Tale valore è pari a

∆f=

(M − 1) h

Ts

(55)

Si vede dalla (55) che per avere la minima occupazione di banda possibile occorre scegliere il

minimo h. Limitandosi a modulazioni ortogonali (si veda Modulazioni M-FSK) si ha che il minimo

valore di h possibile è 0.5. In questo caso, considerando che l’occupazione in banda può essere

approssimativamente considerata uguale a

W = ∆f +

1

M

=

2Ts 2Ts

(56)

si può ricavare l’efficienza spettrale definita in (53) per questa classe di modulazioni come

EE= 2

log 2 ( M )

M

che, diversamente dal caso M-PSK, diminuisce all’aumentare di M.

(57)

2.1. Importanza delle Modulazioni ad inviluppo costante

Data la rappresentazione di un segnale digitale modulato vista in (1), si definisce un segnale ad

inviluppo costante quando l’ampiezza A(t) non varia nel tempo, ovvero, A(t) = A0, in qualsiasi

istante di tempo. In questo caso il segnale modulato può essere espresso come:

s (t ) = A0 cos[2πf c + ϕ (t )]

(46)

Appartengono a questa categoria tutte le modulazioni di fase viste nonché le modulazioni di

frequenza e le modulazioni a fase continua. Le modulazioni di ampiezza invece (non trattate qui),

non appartengono a questa categoria.

L’esigenza di avere un inviluppo costante è particolarmente sentita in quelle applicazioni dove,

presumibilmente, il segnale modulato deve essere trattato da dispositivi non lineari. Questo è il caso

ad esempio delle applicazioni radiomobili dove, a causa delle bassissime potenze con cui arrivano i

segnali a destinazione, si rendono necessari amplificatori che lavorano in “saturazione”. Essi

garantiscono le massime amplificazioni possibili ma introducono al tempo stesso delle distorsioni

dovute alle non linearità.

Un dispositivo non lineare è un dispositivo che ha una relazione ingresso-uscita in cui, in generale,

non vale la legge della sovrapposizione degli effetti (ovvero se l’ingresso aumenta di un fattore α

anche l’uscita aumenta dello stesso fattore). In Figura (28) viene mostrato un esempio della tipica

relazione ingresso-uscita di un amplificatore, in cui si è indicato con x(t) l’ingresso e con y(t)

l’uscita.

Figura 28

Dalla Figura 46 che se si vogliono sfruttare al massimo le capacità dell’amplificatore, bisogna farlo

funzionare per valori più elevati possibile degli ingressi, ovvero in zona non lineare. La relazione

ingresso-uscita di un dispositivo non lineare può in generale essere espressa come:

y (t ) = a1 x (t ) + a1 x 2 (t ) + a1 x 3 (t ) + K

(47)

dove le non linearità sono dovute ai termini dal secondo in poi.

Se l’ingresso è dato da una forma d’onda la cui espressione generale è quella data in (1), assumendo

che la banda occupata dal segnale sia molto minore della frequenza centrale fc (cosa questa sempre

vera per i segnali modulati) si ha che l’uscita è data da tanti termini che si trovano a frequenze 0, fc,

2fc, 3 fc ,... che non si sovrappongono (in frequenza). Questo è dovuto alle proprietà della funzione

cos[2πfct + ϕ(t)]n, che può essere scomposta nella somma di tanti contributi a frequenza multipla di

fc.

Utilizzando un filtro passa banda in uscita all’amplificatore per isolare la componente a frequenza fc

(quella di interesse), si ha:

3

5

⎡

⎤

s (t ) = ⎢ a1 A(t ) + a3 A3 (t ) + a 4 A5 (t ) + K⎥ cos[2πf c + ϕ (t )]

4

8

⎣

⎦

(48)

L’ampiezza del segnale risulta allora fortemente distorta, cosa questa che può comportare un forte

deterioramento delle prestazioni del sistema.

Nel caso in cui invece si abbia in ingresso un segnale modulato ad inviluppo costante come quello

visto in (46), l’uscita assume la forma:

3

5

⎡

⎤

s (t ) = ⎢a1 A0 + a3 A03 + a 4 A05 + K⎥ cos[2πf c + ϕ (t )]

4

8

⎣

⎦

(49)

che è esattamente identico al segnale di ingresso moltiplicato per una costante (ovvero non c’è

distorsione).

La conclusione di questo ragionamento è che per applicazioni in cui sono necessari dispositivi che

introducono non linearità, sono senz’altro preferibili le modulazioni ad inviluppo costante.

All’inizio di questo paragrafo, abbiamo elencato quelle che, stando alle definizioni viste nei

paragrafi precedenti, possono essere classificate come modulazioni ad inviluppo costante. Tuttavia

già si era accennato precedentemente al fatto che, per avere inviluppo costante nelle modulazioni di

fase, occorre che la forma d’onda in banda base, denominata g(t), sia un rettangolo perfetto. Questo

nella realtà non sarà possibile perché una forma d’onda di tale natura risulterebbe fortemente

distorta dal canale. Per questo, le modulazioni di fase prevedono l’utilizzo di un filtro passa basso

(si veda a tal proposito la Figura 6); questo le rende di fatto appartenenti alla classe delle

modulazioni ad inviluppo non costante.

In Figura 29 si riporta un esempio di modulazione 4-PSK che utilizza delle forme d’onda non

rettangolari, da cui risulta evidente che l’ampiezza del segnale non è costante.

Figura 29

3.

Demodulazione di dati numerici

3.1. Rumore termico

Quando si invia un segnale modulato digitale che ha un’espressione come quella mostrata in (1) in

un canale (radio, cavo telefonico, fibra ottica, ecc.), si ha, in ricezione, un segnale r(t) che può

essere espresso:

r (t ) = A(t ) cos [2πf c + ϕ (t ) + ϕ 0 ] + n (t )

(58)

dove ϕ0 è uno sfasamento introdotto dal canale e n(t) è contributo di rumore (indesiderato) che è

principalmente dovuto al canale e all’amplificatore di antenna in ricezione. Questo genere di rumore

viene detto anche termico ed è presente per il fatto che gli apparati resistivi che costituiscono i

blocchi circuitali dei ricevitori funzionano a una temperatura maggiore dello zero assoluto e, quindi,

producono un movimento casuale degli elettroni. Inoltre, gli apparati riceventi (modellabili con

quadrupoli) introducono un rumore essi stessi della stessa natura del rumore termico nel tentativo di

amplificare il segnale ricevuto e renderlo così intelligibile ai blocchi che seguono (rumore di

apparato, indipendente dalla temperatura di rumore).

La temperatura equivalente di rumore è una grandezza utilizzata in elettronica e nel campo delle

telecomunicazioni assieme alla cifra di rumore per quantificare la rumorosità di un sistema (in

genere un quadripolo che modella un ricevitore).

La determinazione della rumorosità di un quadripolo viene effettuata mediante il confronto con la

rumorosità introdotta da un riferimento, il quale è in generale la resistenza che adatta in potenza la

porta d'ingresso del quadripolo stesso e che si trova alla temperatura assoluta di 290 kelvin (17 °C).

Nello schema dNi indica la potenza disponibile di rumore (in una banda di frequenze infinitesima)

introdotta dal resistore posto all'ingresso del quadripolo mentre dNu indica la potenza disponibile di

rumore misurata all'uscita. La potenza disponibile di rumore dNi è data da:

dNi=kTdf

in cui k = 1.38 × 10−23 J / K è la costante di Boltzmann e T è la temperatura assoluta a cui si trova

il resistore (per convenzione si pone T=290 kelvin ogniqualvolta non è specificato).

La potenza disponibile di rumore dNu può essere scomposta come la somma di due contributi:

dNu=G dNi+dNa

con G guadagno del quadrupolo. Il primo tiene conto della rumorosità dovuta al solo riferimento R

(alla temperatura assoluta T) mentre il secondo termine tiene conto della rumorosità introdotta dal

solo quadripolo, la quale non dipende dalla temperatura alla quale si trova il riferimento.

Considerando il quadripolo ideale (e quindi non rumoroso) è possibile determinare il valore della

temperatura assoluta Tr alla quale dovrebbe trovarsi il riferimento R per poter misurare ai morsetti

di uscita del quadripolo stesso la potenza dNa. Tr prende il nome di temperatura equivalente di

rumore. La potenza disponibile di rumore dNu è quindi data da:

dNu=G dNi+dNa=kTdf G+k Tr df G=k(T+Tr)dfG

In altri termini, la temperatura equivalente di rumore è la temperatura che si dovrebbe sommare alla

temperatura T del riferimento R per poter misurare ai morsetti d'uscita del quadripolo, considerato

ideale, la potenza disponibile di rumore dNu.

È importante sottolineare che la temperatura equivalente di rumore non è la temperatura fisica alla

quale si trova l'apparato; è per sottolineare questa sostanziale differenza che si utilizza il termine

equivalente.

Il parametro che definisce la bontà di un apparato in termini di rumore introdotto è spesso la cifra di

rumore F. Tale parametro indica il rapporto fra il rapporto segnale rumore in ingresso al dispositivo

e quello in uscita. Ovviamente, poiché il dispositivo introduce rumore, il valore di F è sempre

maggiore di uno, e tanto più è grande e quanto peggiore è il dispositivo.

La temperatura equivalente di rumore e la cifra di rumore sono fra loro legate dalle seguenti

relazioni, ottenibili confrontando le espressioni di dNu che si ottengono utilizzando F o Tr in

riferimento allo stesso quadripolo:

F=(T+Tr)/T

Tr=(F-1)T

in cui T è la temperatura assoluta del riferimento alla quale è stata calcolata F (in genere 290

kelvin). In genere un ricevitore è costituito da una cascata di dispositivi modellabili come

quadrupoli, ognuno dei quali sarà caratterizzato da una cifra di rumore. Nel caso di una cascata di

quadrupoli caratterizzati dai guadagni G1,G2,….,GN, è facile verificare che la cifra di rumore

complessiva del quadrupolo che modella la cascata con guadagni G = G1 G2 …. GN è:

F = F1 + (F2-1)/G1 + (F3-1)/(G1G2) + ……. + (FN-1)/(G1G2….GN-1)

Poiché in genere il primo blocco introduce una forte amplificazione (G1 elevato), si possono

trascurare i termini seguenti il primo che rimane come quello più importante ai fini del rumore.

Il rumore termico sopra descritto può essere ragionevolmente modellato come una funzione

aleatoria (ovvero il cui valore in funzione del tempo non è noto, ma può essere solo descritto

statisticamente) di tipo bianco e Gaussiano.

Il primo aggettivo (bianco) sta ad indicare che il suo contenuto spettrale è costante su tutte le

frequenze. Tale valore costante (definito densità spettrale di potenza) viene spesso indicato con N0.

Questo vuol dire che se filtriamo il rumore con un filtro di larghezza di banda W, la potenza del

rumore in uscita (ovvero il valore medio del rumore al quadrato) è sempre uguale a WN0

indipendentemente dalla frequenza fc in cui è centrato il filtro. Si veda a tal proposito la Figura 34,

che rappresenta il contenuto spettrale N(f) del rumore in funzione della frequenza.

Figura 34

Il secondo aggettivo (Gaussiano) sta ad indicare che la sua distribuzione di probabilità è Gaussiana,

ovvero che la distribuzione di probabilità del rumore in ogni istante segue un andamento Gaussiano.

Questo tipo di distribuzioni sono caratterizzate dal valore medio (nullo nel caso di rumore bianco) e

dalla varianza (che rappresenta proprio la potenza del rumore). Ad esempio in uscita da un filtro di

larghezza W il rumore è caratterizzato dall’avere valore medio nullo e varianza WN0.

Il modello riportato in (58) viene dunque spesso indicato come canale additivo bianco e Gaussiano.

3.2. Demodulazione

Il problema generale della demodulazione digitale è quello di estrarre da r(t) il segnale digitale

originario che è in qualche modo inserito nell’ampiezza e/o nella fase di s(t) (in dipendenza del tipo

di modulazione scelta).

Lo schema generale del modello di canale additivo e della procedura di demodulazione è mostrato

in Figura 35.

Figura 35

Il blocco Demodulatore analogico ha il compito di riportare il segnale (che si trova a frequenza fc)

in banda base, cercando di limitare al massimo l’influenza (negativa) del rumore. Fra i demodulatori

si distinguono i demodulatori coerenti e quelli incoerenti. Nel caso coerente, si assume che il

demodulatore sia a conoscenza dello sfasamento ϕ0 introdotto dal canale. Ovviamente questo non è

possibile in generale, per cui dire che il demodulatore conosce ϕ0 equivale a dire che è in grado di

stimarla. Il processo di stima della fase, oltre ad aumentare la complessità del ricevitore, introduce

spesso degli errori di stima che possono degradare notevolmente le prestazioni del ricevitore. Per

questo, sono state studiate tecniche alternative di demodulazione, cosiddette incoerenti, in cui la

fase ϕ0 è assunta del tutto sconosciuta (ovvero che può assumere qualsiasi valore fra 0 e 2π con

uguale probabilità). In questo caso ovviamente non c’è bisogno di stimare ϕ0, per cui si evitano gli

errori di stima della fase anche se si devono accettare delle degradazioni di prestazioni rispetto al

ricevitore coerente ottimo.

Il sincronizzatore ha poi il compito di selezionare il segnale in banda base negli istanti esatti di

inizio simbolo, in modo da poter estrarre dei numeri (o coppie di numeri come vedremo) che sono

direttamente relazionati al simbolo informativo trasmesso. Si noti che questa operazione richiede

che il ricevitore sia a conoscenza degli istanti di inizio trasmissione dei bit. Questo, in generale, non

è possibile in un sistema di telecomunicazione, per cui si renderà necessaria una stima di tali istanti.

Tale stima può essere soggetta ad errori di sincronismo che possono avere talvolta effetti devastanti

nelle prestazioni del ricevitore. Da ora in poi assumeremo tuttavia che il sincronismo di simbolo sia

perfetto.

Il Mappatore digitale infine ha il compito di associare al segnale digitale in ingresso campionato un

simbolo informativo (e quindi una sequenza di bit). Nel fare questo il mappatore deve effettuare una

decisione, poiché per effetto del rumore il segnale digitale ricostruito sarà diverso da quello

trasmesso.

Le prestazioni di un demodulatore digitale sono date in termini di probabilità di errore per bit,

ovvero probabilità che il decisore scelga per un 1 quando è stato trasmesso uno 0, o viceversa.

Ovviamente queste prestazioni dipenderanno dalla potenza del rumore rispetto a quella del segnale.

Se infatti il rumore è insignificante il decisore non sbaglia mai, ovvero la probabilità di errore è

nulla. Se viceversa il rumore è nettamente preponderante, il decisore non potrà far altro che

prendere decisioni casuali, ovvero la probabilità di errore è massima ed uguale a 0.5.

Si definisce ora con Energia per simbolo Es, l’energia del segnale ricevuto contenuta in un tempo di

simbolo, ovvero:

Es =

Ts

∫A

2

(t ) cos 2 [2πf c + ϕ (t ) + ϕ 0 ]dt

(60)

0

Si definisce ora con Energia per bit Eb, l’energia del segnale ricevuto contenuta in un bit; essa sarà

uguale a Es/k, dove k è il numero di bit per tempo di simbolo. Questo termine è dato dalla potenza

del segnale ricevuto P (dove con potenza si intende il valore medio del quadrato del segnale in un

tempo di simbolo) moltiplicata per il tempo di bit Tb ovvero dalla potenza divisa per la velocità di

trasmissione Rb. La probabilità di errore per bit, definita Pe,b di un demodulatore sarà allora in

generale una funzione decrescente del rapporto fra l’energia per bit e la densità spettrale del rumore,

ovvero:

⎛E ⎞

Pe ,b = f ⎜⎜ b ⎟⎟

⎝ N0 ⎠

dove f è una funzione decrescente che assumerà valori compresi fra 0.5 e 0, e che dipenderà dal tipo

di modulazione e di demodulazione scelte. Le modulazioni (e demodulazioni) migliori sono quelle

che forniscono la minore probabilità di errore a parità di Eb/N0. Si noti che, a parità di densità

spettrale di rumore, le stesse prestazioni in termini di probabilità di errore si ottengono

raddoppiando la potenza e raddoppiando la velocità di trasmissione. Questo vuol dire che si vuole

trasmettere più veloce bisogna trasmettere più potente (a parità di prestazioni). La cosa non deve

sembrare strana, poiché la banda del segnale digitale è direttamente proporzionale alla velocità Rb,

per cui, aumentando la velocità aumenta la banda, ovvero aumenta il rumore, la cui potenza, a sua

volta, è direttamente proporzionale alla banda.

3.3. Demodulazione coerente per modulazioni lineari

Nelle modulazioni lineari, il segnale modulato s(t) può essere espresso come

s (t ) =

+∞

∑ α n g (t − nTs ) cos(2πf c t ) −β n g (t − nTs ) sin(2πf c t )

(59)

n = −∞

dove αn e βn sono dei numeri reali in qualche modo legati al simbolo digitale trasmesso

nell’intervallo [nTs, (n+1)Ts], e g(t) è l’impulso in banda base associato alla trasmissione del

simbolo

Il segnale ricevuto è allora della forma:

r (t ) =

+∞

∑ α n g (t − nTs ) cos(2πf c t + ϕ 0 ) −β n g (t − nTs ) sin(2πf c t + ϕ 0 ) + n(t )

(60)

n = −∞

Nel caso di demodulazione coerente la fase ϕ0 è nota al ricevitore, per cui il segnale (60) può essere

riportato in banda base attraverso un schema come quello mostrato in Figura 36.

Figura 36

Per comprendere il funzionamento dello schema di Figura 36 riportiamo i seguenti risultati di

trigonometria:

1 cos (4πf c t + 2ϕ o )

+

2

2

1 cos (4πf c t + 2ϕ o )

sin 2 (2πf c t + ϕ o ) = −

2

2

sin (4πf c t + 2ϕ o )

sin (2πf c t + ϕ o )cos (2πf c t + ϕ o ) =

2

cos 2 (2πf c t + ϕ o ) =

(61)

Allora, se consideriamo che il filtro passa basso elimina le componenti ad alta frequenza (ovvero a

frequenza 2fc), è immediato verificare che l’uscita del filtro può essere rappresentata, come:

rI (t ) =

rQ (t ) =

+∞

∑ α n x(t − lTs ) +n I (t )

l = −∞

+∞

(62)

∑ β n x(t − lTs ) +nQ (t )

l = −∞

dove x(t) è l’uscita dell’impulso g(t) al filtro passa basso che ha risposta in frequenza H(f), mentre i

termini nI e nQ sono rumori Gaussiani con valore medio nullo e varianza che dipende da N0 e dalla

banda passante del filtro.

L’uscita del sincronizzatore mostrata in Figura 36 può ora essere facilmente ricavata dalla (62)

ponendo t = nTs, assumendo senza perdere in generalità, x0 = 1, e supponendo che l’impulso x(t) in

uscita dal filtro sia tale per cui: x(mTs) = 0 per m ≠ 0. Questa ultima condizione significa che non

c’è interferenza fra i vari simboli informativi e che quindi è possibile demodulare un simbolo per

volta.

Il filtro passa basso H(f) va costruito in maniera tale da ridurre il più possibile la potenza di rumore,

mantenendo al tempo stesso inalterato (per quanto è possibile) il segnale utile. Si può dimostrare

che il filtro che consente di massimizzare il rapporto segnale rumore in uscita è il filtro adattato,

quello che ha cioè una risposta in frequenza pari al complesso coniugato della trasformata di

Fourier dell’impulso in banda base, ovvero H(f) = G*(f). Ne deriva ovviamente che la trasformata di

Fourier dell’impulso in uscita x(t), che denomineremo X(f), vale: X(f) = |G(f)|2. Dalle proprietà delle

trasformate di Fourier è immediato verificare che l’impulso in uscita x(t) è dato da:

+∞

x (t ) =

∫ g (τ ) g (τ − t )dt

−∞

che è un impulso simmetrico rispetto all’asse t=0, con valore massimo nell’origine (pari

all’integrale del quadrato dell’impulso g(t), ovvero alla sua energia). In Figura si riportano due

esempi di impulsi x(t) messi in relazione a possibili forme d’onda g(t).

Sempre assumendo senza perdere in generalità x0 = 1, si può ricavare dalla (60):

(α n2 + β n2 ) = 2 E s = 2kE b

var( n I ) =var( nQ )=N 0

(I)

Si noti che il rapporto fra la somma dei quadrati delle variabili di decisione in fase e in quadratura e

la somma delle varianze dei rumori in fase e in quadratura è pari a Es/N0.

Adesso rimane il problema della decisione sul simbolo informativo. Il decisore osserva i due numeri

provenienti dai due rami del demodulatore e sceglie il simbolo informativo corrispondente.

Ovviamente, i due numeri reali αn e βn sono in corrispondenza 1:1 con il simbolo informativo

trasmesso all’istante n, per cui il problema del decisore si può spostare sulla decisione di quale

coppia di numeri αn e βn è stata trasmessa una volta osservata la coppia αn + nI e βn + nQ, che ne è

una versione rumorosa. Per chiarire meglio, consideriamo una modulazione 4-PSK. In questo caso,

αn = an = ± A e βn = bn = ± A , rappresentano i due bit informativi trasmessi nell’intervallo [nTs,

(n+1)Ts]. Se non ci fosse rumore il decisore riceverebbe in ingresso ogni volta una coppia di numeri

fra quelle indicate in Figura 37 (a) e deciderebbe di conseguenza i due bit senza commettere errori.

Viceversa in presenza di rumore, il decisore si trova in ingresso delle coppie che possono assumere

valori diversi, come in Figura 37 (b). In questo caso si pone il problema della decisione.

Ovviamente, tanto maggiore è la varianza del rumore e tanto più si allargano le nuvolette in Figura

37 (b), rendendo sempre più incerta la decisione

Figura 37

Si può dimostrare che la regola di decisione ottima (nel senso che rende più piccola possibile la

probabilità di errore) consiste nello scegliere come simbolo informativo quello che è caratterizzato

dalla coppia αn e βn più “vicina” alla coppia ricevuta αn + nI e βn + nQ, dove la vicinanza va intesa

in senso geometrico. In questo modo il decisore può stabilire delle regioni di decisione, ovvero delle

regioni associate con ciascun simbolo informativo tali per cui, se la coppia di valori cade in quella

regione, allora si decide per quel simbolo. Nel caso della modulazione 4-PSK le regioni di decisione

sono mostrate in Figura 38.

Figura 38.

Ovviamente quando il rumore è molto elevato, è possibile che una coppia relativa ad un certo

simbolo informativo cada in una regione di decisione diversa: in questo caso si ha l’evento errore.

Quello a cui siamo interessati, per valutare le prestazioni del ricevitore, è la probabilità che questo

evento errore avvenga. Il calcolo esatto della probabilità di errore sul simbolo può essere in molti

casi molto complesso. Ci riferiremo in questa sede ad un’approssimazione (spesso utilizzata nella

pratica) in cui si considerano solamente gli eventi errore relativi ai simboli più vicini fra loro.

Allora, il procedimento per il calcolo approssimato della probabilità di errore è il seguente:

• Ci si condiziona ad uno qualsiasi dei simboli informativi trasmessi.

• Per quel simbolo si vanno a misurare tutte le distanze con gli altri simboli nella

rappresentazione bidimensionale.

• Si va a misurare la distanza minima e si chiama dfree.

• Questa distanza minima ricorrerà per un certo numero di volte: si chiama con L tale numero

A questo punto si deriva la probabilità Pe,s di errore sul simbolo come:

Pe , s

⎛ d2 ⎞

free ⎟

= 0.5 L × erfc ⎜

⎜ 8N 0 ⎟

⎝

⎠

(63)

dove la funzione erfc(x) viene detta funzione errore complementare. Nella Tabella sottostante

vengono mostrati i valori della funzione erfc per valori di x nell’intervallo [1,4].

x

erfc(x)

1

1.2

1.4

1.6

1.8

2

2.2

2.4

2.6

2.8

3

3.2

3.4

3.6

3.8

4

1.58 10-1

8.97 10-2

4.78 10-2

2.37 10-2

1.10 10-2

4.68 10-3

1.87 10-3

6.89 10-4

2.37 10-4

7.50 10-5

2.21 10-5

6.03 10-6

1.52 10-6

3.56 10-7

7.70 10-7

1.54 10-8

Riguardo al primo punto della procedura elencata sopra si osserva come, ad esempio nel caso 4PSK, cambiando il simbolo informativo trasmesso non cambia il calcolo della probabilità (63).

Questo è vero per tutte le modulazioni da noi considerate (non è tuttavia vero in generale).

Tornando alla (63), si osserva che per poter caratterizzare le prestazioni del demodulatore mancano

ancora due cose.

La prima è quella di relazionare la dfree con l’energia per Eb. La seconda è quella di relazionare la

probabilità di errore sul simbolo con la probabilità di errore sul bit. In questo caso si può

approssimativamente dire che Pe,b ≅ Pe,s / k, dove k è il numero di bit per simbolo. Siamo ora in

grado di valutare la probabilità di errore per bit in funzione di Eb/N0 per tutte le modulazioni lineari

considerate. Svilupperemo qui il ragionamento per la modulazione 4-PSK.

Partiamo dal simbolo informativo 1,1 (si veda Figura 37 (a)). Si osserva che la minima distanza è in

questo caso d2free = 4A2. Tale minima distanza la si ottiene due volte (con i simboli 1,-1 e –1,1).

Perciò L = 2. Osservando che l’energia per bit è in questo caso pari ad A2/2 (si veda equazione (I)) e

che k = 2, si ottiene infine:

⎛ Eb ⎞

⎟

Pe ,b = 0.5 × erfc ⎜⎜

⎟

N

0 ⎠

⎝

(64)

Si riporta nella Tabella seguente il valore della probabilità di errore per bit per le modulazioni

lineari viste:

Modulazione

Probabilità di errore per bit

2-PSK

4-PSK

⎛

Pe ,b = 0.5 × erfc ⎜⎜

⎝

⎛

Pe ,b = 0.5 × erfc ⎜⎜

⎝

M-PSK (M > 4)

Pe ,b

ASK

QASK

MSK

⎞

⎟

⎟

⎠

Eb ⎞

⎟

N 0 ⎟⎠

⎡ ⎛ π ⎞ log 2 ( M ) Eb ⎤

1

≅

× erfc ⎢ sin ⎜ ⎟

⎥

log 2 ( M )

N0

⎣ ⎝M ⎠

⎦

Eb

N0

⎡ 2 Eb ⎤

Pe ,b ≅ 0.5 × erfc ⎢

⎥

⎣ 5N 0 ⎦

⎡ 2 Eb ⎤

3

Pe ,b ≅ × erfc ⎢

⎥

4

⎣ 5N 0 ⎦

⎛ Eb ⎞

⎟

Pe ,b = 0.5 × erfc ⎜⎜

⎟

N

0 ⎠

⎝

In Figura 39 si mostra infine il grafico della probabilità di errore per le diverse modulazioni

considerate.

Figura 39

Se analizziamo il comportamento delle modulazioni M-PSK in particolare, ci accorgiamo che

aumentando M si ottiene un peggioramento delle prestazioni (a parte per il caso 4-PSK che è uguale

al 2-PSK). Del resto, si era visto che aumentando M si ha un miglioramento dell’efficienza

spettrale. Si ha cioè un risultato che si può generalizzare a tutte le modulazioni numeriche: se si

vuole guadagnare in banda bisogna pagare in termini di probabilità di errore, e viceversa. Il caso 4-

PSK è un caso particolare in cui si ha, rispetto al 2-PSK, un miglioramento in banda senza pagare in

probabilità di errore. Per questo le modulazioni 4-PSK sono in genere le più usate fra le M-PSK.

4.

Capacità di canale

Abbiamo quindi visto come sono relazionate fra di loro le risorse Banda e Potenza in un sistema di

comunicazione digitale che fa uso di modulazioni numeriche. Le prestazioni viste in precedenza in

particolare ci dicono quanta energia per bit è necessaria per avere buone prestazioni in termini di

probabilità di errore per un dato livello di rumore, o in altri termini, di quanta potenza è necessaria

per un dato bit rate e un dato livello di rumore. Un modo molto interessante per confrontare fra di

loro le modulazioni numeriche è quello di ricorrere al grafico EE contro Eb/N0. Per ottenere tale

grafico si fissa la probabilità di errore per bit che vogliamo ottenere, ad esempio Pe,b = 0.001 e

invertendo le formule della tabella precedente si trova Eb/N0. La corrispondente EE è quella tipica

della modulazione considerata. I punti corrispondenti alle diverse modulazioni sono riportati nella

figura sottostante.

La curva continua corrisponde al limite teorico di Shannon dato dalla formula:

⎛

E ⎞

EE = log 2 ⎜⎜ 1 + EE b ⎟⎟

N0 ⎠

⎝

Tale limite può essere avvicinato tramite l’utilizzo di tecniche di codifica di canale in cui la

sequenza in ingresso al trasmettitore è generata da un codificatore che associa in maniera opportuna

a una sequenza di k bit d’ingresso una sequenza di n bit di uscita (eventualmente occupando più

tempi di simbolo) e in cui il demodulatore manda i bit demodulati al decodificatore di canale che

ricostruisce la sequenza originaria (correggendo fino a un certo numero massimo di errori se

presenti).

Il significato della figura è che se vogliamo risparmiare in potenza/energia occorre spostarsi a

sinistra e questo lo si paga con una minore efficienza spettrale, ovvero con il consumo di più banda

per trasmettere lo stesso bit rate. D’altra parte, se vogliamo risparmiare banda a parità di bit rate

occorre spostarsi verso l’alto e questo lo si paga con una maggiore potenza.

Quando le risorse banda/potenza sono risorse critiche, diventa necessario cercare di avvicinare il più

possibile il limite teorico di Shannon, ovvero utilizzare tecniche di modulazione/codifica di canale

più efficienti possibile.