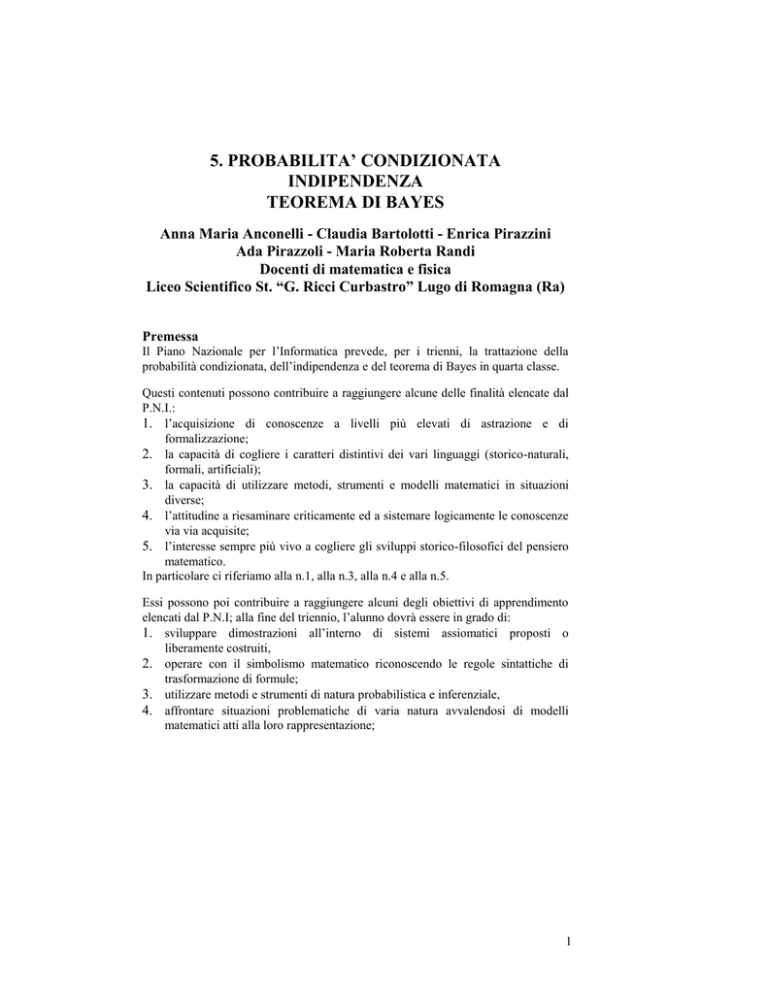

5. PROBABILITA’ CONDIZIONATA

INDIPENDENZA

TEOREMA DI BAYES

Anna Maria Anconelli - Claudia Bartolotti - Enrica Pirazzini

Ada Pirazzoli - Maria Roberta Randi

Docenti di matematica e fisica

Liceo Scientifico St. “G. Ricci Curbastro” Lugo di Romagna (Ra)

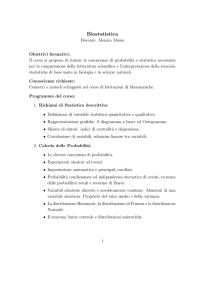

Premessa

Il Piano Nazionale per l’Informatica prevede, per i trienni, la trattazione della

probabilità condizionata, dell’indipendenza e del teorema di Bayes in quarta classe.

Questi contenuti possono contribuire a raggiungere alcune delle finalità elencate dal

P.N.I.:

1. l’acquisizione di conoscenze a livelli più elevati di astrazione e di

formalizzazione;

2. la capacità di cogliere i caratteri distintivi dei vari linguaggi (storico-naturali,

formali, artificiali);

3. la capacità di utilizzare metodi, strumenti e modelli matematici in situazioni

diverse;

4. l’attitudine a riesaminare criticamente ed a sistemare logicamente le conoscenze

via via acquisite;

5. l’interesse sempre più vivo a cogliere gli sviluppi storico-filosofici del pensiero

matematico.

In particolare ci riferiamo alla n.1, alla n.3, alla n.4 e alla n.5.

Essi possono poi contribuire a raggiungere alcuni degli obiettivi di apprendimento

elencati dal P.N.I; alla fine del triennio, l’alunno dovrà essere in grado di:

1. sviluppare dimostrazioni all’interno di sistemi assiomatici proposti o

liberamente costruiti,

2. operare con il simbolismo matematico riconoscendo le regole sintattiche di

trasformazione di formule;

3. utilizzare metodi e strumenti di natura probabilistica e inferenziale,

4. affrontare situazioni problematiche di varia natura avvalendosi di modelli

matematici atti alla loro rappresentazione;

1

5. costruire procedure di risoluzione di un problema e, ove sia il caso, tradurle in

programmi per il calcolatore;

risolvere problemi geometrici per via sintetica o per via analitica;

interpretare intuitivamente situazioni geometriche spaziali;

applicare le regole della logica in campo matematico;

utilizzare consapevolmente elementi del calcolo differenziale;

riconoscere il contributo dato dalla matematica allo sviluppo delle scienze

sperimentali;

11. inquadrare storicamente l’evoluzione delle idee matematiche fondamentali;

12. cogliere interazioni tra pensiero filosofico e pensiero matematico.

In particolare ci riferiamo al n.1, al n.3, al n4, al n5,al n.8, al n.10, al n.11 e al n.12.

6.

7.

8.

9.

10.

Nel commento al tema n.4 - probabilità e statistica – del quale gli argomenti in

oggetto fanno parte con l’indicazione 4.c, il P.N.I. sostiene che “gli elementi di

probabilità e statistica rispondono all’esigenza di abituare l’alunno ad effettuare

modellizzazioni di situazioni in condizioni di incertezza”.

Nelle indicazioni metodologiche, il P.N.I. insiste

sull’opportunità che

l’insegnamento sia condotto per problemi: “dall’esame di una data situazione

problematica l’alunno sarà portato, prima a formulare una ipotesi di soluzione, poi

a ricercare il procedimento risolutivo mediante il ricorso alle conoscenze già

acquisite, ed infine ad inserire il risultato ottenuto in un organico quadro teorico

complessivo, un processo in cui l’appello all’intuizione sarà via via ridotto per dare

più spazio all’astrazione ed alla sistemazione razionale. Si ricorda che il termine

problema va inteso nella sua accezione più ampia…in questa ipotesi potrà risultare

didatticamente proficuo storicizzare la questione presentandola come una

successione di tentativi portati a livello di rigore e di astrazione sempre più

spinti…A conclusione degli studi secondari scaturirà così naturale nell’alunno

l’interesse ad una revisione critica dei concetti e delle teorie via via apprese, anche

in un contesto interdisciplinare…che lo porterà a recepire un procedimento che è

diventato paradigmatico in qualsiasi ricerca e in ogni ambito disciplinare.”

Quanto detto fino qui, con gli opportuni riferimenti, si adatta perfettamente anche ai

programmi ministeriali elaborati dalla Commissione Brocca per i trienni.

Per quanto riguarda i vari indirizzi di studio ci si riferisce a quanto detto

espressamente per ciascuno di essi sia nel P.N.I. che nel Progetto Brocca.

A nostro parere la probabilità condizionata, l’indipendenza e il teorema di Bayes si

prestano benissimo come esempio per far vedere che la probabilità e la statistica non

sono argomenti in più da trattare, ma temi che si possono “fondere” con gli altri e

non solo a livello contenutistico, ma anche e soprattutto a livello metodologico:

possono aiutare moltissimo a superare la visione negativamente dogmatica della

2

matematica; possono, inoltre, aumentare le possibilità di saper indagare e conoscere

in modo consapevole la realtà.

Consigliamo in particolare di fare riferimento al primo capitolo del Quaderno n.8 del

M.P.I. ( vedi bibliografia [1] ).

Gli studenti incontrano:

l’induzione matematica come nuova forma di ragionamento che procede dal

particolare al generale;

l’induzione sperimentale, quasi esclusivamente in fisica, per capire che in campo

scientifico dalla conoscenza dei dati sperimentali si vuole arrivare alle leggi, alle

proprietà che regolano il fenomeno al quale l’esperimento si riferisce.

In questo caso essi hanno l’opportunità di avvicinarsi all’induzione statistica: si cerca

di arrivare a conclusioni, di formulare leggi aventi una validità generale per l’intera

collettività partendo da una parte di essa o campione; questo processo è ovviamente

attuato con gli strumenti della metodologia statistica e della probabilità e quindi

rappresenta un nuovo e diverso ambiente di lavoro e favorirà al massimo livello quel

“diventare paradigmatico” citato in precedenza.

Per quanto riguarda in particolare il teorema di Bayes, esso conclude la trattazione

della probabilità ed è di importanza fondamentale per l’induzione statistica; le

eventuali applicazioni anche nel continuo, si realizzeranno in quinta classe, quando

si concluderà il lavoro con la parte inferenziale e gli studenti saranno in possesso

anche di adeguati concetti matematici.

L’insistenza su tale teorema è giustificata dal fatto che crediamo possa permettere la

rivisitazione quasi naturale di tanti argomenti già trattati, in un momento in cui gli

studenti sono in possesso di più strumenti conoscitivi e sono anche in grado di

valutare diversi metodi da vari punti di vista; la conoscenza di quegli argomenti

diventerà quindi più ampia e più sicura.

In particolare pensiamo che lavorare su questi argomenti rappresenti un’occasione in

più e diversa dalle solite, concettualmente più impegnativa e di applicazioni più

profonde della logica.

Prerequisiti

1.

concetti di base della teoria degli insiemi; (unione, intersezione, complementare,

prodotto cartesiano);

2. concetti di base corrispondenti di logica matematica (vel, et, non);

3. uso appropriato di diagrammi di vario tipo e in particolare ad albero;

4. concetti di base di calcolo combinatorio (non indispensabili, ma utili per avere

più libertà di scelta di esempi di vario genere);

5. probabilità:

definizione classica;

definizione statistica, frequentista;

definizione soggettiva;

3

definizione assiomatica;

primi riferimenti storici.

OBIETTIVI

SAPERE

SAPER FARE

Concetti di prova e di evento

Lavorare con gli eventi

Concetto di probabilità degli eventi da

vari punti di vista

Calcolare la probabilità di eventi in vari

contesti

Concetti di eventi incompatibili e

compatibili

Calcolare la probabilità di eventi anche

definiti attraverso i connettivi e, o, non

Legge delle probabilità totali

Lavorare sia in caso di incompatibilità

che in caso di compatibilità

Definizione di probabilità condizionata

Calcolare la probabilità condizionata

lavorando anche con gli insiemi

Legge delle probabilità composte

Applicare la legge

Concetto di indipendenza

Lavorare con esempi

rispetto anche a tre casi

Enunciare il teorema di Bayes

Applicare il teorema in casi standard

Dimostrare il teorema di Bayes

Applicare il teorema in situazioni nuove

Esporre il concetto, il significato ad

esso sotteso

Distinguere le situazioni in cui il

teorema è applicabile

Sintetizzare le nuove conoscenze

Usare la tecnica

insiemistico

Valutare queste conoscenze in rapporto

ad altre e anche di altre discipline

Usare la tecnica del diagramma ad

albero

Utilizzare consapevolmente la logica

Usare la tecnica della tabella

Distinguere l’induzione matematica da

quella sperimentale

Stabilire la probabilità che un evento sia

“causa” di un altro

significativi

del

diagramma

4

Inquadrare storicamente il teorema

Applicare il teorema in vari contesti ed

anche di ambiti disciplinari diversi

Contenuti:

probabilità condizionata;

indipendenza;

teorema di Bayes e sue applicazioni in ambito discreto.

Strumenti:

appunti personali di corsi di aggiornamento;

articoli su riviste di didattica della matematica (vedi bibliografia);

libri di scuola secondaria o universitari (vedi bibliografia);

libri divulgativi (vedi bibliografia);

strumenti informatici adeguati.

Metodologia

Il lavoro si articola in fasi di vario genere che possono essere così schematizzate:

1) si assegnano problemi stimolo individualmente, in classe o a casa;

2) si discutono in classe le “pensate individuali”;

3) dalla discussione emerge la necessità di esaminare altre situazioni, allora si

assegnano altri problemi stimolo che sono affrontati in classe in gruppo ed

eventualmente “ripensati” a casa;

4) dalla nuova discussione emerge una prima sistematizzazione;

5) si assegnano esercitazioni di rinforzo da fare a casa individualmente,

6) si correggono in classe,

7) seguono le necessarie lezioni frontali fino alla completa sistematizzazione;

8) si fa una prima verifica formativa individuale scritta ;

9) alla sua correzione segue un eventuale lavoro di sostegno-recupero ,

10) si fa una verifica sommativa individuale scritta;

11) segue la sua correzione;

12) gli studenti, a casa, lavorano con tutti gli elementi in loro possesso;

13) si fa una verifica sommativa, individuale, orale, conclusiva.

Tempi e osservazioni

Il lavoro didattico così organizzato implica la necessità di utilizzare un certo tempo;

pensiamo che ne valga la pena data l’importanza che questi argomenti hanno dal

punto di vista concettuale, rappresentando il nucleo fondante l’argomento della

probabilità.

E’ opportuno un buon approfondimento per portare gli studenti a padroneggiare con

sicurezza un argomento di cui vogliamo che condividano l’importanza, senza dover

superare più difficoltà rispetto a quando “fanno matematica” e nello stesso tempo a

5

vederlo ben integrato con gli altri temi visto anche il notevole interesse che suscita

dato che il contesto è stimolante, aderente alla realtà e diverso dal solito.

Considerazioni storiche

Gli studenti, fin dal biennio, hanno avuto varie occasioni per riflessioni storiche

riguardanti la statistica e la probabilità: ci sembra opportuno, infatti, stimolare da

subito la loro curiosità circa l’origine dei lavori su tali argomenti.

Esaminate le varie ipotesi riguardanti dove e quando sarebbe nata la probabilità, si

passa attraverso un’opera di Cicerone e dopo un salto di secoli si arriva fino a

Cardano; la grande diffusione del gioco d’azzardo porta in particolare ai lavori di

Galileo, di Pascal e di Fermat che segnano l’inizio di lavori organici.

Suscita sicuro interesse entrare un po’ nei particolari di vicende come quella del

problema dei tre dadi nel gioco della zara circa i punteggi 9, 10, proposto dai

gentiluomini fiorentini a Galileo o del problema della ripartizione della posta, del

Cavaliere De Meré, accanito giocatore, che lo propose a Pascal: G. Prodi nel suo

libro “Matematica come scoperta” lo titola “l’utilità dei fannulloni”.

Nel tempo, con il contributo di tanti, la probabilità diventa una teoria autonoma;

nascono e si sviluppano le varie concezioni e dai contrasti nascono dibattiti proficui

che rivelano la complessità dei problemi e nuovi campi di applicazione.

In particolare si può fare riferimento al teorema o, come riportato da diversi autori,

alla formula, che risale ad un lavoro di Thomas Bayes(1702-1761).

In tale studio veniva implicitamente ammesso che le varie alternative (in numero

finito) avessero uguale probabilità e quindi le probabilità a posteriori risultavano

proporzionali alle probabilità condizionate o verosimiglianze. Questo risultato lasciò

dubbioso Bayes che non pubblicò il suo lavoro. Quest’ultimo apparve solo nel 1763,

dopo la sua morte, a cura di un amico e sollevò molto interesse. Solo in seguito, il

procedimento per ricavare le probabilità a posteriori venne separato dalla ipotesi di

uguale probabilità e il risultato venne esteso, lasciando cadere tale ipotesi, e si

ottenne la forma che oggi vediamo del teorema. L’ipotesi di uguali probabilità a

priori venne ripresa e analizzata in particolare da Laplace, e viene detta ipotesi di

Bayes-Laplace. Molte discussioni, spesso polemiche, hanno accompagnato sia questa

ipotesi che in generale le applicazioni del Teorema di Bayes.

L’insegnante presenta, in classe, brevemente, le principali situazioni storiche; gli

studenti, singolarmente o a gruppi , a seconda degli interessi personali sviluppano a

casa delle parti, per un tempo concordato, durante il quale possono consultarsi con

l’insegnante per una miglior riuscita del percorso.

In un incontro prefissato ciascuno porta i materiali di riferimento ed espone la propria

parte, anche con l’aiuto di lucidi, cartelloni, mezzi informatici, in ordine rispetto

all’impianto complessivo di cui tutti debbono essere a conoscenza.

6

Didatticamente un momento come questo è proficuo da vari punti di vista; in

particolare accresce la capacità di autonomia del singolo ma aiuta soprattutto il

lavoro globale a cui ogni singolo deve sentire di partecipare in modo determinante.

5.1. Prove, eventi, insiemi, probabilità

Il lavoro inizia riprendendo e cercando di consolidare quanto è stato fatto nel

precedente biennio.

In particolare gli studenti debbono avere ben chiari i concetti di base tra i quali quelli

di prova o esperimento e di evento.

Il lancio di un dado è una prova. L’apparire di un 3 o di un 6 o di un numero pari,

sono eventi.

Se lanciamo un dado successivamente per tre volte e ci chiediamo se la terna che

appare è fatta di numeri tutti pari, per il risultato che ci interessa, la prova è l’insieme

dei tre lanci e solo per utilità pratica possiamo pensare ad ogni singolo lancio come

ad una “sottoprova” delle prova; l’apparizione di una terna di numeri tutti pari è un

evento.

Chiamiamo l’insieme totale o spazio che rappresenta tutti i possibili risultati della

prova: in esso ci sono tutti gli eventi su cui si possono fare le operazioni che

interessano; esso è l’evento certo e il suo complementare, l’insieme vuoto, è l’evento

impossibile.

E’ opportuno chiarire che la scelta di è legata sì alla prova, all’esperimento, ma

può dipendere anche dal problema.

Facciamo un esempio. Se lanciamo un dado, in generale si ha che =1,2,3,4,5,6;

se ci interessa distinguere solo l’uscita di un numero pari o dispari si ha che

=P,D.

Un evento è un insieme di eventi elementari, un sottoinsieme dell’insieme di tutti i

possibili risultati della prova, cioè dello spazio .

Per rafforzare ulteriormente la chiara comprensione concettuale proponiamo il

seguente esempio:

abbiamo un’urna contenente 5 palline numerate da 1 a 5, estraiamo due palline con

reimbussolamento; ci interessa l’evento E “uscita di due numeri dispari”.

è costituto dalle 25 coppie ordinate (1,1); (1,2); …(5,5) che si ottengono

associando i 5 numeri che possono uscire alla prima estrazione con i 5 numeri che

possono uscire alla seconda estrazione.

Sia A l’evento “esce un numero dispari nella prima estrazione ed esce un numero

qualsiasi nella seconda estrazione”, sia B l’evento “esce un numero qualsiasi nella

prima estrazione ed esce un numero dispari nella seconda estrazione”.

In tal modo E=AB e P(E)=9/25.

7

Attenzione a non lavorare con l’evento A1 “il primo numero estratto è dispari” e con

l’evento B1 “il secondo numero estratto è dispari” intendendo A1=B1=1,3,5 come

sottoinsiemi di =1,2,3,4,5; in tal modo E=A1B1 è concettualmente errato

perché è costituito da tutte le coppie ordinate risultato della prova che è costituita

da due estrazioni.

La seguente tabella, opportunamente schematizzata, ci sembra visivamente efficace:

(1,1) (1,3) (1,5)

(3,1) (3,3) (3,5)

(5,1) (5,3) (5,5)

(1,2) (1,4)

(3,2) (3,4)

(5,2) (5,4)

(2,1) (2,3) (2,5)

(4,1) (4,3) (4,5)

(2,2) (2,4)

(4,2) (4,4)

Diamo un’importante definizione.

Una famiglia di eventi, non vuota (che abbia almeno un evento) e tale che:

1. se A, allora A,

2. se A, B , allora anche AB,

si dice che costituisce un’algebra di eventi o una famiglia non vuota chiusa rispetto

alla negazione e all’unione, detta classe additiva.

Si vede facilmente che sia che appartengono ad .

Sappiamo infatti che A A= e che = ; applicando poi 1) e 2) si deduce

l’appartenenza.

Si vede inoltre che contiene anche l’intersezione di due suoi eventi qualsiasi.

Basta ricordare l’identità che lega la negazione di AB con A B e applicando 1)

e 2) si ottiene l’appartenenza.

Una classe additiva può essere composta da tutti i sottoinsiemi di o solo da una

parte. A tal proposito si può vedere l’esempio a pag. 23 di [13].

Un evento si dice elementare se è diverso dall’insieme vuoto e, intersecato con un

qualunque altro evento, o rimane invariato o dà l’insieme vuoto. A tal proposito si

può vedere l’esempio a pag. 24 di [13].

Scegliamo di rappresentare gli eventi come insiemi perché così facendo si ha uno

strumento di lavoro agile ed utilissimo: si calcolano le probabilità degli eventi e si

ottiene una struttura di calcolo per gli eventi stessi ad esempio attraverso i concetti di

unione, passaggio al complementare e chiusura negli insiemi.

8

In altre parole, adottando gli insiemi come rappresentazione degli eventi, si realizza

un collegamento fra l’algebra degli insiemi e la logica degli eventi.

Nel lancio di una moneta =T, C, gli eventi elementari T=“testa”, C=“croce”

costituiscono una partizione e l’algebra degli eventi ad essa associata è:

=T,C,,.

Proseguiamo il lavoro riprendendo altri concetti importanti.

Due eventi si dicono incompatibili se la loro intersezione è l’evento impossibile (non

si verificano contemporaneamente).

Più eventi si definiscono incompatibili se lo sono a due a due.

Più eventi si definiscono necessari se la loro unione è l’evento certo (almeno uno di

essi si deve verificare).

Se più eventi sono necessari e incompatibili costituiscono una partizione di .

Riprendiamo, in particolare, la ”legge delle probabilità totali” per eventi

incompatibili e la sua estensione quando cade la condizione di incompatibilità.

Lavoriamo sempre su tanti esempi adeguati che sono facilmente reperibili nei testi.

Riteniamo che sia importantissimo fare sempre riferimento alle varie definizioni di

probabilità mano a mano che si incontrano situazioni adatte a ciascuna di esse; in tal

modo si spera di evitare che per gli studenti esse risultino appartenere ad una

classificazione astratta anziché rappresentare precisi punti di vista.

Quando riteniamo che gli studenti abbiano raggiunto un’adeguata preparazione

passiamo a trattare la probabilità condizionata seguita nell’ordine dalla indipendenza

tra eventi.

La scelta di tale ordine di presentazione è dettata anche da motivazioni didattiche ma

soprattutto da motivazioni concettuali; la sua importanza emergerà chiaramente nel

proseguimento del lavoro.

A tal proposito si possono vedere i riferimenti bibliografici [13] e [R9].

5.2. La probabilità condizionata

Proponiamo il seguente problema: lanciando due volte un dado qual è la probabilità

che la somma dei punti sia dodici?

Si invitano gli studenti a riflettere sulle varie posizioni che singolarmente o a gruppi

possono aver preso; si cerca di aiutarli con la seguente tabella, opportunamente

predisposta:

(1,1) (1,2) (1,3) (1,4) (1,5)

(2,1) (2,2) (2,3) (2,4) (2,5)

(1,6)

(2,6)

9

(3,1) (3,2) (3,3) (3,4) (3,5)

(4,1) (4,2) (4,3) (4,4) (4,5)

(5,1) (5,2) (5,3) (5,4) (5,5)

(3,6)

(4,6)

(5,6)

(6,1) (6,2) (6,3) (6,4) (6,5) (6,6)

Si arriva alle seguenti situazioni:

effettuo il primo lancio e, senza guardare il risultato, immediatamente effettuo il

secondo lancio; delle 36 coppie ordinate possibili (tutte ugualmente possibili)

l’unica favorevole all’evento è la (6,6) per cui la valutazione che faccio è che la

probabilità dell’evento considerato è 1/36;

effettuo il primo lancio e guardo il risultato ottenuto; ora la valutazione che

posso fare è diversa dalla precedente e dipende da quale risultato ho ottenuto:

se il risultato è 6 concludo che la probabilità dell’evento considerato è 1/6;

se il risultato è diverso da 6 concludo che la probabilità è 0.

Questo primo problema viene analizzato a fondo e appositamente senza ricorrere ad

alcun formalismo per portare gli studenti a riflessioni libere e per rivisitare ancora

una volta i concetti di prova e di evento.

Proponiamo un secondo problema.

Consideriamo un’urna contenente sei palline, numerate da uno a sei; estraiamo una

prima pallina, la mettiamo da parte ed estraiamo una seconda pallina (procedimento

chiamato di estrazione senza reimbussolamento). Ci proponiamo di valutare la

probabilità dell’evento E: “la seconda pallina è contrassegnata dal numero quattro”.

Procedendo come per il problema precedente arriviamo alle seguenti situazioni:

se non abbiamo potuto vedere il numero della prima pallina, la probabilità

dell’evento E è ancora 1/6; in assenza di altre informazioni, ciascuno dei sei

numeri presenti nell’urna potrebbe esservi rimasto dopo la prima estrazione, per

considerazioni di simmetria a ciascuno di tali sei numeri va attribuita uguale

probabilità di uscita alla seconda estrazione; ragionando sulla seguente tabella si

ottiene 5/30=1/6.

(2,1)

(3,1)

(4,1)

(5,1)

(6,1)

(1,2) (1,3)

(2,3)

(3,2)

(4,2) (4,3)

(5,2) (5,3)

(6,2) (6,3)

(1,5)

(2,5)

(3,5)

(4,5)

(6,5)

(1,6)

(2,6)

(3,6)

(4,6)

(5,6)

(1,4)

(2,4)

(3,4)

(5,4)

(6,4)

10

se invece abbiamo potuto vedere il numero della prima pallina e tale numero non

era il quattro, la probabilità dell’evento E è 5/25=1/5; ci aiutiamo con la seguente

tabella:

(1,2) (1,3) (1,5) (1,6) (1,4)

(2,1)

(2,3) (2,5) (2,6) (2,4)

(3,1) (3,2)

(3,5) (3,6) (3,4)

(5,1) (5,2) (5,3)

(5,6) (5,4)

(6,1) (6,2) (6,3) (6,5)

(6,4)

(4,1) (4,2) (4,3) (4,5) (4,6)

se, infine, abbiamo potuto vedere il numero della prima pallina e tale numero era

proprio il quattro, la probabilità dell’evento E è 0, come ci fa vedere bene la

tabella relativa al caso precedente.

A questo punto si fanno riflettere gli studenti sulla seguente frase:

“Calcolo delle probabilità di certi eventi, partendo da quelle di altri eventi che

vengono considerate note”

( dalla relazione “Introduzione alla probabilità” di G. Dall’Aglio in [R9] ).

La nozione di probabilità si ricollega strettamente a situazioni di incertezza, ossia di

incompletezza delle informazioni relative al fenomeno che si intende esaminare; non

stupisce pertanto il fatto che, al variare delle informazioni in nostro possesso, la

valutazione della probabilità di uno stesso evento possa modificarsi anche

radicalmente.

Affrontiamo un terzo problema e cominciamo a lavorare in forma precisa, con il

formalismo adeguato.

Consideriamo un’urna contenente 10 palline numerate da 1 a 10 e ne estraiamo una.

Sapendo che è uscito un numero pari calcolare la probabilità che esso sia divisibile

per tre.

Sia A l’evento “numero pari”, sia B l’evento “numero divisibile per tre”.

Allora. A=2,4,6,8,10, B=3,6,9, AB=6.

Calcoliamo: P(A)=5/10, P(B)=3/10, P(AB)=1/10

11

P( B / A)

1 nA B nA B / n P( A B) 1 / 10

1 / 5

5

nA

nA / n

P( A)

5 / 10

I casi possibili non sono più tutti quelli iniziali, ma solo quelli favorevoli ad A e i

casi favorevoli sono, tra questi, quelli favorevoli a B, cioè i casi favorevoli sia ad A

che a B, in altre parole i casi favorevoli ad AB.

1

7

5

A

B

2

4

3

6

9

10

8

Altro problema

Si ha una partita di 300 pneumatici, dei quali 25 presentano delle irregolarità solo

nello spessore del battistrada (S), 12 hanno solo le tracce non regolamentari (T) e 7

presentano entrambi i difetti. Se ogni pneumatico ha la stessa probabilità di essere

estratto, calcolare la probabilità di estrarre un pneumatico avente le tracce non

regolamentari, sapendo che ha delle irregolarità nello spessore.

Calcoliamo: P(T/S)=7/32=P(TS)/P(S)=7/300 : 32/300 = 7/32.

(300)

T (19)

S (32)

(25)

(7)

(12)

(256)

12

Diamo ora la definizione di probabilità condizionata.

Dati due eventi E ed H con P(H)0 si dice probabilità condizionata di E dato H il

numero P(EH)/P(H)e si indica P(E/H).

P( H ) 0

nE H nE H nH P ( E H )

:

P( E / H )

nH

n n

P( H )

Il concetto di probabilità condizionata fornisce:

la probabilità dell’evento E condizionata dal verificarsi dell’evento H; in altre

parole, la probabilità che si verifichi l’evento E quando si sa che l’evento H si è

verificato;

la probabilità dell’evento E quando si considera valida la prova solo se l’evento

H si verifica;

la probabilità dell’evento E considerando possibili solo i casi favorevoli

all’evento H condizionante.

Si fa poi riferimento alle diverse impostazioni della probabilità.

Dalla definizione, inoltre, si ottiene che:

P(E/E)=1;

se EH

P(E/H)=P(E)/P(H);

se HE

P(E/H)=1;

se EH= P(E/H)=0.

Se scriviamo: P(H)0

P(EH) = P(H)P(E/H)

Otteniamo la legge delle probabilità composte.

E’ bene insistere con gli studenti che non debbono confondere gli eventi: E/H, EH.

E/H significa che H si deve verificare e poi si vede che cosa succede ad E.

EH significa che per verificarsi debbono verificarsi sia E che H.

13

Facciamo un’ulteriore considerazione attraverso un esempio.

Si estrae una carta da un mazzo di 40 carte, la si guarda, la si tiene fuori e si estrae

un’altra carta dal mazzo delle 39 rimanenti e la si guarda. Si vuole calcolare la

probabilità dell’evento M “entrambe le carte sono di denari”.

Possiamo pensare a due eventi:

A “la prima carta estratta è di denari, la seconda carta estratta è qualsiasi”;

B “la prima carta estratta è qualsiasi, la seconda carta estratta è di denari”.

Vediamo con estrema facilità che non c’è differenza fra l’evento AB e l’evento

BA.

40

D

D

10/40

30/40

39

39

D

D

9/39

30/39

10/39

10/40*9/39

10/40*30/39

D

30/40*10/39

D

29/39

30/40*29/39

Calcoliamo poi:

14

P(A)=(10*9+10*30)/(40*39)=1/4

P(B)=(10*9+30*10)/(40*39)=1/4

P(AB)=(10*9)/(40*39)=3/52

P(A/B)=P(B/A)=3/13

P(M)=P(BA)=P(B/A)P(A)=3/13*1/4=3/52;

P(M)=P(AB)=P(A/B)P(B)=3/13*1/4=3/52.

(40*39)

A (10+9+10*30)

B (10*9+30*10)

(10*30)

M (10*9)

(30*10)

(30*29)

Dal punto di vista logico tutto funziona bene, ma ovviamente dobbiamo vedere che

cosa succede in pratica:

P(B/A) si legge

“la seconda carta estratta è di denari, sapendo che la prima estratta è di denari”;

P(A/B) si legge

“la prima carta estratta è di denari, sapendo che la seconda estratta è di denari”.

Questo secondo enunciato, non privo di senso dal punto di vista logico, nella realtà

non si prende in considerazione perché le due estrazioni avvengono in due tempi

successivi e nell’ordine già precisato.

Facciamo ora altri esempi.

Esempio 1

Giochiamo al lotto il numero 50 sulla ruota di Napoli.

Ascoltiamo l’estrazione alla radio e sentiamo 14,25,39,21 e non capiamo l’ultimo

numero estratto.

15

Calcolare la probabilità di vincere:

al momento della giocata;

dopo aver ascoltato in quel modo l’estrazione.

Sia E l’evento “tra i cinque numeri estratti sulla ruota di Napoli c’è il 50”.

Sia H l’evento ”i primi quattro numeri estratti sono 14,25,39,21”.

Calcoliamo P(E)=5/90, P(E/H)=1/86.

L’evento E è condizionato dall’evento H negativamente perché 1/86 < 5/90.

Esempio 2

Consideriamo il gioco della “roulette russa”: si carica con un solo proiettile una

pistola a tamburo a sei colpi, si fa ruotare il tamburo, si punta l’arma alla tempia e si

preme il grilletto. In caso di sopravvivenza si preme di nuovo il grilletto senza ruotare

il tamburo.

Calcolare:

la probabilità di morte al primo colpo (evento A);

la probabilità di morte al secondo colpo (evento B).

Sia H l’evento “il primo colpo non è mortale”.

Calcoliamo:

P(A)=1/6

P(B)=1/5.

Possiamo commentare che quando si calcola la probabilità relativa all’evento B si ha

un’informazione (si è verificato l’evento H) che determina una situazione diversa

rispetto a quando ci si riferisce all’evento A.

La probabilità di morte al secondo colpo è maggiore della probabilità di morte al

primo colpo.

Esempio 3

Uno studente deve rispondere con si/no a cinque domande di un test.

E’ completamente impreparato per cui decide di rispondere a caso.

Durante la prova un amico gli fornisce la risposta esatta alle ultime tre domande.

Calcolare la probabilità di rispondere esattamente a tutte e cinque le domande:

prima di effettuare la prova;

dopo aver ricevuto i suggerimenti dall’amico.

Sia E l’evento “ tutte e cinque le risposte sono esatte”.

Sia H l’evento “ le ultime tre risposte sono esatte”.

Calcoliamo:

P(E)=1/32

P(E/H)=1/4.

L’evento E è condizionato dall’evento H positivamente perché 1/4 > 1/32.

16

Esempio 4

Si lanciano due dadi: se la somma dei due punteggi è 6 si determini la probabilità che

uno dei dadi abbia dato punteggio 2.

Indichiamo con H l’evento “la somma dei punteggi è 6”.

Indichiamo con E l’evento “uno dei dadi ha dato punteggio 2”.

Ci serviamo della seguente tabella opportunamente strutturata:

(1,1)

(1,3) (1,4)

(3,1)

(4,1)

(3,4) (3,5) (3,6)

(4,3) (4,4) (4,5) (4,6)

(5,3) (5,4) (5,5) (5,6)

(6,3) (6,4) (6,5) (6,6)

(6,1)

(1,6)

(5,1) (3,3) (1,5)

(1,2)

(2,2)

(3,2)

(5,2)

(6,2)

(2,1)

(2,3)

(2,5)

(2,6)

(4,2)

(2,4)

Calcoliamo:

P(E/H)= P(EH)/P(H)=2/5

P(E)=11/36.

L’evento E è condizionato dall’evento H positivamente perché 2/5>11/36.

Esempio 5

La seguente tabella mostra l’incidenza del daltonismo per il rosso-verde in una

popolazione umana (i valori sono in percentuale):

DALTONICO

NORMALE

TOTALE

MASCHIO

4.23

48.48

52.71

FEMMINA

0.65

46.64

47.29

TOTALE

4.88

95.12

100.00

Qual è l’incidenza del daltonismo per i maschi?

17

P(D/M)= P(DM)/P(M)=4.23/52.71=8.03%.

Qual è l’incidenza del daltonismo per le femmine?

P(D/F)= P(DF)/P(F)=0.65/47.29=1.37%.

Poiché P(D)=4.88%, il daltonismo dipende dal sesso e precisamente, positivamente

per i maschi (8.03>4.88), negativamente per le femmine (1.37<4.88) e si conclude

che il daltonismo per il rosso-verde si osserva più frequentemente nei maschi che

nelle femmine (8.03>1.37).

Esempio 6

In una elezione i candidati A, B, C, D hanno rispettivamente probabilità di riuscire

eletti:

P(A)=0.4, P(B)=0.3, P(C)=0.2, P(D)=0.1.

Prima delle elezioni il candidato C si ritira. Calcolare come si modificano le

probabilità di elezione degli altri tre candidati.

P( A/C)=P( AC)/P(C )=0.4/0.8=0.500 > P(A)

P( B/C)=P( BC)/P(C )=0.3/0.8=0.375 > P(B)

P( D/C)=P( DC)/P(C )=0.1/0.8=0.125 > P(D)

Diamo la seguente definizione:

se P(E/H)>P(E) si dice che l’evento E è correlato positivamente all’evento H.

Teorema

Se P(E/H)>P(E) allora anche P(H/E)>P(H).

Dimostrazione

Per ipotesi P(E/H)=P(EH)/P(H)>P(E).

Allora P(H/E)=P(HE)/P(E)=P(E/H)P(H)/P(E)=[P(E/H)/P(E)]*P(H).

Per l’ipotesi P(E/H)>P(E) si può anche dire che P(E/H)/P(E)>1 e allora si ottiene

P(H/E)>P(H).

c.v.d.

Abbiamo dimostrato che se l’evento E è correlato positivamente all’evento H allora

anche l’evento H è correlato positivamente all’evento E.

Con gli ovvi cambiamenti si parla di correlazione negativa.

In generale si parla di eventi correlati positivamente o negativamente.

5.3. L’indipendenza

Gli ultimi esempi ci hanno portato a conclusioni del tipo P(E/H)>P(E) oppure del

tipo P(E/H)<P(E).

Lavoriamo con altri esempi per vedere se incontriamo anche l’uguaglianza.

18

Esempio 1

Lanciamo un dado e consideriamo i seguenti eventi: E=2,4,6, H=1,2.

Otteniamo che EH=2 e che P(E)=3/6, P(H)=2/6, P(EH)=1/6.

Con semplici calcoli otteniamo:

P(E/H)=P(EH)/P(H)=1/6 : 2/6=1/2 = P(E);

P(H/E)=P(HE)/P(E)=1/6 : 3/6 = 1/3 = P(H).

Esempio 2

Lanciamo un dado e consideriamo i seguenti eventi: E=2,3,4,6, H=1,2,6.

Otteniamo che EH=2,6 e che:

P(E)=4/6, P(H)=3/6, P(EH)=2/6.

Con semplici calcoli otteniamo:

P(E/H)=P(EH)/P(H)=2/6 : 3/6=2/3 = P(E);

P(H/E)=P(HE)/P(E)=2/6 : 4/6 = 1/2 = P(H).

Esempio 3

Lanciamo un dado e consideriamo i seguenti eventi: E=2, H=1,2,6.

Otteniamo che EH=2 e che:

P(E)=1/6, P(H)=3/6, P(EH)=1/6.

Con semplici calcoli otteniamo:

P(E/H)=P(EH)/P(H)=1/6 : 3/6=1/3 P(E);

P(H/E)=P(HE)/P(E)=1/6 : 1/6 = 1 P(H).

Esempio 4

Lanciamo un dado e consideriamo i seguenti eventi: E=2,3,4, H=1,2,6.

Otteniamo che EH=2 e che:

P(E)=3/6, P(H)=3/6, P(EH)=1/6.

Con semplici calcoli otteniamo:

P(E/H)=P(EH)/P(H)=1/6 : 3/6=1/3 P(E);

P(H/E)=P(HE)/P(E)=1/6 : 3/6 =1/3 P(H).

Esempio 5

Un’urna contiene sei palline rosse e quattro verdi; da essa si estrae una pallina, si

guarda, poi si estrae una seconda pallina e si guarda.

Sia E l’evento “la prima pallina estratta è rossa, la seconda pallina estratta è

qualsiasi”, sia H l’evento “la prima pallina estratta è qualsiasi, la seconda pallina

estratta è verde”.

19

Con semplici calcoli otteniamo:

P(E)=(6*5+6*4)/(10*9)=54/90=3/5;

P(H)=(6*4+4*3)/(10*9)=36/90=2/5;

P(EH)=(6*4)/(10*9)=24/90=4/15.

Allora:

P(E/H)=P(EH)/P(H)=4/15 : 2/5=2/3 P(E);

P(H/E)=P(HE)/P(E)=4/15 : 3/5=4/9 P(H).

Esempio 6

Un’urna contiene sei palline rosse e quattro verdi; da essa si estrae una pallina, si

guarda, si rimette nell’urna, poi si estrae una seconda pallina e si guarda.

Sia E l’evento “la prima pallina estratta è rossa, la seconda pallina estratta è

qualsiasi”, sia H l’evento “la prima pallina estratta è qualsiasi, la seconda pallina

estratta è verde”.

Con semplici calcoli otteniamo:

P(E)=(6*6+6*4)/(10*10)=60/100=3/5;

P(H)=(6*4+4*4)/(10*10)=40/100=2/5;

P(EH)=(6*4)/(10*10)=24/100=6/25.

Allora:

P(E/H)=P(EH)/P(H)=6/25 : 2/5=3/5 = P(E);

P(H/E)=P(HE)/P(E)=6/25 : 3/5=2/5 = P(H).

Da questi sei esempi sembra che:

se P(E/H)=P(E) allora P(H/E)=P(H);

in generale P(E/H) P(H/E);

se P(E/H) = P(H/E) allora, in generale P(E/H) P(E) e P(H/E) P(H); infatti, se

in un caso valesse l’uguaglianza, data l’ipotesi, varrebbe in entrambi i casi e

allora si avrebbe: P(E/H)=P(H/E)=P(E)=P(H)=p e P(EH)=p^2, cioè una

situazione particolarissima.

A proposito dell’ultima considerazione vediamo il seguente esempio: un’urna

contiene tre palline rosse, tre palline verdi e quattro gialle; da essa si estrae una

pallina, si guarda, si rimette nell’urna, poi si estrae una seconda pallina e si guarda.

Sia E l’evento “la prima pallina estratta è rossa, la seconda pallina estratta è

qualsiasi”, sia H l’evento “la prima pallina estratta è qualsiasi, la seconda pallina

estratta è verde”.

Con semplici calcoli otteniamo:

P(E)=(3*3+3*3+3*4)/(10*10)=30/100=3/10;

P(H)=(3*3+3*3+4*3)/(10*10)=30/100=3/10;

20

P(EH)=(3*3)/(10*10)=9/100.

Allora:

P(E/H)=P(EH)/P(H)=9/100 : 3/10=3/10 = P(E);

P(H/E)=P(HE)/P(E)=9/100 : 3/10=3/10 = P(H).

Vediamo di sistemare concettualmente le considerazioni suggerite dai casi esaminati.

Diamo la definizione di indipendenza stocastica.

L’evento E si dice indipendente probabilisticamente dall’evento H se il verificarsi di

H non influisce sulla probabilità di verificarsi di E: P(E/H)=P(E).

Teorema

Se P(E/H)=P(E) allora P(H/E)=P(H).

Dimostrazione

Per ipotesi P(E/H)=P(EH)/P(H)=P(E).

Possiamo scrivere: P(EH)=P(H)P(E/H) = P(H)P(E).

Allora P(H/E)=P(HE)/P(E)=[P(E/H)P(H)]/P(E)=[P(E/H)/P(E)]*P(H).

Per l’ipotesi P(E/H)=P(E) allora si ottiene P(H/E)=P(H).

c.v.d.

Riprendiamo una relazione che abbiamo trovato facendo la dimostrazione del

teorema precedente:

P(E)0, P(H) 0

P(E/H)=P(EH)/P(H)=P(E)

P(H/E)=P(HE)/P(E)=P(H)

e allora:

P(E)0, P(H) 0

P(EH)=P(H)P(E).

Quest’ultima relazione

può essere presa come definizione matematica di

indipendenza e come tale va considerata come una condizione necessaria e

sufficiente: in base alla prova, se i due eventi sono indipendenti, valgono quelle

relazioni, viceversa, se valgono quelle relazioni, calcolando le varie probabilità,

allora i due eventi sono indipendenti.

La relazione ottenuta è simmetrica rispetto ai due eventi cioè l’indipendenza è

reciproca: se E è indipendente da H anche H è indipendente da E.

Si parla di legge delle probabilità composte.

Nel caso di dipendenza si ha:

P(E)0, P(H) 0

P(EH)=P(H)P(E/H)

P(HE)=P(E)P(H/E).

21

Nel caso di indipendenza è chiamata anche regola del prodotto e si ha:

P(E)0, P(H) 0

P(EH)=P(H)P(E).

Se l’evento E è probabilisticamente indipendente dall’evento H significa che il

verificarsi o meno di H non influisce sulla probabilità di E, la probabilità

condizionata di E è uguale alla probabilità “assoluta”; l’informazione che H si sia

verificato non modifica la valutazione della probabilità di E.

Si può facilmente dimostrare che se E ed H sono indipendenti, lo sono anche:

E e H;

E e H;

E e H.

Per la dimostrazione si può vedere il riferimento bibliografico [13].

E’ importante chiarire che l’indipendenza non va valutata in base allo svolgimento

della prova: due eventi sono considerati indipendenti perché relativi a prove

indipendenti, come ad esempio due lanci successivi di un dado.

Ribadiamo, anche riferendoci agli esempi fatti, che lanciando due dadi le due

sottoprove in cui si articola la prova possono dare la convinzione errata

dell’indipendenza degli eventi.

Ciò non esaurisce il concetto di indipendenza.

Ripensando agli esempi fatti, in alcuni casi c’era una analogia “fisica”, eppure a volte

si aveva dipendenza, a volte si aveva indipendenza, a ribadire il fatto che il concetto

di indipendenza stocastica è più ampio.

Calcolate le probabilità, in base alla definizione si conclude che i due eventi sono

indipendenti o dipendenti.

Ribadiamo che la definizione di indipendenza è data mediante una relazione sulle

probabilità e dipende dalla probabilità degli eventi; invece la incompatibilità è una

proprietà intrinseca degli eventi.

Inoltre se P(A)>0 e se P(B)>0, A e B non possono essere contemporaneamente

incompatibili e indipendenti.

Se sono incompatibili allora per definizione P(AB)=0.

Se sono indipendenti allora P(AB)=P(A)P(B)>0.

Quando scriviamo E/H, indichiamo che l’evento E è condizionato all’evento H e

l’ipotesi H equivale a dire che esaminiamo la questione solo se l’evento H non è

falso (se si acquisisce l’informazione che H è falso non interessa più sapere se E è

vero o falso).

Sotto questa ipotesi possono poi aversi due sottocasi:

22

H vero, E vero;

H vero, E falso.

(Ovviamente H non equivale a P(H) 0).

Nel valutare la probabilità di un evento si deve tenere conto di ogni altro evento che

interviene a modificare lo stato di informazione e che influenza la valutazione della

probabilità.

Esempio

Si hanno 10 monete, 9 normali ed 1 truccata (con 2 T).

Se ne estrae una a caso e, senza guardarla, si lancia sei volte, ottenendo sei volte T

(sia E questo evento): ci proponiamo di calcolare la probabilità che la moneta estratta

sia quella truccata. Chiamando H l’evento “la moneta estratta è quella truccata”, si

ha, prima della prova, P(H)=1/10; d’altra parte, essendo HE, si ha P(EH)=P(H) e

allora P(H/E)=P(HE)/P(E)=P(H)/P(E)=(1/10)/[1/10+(9/10)*(1/64)]=64/73.

Concludendo la valutazione iniziale P(H)=1/10 si è trasformata nella valutazione

finale P(H/E)=64/73. E’ aumentata infatti 64/73 > 1/10.

Esempio

Si vuole sapere se c’è dipendenza tra il daltonismo e la sordità in un certo gruppo di

maschi, conoscendo le probabilità come indicato nella seguente tabella:

DALTONICO

NON DALTONICO

TOTALE

SORDO

0.0004

0.0046

0.0050

NON SORDO TOTALE

0.0796

0.0800

0.9154

0.9200

0.9950

1.0000

Dai dati ricaviamo che: P(S)=0.0050, P(D)=0.0800,

P(S/D)= P(SD)/P(D)=0.0004/0.0800=0.0050=P(S)

P(D/S)= P(DS)/P(S)=0.0004/0.0050=0.800=P(D)

Si conclude che la sordità è indipendente dal daltonismo.

Esempio

Sono date due urne:

la prima urna contiene una pallina bianca, una rossa, una nera e da essa si estrae

una pallina;

la seconda urna contiene una pallina bianca, una rossa, una nera, una gialla e da

essa si estrae una pallina.

Chiamiamo B1,R1,N1 gli eventi relativi alla prima urna.

Chiamiamo B2, R2, N2,G2 gli eventi relativi alla seconda urna.

23

Chiamiamo E1=B1R1, E2=B2R2, H1=B1N1, H2=B2N2, A2= B2G2.

Calcoliamo le varie probabilità.

P(B1)=P(R1)=P(N1)=1/3

P(B2)=P(R2)=P(N2)=P(G2)=1/4

P(E1)=P(H1)=2/3

P(E2)=P(H2)=P(A2)=1/2

P(E1H1)=1/3 P(E1)P(H1)=2/3*2/3=4/9

P(E2H2)=1/4 = P(E2)P(H2)=1/2*1/2=1/4

P(E2A2)=1/4 = P(E2)P(A2)=1/2*1/2=1/4

P(A2H2)=1/4 = P(A2)P(H2)=1/2*1/2=1/4

P(E2H2A2)=1/4 P(E2)P(H2)P(A2)=1/2*1/2*1/2=1/8

Dai calcoli fatti si trova che, mentre E1, H1 non sono indipendenti, E2, H2 sono

indipendenti: dal punto di vista fisico sono situazioni simili ma dal punto di vista

stocastico può non avere alcuna importanza.

Si traggono conclusioni diverse a sostegno del fatto che il concetto di indipendenza

stocastica è appunto più ampio di quello di eventi relativi a prove indipendenti.

Sempre dai calcoli fatti si trova che i tre eventi E2, H2, A2 non sono indipendenti

mentre lo sono due a due.

Esempio

Si lancia tre volte una moneta.

I risultati possibili sono otto: =TTT;TTC;TCT;CTT;CCT;CTC;TCC;CCC.

Sia E1 l’evento “almeno due T”.

Sia E2 l’evento “un numero pari di T”.

Sia E3 l’evento “C al primo posto”.

Allora:

E1=TTT;TTC;TCT;CTT

E2=TTC;TCT;CTT;CCC

E3=CTT;CCT;CTC;CCC

E1E2=TTC;TCT;CTT

E2E3=CTT

E1E3=CTT

E1E2E3=CTT

Calcoliamo le probabilità:

P(E1)=4/8=1/2

P(E2)=4/8=1/2

P(E3)=4/8=1/2

24

P(E1E2)=3/8

P(E2E3)=1/8

P(E1E3)=1/8

P(E1E2E3)=1/8

P(E1E2)=3/8P(E1)P(E2)=4/8*4/8=1/4

P(E2E3)=1/8P(E2)P(E3)=4/8*4/8=1/4

P(E1E3)=1/8P(E1)P(E3)=4/8*4/8=1/4

P(E1E2E3)=1/8=P(E1)P(E2)P(E3)=4/8*4/8*4/8=1/8.

Dall’esempio si vede che gli eventi presi a tre sono indipendenti mentre non lo sono

due a due.

L’indipendenza di tre eventi si definisce:

P(E1E2E3)=P(E1)P(E2)P(E3)

e

P(E1E2)=P(E1)P(E2)

P(E1E3)=P(E1)P(E3)

P(E2E3)=P(E2)P(E3)

5.4. Il teorema di Bayes

I processi logici, che rendono esplicita una conoscenza già contenuta implicitamente

nelle premesse, accrescono la nostra conoscenza. Pensiamo ad esempio alle regole

del modus ponens o del modus tollens: con la prima facciamo delle deduzioni (la

direzione lungo cui la verità si trasmette è dall’universale al particolare), con la

seconda delle falsificazioni (se una teoria A prevede una conseguenza B, se si

verifica non B, A deve essere rigettata.).

Come ampliare il quadro della logica e trovare degli strumenti che consentano di

imparare dall’esperienza?

Si può invertire quella direzione e andare dal particolare all’universale, si può fare

cioè dell’induzione?

Si può trovare un legame fra probabilità e conoscenza?

Ampliamo il quadro della logica che assegna agli enunciati i valori di verità zero

oppure uno, assegnando loro un valore di probabilità compreso fra zero e uno: la

nozione di probabilità fa riferimento alla nostra conoscenza, riguarda anche i giudizi

che noi possiamo formulare.

25

Scrivere AB equivale a dire che l’evento A implica l’evento B, ogni volta che si

verifica A si verifica anche B.

Dalla teoria degli insiemi si ha che: AB B A.

La corrispondente legge logica è che se A implica B, B implicaA: sapendo che

ogni volta che si verifica A si verifica necessariamente anche B, possiamo dire che se

non si verifica B non si può verificare A.

Generalizziamo poi il quadro della logica per quanto riguarda l’implicazione: vi sono

molte situazioni in cui, dati due eventi, non si può affermare che “uno implica

l’altro”, ma si può solo attribuire una certa probabilità all’uno, una volta che sia noto

che l’altro si è verificato (concetto di probabilità condizionata).

Ricordiamo che se supponiamo che P(A) e P(B) siano entrambi valori non nulli,

possiamo considerare sia P(B/A) che P(A/B) e che fra i quattro valori sussiste il

seguente legame: P(A)P(B/A) = P(B)P(A/B) = P(AB) = P(BA).

Nella interpretazione che ci interessa, B potrà essere un’ipotesi ed A un evento che si

è verificato (ad esempio: l’esito di un esperimento); P(B) ha il significato di

probabilità attribuita a B “a priori” (cioè prima dell’esperimento e, comunque , a

prescindere dal suo esito) e indipendentemente dal presentarsi o meno dell’evento A,

mentre P(B/A) ha il significato di probabilità “a posteriori”, o finale, cioè sapendo

che l’evento A si è verificato.

Se supponiamo di conoscere P(A/B) (valore che misura il grado di dipendenza

dell’evento A dall’evento B) e P(A), si può esprimere la probabilità “a posteriori” di

B nel seguente modo: P(B/A)=[P(B)P(A/B)]/P(A).

Il verificarsi dell’evento A modifica la probabilità di B facendola passare da P(B) a

P(B/A) e tale modifica è dovuta alla probabilità probativa o verosimiglianza P(A/B).

Per concludere, escludendo il caso di eventi con probabilità nulla, dall’espressione

P(A)P(B/A)=P(B)P(A/B)=P(AB)=P(BA) si ottiene la relazione, particolarmente

significativa:

P( B / A)

P( B)P( A / B)

P( A)

Consideriamo ora il caso particolare in cui si hanno:

un evento A, con P(A)0;

le due sole alternative B,B;

A B B.

Si ottiene che:

26

A=A(B B)=(A B)(A B);

P(A)=P(A B) + P(A B)=P(B)P(A/B) + P(B )P(A /B);

P( B / A)

P( B) P( A / B)

P( B) P( A / B) P( B) P( A / B)

Esempio

Diagnosticare la presenza o meno di una certa malattia, sulla base della presenza o

meno di un determinato sintomo.

Schematizziamo opportunamente il problema; indichiamo con A l’evento “il paziente

presenta il sintomo”, indichiamo con B l’evento “il paziente è affetto dalla malattia”.

A seguito di opportune indagini epidemiologiche, si conoscono:

la percentuale degli individui della popolazione che presentano il sintomo, indicata

con P(A) la percentuale degli individui ammalati che presentano il sintomo, indicata

con P(A/B).

Possiamo allora calcolare P(B/A) cioè la probabilità che quel tale sintomo sia un

indicatore atto a segnalare la presenza della malattia.

In concreto i dati siano i seguenti:

P(A)=5%, P(B)=15%, P(A/B)=30%.

Diamo la seguente rappresentazione, sicuramente efficace ai fini della comprensione

concettuale:

B (15)

A (5)

B (85)

(10.5)

(4.5)

(0.5)

(84.5)

(100)

27

Si ricava allora:

P(B/A) = (15%*30%)/(5%) = 90%.

La presenza del sintomo segnala la presenza della malattia nel 90% dei casi.

Altro esempio

Da un rilevamento statistico è noto che una certa popolazione è composta per il 40%

di fumatori abituali, che il 5% dei decessi avviene a causa di un certo tumore T e

che, tra quanti sono deceduti a causa del tumore T, il 60% erano fumatori abituali.

Calcolare la probabilità, per i fumatori abituali, di morire per il tumore T.

Indichiamo con B “fumatore abituale” e con A “decesso per tumore T”.

Ci aiutiamo con gli insiemi:

B (40)

B (60)

A (5)

(37)

(3)

(2)

(58)

(100)

Abbiamo che:

P(A)=5%, P(B)=40%, P(B/A)=60%.

28

Allora:

P(A/B)=[P(A)P(B/A)]/P(B)=(5%*60%)/(40%)=7.5%

Questo esempio, così formulato, viene riportato appositamente in questa fase

iniziale, in cui può essere facile per gli studenti cadere nei formalismi anziché

preoccuparsi di far prevalere i ragionamenti.

Cerchiamo di andare oltre le due sole ipotesi B, B.

Consideriamo tre ipotesi A1, A2, A3 incompatibili e necessarie.

Sia P(A) 0 e A A1A2A3.

Si può scrivere: A(A1A2A3) = (AA1) (AA2) (AA3).

Si ottiene:

P(A) = P(AA1)+P(AA2)+P(AA3);

P(A) = P(A/A1)P(A1)+P(A/A2)P(A2)+P(A/A3)P(A3).

Facciamo il seguente esempio.

Un medico visita un ammalato, che può essere affetto da una delle tre malattie A1,

A2, A3. Tenendo conto dei primi sintomi, delle statistiche di cui dispone, di tutte le

informazioni in suo possesso, assegna le seguenti probabilità a ciascuna delle tre

malattie: P(A1)=0.2, P(A2)=0.3, P(A3)=0.5.

A questo punto il medico prescrive un esame clinico, che, secondo le statistiche, ha il

seguente comportamento:

risulta positivo nel 15 % dei casi se l’ammalato ha la A1;

risulta positivo nel 25% dei casi se l’ammalato ha la A2,

risulta positivo nel 98 % dei casi se l’ammalato ha la A3.

Se l’esito del test è positivo (chiamato evento A) che cosa si può concludere?

A2 (30)

A1 (20)

A (59.5)

(22.5)

(17)

(3)

(7.5)

(49)

A3 (50)

(1)

(100)

29

Dal punto di vista didattico crediamo che quando la situazione si presenta più

complessa, oltre alla rappresentazione con gli insiemi, sia di grande efficacia per la

buona comprensione concettuale usare anche il mezzo del disegno ad albero o della

tabella, opportunamente strutturati.

A1

A2

20%

15%

85%

3%

Malattia

A1

A2

A3

+

30%

25%

7.5%

P(Ai) P(A/Ai)

0.2

0.3

0.5

0.15

0.25

0.98

A3

50%

75%

+

98%

2%

49% = 59.5%

P(Ai)P(A/Ai)

P(Ai/A)

0.030

0.075

0.490

0.030/0.595=0.050

0.075/0.595=0.126

0.490/0.595=0.824

30

Totali

1

0.595

1

Si può concludere che il test ha nettamente rafforzato la probabilità che il malato sia

affetto dalla malattia A3.

Cerchiamo ora la sistemazione teorica di quanto visto negli esempi.

Il teorema di BAYES

Sono dati:

un insieme finito o numerabile di eventi incompatibili

un evento E tale che:

P(E) 0

Ar

E Ar

r

allora

P ( Ar / E )

P ( Ar ) P ( E / Ar )

P( A ) P( E / A )

Dimostrazione:

Per la definizione di probabilità condizionata e per la legge delle probabilità

composte possiamo scrivere:

P( Ar / E )

dall’ipotesi

P( Ar E ) P( Ar ) P( E / Ar )

P( E )

P( E )

E Ar

segue che:

E E ( A ) ( E A )

r

ma per l’ipotesi di incompatibilità fatta sugli

Ar

anche gli eventi

E A

sono

incompatibili per cui si ha che:

P( E ) P( E A ) P( A ) P( E / A )

31

c.v.d.

Nell’ipotesi che gli eventi

Ar siano anche necessari, cioè che Ar

r

la condizione

E Ar

è soddisfatta per ogni E.

r

L’importanza del teorema di Bayes sta anche nelle applicazioni, come si può

desumere da esercizi di vario genere riportati nei testi, ma un suo significato

profondo riguarda i fondamenti del calcolo delle probabilità e della induzione

statistica.

Gli eventi

Ar

possono essere considerati come possibili cause dell’evento E, o

ipotesi che lo spiegano.

La condizione: E A significa che se si verifica E, si verifica necessariamente

r

r

uno degli eventi

Ar

e uno solo perché sono incompatibili. Ciò significa che

l’insieme delle cause è esaustivo: se si verifica E, una e una sola delle cause deve

aver agito.

Osservato l’evento E ci chiediamo quale delle cause abbia agito: si trova la risposta

applicando il teorema di Bayes. Ovviamente la risposta è di tipo probabilistico.

P( Ar )

è chiamata probabilità iniziale o a priori perché è la semplice probabilità

che si verifiche l’evento

P( Ar / E )

Ar

indipendentemente da ciò che accade per l’evento E.

è chiamata probabilità finale o a posteriori ed è la probabilità di

Ar

condizionata perché è valutata sapendo che E si è verificato.

Il teorema di Bayes ci dice come il verificarsi dell’evento E modifica la probabilità

dell’evento

Ar

per cui da

P( Ar / E ) ; dall’espressione del

che tale cambiamento dipende dalla P ( E / Ar ) che

P( Ar )

teorema si vede chiaramente

si ottiene poi

è chiamata probabilità probativa o verosimiglianza.

32

Le informazioni fornite dai dati osservati sono sintetizzate nelle verosimiglianze.

Ar , As

P( E / Ar ) / P( E / As )

Se si lavora rispetto a due cause

verosimiglianza:

si può introdurre il rapporto di

P( Ar / E ) P( Ar ) P( E / Ar )

P( As / E ) P( As ) P( E / As )

Facciamo ora alcuni esempi che ci sembrano significativi.

Esempio (1)

Si hanno tre scatole (che indichiamo con A1, A2, A3): nella prima ci sono due

monete da 50 lire, nella seconda una da 50 lire e una da 100 lire e nella terza due da

100 lire. Si sceglie a caso una delle tre scatole e si estrae da questa una moneta (con

probabilità uguale per le due monete: si fa l’ipotesi che le due monete siano

“fisicamente” uguali, di diverso hanno eventualmente solo la scritta). La moneta

estratta è da 50 lire. A questo punto si estrae un’altra moneta.

Qual’ è la probabilità che anche la seconda moneta sia da 50 lire?

In altre parole qual’ è la probabilità che si tratti della prima scatola?

Indichiamo con E l’evento “estrazione di una moneta da 50 lire”.

Ci aiutiamo con una tabelle opportunamente strutturata:

Scatola

Prima

A1

Seconda A2

Terza

A3

Totali

P(Ai)

P(E/Ai)

P(Ai)P(E/Ai)

1/3

1/3

1/3

1

1/2

0

1/3

1/6

0

1

P(Ai/E)

1/3:1/2=2/3

1/6:1/2=1/3

0

1/2

1

Sapendo che la moneta estratta è da 50 lire, la probabilità che avessimo scelto la

terza scatola è nulla.

Il rapporto di verosimiglianza relativo alle prime due scatole è P(E/A1) / P(E/A2)=2.

Due è il fattore che, come dice la relazione:

33

P( Ar / E ) P( Ar ) P( E / Ar )

P( As / E ) P( As ) P( E / As )

fa passare dal rapporto tra le probabilità a priori, a quello tra le probabilità a

posteriori.

In questo caso le probabilità a priori sono uguali, per cui il rapporto tra le probabilità

a posteriori è uguale al rapporto di verosimiglianza; in altre condizioni non si avrà

questa uguaglianza.

A questo proposito facciamo un esempio opportuno.

Esempio (2)

Vedi esempio (1) con la seguente situazione: una scatola del primo tipo, 8 scatole del

secondo tipo, una scatola del terzo tipo.

Indichiamo con A1, A2, A3 i tre gruppi di scatole.

Ci aiutiamo di nuovo con una tabella opportunamente strutturata:

Gruppi di scatole

P(Ai)

P(E/Ai)

P(Ai)P(E/Ai)

Primo

Secondo

Terzo

1/10

8/10

1/10

1

1/2

0

1/10

8/20

0

A1

A2

A3

Totali

1

P(Ai/E)

1/10:1/2=1/5

8/20:1/2=4/5

0

1/2

1

Sapendo che la moneta estratta è da 50 lire, la probabilità che avessimo scelto la

terza scatola è nulla.

Il rapporto di verosimiglianza relativo ai primi due gruppi di scatole è:

P(E/A1)/P(E/A2)=2; inoltre P(A1/E)/P(A2/E)=1/4 e P(A1)/P(A2)=1/8 per cui è

soddisfatta la relazione

P( Ar / E ) P( Ar ) P( E / Ar )

P( As / E ) P( As ) P( E / As )

Esempio (3) (Esempio di riapplicazione del Teorema di Bayes)

Vedi esempio (1) con la seguente situazione: si rimette nella scatola la moneta

estratta e se ne estrae a caso un’altra che risulta ancora da 50 lire. Qual’ è ora la

probabilità che si tratti della prima scatola?

34

Dopo aver rimesso la moneta nella scatola, non mescoliamo le scatole; se facessimo

così rinunceremmo alla informazione acquisita con l’evento E.

Indichiamo con E1 l’evento “la seconda estrazione di una moneta da 50 lire”.

Facciamo riferimento ai risultati dell’esempio (1) e ci aiutiamo sempre con una

tabella opportunamente strutturata:

Scatola

Prima

A1

Seconda A2

Terza

A3

P(Ai/E)

P(E1/Ai)

P(Ai/E)P(E1/Ai)

2/3

1/3

0

1

1/2

0

2/3

1/6

0

Totali

1

P(Ai/E1)

2/3:5/6=4/5

1/6:5/6=1/5

0

5/6

1

Esempio (4)

Vedi esempio (3) con la seguente situazione: scelta a caso una delle tre scatole si

estraggono successivamente con reimbussolamento due monete ed esse risultano

entrambe da 50 lire. Quale è la probabilità che si tratti della prima scatola?

Ci aiutiamo con una tabella opportunamente strutturata:

Scatola

P(Ai)

P((EE1)/Ai)

P(Ai)P((EE1)/Ai)

P(Ai/(EE1))

A1

A2

A3

1/3

1/3

1/3

1

¼

0

1/3

1/12

0

1/3:5/12=4/5

1/12:5/12=1/5

0

Totali

1

5/12

1

Si ottiene lo stesso risultato dell’esempio precedente ma ora si lavora in un tempo

mentre prima si lavorava in due tempi. E’ interessante confrontare le due tabelle.

Riteniamo che l’uso di tabelle, alberi, insiemi vada sollecitato il più possibile per

scongiurare il pericolo, con questo argomento, di cadere nell’abitudine ai formalismi

perdendo così di vista i concetti sottesi.

In questo caso ad esempio può aiutare il grafo ad albero:

35

Esempio (5)

Vedi esempio (4) con la seguente situazione: senza reimbussolamento.

Ci aiutiamo con una tabella opportunamente strutturata:

Scatola

P(Ai)

P((EE1)/Ai)

P(Ai)P((EE1)/Ai)

P(Ai/(EE1))

A1

A2

A3

1/3

1/3

1/3

1

0

0

1/3

0

0

1/3:1/3=1

0

0

Totali

1

1/3

1

36

Facciamo un ulteriore esempio che ci sembra significativo: uno studente ad una

domanda di un test con quattro risposte alternative risponde esattamente.

L’esaminatore si chiede quale è la probabilità che egli conosca veramente la risposta.

Indichiamo con H l’evento “lo studente sa la risposta” e supponiamo che P(H)=p.

Sia E l’evento “lo studente indica la risposta esatta”.

Ovviamente P(E/H)=1.

Se non conosce la risposta supponiamo che risponda a caso: P( E/H)=1/4.

Allora P(H/E)=[P(H)P(E/H)]/P(E)=(1*p)/[1*p+(1/4)(1-p)]=4p/(3p+1).

Com’è p rispetto a 4p/(3p+1)? È minore. L’aver risposto giusto fa aumentare la

probabilità che conosca la risposta.

Facciamo il grafo ad albero opportunamente strutturato:

37

Quando si studia un fenomeno o si realizza un esperimento si hanno dei dati che

possono confermare o meno un’ipotesi iniziale. Questi dati costituiscono l’evento E

e la verosimiglianza P(E/H) è la misura di quanto l’evento E conferma l’ipotesi.

La verosimiglianza e ogni altra indicazione che possiamo trarre dalle osservazioni,

non ci danno informazioni sulla validità assoluta dell’ipotesi; si trova la probabilità

dell’ipotesi condizionata da E, P(H/E), sfruttando i dati sperimentali osservati; oltre

alla verosimiglianza P(E/H) bisogna conoscere la probabilità a priori P(H).

Un esempio adatto a certi avvenimenti.

Un medico può trovare in un paziente un insieme di sintomi (E) che accompagna

sempre il colera (A1) ma anche, meno frequentemente, una forma benigna di tifo

(A2). In altri termini: P(E/A1)=1, p=P(E/A2)<1.

La verosimiglianza, quindi, è favorevole al colera, ma non per questo la diagnosi si

fermerà automaticamente su questa malattia.

In condizioni normali il medico propenderà per il tifo, che in Italia è più frequente

del colera; se nella zona però è in atto un’epidemia dell’altra malattia, la diagnosi si

orienterà verso il colera.

Nella formulazione probabilistica, la probabilità a priori P(A1) del colera sarà, in

condizioni normali, molto minore di P(A2), e quindi il rapporto tra le probabilità a

posteriori:

P( A2 / E ) P( A2 ) P( E / A2 ) P( A2 )

p

P( A1 / E ) P( A1 ) P( E / A1 ) P( A1 )

sarà maggiore di uno, pur essendo il rapporto di verosimiglianza p minore di uno.

In presenza di un’epidemia di colera, P(A1) è più grande e quindi il rapporto al

primo membro può risultare minore di 1.

Per quanto riguarda ulteriori considerazioni legate alle varie impostazioni, si

rimanda alla bibliografia [12].

La formula che esprime il teorema di Bayes si presta bene a rappresentare il modo

con cui la conoscenza si accresce mediante l’esperienza. All’inizio di un’esperienza

si hanno delle valutazioni, delle opinioni (le probabilità a priori); un insieme di

ipotesi, con le relative probabilità a priori si aggiornano con i risultati sperimentali

mediante il Teorema di Bayes si può verificare un’ipotesi iniziale alla luce delle

nuove informazioni possedute; a questo proposito vedi bibliografia [23].

Si può notare che P(Ai/E)=1 perché ovviamente la somma “ a posteriori” delle

probabilità deve essere ancora 1.

38

Si può anche notare che le probabilità “ a posteriori “ sono proporzionali ai prodotti

P(Ai)P(E/Ai).

Nella formula compaiono le probabilità a priori. Di fatto all’inizio di ogni

esperienza, la nostra mente non è mai “tabula rasa”: c’è sempre una valutazione,

un’opinione.

Inoltre, la formula di Bayes fornisce un interessante modello di come la conoscenza

possa accrescersi per successivi apporti.

Le Ai sono un insieme di ipotesi con le relative probabilità a priori; queste

probabilità possono essere aggiornate tenendo conto dei risultati sperimentali B, C e

così via cioè dell’evento globale BC. E’ indifferente lavorare prima con B poi con

C o viceversa, per il discorso fatto sulla proporzionalità.

A tal proposito vedi bibliografia [23].

Osservazioni conclusive:

- crediamo sia importante, in ogni situazione, esplorare i significati che gli alunni

attribuiscono ai termini e mettere in luce le differenze tra linguaggio comune e

linguaggi specialistici in particolare per prevenire/superare confusioni

concettuali;

- abbiamo affrontato parecchie applicazioni per avere un ampio ventaglio di casi

che permettano di mettere a fuoco natura e limiti dei modelli matematici;

- in ogni caso, ci adoperiamo per evitare il più possibile l’uso della ricetta (in

questo caso può essere particolarmente facile cadere nel solo uso inconsapevole

di formule), facendo un’analisi senza pregiudizi, che eviti di applicare uno

schema risolutivo magari non adatto e non faccia cogliere la possibilità di

affrontare la situazione con strumenti magari anche più elementari fino a trovare

un procedimento risolutivo con consapevolezza concettuale;

- i temi della statistica e della probabilità, che offrono una grande varietà di

attività di modellizzazione significative e spesso realizzabili con tecniche

matematiche elementari, possono avere un ruolo importante nella educazione

matematica, nella esplorazione delle abilità di matematizzazione degli alunni,

nel recupero di motivazioni alla matematica stessa;

- non abbiamo presentato il lavoro sotto forma di unità didattica “pulita”,

appositamente per comunicare ai colleghi tante considerazioni secondo noi

importanti e che non è detto che potessero essere desunte “tra le righe”.

39

Dedichiamo questo lavoro ai nostri alunni la cui collaborazione è stata determinante

per giungere a queste scelte di percorso.

I colleghi presenti al seminario ricorderanno la presentazione che la classe 4^S di

quell’anno scolastico fece di tutto il lavoro fatto rispecchiando appunto quanto più

volte abbiamo ribadito e in particolare a proposito delle considerazioni storiche; una

dedica particolare va a ROBERTO che ci ha lasciato.

BIBLIOGRAFIA

1.

2.

3.

4.

5.

6.

7.

8.

9.

10.

11.

12.

13.

14.

15.

16.

17.

18.

19.

20.

21.

G.T.Bagni CORSO DI MATEMATICA vol 1-2-3 ed. Zanichelli

P.Baldi CALCOLO DELLE PROBABILITA’ E STATISTICA ed. McGrawHill

E.Ballatori M.A.Pannone DIDATTICA DELLA STATISTICA E DELLA

PROBABILITA’ ed. Mondadori

P.Baraggia, N.Nava PROBABILITA’ E STATISTICA ed. Hoepli

E.Batschelet INTRODUZIONE ALLA MATEMATICA PER BIOLOGI ed.

Piccin

K.Baclawski, M.Cerasoli, G.Rota INTRODUZIONE ALLA PROBABILITA’

U.M.I.

A.Boggio, G.Borello STATISTICA ed. Petrini

M.Cerasoli PROBLEMI RISOLTI DI CALCOLO DELLE PROBABILITA’ ed.

Ambrosiana

A.M.Cerasoli CALCOLO DELLE PROBABILITA’ ed Zanichelli

G.Chichitelli PROBABILITA’ E STATISTICA ed Maggioli

D.Costantini INTRODUZIONE ALLA PROBABILITA’ ed. Boringhieri

G. Dall’Aglio CALCOLO DELLE PROBABILITA’ ed. Zanichelli

Di Bacco, Lombardo FATTI E CONGETTURE vol 1-2 ed. La Nuova Italia

P.Dupont PRIMO INCONTRO CON LA PROBABILITA’ ed. Sei

A.Frigessi CALCOLO DELLE PROBABILITA’ ed.Etas

Gambotto Manzone PROBABILITA’ E STATISTICA ed. Tramontana

G.Girone, M.Stoka CALCOLO DELLE PROBABILITA’ STATISTICA ed.

Cedam

F. R.Malara LA MACCHINA DELLA PROBABILITA’ ed La Scuola

W.Maraschini, M.Palma PROBABILITA’ E STATISTICA ed.Paravia

P.Negrini, M.Ragagni PROBABILITA’ ed Faenza

Kemeny, Snell, Thompson MATEMATICA E ATTIVITA’ UMANE ed.

Feltrinelli

40

22. F.Pesarin INTRODUZIONE AL CALCOLO DELLE PROBABILITA’ ed. La

Nuova Italia Scientifica

23. G. Prodi METODI MATEMATICI E STATISTICI ed. McGraw-Hill

24. G. Prodi MATEMATICA COME SCOPERTA vol. 1-2 ed. D’Anna

25. G.Prodi, E.Magenes ELEMENTI DI ANALISI MATEMATICA ed. D’Anna

26. Quaderno n. 8 M.P.I. L’INSEGNAMENTO DI PROBABILITA’ E

STATISTICA NELLA SCUOLA LICEALE Liceo Scientifico st.

“G.R.Curbastro Lugo di Romagna

27. R. Quatrale CORSO DI PROBABILITA’ E STATISTICA vol. 1-2 ed.Cedam

28. P.Rocchi LA PROBABILITA’ E’ OGGETTIVA O SOGGETTIVA? Ed.

Pitagora

29. R. Scozzafava LA PROBABILITA’ SOGGETTIVA E LE SUE

APPLICAZIONI ed. Veschi

30. M.Trovato,F.Rossetti PROBABILITA’ ed. Ghisetti e Corvi

31. G.Vicario, R.Levi CALCOLO DELLE PROBABILITÀ ed Progetto Leonardo

Bo

32. V.Villani MATEMATICA PER DISCIPLINE BIO-MEDICHE ed. McGrawHill

Vari articoli sulla probabilità sono stati letti sulle seguenti riviste:

R1) ARCHIMEDE Le Monnier

R2) DIDATTICA DELLE SCIENZE La Scuola

R3) INDUZIONI Istituti Editoriali e Poligrafici Internazionali Pisa

R4) L’EDUCAZIONE MATEMATICA C.R.S.E.M. Cagliari

R5) LA MATEMATICA E LA SUA DIDATTICA Armando

R6) LE SCIENZE E IL LORO INSEGNAMENTO Le Monnier

R7) LETTERA MATEMATICA PRISTEM Bocconi

R8) L’INSEGNAMENTO DELLA MATEMATICA E DELLE SCIENZE

INTEGRATE Centro Ricerche Didattiche U.Morin

R9) NOTIZIARIO U.M.I. Supplemento al n. 7 Luglio 1994

R10) NUOVA SECONDARIA La Scuola

R11) PERIODICO DI MATEMATICHE Mathesis

N.B.: Teniamo a precisare che in questi vari anni di lavoro abbiamo consultato tanti

testi sia a livello universitario che di scuola secondaria superiore e abbiamo letto

tanti articoli di didattica; abbiamo inoltre utilizzato i materiali ricavati da vari corsi

di aggiornamento che abbiamo seguito, riguardanti la probabilità e la statistica.

Questo nuovo tema non apparteneva ai nostri studi universitari e poiché abbiamo

condiviso in pieno la necessità della sua introduzione nella scuola, abbiamo cercato

41

di impadronircene e piano piano lo abbiamo inserito nel nostro lavoro cercando

sempre di fonderlo in esso, di non lasciarlo mai a sé.

Nella fase della trasposizione didattica, non avendo una esperienza consolidata e per

le motivazioni sopra dette, ognuna di noi ha attinto dall’esistente quelle che

sembravano le idee che più si adattavano alla propria realtà; questo lavoro è il

risultato delle nostre esperienze in classe che ci hanno portato a questo percorso che

abbiamo descritto; di conseguenza non abbiamo alcuna pretesa di originalità e

sicuramente parecchi autori si riconosceranno negli esempi; ci scusiamo

dell’eventualità di aver tralasciato involontariamente fonti bibliografiche.

42