Technology Assessment

Che cos’è e a cosa serve

Il Technology Assessment ( di seguito: T.A.) si pone è mirato a fornire ad amministratori e decisori

della sanità le informazioni necessarie per fare scelte appropriate sul piano economico e gestionale.

Essenzialmente i processi di TA cercano di valutare in modo complessivo i costi e i benefici

conseguenti all’adozione e all’uso di una determinata tecnologia.

Che metodo utilizza

Elementi essenziali del processo di T.A. sono :

-identificazione del quesito da affrontare;

-trasformazione del quesito in domande in cui è possibile dare una risposta sulla base delle

informazioni scientifiche disponibili;

-descrizione e valutazione dello stato attuale dell’utilizzo della tecnologia oggetto d’indagine;

-revisione sistematica delle informazioni relative all’ efficacia, all’efficienza ed alla sicurezza della

tecnologia;

-valutazione implicazioni sanitarie, organizzative e sociali dell’uso della tecnologia;

-identificazione delle possibili decisioni da assumere in funzione delle valutazioni emerse dai punti

precedenti e presentazione delle raccomandazioni principali.

Quali contenuti

Caratteristiche principali del TA sono l’enfasi nell’utilizzo di metodi di valutazione scientifici e

trasparenti, nonché l’assunzione di una prospettiva di valutazione ampia, capace di affrontare non

solo le implicazioni cliniche ma anche quelle organizzative, gestionali, economiche e sociali

dell’uso di una tecnologia.

A cosa si applica

Esempi tipici di esercizi di T.A. che hanno prodotto serie di raccomandazioni per la pratica clinica

riguardano i rapporti – preparati da diverse agenzie internazionali, sullo screening mammografico,

sull’utilizzo di tecnologie chirurgiche, e sull’uso di tecnologie diagnostiche.

Comunque il termine più comunemente usato nell’ambito della sanità è Health Technology

Assessment.

Che cos’è l’ Health Technology Assessment (HTA)?

L’acronimo HTA indica tre termini inglesi:

-Health = salute

-Technology = procedura, tecnica, struttura;

-Assessment = valutazione.

Perché l’HTA?

Nell’assistenza sanitaria, siamo ancora molto lontani dall’aver dimostrato con certezza la necessità

e l’appropriatezza di molte prestazioni mediche. E’ noto, infatti, che a seconda della situazione la

medesima prestazione può essere necessaria e appropriata, ma anche inappropriata e perfino

1

dannosa. Attualmente, si stima che la percentuale degli interventi sanitari la cui efficacia è

scientificamente provata oscilli, a seconda delle discipline mediche, dal 30 all’80%.

Purtroppo, la crescita costante dell’offerta sanitaria ha prodotto non soltanto dei benefici, ma anche

alcuni effetti indesiderati; è ormai assodato che una maggiore disponibilità di prestazioni sanitarie

può anche determinare un eccesso di trattamenti, con tutti gli svantaggi che ne derivano,

inconvenienti che sovente sono maggiori dei benefici.

Stanziare maggiori risorse per la sanità, quindi, non vuol dire necessariamente ottenere più salute

nella popolazione. Ecco perché, di fronte all’incremento costante della spesa sanitaria, causata sia

dall’invecchiamento della popolazione, sia dal progresso incalzante di tecnologie sempre più

costose, diversi paesi stanno adottando l’HTA come strumento di valutazione delle prestazioni

mediche. La sanità è un’importante impresa economica, scientifica e sociale per tutti i paesi

dell’OCSE. Ha contribuito ad allungare la vita umana e a ridurre il dolore, il rischio di malattie e le

condizioni d’invalidità DATI…... Tuttavia, negli ultimi decenni, le attività associate alla salute

hanno assorbito crescenti porzioni del P.I.L.. Nel 1990 la spesa media per le cure sanitarie nei paesi

dell’OCSE ammontava al 7,3% del P.I.L.. Nel 2001 questa media era salita all’8,4%, segnando un

aumento che superava del 15% la crescita del P.I.L. Nel contesto della minor crescita economica,

dell’invecchiamento della popolazione e dell’aumento dei prezzi delle cure sanitarie e del loro uso,

molti governi dell’OCSE si preoccuparono della sostenibilità dei finanziamenti assegnati alla sanità

pubblica. L’HTA è dunque una metodologia per valutare le prestazioni sanitarie erogate o

comunque disponibili, e pianificare e gestire in modo più funzionale l’assistenza ai cittadini.

Nella fattispecie, il termine “tecnologie” si riferisce tanto agli interventi terapeutici e riabilitativi

quanto agli strumenti, alle apparecchiature, alle procedure mediche e chirurgiche, ai protocolli

d’intervento e d’assistenza, alle applicazioni informatiche (per esempio, la cartella clinica

elettronica), e non ultimo ai sistemi organizzativi e gestionali. L’HTA valuta quindi l’efficacia

sperimentale (in termini d’efficacia assoluta o efficacy), l’efficacia pratica (detta “efficacia relativa”

o effectiveness) e l’efficienza (efficiency) di ciascuna “tecnologia” che prende in esame.

Efficacia :

questo termine traduce la parola inglese “effectiveness”; nel contesto dei sistemi socio-sanitari con

“efficacia” si intende la capacità, da parte di un intervento o di una prestazione, di raggiungere gli

obiettivi per i quali è stato effettuato e il beneficio e/o l’utilità che un individuo o una popolazione

non selezionata riceve dall’offerta di un servizio, trattamento, programma di intervento di cui sia

stata preliminarmente valutata la “efficacia clinica” (in inglese “efficacy”) nella popolazione target

di uno studio clinico. L’efficacia clinica si valuta nel contesto di studi sperimentali (per esempio, i

randomised controlled trials), che mettano a confronto una procedura diagnostica o una terapia con

altra strategia o trattamento somministrati in un gruppo di controllo, nella situazione ideale in cui

tutti i soggetti seguono il trattamento cui sono stati assegnati con randomizzazione, esattamente

come prescritto dal protocollo sperimentale.

Efficienza :

traduzione della parola inglese “efficienty”, è il rapporto tra risorse impegnate ed ottenimento dei

risultati in tutte le caratteristiche essenziali della qualità: appropriatezza, accessibilità, gradimento,

ma soprattutto efficacia. E’ importante non confondere questo concetti di efficienza con quello

derivato da culture non sanitarie, inteso come massimo numero di prestazioni rispetto alle risorse

impiegate. La pratica clinica più “efficiente” è quella che migliora di più lo stato di salute della

popolazione oggetto della prestazione in rapporto ad un determinato budget. L’efficienza viene

solitamente analizzata verificando se i mezzi impiegati per raggiungere uno scopo avrebbero potuto

essere meglio impiegati investendoli in diversa maniera. Per esempio, i costi del rimborso pubblico

2

di una terapia di disassuefazione al fumo potrebbero essere messi a confronto con i risultati di una

campagna informativa anti-fumo o dell’attuazione di una legge più restrittiva nei confronti dei

fumatori.

Al livello minimo, l’H.T.A. mirata per certe tecnologie biomediche affronta la sicurezza e

l’efficacia di quelle tecnologie; in altre parole, che cosa comportano i rischi per i pazienti e se sono

giustificati rispetto ai possibili benefici alla salute; e se le tecnologie biomediche forniscono esiti

benefici alla salute e come quegli esiti per la salute si possono comparare a tecnologie alternative.

Molto spesso l’HTA comprende la valutazione economica, in genere come analisi costo-efficacia

(cost efficacy analisys: CEA). E’ importante osservare che la CEA si pone un quesito diverso

dall’analisi costo-beneficio ( cost-benefit- analisys: CBA). La CBA e la CEA pongono un quesito

simile a livello generale, cioè “le spese di un investimento sono giustificate dai suoi costi?”. A

differenza della CBA, la CEA valuta gli esiti in unità naturali del beneficio alla salute piuttosto che

in termini monetari. Idealmente queste misure sono un’unità pluridimensionale come gli anni di vita

migliorati per quanto riguarda la qualità oppure un’unità di anni di vita salvati; o, in via meno

ideale, unità quali il numero di eventi di morbilità evitati (esempio: il costo di un infarto miocardico

acuto evitato).

Il quesito specifico della CEA tende ad essere: “se una tecnologia è in grado di fornire benefici netti

a livello di salute della comunità, e se la tecnologia costa di più delle possibili alternative (e in

genere costano di più), qual’è il costo per unità di beneficio per la salute ed è un investimento utile

per la comunità?”.

Gli obiettivi

L’HTA si propone di valutare la reale efficacia degli interventi medici, l’appropriatezza, e

l’efficienza con cui sono adottati, i loro miglioramenti qualitativi, i benefici clinici e organizzativi,

il loro consenso sociale e così via, suggerendo di conseguenza come gestirli, promuoverli o

scoraggiarli. In questo caso, l’HTA incide direttamente sulle scelte che riguardano l’utilità clinica

ed economica delle tecnologie sanitarie: se infatti vogliamo evitare che l’incremento della spesa

sanitaria spinga a razionare le prestazioni, dobbiamo razionalizzare l’uso delle risorse disponibili,

trasferendole dalle prestazioni meno efficaci a quelle di cui sia stata provata l’utilità e la necessità.

L’HTA è la valutazione sistematica di procedure e tecnologie impiegate nell’assistenza sanitaria

alla popolazione, messa in atto raccogliendo e valutando le conoscenze e i dati della ricerca in

materia, riassumendoli in un apposito rapporto, traendo le relative conclusioni e fornendo tutti i

suggerimenti operativi necessari per il sistema sanitario. Le scelte compiute nella sanità e nella

politica sanitaria vanno adottare in base a dati scientifici e certi, e devono essere basate sulle prove

desunte dalla ricerca clinica sperimentale rigorosamente condotta (evidence-based). L’HTA, quindi,

aiuta a prevenire l’erogazione di prestazioni inefficaci, inappropriate o superflue nell’ambito del

sistema sanitario, contenendo così la spesa che comporterebbero e migliorando la qualità

complessiva dell’assistenza medica.

Il rapporto HTA

Il risultato d’ogni valutazione oggettiva è riassunto nel cosiddetto “rapporto HTA”, che si articola

nei seguenti capitoli:

-presentazione dei dati scientifici più aggiornati su una determinata metodologia diagnostica o

intervento terapeutica, redatta in modo trasparente, comprensibile ed obiettivo (evidence-based);

-discussione sulla sua rilevanza clinica;

-confronto con altri metodi;

-analisi delle ripercussioni sulla spesa sanitaria della procedura in questione.

Il rapporto tra l’HTA e l’Evidence-based Medicine (EBM)

3

L’EBM si propone di confrontare tra loro diversi risultati della ricerca clinica, puntando soprattutto

a verificare l’efficacia degli interventi sanitari; si tratta di una metodologia di analisi

particolarmente utile nell’assunzione delle decisioni cliniche quotidiane. L’HTA, invece, si spinge

oltre la mera valutazione dell’efficacia degli interventi terapeutici e fornisce indicazioni sulle

strategie di prevenzione (per esempio sull’utilità dello screening), sugli interventi a carattere

riabilitativo, sulle strategie di ottimizzazione medica ed economica, sulla gestione e

programmazione delle strutture sanitarie, sulle intricate questioni legate all’allocazione delle risorse.

Di conseguenza, l’HTA crea un collegamento diretto tra la ricerca e le scelte concrete di politica

sanitaria. Da quanto detto, emerge che l’HTA e l’EBM sono due discipline che si integrano a

vicenda. Il valore aggiunto che l’HTA può garantire alla politica sanitaria dipende anche dalla

continuità del suo impiego e dalla complessità dei fattori presi in considerazione.

Conclusioni

Le tecnologie biomediche possono conferire grandi benefici alla salute, ma possono rappresentare

metà dell’incremento dei costi della sanità. (DATI)

Coloro che occupano un ruolo decisionale nella sanità affrontano il compito difficile di utilizzare le

opportunità create dalle tecnologie biomediche, allo stesso tempo assicurandosi che il sistema

sanitario resti sostenibile ed equo. In aggiunta a questa sfida ci sono talvolta le pressioni conflittuali

e le esigenze dei pazienti (chi paga le tasse), del personale sanitario, dei produttori di nuove

tecnologie e di una gamma di altri gruppi di pressione.

Le prove obiettive sono di importanza fondamentale nel contribuire a risolvere esigenze conflittuali

per raggiungere un accordo trasparente sul percorso ottimale da seguire. Senza prove, la

comprensione e la diffusione delle tecnologie saranno più probabilmente influenzate da un’ampia

gamma di fattori sociali, finanziari, professionali e istituzionali, e potrebbero non produrre livelli

ottimali sugli esiti per la salute. L’HTA è una forma di accertamento che considera non solo

l’efficcia delle tecnologie ma anche il loro più ampio impatto, comprese le problematiche legali e

sociali oltre all’efficienza. Il ruolo dell’HTA è molto apprezzato da coloro che sono chiamati a

prendere decisioni e svolgere un ruolo sempre maggiore in molti paesi dell’OCSE.

Cenni di storia

La radiologia deve le sue origini a degli esperimenti effettuati a partire dal 1895 dal primo premio

Nobel per la fisica Wilhelm Conrad Roentgen (1845-1923). Egli, per primo si accorse di uno strano

fenomeno di luminescenza dato dal fluire di corrente elettrica all’interno di un tubo di vetro nel

quale era stato creato il vuoto. Egli chiamò questo fenomeno radiazione X o raggi-X. Roentgen

scoprì che gli oggetti metallici non lasciavano passare le radiazioni, le quali invece attraversavano

molto bene il legno, la carta ed altri materiali. Ma la cosa più sorprendente era che, se al posto del

legno veniva interposto un arto, questo appariva come trasparente, lasciando però vedere l’intera

sua struttura ossea. L’anno dopo, un altro fisico, Henri Becquerel (1.852-1.908), si interessò alle

potenzialità dei raggi-X. Egli diede inizio nel 1896 allo studio della fisica nucleare. In quell’anno

Henri Becquerel fece un’importante scoperta : nei suoi esperimenti sulla fosforescenza trovò che

certi minerali (che contenevano uranio) impressionavano le lastre fotografiche anche quando queste

erano protette in modo da escludere la presenza di luce. Era chiaro che il minerale emetteva qualche

nuovo tipo di radiazione che, a differenza dei raggi-X, si verificava senza alcuno stimolo esterno.

Questo fenomeno fu alla fine chiamato radioattività. Poco dopo la scoperta di Becquerel, Marie

Curie (1.867-1.934) e suo marito Pierre Curie (1.859-1.906) isolarono 2 elementi prima sconosciuti,

che risultavano altamente radioattivi. Li chiamarono Polonio e Radio. A questi ne seguirono presto

anche altri.Si trovò che in tutti i casi la radioattività non veniva influenzata da alcun trattamento di

tipo fisico o chimico per quanto violento, inclusi un forte riscaldamento o raffreddamento e l’azione

4

di potenti reagenti chimici. Era chiaro che l’origine della radioattività doveva trovarsi nella

profondità dell’atomo e quindi provenire dal nucleo. Ben presto emerse che la radioattività era il

risultato della disintegrazione o decadimento di un nucleo instabile. Alcuni isotopi non sono stabili

sotto l’azione della forza nucleare, e quindi decadono con emissione di alcuni tipi di radiazione o

raggi. Esistono molti isotopi instabili in natura e la radioattività che essi emanano è chiamata

radioattività naturale. In laboratorio si possono produrre altri isotopi instabili per mezzo di reazioni

nucleari (come oggi avviene in medicina nucleare ed in PET, con la formazione dei radioisotopi o

traccianti) : si dice quindi che sono prodotti artificialmente e si parla di radioattività artificiale.

Quando il mondo venne a conoscenza della scoperta di Roentgen, diversi altri studiosi resero

possibili le sue applicazioni pratiche. La possibilità di guardare all’interno del corpo umano, apriva

delle nuove ed incredibili possibilità per la medicina. L’utilizzo dei raggi-X si diffuse molto

velocemente in tutta l’Europa e negli Stati Uniti e la diagnostica per immagini cominciò a diventare

una branca della medicina a se stante. L’avvento della Diagnostica per Immagini diede la possibilità

di prevedere l’insorgere di diversi tipi di malattie. Permise, inoltre, ai medici, di avere maggiori e

più precise informazioni sulle quali basare le proprie osservazioni. I primi passi evolutivi furono

indirizzati soprattutto verso lo sviluppo di strumentazioni che permettessero un maggiore controllo

sul flusso dei raggi-X. Parallelamente, lo sviluppo di nuove tecniche per la stampa delle immagini

radiografiche (pellicole al posto di lastre), permise di ottenere immagini sempre più nitide e

significative. A partire dagli anni ’70 del XX secolo, la Diagnostica per Immagini ebbe a sua

disposizione i calcolatori elettronici. Si apriva l’era della Radiologia Digitale. I primi esperimenti in

tal senso si debbono all’ingegnere inglese Godfrey Hounsfield. Egli, nel 1972, inventò la

Tomografia Computerizzata. Il concetto alla base di questa invenzione è abbastanza semplice: una

volta fatte diverse radiografie alla stessa regione del corpo ma da angoli leggermente differenti, un

computer può prelevare le informazioni contenute nelle immagini e creare una vista virtuale

dell’area interessata. Un ulteriore sviluppo della radiologia si ebbe con la sostituzione delle pellicole

radiografiche da parte di lamine sensibili (fosfori di memoria), o, più recentemente, da sensori a

carica elettrica (CCD sensor). Questi supporti sono, in pratica, come dei fogli con tanti occhi sopra.

Ogni occhio si ricorda quanta luce ha visto e con quanta intensità l’ha percepita. Appositi lettori si

occupano di recuperare queste informazioni e ricostruire l’immagine radiologica. I vantaggi di

questo tipo di tecniche sono molteplici: la possibilità di elaborare elettronicamente le immagini per

esaltarne alcune caratteristiche salienti, la possibilità di conservare le immagini in supporti più

durevoli, etc.... Sicuramente uno dei maggiori vantaggi è dato dalla minore quantità di radiazioni

necessarie per effettuare l’esame. A più di un secolo dalla sua scoperta la radiologia è ancora

necessaria e fondamentale per la diagnosi medica. Esistono altre tecniche che sfruttano fonti di

energia differenti (gli ultrasuoni per l’ecografia; i campi magnetici e le radioonde per la risonanza

magnetica nucleare), ma i raggi-X sono, a tutt’oggi una risorsa necessaria e imprescindibile.

Tomografia Computerizzata (TC).

Introduzione

La tomografia computerizzata (TC) ha rappresentato una rivoluzione nel campo della diagnostica

per immagini sia per le sue caratteristiche tecniche, sia per le indicazioni di impiego che si sono

progressivamente ampliate e precisate. Negli anni 1972/73 Hounsfield e Ambrose riportarono le

loro esperienze preliminari con un prototipo di sistema TC, ma, come per tutte le scoperte

scientifiche, la tecnologia TC rappresentava in realtà la sintesi di numerosi acquisizioni scientifiche

ottenute nel tempo. Infatti già nel 1956 e 1961 Cormack e Holdendorf avevano realizzato sistemi

concettualmente paragonabili a quelli di Hounsfield, mentre nel 1917 Radon aveva per primo messo

a punto una tecnica di “ricostruzione da proiezioni”, che è uno dei fondamenti della tecnologia TC.

Ad Hounsfield ed a Cormack venne conferito nel 1979 il premio Nobel per la medicina per aver

scoperto – in modo indipendente – il procedimento tomografico computerizzato, che, superando i

5

limiti naturali delle metodiche radiologiche convenzionali, apriva la via a nuove esaltanti possibilità

diagnostiche. Nella radiologia tradizionale l’immagine radiografica dipende dall’assorbimento

totale del fascio di fotoni X da parte del corpo del paziente; l’informazione è “sintetica”,

rappresentando cioè la sovrapposizione della densità di ogni punto. Da ciò derivano tre

fondamentali limiti, che Hounsfield rivelò e si propose di superare: l’impossibilità di ottenere da

un’immagine radiografica bidimensionale tutta l’informazione contenuta in una regione di esame

tridimensionale, l’impossibilità di discriminare i tessuti molli se non facendo ricorso a M.d.C. e

l’impossibilità di attuare misure quantitative di assorbimenti regionali della radiazione X. La

tomografia convenzionale è una tecnica radiografica-volumetrica che produce l’immagine di uno

strato singolo e quindi i dati ottenuti possono essere considerati “analitici”, riguardanti cioè la sola

struttura inclusa nello strato selezionato. Tale tecnica rappresenta comunque una serie di limitazioni

che condizionano la qualità dell’immagine, quali, ad esempio, la ridotta definizione a causa della

distanza dal piano focale e il basso contrasto per l’effetto di sfocamento degli strati sopra e

sottostanti a quello selezionato.

Natura e ruolo della tomografia computerizzata

La TC è un procedimento radiografico digitalizzato che permette di rappresentare sezioni assiali o

parassiali di spessore finito del corpo umano tramite immagini esenti da sovrapposizioni e da

cancellazioni, caratterizzate da un’elevatissima risoluzione contrastografica. I valori di densità dei

singoli elementi di volume in cui viene suddiviso lo strato in esame si traducono in corrispondenti

tonalità di grigio sull’immagine. Si effettua in pratica la misura di una mappa di valori di

assorbimento e la sua trasformazione in una mappa di grigi. Nella ricostruzione dello strato, la sua

superficie viene suddivisa in una matrice di elementi di dimensioni uniformi – PIXELS -. Elementi

di volume di dimensioni uniformi – VOXELS – risultano quindi definiti stabilendo lo spessore

dello strato. La TC è stata la prima metodica di “imaging” diagnostico, ad avvalersi del computer ed

ha aperto la via dell’”imaging” digitale. Il sistema di misura costituito da una sorgente radiogena e

da un detettore, allineati e contrapposti, opera una scansione lineare sul piano tomografico lungo

tutta la sezione trasversale interessata. Segue una rotazione del sistema di misura di circa 1° alla

quale succede una nuova scansione lineare in senso opposto e così via fino a che non sia stata

completata una rotazione complessiva di almeno 180°. Durante l’interio procedimento di scansione

il segnale di misura, ottenuto da un pennello raggi finemente collimato, viene campionato,

digitalizzato e trasmesso ad un computer. Questo calcola dai valori di misura la distribuzione

bidimensionale di valori di assorbimento dello strato in esame, la quale infine, dopo la

commutazione in segnale video, permette di rappresentare l’immagine della sezione sul monitor

televisivo.

Evoluzione delle apparecchiature

Il progresso tecnologico della TC è avanzato lungo le seguenti principali direttrici:

-sviluppo di nuovi sistemi, fondati su differenti principi di scansione, nell’intento prioritario di

abbreviare il tempo di raccolta delle misure;

-sviluppo ed utilizzo di nuovi e più perfezionati componenti d’impianto al fine di migliorare la

qualità dell’immagine ed allo stesso tempo di aumentare l’efficienza operativa ed il comfort;

-sviluppo di sistemi di calcolo più efficienti al fine di ridurre il tempo di attesa dell’immagine,

migliorare la qualità della stessa ed aumentare il flusso degli esami;

-sviluppo di software applicativi per l’esecuzione di esami funzionali e l’incremento delle

possibilità di post-processing.

Tappe evolutive della TC

6

Nell’intento di migliorare le prestazioni riducendo il tempo di misura sono stati sviluppati ed

introdotti nell’esercizio clinico tomografi computerizzati realizzati secondo i quattro fondamentali

principi di scansione.

a)L’impianto a scansione parallela per mezzo di un singolo pennello raggi, che viene

alternativamente traslato e ruotato, utilizza in modo assolutamente scarso la radiazione del tubo

radiogeno e richiede un lungo tempo di misura.

b)L’impianto a scansione parallela per mezzo di più pennelli raggi offre un miglior utilizzo della

radiazione emessa e porta quindi ad abbreviare il tempo di misura.

c)L’impianto con fascio a ventaglio presenta una rotazione solidale intorno al paziente della

sorgente radiogena e di un sistema rivelatore ad essa contrapposto ed allineato.

d)L’impianto ad anello di detettori ha una corona fissa di rivelatori, lavora con un fascio a forma di

ventaglio piatto di apertura tale da investire simultaneamente tutta la sezione trasversale del corpo e

richiede pertanto solo un movimento di rotazione della sorgente radiogena. Il sistema di tipo a), a

traslazione rotazione con rivelatore singolo, fu concepito da Hounsfield e venne prodotto su scala

industriale dal 1973 al 1975. Questi apparecchi furono in seguito classificati in letteratura come di

prima generazione.

Il sistema di tipo b), a traslazione-rotazione con catena di rivelatori, fu prodotto industrialmente dal

1974 al 1979. In esso un fascio di raggi a ventaglio di apertura limitata – da un minimo di 3° ad un

massimo di 20°- investiva una serie di rivelatori allineati, il cui numero era pure compreso fra un

minimo di 3 ad un massimo di 30 elementi. Permaneva quindi il principio di acquisizione

precedente, ma risultava nettamente abbreviato il tempo di scansione.

Il sistema di tipo c), a rotazione solidale del tubo radiogeno e dell’arco detettore fu presentato nel

1974 ed introdotto nel 1975. Su questo sistema –detto di terza generazione- si sono orientati

decisamente tutti i grandi costruttori radiologici e su di esso è ricaduta negli ultimi anni per oltre il

90% la scelta degli utilizzatori mondiali. Esso consente, in virtù dell’ottimale sfruttamento

dell’emissione del tubo e della semplificazione del movimento di scansione, di raccogliere un

grande numero di dati di misura in un tempo ridotto in modo drastico rispetto a quello conseguibile

col sistema traslo-rotatorio. Il fascio radiante è un sottile ventaglio di apertura tale da inquadrare

completamente un campo di misura di circa 50 cm di diametro, investendo infine un sistema

detettore costituito da diverse centinaia di rivelatori assemblati compatti su un arco di cerchio

centrato sul fuoco del tubo radiogeno. L’acquisizione avviene tramite un movimento di rotazione

sincrono della sorgente radiogena e dei rivelatori per un angolo tipico di 360°.

Il sistema di tipo d) con il sistema detettore ad anello completo –detto di quarta generazione- fu

presentato nel 1976 ed introdotto nel 1977, suscitando un forte interesse che tuttavia è andato di

anno in anno scemando.

Anche in questo caso il fascio radiante è rappresentato da un sottile ventaglio di apertura tale da

avvolgere tutto il campo di misura, mentre i rivelatori sono disposti lungo una corona circolare

completa. Soltanto la sorgente radiogena ruota percorrendo una circonferenza concentrica interna a

quella dei rilevatori, mantenendo l’asse del fascio raggi centrato rispetto al campo di misura. Il

fascio radiante assumendo incidenze diverse rispetto all’oggetto in esame viene ad interessare via

via rilevatori diversi fino al completamento della rotazione. Come non trascurabili punti critici

devono essere citati la non favorevole geometria di scansione e la pratica impossibilità di attuare

efficaci misure di attenuazione della radiazione diffusa.

Stato dell’arte: TC volumetrica con sistemi a rotazione continua

Le prestazioni sopra descritte sono da considerarsi ben corrispondenti alle esigenze dell’esame TC

sui distretti anatomici non soggetti a movimenti, mentre non lo sono per i distretti critici soggetti a

movimenti respiratori, in particolare su pazienti non collaborativi e per esami TC funzionali. Sono

stati così sviluppati ed introdotti nell’esercizio clinico Tomografi Computerizzati di nuova

concezione e tecnologia, con rotazione continua di tutto il complesso di misura. Nel processo di

7

sviluppo tecnico e di applicazione diagnostica si possono distinguere due momenti: un primo

periodo in cui si sono migliorate le qualità e l’operatività dell’esame TC –nell’ambito di

un’acquisizione volumetrica discontinua, con pacchetti di sezioni singole-, ed un secondo periodo,

che ha condotto l’acquisizione volumetrica continua di tutto il distretto di interesse diagnostico,

attraverso nuove tecniche d’esame: TC Spirale e la TC Angio.

Sistema a rotazione continua

Un sistema di misura che ruota in modo continuo garantisce una rapida, ininterrotta acquisizione dei

dati. L’inizio e la fine di ogni scansione sono determinati soltanto da un segnale elettronico e non

sono legati ad alcuna posizione geometrica. Non vi sono fasi di accelerazione o decelerazione

durante la sequenza di scansione. Anelli rotanti (slip-ring), solidali col sistema di misura vengono

posti in collegamento con la parte fissa della testata, garantendo per strisciamento l’alimentazione

elettrica del tubo radiogeno e delle parti di controllo, e per via optoelettronica la trasmissione al

computer dei dati misurati.

Scansioni di volume continuo: TC Spirale

Fu ideata nel 1989 la tecnica TC Spirale, intesa ad eseguire nel più breve tempo possibile la

scansione continua di un intero volume anatomico. Essa venne accolta favorevolmente ed entrò in

esercizio clinico nel 1990. Attualmente è entrata nella routine. La scansione continua di volume

viene ottenuta dall’acquisizione continua dei dati di molteplici rotazioni del sistema tubo radiogenodetettore intorno ad un paziente in movimento continuo attraverso il foro del gantry. Il parametro

aggiuntivo è dato dall’avanzamento in mm del lettino per 360° di rotazione del sistema di misura.

Viene definito “Pitch” il rapporto fra l’avanzamento corrispondente a 360° di rotazione e lo

spessore dello strato collimato.

Applicazioni

Tra le applicazioni TC è di particolare importanza la tomografia computerizzata dinamica che

permette la visualizzazione di processi tempo-varianti e fenomeni di flusso nei vasi o negli organi.

La ricostruzione dinamica consiste in una rapida sequenza di scansioni di breve durata: richiede la

rotazione continua del tubo radiogeno, una notevole efficienza dei detettori ed un’alta velocità di

elaborazione dei dati.

Questo tipo di esame è utilizzato nello studio, mediante una serie di scansioni sullo stesso campo di

immagine, della diffusione di un mezzo di contrasto nei vasi e nei tessuti, dal momento della sua

iniezione nel paziente. Si ottengono, tra l’altro, le curve della densità in funzione del tempo, relative

a regioni di interesse selezionate nonché misure quantitative del flusso del sangue, con informazioni

diagnostiche utili sull’occlusione dei vasi, malformazioni arterio-venose, infarti, perfusione.

E’ possibile, inoltre, osservare organi in movimento che, nelle immagini TC convenzionali,

appaiono confusi e con artefatti: negli esami cardiografici, ad esempio, vengono acquisiti i dati in

una fase selezionata del ciclo cardiaco con trigger dell’elettrocardiogramma.

Un’innovazione degli ultimi anni è rappresentata dalla fluoroscopia TC. L’utilizzo di processori ad

alta velocità ha permesso di acquisire e visualizzare le immagini TC quasi in tempo reale. Essa è

stata utilizzata con buoni risultati nel monitoraggio di alcuni interventi chirurgici non vascolari.

Un’altra applicazione è l’immagine funzionale, nella quale i livelli di grigio non sono più legati ai

coefficienti di attenuazione lineare, ovvero alla densità, ma rappresentano un parametro funzionale

locale, come ad esempio il flusso sanguigno o il tempo medio di transito del mezzo di contrasto.

Linee guida per la scelta

8

La scelta di una TC è resa complessa da un elevato numero di considerazioni tecniche, economiche

e cliniche: innanzi tutto si tratta di una tecnologia sofisticata che presenta un costo di acquisto e

manutenzione relativamente alto. Il numero di esami effettuabili nella routine diagnosticostrumentale è ridotto rispetto ad altre tecniche radiologiche tradizionali ed il costo di ogni singolo

esame risulta essere superiore.

Per tale motivo, sebbene la Tc sia oramai divenuta un’apparecchiatura di routine, l’acquisto

dovrebbe essere sempre preceduto da un attento studio costo/efficacia allo scopo di ottimizzare

l’utilizzo del tempo macchina ed impedire sprechi di risorse. Oltre ad essere metodologicamente

corretta, questa pratica, infatti, consente di migliorare il servizio prevenendo eventuali degradi delle

prestazioni ed individuando le dosi ottimali per ciascuna tipologia di esame.

Un ulteriore costo è rappresentato dalla formazione del personale. Il processo di formazione è infatti

più lungo sulla TC che sulle tecniche radiologiche tradizionali.

L’elevato costo del tempo macchina richiede una notevole efficienza del servizio di manutenzione

della ditta produttrice nonché la disponibilità ad interventi rapidi. Per tale motivo, nell’acquisto di

una TC, assume notevole importanza la garanzia offerta dal produttore ed il tipo di contratto di

assistenza. Quest’ultimo, in particolare, può influire in maniera sostanziale sul costo

dell’apparecchiatura. Il contratto di acquisto può prevedere la formazione del personale tecnico a

spese della ditta produttrice.

La Tomografia a Risonanza Magnetica

Principi di base

La Risonanza Magnetica Nucleare (RM) è una tecnica che usa potenti magneti e radioonde per

analizzare le strutture interne del corpo. Essa combina i vantaggi delle altre tecniche di imaging

esistenti, senza tuttavia spartirne gli svantaggi. Come la Tc fornisce immagini tomografiche ed è

dotata di eccellente risoluzione spaziale e di contrasto, come l’Ecotomografia (ETG) non usa

radiazioni ionizzanti e produce immagini orientabili variamente, come la Medicina Nucleare infine

è in grado di fornire informazioni sui processi metabolici a livello tissutale. Si tratta di una tecnica

abbastanza recente e tuttavia in rapida espansione. Il numero di RM è in progressiva in crescita e

continue sono le innovazioni tecnologiche che interessano le varie componenti sia software che

hardware del sistema RM. Come la TC anche la RM ha avuto dapprima un impatto clinico nel

campo neurologico, e solo successivamente ha trovato, e sta trovando, utili campi di applicazione

clinica nell’imaging del resto del corpo. Sebbene l’imaging con RM sia di recente applicazione

clinica, la RM è una tecnica che affonda le sue radici in un passato piuttosto lontano. Nel 1924 Pauli

propose l’esistenza i un magnetismo nucleare. Nel 1946, indipendentemente, l’equipes di Purcell e

Block dimostrarono sperimentalmente il fenomeno della risonanza magnetica. Rapidamente la RM

fu applicata a molti campi della fisica e della chimica, per lo studio della struttura e dei movimenti

delle molecole. Con l’avvento degli elaboratori elettronici e dei magneti superconduttori la

sensibilità e l’accuratezza delle tecniche di analisi RM è migliorata in modo drastico, provocando la

sempre maggiore diffusione. Dopo circa un venticinquennio di applicazioni della RM all’analisi di

campioni omogenei, per esempio soluzioni di macromolecole, nel 1972, Lauterbur per primo ebbe

l’idea di utilizzare la RM per produrre immagini di strutture disomogenee come il corpo. Secondo la

sua idea ciò poteva avvenire introducendo nel campo magnetico principale, perfettamente

omogeneo, alcune disomogeneità controllate, dette gradienti magnetici, così da creare le coordinate

spaziali necessarie per la formazione di immagini. La realizzazione pratica di questa idea è stata

possibile grazie ai progressi compiuti nei campi della matematica applicata (algoritmi di

ricostruzione delle immagini; Fast Fourier Transform Algorithm) e degli elaboratori elettronici

digitali. Il successo di ogni tecnica di diagnosi radiologica dipende innanzitutto da una metodologia

di esecuzione appropriata. Quest’ultima, a sua volta, presuppone una buona conoscenza di vari

aspetti: principi fisici di formazione dell’immagine, conformazione e funzionamento

9

dell’apparecchiatura, anatomia e fisiologia umana, posizionamento del paziente. L’imaging con RM

non si sottrae a questa regola e richiede al radiologo un particolare impegno per la comprensione di

principi fisici del tutto diversi da quelli abituali.

Principi fisici di Risonanza Magnetica

Il campo magnetico principale B0 e la precessione dei nuclei.

In natura i nuclei di alcuni elementi con numero dispari di protoni e/o neutroni (per es. 1H; 31P;

19F) sono dotati di spin intrinseco cioè ruotano intorno a se stessi. Dato che ogni carica elettrica in

movimento produce un campo magnetico, anche questi nuclei, carichi elettricamente e dotati di

spin, sono associati ad un campo magnetico microscopico detto momento magnetico nucleare o

dipolo magnetico. In parole più semplici ogni singolo nucleo dotato di spin può essere considerato

come un piccolo magnete (dipolo magnetico). Quasi tutti i sistemi RM oggi in funzione producono

immagini utilizzandole proprietà magnetiche del nucleo dell’ idrogeno o protone. L’idrogeno

infatti, rispetto agli altri elementi utilizzabili in RM è il più abbondante nell’organismo, ed è quello

che produce il segnale più intenso. In condizioni normali, cioè in assenza di un campo magnetico

esterno, i momenti magnetici dei singoli protoni sono orientati casualmente nei tessuti. Di

conseguenza la loro somma, detta magnetizzazione risultante (M) è nulla. Viceversa, in presenza di

un forte campo magnetico esterno stazionario (B0) questi protoni tendono ad orientarsi

parallelamente alla direzione del campo magnetico esterno B0. Si produce così una magnetizzazione

risultante M, macroscopicamente misurabile, orientata anch’essa a B0. Inoltre, sempre per effetto di

B0, il momento magnetico di ciascun protone comincia a ruotare, cioè a precedere attorno alla

direzione di B0 nello stesso modo in cui l’asse di una trottola ruota intorno alla direzione della forza

di gravità. Da un punto di vista energetico, la meccanica quantistica prevede che ciascuna specie

nucleare possa assumere solo orientamenti ben definiti, corrispondenti a precisi livelli energetici.

Per i protoni esistono solo due possibili orientamenti, parallelo ed opposti rispetto a B0.

L’orientamento parallelo corrisponde al livello energetico basso, mentre l’orientamento opposto

corrisponde al livello energetico alto. In condizioni di equilibrio il numero di protoni nel livello

energetico basso, è lievemente superiore rispetto al numero di protoni nel livello energetico alto.

Questa piccola preponderanza di protoni paralleli, approssimativamente di uno per milione, per

valori di B0 intorno al tesla, produce una magnetizzazione risultante (M) macroscopicamente

misurabile, che ha la stessa direzione e verso del campo magnetico esterno B0. La frequenza con cui

i protoni ruotano intorno alla direzione B0 è detta frequenza di precessione o di Larmor e dipende da

due fattori: la costante giromagnetica, valore numerico caratteristico di ciascuna specie nucleare, e

la forza del campo magnetico principale B0. Pertanto, mantenendo costante B0, ciascuna specie

nucleare ha frequenza di precessione caratteristica. Viceversa, per ogni dato nucleo, la frequenza di

precessione è direttamente proporzionale alla forza di B0.In condizioni di equilibrio, in presenza di

un campo magnetico uniforme come B0, tutti i nuclei hanno la stessa frequenza, ma non la stessa

fase di precessione. In altre parole i nuclei in precessione non sono fra loro sincronizzati e sono

sparpagliati attorno alla direzione di B0. In realtà i momenti magnetici considerati singolarmente,

non sono esattamente paralleli o antiparalleli rispetto a B0, ma precedono ad un certo angolo da B0.

Di ciascuno di essi possono quindi essere considerate due componenti vettoriali: una longitudinale e

l’altra trasversale a B0. In condizioni di equilibrio, non esiste alcuna magnetizzazione trasversa,

perché a causa della diversa fase di precessione le componenti trasverse dei singoli nuclei si trovano

sparpagliate casualmente, annullandosi reciprocamente. Viceversa, le componenti magnetiche

longitudinali degli stessi nuclei si sommano e danno origine alla magnetizzazione longitudinale M.

Radiofrequenza (RF) e risonanza magnetica (RNM)

10

Lo stato di equilibrio può essere alterato mediante l’applicazione di onde elettromagnetiche la cui

frequenza sia uguale a quella di precessione nucleare. Solo in tali condizioni si verifica il fenomeno

della risonanza, con passaggio di energia dalla radiazione elettromagnetica al sistema di nuclei.

Infatti, dato un sistema qualsiasi, si parla di risonanza quando una forza rilascia energia ad una

frequenza uguale a quella intrinseca del sistema considerato; per frequenze diverse da quella ideale

non si ha alcun fenomeno di risonanza e non si verifica alcuno scambio di energia. Nel campo

magnetico la RF viene applicata per tempi molto brevi per cui si parla di impulsi di RF:

L’applicazione della RF equivale all’applicazione di un secondo campo magnetico perpendicolare a

B0, detto B1. B1 ha un’intensità molto inferiore a B0, ed una frequenza uguale a quella di

precessione, inducendo così il fenomeno della risonanza. La stimolazione RF, in condizioni di

risonanza, allontana M dall’asse di B0, compiendo una traiettoria a spirale. Più intenso e prolungato

è l’impulso di RF, maggiore è l’angolo.

Il segnale RNM

Ben noto è il fenomeno dell’induzione elettromagnetica secondo il quale in un circuito si genera

una corrente elettrica indotta tutte le volte che il circuito stesso è attraversato da un campo

magnetico variabile nel tempo. Allo stesso modo la magnetizzazione M, dopo un impulso di RF di

eccitazione di 90°, genera nel circuito (antenna) ricevente una corrente misurabile che è il segnale di

RNM, anche detto segnale di precessione libera o FID (free-induction-decay). Solo la

magnetizzazione presente nel piano trasverso attraversa l’antenna ricevente e vi genera un segnale

elettrico. Il segnale RNM può essere convertito in spettro per mezzo di un procedimento

matematico detto Trasformata di Fourier.

Effetti biologici, controindicazioni

L’imaging con RM può produrre effetti biologici con tre diversi meccanismi, che dipendono dalle

tre componenti principali del sistema: il magnete principale, i gradienti magnetici e la

radiofrequenza. Il rischio teorico legato al campo magnetico principale consiste nella possibile

interazione dello steso con i protoni e gli elettroni all’interno delle molecole, con conseguente

possibile alterazione dei legami chimici e quindi della funzione biochimica. Per verificare la reale

entità di questo ipotetico rischio sono stati condotti numerosi esperimenti. Le conclusioni sono

univoche nell’affermare l’assenza di qualsiasi danno biologico per le intensità di campo magnetico

impiegate.

I gradienti magnetici possono teoricamente produrre danno perché sono costituiti da campi

magnetici che variano nel tempo e che possono pertanto indurre correnti elettriche nei tessuti in

esame. Le numerosi valutazioni sperimentali eseguite per verificare l’ipotetico rischio legato

all’impiego dei gradienti magnetici hanno dimostrato che i gradienti magnetici oggi impiegati nei

sistemi RM non sono in grado di produrre gli effetti biologici cui si è accennato. Gli effetti biologici

della radiofrequenza sono stati studiati per lungo tempo, anche indipendentemente dall’avvento

della risonanza magnetica. L‘effetto principale della RF è il riscaldamento, dovuto all’oscillazione

delle molecole ed atomi da essa prodotto. Sebbene sia possibile un lieve aumento della temperatura

corporea nel soggetto in esame, tale effetto non costituisce in genere alcun problema, a meno che

non vi siano gravi alterazioni dei sistemi cardiocircolatorio e della termoregolazione.

Sebbene generalmente non produca danno biologico, la risonanza magnetica può produrre effetti

nocivi in alcune particolari categorie di soggetti: i portatori di pace-makers, i soggetti con clips

ferromagnetiche vascolari cerebrali e quelli con corpi estranei metallici endooculari. Le grosse

protesi articolari nella grande maggioranza dei casi non sono ferromagnetiche, o lo sono solo

debolmente e non costituiscono controindicazione all’esame. Tutti i moderni tipi di valvole

cardiache non costituiscono controindicazione all’esame, solamente i tipi vecchi, prodotti prima del

11

1964 possono costituire una controindicazione. Anche i portatori di dispositivi cocleari non sono

candidati all’esame.

Applicazioni

Principalmente a causa dell’elevato contrasto ottenibile tra materia bianca materia grigia, la RNM

fu impiegata inizialmente soprattutto in campo neurologico. L’alto livello di contrasto consente

infatti di ottenere informazioni diagnostiche sia sulla morfologia di tumori cerebrali e sia sui

processi di demielinizzazione, che possono essere diagnosticati fin dallo stadio iniziale del loro

insorgere. I principali vantaggi della RNM, rispetto alla TC, sono rappresentati dall’assenza di

artefatti dovuti a strutture ossee, di particolare rilievo nelle immagini della fossa cranica posteriore.

Ne gli ultimi anni le applicazioni della RNM sono state notevolmente ampliate fino a comprendere

esami delle articolazioni, imaging cardiaco, imaging angiografico, imaging funzionale, etc..........

Linee guida per la scelta

Nella scelta di una RNM il primo criterio di selezione deve necessariamente riguardare la possibilità

di effettuare spettroscopia in vivo. Se vi è necessità di effettuare spettroscopia la scelta deve

forzatamente venire rivolta alle apparecchiature ad alto campo. I tomografi ad alto campo sono

sempre a magnete superconduttivo e offrono le prestazioni migliori in fatto di qualità dell’immagine

e i perfezionamenti tecnici più avanzati. I costi di acquisto, gestione e manutenzione, tuttavia, sono

decisamente elevati e l’installazione richiede spesso l’esistenza di ambienti costruiti ad hoc a causa

del peso del magnete. Viceversa, se non si è interessati a realizzare spettroscopia in vivo, è possibile

considerare l’acquisto di apparecchiature a basso campo. I magneti sono ancora superconduttivi e

vengono spesso utilizzate soluzioni derivate dai modelli ad alto campo. La qualità dell’immagine a

volte è decisamente ottima, i pesi sono più contenuti e i costi di acquisto, gestione e manutenzione

sono fortemente ridotti. Se la RNM viene interpretata come un esame di routine è possibile

considerare la scelta di sistemi a basso campo. I magneti sono permanenti o, in pochi casi, resistivi.

I costi iniziali sono a volte comparabili con quelli della TC di elevata qualità mentre la gestione dei

magneti permanenti è decisamente più economica. Se i sistemi resistivi richiedono una potenza non

trascurabile per la generazione del campo magnetico e per il raffreddamento, viceversa i sistemi

permanenti non consumano energia elettrica e non necessitano alcun raffreddamento. I sistemi a

basso campo non permettono forse la realizzare indagini di qualità elevatissima, ma la flessibilità

d’uso, la praticità, i costi ridotti e gli ingombri contenuti rappresentano ottimi motivi per preferirli

nel caso di esami che rientrino nella routine clinica. Di particolare interesse risultano, inoltre, i

sistemi settoriali, che rientrano tra le apparecchiature non soggette ad autorizzazione per

l’installazione e l’uso, e i sistemi aperti, che rimuovono definitivamente le controindicazioni di

esami di RNM nel caso di pazienti claustrofobici.

Tomografo ad emissione di Positroni e il Ciclotrone

Introduzione

La Tomografia ad emissione di Positroni (PET) è una tecnica per la creazione di immagini

tomografiche. La PET genera immagini rilevando la distribuzione dell’emissione di positroni,

particelle identiche agli elettroni ma di carica positiva, da parte di radiofarmaci che sono stati

assunti, tramite inalazione o iniezione, dal paziente prima dell’esame. La caratteristica essenziale

che distingue la PET da altre tecniche per la generazione di bioimmagini (TC, RNM, Raggi X,

Ecografia, etc...) è che, mentre queste ultime sono in grado di rilevare caratteristiche anatomiche ed

alcune attività fisiologiche, essa è capace di rilevare con grande precisione le attività biochimiche e

metaboliche. In sostanza, anziché fornire una mappatura delle alterazioni anatomiche, la PET

12

permette di avere una mappa 3D delle alterazioni biochimiche e metaboliche presenti nel corpo del

paziente. Tali alterazioni sono associate a numerose patologie di cui permettono la diagnosi.

I radiofarmaci

I radiofarmaci sono delle molecole marcate con atomi dal nucleo radioattivo (radionuclide). Il

radionuclide è un nucleo instabile che durante il suo decadimento (il processo di stabilizzazione)

emette radiazioni). Il tipo di radiazione (raggi x, raggi , raggi , neutroni, positroni,....) dipende dal

radionuclide: per gli esami PET vengono scelti marcatori che emettono positroni.

La struttura

Attraverso opportuni procedimenti, vengono create strutture molecolari al cui interno è presente un

atomo marcatore. Nell’esempio in figura, nella molecola di fluorodesossiglucosio, utilizzata per

studiare il metabolismo del glucosio, allo stabile Fluoro-17 viene sostituito il radioattivo Fluoro-18.

Il decadimento del Fluoro-18 (radiomarcatore) causa l’emissione di un positrone (e+).

La PET è in grado di rilevare la posizione in cui è avvenuta l’emissione del positrone e quindi di

individuare la collocazione della molecola marcata. La maggiore concentrazione di tale molecola in

una certa regione del corpo darà origine, nell’ambito dell’immagine tomografica, ad un’area di

contrasto che fornirà all’operatore la posizione dell’anatomia biochimica o metabolica nel corpo del

paziente. Quest’alterazione del metabolismo sarà, al variare dei radiofarmaci usati e della

collocazione, indicativa di un ampio spettro di patologie che vanno dal morbo di Parkinson al

tumore.

HO

O

HO

HO

OH

18

F

I marcatori radioattivi

Gli isotopi radioattivi che, all’interno delle molecole scelte come radiofarmaci, assolvono alla

funzione di radiomarcatori ad emissione di positroni, assieme al Fluoro-18, sono: Carbonio-11;

Azoto-13; Ossigeno-15; Rubidio-82; Iodio-124. Nella scelta del radiofarmaco è particolarmente

importante tenere conto della vita media o tempo di dimezzamento (T.1/2) dell’isotopo utilizzato

come marcatore. Il parametro T-1/2 è l’intervallo di tempo che trascorre tra il momento della

creazione degli isotopi marcati nel ciclotrone ed il decadimento del 50% di essi. Come evidenziato

nella tabella, il tempo di dimezzamento varia in funzione dell’isotopo marcatore utilizzato.

13

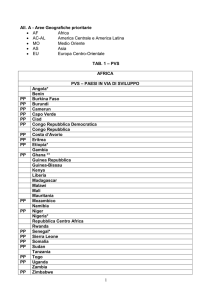

MARCATORE

Carbonio-11

Azoto-13

Ossigeno-15

Fluoro-18

Rubidio-82

Iodio-124

T-1/2

20,4 minuti

12 minuti

120 secondi

110 minuti

1,25 minuti

4,176 giorni

Questo parametro dà all’operatore una misura del tempo utile per effettuare l’esame PET. Per

rimanere all’esempio dell’FDG marcato con Fluoro-18, trascorsi 110 minuti dal momento della sua

produzione, la metà delle molecole avrà già emesso il positrone.

Le attività funzionali dei radiofarmaci

Le molecole marcate prendono parte alle attività biochimiche e metaboliche come le loro omologhe

non radioattive. In funzione delle patologie da individuare o delle ricerche in atto vengono assunti,

prima dell’esame PET, uno o più radiofarmaci scelti tra un set di cui presentiamo gli elementi più

utilizzati:

Marcatore: Azoto-13

L’ammoniaca può utilizzarsi come quantificatore del flusso sanguigno. La molecola migra dallo

spazio vascolare al tessuto sia per trasporto attivo (pompa Na-K) che per diffusione. Una volta

all’interno delle cellule è metabolizzata dal ciclo acido glutammico-glutammina. L’ammoniaca

marcata è un eccellente tracciatore della perfusione sanguigna del miocardio sia in situazioni

ordinarie che patologiche. La rapida eliminazione dell’ammoniaca dal sangue e la sua alta

ritenzione nei tessuti permette di ottenere immagini ad alto contrasto. Un ulteriore vantaggio è che

l’Azoto-13, avendo una vita media relativamente breve, permette di effettuare più esami

consecutivamente.

Marcatore: Carbonio-11

L’acetato (HC2H3O) è usato per monitorare il metabolismo ossidativo. Nel miocardio tale

metabolismo si alimenta essenzialmente di acidi grassi e quindi l’acetato risulta molto utile per

analizzare lo stato del metabolismo cardiaco.

Il carfentanil è un narcotico circa 8000 volte più potente della morfina. Viene utilizzato, marcato

con C-11, negli esami PET per studiare i recettori dei narcotici nel cervello.

La cocaina: la PET può essere utilizzata per localizzare i siti cerebrali in cui la cocaina si

distribuisce e la sua farmacocinetica. Si possono altresì studiare gli effetti biologici della cocaina

come la riduzione del metabolismo della dopamina.

La leucina marcata con C-11 può essere utilizzata per valutare l’attività di sintesi proteica volta allo

studio del grado di vitalità del tumore.

La metionina ha, per gli esami PET, le stesse caratteristiche funzionali della leucina.

Marcatore: Fluoro-18

L’isotopo ionico Fluoro-18 (18F-) viene utilizzato per l’analisi delle patologie dello scheletro. Lo

ione F-18 ha lo stesso pattern del tecnezio-99m difosfonato, marcatore usato per le gamma camere.

Il fluorodesossiglucosio (FDG), è, ad oggi, il radiofarmaco più utilizzato per gli esami PET. La sua

capacità di monitorare il metabolismo del glucosio lo rende utilizzabile per la diagnosi e lo studio di

patologie neurologiche, cardiologiche ed oncologiche. L’FDG si è dimostrato altresì utile per

distinguere le forme maligne e benigne di certi tipi di tumori, in virtù della maggior attività

metabolica delle forme maligne.

La Fluoro-L-Dopo si può utilizzare in neurologia per studiare il metabolismo, la neurotrasmissione

ed i processi cellulari. In particolare si possono ricavare informazioni sulla distribuzione presinaptica dei neurotrasmettitori. Affine alla dopamina viene agganciata ai suoi terminali ed

incorporata nel neurotrasmettitore.

14

Fluorouracile: è stato usato per monitorare la distribuzione degli agenti chemioterapici durante il

trattamento.

Marcatore: Rubidio-82

L’isotopo ionico Rubidio-82, chimicamente affine allo ione Potassio, viene assorbito dalle cellule

del miocardio. La sua breve vita (85 secondi) media permette di effettuare esami PET cardiaci

ravvicinati per comparare situazioni di stress-riposo del muscolo cardiaco. Un vantaggio di questo

radiofarmaco è costituito dalla possibilità di produrlo, senza utilizzare un ciclotrone, con un

generatore a colonna.

La preparazione dei radioisotopi

I ridotti tempi di decadimento dei marcatori usati per gli esami PET, vantaggiosi per ripetere esami

ravvicinati nel tempo e per limitare l’esposizione del paziente alle radiazioni, obbligano però

l’utilizzazione di una produzione “in situ” dei radiofarmaci. Nella maggior parte dei casi è

necessario un ciclotrone accoppiato ad un’unità per la biosintesi delle molecole radiomarcate.

Il ciclotrone

Il ciclotrone è sostanzialmente un acceleratore circolare di particelle cariche, di piccole dimensioni,

adatto alla produzione di radioisotopi. Esso consiste in una coppia di elettrodi metallici a forma di

D, posizionata tra i poli di un largo elettromagnete. La coppia di elettrodi è separata da un sottile

gap in cui è posizionata una sorgente di ioni che è usata per generare particelle cariche. Subito dopo

la produzione di fasci di ioni (ad esempio Idrogeni) un filamento posizionato nella sorgente

permette di caricare negativamente gli ioni di idrogeno tramite l’aggiunta di due elettroni (H). In

seguito gli ioni negativi entrano nella camera a vuoto dove guadagnano energia grazie al campo

elettrico ad alta frequenza che viene indotto dagli elettrodi metallici precedentemente descritti e

vengono curvati da un forte campo magnetico generato da elettromagneti posti sopra e sotto la

camera a vuoto. Grazie ad un oscillatore RF (Radio-Frequenza) che permette di cambiare la polarità

degli elettrodi metallici ad ogni passaggio delle particelle cariche, il flusso di ioni negativi risulta

continuamente accelerato e guidato lungo una traiettoria a spirale verso l’esterno. Dopo aver

percorso diversi giri dentro la camera a vuoto il fascio di ioni negativi viene a contatto con una

particolare struttura denominata carosello composta da diversi strati sottili di carbonio che

permettono di strappare i due elettroni dallo ione H. Quando gli ioni negativi perdono entrambi gli

elettroni ed acquistano carica positiva, il campo magnetico ancora presente nel carosello li porta a

curvare lungo una nuova orbita circolare che li allontana dal centro del ciclotrone. Il fascio di

protoni è così indirizzato verso una camera a targhetta fissa (di solito per ogni ciclotrone associato

all’apparecchio per la PET ne sono presenti almeno due) dove viene posizionato il materiale atto

alla produzione di radioisotopi. Il fascio di protoni entra così nella camera a targhetta ed attraverso

particolare reazioni nucleari cambia la natura del materiale stabile, generandovi isotopi radioattivi

soggetti a decadimento +. Una volta prodotti, i radioisotopi vengono trasferiti ad un’entità

denominata biosintetizzatore dove vengono “attaccati” a particolari molecole per formare i

radiofarmaci. Tutte le funzioni sopra descritte, incluso il ciclotrone e le unità biosintetizzatrici, sono

controllate attraverso un personal computer.

La fisica della PET

I radiofarmaci usati nella PET contengono dunque particolari isotopi che sono instabili poiché i loro

nuclei hanno un eccesso di protoni e quindi possiedono una carica positiva. Per raggiungere una

configurazione più stabile per la loro natura, tali nuclei emettono un positrone (denominato + o e+).

Questa particella perde energia attraverso un processo dissipativo all’interno del tessuto del paziente

stesso oppure con una certa probabilità viene a contatto con un elettrone libero. L’interazione di un

15

positrone con un elettrone (una l’antiparticella dell’altra) è un evento di annichilazione, ovvero le

due particelle si convertono in una coppia di fotoni gamma: la loro massa si trasforma in energia.

Essendo la massa di ciascuna particella di 511KeV, i due fotoni creati dall’interazione avranno

ognuno un’energia pari a 511 KeV. Inoltre la legge di conservazione della quantità di moto impone

che i due raggi gamma viaggino in verso opposto lungo la stessa retta. Potendo passare

sostanzialmente indisturbati attraverso il corpo umano, i due fotoni possono essere così rilevati da

due distinte sezioni di un apposito rilevatore posto intorno al paziente. Tramite un circuito di

coincidenza verrà determinata la posizione dell’evento di annichilazione e una ricostruzione

elaborata da un computer esterno potrà dare l’immagine della distribuzione del radionucleo nel

corpo del paziente.

Ricostruzione dell’immagine

Innanzitutto cerchiamo brevemente di descrivere come avviene la tomografia dei raggi gamma da

511 KeV emessi nell’annichilazione del positrone con un elettrone. In uno studio PET, un

radioisotopo capace di emettere positroni viene iniettato o inalato nel paziente. In seguito l’isotopo

circola attraverso il sangue per raggiungere, per esempio, il tessuto cerebrale, o il muscolo cardiaco.

Appena è avvenuta un’annichilazione, il tomografo può rilevare la posizione nel corpo del paziente

e la concentrazione dell’isotopo. La linea che appare dopo l’annichilazione del positrone

rappresenta, infatti, la direzione di emissione dei due raggi gamma, ognuno ad angolo di 180°

dall’altro. Il lavoro che deve fare il tomografo consiste dunque nel rilevare correttamente questi due

raggi coincidenti, indicanti che l’annichilazione di un positrone è avvenuta in un punto specifico

lungo la linea di coincidenza ricostruita. Quando i due raggi gamma interagiscono con i cristalli

dello scintillatore, composto solitamente di germanato di bismuto (BGO), essi vengono convertiti in

fotoni di luce visibile e quindi raccolti e amplificati da tubi fotomoltiplicatori (PMTs). Sempre nei

PMTs i fotoni vengono convertiti in segnali elettrici che sono poi memorizzati dall’elettronica del

tomografo. Il processo di conversione e memorizzazione avviene quasi istantaneamente, il che

permette di poter comparare gli eventi di scintillazione di tutti i rilevatori opposti (cioè lungo tutte

le linee di coincidenza possibili). Una volta che l’emissione di positroni è stata rivelata e

memorizzata, il passo successivo consiste nell’elaborazione dell’immagine dell’organo e della

relativa diagnosi associata. Descriviamo brevemente come avviene il processo di ricostruzione

dell’immagine. Il risultato finale di una PET è l’insieme di immagini di diverse “fettine” (slices)

trasversali dell’organo interessato, con le aree caratterizzate da una ben definita attività biochimica

e metabolica chiaramente delineate da differenti colori. In sostanza l’immagina PET rappresenta la

distribuzione dei radionuclidi nel corpo del paziente. Quando due cristalli opposti rilevano una

coppia di fotoni gamma all’interno della corretta finestra di coincidenza, viene memorizzata una

linea di risposta (LOR), identificata da un angolo e da un raggio calcolati rispetto ad una linea

perpendicolare direzionata verso il centro del campo di vista (FOV) che si sta analizzando. Ogni

volta che un evento viene rivelato, la relativa LOR viene memorizzata e rappresentata in un insieme

di coordinate polari che chiamano sinogrammi. Per cui se vogliamo studiare tutte le linee di

coincidenza parallele ad un certo angolo (cioè studiare la vista lungo una singola direziona) ci basta

studiare un singolo vettore di dati del sinogramma. Il processore di immagini ricostruisce

l’immagine dal sinogramma usando diversi protocolli matematici come le trasformate di Fourier

veloci (FFT), usate anche in apparecchiature tomografiche come la TC e SPECT. Essendo ogni

unità PET dotata di un hardware specifico per la ricostruzione dell’immagine, il computer PET può

ricostruire un’immagine in circa due secondi. I dati grezzi vengono comunque scremati dagli eventi

di tipo casuale, da quelli scatterati e corretti a seconda dei tempi morti e delle attenuazioni prima

che l’immagina finale venga prodotta. Esiste infine la possibilità, per le PET dotate di anelli

multipli e capaci di acquisire simultaneamente diverse fettine, di combinare opportunamente

“slices” adiacenti producendo viste coronali e sagittali degli organi studiati. Uno degli ultimi passi

che caratterizzano la catena di processi nello studio PET è la produzione di una stesura delle

16

immagini utile per la diagnosi. Il modo convenzionale di presentare i dati dell’immagine è quello di

produrre una pellicola trasparente (X-ray film) delle immagini visualizzate dal monitor del

computer. In aggiunta ai dati di immagine, la pellicola considerata dovrebbe essere etichettata con i

dati specifici del singolo caso clinico. Dato che questa informazione è solitamente memorizzata nei

file di immagine insieme ai dati sull’immagine, l’etichettatura e la stesura delle immagini prodotta

sul display può essere automaticamente trasferita e immagazzinata via software. Comunque, con il

rapido sviluppo di network locali e sistemi PACS, le pellicole potranno non essere più

indispensabili. Le immagini potranno essere infatti lette direttamente dal sistema e mostrate su

appositi display per la refertazione.

L’evoluzione tecnologica e la possibilità di fondere le immagini PET, che hanno un elevato

contenuto di tipo metabolico-funzionale, con quelle della tomografia computerizzata (TC), che

presentano una grande accuratezza spaziale, hanno contribuito in questi ultimi tempi a ottimizzare

le informazioni emergenti da questa tecnica diagnostica. I tomografi ibridi PET/TC di ultima

generazione infatti sono in grado di ottenere nello stesso paziente sia un’immagine PET che la

corrispondente immagine TC, e di riprodurre in tempi molto brevi le due immagini sovrapposte in

un’immagine iconografico tridimensionale che rappresenta l’intero distretto corporeo. Negli ultimi

anni è stata sviluppata e commercializzata una nuova generazione di strumenti ibridi PET/TC. I

vantaggi ricavabili da questo accoppiamento sono:

-le radiazioni della TC possono essere utilizzate per correggere il fenomeno dell’attenuazione delle

radiazioni attraverso i tessuti dell’organismo, e questo permette di “ripulire” l’immagine PET da

possibili interferenze e di migliorare la qualità dell’informazione;

-l’impiego della TC per la correzione dell’attenuazione rende l’esame complessivamente più veloce,

e pertanto permette lo studio di un maggior numero di pazienti nello stesso tempo;

-l’immagini della TC, più accurate nel definire i dettagli anatomici, migliorano l’interpretazione

della localizzazione spaziale degli accumuli osservati con la PET;

-la possibilità di fondere in un’unica immagine informazioni morfologiche e funzionali rende più

agevole l’interpretazione diagnostica, e migliora ulteriormente l’accuratezza diagnostica della PET.

Le specifiche delle prestazioni

Negli ultimi anni sono stati definiti gli standard per le prestazioni che devono avere le macchine per

la PET, è stata definita una terminologia di base comune a tutti i prodotti in commercio e studiate

procedure di test sperimentali per valutare le capacità di scansione dei vari modelli. Attualmente la

risoluzione spaziale, la sensibilità (energetica), la stima delle correzioni alle quantità acquisite,

rispetto alla frazione di radiazione scatterata, alla frequenza di perdita di conteggi, agli eventi

casuali, all’uniformità di conteggi e attenuazioni, vengono effettuate usando un fantoccio cilindrico

di mecrilato di metilene o polietilene di 18-20 cm. La risoluzione spaziale misura la capacità dello

scanner di determinare accuratamente la posizione di ogni evento di annichilazione ed è definita

come la larghezza a metà altezza (FWHM) della funzione di distribuzione dei punti di ogni

immagine. La risoluzione nella direzione trasversa è calcolata ricostruendo l’immagine di una

sorgente posta in aria a diverse distanze radiali tra 0 e 10 cm dentro un definito FOV, e mantenuta

stazionaria o in rotazione fuori dal piano. La risoluzione assiale è invece misurata in tre definite

posizioni radiali della sorgente: 0 cm, 10 cm e 20 cm dal centro. La risoluzione spaziale di un’unità

PET è limitata principalmente dalle dimensioni del rilevatore, dal cammino medio che il positrone

fa nel corpo del paziente prima di annichilirsi (range) e dalle deviazioni dei fotoni gamma lungo il

percorso (scattering). L’uso di circuiti di coincidenza opportuni per la rilevazione delle radiazioni e

di particolari collimatori. La sensibilità del sistema, che misura la capacità per ogni singolo

rivelatore di rivelare e discriminare i fotoni di 511 KeV, viene calcolata considerando l’efficienza

nel conteggio dello scanner quando un fantoccio è riempito con un quantitativo e una distribuzione

conosciuta di materiale radioattivo. La sensibilità totale del sistema è definita come la somma delle

sensibilità misurata per ogni fettina ed è rappresentata in conteggi per secondo (cps) per una data

17

attività, solitamente in unità di microcurie per centimetro cubo (Ci/cc). La frazione di eventi

diffusi (scatter radiation) sul totale di quelli registrati, rappresenta una buona misura della sensibilità

dello strumento nel discriminare la radiazione diffusa e viene testata usando un fantoccio riempito

con acqua. Per la sua determinazione si considerano i dati registrati nel sinogramma, ed è

consigliabile sia calcolare il valore della frazione per ogni singola fettina, sia estrarre un valore

medio su tutte le slice possibili. Questo dato riveste una notevole importanza nella valutazione

standard dei differenti scanner prodotti in quanto esso viene modificato principalmente dalla

geometria e dal materiale del rivelatore e dalla posizione degli scudi. Nella valutazione di tale

parametro bisogna comunque tenere conto che le dimensioni del fantoccio non corrispondono ne a

quelle di un singolo organo ne tanto meno a quelle del corpo umano per cui la frazione di radiazione

diffusa in una reale situazione clinica non può essere accuratamente predetta dai test di qualità. Un

aspetto che può influire molto sulla accuratezza della misura è sicuramente la perdita di conteggi

per effetto dei tempi morti caratteristici del sistema di rilevazione e acquisizione. Più esattamente il

tempo morto è il periodo di tempo, solitamente di alcuni microsecondi, in cui un evento di

annichilazione viene processato e nessun altro evento può essere memorizzato. Per la stima di

questo parametro si procede a misurare diverse volte un fantoccio riempito uniformemente con

materiale radioattivo. In questo modo si può avere una stima della perdita di conteggi a diversi

livelli di attività della sorgente, calcolata in cps o in kilo-conteggi per secondo (kps). I valori

misurati di frequenza di conteggio sono solitamente usati per stimare la capacità di acquisizione del

sistema e vengono rappresentati con un grafico dell’attività verso conteggi. Il valore sul plot per cui

il numero di eventi casuali eguaglia il numero di eventi reali, il punto al quale il tempo morto

raggiunge il 50%, è usato come stima della capacità di frequenza di conteggi del sistema. Nei

software usati per la ricostruzione delle immagini sono implementati algoritmi che tengono conto

dei tempi morti e degli eventi casuali. La misura dell’uniformità della risposta del sistema è usata

per valutare le imperfezioni nell’immagine ricostruita proveniente da imperfezioni del sistema

stesso come una non eguale risposta dei vari cristalli del rivelatore che può poi essere corretta a

livello software. Il test associato all’uniformità fa uso di un fantoccio riempito con una distribuzione

uniforme di radioattività e piazzato ad una distanza verticale di 2,5 cm rispetto al centro. Dopo che

il fantoccio è stato rivelato con l’acquisizione di circa venti milioni di conteggi per fettina, la

percentuale di non uniformità è determinata dai conteggi acquisiti in aree di 1 cm2 su una precisa

regione di interesse (ROI). La correzione per attenuazione è un aspetto importante nella scansione

della PET in quanto permette di correggere un’eventuale formazione di artefatti nell’immagini finali

attraverso l’uso di collimatori elettronici. Una scansione della trasmissione viene di solito effettuata

prima dell’iniezione di un radiofarmaco nel paziente per poter stabilire le correzioni da effettuare

sulle attenuazioni dei fotoni di annichilazione nel tessuto del paziente. Recenti sviluppi nelle

tecnologie di trasmissione permettono oggi di poter effettuare simultaneamente scansioni del

paziente con emissione e trasmissione. I dati raccolti durante questo tipo di scansione vengono poi

elaborati dal computer che provvede a correggere le attenuazioni e testare le distorsioni spaziali da

esse prodotte.

Descrizione strumentale

La struttura generale di un apparecchi PET si è oramai definita nel corso degli ultimi anni e

nonostante ci possano essere differenze nella capacità di elaborare immagini sempre più precise

possiamo raggruppare gli elementi principali nel seguente modo :

-Gantry

-Apparecchiatura rivelatrice

-Elettronica di acquisizione

-Lettino del paziente

-Sistema computerizzato

18

Il Gantry

Il gantry contiene il circuito elettronico, i laser per il posizionamento del paziente, la TC e permette

l’assemblaggio e l’alloggiamento del rivelatore ad anello per la ricostruzione degli eventi con

emissione di due fotoni.

Il rivelatore

Cristalli di manganato di bismuto (BGO) che hanno la caratteristica di emettere luce (scintillare)

quando esposti a radiazioni ionizzanti, costituiscono la parte attiva del detector, capace cioè di

rivelare gli eventi di annichilazione dei positroni. In alcune apparecchiature PET vengono usati altri

cristalli scintillanti come lo ioduro di sodio attivato al tallio (Na-Tl) o il fluoruro di bario (BaF)

oppure il fluoruro di cesio. I vari cristalli del rivelatore sono posizionati in anelli stazionari intorno

al paziente.In molti casi gli analizzatori PET hanno da 6 a 16 anelli esagonali, ottagonali o circolari

ognuno dei quali è composto da 220 a 512 cristalli. I cristalli sono otticamente accoppiati (cioè

collegati tramite l’uso di guide di luce o fibre ottiche) a tubi fotomoltiplicatori (PMTs) che

convergono i segnali di luce degli scintillatori in impulsi elettrici opportunamente formati e

amplificati. Ad un PMT può essere accoppiato un numero variabile di cristalli tra 1 e 16 tanto che in

alcuni sistemi vengono considerati gruppi di rivelatori associati in blocchi di 4 elementi che

distribuiscono la luce emessa dagli eventi di scintillazione in 64 cristalli a 4 PMTs. Grazie alla loro

spaziatura e all’angolazione con cui vengono disposti, questi blocchi di scintillatori raggiungono

così livelli uniformi di efficienza e risoluzione. Altri esempi di apparecchiature PET in funzione

usano, invece 6 rivelatori al Na-Tl ad ampia superficie, ognuno accoppiato a 34 PMTs quadrati

oppure cristalli di fluoruro di cesio, con un cristallo per PMT.

Elettronica di acquisizione

Ogni struttura “rivelatore + PMT” è collegata elettronicamente ad un circuito di acquisizione

(denominato coincidence circuit o Front End Electronics) che registra possibili eventi di

annichilazione rivelati da due cristalli distinti soltanto se entrambi i segnali provenienti da PMTs

risultano essere coincidenti. La verifica della coincidenza avviene attraverso un circuito elettronico

che compara gli istanti di formazione del segnale con un intervallo temporale ben determinato

(finestra temporale di coincidenza) che può variare da meno di un nanosecondo (ns) ad alcuni

nanosecondi. La selezione di eventi collimati, cioè di segnali non provenienti da radiazione

“scatterata”, è raggiunta elettronicamente attraverso il circuito di coincidenza, piuttosto che

attraverso collimatori in piombo usati nelle immagini nella medicina nucleare convenzionale che fa

uso di emissioni ad un singolo fotone. La tecnica di coincidenza si basa sulla generazione di un

impulso standard (e.g. 1 Volt di altezza e 5 nsec di ampiezza) ogni volta un evento di annichilazione

è rivelato. Questo segnale di output è sommato con il segnale proveniente dal rivelatore opposto; se

gli impulsi sono coincidenti vengono sovrapposti e in seguito sommati producendo un segnale

elettrico con altezza di impulso raddoppiato. Attraverso questo circuito di collimazione è così

possibile ottenere una migliore risoluzione di contrasto e spaziale, un’efficienza più alta, ed una

frequenza di conteggi più alta di quelle ottenibili con le tecniche per singolo fotone usate nelle

gamme-camere. Il rumore del sistema di acquisizione è dovuto principalmente alla registrazione di

eventi di coincidenza casuali provenienti da sezioni del rivelatore non correlati (cioè non opposti

l’uno con l’altro). Questo tipo di rumore può essere ridotto migliorando: la finestra temporale di

coincidenza (principalmente restringendola), la struttura del gantry e gli scudi di piombo. Per

aumentare il rapporto tra eventi di coincidenza e non coincidenza e per ridurre la radiazione

scatterata sugli anelli del rivelatore vengono posizionati degli anelli stazionari, composti da dischi

di tungsteno o piombo posizionati tra in gap opportune tra ogni anello del rivelatore e di spessore di