La probabilità condizionata

e il teorema di Bayes

«La probabilità è la miglior guida nella vita».

Marco Tullio Cicerone

«Il concetto di probabilità è il più importante

di tutta la scienza moderna, soprattutto

perché nessuno ha la più pallida idea del suo

significato».

Bertrand Russell

Il calcolo della probabilità

In questa lezione considereremo solo la cosiddetta definizione classica della

probabilità:

la probabilità che si verifichi un evento è il rapporto

tra il numero dei casi favorevoli affinché l’evento si

verifichi, e il numero dei casi possibili.

In simboli:

f

P(E)

u

in cui f è il numero dei casi

favorevoli ed u è il numero

dei casi possibili.

Un semplice esempio ci aiuterà a capire la definizione:

Lanciando un dado, la probabilità di fare un 4 è 1/6; la

probabilità di fare un numero pari è 1/2; la probabilità

di fare un numero maggiore di 4 è 1/3 e così via.

Questo calcolo è valido se tutti gli eventi elementari (ad esempio l’uscita di un

particolare numero di un dado) sono equiprobabili, cioè se hanno la stessa

probabilità di verificarsi individualmente.

Lanciando una moneta, la

probabilità che venga testa è

esattamente 1/2 (come la

probabilità che venga croce),

se la moneta non è truccata…

… e se non si è

particolarmente sfortunati.

Lo spazio degli eventi

E’ possibile parlare di probabilità usando definizioni e concetti tipici

dell’insiemistica, con il vantaggio non indifferente di poter visualizzare

graficamente il problema.

Si chiama spazio degli eventi o spazio campionario, e si indica con E,

l’insieme di tutti i risultati possibili di un evento aleatorio. Alcuni esempi:

T

1

C

Spazio degli eventi del

lancio di una moneta

E

2

3

4

5

6

Spazio degli eventi del

lancio di un dado

Ogni elemento dello spazio campionario rappresenta uno dei possibili

esiti (equiprobabili) della prova e si chiama evento elementare.

Eventi come sottoinsiemi

In realtà, un evento generico En può essere formato da più eventi

elementari, se può verificarsi in più modalità diverse; ad esempio,

l’evento E1: “lancio un dado ed esce un numero dispari” si verifica se

lanciando un dado si verifica l’evento elementare 1, oppure 3, oppure 5.

Si chiama evento ogni possibile sottoinsieme dello spazio campionario.

E

E1

1

3

2

5

6

4

3 1

pE1

6 2

La probabilità di questo evento è data dal rapporto tra il numero degli

elementi del sottoinsieme “esce un numero dispari” (casi favorevoli) e

il numero totale degli eventi, o casi, possibili.

Probabilità come funzione matematica

Una definizione più recente della probabilità (definizione assiomatica) afferma che

la probabilità è una funzione che associa a ogni sottoinsieme dello spazio degli

eventi un numero reale compreso tra 0 e 1. Se un evento non può avvenire (evento

impossibile) la sua probabilità è nulla, mentre per un evento certo la probabilità

vale 1. Gli eventi aleatori hanno valori di probabilità compresi tra questi estremi.

Evento impossibile

(provateci…!)

Prima o poi qualcuno fra i giocatori

farà tombola: evento certo

P(E) = 0

P(E) = 1

Definire lo spazio degli eventi

Questo è un punto cruciale per capire la probabilità.

Se lanciamo due dadi, sappiamo che il punteggio ottenuto può andare da

2 a 12; è corretto considerare come eventi elementari i numeri da 2 a 12?

No! Questi risultati non sono equiprobabili, poiché si possono ottenere in

modi diversi, e bisogna tener conto del numero di queste modalità.

Gli eventi elementari sono le 36 possibili coppie diverse

di numeri da 1 a 6; la probabilità del risultato è legata al

numero di coppie che lo generano come somma.

Girolamo Cardano

Galileo Galilei

Algebra della probabilità: somma logica

Consideriamo un evento più complesso, come l’estrazione di “un asso o una figura”

da un mazzo di 40 carte: esso si verifica se si verifica uno dei due eventi E1: “esce

un asso” oppure E2: “esce una figura”.

Si definisce tale evento come somma logica dei due eventi e si indica con E1E2; la

sua probabilità è P(E1E2) = P(E1) + P (E2).

In questo esempio:

4

12

; P(E 2 )

40

40

4 12 16

P(E1 E 2 )

40 40 40

E2

E1

P(E1)

4 assi

Ma… attenzione!

Questo vale solo se gli eventi E1 ed E2 non

possono verificarsi contemporaneamente,

cioè se gli insiemi E1 ed E2 non hanno

elementi in comune. In questo caso si

dicono eventi disgiunti o incompatibili.

12 figure

40 carte totali

Probabilità della somma logica

di eventi incompatibili:

P(E1 E2 ) P(E1) P(E2 )

Somma logica di eventi compatibili

Se gli eventi E1 ed E2 possono verificarsi contemporaneamente, si dicono eventi

compatibili. Ad esempio, l’evento “da un mazzo di 40 carte estraggo una figura o

una carta rossa” è composto dagli eventi compatibili E1: “estraggo una figura” ed

E2: “estraggo una carta rossa”; la carta estratta potrebbe essere una figura rossa.

Ma qual è la probabilità di due eventi compatibili? Quanto vale ora P(E1E2)?

E1 E2

Se applichiamo la formula di

prima, contiamo due volte gli

eventi compatibili (contenuti

sia in E1 che in E2): si evita

questo errore dicendo che gli

eventi favorevoli sono quelli

di E1 più quelli di E2 meno

quelli contenuti in entrambi

gli insiemi, cioè E1E2.

E2

E1

12 figure (di

cui 6 rosse)

6 figure

rosse

20 carte rosse

(di cui 6 figure)

40 carte totali

Probabilità della somma logica di eventi compatibili:

P(E1 E2 ) P(E1) P(E2 ) P(E1 E2 )

Nel nostro esempio, si ha:

12

20

6

P(E1) ; P(E 2 ) ; P(E1 E 2 )

40

40

40

12 20 6 26

P(E1 E 2 )

40 40 40 40

Gli eventi compatibili hanno

una probabilità totale che è

minore della somma delle loro

singole probabilità.

Se non ne tenessimo conto,

potremmo costruire eventi con

probabilità maggiore di uno,

oppure metodi “sicuri” per

vincere al gioco (che ci

farebbero perdere un sacco di

soldi…!)

La probabilità di questo evento

non è 32/40, ma solo 26/40.

E1 E2

E2

E1

12 figure (di

cui 6 rosse)

6 figure

rosse

20 carte rosse

(di cui 6 figure)

40 carte totali

Probabilità della somma logica

di eventi compatibili:

P(E1 E2 ) P(E1) P(E2 ) P(E1 E2 )

Il prodotto logico di eventi

Abbiamo così introdotto il cosiddetto prodotto logico di eventi: è l’evento che si

verifica se si verificano contemporaneamente sia l’evento E1 che l’evento E2; nel

linguaggio degli insiemi (e della logica) si indica con E1E2.

Se il verificarsi di E1 non influenza E2 e viceversa, i due eventi sono

indipendenti e il calcolo di P(E1E2) si riduce al prodotto di P(E1) e P (E2):

P(E1 E2 ) P(E1) P(E2 )

Probabilità del prodotto logico

di eventi indipendenti

Tirando una moneta e un dado la probabilità di avere “croce e un sei” è

1/12, dato che si devono verificare entrambi gli eventi la cui probabilità

è rispettivamente 1/2 e 1/6, e che sono manifestamente indipendenti.

T

1

C

2

3

4

5

E1

E2

P(E1) = 1/2

P(E2) = 1/6

6

1 1 1

P(E1 E 2 )

2 6 12

Eventi dipendenti

Accade spesso che il verificarsi di un evento possa influenzare un secondo evento,

modificandone la probabilità. In tal caso, gli eventi si dicono dipendenti e la

probabilità del loro prodotto logico è diversa da quella degli eventi indipendenti.

Un esempio che aiuta a capire questa differenza è quello dell’estrazione con o

senza reimbussolamento.

Un’urna contiene due palline nere e tre rosse; estraendo successivamente

due palline, qual è la probabilità che entrambe siano rosse?

Se dopo la prima estrazione rimettiamo la pallina nell’urna , la

seconda estrazione avverrà nelle stesse condizioni della prima:

gli eventi sono completamente indipendenti l’uno dall’altro e

la probabilità totale è il prodotto di due valori identici.

P(rossa) = 3/5

3 3 9

P(due rosse)

5 5 25

P(rossa) = 3/5

I due eventi sono indipendenti

Ma se dopo la prima estrazione non rimettiamo la pallina nell’urna, la probabilità

che alla seconda estrazione si ottenga una pallina rossa è diversa: ora l’urna ne

contiene solo quattro, di cui due rosse e due nere, e la probabilità cambia.

P(prima pallina rossa) = 3/5

P(seconda pallina rossa) = 2/4

3 2 3

P(due rosse)

5 4 10

Eventi dipendenti o correlati

Il verificarsi del primo evento influenza la probabilità del secondo evento,

e dunque i due eventi sono dipendenti o correlati.

Il nostro risultato è corretto: lo si può ottenere applicando la definizione classica

di probabilità e il calcolo combinatorio, dividendo il numero dei casi favorevoli

C3,2 per il numero dei casi possibili C5,2.

numero casi favorevoli C3,2 3 2 3

P(due rosse)

numero casi possibili

C5,2 5 4 10

La probabilità condizionata

Il verificarsi di un evento può influenzarne un altro, e dunque la probabilità di

questo secondo evento è condizionata dal verificarsi o meno del primo.

La conoscenza dell’esito del primo evento modifica la probabilità del secondo.

Un esempio: lanciamo un dado per due volte. Qual è la probabilità che

il secondo lancio dia un risultato maggiore del primo?

La tabella a fianco rappresenta

lo spazio degli eventi del

doppio lancio di un dado.

Secondo la definizione classica,

la probabilità cercata è il

rapporto tra i casi favorevoli,

che sono 15, e tutti quelli

possibili, che sono 36. Dunque:

15

P(2 lancio > 1 lancio) =

36

Ora lanciamo il primo dado, e osserviamo

il risultato; supponiamo che sia 2. Qual è

ora la probabilità che il secondo lancio sia

maggiore del primo?

Abbiamo ben quattro risultati favorevoli

su sei possibili, quindi ora la probabilità è

2/3, ben maggiore di 15/36.

Se invece fosse uscito un 5, scommettereste sul verificarsi dell’evento?

Si indica con P (E2 E1) la probabilità dell’evento E2 condizionata a E1,

cioè la probabilità che si verifichi E2 nell’ipotesi che si sia verificato E1.

• E1 = 1 ==> P (E2E1) = 5/6

• E1 = 2 ==> P (E2E1) = 4/6

• E1 = 3 ==> P (E2E1) = 3/6

• E1 = 4 ==> P (E2E1) = 2/6

• E1 = 5 ==> P (E2E1) = 1/6

• E1 = 6 ==> P (E2E1) = 0

Se due eventi sono dipendenti, la conoscenza

dell’esito di uno dei due può aumentare o

ridurre le probabilità dell’altro.

Se queste probabilità aumentano

si dice che i due eventi sono

correlati positivamente, se

invece diminuiscono sono

correlati negativamente.

Vediamo altri esempi:

Se estraiamo due palline dello stesso colore da

questa urna, vinciamo un premio.

Il colore della prima pallina estratta cambia le

nostre probabilità di vincere?

Il gioco del poker è un’applicazione

diretta della probabilità condizionata:

il giocatore valuta, sulla base delle

cinque carte ricevute nella mano

iniziale, la probabilità di ottenere il

punteggio più alto possibile.

Probabilità del prodotto logico

Torniamo al caso dell’estrazione dall’urna a sinistra

di due palline rosse senza reimbussolamento. Sono

due eventi dipendenti, di cui abbiamo già calcolato

la probabilità:

3 2 3

P(due rosse)

5 4 10

Ciò equivale a moltiplicare la probabilità che la prima pallina sia rossa

(evento E1) per la probabilità che la seconda pallina sia rossa (evento E2)

nel caso che alla prima estrazione

si sia verificato E1. In simboli:

P(E 2 E1) P(E1 ) P(E 2 E1)

Probabilità del prodotto logico di eventi dipendenti

o probabilità composta

La formula vale anche per eventi indipendenti: in tal caso P (E2E1) = P(E2)

e dunque ritroviamo la formula P(E1E2) = P(E1) · P (E2).

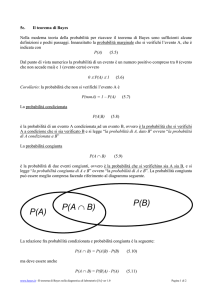

Probabilità condizionata

La formula precedente si può scrivere anche in questo modo:

P(E 2 E1 )

P(E 2 E1)

P(E1 )

Formula della

probabilità

condizionata

In questi termini, essa rappresenta il calcolo della probabilità di un evento E2

condizionata al verificarsi di un evento E1. Vediamo qualche esempio:

E1

E2

1

2

4

3

5 6

La probabilità condizionata riduce

lo spazio degli eventi.

Lanciando un dado, la probabilità

di fare “5 oppure 6” (evento E2) è

1/3. Qual è la probabilità di E2

sapendo che il numero uscito è

maggiore di 3?

1

P(E 2 E1 ) 3 2

P(E 2 E1)

1 3

P(E1 )

2

Abbiamo già visto nell’esempio del lancio di due dadi l’applicazione di questo

fondamentale principio:

La probabilità condizionata riduce

lo spazio degli eventi.

La corretta applicazione della probabilità condizionata può evitare errori

comuni, come l’aspettativa per l’esito di un evento dopo una lunga serie di

eventi contrari: i cosiddetti “ritardi” dei numeri del lotto e di giochi simili.

Lanciando per dieci volte di seguito una moneta non truccata, esce sempre

“croce”. Qual è la probabilità che all’undicesimo lancio esca “testa”?

?

Viene naturale pensare che vi sia un’alta probabilità che esca, finalmente, “testa”.

Ma non è così: la probabilità è ancora 1/2, perché ogni lancio è indipendente dai

precedenti. «La moneta non ricorda», come dicono gli inglesi.

Infatti, noi sappiamo cosa è successo nei lanci precedenti, e ciò che vogliamo

valutare è la probabilità condizionata che esca “testa”, se nei lanci precedenti è

uscita “croce” per dieci volte consecutive. Per semplificare il calcolo, riduciamo

il numero dei lanci a quattro, nei primi tre dei quali sia uscita “croce”.

?

CCCC

CCCT

CCTC

CCTT

CTCC

CTCT

CTTC

CTTT

TCCC

TCCT

TCTC

TCTT

TTCC

TTCT

TTTC

TTTT

Sapere che nei primi tre lanci

è uscita “croce” riduce lo

spazio degli eventi da sedici

a due sole possibilità, una

sola delle quali verifica il

nostro evento.

Possiamo ottenere lo stesso risultato applicando la formula della probabilità

condizionata:

P(E 2 E1 )

P(E 2 E1)

P(E1 )

Chiamiamo C1, C2 e C3 l’uscita di “croce” per i primi tre lanci, e T4

l’evento “testa” al quarto lancio. Vogliamo determinare P (T4C1C2C3):

1

P(T4 C1C2C3 ) 16 1

P(T4 C1C2C3 )

1 2

P(C1C2C3 )

8

Non c’è alcun motivo per puntare sugli eventi “ritardatari”!

Un caso semplice

Lanciamo due monete; una di esse rotola sotto un divano,

mentre nell’altra esce “testa”. Qual è la probabilità che

anche la moneta sotto il divano dia “testa”?

La risposta sembra scontata: i due eventi non possono

influenzarsi, quindi la probabilità dovrebbe essere 1/2.

Ma non è così! Abbiamo lanciato due monete, e questo è lo spazio

campionario dei loro risultati:

In realtà la nostra è una probabilità

condizionata: dunque sapere che una

delle monete ha dato “testa” ci porta

ad escludere l’esito “croce-croce”.

TC

TT

CT

CC

Ora gli esiti possibili sono solo tre, e

uno solo di questi ammette due teste.

La probabilità del nostro evento è 1/3, non 1/2.

Se chiamiamo E1 l’evento “esce testa in una moneta” ed E2 l’evento

“esce testa anche nell’altra moneta”, possiamo calcolare P (E2E1)

utilizzando la formula:

P(E 2 E1 )

P(E 2 E1)

P(E1 )

E1

Poiché:

E2

T T

P(E2E1) = P(T-T) = 1/4

TC

CT

CC

Funziona!

P(E1) = P [(T-T)(T-C)(C-T)] = 3/4

Si ha:

1

P(E 2 E1 ) 4 1

P(E 2 E1)

3 3

P(E1 )

4

Maturità 2010 - Quesito n.7

Per la ricorrenza della festa della mamma, la sig.ra Luisa organizza una cena a

casa sua, con le amiche che hanno almeno una figlia femmina. La sig.ra Anna è

una delle invitate e perciò ha almeno una figlia femmina. Durante la cena, la sig.ra

Anna dichiara di avere esattamente due figli. Si chiede: qual è la probabilità che

anche l’altro figlio della sig.ra Anna sia femmina? Si argomenti la risposta.

FF

FM

MF

MM

Il caso è in tutto identico al

precedente, ed è ancora

un’applicazione della

probabilità condizionata.

Sapere che la sig.ra Anna ha almeno una figlia femmina esclude dallo

spazio degli eventi la possibilità che i suoi due figli siano entrambi

maschi; resta un solo caso favorevole su tre possibili: la probabilità che

anche l’altra figlia sia femmina è 1/3.

Il problema

di Monty Hall

Dal quiz televisivo americano

Let’s Make a Deal, condotto dal

presentatore Monty Hall. 4500

puntate dal 1963 al 1991.

Nel momento culminante della serata, il

concorrente deve scegliere una delle tre

porte chiuse che ha davanti a sé: dietro

a due di esse c’è una capra, dietro

l’altra c’è una macchina. Ovviamente,

né lui né il pubblico sanno dietro a

quale porta si trova l’auto.

A questo punto, il presentatore apre

una delle altre due porte, rivelando

una capra.

Quindi chiede al concorrente se

vuole mantenere la porta scelta,

o se vuole cambiarla.

La domanda è:

al concorrente conviene cambiare?

La risposta sembra ovvia: sono rimaste due porte,

e dietro una di esse c’è l’auto. Cambiare porta

non dovrebbe influenzare le probabilità di vincita

che a questo punto è logico ritenere pari a 1/2,

che si decida di cambiare o meno.

E invece no: conviene cambiare!

Supponiamo di aver scelto proprio la porta dietro alla quale è nascosta la macchina

(ad esempio, la numero 1): è un evento che ha solo una probabilità su tre di

verificarsi.

A questo punto il presentatore, che sa dov’è

la macchina, aprirà a caso una delle altre due

porte, mostrando la capra; poi ci chiede se

vogliamo cambiare la porta scelta

inizialmente.

In questo caso, cambiare porta ci fa

perdere l’auto.

Dunque ho una probabilità su tre di avere

scelta la porta giusta, e in questo caso la

decisione di cambiare mi fa perdere.

Supponiamo invece di aver scelto una porta dietro alla quale c’è una capra: in

questo caso il presentatore deve aprire necessariamente la porta con l’altra capra,

lasciando chiusa la porta con l’auto. Se cambio porta, vinco sicuramente.

Questo caso ha probabilità 2/3

di verificarsi, mentre il caso

precedente ha probabilità 1/3:

dunque se cambio porta vinco

due volte su tre, mentre se

mantengo la scelta vinco solo

una volta su tre.

Considerando lo spazio degli eventi si nota che l’intervento del presentatore

fa aumentare le probabilità di vincita, che da 1/3 passano a 1/2 se si affida al

caso la scelta di cambiare porta, e a 2/3 se si cambia sempre porta: è ancora

un caso di probabilità condizionata.

La probabilità totale

Supponiamo che un evento possa avvenire seguendo modalità diverse. Ad esempio:

L’urna T contiene una pallina rossa e due nere, mentre l’urna C

contiene due palline rosse e tre nere. Si lancia una moneta: se viene

testa si estrae una pallina dall’urna T, se viene croce la si estrae

dall’urna C. Qual è la probabilità che la pallina estratta sia rossa?

Urna T

Urna C

Per rispondere è necessario valutare prima le seguenti probabilità:

P(T) = P (C) = 1/2

P(RT) = 1/3

P(RC) = 2/5

Per calcolare P(R) si può seguire il diagramma detto “albero degli eventi”:

1/2

1/2

1/3

R

P (RT) = P(T) · P(RT) = 1/2 ·1/3 = 1/6

2/3

N

P (NT) = P(T) · P(NT) = 1/2 ·2/3 = 1/3

2/5

R

P (RC) = P(C) · P(RC) = 1/2 ·2/5 =

1/5

3/5

N

T

C

R

P (NC) = P(C) · P(NC) = 1/2 ·3/5 =

3/10

L’evento R è composto dai due eventi RT

ed RC, che sono necessariamente disgiunti.

Dunque:

RT

RC

T

C

P(R) = P(RT) + P(RC)

P(R) = P(T) · P(RT) + P(C) · P(RC)

P(R) = 1/6 + 1/5 = 11/30

Generalizzando, se un evento può avvenire secondo due modalità

diverse A e B, si ha:

P(E) P(A) P(E A) P(B) P(E B)

Generalizzando ancora di più, si può ricavare la formula valida per una qualunque

partizione dello spazio campionario:

Tornando alle due urne precedenti, potremmo porci una domanda diversa:

Se facendo l’esperimento ho ottenuto una pallina rossa, qual è la

probabilità che essa sia stata estratta dall’urna T?

Ci stiamo chiedendo quanto vale P(TR), che non è P(RT).

Il primo a trovare questa risposta è stato Thomas Bayes.

Un reverendo matematico

Thomas Bayes nacque a Londra nel 1701;

studiò logica e teologia all’Università di

Edimburgo e nel 1733 fu ordinato pastore

nella cappella presbiteriana di Tunbridge

Wells, dove visse fino alla morte, nel 1761.

Noto come abile matematico, tanto da

essere accettato nell’esclusiva cerchia

della Royal Society, non pubblicò nella sua

vita alcuno scritto degno di attenzione, ma

alla sua morte lasciò all’amico Richard

Price i suoi manoscritti.

Tra questi, uno studio dal titolo Essay

toward solving a problem in the doctrine

of chance che conteneva alcune idee

nuove, e un teorema sulla probabilità.

Thomas Bayes

(Londra, 1701? - Tunbridge Wells, 1761)

Il teorema di Bayes

Su sollecitazione di Price, lo scritto di Bayes fu pubblicato postumo nel 1764 nella

rivista della Royal Society Phylosophical Transactions. Inizialmente passò quasi

inosservato, ma ben presto matematici e statistici ne apprezzarono il contenuto, fino

alla piena valorizzazione che giungerà pochi anni dopo con Pierre-Simon Laplace.

L’idea centrale di Bayes metteva in relazione le probabilità condizionate

di due eventi correlati A e B, con questa intuizione fondamentale:

P(A B) P(B A)

Non commutatività della

probabilità condizionata

Bayes formulò inoltre un teorema che permette

di quantificare la probabilità che un dato evento

abbia alla sua origine una determinata causa; ad

esempio, nel nostro caso precedente, permette

di calcolare la probabilità che una pallina rossa

sia stata estratta dall’urna T.

Ecco una dimostrazione semplificata del teorema. Partiamo dalla formula della

probabilità condizionata:

P(A B)

P(A B)

P(B)

Dato che la probabilità del prodotto logico tra A e B è la probabilità composta:

P(A B) P(A) P(B A)

Si ha l’espressione del teorema, che si può scrivere indifferentemente:

P(A) P(B A)

P(A B)

P(B)

P(B) P(A B)

P(B A)

P(A)

Teorema di Bayes

In altre parole, se A è una possibile causa dell’evento B, una volta che B si sia

verificato, il teorema di Bayes ci permette di calcolare la probabilità che esso

sia stato generato da A.

Applichiamo questa formula al nostro esempio:

P(T) P(R T)

P(T R)

P(R)

Urna T

Urna C

Dato che, come avevamo calcolato:

P(T) = 1/2;

P(RT) = 1/3;

P(R) = 11/30

Il teorema di Bayes dà:

1 1

1 30 5

2

3

P(T R)

11

6 11 11

30

Probabilità che, nel caso sia

stata estratta una pallina rossa,

essa provenga dall’urna T.

Come si vede, P(TR) è diverso da P(RT).

La probabilità delle cause

Il teorema di Bayes è detto anche teorema della probabilità delle cause, e si

può applicare a moltissime situazioni diverse. Ecco un altro esempio:

Un’azienda ha due linee di produzione: la linea A fornisce il 60% della

produzione giornaliera e il 5% dei suoi prodotti è difettoso; la linea B

produce il restante 40%, con il 3% di pezzi difettosi. Se un pezzo è

difettoso, qual è la probabilità che venga dalla linea A?

Prima di tutto bisogna calcolare la probabilità che il pezzo sia difettoso:

D

P(A) · P(DA) = 0.6 · 0.05 = 0.03

0.05

A

0.6

ND

0.95

0.4

0.03

D

0.97

ND

B

Ora calcoliamo P(AD)

con la formula di Bayes:

P(B) · P(DB) = 0.4 · 0.03 = 0.012

P(D) = 0.03 + 0.012 = 0.042

P(A) P(D A) 0.03

P(A D)

0.715

P(D)

0.042

Altri esempi di applicazione del teorema di Bayes:

• Controllo di qualità

Un’azienda produce lampadine, il 20% delle quali risulta difettoso. La

fabbrica ha un processo di controllo di qualità che elimina il 99.5% delle

lampadine difettose; c’è però una probabilità dello 0.1% che il sistema

elimini anche una lampadina non difettosa. Qual è la probabilità che una

lampadina che non viene eliminata sia difettosa?

Provateci… la risposta è: 0.125%.

• Indagine di mercato

I nuovi giocattoli che una ditta mette sul mercato hanno successo nel 65%

dei casi. In passato, gli esperti di marketing della ditta avevano previsto il

successo di un nuovo gioco nell’80% dei casi, mentre avevano dato un

giudizio positivo al 30% dei giocattoli che non avevano avuto successo.

Qual è la probabilità che un nuovo gioco sul quale il giudizio degli esperti

è positivo abbia effettivamente successo sul mercato?

Risposta: 83.2%.

Ora vediamo alcune applicazioni del teorema in campo medico e giuridico.

Il teorema di Bayes in medicina

Nella diagnostica medica il test ideale è quello

che ha un livello di confidenza del 100%, ovvero

che permette di stabilire con assoluta certezza se

un soggetto è sano, o se è malato. Un test ideale

dà risposte come quella della figura a destra:

I test diagnostici reali hanno un margine di errore non

trascurabile, risultando positivi per alcuni soggetti sani

(falsi positivi) e negativi per alcuni soggetti malati

(falsi negativi), come si vede nella figura a sinistra.

In altre parole, risultare positivo a un dato esame non

significa automaticamente essere malato, e viceversa.

Il teorema di Bayes si addice perfettamente a queste situazioni, nelle quali

è assolutamente importante valutare la probabilità che la causa di un dato

reale e oggettivo (l’esito del test) sia proprio la presenza della malattia.

Consideriamo questo esempio:

Una certa malattia ha una diffusione del 2%; un esame diagnostico

rivela la presenza della malattia nell’80% dei casi (quindi ha il 20% di

falsi negativi), mentre nel 10% dei casi l’esame risulta positivo anche se

il soggetto è sano, ovvero ha un 10% di falsi positivi.

Se il mio esame è positivo, qual è la probabilità che io sia malato?

A questa domanda, quasi tutti i medici rispondono

“l’80% circa”.

Ma la realtà è molto diversa!

L’errore dei medici sta nel confondere la probabilità che

l’esame sia positivo se il paziente è malato, con la

probabilità che il paziente sia malato se il test è positivo.

In altre parole: si sa che P(T+M) = 80%; ma ciò che

mi interessa davvero è P(MT+).

Posso scoprirlo applicando il teorema di Bayes.

Applicando il teorema di Bayes:

P T M P(M)

0.8 0.02

P M T

14%

P(T)

0.8 0.02 0.1 0.98

La probabilità di essere realmente malato, anche se il test è positivo, è molto bassa.

Un altro modo per capire questa situazione è il seguente: vediamo come

si divide un campione di 1000 persone che hanno eseguito il test:

16 (T+M)

20 malati

4 (T-M)

1000

persone

falsi negativi

98 (T+non M) falsi positivi

980 sani

882 (T-non M)

Dunque su queste 1000 persone, 114 (16 + 98) risultano positive al test:

ma solo 16 di queste sono effettivamente malate. La relativa probabilità

risulta solo di 14/116 = 14% circa.

Un cane insegue un gatto; se lo prende, c’è una

probabilità del 90% che lo uccida, ma la probabilità

che lo prenda è solo del 20%. Il gatto però scappa

veloce, e nella sua corsa ha una probabilità del 40%

di morire sotto una macchina.

Se il gatto viene trovato morto, qual è la probabilità

che lo abbia ucciso il cane?

Prima di tutto, dobbiamo calcolare la probabilità che il gatto muoia:

1/5

4/5

9/10

M

1/10

V

2/5

M

3/5

V

P(C) · P(MC) = 1/5 ·9/10 = 9/50

Cattura

Non Cat.

Applichiamo il

teorema di Bayes:

P(NC) · P(MNC) = 4/5 ·2/5 =

8/25

P(M) = 9/50 + 8/25 = 1/2

P(C) P(M C) 9 /50 9

P(C M)

36%

P(M)

1/2 25

Gli errori giudiziari

La storia del diritto offre molti esempi di errata

applicazione della probabilità, che hanno

condotto a veri e propri errori giudiziari.

Ad esempio, nel diritto romano due mezze

prove, o due indizi, equivalevano a una prova.

Nel 1968, in un famoso processo contro Malcolm e Janet

Collins, un consulente matematico dell’accusa convinse la

giuria che la probabilità che la coppia fosse innocente era

1/12000000.

Per giungere a questa stima però aveva moltiplicato tra loro

le singole probabilità di eventi dipendenti: un errore che

costrinse la Corte Suprema ad annullare la sentenza, e a

mettere al bando i matematici dalle aule dei tribunali

americani per molti anni.

L’errore del procuratore

In realtà il teorema di Bayes è oggi accettato nei tribunali, soprattutto per evitare il

cosiddetto errore del procuratore che consiste nel confondere (più o meno

consapevolmente) la probabilità che l’imputato sia colpevole, dati gli indizi a suo

carico, con la probabilità che si ottengano quegli indizi, se l’imputato è colpevole.

Ma Thomas Bayes aveva capito che:

P(C E) P(E C)

C: colpevolezza

E: evidenza, prova

Se sono stato io a mangiare la marmellata, è molto probabile che ne

abbia le mani sporche. Se ho le mani sporche di marmellata,

è altrettanto probabile che sia stato io a mangiarla?

Se ho avvelenato mia suocera, è molto probabile

che poco prima io abbia comprato del veleno;

ma se ho comprato del veleno non è detto che sia

stato io a ucciderla.

Oltre ogni ragionevole dubbio

L’attività giuridica consiste essenzialmente nello stabilire, oltre ogni

ragionevole dubbio, la colpevolezza o l’innocenza di un imputato.

Secondo la logica bayesiana, il tribunale parte da un’ipotesi accusatoria

cha ha una certa probabilità a priori, e valuta il contributo che ogni

indizio, prova o testimonianza apportano a tale ipotesi, fino a giungere a

un valore di probabilità a posteriori tale da poter emettere la sentenza.

Siano date le seguenti definizioni:

P(H): probabilità a priori dell’ipotesi di colpevolezza H.

P(H | E): probabilità a posteriori di H in presenza dell’evidenza E

P(E): probabilità di E indipendente da H

P(E | H): probabilità di ottenere un’evidenza E se H è vera.

Partendo dall’ipotesi accusatoria H, ad ogni nuovo indizio il tribunale valuta la

nuova probabilità a posteriori:

P(H) P(E H)

P(H E)

P(E)

P(EH)/P(E) è detto rapporto di verosimiglianza ed è il contributo, detto

anche forza probatoria, che l’evidenza E porta all’ipotesi accusatoria.

Si pensi a come cambia tale rapporto se, ad esempio, fossi accusato di aver

accoltellato il mio vicino in presenza di queste diverse evidenze E:

E1: porto con me un coltello

E2: porto con me un coltello insanguinato

E3: porto con me un coltello insanguinato

del sangue del mio vicino

I casi giudiziari famosi

Ecco alcuni casi di processi di grande

risonanza in cui sono stati commessi errori

giudiziari riconducibili alla mancata o errata

applicazione del teorema di Bayes:

• Parigi, 1894: il caso Dreyfus

• Los Angeles, 1994: il caso O.J.Simpson

• Londra, 1999: il caso Sally Clark

BIBLIOGRAFIA

• Leonard Mlodinov, La passeggiata dell’ubriaco, Rizzoli, 2009

• Keith Devlin, La lettera di Pascal, Rizzoli, 2008

• K.Devlin e G.Lorden, Il matematico e il detective, Longanesi, 2008

• Brian Everitt, Le leggi del caso, UTET, 2008

• D.Costantini, Regole matematiche del gioco d’azzardo, Muzzio, 2008

Nel web:

• yudkowsky.net/rational/bayes

• www.bayes.it

• www.psicologiagiuridica.com/pub/docs/numero_1/annoxx%202011/

tesina_fondazione_selenia.pdf

• bayesian.org (sito della International Society for Bayesian Analysis)