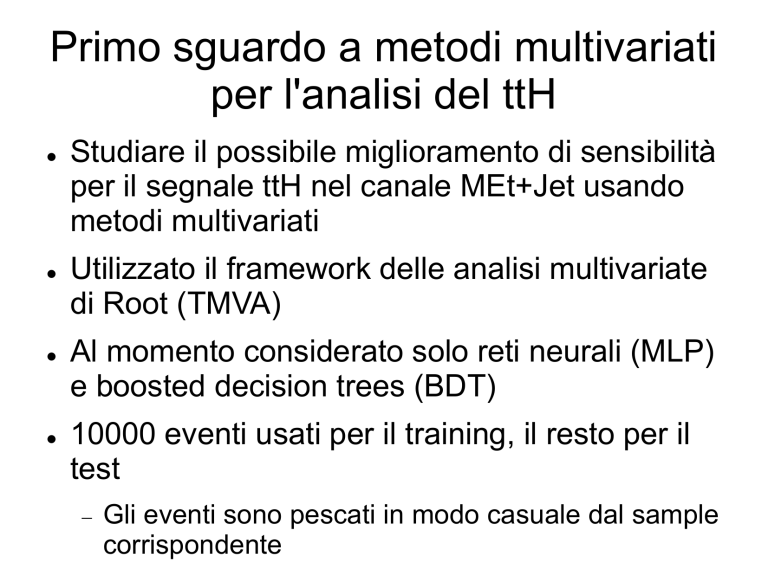

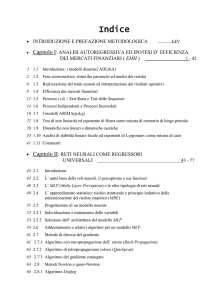

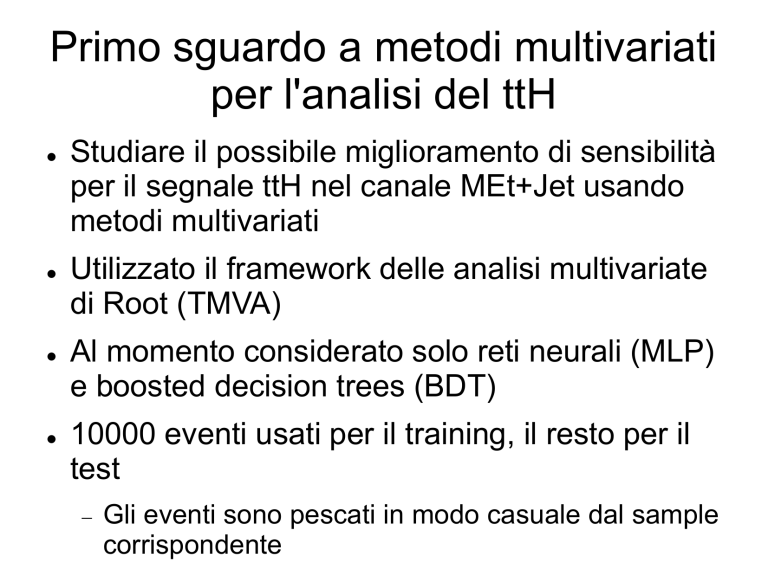

Primo sguardo a metodi multivariati

per l'analisi del ttH

Studiare il possibile miglioramento di sensibilità

per il segnale ttH nel canale MEt+Jet usando

metodi multivariati

Utilizzato il framework delle analisi multivariate

di Root (TMVA)

Al momento considerato solo reti neurali (MLP)

e boosted decision trees (BDT)

10000 eventi usati per il training, il resto per il

test

Gli eventi sono pescati in modo casuale dal sample

corrispondente

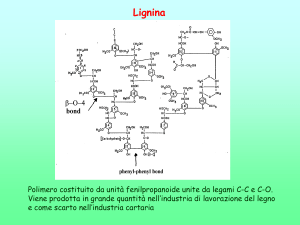

Variabili usate e loro correlazioni

Dopo la selezione di eventi con MEtSig > 3 e

jets(Et>25GeV && |η|<3) >= 5 e niente trigger

ttH

tt+Njets

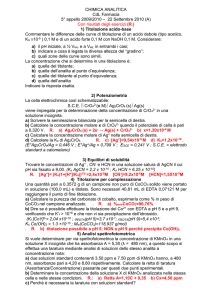

Boosted decision trees

Un decision tree è un

classificatore ad albero binario

in cui decisioni binarie vengono

ripetute su un evento finchè non

si raggiunge una classificazione

(una foglia)

Il boosting consiste nel creare

una foresta di alberi

ad ogni iterazione gli eventi

vengono pesati secondo

l'errore dell'iterazione

precedente

Alla fine viene presa una

decisione democratica usando

tutta la foresta

Classificazione eventi ttH vs tt+Njets

Addestrata una foresta di

400 alberi

Indice di Gini i = p(1-p)

seleziona la decisione

per cui

imother – Σ(idaughter*evfrac)

è massima

nCuts = 20

AdaBoost α = (1-err)/err

Pruning a 4.5 (Cost

Complexity) fatto dopo il

boosting

Risposta

yBDT(x) = Σln(αi)hi(x)

Discriminatore S vs B

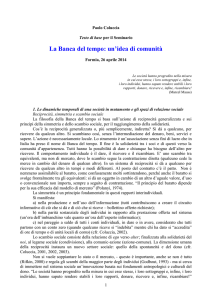

Rete Neurale MLP

Una rete neurale è una

sequenza di neuroni che

rispondono in funzione dell'input

ricevuto

Può essere vista come una

mappa non lineare (se almeno

uno dei neuroni ha funzione di

risposta non lineare) dallo

spazio delle variabili a uno

spazio di arrivo

Si parte da pesi casuali e li si

modifica in modo da

minimizzare l'errore sulla

risposta

Classificazione eventi con MLP

MLP feed-forward

2 strati nascosti, il primo con 26

neuroni e il secondo con 25

Funzione di risposta del

neurone = sigmoide

Addestramento con backpropagation, online

Per ridurre overtraining si

controlla ad ogni iterazione

l'errore sul test sample oltre che

sul training sample

Si ferma quando l'errore sul

campione di controllo è

sotto la soglia fissata

Confronto overtraining

Il BDT è più sensibile a overtraining, bisogna aumentare il

campione di training e aggiustare il pruning

Overtraining del

BDT

Efficienza di segnale vs reiezione

del bakground

Il BDT è migliore per alti valori di efficienza, ma

nella regione con alta reiezione di bakground la

differenza è minore

Rimosse le variabili più correlate

Tenendo le 14 variabili meno correlate non si perde molto

in discriminazione, l'MLP recupera sul BDT

MLP con 2 strati:15,14

Variazioni struttura MLP

Layer dell'MLP:

3 layer: 15-5+5,14-5+5,13-5+5

2 layer: 15-5+5,14-5+5

Modificando la struttura non si guadagna molto

2 Layer

3 Layer

BDT

MLP

To do

Gli eventi di fondo non sono pesati, pesare i diversi tipi in

proporzione alle sezioni d'urto

Confrontare l'aumento di significanza rispetto al metodo di

likelihood già studiato

Ottimizzare il set di

variabili da usare per MLP

e BDT separatamente

Determinare i parametri

(struttura della rete, forza

del pruning per il BDT, ...)

Aggiungere altri metodi, il

SVM sembra promettente

Testare anche il metodo di decorrelazione lineare interno

di TMVA