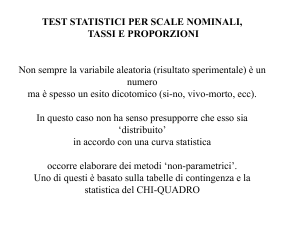

LA REGRESSIONE LOGISTICA

Un’importante area di applicazione dell’analisi di regressione

riguarda il caso in cui la variabile dipendente è una variabile di

tipo qualitativo, ossia dicotomica,nominale o ordinale.

Nelle scienze sociali le variabili dipendenti di questo tipo sono

molto diffuse in quanto rappresentano in modo appropriato

numerosi fenomeni di interesse, ad es. i giovani che conseguono

il diploma decidono se iscriversi o meno all’università,

appartenenza alla forza lavoro (occupazione/disoccupazione).

La differenza essenziale (anche se non unica) tra la regressione

logistica binomiale e la regressione lineare consiste nella natura

della variabile dipendente; nel caso questa sia dicotomica

(oppure dicotomizzata ai fini dell’analisi) non è infatti possibile

ipotizzare una sua distribuzione normale: se Y è dicotomica la

sua distribuzione è binomiale, dunque la sua stima dovrà

variare tra 0 e 1 e non tra - infinito e + infinito come le stime

della regressione lineare.

Lo scopo è descrivere la relazione di dipendenza del possesso di

un attributo dicotomico da una o più variabili indipendenti (X1, X2,

..., Xp)=X, dove:

Y -> dicotomica

(X1, X2, ..., Xp)=X -> dicotomiche, nominali,

ordinali, cardinali.

Nella regressione lineare la variabile che si ipotizza funzione di X è

il valore medio aritmetico della variabile dipendente Y

condizionato ad un dato valore di X: E(Y|x). Si assume una

distribuzione degli errori normale (con media nulla e varianza

costante).

Nel caso la variabile dipendente sia dicotomica il valore medio

condizionato corrisponde a P(Y=1|x): cioè alla probabilità di

possedere l’attributo in esame condizionata al fatto che il vettore

delle variabili indipendenti assuma valore x (indicata con π(x)).

Y = π(x) + ε

da cui

ε=Y - π(x)

L’errore può quindi assumere solo due valori:

Se Y=1

ε=1 - π(x)

Se Y=0

ε= - π(x)

• con media

E (ε ) = [1 − π ( x )]π ( x ) − π ( x )[1 − π ( x )] = 0

• e varianza

V(ε)=[1−π(x)]2π(x)+π(x)2[1−π(x)]=π(x)[1−π(x)]

che dipende da x e dunque non è costante.

Il logit serve a descrivere una funzione che lega la probabilità di Y

alla combinazione delle variabili indipendenti X: la probabilità

infatti ha come limiti 0 e 1 e descrive una figura a S (sigmoide)

che assomiglia alla cumulata della distribuzione casuale degli

errori chiamata “funzione logistica”.

La formula della funzione logistica è la seguente:

𝑒𝑥

𝜋(𝑥 ) =

1 + 𝑒𝑥

Il logit non è l’unica funzione in grado di modellizzare la

probabilità di un fenomeno, ma è privilegiata essendo una

trasformata del rapporto tra due probabilità complementari

(odd).

La stima di Y nella regressione logistica assume il significato di

probabilità che Y sia uguale a 1:

P(Y=1|x)=π(x)

La funzione di regressione logistica é così espressa:

𝑝

𝑙𝑜𝑔𝑖𝑡(𝜋(𝑥 )) = 𝛽0 + ∑ 𝛽𝑗 𝑥𝑗

𝑗=1

Dove logit(π(x)) è il logaritmo naturale del rapporto tra la

probabilità di 1 e la probabilità di 0 dato il vettore (x), cioè la/le

variabili predittive:

𝜋(𝑥)

𝑙𝑜𝑔𝑖𝑡(𝜋(𝑥 )) = 𝑙𝑛 [

]

1 − 𝜋(𝑥)

Dunque è possibile descrivere la funzione di dipendenza della

probabilità π(x) dai valori di X utilizzando una funzione logistica:

𝑒 𝛽0 +𝛽1 𝑥

𝜋(𝑥 ) =

1 + 𝑒𝛽0 +𝛽1 𝑥

Quindi il logit diventa

𝑒 𝛽0 +𝛽1 𝑥

𝛽0 +𝛽1 𝑥

𝜋(𝑥)

1

+

𝑒

𝑙𝑜𝑔𝑖𝑡(𝜋(𝑥 )) = 𝑙𝑛 [

] = 𝑙𝑛 [

]

1 − 𝜋(𝑥)

𝑒𝛽0 +𝛽1 𝑥

1−

1 + 𝑒𝛽0 +𝛽1 𝑥

𝑒 𝛽0 +𝛽1 𝑥

𝛽0 +𝛽1 𝑥

1

+

𝑒

= 𝑙𝑛 [

]

1 + 𝑒𝛽0 +𝛽1 𝑥 − 𝑒 𝛽0 +𝛽1 𝑥

1 + 𝑒𝛽0 +𝛽1 𝑥

𝑒 𝛽0 +𝛽1 𝑥 1 + 𝑒 𝛽0 +𝛽1 𝑥

= 𝑙𝑛 [

] = 𝑙𝑛[𝑒 𝛽0 +𝛽1 𝑥 ]

𝛽

+𝛽

𝑥

1

1+𝑒 0 1

= 𝛽0 + 𝛽1 𝑥

Nel caso si abbia più di una variabile dipendente la funzione è la

stessa:

𝜋(𝑥 ) =

𝑒

𝑝

𝛽0 +∑𝑗=1 𝛽𝑗 𝑥𝑗

𝑝

𝛽0 +∑𝑗=1 𝛽𝑗 𝑥𝑗

1+𝑒

Una volta stimati i parametri è possibile ricavare la probabilità

che Y sia 1 per ogni valore assunto dall’insieme delle variabili

indipendenti.

Le variabili indipendenti

X dicotomica: β misura la variazione del logit dovuta al possesso

della proprietà descritta dalla variabile indipendente;

X categoriale/ordinale: è possibile ricondurre le k modalità di X a

k-1 variabili dummy, selezionando una delle modalità come

gruppo di riferimento (considerandola cioè come lo 0 delle

dicotomiche) quindi è possibile calcolare l’odds ratio di ogni

gruppo rispetto a quello di riferimento ed è pari a eβ1,i;

X continua: l’odds ratio corrispondente ad un incremento unitario

di X è pari a eβi;

𝜋(1)

𝑜𝑑𝑑𝑠 𝑟𝑎𝑡𝑖𝑜 = 1−𝜋(1)⁄ 𝜋(0) =

1−𝜋(0)

𝑒 𝛽1

𝑒𝛽0 +𝛽1

1+𝑒𝛽0 +𝛽1

1

1+𝑒𝛽0 +𝛽1

⁄𝑒𝛽0 = 𝑒 𝛽0 +𝛽1 /𝑒 𝛽0 =

1+𝑒𝛽0

1

1+𝑒𝛽0

ESEMPIO DI ODDS

Gli odds si utilizzano nel mondo delle scommesse perché

consentono allo scommettitore di calcolare facilmente la somma

da incassare in caso di vittoria.

Per esempio si ipotizzi che le probabilità di vittoria per una

squadra di calcio al campionato italiano siano date dal

bookmaker 4:1 “a sfavore”.

Questo equivale a dire che la probabilità di sconfitta (π) della

squadra sono state considerate quattro volte più alte di quelle di

una sua vittoria pari a (1-π).

Quindi la vittoria della squadra è da pagare 4 volte la cifra

scommessa.

Gli odds si possono trasformare in probabilità: la squadra

considerata ha una 1 probabilità su 5 di vincere (p=0,2) e 4

probabilità su 5 su perdere (1-p=0,8).

INTERPRETAZIONE DEI PARAMETRI DEL MODELLO

1. Se non sussiste nessuna relazione tra la variabile esplicativa

Xj e la probabilità che la variabile risposta Y assuma valore 1

il valore dell’odds ratio è pari a 1 da cui βj = 0.

2. Valori dell’odds ratio maggiori di 1 – a cui corrispondono

valori del parametro βj maggiori di zero – indicano un

effetto positivo della variabile esplicativa sulla probabilità

che la variabile risposta Y assuma il valore 1.

3. Valori dell’odds ratio compresi tra 0 e 1 – a cui

corrispondono valori del parametro βj minori di zero –

indicano un effetto negativo della variabile esplicativa sulla

probabilità che la variabile risposta Y assuma il valore 1.

4. L’esistenza di tale asimmetria (nei valori degli odds ratio)

richiede cautela quando si confrontano OR caratterizzati da

segno diverso. Ad esempio, un OR pari a due ha esattamente

la stessa intensità di un OR “negativo” pari a 0,5.

5. i valori di Exp(β) non possono essere confrontati calcolando

delle differenze, ma è necessario fare riferimento a dei

rapporti.

ESEMPIO DI STIMA DI ODDS RATIO

Si ipotizzi di effettuare un’analisi di regressione logistica che

modelli la probabilità di progresso nella conoscenza

dell’inglese (Y=1, progresso) in funzione dell’esposizione ad un

nuovo metodo di studio (X=1, esposizione) ottenendo una

stima del relativo parametro β pari a 2.

Tale risultato indica un effetto positivo dell’esposizione al

nuovo metodo sull’apprendimento della lingua straniera, che si

traduce in una maggiore probabilità di osservare un progresso

nella conoscenza della lingua in caso di esposizione al nuovo

metodo.

Tale maggiore probabilità può essere meglio quantificata

tramite la stima dell’odds ratio corrispondente al passaggio

dallo stato 0 allo stato 1 della variabile X, dato exp(β) = exp(2) =

7,4.

Dalla stima dell’OR si deduce che la frequenza relativa di coloro

che hanno progredito nella conoscenza della lingua è oltre 7

volte superiore nel gruppo degli esposti al nuovo metodo

rispetto al gruppo dei non esposti.

COME SI STIMANO I PARAMETRI ?

La stima dei parametri ignoti β non può essere effettuata con il

metodo dei minimi quadrati dato che non vale

l’omoschedasticità dei residui.

La stima si effettua con il metodo della massima

verosimiglianza che si basa sulla probabilità di osservare

l’insieme di dati osservato in funzione di β.

La funzione di verosimiglianza L si ottiene invertendo i ruoli di

X e Y; ovvero interpretando Y come l'informazione nota (cioè il

punto di vista della stima):

𝑛

𝑛

𝐿(𝛽0 , 𝛽1 ) = ∏ 𝑓(𝑦𝑖 |𝑥𝑖 ) = ∏ 𝜋(𝑥𝑖 )𝑦𝑖 [1 − 𝜋(𝑥𝑖) ]

𝑖=1

(1−𝑦𝑖 )

𝑖=1

Per ottenere la stima della massima verosimiglianza dei

parametri si determina il valore di β che massimizza il

logaritmo di L(β) (detto log-verosimiglianza). L’individuazione

dei parametri non è immediata, ma richiede l’applicazione di

calcoli iterativi fino alla massimizzazione della verosimiglianza.

In pratica cerchiamo di trovare i valori dei parametri che

possono aver prodotto con la maggiore i dati osservati

PROBLEMI DI CALCOLO NELLE STIME

Alcune caratteristiche dei dati in analisi possono creare dei

problemi nel calcolo delle stime dei parametri. In particolare ci

sono problemi di questo tipo se:

• l’errore standard dei parametri risulta eccessivo rispetto al

valore dei parametri stimati

• le stime di β aumentano rapidamente all’aumentare delle

iterazioni necessarie per la stima.

Ci possono essere problemi se:

1. Una frequenza è nulla (cioè se c’è una cella vuota

nell’ipotetica tabella di contingenza tra tutte le variabili

inserite nell’analisi);

2. L’insieme delle variabili indipendenti discrimina

perfettamente il gruppo di unità per cui Y=0 da quello per

cui Y=1;

3. Le variabili esplicative sono collineari (ossia almeno una di

loro è esprimibile come funzione lineare delle altre.

INFERENZA NEL MODELLO DI REGRESSIONE LOGISTICA –

BONTA’ DEL MODELLO NEL SUO COMPLESSO

Per verificare la significatività di un modello nel suo complesso

si calcola la differenza G – detta extradevianza- tra la devianza

del modello avente la sola intercetta e la devianza del modello

in esame, basata sul rapporto di verosimiglianza, secondo la

seguente espressione:

G = D(modello intercetta)-D(modello completo) =

𝐿(0)

𝐿(𝛽)

Dove L(0) rappresenta la massima verosimiglianza in

corrispondenza del modello con la sola intercetta, mentre L(β)

rappresenta la massima verosimiglianza in corrispondenza del

modello completo.

La verifica della bontà di un modello sulla base del rapporto di

verosimiglianza (Likeihood Ratio) si fonda sull’idea che se le

variabili considerate aggiungono molta informazione al

modello con la sola intercetta, la verosimiglianza relativa al

modello completo L(β) sarà molto maggiore di quella che si

ottiene considerando il modello con la sola intercetta L(0). In

tal caso il rapporto di verosimiglianza tende ad assumere valori

molto piccoli, anche prossimi allo zero.

−2𝑙𝑜𝑔

INFERENZA NEL MODELLO DI REGRESSIONE LOGISTICA-BONTA’

DEL MODELLO NEL SUO COMPLESSO

Attraverso la statistica G, basata sul rapporto di

verosimiglianza, si sottopone a verifica il seguente sistema di

ipotesi:

𝐻0 : = 𝛽1 = 𝛽2 = ⋯ = 𝛽𝑘 = 0

𝐻1 : 𝑎𝑙𝑚𝑒𝑛𝑜 𝑢𝑛 𝛽𝑗 ≠ 0

dove j=1,2,…k

Si può dimostrare che sotto l’ipotesi nulla G si distribuisce

come un X2 con k-1 gradi di libertà. Pertanto si respinge

l’ipotesi nulla se si verifica che

2

𝐺 > 𝑋𝑘−1,𝛼/2

E’ desiderabile che il valore G sia elevato, il che sta a significare

che le variabili esplicative introducono una quantità

significativa di informazione rispetto alla sola intercetta.

Per la valutazione della bontà di adattamento del modello di

regressione logistica ai dati si può ricorrere ad una misura

analoga al coefficiente di determinazione multiplo. Cox e Snell

(1989) hanno proposto la seguente generalizzazione del

coeffciente di determinazione per modelli non lineari chiamato

Pseudo R2:

𝑅𝑔2

𝐿(0)

=1−[

]

𝐿(𝛽)

2

𝑛

dove L(0) e L(β) rappresentano rispettivamente la massima

verosimiglianza in corrispondenza del modello con la sola

intercetta e la massima verosimiglianza in corrispondenza del

modello considerato, dove n è la numerosità delle

osservazioni.

Il coefficiente di determinazione può variare tra 0,

corrispondente alla situazione in cui il modello considerato non

aggiunge informazione al modello con la sola intercetta per cui

vale L(β) = L(0), e il suo valore massimo che è

2

𝑅𝑔,𝑀𝐴𝑋

= 1 − (𝐿(0)

2

𝑛

Poiché R2g,max è minore di 1, per poter disporre di una misura

che varia tra 0 e 1, dove zero rappresenta assenza di

adattamento e 1 adattamento massimo del modello ai dati si

può far riferimento al coefficiente riscalato (Nagelkerke, 1991):

̅̅̅

𝑅𝑔2̅ =

2

𝑅𝑔

2

𝑅𝑔,𝑚𝑎𝑥

CONFRONTO TRA DUE MODELLI COMPARABILI

Una procedura analoga può essere utilizzata per confrontare i

modelli annidati:

modello completo k-1 variabili esplicative

modello ridotto

le ultime s variabili del modello completo

sono escluse (totale variabili k-s-1).

Si calcola quindi l’extradevianza Gs che misura la differenza tra

la devianza del modello ridotto e quella del modello completo.

Si può dimostrare che sotto ipotesi nulla Gs si distribuisce come

un X2 con s gradi di libertà, pertanto si respinge l’ipotesi nulla

se si verifica che

2

𝐺𝑠 > 𝑋𝑠,𝛼/2

SIGNIFICATIVITA’ PER OGNI SINGOLO PARAMETRO

Per verificare la significatività della stima bj del j-esimo

parametro del modello si fa ricorso generalmente al test di

Wald, nel caso uni variato dato da

𝑏𝑗

𝑊 = 𝑠(𝑏

𝑗)

Sulla base dell’ipotesi nulla del seguente sistema di ipotesi

𝐻0 : 𝛽𝑗 = 0

𝐻1 = 𝛽𝑗 ≠ 0

W si distribuisce come una distribuzione normale

standardizzata.

Se nell’esecuzione del test si verifica che

|𝑊 | > 𝑧𝛼/2

si respinge l’ipotesi nulla e si conclude che il parametro è

significativamente diverso da 0, ovvero la variabile esplicativa

corrispondente influisce sulla variabile risposta.

VALUTARE LA BONTA’ DELLA CLASSIFICAZIONE

Una volta stimati i parametri del modello logistico,

disponiamo anche di un metodo di classificazione.

Questo significa che, una volta noti i valori delle variabili

esplicative X1,…, Xp che caratterizzano un individuo

disponiamo di una regola per assegnarlo ad una delle due

classi che stiamo studiando.

Il criterio di classificazione si costruisce semplicemente

scegliendo una soglia h per la probabilità stimata π* ed

assegnando un individuo al gruppo definito da Y>1 se π*>h,

ed al gruppo definito da Y=0 altrimenti.

La soglia più “neutra” è h=1/2.

Per valutare il metodo di classificazione di solito si procede

così:

1. Gli individui disponibili (per i quali conosciamo già la

classe di appartenenza) vengono divisi in due insiemi (A e

B).

2. L’insieme A viene usato per stimare il modello di

regressione logistica e costruire quindi la regola di

classificazione.

3. Gli individui appartenenti all’insieme B (che non sono stati

usati nella stima) vengono classificati sulla base di tale

regola.

4. Le classificazioni così ottenute (per gli individui di B)

vengono confrontate con le reali classi di appartenenza. Il

metodo è buono se commette “pochi” errori di

classificazione.

In questo modo al punto 3 si sta facendo una vera e propria

previsione, in quanto i dati nell’insieme B possono essere

considerati come “nuovi” rispetto a quelli usati per stimare il

modello.

Se usassimo i dati dell’insieme B sia per costruire la regola che

per valutarla staremmo barando a nostro favore: la stessa

definizione della regola terrebbe già conto della classe di

appartenenza degli individui in B.

LA MATRICE DI CONFUSIONE

La procedura appena vista ci permette di costruire una tabella

che viene chiamata “matrice di confusione”.

Previsione

0

1

totale

Osservazione

0

1

n11

n12

n21

n22

n.1

n.2

totale

n1.

n2.

n

Si ricordi che gli individui per i quali si verifica l’evento

presentano Y=1, mentre gli altri presentano Y=0. Gli individui per i

quali viene previsto Y*=1, invece, sono quelli che presentano una

probabilità prevista π* al di sopra di una certa soglia h; per gli

altri viene previsto Y*=0.

I valori sulla diagonale principale si riferiscono alle previsioni

corrette. Più precisamente n11 (n22) indica il numero di individui

per i quali non si verifica (si verifica) l’evento, che vengono

correttamente previsti come tali.

I valori sulla diagonale secondaria si riferiscono a previsioni

sbagliate. In particolare n21 indica il numero di individui per i

quali l’evento non si verifica, ma viene previsto che si verifichi

(falsi positivi). Al contrario n12 indica il numero di individui per i

quali l’evento si verifica, ma viene previsto che non si verifichi (

falsi negativi).

Si noti che se la suddivisione degli individui tra gli insiemi A e B è

casuale, anche la matrice di confusione e le misure di bontà che

ne derivano sono casuali. Si preume, tuttavia, che una ripetizione

dell’esperimento che porta ad una diversa suddivisione tra A e B

non fornisca valutazioni molto diverse sulla bontà del metodo di

classificazione.

La più ovvia misura della bontà è data dalla frazione di individui

classificati correttamente

𝑛11 + 𝑛22

𝑛

Questa misura varia tra 0 e 1 e ci aspettiamo che sia alta per un

buon metodo di classificazione.

𝑓𝑐 =

Una misura equivalente è data da 1-fc, che ovviamente ci

aspettiamo sia piccola per un buon metodo di classificazione.

Le misure appena viste mettono sullo stesso piano i due tipi di

errori che possono essere commessi poiché spesso i due errori

non hanno la stessa importanza.

Nelle valutazioni sulla bontà della classificazione allora è

opportuno tener conto di cosa succede dando pesi diversi ai falsi

positivi e ai falsi negativi.

Un modo per ottenere l’obiettivo appena visto consiste nel

considerare le classificazioni risultanti per diversi valori di h.

Per valori di h piccoli , infatti, vi saranno molti falsi positivi e pochi

falsi negativi. Il caso limite è costituito dalla scelta h=0 in seguito

alla quale per tutti gli individui viene previsto un valore Y*=1 e

quindi non vi sono falsi negativi ma solo falsi positivi.

La situazione opposta si verifica per valori di h grandi: vi saranno

molti falsi negativi e pochi falsi positivi. In questo caso la

situazione limite si verifica per h=1, quando per tutti gli individui

viene previsto un valore Y*=0 e quindi non vi sono falsi positivi

ma solo falsi negativi.

LA CURVA ROC

Lo strumento formale che ci permette di valutare il metodo di

classificazione per diversi valori di h si chiama curva ROC

(Receiver Operating Characteristic). Per definirla abbiamo

bisogno dei concetti si sensibilità e specificità.

Si dice sensibilità la proporzione di previsti positivi rispetto al

numero di positivi effettivi. Questa quantità viene stimata da

𝑛22

𝑛12 +𝑛22

Si dice specificità la proporzione di proporzione di previsti

negativi rispetto al numero di negativi effettivi. Questa quantità

viene stimata da

𝑛11

𝑛11 + 𝑛21

La sensibilità è = 1 – Frazione dei falsi negativi

La specificità è = 1 – Frazione dei falsi positivi

LA CURVA ROC-SENSIBILITA’ E SPECIFICITA’

Poiché i valori nlm (l,m=1,2) sono tutti non negativi, sensibilità e

specificità variano tra 0 e 1.

Il metodo di classificazione è tanto migliore quanto più i valori di

sensibilità e specificità si avvicinano ad 1. Infatti se fossero

entrambi pari a 1, questo significherebbe che n12 e n21 =0, ossia il

metodo non commette errori. Al contrario, se fossero entrambe

zero, questo significherebbe che n11 e n22 =0, ossia il metodo non

fa mai la cosa giusta.

Si noti anche che sensibilità e specificità dipendono dai valori nlm

nella matrice di confusione, che a loro volta dipendono dalla

soglia h per la probabilità stimata π*.

Ne segue che facendo variare h otteniamo diversi valori di

sensibilità e specificità.

La curva ROC è costruita unendo i punti di coordinate (1specificità, sensibilità) ottenuti per tutti i possibili valori di h.

Per quanto discusso in precedenza, sappiamo che un metodo di

classificazione perfetto fornirebbe, nel grafico della curva ROC,

un punto di coordinate (0,1). Questo infatti significherebbe che

sensibilità e specificità sono entrambe pari ad 1.

Si può dimostrare che un metodo di classificazione che assegna

gli individui in maniera del tutto casuale (ossia senza nessuna

guida, ignorando completamente i valori delle variabili

esplicative) produrrebbe una curva ROC sovrapposta alla

bisettrice.

Ne segue che un metodo di classificazione è buono se fornisce

una curva ROC che cresce molto rapidamente, per poi assestarsi

su valor prossimi ad 1.

Per avere un valore singolo, invece di una curva, che permetta di

valutare la bontà di un metodo di classificazione si usa l’area

sottostante alla curva ROC. In inglese si usa l’acronimo Area

Under the Curve (AUC).

Un valore di AUC pari a 0,5 indica un metodo che compie la

classificazione completamente a caso. Il metodo è tanto migliore

quanto più l’AUC si avvicina ad 1. Il valore 1 indica la

classificazione perfetta.

STIME DI MODELLI DI REGRESSIONE LOGISTICA

Una ricerca di mercato si propone di stimare la probabilità di

acquisto di un particolare snack alimentare sulla base di un

insieme di variabili esplicative raccolte attraverso un’indagine

campionaria che ha coinvolto 32 giovani di età compresa tra 12 e

29 anni.

La ricerca ha rilevato, insieme ad altre variabili di seguito

illustrate, l’acquisto da parte del rispondente di almeno uno

snack nel corso dell’ultimo mese. Nella codifica di tale variabile è

stato attribuito il valore 1 nel caso in cui il rispondente ha

dichiarato di avere acquistato almeno uno snack nel corso

dell’ultimo mese e 0 altrimenti.

Le altre variabili rilevate sono le seguenti

- Numero medio mensile di snack consumati (n_pezzi_medio)

calcolato sulla base degli acquisti effettuati negli ultimi 6

mesi.

- Età del rispondente.

- Esposizione alla pubblicità relativa al prodotto in questione

(tale variabile, di tipo dummy, assume valore 1 nel caso in

cui il rispondente dichiari di aver visto almeno una volta alla

televisione lo spot pubblicitario del prodotto in questione; 0

altrimenti.

FORMA DEL DATASET

Obs

N_pezzi_med

1

2,66

2

2,89

3

3,28

4

2,92

5

4

6

2,86

Età

20

22

24

12

21

17

Espos_pubb

0

0

0

0

0

0

Acquisto

ESEMPIO DI STIMA DI UN MODELLO DI REGRESSIONE LOGISTICA

Iteration 0 :

Iteration 1 :

Iteration 2 :

Iteration 3 :

Iteration 4 :

Iteration 5:

log likelihood=

log likelihood=

log likelihood=

log likelihood=

log likelihood=

log likelihood=

Number of obs =

32

LR chi2(3)

= 15,40

Prob>chi2

= 0,0015

Pseudo R2

= 0,3740

-20,59173

-13,496795

-12,929188

-12,889941

-12,889633

-12,889633

0

0

0

0

1

0

Acquisto Coef.

St. err

N_pezzi 2,8261 1,2629

Età 0,0951 0,1415

Espos_pu 2,3787 1,0646

Constant -13,021 4,9313

Variabile

N_pezzi_medio

Età

Espos_pubb

z

Prob>z 95%Conf. Interv.

2,24

0,025 0,3508 5,3014

0,67

0,501 -0,1822 0,3726

2,23

0,025 0,2922 4,4652

-2,64

0,008 -22,687 -3,356

Odds Ratio

16,88

1,10

10,79

Dopo aver stimato il modello, possibile calcolare per ogni

osservazione

campionaria

la

“probabilità

prevista”

(corrispondente in questo specifico caso alla probabilità di

acquistare uno snack) dati i valori assunti dalle variabili

indipendenti (chiamiamo la nuova variabile pr_for). Le statistiche

di sintesi sono riportate nella seguente tabella

Variable

Pr_for

Obs

32

Mean

Std. Dev.

0,34375 0,31690

Min

0,02447

Max

0,94534

E’ anche possibile allo stesso tempo computare, sempre sulla

base della relazione stimata, la probabilità di avere un successo e

quindi la P(Y=1|x) quando le variabili indipendenti assumono

particolari e specifici valori.

Ad esempio se il vettore x assume valori

N_pezzi_medio = 3,1171875

Età = 21,9375

Espos_pubb = 0

P(Y=1|x3=0) = 0,1068

P(Y=0|x3=0) = 0,8932

Se invece assumiamo che x3 = 1 le probabilità sono le seguenti

P(Y=1|x3=1) = 0,5633

P(Y=0|x3=1) = 0,4367

ESEMPIO 2

Supponiamo che un’azienda Gamma sia interessata a valutare

l’efficacia che ha avuto uno spot pubblicitario su un suo prodotto

lanciato sul mercato. Per questo motivo progetta un’indagine ad

hoc. Una volta raccolti i dati il nostro problema quindi consiste

nel regredire una variabile dicotomica (acquisto/non acquisto) su

un’altra variabile dicotomica che indicizza la visione della

pubblicità del prodotto.

Supponiamo di regredire la variabile dicotomica y (acquisto, sì=1,

no=0) sul regressore x che indica se il cliente ha visto lo spot o

meno (visto spot=1, non visto spot=0). Otteniamo i seguenti

risultati:

Variabile

Intercetta

Spot

Coeff.

Std. Dev.

z value

Prob>z

-0,9694

0,3441

-2,738

0,00619

0,9027

0,4383

2,059

0,03945

Commenti

- La pubblicità influenza significativamente la probabilità di

acquistare il prodotto; l’ipotesi nulla è rifiutata al livello di

significatività del 5%. Quindi la visione dello spot ha

un’influenza significativa sulle vendite.

- Il segno del coefficiente beta e questo è conforme alle

attese.

Quale è l’effetto marginale della pubblicità sulla probabilità di

acquistare?

Per calcolare direttamente la probabilità stimata di acquisto

𝑃(𝑌𝑖 = 1|𝑥) =

exp(−0,9694 + 0,9027𝑥)

1 + exp(−0,9694 + 0,9027𝑥

exp(−0,9694 + 0,9027)

𝑃(𝑌𝑖 = 1|𝑥 = 1) =

= 0,4839

1 + exp(−0,9694 + 0,9027)

𝑃(𝑌𝑖 = 1|𝑥 = 0) =

exp(−0,9694)

= 0,2750

1 + exp(−0,9694)

Poiché x è una variabile dicotomica il suo effetto marginale è

calcolabile come

𝑃(𝑌𝑖 = 1|𝑥 = 1) − 𝑃(𝑌𝑖 = 1|𝑥 = 0) = 0,4839 − 0,2750

= 0,2089

Per costruire un intervallo di confidenza al livello basta

applicare la formula (abbiamo scelto il 95%)

IC(95%) = (0,9027±1,96 x 0,4383).

Vogliamo comprendere l’effetto che ha x sulla propensione

all’acquisto, ragionando in termini di Odds Ratio.

Passo 1. Riscriviamo il predittore lineare per il nostro esempio:

logit (πi) = -0,9694+0,9027x

Passo 2. Calcoliamo l’odds associato ad x

𝜋𝑖

𝑃(𝑌𝑖 = 1|𝑥)

=

= exp(−0,9694 + 0,9027𝑥)

1 − 𝜋𝑖

1 − 𝑃(𝑌𝑖 = 1|𝑥)

Passo 3. Calcoliamo l’odds per i due valori che assume x

Per x = 1

𝑃(𝑌𝑖 = 1|𝑥 = 1)

= exp(−0,9694 + 0,9027) = 0,9361

1 − 𝑃(𝑌𝑖 = 1|𝑥 = 1)

Per x = 0

𝑃(𝑌𝑖 = 1|𝑥 = 0)

= exp(−0,9694) = 0,3795

1 − 𝑃(𝑌𝑖 = 1|𝑥 = 0)

L’Odds Ratio è il rapporto tra i due odds appena calcolati

OR = 0,9361/0,3795 = 2,46 =

𝑃(𝑌𝑖 = 1|𝑥 = 1)

1 − 𝑃(𝑌𝑖 = 1|𝑥 = 1)

= exp(0,9027)

𝑃(𝑌𝑖 = 1|𝑥 = 0)

1 − 𝑃(𝑌𝑖 = 1|𝑥 = 0)

Quindi la propensione all’acquisto è circa due volte e mezzo più

grande se si è visto lo spot. Notare che senza fare i calcoli

potevamo direttamente utilizzare exp().

Per costruire l’intervallo di confidenza per gli OR basta fare

l’esponente della formula vista in precedenza

IC(OR 95%) = exp(0,9027±1,96 x 0,4383) = (0,96; 5,83).

In conclusione il manager dell’azienda Gamma decide di investire

ancora in pubblicità perché la propensione all’acquisto dei clienti

che hanno visto la pubblicità è maggiore.

ESEMPIO 3

L’ufficio marketing di un’impresa assicurativa che stipula polizze

sulla vita vuole aumentare il suo volume di attività. Per questo

motivo predispone uno studio tra i propri clienti per capire quali

fattori influiscano sul rinnovo della polizza.

- Variabile dipendente RINNOVO = y =(1 se sì, 0 se no)

- x1 età del cliente

- x2 reddito del cliente

- x3 collocazione dell’ufficio in cui il cliente si serve (1 in

centro, 0 altrimenti).

Risultati della stima

1stime

Std. Err.

intercetta -8,4349

0,0854

x1

0,0223

0,0004

x2

0,0743

0,0019

x3

0,8237

0,0186

X2

9760,72

2967,84

1529,00

1862,48

p-value

‹0,0001

‹0,0001

‹0,0001

‹0,0001

OR

1,023

1,077

2,279

Fissati i valori delle variabili x1 e x2, l’OR per la variabile x3 è dato

da:

𝑂𝑅𝑥3 =

𝑜𝑑𝑑𝑠(𝑥3 = 1; 𝑥1 = 𝑐𝑜𝑠𝑡𝑎𝑛𝑡𝑒; 𝑥2 = 𝑐𝑜𝑠𝑡𝑎𝑛𝑡𝑒)

1 − 𝑜𝑑𝑑𝑠(𝑥3 = 0; 𝑥1 = 𝑐𝑜𝑠𝑡𝑎𝑛𝑡𝑒; 𝑥2 = 𝑐𝑜𝑠𝑡𝑎𝑛𝑡𝑒)

= exp(0,8237)

Questo significa che un individuo che si serve in un ufficio in

centro ha una propensione a rinnovare la polizza 2,3 volte più

grande rispetto a chi si serve altrove, mantenendo costanti le

altre variabili.

La stima del coefficiente della variabile x1 è 0,0223. Ciò vuol dire

che per un incremento di una unità della variabile età del cliente

(ad esempio da 58 a 59 anni) ci aspettiamo un incremento in

logodds di 0,0223. Per un incremento di 5 unità della variabile età

del cliente ci aspettiamo un aumento in logodds di 5*0,0223. In

altre parole l’odds ratio associato ad incrementi di 5 anni è

exp(5*0,0223). Considerato l’incremento di un anno abbiamo

OR𝑥1 = exp(0,0223)=1,023 che indica che per ogni anno in pù del

cliente ci aspettiamo un incremento nell’odds pari al 2,3%

mantenendo fisse le altre variabili.

Un ragionamento analogo lo possiamo fare per l’altra variabile

continua del modello.

Supponiamo ora di voler stimare quale sia la probabilità di

rinnovare la polizza se il cliente ha 58 anni ed ha un reddito pari a

50 (migliaia di euro) e si serve di un ufficio non in centro

P(y=1|x1=58, x2=50, x3=0)

exp(−8,43 + 0,0223 ∗ 58 + 0,074 ∗ 50 + 0,82 ∗ 0)

1 + exp(−8,43 + 0,0223 ∗ 58 + 0,074 ∗ 50 + 0,82 ∗ 0)

exp(−3,347)

0,0352

=

=

= 0,034

1 + exp(−3,347) 1,0352

Quale è l’effetto marginale di x3 sulla probabilità di rinnovo della

polizza

P(y=1|x1=58, x2=50, x3=1)-P(y=1|x1=58, x2=50, x3=0)

P(y=1|x1=58, x2=50, x3=1) =

exp(−8,43 + 0,0223 ∗ 58 + 0,074 ∗ 50 + 0,82 ∗ 1)

1 + exp(−8,43 + 0,0223 ∗ 58 + 0,074 ∗ 50 + 0,82 ∗ 1)

exp(−2,527)

0,0799

=

=

= 0,074

1 + exp(−2,527) 1,0799

L’effetto marginale quindi è dato da 0,074-0,034 = 0,040.

EFFETTO MARGINALE DI UNA VARIABILE CONTINUA

Con riferimento al modello espresso in termini di probabilità, per

valutare l’effetto sulla probabilità di successo della variazione di

una covariata continua, ad esempio xj, si ricorre a

𝜕𝜋𝑖

𝜕𝑃(𝑌𝑖 = 1|𝑥𝑖 )

exp(𝑥 ′ 𝛽)

=

= 𝛽𝑗

𝜕𝑥𝑖𝑗

𝜕𝑥𝑖𝑗

(1 + exp(𝑥 ′ 𝛽))2

Quindi l’effetto sulla probabilità di successo della variazione di

una delle covariate:

- dipende dal valore assunto da tutte le covariate

- coincide con il segno del coefficiente

Può essere interessante valutare tale variazione in

corrispondenza di particolari valori delle covariate (spesso si

sceglie a tale scopo il vettore dei valori medi).

Con riferimento all’esempio precedente, l’effetto marginale della

variabile reddito per i valori età di 58 anni, reddito di 50.000 euro

ed ufficio in centro:

0,074 * (0,0799/(1,0799)2) =0,005