SEZIONE 3

ESPERIMENTI E MODELLI CONTRO LA FISICA CLASSICA

1. La scoperta del “quanto d’azione”

Come è stato detto, la meccanica statistica classica si basa sui concetti di funzione di distribuzione e di probabilità di

stato del sistema. La funzione di distribuzione dell’energia tra gli N elementi interagenti che formano un sistema

macroscopico è, come è noto, la “distribuzione di Maxwell-Boltzmann” (d’ora in poi fMB); essa ha un campo di

applicazione del tutto generale e riguarda gli stati energetici di qualsiasi sistema per il quale abbia senso definire

uno stato di equilibrio termodinamico e quindi una temperatura. Lo stato di equilibrio del sistema, per il quale

vale la fMB, è di gran lunga più probabile e, in base al principio di Boltzmann, l’entropia del sistema è proporzionale

al logaritmo naturale di tale probabilità:

S = klogW

dove k è la “costante di Boltzmann”.

Nello stato d’equilibrio vale anche il cosiddetto principio di equipartizione dell’energia, che afferma che ad ogni

grado di libertà dei costituenti elementari del sistema è associata un’energia media pari a (1/2)kt. Come si è detto,

il principio d’equipartizione dell’energia ha conseguenze importanti, che consentono di mettere in relazione la

teoria cinetica con i dati sperimentali. Tra l’altro esso riguarda direttamente il problema dei modelli molecolari, ivi

comprese le interazioni tra le molecole e il campo elettromagnetico, e poi deve far fronte all’evidenza relativa alla

dipendenza dei valori dei calori specifici dalla temperatura.1

Tutte le questioni cui abbiamo accennato indicano un’unica possibile soluzione, anche se i fisici dell’epoca

non furono in grado di immaginarla. In effetti, per evitare le conseguenze inaccettabili dei modelli adottati, sarebbe bastato cercare un’ipotesi tale da comportare una drastica riduzione del numero dei gradi di libertà che si

“attivano” nell’interazione dinamica tra i sistemi elementari considerati. Sarebbe stato necessario, in altre parole,

trovare un’ipotesi tale da produrre il congelamento della stragrande maggioranza dei gradi di libertà di ogni sistema

elementare, interagente ad esempio con il campo elettromagnetico.

I problemi suddetti assumono una forma drammatica quando, verso la fine del XIX secolo, Max Planck comincia ad occuparsi del problema della radiazione termica. L’idea che la materia è fatta di cariche elettriche elementari costituisce il punto di partenza per comprendere i processi d’emissione e assorbimento della radiazione da parte

della materia. Per esempio, è quasi naturale pensare che gli elettroni presenti nella materia si comportano come

oscillatori armonici, capaci quindi di entrare in risonanza con le onde della radiazione che le investe. Una volta “eccitati” dalla radiazione incidente, gli elettroni diventano a loro volta “sorgenti” emissive: ecco perché una superficie

metallica è una superficie riflettente. Planck applica dunque questo modello per ottenere una giustificazione dello

stato di equilibrio di una certa quantità di radiazione in equilibrio con un sistema materiale a temperatura T.2 Si

tratta di confrontare teoria ed esperienza, ossia cercare di spiegare in base a ipotesi teoriche semplici lo spettro

della radiazione emessa da un piccolo foro prodotto in una cavità a pareti metalliche perfettamente riflettenti, avendo assunto che in un tempo molto breve la radiazione all’interno della cavità raggiungesse l’equilibrio termico

con le pareti della cavità stessa, ossia assumesse la loro stessa temperatura. In particolare, i modelli adottati hanno

le seguenti caratteristiche.

1) Nella materia in equilibrio termico con la radiazione è presente un numero enorme di elettroni oscillanti che

assorbono ed emettono continuamente la radiazione con cui interagiscono. Naturalmente all’interno del metallo non può esservi campo elettromagnetico. Le onde elettromagnetiche sono quindi “confinate” e la cavità

metallica costituisce un “recipiente” in cui è racchiusa la radiazione termica.

2) In tali condizioni, la radiazione all’interno della cavità può essere formata soltanto da onde stazionarie (i modi

normali del campo). È allora possibile contare il numero totale Ntot di tali modi normali e attribuire a ciascuno

di essi un’energia media basandosi sul principio di equipartizione. È facile constatare che (come nel caso della

corda vibrante) i modi indipendenti possibili sono infiniti. Si giunge quindi al risultato

Ntot = (8π/3)Vν3/c3

dove V è il volume della cavità, ν è la frequenza e c la velocità della luce.

1

Il problema nasce, come si è detto, dal fatto che il valore dei calori specifici non è indipendente dalla temperatura. Lo studio di sistemi

portati a temperature molto basse mostra che il calore specifico delle sostanze tende a zero col tendere a zero della temperatura.

2

Si noti che Planck attribuisce la stessa temperatura alla radiazione. Per farlo, però, deve introdurre un’ipotesi sul carattere “disordinato”

della radiazione cosiddetta “naturale” analoga a quella introdotta per il moto delle molecole di un gas: le ampiezze e le fasi delle componenti ondulatorie elementari della radiazione naturali sono distribuite in modo del tutto casuale.

3) Per ricavare la densità di energia ρ(ν, T), ci interessa il numero di modi propri per unità di volume e per unità

di intervallo di frequenza, ossia

N = (1/V)dNtot/dν = 8πν2/c3

Applicando il principio d’equipartizione dell’energia si ottiene quindi facilmente la densità di energia ρ(ν, T),

giungendo così alla nota “legge di Rayleigh-Jeans”:

ρ(ν, T) = 8πν2/c3kT

Si vede subito che la dipendenza da ν2 fa sì che, la distribuzione dell’energia diverge al crescere della frequenza.

Ciò comporta, tra l’altro, che il calore specifico del sistema deve essere infinito! È questa la conseguenza ineluttabile del modello classico, poi chiamata, per motivi ora facilmente comprensibili, “catastrofe ultravioletta”.

Per “salvare l’esperienza” Planck propone la seguente ipotesi: l’energia da attribuire a ciascuno degli oscillatori

armonici non può assumere qualsiasi valore, ma solo multipli interi di un “quanto elementare” ε = hν, dove ν è

la frequenza propria dell’oscillatore ed h una costante universale. In altri termini, l’energia di un elettrone che oscilla con frequenza ν non può essere piccola quanto si vuole: il suo valore minimo è ε = hν, un valore che cresce col crescere della frequenza. Evidentemente, se E è l’energia totale del sistema, frequenze di oscillazione tali

che hν > E non possono essere più attive. Mancheranno quindi anche i modi normali corrispondenti. Viene meno il principio di equipartizione dell’energia tra gli oscillatori di tutte le frequenze, ossia tra tutti i modi normali

della radiazione. La quantizzazione dell’energia finisce per introdurre un fattore esponenziale che elimina ogni

forma di divergenza dall’espressione della densità di energia della radiazione. La formula di Planck, in perfetto

accordo con i dati sperimentali, è la seguente:

ρ(ν, T) = (8πν2/c3)hν/[exp(hν/kT) -1]

La conferma decisiva del fatto che il procedimento escogitato da Planck aveva una notevole efficacia avvenne

quando il giovane Einstein, tra il 1906 e il 1907, se ne servì per risolvere l’annoso problema dei calori specifici.

Ripercorriamo a grandi linee il contributo di Einstein. Per semplificare il problema Einstein introduce il modello

più semplice possibile di materia solida: un reticolo cristallino in cui i singoli atomi sono collocati ai vertici delle

celle elementari e ivi oscillano armonicamente. 3 Dall’ipotesi di Planck segue che l’energia totale di N oscillatori è

3Nhν/[exp(hν/kT) -1]

Essendo cv = dU/dT, si ha che il calore specifico del modello di solido è

cv = [3Nk(hν/kT)2]{[exp(hν/kT)]/[exp(hν/kT) – 1]2}

Rappresentando graficamente cv in funzione di kT/hν, si ottiene un andamento che mostra chiaramente non solo

che esso tende a zero col tendere a zero di T, ma anche che questa tendenza dipende essenzialmente dal valore delle frequenze di oscillazione. Per esempio, ad una temperatura T = 300K, per una lunghezza d’onda λ = c/ ν = 4.8 mm, cv

è praticamente uguale a zero (kT/hν = 0.1). Si capisce così perché, per esempio, le oscillazioni delle particelle

piccole come gli elettroni degli atomi non contribuiscono al calore specifico, dato che le loro frequenze caratteristiche sono molto più grandi del valore indicato. I gradi di libertà associati al moto degli elettroni non possono, a

quelle temperature, essere eccitati: come si dice in gergo, sono “congelati”.

Si possono ora comprendere appieno i motivi dell’efficacia dell’ipotesi di Planck. Fissata la quantità di energia,

un sistema può assorbire un numero relativamente grande di quanti “piccoli” e un numero relativamente piccolo

di quanti “grandi”. Esiste anzi un limite oltre il quale certamente non si può andare: la frequenza può essere così

elevata che anche un solo quanto d’energia è uguale all’intero ammontare dell’energia fornita al sistema. Ne segue

che i gradi di libertà associati a frequenze proprie molto elevate non possono essere “attivati” (o “eccitati”).

L’ipotesi di Planck è certamente semplice, ma è sicuramente problematica dal punto di vista del suo significato fisico: infatti, come può l’energia di un sistema oscillante essere legata alla sua frequenza propria? Abbiamo già

visto che, in fisica classica, l’energia di un sistema armonico dipende dalle sue condizioni iniziali, e non dalle caratteristiche intrinseche del sistema. Appare quindi molto difficile integrare l’ipotesi di Planck in un modello classico di sistema fisico oscillante. D’altra parte essa introduce un elemento di “discontinuità” nel comportamento

dinamico degli elettroni atomici, cosa del tutto inconcepibile dal punto di vista classico. La crisi della fisica classica è ormai apertamente proclamata, anche se l’ipotesi di Planck sembra ancora un artificio puramente formale e

provvisorio per risolvere un problema altrimenti insolubile.

2. Il “dilemma onda-corpuscolo

Il modello classico, cui abbiamo già accennato per interpretare l’emissione e l’assorbimento della radiazione da

parte della materia, fa riferimento a particelle cariche (gli elettroni), legate elasticamente agli atomi nei dielettrici e

3

Occorre notare che la tipica disinvoltura di Einstein si manifesta nel fatto che egli trasferisce l’ipotesi di Planck agli atomi neutri. La

quantizzazione non riguarda più solo cariche oscillanti (il che poteva far pensare a un “effetto elettromagnetico”) ma si estende a tutte le

particelle materiali e riguarda quindi la loro “meccanica”.

libere di muoversi nei conduttori. Gli elettroni legati oscillano attorno a posizioni d’equilibrio e quindi sono caratterizzate da diverse frequenze proprie d’oscillazione. Nei metalli, gli elettroni di conduzione sono quindi “liberi”, ma sono confinati all’interno del materiale da una “barriera di potenziale”. Per essere estratti dal conduttore,

essi devono ricevere una quantità d’energia tale da superare il cosiddetto “potenziale di estrazione” che è diverso

per ciascun metallo.

Abbiamo già visto come Hertz aveva rivelato nel 1887 la propagazione di “onde elettriche” nello spazio, servendosi di un circuito “primario”, in cui si produceva una forte scarica elettrica, e di un circuito “secondario” che

misurava il “campo” ad una certa distanza dal primario, anch’esso tramite piccole scintille. Nel compiere queste

misure Hertz si accorse che spesso si produceva un fenomeno che disturbava l’esperimento in questione, fenomeno che egli chiamò immediatamente “effetto fotoelettrico”. Avveniva che, quando i poli del circuito rivelatore

erano esposti alla luce proveniente dalla scintilla principale, la scintilla “secondaria” si produceva con facilità molluce

anodo

catodo

raggi catodici

Fig. 1

to maggiore, impedendo quindi al rivelatore di dare misure affidabili. Hertz diede subito importanza al fenomeno, poiché esso rivelava un’altra connessione (sia pure misteriosa) tra luce ed elettricità. Decise quindi di approfondirne l’esame. Usando vari filtri ottici egli riuscì a rivelare che la parte più efficace della radiazione emessa dalla scarica principale era quella corrispondente alla regione violetta e ultravioletta. C’era quindi una connessione

tra l’intensità dell’effetto e la lunghezza d’onda della luce che lo provocava. Fin qui Hertz. A partire dall’anno

successivo le ricerche sul fenomeno si moltiplicarono e furono proposte molte ipotesi per spiegarlo. Le circostanze del fenomeno divennero più chiare alla fine del secolo, quando la natura corpuscolare dell’elettricità fu definitivamente confermata dalle esperienze di J. J. Thomson sui raggi catodici. La luce faceva sì che una superficie,

in genere metallica, emettesse le stesse particelle che, opportunamente accelerate, formavano i raggi catodici, ossia fasci di elettroni (fig. 1)

La ricerca sperimentale più avanzata, prima del 1905, fu quella effettuata dall’ex assistente di Hertz, Philip Lenard. Il merito di Lenard fu non solo quello di esporre il metallo a radiazioni di frequenza diversa, ma anche

quello di trovare un metodo per misurare l’energia cinetica degli elettroni emessi, utilizzando per questo scopo

un campo elettrico uniforme diretto in modo tale da frenare gli elettroni che uscivano dal metallo (v. fig. 2).

luce

metallo

elettrodo

galvanometro

Fig. 2

In questo modo, quando la corrente che passava tra gli elettrodi si annullava, si poteva assumere che nessun elettrone espulso dal metallo riusciva a raggiungere l’elettrodo opposto. Dal potenziale V (negativo) di tale elettrodo

e dalla carica dell’elettrone e si poteva quindi ricavare il limite superiore per l’energia cinetica degli elettroni emessi:

½mv2 = eV

Lenard confermò il fatto che per attivare la foto emissione la luce doveva superare una frequenza di soglia

che dipendeva dalla natura della placca metallica e trovò anche che l’energia cinetica massima dei fotoelettroni

dipendeva dalla frequenza, anche se non indagò sulla forma di questa relazione. Per lui l’emissione degli elettroni

era dovuta a una sorta di “esplosione” degli atomi del metallo innescata dalla luce e, per questo, egli assimilava

l’effetto fotoelettrico all’emissione di particelle da parte delle sostanze radioattive.

Finalmente, nel 1905, Einstein riesce quasi a sorpresa a collegare i problemi sollevati dall’effetto fotoelettrico

con l’ipotesi dei quanti di Planck. L’intento di Einstein è tuttavia più generale. Come abbiamo visto quando abbiamo parlato dell’antinomia tra continuo e discreto, Einstein cerca di indicare una prospettiva ipotetica per eliminare il “dualismo” tra campi continui e materia discreta. A tal fine, egli utilizza un metodo, detto “termodinamico-statistico”, studiando le conseguenze di un’interpretazione statistica della legge del corpo nero sulla natura

microscopica della radiazione. L’identificazione dell’entropia con la probabilità di uno stato macroscopico consente di analizzare la dipendenza della probabilità da alcune grandezze caratteristiche del sistema. Ora, la dipendenza dal volume dell’entropia di un sistema costitutivo da sola radiazione risulta, nella regione delle alte frequenze, del tutto analoga alla dipendenza dal volume di un gas perfetto. Ciò rivela che la densità di energia della

radiazione in diversi punti dello spazio occupato non mostra alcuna correlazione, come sarebbe stato richiesto

dalla teoria ondulatoria.

Einstein deduce quindi che, almeno nella regione delle alte frequenze, la luce deve essere costituita da corpuscoli, la cui posizione nello spazio non dipendeva da quella degli altri proprio come le molecole di un gas. Egli

chiama tali corpuscoli “quanti di luce” (lichtquanta) e dimostra che la loro energia è proporzionale alla loro frequenza. Come egli afferma,

in base all’ipotesi che qui proponiamo, quando un raggio di luce si propaga partendo da un punto, l’energia non si distribuisce con continuità in un volume sempre crescente, ma è costituita da un numero finito di quanti di energia, localizzati nello spazio, che si muovono senza suddividersi e che possono essere emessi o assorbiti solo globalmente.

A questo punto una spiegazione fenomenologica dell’effetto fotoelettrico è a portata di mano: gli elettroni del

metallo sono investiti da quanti di luce la cui energia è tanto più grande quanto più grande è la frequenza.

L’elettrone “colpito” dal quanto di luce assorbe la sua energia e, se questa è sufficientemente elevata, riesce a

sfuggire dal metallo. Ora, l’energia cinetica massima di un elettrone strappato al metallo dalla luce deve essere

uguale all’energia del quanto di luce meno l’energia che l’elettrone spende per superare il potenziale di estrazione

P. Tale energia cinetica è poi consumata nel vincere il campo elettrico che si oppone al moto dell’elettrone. In

sintesi:

½mv2 = eV = hν - eP

Rappresentando in un grafico V in funzione di ν si ottiene quindi una retta il cui coefficiente angolare è proprio

uguale a h. Ma questa congettura sarebbe stata verificata sperimentalmente solo nel 1915 da parte di Millikan.

Molti fenomeni prodotti dall’interazione tra radiazione e materia, essendo molteplici i modelli microscopici

della struttura dei materiali, si prestano a varie interpretazioni. Quella proposta da Einstein per l’effetto fotoelettrico presta il fianco a molteplici critiche, anche se il suo modello è basato su un’intuizione teorica di grande respiro. L’ipotesi di Planck si riferisce invece alla quantizzazione dell’energia di sistemi oscillanti e non coinvolge

direttamente la natura della radiazione. Per Planck, gli aspetti ondulatori della radiazione, soprattutto nei fenomeni di polarizzazione, diffrazione e interferenza sono così evidenti, che è difficile accettare un’ipotesi che li rende di colpo inspiegabili. In pratica il modello corpuscolare della radiazione è insostenibile di fronte all’evidenza

della natura ondulatoria della luce e, anche dopo il 1905, quasi tutti i fisici continuano a pensare che effetti “anomali”, come quello fotoelettrico, possono essere imputati piuttosto alla struttura e alle proprietà, ancora sconosciute, della struttura della materia. Va ricordato, per esempio, che in quel periodo la natura dei raggi X è ancora misteriosa. Solo nel 1912 sono scoperti i fenomeni di diffrazione che si producono illuminando con i raggi X

strutture cristalline: grazie a questi fenomeni, anche i raggi X entrano a far parte dello “spettro” della radiazione

elettromagnetica. Del resto, anche Einstein si è ormai reso conto che la luce non può avere una natura strettamente corpuscolare e già nel 1908 parla della necessità di una teoria che realizzi una “fusione” tra le proprietà

corpuscolari e quelli ondulatorie.

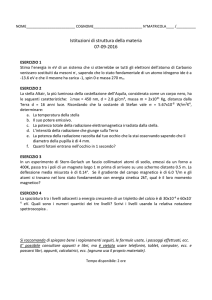

Tra le molteplici esperienze che rendono impraticabile una visione corpuscolare della radiazione ne citiamo

due che hanno una certa rilevanza anche dal punto di vista strettamente concettuale. La prima riguarda il comportamento dei cosiddetti “reticoli di diffrazione”. L’apparato sperimentale è molto semplice ed il fenomeno è

riproducibile in qualsiasi laboratorio scolastico. Un reticolo non produce una riflessione “semplice”, ma la luce

riflessa presenta un massimo principale, che corrisponde alla riflessione ordinaria e una serie di altri massimi “secondari”, che formano angoli ben precisi con la direzione del massimo principale (fig. 3). Ora, la configurazione

dei massimi d’intensità della luce riflessa dal reticolo, dipende dal numero totale delle incisioni investite dalla luce,

ossia dalla lunghezza del reticolo. Ne deriva che, se il fascio fosse composto da uno “sciame” di fotoni, ciascun

fotone dovrebbe “sapere”, nel momento dell’impatto col reticolo, in un punto determinato, quanto è lungo il reticolo stesso. È come se si producesse una forma d’interazione non-locale tra il presunto “corpuscolo” luminoso e

l’intero apparato di misura.

Fig. 3

Il secondo esperimento, più difficile da realizzare in laboratorio, si basa sul comportamento di un particolare

interferometro, detto “di Mach-Zehnder”, composto da due specchi semiriflettenti e due specchi totalmente riflettenti (fig. 4).

A

B

Fig. 4 - A sinistra, il rivelatore B riceve tutta la luce emessa dalla sorgente, mentre il rivelatore A non riceve nulla. Al

centro e a destra, perché si realizzino le sovrapposizioni costruttiva (al centro) e distruttiva (a destra), è necessario che

la luce compia contemporaneamente i quattro percorsi disegnati.

È facile accorgersi che il fenomeno è possibile se e solo se, dopo il primo specchio semiriflettente, la luce prosegue contemporaneamente lungo il cammino orizzontale e lungo il cammino verticale. La cosa è semplicemente

inconcepibile se la luce è composta di corpuscoli. Il fenomeno è ancora più paradossale se si tiene conto del fatto

che si può attenuare l’intensità luminosa in modo tale che il rivelatore B “conta” un numero intero di “click”

chiaramente distanziati nel tempo l’uno dall’altro.

In ogni caso, anche il modello ondulatorio non poteva spiegare altri fenomeni sperimentali che si rendevano

a mano a mano sempre più evidenti. Per esempio:

- come mai un fascio di radiazione ionizza qui e là in modo relativamente casuale solo alcuni degli atomi o le

molecole della sostanza su cui incide o che attraversa?

- Come mai in una lastra fotografica illuminata molto debolmente sono anneriti solo alcuni granuli, sparsi qui e

là, dell’emulsione?

- Come mai per strappare uno o più elettroni ad una sostanza occorre superare una frequenza “di soglia” che

dipende dalla sostanza stessa?

- Come mai le sostanze investite dalla luce emettono elettroni in numero proporzionale all’intensità della radiazione incidente, ma con energia proporzionale alla sua frequenza?

- Come mai un elemento, investito da una radiazione con un certo spettro, “riflette” solo le frequenze inferiori

alla frequenza massima dello spettro della radiazione incidente (legge di Stokes)?

Tutti questi fenomeni sembrano indicare non solo che l’energia ceduta dalla radiazione alla materia è da associarsi alla frequenza e non all’ampiezza (ovvero all’intensità) della radiazione stessa. Ma c’era anche il fatto che lo

scambio di energia tra radiazione e materia avveniva solo in certi punti “localizzati”, proprio come se tutta

l’energia dell’onda finisse per concentrarsi in questi punti. Torneremo su questo problema parlando della figura

d’interferenza che si produce nel “classico” esperimento della “doppia fenditura”.

Per completare il quadro delle scoperte “sconcertanti” che formano il retroterra della formulazione della

meccanica quantistica occorre mettere nella giusta evidenza un’ipotesi, avanzata dal fisico teorico francese Louis

de Broglie all’inizio degli anni ’20. De Broglie avanzò l’ipotesi che anche gli elettroni, come del resto tutte le

“particelle” elementari esibiscono un comportamento ondulatorio, essendo modellizzabili anche come onde aventi una lunghezza d’onda λdB legata al loro impulso p e alla costante h dalla relazione seguente:

λdB = h/p

Questa ipotesi ebbe una definitiva conferma sperimentale solo nel 1927, ma l’ipotesi contribuì in modo decisivo

alla formulazione della meccanica ondulatoria di Schrödinger nel 1926.

L’interesse dell’ipotesi è legato alla nuova luce che essa getta sulla teoria della struttura atomica proposta da

Niels Bohr nel 1913 e, da allora, oggetto principale degli sforzi della ricerca teorica e sperimentale. Sul modello di

Bohr dell’atomo d’idrogeno (formato da un elettrone e un protone) torneremo nel prossimo paragrafo. Per ora ci

limitiamo a segnalare il nesso della sua proprietà fondamentale con l’ipotesi di de Broglie. Come è ormai abbastanza noto, in base al modello di Bohr, l’elettrone dell’atomo d’idrogeno occupa livelli energetici discreti, ricavati

inizialmente da un insolito accoppiamento tra la dinamica classica (moto orbitale) e postulato della quantizzazione dell’energia. Ora, de Broglie sapeva benissimo che un sistema “confinato” (come l’elettrone dell’atomo di idrogeno), se ha natura ondulatoria, forma un sistema discreto di onde stazionarie, caratterizzate ciascuna da una

frequenza (o lunghezza d’onda) diversa. Ovviamente il “campo” elettronico ha proprietà peculiari, per cui non ci

si può aspettare la regolarità dello spettro di frequenze tipico, per esempio, di una corda vibrante. A questo punto

il postulato di Planck trova un’applicazione diversa e più diretta: basta associare ai valori “permessi” delle frequenze il corrispondente valore dell’energia.4 Con questo passo si esce evidentemente completamente dal quadro

classico, nel quale, come abbiamo più volte detto, l’energia di un’oscillazione stazionaria, è legata alla sua ampiezza, ossia alle sue condizioni iniziali (contingenti), e non alla sua frequenza che è un parametro intrinseco del sistema (necessario).

3. L’inspiegabile struttura atomica

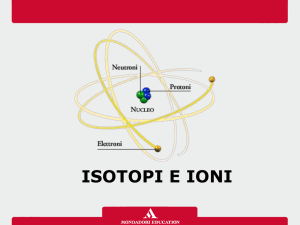

Torniamo ora alle caratteristiche principali del modello di Bohr. Come sappiamo, nei primi anni del Novecento,

l’avvenuta dimostrazione dell’esistenza di particelle subatomiche, i cosiddetti “elettroni”, di massa molto inferiore

a quella di un atomo d’idrogeno (l’elemento più semplice), spinge la ricerca a costruire un modello della struttura

dell’atomo, capace di dar conto dell’evidenza sperimentale che si era andata accumulando nei decenni precedenti.

La costruzione di un modello dell’atomo è rivolta a stabilire quale configurazione può avere il sistema di cariche

positive e negative che forma un atomo neutro. Com’è noto, in seguito agli esperimenti guidati da Rutherford, a

partire dal 1910 si afferma definitivamente il modello dell’atomo “nucleare”.

Sappiamo anche che qualsiasi configurazione di particelle interagenti secondo le leggi della fisica classica pone

seri problemi di stabilità. Invece, lo spettro della radiazione emessa da ciascun elemento chimico è sempre lo

stesso, come se ciascun atomo dovesse ripetere sempre gli stessi processi di emissione e assorbimento della radiazione, a partire dalle stesse condizioni iniziali. Ogni singolo atomo (inteso come sistema di particelle interagenti)mantiene sempre una propria identità strutturale (per esempio, le sue dimensioni sono caratteristiche

dell’elemento considerato) e una propria regolarità di comportamento (l’atomo emette radiazione solo di particolari frequenze, ha sempre le stesse proprietà di combinazione chimica, ecc.). Ora, non esiste un modello classico

capace di preservare determinate caratteristiche dinamiche e strutturali indipendentemente dalle condizioni iniziali e da qualsiasi tipo di perturbazione cui è soggetto.

Il giovane fisico danese Niels Bohr, lavorando come dottorando presso i laboratori di J.J.Thomson e di Rutherford, riconosce molto presto l’inutilità delle ricerche volte cercare un modello classico della struttura atomica

capace di render conto delle suddette caratteristiche di stabilità e regolarità. Il suo merito è quello di accorgersi

che la recente scoperta di Planck indicava una via per risolvere il problema. Così come gli oscillatori possono assumere soltanto livelli discreti di energia, anche l’elettrone legato al nucleo può ruotare solo su particolari orbite

corrispondenti a valori discreti dell’energia di legame col nucleo. Dunque, l’ipotesi fondamentale di Bohr consiste

nell’affermare che l’elettrone dell’atomo di idrogeno occupa “livelli energetici” che dipendono da un numero intero n; in altri termini, sono “permesse” solo le orbite di energia pari a

En = – me4/2h2n2

(1)

In questo modo le orbite elettroniche appaiono “quantizzate” (il numero n è chiamato numero quantico principale).

Dalla (1) si ricava anche la relazione che fornisce la distanza rn dell’elettrone dal nucleo:

rn = (e2/2hR)/n2

È quindi possibile dedurre da principi fisici le dimensioni dell’atomo, il che era impossibile per qualsiasi modello

classico. Il principio di quantizzazione introdotto da Bohr ha preso il nome di postulato degli stati stazionari: si assume che l’elettrone orbitante con un valore determinato dell’energia non emette alcuna radiazione e quindi il suo stato di moto si riproduce indefinitamente con il suo periodo caratteristico, finché non interviene una perturbazione

esterna.

4

Anche dal punto di vista didattico, un approccio di questo tipo è spesso giudicato più accessibile rispetto ad un approccio

“elettromeccanico”.

Il secondo obiettivo da raggiungere è quello di trovare un’ipotesi sull’interazione dell’atomo con la radiazione

elettromagnetica, tale da risolvere l’annosa questione dell’origine e della distribuzione delle righe spettrali.

L’ipotesi straordinariamente audace che Bohr introduce a questo proposito prende il nome di legge delle frequenze:

la radiazione è emessa o assorbita quando l’elettrone effettua una “transizione” tra due livelli energetici (comunemente detta salto quantico); la frequenza della radiazione emessa o assorbita è legata esclusivamente alla differenza

tra le energie dei livelli che l’elettrone “occupa” prima e dopo la transizione, ossia

νmn = (Em – En)/h

(2)

L’importanza della (2) sta nel fatto che in primo luogo l’elettrone non emette o assorbe a tutte le frequenze

della radiazione, ma solo quelle che corrispondono alle transizioni possibili: ecco perché gli spettri appaiono come un insieme discreto di righe. La seconda conseguenza, sicuramente più sconcertante dal punto di vista teorico, è che la (2) spezza ogni possibile legame tra la periodicità del moto dell’elettrone e la frequenza della radiazione emessa o assorbita. Le frequenze proprie del moto di rotazione non corrispondono alle frequenze a cui

l’atomo è “sensibile”. Il modello di Bohr è quindi in netta contraddizione sia con la meccanica sia con l’elettrodinamica classiche.5

La ricerca sul modello di Bohr continua per più di un decennio. I suoi obiettivi caratterizzavano una tipica fase di transizione in cui le conoscenze classiche erano integrate da opportune ipotesi di quantizzazione, che limitavano la continuità infinita delle situazioni dinamiche compatibili col punto di vista classico, senza però alterarne

la struttura portante. Infatti, il modello preservava aspetti essenziali della trattazione meccanica ed elettrodinamica classica. Per esempio, l’elettrone dell’atomo di idrogeno non poteva che essere attratto da una forza coulombiana diretta verso il nucleo e pari a e2/r2, essendo e la carica dell’elettrone e r la distanza tra elettrone e nucleo.

Come si è detto, trattandosi di una forza di tipo newtoniano, la conclusione più ovvia era che l’elettrone si comportasse in modo “kepleriano”, compiendo orbite ellittiche attorno al nucleo a ciascuna delle quali doveva essere

attribuito un momento angolare L costante.

La quantizzazione espressa dalla (1) esprime semplicemente il fatto che, per l’atomo di idrogeno, tra tutti le orbite meccanicamente possibili erano ammesse solo quelle cui corrispondevano determinati valori dell’energia. Essa riduce quindi

drasticamente la molteplicità infinitamente continua delle orbite ammissibili in linea di principio in base al modello classico. Ma la molteplicità delle righe spettrali, resa evidente da osservazioni riguardanti l’emissione di atomi

immersi in campi elettrici e magnetici, impone che, per un dato valore dell’energia, possano manifestarsi più livelli energetici quantizzati.6 In effetti, dalla quantizzazione dell’energia segue immediatamente la quantizzazione del

momento angolare L dell’elettrone. Per ogni livello energetico n, tale momento può assumere solo i valori 1, 2, ..., n

(fig. 1) Occorre dunque un altro numero quantico l, tale che

L = lh

(3)

Anche la proiezione del momento angolare lungo un asse Lz risulta quantizzata:

Lz = mh

(4)

Noto l, il numero quantico m può assumere i 2l + 1 valori m = l, l – 1, l – 2, ..., – (l – 1), – l. Si ha dunque che la

molteplicità delle righe spettrali non può essere ricondotta soltanto al numero dei livelli energetici. Infatti per ogni livello energetico sono possibili diversi stati del momento angolare e della sua proiezione lungo l’asse z. Si

suole dire, in questo caso, che i livelli energetici individuano stati degeneri.

La rimozione della degenerazione delle orbite dell’elettrone si verifica ogni volta che lo stato dell’atomo è perturbato da campi elettrici o magnetici. In particolare, l’immersione del gas incandescente in un campo magnetico,

“splitta” le righe spettrali ottenute in condizioni normali (effetto Zeeman) e consente quindi di indagare sul grado di degenerazione di un’orbita elettronica. Queste ricerche portano a individuare che, oltre al momento angolare dovuto al “moto” dell’elettrone, esiste un momento angolare “intrinseco” J legato allo spin dell’elettrone stesso. Ora, rispetto ad un campo magnetico diretto in una certa direzione, il momento magnetico di spin potesse

avere solo due direzioni: una parallela e una antiparallela. La corrispondente regola di quantizzazione assume

dunque la forma solita:

J = hs

(5)

con s che poteva assumere solo i due valori s = ± ½. Ad ogni valore di m (intero) corrispondono quindi due valori di s che distinguono le due possibili orientazioni dello spin dell’elettrone.

5

Nonostante la sua stranezza e contraddittorietà, il modello di Bohr è accettato dalla maggioranza dei fisici per la sua straordinaria capacità di spiegare diversi fatti sperimentali: dagli spettri di emissione e assorbimento dell’idrogeno atomico, ai fenomeni di risonanza ottica e di

fluorescenza.

6

Non prendiamo in esame in questa sede gli esperimenti che hanno portato alla differenziazione delle ipotesi di quantizzazione. Ci riferiamo, in particolare, all’effetto Stark, all’effetto Zeeman e, in particolare, all’esperienza di Stern e Gelach (su cui per altro torneremo in

seguito), esperimenti ben descritti da molti manuali ed enciclopedie.

In conclusione, i numeri quantici necessari per una teoria “fenomenologia” completa della struttura atomica

sono quattro: n, l, m e s. Occorrono quindi altrettanti principi di quantizzazione. Riassumendo, tali principi sono

I. En = – Rh/n2 (quantizzazione dell’energia)

II. L = hl

III. Lz = hm

IV. J = hs

Si è giunti così alla conclusione che gli stati stazionari dell’elettrone dell’atomo di idrogeno non sono quindi determinati dalla quantizzazione energia totale, ma la loro molteplicità è molto superiore essendo essi determinati

anche dai valori dei numeri quantici l, m e s. Non si può quindi più parlare di sola quantizzazione dell’energia: occorreva applicare l’ipotesi di quantizzazione alle altre grandezze caratterizzanti il moto dell’elettrone. La potenza

della teoria di Bohr si rivela nel fatto che, partendo da queste regole di quantizzazione non solo diviene possibile

spiegare la molteplicità delle righe spettrali, ma si può anche procedere all’interpretazione della tavola periodica

degli elementi di Mendeleev. Da questo punto di vista, la presenza di una serie di livelli energetici e la periodicità

delle proprietà chimiche degli elementi, confermano che l’atomo è formato da “gusci” (shells) concentrici, ciascuno dei quali è caratterizzato dal numero quantico principale n e dai valori possibili per gli altri numeri quantici l, m

ed s. Per l’idrogeno, lo stato di energia più bassa (n = 1) è occupato da un solo elettrone, per il quale il numero l è

necessariamente nullo. Per i due elettroni dell’atomo di elio, n resta uguale a 1, ma s assume i due valori ±½. A

questo punto bisogna ipotizzare che per il terzo elettrone del terzo elemento, il litio, non ci sia più “spazio” nello

stato n = 1: esso deve occupare lo stato corrispondente a n = 2. Nel secondo livello, potendo l assumere il valore

1, c’è quindi spazio per otto elettroni e così si completa la prima riga di otto elementi che compare nella tavola

periodica. Procedendo in tal modo si riesce a ricostruire l’intera tavola periodica senza bisogno di calcoli complicati.

Tuttavia il suddetto procedimento mostra con chiarezza l’esistenza di un problema: perché gli elettroni si distribuiscono su diversi livelli invece di collocarsi tutti al livello di energia minima? La risposta, puramente empirica, fu data da Pauli nel 1925. Egli introdusse una nuova regola, chiamata principio di esclusione. Tale regola afferma

che non possono esistere due elettroni il cui stato sia individuato da quatto numeri quantici identici tra loro. Anche questa regola, inizialmente introdotta in modo empirico, avrebbe poi trovato una giustificazione più generale

nei principi della nuova meccanica quantistica.