Marco Messeri

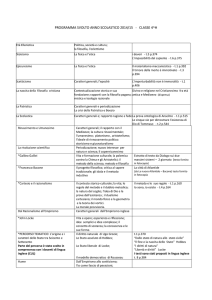

LA FILOSOFIA DELLA SCIENZA NEL NOVECENTO

Sebbene tutta la storia della filosofia sia costellata da riflessioni intorno al legame che si

stabilisce tra esperienza e teoria nel corso dell’indagine scientifica, la filosofia delle scienze

empiriche propriamente detta si organizza come disciplina filosofica essenzialmente nel XIX

secolo. L’obiettivo è quello di ricostruire la struttura del metodo scientifico. Ci sono dei punti

che sono ritenuti assodati. Tutti coloro che partecipano al dibattito sanno bene che del metodo

scientifico fanno parte sia la costruzione di teorie sia la ricerca empirica. Tutti sanno che il

cuore della ricerca empirica è dato dalla produzione consapevole di dati osservativi attraverso

la realizzazione di esperimenti, esperienze artificiali provocate appositamente per rispondere a

questioni poste dalla riflessione teorica. Danno per acquisito che i dati osservativi prodotti

dalla ricerca empirica sono il criterio ultimo di controllo per la validità delle teorie

scientifiche. Tutti concordano che nessuna teoria scientifica può vantare una certezza a priori

e che le teorie scientifiche, prima di potere essere considerate certe, definitive conoscenze,

vivono a lungo come semplici ipotesi, magari altamente confermate dai dati osservativi, ma in

linea di principio rivedibili o suscettibili di posteriore confutazione.

Queste convinzioni condivise sono, però, ben lungi da risolvere ogni questione circa la

struttura del metodo scientifico. Molte domande restano senza precisa risposta. Una dopo

l’altra entreranno nella discussione dei filosofi della scienza. Eccone alcune:

•

C’è un modo per distinguere i veri dati osservativi dalle loro interpretazioni fuorviate

da pregiudizi teorici?

•

C’è una procedura basata sui dati osservativi capace di guidarci nella costruzione di

spiegazioni teoriche almeno plausibili (induzione)?

•

Ci sono dei principi noti relativi alla struttura generale della natura (certezze di filosofia

della natura, p.es. il meccanicismo) suscettibili di limitare la libertà d’invenzione di

teorie che vogliano essere plausibili?

•

L’apparato matematico e simbolico della teoria deve avere un’interpretazione

all’interno di qualche teoria più generale capace di fornire un’immagine complessiva

della natura o può essere autosufficiente nella descrizione del proprio campo d’indagine

particolare?

1

•

L’apparato matematico e simbolico della teoria deve avere un’interpretazione completa

o è sufficiente che l’abbiano le sue proposizioni suscettibili di controllo attraverso i dati

osservativi?

•

C’è una procedura di controllo basata sui dati osservativi capace di provare la verità di

una teoria?

•

C’è una procedura di controllo basata sui dati osservativi capace di provare la falsità di

una teoria?

•

Una teoria confutata deve essere abbandonata?

•

Ci sono delle procedure di controllo capaci di trasformare ipotesi teoriche confermate

sufficientemente a lungo in vere e proprie conoscenze (certezze) scientifiche?

La storia della filosofia della scienza comincia nel XIX secolo, soprattutto quando si

propone con chiarezza l’alternativa tra l’induttivismo e la teoria del metodo ipoteticodeduttivo. La prima posizione epistemologica si caratterizza per la convinzione che sia

possibile delineare una procedura metodica (l’induzione) attraverso la quale ricavare una

conclusione teorica intorno alle cause o alla spiegazione di un determinato fenomeno dai dati

registrati empiricamente circa il fenomeno stesso. La seconda posizione invece si caratterizza

per l’idea che la teoria intorno alle cause del fenomeno, o che comunque cerca di spiegare il

fenomeno, non giunge al termine del processo d’indagine come conclusione, ma viene sempre

formulata nel suo corso, o magari all’inizio, come ipotesi, e che tutta l’indagine ulteriore

consiste appunto nel tentativo di provare, confermare, o viceversa confutare l’ipotesi stessa,

raccogliendo dati intorno al fenomeno, per stabire se essi risultino concordanti o discordanti

con le conseguenze deducibili dall’ipotesi.

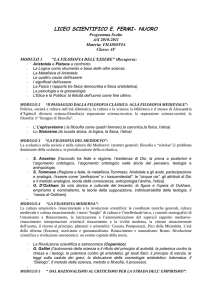

L’induttivismo di Mill

Economista e filosofo inglese, John Stuart Mill (1806-1873) è figlio di James Mill, tra i

principali discepoli di Bentham e i maggiori protagonisti dell'utilitarismo britannico. Compie

studi scientifici in Francia e poi giuridici in Inghilterra. Lavora per la Compagnia delle Indie

fino al 1858, quando essa viene sciolta. Con il Sistema di logica deduttiva e induttiva (1843),

ripensando sotto l'influenza di Comte la tradizione empirista inglese, egli è il massimo

campione dell'induttivismo nel XIX secolo.

Mill si riallaccia alle teorizzazioni secentesche di Bacone e di Boyle intorno al metodo

scientifico. Egli rifiuta innanzitutto ogni valore euristico al ragionamento deduttivo. Ri2

prendendo un'antica critica, che risale almeno a Sesto Empirico, nega che il sillogismo possa

accrescere la nostra conoscenza. Come può infatti essere certo delle premesse di un sillogismo

(p.es. del fatto che tutti gli uomini siano mortali) chi è ancora incerto della sua conclusione

(p.es. del fatto che il duca di Wellington sia mortale)? Il punto è che la conoscenza della

verità delle premesse del sillogismo presuppone la conoscenza della verità della sua

conclusione. Non può avere un valore euristico dunque l'inferenza deduttiva dal generale al

particolare, ma solo quella «transduttiva» o «associativa» dal particolare al particolare: la sola

giustificazione che abbiamo per attenderci un particolare evento futuro è rappresentata dai

particolari eventi passati che abbiamo osservato. La legge generale è soltanto un espediente

linguistico per conservare in maniera economica la memoria di un insieme di dati di fatto

particolari ed esprimere l'attesa di altrettanto particolari casi futuri. L'induzione non è altro

che il procedimento di costruzione di questa legge generale. Mill ritiene di potere indicare

quattro schemi di inferenza induttiva: quello della concordanza, quello della differenza, quello

delle variazioni concomitanti, e quello dei residui:

CONCORDANZA

caso circostanze antecedenti

fenomeni

1

ABEF

abe

2

ABC

acd

3

ABCE

afg

quindi A è probabilmente la causa di a

DIFFERENZA

caso

circostanze antecedenti

fenomeni

1

ABC

a

2

BC

-

quindi A è parte indispensabile della causa di a

VARIAZIONI CONCOMITANTI

caso circostanze antecedenti

fenomeni

1

A+ BC

a+ b

2

A° BC

a° b

3

3

A– BC

a– b

quindi A è probabilmente la causa di a

RESIDUI

caso circostanze antecedenti

1

fenomeni

ABC

abc

ma B è la causa di b, e C è la causa di c

quindi A è la causa di a

Mill sostiene inoltre che la possibilità dell'induzione si fonda sulla validità del principio

di «uniformità della natura», e, rifiutando ogni giustificazione aprioristica di questo, afferma

che la nostra conoscenza dell'uniformità della natura si basa essa stessa su di una generalissima induzione. Questo principio è infatti, per lui, il risultato di un’induzione che presuppone il buon esito di un gran numero di induzioni antecedenti: così come dalla

constatazione del verificarsi di un certo fenomeno in alcuni casi di un determinato genere, noi

siamo autorizzati a concludere che quel fenomeno si deve verificare in tutti i casi di quel

genere, altrettanto dalla constatazione del fatto che il comportamento della natura è risultato

uniforme in alcuni casi, scoperti appunto con induzioni particolari antecedenti, noi siamo

autorizzati a concludere che il comportamento della natura è in generale uniforme. Per Mill, il

rapporto che sussiste tra il principio dell'uniformità della natura, le premesse di un'induzione e

la conclusione di questa, è dunque paragonabile al rapporto che sussiste tra la premessa

maggiore di un sillogismo, la minore e la conclusione di tale sillogismo:

a) come la verità della premessa maggiore del sillogismo non può essere scoperta se non

si è prima scoperto che l'inferenza dalla premessa minore alla conclusione del sillogismo è

legittima, così la verità del principio dell'uniformità della natura non può essere scoperta se

prima non si è scoperto che è legittima l'induzione da una selezione di casi essenzialmente

simili alla totalità dei casi essenzialmente simili dello stesso genere;

b) d'altra parte, come la verità della premessa maggiore del sillogismo è condizione

necessaria per la validità dell'inferenza dalla premessa minore alla conclusione, così la verità

del principio dell'uniformità della natura è condizione necessaria per la validità di una

qualsiasi induzione.

4

Se Mill è senza dubbio l'esponente dell'empirismo inglese del XIX secolo più nettamente schierato in difesa del metodo induttivo, non va d'altra parte dimenticato che anch'egli

si trova costretto a riconoscere un qualche spazio al metodo ipotetico-deduttivo: nel caso dei

fenomeni dipendenti dal concorso di una molteplicità di cause, Mill infatti ammette che

nessuno degli schemi dell'inferenza induttiva è capace di determinare la spiegazione cercata, e

deve concludere che lo scienziato non ha altro mezzo che quello di formulare delle ipotesi e

sottoporle poi al controllo sperimentale.

La teoria del metodo ipotetico-deduttivo

L'importanza e la stessa possibilità di un ragionamento induttivo erano già contestate

nell'epistemologia del XIX secolo, e perfino nell'epistemologia di ascendenza più

schiettamente empiristica. In particolare, già il maggiore filosofo della scienza dei primi

decenni del XIX secolo, l’astronomo, matematico e chimico inglese John Herschel (17921871), pur assumendo anch'egli la filosofia di Bacone come principale punto di riferimento,

aveva sostenuto che il ragionamento induttivo è solo una delle vie che conducono alla

scoperta delle leggi naturali, e non la più importante. Egli osservava che se la legge di Boyle

relativa ai rapporti tra volume, pressione e temperatura dei gas è stata scoperta grazie alla

generalizzazione di dati osservativi, la gran parte delle leggi naturali è stata scoperta invece

attraverso un diverso percorso metodico: non grazie all'induzione, ma grazie all'elaborazione

di ipotesi e al loro successivo controllo per mezzo dell'esperienza. Non sempre, cioè, né

perlopiù, gli scienziati partono dall'osservazione. Più spesso essi immaginano le loro ipotesi di

spiegazione: partono dunque dalle idee. Non c'è, d'altra parte, secondo Herschel, un metodo

per elaborare ipotesi: elaborare ipotesi è un'attività creativa non disciplinabile tramite regole.

Suscettibile di regolamentazione metodica, per Herschel, non è infatti la scoperta, ma la

giustificazione dei risultati scientifici: non la produzione dell'ipotesi, ma la valutazione della

sua accettabilità. A suo giudizio, l'accordo con le osservazioni è il più importante criterio di

accettabilità delle ipotesi scientifiche, e alcune istanze di conferma hanno maggior significato

di altre: la conferma dell'ipotesi nei casi estremi, la conferma nei casi inattesi, la conferma in

un esperimento cruciale, e cioè, secondo la terminologia baconiana, in un esperimento capace

di discriminare tra ipotesi alternative.

Su posizioni non lontane, quasi negli stessi anni, era stato William Whewell (17941866), scienziato inglese dai vasti interessi. Egli aveva usato largamente il termine induzione,

5

ma, al pari di Herschel, non credeva che il lavoro scientifico potesse essere regolamentato da

un metodo. Ciò che egli chiamava induzione infatti era la sovrapposizione di un particolare

modello concettuale alle osservazioni preliminari compiute intorno al fenomeno studiato:

precisamente la creazione di un'ipotesi capace di spiegare il fenomeno. E, come Herschel,

Whewell negava che la creazione di un'ipotesi potesse essere disciplinata da regole. A suo

avviso l'ipotesi non può, in particolare, essere ricavata dalle osservazioni. Essa, invece, può e

deve essere controllata sulla base delle osservazioni. Epistemologi come Herschel e Whewell

propongono dunque, in sostanza, proprio il metodo che, col nome di ipotetico-deduttivo, nel

XX secolo sarebbe stato contrapposto al metodo induttivo: la procedura consistente

nell'elaborare liberamente e creativamente una ipotesi di spiegazione per il fenomeno naturale

indagato, nel ricavarne poi deduttivamente delle previsioni suscettibili di essere controllate

sulla base dell'esperienza, e quindi, infine, nel realizzare sperimentalmente i controlli

immaginati, confutando o confermando l'ipotesi.

A maggior ragione posizioni schiettamente induttivistiche come quelle espresse da Mill

non restano incontestate nella filosofia della scienza della seconda metà del secolo. In

Inghilterra il logico ed economista William Stanley Jevons (1835-1882) polemizza

esplicitamente con Mill, e, contro la pretesa di questi di codificare un ragionamento induttivo

capace di condurre alla scoperta delle leggi della natura, ripropone il metodo ipoteticodeduttivo di Herschel e di Whewell. In Francia il fisiologo Claude Bernard (1813-1878)

afferma che il solo metodo scientifico è quello sperimentale, ma, in consonanza con le

posizioni di Jevons, insiste sul fatto che l'esperimento presuppone la precedente elaborazione

di un'ipotesi, e nega che l'elaborazione di ipotesi possa mai essere codificata attraverso regole

e sottratta alla creatività della fantasia umana. In America il filosofo Charles Sanders Peirce

(1839-1914) riconosce che la parte più significativa delle ricerche scientifiche non può

avvalersi né del metodo deduttivo né del metodo induttivo, bensì del procedimento della

«abduzione» consistente appunto nel passaggio dal dato all’ipotesi che ne dà la spiegazione

più soddisfacente. Il suo prodotto è un’ipotesi: un assunto cioè che non pretende la certezza,

come fa la conclusione deduttiva; ma che, a differenza di questa, può trascendere quanto è

contenuto nel mero dato, pretendere un valore predittivo, e dunque un interesse pratico.

La vittoria del metodo ipotetico-deduttivo sarà indiscutibile. Nessun filosofo nel XX

secolo riterrà seriamente possibile escogitare un meccanismo inferenziale capace di estrarre

una conoscenza delle leggi generali della natura dalla constatazione dei casi particolari

6

appresi per mezzo dell'osservazione. Ne è prova il fatto che i filosofi che riterranno ancora

legittimo parlare di induzione, come in particolare gli empiristi logici, impiegheranno il

concetto di induzione in un senso sostanzialmente nuovo: nessuno di essi riterrà comunque

possibile una scoperta induttiva delle leggi naturali.

La sfida pragmatista e convenzionalista

Non tutta la filosofia della scienza condivide però una visione realista della funzione

delle teorie, e non la condivide neppure tutta la filosofia empiristica contemporanea. Tra la

fine del XIX secolo e l'inizio del XX, anche per effetto del generale discredito che investe

l'idea di un meccanismo induttivo per la scoperta delle leggi naturali, si fa sempre più viva la

consapevolezza del fatto che le teorie scientifiche non si risolvono in un insieme di dati

osservativi, che esse includono una componente creativa, e che tale componente creativa trae

il suo valore dall'importanza pragmatica che dimostra, ovvero dalla sua capacità di facilitare

le nostre operazioni. Per alcuni pensatori, sulla scia di Darwin e delle sue stesse osservazioni

epitemologiche, l'importanza pragmatica delle teorie si identifica col loro potere di

incrementare la nostra generale capacità di sopravvivenza e di dominio della natura; per altri,

più limitatamente, col potere di migliorare la nostra capacità di manipolare e organizzare gli

stessi dati osservativi in maniera economica.

La convinzione che il valore conoscitivo delle teorie scientifiche si identifichi con la

capacità che esse ci danno di operare nel mondo è al centro della proposta filosofica di quella

corrente originariamente americana dell'empirismo che si è autodefinita attraverso l'etichetta

di pragmatismo. Peirce ne è l'iniziatore. Ricevuta una solida formazione matematica e

scientifica, si dedica agli studi di filosofici, rivolgendo il suo interesse soprattutto alla logica.

Ha solo incarichi annuali di logica e di filosofia della scienza presso la John Hopkins

University di Baltimora, il Lowell Istitute di Boston e l'Università di Harvard, ma esercita una

decisiva influenza sulla filosofia e sulla cultura americane. Ne Il fissarsi della credenza

(1877) e Del modo di chiarire le nostre idee (1878), Peirce affronta il problema filosofico

della conoscenza a partire dalla condizione dell'uomo in quanto essere caratterizzato da

bisogni e impegnato in un costante tentativo di adattarsi all'ambiente esterno e di adattare

questo alle proprie esigenze. La ricerca di conoscenza muove per lui da una situazione iniziale

di «dubbio», che è come tale una situazione di insoddisfazione, e mira al conseguimento di

una situazione di «credenza» la più stabile, rassicurante e soddisfacente possibile. Spiegare il

7

ruolo della conoscenza nella vita umana, secondo il punto di vista di Peirce, non è chiarire il

rapporto tra la mente umana e la verità, come ha cercato di fare tutta la tradizione della

metafisica, bensì descrivere le diverse modalità di «fissazione della credenza»: non

impegnarsi nel tentativo disperato di chiarire la relazione tra un soggetto sovrasensibile e una

realtà assoluta ultrafenomenica, ma descrivere le diverse forme di adattamento mentale di un

essere corporeo intelligente al suo ambiente naturale e artificiale. Una tale impresa si risolve

in una analisi della vita umana, condotta dal punto di vista che Kant aveva chiamato

«pragmatico» in contrapposizione al punto di vista «pratico», e cioè dal punto di vista

adattivo e privo di presupposizioni etiche dell'interesse per la sopravvivenza e la crescente

sicurezza. Ciò che Peirce battezza «pragmatismo» è appunto la scelta filosofica di concentrare

la ricerca epistemologica sul valore pragmatico delle idee, allo scopo di permettere una

comprensione concreta del loro significato, accantonando gli approcci metafisici, che con la

loro pretesa di afferrare un significato delle idee più profondo di quello pragmatico, si

arrestano viceversa alla mera veste verbale delle idee stesse e generano solo una pseudocomprensione.

Peirce indica quattro metodi di fissazione della credenza e li ordina secondo le loro

possibilità di successo pragmatico: il rudimentale «metodo della tenacia», consistente nel

tenersi saldi alle credenze acquisite qualunque cosa accada, che evidentemente espone l'uomo

al pericolo dell'azione inefficace o addirittura controproducente; il «metodo dell'autorità»,

consistente nella imposizione delle proprie credenze agli altri, metodo che ha consentito in

passato a grandi religioni di conservarsi a lungo, ma non ha potuto e non potrà mai garantire

una stabilità definitiva; il «metodo dell'a priori», consistente nel rafforzamento delle credenze

per mezzo della pura argomentazione intellettuale, tipico della metafisica e, come la storia di

questa dimostra, incapace di fornire quel consenso generale che è condizione necessaria per la

piena stabilizzazione di una credenza; il «metodo scientifico», e cioè, come si è visto, per

Peirce, il metodo ipotetico-deduttivo, che consente la maggiore stabilità e continuità possibile

al pensiero umano, precisamente grazie al fatto di non irrigidirlo in particolari teorie, ma di

lasciarlo aperto alla revisione permanente sulla base del confronto con i fatti empirici.

Le scelte filosofiche di Peirce trovano in America e poi anche in Europa, soprattutto in

Italia, numerosi seguaci. L'orientamento pragmatista tuttavia va presto incontro a

differenziazioni e finisce col dividersi sulla stessa interpretazione dei propri assunti basilari.

Una prima importante differenza appare con lo statunitense William James (1842-1910).

8

Professore all'Università di Harvard, è tra i promotori della psicologia sperimentale negli

USA. Ad essa dedica i suoi autorevoli Principi di psicologia (1890). Come è evidente

soprattutto da La volontà di credere (1897), Pragmatismo (1907) e Il significato della verità

(1909), James intende il pragmatismo come una specifica concezione della verità: lo identifica

con la tesi che la verità di una credenza coincide con la capacità di operare con successo che

questa credenza assicura al suo portatore, e ne trae esplicitamente il corollario che la verità

non è una proprietà permanente della credenza, bensì un carattere altrettanto transitorio del

successo operativo stesso. L'impostazione di James suscita le obiezioni di numerosi filosofi,

che, persuasi della perfetta concepibilità di idee vere, ma incapaci di produrre conseguenze

operative, e di idee false, ma praticamente utilizzabili in specifici contesti operativi, accusano

tale impostazione di risolversi nella introduzione di un nuovo concetto di verità, piuttosto che

nel chiarimento del concetto consueto, e suscita il dissenso di alcuni tra gli stessi pragmatisti.

Tra questi deve essere ricordato in special modo l’italiano Giovanni Vailati (1863-1909), che

alla lettura del pragmatismo come nuova teoria della verità contrappone l'interpretazione del

pragmatismo come metodo filosofico finalizzato al dissolvimento delle questioni insolubili e

sterili: per Vailati il pragmatista non è colui che afferma la coincidenza di verità e utilità,

bensì colui che rifiuta di attribuire un diverso significato alle idee che hanno identici corollari

operativi e di misurarsi con domande pragmaticamente indecidibili.

In America il pragmatismo acquisirà nella prima metà del XX secolo una vera e propria

egemonia filosofica soprattutto grazie all'influenza di John Dewey (1859-1952). Muovendo

dal punto di vista di Peirce, infatti, Dewey elabora una generale concezione «strumentalistica»

dei compiti del sapere che rigetta il dogmatismo caratteristico di buona parte della tradizione

filosofica, individua nel metodo ipotetico-deduttivo della scienza la più rilevante alternativa a

tale dogmatismo filosofico e legge nella democrazia la traduzione dello spirito antidogmatico

della scienza nel campo della politica.

Al diffondersi della concezione strumentalista in Europa contribuisce, oltre che il

pragmatismo americano, perlomeno anche un'altra fonte. Si tratta del pensiero del tedesco

Friedrich Nietzsche (1844-1900). Nietzsche infatti, negli stessi anni in cui Peirce affronta il

problema della fissazione delle credenze, sviluppa una aggressiva polemica contro il culto

positivistico per i fatti empiricamente accertati. Il positivista chiede di restare ai fatti perché

desidera raggiungere una visione imparziale: condanna la sovrapposizione delle

interpretazioni ai dati oggettivi. Nietzsche ribatte che «non ci sono fatti, bensì solo

9

interpretazioni». Le constatazioni passive infatti non contengono indicazioni sul corso futuro

degli eventi e sono dunque sterili. Le idee che abbiano una importanza non possono perciò

risolversi in constatazioni. Esse sono viceversa sempre interpretazioni dei fatti constatati alla

luce del nostro interesse vitale per il rafforzamento della nostra esistenza: consideriamo

credibili quelle che favoriscono il nostro controllo sugli eventi, errate quelle che lo

ostacolano. La verità assoluta, al di là dei nostri interessi vitali, è solo una chimera della

metafisica.

Su posizioni radicali è anche il tedesco Hans Vaihinger (1852-1933), che, nel suo

Filosofia del 'come se' (1911), sulla scorta di Nietzsche, interpreta la scienza come un sistema

di «finzioni» convenzionali accettabili solo in ragione del successo operativo che ci

consentono, e dunque perché agiscono come se fossero vere, e non perché siano vere in

qualche senso metafisico. Vaihinger definisce la propria filosofia del «come se» un

«idealismo positivistico». Su posizioni radicali è anche, in Italia, il filosofo, storico e critico

letterario Benedetto Croce (1866-1952), che descrive le nozioni teoriche della scienza

naturale come «pseudo-concetti» astratti dotati di un valore solo «economico» e utilitario.

Croce trae da questa visione delle nozioni scientifiche il rifiuto del valore conoscitivo delle

scienze naturali. Se ne serve per giustificare la concezione dichiaratamente neohegeliana

dell'esclusivo valore conoscitivo del concetto filosofico, concetto che, in quanto «universale

concreto» non distinguibile dalla comprensione dell'individuo, a suo avviso viene peraltro a

identificarsi col giudizio storico.

In una versione complessivamente meno estrema l'idea del valore pragmatico delle

teorie si diffonde anche in Francia. È vero che Edouard Le Roy (1870-1954) in Scienza e

filosofia (1899-1900) si spinge fino a sostenere che le teorie scientifiche hanno un carattere

convenzionale: che esse dunque valgono come un reticolo di definizioni implicite dei concetti

che introducono, e non come un insieme di enunciati intorno alla realtà; che la verità attribuita

loro dalle scienze è una semplice verità per convenzione decisa alla luce della utilità che le

teorie rivelano. Il punto, per Le Roy, è che i fatti stessi che la teoria spiega sono strutturati dai

concetti di questa e dipendono dunque dalle sue convenzioni.

Le posizioni di Le Roy vengono tuttavia fatte oggetto di una contestazione puntuale e

acuta da parte del filosofo e matematico francese Henri Poincaré (1854-1912). In La scienza e

l'ipotesi (1902), Il valore della scienza (1905) e Scienza e metodo (1909), Poincaré riconosce

senz'altro la presenza nelle teorie scientifiche di una componente convenzionale, ma nega che

10

possa essere giudicata convenzionale la scienza nel suo insieme, e che possa essere giudicata

convenzionale la verità dei fatti con cui la scienza si confronta. Egli riflette in particolare sul

significato dell'emergere delle geometrie non-euclidee. La geometria non è una scienza

empirica. Essa non tratta dei «solidi naturali» che troviamo nel mondo materiale intorno a noi

e che l’esperienza ci mostra più o meno perfettamente. Essa tratta di «solidi ideali»

creativamente immaginati dalla mente umana e rigorosamente, ma anche convenzionalmente,

definiti da un preciso insieme di assunti fondamentali, che possono essere deduttivamente

sviluppati in una serie di teoremi. Alle scienze naturali riesce comodo prevedere l’aspetto e il

comportamento dei corpi reali, sia pure in maniera approssimativa, come se essi si

identificassero con i solidi ideali della geometria. E per questa operazione semplificatrice

possono servirsi sia della tradizionale geometria euclidea sia di una nuova geometria noneuclidea. Ma la geometria prescelta non è «vera» o «falsa», ma solo più o meno «comoda»

per la semplificazione del lavoro scientifico. Tutte le geometrie esistenti sono cornici

compatibili con i fatti fisici, nessuna è resa obbligatoria dai dati e nessuna è da essi proibita.

Una geometria dunque è effettivamente solo un insieme di «convenzioni», da valutarsi

pragmaticamente per l’idoneità maggiore o minore ad affrontare e organizzare i dati empirici

disponibili. Tuttavia, secondo Poincaré, vi sono dei dati ed essi preesistono alle convenzioni

della scienza. È vero, come afferma Le Roy, che gli scienziati parlano dei fatti all'interno delle

maglie del loro proprio sistema concettuale, e che questo sistema incorpora sempre delle

convenzioni. Ma ciò significa solo che i «fatti bruti» che preesistono a ogni convenzione

scientifica sono sempre riformulati alla luce di specifiche convenzioni teoriche, e che solo

grazie a questa riformulazione divengono «fatti scientifici», ovvero fatti incorporati nella

pratica scientifica. Non significa che i fatti si risolvano nel reticolo linguistico convenzionale

adottato per parlarne. Lo scienziato non crea i fatti.

Su posizioni moderate, analoghe a quelle di Poincaré, è un altro importante pensatore

francese, Pierre Duhem (1861-1916), che, da storico della scienza prima ancora che da

filosofo, dedica al ruolo che la teoria svolge nella scienza il suo La teoria fisica (1904-6).

Duhem rifiuta l'idea che la teoria fisica abbia la funzione di spiegare le regolarità empiriche

constatate, rivelandoci la realtà soggiacente al mero ordine fenomenico. La teoria fisica è

piuttosto un sistema concettuale convenzionale che serve per organizzare nella maniera più

comoda e semplice la nostra conoscenza delle regolarità empiriche stesse. Sono sempre

possibili più organizzazioni concettuali diverse dei medesimi dati osservativi. La scelta

11

dell'una o dell'altra contiene sempre un elemento arbitrario. Ma il criterio ultimo è pur sempre

rappresentato dai fatti che constatiamo. Duhem fa notare d'altronde che il controllo empirico

di una teoria è comunque impresa ineliminabilmente complessa. Nessuna teoria è sufficiente

da sola per ricavare conseguenze osservative e nessuna dunque può essere controllata

separatamente. Una teoria fisica può essere messa a confronto con i fatti solo presupponendo

la validità di un insieme variamente ampio di altre teorie: teorie geometriche sulla struttura

dello spazio, criteri di conguenza che correlino i valori geometrici delle lunghezze a precise

operazioni di misura effettuate con regoli materiali, teorie ottiche o meccaniche che

giustifichino i nostri assunti sul funzionamento degli strumenti di osservazione e di misura, e

ci garantiscano la correttezza dei dati che ricaviamo da essi, altre teorie dinamiche che ci

permettano di calcolare l'effetto dei fattori di disturbo, degli attriti, della resistenza del mezzo,

etc. Non è quindi mai corretto dire che una determinata esperienza contrasta in particolare con

una determinata teoria, ma solo che essa contrasta con una delle teorie che sono state

impiegate nella interpretazione dell'esperienza stessa. L'esperienza quindi è il criterio ultimo,

ma essa non ci insegna mai come dobbiamo modificare le nostre teorie, e neppure quale delle

nostre teorie noi dobbiamo più determinatamente modificare.

Nel mondo di lingua tedesca, non lontano da questa visione convenzionalistica

moderata della teoria scientifica è l’austriaco Ernst Mach (1838-1916). Fisico, filosofo e

storico della scienza, nella Storia critica dello sviluppo della meccanica (1883) elabora una

critica dei fondamenti metafisici della fisica classica, influenzando la formazione del punto di

vista scientifico che avrebbe poi condotto Einstein a costruire la teoria della relatività. Egli

insiste sulle convenzioni che reggono la codificazione newtoniana della fisica, e sostiene che

la maturazione della scienza naturale conduce ad accantonare progressivamente concetti

metafisici come quelli di causa e di sostanza, segnati dalla pretesa di spiegare la realtà

fenomenica, scoprendone il presunto fondamento soggiacente, a beneficio del meno

impegnativo concetto di «funzione», che ci consente di registrare puramente e semplicemente

le interdipendenze constatabili tra le grandezze empiriche. Non lontano da Poincaré e Duhem,

in Analisi delle sensazioni (1886) e in Conoscenza ed errore (1905), Mach afferma che lo

scopo della teoria non sia quello di spiegare i fatti constatati, bensì quello di organizzare nella

maniera più comoda e semplice i dati stessi, e afferma che scopo della scienza è di

«economizzare esperienze mediante la riproduzione e l'anticipazione di fatti nel pensiero».

12

Le posizioni di Mach intorno allo scopo della teoria fisica sono accolte dall’austriaco

Ludwig Wittgenstein (1889-1951) nel Tractatus logico-philosophicus (1921-22). Secondo il

Tractatus le leggi generali a priori della fisica, a differenza delle leggi particolari, che sono

meri compendi di osservazioni, hanno un valore convenzionale: proposizioni come la legge di

causalità, il principio di minima azione, gli assiomi della meccanica non sono infatti veri

enunciati dotati di un significato autonomo - solo le proposizioni che enunciano fatti lo sono -,

bensì regole che ci consentono di raccogliere i fenomeni fisici nella maniera più consona alle

nostre esigenze pragmatiche. Tali proposizioni sono come il reticolo di cui ci serviamo per

indicare le parti di una certa superficie. Le maglie del reticolo potrebbero avere forme diverse,

a seconda delle nostre esigenze: è comunque chiaro che la forma delle maglie non cambia

l'aspetto della superficie che noi ci proponiamo di descrivere, ma solo rende più o meno

agevole la descrizione. Allo stesso modo le teorie non devono essere interpretate come

generalissime descrizioni della realtà, bensì come strumenti deduttivi per inferire dalle

osservazioni passate le previsioni circa il futuro.

Intanto, nuove formidabili domande vengono sollecitate dagli sviluppi della ricerca

fisica generati dallo studio dei fenomeni elettromagnetici. È lo stesso quadro d’insieme

rappresentato dai principi di Newton e dalla geometria di Euclide che risulta scosso e da

rivedere. La stessa «fisica classica», come si comincia ora a chiamarla, pare superata.

La crisi della fisica classica

Il britannico Thomas Young (1773-1829), nel 1801, e poi il francese Augustin Fresnel

(1788-1827), nel 1815, studiano i fenomeni di interferenza luminosa ricorrendo all’ipotesi

ondulatoria. Per la scienza successiva è un fatto acquisito che la luce è costituita non da

corpuscoli, come aveva ipotizzato Isaac Newton (1642-1727), ma da onde, come aveva invece

ipotizzato Christiaan Huygens (1629-1695). In coerenza con l’ipotesi, gli scienziati

introducono il concetto di «etere luminoso» per indicare il mezzo elastico nel quale si

propagherebbero le onde luminose.

Intanto è diventato chiaro come elettricità e magnetismo siano solo due aspetti del

medesimo fenomeno. Il danese Hans Christian Oersted (1777-1851) nel 1820 nota che un ago

magnetizzato viene deviato dal filo attraversato da corrente elettrica posto nelle vicinanze. Nel

1821 il britannico Michael Faraday (1791-1867) pubblica una memoria in cui mostra come

una corrente elettrica posta sotto l’azione di un magnete riesca a generare un movimento di

13

rotazione. Infine, nel 1825 il britannico William Sturgeon (1783-1850) costruisce la prima

elettrocalamita. È Faraday nel 1851 il primo a interpretare le linee di forza generate dalle

forze elettromagnetiche come realtà fisiche, aprendo così la strada al concetto di campo: una

realtà non materiale capace di occupare con continuità lo spazio vuoto di materia e di

esercitare delle forze esattamente come potrebbe fare la materia stessa. Si comincia a parlare

di «etere elettromagnetico» per indicare il mezzo non materiale portatore del campo.

Nel 1865 il fisico scozzese James Clerk Maxwell (1831-1879) pubblica le quattro

equazioni che descrivono il campo elettromagnetico. La sua teoria richiede che il campo

elettromagnetico si propaghi per mezzo di onde e permette di ricavare la velocità costante con

cui tale onde si dovrebbero propagare (c): circa 300 mila km al secondo. Data la concordanza

con le misure intorno alla velocità della luce, ipotizza che le onde luminose siano appunto

onde elettromagnetiche e identifica etere luminoso ed etere elettromagnetico. Nel 1886 il

tedesco Heinrich Rudolf Hertz (1857-1894) conferma la teoria, producendo con mezzi

elettromagnetici delle onde che si comportano secondo le previsoni di Maxwell.

Comincia la ricerca intorno all’etere elettromagnetico. La teoria afferma che le onde

elettromagnetiche, e in particolare quelle luminose, si propagano con velocità costante c solo

rispetto all’etere elettromagnetico. Misurata rispetto ad altri sistemi di riferimento la velocità

di propagazione dovrebbe risultare sensibilmente diversa. Così, tale etere elettromagnetico

pare un buon candidato per incarnare la realtà fisica “davvero in quiete”, costituente il sistema

di riferimento “naturale” e “privilegiato” per descrivere i fenomeni naturali: lo «spazio

assoluto» postulato da Newton. Attraverso la misurazione della velocità della luce in direzioni

diverse dovrebbe essere possibile evidenziare il moto della Terra rispetto all’etere in quiete

assoluta (o, in altri termini, l’apparente «vento d’etere» che si immagina sembrerebbe soffiare

contro la Terra, a causa del moto assoluto di quest’ultima rispetto all’etere stesso).

Nel 1887 i fisici statunitensi Albert Michelson (1852-1931) e Edward Morley (18381923) tentano di evidenziare il moto della Terra rispetto all’etere attraverso un interferometro

a bracci ortogonali: se la luce si propaga con velocità diverse rispetto a un sistema di

coordinate solidale con la Terra, quando viaggia in direzioni diverse, il fatto risulterà dal

comparire di un fenomeno di interferenza tra raggi che hanno viaggiato in direzioni tra loro

perpendicolari. Il fenomeno di interferenza, tuttavia, non compare affatto, comunque

l’apparato venga orientato. Il «vento d’etere» non sembra esistere. Tutto si verifica proprio

come se la Terra fosse in quiete rispetto all’«oceano d’etere».

14

Il risultato sconcerta la comunità scientifica. Per spiegare il sorprendente risultato

l’irlandese George FitzGerald (1851-1901) nel 1889 e poi l’olandese Hendrik Lorentz (18531928) nel 1892 ipotizzano che l’etere esista effettivamente, ma che il moto rispetto a esso non

possa essere rilevato perché i corpi materiali (e quindi anche i bracci dell’interferometro di

Michelson e Morley) si contraggono di un fattore

nella direzione del moto, quando si

muovono con velocità v rispetto all’etere. L’ipotesi suscita, tuttavia, scetticismo perché pare

artificiosa e poco comprensibile.

Nel 1905 il tedesco Albert Einstein (1879-1955) pubblica la «teoria della relatività

ristretta», per mezzo della quale propone una spiegazione dei risultati di Michelson e Morley

tanto semplice ed elegante quanto rivoluzionaria: non è la natura della materia in moto a

essere diversa da ciò che gli scienziati hanno ipotizzato, bensì la natura di spazio e tempo.

Einstein suppone che tutte le leggi naturali (comprese le equazioni di Maxwell) siano

invarianti rispetto alla scelta tra diversi sistemi inerziali di coordinate spazio-temporali e che

sia una legge di natura anche la costanza della velocità delle onde elettromagnetiche rispetto a

qualsiasi sistema di riferimento inerziale. Le conseguenze di tali assunti sono sorprendenti: le

trasformazioni “galeleiane” tra sistemi di coordinate non sono valide e vanno sostituite con le

trasformazioni di Lorentz, sebbene per una ragione diversa da quella ipotizzata dal fisico

olandese, nelle quali ha un ruolo cruciale il fattore

; eventi che sono simultanei, se

misurati entro un sistema di riferimento inerziale, non sono simultanei se misurati entro un

diverso sistema di riferimento inerziale in moto rispetto al primo; la lunghezza dei corpi rigidi

non è invariante, ma dipende dal sistema inerziale assunto per effettuare la misura, e, se il

sistema è il moto rispetto al corpo da misurare, essa risulta più corta che se è in quiete

(contrazione dello spazio); la durata dei processi fisici non è invariante, ma dipende dal

sistema inerziale assunto per effettuare la misura, e, se il sistema è il moto rispetto al corpo da

misurare, essa risulta più lunga che se è in quiete (dilatazione del tempo); la massa di un

corpo non è invariante, ma dipende dal sistema inerziale assunto per effettuare la misura, e, se

il sistema è il moto rispetto al corpo da misurare, essa risulta maggiore che se è in quiete

(aumento della massa); un corpo contiene energia per il solo fatto di avere una certa massa a

riposo (inerzia dell’energia), energia che entra nel bilancio complessivo della conservazione

dell’energia totale, e che, in opportune condizioni fisiche, può essere trasformata in altre

15

forme di energia, come in particolare l’energia cinetica (ci possono essere fenomeni fisici di

perdita di energia cinetica e potenziale con acquisto di massa, e viceversa).

Le prime conferme della relatività ristretta verranno nel 1932, quando lo statunitense

Carl David Anderson (1905-1991) osserverà nei raggi cosmici il positrone, l’antiparticella

dell’elettrone, prodotto in coppia con quest’ultimo attraverso la conversione di energia in

massa, secondo la previsione dell’inglese Paul Dirac (1902-1984). Lo stesso anno l’irlandese

Ernest Walton (1903-1995) e il britannico John Cockcroft (1897-1967) realizzeranno per

primi artificialmente la fissione nucleare, che produce energia attraverso la scomparsa di

massa. Solo più tardi viene confermata la dilatazione relativistica del tempo. Nel 1941

l’italiano Bruno Rossi spiega con la relatività il tempo singolarmente lungo di decadimento

dei muoni nei raggi cosmici. Nel 1971 gli statunitensi Joseph Hafele e Richard Keating

confermano la dilatazione del tempo confrontando la durata del viaggio di un aereo che fa il

giro del mondo, quando viene misurata da terra e quando è misurata sull’aereo stesso. Nel

1975 gli italiani Luigi Briatore e Sigfrido Leschiutta confermano la dilatazione del tempo con

orologi posti a quote diverse.

Intanto nel 1916 Einstein ha pubblicato un’estensione della relatività ristretta, nota

come «teoria della relatività generale». Con essa vengono presi in considerazione anche

sistemi di riferimento non inerziali e viene studiata la gravitazione, ancora con un’ipotesi

rivoluzionaria circa la natura di spazio e tempo. La nuova ipotesi di Einstein mira a spiegare il

fatto, constatato ma non spiegato dalla fisica classica, dell’uguaglianza di massa inerziale e

massa gravitazionale. Einstein ipotizza che i fenomeni gravitazionali siano dovuti non alla

natura della materia, ma alla struttura geometrica stessa dello spazio-tempo, che non sarebbe

euclidea, bensì conforme alla geometria ellittica di Riemann: lo spazio-tempo sarebbe infatti

un sistema quadridimensionale curvo immerso in uno spazio con un numero maggiore di

dimensioni, un po’ come è curva la superficie di una sfera o di un ellissoide posti entro lo

spazio tridimensionale euclideo. Le linee seguite nello spazio-tempo dai corpi soggetti a un

campo gravitazionale non sarebbero altro che le linee più brevi in tale struttura curva, così

come nella fisica classica le più brevi sono le linee seguite solo dai corpi non soggetti a forze:

la gravitazione non sarebbe perciò una forza che si esercita nello spazio e nel tempo, ma un

aspetto della struttura geometrica stessa di spazio e tempo. Il campo gravitazionale, poi, non è

uniforme, ma presenta dei centri d’irradiazione di massa diversa, perché la curvatura

medesima dello spazio-tempo non è uniforme: le diverse concentrazioni di materia si

16

riducono esse stesse alle irregolarità della geometria di quello. La relatività generale prevede

fenomeni di dilatazione del tempo dovuti alla struttura geometrica gravitazionale dello spaziotempo.

La relatività generale permette ad Einstein di spiegare fino dal 1916 la già nota, ma fino

ad allora inesplicabile, difformità dell’orbita di Mercurio dall’ellisse. Nel 1919 poi l’inglese

Arthur Eddington (1882-1944) conferma la deviazione dei raggi luminosi in prossimità del

Sole, prevista dalla teoria di Einstein. Nel 1925 lo statunitense Walter Adams (1876-1956)

rileva uno spostamento verso il rosso delle righe spettrali della radiazione delle nane bianche,

attribuibile a un effetto gravitazionale previsto dalla relatività generale.

Frattanto un seconda serie di rivoluzionarie trasformazioni teoriche è stata suscitata

anch’essa dall’approfondimento dei fenomeni elettromagnetici. È risultato che l’elettricità

consiste in un flusso di corpuscoli, «atomi di elettricità», «elettroni», analoghi agli atomi di

materia che nel 1803 l’inglese John Dalton (1766-1844) aveva riproposto per spiegare la

differenza degli elementi chimici e che nel 1870 il russo Dmitrij Mendeleev (1834-1907)

aveva posto alla base della loro classificazione. Nel 1887 Hertz scopre infatti l’effetto

fotoelettrico e nel 1897 l’inglese Joseph Thomson (1856-1940) misura carica e massa

dell’elettrone.

Fanno discutere il fenomeno fotoelettrico e il problema della radiazione del corpo nero,

l’oggetto ideale capace di assorbire onde luminose di tutte le lunghezze d’onda. Le

simulazioni su sistemi sufficientemente simili al modello ideale mostrano un fenomeno

inatteso, la cosiddetta «catastrofe ultravioletta»: l’intensità della radiazione emessa per

lunghezze d’onda molto piccole (ultraviolette) non è alta, come la teoria corrente basata sulle

equazioni di Maxwell prevederebbe, ma molto bassa e tende a zero con il decrescere della

lunghezza d’onda. Quanto all’effetto fotoelettrico, la teoria di Maxwell prevede che si

manifesti solo se l’onda elettromagnetica che colpisce la lastra metallica ha un’intensità

sufficientemente elevata e che l’energia cinetica degli elettroni emessi dipenda da tale

intensità. Invece, dai dati sperimentali risulta che l’effetto si manifesta indipendentemente

dall’intensità dell’onda elettromagnetica, purché la sua frequenza sia sufficientemente elevata

e che l’energia cinetica degli elettroni emessi dipende dalla frequenza e non dall’intensità

dell’onda.

Nel 1900 il fisico teorico tedesco Max Planck (1858-1947) spiega la radiazione del

corpo nero proponendo l’«ipotesi dei quanti»: l’energia non viene assorbita o irradiata dagli

17

atomi in quantità suscettibili di variare con continuità, ma in pacchetti, «quanti di energia», di

precisa grandezza. Essa varia dunque in maniera discreta. Come la materia, anche l’energia

pare avere i suoi indivisibili. Nel 1905 Einstein spiega l’effetto fotoelettrico proprio

ricorrendo all’ipotesi di Planck e ipotizza che la radiazione luminosa sia costituita da

«fotoni», quanti di luce, corpuscoli luminosi: l’ipotesi corpuscolare newtoniana pare

recuperare credibilità. Già Einstein connette l’intensità dell’onda in un punto dello spazio e

del tempo alla probabilità di trovare il fotone in tale punto stesso.

L’ipotesi attrae i fisici impegnati nella ricerca sulla struttura dell’atomo. Nel 1901 il

francese Jean-Baptiste Perrin (1870-1942) per primo ha ipotizzato che l’atomo sia un sistema

solare in miniatura, con elettroni che orbitano attorno a un nucleo carico positivamente, e nel

1911 il britannico Ernest Rutherford (1871–1937) ricorre al modello planetario per spiegare le

deviazioni dei raggi alfa che attraversano una lamina di metallo. L’ipotesi dei quanti entra in

gioco nel 1913, quando il danese Niels Bohr (1885-1962) elabora la versione quantistica del

modello atomico planetario: gli elettroni non orbitano attorno al nucleo a distanze qualsiasi,

ma solo a certe precise distanze associate a precisi livelli di energia, e, pur essendo carichi

elettricamente, non irradiano sempre, ma solo quando si spostano da un livello energetico a un

altro, emettendo radiazione di energia corrispondente alla differenza tra i livelli e con

lunghezza d’onda conforme all’ipotesi di Planck.

Una nuova proposta rivoluzionaria compare inoltre nel 1924, quando il francese Louis

de Broglie (1892-1987) formula l’ipotesi delle «onde materiali»: come, secondo la

spiegazione einsteiniana dell’effetto fotoelettrico, all’onda elettromagnetica è associato un

corpuscolo, così alla materia e ai suoi corpuscoli è associata un’onda, delle quali le equazioni

di de Broglie permettono di calcolare la lunghezza. L’ipotesi di de Broglie mira a spiegare la

quantizzazione del raggio orbitale riconosciuta da Bohr: le sole orbite possibili per l’elettrone

devono essere quelle in cui l’onda elettronica è stazionaria, dunque quelle in cui la lunghezza

dell’orbita è un multiplo della lunghezza d’onda dell’elettrone. Nel 1927 l’ipotesi di de

Broglie riceve una impressionante conferma sperimentale, quando gli statunitensi Clinton

Davisson (1881-1958) e Lester Germer (1896-1971) producono in laboratorio la diffrazione

dell’elettrone. È per affrontare questa singolare situazione osservata negli esperimenti che

nello stesso anno Bohr enuncia il suo «principio di complementarità»: tutti gli oggetti

microfisici presentano sia aspetti ondulatori sia aspetti corpuscolari, non devono essere

concepiti solo come onde o solo come corpuscoli. Il principio tuttavia suona misterioso: se la

18

luce e anche la materia possono essere interpretate come onde, che natura ha il mezzo

oscillante in cui si propagano tali onde? come è possibile che una particella dotata di massa e

che occupa una parte finita e discreta di spazio coincida con un’onda, che per sua natura nello

spazio si distribuisce con continuità?

Un primo tentativo di risposta viene dall’austriaco Erwin Schrödinger (1887-1961):

ogni ente fisico è in realtà un’onda; la particella è un «pacchetto d’onda», una

sovrapposizione di onde interferenti tra loro che non si annullano a vicenda solo in una

determinata estensione spaziale; quelle che appaiono abitualmente come le dimensioni della

particella dotata di massa, coincidono in realtà con l’estensione del pacchetto d’onda; la

velocità di ciò che appare abitualmente una particella dotata di massa è in realtà la velocità di

gruppo del pacchetto d’onda. L’ipotesi di Schrödinger si scontra tuttavia con una difficoltà: la

teoria dei fenomeni ondulatori prevede che il movimento del pacchetto d’onda immaginato

dall’austriaco dovrebbe dare luogo a un fenomeno di sparpagliamento, che i dati empirici,

invece, non confermano affatto.

Nel 1925 il fisico teorico tedesco Werner Heisenberg (1901-1976) accantona del tutto

tali domande, sceglie di mettere al centro della teoria un aspetto chiaramente osservabile e

misurabile degli stati dell’atomo di Bohr, la probabilità con la quale si verifica la transizione

dall’uno all’altro, associa le grandezze fisiche fondamentali a matrici che esprimono il sistema

di tali probabilità e esprime i dati noti relativi ai fenomeni microfisici nel formalismo

algebrico della «meccanica delle matrici». Nel 1926, poi, Schrödinger stesso fonda la

«meccanica ondulatoria», al centro della quale c’è un’importante equazione differenziale che

ha come soluzione la «funzione d’onda»: la funzione d’onda rappresenta lo stato d’insieme

del sistema microfisico e incorpora tutti i dati prevedibili riguardo alle grandezze fisiche

consuete, come energia, posizione e impulso; l’equazione di Schrödinger descrive

l’evoluzione temporale della funzione d’onda. Schrödinger dimostra inoltre l’equivalenza tra

la propria meccanica ondulatoria e la meccanica delle matrici di Heisenberg, le quali, infatti,

da allora saranno presentate in una formulazione integrata, detta abitualmente meccanica

quantistica.

Nel 1927, poi, Heisenberg ricava una sorprendente conseguenza della meccanica

quantistica, il «principio di indeterminazione»: l’errore minimo che si può compiere

misurando la posizione spaziale di un oggetto quantistico moltiplicato per l’errore minimo che

si può compiere misurando la sua quantità di moto non può mai essere inferiore a un certo

19

valore costante (così come non può esserlo il prodotto degli errori minimi compiuti

misurandone l’energia e la posizione temporale): quanto più esatto risulta il valore di una

grandezza, tanto meno lo è quello dell’altra. Per Heisenberg, nella fisica quantistica, lo stato

del sistema descritto dalla sua funzione d’onda è sempre dato per una certa grandezza da un

insieme di valori diversi associati a una peculiare probabilità. La misurazione altera la

funzione d’onda facendola collassare su un diverso insieme, in cui un dato valore della

grandezza viene ad avere probabilità 1 e gli altri probabilità 0, ma anche con l’effetto di

rendere più indeterminata la distribuzione delle probabilità per la grandezza che il principio

d’indeterminazione correla a quella misurata.

Ancora nel 1927 il tedesco Max Born (1882-1970) elabora una nuova ipotesi circa la

natura dei fenomeni quantistici. L’onda descritta dalla meccanica quantistica non deve essere

interpretata come una vera oscillazione. Piuttosto, essa è “onda” solo in un senso traslato, in

virtù dell’analogia formale e matematica che risulta esserci tra i veri fenomeni ondulatori e lo

stato dell’oggetto quantistico. Secondo Born, inoltre, il quadrato del modulo della funzione

d’onda che descrive lo stato dell’oggetto quantistico deve essere inteso come la densità di

probabilità di trovare l’oggetto in quello stato, se lo si sottopone a un processo di misura;

p.es., la densità di probabilità di trovare la particella in un certo punto dello spazio, se si

sottopone la particella a un processo di misura della sua posizione. Diversi fisici accettano

l’ipotesi di Born semplicemente come un nuovo assioma della meccanica quantistica da

accettarsi come tale, arrestando ogni ulteriore speculazione ontologica. Non Schrödinger, che

per parte sua cercherà invece sempre di elaborare la propria ipotesi sulla riduzione di ogni

ente fisico a onda, in modo da rendere tale ipotesi stessa conciliabile con i dati sperimentali.

Tutti comprendono comunque che è necessario abbandonare il modello planetario

dell’atomo. Le proprietà dell’atomo devono essere ricavate esclusivamente a partire dalla

funzione d’onda dell’elettrone: nella nuova concezione di atomo non esiste nulla di simile a

un orbita per gli elettroni; anzi, non viene avanzata alcuna ipotesi su come l’elettrone si

muova all’interno dell’atomo. C’è piuttosto l’«orbitale», una distribuzione nello spazio della

probabilità di trovare l’elettrone, se si sottopone l’elettrone a un processo di misura della sua

posizione, e questa è l’unica specificazione circa la struttura interna dell’atomo che lo

scienziato possa consentirsi.

Nello stesso 1927 al V Congresso Solvay di Fisica a Bruxelles, prevedibilmente, la

discussione intorno alla fisica quantistica si colora di filosofia. Da un lato si pone

20

l’«interpretazione di Copenaghen» proposta da Bohr, da Dirac, da Heisenberg e da Born.

Secondo loro la fisica quantistica è già solidamente fondata sulla coerenza del suo formalismo

matematico e sulla conferma delle sue predizioni osservative; chiedersi che cosa siano

davvero gli oggetti microfisici, al di là di ciò che afferma di loro la teoria nella sua

espressione formale, se essi siano cioè onde o corpuscoli, è avviarsi sulla strada di

speculazioni gratuite e uscire dai binari della scienza vera e propria. Dice Born: gli scienziati

non devono spiegare la natura dei quanti, ma solo imparare a usarli; non devono farsi

imprigionare da concetti superati di spazio, tempo, materia, composizione interna. Contro

l’interpretazione di Copenaghen, invece, si schierano de Broglie e Schrödinger, che inclinano

verso un’interpretazione più realistica del carattere ondulatorio dei fenomeni microfisici. E si

schiera soprattutto Einstein che giudica estraneo allo spirito scientifico accettare come fatti

definitivi l’indeterminazione e il carattere probabilistico della meccanica quantistica nella

formulazione dovuta a Heisenberg e a Schrödinger. Per lui, «Dio non gioca a dadi con

l’universo». È convinto che il probabilismo della meccanica quantistica sia dovuto alla nostra

incompleta conoscenza della natura e che il futuro permetterà di individuare i «parametri

nascosti», conosciuti i quali anche la microfisica assumerà la forma deterministica che la

scienza richiede.

Il dibattito tra i filosofi della scienza non può non accettare i termini della discussione

filosofica imposta dagli scienziati stessi. Il Circolo di Vienna sarà il principale luogo

intellettuale per la ricezione schiettamente filosofica di tale discussione.

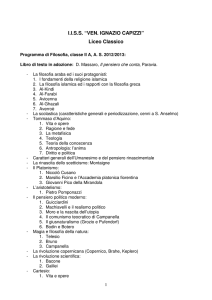

Le origini dell’empirismo logico

Il Circolo di Vienna si forma intorno al tedesco Moritz Schlick (1882-1936). Allievo di

Planck, dal 1922 presso l'Università di Vienna è titolare della cattedra di filosofia delle

scienze induttive, che era stata di Mach e di Boltzmann. Le sue prime pubblicazioni sono

dedicate alla discussione del valore filosofico della teoria della relatività. Sostiene, in pieno

accordo con il tedesco Hans Reichenbach (1891-1953), che la teoria einsteiniana confuta in

modo definitivo la tesi della conoscenza sintetica a priori difesa da neokantiani come Ernst

Cassirer (1874-1945) e dai seguaci di Edmund Husserl (1859-1938). Comincia a interessarsi

di filosofia del linguaggio sotto la suggestione del Tractatus logico-philosophicus di Wittgenstein. Dell'opera lo colpiscono soprattutto la tesi del carattere analitico di tutta quanta la

logica, che, secondo il punto di vista «logicista» dei matematici Gottlob Frege (1848-1925) e

21

Bertrand Russell (1872-1970), include la matematica stessa, la tesi della natura non-referenziale delle verità analitiche, e la tesi della assenza di significato dell'intera problematica

metafisica. Sono esse, prese insieme con la classica tesi empiristica del carattere

necessariamente empirico della conoscenza fattuale, a costituire la base teorica comune dell'orientamento filosofico del quale Schlick diviene promotore, che sarà detto «empirismo

logico» (o, meno propriamente, «positivismo logico», «neopositivismo» e «neoempirismo»).

Intorno al seminario tenuto da Schlick si forma, a partire dal 1923, l'Associazione Ernst

Mach, indicata anche col nome di Circolo di Vienna. Ne fanno parte i filosofi Friedrich

Waismann (1896-1959) e Herbert Feigl (1902-1988), il matematico Hans Hahn (1879-1934),

il fisico Philipp Frank (1884-1966), lo storico Victor Kraft (1880-1975), il sociologo Otto

Neurath (1882-1945), il giurista Felix Kaufmann (1895-1949). Hanno contatti occasionali col

gruppo anche il giurista Hans Kelsen (1881-1973), nonché i logici Kurt Gödel (1906-1978) e

Alfred Tarski (1901-1983). Dal 1925 i membri del Circolo tengono delle riunioni settimanali

il giovedì sera. Nel 1926 entra a far parte del Circolo il tedesco Rudolf Carnap (1891-1970),

allievo del matematico Frege e da quell'anno istruttore di filosofia presso l'Università di

Vienna. Nel 1926 il Circolo studia e discute il Tractatus di Wittgenstein.

Il Circolo di Vienna stabilisce legami con i filosofi di analogo orientamento che formano la Scuola di Berlino, promossa da Reichenbach. Reichenbach ha studiato con Planck,

Hilbert, Einstein e Cassirer. Dal 1926 al 1933 è professore di filosofia della fisica presso l'Università di Berlino. Ne La filosofia dello spazio e del tempo (1928), sostiene che la teoria

einsteiniana della relatività rappresenta una confutazione definitiva delle tesi di Kant intorno

allo spazio e al tempo e difende la tesi realista dell'esistenza del mondo esterno, interpretandola d'altra parte non come una verità a priori, bensì semplicemente come una valida

ipotesi empirica. Profondamente interessato alla riflessione sulle tematiche della nuova fisica,

nei Fondamenti filosofici della meccanica quantistica (1944), sosterrà che la teoria dei quanti

richiede una logica non classica, avviando le ricerche sulla formalizzazione della logica

quantistica. L'opera che più di ogni altra riassume la sua complessiva visione della filosofia

della scienza è La nascita della filosofia scientifica (1951).

Nel 1928 Reichenbach raccoglie attorno a sé un circolo filosofico di cui fanno parte

Carl Gustav Hempel (1905-1997), suo allievo, e il matematico austriaco Richard von Mises

(1883-1953). Tra la Scuola di Berlino e il Circolo di Vienna si stabiliscono subito contatti

22

intellettuali, che culminano nel 1930 con la fondazione della rivista "Erkenntnis", diretta

insieme da Reichenbach e Carnap.

Altre personalità filosofiche dialogano con l’empirismo logico. Ha contatti col Circolo

di Vienna, sebbene resti su posizioni autonome, l'austriaco Karl Raimund Popper (19021994). Da ricordare infine che con Schlick, con Waismann, e più saltuariamente anche con

altri membri del Circolo di Vienna, tra il 1927 e il 1932, ha degli incontri lo stesso Wittgenstein. È in sintonia col Circolo di Vienna poi anche l'inglese Alfred J. Ayer (1910-1989),

ricercatore al Christ Church College di Oxford, autore di Linguaggio, verità e logica (1936),

che introduce nell’empirismo logico molti spunti tradizionali dell'empirismo inglese sei-settecentesco.

Nel 1929, viene pubblicata a firma di Neurath, Carnap e Hahn La concezione scientifica

del mondo, manifesto programmatico dell'empirismo logico. Il manifesto denuncia come

«privi di senso» gli enigmi insolubili della metafisica, si pronuncia a favore di una

«concezione scientifica del mondo» «empiristica e positivistica», elogia l'impiego dei concetti

formali elaborati dai logici matematici allo scopo di dissipare le oscurità del linguaggio

ordinario, propone la ridefinizione della filosofia come disciplina «fondazionale» volta non a

espandere il sapere, bensì a ottenere la sua chiarificazione per mezzo della «analisi logica» del

linguaggio, delinea l'obiettivo di una «scienza unificata» capace di soddisfare la vocazione

essenzialmente intersoggettiva dell'impresa scientifica. Il manifesto sottolinea inoltre la

continuità della concezione scientifica del mondo con la tradizione umanistica e illuministica,

prendendo posizione contro il vitalismo in biologia, contro lo spiritualismo nelle scienze

storico-sociali, e viceversa a favore del comportamentismo, dell'utilitarismo, dell'atteggiamento demistificatore caratteristico di Feuerbach e di Marx.

Schlick e il verificazionismo

La dottrina che l’empirismo logico deglle origini ritiene più cruciale è la concezione

verificazionista del significato: il senso dell'enunciato consiste nelle condizioni della sua

possibile verificazione, cioè è dato dalle possibili esperienze che proverebbero la sua verità.

Questa aveva trovato le prime embrionali formulazioni già negli scritti del francese Auguste

Comte (1798-1857) e dello statunitense Charles Sanders Peirce (1839-1914). Peirce in

particolare desume il verificazionismo dalla concezione pragmatistica che pone la funzione

del pensiero nella creazione di abiti di azione: hanno senso diverso tra loro solo gli enunciati

23

la cui eventuale verità comporta qualche differenza in rapporto al nostro agire; dunque solo

quelli la cui verità può essere accertata da noi empiricamente per mezzo di esperienze

distinguibili tra loro. Su analoghe posizioni sarà, nel quadro della complessiva egemonia

pragmatista che caratterizza la filosofia americana dei primi decenni del XX secolo, Percy

William Bridgman con l’«operazionismo» di La logica della fisica moderna (1927) e La

natura della teoria fisica (1936). Fisico in primo piano nella discussione intorno alla teoria

einsteiniana della relatività, Bridgman sostiene che tutti i concetti scientifici, e in particolare i

diversi concetti scientifici di lunghezza e di durata, ricevono il loro significato dalle

operazioni che ci consentono di effettuarne una applicazione corretta. Egli ritiene che molti

problemi filosofici siano privi di significato appunto per l'assenza di un significato operativo.

Secondo Bridgman, lo stesso concetto di esistenza equivale al concetto di operatività:

riconoscere una cosa come esistente non è altro che riconoscere il successo operativo della

sua idea.

Nell’ambito dell’empirismo logico è Schlick soprattutto a elaborare la spiegazione

verificazionista del significato. La espone in diversi scritti, tra i quali Positivismo e realismo

(1932). Per Schlick la verificabilità empirica non è solo un requisito per la produttività e la

affidabilità delle nostre asserzioni. È la condizione necessaria e sufficiente della loro significanza: dicono qualcosa solo gli enunciati empiricamente verificabili, e il loro significato è

dato precisamente dalle condizioni della loro possibile verifica, e cioè dalle esperienze

suscettibili di provare la loro verità. Coloro che asseriscono enunciati incapaci di verifica non

danno affatto un senso alle loro parole: le loro asserzioni sono letteralmente vuote, non dicono

nulla. Gli insegnamenti della scienza sono verificabili e hanno dunque un senso. Le

proposizioni della metafisica, della religione, dell'etica e dell'estetica non sono verificabili e

non hanno perciò alcun senso: esse possono manifestare le emozioni di chi le accetta, ma non

enunciano alcuno stato di cose. Non enunciano in particolare neppure il fatto che chi le fa sue

prova certe determinate emozioni. Un conto è infatti lasciare trasparire le emozioni, un conto

è descriverle: lasciare trasparire le emozioni è solo un esito involontario per pronunciamenti,

come quelli di gran parte della filosofia tradizionale, semanticamente vuoti. A partire dalla

concezione verificazionista Schlick sostiene in particolare il carattere metafisico, e perciò

privo di senso, della contrapposizione tra realismo e fenomenismo.

Schlick arriva a queste posizioni riflettendo sui presupposti teorici della concezione del

senso dell'enunciato che era stata elaborata da Frege e da Wittgenstein. Frege aveva distinto

24

tra il senso dell'espressione linguistica (il pensiero che ci guida nel suo impiego) e il suo

riferimento (la cosa che è indicata da essa). Egli aveva sostenuto che il senso dell'enunciato è

dato dalle sue condizioni di verità: hanno il medesimo senso gli enunciati che sarebbero veri

nelle medesime condizioni, nelle stesse situazioni. Il Tractatus di Wittgenstein aveva

esplicitato presupposti e conseguenze della concezione fregeana.

Schlick giunge alla concezione verificazionista, integrando l’idea che il senso

dell’enunciato sia dato dalle sue condizioni di verità con l’idea che il senso dell’enunciato è

qualcosa che le persone possono comprendere, comunicare e spiegare: deve sempre essere

possibile stabilire se l’enunciato è usato correttamente (cioè secondo il suo significato) o

scorrettamente (cioè in modo incompatibile col suo significato). Dunque deve sempre essere

possibile stabilire se l’impiego dell’enunciato è vero o falso: il sussistere delle condizioni di

verità deve essere accertabile; le condizioni di verità devono essere anche condizioni di

verificazione.

L’antimetafisica del Circolo di Vienna

A Wittgenstein i filosofi viennesi si sentono vicini anche per la tesi che le proposizioni

metafisiche siano prive di senso. Il tentativo di enunciare la struttura della realtà appartiene

alla metafisica e si condanna dunque automaticamente al non-senso; l'ontologia è in linea di

principio impossibile. I metafisici credono di parlare di qualcosa: in realtà essi parlano di

niente, perché non hanno assegnato alcun senso alle parole del loro linguaggio.

Ne Il superamento della metafisica mediante l'analisi del linguaggio (1931), Carnap in

particolare dichiara che la metafisica esprime il nostro atteggiamento nei confronti della vita,

ma non enuncia alcunché. Essa è più vicina all'arte che alla scienza: come l'arte infatti può

dare voce ai sentimenti, ma non allargare la conoscenza. L'arte però sa parlare a tutti gli

uomini, la metafisica invece si risolve in un esoterico rincorrersi di parole insensate o

combinate in maniera insensata. L'analisi rivela infatti che parole metafisiche come 'principio'

o 'Dio' sono state gradualmente private del loro originario significato empirico, senza tuttavia

che esse abbiano ricevuto alcuno specifico nuovo significato: nessuno saprebbe indicare quali

siano le condizioni empiriche di verità della loro applicazione, e, dunque, che cosa possa

renderle comprensibili. I metafisici sono solo «musicisti senza talento musicale».

I filosofi del Circolo di Vienna tuttavia non intendono la tesi che la metafisica è priva di

senso allo stesso modo di Wittgenstein. Sono assai lontani da lui sia nella giustificazione che

25

danno di tale tesi, sia nelle risonanze assiologiche di cui la investono, sia nelle conseguenze

che ne traggono riguardo ai compiti della filosofia. Essi infatti ritengono che la metafisica sia

priva di senso perché è in linea di principio inverificabile attraverso l'esperienza. Per loro, l'enunciato trae il suo senso dalle condizioni della sua possibile verifica empirica. Wittgenstein

invece ritiene che la metafisica sia priva di senso perché essa si propone di enunciare ciò che è

privo di alternative, dunque non determinabile per contrasto con niente altro, e di conseguenza

indicibile. Almeno originariamente, i filosofi viennesi non sono consapevoli di questa

divergenza di punti di vista: leggono nel Tractatus l'affermazione che il senso di un enunciato

dipende dal suo confronto con i fatti, e intendono questo confronto come esperienza

verificante o falsificante, laddove Wittgenstein lo intendeva in maniera più neutra come

possibilità dell'enunciato di accordarsi o non accordarsi con i fatti, e cioè di disporre di

alternative concepibili. Per essi, inoltre, il fatto che gli enunciati metafisici siano privi di senso

implica che essi sono privi di importanza. Per Wittgenstein invece la metafisica, con i suoi

interrogativi incapaci di risposta e con le sue ribellioni alla logica, è di vitale importanza: i

problemi insolubili della metafisica danno voce al disagio del nostro vivere. Wittgenstein non

sacralizza affatto ciò che è dicibile. I viennesi infine pensano che, accantonata la metafisica, la

filosofia debba dedicarsi al più produttivo compito di codificare la logica del linguaggio.

Wittgenstein pensa invece che non ci sia alcun modo di enunciare tale logica, e risolve tutto il

lavoro filosofico nell'impresa nichilistica di porre termine alla filosofia. Così, il filosofo

viennese che maggiormente comprende il Tractatus, è paradossalmente proprio Otto Neurath,

che rifiuta il pensiero di Wittgenstein perché ne afferra l'intimo coinvolgimento con la metafisica e l'incompatibilità col progetto di una filosofia scientifica.

Carnap: La costruzione logica del mondo

Allievo di Frege, Carnap viene già da studente a conoscenza delle ricerche di Russell. Si

laurea con una tesi di impostazione neokantiana intorno al concetto di spazio. Nel 1923 entra

in contatto con Reichenbach e, per suo tramite, con Schlick. La sua Costruzione logica del

mondo (1928) influenza largamente le posizioni iniziali del Circolo di Vienna. Nell'opera

Carnap spiega come l'intero edificio del sapere possa essere ridotto a enunciati esprimenti il

contenuto dell'esperienza immediata.

Carnap infatti sostiene che tutti i concetti di interesse scientifico grazie ai quali

conosciamo la realtà si lasciano risolvere in semplici rappresentazioni dell'esperienza imme-

26

diata. Egli sottolinea il fatto che i concetti impiegati entro un certo ambito scientifico possono

essere analizzati come «costruzioni logiche» di concetti appartenenti ad ambiti più elementari:

che i concetti più complessi, cioè, possono essere sostituiti da opportune combinazioni degli

altri, in modo tale che, senza la pretesa di riprodurre il senso dei primi, i secondi riproducano

almeno il loro riferimento, e cioè le cose che essi indicano. In particolare, per Carnap, i

concetti del «campo spirituale», usati dalle scienze sociologiche, possono essere riportati a

quelli psicologici del «campo psichico altrui»: i concetti relativi a collettivi di uomini possono

essere analizzati in termini di azioni e di condizioni psichiche dei singoli esseri umani che

fanno parte di essi. A loro volta, i concetti psicologici possono essere riportati a quelli

naturalistici del «campo fisico», interpretando comportamentisticamente ciascun fenomeno

mentale come la disposizione a realizzare un determinato tipo di atti. I concetti delle scienze

naturali, poi, possono essere definiti attraverso quelli del «campo psichico proprio»,

intendendo ogni espressione relativa a corpi come una costruzione logica di espressioni

relative a dati di senso. Noi infine possiamo classificare i dati di senso senza ulteriori mediazioni grazie all'esperienza del «riconoscimento di similarità».

Ora, d'altra parte, Carnap insiste sul fatto che una simile catena di procedimenti riduttivi

ha un puro valore convenzionale, e che non deve essere considerata come una ricostruzione

dei 'veri' rapporti sussistenti tra i 'livelli della realtà': essa infatti vale solo come una possibile

scelta «metodologica», utile soprattutto a esibire le basi empiriche che nei diversi campi

scientifici dovrebbero orientare le nostre assunzioni, e non come una teoria «ontologica»

riguardante la natura delle cose. Carnap non vuole affatto sostenere, con il fenomenismo di

Mach e di Russell, che i dati di senso siano i costituenti ultimi di tutta quanta la realtà. Ritiene

infatti che ogni teoria circa la struttura della realtà sia parimenti inverificabile e perciò priva

di senso. La metafisica fenomenista è dunque per lui altrettanto inconsistente della metafisica

materialista. Ciò che è legittimo, invece, è trattare il fenomenismo come una convenzione

concettuale utile in particolare ai fini della ricerca epistemologica, e assumerne il linguaggio,

senza preclusioni per eventuali opzioni alternative: Carnap insiste sul fatto che il linguaggio

materialista, che assume come primari i nomi di oggetti fisici, potrebbe essere altrettanto utile

in vista di ulteriori scopi.

Dalle considerazioni di Carnap molti esponenti dell'empirismo logico si fanno

convincere del fatto che un fenomenismo accettabile dovrebbe avere carattere metodologico e

non ontologico: primo tra tutti Schlick, che è il punto di riferimento riconosciuto della

27

corrente. Anche Schlick infatti accetta la natura puramente convenzionale del linguaggio

fenomenistico e riconosce come priva di senso l'intera controversia metafisica tra

fenomenismo e materialismo.

Il dibattito sul verificazionismo

In seno al Circolo di Vienna non regna una piatta unanimità. Già nei primi anni Trenta

le tesi verificazioniste di Schlick suscitano un importante dibattito filosofico. Con Schlick si

schiera Wittgenstein stesso, che, probabilmente anche sotto l'influenza del costruttivismo

matematico di Luitzen Brouwer (1881-1966), tra il 1929 e il 1930 rielabora le posizioni

originarie espresse nel Tractatus e si avvicina al verificazionismo.

Sono in molti però a ritenere opportuno un indebolimento del principio di verificazione.

Tutti sono d’accordo che se un enunciato sintetico non risultasse almeno indirettamente

controllabile sulla base dell’esperienza, esso dovrebbe essere ritenuto privo di senso. Ma in

molti sottolineano il fatto che anche buona parte degli enunciati sintetici apparentemente

dotati di senso, nella stessa scienza e non solo nei campi più speculativi della filosofia, sono

incapaci di sottostare un controllo empirico completo. Non sono dunque a stretti termini

verificabili.

Così pensa lo stesso Wittgenstein. Per un indebolimento del principio si pronuncia del

resto anche Ayer. Ayer osserva che ogni enunciato contiene più informazioni di quanta ne

contenga una particolare esperienza: nell'enunciato infatti il dato di senso viene classificato

per mezzo di termini universali e dunque messo in rapporto con i dati di altre esperienze. Egli

propone dunque di dichiarare significante solo l'enunciato che, in congiunzione con altri

enunciati, consente di dedurre delle conseguenze osservative che non potrebbero essere dedotte senza di esso. Ayer si pronuncia inoltre per una concezione non egocentrica della

verificabilità: l'enunciato non è verificabile solo se è verificabile adesso da parte nostra, ma se

è verificabile comunque per qualcuno in qualche tempo; ciò permette in particolare, secondo