Capitolo 2

Strutture

2.1 Strutture e tipi

Una struttura A e costituita da un insieme A, il dominio della struttura, e da

una successione di relazioni su A, funzioni su A e individui di A detti costanti.

Il concetto di struttura e molto duttile e consente di rappresentare in modo

ecace diverse situazioni di carattere empirico e teorico. Ridurre una situazione

a una struttura signica ricondurla nell'ambito dell'algebra. Il passaggio da

una situazione \concreta" a una struttura \astratta" e un impoverimento, nel

senso che molti dettagli, molti aspetti specici vanno inevitabilmente perduti,

tuttavia non si deve concepire il sacricio dei particolari come un limite di

questo modo di procedere, dato che buona parte dell'attivita conoscitiva umana

consiste precisamente nella produzione di astrazioni che isolano, in una certa

realta, cio che si ritiene essenziale da cio che si ritiene contingente, gli aspetti

fondamentali da trasferire nella struttura, dagli aspetti che invece si ritengono

inessenziali.

Esaminiamo alcuni esempi di strutture che saranno utili in seguito. Consideriamo la porzione di realta costituita da tutti i sottoinsiemi di un dato insieme

A. E possibile organizzare questi oggetti in una struttura isolando la relazione

di inclusione fra insiemi come un aspetto fondamentale della realta: otteniamo

cos la struttura costituita dall'insieme ordinato (P(A); ). Nella stessa realta

insiemistica di base si possono invece considerare come fondamentali le operazioni insiemistiche di intersezione, unione e complemento e quegli insiemi molto

particolari che sono ; e A: otteniamo cos la struttura (P (A); \; [; ;; ;; A),

detta algebra dell'insieme potenza, che indicheremo con B(A). Scegliendo le relazioni, le funzioni e le costanti che fanno parte della struttura, dichiariamo cio

che riteniamo fondamentale nella realta in esame e a diverse scelte degli elementi

caratterizzanti corrispondono diverse strutture.

Una prima classicazione delle strutture si ottiene mediante la nozione di

tipo, ossia isolando il linguaggio necessario per nominare le relazioni, le funzioni

e le costanti presenti nella struttura: strutture dello stesso tipo sono descrivibili

34

Capitolo 2. Strutture

col medesimo linguaggio. Piu precisamente un tipo e una quadrupla

= (fRigi2I ; fFj gj 2J ; fck gk2K ; ar)

che soddisfa le condizioni seguenti. Le successioni fRigi2I , fFj gj 2J e fck gk2K

non contengono ripetizioni. Indicheremo con Rel, Fun e Cos le immagini di

queste funzioni. L'insieme Rel contiene i simboli di relazione, Fun i simboli di

funzione e Cos i simboli di costante : supporremo che questi insiemi di simboli

non abbiano elementi in comune. La funzione ar : Rel [ F un ! ! assegna

ad ogni simbolo di relazione e di funzione un numero naturale detto arieta del

simbolo e parleremo quindi di simboli funzionali e relazionali n-ari. I simboli di

relazione 1-ari sono detti anche simboli di predicato. Se e un tipo, deniamo

struttura di tipo una coppia A = (A; I ), dove A e un insieme non vuoto, detto

dominio della struttura, e I e una funzione, detta interpretazione , che assegna

ad ogni simbolo di relazione una relazione su A, ad ogni simbolo di funzione una

funzione su A e ad ogni simbolo di costante una costante di A, ossia un elemento

di A, in modo che le arieta dei simboli di relazione e di funzione corrispondano

a quelle delle relazioni e funzioni loro assegnate. In altri termini:

1. per ogni simbolo relazionale n-ario, I (Ri) An,

2. per ogni simbolo funzionale n-ario, I (Fj ) : An ! A,

3. per ogni simbolo di costante, I (ck ) 2 A.

La restrizione a strutture con dominio non vuoto e essenziale. Se ammettessimo

strutture con dominio vuoto dovremmo modicare la logica classica, nella quale

l'esistenza di almeno un oggetto e formalmente dimostrabile (si veda il paragrafo 4.6). In alcune trattazioni i simboli di costante sono eliminati a favore di

simboli di funzioni 0-arie, dato che una funzione 0-aria su A consiste nella scelta

di un individuo di A. Scriveremo RAi al posto di I (Ri) per semplicita e per

sottolineare il legame con la struttura A. Lo stesso dicasi per simboli di funzione e di costante. Adotteremo la notazione (A; fRAi gi2I ; fFjAgj 2J ; fcAk gk2K )

per denotare la struttura (A,I ), senza indicare il tipo e la funzione arieta in

modo esplicito. Quando relazioni, funzioni e costanti sono in numero nito, ci

limiteremo ad elencarle, dopo il dominio, in un'unica successione. A volte scriveremo semplicemente R invece di RA , quando non ci sia pericolo di confondere

il simbolo di relazione con la relazione stessa. Lo stesso dicasi per i simboli di

funzione e di costante. Puo accadere che il tipo di una struttura non contenga

del tutto simboli, in questo caso la struttura A si riduce a un semplice insieme

A. Se mancano i simboli di funzione e di costante, allora parliamo di struttura

relazionale, se mancano quelli di relazione, parliamo di struttura algebrica.

Ogni tipo da origine a innite strutture di quel tipo, sia perche e possibile

scegliere insiemi diversi come dominio dell'interpretazione, sia perche, una volta

scelto un insieme come dominio, esiste una varieta di modi distinti di interpretarvi i simboli del tipo. Sul dominio ! possiamo considerare sia la struttura

relazionale A = (!; A), dove A e la relazione di minore o uguale, sia la struttura relazionale B = (!; B ), dove B e la relazione \x divide y". Avremo

2.2. Iso e monomorsmi

35

dunque 2 A 3 e non 2 B 3. La scelta di adottare il simbolo invece di R

e dettata solo dal fatto che suggerisce l'idea di un ordine parziale, ma solo

A e la \vera" relazione di minore o uguale. Sempre su ! possiamo denire

sia la struttura algebrica A = (!; S A ; 0A), dove S A e la funzione successore

e 0A il numero zero, sia la struttura algebrica B = (!; S B ; 0B ), dove S B e la

funzione elevamento al quadrato e 0B il numero 2. Avremo dunque S A (0A) = 1

e S B (0B ) = 4. In linea di principio l'interpretazione di un simbolo del tipo non

e soggetta ad alcun vincolo, tranne il rispetto delle arieta, quindi non bisogna

lasciarsi fuorviare dall'aspetto di simboli come +, e 0, che possono ricevere

interpretazioni che nulla hanno da spartire con somma, minore o uguale e zero.

La distinzione tra R e RA, tra un simbolo e la sua interpretazione, e particolarmente utile quando il discorso verte su strutture dierenti in cui lo stesso

simbolo riceve interpretazioni diverse, altrimenti la distinzione puntigliosa tra

i simboli e le loro interpretazioni appesantisce eccessivamente il discorso. Ci

sara quindi consentito adottare la notazione (P (A); \; [; ;; ;; A) per quella

che formalmente e una struttura di tipo = (;; fFigi23; fck gk22; ar) dove

ar(F0 ) = ar(F1) = 2 e ar(F2 ) = 1. Il lettore dovrebbe essere in grado, ogni volta

che in seguito verra presentata una struttura in modo informale, di ricostruirne

la presentazione rigorosa e di individuarne il tipo.

Per convincersi della duttilita del concetto di struttura puo essere utile cercare di analizzare in termini di strutture varie realta concrete della nostra esperienza, individuando prima gli elementi dell'insieme coinvolto, quindi le funzioni

e le relazioni che li legano. E' sorprendente quanto di ogni specica situazione

possa essere travasato in una struttura: piu la nostra analisi sara dettagliata,

maggiore sara il numero delle costanti, delle funzioni e delle relazioni coinvolte

nella rappresentazione.

2.2 Iso e monomorsmi

Gli individui che appartengono al dominio di una struttura non sono tanto caratterizzati da una loro sostanza, quanto dai rapporti che li legano agli altri

individui: un individuo e cio che e solo in virtu delle relazioni che lo legano

agli altri. Quindi se una struttura e ottenuta da un'altra semplicemente sostituendo gli individui del dominio della prima con altri, e tuttavia mantenendo

inalterato il loro comportamento rispetto a relazioni e funzioni, non la si dovra

considerare come qualcosa di essenzialmente diverso dalla prima. Sulla base

di questa osservazione possiamo concepire l'essenza di una struttura come cio

che e invariante rispetto a questo tipo di sostituzione, ossia la forma generale

dei rapporti in cui entrano tali individui in virtu delle funzioni e delle relazioni

della struttura. La sostanza degli individui che la compongono diviene un fatto

accidentale, un aspetto del tutto marginale della realta. Questo punto di vista

da origine a un nuovo tipo di sostanza e porta in primo piano il linguaggio, mediante il quale vengono rappresentati i rapporti tra gli individui della struttura,

come strumento di individuazione della natura profonda degli oggetti.

Per chiarire questo punto di vista consideriamo la struttura A = (A; ) dove

36

Capitolo 2. Strutture

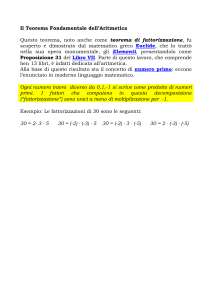

A = P(fa; b; cg) e e la relazione di inclusione, e la struttura B = (B; j) dove

B = f1; 2; 3; 5; 6; 10;15;30g e j la relazione \divide". Adottando la rappresentazione introdotta nel paragrafo 1.4 per gli insiemi parziali, le due strutture

possono essere ragurate nel modo seguente:

fa; b; cg

; @@

;

@

;

fa; bg fa; cg fb; cg

@@; @@;

;@ ;;@

;

fag

fbg

fcg

@@

;

;

@;;

30

; @@

;

; 10 @15

6

@@; @@;

;@ ;;@

;

2

3

5

@@

;

;

@1;

Deniamo ora una biiezione ' : A ! B che associ ad ogni punto di A il punto

omologo di B. E evidente allora che, per ogni x; y 2 A, x y sse '(x)j'(y):

due insiemi sono inclusi l'uno nell'altro sse il numero che e immagine del primo

divide il numero che e immagine del secondo. Comunque si scelga un oggetto in

A, le sue relazioni con gli oggetti di A si rispecchiano esattamente nelle relazioni

che la sua immagine in B intrattiene con le immagini in B degli altri oggetti di

A. Che cosa distingue le due strutture? Solo la natura degli oggetti del dominio,

ma non la forma dei rapporti che gli oggetti intrattengono fra di loro. Si osservi

che nel passaggio da A a B sono conservati anche i rapporti negativi, oltre a

quelli positivi: il fatto chefbg * fa; cg si riette in 3 - 10.

Consideriamo un altro esempio in cui le strutture in gioco contengono funzioni e costanti : sia C = (P (A); \; [; ;; A) dove A = fa; bg e \ e [ sono le

usuali operazioni di intersezione e unione, e sia D = (B; MCD; mcm; 1; 6) dove

B = f1; 2; 3; 6g e MCD e mcm sono rispettivamente le operazioni di \massimo

comun divisore" e \minimo comune multiplo". (Si noti che le due strutture

hanno lo stesso tipo dato che sono costituite entrambe da due funzioni binarie e

da due costanti.) Deniamo ora una biiezione : P(A) ! B ponendo (;) = 1,

(fag) = 2, (fbg) = 3, (fa; bg) = 6. Le due tabelle seguenti rappresentano

le funzioni \ e MCD:

MCD 6 3 2 1

\ fa; bg fag fbg ;

fa; bg fa; bg fag fbg ;

6

6 3 2 1

fag fag fag ; ;

3

3 3 1 1

fbg fbg ; fbg ;

2

2 1 2 1

;

;

; ; ;

1

1 1 1 1

Si noti che gli elementi della seconda tabella sono ottenuti dagli elementi omologhi della prima mediante l'applicazione di . Lo stesso si verica per le due

tabelle seguenti, che rappresentano rispettivamente [ e mcm:

2.2. Iso e monomorsmi

[

fa; bg

fag

fbg

;

fa; bg fag fbg

;

fa; bg fa; bg fa; bg fa; bg

fa; bg fag fa; bg fag

fa; bg fa; bg fbg fbg

fa; bg fag fbg

;

37

mcm 6 3 2 1

6 6 6 6 6

3 6 3 6 3

2 6 6 2 2

1 6 3 2 1

Cio signica che se si sostituiscono gli insiemi coi numeri, secondo il criterio

fornito da , intersecare e come calcolare il massimo comun divisore, riunire e

come calcolare il minimo comune multiplo. In altri termini, per ogni x; y 2 P (A)

(x \ y) = MCD( (x); (y)) e (x [ y) = mcm( (x); (y)):

Il tipo di rapporto tra strutture illustrato dagli esempi precedenti si puo vedere come un trasferimento di forma da una struttura all'altra, ossia come un

morsmo. In questo paragrafo studieremo alcuni dei principali tipi di morsmi: si tratta di relazioni fra strutture la cui importanza trascende l'algebra,

se si pensa a quante delle nostre modalita conoscitive siano catalogabili come

metafore, come \riconoscere che qualcosa e, sotto certi aspetti, anche qualcosa

d'altro", a quante conoscenze mirino a stabilire qualche tipo di \identita di

struttura". Per prima cosa sottolineiamo che si parla di morsmi solo fra strutture del medesimo tipo, infatti le strutture di tipo , per quanto diversi possano

essere i loro domini, sono accomunate dal fatto di contenere solo relazioni, funzioni e costanti descrivibili coi simboli di e cio ci permette di individuare in

esse le relazioni, le funzioni e le costanti corrispondenti, ossia denotate dal medesimo simbolo. Quindi, se A e B sono due strutture di tipo e R e un simbolo

relazionale di , le relazioni RA e RB sono corrispondenti. In modo analogo

parleremo di funzioni e di costanti corrispondenti. Gli oggetti corrispondenti,

per quanto diversi fra loro, avranno la stessa arieta. Ogni morsmo da A verso

B presenta le caratteristiche seguenti: a) esiste una funzione ' : A ! B che

crea un'immagine del dominio di A entro il dominio di B, b) le immagini degli

individui di A giocano i medesimi ruoli rispetto alle relazioni, alle funzioni e

alle costanti corrispondenti. Cio signica che, identicando RA con RB , F A

con F B , cA con cB e a 2 A con '(a) 2 B, possiamo trasferire la forma di A

entro B. Veniamo ora alla denizione formale. Date A e B dello stesso tipo

= (fRigi2I ; fFj gj 2J ; fck gk2K ), diremo che una biiezione ' : A ! B e un

isomorsmo se per ogni Ri , Fj e ck del tipo , per ogni a0; : : : ; an;1 2 A:

i) RAi (a0 ; : : : ; an;1) sse RBi ('(a0 ); : : : ; '(an;1)),

ii) '(FjA(a0; : : : ; an;1)) = FjB('(a0 ); : : : ; '(an;1)),

iii) '(cAk ) = cBk .

La struttura A e isomorfa a B se esiste un isomorsmo di A verso B. Se A

e isomorfa a B, lo indichiamo scrivendo A ' B. E' facile vericare che la

relazione di isomorsmo fra strutture di tipo e una relazione di equivalenza,

ossia e riessiva, simmetrica e transitiva, quindi l'insieme di tutte le strutture di

tipo puo essere ripartito in classi di equivalenza di strutture isomorfe tra loro.

38

Capitolo 2. Strutture

Ai ni del nostro discorso strutture isomorfe sono considerate come la stessa

struttura, quindi ogni volta che parleremo di A in realta il discorso varra per

tutte le strutture della classe di equivalenza di A rispetto a '. Il lettore dovrebbe

ritornare agli esempi precedenti e vericare che ' e sono eettivamente degli

isomorsmi, rispettivamente, tra A e B e tra C e D. Nel primo caso occorrera

vericare la i), mentre nel secondo caso occorrera vericare la ii) e la iii). (Lo

schema della ii) si riproduce in modo piu evidente, se scriviamo \(x; y) invece

di x \ y e [(x; y) invece di x [ y.) L'esempio seguente dovrebbe chiarire come le

costanti contribuiscano a costituire quella \forma" che deve essere conservata nei

morsmi. Se A = (!; <; cA) e B = (! ;f0g; <; cB ), l'esistenza di un isomorsmo

dipende dall'interpretazione della costante c. Se cA e cB sono il medesimo

oggetto, per esempio il numero 1, non esiste isomorsmo tra A e B. Se esistesse

dovrebbe valere '(cA ) = cB . Come scegliere ora '(0)? Comunque si ponga

'(0) = n, dovra essere n > 1 e questo impedisce che la relazione 0 <A cA sia

conservata da ', dato che non potra valere '(0) <B cB . Per avere isomorsmo

occorre che cA e cB giochino il medesimo ruolo rispetto alla relazione denotata

da <, quindi se interpretiamo cA come 1, cioe come secondo elemento di A,

occorre che cB sia 2, il secondo elemento di B. A questo punto la funzione

'(n) = n + 1 puo connettere gli elementi di A a quelli di B in modo che le

relazioni siano conservate.

Se nella denizione di isomorsmo richiediamo solo che ' sia iniettiva (e non

necessariamente suriettiva), otteniamo il concetto di monomorsmo . Diremo

che A e immergibile in B se esiste un monomorsmo di A verso B. Se ' : A

! B e un monomorsmo, possiamo utilizzare ' per creare una nuova struttura

C di dominio '[A] nel modo seguente: per ogni x0; : : : ; xn;1 2 '[A] deniamo

1. RC (x0; : : : ; xn;1) sse RA (';1 (x0); : : : ; ';1 (xn;1)),

2. F C (x0 ; : : : ; xn;1) = '(F A (';1 (x0); : : : ; ';1(xn;1))),

3. cC = '(cA ).

Talvolta indicheremo C con '[A] per sottolineare che si tratta di una struttura

indotta da '. E immediato vericare che C e dello stesso tipo di A e B, e che '

e un isomorsmo tra A e C : quindi ogni monomorsmo ' : A ! B permette di

ritagliare in B una struttura isomorfa ad A.

Date due strutture B e C del medesimo tipo, diremo che C e sottostruttura

di B, in simboli C B, se C B e per ogni simbolo di relazione R, di funzione

F e di costante c,

1. RC e la restrizione a C n di RB , ossia RC = C n \ RB ,

2. F C e la restrizione a C n di F B , ossia F C = F B C n,

3. cC = cB .

I due teoremi seguenti illustrano i rapporti tra monomorsmo, isomorsmo e

sottostruttura e permettono di concepire il concetto di monomorsmo come

generalizzazione di quello di sottostruttura.

2.2. Iso e monomorsmi

39

Teorema 2.2.1 La funzione ' : A ! B e un monomorsmo sse esiste una

struttura C tale che ' e un isomorsmo tra A e C e C B.

La prima implicazione si dimostra ponendo C = '[A], la struttura indotta

da ' tramite le 1)-3) precedenti. Si verica facilmente che C e sottostruttura di B. Per la seconda, osserviamo che se ' : A ! C e un isomorsmo

e C B, allora C B e ' e una funzione iniettiva da A verso B. Dimo-

striamo che e un monomorsmo. Abbiamo infatti RA(a0 ; : : : ; an;1) se e solo se

RC ('(a0 ); : : : ; '(an;1)), perche ' e un isomorsmo, e RC ('(a0); : : : ; '(an;1))

se e solo se RB ('(a0); : : : ; '(an;1)), perche RC e la restrizione di RB a '[A].

Per quanto riguarda le funzioni,

'(F A(a0 ; : : : ; an;1)) = F C ('(a0 ); : : : ; '(an;1))

= F B ('(a0 ); : : : ; '(an;1));

essendo ' un isomorsmo e F C la restrizione di F B a '[A]. Per quanto riguarda

le costanti, '(cA ) = cC = cB .

Corollario 2.2.2 A B sse iA : A ! B e un monomorsmo.

Per il teorema precedente, iA e un monomorsmo sse esiste una struttura C

tale che iA : A ! C e un isomorsmo e C B. Ma poiche il monomorsmo e

l'identita, C coincide con A.

Non tutti i sottoinsiemi del dominio di una struttura A costituiscono il dominio di una sottostruttura di A. Se B A pretende di essere il dominio di

una sottostruttura di A, allora B non deve essere vuoto e deve essere chiuso

rispetto alle funzioni di A. (Ricordiamo che un insieme B A e chiuso rispetto

a una funzione n-aria f se per ogni n-pla x0 ; :::; xn;1 di elementi di B vale

f(x0 ; :::; xn;1) 2 B:) Solo cos, infatti, possiamo denire F B come la restrizione

di F A alle n-ple di B. Mancando la chiusura, la restrizione risulterebbe indenita per qualche n-pla di elementi di B e non sarebbe quindi una funzione.

Inoltre B deve contenere tutte le costanti di A, perche solo cos possiamo denire cB = cA: Se consideriamo le costanti come funzioni 0-arie, quest'ultima

condizione si riduce alla chiusura.

Supponiamo, ad esempio, che A sia (Z; +A ; ;A) e che sia ! = X. E' chiaro

che X non puo essere il dominio di una sottostruttura di A dato che non e

chiuso rispetto a ;A . E' vero che possiamo sempre denire una funzione 2-aria

f simile alla sottrazione ponendo

A

n) se n m

f(m; n) = ; (m;

0

altrimenti.

Ma allora la struttura B = (!; +B ; ;B ), dove ;B e f, non e sottostruttura

di A perche ;B non coincide con la restrizione di ;A alle coppie di elementi di

!. Ad esempio, ;A (1; 2) = ;1 mentre ;B (1; 2) = 0. Se A e (Z; +A), allora !,

essendo chiuso rispetto alla somma,e il dominio di una sottostruttura. Problemi

analoghi possono sorgere con le costanti. Se A e (!; +A; 0A) allora ! ; f0g e

40

Capitolo 2. Strutture

chiuso rispetto alle funzioni di A, ma non ne contiene le costanti. Comunque si

denisca una struttura B = (! ; f0g; +B ; 0B ), possiamo ottenere che +B sia la

restrizione di +A a B, ma non possiamo avere 0B = 0A . Le relazioni, invece,

non pongono problemi di questo tipo: per ogni B A e ogni relazione n-aria

RA su A, e sempre possibile denire RB come la restrizione di RA a B n , dato

che RA \ B n e sempre una relazione su B. (Anche ; e una relazione su B.)

Tuttavia, se X A non e il dominio di una sottostruttura di A, e sempre

possibile estenderlo quanto basta per renderlo tale. Innanzitutto osserviamo che,

sotto opportune condizioni, possiamo introdurre il concetto di intersezione di

strutture. Data una famiglia non vuota di struttureTfAi gi2I , se le varie Ai sono

tutte sottostrutture

della stessa A di tipo e se fAig 6= ;, allora possiamo

T

denire fAigi2I come la struttura B di tipo tale che

T

1. B = fAigi2I ,

2. RB (b0; :::; bn;1) sse RA(b0 ; :::; bn;1),

3. F B (b0 ; :::; bn;1) = F A(b0 ; :::; bn;1),

4. cB = cA .

Verichiamo che le condizioni precedenti deniscono eettivamente una struttura. Il primo punto stabilisce il dominio, che risulta essere non vuoto, il secondo

stabilisce che le relazioni di B sono semplicemente la restrizione a B delle relazioni di A. Il terzo punto e piu delicato, perche occorre vericare che, per

ogni b0; : : : ; bn;1 2 B, il valore di F A per tale argomento sia ancora in B.

Poiche b0; : : : ; bn;1 appartengono a B, appartengono anche ad ogni Ai e quindi

ogni Ai contiene il valore di F A per l'argomento b0 ; : : : ; bn;1. D'altra parte

ogni Ai e sottostruttura di A e quindi F A (b0 ; : : : ; bn;1) coincide sempre con

F A (b0; : : : ; bn;1). Ne segue che quest'ultimo appartiene ad ogni Ai e quindi a

B. Le stesse considerazioni valgono per il quarto punto. E chiaro allora che B

e una struttura ed inoltre e sottostruttura di ogni Ai , e quindi di A.

Siamo ora in grado diTdenire, per ogni B A, B 6= ;, la sottostruttura

generata da B in A come fC : C A; B C g. La denizione e corretta, dato

che la famiglia di strutture in questione non e vuota, perche contiene almeno A,

e inoltre l'intersezione dei domini delle varie C non e vuota, poiche ognuno deve

includere B 6= ;. Dalla denizione risulta immediatamente che la sottostruttura

generata da B in A e anche la minima sottostruttura di A che includa B ed

e quindi ottenuta estendendo B quanto basta per ottenere un insieme chiuso

rispetto alle funzioni di A e contenente le costanti di A.

Ci sono due casi limite di sottostruttura generata da B in A. Nel primo, il

dominio della sottostruttura generata coincide con B: in questo caso B era il

sostegno adatto per una sottostruttura di A senza che fosse necessario aggiungere nulla. Nel secondo, il dominio della sottostruttura generata e A: in questo

caso si sono dovuti aggiungere tutti gli elementi di A ; B per ottenere una sottostruttura. In questo secondo caso diremo che B e un insieme di generatori

per A.

i

i

2.2. Iso e monomorsmi

41

Consideriamo, ad esempio, la struttura A = (!; S A ). Per ogni B !,

la sottostruttura generata da B in A ha come dominio l'insieme dei numeri

naturali maggiori o uguali al minimo di B. Se A = (!; S A ; 0A), per ogni B !

la sottostruttura generata da B coincide con A poiche dovra contenere lo zero

ed essere chiusa rispetto alla funzione successore. Quindi una struttura puo

avere diversi insiemi di generatori: in quest'ultimo esempio ogni sottoinsieme

del dominio e un insieme di generatori.

Esercizio 2.2.1 Si dimostri che ogni struttura (A; ), dove e un ordine parziale, e isomorfa a una struttura (B; ) dove e l'inclusione insiemistica. (Si

associ ad a 2 A l'insieme fb : b ag.)

Esercizio 2.2.2 Si determini se A e immergibile in B, se A ' B, se A B in

ognuno dei casi seguenti:

A = (!; ) e B = (Z; ),

A = (!; +; ) e B = (Z; +; ),

A = (!; +; ) e B = (Z; ; +);

A = (!; +; 0) e B = (!; ; 1).

Esercizio 2.2.3 Si determini se A e immergibile in B quando

1. A= (!; ; ; 1) e B= (!; ; +; 0).

2. A =(! ; f0g; ; ; 1) e B= (!; ; +; 0).

3. A =(! ; f0g; ; 1) e B =(!; +; 0).

Esercizio 2.2.4 Sia A = (P(fa; bg; \; [) e B = (P (fa; b; cg; \; [). Si dimostri

che A B. Supponiamo che A0 e B0 siano ottenute aggiungendo alle strutture

precedenti l'operazione di complemento: si dimostri che A0 6 B0 .

Esercizio 2.2.5 Si dimostri che la relazione A ' B e di equivalenza e che la

relazione A B e un ordine parziale.

Esercizio 2.2.6 Deniamo R(A; B) sse A e immergibile in B. Si dimostri che:

1.

2.

3.

4.

1. R e riessiva e transitiva ma non antisimmetrica;

2. R(A; B) e R(B; A) non implica A ' B. (Si considerino Q e Q+ con .)

Esercizio 2.2.7 (Questo esercizio richiede alcuni risultati di aritmetica cardi-

nale.) Sia A un insieme di cardinalita innita . Si determini il numero di

strutture distinte di dominio A (vale a dire strutture ottenute con dierenti

interpretazioni dei simboli del tipo) nei casi seguenti:

1. = (fcg)

[]

42

Capitolo 2. Strutture

2. = (fck gk2K )

3. = (fF0 g)

4. = (fFj gj 2J )

5. = (fR0g)

6. = (fRi gi2I )

[jK j ]

[2]

[2+jJ j ]

[2]

[2+jI j ]

Esercizio 2.2.8 Sia j j = supfjI j; jJ j; jK jg. Se e il cardinale di A ed e

innito, si dimostri che esistono al piu 2supf;j jg strutture non isomorfe di tipo

e dominio A.

2.3 Omomorsmi

Il concetto di omomorsmo si ottiene da quello di monomorsmo lasciando cadere la richiesta di iniettivita della funzione. Quindi l'uguaglianza '(x) = '(y)

e compatibile sia con x = y sia con x 6= y, mentre x = y implica necessariamente '(x) = '(y). Questo comportamento della relazione di identita, per

cui a punti identici devono corrispondere immagini identiche mentre immagini

identiche possono provenire da punti distinti, e esteso a tutte le relazioni della

struttura e si esprime nella prima condizione della denizione seguente che e

un indebolimento della corrispondente condizione nella denizione di monomorsmo. Date due strutture A e B dello stesso tipo, diremo che una funzione

' : A ! B e un omomorsmo se per ogni Ri, Fj e ck del tipo , per ogni

a0 ; : : : ; an;1 2 A:

i) se RAi (a0; : : : ; an;1) allora RBi ('(a0 ); : : : ; '(an;1)),

ii) '(FjA(a0; : : : ; an;1)) = FjB ('(a0); : : : ; '(an;1)),

iii) '(cAk ) = cBk .

Diremo che ' e un omomorsmo forte se e possibile sostituire la i) con la condizione seguente che coincide con la condizione corrispondente nella denizione

di monomorsmo:

i') RAi (a0; : : : ; an;1) sse RBi ('(a0); : : : ; '(an;1)).

Se A e B sono strutture algebriche, ossia sono prive di relazioni, la distinzione

tra omomorsmo e omomorsmo forte non ha piu luogo e diremo semplicemente

che ' e un omomorsmo se verica le condizioni ii) e iii). Se A e B sono ordini

parziali, un omomorsmodi A verso B e una funzione ' : A ! B tale che x A y

implica '(x) B '(y). Nella gura seguente ' e un esempio di omomorsmo

tra ordini parziali, ma non e un omomorsmo forte:

43

2.3. Omomorsmi

e

; @@

;

@d

;

c

@@

;

;

@b;

'(e)

'(c); '(d)

a

'(a); '(b)

Come esempio di omomorsmo tra strutture algebriche consideriamo le due

strutture A = (P(A); \; [; A; ;) e B = (P(B); \; [; B; ;) dove B A e la

funzione ' : P (A) ! P(B) denita ponendo '(X) = X \ B per ogni X A.

Verichiamo che ' conserva le operazioni e le costanti:

'(X \ Y ) = (X \ Y ) \ B = (X \ B) \ (Y \ B) = '(X) \ '(Y );

'(X [ Y ) = (X [ Y ) \ B = (X \ B) [ (Y \ B) = '(X) [ '(Y );

'(A) = A \ B = B;

'(;) = ; \ B = ;:

Mentre iso e monomorsmi forniscono immagini che sono copie esatte del

dominio, l'immagine fornita dall'omomorsmo, proprio perche fornita da una

semplice funzione, e costituita da oggetti che possono essere visti come rappresentanti di classi di equivalenza di individui del dominio. Nel paragrafo dedicato

alle relazioni di equivalenza abbiamo visto che ad ogni relazione di equivalenza

su A e associato un insieme quoziente A= i cui elementi sono esattamente

le classi di equivalenza degli elementi di A. Se immaginiamo che A sia l'insieme

degli esseri umani e la relazione \x e nato nello stesso anno di y", allora gli

elementi di A= sono le classi di tutti gli esseri umani nati nel medesimo anno.

Il passaggio da A a A= e del tipo molti-uno: molti individui vengono radunati

sotto un unico aspetto e da essi si astrae un nuovo tipo di individuo, la classe di

equivalenza. Supponiamo ora che A sia il dominio di una struttura A. Ci si puo

chiedere se i rapporti che valgono fra gli elementi di A, stabiliti dalle funzioni

e dalle relazioni di A, sono estendibili a rapporti tra le classi di equivalenza in

modo che la struttura A induca una struttura dello stesso tipo su A= . Ad

esempio, se A e l'insieme degli esseri umani e tra gli elementi di A e stabilita

la relazione \x e piu vecchio di y", e possibile estendere questa relazione a una

relazione R tra classi di equivalenza denita ponendo [x]R[y] sse x e piu vecchio

di y? La cosa e sensata, dato che se x e piu vecchio di y, allora anche tutti gli

elementi di [x] sono piu vecchi degli elementi di [y], quindi il comportamento

degli elementi delle classi di equivalenza e omogeneo rispetto alla relazione R.

D'altra parte non e sempre lecito questo passaggio alle classi di equivalenza.

Consideriamo la relazione \x ama y". Non e detto che, se x ama y, anche tutti

44

Capitolo 2. Strutture

gli esseri umani nati nello stesso anno di x amino tutti gli esseri umani nati

nello stesso anno di y, quindi questa relazione non e estendibile a A=. Analogo

discorso si puo fare per le funzioni. Cerchiamo ora di ssare le caratteristiche di

una relazione e di una funzione estendibile alle classi di equivalenza. Diremo che

una relazione binaria e una congruenza su A se e una relazione di equivalenza

su A e inoltre, per ogni funzione F A e ogni relazione RA , se ai bi per ogni

i < n, allora

1. F A(a0 ; : : : ; an;1) F A(b0 ; : : : ; bn;1),

2. RA (a0 ; : : : ; an;1) implica RA (b0; : : : ; bn;1).

Si osservi che, essendo simmetrica, nella 2) possiamo sostituire \implica" con

\sse". Ogni congruenza su A induce una struttura su A= nel modo seguente.

Deniamo struttura quoziente di A modulo la struttura B dello stesso tipo

di A avente dominio B = A= e tale che, per ogni simbolo di costante c, di

funzione F, di relazione R,

1.

2.

3.

cB = [cA],

F B ([a0 ]; : : : ; [an;1]) = [F A(a0; : : : ; a ; n ; 1)],

RB ([a0]; : : : ; [an;1]) sse RA(a0 ; : : : ; an;1).

E immediato vericare che le funzioni e le relazioni di B risultano ben denite

sulle classi di equivalenza proprio perche e una congruenza. Solitamente si

indica B con A=.

La caratteristica fondamentale della congruenza, vale a dire l'essere compatibile con le relazioni e le funzioni di A, rende possibile un trasferimento di

struttura da A verso la struttura quoziente A=. Per ogni congruenza su A

deniamo una funzione ' : A ! A= ponendo ' (a) = [a].

Teorema 2.3.1 Se e una congruenza su A, allora ' e un omomorsmo

forte suriettivo da A verso A=.

Semplichiamo la notazione ponendo A= = B. Per quanto riguarda le

relazioni,

RA(a0 ; : : : ; an;1) sse RB ([a0]; : : : ; [an;1])

sse RB (' (a0 ); : : : ; ' (an;1 )):

Per quanto riguarda le funzioni,

'(F A(a0 ; : : : ; an;1)) = [F A(a0 ; : : : ; an;1)]

= F B ([a0]; : : : ; [an;1])

= F B (' (a0 ); : : : ; ' (an;1 )):

Per quanto riguarda le costanti, ' (cA ) = [cA ] = cB .

2.3. Omomorsmi

45

Abbiamo visto che il risultato di una congruenza, cioe il passaggio a una

struttura quoziente, e sempre ottenibile come immagime omomorfa della struttura di partenza, poiche A= coincide con ' [A]. Mostriamo ora che ogni immagine omomorfa e ottenibile quozientando la struttura di partenza con un'opportuna congruenza. Ad ogni funzione ' : A ! B e associata una relazione

binaria ' su A denita ponendo x ' y sse '(x) = '(y).

Teorema 2.3.2 Se ' : A ! B e un omomorsmo forte, allora ' e una

congruenza su A.

Dato che = e una relazione di equivalenza, anche ' lo e. Supponiamo che

ai ' bi per ogni i < n, e quindi che '(ai ) = '(bi ). Poiche ' e un omomorsmo,

per ogni simbolo funzionale F

'(F A (a0 ; : : : ; an;1)) = F B ('(a0); : : : ; '(an;1))

= F B ('(b0); : : : ; '(bn;1))

= '(F A (b0; : : : ; bn;1)):

Quindi F A(a0; : : : ; an;1) ' F A(b0 ; : : : ; bn;1). Poiche ' e un omomorsmo

forte, per ogni simbolo relazionale R abbiamo

RA (a0; : : : ; an;1) implica RB ('(a0 ); : : : ; '(an;1))

implica RB ('(b0 ); : : : ; '(bn;1))

implica RA (b0; : : : ; bn;1):

Si osservi che l'ultimo passaggio richiede che ' sia forte.

Teorema 2.3.3 Se ' : A ! B e un omomorsmo forte suriettivo, esiste un

isomorsmo tra A=' e B.

Per il teorema precedente ' e una congruenza su A e quindi possiamo

considerare la struttura quoziente A= ' . Come abbiamo visto nel teorema

1.4.3, la funzione : A=' ! B denita ponendo ([a]) = '(a) e una biiezione.

Dimostriamo che e anche un isomorsmo. Per brevita poniamo C = A= ' ,

abbiamo allora

(F C ([a0]; : : : ; [an;1])) = ([F A(a0 ; : : : ; an;1)])

= '(F A(a0 ; : : : ; an;1))

= F B ('(a0 ); : : : ; '(an;1))

= F B ( [a0]; : : : ; [an;1])

Per quanto riguarda le relazioni abbiamo

RC ([a0 ]; : : : ; [an]) sse RA (a0 ; : : : ; an;1)

sse RB ('(a0 ); : : : ; '(an;1))

sse RB ( [a0 ]; : : : ; [an;1]):

La situazione e illustrata dalla gura seguente, dove indica la funzione da A

verso A=' che associa ad ogni a 2 A la sua classe [a] modulo ' .

46

Capitolo 2. Strutture

AQ

- A=R

QQ

'Q

QQs ?

B

' = Congruenze e omomorsmiforti sono due aspetti diversi di una medesima realta.

La congruenza eettua una costruzione col materiale fornito dalla struttura di

partenza, organizzandolo in classi di equivalenza in modo tale che si conservino

funzioni e relazioni della struttura, mentre l'omomorsmo produce un'immagine

\esterna" alla struttura data, ma i teoremi precedenti garantiscono l'equivalenza

tra queste due operazioni che riproducono, nelle sue linee fondamentali, la procedura di astrazione. Procedere per astrazione conduce alla formazione di nuovi

enti, le classi di individui identicabili rispetto alle caratteristiche da cui si

astrae, ma l'astrazione si rivela particolarmente feconda dal punto di vista conoscitivo quando la classicazione riproduce alcuni aspetti strutturali rilevanti

della realta da cui eravamo partiti, cioe quando funzioni e relazioni vigenti tra

le classi rispecchiano un'analoga strutturazione dei dati iniziali. E questo e, a

piacere, omomorsmo o congruenza.

Esercizio 2.3.1 Si dimostri che, nel caso degli ordini, un omomorsmo forte e

addirittura un monomorsmo.

2.4 Reticoli e algebre di Boole

In questo paragrafo presenteremo due classi di strutture particolarmente importanti nello studio della logica: i reticoli e le algebre di Boole. Gli assiomi che

le individuano sono ispirati dalle proprieta che caratterizzano le operazioni insiemistiche fondamentali e la genesi di tali assiomi fornisce un esempio di come

si costituiscano le moderne teorie assiomatiche. Se consideriamo i sottoinsiemi

di W come oggetti di studio, possiamo dapprima considerare fondamentali le

operazioni di unione e intersezione e quindi organizzare P(W) nella struttura

R(W ) = (P(W); \; [) di tipo (^; _), dove ^, _ sono simboli funzionali binari. Il

tipo permette una prima rozza classicazione delle strutture: scegliendo il tipo

dichiariamo con quale linguaggio intendiamo studiare la realta, quali rapporti

fra gli oggetti siamo disposti a considerare come fondamentali. Esistono tuttavia innite strutture di tipo (^; _) che nulla hanno a che vedere con gli insiemi,

ad esempio (Z; +; ). Se vogliamo caratterizzare meglio il nostro oggetto di studio, possiamo isolare alcune proprieta fondamentali delle funzioni di R(W). Si

ottiene cosi il seguente insieme L di assiomi:

i) x ^ y = y ^ x e x _ y = y _ x (commutativita),

ii) (x ^ y) ^ z = x ^ (y ^ z) e (x _ y) _ z = x _ (y _ z) (associativita),

iii) (x ^ y) _ y = y e (x _ y) ^ y = y (assorbimento),

2.4. Reticoli e algebre di Boole

47

Se A e una struttura di tipo , diremo che tali assiomi sono veri in A se,

interpretando ^ come ^A e _ come _A, otteniamo equazioni soddisfatte da ogni

possibile sostituzione delle variabili x, y, z con oggetti di A. Se tutti gli assiomi

di L sono veri in A, diremo che A e un modello degli assiomi L, ossia che A

e un reticolo . Si verica facilmente che R(W) e un reticolo: basta rimpiazzare

^ con \ e _ con [. Quando W = 1 otteniamo un reticolo particolarmente

importante, che indichiamo con 2, poiche il suo dominio e P (1), ossia P (f;g) =

f;; f;gg = f0; 1g = 2. Non tutti i reticoli hanno domini costituiti da insiemi

strutturati dalle usuali operazioni insiemistiche: basta considerare l'algebra A

in cui A = fx : x divide 30g, ^A = MCD, _A = mcm. Lasciamo al lettore il

compito di vericare che Z non e un modello dell'insieme di assiomi L.

Per ogni proposizione riguardante i reticoli, deniamo come la proposizione ottenuta sostituendo in i simboli ^ con _ e _ con ^. Diremo che

e la duale di . Si verica facilmente che se e un assioma di L anche

lo e. Cio signica che se A = (A; ^A; _A) e un reticolo, anche la struttura

A = (A; _A; ^A) lo e. Possiamo allora giusticare il seguente principio di dualita : ogni volta che abbiamo dimostrato che la proposizione e vera in ogni

reticolo, sappiamo che anche e vera in ogni reticolo. (Basta osservare che

per ipotesi a vera in ogni reticolo e quindi anche in A , ma allora e vera

in A = A.) Tale principio dimezza l'impegno dimostrativo: tutte le volte che

abbiamo dimostrato un teorema , vale anche il teorema duale .

E possibile esprimere la relazione X Y senza fare riferimento agli elementi

di X e di Y : infatti, se deniamo una relazione XRY sse X \ Y = X, si dimostra

facilmente che R coincide con . Se ora ci collochiamo in un reticolo qualsiasi,

che cosa possiamo dire in generale di una relazione denita ponendo x y

sse x ^ y = x? Il signicato di e legato a quello di ^ che a sua volta dipende

solamente dagli assiomi di reticolo, ma tali assiomi sono sucienti a dimostrare

che e un ordine.

Teorema 2.4.1 In ogni reticolo valgono le equazioni seguenti:

1. x ^ x = x e x _ x = x (idempotenza),

2. x ^ y = x sse x _ y = y.

1. Usando gli assiomi i) e iii): x ^ x = x ^ (x _ (y ^ x)) = x. L'altra equazione

si ottiene per dualita.

2. Usando l'assioma iii), se x ^ y = x allora x _ y = (x ^ y) _ y = y. Usando

gli assiomi i) e iii), se x _ y = y allora x ^ y = x ^ (x _ y) = (y _ x) ^ x = x.

Teorema 2.4.2 La relazione x y sse x ^ y = x e un ordine.

Per il punto 1) del teorema precedente e riessiva. Per l'assioma i) e

antisimmetrica: infatti da x y e y x segue x ^ y = x e y ^ x = y, ma per

la commutativita x ^ y = y ^ x. Per l'assioma ii) e transitiva. Infatti da x y

e y z otteniamo x ^ y = x e y ^ z = y. Sostituendo e usando l'associativita

otteniamo x z, dato che x = x ^ y = x ^ (y ^ z) = (x ^ y) ^ z = x ^ z:

48

Capitolo 2. Strutture

Teorema 2.4.3 Le operazioni ^ e _ sono monotone rispetto a , vale a dire

se x y allora x ^ z y ^ z e x _ z y _ z .

Se x y allora x ^ y = x e quindi (x ^ y) ^ z = x ^ z. Utilizzando

commutativita, associativita e idempotenza abbiamo allora (x ^ z) ^ (y ^ z) =

(x ^ y) ^ z = x ^ z, da cui x ^ z y ^ z. In modo analogo si procede con _.

Quindi a ogni reticolo possiamo associare un insieme ordinato avente lo stesso

dominio e strutturato da una relazione d'ordine x y che puo essere denita

indierentemente da x ^ y = x o da x _ y = y. Torniamo ora alla realta

insiemistica da cui siamo partiti per ricavarne altre signicative proprieta di \

e di [. Osserviamo che vale la distributivita di \ su [ e da essa ricaviamo

l'assioma

iv) x ^ (y _ z) = (x ^ y) _ (x ^ z) (distributivita di ^ su _).

Diremo che una struttura A e un reticolo distributivo se in essa valgono gli

assiomi i)-iv). Il teorema seguente mostra che non e necessario assumere anche

la distributivita duale.

Teorema 2.4.4 In ogni reticolo, se vale iv) allora vale anche iv) e viceversa.

Utilizzando iv), iii) e i) otteniamo

(x _ y) ^ (x _ z) =

=

=

=

((x _ y) ^ x) _ ((x _ y) ^ z)

x _ (z ^ (x _ y))

x _ (z ^ x) _ (z ^ y)

x _ (z ^ y):

Assumendo iv) si ottiene iv) con una dimostrazione duale.

Tutti gli esempi di reticolo introdotti nora sono distributivi, ma vedremo

in seguito che non tutti i reticoli lo sono. La distributivita e comunque una proprieta che caratterizza fortemente la realta insiemistica che ha ispirato i nostri

assiomi, e infatti possibile dimostrare il seguente teorema di rappresentazione:

ogni reticolo distributivo e isomorfo a una sottostruttura di R(W), per un'opportuna scelta di W (si veda, ad esempio, [Davey-Priestley 90, teorema 10.3]).

Un altro aspetto importante di P (W) che possiamo tradurre negli assiomi

e la presenza di un insieme massimo e di un insieme minimo rispetto a ,

rispettivamente W e ;. Per ogni X 2 P(W ) vale X W e ; X e tali

proprieta di W e di ; si esprimono in termini di [ e di \ mediante le equazioni

X [ W = W e X \ ; = ;. Se espandiamo il tipo dei reticoli con l'aggiunta di

due simboli di costante 1 e 0, possiamo riprodurle nei due assiomi seguenti:

M) x _ 1 = 1,

m) x ^ 0 = 0.

2.4. Reticoli e algebre di Boole

49

Chiameremo reticolo limitato ogni reticolo in cui valgano anche gli assiomi M) e

m). Si vede immediatamente che in ogni reticolo limitato A gli elementi 0A e 1A

sono rispettivamente il minimo e il massimo rispetto alla relazione associata

al reticolo. Tutti gli esempi di reticoli che abbiamo mostrato possono essere

espansi a reticoli limitati, con l'introduzione di due costanti denite in modo da

rendere veri gli assiomi di massimo e minimo, ma vedremo in seguito che non

tutti i reticoli sono limitati. Nel caso dei reticoli limitati, la duale di una

proposizione si ottiene scambiando ^ con _, _ con ^, 0 con 1 e 1 con 0.

L'ultimo aspetto di P(W) che vogliamo rispecchiare negli assiomi e l'esistenza del complemento. Se pensiamo P(W ) strutturato come l'algebra dell'insieme potenza B(W ), vediamo che per ogni X 2 P (W) esiste un elemento di

P(W ), indicato con ;X, tale che X \ ;X = ; e X [ ;X = W. Se espandiamo

il tipo dei reticoli limitati con l'aggiunta di un simbolo funzionale unario :,

possiamo tradurre le equazioni precedenti nei seguenti assiomi:

v) x ^ :x = 0 e x _ :x = 1.

Indichiamo con BA l'insieme degli assiomi i)-v) e chiamiamo algebra di Boole

una struttura A che sia modello degli assiomi BA. Quindi un'algebra di Boole

e un reticolo distributivo in cui vale l'assioma v). Si verica facilmente che

B(W ) e un'algebra di Boole: basta interpretare ^ su \, _ su [, : su ;, 0 su

;, 1 su W. Quando W = f;g otteniamo un'algebra di Boole particolarmente

importante, che indichiamo ancora con 2, come il reticolo di due elementi. Il

reticolo (A; MCD; mcm), dove A = fx 2 ! : x divide 30g, si puo espandere a

un'algebra di Boole denendo :A(x) = 30=x, 0A = 1, 1A = 30. Anche per

le algebre di Boole vale un teorema di rappresentazione analogo a quello dei

reticoli distributivi : ogni algebra di Boole e isomorfa a una sottostruttura di

B(W ), per un'opportuna scelta di W (si veda, ad esempio, [Davey-Priestley 90,

teorema 10.4]). Il primo punto del teorema seguente mostra che ogni algebra di

Boole e un reticolo limitato, poiche 0 e 1 soddisfano le condizioni poste dagli

assiomi m) e M). D'ora in poi daremo le dimostrazioni in forma abbreviata,

senza segnalare tutti gli assiomi o i teoremi precedenti utilizzati.

Teorema 2.4.5 Le proposizioni seguenti valgono in ogni algebra di Boole:

1. x ^ 0 = 0 e x _ 1 = 1, ossia 0 x e x 1,

2. x ^ 1 = x e x _ 0 = x,

3. x = :y sse x _ y = 1 e x ^ y = 0,

4. x = ::x,

5. :(x ^ y) = :x _ :y e :(x _ y) = :x ^ :y (leggi di De Morgan),

6. x ^ y z sse x :y _ z ,

7. x y sse :x _ y = 1.

50

Capitolo 2. Strutture

1. Usando gli assiomi v), ii) e l'idempotenza (teorema 2.4.1): x ^ 0 =

x ^ (x ^ :x) = (x ^ x) ^ :x = x ^ :x = 0. L'altra equazione si ottiene per

dualita.

2. Usando gli assiomi v), i) e iii): x ^ 1 = x ^ (x _ :x) = (:x _ x) ^ x = x.

L'altra equazione si ottiene per dualita.

3. Se x = :y allora x _ y = :y _ y = 1, utilizzando i) e v); x ^ y = 1 si ottiene

per dualita. Assumiamo ora x _ y = 1 e x ^ y = 0. Utilizzando gli assiomi v),

iv), i) e il punto 2):

x =

=

=

=

=

=

=

=

=

x^1

x ^ (y _ :y)

(x ^ y) _ (x ^ :y)

0 _ (x ^ :y)

(y ^ :y) _ (x ^ :y)

(:y ^ y) _ (:y ^ x)

:y ^ (y _ x)

:y ^ 1

:y:

4. Per il punto precedente, basta vericare che x _ :x = 1 e x ^ :x = 0, il

che segue da v).

5. Basta dimostrare la prima equazione, perche la seconda si ottiene per

dualita. Per dimostrare che :x _ :y = :(x ^ y) e suciente dimostrare, per il

punto 3), che (:x _ :y) _ (x ^ y) = 1 e (:x _ :y) ^ (x ^ y) = 0. La prima e

giusticata da

(:x _ :y) _ (x ^ y) = (:x _ :y _ x) ^ (:x _ :y _ y)

= 1^1

= 1

e la seconda e giusticata da

(:x _ :y) ^ (x ^ y) = (:x ^ x ^ y) ^ (:y _ x ^ y)

= 0^0

= 0:

6. Se x ^ y z allora (x ^ y) _ :y z _ :y per il teorema 2.4.3. Ma

x x _ :y = (x _ :y) ^ (y _ :y) = (x ^ y) _ :y

per la distributivita, l'assioma v) e il punto 2) e quindi x :y _ z. Se x :y _ z

allora x ^ y (:y _ z) ^ y per il teorema 2.4.3. Ma

(:y _ z) ^ y (:y ^ y) _ (z ^ y) = z ^ y y

2.4. Reticoli e algebre di Boole

51

per la distributivita, l'assioma v) e il punto 2).

7. Per il punto 2) l'asserzione x y equivale a 1 ^ x y, che equivale a

1 :x _ y per il punto 6), che inne equivale a 1 = :x _ y per il punto 1).

Consideriamo ora P(W ) sotto un altro punto di vista, isolando come fondamentale la relazione di inclusione tra insiemi: la struttura che si ottiene

e l'insieme ordinato (P (W); ). Ora il tipo contiene solo il simbolo relazionale

binario e nel linguaggio associato al tipo possiamo formulare gli assiomi che

caratterizzano la relazione di inclusione come ordine parziale:

a1 ) x x (riessivita),

a2 ) se x y e y x allora x = y (antisimmetria),

a3 ) se x y e y z allora x z (transitivita).

Indichiamo con OP l'insieme degli assiomi a1)-a3). Tali assiomi fanno si che

in ogni modello A di OP la relazione A sia un ordine e quindi A sia un

insieme ordinato. Anche per gli insiemi ordinati vale un principio di dualita

analogo a quello dei reticoli, denendo la duale di una proposizione come

la proposizione ottenuta da sostituendo con . Per giusticare questo

principio basta osservare che ogni insieme ordinato A = (A; ) si trasforma in

un altro insieme ordinato A = (A; ) tale che vale in A sse vale in A . Se

adottiamo la rappresentazione graca degli insiemi ordinati del paragrafo 1.4,

la rappresentazione di A si ottiene capovolgendo quella di A.

Gli assiomi OP non colgono pero un aspetto importante di P(W ): la possibilita di formare intersezioni e unioni. Il fatto che ora il linguaggio non disponga

di simboli funzionali binari per rappresentare \ e [ non signica che non si possano esprimere, nei termini di , le proprieta che caratterizzano X \ Y e X [ Y .

Iniziamo da \ e osserviamo che X \ Y X e X \ Y Y . Inoltre, tra gli

insiemi Z che sono simultaneamente inclusi in X e in Y , l'intersezione X \ Y

e il massimo. Per quanto riguarda [ valgono le proprieta duali: X X [ Y

e Y X [ Y e inoltre, tra gli insiemi Z che includono simultaneamente X e

Y , l'unione X [ Y e il minimo. Da questa analisi possiamo ricavare gli assiomi

seguenti:

a4 ) per ogni x, y esiste uno z tale che: z x e z y e per ogni w, se w x e

w y allora w z;

a5) per ogni x, y esiste uno z tale che: x z e y z e per ogni w, se x w e

y w allora z w.

Un insieme ordinato in cui valgano gli assiomi a4) e a5 ) e detto reticolo, per

ragioni che risulteranno chiare dal teorema seguente. Supponiamo che A sia

un insieme ordinato. Se X A, diremo che un elemento a di A e un conne

superiore di X se, per ogni x 2 X, vale x a. Sia X + l'insieme dei conni

superiori di X: se X + ha un minimo, tale elemento e detto minimo conne

superiore, o supremum, di X ed e denotato da sup X. Dualmente, deniamo

conne inferiore di X un elemento a di A tale che, per ogni x 2 X, valga a x.

52

Capitolo 2. Strutture

Indichiamo con X ; l'insieme dei conni inferiori di X: se X ; ha un massimo,

tale elemento e detto massimo conne inferiore, o inmum, di X ed e denotato

da inf X. Poiche il massimo e il minimo di un insieme, se esistono, sono unici,

ne segue che inf X e sup X, se esistono, sono unici. Quindi in una struttura che

renda veri gli assiomi a1)-a5 ) possiamo usare inf fx; yg e supfx; yg come funzioni

binarie: gli assiomi a4 ) e a5 ) garantiscono l'esistenza del valore, l'antisimmetria

l'unicita.

Teorema 2.4.6 Se A = (A; ) e modello degli assiomi a1 )-a5 ) allora possiamo

espandere il suo tipo con l'aggiunta di due simboli funzionali binari ^ e _

in modo tale che, interpretando ^ su inf fx; yg e _ su supfx; yg, la struttura

(A; ^A ,_A) soddis gli assiomi L.

La commutativita di ^ ossia inf fx; yg = inf fy; xg dipende dal fatto che

fx; yg = fy; xg. La commutativita di _ si ottiene per dualita. Per dimostrare

l'associativita di ^ ossia

inf fx; inffy; z gg = inf finf fx; yg; z g

osserviamo innanzitutto che inf fx; inffy; z gg = inf fx; y; z g: basta vericare che

fx; inf fy; z gg; = fx; y; z g;. Analogamente si dimostra che inf finf fx; yg; z g =

inf fx; y; z g. L'associativita di _ si ottiene per dualita. Dimostriamo che l'assioma (x ^ y) _ y = y e vero, ossia che supfinf fx; yg; yg = y. Osserviamo che

inf fx; yg y e quindi y appartiene a finf fx; yg; yg+ . D'altra parte, per ogni

z 2 finf fx; yg; yg+ vale y z e quindi y e il minimo tra i conni superiori di

finf fx; yg; yg.

Useremo quindi il termine reticolo per indicare sia una struttura per f^; _g

in cui valgano gli assiomi L, sia una struttura per fg in cui valgano gli assiomi

a1 )-a5), lasciando al contesto il compito di determinare quale delle due accezioni

del termine stiamo usando.

e

d

@

r

;@@

;

;

@@

;

a @ e

c

;

@@ ;;

@;

r

r

r

r

b

r

@

@@

d

J

JJ

c

;

JJ ;;

J;

r

a

r

r

r

b

Spesso conviene pensare un reticolo come un particolare insieme ordinato, perche

in tal modo possiamo darne una rappresentazione graca intuitiva. La gura

precedente presenta due reticoli nei quali non vale l'assioma di distributivita.

Nel primo e ^ (a _ c) 6= (e ^ a) _ (e ^ c) nel secondo d ^ (a _ c) 6= (d ^ a) _ (d ^ c).

2.5. Denizioni induttive

53

Esercizio 2.4.1 Si dimostri che ogni catena (insieme totalmente ordinato) e

un reticolo. Si fornisca quindi un esempio di reticolo non limitato.

Esercizio 2.4.2 Se A = (A; ^; _) e B = (B; ^; _) sono due reticoli e ':A ! B

e un omomorsmo, allora ' conserva anche la relazione d'ordine associata ai

reticoli. Se A = (A; ) e B = (B; ) sono due reticoli e ':A ! B e un

omomorsmo, allora ' in genere non conserva le operazioni inf e sup.

Esercizio 2.4.3 Espandiamo un reticolo con due costanti 0 e 1 che soddisno

i due assiomi seguenti: i) x ^ 1 = x, ii) x _ 0 = x. Si dimostri che il reticolo cosi

ottenuto e limitato. Viceversa, si dimostri che in ogni reticolo limitato valgono

i) e ii).

Esercizio 2.4.4 Sia 2 il reticolo R(1) = (f0; 1g; \; [). Si dimostri che tutti i

reticoli con due elementi sono isomor a 2. Si dimostri un risultato analogo per

le algebre di Boole.

Esercizio 2.4.5 Sia a un elemento ssato di A. Si dimostri che la funzione

f : P (A) ! 2 denita ponendo, per ogni X A,

a 2= X

f(X) = 01 se

se a 2 X

e un omomorsmo da B(A) verso 2, dove 2 e l'algebra di Boole con due elementi.

Esercizio 2.4.6 In ogni reticolo limitato A deniamo complemento di un elemento a un elemento a0 tale che a ^ a0 = 0 e a _ a0 = 1. Diremo che un reticolo

e complementato se e limitato e ogni elemento ha un complemento. Si dimostri

che in un reticolo complementato e distributivo ogni elemento ha un unico complemento. Quindi in ogni reticolo complementato e distributivo si puo espandere

a un'algebra di Boole.

2.5 Denizioni induttive

Tutti gli oggetti del nostro discorso sono insiemi, quindi ogni volta che si denisce un oggetto si tratta della denizione di un insieme. Fino a questo punto

le denizioni adottate sono state sempre del tipo seguente: dato un insieme A

e una proprieta P, deniamo fx : P(x)g come l'insieme degli elementi di A che

godono di P . Diremo che l'insieme in questione e denito esplicitamente sulla

base dell'insieme A dalla proprieta P . Ad esempio, l'insieme dei numeri pari

puo essere denito sulla base dell'insieme dei numeri naturali ! considerando

la proprieta \esiste un n 2 ! tale che n + n = x". Cerchiamo ora di immaginare l'insieme dei pari come il frutto di un processo generativo ne fornisca gli

elementi in successione. Non e dicile immaginare una legge di generazione che

operi all'interno di !: si parte da 0 e quindi si applica la funzione (x) = x + 2

ripetutamente ottenendo f0; (0); ( (0)); : : : g. E immediato riconoscere che

54

Capitolo 2. Strutture

abbiamo ottenuto l'insieme dei numeri pari, anche se non e altrettanto immediato giusticare questo tipo di denizione. Gli elementi dell'insieme possiedono

una descrizione uniforme, ma siamo ben lontani dall'avere una denizione esplicita, cioe una proprieta goduta da tutti e soli gli elementi dell'insieme.

Sottolineiamo che quando si parla di \processo generativo" non si intende

necessariamente che in virtu di questo processo si porti qualcosa all'esistenza.

Esistono infatti due modi profondamente diversi di considerare le denizioni

degli oggetti matematici: si puo ritenere che esse creino gli oggetti che deniscono, che nell'atto della denizione si conferisca ad essi l'esistenza, oppure si

puo pensare che le denizioni si limitino a segnare i conni di un insieme di

oggetti e che quindi abbiano un compito puramente descrittivo. Noi adottiamo

questo secondo punto di vista e quindi assumiamo che sia gli oggetti che verranno a costituire un insieme, sia l'insieme stesso di questi oggetti, preesistano

alla denizione e che quest'ultima sia solo un modo per individuare tale insieme

e sottoporlo all'attenzione. Nell'esempio precedente i numeri pari gia esistono

come elementi dell'insieme !. Se proprio vogliamo vedere qualcosa che si crea,

questo e il \bordo" dell'insieme dei pari che viene ritagliato in !, ma cio non e

strettamente necessario, dato che l'insieme dei pari esiste gia come elemento di

P (!), l'insieme potenza di ! che contiene tutti i sottoinsiemi di !. Alle denizioni non attribuiamo dunque alcuna facolta creatrice: tutto esiste n dall'inizio

ed e proprio nel momento iniziale, cioe negli assiomi della teoria degli insiemi,

che si stabilisce che cosa debba esistere.

Vediamo ora di cogliere gli aspetti piu generali di questo nuovo modo di

denire insiemi. Innanzitutto supponiamo che ogni denizione di questo tipo

sia formulata in riferimento a una data struttura A: cio signica che essa avra

il compito di denire un sottoinsieme del dominio A di A e che nel fare cio

potra utilizzare solo funzioni e costanti della struttura A. Vi sono inoltre due

elementi della denizione precedente che possono essere generalizzati: possiamo

ammettere come punto di partenza un sottoinsieme qualsiasi di A, senza necessariamente limitarci a quelli unitari, e possiamo ammettere che il processo

generativo sia sostenuto dall'insieme F delle funzioni e delle costanti di A, piuttosto che da un'unica funzione. Chiameremo allora denizione induttiva in A

una coppia (B; F ) tale che B A, B 6= ; e F e l'insieme delle funzioni e delle

costanti di A. Diremo che un insieme X A e (B; F )-chiuso se:

B X,

cA 2 X, per ogni cA 2 F ,

F A(x0 ; : : : ; xn;1) 2 X, per ogni F A 2 F e x0 ; : : : ; xn;1 2 X.

Diremo inne che l'insieme

\

IB;F = fX A : X e (B; F )-chiusog

1.

2.

3.

e l'insieme denito per induzione da (B; F ) in A. Gli insiemi (B; F )-chiusi

coincidono con le sottostrutture di A che includono B e quindi IB;F e il dominio

2.5. Denizioni induttive

55

della sottostruttura generata da B in A. Consideriamo, ad esempio, la struttura

A = (!; F A), dove F A (n) = n + 2, e poniamo B = f0g e F = fF Ag: l'insieme

IB;F denito per induzione dalla coppia (B; F ) e l'insieme dei pari.

L'insieme IB;F , proprio perche e denito induttivamente da (B; F ) in A,

possiede una particolare struttura alla quale possiamo fare appello quando vogliamo dimostrare che ogni suo elemento gode di una particolare proprieta P .

Il teorema seguente convalida un principio di induzione che garantisce la possibilita di dimostrare per induzione.

Teorema 2.5.1 Per ogni denizione induttiva (B; F ) in A e per ogni proprieta

P A, per dimostrare che IB;F P basta dimostrare che P e (B; F )-chiuso.

Poiche IB;F e l'intersezione di tutti gli insiemi (B; F )-chiusi, e incluso in

ogni insieme (B; F )-chiuso e quindi, in particolare, in P .

Se A = (!; ) allora A = IB;F , con B = f0g e F = fg, e in questo caso

il principio di induzione coincide con l'induzione sui naturali del paragrafo 1.5.

Come primo esempio di dimostrazione per induzione, presentiamo un teorema

che ci sara utile nel paragrafo seguente.

Teorema 2.5.2 Supponiamo che A sia generata da B A. Se D e una struttura dello stesso tipo di A e h e h0 sono due morsmi da A verso D che coincidono sui generatori, ossia tali che h(b) = h0(b) per ogni b 2 B , allora h = h0 .

Sia K = fx 2 A : h(x) = h0 (x)g. Se dimostriamo che K = A, allora

per ogni x 2 A avremo h(x) = h0(x) e quindi h = h0 . Poiche per ipotesi

A = IB;F , dove F e l'insieme delle funzioni e delle costanti di A, possiamo

procedere per induzione mostrando che K e (B; F )-chiuso. Verichiamo che

B K: cio deriva immediatamente dal fatto che h e h0 coincidono per ipotesi

sui generatori. Verichiamo che cA 2 K, per ogni costante di A. Poiche h e h0

sono morsmi

h(cA ) = cD = h0(cA ):

Supponiamo ora che F A sia una funzione n-aria di A e mostriamo che, se ogni

ai appartiene a K, per i < n, allora F A(a0 ; : : : ; an;1) 2 K. A tale scopo basta

vericare che, essendo h e h0 morsmi,

h(F A (a0; : : : ; an;1)) = F D (h(a0 ); : : : ; h(an;1))

= F D (h0 (a0 ); : : : ; h0(an;1))

= h0 (F A(a0 ; : : : ; an;1)):

La seconda riga deriva dal fatto che a0 ; : : : ; an;1 2 K.

Il punto piu delicato delle dimostrazioni per induzione e il passo induttivo,

ossia la dimostrazione dell'implicazione \se ai 2 P , per ogni i < n, allora

F A(a0 ; : : : ; an;1) 2 P " che garantisce l'estendibilita di P da B a tutto IB;F .

Per dimostrare che F A(a0 ; : : : ; an;1) appartiene a P puo accadere che occorra

assumere non solo che P sia goduta da ogni ai , ma che P sia goduta anche da

56

Capitolo 2. Strutture

tutti gli elementi di IB;F che sono \piu semplici" di F A(a0 ; : : : ; an;1), rispetto a

un criterio di semplicita pressato. Dimostriamo che questo modo di procedere

e lecito. Innanzitutto conveniamo di misurare la semplicita degli elementi di

un insieme qualsiasi A mediante una funzione ' : A ! !. Vedremo in seguito

che esistono diversi tipi di misure, per il momento chiameremo genericamente

livello il numero naturale assegnato da ' agli elementi di A. Deniamo Ai =

fx : '(x) ig per ogni i 2 !, l'insieme di tutti gli elementi di A aventi livello

i. Evidentemente gli insiemi Ai formano una catena.

Lemma 2.5.3 Sia ' : A ! ! e P A. Se A0 P e, per ogni i 2 !, Ai P

implica Ai+1 P , allora A = P .

Consideriamo l'insieme di numeri naturali N = fx : Ax P g. Per induzione

su ! possiamo concludere

S che N = ! e quindi, per ogni i 2 !, Ai P. Quindi

A P dato che A = fAi gi2! . Poiche P A possiamo concludere P = A.

Diremo che un elemento a 2 A e P; '-completo se, per ogni x 2 A, '(x) <

'(a) implica P(x). Diremo che una proprieta P e '-progressiva se ogni elemento

P; '-completo gode di P. In altri termini, se P e '-progressiva accade che

quando un elemento x di A e tale che tutti gli elementi piu semplici di x godono

di P, anche x gode di P , dove maggiore semplicita signica livello minore.

Possiamo allora convalidare il principio induttivo seguente.

Teorema 2.5.4 Se ' : A ! ! e P e '-progressiva, allora A = P .

Dimostriamo che A0 P. Se a 2 A0 allora '(a) = 0 e quindi '(x) < '(a)

e falsa per ogni x 2 A. Allora e banalmente vero che '(x) < '(a) implica

P (a). Cio dimostra che a e P; '-completo e poiche P e '-progressiva a 2 P.

Mostriamo ora che, per ogni i 2 !, Ai P implica Ai+1 P . Per il lemma

precedente potremo allora concludere che A = P . Sia Ai P e sia a 2 Ai+1 .

Poiche Ai Ai+1 si danno due casi. Caso 1), a 2 Ai e allora per ipotesi

induttiva a 2 P. Caso 2), a 2 Ai+1 ; Ai , allora '(a) = i + 1. Per ogni x 2 A,

'(x) < '(a) implica x 2 P, perche '(x) < '(a) implica '(x) i e quindi

x 2 Ai . Allora a e P; '-completo e poiche P e '-progressiva per ipotesi, a 2 P.

Quindi in entrambi i casi Ai+1 P.

Esercizio 2.5.1 Supponiamo che A abbia dominio !. Si verichi che IB;F e:

! ; f0g quando B = f1g e F = f+g, ! quando B = f0g e F = f; +g, f0g

quando B = f0g e F = f+g. Se F = fg, qual e il minimo B tale che IB;F = !?

2.6 Denizioni per recursione

Se A e generata da B e la struttura D e dello stesso tipo di A, potremmo

cercare di denire una funzione h : A ! D nel modo seguente. Fissiamo

il comportamento di h sugli elementi di B, vale a dire supponiamo data una

funzione g : B ! D e poniamo h(b) = g(b) per ogni b 2 B. Quanto agli

57

2.6. Denizioni per recursione

a 2 A ; B, poniamo

D

a = cA

h(a) = cF D (h(a0 ) : : :h(an;1)) se

se a = F A(a0 ; : : : ; an;1).

Diremo allora che h e denita per recursione. Che cosa garantisce che abbiamo

veramente denito una funzione da A verso D, ossia che ad ogni elemento di A

abbiamo associato un unico valore? Se a = cA e a 2 B abbiamo cD = h(a) =

g(a), e nulla garantisce che cD sia uguale a g(a). Inoltre h(F A(a0 ; : : : ; an;1))

sembra denito in modo circolare nei termini dei vari h(ai ): chi ci assicura che

abbiamo denito qualcosa? Il teorema di recursione che dimostreremo in questo

paragrafo mostra che e possibile denire per recursione, quando A soddisfa

particolari condizioni, ma prima di presentare la dimostrazione del teorema

conviene riesaminare le denizioni induttive.

Sia A una struttura, B A e F l'insieme delle funzioni e delle costanti di

A. (Non e necessario supporre che IB;F coincida con A.) Nel paragrafo precedente abbiamo sottolineato che le denizioni induttive non creano gli oggetti

che deniscono, e vero tuttavia che gli elementi di IB;F sono ottenuti da B con

un processo di generazione nel quale intervengono le funzioni e le costanti di F .

Il processo di generazione di un a 2 IB;F puo essere rappresentato mediante un

albero etichettato ' : ! A, ossia una funzione ' che assegna ad ogni nodo

dell'albero un oggetto di A come etichetta. Richiederemo che il vertice di sia etichettato da a e che i nodi terminali siano etichettati dagli elementi di B e

dalle costanti di F che intervengono nel processo. Se 2 non e un nodo terminale e se 0 ; : : : ; n;1 sono i suoi successori, allora ricevera come etichetta

F A(a0 ; : : : ; an;1), dove ai e l'etichetta di i per i < n. Un albero etichettato di

questo genere e detto (B; F )-costruzione di a, o semplicemente costruzione, se e

chiaro dal contesto qual e la coppia (B; F ) a cui si fa riferimento. Supponiamo,

ad esempio, che sia A = (!; GA; F A; cA), dove GA e il successore, F A la somma,

cA lo zero, e poniamo B = f1g. Possiamo visualizzare alcune costruzioni nel

modo seguente:

cA

GA (cA )

1

GA (1)

cA

@@ ;;

@;

1

1

@@ ;;

@;

GA(GA (cA )) F A(GA(1); cA )

F A(1; 1)

Nella gura precedente sono mostrate tre costruzioni di 2: e evidente, quindi,

che un elemento puo avere costruzioni dierenti. Tuttavia, se ci limitiamo a considerare strutture A in cui ogni elemento del dominio ha un'unica costruzione,

allora possiamo sfruttare questa caratteristica di A per denire h : A ! D

58

Capitolo 2. Strutture

per recursione. Dato a 2 A consideriamo l'unica costruzione che lo genera e la

trasformiamo modicandone sistematicamente le etichette nel modo seguente:

i) sostituendo nei nodi terminali b con g(b) e le costanti di A con quelle di D,

ii) utilizzando negli altri nodi le funzioni di D corrispondenti a quelle di A. La

gura seguente illustra questa trasformazione:

b

GA (b)

g(b)

cA

@@ ;;

@;

GD (g(b))

cD

@@ ;;

@;

F A(GA (b); cA)

F D (GD (g(b)); cD )

Deniamo h(a) come l'elemento nel vertice della costruzione trasformata. Nel

caso della gura precedente,

h(F A(GA (b); cA)) = F D (GD (g(b)); cD ):

E evidente che una h cosi denita e un morsmo, mentre il fatto che sia una funzione dipende essenzialmente dall'unicita della costruzione degli elementi della

struttura A.

Il processo mediante il quale si trasforma una (B; F )- costruzione in una

(g[B]; H)-costruzione, dove H e l'insieme di funzioni e costanti di D, e alla

base della dimostrazione del teorema di recursione. La condizione che ogni

elemento di A abbia un'unica costruzione e rimpiazzata dalla richiesta che A

sia generata liberamente da B, ossia che A sia generata da B e che (B; F )

soddis le condizioni seguenti:

1. cA 62 B, per ogni cA 2 F ,

2. cA 6= eA , per ogni cA , eA 2 F tali che c 6= e,

3. Im(F A ) \ B = ;, per ogni F A 2 F ,

4. Im(F A ) \ Im(GA ) = ;, per ogni F A, GA 2 F tali che F 6= G,

5. cA 62 Im(F A ), per ogni cA , F A 2 F ,

6. F A e iniettiva, per ogni F A 2 F .

(E possibile dimostrare che se A e generata liberamente, ogni suo elemento

possiede un'unica costruzione.)

Teorema 2.6.1 Se A e generata liberamente da B A allora, per ogni struttura D dello stesso tipo di A e ogni g : B ! D, esiste un'unico morsmo

h : A ! D che estende g.

2.6. Denizioni per recursione

59

La funzione h che deniremo e un insieme di coppie ordinate incluso in A

D.

Poiche h sara denita per induzione, penseremo A D come il dominio di una

struttura C = A D, detta prodotto cartesiamo di A per B e denita nel modo

seguente. La struttura C ha lo stesso tipo di A e D e inoltre cC =< cA ; cD >

per ogni simbolo di costante c e

F C (< x0; y0 >; : : : ; < xn;1; yn;1 >) =< F Ax; F Dy >

per ogni simbolo di funzione F, dove x 2 An e y 2 Dn . Consideriamo allora la

denizione induttiva (g; F ) in C , dove F e costituito da tutte le funzioni e le

costanti di C e poniamo h = Ig;F . La dimostrazione del fatto che h soddisfa le

condizioni del teorema si articola in quattro punti.

1. Dimostriamo che h e una funzione. Sia K l'insieme degli elementi di A

sui quali h, se e defnita, e univoca:

K = fx 2 A : < x; y >; < x; z >2 h implica y = z g:

Dimostreremo che K e B; F -chiuso e quindi K = A. Poiche per ogni < x; y >

e < x; z > in h vale sempre x 2 A, ne segue che y = z, quindi h e una funzione.

Passiamo ora alla dimostrazione di B; F -chiusura per K.

Dimostriamo che B K. Dobbiamo vericare che se < b; y > e < b; z >

sono in h allora y = z. Se < b; y > e in h si danno i tre casi seguenti: i)

< b; y >2 g e allora y = g(b); ii) < b; y >=< cA; cD >, per qualche simbolo di

costante c, ma allora b = cA , il che e impossibile per il punto 1) della denizione

di struttura generata liberamente; iii) < b; y >=< F Ax; F Dy >, per qualche

simbolo di funzione F e per x 2 An , y 2 Dn , ma allora b = F Ax, il che e

impossibile per il punto 3) della denizione. Analogamente se < b; z > e in h

possiamo dimostrare che z = g(b). Ma allora y = g(b) = z.

Dimostriamo che cA 2 K, per ogni simbolo di costante c. Dobbiamo vericare che se < cA ; y > e < cA ; z > sono in h allora y = z. Se < cA ; y > e in

h si danno i tre casi seguenti: i) < cA ; y >2 g e allora < cA; y >=< b; g(b) >

e quindi cA = b, per qualche b 2 B, ma cio e impossibile per il punto 1) della

denizione; ii) < cA ; y >=< eA ; eD >, per qualche simbolo di costante e, e

quindi cA = eA e y = eD , ma allora c = e per il punto 2) della denizione e

quindi y = eD = cD ; iii) < cA ; y >=< F Ax; F D y >, per qualche simbolo di

funzione F e per x 2 An , y 2 Dn , ma allora cA = F Ax, il che e impossibile per

il punto 5) della denizione. Quindi se < cA ; y > e in h deve essere y = cD .

Analogamente se < cA ; z > e in h deve essere z = cD . Quindi dalla nostra

ipotesi segue y = cD = z.

Dimostriamo che se a 2 K n allora F Aa 2 K. Dobbiamo vericare che

se < F Aa; y > e < F Aa; z > sono in h allora y = z. Se < F Aa; y > e

in h si danno i tre casi seguenti: i) < F A a; y >=< b; g(b) >, per qualche

b 2 B, ma allora F Aa = b e cio e impossibile per il punto 3) della denizione;

ii) < F Aa; y >=< eA ; eD >, per qualche simbolo di costante e, ma allora

F Aa = eA e y = eD , ma cio e impossibile per il punto 5) della denizione;

iii) < F Aa; y >=< GA q; GDr >, dove q 2 Am e r 2 Dm e dove < qi ; ri >

60

Capitolo 2. Strutture

appartiene a h. Allora

F A(a0 ; :::; an;1) = GA (q0; : : : ; qm;1)

da cui segue per il punto 4) della denizione sia F = G sia n = m. Quindi

F A(a0 ; :::; an;1) = F A(q0; : : : ; qn;1)

da cui segue ai = qi per il punto 6) della denizione. Allora anche < ai; ri >

appartiene a h. Poiche F = G e n = m, abbiamo

y = GD (r0 ; : : : ; rm;1) = F D (r0; : : : ; rn;1)

e poiche h(ai) = ri , vale F D (r0; : : : ; rn;1) = F D (h(a0); : : : ; h(an;1)). Abbiamo allora y = F D (h(a0); : : : ; h(an;1)). Se < F A(a); z > e in h otteniamo

analogamente z = F D (h(a0 ); : : : ; h(an;1)) e quindi y = z.

2. Dimostriamo che Dom(h) = A e Im(h) D. E evidente che Im(h)

e inclusa in D. Dimostriamo che A e il dominio di h. A tale scopo basta

dimostrare che Dom(h) e (B; F )-chiuso. Vale B Dom(h), dato che g h e

B = Dom(g). Vale cA 2 Dom(h), dato che < cA ; cD >2 h per ogni simbolo

di costante c. Supponiamo ora che a0 ; : : : ; an;1 2 Dom(h) e dimostriamo che

F A (a) 2 Dom(h). Per ipotesi esistono d0; : : : ; dn;1 2 D tali che ogni < ai ; di >

appartiene a h e quindi anche < F A(a); F A(d) > appartiene a h, poiche h e

(g; F )-chiuso. Ma allora F A (a) appartiene a Dom(h).

3. Dimostriamo h e un omomorsmo. Vale ovviamente h(cA ) = cD . Supponiamo ora che a0 ; : : : ; an;1 2 A, poiche Dom(h) = A esistono d0; : : : ; dn;1 2 D

tali che h(ai ) = di . Poiche h e un insieme (g; F )-chiuso deve contenere anche

< F A(a); F D(d) > e quindi

h(F A (a0; : : : ; an;1)) = F D (d0; : : : ; dn;1) = F D (h(a0) : : :h(an;1)):

4. Inne si dimostra facilmente, utilizzando il teorema 2.5.2, che h e l'unico

omomorsmo da A verso D che estende g.

Gli esempi piu semplici di denizioni per recursione si ottengono utilizzando

la struttura A = (!; A ), dove A = . E evidente che A e generata liberamente

da B = f0g. Se consideriamo la struttura D = (!; D ), dove D = , allora

il teorema 2.6.1 garantisce che per ogni funzione g : f0g ! ! esiste un'unica

funzione ' : ! ! ! tale che

'(0) = g(0) e '((n)) = ('(n)):

Diremo allora che ' e denita per iterazione a partire da e da g.

Il teorema 2.6.1 permette di giusticare anche denizioni piu complesse dell'iterazione, nelle quali il valore '(n+1) dipende non solo dal valore precedente

'(n), ma anche dal livello della recursione, ossia da n. Diremo che una funzione

' : ! ! ! e denita per recursione primitiva da k e : 2 ! ! ! se

'(0) = k e '((n)) = ('(n); n):

61

2.6. Denizioni per recursione

Mentre nell'iterazione abbiamo '(n + 1) = (: : : (0) : : :), dove la funzione

viene applicata n + 1-volte, nella recursione primitiva abbiamo la chiamata in

successione di diverse funzioni, tutte ottenibili come parametrizzazioni di .

Se parametrizziamo la seconda variabile di con dierenti numeri naturali,

otteniamo la successione di funzioni

0(x) = (x; 0); : : : ; n (x) = (x; n); : : :

e possiamo scrivere '(n + 1) = n(: : : 0 (0) : : :). Non si tratta quindi di un'iterazione, ma l'uniformita che sussiste nel passaggio dal calcolo del valore per n

al calcolo del valore per n+1 e suciente per poter aerrare la procedura come

un unico processo, detto recursione primitiva. Il teorema seguente giustica una

forma piu generale di recursione primitiva che ci sara utile in seguito.

Teorema 2.6.2 Per ogni c 2 C e : C ! ! C , esiste una funzione ' : ! ! C

tale che

'(0) = c e '((n)) = ('(n); n):

Diremo che ' e denita per recursione primitiva da c e .

Consideriamo una struttura A = (!; A), dove A = , e una struttura

D = (C !; D ) dove, per ogni x 2 C e ogni n 2 !, D (x; n) = ( (x; n); (n)).

Per il teorema 2.6.1 esiste una funzione : ! ! D tale che

(0) = (c; 0) e (A (n)) = D ((n)):

Osserviamo che (n) = (i20 ((n)); i21 ((n))), dove i20 e i21 sono le funzioni che

danno rispettivamente il primo e il secondo elemento di una 2-pla. Dimostriamo

per induzione su ! il seguente lemma:

i21 ((n)) = n:

Vale infatti i21 ((0)) = i21 (k; 0) = 0. Supponiamo che l'asserto valga per n,

abbiamo allora, ricordando che A = ,

i21 (((n)) = i21 (D ((n))

= i21 (D (i20 ((n)); i21 ((n)))

= i21 ( (i20 ((n)); i21 ((n))); (i21 ((n))))

= (i21 ((n)))

= (n):

A questo punto possiamo denire ' = i20 . Verichiamo che ' soddisfa le

condizioni poste dal teorema. Innanzitutto

'(0) = i20 ((0)) = i20 (c; 0) = c:

62

Capitolo 2. Strutture

Inoltre abbiamo

'((n)) = i20 (((n)))

= i20 (D ((n)))

= i20 (D (i20 ((n)); i21((n)))

= i20 ( (i20 ((n)); i21 ((n))); (i21 ((n))))

= (i20 ((n)); i21 ((n)))

= (i20 ((n)); n)

= ('(n); n);

dove la penultima equazione si ottiene per il lemma e l'ultima per la denizione

di '.

Corollario 2.6.3 Per ogni : C ! C e : C ! C ! C , esiste una funzione

' : ! C ! C tale che, per ogni c 2 C ,

'(0; c) = (c) e '((n); c) = ('(n; c); n; c):

Diremo che ' e denita per recursione primitiva da e .

Fissiamo un elemento qualsiasi c 2 C e con esso parametrizziamo l'ultimo

argomento di ottenendo una funzione c : C ! ! C tale che, per ogni x 2 C

e ogni n 2 !, c (x; n) = (x; n; c). Se siamo in grado di denire una funzione

'c : ! ! C tale che

'c (0) = (c) e 'c ((n)) = c('c (n); n);

allora possiamo dimostrare, per induzione su !, che 'c (n) = '(n; c) e quindi

possiamo usare quest'ultima equazione per denire, al variare di c 2 C, la

' richiesta dal teorema. Ma l'esistenza di 'c si ottiene immediatamente dal

teorema precedente.

Siamo ora in grado di giusticare la seguente denizione ricorsiva della funzione somma:

+(0; m) = m e + ((n); m) = (+(n; m)):