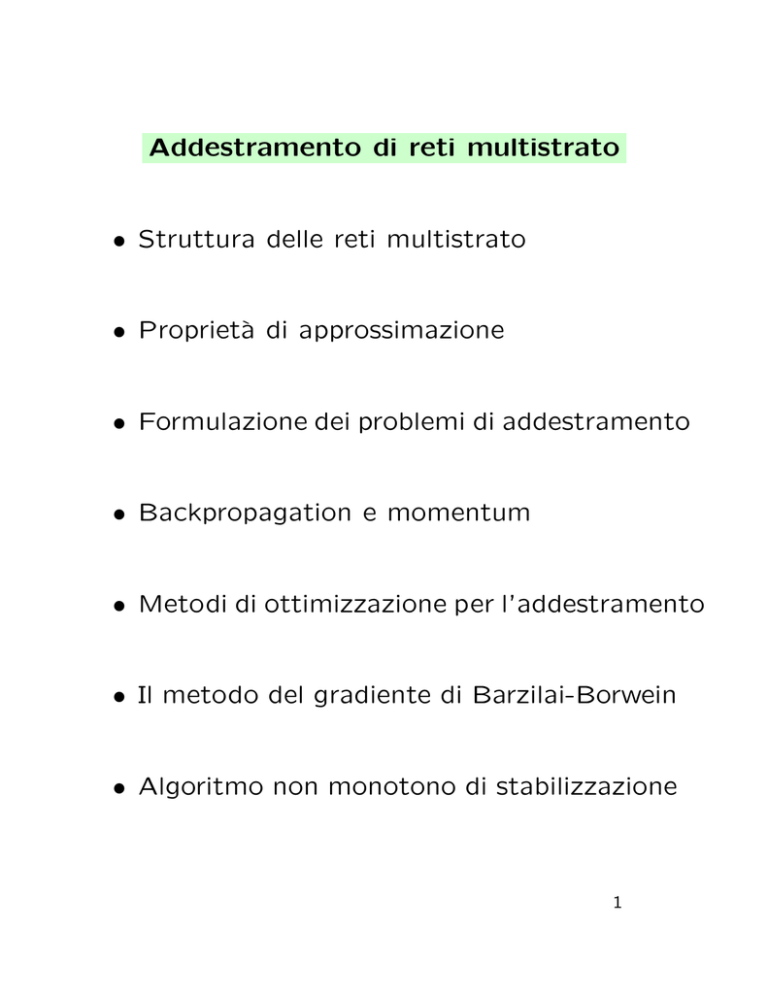

Addestramento di reti multistrato

² Struttura delle reti multistrato

² Proprietµ

a di approssimazione

² Formulazione dei problemi di addestramento

² Backpropagation e momentum

² Metodi di ottimizzazione per l'addestramento

² Il metodo del gradiente di Barzilai-Borwein

² Algoritmo non monotono di stabilizzazione

1

Struttura delle reti multistrato

L'architettura di una rete multistrato

(multilayer feed-forward, multilayer perceptron)

µ

e de¯nita da:

² M nodi di ingresso, sprovvisti di capacitµ

a di

elaborazione, associati agli ingressi xi 2 R

² un insieme di neuroni organizzati in L ¸ 2

strati, di cui:

{ L ¡ 1 strati nascosti (hidden layers) ;

{ uno strato di uscita, che fornisce le uscite

yi della rete

² un insieme di archi orientati e pesati che stabiliscono le connessioni.

Non esistono connessioni tra i neuroni di uno

stesso strato, n¶

e connessioni in feedback.

2

Rete multistrato

ingressi

x1

uscite

y1

x2

y2

x3

strato d’uscita

strato nascosto strato nascosto

Rete a 3 strati con 2 strati nascosti, 3 ingressi, 2 uscite.

3

Consideriamo una rete a 2 strati, con 1 strato

nascosto e 1 uscita (lineare):

²

xi: i¡ma componente dell'ingresso

² wji: peso della connessione tra l'ingresso i

e il neurone nascosto j

²

µj : soglia del neurone nascosto j

²

vj : peso della connessione tra il neurone

nascosto j e il neurone d'uscita

²

Ã: funzione di attivazione dei

neuroni dello strato nascosto

²

zj : uscita del neurone nascosto j

²

aj : combinazione dei segnali in ingresso

al neurone nascosto j

²

y: uscita della rete.

4

Si ha:

aj =

M

X

i=1

y=

wjixi ¡ µj ;

N

X

vj zj =

j=1

=

zj = Ã(aj );

N

X

0

vj à @

M

X

j=1

i=1

N

³

´

X

T

vj à wj x ¡ µj ;

j=1

j = 1; : : : ; N

1

wjixi ¡ µj A

dove wj = (wj1; : : : ; wjM )T .

La funzione di attivazione à si suppone usualmente di®erenziabile e sigmoidale. Le funzioni

piµ

u comuni sono la

funzione logistica

1

; c>0

¡ct

1+e

e la funzione tangente iperbolica

Ãc(t) =

1 ¡ e¡t

Ã(t) = tanh(t=2) =

:

¡t

1+e

5

Rete con 2 strati e 1 strato nascosto

+

w11

w21

x1

1

2

ψ

z1

1

θ1

v1

w31

+

w12

x2

a1

w22

w32

a2

v2

y

+

2

θ2

v3

+

θ3

ψ

z2

a3

ψ

z3

3

6

Proprietµ

a di approssimazione

Le proprietµ

a di approssimazione delle reti multistrato sono state oggetto di numerosi studi.

In particolare, le reti a 2 strati con 1 strato

nascosto sono approssimatori universali per

le funzioni continue su insiemi compatti di RM ,

per un'ampia classe di funzioni di attivazione.

Poniamo

M(Ã) = spanfÃ(w0x ¡ µ); µ 2 R; w 2 RM g;

(ossia M(Ã) µ

e l'insieme di tutte le combinazioni

lineari delle funzioni ottenute applicando la funzione di attivazione à a una trasformazione

a±ne di x de¯nita da w e µ.)

Vale il risultato seguente

Teorema 1 (Pinkus, 1996) Sia à 2 C(R).

Allora M(Ã) µ

e denso in C(RM ), nella topologia

della convergenza uniforme sugli insiemi compatti se e solo se à non µ

e un polinomio.

7

Ne segue che, dati :

² una qualsiasi funzione f 2 C(RM ),

² un qualsiasi insieme compatto − ½ RM

² un qualsiasi " > 0

e ¯ssata una funzione di attivazione à qualsiasi

(purch¶

e continua e non polinomiale) si puµ

o

costruire una rete a 2 strati (con scelta opportuna del numero dei neuroni, e dei valori

dei pesi e delle soglie), tale che la funzione ingresso uscita g 2 M(Ã) realizzata dalla rete

soddis¯:

max jf (x) ¡ g(x)j < ":

x2−

Altri risultati recenti consentono di restringere

la scelta di w e µ e anche di allargare l'insieme

delle funzioni di attivazione ammissibili (cfr.

Pinkus, 1999).

8

Le reti a 2 strati consentono anche, in linea di

principio, di interpolare esattamente i dati.

Vale il risultato seguente.

Teorema 2 (Pinkus, 1999) Sia à 2 C(R)

non polinomiale.

M e K numeri

Dati K punti distinti fxigK

i=1 ½ R

K

M

f®igK

i=1 ½ R, esistono K vettori fwj gj=1 ½ R

K

e 2K numeri fvj gK

j=1; fµj gj=1 ½ R tali che

K

X

j=1

vj Ã(wjT xi ¡ µj ) = ®i;

i = 1; : : : ; K:

Molti studi recenti sono stati dedicati alla stima

del grado di approssimazione , in funzione

di M e del numero N di neuroni. Nel caso

generale, per funzioni appartenenti a spazi di

Sobolev, sono stati stabiliti lower bound sull'errore di approssimazione, che implicano la necessitµ

a di una crescita esponenziale del numero

di neuroni di una rete a 2 strati al crescere della

dimensione dello spazio.

9

Un risultato interessante µ

e che per reti a 3

strati (con 2 strati nascosti), in cui la funzione

ingresso-uscita sia del tipo

y=

N2

X

i=1

0

uià @

N1

X

j=1

1

T

vij Ã(wij

x ¡ µij ) ¡ °iA ;

non esistono lower bound teorici sull'errore di

approssimazione e vale il risultato seguente.

Teorema 3 (Maiorov and Pinkus, 1999)

Esiste una funzione di attivazione à 2 C 1,

strettamente crescente e sigmoidale tale che:

per ogni funzione f 2 C([0; 1]M ) ed ogni " > 0,

esistono costanti ui, vij , µij , °i e vettori

wij 2 RM , per cui risulta:

¯

0

1¯

¯

¯

4M+3

2M

+1

X

X

¯

¯

T

¯f (x) ¡

@

A

uiÃ

vij Ã(wij x ¡ µij ) ¡ °i ¯¯ < ";

¯

¯

¯

i=1

j=1

per ogni x 2 [0; 1]M :

10

Il teorema precedente µ

e basato sul famoso

Teorema di Kolmogorov (1957), che ha risolto (in senso negativo) la congettura di Hilbert

sull' esistenza di funzioni continue di tre

variabili, non rappresentabili come composizione di funzioni continue di due variabili

(13-mo problema di Hilbert).

Nel Teorema di Kolmogorov si dimostra che le

funzioni continue di n varabili si possono rappresentare come sovrapposizione di funzioni

di una variabile. Nella versione piµ

u semplice

(Lorentz, 1976) si ha

Teorema 4 Esistono n costanti ¸j > 0,

Pn

j=1 ¸j · 1 e 2n + 1 funzioni continue strettamente crescenti Ái : [0; 1] ! [0; 1] tali che ogni

funzione continua f di n variabili su [0; 1]n si

puµ

o rapprentare nella forma:

f (x1 : : : ; xn) =

2n+1

X

i=1

0

g@

n

X

j=1

1

¸j Ái(xj )A ;

per qualche g 2 C[0; 1] dipendente da f .

11

Il ruolo (controverso) del Teorema di Kolmogorov

nello studio delle reti neurali µ

e stato (ed µ

e tuttora oggetto) di un intenso dibattito.

Alcune delle versioni del Teorema sembrano

suggerire la rappresentazione di una funzione

attraverso una struttura di rete multistrato, in

cui perµ

o la funzione (di attivazione) g µ

e incognita e puµ

o avere un andamento fortemente

non smooth (Vitushkin (1964)). Ciµ

o potrebbe

rendere scarsamente signi¯cativa l'interpretazione neurale. Questa µ

e la tesi in

F.Girosi and T.Poggio, Representation properties of

Networks: Kolmogorov's Theorem is irrelevant, Neural

computation, 1989.

D'altra parte, in molti lavori recenti Kurkova,

Sprecher, Pinkus,..) il teorema di Kolmogorov

viene utilizzato per stabilire risultati di approssimazione attraverso reti multistrato.

V.Kurkova, Kolmogorov's Theorem is relevant,

Neu-

ral computation, 1991.

Cfr. anche il survey:

F.Scarselli and A.C. Tsoi, Neural Networks,1998.

12

Formulazione dei problemi di addestramento

Fissata l'architettura (2 strati, 1 uscita), e raccogliendo in un vettore w 2 Rn tutti i parametri

incogniti, il problema dell'addestramento relativo a un training set assegnato:

T = f(xp; dp); p = 1; : : : ; P g

viene usualmente formulato un come problema

di ottimizzazione del tipo:

P

1 X

min E(w) =

Ep(w);

w

2P p=1

e una misura dell'errore relativa al

in cui Ep µ

p¡mo pattern. La misura piµ

u usata µ

e l'errore

quadratico

Ep(w) = (y(xp; w) ¡ dp)2;

dove y(xp; w) µ

e l'uscita della rete in corrispondeza all'ingresso xp e al vettore di parametri w.

13

Le di±coltµ

a computazionali dei problemi di addestramento di reti multistrato sono tipicamente dovute a

² non compattezza degli insiemi di livello

² forti nonlinearitµ

a di E

² presenza di zone \piatte" nella super¯cie

della funzione d'errore

² possibile mal condizionamento dell'Hessiana

² elevata dimensionalitµ

a di w

² elevato numero P di campioni

² presenza di minimi locali

a di dover ripetere l'addestramento

² necessitµ

in corrispondenza a varie architetture, a varie

funzioni di errore, a vari criteri di arresto.

µ da notare, tuttavia che non µ

E

e richiesta una

grande precisione nella soluzione e puµ

o anche

essere preferibile interrompere il processo di

minimizzazione prematuramente (in base all'errore ottenuto su un validation set)

( \early stopping" ).

14

La compattezza degli insiemi di livello µ

e assicurata se alla funzione di errore si aggiunge

un termine di regolarizzazione, de¯nendo la

nuova funzione obiettivo

P

1 X

Ep(w) + °kwk2 ;

E(w) =

2P p=1

con ° > 0:

In tal caso tutti gli insiemi di livello

L(®) = fw 2 Rn : E(w) · ®g

sono compatti ed µ

e possibile stabilire risultati

di convergenza globale (a punti stazionari)

per molti algoritmi di ottimizzazione.

La presenza del termine di regolarizzazione µ

e

tuttavia motivata, nella teoria dell'apprendimento, dall'esigenza di migliorare le capacitµ

a di

generalizzazione, penalizzando valori elevati dei

pesi e prevenendo fenomeni di overtraining.

In particolare, ° potrebbe essere scelto utilizzando un validation set.

15

Super¯cie d'errore di una rete costituita da

1 solo neurone, con 1 ingresso e 1 uscita,

in funzione del peso e della soglia

16

Backpropagation e Momentum

Uno dei primi algoritmi proposti per il calcolo

dei pesi µ

e il metodo noto come metodo di

backpropagation (BP), e si puµ

o identi¯care

con il metodo del gradiente.

La versione batch µ

e de¯nita dall'iterazione

wk+1 = wk ¡ ´k rE(wk );

e il gradiente di E in wk

dove: rE(wk ) µ

´k 2 R (learning rate) de¯nisce il passo.

Il termine backpropagation µ

e legato alla tecnica utilizzata per il calcolo del gradiente, che

si puµ

o ricondurre attualmente a una tecnica di

di®erenziazione automatica.

Una tecnica analoga µ

e quella utilizzata da tempo

nei problemi di controllo ottimo per esprimere

(in funzione di stato e costato) il gradiente

rispetto al controllo (Bryson-Ho, 1969).

17

Sia wji il peso di un arco entrante nel neurone j. Calcoliamo il termine @Ep =@wji

(per una rete multistrato di tipo generale).

i

zi

wji

aj

zj

ψ

j

Utilizzando le regole di derivazione, e tenendo conto

della struttura, si puµ

o porre

@Ep @aj

@Ep

=

:

@wji

@aj @wji

De¯nendo

@Ep

;

@aj

±j =

e ricordando che

aj =

X

wjizi;

i

dove la sommatoria µ

e estesa ai neuroni e agli ingressi

che inviano archi a j (inclusa la soglia wj0 con z0 = 1),

si ha

@Ep

= ±j zi:

@wji

18

Basta calcolare zi, ±j per ottenere la derivata.

e l'uscita del neurone i e quindi si puµ

o

La quantitµ

a zi µ

determinare, a partire dall'ingresso, applicando successivamente le trasformazioni de¯nite dalla rete

( propagazione in avanti degli ingressi ).

Rimane da calcolare, per ogni neurone, la quantitµ

a

±j =

@Ep

:

@aj

Distinguiamo due casi:

(a) il neurone k appartiene allo strato d'uscita.

δk

ak

Ψ’(ak)

yk

δΕ

δyk

k

In tal caso yk = Ã(ak ) e quindi

@Ep

@Ep

= Ã(ak )0

;

@ak

@yk

essendo Ã(ak )0 la derivata della funzione di attivazione

e @Ep=@yk calcolabile analiticamente.

±k ´

19

(b) il neurone j µ

e un neurone nascosto.

In tal caso, si puµ

o porre:

X @Ep @ak

@Ep

=

;

±j ´

@aj

@ak @aj

k

dove la somma µ

e estesa a tutti i neuroni (nascosti o

d'uscita) che ricevono segnali dal neurone j.

(Ep dipende da aj solo attraverso la dipendenza da ak ) .

Essendo

ak = : : : + wkj zj + : : :

=

: : : + wkj Ã(aj ) + : : :

si ha:

@ak

= Ã(aj )0wkj ;

@aj

e quindi si puµ

o scrivere

X

0

±j = Ã(aj )

±k wkj ;

k

Quindi:

le quantitµ

a ±j (dette errori) relative ai neuroni di uno

strato, si ottengono propagando all'indietro lungo la rete

gli errori relativi ai neuroni dello strato successivo, a

partire dallo strato d'uscita.

( retro-propagazione degli errori )

20

Retro-propagazione

a

δj

k

ψ

Ψ’(aj)

k

k

wkj

+

y

δk

k

j

±j = Ã(aj

)0

X

±k wkj :

k

La tecnica di backpropagation consente di calP

colare rE = p rEp con un costo

O(P £ W );

dove W µ

e il numero di parametri, P il numero

di pattern.

21

La convergenza del metodo BP, per un valore

costante della learning rate ´ puµ

o essere garantita nell'ipotesi che il gradiente di E soddis¯

una condizione di Lipschitz, ossia esista L tale

che, per ogni w; u si abbia:

krE(w) ¡ rE(u)k · Lkw ¡ uk:

Fissato un punto iniziale w0 2 Rn de¯niamo

l'insieme di livello

L0 = fw : E(w) · E(w0)g:

Vale il risultato seguente.

Teorema 5 Supponiamo che valga una condizione di Lipschitz su un insieme limitato convesso contenente L0 e che si assuma

2¡"

;

L

con " > 0. Allora la successione fwk g de¯nita

da

"·´·

wk+1 = wk ¡ ´rE(wk )

ha punti di accumulazione e ogni punto di accumulazione µ

e un punto stazionario di E.

22

In pratica, puµ

o essere di±cile stimare L e un

passo costante µ

e in genere ine±ciente.

Sono disponibili varie tecniche di ricerca unidimensionale, ben note nel campo dei metodi

di ottimizzazione, che garantiscono la convergenza e fanno migliorare notevolmente il comportamento del metodo.

Tuttavia, tutte le implementazioni tradizionali

del metodo del gradiente sono in generale inef¯cienti e possono richiedere un numero molto

elevato di iterazioni e di valutazioni della funzione e del gradiente anche per problemi di piccola dimensione.

Una modi¯ca spesso e±cace µ

e la cosiddetta

momentum updating rule

wk+1 = wk ¡ ´rE(wk ) + ¯(wk ¡ wk¡1);

dove ´ > 0 e ¯ > 0 sono valori ¯ssati

(ad es. ´ ¼ 0:01 ¥ 0:001, ¯ ¼ 0:7 ¥ 0:9).

23

Tale modi¯ca µ

e nota nel campo dei metodi

di ottimizzazione come Heavy Ball method

(HB), a causa dell'analogia con il moto di un

corpo pesante in un campo di forze, in presenza

di attrito.

Si puµ

o enunciare il risultato seguente, che µ

e un

risultato di convergenza locale.

Teorema 6 (Poljak, 1964) Sia w¤ un punto

di minimo di E, tale che la matrice Hessiana

sia de¯nita positiva e abbia tutti gli autovalori

in [`; L] con ` > 0. Supponiamo che

0 · ¯ < 1;

0 < ´ < 2(1 + ¯)=L:

Allora esiste " > 0, tale che se w0; w1 stanno

nella sfera fu : jju ¡ w¤jj · "g, il metodo (HB)

a lineare.

converge a w¤ con rapiditµ

24

Nel caso quadratico si dimostra che, con una

scelta opportuna dei parametri, la rapiditµ

a di

convergenza µ

e superiore a quella del metodo

del gradiente ed µ

e comparabile con quella del

gradiente coniugato. La scelta ottima µ

e

p !2

Ãp

4

L¡ `

p

p

´= p

¯= p

2

( L + `)

L+ `

e garantisce un bound sul rapporto fra gli errori

consecutivi approssimativamente eguale a

p

p

L¡ `

p :

p

q=

L+ `

Nel metodo del gradiente con ricerche esatte

L¡`

q=

:

L+`

Nel caso generale, tuttavia la convergenza non

puµ

o essere garantita e la scelta dei parametri

puµ

o essere di±cile.

Il metodo µ

e stato applicato con criteri euristici

e risulta notevolmente piµ

u e±ciente, in pratica,

rispetto al metodo del gradiente anche per valori costanti di ´ e ¯.

25

Metodi di ottimizzazione per l'addestramento

Per l'addestramento di reti multistrato sono

utilizzabili i metodi di ottimizzazione non vincolata per problemi a grande dimensione e in

particolare:

² Metodi delle direzioni coniugate

(implementazioni globalmente convergenti del

metodo di Polak-Ribiµ

ere)

² Metodi Quasi-Newton a memoria

limitata

² Metodi tipo Gauss-Newton (troncati)

² Metodi di Newton (troncati)

µ possibile fornire formule di backpropagation

E

anche per il calcolo dell'Hessiana, per il calcolo

del prodotto Hessiana£direzione e per il calcolo

della Jacobiana (in Gauss-Newton) (Bishop).

Tuttavia per il calcolo delle derivate seconde il

costo puµ

o crescere con O(P £ W 2) .

26

La classe di metodi di addestramento piµ

u e±ciente, nei problemi di \media" di±coltµ

a e con

numero di variabili dell'ordine del migliaio appare essere quella dei

metodi Quasi-Newton a memoria limitata .

Tuttavia il limite principale dei metodi tipo

Quasi-Newton (e dei metodi del Gradiente Coniugato) nei problemi di addestramento \difa

¯cili" risiede nel requisito di monotonicitµ

nella riduzione di E:

E(wk+1) < E(wk );

che deve esere \su±ciente" e deve essere

assicurata attraverso ricerche unidimensionali

abbastanza accurate e costose .

Ciµ

o puµ

o comportare costi computazionali inaccettabili, soprattutto in presenza di \valli

ripide"

(di±coltµ

a tipica dei problemi non lineari, in

presenza di mal condizionamento della matrice

Hessiana).

27

Esempio: Funzione di Maratos

2 ¡ 1)2

F (x) = x1 + ¿ (x2

+

x

1

2

(¿ = 10)

Per valori abbastanza elevati di ¿ la funzione ha

una valle (lungo x21 + x22 = 1) ed ha punto di minimo

prossimo a (¡1; 0). Tutti i metodi monotoni devono

seguire la valle.

28

Il metodo del gradiente di Barzilai-Borwein

Una recente versione del metodo del gradiente,

nota come metodo del gradiente di BarzilaiBorwein (BB), appare particolarmente promettente nei problemi di addestramento \di±cili".

Il metodo BB µ

e un metodo di tipo gradiente

descritto dallo schema iterativo

1

k+1

k

w

= w ¡ k rE(wk )

®

e de¯nito mediante una delle

dove lo scalare ®k µ

seguenti formule

sT y

®1 = T

s s

yT y

®2 = T

s y

con

s = wk ¡ wk¡1;

y = rE(wk ) ¡ rE(wk¡1):

29

Le scelte dello scalare ®k sono connesse

all'equazione Quasi-Newton

Bs = y

dove B µ

e una matrice n £ n simmetrica de¯nita

positiva che approssima la matrice Hessiana

r2E(wk ).

Infatti, gli scalari

sT y

®1 = T

®2 =

s s

minimizzano, rispettivamente:

yT y

sT y

1

k®Is ¡ yk

ks ¡ Iyk

®

(Ossia B viene scelta della forma B = ®I)

Altra interpretazione:

Nel caso quadratico, ®1 e ®2 sono approssimazioni degli autovalori ¸i dell'Hessiana.

Per una funzione quadratica, il metodo del

gradiente converge in n passi se gli spostamenti sono 1=¸i, per i = 1; : : : ; n.

30

La convergenza del metodo del gradiente BB µ

e

stata stabilita nel caso di obiettivo quadratico

strettamente convesso (Raydan, 93).

Nel caso generale, il metodo BB puµ

o non convergere. Un metodo di stabilizzazione globale

(GBB method), (Raydan, 97) µ

e de¯nito da

1

k)

=

rE(w

®k

dove 0 < ¸k · 1 µ

e calcolato per mezzo di una

line search non monotona di tipo Armijo

(introdotta originariamente per stabilizzare il

metodo di Newton) (Grippo, Lampariello,

Lucidi, 86), e basata sulla condizione

wk+1

wk

¡ ¸k

E(wk + ¸dk ) ·

max

0·j·min(k;M)

n

E(wk¡j )

o

+ °¸rE(wk )T dk ;

dove

1

dk = ¡ k rE(wk )

®

e il passo BB (eventualmente modi¯cato).

e ®k µ

31

Il metodo GBB

² consente di migliorare notevolmente il

comportamento del metodo del gradiente

²µ

e competitivo con il metodo del gradiente

coniugato anche nei problemi convessi

a grande dimensione

² puµ

o richiedere un costo computazionale

elevato in problemi di±cili.

µ necessario un ulteriore rilassamento della non

E

monotonicitµ

a (Fletcher,2001)

Una nuova tecnica di stabilizzazione non

monotona del metodo BB µ

e stata de¯nita recentemente ed µ

e basata su:¤

{ la combinazione di una tecnica

watchdog non monotona

con una

line search non monotona

{ l'introduzione di una nuova linesearch che

consente anche incrementi del passo

Appare particolarmente promettente

per l'addestramento di reti multistrato

¤ Grippo

e Sciandrone, 2001, in corso di stampa su

Computational Optimization and Applications

32

Algoritmo non monotono di stabilizzazione

Lo schema di globalizzazione proposto (NMS1)

µ

e applicabile ad un metodo qualsiasi.

Si puµ

o descrivere de¯nendo

² una sequenza di iterazioni principali k = 0; 1::

che producono i punti wk

² per ogni k, una sequenza di iterazioni interne

che generano attraverso un algoritmo locale

una sequenza ¯nita di N punti:

k

yik ; y2k ; : : : ; yN

Si suppone che per ogni k sia generata una direzione dk gradient-related, ossia tale che

kdk k · c1krE(wk )k

rE(wk )T dk · ¡c2krE(wk )k2;

per c1; c2 > 0.

Ad esempio dk = (1=®k )rE(wk ); con

0 < " · ®k · 1=":

33

Un'iterazione principale puµ

o essere descritta dallo

schema seguente

Algoritmo NMS1

Passo 1. Calcola la direzione dk e poni

p1 = dk ;

y1 = wk + dk

Passo 2. Per i = 2; N determina una direzione

pi (con un algoritmo qualsiasi) e poni

yi = yi¡1 + pi

Passo 3. Se risulta

E(yN ) ·

max

fE(wk¡j )g ¡ ¯(

0·j·min(k;M )

N

X

i=1

kpik);

dove M ¸ 0 µ

e un intero pre¯ssato, poni

wk+1 = yN ;

altrimenti determina ¸k utilizzando un

algoritmo di ricerca unidimensionale

non monotono e poni

wk+1 = wk + ¸k dk

34

La ricerca unidimensionale deve soddisfare la

condizione seguente:

Condizione sulla line search (LS)

Sia K un sottoinsieme di indici tale che

wk+1 = wk + ¸k dk ;

Allora:

(C1) Per ogni k 2 K risulta:

E(wk + ¸k dk ) ·

max

0·j·min(k;M)

k 2 K;

fE(wk¡j )g¡¾(¸k kdk k);

dove M ¸ 0 µ

e un intero pre¯ssato,

e ¾ : R+ ! R+ µ

e una funzione di forzamento;

(C2) Se K µ

e un sottoinsieme in¯nito, se fE(wk )g

converge e se fwk gK µ

e limitata, allora si ha

rE(wk )T dk

lim

= 0:

k

k!1;k2K

kd k

La condizione (LS) puµ

o essere soddisfatta in

modo costruttivo, attraverso un algoritmo di

ricerca unidimensionale che ammette anche eventuali incrementi del passo di primo tentativo

¸=1

35

Si puµ

o dimostrare il seguente risultato.

Teorema 7 Supponiamo che l'insieme di

livello L0 sia compatto, che che fwk g sia una

successione in¯nita prodotta dall'algoritmo

NMS1 e che la condizione LS sia soddisfatta.

Allora:

(i) fwk g ½ L0 ed ha punti limite

e

(ii) Ogni punto limite della sequenza fwk g µ

e un

un punto stazionario di E in L0, e non µ

punto di massimo locale.

(iii) Siano fyik g, con i = 1; : : : ; N le sequenze

dei punti generati e accettati dall'algoritmo

nelle iterazioni interne.

Allora ogni punto

e un punto

limite di ogni sequenza fyik g µ

e un punto di

stazionario di E in L0, e non µ

massimo locale.

36

Esperienza computazionale

² Il metodo BB µ

e stato inserito nell'algoritmo

di stabilizzazione, utilizzando sia ®1 che ®2

nelle iterazioni locali

² l'algoritmo µ

e stato sperimentato su un

elevato numero di problemi test (CUTE)

con dimensione n da 100 a 10000

² confronti con un metodo Quasi-Newton

a memoria limitata (NAG)

² risultati preliminari su problemi di

addestramento di reti neurali multistrato

La sperimentazione ha mostrato che:

² nei problemi test a grande dimensione il metodo

µ

e competitivo con tecniche tipo Q-N;

² consente di risolvere problemi di±cili

non a®rontabili con metodi monotoni;

² appare particolarmente adatto a risolvere

problemi di addestramento di reti neurali;

²µ

e di semplice programmazione.

Promettente anche la stabilizzazione non

monotona del metodo \momentum".

37

Esempio 1

Rete multistrato (1,2,1) per approssimare sen(x)

1. Prime 300 iterazioni

Approssimazione Sen(x)

100

10

BP

Armijo

Momentum

NMS1(20)

28

25

22

19

16

13

7

4

10

E(w)

1

1

0.1

0.01

0.001

Iterazioni(/10)

38

Esempio 1

Rete multistrato (1,2,1) per approssimare sen(x)

2. 5000 iterazioni

Approssimazione Sen(x)

100

10

E(w)

0.1

469

433

397

361

325

289

253

217

181

145

109

73

37

1

1

BP

Armijo

Momentum

NMS1(20)

0.01

0.001

ITERAZIONI/10

39

Esempio 2

Problema di addestramento 50 neuroni

Modello neurale di combustore

Combust1 50

100000

1000

Q. Newton

NMS1(2)

100

10

100

91

82

73

64

55

46

37

28

19

10

1

1

lo g E (w )

10000

ng/10

40

Esempio 3

Funzione di Maratos

Iterazioni 5-40

Omessi alcuni salti non monotoni

1.5

1

0.5

-1

-1.5

41

33

31

29

27

25

23

21

19

17

15

13

11

9

7

5

3

1

-0.5

QN

35

NMS2

0

Esempio 3

Funzione di Maratos

iterazioni 40-6289 (QN)

1.5

1

0.5

NMS2

1

394

787

1180

1573

1966

2359

2752

3145

3538

3931

4324

4717

5110

5503

5896

6289

0

-0.5

-1

-1.5

42

QN

Ricerca in corso

² Estensioni del metodo BB basate su

stime diverse del passo (uso dei passi BB

calcolati in iterazioni precedenti)

² Stabilizzazione non monotona del metodo

Momentum

² Versioni senza derivate del metodo BB

² Sperimentazione di tecniche di addestramento per reti con 2 strati nascosti

o per reti di Kolmogorov

43