Capitolo 8

Stima dei Parametri

Lo scopo dello studio dei fenomeni fisici è quello di scoprire le leggi che legano le grandezze

oggetto di indagine e di misurare il valore delle costanti che compaiono della formulazione di

leggi fisiche note. Il primo passo in questa analisi consiste nell’ipotizzare una relazione matematica tra le grandezze fisiche che caratterizzano il fenomeno osservato. Questa funzione

matematica costituisce il cosiddetto “modello matematico”, brevemente “modello”. Con

modello si intende una forma matematica (lineare, quadratica, esponenziale,. . . o una loro

combinazione) della quale fanno parte un certo numero di parametri incogniti λ 1 , λ2 , . . . , λk

(che alle volte saranno indicate con Λ per brevità). La stima del valore di questi parametri è,

in molti casi, l’obiettivo principale dello studio del fenomeno fisico. Una volta specificato un

modello, i dati raccolti permettono di stimare i parametri con i metodi che verranno esposti

nei prossimi paragrafi.

La stima del valore dei parametri che caratterizzano una popolazione statistica è un’importante capitolo della statistica detto teoria degli stimatori. La teoria degli stimatori si

divide in puntuale, quando valuta il valore di un parametro, e in stima di intervallo, quando

assegna un intervallo di valori che includa il parametro cercato con un prefissato livello di

fiducia1

Come esempio si consideri un esperimento in cui per stimare l’accelerazione di gravità

locale si studia il moto di un grave in caduta libera; le grandezze fisiche osservate sono un

certo numero di distanze percorse dal grave in corrispondenza di tempi fissati (s i , ti ), i =

1, . . . , N . La teoria, in particolare il secondo principio della dinamica, stabilisce che queste

grandezze soddisfano la relazione2 s = gt2 /2 dove g è l’accelerazione di gravità; il modello

matematico da adattare ai dati sarà quindi una forma quadratica: s = λ 1 + λ2 t + λ3 t2

dove il parametro λ1 tiene conto di una eventuale valore non nullo della reale coordinata

di inizio del moto, λ2 tiene conto di un’eventuale velocità iniziale non nulla e infine λ 3 è

il parametro che stima l’accelerazione di gravità diviso 2. Se i dati sperimentali sono in

numero sufficiente (possibilmente in numero molto maggiore dei parametri Λ) la teoria degli

estimatori (in particolare la stima puntuale) fornisce gli strumenti per stimare i parametri dai

dati sperimentali.

Nei paragrafi successivi saranno esposti i due metodi più usati per la stima puntuale dei

parametri: il metodo dei minimi quadrati e il metodo di massima verosimiglianza.

1

Si parla di fiducia e non di probabilità perché nell’interpretazione frequentista della probabilità i parametri

delle teorie hanno valori fissi per quanto non noti e quindi non ammettono una distribuzione di probabilità.

L’interpretazione soggettivista della probabilità al contrario, ammette che i parametri incogniti in quanto tali

abbiano una distribuzione di probabilità.

2

Supponendo velocità iniziale e coordinata di inizio del moto nulle

85

CAPITOLO 8. STIMA DEI PARAMETRI

8.1

86

Metodo dei Minimi Quadrati

In questo paragrafo illustriamo metodo dei minimi quadrati, uno dei metodi di stima puntuale

più utilizzati in fisica e non solo. Consideriamo un esperimento nel quale siano state acquisite

N coppie di valori (xi , yi ) di due grandezze fisiche X e Y tra le quali si ipotizza che esista

una relazione funzionale3 Y = f (X|Λ), (il modello). Come già detto la funzione f dipenderà

anche da un certo numero di parametri Λ : {λk }; ad esempio se la relazione funzionale è

lineare avremo: f (X|λ1 , λ2 ) = λ1 + λ2 X, se è quadratica: f (X|λ1 , λ2 , λ3 ) = λ1 + λ2 X +

λ3 X 2 , se è esponenziale: f (X|λ1 , λ2 ) = λ1 exp(λ2 X) e così via. Supponiamo inoltre le

grandezze yi siano affette dalle incertezze uyi mentre le incertezze sulle grandezze xi possano

essere ritenute trascurabili.

Fatte queste premesse, possiamo enunciare il Principio dei Minimi Quadrati: la stima

migliore dei parametri incogniti Λ è quella che minimizza la seguente espressione:

R=

N

�

(yi − f (xi |Λ) )2

i=1

(8.1)

u2yi

somma R degli scarti quadrati tra il valore sperimentale e quello previsto dal modello (il valore

“teorico”) diviso per la stima della varianza di yi (u2yi ). Per ottenere la stima di parametri

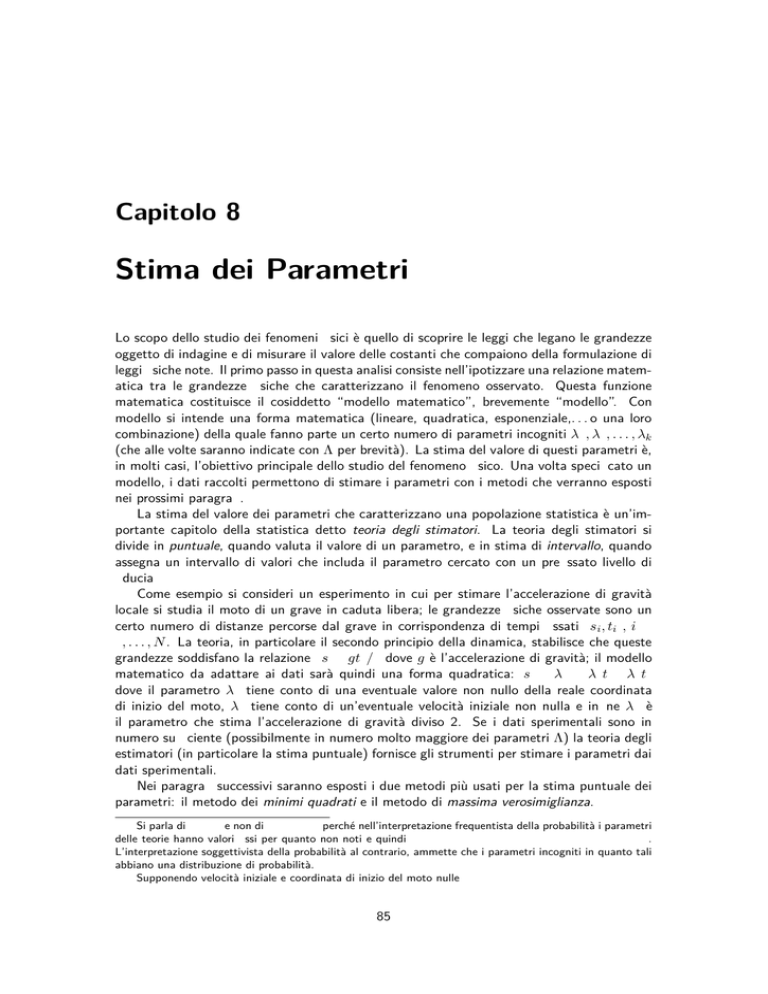

f(x)

x

Figura 8.1: La somma delle distanze al quadrato tra i punti “sperimentali” e i corrispondenti valori teorici

(quelli sulla curva) deve essere minima per la definizione della migliore curva secondo il Metodo del Minimi

Quadrati.

Λ si deve trovare il minimo dell’espressione (8.1) vista come funzione dei parametri, ovvero

si deve risolvere il seguente sistema:

∂R

∂R

∂R

=

= ... =

=0

∂λ1

∂λ2

∂λm

(8.2)

dove m è il numero dei parametri da determinare. Se indichiamo con Λ o = {λ1o , λ2o , . . . λmo }

la soluzione del sistema (8.2), la funzione f (X, Λo ) è completamente determinata e generalmente viene indicata con il termine gergale di fit4 dei dati.

Si noti il principio dei minimi quadrati non richiede alcuna condizione sulla distribuzione

di probabilità delle grandezze yi ; tuttavia se le yi hanno distribuzioni gaussiane con valore

3

La relazione matematica da utilizzare può derivare da considerazioni teoriche legate all’analisi del

fenomeno che si studia oppure può essere suggerita dagli andamenti fenomenologici sperimentali

4

Il termine inglese fit si può tradurre, in questo contesto, con: procedura di adattamento di una curva

teorica ai dati sperimentali

CAPITOLO 8. STIMA DEI PARAMETRI

87

medio f (xi |Λo ) e deviazione standard uyi allora l’espressione che si ottiene dalla (8.1) quando

Λ = Λo è per definizione una variabile che segue la distribuzione del χ 2 (vedi il paragrafo

5.9.6), e potremo scrivere5 :

N

�

(yi − f (xi |Λo ) )2

(8.3)

χ2 =

u2yi

i=1

In questo caso, utilizzando le tabelle precompilate della distribuzione del χ 2 , si potranno fare

considerazioni probabilistiche sulla qualità del fit ottenuto 6 , come sarà mostrato nel capitolo

9.

8.2

Minimi quadrati e fit lineare

L’applicazione più semplice del metodo dei minimi quadrati si ha quando la funzione che si

vuole adattare all’insieme delle N coppie di dati (xi , yi ± uyi ) è lineare. Il modello teorico

in questo caso è rappresentato da una retta: y = a + bx (per raccordarsi con la notazione

precedente: λ1 = a e λ2 = b), nel piano xy e la funzione R da minimizzare si scrive come:

R=

N

�

i=1

wi (yi − a − bxi )2

dove per semplificare la notazione si sono introdotti i pesi wi delle misure yi definiti dalla

relazione: wi = 1/u2yi . In valori di a e b che minimizzano R sono quelli che annullano le

derivate di R rispetto ai due parametri:

N

�

∂R

wi (yi − a − bxi ) = 0

=−2

∂a

(8.4)

i=1

N

�

∂R

wi xi (yi − a − bxi ) = 0

=−2

∂b

i=1

Per alleggerire la notazione poniamo:

S0 =

�

wi , S x =

�

wi xi , Sxx =

�

wi x2i , Sxy =

Con queste posizioni il sistema precedente si scrive:

�

�

w i x i yi , S y =

aS0 + bSx = Sy

aSx + bSxx = Sxy

�

wi yi (8.5)

(8.6)

La soluzione del sistema precedente è:

a=

dove

1

(Sxx Sy − Sx Sxy ) ,

Δ

b=

1

(S0 Sxy − Sy Sx )

Δ

(8.7)

Δ = S0 Sxx − (Sx )2

Si verifica facilmente che i valori trovati corrispondono al minimo di R. Riassumendo, le

relazioni (8.7) sono le stime dei parametri a e b con il metodo dei minimi quadrati.

5

In molti testi, anche se in modo improprio e che può generare confusione, l’espressione (8.1) è indicata

con il simbolo χ2 anche nel caso generale in cui la distribuzione delle yi non sia normale.

6

Se la distribuzione cui appartengono le yi non è gaussiana ma è nota, il calcolo della qualità del fit

ottenuto è molto più complessa da ottenere

CAPITOLO 8. STIMA DEI PARAMETRI

88

Incertezza sui parametri a e b. I parametri a e b sono variabili aleatorie in quanto funzioni,

in particolare lineari, delle variabili aleatorie y i , quindi applicando la formula di propagazione

delle incertezze (7.10) si ha per l’incertezza su parametro a:

N

�

u2a =

j=1

=

�

∂a

∂yj

�2

u2yj

�

N

∂Sy

∂Sxy

1 �

= 2

Sxx

− Sx

Δ j=1

∂yj

∂yj

�2

N

1

(Sxx wj − Sx wj xj )2

1 �

= 2

=

wj

Δ j=1

wj

N �

�

�

1 �

1 � 2

Sxx

2

2

2

2

2

S

w

+

S

w

x

−

2S

S

w

x

=

S

S

+

S

S

−

2S

S

xx x j j

xx x =

xx j

x j j

xx 0

x xx

2

2

Δ j=1

Δ

Δ

e per l’incertezza sul parametro b:

u2b

=

N

�

j=1

=

�

∂b

∂yj

�2

u2yj

�

N

∂Sxy

∂Sy

1 �

= 2

S0

− Sx

Δ j=1

∂yj

∂yj

�2

N

1

(S0 wj xj − Sx wj )2

1 �

= 2

=

wj

Δ j=1

wj

N �

�

�

1 �

1 � 2

S0

2

2

2

2

2

S

w

x

+

S

w

−

2S

S

w

x

=

S

S

+

S

S

−

2S

S

j

j

0

x

j

j

xx

0

0

0

j

x

0

x

x =

2

2

Δ j=1

Δ

Δ

Riassumendo le incertezze standard sui parametri a e b ottenuti con il metodo dei minimi

quadrati sono:

�

�

Sxx

S0

ub =

(8.8)

ua =

Δ

Δ

Caso delle incertezze uguali. Nel caso in cui tutte le incertezze sulle yi siano uguali

(uyi = uy ) le posizioni (8.5) si semplificano, utilizzando il peso w = 1/u 2y , in

S0 = wN, Sx = w

�

xi , Sxx = w

�

x2i , Sxy = w

�

x i yi , S y = w

�

yi

(8.9)

Si verifica facilmente che in questo caso il valore di entrambi i parametri a e b, dati dalle

(8.7), non dipende dal valore dell’incertezza uy . Le incertezze su a e b date dalle (8.8) in

questo caso divengono:

ua = u y

8.2.1

Esempi

�

N

� 2

x

� 2 i�

xi − (

xi ) 2

ub = u y

�

N

N

� 2

�

xi − ( xi ) 2

Consideriamo un esperimento con cui si vuole misurare la costante elastica di una molla

elicoidale. L’esperimento si esegue nel seguente modo: la molla viene sospesa e se ne misura

l’allungamento rispetto alla sua posizione di riposo in funzione della massa che è agganciata

all’estremo libero della molla. Nell’esperimento si misurano, con un’incertezza trascurabile,

la massa del peso (variabile x) che si aggancia all’estremo libero della molla e il conseguente

allungamento (variabile y) con la sua incertezza uy . Nella tabella seguente sono riportate 5

coppie di misure delle grandezze x e y.

x (g)

50

100

150

200

250

(y ± uy ) (mm)

50 ± 2

91 ± 4

120 ± 6

174 ± 8

225 ± 11

CAPITOLO 8. STIMA DEI PARAMETRI

89

y = allungamento (mm)

300

250

200

150

100

50

0

0

50

100

150

200

250

300

x = massa del peso (g)

Figura 8.2: Grafico dell’allungamento di una molla in fuzione della massa del peso applicato. La retta nel

grafico è il fit ai dati ottenuto con il metodo dei minimmi quadrati.

La teoria dell’elasticità, in particolare la legge di Hooke (F = −kΔx), prevede che

in condizioni di equilibrio ci sia proporzionalità tra la forza generata dalla molla e il suo

allungamento. Quindi il modello matematico da applicare è quello lineare. Volendo stimare

con il metodo dei minimi quadrati il valore della costante k della molla assumeremo come

variabile “x” (quella con incertezze trascurabili) la massa del peso e come variabile “y”

l’allungamento della molla. Nel grafico in figura 8.2 sono riportati i punti della tabella

precedente con la massa del peso nell’asse delle ascisse e l’allungamento della molla nell’asse

delle ordinate. La curva (una retta) che si vuole adattare ai dati (ovvero eseguire il “fit”) è:

(8.10)

y = a + bx

Dove la costante a tiene conto del fatto che in questo esperimento non sempre si riesce a

misurare il vero allungamento (rispetto alla condizione di “molla a riposo”); in pratica si

misura la coordinata dell’estremo della molla rispetto ad un’origine arbitraria. La costante

a, una volta stimata, fornirà appunto il valore della coordinata dell’estremo della molla a

riposo. La costante b, attraverso la legge di Hooke, si esprime come b = k/g dove k è la

costante della molla cercata e g è l’accelerazione di gravità.

Applichiamo il metodo dei minimi quadrati a questo problema iniziando con il calcolare

il valore delle espressioni (8.5). Con semplici calcoli algebrici si ottiene 7

S0 = 0.257, Sx = 21.615, Sxx = 2530.332, Sy = 19.806, Sxy = 2243.775

e quindi

a=

Sxx Sy − Sx Sxy

= 8.803 mm

S0 Sxx − (Sx )2

b=

S0 Sxy − Sy Sx

= 0.812 mm g−1

S0 Sxx − (Sx )2

(8.11)

Attraverso le (8.8) si ottengono le incertezze standard sui parametri a e b:

ua =

7

�

Sxx

= 3.71 mm

S0 Sxx − (Sx )2

ub =

�

S0

= 0.0374 mm g−1

S0 Sxx − (Sx )2

Per questo tipo di calcoli, in particolare quando il numero di dati è elevato, l’aiuto di programmi di calcolo

facilita e velocizza la procedura e rende più difficile fare errori nei calcoli. Un programma particolarmente

utile per questi calcoli è il foglio elettronico excel oppure il suo equivalente open source

CAPITOLO 8. STIMA DEI PARAMETRI

90

In conclusione la stima puntuale dei parametri a e b con il metodo dei minimi quadrati è:

a = (8 ± 4) mm

b = (0.81 ± 0.04) mm g−1

Dal valore di b si risale alla costante k della molla attraverso la relazione k = bg.

L’incertezza su k si ottiene propagando unicamente quella b, solo se si assume per g un

valore la cui incertezza8 sia tale che ug � gub /b. La giustificazione di questa condizione è

lasciata al lettore.

8.2.2

Minimi quadrati e Media pesata

Supponiamo di avere n misure yi di una stessa grandezza fisica, ciascuna con una propria

incertezza ui . Supponiamo inoltre che queste misurazioni siano state eseguite con diverse

modalità per cui le varie incertezze sono differenti, come ad esempio mostrato nella figura

8.3. Applichiamo il metodo dei minimi quadrati per ottenere una stima della grandezza che

tenga conto di tutte le misurazioni eseguite con le loro incertezze. In questo caso la funzione

f (x|Λ) si riduce ad una costante, λ, il cui valore corrisponde al valore della grandezza cercata.

La funzione R da minimizzare è

R=

n

�

(yi − λ)2

u2i

i=1

derivando e annullando la relazione precedente si ha:

�

n

n

n

�

�

�

∂R

yi − λ

yi

1

=

−2

−

λ

= −2

2

2

∂λ

ui

u

u2

i=1

i=1 i

i=1 i

�

=0

Da cui introducendo i pesi wi = 1/u2i otteniamo la nota formula della media aritmetica

pesata:

�

w i yi

y≡λ= �

wi

Y

1

2

3

4

5

Figura 8.3: Misure ripetute con incertezze differenti.

8

in tutti i casi in cui nelle formule appaiono grandezze di riferimento (come l’accelerazione di gravità),

l’incertezza è sostanzialmente determinata dal numero di cifre significative che si utilizzano nei calcoli

CAPITOLO 8. STIMA DEI PARAMETRI

8.3

91

Il metodo di Massima Verosimiglianza

Esempio introduttivo. Per introdurre il concetto della verosimiglianza in statistica e del

suo uso nella valutazione dei parametri consideriamo un semplice esperimento consistente

in N lanci di un dado e definiamo come evento favorevole l’uscita del numero “6”. Come è

noto, la distribuzione del numero di eventi favorevoli segue la distribuzione binomiale 9

B(k|p) =

� �

N k

p (1 − p)N −k

k

(8.12)

dove p è la probabilità del singolo evento e, fissato il numero N degli eventi, p è l’unico

parametro della distribuzione. Se il dado è ben equilibrato possiamo supporre p = 1/6 e la

forma della distribuzione di probabilità (8.12) è completamente determinata. Ad esempio,

tramite la (8.12), possiamo calcolare la probabilità che in 10 lanci del dado esca un solo 6

(il 32%), oppure che ne escano tre (il 16%). La distribuzione di probabilià binomiale (8.12)

con N = 10 e p = 1/6 è mostrata nella figura 8.4. In generale potremo affermare che

Figura 8.4: Distribuzione binomiale di probabilità per N = 10 e p = 1/6

se conosciamo la distribuzione di probabilità e il valore dei parametri che la caratterizzano

siamo in grado di conoscere la probabilità con cui si realizzano gli eventi.

Tuttavia il problema che si deve affrontare nell’attività sperimentale è quello inverso, e

cioè noti i dati si vuole ottenere la stima dei parametri. Continuando con l’esempio del dado,

supponiamo che si abbia il sospetto che il dado sia “truccato” (ad esempio appesantendo

una faccia) e che quindi la probabilità del “6” sia p, differente da 1/6. Eseguiamo quindi un

esperimento lanciando il dado N volte e sia k = ko il numero di volte che è uscito il “6”.

Un modo di stimare il valore di p, consiste nel calcolare la probabilità assegnata all’evento

osservato come una funzione del parametro p avendo fissato il valore della variabile aleatoria

a quello osservato (k = ko ):

L(p|k0 ) =

�

�

N k0

p (1 − p)N −k0

k0

(8.13)

la funzione L(p|k0 ), detta funzione di verosimiglianza, descrive l’informazione guadagnata

eseguendo l’esperimento. La funzione di verosimiglianza ha la stessa forma algebrica della

9

Sulla distribuzione binomiale vedi il paragrafo 5.8.2

CAPITOLO 8. STIMA DEI PARAMETRI

92

distribuzione di probabilità (8.12) ma ha un significato totalmente differente, infatti la funzione L dipende unicamente dai parametri (in questo esempio p) mentre le variabili aleatorie

prendono un valore fisso (k = k0 ). Nella figura 8.5 è mostrato l’andamento della funzione

di verosimiglianza (8.13) per due valori differenti di ko .

Figura 8.5: Funzione di verosimiglianza (8.13) in funzione del parametro p. Le due curve di verosimiglianza

mostrate corrispondono a due serie di 10 lanci di un dado in cui si sono avuti k 0 = 1 eventi favorevoli (curva

con il massimo a p = 0.1) e k0 = 3 eventi favorevoli (curva con il massimo a p = 0.3).

Il criterio per stimare p, noto come il criterio di massima verosimiglianza, afferma che

l’evento che si è realizzato (in questo caso esemplificato da k = k0 ) ha la massima probabilità

di accadere (infatti è accaduto) e la stima del parametro p (con il metodo di massima

verosimiglianza) si ottiene massimizzando la funzione di verosimiglianza (8.13) in funzione

di p. Tornando all’esempio, calcoliamo il valore di p per cui la funzione di verosimiglianza

(8.13) ha il suo massimo. Questo valore sarà la stima di massima verosimiglianza (p̂) del

parametro p. Per semplificare i calcoli è consuetudine utilizzare al posto della funzione L il

suo logaritmo10 : L = ln L. Nel nostro esempio:

L = ln

��

�

�

�

N k0

N

p (1 − p)N −k0 = ko ln p + (N − k0 ) ln(1 − p) + ln

k0

k0

�

Per trovare il massimo di L annulliamo la sua derivata prima:

dL

k0 N − k 0

=

−

= 0,

dp

p

1−p

da cui

p̂ =

k0

N

Il valore p̂ così ottenuto è la stima di massima verosimiglianza del parametro p. Notiamo

che essendo ko un evento

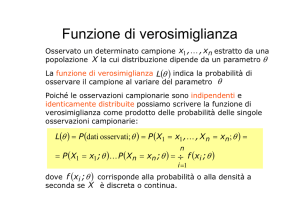

Caso generale. Generalizziamo l’esempio precedente considerando un evento definito da N

grandezze aleatorie X1 , X2 , . . . , XN indipendenti11 tra loro e siano fi (Xi |Λ) le distribuzioni

di probabilità che danno la probabilità di osservare X i dato Λ; Λ = {λ1 , . . . , λm } rappresenta

l’insieme degli m parametri da cui dipendo le fi .

10

Si può facilmente dimostrare che L e L = ln L hanno massimi (e minimi) per gli stessi valori delle variabili

da cui dipendono

11

La condizione di indipendenza non è essenziale per nella definizione del metodo di massima verosimiglianza

ma ne semplifica la formulazione matematica

CAPITOLO 8. STIMA DEI PARAMETRI

93

Data l’indipendenza delle realizzazioni Xi la probabilità di osservare una particolare

realizzazione delle Xi , che indichiamo con {x1 , x2 , . . . , xN } è proporzionale a:

f1 (x1 |Λ) · f2 (x2 |Λ) · . . . fn (xN |Λ) =

N

�

i=1

fi (xi |Λ)

(8.14)

se in questa relazione le xi sono gli esiti di un esperimento, ovvero uno specifico campione

statistico, le xi hanno un valore numerico definito e la relazione (8.14) diviene una funzione

dei soli parametri Λ. Questa funzione, in analogia con l’esempio precedente, è detta funzione

di verosimiglianza (ing. Likelihood):

L=

N

�

i=1

(8.15)

f (xi |Λ)

Come già anticipato nell’esempio introduttivo, in luogo della (8.15) si usa definire come

funzione di verosimiglianza il logaritmo della (8.15):

L = ln L = ln

N

�

i=1

f (xi |Λ) =

N

�

i=1

ln f (xi |Λ)

(8.16)

Il criterio di massima verosimiglianza. Questo criterio, originariamente sviluppato da

R. A. Fisher nel 1922, stabilisce che i valori preferiti dei parametri di una funzione di

verosimiglianza sono quelli che rendono massima la probabilità di ottenere i dati osservati.

La stima dei parametri che si ottengono massimizzando la funzione (8.16) è detta stima

di massima verosimiglianza dei parametri.

Esempi.

1. Valore medio della gaussiana. Consideriamo n misurazioni ripetute di una grandezza

{x1 , x2 , . . . , xn } che sappiamo avere una distribuzione normale di varianza nota σ e valore

medio da determinare. Supponiamo inoltre che le misurazioni ripetute della grandezza siano

indipendenti. Determiniamo la stima di massima verosimiglianza del valore medio µ. Da

quanto detto la funzione di verosimiglianza in questo caso è

L(µ) = ln

n

�

i=1

√

n

�

1

(xi − µ)2 n

−(xi −µ)2 /2σ 2

=

−

+ ln 2πσ 2

e

2

2σ

2

2πσ

i

(8.17)

Derivando la funzione di verosimiglianza rispetto a µ e annullando la derivata si ha:

n

dL �

(xi − µ)

= 0,

=

dµ

σ2

i

da cui

µ̂ =

n

1�

xi

n i

La stima di massima verosimiglianza del valore medio di una gaussiana µ̂ è data dalla

media aritmetica del campione di dati acquisiti.

2. Deviazione standard della gaussiana. Ripetiamo l’esempio 1 supponendo che anche la

varianza σ sia un parametro da determinare. Derivando rispetto a σ l’espressione della

funzione di verosimiglianza (8.17) e annullando la derivata si ha:

n

(xi − µ)2 n

dL �

=

+ = 0,

dσ

σ3

σ

i

da cui

�

�

n

�1 �

σ̂ = �

(xi − µ)2

n

i

CAPITOLO 8. STIMA DEI PARAMETRI

94

Si noti che in questo caso la stima di massima verosimiglianza della deviazione standard

è distorta se, come succede nella maggior parte dei casi, il valore medio µ è ignoto ed è

sostituito con la sua stima µ̂.

3. Media pesata. La formula della media pesata già usata precedentemente può essere

ottenuta dal metodo di massima verosimiglianza. Per semplicità consideriamo solo due

misure indipendenti x1 ± u1 , x2 ± u2 di una grandezza supponendo inoltre che le due misure

siano distribuite in modo normale con parametri σ dati rispettivamente da u 1 e u2 .

Indichiamo con µ il valore “vero” della grandezza, che è il parametro da stimare, le pdf

delle variabili aleatorie x1 e x2 sono:

√

1

2

2

e−(x1 −µ) /2u1 ;

2πu1

La funzione di verosimiglianza L è

1 1 −

e

L(µ) = ln

2π u1 u2

(x1 −µ)2

2u2

1

e

−

(x2 −µ)2

2u2

2

√

1

2

2

e−(x2 −µ) /2u2

2πu2

�

�

(x1 − µ)2 (x2 − µ)2

=−

+

+ cost.

2u21

2u22

Per trovare il massimo di L uguagliamo a zero la derivata rispetto a µ

d

d

L(µ) = −

dµ

dµ

�

(x1 − µ)2 (x2 − µ)2

+

2u21

2u22

�

=0

da cui, ponendo wi = 1/u2i , (i = 1, 2) si ottiene w1 (x1 − µ) + w2 (x2 − µ) = 0 , e risolvendo

per µ, si ha

w 1 x1 + w 2 x2

µ̂ =

w1 + w2

che è proprio la formula della media pesata.

4. Processo di Poisson. Consideriamo un processo governato dalla statistica di Poisson come

ad esempio il numero di conteggi di un contatore di raggi cosmici in un fissato intervallo temporale. Siano k1 , k2 , . . . , kn n realizzazioni del processo di Poisson considerato; la funzione

di verosimiglianza in questo caso si scrive

L(µ) = ln

�n

� µ ki

ki !

i

e

−µ

�

=

�

�

i

�

ki ln µ − nµ −

�

ln ki !

i

Derivando rispetto a µ e annullando la derivata dell’espressione precedente, si ha

dL

=

dµ

8.3.1

�n

i

µ

ki

− n = 0,

da cui

n

1�

ki

µ̂ =

n i

Minimi quadrati e Massima Verosimiglianza

Il metodo dei minimi quadrati può essere derivato da quello di Massima Verosimiglianza nel

caso particolare in cui le grandezze “y” siano distribuite in modo gaussiano. Consideriamo

due grandezze X e Y tra le quali si suppone esista una relazione funzionale Y = φ(X|Λ)

dove Λ rappresenta l’insieme dei parametri da determinare eseguendo un esperimento. Siano

xi yi ± σi N misurazioni indipendenti delle grandezze X e Y con le y distribuite in modo

gaussiano attorno al valore φ(xi |Λ) con deviazione standard σi e siano inoltre trascurabili le

CAPITOLO 8. STIMA DEI PARAMETRI

95

incertezze sulle xi . Per ipotesi, in corrispondenza ad ogni valore xi le misurazioni y hanno

la distribuzione:

1

2

2

e−(y−φ(xi |Λ)) /2σi

(8.18)

fi (y) = √

2πσi

Per l’indipendenza delle misure yi la probabilità di ottenere un particolare evento y1 , . . . , yN

è proporzionale a: f1 (y1 |Λ)f2 (y2 |Λ) . . . fN (yN |Λ). Utilizzando la (8.16), fa funzione di

verosimiglianza in questo caso si scrive:

�

N

�

(yi − φ(xi |Λ))2

1

2

2

ln √

e−(yi −φ(xi |Λ)) /2σi = −

L(Λ) =

2σi2

2πσi

i=1

i=1

N

�

�

+ cost.

Il metodo di massima verosimiglianza richiede di massimizzare L che, in questo caso, si

ottiene minimizzando la sommatoria tra parentesi. Quest’ultima è proprio la somma degli

scarti quadrati divisi per la varianza, la cui minimizzazione è esattamente la condizione

richiesta dal metodo dei minimi quadrati, a parte l’ininfluente fattore 2. Concludiamo quindi

che quando le variabili aleatorie sono distribuite in modo normale, il metodo dei minimi

quadrati e quello di massima verosimiglianza sono equivalenti, ovvero portano alla stessa

stima dei parametri incogniti.