1

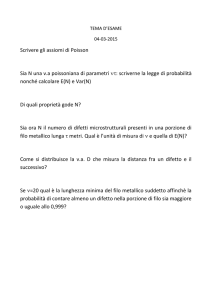

lo stimatore nearest neighbour

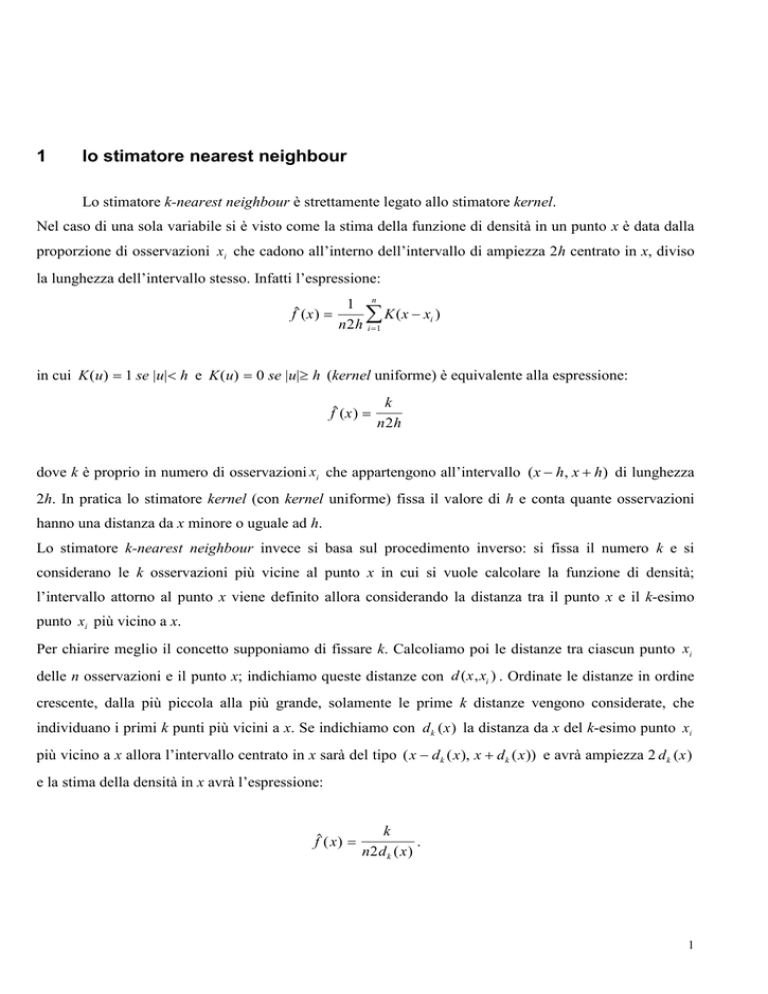

Lo stimatore k-nearest neighbour è strettamente legato allo stimatore kernel.

Nel caso di una sola variabile si è visto come la stima della funzione di densità in un punto x è data dalla

proporzione di osservazioni xi che cadono all’interno dell’intervallo di ampiezza 2h centrato in x, diviso

la lunghezza dell’intervallo stesso. Infatti l’espressione:

f ( x )

1 n

K (x xi )

n2h i 1

in cui K (u) 1 se |u| h e K (u) 0 se |u| h (kernel uniforme) è equivalente alla espressione:

f ( x )

k

n2h

dove k è proprio in numero di osservazioni xi che appartengono all’intervallo (x h, x h) di lunghezza

2h. In pratica lo stimatore kernel (con kernel uniforme) fissa il valore di h e conta quante osservazioni

hanno una distanza da x minore o uguale ad h.

Lo stimatore k-nearest neighbour invece si basa sul procedimento inverso: si fissa il numero k e si

considerano le k osservazioni più vicine al punto x in cui si vuole calcolare la funzione di densità;

l’intervallo attorno al punto x viene definito allora considerando la distanza tra il punto x e il k-esimo

punto xi più vicino a x.

Per chiarire meglio il concetto supponiamo di fissare k. Calcoliamo poi le distanze tra ciascun punto xi

delle n osservazioni e il punto x; indichiamo queste distanze con d ( x , xi ) . Ordinate le distanze in ordine

crescente, dalla più piccola alla più grande, solamente le prime k distanze vengono considerate, che

individuano i primi k punti più vicini a x. Se indichiamo con d k ( x ) la distanza da x del k-esimo punto xi

più vicino a x allora l’intervallo centrato in x sarà del tipo ( x dk ( x ), x dk ( x )) e avrà ampiezza 2 d k ( x )

e la stima della densità in x avrà l’espressione:

f ( x )

k

.

n2 d k ( x )

1

In questo caso quindi l’intervallo attorno al punto x non avrà ampiezza fissa ma varierà al variare di x in

modo tale da contenere esattamente k osservazioni (quelle più vicine ad x).

Nello stimatore k-nearest neighbour il parametro k svolge lo stesso ruolo del parametro h nello stimatore

kernel, da cui dipende il grado di irregolarità della funzione di densità stimata: grandi valori di k

producono una funzione di densità stimata molto liscia e piuttosto piatta mentre piccoli valori di k

producono una funzione molto irregolare.

Come per lo stimatore kernel, il passaggio dal caso di una sola variabile al caso di due o più variabili è

abbastanza semplice.

Quando si lavora con più di una variabile la cella costruita attorno al punto x non è più un intervallo (cioè

un segmento di retta) ma una regione dello spazio (ellissoide) centrata nel punto x: questa regione è

definita come l’insieme dei punti dello spazio z tali che la loro distanza da x sia minore di un certo valore

r.

Nel caso dello stimatore k-nearest neighbour, fissato k, r viene preso uguale alla distanza tra x e il kesimo punto più vicino a x e l’ellissoide attorno ad x è costituito allora da tutti quei punti z tali che

d 2 (x, z) dk2 (x) dove dk2 (x) è proprio il quadrato della distanza tra x e la k-esima osservazione più

vicina a x. Esattamente k osservazioni x i apparterranno a questa regione, per come questa è stata definita,

e la stima della densità nel punto x sarà data allora dalla formula:

f ( x)

k

nvk ( x)

dove vk ( x ) è il volume dell’ellissoide costruito attorno al punto x.

Occorre però decidere come devono essere calcolate le distanze tra punti in uno spazio a più dimensioni,

cioè occorre definire una “metrica” nello spazio dei punti x.

L’espressione generale della distanza tra due punti x e z è data dalla formula:

d 2 (x, z) ( z x) V 1 ( z x)

dove V 1 è una matrice quadrata simmetrica di ordine p che definisce la metrica dello spazio.

La matrice V generalmente utilizzata quando si lavora nello spazio delle osservazioni x i relative a p

variabili è la matrice di varianza e covarianza stimata S e la distanza che ne deriva viene indicata in

letteratura come distanza di Mahalanobis; le distanze tra il punto x e ciascuna osservazione x i diventano

allora:

d 2 (x, xi ) (xi x) S 1 (xi x)

2

Altre metriche tuttavia possono essere utilizzate, per esempio ponendo V uguale alla matrice diagonale

delle varianze campionarie di ciascuna variabile o alla matrice identità (che corrisponde alla metrica

euclidea).

Per la classificazione di una particolare osservazione sulla base delle osservazioni del training set si può

procedere quindi stimando separatamente le funzioni di densità nei due gruppi e applicando poi una delle

regole di classificazione introdotte precedentemente. In questo caso possono essere utilizzate due

metriche diverse nei due gruppi per il calcolo delle distanze; per esempio V potrà essere la matrice di

varianza e covarianza di gruppo.

Fissato k, il metodo trova la distanza tra x e la k-esima osservazione del training set più vicina ad x

secondo la metrica Sj 1 (nel j-esimo gruppo) e costruisce gli ellissoidi attorno a x dati dai punti z tali che

d 2 (x, z) ( z x) Sj 1 ( z x) d jk2 (x) . Se indichiamo con k j in numero di osservazioni del gruppo j che

cadono all’interno dell’ellissoide (in ciascun gruppo) la densità stimata di x per il gruppo j è:

f ( x| j )

kj

n j v jk ( x )

dove n j è la numerosità del gruppo j-esimo e v jk ( x ) è il volume dell’ellissoide corrispondente.

Tuttavia la scelta di un’unica metrica nei due gruppi, nel caso specifico la matrice di varianza e

covarianza complessiva stimata dalle osservazioni di entrambi i gruppi, semplifica notevolmente la

procedura di classificazione ed elimina la necessità della stima delle funzioni di densità di gruppo.

In questo caso infatti l’ellissoide è lo stesso per ogni gruppo e il suo volume è una costante indipendente

dall’appartenenza delle osservazioni ad uno dei due gruppi e quindi ininfluente nel confronto tra le

densità o tra le probabilità a posteriori. Ciò che è rilevante è invece la proporzione k j / n j di osservazioni

del gruppo j che appartengono all’ellissoide; in particolare se si assume che le probabilità a priori siano

uguali, l’osservazione x viene assegnata al gruppo per il quale è maggiore la proporzione k j / n j . Se anche

le numerosità dei due gruppi sono uguali, x sarà assegnato al gruppo per il quale è maggiore il numero di

osservazioni che appartengono all’ellissoide.

Infine se si pone k = 1 allora x sarà assegnato al gruppo a cui appartiene l’osservazione con distanza

minima da x.

3

2

Appendice D: Scelta dei parametri di smoothing nella discriminante

non parametrica

Nelle precedenti appendici abbiamo sottolineato il ruolo fondamentale svolto dai parametri h e k

degli stimatori kernel e k-nearest neighbour nella stima delle funzioni di densità del vettore x nelle due

popolazioni: grandi valori di h e k producono una funzione appiattita (la stima della funzione di densità in

ciascun punto non è corretta) mentre piccoli valori degli stessi parametri danno luogo ad una funzione

molto irregolare (con una distorsione minore ma con una variabilità abbastanza elevata). La scelta di

questi parametri è quindi cruciale per ottenere una buona stima della funzione di densità.

Diversi metodi sono stati proposti in letteratura (per una rassegna si vedano i lavori di Silverman, 1986 e

Hand, 1982). Molti di questi metodi si basano sull’ottimizzazione di una funzione obiettivo che coinvolge

la differenza tra la funzione di densità stimata e quella vera: in questo caso h e k vengono scelti in modo

da ottimizzare una misura di adattamento delle stime delle densità di gruppo alle vere distribuzioni (o ad

una qualche approssimazione calcolabile di queste).

Nell’analisi discriminante tuttavia l’obiettivo principale è quello di minimizzare il tasso di errore della

classificazione della regola utilizzata. Poiché, da ciò che si è detto precedentemente, la funzione

discriminante diventa funzione dei parametri di smoothing, un approccio più appropriato sembra essere

quello di scegliere il valore del parametro di smoothing che minimizza il tasso di errore (benché in alcune

circostanze possano essere avanzate alcune obiezioni concrete per il suo uso, cfr. Hand, 1982) .

In questo caso la stima delle funzioni di densità di gruppo è solamente un obiettivo intermedio mentre

l’obiettivo finale è quello di ottenere una buona classificazione (anche se ovviamente migliori saranno le

stime delle densità di gruppo migliore sarà la classificazione). In certe situazioni per esempio anche stime

della densità non molto sofisticate possono dare una buona classificazione; se tuttavia si è interessati

anche ad ottenere stime accurate delle probabilità a posteriori sarà più indicato scegliere i parametri di

smoothing in maniera da ottimizzare la stima delle densità di gruppo (per una discussione sulla scelta del

criterio di ottimizzazione cfr. Hand, 1982) .

In questo analisi abbiamo deciso di scegliere i valori di h e k in maniera da minimizzare il tasso di errore:

stimato il modello discriminante (kernel e nearest-neighbour) per diversi valori di h e k viene scelto

quello che ottiene il tasso di errore più basso.

3

Bibliografia

4

Alberici, A. (1975), Analisi dei bilanci e previsioni delle insolvenze, Isedi, Milano.

Altman, E. (1993), Corporate Financial Distress and Bankruptcy, 2nd ed., Wiley, New York.

Altman, E.I., Eom, Y.H., Kim, D.W. (1994), ‘Distress classification of Korean firms’, Working Paper

Series S-94-6, New York University Salomon Center.

Atkinson, A.C. e Riani, M (1997), Bivariate Boxplots, Multiple Outliers, Multivariate transformations

and Discriminant Analysis: the 1997 Hunter Lecture, Environmetrics, 8.

Balestri,

Forster, G. (1986), Financial Statement Analysis, 2nd ed., Prentice Hall, New York.

Hand, D.J. (1981), Discrimination and classification, Wiley, New York.

Hand, D.J. (1982), Kernel discriminant analysis, Research Studies Press.

Hartigan, J.A. (1975), Clustering Algorithms, Wiley, New York.

Huberty, C.J. (1994), Applied discriminant analysis, Wiley, New York.

Jollife, I.T. (1986), Principal Component Analysis, Springer Verlag, New York.

Krzanowski, W.J. (1988), Principle of multivariate analysis, a user’s perspective, Clarendon Press,

Oxford.

Marbach, G. (1989), Previsioni e Misure di Efficienza Aziendale, NIS, Roma.

Mardia K.V., Kent J.V. and Bibby, J.M. (1994), Multivariate Analysis, Academic Press, Londra.

Mclachlan G.J (1992), Discriminant analysis and statistical Pattern Recognition, Wiley, New York.

Milligan, G.W., Cooper, M.C. (1985), An Examination of Procedures for Determining the Number of

Clusters in a Data Set, Psychometrika, pp. 159-179.

Murphy, B.J, Moran M.A. (1986), ‘Parametric and kernel density estimation in discriminant analysis:

another comparision’, Comput. Math. Applic. 12A .

Riani, M. (1997), Monitoraggio delle imprese in base ai bilanci: il caso delle aziende tessili del distretto

di Prato, Atti del convegno SIS: La statistica per le imprese, Torino.

Riani, M. e Zani, S. (1997), “An Iterative Procedure for the Detection of Multiple Outliers”, Metron.

Silverman, B.W. (1986), Density estimation for statistics and data analysis, Chapman and Hall, London.

Atkinson, A.C. and Riani, M. "Robust Diagnostic Regression Analysis, Springer Verlag, New York

(2000).

Harvey, A.C., Koopman, S.J, Riani, M. (1997) "The Modeling and Seasonal Adjustment of Weekly

Observations", Journal of Business and Economic Statistics, , pp. 354-368.

Riani, M. (1998) "Weights and Robustness of Model Based Seasonal Adjustment", Journal of

Forecasting, pp. 19-34.

Cerioli, A. and Riani, M. (1999) "The Ordering of Spatial Data and the Detection of Multiple Outliers",

Journal of Computational and Graphical Statistics, (1999), pp. 1-20.

5

6