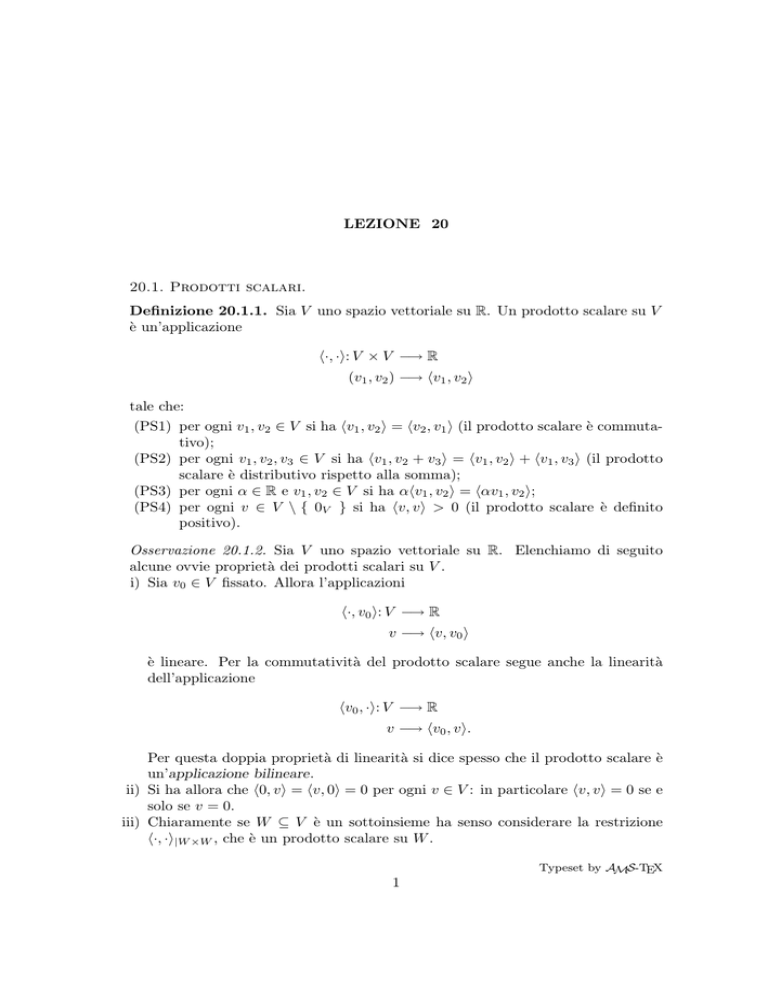

LEZIONE 20

20.1. Prodotti scalari.

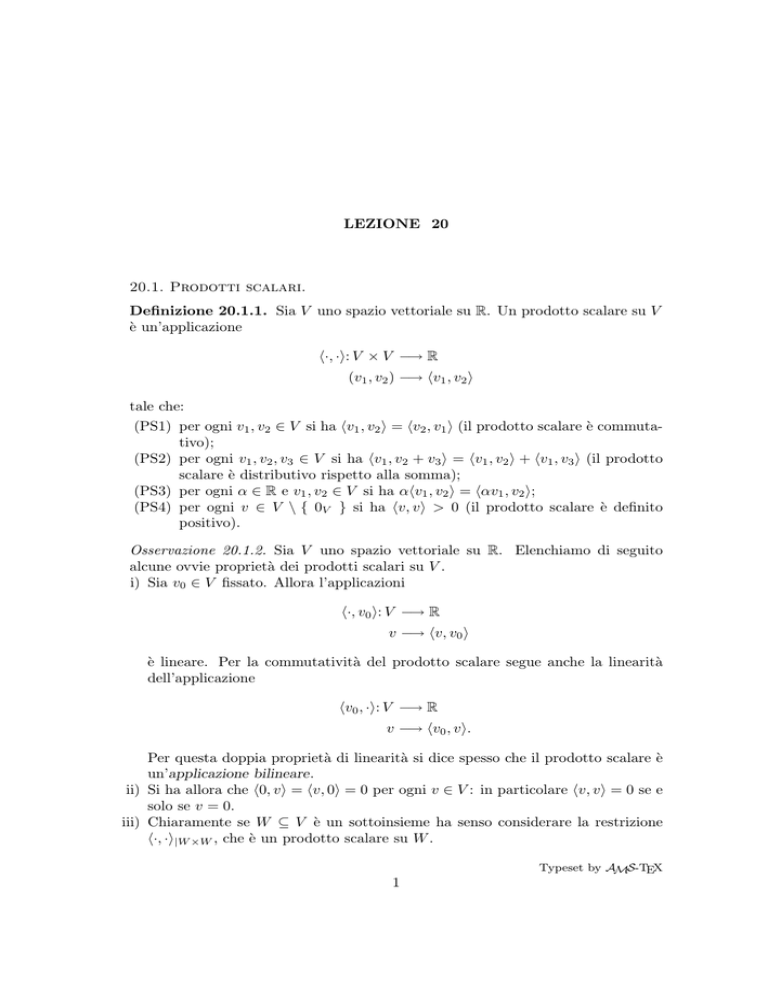

Definizione 20.1.1. Sia V uno spazio vettoriale su R. Un prodotto scalare su V

è un’applicazione

h·, ·i: V × V −→ R

(v1 , v2 ) −→ hv1 , v2 i

tale che:

(PS1) per ogni v1 , v2 ∈ V si ha hv1 , v2 i = hv2 , v1 i (il prodotto scalare è commutativo);

(PS2) per ogni v1 , v2 , v3 ∈ V si ha hv1 , v2 + v3 i = hv1 , v2 i + hv1 , v3 i (il prodotto

scalare è distributivo rispetto alla somma);

(PS3) per ogni α ∈ R e v1 , v2 ∈ V si ha αhv1 , v2 i = hαv1 , v2 i;

(PS4) per ogni v ∈ V \ { 0V } si ha hv, vi > 0 (il prodotto scalare è definito

positivo).

Osservazione 20.1.2. Sia V uno spazio vettoriale su R. Elenchiamo di seguito

alcune ovvie proprietà dei prodotti scalari su V .

i) Sia v0 ∈ V fissato. Allora l’applicazioni

h·, v0 i: V −→ R

v −→ hv, v0 i

è lineare. Per la commutatività del prodotto scalare segue anche la linearità

dell’applicazione

hv0 , ·i: V −→ R

v −→ hv0 , vi.

Per questa doppia proprietà di linearità si dice spesso che il prodotto scalare è

un’applicazione bilineare.

ii) Si ha allora che h0, vi = hv, 0i = 0 per ogni v ∈ V : in particolare hv, vi = 0 se e

solo se v = 0.

iii) Chiaramente se W ⊆ V è un sottoinsieme ha senso considerare la restrizione

h·, ·i|W ×W , che è un prodotto scalare su W .

Typeset by AMS-TEX

1

2

20.1. PRODOTTI SCALARI

Definizione 20.1.3. Sia V uno spazio vettoriale

su R munito di prodotto scalare

p

h·, ·i. Per ogni v ∈ V il numero |v| = hv, vi si dice modulo di v: i vettori di

modulo 1 si dicono versori.

Esempio 20.1.4. Nello spazio V3 (O) dei vettori applicati in O si può definire un

prodotto scalare in V3 (O) ponendo

h~v , wi

~ = |~v | |w|

~ cos(~vc

w)

~

(20.1.3.1)

per ogni coppia di vettori ~v , w

~ ∈ V3 (O) non nulli. Se O~ı~~k è un fissato sistema di

riferimento nello spazio e ~v = vx~ı + vy~ + vz~k , w = wx~ı + wy~ + wz~k , è noto che

h~v , wi

~ = vx w x + vy w y + vz w z .

Esempio 20.1.5. Sia V = Rn . Se x = (x1 , . . . , xn ) e y = (y1 , . . . , yn ) si definisce

prodotto scalare standard

hx, yi = x1 y1 + · · · + xn yn .

Si noti che in tal caso risulta

hx, yi = xt y = xIn t y

come prodotto di matrici. Il fatto che tale applicazione soddisfi le prorietà (PS1),

(PS2) e (PS3) è evidente dalla definizione. Per quanto riguarda la proprietà (PS4)

si noti che

hx, xi = x21 + · · · + x2n :

ma una somma di numeri reali non negativi, come lo sono i quadrati di numeri

reali, è non negativa ed è nulla se e solo se tutti gli addendi sono nulli.

Si noti che questo non è l’unico possibile prodotto scalare che possiamo definire

su Rn . Per esempio si verifichi che l’applicazione

((x1 , x2 ), (y1 , y2 )) 7→ 3x1 y1 + x2 y2 /2

è un prodotto scalare in R2 diverso dal prodotto standard. Si noti che

3

0

y1

3x1 y1 + x2 y2 /2 = ( x1 x2 )

.

0 1/4

y2

Sia V uno spazio vettoriale su R munito di prodotto scalare h·, ·i. Se v, w ∈

V \ { 0V }, per ogni t ∈ R si ha

|v|2 − 2thv, wi + t2 |w|2 = hv − tw, v − twi ≥ 0.

Il primo membro di tale trinomio non può avere radici distinte, dovendo altrimenti

cambiare di segno, quindi hv, wi2 − |v|2 |w|2 ≤ 0: essendo |v|, |w| > 0 segue allora

la cosiddetta disuguaglianza di Cauchy–Schwartz.

LEZIONE 20

3

Proposizione 20.1.6. Sia V uno spazio vettoriale su R munito di prodotto scalare

h·, ·i. Per ogni v, w ∈ V

(20.1.6.1)

|hv, wi| ≤ |v||w|

Inoltre vale l’uguaglianza in (20.1.6.1) se e solo se v e w sono proporzionali.

Dimostrazione. Rimane da dimostrare la seconda affermazione. Vale l’uguaglianza

in (20.1.6.1) se e solo se l’equazione |v|2 −2thv, wi+t2 |w|2 = 0 ha soluzione, ovvero

se e solo se hv − tw, v − twi = 0 ha soluzione, cioè se e solo se v = tw. Osservazione 20.1.7. Sia V uno spazio vettoriale su R munito di prodotto scalare

h·, ·i.

i) Se v, w ∈ V \ { 0V } allora

−1 ≤

hv, wi

≤1:

|v||w|

possiamo perciò definire l’angolo fra v e w come

hv, wi

.

vw

c = arccos

|v||w|

Si ha quindi hv, wi = |v||w| cos(vw)

c che generalizza la (20.1.6.1) a prodotti

scalari qualsiasi.

ii) Sempre da 20.1.5 ricaviamo la disuguaglianza triangolare:

|v + w|2 = hv + w, v + wi = |v|2 + hv, wi + hw, vi + |w|2 =

= |v|2 + 2hv, wi + |w|2 ≤ |v|2 + 2|hv, wi| + |w|2 ≤

≤ |v|2 + 2|v||w| + |w|2 = (|v| + |w|)2 ,

quindi |v + w| ≤ |v| + |w|. In modo analogo verificare che |v − w| ≥ ||v| − |w||.

Esempio 20.1.8. Sia I = [a, b] ⊆ R non vuoto e si consideri nello spazio C 0 (I)

l’applicazione

Z b

hf, gi =

f (x)g(x)dx.

a

Che le proprietà di prodotto scalare (PS1), (PS2), (PS3) siano soddisfatte è ovvio.

Inoltre il teorema della permanenza del segno per funzioni continue ci assicura che

anche la condizione (PS4) è soddisfatta.

In questo caso la disuguaglianza di Cauchy–Schwartz diviene

s

Z

sZ

Z b

b

b

2

f (x)g(x)dx ≤

f (x) dx

g(x)2 dx.

a

a

a

4

20.2. BASI ORTONORMALI

Per ogni f ∈ C 0 (I) la quantità

s

Z

b

|f |2 =

f (x)2 dx

a

viene detta norma L2 di f .

20.2. Basi ortonormali.

Definizione 20.2.1. Sia V uno spazio vettoriale su R munito di prodotto scalare

h·, ·i. I vettori v1 , v2 ∈ V si dicono ortogonali (o perpendicolari) se hv1 , v2 i = 0 ed

in tal caso si scrive v1 ⊥ v2 .

L’insieme { v1 , . . . , vn } ⊆ V si dice ortogonale se vi ⊥ vj per i, j ∈ I con i 6= j.

L’insieme { v1 , . . . , vn } ⊆ V si dice ortonormale se è ortogonale ed i vi sono

versori.

Se V è finitamente generato, una base ortonormale B = (v1 , . . . , vn ) è una base

di V tale che l’insieme { v1 , . . . , vn } sia ortonormale.

In base alla definizione concludiamo che l’insieme { v1 , . . . , vn } ⊆ V è ortonormale se per ogni i, j = 1, . . . , n

hvi , vj i = δi,j =

1

i = j,

0

i 6= j.

Esempio 20.2.2. Si fissi un sistema di riferimento O~ı~~k nello spazio. Allora

l’insieme { ~ı , ~ , ~k } è ortonormale in V3 (O) rispetto al prodotto scalare geometrico

(si veda l’Esempio 20.1.4). Si noti che B = (~ı , ~ , ~k ) viene quindi ad essere una

base ortonormale di V3 (O).

Esempio 20.2.3. Si consideri lo spazio Rn munito del prodotto scalare h·, ·i

definito nell’Esempio 20.1.5. Allora i vettori della base canonica formano un

insieme { e1 , . . . , en } ortonormale: perciò la base canonica C = (e1 , . . . , en ) è

una base ortonormale.

Invece { e1 , e2 } non è ortonormale rispetto al prodotto scalare

((x1 , x2 ), (y1 , y2 )) 7→ 3x1 y1 + x2 y2 /2

√

introdotto

nello

stesso

esempio.

Infatti

è

vero

che

e

⊥

e

ma

|e

|

=

1

2

1

√

√ √ 3 e

|e2 | = 1/ 2. Concludiamo che, rispetto a tale prodotto scalare, { e1 / 3, 2e2 }

è ortonormale.

LEZIONE 20

5

Esempio 20.2.4. Si consideri lo spazio V delle funzioni continue e periodiche di

periodo 2π. Per esempio 1, cos px, sin px ∈ V per ogni p ∈ N (si noti che sin px e

cos px hanno periodo minimo 2π/p). In V definiamo

1

hf, gi =

π

Z

π

f (x)g(x)dx :

−π

è facile verificare che h·, ·i è un prodotto scalare. Inoltre dall’analisi è noto che

√

√

h1/ 2, 1/ 2i = 1

1 se p = q 6= 0,

hcos px, cos qxi =

0 se p 6= q,

hsin px, cos qxi = 0

1 se p = q 6= 0,

hsin px, sin qxi =

0 se p 6= q,

√

quindi, per ogni N ∈ N, l’insieme { 1/ 2, cos px, sin qx }p,q=1,...,N è ortonormale.

Abbiamo visto che in tutti gli esempi trattati è sempre possibile determinare

una base ortonormale. Di fatto questo è un risultato generale che si può dimostrare

in modo algoritmico con il metodo di ortonormalizzazione di Gram–Schmidt. Ci

limiteremo ad enunciare il seguente risultato.

Proposizione 20.2.5. Sia V 6= { 0V } uno spazio vettoriale finitamente generato

su R munito di prodotto scalare h·, ·i. Allora esistono in V basi ortonormali. L’importanza ed utilità delle basi ortonormali è data dalla seguente

Proposizione 20.2.6. Sia V uno spazio vettoriale su R munito di prodotto scalare

h·, ·i. Sia { v1 , . . . , vn } ⊆ V è un insieme ortonormale. Allora:

i) v1 , . . . , vn sono linearmente indipendenti;

ii) se V è finitamente generato e dimR (V ) = n, allora B = (v1 . . . , vn ) è una base

ortonormale di V e si ha v = hv, v1 iv1 + · · · + hv, vn ivn per ogni v ∈ V .

Dimostrazione. Per definizione { v1 , . . . , vn } ⊆ V è un insieme di vettori ortonormali se e solo se

0 se i 6= j,

hvi , vj i =

1 se i = j,

quindi, se α1 v1 + · · · + αn vn = 0 è una relazione di dipendenza lineare, si ha

0 = h0, vj i = hα1 v1 + · · · + αn vn , vj i = α1 hv1 , vj i + · · · + αn hvn , vj i = αj .

In particolare v1 , . . . , vn sono linearmente indipendenti.

Se V è finitamente generato e dimR (V ) = n, per la Proposizione 14.1.7, segue

che B è una base di V .

6

20.2. BASI ORTONORMALI

In particolare per ogni v ∈ V esistono α1 , . . . , αn ∈ R tali che v = α1 v1 + · · · +

αn vn . Quindi

hv, vj i = hα1 v1 + · · · + αn vn , vj i = α1 hv1 , vj i + · · · + αn hvn , vj i = αj

per ogni j = 1, . . . , n. Il coefficiente hv, vj i viene spesso detto coefficiente di Fourier (di v rispetto a

vj ).

Esempio 20.2.7. Si consideri lo spazio R3 munito del prodotto scalare h·, ·i

definito nell’Esempio 20.1.5. I tre vettori v1 = 1/3(2, 2, 1), v2 = 1/3(1, −2, 2)

e v3 = 1/3(−2, 1, 2) formano un insieme { v1 , v2 , v3 } ortonormale, quindi B =

(v1 , v2 , v3 ) è una base di R3 .

Sia v = (1, 1, 1) ∈ R3 . Allora hv, v1 i = 5/3, hv, v2 i = hv, v3 i = 1/3: quindi,

come è anche facile verificare direttamente, risulta

v=

1

1

5

v 1 + v2 + v3 .

3

3

3

20.3. Matrici ortogonali.

Facciamo una breve digressione su un’importante famiglia di matrici, quelle

ortogonali.

Definizione 20.3.1. P ∈ Rn,n si dice ortogonale se t P P = In .

Prima di dare esempi di matrici ortogonali, facciamo alcune osservazioni.

Osservazione 20.3.2. Si noti che la matrice identità In è ortogonale in base alla

definizione data: anche ogni matrice ottenuta da In cambiando segno ad una o più

delle sue entrate è ortogonale.

Sia P ∈ Rn,n ortogonale.

i) Poiché t P P = In , segue che P è invertibile e P −1 = t P : in particolare si ha

anche P t P = In . In maniera analoga si dimostra che se P t P = In allora anche

t

P P = In , cioè P è ortogonale se e solo se P t P = In .

ii) Si ha 1 = det(In ) = det(t P P ) = det(t P ) det(P ) = det(P )2 , dunque det(P ) =

±1: quanto sopra osservato sulla matrice identità ci permette di affermare che

esistono matrici di entrambe i tipi.

iii) Poiché la riga i–esima di t P è la colonna i–esima Pi di P , la condizione t P P = In

si può leggere dicendo che il prodotto scalare standard (si veda l’Esempio 20.1.5

con la solita identificazione di Rn con Rn,1 ) delle colonne Pi e Pj di P è δi,j : in

altre parole una matrice è ortogonale se e solo se le sue colonne sono un insieme

ortonormale, rispetto al prodotto scalare standard, di n vettori di Rn,1 .

iv) In maniera simile, poiché anche P t P = In , anche le righe di P formano un

insieme ortonormale, rispetto al prodotto scalare standard, di n vettori di R1,n .

LEZIONE 20

7

Le matrici ortogonali si dividono, quindi, in due classi non vuote, quelle con

determinante 1 e quelle con determinante −1. Ha senso dare un nome a questi

due tipi di matrici.

Definizione 20.3.3. Sia P ∈ Rn,n ortogonale. P si dice speciale se det(P ) = 1

non speciale det(P ) = −1.

Grazie a quanto osservato sopra, siamo perciò in grado di dare esempi non

banali di matrici ortogonali.

Esempio 20.3.4. Le matrici di R3,3

1 2

2

1

P1 = 2 1 −2 ,

3

2 −2 1

1

1

P2 = 2

3

−2

2 2

1 −2 ,

2 −1

sono ortogonali. La prima è non speciale, la seconda speciale.

Esempio 20.3.5. Determiniamo tutte le matrici ortogonali d’ordine 2. Sia

p1,1 p1,2

P =

∈ R2,2

p2,1 p2,2

ortogonale. La condizione P t P = I2 si traduce allora nel sistema

2

2

p1,1 + p1,2 = 1

p1,1 p2,1 + p1,2 p2,2 = 0

2

p2,1 + p22,2 = 1.

La prima e la terza equazione implicano l’esistenza di ϑ, ϕ ∈ [0, 2π] tali che p1,1 =

cos ϑ, p1,2 = − sin ϑ, p2,1 = sin ϕ, p2,2 = cos ϕ. La seconda equazione è allora

equivalente a

0 = cos ϑ sin ϕ − sin ϑ cos ϕ = sin(ϕ − ϑ).

In particolare, a meno di multipli di 2π, si deve avere o ϕ = ϑ ovvero ϕ = ϑ + π.

Nel primo caso

cos ϑ − sin ϑ

P =

,

sin ϑ cos ϑ

(in tal caso P è ortogonale speciale) nel secondo

cos ϑ − sin ϑ

P =

− sin ϑ − cos ϑ

(in tal caso P è ortogonale non speciale).

Ricordiamo un’interpretazione geometrica delle matrici ortogonali speciali già

vista all’inizio del corso. Consideriamo nel piano due sistemi di riferimento O~ı~ ,

8

20.3. MATRICI ORTOGONALI

O~ı 0~ 0 e sia ψ l’angolo misurato in senso antiorario fra i versori ~ı e ~ı 0 . Allora si

deve avere ~ı 0 = a~ı + b~ , ~ 0 = c~ı + d~ e si ha, per la Proposizione 20.2.6 ii),

a = h~ı 0 ,~ı i = cos ψ,

c = h~ 0 ,~ı i = − sin ψ,

b = h~ı 0 , ~ i = sin ψ,

d = h~ 0 , ~ i = cos ψ.

Se ora considero ~v = x0~ı 0 + y 0~ 0 = x~ı + y~ , sostituendo le espressioni ottenute

sopra di ~ı 0 e ~ 0 in funzione di ~ı e ~ , tenendo conto che (~ı , ~ ) è una base di V2 (O),

si ottiene

0 x

cos ψ

sin ψ

x

=

.

0

y

− sin ψ cos ψ

y

Concludiamo che le matrici ortogonali speciali corrispondono alle rotazioni nel

piano. Per questo spesso indichiamo con Rψ la matrice

cos ψ

− sin ψ

sin ψ

cos ψ

.

Un’analoga interpretazione può essere data per matrici ortogonali in Rn,n con

n ≥ 3.