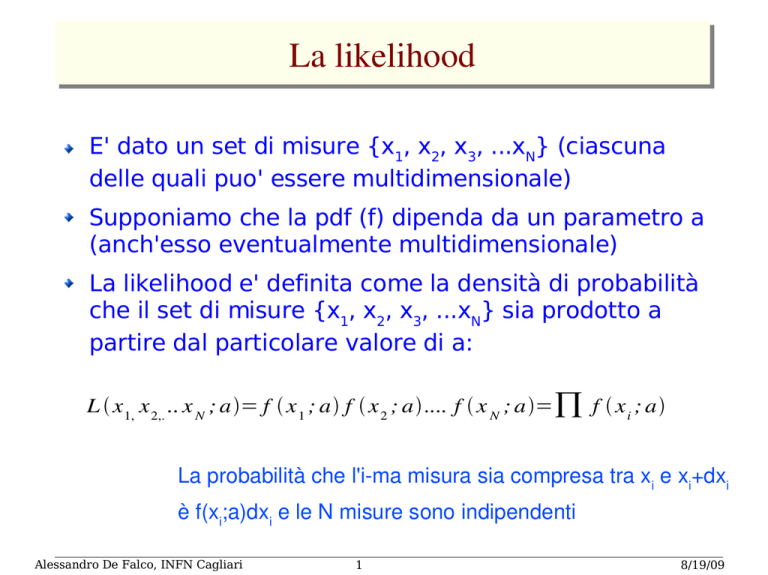

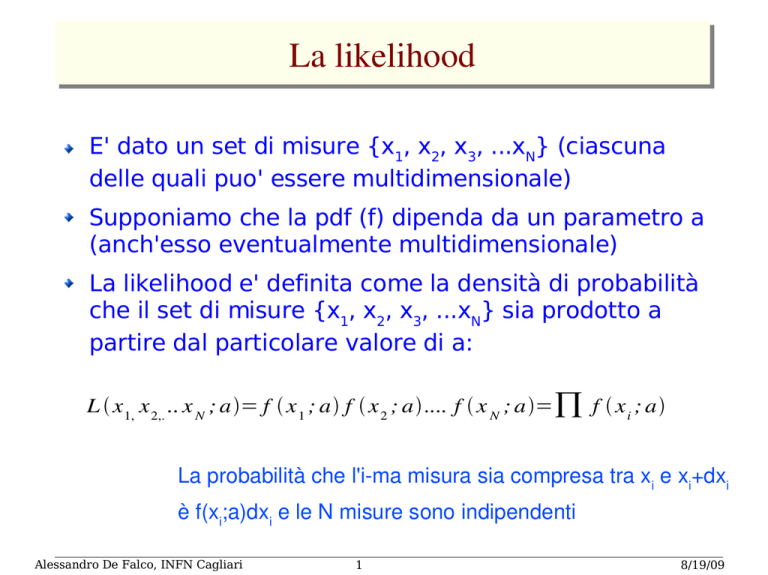

La likelihood

E' dato un set di misure {x1, x2, x3, ...xN} (ciascuna

delle quali puo' essere multidimensionale)

Supponiamo che la pdf (f) dipenda da un parametro a

(anch'esso eventualmente multidimensionale)

La likelihood e' definita come la densità di probabilità

che il set di misure {x1, x2, x3, ...xN} sia prodotto a

partire dal particolare valore di a:

L x1, x 2,. .. x N ; a= f x 1 ; a f x 2 ; a.... f x N ; a=∏ f x i ; a

La probabilità che l'i­ma misura sia compresa tra xi e xi+dxi è f(xi;a)dxi e le N misure sono indipendenti

Alessandro De Falco, INFN Cagliari

1

8/19/09

Il criterio della massima likelihood

Dati {x1, x2, x3, ...xN}, si puo' stimare il parametro a

che caratterizza la pdf f(xi;a) massimizzando la

likelihood rispetto ad a

ln L

Normalmente e' preferibile

calcolare il logaritmo della

likelihood, per poter trattare

somme anziche' prodotti

a

Nota: non è necessario eseguire un binning dei dati:

usiamo tutta l'informazione.

Alessandro De Falco, INFN Cagliari

2

a

8/19/09

Proprieta' della massima likelihood

E' consistente

E' affetta da bias per piccoli N. L'effetto diventa

trascurabile a grandi N

E' efficiente per grandi N

E' invariante: se si usa u(a) al posto di a e si stima u

mediante la maximum likelihood, si ottiene

u=u

a

ln L

ln L

a

Alessandro De Falco, INFN Cagliari

u

3

8/19/09

Altre considerazioni sulla ML

Spesso sono richiesti metodi numerici

La massimizzazione (o la minimizzazione, se si

considera -ln L) in piu' di una variabile non e'

facile

La likelihood fornisce solo il parametro piu'

corretto ma non da' alcuna informazione sulla

qualita' del fit.

Il valore di L non fornisce alcuna informazione

Alessandro De Falco, INFN Cagliari

4

8/19/09

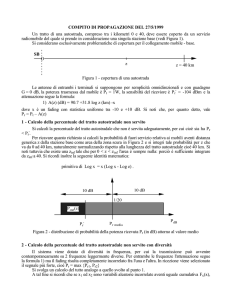

Esempio: distribuzione esponenziale

Abbiamo un campione di dati t1, t2,...,tn che segue la

pdf

1 −t /

f t ; = e

con da determinare. Calcolo la likelihood e la

massimizzo rispetto a

n

log L =∑ log f t i ; =∑

∂ log L

1 ti

log −

i=1

i

=0

=

∂

1

n

∑ ti

i

La stima con la massima likelihood del parametro

libero corrisponde alla media aritmetica dei dati

osservati.

Lo stimatore non ha bias: infatti la media aritmetica è

uno stimatore senza bias per E[t], e per la

distribuzione esponenziale E[t]=

Alessandro De Falco, INFN Cagliari

5

8/19/09

Possiamo chiederci quale è la stima con la ML per la

funzione:

1

=

− t

f t ; = e

Per una funzione a() del parametro non ha importanza

esprimere L in termini di della funzione o del parametro. La a

che massimizza La(a) è

dove massimizza L)

a

Dunque, per l'esponenziale:

1

1

=

= ∑ ti

n i

−1

ha un bias. Si può dimostrare che:

E [ ]=

n

n−1

Asintoticamente il bias

tende a zero

In generale è vero che una funzione non lineare di uno

stimatore senza bias è uno stimatore con bias del parametro

Alessandro De Falco, INFN Cagliari

6

8/19/09

Stima di di una gaussiana con la ML

1

2

f x ; , =

2

2

log L , =∑ log f =∑ log

i

∂ log L

=0

∂

∂ log L

∂

2

=0

i

=

1

n

exp −

2

1

2

∑ xi

2

2

log

2

1

2

2

−

1 x i −

2

2

Si dimostra che la stima non ha bias

i

2

2 = 1

∑ xi −

n i

2 ]= n−1 2

E[

n

Alessandro De Falco, INFN Cagliari

1

1 x−2

7

La stima ha bias che tende a

zero per n che tende all'infinito

8/19/09

Varianza dello stimatore con la ML

Vogliamo determinare l'incertezza statistica sul parametro

stimato:

che risultato avremmo ottenuto ripetendo molte volte lo

stesso esperimento con lo stesso numero n di misure?

Nel caso della distribuzione esponenziale:

2

2

V [ ]=

E [ ]− E [ ]

2

1

1

t

exp−t

/

.....

∑ i

1

exp−t n /

∑

=∫ ...∫ dt 1. .. dt n

− ∫ ... ∫ dt 1. .. dt n

1

n

n

1

n

i=1

n

i=1

2

2

1

1

t i exp −t 1 / ..... exp −t n / =

n

(La varianza dipende dal parametro , mentre noi abbiamo

u possiamo sostituire con la

la sua stima Poichè u =

sua stima)

Alessandro De Falco, INFN Cagliari

8

8/19/09

Varianza dello stimatore con la ML: metodo Monte Carlo

Per casi difficilmente risolvibili per via analitica, si può

utilizzare il MC:

Supponiamo la pdf nota, fissando il valore del parametro

secondo la misura ottenuta dall'esperimento

Simuliamo N esperimenti (N>>1)

Per ciascuno degli esperimenti, calcoliamo la stima del

parametro con la ML

Dalla distribuzione del parametro così ottenuta ricaviamo la

RMS

Esercizio: partiamo da una distribuzione esponenziale con τ=1 e 100 misure; costruiamo il campione dei dati 'veri' (anche questo con una simulazione) e

stimiamo il parametro Mettiamo i risultati su un istogramma. Calcoliamo dunque l'errore sulla stima del parametro ricostruendo 1000 campioni da 100 misure ciascuno e calcolandone la RMS. Che forma ha la distribuzione?

Alessandro De Falco, INFN Cagliari

9

8/19/09

Varianza dello stimatore con la ML: metodo grafico

Supponiamo che L=L(θ) e calcoliamo lo sviluppo in serie:

[

log L =log L

∂ log L

∂

]

−

=

=0 perchè in la likelihood è max per definizione

1

2

log L =log L max −

−

2

2

2

1 ∂ log L

2

[

∂

[

2 =

ovvero:

La variazione del parametro pari a una

deviazione standard a partire dal valore

stimato comporta una riduzione di log(L)

pari a ½ rispetto al valore massimo

2

]

2 ...

−

=

−1

2

2

⟨d log L / d ⟩

]

=

log L ±

=log L max −

1

2

Possiamo così definire l'errore statistico sul

parametro, che possiamo ricavare da un

grafico di log(L) come mostrato in figura

Alessandro De Falco, INFN Cagliari

10

8/19/09

Maximum likelihood con dati binnati

N

n = n1, n 2,. ... , n N n =∑ n

Spesso i dati vengono messi in un istogramma

tot

i

x i max

con v. di aspettazione i =n tot

∫

x i min

f x ; dx

=1, 2,. ... , N

i=1

N

tot =∑ i

i=1

L'istogramma è una misura di un vettore di dimensione N, la cui pdf

congiunta sarà multinomiale:

f

N

joint

n ,

=ntot ! ∏

Al limite

k=1

N ∞

1

k

nk

n k ! ntot

N

log L =∑ n i logi

Trascuro i termini che non dipendono dai parametri

i=1

(o xi(max)-xi(min)-> 0) ci si riporta al caso senza binning

Il metodo è applicabile quando nk=0 (diversamente dai minimi quadrati,

che tratteremo in seguito)

Alessandro De Falco, INFN Cagliari

11

8/19/09

Stima con la ML: in sintesi

Aspetti positivi della stima con la ML:

per N abbastanza grande:

✔

✔

E' senza bias (una stima consistente è asintoticamente priva di

bias)

E' efficiente: la varianza si approssima al MVB

Può essere usata senza binning (che comporta perdita di

informazione)

Può essere usata per stimare più parametri

Permette di calcolare facilmente l'errore sui parametri

Limiti:

Per N piccolo, solitamente presenta un bias

E' necessario conoscere la forma della pdf

✔

Non fornisce informazioni sulla bontà del fit

Spesso è necessario stimare i parametri con un calcolo numerico

Alessandro De Falco, INFN Cagliari

12

8/19/09