CORSO DI LAUREA IN ECONOMIA AZIENDALE

Metodi Statistici per l’impresa (Note didattiche)

Bruno Chiandotto – Fabrizio Cipollini

Capitolo 2

CALCOLO DELLE PROBABILITÀ

Il calcolo delle probabilità, nato nel contesto dei giochi d’azzardo si è sviluppato

teoricamente fino ad assumere un ruolo particolarmente rilevante nell’analisi dei

fenomeni collettivi, diventando presupposto essenziale della teoria della statistica. La

teoria delle probabilità è una disciplina matematica astratta e altamente formalizzata pur

conservando il suo originale e rilevante contenuto empirico; in questa esposizione ci

limiteremo a esporre gli aspetti essenziali per la comprensione degli argomenti trattati

nel seguito.

1. Esperimento casuale, spazio campionario, eventi

Definizione 1: Definizione di esperimento casuale. Si dice esperimento casuale,

ogni fenomeno il cui risultato non può essere previsto con certezza.

Si evidenzia che il termine esperimento va qui inteso in senso lato. Infatti comprende

giochi di sorte (come il lancio di una moneta, l’estrazione di un numero al lotto,

l’estrazione di una numero alla roulette), esperimenti di laboratorio (come il test di

durata di un pneumatico, la somministrazione di un principio attivo ad un insieme di

cavie o il numero massimo di battiti cardiaci di un paziente durante un test di sforzo),

misurazioni fisiche (come la temperatura minima di domani in una certa stazione

meteorologica o l’intensità di una certa scossa di terremoto) fenomeni economici e

sociali (come il numero di computer prodotti da un’impresa del settore, il PIL italiano

fra 5 anni, il numero di imprese che falliranno in Inghilterra nel prossimo anno o il ROE

di un impresa nel prossimo esercizio) e più in generale tutte le prove, operazioni,

attività o fenomeni il cui esito non è prevedibile con certezza.

1

B. Chiandotto - F. Cipollini

Versione 2003 - Cap. 2

Metodi Statistici per l’impresa

Definizione 2: Definizione di spazio campionario. Dato un esperimento casuale, si

dice spazio campionario l'insieme Ω di tutti i possibili risultati,

esaustivi e mutualmente esclusivi, dell'esperimento stesso. Tali possibili

risultati sono detti punti campionari.

Alcuni esempi

Se l'esperimento casuale consiste nel lancio di una MONETA a due facce, lo spazio

campionario è dato da

Ω = {T, C}

dove T è il punto campionario testa e C è il punto campionario croce.

In questo esempio si è assunto (come si fa di solito) che gli unici risultati possibili siano

T e C, e che quindi la moneta non possa rimanere in equilibrio sul bordo. Se invece si

ipotizza che anche questo risultato sia possibile, allora lo spazio campionario di questo

esperimento casuale è

Ω = {T, C, B},

dove B è il punto campionario “moneta in equilibrio sul bordo”.

Una situazione analoga al lancio della moneta si ha nel caso in cui l'esperimento casuale

sia l’esito di una operazione di finanziamento di una banca ad una impresa cliente, i cui

risultati possibili sono la restituzione o meno del finanziamento concesso da parte

dell’impresa. In tal caso infatti lo spazio campionario Ω è dato da

Ω = {R, NR},

dove R è il punto campionario finanziamento restituito e NR il punto campionario

finanziamento non restituito.

Se l'esperimento casuale consiste nell'estrazione di un numero al lotto, lo spazio

campionario è dato da

Ω = {1, 2, …, 90},

costituito, come è ovvio, da tutti i numeri interi da 1 a 90.

Analogamente se l'esperimento casuale consiste nell'estrazione di un numero alla

roulette, lo spazio campionario è dato da

Ω = {0, 1, 2, …, 36}.

Se l'esperimento casuale consiste nel contare il numero di difetti (ad esempio dei nodi)

in una matassa di filato da 100 metri, lo spazio campionario è dato da

2

B. Chiandotto - F. Cipollini

Versione 2003 - Cap. 2

Metodi Statistici per l’impresa

Ω = {0, 1, 2, …}.

cioè da tutti i numeri interi non negativi, dato che il numero di difetti è un numero intero

e non è possibile stabilire a priori il numero massimo.

Una situazione analoga si ha se l’esperimento casuale consiste nel contare il numero di

accessi ad un certo sito internet nell’arco di un anno oppure nel contare il numero

massimo di battiti cardiaci durante un test di sforzo.

Se l'esperimento casuale consiste nel test di durata di un pneumatico, lo spazio

campionario è costituito da

Ω = [0, +∞),

cioè tutti i numeri reali non negativi, dato che la durata è un numero che non può essere

negativo. Una considerazione analoga vale per l’intensità di una scossa di terremoto,

dato che questa, se misurata si scala RICHTER, sarà un numero non negativo (0 se non

c’è stata nessuna scossa).

Se l'esperimento casuale consiste nel valutare il ROE di un’impresa nel prossimo

esercizio, lo spazio campionario è costituito da

Ω = (–∞, +∞)

dato che il ROE di un’impresa può essere un qualsiasi numero reale.

Se l'esperimento casuale consiste nel misurare la temperatura (in gradi centigradi) in

una certa stazione meteorologica, lo spazio campionario è costituito da

Ω = [–273, +∞),

dato che secondo la fisica la temperatura non può scendere sotto lo 0 assoluto (circa –

273 °C).

Riepilogando, allora, lo spazio campionario è l’insieme dei risultati possibili

dell’esperimento campionario considerato.

Dagli esempi riportati possiamo notare che lo spazio campionario può essere costituito

da un numero finito di punti campionari (come nel caso del lancio della moneta, dei

pezzi buoni/difettosi, delle palline estratte da un’urna o dell’estrazione alla roulette),

oppure da un’infinità numerabile di punti campionari (come nel caso del numero di

computer prodotti, del numero di accessi ad un sito internet o del numero di battiti

cardiaci), o infine da un’infinità non numerabile di punti campionari (come nel caso

del test di durata di un pneumatico, del PIL italiano fra 5 anni, della temperatura di un

luogo o del ROE di un’impresa).

3

B. Chiandotto - F. Cipollini

Versione 2003 - Cap. 2

Metodi Statistici per l’impresa

Definizione 3: Definizione di evento. Dato uno spazio campionario Ω relativo ad un

certo esperimento casuale, un evento è sempre un sottoinsieme di Ω.

Tuttavia:

•

se Ω è costituito da un numero finito o da un’infinità numerabile di

punti campionari, è evento ogni sottoinsieme A di Ω;

•

se invece Ω è costituito da un’infinità non numerabile di punti, non

tutti i possibili sottoinsiemi di Ω sono eventi ma soltanto i cosiddetti

sottoinsiemi ammissibili di Ω.

In ogni caso, comunque, un evento è un sottoinsieme di Ω ed è quindi costituito da un

insieme di punti campionari. Precisiamo inoltre che nel caso in cui Ω sia costituito da

un’infinità non numerabile di punti, i sottoinsiemi non ammissibili sono piuttosto

artificiosi da costruire: i sottoinsiemi ai quali si è comunemente interessati (vedremo poi

alcuni esempi) sono tutti ammissibili.

Definizione 4: Verificarsi di un evento. Dato uno spazio campionario Ω relativo ad

un certo esperimento casuale, l’evento A si verifica (si realizza) solo se

il risultato dell’esperimento casuale è un qualsiasi punto campionario di

A; in caso contrario A non si verifica.

Le due definizioni precedenti ci consentono di precisare che sono eventi anche:

•

Ω stesso, che contenendo tutti i punti campionari deve per forza verificarsi ed è

quindi detto evento certo (importante: in generale tutti gli eventi certi possono

essere indicati con Ω).

•

tutti gli eventi del tipo {ω}, cioè costituiti da un solo punto campionario ω, che

come tali sono detti eventi elementari;

•

ø, che non contenendo alcun punto campionario non si potrà mai realizzare e che è

quindi detto evento impossibile (importante: in generale tutti gli eventi impossibili

possono essere indicati con ø).

4

B. Chiandotto - F. Cipollini

Versione 2003 - Cap. 2

Metodi Statistici per l’impresa

Alcuni esempi

Se l'esperimento casuale consiste nel lancio di una moneta a due facce, sono eventi:

{T}, {C}, Ω = {T, C}, ø. Questi sono anche gli unici eventi che possono essere definiti

nell’esperimento casuale indicato. {T} e {C} sono eventi elementari in quanto costituiti

da un solo punto campionario; Ω è l’evento certo (infatti è certo che dal lancio venga T

o C); gli eventi {BABBO} oppure {CANE, GATTO} sono impossibili e possono essere

rappresentati, come tutti gli eventi impossibili, col simbolo ø. In questo esperimento

casuale implicitamente abbiamo escluso che la moneta possa rimanere in equilibrio sul

bordo. Quindi anche l’evento {B} è impossibile e può essere indicato con ø.

Se invece nell’esperimento della moneta a due facce è possibile che la moneta rimanga

in equilibrio sul bordo allora sono eventi: {T}, {C}, {B}, {T, C}, {T, B}, {C, B}, Ω =

{T, C, B}, ø; questi sono anche gli unici eventi che possono essere definiti in questo

esperimento casuale. {T}, {C} e {B} sono eventi elementari, mentre {T, C} non è più

l’evento certo (infatti non è certo che venga T o C, dato che è possibile che la moneta

rimanga sul B); {B} non è più impossibile mentre rimangono impossibili (e quindi

identificabili con col simbolo ø) gli eventi {BABBO} e {CANE, GATTO}. Se nel lancio

viene B allora si realizzano tutti gli eventi che contengono B ({B}, {C, B}, {T, B} ed

ovviamente Ω), mentre non si realizzano tutti quelli che non lo contengono ({C}, {T},

{T, C} ed ovviamente ø).

Una situazione simile a quella del lancio della moneta si ha nel caso in cui l'esperimento

casuale sia l’esito di una operazione di finanziamento di una banca ad una impresa

cliente. [Lo studente provi per conto proprio a scrivere gli eventi che possono essere

costruiti in questo caso, indicando quali sono quelli che si verificano se l’esito è NR]

Se l'esperimento casuale consiste nell'estrazione di un numero al lotto, costruire l’elenco

di tutti gli eventi possibili è un’operazione lunghissima (e anche inutile!). Siccome lo

spazio campionario contiene un numero finito di punti campionari tutti i sottoinsiemi

possibili di Ω sono eventi, ivi compresi Ω stesso e ø. Ad esempio {33}, {99}, { 10 },

{55, 58}, {–3, 2.5} {99, 5}, {numeri pari}, {numeri divisibili per 10}, {numeri reali},

sono tutti eventi. Fra questi {99}, { 10 } e {–3, 2.5} sono impossibili e possono essere

indicati con ø; gli altri sono invece possibili (ivi compreso {99, 5}: se infatti viene fuori

il 5 questo evento si realizza); {numeri reali} è certo e può essere indicato con Ω. Se

viene estratto il 30 allora si verificano tutti gli eventi che contengono il 30 (ad esempio

5

B. Chiandotto - F. Cipollini

Versione 2003 - Cap. 2

Metodi Statistici per l’impresa

si verificano {numeri pari}, {numeri divisibili per 10}, {30, 60, 90} e, naturalmente, Ω)

mentre non si verificano quelli che non lo contengono (ad esempio non si verificano

{dispari}, {numeri divisibili per 7}, {11, 22, 33} e, naturalmente, ø).

Se l'esperimento casuale consiste nel contare il numero di difetti in una matassa di filato

da 100 metri, costruire l’elenco di tutti gli eventi possibili è un’operazione impossibile,

dato che Ω contiene una infinità numerabile di punti campionari. Anche in questo caso,

comunque, tutti i sottoinsiemi di Ω sono eventi. Ad esempio sono eventi possibili {0},

{33}, {99}, {55, 58}, {99, 5}, {numeri pari}, {numeri divisibili per 10}; {numeri

reali}, {numeri non negativi} coincidono con l’evento certo Ω; sono invece impossibili

{ 10 }, {–8}, {–3, 2.5}, {numeri negativi} che possono essere quindi indicati con ø.

Se l'esperimento casuale consiste nel test di durata di un pneumatico, allora non tutti i

sottoinsiemi di Ω sono eventi ma soltanto quelli ammissibili; tuttavia, come indicato,

quelli ai quali si è comunemente interessati sono tutti ammissibili. Sono allora eventi

possibili {0}, {33}, { 10 }, {3/4, 58}, [3,9), (–∞, 5), {numeri divisibili per 10};

{numeri reali}, {numeri non negativi} coincidono con l’evento certo Ω; sono invece

impossibili {–55}, [–2,–1] che possono essere quindi indicati con ø.

[Lo studente provi per conto proprio a sviluppare in modo analogo ai precedenti altri

esempi di esperimenti casuali]

E’ chiaro che poiché lo spazio campionario Ω contiene solo i risultati possibili, e poiché

gli eventi sono sottoinsiemi di Ω, è conveniente “ripulire” gli eventi dai punti

campionari impossibili quando li contengono. Per definizione tutti i risultati possibili

devono essere inclusi; tutto il resto è impossibile.

Relativamente agli esperimenti casuali più semplici non s'incontrano, usualmente,

difficoltà nell'individuazione e nella successiva enumerazione dei punti campionari che

ne costituiscono i possibili risultati. In esperimenti più complessi possono risultare di

aiuto alcune formule combinatorie (richiamate in appendice al capitolo) che facilitano

tale operazione. L’utilità di tale enumerazione sarà più chiara quando si parlerà di

probabilità.

6

B. Chiandotto - F. Cipollini

Versione 2003 - Cap. 2

Metodi Statistici per l’impresa

Riepilogando, lo spazio campionario Ω è l’insieme dei risultati possibili

dell’esperimento campionario considerato, mentre un evento è sempre un sottoinsieme

di Ω.

Spesso è utile operare sugli eventi, combinandoli fra di loro in modo opportuno, per

crearne di nuovi a seconda dell’interesse di chi studia il fenomeno (esperimento

casuale) considerato. D’altra parte poiché come detto gli eventi sono in tutto per tutto

degli insiemi è inutile inventare un modo nuovo per operare sugli eventi: conviene

prendere a prestito dalla matematica gli strumenti della teoria degli insiemi. In questo

ambito l'evento certo Ω (coincidente con l'intero spazio campionario) non rappresenta

altro che l'insieme universale, mentre l'evento impossibile ø corrisponde all'insieme

vuoto. Nelle pagine che seguono si richiamano gli aspetti fondamentali della teoria

degli insiemi che risultano utili per operare sugli eventi.

Le relazioni/operazioni della teoria degli insiemi che risultano di particolare interesse

per operare sugli eventi sono la relazione di inclusione (⊆) e le operazioni di negazione

(o complementazione) A , di intersezione (∩), di unione (∪), e di differenza (–). Per

comprendere e mettere in pratica queste relazioni ed operazioni sono utili i cosiddetti

diagrammi di Venn.

Relazione di inclusione. Un evento A è incluso nell'evento B, e si scrive A ⊆ B, se ogni

punto campionario di A appartiene anche a B (non è detto che valga il viceversa).

Relazione di uguaglianza. Due eventi A e B sono uguali sse contengono gli stessi punti

campionari, ovvero sse contemporaneamente

A ⊆ Be B ⊆ A

Operazione di negazione. La negazione (complementazione nella teoria degli insiemi)

di un evento A è l’evento A costituito da tutti i punti campionari di Ω che non

appartengono ad A.

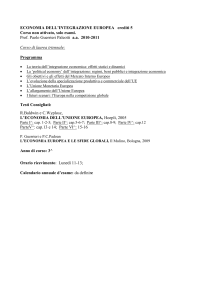

Il seguente diagramma di Venn illustra graficamente il concetto di evento incluso e di

evento negato.

7

B. Chiandotto - F. Cipollini

Versione 2003 - Cap. 2

Metodi Statistici per l’impresa

Ω

A

B

B

Fig. 1 - Diagramma di Venn per l’inclusione e la negazione dove il quadrato

rappresenta l’intero spazio campionario Ω e A ⊆ B.

Operazione di intersezione. L'intersezione tra due eventi A e B è l'evento E1 = A ∩ B

costituito da tutti i punti campionari che appartengono sia ad A che a B.

Operazione di unione. L'unione tra due eventi A e B è l'evento E2 = A ∪ B costituito da

tutti i punti campionari che appartengono ad almeno uno fra A e B.

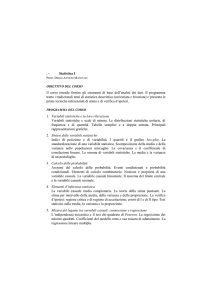

Il seguente diagramma di Venn illustra graficamente le due operazioni (intersezione ed

unione).

Ω

Ω

E1

A

A

B

B

E2

Fig. 2 - Diagrammi di Venn per l’intersezione e l’unione. Il tratteggio evidenzia

l’evento intersezione nella prima figura e l’evento unione nella seconda figura.

Operazione di differenza. La differenza fra due eventi A e B è l’evento

E3 = A – B costituito da tutti i punti campionari che appartengono ad A ma non a B.

8

B. Chiandotto - F. Cipollini

Versione 2003 - Cap. 2

Metodi Statistici per l’impresa

I palati matematici più fini, noteranno che una volta introdotte le operazioni di

negazione ed intersezione si potrebbe fare a meno d'introdurre le due ulteriori

operazioni di unione e di differenza. Infatti queste due operazioni possono essere

definite a partire dalle precedenti nel modo seguente [lo studente verifichi tali relazioni

utilizzando i diagrammi di Venn]:

A ∪ B = (A ∩ B )

A − B = (A ∩ B )

L'introduzione di queste due ultime operazioni è giustificata dalla semplificazione che

esse comportano quando si opera sugli eventi (insiemi).

Si segnala anche che la relazione

A ∪ B = (A ∩ B )

e la relazione duale

A ∩ B = (A ∪ B ) vengono usualmente dette leggi di de Morgan [si invita lo studente a

verificarle entrambe utilizzando i diagrammi di Venn].

Le operazioni di unione e di intersezione possono, naturalmente, essere applicate anche

a k (>2) eventi.

L'intersezione fra k eventi A1, A2, …, Ak fornisce come risultato l'evento

A = A1 ∩ A2 ∩ ... ∩ Ak =

k

I Ai

i =1

che contiene tutti i punti campionari comuni ai k eventi considerati.

L'unione tra gli stessi k eventi dà come risultato l'evento

A = A1 ∪ A2 ∪ ... ∪ Ak =

k

U Ai

i =1

che contiene tutti i punti campionari che appartengono ad almeno uno dei k eventi

considerati.

A questo punto possiamo elencare una serie di proprietà di facile dimostrazione che

conseguono dalle operazioni introdotte. Lo studente è invitato a dimostrarle utilizzando

i diagrammi di Venn (il simbolo ⇒ rappresenta la relazione di implicazione).

A⊆B ⇒ A∩B=A

A ⊆ B⇒ A ∪ B = B

9

B. Chiandotto - F. Cipollini

Versione 2003 - Cap. 2

Metodi Statistici per l’impresa

φ =Ω

Ω=ø

ø⊆A⊆Ω

A∩ø=ø

A∩Ω=A

A∪ø=A

A∪Ω=Ω

A∩ A =ø

A∪ A=Ω

A ⊆ (A ∪ B)

(A ∩ B) ⊆ A

B ⊆ (A ∪ B)

(A ∩ B) ⊆ B

A∩B=B∩A

(proprietà commutativa)

A∪B=B∪A

(proprietà commutativa)

A1 ∩ A2 ∩ A3 = (A1 ∩ A2) ∩ A3 = A1 ∩ (A2 ∩ A3)

(proprietà associativa)

A1 ∪ A2 ∪ A3 = (A1 ∪ A2) ∪ A3 = A1 ∪ (A2 ∪ A3)

(proprietà associativa)

A1 ∩ (A2 ∪ A3) = (A1 ∩ A2) ∪ (A1 ∩ A3)

(proprietà distributiva)

A1 ∪ (A2 ∩ A3) = (A1 ∪ A2) ∩ (A1 ∪ A3)

(proprietà distributiva)

Le due ultime proprietà (distributive) per k eventi divengono

k

k

A ∩ ( U Ai) =

i=1

i=1

k

k

A ∪ ( I Ai) =

i=1

U (A ∩ Ai)

I (A ∪ Ai)

i=1

Dopo aver elencato relazioni ed operazioni della teoria degli insiemi utili per operare

sugli eventi, utilizziamo ora la teoria degli insiemi anche per definire il concetto

importante di incompatibilità fra eventi. Due eventi A e B sono incompatibili se la loro

intersezione è l’evento impossibile, cioè

10

B. Chiandotto - F. Cipollini

Versione 2003 - Cap. 2

Metodi Statistici per l’impresa

A ∩ B = ø.

In pratica ciò significa o che i due eventi che non hanno punti campionari in comune,

oppure che hanno qualche punto in comune che però è impossibile (e quindi è come se

non l’avessero).

Un altro concetto importante (e nel quale di nuovo si sfrutta la teoria degli insiemi)

quando si opera sugli eventi è quello di condizionamento. Questo è utile quando si

vuol analizzare un certo evento A (l’evento condizionato) avendo a disposizione una

certa informazione B (l’evento condizionante). Per fare un esempio, nel lotto l’uscita

alla seconda estrazione del 5 nel caso in cui (informazione) alla prima estrazione sia

uscito il 90.

L'evento A | B (A condizionatamente ad B o, più semplicemente, A dato B) riguarda

l’analisi di A assumendo verificato l'evento condizionante (informazione) B. Si

sottolinea che l’espressione assumendo verificato non significa necessariamente che B

si è verificato, ma solo che noi si ragiona come se si fosse verificato (si ragiona cioè

sulla base dell’informazione a disposizione). Il condizionamento degli eventi si risolve

in pratica in una sorta di ridefinizione dello spazio campionario nel modo seguente.

Ω

A

B

Fig. 3 - Ridefinizione degli spazi per eventi condizionati.

Se si assume che l'evento B si è verificato allora accadono due importanti conseguenze:

1. perdono di rilevanza tutti i punti campionari che non appartengono ad B; in pratica

nell’assumere che si è verificato B diviene una specie di nuovo evento certo.

2. perdono di rilevanza tutti i punti campionari di A non appartengono ad B.

11

B. Chiandotto - F. Cipollini

Versione 2003 - Cap. 2

Metodi Statistici per l’impresa

Quindi se si considera l'evento condizionato A | B, B “si trasforma” in Ω ed A “si

trasforma” nell'evento A ∩ B. Ulteriori dettagli su questo concetto saranno dati nel

seguito parlando di probabilità condizionata.

Infine un ultimo importante concetto: quello di algebra. Poiché tale concetto non è di

semplice comprensione, facciamolo precedere da alcune considerazioni intuitive.

Nelle pagine precedenti, dopo avere dato la definizione di evento abbiamo analizzato

alcuni esempi. Abbiamo visto che quando lo spazio campionario Ω è composto da pochi

punti campionari è semplice costruire la “lista” di tutti gli eventi: basta fare l’elenco di

tutti i sottoinsiemi di Ω. Se invece Ω è composto da un numero sempre finito ma

abbastanza elevato punti campionari, esplicitare tale “lista” è un’operazione alquanto

“tediosa”. Operazione che risulta addirittura impossibile se Ω è costituito da un numero

infinito di punti campionari. D’altra parte, abbiamo notato che esplicitare l’”insiemone”

di tutti gli eventi, talvolta chiamato spazio degli eventi, non è un’operazione molto

utile. Quello che invece è importante è stato, seppure implicitamente, evidenziato dopo:

operare sugli eventi con le operazioni della teoria degli insiemi produce come risultato

altri eventi. In altri termini è importante operare in un insieme chiuso. Possiamo

sintetizzare tutto ciò nel modo seguente: lo spazio degli eventi (facile da esplicitare solo

in casi particolarmente semplici) è un insieme chiuso rispetto alle operazioni di

negazione e di intersezione (e quindi anche rispetto all’unione e alla differenza che

possono essere derivate dalle precedenti).

Esplicitiamo ora questo concetto in modo più rigoroso. Un’algebra è un insieme chiuso

rispetto alle operazioni di negazione e di intersezione fra insiemi (e quindi anche

rispetto a quelle di unione e differenza che possono essere definite a partire dalle

precedenti): ciò significa che se prendiamo elementi appartenenti all’insieme, allora

anche il risultato delle operazioni di negazione e di intersezione fatte su di essi

appartengono all’insieme. Più in particolare, se l’insieme è chiuso rispetto ad un numero

finito di operazioni, si parla di algebra di Boole o, più semplicemente, di algebra; se il

sistema è chiuso rispetto ad un’infinità numerabile di operazioni, si parla di algebra di

Boole completa o, più semplicemente, di σ-algebra.

Nella successiva esposizione si assumerà che dato un esperimento casuale e lo spazio

campionario Ω ad esso relativo, gli eventi che possono essere costruiti a partire da Ω

12

B. Chiandotto - F. Cipollini

Versione 2003 - Cap. 2

Metodi Statistici per l’impresa

formino una σ-algebra A. Quindi lo spazio degli eventi A sarà una σ-algebra e il

risultato di un numero finito o infinito numerabile di operazioni fatte su eventi (elementi

di A) sarà ancora un evento (elemento di A).

Tornando a una distinzione fatta in precedenza, se Ω è costituito da un numero finito

oppure da un’infinità numerabile di elementi allora A contiene tutti i possibili

sottoinsiemi di Ω; se invece Ω è costituito da un’infinità non numerabile di elementi

allora A contiene solo i sottoinsiemi “ammissibili” di Ω.

Dato un esperimento casuale, la coppia (Ω, A), dove Ω è lo spazio campionario e A è la

σ-algebra generata da Ω, è detta spazio misurabile.

2. La probabilità

Ognuno di noi ha in testa una idea, almeno vaga, del concetto di probabilità. Per

introdurre il concetto di probabilità partiamo proprio da questa idea intuitiva. Se

volessimo spiegare il concetto con parole semplici, potremmo dire che la probabilità di

un evento A è il grado di certezza, su una scala da 0 ad 1, attribuito al verificarsi di tale

evento: più è la probabilità è vicina a 1 più è sicuro che A si verifichi; più la probabilità

è vicina a 0 meno è sicuro che A si verifichi.

Facendo per il momento affidamento su questa idea intuitiva di probabilità, il primo

problema che occorre affrontare nella pratica è come attribuire la probabilità, dal punto

di vista numerico, nei singoli casi concreti. Tra le innumerevoli definizioni proposte in

letteratura, ne presentiamo presentano soltanto tre: la definizione classica, la

definizione frequentista e la definizione soggettiva.

Definizione 5: Definizione classica della probabilità. La probabilità di un evento A è

data dal rapporto

P(A) =

n A numero dei casi favorevoli

=

numero dei casi possibili

n

purché tutti i casi siano ugualmente possibili.

13

B. Chiandotto - F. Cipollini

Versione 2003 - Cap. 2

Metodi Statistici per l’impresa

Alla definizione classica di probabilità sono state rivolte critiche di varia natura. La

prima critica è di ordine logico e riguarda la circolarità della definizione: affermare che

tutti i casi sono ugualmente possibili significa dire che sono ugualmente probabili (non

si può definire un concetto utilizzando se stesso).

Altre due critiche, decisamente più rilevanti dal punto di vista pratico, riguardano

l’operatività della definizione: non sono affatto rare le situazioni reali nelle quali non è

possibile procedere all’enumerazione dei casi favorevoli e dei casi possibili; inoltre,

anche nelle situazioni in cui si può effettuare una tale enumerazione, non è infrequente

la circostanza in cui non tutti i casi sono ugualmente possibili.

Per superare questi inconvenienti è stata introdotta la seguente definizione di

probabilità.

Definizione 6: Definizione frequentista della probabilità. La probabilità di un

evento ripetibile A è data dal rapporto fra nA, il numero di volte in cui A

si è verificato, ed n, il numero delle prove, quando il numero delle

prove tende ad infinito

nA

,

n →∞ n

P(A) = lim

supposto che tutte le prove siano effettuate nelle stesse condizioni.

La probabilità, secondo questa definizione, può essere quindi intesa come una sorta di

idealizzazione della frequenza relativa che verrà introdotta nel contesto della statistica

descrittiva. Taluni autori ritengono, infatti, che probabilità e frequenza relativa non

siano altro che l'aspetto teorico e quello empirico di uno stesso concetto ed interpretano

la frequenza relativa di un evento come misura approssimata (per n finito) della

probabilità.

Anche alla definizione frequentista sono state rivolte critiche di varia natura. Anzitutto

quella relativa al limite irraggiungibile (+∞) imposto al numero delle prove; ma a tale

critica si risponde accettando la frequenza relativa di un numero finito (ma

sufficientemente elevato) di prove come misura approssimata della probabilità. Più

problematiche sono la critica relativa alla ripetibilità delle prove (esperimento) in

situazioni invariate e, soprattutto, quella che fa riferimento alle situazioni reali, e non

14

B. Chiandotto - F. Cipollini

Versione 2003 - Cap. 2

Metodi Statistici per l’impresa

sono affatto infrequenti, nelle quali non è possibile procedere all’effettuazione di alcuna

prova.

Una definizione che supera le critiche, sia di ordine logico che operativo, rivolte alla

definizione classica e alla definizione frequentista di probabilità è la definizione

seguente.

Definizione 7: Definizione soggettiva della probabilità. La probabilità di un evento A

è definita come il grado di fiducia che un individuo razionale

attribuisce al verificarsi di un evento. La misura (soggettiva) di

probabilità si deriva ponendo l'individuo (razionale) di fronte ad

un'operazione di scommessa chiedendo quanto è disposto a puntare per

ricevere 1 nel caso in cui l'evento in questione si realizzi.

Anche alla definizione soggettiva di probabilità sono state rivolte critiche: la prima

riguarda proprio la soggettività insita nella definizione; la seconda è relativa alla

difficoltà di tradurre in un valore numerico il grado di fiducia.

Alla prima critica si risponde osservando che qualunque probabilità deve essere intesa

in senso condizionato, cioè condizionatamente all’informazione dell’individuo

(razionale). Pertanto, anche se apparentemente due individui diversi attribuiscono una

diversa misura di probabilità ad uno stesso evento, gli stessi individui si riferiscono a

due diversi eventi essendo diversa l’informazione sulla base del quale formulano il

proprio grado di fiducia.

Alla seconda critica si risponde che, nonostante alcune difficoltà operative, alla misura

di probabilità si perviene, come detto, attraverso l’attivazione di un processo

relativamente semplice (almeno sul piano concettuale) che è quello di porre l’individuo

di fronte ad una operazione di scommessa.

Le tre definizioni introdotte, cui si può far ricorso per ottenere una valutazione

numerica della probabilità, non sono necessarie per lo sviluppo del calcolo delle

probabilità. A tal fine infatti è sufficiente una definizione di carattere più formale che

invece di stabilire come attribuire i valori di probabilità nei casi concreti, fissa

semplicemente le regole che la probabilità deve rispettare. A questa definizione

15

B. Chiandotto - F. Cipollini

Versione 2003 - Cap. 2

Metodi Statistici per l’impresa

assiomatica si farà riferimento negli sviluppi teorici che seguono, mentre le tre

definizioni non assiomatiche saranno utilizzate in alcuni esempi.

Definizione 8: Definizione assiomatica della probabilità. Siano dati un esperimento

casuale, con il suo spazio campionario Ω e la corrispondente σ-algebra

A (l’insieme degli eventi generati da Ω). Allora la probabilità è una

funzione che ad ogni evento (elemento di A) associa un numero fra 0 e

1, in simboli

P: A → [0,1]

A a P(A),

che soddisfa le seguenti proprietà:

1. P(A) ≥ 0 (ridondante, ma è bene sottolinearla)

2. P(Ω) = 1

3. Se A ∩ B = ø (cioè A e B sono incompatibili), allora

P(A ∪ B) = P(A) + P(B).

Questa definizione assiomatica della probabilità, dovuta a Kolmogorov, non ha

sollevato obiezioni sostanziali da parte degli studiosi. Infatti precisa e chiarisce soltanto

i contenuti sintattici, cioè le regole formali che deve rispettare la probabilità, regole

sulle quali è più facile trovare l'accordo. Dall'altro lato il considerare i soli aspetti

formali esclude ogni operatività della definizione, in quanto non dice niente su come

attribuire la probabilità, dal punto di vista numerico, nei singoli casi concreti. Quando si

vuol utilizzare la probabilità per risolvere problemi reali si dovrà, quindi, fare

necessariamente ricorso alle definizioni precedenti, nelle quali l'aspetto semantico, cioè

del significato, viene privilegiato.

Notiamo che la distinzione fra aspetto sintattico (o delle regole formali) e aspetto

semantico (o del significato) è la stessa distinzione che c’è, nello svolgimento di un

tema, fra l’aspetto grammaticale, che riguarda solo le regole della lingua in cui si scrive,

e l’aspetto dei contenuti e delle idee che nel tema sono esposte. I due non vanno

necessariamente insieme: un tema può essere buono come forma ma povero di idee o

viceversa un po’ sgrammaticato ma dai contenuti interessanti.

16

B. Chiandotto - F. Cipollini

Versione 2003 - Cap. 2

Metodi Statistici per l’impresa

Si evidenzia infine che tutte e tre le definizioni non assiomatiche soddisfano le regole

della definizione assiomatica di probabilità.

Ricollegandosi alla definizione assiomatica, è facile dimostrare che da tale definizione

seguono alcune utili relazioni:

P(A) ≤ 1

P(ø) = 0

A ⊆ B ⇒ P(A) ≤ P(B)

P(A ∪ B) = P(A) + P(B) – P(A ∩ B)

L'ultima relazione per 3 eventi diventa

P(A ∪ B ∪ C) = P(A) + P(B) + P(C) – P(A ∩ B) – P(A ∩ C) – P(B ∩ C) + P(A ∩ B ∩

C)

che ovviamente si riduce a

P(A ∪ B ∪ C) = P(A) + P(B) + P(C)

quando i 3 eventi sono tra loro incompatibili.

Per k eventi tale relazione diventa

k

P U Ai =

i =1

∑ P( Ai ) − ∑ ∑ P(Ai ∩ A j ) + ∑ ∑ ∑ P(Ai ∩ A j ∩ Ah )

i

i

j ≠i

i

j ≠i h ≠i , j

+ K + (− 1)k +1 P I Ai

i =1

k

che ovviamente si riduce a

k

k

P U Ai = ∑ P(Ai )

i =1 i =1

quando i k eventi sono tra loro incompatibili.

In conclusione un’ultima notazione. Alla fine della sezione 2 abbiamo detto che dato un

esperimento casuale, la coppia (Ω, A), dove Ω è lo spazio campionario e A è la σalgebra generata da Ω, è detta spazio misurabile. Se a questa coppia aggiungiamo la

(funzione) probabilità otteniamo la tripletta (Ω, A, P(.)) detta spazio probabilistico.

17

B. Chiandotto - F. Cipollini

Versione 2003 - Cap. 2

Metodi Statistici per l’impresa

3. La probabilità condizionata

Nella sezione 1 abbiamo enunciato il concetto di condizionamento fra eventi.

Ricordandone gli elementi fondamentali, (per maggiori dettagli si veda la sezione

indicata) il condizionamento è utile quando si vuole analizzare un certo evento A

(l’evento condizionato) avendo a disposizione una certa informazione B (l’evento

condizionante): l'evento A | B (detto A condizionatamente a B o A dato B) riguarda

quindi l’analisi di A assumendo verificato l'evento condizionante (informazione) B. Si

ricorda anche che l’espressione assumendo verificato non significa necessariamente che

B si è verificato, ma solo che si ragiona come se si fosse verificato (cioè prendendo per

buona l’informazione a disposizione). Abbiamo anche detto che il condizionamento

degli eventi si risolve in pratica in una sorta di ridefinizione dello spazio campionario.

Infatti se si assume che B si è verificato ne consegue che:

1. perdono di rilevanza tutti i punti campionari che non appartengono a B, cosicché B

diviene “una specie” di nuovo evento certo;

2. perdono di rilevanza tutti i punti campionari di A che non appartengono a B,

cosicché l’unica parte di A che ancora può verificarsi è soltanto A ∩ B.

La seguente definizione di probabilità condizionata risponde perfettamente a questa

logica.

Definizione 9: Definizione di probabilità condizionata. Assumendo P(B) > 0, la

probabilità di A | B è data da

P(A | B) =

P( A ∩ B )

P (B )

In pratica, allora, P(A | B) non è altro che P(A ∩ B) riproporzionato sulla base di P(B)

(la probabilità dell’evento condizionante).

Si può dimostrare [si invita lo studente a provare per conto proprio] che la probabilità

condizionata è una vera e propria probabilità, cioè è una funzione

P(. | B): A → [0,1]

A a P(A | B)

che soddisfa gli assiomi di probabilità 1, 2, 3 di cui alla definizione 8. Infatti

18

B. Chiandotto - F. Cipollini

Versione 2003 - Cap. 2

Metodi Statistici per l’impresa

P(A | B) ≥ 0

P(B | B) = 1

P(A1 ∪ A2 | B) = P(A1 | B) + P(A2 | B)

se A1 ed A2 sono incompatibili.

Valgono inoltre

A1 ⊆ A2 ⇒ P (A1 | B) ≤ P (A2 | B)

P( A1 | B) = 1 – P(A1 | B)

P(A1 ∪ A2 | B) = P(A1 | B) + P(A2 | B) – P(A1 ∩ A2 | B)

Si evidenzia che le regole della probabilità valgono per l’evento a sinistra del | (l’evento

condizionato), mentre l’evento condizionante, l’informazione, è “tenuto fermo”.

E’ ovvio che se il ruolo dei due eventi è invertito rispetto alla definizione, cioè siamo

interessati ad B avendo A come informazione (con P(A) > 0), allora basta scambiare i

due eventi nella definizione per ricavare P(B | A):

P(B | A) =

P (B ∩ A)

.

P ( A)

Dalla definizione di probabilità condizionata e dalle considerazioni precedenti possono

poi essere derivate una serie di formule assai utili nella pratica per il calcolo di certe

probabilità.

1. La prima è nota come formula delle probabilità composte ed è data da

P(A ∩ B) = P(A | B) P(B) = P(B | A) P(A).

Tale relazione si dimostra ricavando P(A ∩ B) in funzione degli altri elementi sia

nella definizione di P(A | B) che di P(B | A) (si ricorda che, per la proprietà

commutativa, A ∩ B = B ∩ A e quindi P(A ∩ B) = P(B ∩ A)).

2. La seconda è nota come formula della probabilità marginale ed è data da

P(B) = P(B | A) P(A) + P(B | A ) P( A )

Questa formula può essere dimostrata, sfruttando le proprietà delle operazioni fra

eventi e della probabilità, attraverso i seguenti passaggi:

P(B) = P(B ∩ Ω) = P[B ∩ (A ∪ A )] = P[(B ∩ A) ∪ (B ∩ A )]

= P(B ∩ A) + P(B ∩ A ) = P(B | A) P(A) + P(B | A ) P( A ),

19

B. Chiandotto - F. Cipollini

Versione 2003 - Cap. 2

Metodi Statistici per l’impresa

dove fra le altre cose si sfrutta il fatto che (B ∩ A) e (B ∩ A ) sono incompatibili (lo

studente è invitato a verificare ciò utilizzando i diagrammi di Venn) e la formula

delle probabilità composte.

3. La terza è nota come formula di Bayes ed è data da

P(A | B) =

P(B | A)P( A)

.

P (B )

Tale formula può essere ricavata immediatamente dalla formula delle probabilità

composte. Si sottolinea che nella pratica il denominatore P(B) è spesso calcolato a

partire da P(B | A), P(B | A ), P(A) e P( A ) utilizzando la formula della probabilità

marginale.

Sulla base delle considerazioni precedenti possiamo ora discutere più in dettaglio

l’utilizzo pratico della probabilità condizionata. E’ banale osservare (ma spesso gli

studenti se lo dimenticano!) che la formula nella definizione di probabilità condizionata

è una uguaglianza: quindi dati due elementi (qualsiasi!) della stessa il terzo può essere

ricavato. Di conseguenza tale definizione può essere utilizzata in tre modi:

1. Uso “diretto”. E’ l’utilizzo più immediato: sapendo P(B) e P(A ∩ B) si ricava P(A |

B) utilizzando direttamente la definizione.

2. Uso “indiretto” via principio delle probabilità composte: sapendo la probabilità

condizionata P(B | A) e quella marginale P(A), si vuol ricavare la probabilità

dell’intersezione P(A ∩ B). In questo caso la definizione è utilizzata indirettamente

perché si ricava la probabilità dell’intersezione in funzione della probabilità

condizionata.

3. Uso “indiretto” via formula di Bayes: sapendo le probabilità condizionate P(B | A) e

P(B | A ) e quella marginale P(A) (da cui si ricava anche e P(B | A )), si vuol ottenere

P(A | B). In questo caso la definizione è utilizzata indirettamente perché si ricava

una probabilità condizionata in funzione di altre probabilità.

Alcune delle relazioni precedenti possono essere estese anche a più di 2 eventi.

1. Il formula delle probabilità composte può riguardare anche un numero qualsiasi di

eventi A1, A2, A3, … Si avrà allora

P(A1 ∩ A2 ∩ … ∩ Ak) = P(A1) P(A2 | A1) P(A3 | A1 ∩ A2) ... P(Ak | A1 ∩ … ∩ Ak–1),

20

B. Chiandotto - F. Cipollini

Versione 2003 - Cap. 2

Metodi Statistici per l’impresa

che è detta anche regola della catena.

2. La formula della probabilità marginale può essere estesa anche ad una partizione

dello spazio campionario Ω più “fine” di quella vista in precedenza fra A e A . Ma

vediamo prima cos’è una partizione.

Una partizione di Ω (ma la definizione di partizione vale per un qualsiasi evento B)

è una suddivisione di tale spazio in tanti eventi A1, A2, ..., Ak che siano esaustivi ed

incompatibili:

•

esaustivi in quanto devono esaurire Ω, cioè

k

U Ai = Ω;

i=1

•

incompatibili in quanto non devono avere punti campionari in comune, cioè

Ai ∩ Aj = ø per ogni i ≠ j.

Per averne un’idea possiamo immaginare la partizione come le mattonelle di un

pavimento: la loro unione forma il pavimento (esaustività) ma fra loro non vi sono

sovrapposizioni (incompatibilità).

Detto cos’è una partizione, la formula della probabilità marginale per una generica

partizione A1, A2, ..., Ak di Ω è data da

k

P(B) =

∑

P(B | Ai) P(Ai).

i =1

Anche questa formula può essere dimostrata sfruttando le proprietà delle operazioni

fra eventi e della probabilità. I passaggi sono i seguenti:

k

k

i=1

i=1

P(B) = P(B ∩ Ω) = P[B ∩ ( U Ai)] = P[ U (B ∩ Ai)] =

=

k

∑ P(B ∩ A )

i

i=1

k

∑ P(B | A ) P(A ),

i

i

i=1

dove fra le altre cose si sfrutta il fatto che i (B ∩ Ai) sono fra loro incompatibili.

3. Analogamente alla formula della probabilità marginale, anche la formula di Bayes

può essere estesa ad una generica partizione A1, A2, ..., Ak di Ω. In tale caso la

formula di Bayes è una semplice riscrittura di quella vista in precedenza:

P(Ai | B) =

P(B | Ai )P( Ai )

,

P (B )

21

B. Chiandotto - F. Cipollini

Versione 2003 - Cap. 2

Metodi Statistici per l’impresa

dove normalmente P(B) è ricavato sulla base della formula della probabilità

marginale precedente.

Precisiamo che da un punto di vista pratico la formula di Bayes assume una

rilevanza particolare quando i k eventi Ai possono essere interpretati come possibili

“cause” dell'evento B. In tale contesto: P(Ai | B) è detta probabilità a posteriori

della causa Ai; P(Ai) è detta probabilità a priori della stessa causa e P(B | Ai) è detta

verosimiglianza dell'evento B.

La formula di Bayes esprime in maniera molto semplice il processo di

apprendimento dall'esperienza in contesti non deterministici. Della realtà si possiede

una conoscenza probabilistica, che viene espressa in termini di probabilità (a priori)

P(Ai); queste probabilità si trasformano, al verificarsi dell'evento B (acquisizione di

ulteriore informazione), nelle probabilità (a posteriori) P(Ai | B). Come molte volte

ripetuto, infatti, le probabilità condizionate si usano per riassegnare le probabilità

agli eventi una volta che siano state acquisite ulteriori informazioni relative ad una

realizzazione parziale di un esperimento casuale.

Ω

A1

A3

A4

A2

A

A5

Fig. 4 - Partizione dello spazio campionario Ω in cinque eventi A1, A2, A3, A4 ed A5

possibili cause dell’evento B.

Vediamo adesso un altro concetto di fondamentale importanza nell’ambito della

probabilità: quello di indipendenza fra eventi (importante: non confonderlo con quello

di incompatibilità!). Avere l’informazione che si è realizzato un certo evento B, non è

detto che modifichi necessariamente la probabilità di verificarsi di un altro evento A;

può accadere cioè che la valutazione di probabilità rimanga la stessa che si aveva senza

avere l’informazione, ovvero

22

B. Chiandotto - F. Cipollini

Versione 2003 - Cap. 2

Metodi Statistici per l’impresa

P(A | B) = P(A).

E’ ragionevole definire questa situazione come indipendenza, e più in particolare A

indipendente da B.

D’altra parte se ciò accade, sostituendo tale relazione nella formula di Bayes per P(B |

A) si ottiene immediatamente

P(B | A) = P(B),

ovvero che B è indipendente da A. Questo significa che la relazione di indipendenza fra

due eventi è biunivoca, cioè se c’è in un senso c’è anche nell’altro: di conseguenza si

può parlare non solo di indipendenza di un evento da un altro ma di indipendenza fra

due eventi.

Inoltre se la relazione P(A | B) = P(A) si sostituisce nella formula delle probabilità

composte si ricava subito che

P(A ∩ B) = P(A) P(B),

che esprime quindi la formula delle probabilità composte per eventi indipendenti.

Riassumendo allora possiamo dare la seguente definizione.

Definizione 10: Definizione di indipendenza. Due eventi A e B sono fra loro

indipendenti se (una qualsiasi implica le altre due):

P(A | B) = P(A),

oppure

P(B | A) = P(B),

oppure

P(A ∩ B) = P(A) P(B).

Più in generale, k eventi A1, A2, ..., Ak sono indipendenti se

(

)

( ) ( )

( )

P Ai1 ∩ Ai2 ∩K∩ Ais = P Ai1 ⋅ P Ai2 ⋅ ... ⋅ P Ais

per ogni sottoinsieme di eventi Ai1 , Ai2 , …, Ais con s = 2, 3, ...,k.

Ad esempio tre eventi A, B, C sono indipendenti se valgono tutte le seguenti relazioni

P(A ∩ B) = P(A) P(B)

P(A ∩ C) = P(A) P(C)

P(B ∩ C) = P(B) P(C)

P(A ∩ B ∩ C) = P(A) P(B) P(C)

23

B. Chiandotto - F. Cipollini

Versione 2003 - Cap. 2

Metodi Statistici per l’impresa

Si sottolinea che le prime tre relazioni (indipendenze doppie) non implicano la quarta

(indipendenza tripla). Così come la quarta relazione non implica le prime tre.

4. Variabili casuali

In estrema sintesi possiamo riassumere le sezioni precedenti nello spazio probabilistico

(Ω, A, P(.)), dove: Ω è lo spazio campionario; A è la σ-algebra generata da Ω, cioè lo

spazio di tutti gli eventi dell’esperimento casuale; P(.) è la funzione di probabilità (si

veda la parte finale della sezione 2). A partire da tale spazio probabilistico (e da tutto

quello che ci sta dietro, ovviamente!) possiamo introdurre un ulteriore concetto

fondamentale nello sviluppo del calcolo delle probabilità e della statistica: quello di

variabile casuale (che spesso abbrevieremo in v.c.).

Definizione 11: Definizione di variabile casuale. Dato uno spazio probabilistico (Ω,

A, P(.)), una variabile casuale è una funzione che ad ogni punto

campionario associa un numero reale, in simboli

X: Ω → R

ω a X(ω),

che soddisfa la seguente proprietà: ogni insieme del tipo

{ω ∈Ω: X(ω) ≤ x}

è un evento, cioè un elemento di A.

In parole semplici una variabile casuale è un modo di trasformare i punti campionari in

numeri. Siccome ci sono infiniti modi di fare questo, di solito si sceglie il modo che più

ci fa comodo e, magari, anche quello più ovvio. Il motivo ritrasformare i punti

campionari in numeri è semplice: lavorare sui numeri è molto più semplice che lavorare

sui punti campionari, anche perché questi ultimi possono essere di natura assai diversa

fra un esperimento casuale ed un altro. La condizione tecnica che {ω ∈Ω: X(ω) ≤ x}

deve appartenere a A, cioè deve essere un evento (ricordiamo che A è l’insieme di tutti

gli eventi di un esperimento casuale) deriva dal fatto che su A abbiamo definito una

24

B. Chiandotto - F. Cipollini

Versione 2003 - Cap. 2

Metodi Statistici per l’impresa

probabilità. Questa probabilità, definita sugli elementi di A, non vogliamo “perderla”,

ma vogliamo “trasferirla” ai sottoinsiemi di R, cioè ai numeri.

Alcuni esempi

Consideriamo l’esempio della moneta a due facce in cui Ω = {T, C}. Come v.c.

possiamo considerare quella che trasforma T in 1 e C in 0, cioè

X(T) = 1

X(C) = 0.

Consideriamo l’esempio dell’urna con 10 palline numerate da 1 a 10. In tal caso Ω =

{1, 2, 3, 4, 5, 6, 7, 8, 9,

}. Come v.c. possiamo considerare quella che associa

ad ogni pallina il numero riportato sulla stessa, cioè

X(

con numero i) = i.

Potrebbe però accadere, nello spesso esempio, di non essere interessati al numero in sé,

ma solo a distinguere fra pari e dispari. In tal caso potremmo considerare la v.c.

X(

X(

con numero pari) = 1

con numero dispari) = 0.

Come ulteriore esempio consideriamo una certa popolazione di N imprese industriali.

Poiché ciascuna impresa è identificata dalla sua ragione sociale, lo spazio campionario è

dato da Ω = {ω1, …, ωN}, dove ωi è la ragione sociale della impresa i. Se di tali imprese

interessa studiare la redditività, ad esempio misurata dall’indice ROE, possiamo

considerare la v.c. X che associa a ciascuna impresa il suo ROE, cioè

X(ω) = ROE dell’impresa ω.

Aggiungiamo che in questi casi per indicare la v.c. considerata si utilizza l’espressione

abbreviata “X è la v.c. ROE”, intendendo “X è la v.c. che associa a ciascuna impresa il

suo ROE”.

Nella stessa situazione delle N imprese potremmo considerare la v.c. ragione sociale,

distinguendo, ad esempio, fra società di persone, società di capitali e società

cooperativa. In tal caso potremmo utilizzare la v.c. X strutturata nel modo seguente:

X(ω) = 1 se ω è una società di persone

X(ω) = 2 se ω è una società di persone

X(ω) = 3 se ω è una società cooperativa

25

B. Chiandotto - F. Cipollini

Versione 2003 - Cap. 2

Metodi Statistici per l’impresa

Anche in questo caso per indicare la v.c. considerata si utilizza l’espressione abbreviata

“X è la v.c. natura giuridica”, intendendo “X è la v.c. che associa a ciascuna impresa un

opportuno codice che identifica la sua natura giuridica”.

Anche se ai fini di un’analisi corretta abbiamo insistito molto sull’aspetto che la v.c.

trasforma i punti campionari in numeri in modo da conservare la probabilità prima

definita sugli eventi, ben presto ci dimenticheremo di tale probabilità e, più in generale,

dello spazio probabilistico (Ω, A, P(.)) che sta “a monte” di ogni v.c. Spesso lo spazio

probabilistico sarà semplicemente sottinteso senza esplicitarlo (questo però non vuol

dire che non c’è!).

Per questo motivo è bene allora avere un’immagine facilmente comprensibile e

immediata di cos’è una v.c., con l’avvertenza che tale immagine deve aiutare a capire

cos’è una v.c. ma non deve sostituire la definizione rigorosa. Possiamo allora pensare

una v.c. come un oggetto casuale, cioè un qualcosa di cui non possiamo sapere con

certezza cosa verrà fuori ma, al massimo, possiamo descrivere cosa può venire fuori e

con quale probabilità. Per avere qualche esempio pensiamo al numero estratto al lotto,

alla quotazione di un titolo azionario fra un mese, al voto che prenderemo all’esame di

statistica: tutti esempi di oggetti casuali, cioè di fenomeni di cui non si conosce con

certezza il risultato (data la presenza del caso) ma, al massimo,

1. quali risultati si possono avere;

2. con che probabilità ciascun risultato può venire fuori.

Vedremo questo più in dettaglio nella prossima sezione.

5. Distribuzione di una variabile casuale

Riassumendo, allora, la variabile casuale serve a due scopi: primo a trasformare i punti

campionari in numeri; secondo a trasferire ai numeri (ma è più corretto dire ai

sottoinsiemi di R) la probabilità prima definita sugli elementi di A. Per identificare una

variabile casuale dobbiamo allora indicare due cose (tenerlo sempre ben presente!):

1. quali valori può assumere;

2. come la probabilità è distribuita su tali valori.

26

B. Chiandotto - F. Cipollini

Versione 2003 - Cap. 2

Metodi Statistici per l’impresa

Relativamente ai valori che la variabile casuale può assumere, come ovvio questi

cambiano da caso a caso, e in seguito ne vedremo numerosi esempi. Tuttavia, per motivi

che vedremo in seguito, vengono distinte in discrete e continue. Una v.c. si dice:

a. discreta, se può assumere un numero finito oppure un'infinità numerabile di valori;

b. continua, se può assumere un insieme continuo (e quindi non numerabile) di valori.

Relativamente a come la probabilità è distribuita (potremmo dire “spalmata”) sui valori

che la variabile casuale può assumere, questo può essere indicato in diversi modi,

ciascuno utile per scopi in parte diversi. Noi ne vedremo 3: la funzione di ripartizione

(definita sia per v.c. discrete che continue), la funzione di massa (definita solo per v.c.

discrete) e la funzione di densità (definita solo per v.c. continue).

Definizione 12: Definizione di funzione di ripartizione (o funzione delle probabilità

cumulate). Data una variabile casuale X, la funzione di ripartizione di

X è la funzione

F(x) = P(X ≤ x),

dove x è un qualsiasi numero reale.

La funzione di ripartizione di una variabile casuale, quindi, è semplicemente P(X ≤ x),

cioè, al variare di x, la probabilità che questa assuma valori minori o uguali ad x: solo

per brevità è indicata con F(x), ma dobbiamo sempre pensare che suo significato è,

appunto, P(X ≤ x). A questo proposito il termine, mutuato dall’inglese, di funzione delle

probabilità cumulate, rende sicuramente meglio l’idea: la probabilità è cumulata da –∞

fino al punto x. Si nota inoltre che la funzione di ripartizione rappresenta (non a caso) la

probabilità degli eventi {ω ∈Ω: X(ω) ≤ x} di cui alla definizione di variabile casuale,

cioè P(X ≤ x) è la scrittura abbreviata per P{ω ∈Ω: X(ω) ≤ x}. Come già detto, infatti, la

proprietà che {ω ∈Ω: X(ω) ≤ x} sia un evento serve per poter “trasferire” la probabilità

dagli eventi ai sottoinsiemi di R (X(ω) ≤ x significa infatti X(ω) ∈ (–∞, x] che appunto è

un sottoinsieme di R).

Analizzeremo in seguito le proprietà più importanti della funzione di ripartizione. Per

adesso facciamo soltanto osservare che conoscendo la funzione di ripartizione di X è

27

B. Chiandotto - F. Cipollini

Versione 2003 - Cap. 2

Metodi Statistici per l’impresa

possibile ricavare la probabilità che X assuma valori in un qualsiasi intervallo (x1, x2].

Infatti

P(x1 < X ≤ x2) = P(X ≤ x2) – P(X ≤ x1) = F(x2) – F(x1).

Tornando a quanto detto sopra, la funzione di ripartizione risponde allora perfettamente

all’esigenza espressa: indicare come la probabilità è distribuita sui valori che la v.c. può

assumere. La funzione di ripartizione fa questo indicando, al variare di x, la probabilità

di X assumere valori minori o uguali ad x.

Questo modo di specificare come la probabilità è distribuita sui valori che la variabile

casuale può assumere, ha dei pregi e dei difetti. Il pregio principale è che la funzione di

ripartizione è definita allo stesso modo sia per v.c. discrete che per v.c. continue. Il

difetto più importante, invece, è che è riferita ad intervalli, in particolare intervalli aperti

a sinistra del tipo (–∞, x]. Infatti per molte esigenze (in particolare la semplicità di

interpretazione) è utile sapere come la probabilità si distribuisce su ciascun valore che la

v.c. può assumere piuttosto che sugli intervalli (–∞, x].

E’ per ovviare a questo inconveniente che si introducono la funzione di massa (per v.c.

discrete) e la funzione di densità (per v.c. continue).

Definizione 13: Definizione di funzione di massa (di probabilità). Sia X una v.c.

discreta che assume valori, ordinati in senso crescente, x1, …, xk

(eventualmente k è ∞ se la v.c. assume un’infinità numerabile di valori).

La funzione di massa di X è la funzione

f(x) = P(X = x).

Tale funzione vale quindi

f(xi) = P(X = xi)

se i = 1, …, k, mentre vale 0 per gli altri valori di x.

La funzione di massa di una v.c. discreta, quindi, è semplicemente P(X = x), cioè la

probabilità che X sia uguale ad x: solo per brevità è indicata con f(x), ma dobbiamo

sempre pensare che suo significato è, appunto, P(X = x). Come indicato nella

definizione, tale probabilità sarà maggiore di 0 solo per i valori x che la v.c. può

assumere, mentre sarà 0 per tutti gli altri valori di x.

28

B. Chiandotto - F. Cipollini

Versione 2003 - Cap. 2

Metodi Statistici per l’impresa

Rispetto alla funzione di ripartizione, la funzione di massa ha il grosso pregio di essere

“più intelligibile”, perché la probabilità è riferita a ciascun punto x invece di essere

cumulata da –∞ a x. D’altra parte c’è un rovescio della medaglia: la funzione di massa

non può essere definita per le v.c. continue. Una spiegazione esauriente del motivo

richiederebbe sofisticati strumenti matematici ai quali non è il caso di fare riferimento;

ci limiteremo quindi ad una spiegazione basata su argomenti intuitivi. Una v.c.

continua, come detto può assumere valori in un insieme continuo. Ora nel continuo, e

questo vale anche se si prende un intervallo “piccolino”, ci sono tanti valori, assai più

che nell’infinito numerabile. Se X avesse probabilità positiva, anche piccolissima, in

ciascuno di questi valori, sommando tali probabilità otterremmo che la probabilità che X

assuma un valore qualsiasi (evento certo) sarebbe infinito, contravvenendo ad una delle

regole fondamentali della probabilità secondo le quali P(Ω) = 1. Quindi: primo, non ci

possono essere più di un’infinità numerabile di punti con probabilità maggiore di 0 (e di

questo ne abbiamo già tenuto conto quando abbiamo parlato della funzione di massa);

secondo, nel continuo P(X = x) = 0 in ogni x. Pertanto nel continuo la funzione di massa

non può essere definita e occorre un altro modo per vedere “cosa accade” sulle singole

x: la funzione di densità.

A questo scopo aggiungiamo un’altra considerazione. Come indicato, nel continuo

parlare di probabilità nel singolo punto non serve a molto, dato che questa è sempre 0.

Ha invece senso parlare di probabilità che la X assuma valori in un certo intervallo,

anche piccolissimo, purché di ampiezza maggiore di 0. Ad esempio ha senso la

probabilità che X appartenga ad un intervallo di ampiezza piccola a piacere dx, cioè

P(x < X ≤ x + dx).

Idealmente, possiamo allora pensare di “far scorrere” x da sinistra a destra (ogni volta

partendo dall’estremo superiore dell’intervallo precedente) e di calcolare, al variare di x,

la probabilità che X assuma valori nell’intervallino (x, x + dx]. Tali probabilità avranno

un certo andamento, che può essere il più vario. La cosa che qui interessa, però, non è

tanto il valore di tali probabilità ma di quanto cambia tale probabilità da una x alla

successiva. Interessa cioè il tasso: quanto vale la probabilità in rapporto all’ampiezza

dell’intervallo (dx), ovvero

P( x < X ≤ x + dx )

.

dx

29

B. Chiandotto - F. Cipollini

Versione 2003 - Cap. 2

Metodi Statistici per l’impresa

La funzione di densità è esattamente tale tasso per l’intervallino di ampiezza

infinitesima.

Definizione 14: Definizione di funzione di densità (di probabilità). Sia X una v.c.

continua che assume valori nell’intervallo (a, b) (eventualmente a può

essere –∞ e b +∞). La funzione di densità di X è la funzione

P( x < X ≤ x + dx ) 1

.

dx→0

dx

f(x) = lim

La funzione di densità in x, allora, rappresenta quanto vale la probabilità “intorno ad x”

in rapporto all’ampiezza di tale “intorno”. Il termine funzione di densità serve proprio

ad evocare quanto illustrato: quanto è densa la probabilità in ciascun punto.

A questo punto riassumiamo quanto visto finora. Prima abbiamo definito il concetto di

variabile casuale; successivamente abbiamo affermato che una variabile casuale si

identifica dando: i valori che questa può assumere e come la probabilità si distribuisce

su questi valori. Infine abbiamo detto che quest’ultima cosa, cioè la distribuzione della

probabilità sulle x, può essere data in tre modi diversi: funzione di ripartizione, funzione

di massa e funzione di densità. Ciascuna con pregi e difetti. Rimane una cosa da vedere:

che i diversi modi di indicare la distribuzione di una v.c. sono fra loro equivalenti. E’

chiaro che deve essere così: preso un esperimento campionario, la probabilità è

distribuita sugli eventi in un solo modo. Pertanto funzione di ripartizione – funzione di

massa (per v.c. discrete) e funzione di ripartizione – funzione di densità (per v.c.

continue) sono fra loro strettamente collegate: si può passare dall’una all’altra a seconda

di quello che fa comodo e di quello che interessa. Insieme a questa equivalenza fra le

diverse funzioni illustreremo anche alcune proprietà importanti delle stesse.

Consideriamo prima il caso discreto. Sia X una v.c. discreta che assume valori, ordinati

in senso crescente, x1, …, xk (eventualmente k è ∞ se la v.c. assume un’infinità

numerabile di valori). Allora per ricavare la funzione di massa dalla funzione di

ripartizione e viceversa possiamo utilizzare le seguenti 2 relazioni:

1

Poiché dx può essere anche negativo, in tale caso il numeratore è da intendere come P(x + dx < X ≤ x ) .

30

B. Chiandotto - F. Cipollini

Versione 2003 - Cap. 2

Metodi Statistici per l’impresa

f(xi) = F(xi) – F(xi–1)

i

∑ f(x).

F(xi) =

j=1

La verifica delle due relazioni è immediata. La prima si ricava dal fatto che

f(xi) = P(X = xi) = P(X ≤ xi) – P(X ≤ xi–1);

la seconda dal fatto che

F(xi) = P(X ≤ xi) =

i

i

j=1

j=1

∑ P(X = xj) = ∑

f(xj).

Consideriamo ora il caso continuo. Sia X una v.c. continua che assume valori

nell’intervallo (a, b) (eventualmente a può essere –∞ e b +∞). Allora per ricavare la

funzione di densità dalla funzione di ripartizione e viceversa possiamo utilizzare le

seguenti 2 relazioni:

f(x) = F’(x);

x

F(x) = ∫ f(y) dy.

a

Anche in questo caso la verifica delle due relazioni (ricordando un po’ di matematica!)

è immediata. Infatti ricordando la definizione di derivata e il fatto che P(x1 < X ≤ x2) =

F(x2) – F(x1) si ottiene

P(x < X ≤ x + dx )

F ( x + dx ) − F ( x )

= lim

= F’(x)

dx→0

dx→0

dx

dx

f(x) = lim

e di conseguenza anche l’altra in base al teorema fondamentale del calcolo integrale.

Ripercorrendo le definizioni della funzione di distribuzione, della funzione di massa e

della funzione di densità, risulta immediata l’individuazione delle principali proprietà

che tali funzioni soddisfano.

Proprietà della funzione di ripartizione

1. La funzione di ripartizione essendo una probabilità gode ovviamente delle proprietà

della probabilità; in particolare 0 ≤ F(x) ≤ 1

2. Valgono i limiti lim F(x) = 0 e lim F(x) = 1

x→−∞

x → +∞

3. F(x) monotona non decrescente

31

B. Chiandotto - F. Cipollini

Versione 2003 - Cap. 2

Metodi Statistici per l’impresa

4. F(x) continua a destra nel caso discreto (i punti di discontinuità si collocano in

corrispondenza dei valori x1, x2, ..., xk assunti dalla variabile) e assolutamente

continua (continua e derivabile quasi ovunque) nel caso continuo.

Proprietà della funzione di massa

1. La funzione di massa essendo una probabilità gode ovviamente delle proprietà della

probabilità; in particolare 0 ≤ f(xi) ≤ 1

k

2.

∑ f(xi) = 1.

i=1

Proprietà della funzione di densità

1. f(x) ≥ 0

2.

b

∫a

f(x) dx = 1

Infine è opportuno esplicitare due formule utili per ricavare la probabilità che X

appartenga ad un dato intervallo, distinguendo a seconda che vogliamo ricavare quanto

interessa dalla funzione di ripartizione oppure dalla funzione di massa o dalla funzione

di densità. Tali relazioni si ricavano facilmente dalle formule precedenti.

1. Se X è una v.c. discreta allora

k

P(xh ≤ X ≤ xk) = F(xk) – F(xh–1) =

∑ f(x ).

i

i=h

2. Se X è una v.c. continua allora

x2

P(x1 ≤ X ≤ x2) = F(x2) – F(x1) =

∫

f(x) dx.

x1

Come prototipo per la comprensione dei concetti introdotti consideriamo i seguenti

esempi: il risultato del lancio di una moneta onesta e il risultato del lancio di un dado

onesto.

32

B. Chiandotto - F. Cipollini

Versione 2003 - Cap. 2

Metodi Statistici per l’impresa

Esempio

Nel lancio di una moneta onesta gli unici risultati possibili sono testa (T) e croce (C),

entrambi con probabilità 1/2. Consideriamo allora la v.c. che associa 1 a T e 0 a C.

Poiché le probabilità si conservano nel passare dai punti campionari ai numeri, la

funzione di massa di questa v.c. è data da

1 / 2 se x = 0

f(x) = 1 / 2 se x = 1

0 altrimenti

da cui si ricava facilmente anche la funzione di ripartizione [si invita lo studente a

farlo]. Funzione di massa e funzione di ripartizione per la v.c. in oggetto sono riportate

in Fig. 5.

1.20

1.20

1.00

1.00

0.80

0.80

0.60

0.60

0.40

0.40

0.20

0.20

0.00

-1

-0.5

0.00

0

0.5

1

1.5

2

-1

-0.5

0

0.5

1

1.5

2

Fig. 5– Funzione di massa e funzione di ripartizione per la v.c. 0/1 nel lancio di una

moneta onesta.

Esempio

Nel lancio di un dado onesto gli unici risultati possibili sono le facce puntinate da 1 a 6

puntini, ciascuna con probabilità 1/6. Consideriamo allora la v.c. che associa a ciascuna

faccia il numero dei puntini. Poiché le probabilità si conservano nel passare dai punti

campionari ai numeri, allora la funzione di massa di questa v.c. è data da

1 / 6 se x = 1,2,3,4,5,6

f(x) =

altrimenti

0

33

B. Chiandotto - F. Cipollini

Versione 2003 - Cap. 2

Metodi Statistici per l’impresa

da cui si ricava facilmente anche la funzione di ripartizione [si invita lo studente a

farlo]. Funzione di massa e funzione di ripartizione per la v.c. in oggetto sono riportate

in Fig. 6.

1.20

1.20

1.00

1.00

0.80

0.80

0.60

0.60

0.40

0.40

0.20

0.20

0.00

0.00

-2

0

2

4

6

8

-2

10

0

2

4

6

8

10

Fig. 6 – Funzione di massa e funzione di ripartizione per la v.c. “numero di puntini” nel

lancio del dado onesto.

6. Indici sintetici di una variabile casuale

Nelle due sezioni precedenti, prima abbiamo definito una v.c. e successivamente

abbiamo analizzato alcuni modi di rappresentare la distribuzione della v.c.

Riepiloghiamo. Un esperimento casuale è un fenomeno il cui risultato non è prevedibile

con certezza, ovvero è frutto del caso: esso genera gli eventi con una certa probabilità.

La v.c. trasforma i risultati dell’esperimento casuale in numeri; ma poiché tali risultati

sono frutto del caso, anche i valori che la v.c. assume sono frutto del caso. Ne possiamo

conoscere il valore solo dopo che l’esperimento è stato effettuato, ma prima il massimo

che possiamo sapere sono: i valori che questa assume e con quale probabilità.

Conoscere queste due cose significa conoscere completamente la v.c.; infatti la

distribuzione identifica la v.c., nel senso che ne descrive completamente il massimo che

della v.c. possiamo conoscere: il suo comportamento probabilistico.

Per particolari esigenze, si può tuttavia essere interessati non alla distribuzione della v.c.

considerata, ma più semplicemente a delle sintesi della stessa. Può, cioè, risultare utile,

descrivere una variabile casuale con degli indici caratteristici, anziché procedere ad

34

B. Chiandotto - F. Cipollini

Versione 2003 - Cap. 2

Metodi Statistici per l’impresa

una sua rappresentazione completa mediante la funzione di distribuzione, la funzione di

massa o la funzione di densità.

A questo scopo, come riferimento per questa sezione supporremo che X sia:

•

o una v.c. discreta che assume valori, ordinati in senso crescente, x1, …, xk

(eventualmente k è ∞ se la v.c. assume un’infinità numerabile di valori) con

funzione di massa f(x);

•

oppure una v.c. continua che assume valori nell’intervallo (a, b) (eventualmente a

può essere –∞ e b +∞) con funzione di densità f(x).

6.1. Momenti di una variabile casuale

Ci sono vari modi di costruire indici caratteristici di una variabile casuale. Uno fra i più

utilizzati è quello di procedere al calcolo di uno o più valori attesi (momenti) della v.c.

Definizione 13:Definizione di valore atteso (momento). Sia X una v.c. con funzione di

massa o funzione di densità f(x) e sia g(X) una trasformazione di X. Il

valore atteso di g(X) è dato da

k

∑ g ( xi ) f ( xi ) se la v.c. è discreta

E[g(X)] = ib=1

.

g ( x ) f (x )dx se la v.c. è continua

∫

a

Si evidenzia che un valore atteso è una costante. Quindi un valore atteso è

effettivamente una sintesi della v.c. nel senso descritto sopra, dato che, appunto,

sintetizza la distribuzione della v.c. in un valore. La definizione evidenzia anche che

tale sintesi è realizzata secondo la seguente logica: scelta una opportuna trasformazione

g(.) di X, i valori x trasformati secondo tale funzione, g(x), vengono sommati (o

integrati) dopo averli pesati con la loro probabilità (o densità). In sintesi, allora, un

valore atteso è la somma pesata, sulla base della distribuzione della v.c., di una

opportuna trasformazione dei valori assunti dalla v.c. stessa.

35

B. Chiandotto - F. Cipollini

Versione 2003 - Cap. 2

Metodi Statistici per l’impresa

Ovviamente possiamo ottenere tanti momenti diversi a seconda della trasformazione

g(.) considerata. Nelle pagine che seguono vedremo che alcune trasformazioni hanno un

ruolo particolare in quanto possono essere interpretati in modo abbastanza semplice.

Prima di analizzare i momenti più importanti è però opportuno illustrare alcune

proprietà che valgono per i momenti in genere. Si evidenzia che tutte le proprietà che

enunceremo dipendono, come è ovvio, da quelle degli operatori

sostanzialmente si tratta delle proprietà delle somme, dato che

generalizzata” mentre

∫

∑

∑

e

∫:

è una “somma

è una “sommatoria nel continuo” [si invita lo studente a

rivedere le proprietà di questi due operatori!].

Valore atteso di una costante. Se g(X) = k costante, allora

E[g(X)] = E(k) = k.

In parole, questa proprietà può essere ricordata con la frase “il valore atteso di una

costante è uguale alla costante stessa”.

La verifica di tale proprietà è del tutto simile nei casi discreto e continuo ed pressoché

immediata ricordando che la sommatoria della funzione di massa e l’integrale della

funzione di densità sono sempre 1 (si veda sez. 0).

Nel discreto:

k

E(k) =

k

∑ k f(x ) = k ∑ f(x ) = k;

i

i=1

i

i=1

nel continuo:

b

b

a

a

E(k) = ∫ k f(x) dx = k ∫ f(x) dx = k.

Proprietà di omogeneità. Sia c è una costante, allora

E[c g(X)] = c E[g(X)].

In parole, questa proprietà può essere ricordata con la frase “il valore atteso di una

costante per g è uguale alla costante per il valore atteso di g”.

36

B. Chiandotto - F. Cipollini

Versione 2003 - Cap. 2

Metodi Statistici per l’impresa

Tale proprietà deriva da quella analoga di omogeneità di cui godono sia la sommatoria

che l’integrale: come si può verificare facilmente osservando i seguenti passaggi, sono

del tutto simili.

Nel discreto:

k

E[c g(X)] =

k

∑ c g(x ) f(x ) = c ∑g(x ) f(x ) = c E[g(X)];

i

i

i

i=1

i

i=1

nel continuo:

b

b

a

a

E[c g(X)] = ∫ c g(x) f(x) dx = c ∫ g(x) f(x) dx = c E[g(X)].

Proprietà di additività. Siano g1(.) e g2(.) due funzioni. Allora

E[g1(X) + g2(X)] = E[g1(X)] + E[g2(X)].

In parole tale proprietà può essere ricordata con la frase “il valore atteso di una somma è

uguale alla somma dei valori attesi”.

Tale proprietà deriva da quella analoga di additività di cui godono sia la sommatoria

che l’integrale.

Nel discreto:

k

E[g1(X) + g2(X)] =

k

k

∑ [g1(x ) + g2(x )] f(x ) = ∑g1(x ) f(x ) + ∑ g1(x ) f(x )

i

i

i=1

i

i

i=1

i

i

i

i=1

= E[g1(X)] + E[g2(X)];

nel continuo:

b

b

b

a

a

a

E[g1(X) + g2(X)] = ∫ [g1(x) + g2(x)] f(x) dx = ∫ g1(x) f(x) dx + ∫ g1(x) f(x) dx

= E[g1(X)] + E[g2(X)].

Le proprietà di omogeneità e di additività possono essere fuse in un’unica proprietà,

quella di linearità.

Proprietà di linearità. Siano c1 e c2 due costanti, g1(.) e g2(.) due funzioni. Allora

E[c1 g1(X) + c2 g2(X)] = c1 E[g1(X)] + c2 E[g2(X)].

37

B. Chiandotto - F. Cipollini

Versione 2003 - Cap. 2

Metodi Statistici per l’impresa

In parole tale proprietà può essere ricordata con la frase “il valore atteso di una

combinazione lineare è uguale alla combinazione lineare dei valori attesi”. [Lo studente

provi a dimostrarla direttamente servendosi delle proprietà della sommatoria e

dell’integrale]

Iniziamo adesso l’analisi dei principali momenti.

Momento r-mo dall’origine

Se si pone g(X) = Xr, per r = 0, 1, 2,..., si ottiene il momento r-mo dall’origine, definito

da

k r

∑ xi f ( xi ) nel discreto

µr = E(Xr) = bi =1

.

x r f ( x)dx nel continuo

∫

a

Per r = 0 si ottiene µ0, il momento dall’origine di ordine 0. Tale momento non è però

interessante, dato che risulta sempre uguale ad 1. Infatti µ0 = E(X0) = E(1) = 1,

ricordando che il valore atteso di una costante è la costante stessa.

Per r = 1 si ottiene µ1, il momento primo dall’origine:

µ1 = E(X).

Tale momento viene di solito chiamato valore atteso o media ed è spesso indicato con

µ. Il valore atteso E(X) è l’indice sintetico più utilizzato per mettere in evidenza quanto

c’è di tipico nella variabile casuale in quanto esprime il valore “intorno” al quale si

collocano i valori che la v.c. X assume.

Altri momenti di un certo interesse sono il momento secondo dall’origine

µ2 = E(X2),

il momento terzo dall’origine

µ3 = E(X3),

ed il momento quarto dall’origine

µ4 = E(X4)

38

B. Chiandotto - F. Cipollini

Versione 2003 - Cap. 2

Metodi Statistici per l’impresa

Momento r-mo centrale

Se si pone g(X) = (X – µ)r, per r = 0, 1, 2,..., dove µ = E(X), si ottiene il momento r-mo

centrale, definito da

k

r

∑ ( xi − µ ) f ( xi ) nel discreto

µ r = E[(X – µ)r] = ib=1

.

( x − µ )r f ( x)dx nel continuo

∫

a

Oltre a µ 0 , il momento centrale di ordine 0 (che risulta sempre 1 per gli stessi motivi di

µ0), non è interessante neppure µ1 , il momento centrale primo. Infatti questo risulta

sempre uguale a 0, come è facile verificare:

µ1 = E(X – µ) = E(X) – µ = µ – µ = 0.

La trasformazione g(X) = X – µ rappresenta una traslazione dell’origine nel punto medio

µ ed è spesso detta variabile scarto. Qualunque variabile casuale scarto ha, pertanto,

sempre valore atteso 0.

Per r = 2 si ottiene µ 2 , il momento primo dall’origine:

µ 2 = E[(X – µ)2].

Tale momento viene di solito chiamato varianza ed è spesso indicato con σ2, con V(X)

o con Var(X). Assume una particolare rilevanza in quanto è l’indice più utilizzato per

sintetizzare la variabilità di una variabile casuale. Si nota che la varianza σ2, può essere

ricavata anche a partire dai momenti dall’origine primo e secondo, secondo la relazione

σ2 = µ2 – µ2.

Questa proprietà, spesso “utile per fare i conti”, può essere verificata nel modo

seguente:

σ2 = µ 2 = E[(X – µ)2] = E[X2 + µ2 – 2µX] = E(X2) + µ2 – 2µE(X) = µ2 + µ2 – 2µ2 = µ2 – µ2