Claudio Pizzi

LEZIONI DI LOGICA DELLA PROVA

LEZIONE 1.

Il calcolo delle probabilità

Sembra che la nascita del calcolo delle probabilità sia stata in qualche misura

favorita dalla cosiddetta “piccola glaciazione”, un mutamento climatico

verificatosi in un arco di tempo che va dall'inizio del XIV secolo alla metà del

XIX secolo. In questo periodo venne registrato un raffreddamento del clima che

raggiunse il suo acme intorno al 1600 e cominciò a decrescere verso il 1800.

Non stupisce constatare che, nel periodo in cui grandi filosofi come Cartesio e

Bacone morivano per un’infreddatura, i pittori davano la preferenza a ritratti e

situazioni ambientate in interni. I nobili limitavano il tempo destinato alla

caccia e alle attività all’aria aperta, dedicando una buona parte del loro tempo

alle letture e ai giochi di società. Questi ultimi erano frequentemente giochi

d’azzardo con uso dei dadi, come il gioco della barca o quello del tric-trac. Di

solito si fa risalire la prima trattazione della probabilità a un libro di Girolamo

Cardano dedicato al gioco d’azzardo, il Liber de ludo aleae (scritto nel 1560, ma

pubblicato solo nel 1663) che contiene tra l’altro una sezione dedicata a metodi

per barare efficacemente.

Ma l’aneddotica vuole che il primo progresso memorabile in questi studi sia

stato originato da una serie di quesiti che il cavaliere de Méré pose all’austero

giansenista Blaise Pascal. Per esempio: “se lanciamo due dadi, quanti lanci sono

necessari per avere almeno il 50% di probabilità di ottenere due sei almeno una

volta”? Le risposte di Pascal, da lui discusse anche con Fermat, si trovano

pubblicate alla fine della Logique de Port Royal (1662). Il salto di qualità rispetto a

trattazioni precedenti fu che per la prima volta si cercava di trattare la nozione

di probabilità in modo astratto, cioè svincolato dal riferimento all soluzione di

specifici problemi. È anche degno di nota che Pascal considerasse la probabilità

applicabile alla valutazione delle prove giudiziarie, idea che venne sviluppata

da Leibniz nel suo Nova methodus discendae docendaeque jurisprudentiae (1667).

Nel 1655 Christian Huygens, dopo aver conosciuto il cavaliere de Méré a una

cena, venne a sapere di questi studi e se ne interessò al punto tale da pubblicare

nel 1657 il primo trattato conosciuto di calcolo delle probabilità, “De ratiociniis in

ludo aleae”. Per la prima volta viene introdotta una nozione che avrebbe avuto

fortuna, quella di speranza matematica. La speranza matematica o utilità attesa di

un singolo evento è il prodotto del guadagno sperato con il verificarsi

dell’evento per la probabilità che tale evento si verifichi. Nel caso di una

pluralità di esiti di un certo tipo di evento, la speranza matematica è la media

ponderata dei valori che si ottengono moltiplicando le probabilità dei vari esiti

per il guadagno sperato da ciascuno di essi. Per esempio, supponiamo di fare

una partita a testa e croce con un solo lancio di moneta, stipulando che se esce

testa si vincono €100 e se esce croce si vincono €0, cioè non si vince nulla.

L’utilità attesa del gioco è €50, ovvero la media tra vincite e perdite se

ponderate con le probabilità di queste . Infatti, stimando come 50% la

probabilità di entrambi gli esiti, la somma

100 • 0,5 + 0 • 0,5 =50

(cioè il guadagno di "testa" per la sua probabilità più il guadagno di "croce" per

la sua probabilità) dà come valore 50. Questo valore costituisce quello che

potremmo dire il costo del gioco: potremmo pensarlo anche come quanto si

deve rischiare per partecipare al gioco senza avere una perdita sicura in un

numero illimitatamente grande di lanci. (Si pensi che una serie di vincite e

perdite potrebbe essere 110,0,0, 100,100,0 ,100,0,0 ……)

Se la moneta fosse sbilanciata a valore di teste potremmo avere risultati

diversi,per esempio

( °)100 • 0,6 + 0 • 0,4 = 60

Si noti che il rapporto tra probabilità matematica e speranza matematica è

simmetrico, nel senso che conoscendo la speranza matematica di un singolo

evento e dell’evento opposto e anche il costo del gioco potremmo derivare la

probabilità. Per esempio dalla relazione (°) ponendo come valore incognito x la

probabilità di Teste e 1-x quello di Croce avremmo

(1) 100 • x + 0 • (1-x) = 60

(2) 100 • x + 0 = 60

(3) 100 • x = 60

(4) x= 60/100 = 0.6

La probabilità dell’uscita di testa quindi viene espressa come un rapporto tra il

costo del gioco (quanto si spende per partecipare) e il guadagno sperato dal

verificarsi di quello specifico evento. La conclusione suggerisce fortemente la

possibilità di definire la nozione di probabilità in termini di rapporti tra somme

di danaro, idea che è diventata quasi un luogo comune nella corrente

novecentesca nota come “soggettivista”. Se, per esempio, scommettendo sulla

vittoria di un cavallo rischio €50 con la prospettiva di vincerne 100, il rapporto

tra 50 e 100,ossia 50%, dà la misura del mio grado di fiducia nel verificarsi

dell’evento in questione; altrimenti detto, dà la misura del grado di probabilità

che soggettivamente associo a siffatto evento.

Per un altro verso, il concetto di media usato pure da Huygens non ha niente di

soggettivo in quanto viene impiegato in nozioni tipicamente statistiche come

quelle di “lunghezza di vita media”, “consumo medio di frutta”, “statura

media” ecc. Quando Huygens inaugurava queste ricerche la statistica muoveva i

suoi primi passi sull’onda degli interessi delle compagnie di assicurazione, alle

quali premeva conoscere con esattezza la speranza di vita dell’assicurato al

momento della stipula della polizza.

È degno di nota, come ha osservato Ian Hacking in “The Emergence of

Probability”, che la probabilità fin dall’inizio reca il marchio di una “dualità”

concettuale di fondo: da un lato è interpretabile come di grado di credenza

soggettiva, dall’altro si lasci rappresentare come una misura di frequenze

statistiche oggettive (chance). Lo stesso Pascal mostrava una certa ambivalenza

nel momento in cui da un lato studiava statisticamente le distribuzioni di

risultati nei giochi di azzardo, ma dall’altro usava il celebre argomento della

scommessa per mostrare la razionalità della disposizione a credere in Dio.

Inoltre, in tema di probabilità statistica o “oggettiva”, va subito considerato

che questa va distinta dalla probabilità teorica dell’evento a cui si riferisce. Il

modo in cui va determinata la probabilità teorica, come vedremo, è oggetto di

discussione filosofica: per ora possiamo dire che è quella che si può stabilire a

piori in base a una considerazione idealizzata delle proprietà dell’oggetto in

questione. Se la probabilità teorica p dell’uscita di testa è, poniamo, 1/2, le

percentuali di testa m che vengono effettivamente osservate dopo un certo

numero di lanci n, espresse dalla frazione m/n,possono essere inferiori, superiori

o uguali a 1/2.

La differenza in valore assoluto tra frequenza osservata m/n e p, |m/n - p|, è

detta scarto e le sue proprietà sono stata oggetto di uno studio matematico

rigoroso. Il famoso teorema di Bernoulli, detto anche legge debole dei grandi

numeri, asserisce che con l’aumentare del numero n di esperimenti aumenta la

probabilità che lo scarto diventi più piccolo di un qualsiasi numero positivo ε è

preso piccolo a piacere1. In parole povere, con l’aumentare degli esperimenti è

sempre più probabile che lo scarto diventi sempre più piccolo.

1

In formula

lim Pr [|m/n - p| < ε ] = 1

n→∞

Si noti che il teorema consiste in un asserto probabilistico circa i rapporti tra

probabilità teoriche e frequenze. Contrariamente a quanto molti sono inclini a

pensare, la proposizione non asserisce che nella realtà le frequenze a lungo

andare tendono alle probabilità teoriche. Questo secondo asserto non è una

proposizione matematica - viene a volte chiamato Postulato empirico del caso- e

descrive una genuina proprietà del nostro mondo reale, che è quella di

presentare una persistente uniformità spazio-temporale delle manifestazioni

fenomeniche. Grazie a tale uniformità della natura, di fatto, le frequenze

osservate tendono a convergere a lungo andare verso la probabilità teorica.

I nomi più importanti da ricordare negli sviluppi del calcolo delle probabilità

tra il 600 e l’ 800 sono quello di Leibniz – che, incidentalmente, essendo laureato

in legge era interessato ad applicare il calcolo alla valutazione delle prove – e

quelli di De Moivre, di Bernoulli e di Laplace . Inoltre vanno ricordati Thomas

Simpson e Carl Friedrich Gauss (che posero le basi della cosiddetta teoria

degli errori).

Già agli inizi del 700 era chiaro che il calcolo comunque si appoggiava a due

regole di calcolo fondamentali, che vennero considerate veri e propri principi

basilari fino a raggiungere la loro forma definitiva nell’ assiomatizzazione

insiemistica formulata da A. Kolmogorov (1932). Ne parleremo come di

Principio delle Probabilità Totali e delle Probabilità Composte: il primo

utilizzabile per sommare probabilità, il secondo per moltiplicare probabilità.

Siano E1 ed E2 due eventi (es. E1:piove, E2:tira vento) , E1 E2 la loro unione

(piove oppure tira vento), E1 E2 la loro intersezione (piove e tira vento) –E1 il

complemento di E1 (non piove). Queste entità sono da intendere come insiemi,

e precisamente come insiemi di casi in cui si verifica un certo evento. Volendo

intendere queste grandezze come proposizioni, si preferisce usare un’altra

notazione , cioè E1 E2, E1 E2, ¬E1.

Pr sia una funzione che associa ad ogni evento un numero razionale o

irrazionale tra 0 e 1 (funzione di probabilità): questo si esprime dicendo che, per

ogni eventi Ei,

0 < Pr(Ei) < 1

Dato che –Ei indica il complemento di Ei (per esempio “non piove” rispetto a

“piove”) nessun evento può avere probabilità maggiore dell’ evento tautologico

Ei –Ei (es. piove o non piove).Quindi Pr (Ei -Ei )=1 .

Fatte queste premesse, il principio delle probabilità totali asserisce questo:

(PT)

Pr (E1 E2) = Pr E1 + Pr E2 – Pr(E1 E2)

Per calcolare il valore sulla sinistra bisogna conoscere i valori di input che si

trovano sulla destra, che sono le c.d. “probabilità iniziali”.. Nel caso del nostro

esempio è difficile determinare la probabilità che piova, che tiri vento o che

piova e tiri vento insieme, a

meno di ricorrere a qualche statistica

metoreologica. Ma altri esempi sono meno difficoltosi perché possiamo ricorrere

a valutazioni “a priori” : per esempio pochi troveranno da ridire sul fatto che

in un mazzo di 52 carte non truccato la probabilità di sorteggiare un asso è 1/13

e quella di sorteggiare una carta di picche è 1/4. Se le cose stanno così, qual è la

probabilità di sorteggiare un asso o una carta di picche?

Risposta. La probabilità richiesta è la probabilità di sorteggiare un asso (1/13)

+ la probabilità di sorteggiare una carta di picche (1/4) meno la probabilità di

sorteggiare una asso di picche (1/52). Quindi (1/13 + ¼) – 1/52 = (4/52+ 13/52)

– 1/52 = 16/52=0,3076923.

Se gli eventi E1 ed E2 sono incompatibili questa proprietà semplifica il calcolo

perché (Pr(E1 E2)= 0. In particolare, se E2 è –E1, avremo

Pr (E1 -E1) = Pr (E1) + Pr(-E1)

oppure, dato che Pr (E1 -E1) =1

1 = Pr (E1) + Pr(-E1).

Da ciò naturalmente segue

Pr(-E1) = 1 – Pr(E1)

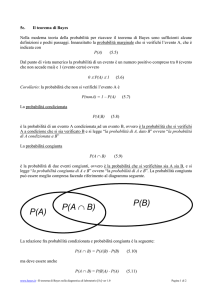

Il Principio delle probabilità composte invece consente di calcolare le

probabilità di eventi congiunti. Indichiamo con Pr(B|A) la probabilità di B dato

A (detta probabilità subordinata o condizionata).Allora il principio asserisce

questo:

(PC)

Pr(A B) = Pr(A) • Pr(B|A)

Dato che A B = B A, vale però anche

(PC*)

Pr(A B) = Pr(B) • Pr(A|B)

Pr(B|A) = Pr(B) significa che i due eventi sono indipendenti, o in altre parole

che A non influenza B e B non influenza A. Se vale l’indipendenza tra A e B,

però, la formula PC si riduce a

(PC**) Pr(A B) = Pr(A) • Pr(B)

Esempio1: Qual è la probabilità che in un lancio di due dadi

escano due 3? Pr E1= 1/6, Pr(E2) = 1/6, Pr(E2|E1)=1/6 (perché i due eventi

sono indipendenti): quindi Pr(E1 E2) = 1/6 • 1/6 = 1/36

Esempio 2: La probabilità che c’è maltempo (M) e la probabilità che piova (P)

non sono indipendenti, anzi la pioggia implica il maltempo! Quindi Pr(M|P) =1.

Quindi la probabilità che piova e ci sia maltempo è uguale a Pr(P) • Pr(M|P) =

Pr(P) •1 =Pr(P).

Dal principio delle probabilità composte seguono alcune conseguenze

interessanti.

La prima è che la nozione di probabilità condizionata o subordinata risulta

definibile in termini di probabilità assoluta. Infatti da

(PC)

Pr(A B) = Pr(A) • Pr(B |A)

abbiamo

(ProbC)

Pr(B|A) = Pr(A B) /Pr(A)

(se Pr(A) ≠ 0)

Questo non va confuso con

(ProbC*)

Pr(A|B) = Pr(A B)/Pr(B)

(se Pr(B)=/0)

da cui

(PC*) Pr(A B) = Pr(B) • Pr(A|B)

Facendo una semplice sostituzione in ProbC abbiamo,Abbiamo, per PC*,

(TB) Pr(B|A) = Pr(B) • Pr(A|B)

(se Pr(A) ≠0)

Pr(A)

Questa formula si può trasformare in formule equivalenti più complesse. Se -B

è un’ipotesi alternativa incompatibile con B (p.es. “pari” e “dispari”), abbiamo

ovviamente per il principio delle probabilità composte

Pr(A -B) = Pr(-B) • Pr(A|-B)

Ora osserviamo che ,per la teoria degli insiemi, A = (A B) (A -B), come

si vede da una semplice diagrammazione.

Si noti ora che il denominatore della frazione in TB è equivalente a

Pr ((A B) (A -B)). Questo per il teorema delle probabilità totali,equivale,

essendo incompatibili i due eventi A B e A -B, alla somma Pr(-B) • Pr(A|B) + Pr( B) • Pr(A|B). In tal caso la formula TB prende la forma più complessa

(TB*) Pr(B|A) = ____Pr(B) • Pr(A|B)

(se Pr(A) ≠0)

Pr(-B) • Pr(A|-B) + Pr( B) • Pr(A|B).

Ovviamente, se le ipotesi incompatibili sono non solo due ma n (B1...Bn), la

formula TB* si può generalizzare a n ipotesi.

TB (TB*) è importante teorema, noto come teorema di Bayes, considerato un

pilastro del calcolo delle probabilità. Il suo nome deriva a dal matematico che

ne diede la prima formulazione in un saggio pubblicato postumo nel 1763 (in

realtà, Bayes era un reverendo presbiteriano nato nel 1702 e morto nel 1761) .

Secondo un luogo comune, Il Teorema di Bayes ha per il calcolo della

probabilità la stessa importanza che ha il teorema di Pitagora per la geometria.

Conoscendo o assumendo i valori di Pr(B) e Pr(A), infatti, è possibile calcolare la

probabilità di B dato A in termini della probabilità inversa di A dato B, che

viene talvolta chiamata verosimiglianza (likelyhood). È quindi possibile calcolare

la probabilità della causa dato l’effetto, o dell’ipotesi esplicativa (explanans) dato

l’ explanandum, una volta che sia nota la probabilità dell’effetto data la causa o

dell’explanandum dato l’explanans.

La funzione di probabilità in effetti è solo una speciale funzione di misura. Le

grandezze misurate sono nella fattispecie le dimensioni di classi di punti dello

spazio-tempo : la classe totale di punti (quella in cui sono vere le tautologie) ha

probabilità 1, la classe vuota (in cui sono vere le contraddizioni) ha probabilità

0. Gli eventi contingenti hanno probabilità intermedie tra 0 e 1. Il calcolo delle

probabilità non è altro che un insieme di metodi per calcolare le misure di

eventi complessi partendo dalle misure di eventi più semplici. Si tratta dunque

semplicemente di un meccanismo input-output che, dati certi valori in ingresso,

produce altri valori in uscita. Questo ci pone di fronte a un problema che il

calcolo in quanto tale non è in grado di risolvere. Per quanti calcoli si possano

fare, dobbiamo sempre prendere le mosse da un input costituito da certi valori

probabilistici iniziali, i quali non si possono a loro volta calcolare da altri valori

probabilistici.

Il problema delle probabilità iniziali non ha risposte di tipo matematico. La

sua soluzione dipende da assunzioni filosofiche ben precise circa la nozione

stessa di probabilità. A seconda della risposta che viene data, cambiano i critieri

di assegnazione dei valori di input, il che può avere conseguenze considerevoli

anche sulle applicazioni del calcolo. È inevitabile quindi esaminare le alternative

elaborate dai filosofi per rispondere a questa basilare e difficile domanda: che

cosa è la probabilità?

Curiosità probabilistiche.

A) Se la probabilità di avere un figlio maschio dato che si hanno già avuti due

figli maschi è ½, qual è la probabilità di avere tre figli maschi in fila? La risposta

è 1/3 ● 1/3●1/3, cioè 1/8. Si noti che qualunque successione di maschi e

femmine in un qualsiasi ordine dà sempre come probabilità 1/8. A parità di

ragionamento , qualunque successione di uscite di numeri rossi e neri alla

roulette (ignorando lo zero, che è verde) ha sempre la stessa probabilità di

qualsiasi altra sequenza ordinata di uscite della stessa lunghezza.

Attenzione però. Dato che gli eventi sopra esemplificati sono indipendenti, la

domanda “qual è la probabilità di avere un figlio maschio dato che si sono già

avuti due figli mschi non è 1/8 ma ½. Analogamente, la probabilità che esca un

numero rosso dato che sono usciti 10 numeri neri è sempre invariabilmente ½.

B) L'autorevole ginecologo Robert Winston, esperto nei problemi della fertilità,

ha immaginato che un medico privo di scrupoli potrebbe pubblicare su un

quotidiano la seguente inserzione, rivolta ai coniugi desiderosi di avere un figlio

maschio :«Dietro invio di 500 sterline, riceverete da me la ricetta infallibile per

avere un maschio. Soddisfatti o rimborsati». Il rimborso ha lo scopo

naturalmente di garantire l'affidabilità del metodo. La ricetta può essere una

qualsiasi pillola di zucchero colorata. In tal modo egli può incassare, poniamo,

su 1000 adesioni, 500.000 sterline. Poiché il 50% dei neonati sono in ogni caso

maschi, egli dovrà rimborsare al rimanente 50% un totale di 250.000 sterline, con

un guadagno netto di 250.000 sterline. Anzi, per ogni femmina nata egli

potrebbe tranquillamente aggiungere altre 250 sterline alle 500 rimborsate e

guadagnare comunque nel lungo periodo una somma di tutto rispetto.

.

3). Per dimostrare l’esistenza di doti paranormali in qualche soggetto presente

nel pubblico potete procedere come racconta Richard Dawkins. «Prima di tutto

vediamo se il sensitivo si trova nella metà destra o nella metà sinistra della sala»

esordii. Quindi invitai la gente ad alzarsi e pregai il mio assistente di lanciare

una moneta. A tutte le persone sul lato sinistro della sala fu chiesto di «volere»

che venisse fuori testa, a tutte quelle sul lato destro di «volere» che venisse fuori

croce. Ovviamente uno dei due schieramenti perse, e venne invitato a sedersi.

Quelli che erano rimasti in piedi furono divisi in due: metà che «volevano» che

uscisse testa e metà che «volevano» che uscisse croce. Ancora una volta i

perdenti furono fatti sedere e ancora una volta si procedette a dividere i

vincenti, finché, dopo sette o otto lanci di monetina, com'era inevitabile, rimase

in piedi una sola persona. «Un grande applauso per il nostro sensitivo!»

esclamai. Non era forse un sensitivo uno che era riuscito a «influenzare» la

moneta

otto

volte

di

seguito?

4)-La probabilità che due persone scelte a caso abbiano lo stesso compleanno,

sulla base di considerazioni sia a priori che a posteriori,

è

1/365

Ora prendiamo una stanza in cui siano presenti solo 23 individui: i

matematici possono dimostrare che vi sono più di 50 probabilità su cento che

almeno due di essi siano nati lo stesso giorno. Lasciamo perdere gli anni

bisestili, che complicano inutilmente le cose, e supponiamo che scommetta con

voi che delle 23 persone presenti, come minimo due siano nate lo stesso giorno.

Tanto per stare al gioco,voi scommettete che non ci siano compleanni comuni.

Faremo il calcolo in modo da arrivare ai 23 individui gradualmente:

cominceremo da uno solo e aggiungeremo gli altri uno alla volta. Se a un certo

punto troveremo un «gemello», io avrò vinto la scommessa, smetteremo di

giocare e non staremo a curarci dei rimanenti individui. Se invece arriveremo al

ventitreesimo senza avere trovato il «gemello», a vincere sarete

voi.

Quando nella stanza c'è solo il primo soggetto, che chiameremo A, le

probabilità che non vi sia alcun «gemello» sono, banalmente, pari a 1 (365

probabilità su 365). Aggiungiamo adesso il soggetto B: le probabilità diventano

1 su 365, quindi le probabilità che non vi siano «gemelli» sono 364/365.

Facciamo entrare ora una terza persona, C: vi sono 1 probabilità su 365 che C sia

nato lo stesso giorno di A e 1 su 365 che sia nato lo stesso giorno di B, sicché le

probabilità che non sia «gemello» né di A né di B sono 363/365, (non può essere

«gemello» di entrambi, perché sappiamo già che A e B non sono nati lo stesso

giorno). Per sapere quali siano complessivamente le probabilità che non si

verifichi un «gemellaggio», dobbiamo prendere 363/365 e moltiplicarlo per le

probabilità che non si sia verificato

un gemellaggio nel caso (o nei casi)

precedenti, ovvero, nell'esempio specifico, moltiplicarlo per 364/365.2 Lo stesso

ragionamento vale quando aggiungiamo la quarta persona, D. Le probabilità

totali che non vi siano «gemelli» diventano 364/365 ● 363/365 ● 362/365. E così

via, finché nella stanza non abbiamo 23 persone. Ogni nuova persona ci porta

un nuovo termine da aggiungere alle moltiplicazioni da fare per calcolare le

probabilità che il «gemello» non si presenti. Se si procede con tali

moltiplicazioni fino ad avere 23 termini (l'ultimo dei quali sarà 343/365), l'esito

sarà 0,49: ed è questa la probabilità che non vi siano nella stanza individui nati

2

Per chiarire questo punto notiamo che aggiungendo via via i soggetti al primo della serie avremo per la sequenza di

probabilità di gemelli i valori

A

AB

0,

1/365,

AB-C

2/365, …..

Mentre per quella di non -gemelli avremo

1, 364/365,

363/365●364/365 …

→ 0,49

Perché il terzo valore della seconda serie non è il complemento del terzo valore della prima serie? Se C è gemello di A o

B , significa che C è gemello di A o gemello di B (non di ambedue perché avremmo già chiuso il gioco), per cui si applica

il teorema delle probabilità totali e si sommano le ripsettive probabilità. Ma questo non vale per la non-gemellarità. In

questo

caso

dobbiamo

calcolare

la

probabilità

che

C

non

sia

gemello

né di A né di B e anche la probabilità che A e B non siano gemelli tra loro: per questo calcolo si ricorre al teorema delle

probabilità composte.

lo stesso giorno. Vi sono quindi probabilità lievemente superiori al 50 per cento

(0,51) che almeno due persone in una compagnia di 23 siano «gemelle».

Basandosi sull'intuizione, la maggior parte della gente scommetterebbe contro il

«gemellaggio», ma sbaglierebbe. È proprio questo il tipo di errore intuitivo che

ci induce a considerare arcane coincidenze che sono normalissime.

4) Paradosso della lotteria (H.Kyburg, 1961). Supponiamo ci sia una lotteria

con un milione di biglietti, uno solo dei quali sarà vincente. Comprando un

biglietto si ha la certezza pratica di perdere (stante che la certezza pratica è data

da 1- ε). Così chiunque compri un biglietto ha la stessa certezza pratica. È

dunque razionale accettare la conclusione che nessun biglietto vincerà, mentre si

sa che certezza che qualche biglietto vincerà. Questo paradosso, escogitato da

Henry Kyburg, mira a evidenziare le difficoltà del concetto di accettazione

razionale: Infatti appaiono consistenti questi tre principi:

i) è razionale accettare una proposizione che è molto probabilmente vera

ii)non è razionale accettare una proposizione inconsistente (autocontraddittoria)

iii)se è razionale accettare A e accettare A’, è razionale accettare A e A’. (Nel

caso dell’esempio: se è razionale accettare che la perdita di Tizio è praticamente

certa e che la perdita di Caio è praticamente certa, allora è praticamente certa la

perdita di Tizio e Caio).

Di questi tre principi, è il terzo ad essere più critico, ed infatti è stato lo

stesso Kyburg a proporre la sua rimozione.

LEZIONE 2. Concezioni della probabilità

La più semplice e intuitiva definizione di probabilità è ancor oggi quella

chiamata “classica”, la cui formulazione si deve al sommo astronomo Pierre

Simon de Laplace (1742-1826), detto il “Newton francese”. Secondo la

concezione laplaceana, la probabilità di un evento E è il rapporto tra i casi

favorevoli al v erificarsi di E e i casi possibili, purchè egualmente possibili.

Se, per esempio, mi chiedo qual è la probabilità di estrarre un numero pari al

lotto sulla ruota di Milano con una sola estrazione, i passi da fare per

determinare questo valore sono i seguenti : (1) osservare che i casi possibili sono

90 (2) osservare che tali casi sono equipossibili (3) osservare che le possibilità di

estrarre un numeri pari entro le 90 possibilità sono 45, quindi i casi favorevoli

sono 45. La risposta è data dunque dal rapporto tra 45 e 90, ossia 0,5.

Se i casi non sono equipossibili la risposta non può essere data. Se, per

esempio, mi chiedo qual è la probabilità che un certo aereo cada nella prossima

settimana, i casi possibili sono due (cade/non cade), ma fortunatamente in

condizioni normali non c‘è motivo di considerarli equipossibili.

La clausola della equipossibilità è una fonte di dubbi filosofici. Se

equipossibile vuol dire “equiprobabile” la definizione complessiva diventa

circolare perché si definisce la probabilità in termini di probabilità. La soluzione

è offerta dal cosiddetto “principio di indifferenza” o di “ragione insufficiente”: sono

probabilisticamente uguali quelle alternative per le quali non abbiamo motivo

di attenderci il verificarsi dell’una piuttosto che dell’altra.

È degno di nota che Laplace intendesse estendere l’impiego del calcolo delle

probabilità dal dominio dei fatti naturali a quello dei fatti umano -sociali,

compresa la probabilità delle testimonianze nei processi e delle sentenze nei

tribunali. Da questo punto di vista egli seguiva una linea di riflessione già

avviata da Leibniz, che prima di darsi alla filosofia aveva praticato studi di

giurisprudenza.

La fiducia di Laplace nel meccanicismo newtoniano e nell’infallibile

determinismo che lui riteneva ad esso connaturato è espresso dalla brillante

metafora del “demone di Laplace”: un demone onnisciente che conosca con

esattezza al momento attuale la posizione e la velocità di ogni particella è in

grado di predire con precisione assoluta tutti gli eventi futuri e retrodire tutti gli

eventi passati. Nella mente del demone di Laplace non esistono incertezze. La

probabilità è in effetti il prodotto della nostra ignoranza, che ci distingue dalla

condizione divina : “parlando rigorosamente, quasi tutte le nostre conoscenze

non sono che probabili: e anche quelle pochissime che stimiamo certe, persino

nelle scienze matematiche, si sono date dall’induzione e dall’analogia che,

strumenti principali per giungere alla verità, si fondano sulle probabilità “. Così

egli scrive nella prima pagina del celebre “Saggio filosofico sulle probabilità”.

Come è noto, la possibilità dell’esistenza di un demone di Laplace è negata dal

principio di indeterminazione di Heisenberg e più generalmente dalla

meccanica quantistica, che esclude che sia possibile misurare con precisione

illimitata posizione e velocità di ogni particella (per tacere di altre coppie di

proprietà dette “coniugate”). Di fatto gli eventi singoli sono imprevedibili anche

in fenomeni caotici con alto grado di complessità. L’urto di milioni di molecole

in un millimetro cubo di gas rende di fatto imprevedibile la loro posizione 1

secondo dopo che la posizione di tutte fosse stata accertata con esattezza. Anche

se in teoria un demone laplaceano potrebbe in teoria prevedere la posizione di

tutte le molecole, da un punto di vista pratico non c’è differenza tra

l’indeterminazione dei fenomeni quantistici e dei fenomeni prodotti dal caos

deterministico.

Secondo la concezione classica la determinazione delle probabilità è una

procedura aprioristica, o in altri termini non dipende da informazioni derivate

dall’esperienza. In quanto tale ha tutti i numeri per essere mal vista dagli

empiristi, secondo i quali ogni conoscenza genuina deve provenire

dall’esperienza stessa. A parte i pregiudizi filosofici, l’ idea di basare la

conoscenza non sull’esperienza vissuta ma sull’ignoranza di qualcosa è una

fonte di difficoltà e di paradossi.

Supponiamo per esempio che una persona che estrae una pallina da un’urna a

sappia che l’urna a contiene un numero uguale di palline bianche e nere,

mentre tutto ciò che sa circa l’urna b è che contiene palline bianche e nere, senza

conoscere la composizione dell’urna. Secondo il principio di indifferenza,

questa persona in ambedue i casi deve assegnare ½ all’estrazione di una biglia

bianca (o nera), mentre è chiaro che nei due casi il grado di incertezza è

differente.

A parte questa riserva di indole filosofica, bisogna ammettere che

l’applicazione della teoria laplaceana è spesso problematica al di fuori del caso

dei giochi d’azzardo. Alcune difficoltà dipendono dal fatto che è arduo

enumerare tutte le alternative possibili entro un dato esperimento,e ancora più

difficile dire se esse sono equipossibili nel senso descritto dal principio di

indifferenza. Fa capolino qui il fastidioso germe del soggettivismo: soggetti

diversi possono avere informazioni diverse circa le alternative, cosicchè le

alternative che appaiono indifferenti ad uno possono apparire differenti a

qualcun altro.

A ciò vanno aggiunte difficoltà di natura squisitamente matematica, come i

c.d. “paradossi di Bertrand”. Esempio. Supponiamo di sapere che un’auto ha

impiegato un tempo compreso tra 1 e 2 minuti (quindi tra 60 e 120 secondi) per

percorrere 1 Km. Diremo che per noi è indifferente la stima di 60-90 secondi e

quella di 90-120 secondi, quindi la probabilità che la lunghezza del viaggio

appartenesse al primo intervallo è uguale a quella che appartenesse al secondo.

Veniamo poi a sapere che la velocità media della macchina era compresa tra i 30

e i 60 Km/h. Applicando il principio di indifferenza, quindi, per noi la

probabilità che viaggiasse tra 30 e 45 km/h è la stessa che viaggiasse tra i 45 e i

60 km/h. Ora il valor medio della prima stima è di 90 secondi, cioè 1 minuto e

½, per 1 Km di percorso, e dovrebbe corrispondere al secondo valor medio, cioè

45 km/h. Ma così non è: se una macchina impiega 90 secondi per percorrere 1

Km vuol dire che in un’ora, cioè in 3600 secondi, percorrerà 40 Km, non 45 Km

!

John Maynard Keynes nel suo Treatise of Probabilities ha enumerato un’ampia

classe di problemi inerenti al principio di indifferenza, evidenziando che molte

difficoltà sono prodotte da aspetti matematici, ma anche da aspetti linguistici.

Se, per esempio, in una libreria buia mi chiedo qual è la probabilità di toccare un

libro nero, posso dire che in condizioni di ignoranza le alternative che mi sono

indifferenti sono due (nero/non nero), e in questo caso la probabilità verrà posta

uguale a ½. Me se tengo conto del fatto che i colori dell’iride sono 7, allora tale

probabilità è 1/7. Per cui ½=1/7, il che è assurdo.

A queste difficoltà concettuali si sommano difficoltà di indole pratica. Di fatto,

nel quadro classico l’applicazione del calcolo della probabilità sarebbe

giustificata solo nei casi in cui si danno alternative equipossibili, o presunte tali.

Per un laplaceano ortodosso non avrebbe senso chiedersi, poniamo, qual è la

probabilità di restare avvelenati mangiando un fungo o quella di morire sotto i

ferri di una certa operazione chirurgica perché le alternative da esaminare non

sono equipossibili - anzi è da notare che è proprio la bassa probabilità

dell’alternativa infausta che rende interessante la domanda, in quanto ci fa

valutare se vale la pena di correre o non correre il rischio ad essa connesso.

Secondo Keynes ed altri che hanno tentato di modernizzare la concezione

classica, nei casi in cui i calcoli numerici non sono applicabili possiamo sempre

ricorrere a valutazioni di tipo qualitativo in modo da poter dire, poniamo, che

un’alternativa è più probabile di un’altra e ambedue sono più probabili di una

terza.

Ma la nascita della statistica alla fine del ‘700 e il diffondersi della mentalità

empiristica, per la quale non esistono conoscenze a priori (e nemmeno sintetiche

a priori, con buona pace dei kantiani), spingeva verso una definizione

oggettiva o statistica della probabilità. Per l’800 vanno ricordati i nomi di R. Ellis

e J.Venn, per il ‘900 quelli di R.von Mises e H.Reichenbach, che vengono spesso

accomunati sotto la denominazione di frequentisti.

Da un punto di vista strettamente empirista, l’affermazione che le varie

alternative, per esempio nel lancio di un dado, sono equipossibili, ha un senso

solo se si può provare sperimentalmente che il dado in questione non è stato

truccato e che non presenta asimmetrie tali da favorire qualcuna delle facce a

scapito delle altre. Di fatto, l’unico modo per raggiungere la certezza

dell’equipossibilità sta nel lanciare il dado in questione un numero illimitato di

volte, verificando che le percentuali di uscite di tutte le facce “tendono”, a lungo

andare, ad essere uguali. Con ciò però si compie un salto dal finito all’infinito

che mal si concilia con l’oggettività sperimentale richiesta dagli empiristi.

Secondo Ellis questo ricorso a una serie infinita di esperimenti, cioè a qualcosa

di non sperimentabile in linea di principio, è un’ idealizzazione che si giustifica

come tutte le altre idealizzazioni impiegate nella scienza (p.es. quando si

immagina il movimento di un corpo su un piano senza attrito). Venn chiamava

serie queste successioni in cui le fluttuazioni di frequenze registrate a un certo

punto si stabilizzano e convergono verso un valore che si può considerare il

limite della serie stessa.

Il passo successivo, che poi verrà perfezionato da von Mises, è quello di

identificare questo limite con la probabilità del tipo di evento in questione (non,

si badi, del singolo evento, dato che la probabilità riguarda classi di eventi dello

stesso tipo). Si noti che, ovviamente, il limite di cui si parla qui è diverso da ciò

che in matematica si chiama limite delle successioni numeriche convergenti,

dato che quest’ ultimo si può calcolare rigorosamente con metodi matematici.

Nelle successioni empiriche un calcolo di questo genere è impossibile. Anzi, a

rigore, non si ha neppure la certezza che il limite cercato esiste, perché non c’è

contraddizione nel ritenere che la parte sconosciuta della serie abbia proprietà

diverse da quella conosciuta. Più generalmente, estraendo un campione da un

universo di dimensioni illimitate, non abbiamo nessuna garanzia che le

proprietà riscontrate nel campione siano le stesse presenti nell’universo. Ma

questo è il vecchio problema dell’Uniformità della Natura. Non c’è una garanzia

logica che il futuro di una successione di eventi sarà uguale al passato, anche se

è perfettamente irragionevole supporre il contrario.

Von Mises divenne un esponente di spicco del circolo di Berlino, nato alla fine

degli anni 20 per gemmazione del circolo di Vienna. L’idea basilare è che si

parla di probabilità quando, ipotizzando entro un certo “collettivo” (insieme

di eventi o dati dello stesso genere) si ha ragione di pensare che le frequenze

osservate, se protratte illlimitatamente, tendano verso un limite. Von Mises non

tardava tuttavia a rendersi conto che, perché si possa calcolare la probabilità,

non tutti i collettivi si prestano al calcolo del limite. Una successione di pietre

miliari che presenti delle pietre bianche ogni cento metri e una pietra rossa

ogni chilometro rende facile calcolare che la probabilità di trovare una pietra

rossa è 1/10, ma non ha molto senso parlare di probabilità di un risultato che è

prevedibile, e quindi necessario, in quanto costruito esattamente con quello

scopo. Se, per ipotesi, si togliessero dalla successione tutte le pietre che si

trovano al 10° posto, la probabilità di incontrare pietre rosse scenderebbe dal

10% a 0, il che fa pensare che la successione in oggetto sia priva di una qualità

essenziale per stabilire il limite delle frequenze osservate, quella di essere

irregolare o randomizzata. Von Mises ha cercato di definire con grande

accuratezza la nozione di collettivo irregolare, puntando sull’idea che un

collettivo è irregolare quando il limite stimato è insensibile alle scelte di posto

effettuate secondo qualche regola prefissata (per esempio, risulta lo stesso entro

le sottosuccessioni determinata dalla scelta dei posti pari).

Nonostante questo importante contributo matematico, che lo ha portato a

definire anche operazioni su collettivi, von Mises non ha potuto evitare che la

sua teoria andasse incontro a banalizzazioni. A meno che non si definisca

rigorosamente il concetto di regola, si può trovare sempre una regola stramba

che genera un sottosuccessione tale da modificare il valore del limite. Più in

generale, come avevano già osservato Schlick e Wittgenstein, data qualsiasi

successione di numeri, per quanto bislacca, troviamo sempre una regola che

concorda con la successione (si tratta di un paradosso a volta indicato come

“paradosso di Wittgenstein”). Finora non si è trovata nessuna regola intuitiva

che governi i decimali di p-greco (3,14…), ma non c’è nessun problema a trovare

una regola abnorme a cui si adegua la successione.

Lo stesso discorso che si fa per le regole si fa anche per predicati qualsiasi. Il

ragionamento induttivo, come è noto, consiste nel riscontrare nel campione una

certa proprietà e proiettarla sull’universo: per esempio dopo aver osservato un

campione di smeraldi solo verdi inferiamo che tutti gli smeraldi sono verdi. Ma

allo stesso modo in cui ci regole abnormi ci sono anche predicati abnormi,

come ravvisato da N.Goodman nel c.d. “paradosso del grue-bleen”. Il

predicato “verde ed esaminato prima del 3000” implica un predicato bizzarro

ma perfettamente legittimo come “verde ed esaminato prima del 3000 oppure

blu ed esaminato dopo il 3000”(grue o verdlù) . Si noti però che se è vero che tutti

gli smeraldi sono verdlù, questa è una disgiunzione in cui il primo disgiunto

risulta falso dopo il 3000, per cui dopo tale data il secondo disgiunto risulta

necessariamente vero.

Con ciò non si fa altro che ribadire che l’uniformità della natura non è

giustificata né da ragionamenti deduttivi né da ragionamenti induttivi: infatti

così si fa vedere che non c’è nessuna contraddizione logica nel pensare che gli

smeraldi nel 3000 si trasformino da verdi in blu.

Von Mises vedeva nella meccanica quantistica lo sbocco naturale della sua

teoria dei collettivi, ma trascurava il fatto che in meccanica quantistica si parla

di probabilità di eventi singoli (p.es. la probabilità che un atomo isolato si trovi

in una certa condizione) e non di tipi di eventi, come richiesto dalla sua versione

del frequentismo.

Hans Reichenbach ha fatto vedere che si può, comunque, definire la

probabilità come limite delle frequenze lasciando cadere le restrizioni poste da

von Mises. Abbandonando la nozione di collettivo, Reichenbach chiede, in

primo lugo, che quella che lui chiama classe di riferimento (quella, cioè, entro cui

vengono rilevate le frequenze) oltre ad essere illimitatamente grande sia

formata da elementi che sono simili per aspetti rilevanti a quelli dell’elemento che

ha l’attributo di cui intendiamo calcolare la probabilità. Per fare un esempio, se

voglio sapere qual è la probabilità che il Sig. Rossi abbia un incidente

automobilistico, sceglierò una classe di riferimento costituita, in primo luogo, da

elementi che siano soggetti al rischio di avere un incidente automobilistico.

Escluderò pietre, gatti, pappagalli e mi atterrò a soggetti umani, anzi a simili a

Rossi per aspetti importanti: escluderò pertanto soggetti a lui simili per avere

calzini blu (perché l’avere calzini blu piuttosto che di altro colore è irrilevante

per l’attributo) oppure per il fatto che come lui leggono libri gialli. Viceversa la

classe di riferimento dovrà contenere soggetti, per esempio, che siano simili a lui

per il sesso, per l’età e per il tipo di macchina che possiedono.

Secondariamente, la frequenza dell’attributo riscontrata nella classe di

riferimento deve essere la stessa anche in tutte le sue sottoclassi di questa.

Nella terminologia di Reichenbach la classe di riferimento deve essere omogenea,

cioè che sia insensibile, nel rilevamento delle frequenze, rispetto a partizioni

operate secondo qualche attributo che influenzi la frequenza dell’attributo in

questione (nell’esempio “avere incidenti automobilistici”) . Non compariranno,

quindi, nella classe dell’ esempio, soggetti che sono proprietari di macchine le

quali, pur essendo della stessa marca di quella di Rossi, abbiano un difetto ai

freni, perché nella sottoclasse costituita da questi si potrebbero riscontrare

frequenze diverse negli incidenti automobilistici.

Una volta individuata una classe di riferimento illimitatamente grande e

omogenea, si calcola il limite a cui tendono le frequenze osservate di incidenti

automobilistici subiti da soggetti del tipo di Rossi entro insiemi via via più estesi

tratti da di questa classe. Si identifica quindi questo limite con la probabilità di

avere un' incidente per soggetti del tipo del signor Rossi. Si noti che questo non è

esattamente la stessa cosa che calcolare la probabilità che il Sig. Rossi nella sua

singolarità abbia un incidente, ma possiamo identificare la probabilità di questo

evento singolare (event- token) con quella dell'evento tipico (event- type) di cui si

può considerare rappresentativo: ciò mediante un artificio concettuale che

Reichenbach chiama posit (“asserzione che noi consideriamo come vera anche se

il suo valore di verità è sconosciuto”). Questa distinzione tra eventi singolari

concreti e tipi di evento ricorrerà più volte nelle pagine seguenti.

La classe di riferimento omogenea nel senso di Reichenbach in sostanza è

un’idealizzazione infinitaria di quello che gli statistici chiamato "campione non tarato" (non-biased) o “campione randomizzato”, che ha un ruolo essenziale

nella pratica statistica. La scelta del campione pone problemi di difficile

soluzione (ne parleremo nel paragrafo sulle menzogne statistiche) in quanto

una taratura del campione può dare origine a distorsioni gravi nel rilevamento

delle frequenze.

Per quanto ispirato ad alcuni criteri comunemente usati nella pratica

statistica, il frequentismo nella formulazione di Reichenbach presta il fianco a

diverse critiche. Una di queste è squisitamente matematica e muove

dall’osservazione che la classe di riferimento e gli esperimenti devono essere

necessariamente, anche se di grandi dimensioni, in numero finito. Se così non

fosse, in un numero infinito di lanci di una moneta ci sarebbe un numero

infinito di uscita di teste e un numero infinito di uscite di croci, generando una

frazione che è sempre uguale a ∞/∞, contro l’intuizione che ci dice che questo

valore è 1/2. La concezione della probabilità come limite mira a disinnescare

questa difficoltà. Succede però che l’ordine in cui si distribuiscono gli

esperimenti in una classe finita potrebbe determinare limiti diversi a seconda

dell’ordine in cui si presentano i dati. Non esiste un ordine unico associato a una

determinata classe di riferimento. Qual è, per esempio, l’ordine in cui

“oggettivamente” sono disposte tutte la automobili rosse fabbricate in Italia?

Un secondo problema attiene la probabilità di casi singoli, dato che in questa

concezione appare privo di senso chiedersi, poniamo, qual è la probabilità

dell'uscita di testa al 40° lancio, mentre queste valutazioni di probabilità sono di

uso corrente nella meccanica quantistica.Questo problema è stato sottolineato in

particolare da Karl Popper, che si è fatto portabandiera di una particolare

versione del frequentismo detta propensionismo .

Una terza difficoltà riguarda l'impossibilità di costruire classi di riferimento

dotate delle proprietà richieste anche per eventi rari o unici. Basta pensare che

quando si inviò per la prima volta una spedizione sulla Luna si assegnava

un'alta probabilità al successo dell'impresa, ma questa non poteva sicuramente

essere calcolata sulla base della frequenza statistica dell'evento.

Una quarta difficoltà, spesso trascurata dagli stessi matematici, riguarda il

fatto che per dimostrare che i limiti delle frequenze sono valori di probabilità

bisogna dimostrare che soddisfano gli assiomi di Kolmogorov, cioè i due

principi delle probabilità totali e delle probabilità composte. È stato provato

tuttavia che questa dimostrazione non è banale, anzi che a rigore non è

possibile. Se è così, avrebbero ragioni quanti distinguono, come più volte

enfatizzato da Rudolf Carnap, tra due nozioni diverse di probabilità - una

epistemica e una statistica- che avrebbero anche probabilità matematiche

diverse.

Con ciò è necessario prendere in esame la concezione detta “epistemica” della

probabilità, di cui la concezione classica di Laplace è stata la prima

anticipazione. Qualcuno, come Popper, ha voluto raggruppare tutte le varie

articolazioni della concezione epistemica sotto l’etichetta di “concezione

soggettivista”, con l’intento di sottolineare l’opposizione tra il concepire la

probabilità come proprietà oggettiva del mondo e il concepirla come qualcosa

di dipendente dalla coscienza di uno o più soggetti.

Nella concezione epistemica tuttavia sono riconoscibili almeno due

orientamenti diversi, incompatibili per il diverso atteggiamento verso le

proprietà logiche degli enunciati probabilistici. Secondo i cosiddetti logicisti

(Boole, Jevons, Johnson, Keynes, Heffreys, Carnap) gli enunciati probabilistici,

se veri, sono logicamente veri. In essi viene enunciato un certo rapporto tra un’

ipotesi h (es. il prossimo corvo sarà nero) e un certo stock di evidenza

disponibile a suo favore (p.es. il fatto che 100.000 corvi osservati sono neri e

nessun corvo osservato è di colore diverso). Keynes parla per esempio di questo

rapporto come grado di credenza razionale, e la logica del probabile diventa

quindi una logica della

ragionevolezza. Se è vero che la scelta dell’

informazione da inglobare nell’evidenza e varia da soggetto a soggetto, la

relazione in sè è puramente logica.

Carnap ha sviluppato da queste idee di fondo dei metodi per calcolare gradi

di conferma induttiva espressi mediante la probabilità condizionale. A

differenza di Keynes e altri logicisti, tuttavia, Carnap introduceva due

coefficienti parametrici, λ ed η, esprimenti diverse valutazioni possibili del

fattore logico-linguistico (λ) e del fattore costituito dal peso dell’esperienza (η).

Se, per restare nell`esempio, svalutiamo l`evidenza sperimentale ponendo

uguale a 0 il coefficiente η , allora la probabilità che il prossimo corvo sia nero

dipende unicamente dal linguaggio presupposto. Se il linguaggio contiene nomi

per i soli 7 colori dell’iride, tale probabilità è di 1/7, mentre se si ammette un

numero piu` ampio di nomi per le sfumature dei vari colori (scarlatto,

porpora,...) allora il valore di tale probabilità sarà diverso. Comunque sia,

indipendentemente da come vien fissato il valore parametrico, la conclusione è

ottenuta attraverso un partial entailment, cioè un`implicazione parziale di cui

l`implicazione logica è solo il caso speciale in cui l`output segue al 100%.

Carnap identifica le funzioni di probabilità con le funzioni di conferma: in

questo modo la logica della probabilità coincide con la logica della conferma

induttiva. Sfortunatamente, dato che ciò che viene confermato di solito è una

legge, cioè una generalizzazione infinitaria (p.es. “Tutti i corvi sono neri”), per

ragioni puramente matematiche tale grado di conferma per le leggi tende ad

essere molto basso se il numero di individui dell’universo è molto grande, ed è

addirittura uguale a 0 se si assume che il numero di individui dell’universo è

infinito. (Per capire questo apparente paradosso, si rifletta sulla domanda:

“sapendo che un urna infinita contiene palline di sette colori, qual è la

probabilità di estrarre un numero infinito di palline rosse e nessuna di colore

diverso?”). Questo difetto è stato corretto da J. Hintikka e dalla sua scuola

introducendo nuovi coefficienti parametrici, ma ottenendo sempre valori bassi

per le generalizzazioni infinitarie: cosa che, del resto, appare coerente con

concezioni epistemologiche come quella popperiana, per la quale cui, come è

noto, le leggi sono solo ipotesi destinate ad incappare prima o poi in qualche

falsificazione.

Essenziale per capire la linea Johnson-Keynes-Carnap è il fatto che, nonostante

si ammetta la variabilità dei risultati delle conclusioni probabilistiche, con

conseguente abbandono dell’univocità, le credenze di cui si postula la misura

sono credenze razionali, cioè credenze proprie di un soggetto idealizzato. La

variabilità, come già detto, dipende dall’arbitrarietà dei valori di λ ed η, cioè del

parametro logico e quello empirico. La valutazione di questi può variare a

seconda degli scopi e del contesto scientifico. Se è così, però, non c’è da stupirsi

se negli ultimi anni Carnap fosse incline a considerare il logicismo compatibile

con il osggettivismo probabilisticoNella corrente detta soggettivista (Ramsey, DeFinetti, Savage) questo requisito

di razionalitàviene abbandonato, così come l'idea che gli asserti probabilistici

veri siano verità logiche. I valori probabilistici esprimono solo gradi di credenza

di soggetti concreti che possono tener conto dell`evidenza disponibile nel modo

che preferiscono. I gradi di credenza sono misurati considerando ogni soggetto

alla stregua di un giocatore, razionale o irrazionale che sia, impegnato in un

gioco di scommesse contro un secondo giocatore (allibratore). Se un giocatore è

convinto, per esempio, che la probabilità di sorteggiare un certo numero al lotto

sia del 50%, non c'è nessun argomento che possa impedirgli di fare questa

valutazione.

L’ unico criterio di razionalità che si richiede a un giocatore è la coerenza

interna del suo sistema di credenze: se il giocatore ritiene veramente che la

probabilità che esca il numero 20 in un certa uscita della roulette sia del 90%,

l’intuizione ci dice che non può anche credere che la probabilità che esca il

numero 21 nella stessa uscita sia pure del 90%, dato che l’uscita del 20 e del 21

sono incompatibili tra loro. Per dare una veste matematica a questa intuizione

sono praticabili metodi diversi, anche se i soggettivisti non sono concordi sul

fatto che le probabilità siano da esprimere invariabilmente mediante valori

numerici. In ogni caso, il metodo più semplice per misurare il grado di

credenza è dato dalla misura del quoziente di scommessa, cioè dal rapporto tra

quanto si scommette e quanto si incassa in caso di vincita. Chi scommette su un

certo cavallo 10 euro per averne 100 in caso di vincita (quoziente di scommessa

1 / 10, o ragione di 1 contro 9) mostra una bassa propensione a rischiare

denaro su questo cavallo, quindi un basso grado di credenza nella sua vittoria;

mentre il contrario si direbbe di chi scommette 90 euro per incassarne 100 in

caso di vincita (quoziente 9/10,o ragione di 9 contro 1). La coerenza di un

sistema di scommesse consiste nell’escludere che nel bilancio finale si vada

incontro a una perdita certa, come sarebbe il caso dello sprovveduto che

scommettesse 100 euro su testa per averne 200 e, simultaneamente, 150 euro su

croce per averne 200: in complesso, costui affronterebbe una spesa complessiva

di 250 euro per incassare 200 euro. Un sistema di scommesse incoerente viene

nel gergo chiamato Dutch Book (allibramento olandese). Ramsey e deFinetti

hanno fatto vedere che il requisito della coerenza delle scommesse implica il

soddisfacimento degli assiomi di Kolmogorov, anzi equivale ad esso.

Un indubbio vantaggio del soggettivismo, che spiega in parte il suo recente

successo, è dovuto al fatto che risolve in modo indolore il problema della

probabilità iniziali, dato che in questa prospettiva queste rispecchiano solo le

convinzioni iniziali di un soggetto dato. Può naturalmente sconcertare il fatto

che un soggettivista radicale ammetta anche valutazioni di probabilità che il

senso comune tenderebbe a considerare forsennate. Ma dal suo punto di vista

esistono due principi importanti che, oltre alla coerenza, possono riconciliare il

soggettivismo con il senso comune. Il primo è il già ricordato teorema di Bayes.

Tale teorema ci garantisce un modo per calcolare il passaggio da una certa

assegnazione di probabilità, poniamo h, alla probabilità revisionata (updated) di

h data una certa evidenza e. Possiamo calcolare, per esempio, la probabilità che

tutti i corvi siano neri dato che 100 corvi sono neri (Pr(h/e) ) una volta che si

conosca, oltre alla probabilità di h e quella di e, la probabilità inversa che 100

corvi siano neri dato che tutti i corvi sono neri (Pr e/h, che ovviamente è 1 per

ragioni logiche). In tal modo il teorema di Bayes, a volte impropriamente

chiamato teorema della probabilità delle cause, ci consente di rappresentare

molte - secondo i soggettivisti tutte – forme di ragionamento ampliativo, cioè

di argomentazioni razionali non deduttiva.

Oltre alla coerenza, che è un criterio di raionalità,secondo i soggettivisti c’è

da tenere conto di un secondo principio, valorizzato specialmente da De

Finetti.è il cosiddetto principio di scambiabilità, formulato per la prima volta in

modo esplicito da W.E.Johnson con il nome di “principio di simmetria”. In esso

si dice che l`ordine in cui si presentano gli elementi che costituiscono l’

evidenza positiva a favore di una certa ipotesi è indifferente, nel senso che non

influenza la suddetta valutazione.

Supponiamo di lanciare in aria per dieci

volte una moneta che sappiamo essere

truccata. I lanci non saranno

indipendenti in quanto gli esiti di ogni lancio forniranno indicazioni sulla

probabilità che esca testa nel lancio successivo. D’altro canto, stabilito il

numero di volte in cui esce testa in dieci lanci della moneta, sapere in quali

lanci sia uscito testa non è rilevante. In altri termini, si verifica una invarianza

permutazionale nel senso che la probabilità che si abbia una sequenza di 10

esiti con un certo numero di teste è sempre la stessa a prescindere da quali

siano esattamente le volte in cui è uscita testa. Pertanto, se per esempio è

uscita testa per tre volte su dieci, non importa se ciò si è verificato nei primi tre

tentativi, oppure nel primo, settimo, decimo. De Finetti ha fatto vedere che

l’impiego contestuale del ragionamento bayesiano e del principio di

scambiabilita`è sufficiente ad assicurare la ricostruzione del ragionamento

statistico con risultati identici a quelli cercati dai frequentisti.

Il soggettivismo è diventato il paradigma dominante nelle ricerche

probabilistiche degli ultimi trent’anni. Le critiche a cui va incontro sono state

oggetto di un ampio dibattito che non ha minato le sue radici ma sembra aver

contribuito al suo raffinamento.

Alcune difficoltà del soggettivismo riguardano l’impiego del rapporto tra

somme di denaro per misurare le probabilità, dato che anche per un privilegiato

con un ricco conto in banca rischiare 50 euro per averne 100 non è la stessa

cosa che rischiare 50000 euro per averne 100.000. Eppure nei due casi il rapporto

tra le due quantità è sempre invariabilmente ½ : dovrebbe quindi misurare lo

stesso grado di credenza. A questo problema si può ovviare con strategie

diverse. Una è quella, proposta già da Ramsey negli anni ‘30, che consiste nel

parlare non di scommesse ma di preferenze tra beni dotati di un certo valore di

utilità. In tal modo si è stabilito uno stretto rapporto tra la teoria della

probabilità e quello delle preferenze: si ricordi del resto che già nel ‘7oo era

chiaro che la nozione di probabilità si poteva defnire il termini di speranza

matematica. La seconda strategia, sottoscritta dallo stesso DeFinetti, consiste nel

rinunciare all’assegnazione di valori numerici in tutti i casi. È sufficiente avere

una relazione “è più probabile di”, definita su proposizioni, le cui proprietà

siano descritte da un certo numero di assiomi, che in ogni caso risultano tali da

rendere derivabili gli assiomi di Kolmogorov.

Si noti che la probabilità comparativa ha una rilevanza dal punto di vista

giudiziario, perché una comune obiezione all’impiego del calcolo delle

probabilità è che nelle aule dei tribunali non ha molto senso impiegare valori

numerici esatti, per esempio dicendo che l’imputato ha avvelenato la vittima

con il 93% di probabilità. Come vedremo, questo è soltanto una dei molti

problemi sollevati dall’impiego del linguaggio probabilistico e del calcolo delle

probabilità in ambito giudiziario.

Sempre sul terreno giudiziario, si è fatta spesso sentire contro il soggettivismo

un’obiezione che è stata condivisa da autorevoli filosofi del diritto (in Italia da

M.Taruffo, che propende per una visione logicista della probabilità): se si

aderisce al soggettivismo, le valutazioni probabilistiche diventano soggettive,

con il rischio che un tribunale assolva un imputato che un altro può condannare

in base a diverse valutazioni soggettive. Questa obiezione è importante perché

non è rivolta contro l’impiego del calcolo delle probabilità nei tribunali ma

contro la filosofia soggettivista. Vediamo come potrebbe rispondere un

soggettivista a questa obiezione. Paolo Garbolino ha dato una dettagliata analisi

di come dovrebbe procedere una corte di giustizia che volesse applicare la

concezione soggettivista.

1) accusa e difesa dovrebbero esporre le rispettive ricostruzioni dei fatti,

intese come insiemi di credenze soggettive, evidenziando la loro coerenza

interna.

2) il giudice sceglie la versione dei fatti che gli sembra più probabile, in base

al principio del libero convincimento del giudice.

Si sottolinea che, piaccia o meno, questo è ciò che “di fatto accade”, anche

se i soggetti coinvolti potrebbero in buona fede sentirsi guidati da obiettivi

più elevati, come l’ aspirazione ad “accertare la verità”. Di qui una possibile

obiezione antisoggettivista: è meglio,uno potrebbe dire, una ricostruzione

probabilisticamente incoerente che risulta vera piuttosto che una coerente ma

falsa. Il soggettivista risponde che nessuno può garantire che una certa

ricostruzione sia vera, anche se si può dire che è più o meno approssimata al

vero (Popper parla di verisimilitudine). Molti soggettivisti rifiutano di usare

la nozione stessa di verità associandosi alla domanda di Ponzio Pilato (Quid

est veritas?). Quanto alla verosimilitudine ,il soggettivista si chiede però che

vuol dire però “verosimile”. Se si intende con ciò “credibile” si ricade nel

soggettivismo. Se si intende “approvabile” (quindi in accordo con il parere

di esperti qualificati), che è il senso antico che aveva la parola “probabile”

nel Medio Evo, si regredisce a una concezione prepascaliana della

probabilità. Sembra che non resti che la probabilità in termini di frequenze

relative, ma il soggettivista si oppone al frequentismo non solo evidenziando

le difficoltà interne che abbiamo già discusso, ma osservando che tanto

Carnap che Reichenbach hanno introdotto dei parametri per ponderare le

conclusioni dei ragionamenti induttivi, introducendo quindi surrettiziamente

delle variabili la cui determinazione può essere solo soggettiva.

Negli ultimi anni i contrasti che hanno diviso gli epistemologi sul

significato della nozione di probabilità hanno lasciato posto a un

atteggiamento più flessibile e pluralista. Si ammette, in altre parole, che in

alcuni contesti potrebbe essere utile applicare la nozione classica, in altri

quella statistica, in altri ancora quella soggettivista, fermo restando che la

sintassi impiegata e le regole del calcolo, sono invarianti e devono restare

tali.

LEZIONE 3. Il bayesianesimo

Si è visto nelle lezioni precedenti che il teorema di Bayes è per il soggettivista

l’unico strumento disponibile per effettuare inferenze non-deduttive.

Tali

inferenze, che si chiamano a volte ampliative, nella tradizione logica venivano

classificate in due sottocategorie: quella delle inferenze induttive e quella delle

inferenze abduttive. L’induzione e l’abduzione vengono spesso presentate come

processi inferenziali conversi tra loro. Si guardi a questi due esempi :

(1) Se il fiammifero è stato sfregato, si è acceso

(2) Se il fiammifero si è acceso, (vuol dire che) è stato sfregato .

Nella (1) si passa da un evento ad un altro che può dirsi spiegato in termini del

primo in base ad una legge stabilita induttivamente. Dato che tra i due eventi

sussiste un gap temporale e che la legge in questione appare la descrizione di un

nesso causale, si può anche dire che il primo evento è causa e il secondo effetto.

Nella proposizione (2) l’inferenza procede invece nella direzione inversa.

L’antecedente enuncia un evento del quale il conseguente descrive una

spiegazione causale attendibile.

In ambedue i casi la conclusione non segue dalla premessa con necessità ma

solo con un certo grado di probabilità,

la cui esatta determinazione

naturalmente può essere certo problematica. Nel secondo esempio, comunque,

l’intuizione dice che il grado di probabilità della conclusione è più basso che

quello della conclusione nel primo esempio. La conclusione di (2) è in effetti

lecita una volta che si sia in grado di escludere che non esistono spiegazioni

migliori del fenomeno descritto nell’antecedente, in cui si asserisce che il

fiammifero si è acceso. Dunque quella che viene eseguita è un’inferenza “alla

miglior spiegazione”.

Come vedremo in seguito, la classificazione delle inferenze ampliative in

induttive e abduttive appare insufficiente se si tiene conto di un tipo di

inferenza- l’inferenza controfattuale- che per quanto ignorato nella tradizione

aristotelica e postaristotelica ha un’importanza che la logica contemporanea ha

messo adeguatamente in luce.

È giunto il momento di vedere come si applica il teorema di Bayes nella

trattazione dell’inferenza ampliativa, sottolineando fin dall’inizio che insistere

sulla centralità del teorema di Bayes non è solo prerogativa dei soggettivisti, ma

di una categoria di metodologi che vengono genericamente raggruppati sotto

l’etichetta di bayesiani. Per i bayesiani la probabilità è sempre un grado di

credenza calcolabile che dipende dal grado di probabilità dalle prove

disponibili. Data questa definizione ampia di “bayesiano”, anche epistemologi

non soggettivisti come Carnap si possono chiamare bayesiani.

Il bayesianesimo giuridico (“nuova dottrina delle prove”) è quella corrente di

pensiero che ritiene che ogni inferenza probatoria si basi, magari in modo

implicito o inconscio, su un’applicazione del teorema di Bayes .

Per fare un esempio,supponiamo si debba la stabilire la probabilità che Rossi

abbia avvelenato il caffè alla luce di certe evidenze disponibili.

Il detective comincia assegnando un certo valore a priori alla probabilità di H(

Rossi ha avvelenato il caffè) prima di esaminare le evidenze E1, E2, E3… En,

dove E1 è, supporremo, il fatto che Rossi ha comprato una dose di veleno. Egli

assegna anche un valore a priori a Pr(E1|H), cioè alla probabilità che Rossi abbia

comprato il veleno dato che ha avvelenato il caffè (verosimiglianza). Se assegna

anche un valore a Pr(E1), grazie al teorema di Bayes si trova Pr(H|E1). Dunque

con questo metodo si passa dalla probabilità di H a quella aggiornata (updated)

di H|E1. Chiamiamo Pr(H’) questa probabilità revisionata. Si passa poi con lo

stesso procedimento a calcolare Pr(H’|E2), ripetendo poi la procedura per ogni

presunta prova E1…En. Questa iterazione di revisioni porta a Pr(H’’’’|En). Si

può dimostrare che più aumenta il numero delle condizionalizzazioni più le

valutazioni soggettive tendono a convergere verso un valore unico, limitando

quindi l’ arbitrarietà delle valutazioni a priori.

Un importante teorema noto come teorema di de Finetti è stato considerato

dai bayesiani la carta vincente per ridurre il peso dell’ arbitrarietà delle

valutazioni iniziali.. De Finetti ha dimostrato che, se la sequenza delle prove è

scambiabile e se le credenze di un ricercatore sono coerenti, allora alla fine il

valore che verrà assegnato dopo un numero alto di esperimenti si approssima a

quello della frequenza relativa (come si asserisce nella legge dei grandi numeri).

Come osserva Jonathan Cohen, però, il problema è che due eventi E1 e E2 sono

scambiabili quando sono nella stessa misura irrilevanti per H: ma la rilevanza è

una nozione probabilistica e quindi la stessa nozione di scambiabilità è una

nozione probabilistica –e quindi, per i soggettivisti, sempre dipendente dai

soggetti.

Le applicazioni del teorema di Bayes sono ad ampio raggio. Un esempio di

come si applica il teorema di Bayes è offerto, in medicina, dallo studio statistico

dei falsi positivi. I falsi positivi si verificano quando un test medico dà esito

positivo in modo falso o scorretto: in altre parole, il test indica che il paziente ha

una malattia che in effetti non ha. Possiamo usare il teorema di Bayes per

determinare la probabilità che un risultato positivo sia un falso positivo.

Sorprendentemente risulta che, se una malattia è rara, allora la maggioranza dei

risultati positivi possono essere falsi positivi, anche se il test è accurato.

Supponiamo che un test per una certa malattia produca i risultati seguenti:

1) Se un paziente sottoposto a test ha la malattia, il test produce un risultato

positivo il 99% delle volte, cioè con probabilità 0.99

2) Se un paziente sottoposto a test non ha la malattia, il test produce un

risultato positivo il 5% delle volte, cioè con probabilità 0.05.

Ingenuamente uno potrebbe pensare che solo il 5% dei risultati sono sbagliati,

ma questo è un errore. Supponiamo che la malattia sia rara, per esempio che

solo lo 0.1% della popolazione abbia quella malattia, cosicchè un paziente

scelto a caso ha una probabilità a priori di 0.001 di avere la malattia.Possiamo

usare il teorema di Bayes per calcolare la probabilità che il risultato sia un falso

positivo. Sia A la proposizione che il paziente è malato, mentre B sta per la

proposizione che il test è positivo. Allora,per quanto detto

Pr(B|A)= 0.99 (positivo se malato)

Pr(B|-A) =0.05 (positivo se sano)

Pr(A) = 0.001

Quindi la probabilità che il paziente abbia effettivamente la malattia dato il test

positivo è , come ricordiamo

(TB*) Pr(A|B) =

____Pr(A) • Pr(B|A)

(se Pr(A) ≠0) =

Pr( A) • Pr(B|A) + Pr(-A) • Pr(B|-A)

0.99 • 0.001–––––––––- = 0.019.

0.99 •0.001 + 0.05 • 0.999

Questa dunque è la probabilità di avere un risultato positivo corretto.

Pertanto la probabilità che un risultato positivo sia un falso positivo, cioè il

complemento della probabilità calcolata, è Pr(-A|B), è circa 1-0,019 = 0.98 o

98%. Quindi la probabilità dei falsi positivi risulta altissima: nonostante

l’apparente accuratezza del test, l’incidenza della malattia è così bassa che la

grande maggioranza dei pazienti che risultano positivi al test non hanno la

malattia. Si consideri però che la percentuale di pazienti che risultano positivi

in quanto affetti da questa malattia (0.019) è 19 volte la percentuale di quanti,

pur non avendo ancora subito un controllo, sono realmente malati (0.001).

Pertanto il test non è inutile, e la ripetizione del test può migliorare l’affidabilità

del risultato.

Allo scopo di ridurre il danno prodotto dei falsi positivi, è chiaro che un test

dovrebbe essere molto accurato nel dare esito negativo quando il paziente è

sano. Se il test producesse molto spesso un risultato negativo in pazienti sani,

diciamo con probabilità 0,999, allora Pr(B|-A) (“positivo se sano”) scenderebbe

a 0,001: quindi avremmo per “positivo se malato”

,

cosicchè in questo caso la probabilità di un falso positvo sarebbe 1-0.5=0.5

D’altro canto, i falsi negativi si producono quanto un test dà un esito negativo

in modo falso o scorretto: in altre parole quando il test medico indica che

il paziente non ha una malattia che in effetti ha. Questa eventualità è più

grave di quella del falso positivo, perché si rischia di omettere la cura per

persone realmente malate.Possiamo usare ancora il teorema di Bayes per

calcolare la probabilità di un falso negativo. Nel primo degli esempi di cui

sopra, quello di una malattia rara, si consideri che

Pr(-B|A) = 1- Pr(B|A) = 0,01.

Ergo come valore di « malato se negativo » avremo

La probabilità che un risultato negativo sia un falso negativo è dunque circa

0.0000105, ossia 0.00105%. Quando una malattia è rara, i falsi negativi non

saranno dunque un problema importante nel test. Ma se per caso la

popolazione ammalata fosse il 60%, allora la probabilità di un falso

negativo sarebbe maggiore. In tal caso infatti Pr(A)=0.6.Con lo stesso test,

la probabilità di un falso negativo sarebbe

La probabilità che un risultato negativo sia un falso negativo sale a 0.0155

cioè a 1,55%.

Passiamo ora dalla medicina al diritto. Qui ci si imbatte immediatamente nel

problema di distinguere tra indizi e prove, dove per prova si intende qualcosa

che attribuisce all’ipotesi un elevato grado di probabilità, mentre si intende di

solito per “indizio” ogni elemento di informazione che rende più probabile

l’ipotesi .

Cominciamo con il discutere una regola giudiziaria basata su quello che si

potrebbe dire bayesianesimo ingenuo. Come è noto, nel diritto penale si chiede

normalmente che le conclusioni vengano raggiunte “oltre ogni ragionevole

dubbio”, che si potrebbe parafrasare dicendo che la probabilità deve essere

sopra una soglia di 1-ε. Questa soglia, in prima approssimazione, fissa la

differenza tra ciò che si può dire provato e ciò che non lo è. La regola è allora

(R) Il giudice al termine del processo decide nel merito sulla sola base del valore

di probabilità dell’ipotesi: accetta il thema probandum se la sua probabilità è

superiore a una certa soglia di 1- ε e lo respinge altrimenti.

Sulla esatta determinazione del valore di alta probabilità bisogna osservare

che ci sono state diverse controversie. Il valore di certezza pratica è fissato

convenzionalmente a 0,999999. Adottare la condotta (R) con questo valore di ε

è quello che diremmo un comportamento razionale. Ma non c`è dubbio che un

livello cosi` alto di certezza, se è giustamente richiesto, poniamo, per la

sicurezza aerea, non è quasi mai raggiungibile in un processo penale. Il

dilemma, naturalmente, è quello se punire un numero troppo alto di innocenti

(accettando soglie più basse di probabilita`) o lasciare in libertà un numero

troppo alto di malfattori (accettando una soglia eccessivamente alta di

probabilita`).

Come afferma Eggleston, il diritto inglese assegna alla giuria l`onere di

stabilire cosa sia una misura "ragionevole" (non razionale) di probabilità in quel

particolare contesto. Si parla infatti di "convinzione oltre ogni ragionevole

dubbio". Ma che cosa è un dubbio ragionevole? Il dubbio cartesiano è razionale

ma non ragionevole. In ogni caso di scomparsa di persona, per esempio,

possiamo sollevare il dubbio che lo scomparso sia stato rapito dagli

extraterrestri.. Infatti in tali casi prendiamo in considerazione è una possibilità

logica ma non una possibilità fisica, stante che non disponiamo di leggi fisiche

sulle attività di soggetti extraterrestri.

L’ipotesi di una sostituzione di persona o una diabolica messinscena (su cui

torneremo) rientra nel repertorio giornalistico e anche giudiziario, ma è dubbio

sia ragionevole.

Riteniamo sia utile continuare a usare la formula R lasciando nel vago il valore

di ε come quello di un valore trascurabile non specificato. Si tratta di una

procedura di idealizzazione che non è l`eccezione ma la regola anche nella

scienza. Dal punto di vista applicativo, infatti, questo valore sarà quello in cui

converge la convinzione della giuria una volta che non sia influenzata da fattori

di qualche genere.

Lord Dennig scrisse :"Nei processi penali l`accusa deve essere provata oltre

ogni ragionevole dubbio, ma possono esserci dei gradi all`interno di questo

standard" .La solidità della prova dovrebbe essere proporzionata alla gravità del

reato. Sono state anche fatte delle ricerche sui valori di probabilità che si

stimano sufficienti in rapporto a diversi reati. Per la prova di omicidio, per

esempio, i giudici richiederebbero 0,92 mentre i giurati 0,86.

Un'altra idea a volte sostenuta è che quando il grado di prova è "oltre ogni

ragionevole dubbio" ciascun elemento di prova deve a sua volta risultare tale

oltre ogni ragionevole dubbio. Questo è eccessivo, perché le singole prove

potrebbero non essere certe ma la loro somma complessiva potrebbe portare

l’ipotesi al livello di credibilità richiesto.

Nei processi civili anglosassoni ci si conforma a uno standard diverso da

quello di "oltre ogni ragionevole dubbio", ma le opinioni sul grado di

probabilità richiesto sono divergenti. Il minimo che si chiede è che la probabilità

di A superi la probabilitàdi -A, cioè il 50%., anche se si tende a usare la

locuzione più vaga "preponderanza delle prove". Sempre Lord Denning

sostiene che, allo stesso modo in cui c'è una variabilità del concetto di

ragionevole dubbio, c`è una variabilità anche nel concetto di preponderanza di

probabilita`. Una regola pratica condivisa è per esempio questa: il tribunale

puo` accontentarsi di un minore grado di prova quando ritiene che la

reputazione dell`imputato sia talmente cattiva che una condanna in piu` non

potra peggiorarla.

Si noti che i processi penali e civili possono essere intrecciati: può capitare per

esempio che un tribunale civile impedisca la trasmissione di un patrimonio a

un soggetto che si sospetta abbia assassinato la

donna che ha steso il

testamento.

Una classe importanti di problemi nell’impiego del calcolo delle probabilità è

posta dalla credibilità dei testimoni. Una volta stabilito che i testi sono

indipendenti, la credibilità della testimonianze dovrebbe essere ottenuta

moltiplicando le varie probabilità via il principio delle probabilità composte.