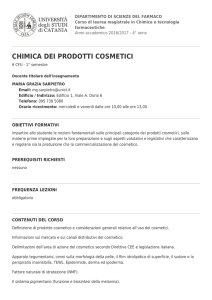

Appunti di Teoria della Probabilità

Università degli Studi di Bari

Corso di Laurea in Scienze Statistiche

A.A. 2011/2012

Alessio Pollice

2

Capitolo 1

Eventi e probabilità

1.1

Premessa

• Etimologia e significato letterale

probabile agg. 1. Di quanto si ammette in base a motivi seri o attendibili ma non certi

(...)

probabilità s.f. 1. Attendibilità confortata da motivi ragionevoli (...) com. la misura

in cui un evento si ritiene probabile (...) 2. In ambito filosofico o teologico, il carattere

distintivo dell’opinione, in quanto questa può essere sostenuta con ragioni tali che non

escludono la ‘possibilità del contrario’.

[G. Devoto, G.C. Oli, Il Dizionario della Lingua Italiana]

• In una prima grossolana definizione la teoria della probabilità può essere individuata come la

base per la rappresentazione di situazioni nelle quali sia necessario effettuare delle scelte o prendere

delle decisioni in condizioni di incertezza.

• Perché un corso di teoria della probabilità nel CdL in SSE.

Malgrado l’importanza e il crescente interesse nei metodi della statistica descrittiva,

questa branca della disciplina costituisce oggi solo una parte, relativamente modesta, della

moderna metodologia statistica. Lo sviluppo più cospicuo si è avuto nel campo della

cosiddetta statistica inferenziale o induttiva. Questa parte della statistica accoglie quelle

metodologie che si occupano di indicare come trarre conclusioni (o inferenze) circa gli

aspetti non noti dei fenomeni sulla base di limitate informazioni; conclusioni di solito

necessarie all’assunzione di decisioni.

Tuttavia, per affrontare la problematica inferenziale sono essenziali i concetti e le tecniche sviluppati da un altro settore disciplinare, quello della teoria della probabilità. Infatti

la risoluzione di problemi inerenti la inferenza (statistica) presuppone la valutazione delle

probabilità con cui certi eventi possono manifestarsi; e tali valutazioni rivestono e giocano

un ruolo tanto importante nelle conclusioni che la stessa statistica, in certa misura, può

essere riguardata come l’area applicativa della teoria della probabilità.

[D.M. Cifarelli, 1998]

3

4

A. Pollice - Appunti di Probabilità

1.2

Eventi e loro rappresentazione matematica

Le situazioni alle quali è possibile applicare il ragionamento probabilistico vengono denominate eventi

(aleatori): la probabilità è un numero associato ad un evento (risultante dall’osservazione di un esperimento) che può o meno verificarsi.

Esempio 1.1 Lancio una moneta (simmetrica) ed ottengo testa;

Esempio 1.2 Lancio due volte una moneta (simmetrica) e ottengo testa al primo lancio e croce al

secondo;

Esempio 1.3 Lancio un dado (non truccato) e ottengo 5 o 6;

Esempio 1.4 Estraggo (a caso) una carta da un mazzo di carte francesi e ottengo una carta di picche;

Esempio 1.5 Scelgo (a caso) un numero reale nell’intervallo [0, 1] e ottengo un numero inferiore a 0.3;

Esempio 1.6 Scelgo (a caso) un punto all’interno di un quadrato con vertici opposti nei punti di

coordinate (−1, −1) e (1, 1) e ottengo un punto la somma delle cui coordinate è inferiore all’unità.

Dagli esempi precedenti risulta che alla base della individuazione di un evento vi è una ben definita

prova o esperimento casuale (rispettivamente il lancio della moneta, il lancio del dado, l’estrazione della

carta e così via).

Definizione 1.1 L’insieme di tutti i possibili risultati di un esperimento casuale è detto spazio dei risultati

(o spazio campionario) e viene generalmente indicato con la lettera greca Ω.

Esempio 1.1 (cnt) Nel caso del lancio di una moneta lo spazio dei risultati è dato da Ω = {T, C}.

Esempio 1.2 (cnt) Nel caso di due lanci della stessa moneta (ovvero di un lancio di due monete

distinte) lo spazio dei risultati è dato da

Ω = {(T, T ) , (T, C) , (C, T ) , (C, C)}

Cap.1: Eventi e probabilità

5

Esempio 1.3 (cnt) Nel caso del lancio di un dado lo spazio dei risultati è dato da Ω = {1, 2, 3, 4, 5, 6}.

Esempio 1.4 (cnt) Nel caso dell’estrazione di una carta da un mazzo di carte francesi lo spazio dei

risultati Ω è dato dall’insieme che ha per elementi tutte le 52 carte del mazzo.

Esempio 1.5 (cnt) Nel caso della scelta di un numero reale nell’intervallo [0, 1] lo spazio dei risultati

Ω corrisponde all’insieme di tutti i punti dell’intervallo. Il numero di elementi di tale insieme è infinito.

Esempio 1.6 (cnt) Nel caso della scelta di un punto all’interno del quadrato lo spazio dei risultati Ω

corrisponde all’insieme di tutti i punti del quadrato. Anche in questo caso il numero di elementi dello

spazio dei risultati è infinito.

Definizione 1.2 Gli elementi di Ω corrispondenti ai possibili risultati dell’esperimento casuale sono detti

eventi elementari e vengono indicati con ϖ1 , ϖ2 , . . .. Se detti elementi sono in numero finito o un’infinità

numerabile, allora ogni sottoinsieme di Ω (ovvero ogni insieme di eventi elementari) è un evento.

Esempio 1.3 (cnt) L’evento “esce 5 o 6” corrisponde all’insieme che ha per elementi i due eventi

elementari “esce 5” ed “esce 6”.

Esempio 1.4 (cnt) L’evento “esce una carta di picche” è dato dall’insieme composto dai 13 eventi

elementari corrispondenti all’estrazione delle carte di picche presenti nel mazzo di carte francesi.

Definizione 1.3 Si dice che il generico evento A riferito allo spazio dei risultati Ω si è verificato (oppure

che esso è vero) quando l’esperimento casuale produce un risultato (elementare) ϖ che implica A, ovvero

quando ϖ ∈ A.

Esempio 1.3 (cnt) L’evento “esce 5 o 6” è vero quando lo è uno dei due eventi elementari “esce 5” ed

“esce 6”.

Esempio 1.4 (cnt) L’evento “esce una carta di picche” si verifica quando è vero uno dei 13 eventi

elementari relativi alle carte di picche.

Definizione 1.4 Si definisce spazio o classe degli eventi e si indica con F l’insieme di tutti gli eventi

associati a un certo esperimento casuale (da non confondere con lo spazio dei risultati che è l’insieme dei

soli eventi elementari).

6

A. Pollice - Appunti di Probabilità

Nel caso di un numero finito o un’infinità numerabile di elementi di Ω, lo spazio degli eventi F corrisponde

all’insieme delle parti (o insieme di potenza) dello spazio dei risultati. Infine nel caso in cui la numerosità

di Ω sia finita e pari ad n lo spazio degli eventi F è formato da un numero di elementi (sottoinsiemi di Ω)

pari a

( ) ( )

( ) ∑

n ( )

n

n

n

n

+

+ ··· +

=

= (1 + 1)n = 2n

(1.1)

0

1

n

i

i=0

Esempio 1.2 (cnt) Lancio di 2 monete distinte:

Spazio dei risultati: Ω = {(T, T ) , (T, C) , (C, T ) , (C, C)};

Esempio di evento: Ai = {“esce i volte testa”} i = 0, 1, 2;

Tutti i possibili 24 = 16 sottoinsiemi di Ω sono eventi e formano lo spazio degli eventi F.

Esempio 1.3 (cnt) Lancio di un dado:

Eventi elementari: ϖi = {“esce la faccia i”} i = 1, . . . , 6;

Spazio dei risultati: Ω = {1, 2, 3, 4, 5, 6};

Esempio di evento: A = {“esce un numero pari”} = {2, 4, 6};

Lo spazio degli eventi F è formato da 26 = 64 eventi corrispondenti a tutti i possibili sottoinsiemi di Ω.

Esempio 1.7 Conteggio del numero di nascite verificatesi in Italia nel 1999:

Eventi elementari: ϖi = {“esattamente i nascite”} i = 0, 1, 2, . . .;

Spazio dei risultati: Ω = {0, 1, 2, 3, . . .};

Esempio di evento: A = {“meno di 500 nascite”} = {0, 1, . . . , 499} ;

Lo spazio dei risultati Ω è un’infinità numerabile così come lo spazio degli eventi F.

Esempio 1.8 Conteggio del numero di piogge e misura del livello complessivo di piovosità:

Evento elementare: ϖ = (7, 46.5);

Spazio dei risultati: Ω = {(i, x) ; i = 0, 1, 2, . . . , x ≥ 0}

i = “numero delle piogge”

x = “precipitazione totale in cm”;

Esempio di evento: A = {(i, x) ; i = 5, . . . , 10, x ≥ 30};

I possibili sottoinsiemi dello spazio Ω sono un’infinità (non numerabile), pertanto non tutti sono eventi.

A questo punto dovrebbe essere chiaro che l’algebra degli insiemi costituisce un presupposto fondamentale per lo sviluppo della teoria della probabilità.

1.3

Algebra degli insiemi e logica degli eventi

L’evento Ω corrispondente all’intero spazio dei risultati dell’esperimento casuale è assimilabile all’insieme

totale o universo. Tale evento si verifica certamente (infatti certamente l’esperimento terminerà con un

elemento di Ω) e viene chiamato evento certo.

Definizione 1.5 Il complementare o la negazione Ā di un insieme A è l’insieme di tutti i punti dell’universo che non appartengono ad A.

Cap.1: Eventi e probabilità

7

Conseguentemente l’evento Ā è costituito da tutti gli eventi elementari ϖ di Ω che non appartengono ad A,

ovvero dagli elementi di F diversi da A. Quindi , dato un evento A = {ϖ ∈ Ω : ϖ ∈ A} la sua negazione

Ā = {ϖ ∈ Ω : ϖ ∈

/ A} è l’evento che si verifica se e solo se non si verifica A. Si noti che vale la seguente

proprietà: Ā = A.

Esempio 1.9 Si determini il complementare Ā dell’insieme A rispetto allo spazio F:

1. F = {x; 0 < x < 1}

{

}

A = x; 58 ≤ x < 1

{

}

Ā = x; 0 < x < 58 ;

{

}

2. F = (x, y, z) ; x2 + y 2 + z 2 ≤ 1

{

}

A = (x, y, z) ; x2 + y 2 + z 2 = 1

Ā è l’insieme dei punti interni ad un sfera di raggio 1 e centro nell’origine di un riferimento

cartesiano tridimensionale;

{

}

3. F = (x, y) ; x2 + y 2 ≤ 1

A = {(x, y) ;

|x| + |y| < 1}

Ā è l’insieme dei punti compresi tra il cerchio di raggio unitario e centro nell’origine ed un quadrato

di vertici opposti (0, −1) e (0, 1) (l’insieme contiene i suoi punti di frontiera).

Definizione 1.6 Il complementare di Ω è l’insieme vuoto ∅ anche detto evento impossibile.

Definizione 1.7 L’ unione A ∪ B di due insiemi A e B è l’insieme costituito dai punti appartenenti ad

uno dei due insiemi o a entrambi; l’evento A ∪ B si verifica dunque quando si verificano A, B o entrambi.

Si noti che l’unione gode delle seguenti proprietà:

A∪B = B∪A

A∪A = A

A∪∅ = A

(1.2)

A∪Ω = Ω

A ∪ Ā = Ω

Definizione 1.8 L’ intersezione A ∩ B di due insiemi A e B è l’insieme costituito dai punti comuni ad

entrambi gli insiemi; l’evento A ∩ B si verifica dunque quando si verificano sia A che B.

Si noti che l’intersezione gode delle seguenti proprietà:

A∩B = B∩A

A∩A = A

A∩∅ = ∅

(1.3)

A∩Ω = A

A ∩ Ā = ∅

Definizione 1.9 Due eventi A e B si dicono incompatibili se la loro intersezione è l’evento impossibile

A ∩ B = ∅, cioé se è impossibile che si verifichino entrambi.

8

A. Pollice - Appunti di Probabilità

Teorema 1.1 Leggi associative:

A ∪ (B ∪ C) = (A ∪ B) ∪ C

A ∩ (B ∩ C) = (A ∩ B) ∩ C

Teorema 1.2 Leggi distributive:

A ∪ (B ∩ C) = (A ∪ B) ∩ (A ∪ C)

A ∩ (B ∪ C) = (A ∩ B) ∪ (A ∩ C)

Esempio 1.10 Siano A, B e C tre eventi appartenenti alla stessa famiglia F. Tramite le operazioni

logiche di unione, intersezione e negazione si determinino le espressioni per i seguenti eventi:

1. “solo A si verifica”= A ∩ B ∩ C;

2. “A e C si verificano, ma non B”= A ∩ B ∩ C;

3. “tutti e tre gli eventi si verificano”= A ∩ B ∩ C;

4. “nessuno dei tre eventi si verifica”= A ∩ B ∩ C;

(

) (

) (

)

5. “due dei tre eventi si verificano”= A ∩ B ∩ C ∪ A ∩ B ∩ C ∪ A ∩ B ∩ C ;

(

) (

) (

)

6. “almeno due dei tre eventi si verificano”= A ∩ B ∩ C ∪ A ∩ B ∩ C ∪ A ∩ B ∩ C ∪(A ∩ B ∩ C);

(

) (

) (

) (

)

7. “almeno

uno) dei( tre eventi si

(

) verifica”= A ∩ B ∩ C ∪ A ∩ B ∩ C ∪ A ∩ B ∩ C ∪ A ∩ B ∩ C ∪

A ∩ B ∩ C ∪ A ∩ B ∩ C ∪ (A ∩ B ∩ C) = A ∪ B ∪ C;

(

) (

) (

) (

)

8. “al più uno dei tre eventi si verifica”= A ∩ B ∩ C ∪ A ∩ B ∩ C ∪ A ∩ B ∩ C ∪ A ∩ B ∩ C ;

(

) (

) (

) (

)

9. (“al più due dei

A) ∩ B ∩ C ∪ A ∩ B ∩ C ∪ A ∩ B ∩ C ∪ A ∩ B ∩ C ∪

) tre

( eventi si )verificano”=

(

A∩B∩C ∪ A∩B∩C ∪ A∩B∩C .

Definizione 1.10 Si dice che l’insieme A è contenuto in o sottoinsieme di B e si indica A ⊂ B se ogni

elemento di A è anche elemento di B.

In tal caso se il risultato dell’esperimento casuale appartiene ad A appartiene anche a B, quindi A ⊂ B

equivale a dire che ogni volta che si verifica A si verifica anche B, ovvero che l’evento A implica B. Si noti

che se A ⊂ B valgono le seguenti proprietà:

A∪B =B

A∩B =A

Definizione 1.11 In generale l’unione

A1 ∪ A2 ∪ . . . ∪ An =

n

∪

Ai

(1.4)

i=1

è l’evento che si verifica quando si verifica almeno uno degli eventi Ai per i = 1, . . . , n.

Definizione 1.12 In generale l’intersezione

A1 ∩ A2 ∩ . . . ∩ An =

n

∩

Ai

i=1

è l’evento che si verifica quando si verificano tutti gli eventi Ai per i = 1, . . . , n.

(1.5)

Cap.1: Eventi e probabilità

9

Teorema 1.3 Legge di de Morgan dell’unione

n

∪

n

∩

Ai =

i=1

Ai

(1.6)

Ai

(1.7)

i=1

Teorema 1.4 Legge di de Morgan dell’intersezione

n

∩

n

∪

Ai =

i=1

i=1

Definizione 1.13 Un insieme indicizzato di eventi {Ai ; i = 1, 2, . . .} è detto successione.

Definizione 1.14 Il limite inferiore di una successione di eventi è definito da:

lim inf Ai = lim

i→∞

i→∞

∞

∩

Ah =

∞ ∩

∞

∪

Ah

(1.8)

i=1 h=i

h=i

∩

Il limite inferiore lim inf i→∞ Ai è dato dall’unione degli eventi ∞

h=i Ah e consiste pertanto nel verificarsi

di almeno uno di tali eventi. Ciò equivale a dire che l’evento lim inf i→∞ Ai si verifica se esiste un valore di

i per il quale si verificano tutti gli eventi Ai , Ai+1 , Ai+2 , . . .. In altri termini lim inf i→∞ Ai è l’evento che si

verifica se e solo se si verificano tutti gli eventi della successione tranne al più un numero finito di essi.

Definizione 1.15 Il limite superiore di una successione di eventi è definito da:

lim sup Ai = lim

i→∞

i→∞

∞

∪

Ah =

∞ ∪

∞

∩

Ah

(1.9)

i=1 h=i

h=i

Con ragionamento analogo a quello esposto

∪∞al punto precedente si può affermare che l’evento lim supi→∞ Ai

equivale al verificarsi di tutti gli eventi h=i Ah , ovvero di infiniti tra gli eventi Ai .

Definizione 1.16 Una successione {Ai ; i ≥ 1} di eventi si dice crescente se vale Ai ⊂ Ai+1 per ogni i.

Definizione 1.17 Una successione {Ai ; i ≥ 1} di eventi si dice decrescente se vale Ai+1 ⊂ Ai per ogni

i.

Definizione 1.18 Il limite di una successione crescente di eventi è definito da

lim Ai =

i→∞

∞

∪

Ai

(1.10)

i=1

Definizione 1.19 Il limite di una successione decrescente di eventi è definito da

lim Ai =

i→∞

∞

∩

i=1

Ai

(1.11)

10

A. Pollice - Appunti di Probabilità

Esempio 1.11 Si determini il limite delle seguenti successioni crescenti di eventi:

{

1. Ai = x :

1

i

≤x≤3−

1

i

}

,

i = 1, 2, . . .

limi→∞ Ai = {x : 0 < x < 3};

}

{

2. Ai = (x, y) : 1i ≤ x2 + y 2 ≤ 4 − 1i , i = 1, 2, . . .

{

}

limi→∞ Ai = (x, y) : 0 < x2 + y 2 < 4 .

Esempio 1.12 Si determini il limite delle seguenti successioni decrescenti di eventi:

}

<x≤2 ,

i = 1, 2, . . .

limi→∞ Ai = {x : x = 2};

{

}

2. Ai = x : 2 < x ≤ 2 + 1i ,

i = 1, 2, . . .

{

1. Ai = x : 2 −

1

i

limi→∞ Ai = ∅;

{

}

3. Ai = (x, y) : 0 ≤ x2 + y 2 ≤ 1i , i = 1, 2, . . .

{

}

limi→∞ Ai = (x, y) : x2 + y 2 = 0 .

Si noti come le seguenti tre proprietà risultano opportune per una semplice caratterizzazione matematica dello spazio degli eventi F:

Ω

∈

F

A ∈ F ⇔ Ā ∈ F

A1 , A2 ∈ F

(1.12)

⇒ A1 ∪ A2 ∈ F

E’ evidente come l’insieme di tutti gli eventi debba essere chiuso rispetto alle operazioni di unione e di

negazione (se si è in grado di dire se A è vero o falso, allora si è in grado di dire anche se Ā è vero o falso;

analogamente se si è in grado di dire se A1 e A2 sono veri o falsi si è in grado di dire se A1 ∪ A2 è vero o

falso).

Definizione 1.20 Una famiglia di insiemi con le suddette caratteristiche (1.15) è detta algebra di Boole.

Inoltre dalle tre condizioni precedenti discendono le seguenti proprietà:

∅

A1 , A2 ∈ F

A1 , A2 , . . . An ∈ F

A1 , A2 , . . . An ∈ F

∈

F

⇒ A1 ∩ A2 ∈ F

n

∪

⇒

Ai ∈ F

⇒

i=1

n

∩

(1.13)

Ai ∈ F

i=1

Definizione 1.21 Si ottiene una struttura algebrica denominata algebra di Boole completa o σ-algebra

o classe additiva se alle tre condizioni che definiscono l’algebra di Boole si aggiunge la condizione che la

Cap.1: Eventi e probabilità

11

famiglia F sia chiusa rispetto all’unione infinita:

A1 , A2 , . . . ∈ F ⇒

∞

∪

Ai ∈ F

(1.14)

i=1

Quando Ω è un’infinità numerabile, l’insieme delle parti di Ω è una σ-algebra. Si può dimostrare inoltre

che se F è una σ-algebra, allora essa è chiusa anche rispetto all’intersezione infinita, ovvero che vale la

proprietà:

∞

∩

A1 , A2 , . . . ∈ F ⇒

Ai ∈ F

(1.15)

i=1

Quando lo spazio Ω non è finito né numerabilmente infinito, il problema della determinazione di

F diviene più complesso. Essendo quello dei numeri reali uno dei più importanti insiemi infiniti (non

numerabili) si supponga Ω = R (o più in generale Ω = Rk , k ≥ 1) e siano inoltre gli intervalli i sottoinsiemi

di R ai quali si sia interessati.

Definizione 1.22 La minima classe di sottonsiemi di R che contiene gli intervalli ed è chiusa rispetto

alla negazione ed all’unione (finita e infinita) è detta σ-algebra di Borel di R.

Come si capisce dalla definizione, la σ-algebra di Borel di R è molto vasta e comprende tutti gli insiemi

di interesse nelle applicazioni, ovvero tutti i sottoinsiemi di R per i quali abbia senso parlare di lunghezza.

In particolare contiene gli insiemi costituiti da singoli punti e tutti gli intervalli aperti e chiusi. Si intende

che in tal caso gli eventi sono comunque sottoinsiemi di Ω = R, viceversa non tutti i sottoinsiemi di R sono

eventi (ma solo quelli che appartengono alla σ-algebra di Borel).

Definizione 1.23 Alla coppia (Ω, F) si dà il nome di spazio misurabile, cioè atto ad essere misurato.

1.4

Diverse interpretazioni della probabilità

Le origini del calcolo delle probabilità sono relativamente recenti. Esso era infatti sconosciuto nel mondo

antico, principalmente a causa dell’assenza del metodo sperimentale nella scienza antica. Già i filosofi

greci discutevano del concetto di probabilità senza addentrarsi in valutazioni quantitative. Dei primitivi

accenni a valutazioni quantitative di probabilità sembra si trovino nella lettura ebraica di commento alle

prescrizioni delle leggi.

Agli inizi dell’età moderna lo spirito sperimentale portò ad interrogarsi sulle regolarità riscontrabili nelle

frequenze dei risultati dell’antico gioco dei dadi (sulla presenza di regolarità pur nella indeterminatezza

dei risultati). La prima trattazione nota sulla probabilità risale al Rinascimento ed è dovuta a Gerolamo

Cardano che nel libro “De ludo aleae” del 1526 (pubblicato postumo nel 1663) discute del calcolo delle

probabilità della somma dei risultati ottenuti lanciando tre dadi (in questo libro viene per la prima volta

enunciata la legge empirica del caso).

La vera nascita del calcolo delle probabilità viene comunemente collegata con gli studi di Blaise Pascal

e Pierre Fermat (sec. XVII), sollecitati dall’interesse crescente per scommesse e giochi d’azzardo. Per

il primo lo studio della probabilità è inquadrabile in una precisa concezione filosofica contrapposta al

razionalismo di R. Descartes che lo precedeva di poche decine d’anni. Come in filosofia Pascal opponeva

“le ragioni del cuore che la ragione non comprende” alle “idee chiare e distinte” di Descartes, così dava inizio

al calcolo delle probabilità in contrasto con la perfetta e stabile sistemazione della geometria cartesiana.

Mentre la posizione di Descartes può essere considerata alla base degli sviluppi del determinismo scientifico

(conoscendo con precisione lo stato dell’universo in un determinato istante si può calcolare la sua evoluzione

in tutti gli istanti successivi), quella di Pascal può essere vista come anticipatrice della moderna visione

della scienza (ed in particolare della fisica) secondo cui i fenomeni osservabili sono unicamente descrivibili

approssimativamente e temporaneamente tramite modelli matematici basati su leggi probabilistiche.

12

A. Pollice - Appunti di Probabilità

Altri studiosi che hanno avuto un ruolo determinante nella nascita e nei primi sviluppi (secc. XVIXVIII) del Calcolo delle Probabilità sono: Christiaan Huygens, Jakob e Daniele Bernoulli, Abraham de

Moivre, Pierre Simon Laplace.

Definizione 1.24 La definizione classica della probabilità (già nota a Cardano come regola di calcolo,

successivamente adottata come definizione da Pascal, poi da de Moivre e Laplace) di un evento corrisponde

al rapporto tra il numero dei risultati favorevoli al verificarsi dell’evento in questione e quello di tutti i

risultati possibili purché tutti ugualmente probabili.

Esempio 1.13 La probabilità di ottenere testa lanciando una volta una moneta simmetrica è pari ad 12 .

Esempio 1.14 La probabilità di ottenere 4 lanciando una volta un dado non truccato è pari ad 16 .

La grave difficoltà di questa definizione sta nel suo carattere tautologico: per definire la probabilità

occorre sapere cosa significa probabile. Inoltre questa definizione ha un ambito di validità limitato: i

risultati possibili dell’esperimento devono essere un numero finito e devono essere ugualmente probabili.

Tuttavia la definizione classica dà luogo ad alcune proprietà. In particolare

1. la probabilità di un evento A risulta essere un numero sempre compreso tra zero (quando nessun

risultato dell’esperimento è favorevole al verificarsi di A, ovvero A è l’evento impossibile ∅) e uno

(quando tutti i risultati dell’esperimento sono favorevoli ad A,ovvero A è l’evento certo Ω)

P (∅) = 0 ≤ P (A) ≤ 1 = P (Ω)

(1.16)

2. le probabilità di eventi incompatibili risultano additive, ovvero la probabilità dell’unione di due

eventi incompatibili è uguale alla somma delle probabilità dei due eventi

A ∩ B = ∅ ⇒ P (A ∪ B) = P (A) + P (B)

(1.17)

Esempio 1.15 La probabilità di ottenere 4 o 5 lanciando una volta un dado non truccato è pari a

1

1

1

6 + 6 = 3.

Esempio 1.16 La probabilità di ottenere una carta di picche estraendo a caso una carta da un mazzo

1

1

1

+ · · · + 52

= 13 × 52

= 14 .

di carte francesi è pari a 52

È opinione comune che la probabilità del risultato di un certo esperimento sia strettamente legata

alla frequenza delle prove nelle quali l’evento stesso si verifica (successi). Formalmente ciò può essere

espresso nella cosiddetta legge empirica del caso: in una successione di prove fatte nelle stesse condizioni, la

frequenza di un evento si avvicina alla probabilità dell’evento stesso, e l’approssimazione tende a migliorare

con l’aumentare del numero delle prove.

Definizione 1.25 Nella definizione frequentista di probabilità tale legge viene rovesciata: piuttosto che

mettere in relazione la frequenza con la probabilità, è la stessa probabilità ad essere definita come limite

della frequenza relativa dei successi quando il numero delle prove tende all’infinito.

Cap.1: Eventi e probabilità

13

Ma poichè le frequenze sono numeri che dipendono dai dati rilevati sperimentalmente, la loro successione

non è governata da una legge matematica (può solo essere osservata per un numero grande ma finito di

prove), e non c’è nulla che ne garantisca la convergenza. Inoltre anche in questo caso la validità della

definizione è limitata ad esperimenti replicabili più volte nelle stesse condizioni.

Si osservi che anche per la definizione frequentista valgono le proprietà

1. la probabilità risulta essere un numero sempre compreso tra zero (quando l’evento non si è verificato

in nessuna prova - evento impossibile ∅) e uno (quando l’evento si è verificato in tutte le prove evento certo Ω);

2. vale l’additività della probabilità per eventi incompatibili.

In questa concezione, come in quella classica, la probabilità è un valore numerico “vero” determinato

dalla natura degli eventi. Essa assume pertanto un significato concreto, fisico, in altri termini, oggettivo.

Definizione 1.26 Nella sua definizione soggettiva (già accennata da Pascal, espressa da J. Bernoulli,

sviluppata in tempi più recenti da B. de Finetti e J. Savage), invece, la probabilità rappresenta un giudizio

quantitativo individuale espresso dalla misura del grado di fiducia che una persona ha nel verificarsi di un

evento. Tale misura dipende dall’individuo stesso, ovvero dalle sue conoscenze ed informazioni riguardo

all’evento e può perciò variare da individuo a individuo.

La ricerca di un metodo per misurare l’opinione individuale sul verificarsi di un evento porta a considerare

una ipotetica scommessa sul verificarsi dell’evento stesso come punto di partenza per la definizione operativa di probabilità dal punto di vista soggettivo (dovuta essenzialmente a B. de Finetti). La probabilità di

un evento corrisponde al prezzo che un individuo è disposto a pagare (riscuotere) per ricevere (pagare) 1

se l’evento si verifica e 0 se l’evento non si verifica. Le alternative tra parentesi stanno a significare che la

definizione non cambia se ci si riferisce allo scommettitore o al banco. La valutazione soddisfa il cosiddetto

principio di coerenza o equità secondo il quale la scommessa in questione (anche se replicata più volte)

non dà luogo a guadagni o perdite certi.

Si osservi che anche per la definizione soggettiva valgono le proprietà

1. la probabilità risulta essere un numero sempre compreso tra zero e uno. Infatti se Ω è l’evento certo e

pago P (Ω) per ricevere certamente 1, allora il guadagno è 1 − P (Ω). Se P (Ω) < 1 si avrà una vincita

certa, mentre se P (Ω) > 1 si avrà una perdita certa in violazione del principio di coerenza, dunque

in tal caso dovrà essere P (Ω) = 1. Se invece ∅ è l’evento impossibile, allora il guadagno è −P (∅),

dunque, affinché per il principio di coerenza tale guadagno sia nullo, dovrà essere necessariamente

P (∅) = 0.

2. vale l’additività della probabilità per eventi incompatibili. Siano infatti A e B due eventi incompatibili, dunque gli eventi A, B e A ∪ B sono incompatibili e necessari, ovvero hanno intersezione nulla

e unione pari all’evento certo.

(

)

(

(

))

P (A) + P (B) + P A ∪ B = P A ∪ B ∪ A ∪ B = P (Ω) = 1

anche gli eventi A ∪ B e A ∪ B sono incompatibili e necessari, quindi

(

)

(

(

))

P (A ∪ B) + P A ∪ B = P (A ∪ B) ∪ A ∪ B = P (Ω) = 1

dal confronto delle due espressioni precedenti si ottiene

A ∩ B = ∅ ⇒ P (A ∪ B) = P (A) + P (B)

14

A. Pollice - Appunti di Probabilità

1.5

Assiomi e rudimenti della probabilità

In un sistema assiomatico si parte da un insieme di assiomi o postulati che definiscono gli oggetti trattati dal

punto di vista matematico. Tramite le operazioni logiche, dagli assiomi vengono tratte delle conseguenze,

e la teoria che ne deriva può applicarsi ad un certo contesto se e solo se in quel contesto sono validi gli

assiomi di partenza.

Nei paragrafi precedenti si è visto come ciascuna delle diverse interpretazioni della probabilità implichi

alcune proprietà di cui essa gode. Con la definizione assiomatica (dovuta ad A. Kolmogorov) della probabilità questo procedimento viene ribaltato, e la probabilità viene vista come una qualsiasi attribuzione di

un valore numerico a un evento, nel rispetto di determinati requisiti matematici o assiomi.

Definizione 1.27 Posto che gli eventi sono sottoinsiemi dello spazio dei risultati possibili Ω e formano

una σ-algebra F, si definisce misura di probabilità di un evento A ∈ F una funzione reale P (A) tale che

1. P (A) ≥ 0;

2. P (Ω) = 1;

∪

∑∞

3. A1 , A2 , . . . ∈ F con Ai ∩ Aj = ∅ per i ̸= j ⇒ P ( ∞

i=1 Ai ) =

i=1 P (Ai ).

Definizione 1.28 La terna formata dallo spazio Ω, dalla σ-algebra F e dalla funzione P viene detta

spazio di probabilità (Ω, F, P ).

Definizione 1.29 Il valore P (A) della funzione P in corrispondenza dell’evento A è detto probabilità

dell’evento A.

Mentre i primi due assiomi sono compatibili con le tre definizioni di probabilità illustrate in precedenza,

il terzo richiede che la probabilità sia additiva per un’infinità numerabile di eventi (additività completa).

L’ultima condizione è ben più restrittiva rispetto all’additività finita derivante dalle definizioni classica,

frequentista e soggettiva, ma implica importanti conseguenze in termini di proprietà matematiche.

Ricordando che in analisi matematica si chiama misura una funzione di insieme non negativa, completamente additiva e che valga 1 se applicata all’intero spazio a cui è riferita, si può affermare che la

probabilità è una misura definita per gli elementi di F.

Ogni applicazione della definizione assiomatica di probabilità richiede un’adeguata specificazione della

terna (Ω, F, P ), un procedimento che coinvolge un certo grado di astrazione da parte di chi affronta il

problema.

Quando Ω è composto da un numero finito n di eventi elementari ϖ1 , . . . , ϖn , a questi può essere

associata la stessa probabilità che, per il secondo e terzo assioma, risulta pari ad 1/n. È questo il caso in

cui gli eventi elementari sono assunti equiprobabili. Se l’evento A è composto da n(A) eventi elementari

(ovviamente incompatibili), il terzo assioma permette di calcolare la probabilità di A, nel modo seguente

P (A) =

∑ 1

n (A)

# (eventi elementari in A)

=

=

n

n

# (eventi elementari in Ω)

(1.18)

ϖi ∈A

In altri termini quando i casi possibili (gli eventi elementari) sono ugualmente probabili, la probabilità

di un evento A è data dal rapporto tra il numero dei casi favorevoli ad A (gli eventi elementari che compongono A) e il numero di casi possibili [si osservi come tale risultato porti a considerare la definizione

classica di probabilità come l’unico modo per valutare la probabilità di un evento in presenza di un numero

finito di alternative equiprobabili].

Cap.1: Eventi e probabilità

15

Esempio 1.17 Si lancino insieme una moneta e un dado. In tal caso lo spazio dei risultati ha

dimensione n = 12, infatti è

Ω = {T 1, T 2, . . . , T 6, C1, C2, . . . , C6}

1. La probabilità che la moneta presenti testa è pari a

2. La probabilità che il dado presenti un numero pari è

6

12

= 12 ;

6

12

= 12 ;

3. La probabilità che il dado presenti una potenza di due è

4

12

= 13 .

Esempio 1.18 Si estragga una pallina a caso da un’urna contenente 90 palline numerate (da 1 a 90).

In tal caso lo spazio dei risultati ha dimensione n = 90, infatti è Ω = {1, 2, . . . , 90}.

1. La probabilità che il numero estratto sia pari è

45

90

= 12 ;

2. La probabilità che il numero estratto sia inferiore a 20 è

3. La probabilità che il numero estratto sia superiore a 9 è

19

90 ;

81

90

=

9

10 ;

4. La probabilità che il numero estratto sia compreso tra 11 e 25 (estremi inclusi) è

5. La probabilità che il numero estratto sia di due cifre di cui la prima sia 1 è

10

90

15

90

= 16 ;

= 19 .

Il campo nel quale più direttamente si può applicare la definizione classica di probabilità è quello dei

giochi d’azzardo. In essi le regole individuano con precisione le diverse alternative e si può ragionevolmente

supporre che esse siano ugualmente probabili. Poiché in tal caso nel calcolo del numero dei risultati

favorevoli e di quelli possibili gioca un ruolo fondamentale il calcolo combinatorio, si parla a volte di

probabilità combinatorie. Allo scopo nel seguito vengono riportate alcune definizioni utili agli sviluppi

successivi.

Definizione 1.30 Dato un insieme di n oggetti distinti, il numero degli allineamenti che si possono formare con r oggetti scelti tra gli n, ritenendo diversi due allineamenti o perché contengono oggetti differenti

o perché gli stessi oggetti si susseguono in ordine diverso o perché uno stesso oggetto si ripete un numero

diverso di volte, è dato da nr . In tal caso gli allineamenti vengono detti disposizioni con ripetizione di n

oggetti in classe r.

Definizione 1.31 Dato un insieme di n oggetti distinti, il numero degli allineamenti che si possono formare con r oggetti scelti tra gli n, ritenendo diversi due allineamenti o perché contengono oggetti differenti

o perché gli stessi oggetti si susseguono in ordine diverso, è dato da n (n − 1) · · · (n − r + 1) = n(r) . In tal

caso gli allineamenti vengono detti disposizioni semplici o senza ripetizione di n oggetti in classe r.

Definizione 1.32 Dato un insieme di n oggetti distinti, il numero degli allineamenti che si possono formare con tutti essi, ritenendo diversi due allineamenti perché gli stessi oggetti si susseguono in ordine

diverso, è dato da n (n − 1) · · · 1 = n!. In tal caso gli allineamenti vengono detti permutazioni di n oggetti.

Definizione 1.33 Dato un insieme di n oggetti distinti, il numero degli allineamenti che si possono formare con r oggetti scelti tra gli n, ritenendo diversi due allineamenti perché contengono oggetti differenti,

( )

(r)

è dato da nr! = nr . In tal caso gli allineamenti vengono detti combinazioni senza ripetizione di n oggetti

in classe r.

16

A. Pollice - Appunti di Probabilità

Esempio 1.19 Da un mazzo di 52 carte francesi vengono estratte casualmente 13 carte. La probabilità

di ottenere un poker d’assi è data dall’espressione

(4)(48)

(52)9

4

13

Esempio 1.20 Da un’urna contenente 20 palline delle quali 6 sono bianche vengono estratte a caso

simultaneamente 4 palline.

1. la probabilità che vengano estratte 2 palline bianche è data da

(6)(14)

(20)2

2

4

2. la probabilità che venga estratta una pallina bianca è data da

(6)(14)

(20)3

1

4

3. la probabilità che non venga estratta alcuna pallina bianca è data da

(6)(14)

(20)4

0

4

4. la probabilità che vengano estratte almeno 3 palline bianche è data da

(6)(14) (6)(14)

(20)1 + 4(20)0

3

4

4

Esempio 1.21 Da un’urna contenente X palline bianche ed Y palline rosse vengono estratte

simultaneamente 2 palline.

1. L’estrazione di due palline dello stesso colore si verifica quando esse sono entrambe rosse ovvero

entrambe bianche. La probabilità di estrarre due palline dello stesso colore è data pertanto

dall’espressione

(X )(Y ) (X )(Y )

X (X − 1) + Y (Y − 1)

(2X+Y0) + (0X+Y2) =

(X + Y ) (X + Y − 1)

2

2

2. Se la probabilità appena calcolata è nota essere uguale a 12 , allora la relazione tra X ed Y è data

da

X (X − 1) + Y (Y − 1)

1

=

(X + Y ) (X + Y − 1)

2

ovvero dopo alcuni passaggi

X + Y = (X − Y )2

Cap.1: Eventi e probabilità

1.6

17

Prime proprietà e teoremi della probabilità

Alcune proprietà della probabilità si deducono immediatamente dagli assiomi.

Teorema 1.5 La probabilità che un evento A non si verifichi è data da 1 − P (A)

( )

P A = 1 − P (A)

(1.19)

(

)

Dimostrazione:

( ) essendo A ∩ A = ∅ ed A ∪ A = Ω, dal primo e dal terzo assioma si ha 1 = P A ∪ A =

P (A) + P A .

Esempio 1.17 (cnt) Vengono lanciati insieme un dado e una moneta.

1. La probabilità che la moneta presenti croce è pari a 1 −

1

2

= 12 ;

2. La probabilità che il dado presenti un numero dispari è 1 −

1

2

= 12 ;

3. La probabilità che il dado non presenti una potenza di due è 1 −

1

3

= 23 .

Esempio 1.18 (cnt) Viene estratta casualmente una pallina da un’urna che contiene 90 palline

numerate.

1. La probabilità che il numero estratto sia dispari è 1 −

1

2

= 12 ;

2. La probabilità che il numero estratto sia superiore o uguale a 20 è 1 −

3. La probabilità che il numero estratto sia inferiore o uguale a 9 è 1 −

19

90

9

10

=

=

71

90 ;

1

10 ;

4. La probabilità che il numero estratto sia inferiore a 11 e superiore a 25 è 1 −

1

6

= 56 ;

5. La probabilità che il numero estratto sia inferiore a 10 e superiore a 19 è 1 −

1

9

= 89 .

Teorema 1.6 Se A è un evento che implica l’evento B, cioè se A ⊂ B, allora

(

)

P (B) = P (A) + P A ∩ B ≥ P (A)

(1.20)

(

)

Dimostrazione: essendo B = A ∪ A ∩ B ed essendo inoltre A ed A ∩ B eventi incompatibili, considerando

il terzo assioma, si ottiene l’enunciato del teorema.

La prima importante conseguenza del precedente teorema è che per qualsiasi evento A si ha P (A) ≤ 1

e si ottiene considerando B = Ω nell’enunciato. Inoltre se A e B sono eventi equivalenti, ovvero se A ⊂ B

e B ⊂ A, il teorema precedente porta a concludere che P (A) = P (B).

Si noti come dalle proprietà elementari dell’unione e dell’intersezione di eventi è possibile ricavare le

seguenti proprietà:

P (A ∩ ∅) = 0

P (A ∪ ∅) = P (A)

(1.21)

P (A ∩ Ω) = P (A)

P (A ∪ Ω) = 1

18

A. Pollice - Appunti di Probabilità

Inoltre l’applicazione ripetuta del precedente teorema permette di estenderne il risultato ad una

successione finita o numerabile di eventi Ai (disuguaglianza di Boole)

(

)

∑

∪

P

Ai ≤

P (Ai )

(1.22)

i

i

Un’altra proprietà molto importante della probabilità risulta dal seguente teorema.

Teorema 1.7 Se A1 , A2 , . . . ∈ F è una successione di eventi crescente o decrescente con A = limi→∞ Ai ,

si ha

)

(

P (A) = P lim Ai = lim P (Ai )

(1.23)

i→∞

i→∞

Dimostrazione: nel caso di una successione crescente di eventi A1 ⊂ A2 ⊂ . . . ∈ F , posto A0 = ∅, si ha

(∞

)

(∞ )

∞

∪(

∪

∑

)

(

)

Ai ∩ Ai−1

P (A) = P

Ai = P

=

P Ai ∩ Ai−1

i=1

i=1

i=1

l’ultimo passaggio è dovuto al fatto che( gli eventi )Ai ∩ Ai−1 sono a due a due incompatibili per i = 1, 2, . . ..

Inoltre poichè P (Ai ) = P (Ai−1 ) + P Ai ∩ Ai−1 posso scrivere

∞

∑

(

P Ai ∩ Ai−1

)

=

i=1

∞

∑

(P (Ai ) − P (Ai−1 ))

i=1

=

=

=

lim

n→∞

lim

n→∞

n

∑

(P (Ai ) − P (Ai−1 ))

i=1

( n

∑

P (Ai ) −

i=1

n

∑

)

P (Ai−1 )

i=1

lim P (An )

n→∞

In conclusione si ha P (A) = P (limi→∞ Ai ) = limi→∞ P (Ai ) c.v.d..

Nel caso di successione

∪∞decrescente

∩∞di eventi A1 ⊃ A2 ⊃ . . . ∈ F si osservi che vale A1 ⊂ A2 ⊂ . . . ∈ F

A

=

A

=

ed inoltre

lim

i=1

i=1 A

) i

(i =) A, quindi dalla prima parte della dimostrazione si ha che

( ) i→∞

( i

vale P A = P limi→∞ Ai = limi→∞ P Ai e quindi

(

)

P (A) = P lim Ai = lim P (Ai )

i→∞

i→∞

c.v.d..

Le proprietà espresse dal precedente teorema vengono dette continuità dal basso (nel caso di successione

crescente di eventi) e continuità dall’alto (nel caso di successione decrescente) della misura di probabilità.

Si è già parlato della probabilità dell’unione di due o più eventi incompatibili. In questo paragrafo

viene trattato lo stesso caso facendo cadere la condizione di incompatibilità.

Teorema 1.8 (Probabilità dell’unione di eventi compatibili) La probabilità che si verifichi almeno uno di

due eventi A e B è data da

P (A ∪ B) = P (A) + P (B) − P (A ∩ B)

(1.24)

Dimostrazione: si noti come valgano le seguenti due uguaglianze

)

(

A ∪ B = A ∪ (A ∩ B )

B = (A ∩ B) ∪ A ∩ B

Cap.1: Eventi e probabilità

19

le due unioni a secondo membro nelle due espressioni precedenti sono tra eventi incompatibili, quindi

(

)

P (A ∪ B) = P (A) + P (A ∩ B )

P (B) = P (A ∩ B) + P A ∩ B

(

)

Sostituendo nella prima uguaglianza l’espressione di P A ∩ B ricavata dalla seconda si ottiene l’enunciato. c.v.d.

Esempio 1.22 Lanciando due dadi distinti (ad esempio uno rosso e l’altro verde) si hanno 36 possibili risultati o eventi elementari rappresentati da coppie di numeri Ω = {(i, j) : i, j = 1, 2, . . . , 6}. Se

attribuiamo a tutti risultati la stessa probabilità questà sarà pari a 1/36.

1. La probabilità dell’evento A =“il dado rosso dà 6” è pari a

6

36

= 16 ;

2. Analogamente la probabilità dell’evento B =“il dado verde dà 6” è pari ad 16 ;

3. La probabilità dell’evento A ∩ B =“entrambi i dadi danno 6” è pari a

1

36 ;

4. La probabilità dell’evento A ∪ B =“almeno un dado dà 6” è pari ad

1

6

+

5. La probabilità dell’evento A ∪ B =“nessun dado dà 6” è pari ad 1 −

11

36

6. La probabilità dell’evento C =“solo il dado rosso dà 6” è pari a

1

6

=

−

1

36

=

11

36 ;

25

36 ;

5

36 ;

7. Analogamente la probabilità dell’evento D =“solo il dado verde dà 6” è pari a

8. La probabilità dell’evento C ∪ D =“solo uno dei due dadi dà 6” è pari a

5

36 ;

10

36 .

L’applicazione ripetuta del precedente teorema permette di estenderne il risultato ad una successione

finita o numerabile di eventi Ai : per n eventi, la probabilità dell’unione è data dalla somma delle probabilità

degli eventi meno la somma delle probabilità delle intersezioni a due a due, più la somma delle probabilità

delle intersezioni a tre a tre, e così via sino alla probabilità dell’intersezione di tutti gli n eventi col segno

(−1)n+1

)

(n

n

∪

∑

∑

Ai

=

P (Ai ) −

P (Aj ∩ Ah )

P

i=1

i=1

+

1≤j<h≤n

∑

P (Ak ∩ Al ∩ Am ) − · · ·

1≤k<l<m≤n

n+1

+ (−1)

P (A1 ∩ A2 ∩ · · · ∩ An )

(1.25)

20

A. Pollice - Appunti di Probabilità

Esempio 1.23 I primi n numeri interi vengono scritti a caso in un certo ordine, assumendo che ciascuno dei possibili n! ordinamenti abbia la stessa probabilità. Si dice che vi è una “coincidenza” se il

numero r occupa l’r-esima posizione nell’ordinamento.

1. La probabilità dell’evento Ai che si verifica quando l’ordinamento presenta una coincidenza nella i-esima posizione

è pari a

(n − 1)!

1

P (Ai ) =

=

i = 1, . . . , n

n!

n

2. La probabilità di due coincidenze nella i-esima e nella j-esima posizione è pari a

P (Ai ∩ Aj ) =

(n − 2)!

n!

1≤i<j≤n

3. La probabilità di tre coincidenze nella k-esima, nella l-esima e nella m-esima posizione è pari a

P (Ak ∩ Al ∩ Am ) =

(n − 3)!

n!

1≤k<l<m≤n

4. Più in generale la probabilità di k specifiche coincidenze è pari per k = 1, . . . , n a

P (Ai1 ∩ Ai2 ∩ . . . ∩ Aik ) =

(n − k)!

n!

1 ≤ i1 < i2 < · · · < ik ≤ n

5. La probabilità di almeno una coincidenza è dunque data da

(∪n

)

( )

( )

P

= nP (Ai ) − n2 P (Ai ∩ Aj ) + n3 P (Ak ∩ Al ∩ Am )

i=1 Ai

(n)

P (Ai1 ∩ Ai2 ∩ . . . ∩ Aik ) + · · ·

k

−

· · · + (−1)k+1

+

(−1)n+1 P (A1 ∩ A2 ∩ . . . ∩ An )

=

n n1 −

+

(−1)k+1

=

1−

1

2!

(n) (n−2)!

n!

2

+

+

(n) (n−k)!

k

1

3!

n!

(n) (n−3)!

3

n!

− ···

+ · · · + (−1)n+1

− · · · + (−1)k+1

1

k!

1

n!

+ · · · + (−1)n+1

1

n!

6. La probabilità di nessuna coincidenza è data da

( n

)

∪

1

1

1

1

1−P

Ai =

−

+ · · · − (−1)k+1

− · · · − (−1)n+1

2!

3!

k!

n!

i=1

Se A e B sono due eventi relativi a un certo esperimento, si indica con P (A|B) la probabilità (condizionata) di A dato B. In altri termini con P (A|B) si indica la probabilità dell’evento A condizionata

dal verificarsi di B, cioè la probabilità che ha A di verificarsi quando si sappia che B si è verificato. La

differenza tra la probabilità di A e quella di A dato B è che nel primo caso si assume che gli eventi

elementari (i possibili risultati dell’esperimento) siano gli elementi di Ω, mentre nel secondo caso gli eventi

elementari sono solo quelli contenuti in B.

Definizione 1.34 Dati due eventi A e B con P (B) ̸= 0 la probabilità (condizionata) di A dato B è data

dall’espressione

P (A ∩ B)

P (A|B) =

(1.26)

P (B)

Cap.1: Eventi e probabilità

21

Esempio 1.24 In una mano (estrazione in blocco di 13 carte dal mazzo di 52) di carte francesi si

determini la probabilità di ottenere almeno tre K condizionata all’ipotesi che la mano ne contenga almeno

due.

Sia nK l’evento che si verifica quando la mano contiene esattamente n K.

P (“almeno tre K”|“almeno due K”) = P (3K ∪ 4K|2K ∪ 3K ∪ 4K)

=

P ((3K∪4K)∩(2K∪3K∪4K))

P (2K∪3K∪4K)

=

P (3K∪4K)

P (2K∪3K∪4K)

=

P (3K)+P (4K)

P (2K)+P (3K)+P (4K)

=

(43)(48

(4)(48)

10)

+ 4 52 9

52

(13)

(13)

4 48

(42)(48

(

(4)(48)

11)

3)(10)

+ 52 + 4 52 9

52

(13)

(13)

(13)

∼

=

0.041+0.003

0.213+0.041+0.003

∼

= 0.171

Si dimostra agevolmente che per ogni prefissato B ∈ F la probabilità condizionata P (·|B) data dalla

definizione precedente gode delle proprietà

1. P (A|B) ≥ 0 ∀A ∈ F

2. P (Ω|B) = 1

3. A1 , A2 , . . . ∈ F, Ai ∩ Aj = ∅, i ̸= j

∪

∑∞

P( ∞

i=1 Ai | B) =

i=1 P (Ai |B)

Dunque la probabilità condizionata soddisfa i tre assiomi che definiscono una misura di probabilità su

F. Inoltre poiché P (Ω|B) = P (B|B), P (·|B) è anche una misura di probabilità sulla σ-algebra B ⊂ F

generata da B ⊂ Ω e dà luogo allo spazio di probabilità (B, B, P (·|B)).

Inoltre dalla definizione precedente è immediato ottenere la relazione nota sotto il nome di legge delle

probabilità composte che permette di calcolare la probabilità dell’intersezione di due eventi A e B quando

si conoscano la probabilità condizionata e quella dell’evento condizionante

P (A ∩ B) = P (A|B) P (B)

(1.27)

22

A. Pollice - Appunti di Probabilità

Esempio 1.25 Un’urna contenga 7 palline nere e 5 bianche. La probabilità che 2 palline estratte a caso

senza reinserimento (in blocco) siano nere è data da

(7)(5)

1. soluzione meccanica

(12)0 =

2

2

7

22

2. soluzione ragionata

N 1 =“la prima pallina estratta è nera”

N 2 =“la seconda pallina estratta è nera”

P (N 1) =

7

12 ,

P (N 2|N 1) =

P (N 1 ∩ N 2) = P (N 2|N 1) P (N 1) =

6

11

6×7

11×22

=

7

22

Esempio 1.26 Una persona sbadata cerca di aprire la sua porta di casa prendendo una chiave a caso

da un mazzo di n chiavi ed eliminando di volta in volta le chiavi che ha già provato. Si vuole calcolare

la probabilità che egli provi x chiavi (con x = 0, . . . , n − 1) prima di trovare quella giusta.

Sx =“le prime x chiavi sono sbagliate”

Gx+1 =“la (x + 1)-esima chiave è quella giusta”

(n−1)(1)

1

1

x( ) 0

P (Sx ∩ Gx+1 ) = P (Gx+1 |Sx ) P (Sx ) =

= ··· =

n

n−x

n

x

La legge delle probabilità composte può essere facilmente estesa per induzione a una famiglia di n

eventi A1 , A2 , . . . , An

P (A1 ∩ A2 ∩ . . . ∩ An ) = P (A1 ) P (A2 |A1 ) · · · P (An |A1 ∩ A2 ∩ . . . ∩ An−1 )

(1.28)

Cap.1: Eventi e probabilità

23

Esempio 1.27 Un’urna contiene 3 palline rosse e 5 verdi.Vengono estratte successivamente e senza

reinserimento 4 palline.

Ri =“pallina rossa alla i-esima estrazione” i = 1, . . . , 4

Vi =“pallina verde alla i-esima estrazione” i = 1, . . . , 4

1. La probabilità che i due colori si alternino nelle quattro estrazioni è data da

P [(R1 ∩ V2 ∩ R3 ∩ V4 ) ∪ (V1 ∩ R2 ∩ V3 ∩ R4 )]

=

P (R1 ∩ V2 ∩ R3 ∩ V4 ) + P (V1 ∩ R2 ∩ V3 ∩ R4 )

=

P (V4 |R1 ∩ V2 ∩ R3 ) P (R3 |R1 ∩ V2 ) P (V2 |R1 ) P (R1 )

+P (R4 |V1 ∩ R2 ∩ V3 ) P (V3 |V1 ∩ R2 ) P (R2 |V1 ) P (V1 )

ed essendo

P (R1 ) =

3

8

P (V1 ) =

P (V2 |R1 ) =

5

7

P (R3 |R1 ∩ V2 ) =

2

6

5

8

P (R2 |V1 ) =

3

7

4

6

=

1

3

P (V3 |V1 ∩ R2 ) =

=

2

3

P (V4 |R1 ∩ V2 ∩ R3 ) =

4

5

P (R4 |V1 ∩ R2 ∩ V3 ) =

2

5

si ha che la probabilità cercata è data da

3×5×1×4

5×3×2×2

1

+

=

8×7×3×5

8×7×3×5

7

2. La probabilità di ottenere la prima pallina verde alla terza estrazione è data da

P (V3 ∩ R1 ∩ R2 )

=

P (V3 |R1 ∩ R2 ) P (R1 ∩ R2 )

=

P (V3 |R1 ∩ R2 ) P (R2 |R1 ) P (R1 )

=

5

6

·

2

7

·

3

8

=

5

56

3. La probabilità di ottenere la prima pallina verde alla (x + 1)-esima estrazione (x = 1, 2, 3) è data da

P (Vx+1 ∩ R1 ∩ . . . ∩ Rx )

= P (Vx+1 |R1 ∩ . . . ∩ Rx ) P (R1 ∩ . . . ∩ Rx )

=

5

8−x

·

(x3)(50)

(x8)

x = 1, 2, 3

24

A. Pollice - Appunti di Probabilità

Esempio 1.28 Tre signori lasciano i loro cappelli in un guardaroba buio. Si vuole determinare la

probabilità che scegliendo a caso nessun signore recuperi il proprio cappello.

Ei =“l’i-esimo signore recupera il suo cappello”, i = 1, 2, 3

La probabilità richiesta dalla traccia è

1 − P (E1 ∪ E2 ∪ E3 ) = 1 − [P (E1 ) + P (E2 ) + P (E3 ) − P (E1 ∩ E2 )

−

P (E1 ∩ E3 ) − P (E2 ∩ E3 ) + P (E1 ∩ E2 ∩ E3 )]

poiché è

P (E1 ) = P (E2 ) = P (E3 ) =

1

3

P (E1 ∩ E2 ) = P (E1 ∩ E3 ) = P (E2 ∩ E3 ) = P (E2 |E3 ) P (E3 ) =

P (E1 ∩ E2 ∩ E3 ) = P (E1 |E2 ∩ E3 ) P (E2 ∩ E3 ) = 1 ·

dunque la probabilità cercata è

(

1 1

1

1− 3· −3· +

3

6 6

)

=

1

6

=

1

2

·

1

3

=

1

6

1

6

1

3

Teorema 1.9 (Legge delle probabilità totali) Sia B1 , B2 , . . . una famiglia di eventi dei quali uno e uno

solo si verifica (necessari e incompatibili). In altri termini

1.

∪∞

i=1 Bi

= Ω;

2. Bi ∩ Bj = ∅,

3. P (Bi ) > 0,

i ̸= j;

i = 1, 2, . . ..

Sia A un qualunque altro evento, allora

P (A) =

∞

∑

P (A ∩ Bi ) =

i=1

∞

∑

P (A|Bi ) P (Bi )

(1.29)

i=1

Dimostrazione:

A=A∩Ω=A∩

(∞

∪

)

Bi

=

∞

∪

(A ∩ Bi )

i=1

i=1

Essendo gli eventi A ∩ Bi a due a due incompatibili per i = 1, 2, . . ., dall’applicazione del teorema delle

probabilità totali per eventi incompatibili segue che

P (A) =

∞

∑

i=1

P (A ∩ Bi ) =

∞

∑

P (A|Bi ) P (Bi )

i=1

Il risultato precedente (ovviamente valido in particolare per una famiglia finita B1 , B2 , . . . , Bn di n

eventi) risulta essere estremamente utile per il calcolo delle probabilità di eventi mediante l’uso di probabilità condizionate, ovvero quando è difficile calcolare P (A) e invece risulta più agevole determinare

P (A|Bi ) per i = 1, 2, . . ., cioè la probabilità dello stesso evento A supponendo che si sia verificato Bi per

i = 1, 2, . . ..

Cap.1: Eventi e probabilità

25

Esempio 1.29 In un esperimento per valutarne le capacità di apprendimento un animale da laboratorio

(cavia) può scegliere tra due diverse fonti di cibo poste a destra e a sinistra della gabbia. Nella mangiatoia

a destra viene aggiunto un additivo inodore ed incolore che rende il cibo disgustoso. Si assume che

all’inizio dell’esperimento la cavia abbia la medesima probabilità di mangiare da entrambe le mangiatoie.

Dopo aver mangiato il cibo buono la probabilità che la cavia vada a destra al tentativo successivo è 0.4.

Tuttavia la cavia reagisce in modo più evidente al cibo disgustoso e la probabilità che, avendolo mangiato

essa torni a destra al tentativo successivo è pari a 0.2. Si vogliono conoscere le probabiiltà che la cavia

vada a destra al secondo e al terzo tentativo.

Di =“la cavia va a destra (cibo disgustoso) per la i-esima volta”

Si =“la cavia va a sinistra (cibo buono) per la i-esima volta”

Il problema richiede di determinare P (D2 ) e P (D3 ) sapendo che

P (D1 ) = P (S1 ) = 0.5

P (Di+1 |Si ) = 0.4 ⇒ P (Si+1 |Si ) = 0.6

P (Di+1 |Di ) = 0.2 ⇒ P (Si+1 |Di ) = 0.8

Dall’applicazione del teorema delle probabilità totali si ottiene

P (D2 ) = P (D2 |D1 ) P (D1 ) + P (D2 |S1 ) P (S1 ) = 0.2 × 0.5 + 0.4 × 0.5 = 0.3

ed essendo P (S2 ) = 1 − P (D2 ) = 0.7,

P (D3 ) = P (D3 |D2 ) P (D2 ) + P (D3 |S2 ) P (S2 ) = 0.2 × 0.3 + 0.4 × 0.7 = 0.34

Analogamente possono essere calcolate le probabilità relative ai tentativi successivi

P (D4 ) = 0.332

P (D5 ) = 0.336

P (D6 ) = 0.3328

P (D7 ) = 0.3334

···

che mostrano come al protrarsi dei tentativi la probabilità che la cavia vada a destra tenda a stabilizzarsi

attorno al valore 0.3.

Spesso si dispone di informazioni sotto forma di probabilità condizionate del tipo P (A|B) quando

servirebbe conoscere P (B|A). In altri termini spesso occorre invertire il ruolo di evento condizionato ed

evento condizionante. A titolo di esempio si pensi al caso di un test clinico per la diagnosi di una certa

malattia. Se T indica la presenza della malattia accertata dal test ed M indica l’effettivo stato di salute del

paziente, nella gran parte dei casi si conoscono le probabilità P (M ) (da fonti

e P (T |M )

( epidemiologiche)

)

(caratteristiche operative del test) e si vogliono conoscere P (M |T ) e P M |T , ovvero le probabilità

relative all’affidabilità della diagnosi.

Teorema 1.10 (di Bayes) Data una famiglia finita o numerabile

di eventi B1 , B2 , . . . incompatibili e

∪

necessari (per i quali cioè valgono Bi ∩ Bj = ∅ per i ̸= j e ∞

B

=

Ω con P (Bi ) > 0) e un qualunque

i

i=1

altro evento A con P (A) > 0, si ha

P (A|Bi ) P (Bi )

P (Bi |A) = ∑∞

i=1 P (A|Bi ) P (Bi )

i = 1, 2, . . .

(1.30)

26

A. Pollice - Appunti di Probabilità

Dimostrazione: per la legge delle probabilità composte vale

P (Bi |A) =

P (A ∩ Bi )

P (A|Bi ) P (Bi )

=

P (A)

P (A)

Utilizzando il teorema 5 per il calcolo del denominatore dell’espressione precedente si ottiene l’enunciato

del teorema, c.v.d..

L’espressione precedente, che corrisponde ad una delle formule più utili della teoria della probabilità,

è dovuta al teologo e matematico inglese Thomas Bayes (1702-1761). Gli eventi Bi possono essere considerati come possibili cause dell’evento A ed il teorema di Bayes permette di individuare la probabilità

di tali cause una volta osservato l’effettivo verificarsi dell’evento A. Le probabilità P (Bi ) sono dette probabilità a priori o iniziali, mentre P (Bi |A) sono le probabilità a posteriori o finali (valutate sapendo che

si è verificato A). Il verificarsi di A modifica dunque le probabilità degli eventi Bi e a determinare tale

modifica sono le cosiddette verosimiglianze P (A|Bi ).

Esempio 1.30 La produzione in serie di un certo manufatto abbia una difettosità pari al 2% dei pezzi

prodotti. Si sa che un test per il controllo in corso di produzione ha una probabilità pari a 0.03 di scartare

un pezzo non difettoso e una probabilità pari a 0.05 di accettare un pezzo difettoso.

D =“il pezzo è difettoso”

T =“il pezzo è difettoso secondo il test”

( )

P( (D) )= 0.02

P( D )= 0.98

P (T |D) = 0.03 P T |D = 0.97

P T |D = 0.05 P (T |D) = 0.95

La probabilità che il pezzo analizzato sia difettoso posto che il test dà un risultato non soddisfacente è

P (D|T ) =

P (T |D) P (D)

(

) ( )∼

= 0.39

P (T |D) P (D) + P T |D P D

Esempio 1.31 Si sappia che 5 uomini su 100 e 25 donne su 10000 sono daltonici. Nell’ipotesi che

uomini e donne siano in ugual numero, si voglia conoscere la probabilità che una persona daltonica scelta

a caso sia di sesso femminile.

M =“la persona scelta a caso è di sesso maschile”

F =“la persona scelta a caso è di sesso femminile”

D =“la persona scelta a caso è daltonica”

P (M ) = P (F ) =

P (D|M ) =

5

100

=

1

20

1

2

P (D|F ) =

25

10000

=

1

400

La traccia richiede di determinare la probabilità seguente:

P (D|F ) P (F )

P (F |D) =

=

P (D|F ) P (F ) + P (D|M ) P (M )

1

400 ·

1

1

400 · 2 +

1

2

1

20

·

1

2

=

1

21

Cap.1: Eventi e probabilità

27

Esempio 1.32 Si consideri il gioco seguente. Due buste contengono rispettivamente due banconote da

$100 e una da $1 e una banconota da $100 e due da $1. Dopo aver scelto a caso una delle due buste,

si osservi il valore di una sola delle tre banconote contenute e si decida quale delle due buste tenere. Si

calcoli la probabilità di ottenere la busta con più soldi se si adotta la strategia che porta a tenere la busta

se la banconota osservata vale $100 e a prendere l’altra se invece vale $1.

B1 =“scelgo la busta con 2 banconote da $100 e una da $1”

B2 =“scelgo la busta con 2 banconote da $1 e una da $100”

A =“la banconota osservata vale $100”

P (B1) = P (B2) =

P (A|B1) =

2

3

1

2

P (A|B2) =

1

3

La probabilità richiesta dalla traccia è

P (B1|A) =

P (A|B1) P (B1)

=

P (A|B1) P (B1) + P (A|B2) P (B2)

2

3

·

2 1

3 · 2

1

1

2 + 3

·

1

2

=

2

3

Intuitivamente dire che A è stocasticamente indipendente da B significa dire che il verificarsi di B non

influisce sulla probabilità del verificarsi di A. In altre parole la probabilità di A condizionata al verificarsi

di B è uguale alla probabilità di A (non condizionata)

(1.31)

P (A|B) = P (A)

Definizione 1.35 Due eventi A e B si dicono stocasticamente indipendenti se e solo se

P (A ∩ B) = P (A) · P (B)

(1.32)

Si noti come l’indipendenza stocastica risulti reciproca, essendo la condizione che la definisce simmetrica rispetto ai due eventi. Si noti inoltre come definizione di indipendenza stocastica corrisponda alla

relazione P (A|B) = P (A) quando P (B) ̸= 0, ovvero quando è possibile sostituire a P (A|B) la sua

espressione definitoria.

Esempio 1.33 Due arceri tirano indipendentemente l’uno dall’altro una freccia per ciascuno sullo stesso

bersaglio. Le probabilità che hanno rispettivamente di centrare il bersaglio sono pari a 97 per il primo

9

arcere e a 11

per il secondo. La probabilità che il bersaglio sia centrato da uno dei due arceri è data da

C1 =“il primo arcere fa centro”

C2 =“il secondo arcere fa centro”

P (C1 ∪ C2) = P (C1) + P (C2) − P (C1 ∩ C2)

= P (C1) + P (C2) − P (C1) · P (C2)

=

7

9

+

9

11

−

7×9

9×11

=

95

99

28

A. Pollice - Appunti di Probabilità

Esempio 1.34 Si lancino insieme un dado verde e uno rosso.

F =“il dado verde mostra la faccia 4”

E1 =“la somma dei punti e uguale a 6”

P (E1 ∩ F ) =

P (E1 ) P (F ) =

1

6

·

5

36

1

6

·

=

1

6

1

36

=

5

216

P (E1 ∩ F ) ̸= P (E1 ) P (F )

E1 ed F non sono indipendenti;

E2 =“la somma dei punti e uguale a 7”

P (E2 ∩ F ) =

P (E2 ) P (F ) =

·

1

6

=

6

36

·

1

6

1

6

1

36

=

1

36

P (E2 ∩ F ) = P (E2 ) P (F )

E2 ed F sono indipendenti;

E3 =“la somma dei punti e uguale a 8”

P (E3 ∩ F ) =

P (E3 ) P (F ) =

1

6

·

5

36

1

6

·

=

1

6

1

36

=

5

216

P (E3 ∩ F ) ̸= P (E3 ) P (F )

E3 ed F non sono indipendenti.

La nozione di indipendenza stocastica può essere estesa con riferimento a più di due eventi.

Definizione 1.36 Gli eventi A1 , A2 , . . . , An si dicono mutuamente (stocasticamente) indipendenti se e

solo se

P (Ai1 ∩ Ai2 ∩ . . . ∩ Aik ) = P (Ai1 ) · P (Ai2 ) · · · · · P (Aik )

(1.33)

per ogni k = 2, 3, . . . , n e per ogni allineamento i1 < i2 < · · · < ik dei numeri 1, 2, . . . , n.

Si noti come l’indipendenza tra gli eventi presi a due a due non sia sufficiente a garantire la mutua

indipendenza tra tutti gli n eventi.

Cap.1: Eventi e probabilità

29

Esempio 1.35 Vengono lanciati indipendentemente un dado verde e un dado rosso. Le probabilità dei

tre eventi

A1 =“il dado verde mostra un numero pari”

A2 =“il dado rosso mostra un numero pari”

A3 =“la somma dei risultati dei due dadi è pari”

risultano intuitivamente P (A1 ) = P (A2 ) = P (A3 ) = 12 . Inoltre si verifica facilmente che

P (A1 ∩ A2 ) = P (A2 ∩ A3 ) = P (A1 ∩ A3 ) =

P (A1 ∩ A2 ∩ A3 ) =

1

4

1

4

I tre eventi non risultano dunque indipendenti, pur essendo indipendenti a due a due. Si noti come sia

immediato concludere circa la non indipendenza dei tre eventi, infatti se si verificano A1 e A2 , allora si

verifica necessariamente anche A3 . In altri termini l’evento A1 ∩ A2 implica A3 , quindi A1 ∩ A2 ∩ A3 =

A1 ∩ A2 e di conseguenza P (A3 |A1 ∩ A2 ) = 1.

Esempio 1.36 Sia p la probabilità di nascita di una femmina e 1 − p quella di un maschio. Assunta

l’indipendenza del sesso dei figli di una stessa coppia, la probabilità che una coppia abbia tre figlie femmine

è p3 , quella che abbia tre maschi è (1 − p)3 , quella che abbia tre figli dello stesso sesso è p3 + (1 − p)3 .

Esempio 1.37 Sia p la probablità di vincere a ciascun lancio di un dado. Il giocatore A lancia il dado la

prima volta e se perde lo passa al giocatore B che lo lancia a sua volta. Continuano a lanciare e passarsi

il dado sinché uno dei due vince. Le rispettive probabilità di vincita del giocatore A e del giocatore B

sono date da

P (“A vince”)

= p + (1 − p) (1 − p) p + (1 − p) (1 − p) (1 − p) (1 − p) p + · · ·

2

4

= p + (1 − p) p + (1 − p) p + · · ·

∞ [

]x

∑

1

2

= p

(1 − p)

=p·

2

1

−

(1

− p)

x=0

1

=

2−p

P (“B vince”)

3

5

(1 − p) p + (1 − p) p + (1 − p) p + · · ·

∞ [

]x

∑

2

= p (1 − p)

(1 − p)

=

x=0

=

1−p

2−p

30

A. Pollice - Appunti di Probabilità

Esempio 1.38 (estrazioni senza reimmissione) Da un’urna contenente M palline di cui m bianche ed

M − m nere, si estraggono successivamente n palline senza reimmissione (o in blocco). La probabilità

che x delle n palline estratte siano bianche è data, come è noto, da

(m)(M −m)

x

(Mn−x

)

sup (0, n − M + m) ≤ x ≤ inf (n, m)

(1.34)

n

l’espressione precedente, considerata come funzione dell’argomento x a valori naturali, prende il nome

di distribuzione ipergeometrica.

Esempio 1.39 (estrazioni con reimmissione) Da un’urna contenente M palline di cui m bianche ed M −

m nere, si estraggono successivamente n palline con reimmissione. In altri termini ciascuna estrazione

viene effettuata con la medesima composizione dell’urna. Intuitivamente i risultati di estrazioni successive

sono indipendenti tra loro e la probabilità di estrarre una pallina bianca è costante per ogni estrazione e

m

. La probabilità che x delle n palline estratte siano bianche è data da

pari a M

( )( ) (

n

m x

m )n−x

1−

x = 0, 1, . . . , n

(1.35)

x

M

M

( m )x (

)

m n−x

Infatti M

1− M

è la probabilità che si verifichi una particolare sequenza (di)n estrazioni di cui

x risultano in una pallina bianca e le restanti n − x in una pallina nera, mentre nx è il numero complessivo di possibili sequenze di questo tipo, ovviamente tra loro incompatibili. L’espressione precedente,

considerata come funzione di x, prende il nome di distribuzione binomiale.