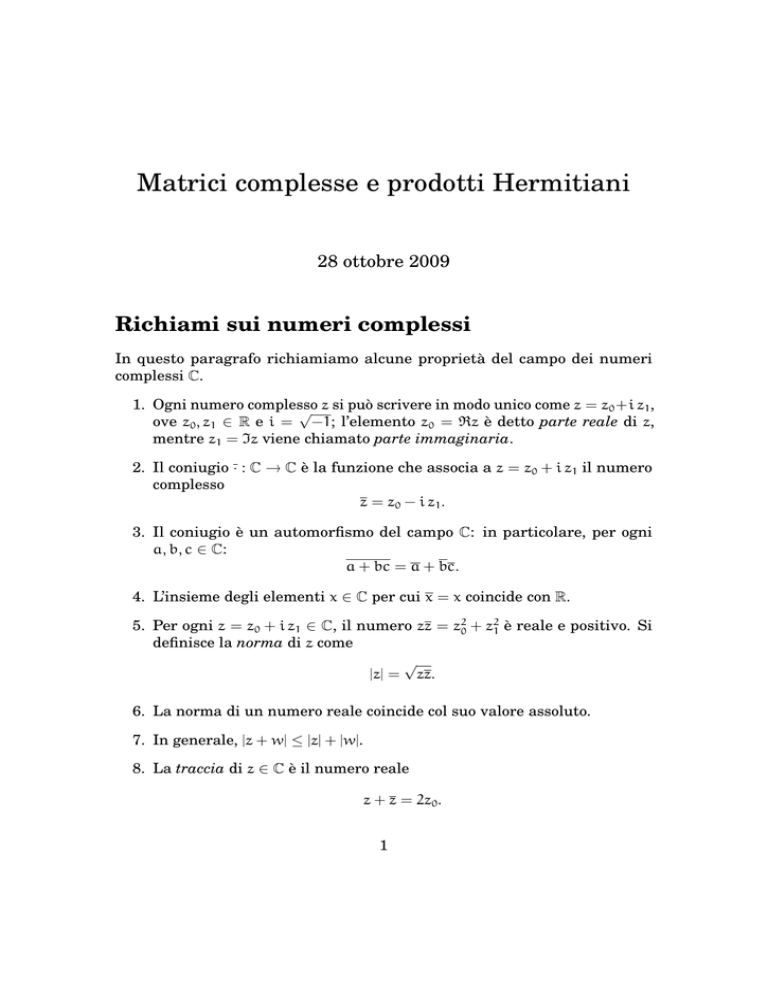

Matrici complesse e prodotti Hermitiani

28 ottobre 2009

Richiami sui numeri complessi

In questo paragrafo richiamiamo alcune proprietà del campo dei numeri

complessi C.

1. Ogni numero complesso

√ z si può scrivere in modo unico come z = z0 +i z1 ,

ove z0 , z1 ∈ R e i = −1; l’elemento z0 = <z è detto parte reale di z,

mentre z1 = =z viene chiamato parte immaginaria.

2. Il coniugio · : C → C è la funzione che associa a z = z0 + i z1 il numero

complesso

z = z0 − i z1 .

3. Il coniugio è un automorfismo del campo C: in particolare, per ogni

a, b, c ∈ C:

a + bc = a + bc.

4. L’insieme degli elementi x ∈ C per cui x = x coincide con R.

5. Per ogni z = z0 + i z1 ∈ C, il numero zz = z20 + z21 è reale e positivo. Si

definisce la norma di z come

√

|z| = zz.

6. La norma di un numero reale coincide col suo valore assoluto.

7. In generale, |z + w| ≤ |z| + |w|.

8. La traccia di z ∈ C è il numero reale

z + z = 2z0 .

1

9. In generale

1

<z = (z + z);

2

i

=z = (z − z).

2

10. Ogni numero complesso può rappresentarsi in forma polare come

z = a(cos θ + i sin θ) = a eiθ ,

ove a, θ ∈ R, a ≥ 0 mentre −π < θ ≤ π. Se z 6= 0 tale rappresentazione

è unica. Il numero a = |z| il modulo di z, mentre θ è detto argomento.

11. Il campo complesso è algebricamente chiuso. In particolare, ogni polinomio p(x) ∈ C[x] di grado almeno 1 a coefficienti in C ammette sempre

almeno una soluzione x

^ ∈ C.

12. Conseguentemente, un polinomio di grado n in C ammette sempre

esattamente n soluzioni complesse, contate con la debita molteplicità.

13. Applicando il teorema di Ruffini si ha che per ogni p(x) ∈ C[x] di grado

n esistono λ1 , . . . , λn (non necessariamente tutti distinti) tali che

p(x) = (x − λ1 )(x − λ2 ) · · · (x − λn ).

In altre parole, si dice che p(x) si spezza in fattori lineari (i.e. di primo

grado) su C.

Prodotti Hermitiani

Vogliamo definire un prodotto fra vettori di uno spazio vettoriale V sul campo

complesso C che subordini una norma su V. In particolare, si desidera ∀x ∈ V,

0 ≤ hx, xi ∈ R.

È chiaro che h·, ·i non potrà essere una forma bilineare ψ, in quanto, anche se

per qualche vettore x ∈ V, si ha ψ(x, x) ∈ R, comunque

ψ((1 + i)x, (1 + i)x) = 2iψ(x, x) 6∈ R

Definizione 1. Sia V uno spazio vettoriale sul campo C. Si dice forma

sesquilineare su V ogni applicazione φ : V × V → C tale che, per ogni x, y, z ∈

V e λ ∈ C:

1. φ è lineare nella prima componente, cioè

φ(x + λy, z) = φ(x, z) + λφ(y, z);

2

2. φ è antilineare nella seconda componente, cioè

φ(z, x + λy) = φ(z, x) + λφ(z, y).

Se vale inoltre la condizione

φ(x, y) = φ(y, x),

allora φ è detta simmetrica.

Data una forma sesquilineare simmetrica φ abbiamo

φ(x, x) = φ(x, x),

da cui segue φ(x, x) ∈ R.

Definizione 2. Sia M ∈ Matn (C). Indichiamo con il simbolo M? la matrice

aggiunta Hermitiana di M, ottenuta coniugando la trasposta di M. In simboli

T

M? = MT = M .

Definizione 3. Una matrice H ∈ Matn (C) è detta Hermitiana se H∗ = H.

Teorema 1. Una forma φ : Cn × Cn → C è sesquilineare simmetrica se, e

solamente se, esiste una matrice Hermitiana H tale che

φ(x, y) = xT Hy.

Dimostrazione. Innanzi tutto verifichiamo che, data una matrice H con H? =

H, l’applicazione θH (x, y) = xT Hy è sesquilineare simmetrica. Infatti, per

ogni x, y, z ∈ Cn e λ ∈ C si ha

1. θ(x + λz, y) = (x + λz)T Hy = xT Hy + λzT Hy = θ(x, y) + λθ(z, y).

2. θ(x, y) = xT Hy = x? Hy = yT H? x = θ(y, x).

Viceversa, sia φ una forma sesquilineare simmetrica e fissiamo una base di

Cn

B = {b1 , b2 , . . . , bn }.

Consideriamo la matrice H = (hij ) le cui entrate sono

hij = φ(bi , bj ).

Per la simmetria di φ, abbiamo che hij = hji , cioè H? = H. Inoltre, scrivendo i

vettori x e y in componenti rispetto B,

φ(x, y) =

n X

n

X

xi yj φ(bi , bj ) =

n X

n

X

i=1 j=1

i=1 j=1

La tesi segue.

3

xi yj hij = xT Hy.

Definizione 4. Sia φ : V × V → C una forma sesquilineare simmetrica.

L’applicazione h : V → R descritta da

h(x) = φ(x, x)

è detta forma Hermitiana associata a φ.

Definizione 5. Una forma Hermitiana h su V è detta definita positiva se, per

ogni x ∈ V si ha h(x) = φ(x, x) ≥ 0 e h(x) = 0 se, e solamente se x = 0. In tale

caso la forma sesquilineare φ che induce h sarà detta prodotto Hermitiano.

Una matrice Hermitiana H è definita positiva se, e solamente se, la forma

Hermitiana

h(x) = xT Hx

ad essa associata è definita positiva.

Osserviamo che poiché h(x) ∈ R per ogni x ∈ V e HT = H,

h(x) = h(x) = x? Hx = x? HT x.

definita positiva associata ad una

Teorema 2. Sia h una forma Hermitiana

p

forma sesquilineare φ. Allora, ||x|| = h(x) è una norma su V.

Dimostrazione. Rammentiamo

che il modulo di un numero complesso λ è il

√

numero reale |λ| = λλ. Innanzi tutto osserviamo che

||λx||2 = λλ||x||2 = |λ|2 ||x||2 .

Dobbiamo verificare ora la disuguaglianza triangolare, cioè (elevando tutto

al quadrato)

h(x + y) ≤ h(x) + h(y).

Dimostriamo dapprima che la disuguaglianza di Schwartz vale anche nel

caso di forme sesquilineari. Poiché φ è definita positiva abbiamo, per ogni

α∈C

φ(x + αy, x + αy) = φ(x, x) + |α|2 φ(y, y) + αφ(x, y) + αφ(x, y) ≥ 0

In particolare, ponendo α = − φ(x,y)

otteniamo

φ(y,y)

φ(x, x) +

|φ(x, y)|2

|φ(x, y)|2

−2

≥0

φ(y, y)

φ(y, y)

4

da cui si deduce

|φ(x, y)|2 ≤ φ(x, x)φ(y, y),

cioè

|φ(x, y)| ≤ ||x|| ||y||.

D’altro canto,

||x + y||2 = h(x + y) = φ(x + y, x + y) =

h(x) + φ(x, y) + φ(x, y) + h(y) ≤ |h(x) + φ(x, y) + φ(x, y) + h(y)| ≤

h(x) + |φ(x, y)| + |φ(x, y)| + h(y) = h(x) + 2|φ(x, y)| + h(y) ≤

||x||2 + 2||x|| ||y|| + ||y||2 .

Quindi,

||x + y|| ≤ ||x|| + ||y||

e la dimostrazione è conclusa.

Sia x un vettore colonna di V = Cn . Il prodotto Hermitiano standard su V

è definito come

hx, yi = xT y.

Pertanto, la forma Hermitiana standard su V risulta

h(x) = xT x.

Tenuto conto che h(x) ∈ R si vede che

h(x) = h(x) = xT x = x? x.

Pertanto, tale forma associa al vettore x = (x1 , x2 , . . . , xn )T il numero reale

X

X

h(x) =

xi xi =

|xi |2 ;

i

i

ed essa risulta definita positiva. La norma indotta da h verrà indicata col

simbolo

p

||x||2 = h(x).

Osserviamo che, se x ∈ Rn , tale norma coincide esattamente con la || · ||2

precedentemente introdotta. Similmente, ristretto a vettori x, y ∈ Rn un

qualsiasi prodotto Hermitiano si comporta come un prodotto scalare.

Diremo che due vettori x, y ∈ Cn sono ortogonali se, e solamente se,

hx, yi = 0,

5

ove h·, ·i denota il prodotto Hermitiano standard.

Sia ora M ∈ Matn,m (C) una matrice qualsiasi. Osserviamo che M induce

in modo naturale un omomorfismo fra gli spazi vettoriali W = Cm e V = Cn .

Prendiamo x ∈ Cn e y ∈ Cm . Inoltre,

T

hx, Myi = xT My = xT MT y = xT (M? )T y = hM? x, yi .

Teorema 3 (Teorema di rappresentazione). Sia V uno spazio vettoriale su C

di dimensione finita, e V ∗ il suo duale. Per ogni ϕ ∈ V ∗ esiste un vettore y ∈ V

tale che, per ogni x ∈ V,

ϕ(x) = hx, yi .

Dimostrazione. Per definizione di forma sesquilineare, l’applicazione h·, yi è

un elemento del duale V ∗ per ogni possibile scelta del vettore y. Fissiamo

una base ortonormale per V

E = {e1 , e2 , . . . , en }

e siano αi = ϕ(ei ) per i = 1, . . . n. Poniamo

y=

n

X

αi ei .

i=1

Allora,

hei , yi =

n

X

hei , αi ei i = αi hei , ei i = αi .

i=1

Poiché le due forme lineari ϕ e h·, yi coincidono su di una base di V, esse sono

la stessa.

Osserviamo che, esattamente come nel caso del prodotto scalare per spazi

vettoriali reali, si che, per ogni y ∈ Cn , l’insieme

y⊥ = {x ∈ Cn : hx, yi = 0}

è un sottospazio vettoriale di Cn avente dimensione n se y = 0 e n − 1 se

y 6= 0, in quanto nucleo di una forma lineare ϕ ∈ V ∗ .

Matrici normali e teorema spettrale

Definizione 6. Una matrice M ∈ Matn (C) si dice

Hermitiana

Unitaria

Normale

se

se

se

6

M? = M

MM? = I

M? M = MM?

Osserviamo che matrici Hermitiane e Unitarie sono sempre normali. Per

matrici reali R ∈ Matn (R) vale la condizione R? = RT , pertanto vigono le le

seguenti implicazioni:

R Ortogonale ⇔

R Simmetrica ⇔

R Unitaria

R Hermitiana

Osserviamo che se U è una matrice unitaria e x ∈ Cn :

||Ux||22 = xT UT Ux = xT UT Ux = x? U? Ux = x? x = xT x = ||x||22 ,

cioè le matrici unitarie corrispondono a trasformazioni lineari dello spazio

vettoriale che conservano la || · ||2 dei vettori. Vedremo in seguito, nel Teorema

14, che vale anche il viceversa.

Dimostriamo ora un risultato che riguarda tutte le matrici a coefficienti

in C.

Teorema 4 (Schur). Sia M ∈ Matn (C). Allora, esiste una matrice unitaria U

tale che U? MU sia triangolare superiore.

Dimostrazione. Procediamo per induzione sull’ordine n della matrice.

• Per n = 1, il teorema è banale.

• Supponiamo che il teorema valga per tutte le matrici di ordine (n − 1) ×

(n−1). Poiché C è algebricamente chiuso, la matrice M ammette almeno

un autovalore λ. Sia x un autovettore associato a λ. È possibile supporre

senza perdere in generalità ||x||2 = 1. Costruiamo una base ortonormale

di Cn che abbia come primo vettore proprio x e consideriamo la matrice

di cambiamento di base V. Allora, V è unitaria e, posto M1 = V ? MV si

ha

VM1 e1 = MVe1 = Mx = λx = λVe1 ,

dal che, tenuto conto del fatto che V è invertibile, si deduce M1 e1 = λe1 ,

cioè e1 è un autovettore per M1 . Ne segue che

λ ...

M1 =

0 M2

con M2 matrice di ordine (n − 1) × (n − 1). Per ipotesi induttiva esiste

f tale che W

f? M2 W

f sia triangolare superiore.

una matrice unitaria W

Poniamo

1 0

W=

f .

0 W

7

Chiaramente W è unitaria e trasforma in modo unitario M1 in una

matrice triangolare superiore T . Pertanto, posto U = VW si ha

U? MU = W ? (V ? MV)W = W ? M1 W = T.

La tesi segue.

Per le matrici Hermitiane e ortogonali si può stabilire di più.

Teorema 5. Gli autovalori di matrici Hermitiane sono tutti reali.

Dimostrazione. Sia M ∈ Matn (C) una matrice Hermitiana e supponiamo che

λ sia un suo autovalore con autovettore x. Allora, tenuto conto che M? = M,

x? M = λ.

Mx = λ,

Pertanto,

λx? x = x? (Mx) = (x? M)x = λx? x,

da cui

(λ − λ)x? x = 0.

Osserviamo che

?

x x = hx, xi =

n

X

|xi |2 > 0.

i=1

Pertanto, λ = λ e dunque λ ∈ R.

Premettiamo al teorema fondamentale di questo paragrafo alcuni lemmi.

Lemma 6. Sia M ∈ Matn (C) una matrice normale. Allora, per ogni x ∈ Cn

si ha

||Mx||2 = ||M? x||2 .

Dimostrazione. Tenuto conto che la norma è un numero reale positivo,

||Mx||22 = xT MT Mx = xT MT Mx = x? M? Mx =

x? MM? x = x? MM? x = (M? x)T M? x = ||M? x||22 .

Lemma 7. Sia M ∈ Matn (C) una matrice normale e supponiamo che x sia

un suo autovettore di autovalore λ. Allora, x è autovettore di M? di autovalore

λ.

8

Dimostrazione. Verifichiamo dapprima che M − λI è una matrice normale.

Infatti

(M − λI)? (M − λI) = (M? − λI)(M − λI) = M? M − λM? − λM + λλI =

MM? − λM? − λM + λλI = (M − λI)(M − λI)? .

In particolare, se x è autovettore di M si ha

0 = ||(M − λI)x||2 = ||(M? − λI)x||2

da cui si deduce

M? x = λx,

che è la tesi.

Teorema 8 (Teorema Spettrale). Ogni matrice normale M ∈ Matn (C) è

diagonalizzabile mediante matrici unitarie.

Dimostrazione. Ragioniamo per induzione sull’ordine n di M.

• Se n = 1 non vi è nulla da dimostrare e la matrice M = (m11 ) è già

diagonale.

• Supponiamo che ogni matrice normale (n − 1) × (n − 1) sia diagonalizzabile mediante matrici unitarie. Per il Teorema 4 esiste sicuramente

una matrice unitaria V tale che M1 = V ? MV sia triangolare superiore.

In particolare, vi è un λ tale che M1 e1 = λe1 . D’altro canto,

M?1 M1 = (V ? M? V)(V ? MV) = V ? (M? M)V =

V ? (MM? )V = (V ? MV)(V ? )M? V) = M1 M?1 ,

per cui anche M1 è normale. Per il Lemma 7, il vettore e1 è anche

autovettore di M?1 e M?1 e1 = λe1 . Ne segue che M1 è diagonale a blocchi

della forma

λ 0

M1 =

.

0 M2

Tenuto conto del fatto che

λλ

λλ

?

?

= M1 M1 = M1 M1 =

0 M?2 M2

M2 M?2

si vede che M2 è una matrice normale (n − 1) × (n − 1).

• La tesi ora segue dall’ipotesi induttiva.

9

In particolare, assegnata una matrice normale M è sempre possibile

trovare una base ortonormale di Cn formata da autovettori della stessa.

Nel caso di matrici reali simmetriche si può dimostrare che è possibile

costruire una base di autovettori reali.

Teorema 9. Sia M ∈ Matn (R) una matrice simmetrica. Allora, esiste una

matrice ortogonale O ∈ Matn (R) tale che D = OMO−1 è diagonale.

Dimostrazione. Innanzi tutto osserviamo che, per il Teorema 5, tutti gli

autovalori di M sono reali. Procediamo per induzione sull’ordine n di M:

• Se n = 1, M è già diagonale.

• Supponiamo che ogni matrice reale simmetrica di ordine (n − 1) sia

diagonalizzabile mediante trasformazioni lineari. Mostriamo che allora

anche una matrice di ordine n lo è. Sia λ un autovalore di M. Allora,

esiste un vettore x tale che

Mx = λx.

Poiché M = M, abbiamo anche

Mx = λx.

Cio significa che x e x sono entrambi autovettori associati al medesimo

autovalore. Distinguiamo due casi:

1. se x = −x, allora il vettore y = ix è un autovettore reale di

autovalore λ;

2. se x 6= −x, allora il vettore y = x + x è reale, diverso da 0 e

My = M(x + x) = λx + λx = λy.

Pertanto, anche in questo caso abbiamo trovato un autovettore

reale.

Consideriamo ora il vettore y 0 =

che manda y 0 in e1 . Allora,

1

y

||y||2

e sia O1 la matrice ortogonale

0

0

O1 MO−1

1 e1 = O1 My = λO1 y = λe1

10

Cioè e1 è autovettore di O1 MO−1

1 . Esattamente come nella dimostrazione del Teorema 8, vediamo che e1 deve essere anche autovettore di

O1 MT O−1

1 . Pertanto,

λ 0

T

−1

OM O1 =

,

0 M0

ove M 0 è una matrice reale e simmetrica di ordine n − 1

• La tesi segue per induzione.

Una conseguenza del Teorema 9 è la seguente caratterizzazione.

Teorema 10 (Teorema dell’asse principale). Sia M ∈ Matn (R) una matrice

reale. Allora, le seguenti tre condizioni sono equivalenti:

(1) Rn ammette una base ortonormale di autovettori per M;

(2) M è diagonalizzabile mediante una matrice ortogonale;

(3) M è simmetrica.

Dimostrazione. Le condizioni (1) e (2) sono equivalenti, per costruzione di

matrice diagonalizzante. Per il Teorema 9, la condizione (3) implica le prime

due. D’altro canto, se M è diagonalizzabile mediante una matrice ortogonale

O, allora

DT = (OMO−1 )T = (OMT O−1 ),

da cui

M = O−1 (OMO−1 )O = O−1 (OMT O−1 )O = MT ,

cioè M è simmetrica.

Esiste un metodo per calcolare gli autovalori di matrici Hermitiane (e

quindi anche reali simmetriche) in termini del valore minimo che le relative

forme Hermitiane assumono su opportuni insiemi.

Sia H una matrice Hermitiana n × n e indichiamo, come al solito, con

h(x) = x? Hx la forma Hermitiana ad essa associata.

Teorema 11 (Quozienti di Rayleigh). Siano λ1 ≤ λ2 ≤ . . . ≤ λn gli n autovalori di H, posti in ordine crescente e contati con le debite molteplicità.

Allora,

h(x)

λk = min max

= min max h(x).

x∈F

dim F=k x∈F\{0} ||x||2

dim F=k

2

||x|| = 1

2

11

Dimostrazione. Per ogni sottospazio F ≤ Cn poniamo

h(x)

= max{h(x) : x ∈ F, ||x||2 = 1}

x∈F\{0} ||x||2

2

R(F) = max

e sia

B = {b1 , b2 , . . . , bn }

n

una base di autovettori,

Pcon Hbi = λi . Chiaramente, per ogni vettore x ∈ C

possiamo scrivere x = i xi bi e si ottiene

X

h(x) =

λi |xi |2 .

i

Consideriamo ora un generico sottospazio F di Cn con dim F = k e poniamo

Bk = {bk , bk+1 , . . . , bn }. Poiché la dimensione del sottospazio vettoriale Bk

generato da Bk è proprio n−k+1, si ha che esiste almeno un vettore x ∈ F∩Bk

con x 6= 0. In particolare per i < k si ha xi = 0.

h(x) =

n

X

λi |xi | =

2

i=0

n

X

λi |xi | ≥ λk

2

i=k

n

X

|xi |2 = λk ||x||22 .

i=k

Pertanto R(F) ≥ λk e quindi

min R(F) ≥ λk .

dim F=k

D’altro canto, se consideriamo lo spazio vettoriale F 0 generato da {b1 , b2 , . . . , bk }

vediamo che:

1. esso ha dimensione k;

2. per ogni x ∈ F 0 si ha

h(x) =

k

X

|xi | λi ≤ λk

2

i=1

k

X

|xi |2 = λk ||x||22 ;

i=1

pertanto R(F 0 ) ≤ λk . D’altro canto bk ∈ F 0 implica proprio R(F 0 ) = λk .

Ne segue che

min R(F) = λk

dim F=k

che è la tesi.

Teorema 12. Una matrice Hermitiana H è definita positiva se, e solamente

se, tutti i suoi autovalori sono strettamente maggiori di 0.

12

Dimostrazione. Gli autovalori di H coincidono con quelli di HT = H. Supponiamo essi siano tutti strettamente maggiori di 0. Poiché H è Hermitiana,

esiste una matrice U tale che U? DU = H, con D matrice diagonale con

dii = λi > 0 Sia

U = {u1 , u2 , . . . , un }

la base di Cn data dalle colonne di U. Per ogni x ∈ Cn si può scrivere

x = x1 u1 + . . . + xn un

e quindi

h(x) = x? Hx =

n

X

xj u?j Hxi ui =

i,j=1

n

X

|xj |2 λi u?j ui .

i,j=1

Tenuto conto che la base U è ortonormale, si deduce che

n

X

|xj |2 λi u?j ui =

i,j=1

n

X

|xi |2 λi ≥ 0,

i=1

e x? Hx = 0 se, e solamente se, x = 0. Pertanto, H è definita positiva.

Viceversa supponiamo che H sia definita positiva e sia U = {u1 , . . . , un }

una base ortonormale di autovettori, con la condizione Hui = λi ui . Allora,

h(ui ) = uTi Hui = λi uTi ui = λi > 0.

Pertanto tutti gli autovalori di H sono tutti positivi.

Corollario 13. Una matrice Hermitiana H ∈ GLn (C) è definita positiva se, e

solamente se, per ogni x ∈ Cn con x 6= 0 si ha

x? Hx > 0.

Dimostrazione. Osserviamo che H è definita positiva se, e solamente se,

HT = H lo è, ovvero

xT HT x = x? Hx > 0,

per ogni x 6= 0.

Come conseguenza diretta del Teorema 12 osserviamo che se due matrici

Hermitiane H1 e H2 sono simili, allora esse hanno i medesimi autovalori e

sono simili alla stessa matrice diagonale D. Pertanto, una matrice Hermitiana simile ad una matrice Hermitiana definita positiva è a sua volta definita

positiva.

13

Isometrie

Sia V = Cn uno spazio vettoriale su C.

Definizione 7. Una trasformazione lineare M : V → V è detta isometria se,

per ogni x ∈ V:

||Mv||2 = ||v||2 .

Caratterizziamo ora tutte le isometrie di V.

Teorema 14. Le isometrie di V = Cn sono tutti e soli gli endomorfismi indotti

da matrici unitarie; similmente le isometrie di W = Rn sono tutti e soli gli

endomorfismi indotti da matrici ortogonali.

Dimostrazione. Sia x ∈ V e U una matrice unitaria. Allora,

||Ux||22 = hUx, Uxi = x? U? Ux = x? x = hx, xi = ||x||22

Pertanto, ogni matrice unitaria induce una isometria.

Viceversa, supponiamo che M induca una isometria su V; allora

||Mx||22 = hMx, Mxi = hM? Mx, xi = hx, xi = ||x||22 .

In particolare, usando la linearità del prodotto Hermitiano nella prima

componente, abbiamo

h(M? M − I)x, xi = 0.

Ora, la matrice S = M? M − I è normale in quanto Hermitiana (poiché S? = S);

pertanto, per il Teorema 9, essa è diagonalizzabile. Sia ora λ un qualsiasi

autovalore di S? e y 6= 0 un suo autovettore. Si ottiene

0 = hSy, yi = hλy, yi = λ hy, yi = λ||y||22 .

Poiché ||y|| 6= 0, si deduce λ = 0 per tutti gli autovalori di S, da cui S = 0 e

M? M = I, ovvero M è unitaria.

Il caso reale si dimostra esattamente al medesimo modo, tenendo conto

del fatto che una matrice reale unitaria è ortogonale.

Una conseguenza del Teorema 14 è la seguente caratterizzazione degli

autovalori di matrici unitarie.

Teorema 15. Gli autovalori di una matrice unitaria U o di una matrice reale

ortogonale sono numeri complessi di modulo 1.

Dimostrazione. Sia λ un autovalore di U con autovettore x. Allora,

||Ux||2 = |λ|2 ||x||22

Per il Teorema 14, U è una isometria; pertanto |λ| = 1.

14

Decomposizione Polare di una matrice

Come richiamato nel primo paragrafo, ogni numero complesso z può essere

identificato dalla coppia (a, θ) ∈ R+ ×] − π, π] mediante la corrispondenza

z = |a| (cos θ + i sin(θ)) .

Un risultato analogo vale anche per le matrici invertibili. Premettiamo due

lemmi.

Lemma 16. Sia H ∈ GLn (C) una matrice Hermitiana definita positiva.

Allora, anche H−1 è Hermitiana definita positiva.

Dimostrazione. Poiché H è Hermitiana, esiste una matrice unitaria U tale

che

H = U? DU,

con D matrice diagonale definita positiva. Chiaramente, anche D−1 è diagonale e definita positiva. D’altro canto, posto M = U? D−1 U abbiamo

HN = (U? DU)(U? D−1 U) = U? DD−1 U = U? U = I.

Pertanto N = H−1 e la tesi segue.

Lemma 17. Sia H una matrice Hermitiana definita

esiste

√ positiva. Allora,

2

una matrice Hermitiana definita positiva N = H tale che N = H. Tale

matrice è detta radice quadrata di H.

Dimostrazione. Per il Teorema 8, esiste una matrice unitaria U tale che

H = U? DU,

ove D è una matrice diagonale, con tutte le entrate d1 , d2 , . . . , dn sulla

diagonale principale reali e strettamente positive. Sia

√

d1 √

√

d2

D=

.

.

.

.

√

dn

√

2

D = D. Poniamo N = U? DU. Allora,

√

√

√

N2 = (U? DU)((U? DU) = U? ( D)2 U = U? DU = H.

√

Pertanto, N = H è la matrice cercata.

Chiaramente,

√

15

Teorema 18. Sia M ∈ GLn (C). Allora esiste un’unica coppia (H, Q) ove

1. H è una matrice Hermitiana positiva definita;

2. Q è una matrice Unitaria;

tale che M = HQ. Se M ∈ GLn (R), allora H risulta essere una matrice

simmetrica definita positiva e Q una matrice ortogonale.

Dimostrazione. Innanzi tutto osserviamo che la matrice MM? è Hermitiana.

Inoltre, se x 6= 0,

x∗ MM? x = hM? x, M? xi > 0,

per cui MM? è anche definita positiva.

Usando il Lemma 17, poniamo

√

H = MM? ,

Q = H−1 M

Chiaramente, M = HQ. Per costruzione, H è Hermitiana, positiva definita e

√

√

√ 2

H2 = HH? = U? DUU? DU = U? D U = U? DU = MM?

D’altro canto,

Q? Q = M? (H−1 )? H−1 M = M? H−2 M = M? (MM? )−1 M = I,

per cui U è unitaria e si è ottenuta una decomposizione polare per M.

Supponiamo ora che M = H 0 Q 0 sia un’altra decomposizione polare per M.

Allora

N = H−1 H 0 = Q(Q 0 )−1

è ovviamente unitaria; pertanto tutti i suoi autovalori hanno modulo 1. Mostriamo ora che N è anche Hermitiana (rammentiamo che, in generale, il

prodotto di due matrici Hermitiane non è Hermitiano), di modo da poter asserire che tutti i suoi autovalori sono reali. Per il Lemma 16, H−1 è Hermitiana

e definita positiva. Pertanto, a norma del Lemma 17 esiste una matrice S

Hermitiana definita positiva tale che S2 = H−1 . Allora,

S−1 NS = S−1 H−1 H 0 S = S−1 S2 H 0 S = SH 0 S,

per cui N è simile ad P = SH 0 S. D’altro canto, usando l’Hermitianità di H 0 e S

si ha

?

P? = S? H 0 S? = SH 0 S = P,

per cui P è Hermitiana e, conseguentemente, lo è pure N.

16

Mostriamo ora che N è definita positiva. Come sopra, ragioniamo su P.

Osserviamo che S è invertibile, per cui x 6= 0 implica Sx 6= 0, e, chiaramente,

per ogni y ∈ Cn con y 6= 0 si ha yT H 0 y > 0. Da ciò si deduce che

T

xT Px = xT (SH 0 S)x = xT S H 0 Sx = (Sx)T H 0 (Sx) = yT H 0 y ≥ 0

Ne segue che P è definita positiva e dunque anche N lo è. Pertanto, N = I.

Incidentalmente, si noti che dalla dimostrazione dell’unicità della decomposizione polare segue anche che la radice quadrata di una matrice

Hermitiana definita positiva è unica.

Definizione 8. Sia M ∈ GLn (C) e indichiamo con (H, Q) la sua decomposizione polare. Gli autovalori di H (ovvero le radici quadrate degli autovalori

di MM? ) sono detti valori singolari di M.

Decomposizione di Choleski

Definizione 9. Sia M ∈ Matn (C). Si dice minore principale p–esimo di M il

minore ottenuto da M prendendo le prime p–righe e le prime p–colonne. Si

indicherà tale minore con il simbolo M(p) .

Lemma 19. Se una matrice Hermitiana M ∈ Matn (C) è definita positiva

allora anche tutti i suoi minori principali M(p) lo sono. In particolare, per

ogni p = 1, . . . , n,

det M(p) 6= 0.

e ∈ Cp con x

e 6= 0 tale che

Dimostrazione. Se esistesse un vettore x

e? M(p) x

e ≤ 0,

x

allora sarebbe possibile scrivere il vettore x = (e

x1 , e

x2 , . . . , e

xp , 0, . . . 0) ∈ Cn \ {0}

per cui

e? M(p) x

e ≤ 0.

x? Mx = x

Pertanto, affinché M sia definita positiva è necessario che tutti i suoi minori

principali lo siano.

Infine, osserviamo che se una matrice N è singolare, allora esiste un

vettore x ∈ ker N con x 6= 0. Pertanto,

x? Nx = 0,

e N non può essere definita positiva. Da questo deduciamo che tutti i minori

M(p) devono essere non singolari.

17

Teorema 20. Sia M ∈ GLn (C) una matrice Hermitiana definita positiva.

Allora, esiste un’unica matrice triangolare inferiore L ∈ Matn (C) con entrate

sulla diagonale principale reali positive tale che M = LL? . Se M è una matrice

reale simmetrica, allora anche la matrice L ottenuta è reale e M = LLT .

Dimostrazione. Poiché M è definita positiva, tutti i suoi minori principali

sono non singolari. Pertanto esiste una fattorizzazione LU di M del tipo M =

L0 U0 con U0 invertibile. Sia D la diagonale di U0 e poniamo U0 = DU1 , ove

U1 è una matrice triangolare superiore con tutti 1 sulla diagonale principale.

Osserviamo che

M = M? = (LDU1 )? = U?1 D? L? .

Dall’unicità della fattorizzazione LU segue

U1 = L?0 .

?

Pertanto, M = L0 (DL?0 ). Posto P = (L−1

0 ) si ha

x? Dy = x? P? MPy = (Px)? M(Py).

Quindi la matrice D è Hermitiana e, per il Corollario 13, visto che M è

definita positiva, è anche essa definita positiva; in particolare D ammette

radice quadrata. Poiché D è diagonale, tutte le sue entrate non nulle

sono

√

reali positive

e,

conseguentemente,

lo

sono

anche

tutte

quelle

di

D.

Posto

√

ora L = L0 D, si ottiene

√ √

LL? = L0 D( D)? L?0 = L0 DL?0 = M,

come desiderato.

Eè chiaro che è possibile ripetere la stessa costruzione√

per una matrice S

reale simmetrica; in questo caso tutte le matrici (incluse D e L) sono reali,

per cui si ottiene

S = LL? = LLT .

18