caricato da

common.user16302

Riassunto statistica

STATISTICA

La statistica è la disciplina che permette di elaborare i dati con l’obiettivo di estrarre informazione

utile per prendere decisioni in condizioni di incertezza.

Una popolazione è l’insieme di tutte le unità statistiche che fanno parte del fenomeno che si vuole

studiare, denotiamo con N la numerosità totale delle osservazioni.

Un campione è un sotto-insieme delle unità statistiche di una popolazione, denotiamo con n la

numerosità campionaria.

Una variabile è una caratteristica dell’unità statistica che viene rilevata, mentre i valori distinti

assunti da una variabile viene detta modalità.

Le tipologie delle variabili sono:

➢ Quantitative, se le modalità sono numeri reali. Una variabile quantitativa può essere:

▪ Discreta → se le modalità sono poste in corrispondenza con l’insieme dei numeri

naturali (anni di età).

▪ Continua → se le modalità appartengono ad un intervallo reale (profitto di una azienda,

temperatura).

➢ Qualitative, se la variabile assume attributi non numerici.

Una variabile qualitativa può essere:

▪ Nominale → se le modalità non seguono alcun ordine (religione, professione).

▪ Ordinale → se le modalità che assume seguono un ordine pre-costituito (valutazioni

scolastiche, gradi militari)

Nell’analizzare dei dati è bene tenere presente il tipo di studio, la distinzione tra:

- Studi sperimentali → dati sono stati raccolti in situazioni replicabili e controllate.

- Studi osservazionali → lo studioso semplicemente rileva dei dati già esistenti.

Olist è una startup brasiliana che opera nel campo dell’e-commerce, cioè concentra i prodotti di

diversi venditori in un unico punto vendita visibile al consumatore finale.

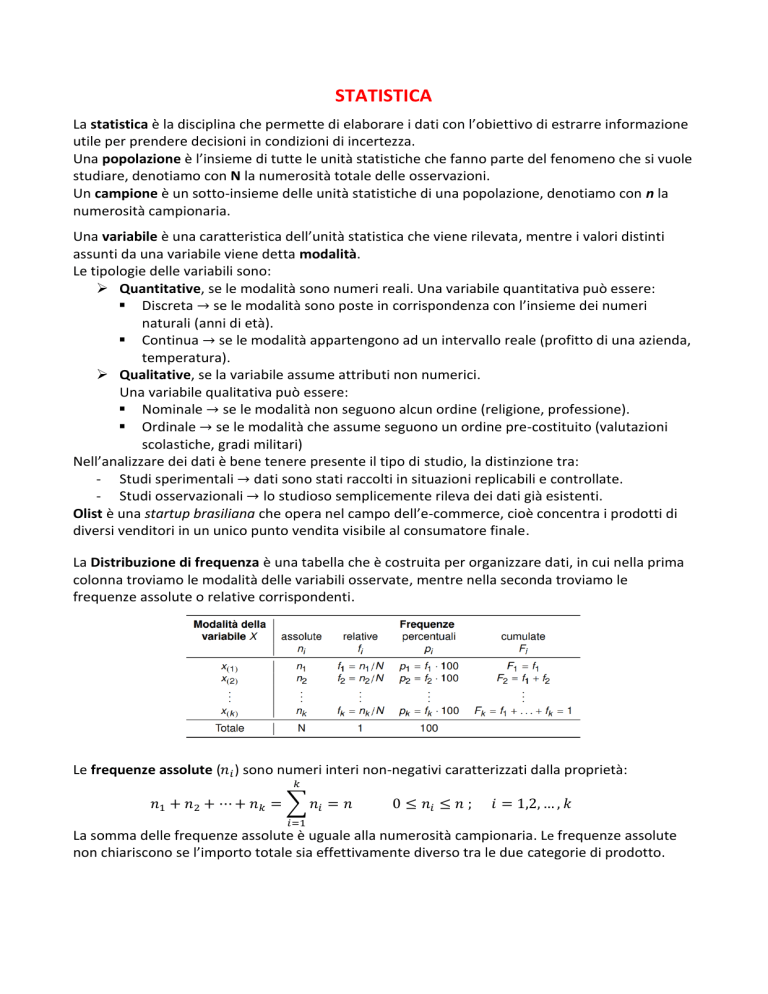

La Distribuzione di frequenza è una tabella che è costruita per organizzare dati, in cui nella prima

colonna troviamo le modalità delle variabili osservate, mentre nella seconda troviamo le

frequenze assolute o relative corrispondenti.

Le frequenze assolute (𝑛𝑖 ) sono numeri interi non-negativi caratterizzati dalla proprietà:

𝑘

𝑛1 + 𝑛2 + ⋯ + 𝑛𝑘 = ∑ 𝑛𝑖 = 𝑛

0 ≤ 𝑛𝑖 ≤ 𝑛 ;

𝑖 = 1,2, … , 𝑘

𝑖=1

La somma delle frequenze assolute è uguale alla numerosità campionaria. Le frequenze assolute

non chiariscono se l’importo totale sia effettivamente diverso tra le due categorie di prodotto.

Le frequenze relative (𝑓𝑖 ) è il rapporto tra la frequenze assolute e le numerosità totali:

𝑛𝑖

𝑓𝑖 =

𝑖 = 1, … , 𝑘

𝑁

Sono numeri reali non-negativi caratterizzati dalle proprietà:

𝑘

𝑓1 + 𝑓2 + ⋯ + 𝑓𝑘 = ∑ 𝑓𝑖 = 1

0 ≤ 𝑓𝑖 ≤ 1 ;

𝑖 = 1,2, … , 𝑘

𝑖=1

A volte le frequenze relative vengono moltiplicate per 100, in tal caso parleremo di

frequenze percentuali ( 𝑝𝑖 ). Formula: 𝑝𝑖 = 𝑓𝑛 ∙ 100

Le differenze tra le distribuzioni di frequenza sono ancora più

evidenti se rappresentate graficamente.

Una possibilità è utilizzare un istogramma, utilizzato solo per

le variabili quantitative.

Una seconda rappresentazione grafica di uso frequente è la cosiddetta

funzione di ripartizione empirica F(x), ovvero il rapporto tra il numero di osservazioni minori o

uguali di x e la numerosità campionaria.

𝑛

1

𝐹(𝑥) = ∑ 1 (𝑥𝑖 ≤ 𝑥)

𝑛

𝑖=1

Dove 1 si chiama funzione indicatrice e

vale 1 se 𝑥𝑖 ≤ 𝑥 e 0 se 𝑥𝑖 > 𝑥

La funzione di ripartizione è caratterizzata dalle

seguenti proprietà:

0 ≤ 𝐹(𝑥) ≤ 1

lim 𝐹(𝑥) = 0

lim 𝐹(𝑥) = 1

𝑥→−∞

F(x) è non decrescente

destra

𝑥→∞

F (x) è continua a

Le frequenze cumulative (𝐹𝑖 ), si ottengono sommando progressivamente le frequenze e quindi

conteggiano il numero (o la frazione) di dati minori di una certa soglia. Forniscono la proporzione

di osservazioni minori o uguali di x.

Il campione casuale è composto da n unità estratte dalla popolazione in maniera casuale. Dunque,

ogni unità, all’interno del campione, ha la stessa probabilità di essere estratta. É necessario

utilizzare dei metodi che permettano di sintetizzare tali dati ed estrapolare informazione.

I due metodi sono: tabelle e grafici.

I dati qualitativi raccolti nella tabella di frequenza possono essere rappresentati tramite:

❖ Grafico a torta → serve ad evidenziare le differenze in termini di proporzione rispetto al

totale

❖ Diagramma a barre → è da preferirsi in presenza di variabili ordinali perché le modalità

vengono riportate nell’asse delle ascisse secondo l’ordinamento previsto.

L’ampiezza della fetta è proporzionale alla frequenza: ampiezza fetta = 360 · 𝑓𝑖

L’ampiezza delle classi (𝑎𝑖 ) è uguale a:

𝑎=

Le ampiezze degli intervalli sono:

max{𝑋} − min {𝑋}

𝑘

𝑎𝑖 = 𝑐𝑖 − 𝑐𝑖−1

Calcoliamo le densità di frequenza (ℎ𝑖 ), ovvero quante sono in media, le unità per ogni unità del

carattere.

ℎ𝑖 =

𝑓𝑖

𝑎𝑖

𝑖 = 1, … , 𝑘

N.B → 𝑓𝑖 non deve essere approssimato. Le classi con maggiore densità sono le classi dove le unità

statistiche sono più concentrate.

Indici di posizione

▪

▪

▪

▪

Media aritmetica

Mediana

Quantili

Moda

o La media aritmetica dei dati è:

𝑁

1

𝜇 = 𝑋̅ = ∑ 𝑥𝑖

𝑁

𝑖=1

➢ Proprietà della media:

1) Rappresentatività

Se i dati sono tutti uguali ad un valore a

𝑥1 = 𝑥2 = ⋯ = 𝑥𝑛 = 𝑎

Allora, la media è uguale all’osservazione

𝑁

1

1

𝑛𝑎

𝜇 = 𝑋̅ = ∑ 𝑥𝑖 = (𝑎 + ⋯ + 𝑎) =

=𝑎

𝑁

𝑛

𝑛

𝑖=1

2) Internalità

La media è sempre compresa tra il più piccolo e il più grande dei valori osservati:

𝑥(1) ≤ 𝑋̅ ≤ 𝑥(𝑛)

3) Associatività

La media rimane invariata se un sotto-insieme di dati

4) Trasformazione lineare

La media di una trasformazione lineare dei dati coincide con la trasformazione lineare della media,

dove:

𝑦𝑖 = 𝑎 + 𝑏𝑥𝑖

𝑖 = 1, … , 𝑛

5) Baricentro

La somma, e dunque la media, delle differenze dei dati dalla loro media, detti scarti, è sempre

pari a 0:

𝑛

∑(𝑥𝑖 − 𝜇) = (𝑥1 − 𝜇) + ⋯ (𝑥𝑛 − 𝜇) = 0

𝑖=1

La Media aritmetica ponderata è:

𝑘

∑𝑘𝑖=1 𝑥𝑖 𝑤𝑖

∑𝑘𝑖=1 𝑥𝑖 𝑛𝑖

𝑛𝑖

𝑋̅ =

=

= ∑ 𝑥𝑖 ∙ 𝑓𝑖 = 𝑘

𝑘

𝑘

∑𝑖=1 𝑤𝑖

∑𝑖=1 𝑛𝑖

∑𝑖=1 𝑛𝑖

𝑖=1

↑

=N

𝑤𝑖 = 𝑛𝑖

o La Mediana

É il valore centrale dei dati ordinati se questi sono in numero dispari, mentre è la media dei

due valori centrali quando i dati sono in numero pari.

𝑀𝑒 = {(𝑥

𝑛

( )

2

𝑥(𝑛+1)

Se n è dispari

+ 𝑥(𝑛+1) )/2

Se n è pari

2

2

Ricordando la definizione della funzione di ripartizione empirica F(x), si nota che la mediana è un

valore tale per cui:

1

𝐹(𝑀𝑒) ≈

2

o I Quantili:

L’idea alla base di un quantile-p, dove p ∈ (0, 1), è trovare quel numero che sia grande di circa

il 100 x p% delle osservazioni e più piccolo della restante parte

𝑃𝑜𝑠𝑖𝑧𝑖𝑜𝑛𝑒 = 𝑝 ∙ (𝑁 + 1)

𝑝𝑜𝑠 = ⌊𝑃𝑜𝑠𝑖𝑧𝑖𝑜𝑛𝑒⌋

ES:

N=9

Posizione = 0.25(9+1)=2.5

o La Moda

La moda di una distribuzione di frequenza è la modalità cui corrisponde la massima frequenza

(assoluta o relativa). La moda è sicuramente un valore osservato. Per variabili continue

raggruppate in classi, si parla di classe modale.

Indici di variabilità

o Varianza

La varianza ( 𝜎 2 o 𝑠 2 ) è quindi una misura di quanto i dati siano distanti dalla media

aritmetica, tale distanza è valutata usando i quadrati delle differenze.

La varianza dei dati è:

𝑛

1

2

𝜎 = ∑(𝑥𝑖 − 𝜇)2

𝑁

𝑖=1

Ulteriore definizione

𝑛

1

𝜎2 = (

∑ 𝑥𝑖2 ) − 𝜇 2

𝑁

È la media del valore al quadrato

meno la media al quadrato

𝑖=1

𝜇 = 𝑝𝑜𝑝𝑜𝑙𝑎𝑧𝑖𝑜𝑛𝑒

N.B → Prima di calcolare la varianza deve essere calcolata la media. {

𝑥̅ = 𝑐𝑎𝑚𝑝𝑖𝑜𝑛𝑒

-

Varianza campionaria

𝑛

(𝑥𝑖 − 𝑥̅ )2

𝑆 =∑

𝑛−1

2

𝑖=1

-

Varianza popolazione

𝑛

(𝑥𝑖 − 𝑥̅ )2

𝜎 =∑

𝑛

2

𝑖=1

➢ Proprietà della varianza:

1. Positività

La varianza è per costruzione sempre maggiore o uguale a zero, ovvero

𝜎2 ≥ 0

Inoltre, la varianza è esattamente pari a zero solo se i dati sono uguali tra loro

2. Trasformazione lineare

𝜎𝑦2 = 𝑏 2 𝜎𝑥2

𝑆2 ∙

(𝑛 − 1)

= 𝜎2

𝑛

3. Scarto quadratico medio (DEVIAZIONE STANDARD)

La radice quadrata della varianza è tipicamente chiamata scarto quadratico medio:

𝜎 = √𝜎 2

➢ Misure di variabilità:

▪ Range

È la differenza tra il massimo ed il minimo, ovvero:

𝑅𝑎𝑛𝑔𝑒(𝑥) = 𝑥(𝑛) − 𝑥(1)

▪ Differenza interquartile

È la differenza tra il terzo ed il primo quartile, ovvero:

𝐼𝑄𝑅 = 𝑞0.75 − 𝑞0.25

▪

Coefficiente di varianza

𝐶𝑉 =

𝜎

𝜇

Il CV è indipendente dall’unità di misura e aggiusta la variabilità tenendo conto anche del livello

del fenomeno.

o BOXPLOT

ES: (si collega con quello del calcolo dei quantili)

Indici di forma

o Dati standardizzati

I dati trasformati hanno media nulla e varianza unitaria

𝑧𝑖 =

𝜇𝑧 = 0

𝜎𝑧 = 1

𝑥𝑖 − 𝜇𝑥

𝜎𝑥

𝑖 = 1, … , 𝑛

Indici di asimmetria

o Simmetria

La simmetria è definita

qualitativamente come la

specularità della distribuzione

rispetto ad un asse

o Indice di asimmetria di Pearson

É una misura di asimmetria l’indice:

𝜇 − 𝑀𝑒

𝛼1 =

𝜎

𝑛

𝑜

1

𝑥𝑖 − 𝜇 3

𝛼2 = ∑ (

)

𝑛

𝜎

𝑖=1

Esso è nullo nel caso di simmetria;

Tende ad assumere valori positivi se la distribuzione presenta asimmetria positiva e valori

negativi nel caso di asimmetria negativa.

o Indice di Curtosi di Pearson

L’indice di curtosi è:

𝑛

1

𝑥𝑖 − 𝜇 4

𝑘 = ∑(

) −3

𝑛

𝜎

𝑖=1

Esso è nullo nel caso di normalità; tende ad assumere valori positivi se la distribuzione

presenta code pesanti e valori negativi nel caso di code leggere

Teoria della probabilità

Con il termine probabilità solitamente si indicano due argomenti:

▪ il calcolo delle probabilità

▪ i modelli di variabili aleatorie

o Spazio Campionario ed Eventi

Il singolo risultato dell’esperimento casuale si chiama evento elementare.

L’insieme degli eventi elementari viene comunemente chiamato spazio dei risultati o

spazio campionario.

Si chiama evento un qualsiasi insieme di eventi elementari, ossia un qualsiasi sottoinsieme

dello spazio campionario Ω .

➢ Operazione sugli insiemi

Si definisce P(·) funzione

d’insieme in quanto il suo

dominio non è costituito dai

punti dell’asse reale bensì da

una collezione di insiemi.

▪

Definizione classica:

La probabilità del verificarsi di un evento è il rapporto tra i casi favorevoli al verificarsi

dell’evento e tutti i casi egualmente possibili.

𝑃(𝐸) =

▪

𝑁𝑐𝑎𝑠𝑖 𝑓𝑎𝑣𝑜𝑟𝑒𝑣𝑜𝑙𝑖

𝑁𝑐𝑎𝑠𝑖 𝑝𝑜𝑠𝑠𝑖𝑏𝑖𝑙𝑖

Definizione frequentista:

Questa definizione si basa sulla legge empirica del caso.

𝑃(𝐸) =

𝑛𝑐𝑎𝑠𝑖 𝑣𝑒𝑟𝑖𝑓𝑖𝑐𝑎𝑡𝑖

= 𝑓(𝐸)

𝑛𝑐𝑎𝑠𝑖 𝑝𝑜𝑠𝑠𝑖𝑏𝑖𝑙𝑖

In una serie di prove di un dato esperimento, ripetuto un gran numero di volte in circostanze il

più possibile simili, ciascuno degli eventi possibili si manifesta con una frequenza relativa che è

pressappoco uguale alla sua probabilità.

𝑃(𝐸) = lim 𝑓(𝐸)

▪

𝑛→∞

Definizione soggettivista:

La probabilità del verificarsi di un evento è il grado di fiducia che un individuo coerente ripone

nel verificarsi dell’evento.

➢ Calcolo combinatorio

1) Disposizioni

Sono i raggruppamenti realizzati quando n > k e conta l’ordine con cui si dispongono

𝐷𝑛,𝑘 =

𝑛!

(𝑛 − 𝑘)!

2) Permutazioni

Sono i raggruppamenti realizzati quando n = k e conta l’ordine con cui si dispongono

𝑃𝑛 = 𝑛!

3) Combinazioni

Sono i raggruppamenti realizzati quando n > k e non conta l’ordine con cui si dispongono

𝐶𝑛,𝑘 =

𝑛!

𝑛

=( )

𝑘! (𝑛 − 𝑘)!

𝑘

𝐜𝐨𝐞𝐟𝐟𝐢𝐜𝐢𝐞𝐧𝐭𝐞 𝐛𝐢𝐧𝐨𝐦𝐢𝐚𝐥𝐞

➢ Probabilità condizionata

Se A e B sono due eventi dello spazio campionario Ω e P(A) > 0, allora il verificarsi di B, una

volta che si è verificato A, comporta il verificarsi di entrambi, pertanto la probabilità di (B|A) è

legata a quella di A ∩ B nel seguente modo:

𝑃(𝐵|𝐴) =

𝑃(𝐴 ∩ 𝐵)

𝑃(𝐴)

➢ Indipendenza stocastica

Gli eventi A e B si dicono stocasticamente indipendenti se la probabilità dell’evento

intersezione può essere scritta come prodotto tra la probabilità di A e la probabilità di B:

𝑃(𝐴 ∩ 𝐵) = 𝑃(𝐴) 𝑃(𝐵)

➢ Regola di Bayes

𝑃(𝐶𝑖 |𝐴) =

𝑃(𝐶𝑖 ∩ 𝐴)

𝑃(𝐴|𝐶𝑖 ) ∙ 𝑃(𝐶𝑖 )

= 𝑘

𝑃(𝐴)

∑𝑖=1 𝑃(𝐴|𝐶𝑖 ) ∙ 𝑃(𝐶𝑖 )

Variabili Aleatorie

L’espressione variabile aleatoria indica una quantità il cui valore dipende dall’esito di un

esperimento casuale. Dizioni equivalenti a variabile aleatoria sono

▪ variabile casuale

▪ variabile stocastica.

Definire una variabile aleatoria (v.a.) significa formulare una regola che fa corrispondere un

numero reale ad ogni evento elementare di uno spazio campione.

➢ Variabile Aleatoria discreta → può assumere un insieme numerabile (non necessariamente

finito) di valori. Per poter operare con una variabile casuale X discreta, è opportuno ordinare in

senso crescente i suoi valori ed assegnare a ciascuno di essi la probabilità che gli compete.

(ES: pag8)

➢ Variabile Aleatoria continua → può assumere qualsiasi valore in un intervallo di numeri reali.

Per ogni valore x assegniamo la probabilità che la variabile casuale X assuma un valore minore

o uguale ad x.

Una variabile casuale X è detta continua se esiste una funzione f(x) tale che la funzione di

ripartizione F(x) = P(X ≤ x) è data dall’area sottesa a f (x) a sinistra di x

La probabilità che X assuma valori all’interno di un qualsiasi intervallo (a, b) è:

𝑏

𝑃(𝑎 < 𝑋 < 𝑏) = ∫ 𝑓(𝑥)𝑑𝑥

𝑎

La probabilità in questione come la differenza tra i valori assunti dalla funzione di ripartizione

in b e in a:

𝑃(𝑎 < 𝑋 < 𝑏) = 𝑃(𝑋 < 𝑏) − 𝑃(𝑋 ≤ 𝑎) = 𝑃(𝑋 ≤ 𝑏) − 𝑃(𝑋 ≤ 𝑎) = 𝐹(𝑏) − 𝐹(𝑎)

La funzione di densità rettangolare o uniforme è costante nell’intervallo di definizione della

variabile casuale. (ES: pag14)

La distribuzione di probabilità di una v.a. può essere descritta sinteticamente mediante:

➢ Media di una Variabile Aleatoria →

➢

Varianza di una Variabile Aleatoria →

➢ Media e Varianza di una combinazione lineare → Sia Y una combinazione lineare di una v.a. X:

𝑌 =𝑎+𝑏𝑋

dove a e b sono delle costanti. Siano 𝔼[𝑋] = 𝜇 e 𝕍[𝑋] = 𝜎 2 .

Si possono allora dimostrare le seguenti

proprietà:

Ponendo 𝑎 = −𝜇 𝑒 𝑏 =

1

𝜎

otteniamo una variabile aleatoria standardizzata

𝑋−𝜇

Con valore atteso 𝔼[Y] = 0

𝑌=

𝜎

e varianza 𝕍[Y] = 1

➢ Quantili di una Variabile Aleatorie → Consideriamo una variabile casuale continua X. Fissato

un livello di probabilità p, si chiama quantile di livello p la quantità 𝑥𝑝 in corrispondenza della

quale la funzione di ripartizione assume il valore p.

In termini grafici, il quantile di livello p è il punto dell’asse delle ascisse alla cui sinistra l’area

sottesa alla funzione di densità è uguale a p. (ES: pag19)

➢ Funzione Generatrice dei Momenti

Sia X una variabile aleatoria e t una variabile reale ausiliaria. E’ detta funzione generatrice dei

momenti di X la speranza matematica della funzione 𝑒 𝑡𝑋 :

𝑒 𝑡𝑥 𝑓(𝑥)

𝑠𝑒 𝑋 è 𝑢𝑛𝑎 𝑣. 𝑎. 𝑑𝑖𝑠𝑐𝑟𝑒𝑡𝑎

∫ 𝑒 𝑡𝑥 𝑓(𝑥)𝑑𝑥

{ −∞

𝑠𝑒 𝑋 è 𝑢𝑛𝑎 𝑣. 𝑎. 𝑐𝑜𝑛𝑡𝑖𝑛𝑢𝑎

∑

ΦX (𝑡) = 𝔼[𝑒

𝑡𝑋 ]

=

∞

𝑥∈𝑆

➢ Funzione Caratteristica

Sia X una variabile aleatoria e t una variabile reale ausiliaria, ed 𝑖 = √−1 l’unità immaginaria.

È detta funzione caratteristica di X la speranza matematica della funzione 𝑒 𝑖𝑡𝑋 :

𝑒 𝑖𝑡𝑥 𝑓(𝑥)

𝑠𝑒 𝑋 è 𝑢𝑛𝑎 𝑣. 𝑎. 𝑑𝑖𝑠𝑐𝑟𝑒𝑡𝑎

∫ 𝑒 𝑖𝑡𝑥 𝑓(𝑥)𝑑𝑥

{ −∞

𝑠𝑒 𝑋 è 𝑢𝑛𝑎 𝑣. 𝑎. 𝑐𝑜𝑛𝑡𝑖𝑛𝑢𝑎

∑

𝛹𝑋 (𝑡) = 𝔼[𝑒

𝑖𝑡𝑋

]=

Questa funzione esiste sempre.

∞

𝑥∈𝑆

➢ Variabile Aleatoria Bernoulli

Tutte le prove che producono solo due possibili

risultati generano v.c. di Bernoulli.

(Controllare lab4 su R)

➢

Variabile Aleatoria Binomiale

La v.a. Binomiale è una distribuzione che si utilizza

quando si è in presenza di n prove indipendenti (es. n

estrazioni con ripetizione o n estrazioni da una

popolazione infinita), ciascuna prova ha solo due esiti

possibili, indicati come successo e insuccesso (es.

difettoso/non difettoso, aumento/decremento,

acquisto/mancato acquisto), e la probabilità π (es. tasso

di difettosità) di osservare un successo in una singola

prova rimane costante per tutte le prove.

(Controllare lab5 su R)

Una v.a. Binomiale può essere ottenuta considerando la somma di v.c. di Bernoulli i.i.d.

(indipendenti e identicamente distribuite):

𝑛

𝑋 = 𝑋1 + 𝑋2 + ⋯ + 𝑋𝑛 = ∑ 𝑋𝑖

𝑖=1

dove 𝑋𝑖 ∼ Bernoulli(π), indipendentemente per ogni i

▪ Il valore atteso e la varianza crescono al crescere di n

▪ Per π = 0.5 la distribuzione è simmetrica rispetto al valor medio

▪ Per 𝑛 → ∞ la distribuzione tende ad essere simmetrica rispetto al valor medio

➢ Variabile Aleatoria Poisson

La distribuzione di Poisson è adeguata per approssimare v.a.

che rappresentano conteggi o il numero di volte che un

certo evento aleatorio si realizzi in un dato intervallo (di

tempo o di spazio).

Se 𝑋𝑖 ∼ Poisson( 𝜆𝑖 ) indipendentemente per ogni i = 1, . . ., k, allora

𝑋 = 𝑋1 + ⋯ + 𝑋𝑘 ~ 𝑃𝑜𝑖𝑠𝑠𝑜𝑛(𝜆)

𝑐𝑜𝑛 𝜆 = 𝜆1 + ⋯ + 𝜆𝑘

Posto λ = n π, per 𝑛 → ∞ e per π piccolo, la distribuzione di Poisson può essere utilizzata per

approssimare la distribuzione Binomiale di parametro π.

La costante λ è proporzionale alla lunghezza dell’intervallo di tempo o della dimensione dello

spazio considerato.

➢ Variabile Aleatoria Uniforme Continua

La distribuzione continua uniforme è una distribuzione di

probabilità continua che è uniforme su un insieme,

ovvero che attribuisce la stessa probabilità a tutti i punti

appartenenti ad un dato intervallo [a, b] contenuto

nell’insieme.

➢ Variabile Aleatoria Esponenziale

Consideriamo la probabilità di non osservare un guasto nel

sistema, nell’intervallo [0, x] di ampiezza x.

La probabilità 𝑃(𝑋 > 𝑥) = 1 − 𝐹(𝑥) = 𝑒 −𝜆𝑥 implica l’assenza di memoria:

𝑃(𝑋 > 𝑎 + 𝑏)

= 𝑃(𝑋 > 𝑏)

𝑃(𝑋 > 𝑎)

La mancanza di memoria esprime il fatto che la variabile non “ricorda il passato” ma si comporta

come se fosse “nuova”.

𝑃(𝑋 > 𝑎 + 𝑏|𝑋 > 𝑎) =

➢ Variabile Aleatoria Gamma

La distribuzione Gamma è la distribuzione di probabilità

della variabile aleatoria definita come la somma di variabili

aleatorie indipendenti e con distribuzione esponenziale.

Viene scelta una parametrizzazione diversa tramite i parametri α e β.

Le due parametrizzazioni sono legate dalle relazioni:

𝛼=𝛼

𝛽=

1

𝜃

➢ Variabile Aleatoria Normale

o Proprietà:

▪ È simmetrica, avendo come asse di simmetria

la retta x = µ;

▪ È crescente nell’intervallo (-∞, µ) e decrescente

nell’intervallo (µ, ∞) ;

▪ Ha due punti di flesso in x = µ − σ e x = µ + σ;

▪ La media individua la posizione della curva

lungo l’asse delle ascisse.

La varianza determina la concentrazione della

curva attorno alla retta x = µ

➢ Variabile Aleatoria Normale Standardizzata

Se X è una v.a. avente distribuzione 𝑁(𝜇, 𝜎 2 ), la variabile casuale standardizzata

corrispondente, data da:

𝑋−𝜇

𝑍=

~ 𝑁(0,1)

𝜎

Ha distribuzione Normale con media 0 e varianza 1.

Inoltre, vale l’identità:

𝑥−𝜇

𝐹(𝑥) = 𝑃(𝑋 ≤ 𝑥) = 𝑃 (𝑍 ≤

) = 𝑃(𝑍 ≤ 𝑧) = Φ(z)

𝜎

Dove Φ(z) è la funzione di ripartizione della distribuzione Normale standard.

o Proprietà:

▪ Dato un valore di Z positivo, vale la seguente relazione:

Φ(z) = 1 − Φ(z)

▪ Ciò significa che, nella distribuzione normale standard, l’area sottesa alla curva a sinistra di

-z è uguale all’area sottesa alla stessa curva a destra di z.

➢

Quantili della distribuzione Normale Standardizzata

Il problema inverso consiste nella determinazione del valore z a cui corrisponde un livello di

probabilità assegnato p della funzione di ripartizione (cioè dell’area sottesa alla curva a sinistra

di z). (ES: pag19)

𝑃(𝑍 ≤ 𝑧) = Φ(z) = 𝑝

➢ Dai quantili della N(0, 1) ai quantili della 𝑵(𝝁, 𝝈𝟐 )

𝑥−𝜇

⇒ 𝑥 =𝜇+𝜎∙𝑧

𝜎

La determinazione dei quantili di una distribuzione normale 𝑁(𝜇, 𝜎 2 ) si effettua in due fasi:

▪ Si determina, prima, il quantile 𝑧𝑝 per la distribuzione N(0, 1);

▪ Poi, il quantile voluto 𝑥𝑝 , riferito cioè alla distribuzione 𝑁(𝜇, 𝜎 2 ), utilizzando la seconda

delle due equazioni precedenti.

𝑧=

➢ Distribuzione Chi quadro

o Proprietà:

▪ La distribuzione 𝑥𝑣2 , viene definita come:

𝑥𝑣2 = ∑𝑣𝑖=1 𝑋𝑖2 = 𝑋21 + 𝑋22 + ⋯ + 𝑋2𝑣

Dove 𝑋𝑖2 sono variabili i sono variabili

aleatorie indipendenti con distribuzione

normale standard, N(0, 1).

▪

Il parametro ν è detto numero di gradi di libertà.

➢ Distribuzione T-student

➢ Proprietà:

▪ Data la v.a. T con distribuzione 𝑇𝑛−1 , essa viene

definita come il

rapporto tra due v.a. indipendenti.

𝑍

𝑇=

𝑉

(𝑛 − 1)

√

2

Dove Z~𝑁(0,1) e 𝑉~𝑥𝑛−1

▪ La distribuzione T-student ha media uguale a 0 ed è

simmetrica.

Controllare la parte di RStudio da pag29 a pag33.

Distribuzione Campionaria

Per modello descrittivo della popolazione intendiamo la distribuzione di frequenze relative di un

carattere all’interno di una popolazione finita, oppure un vero e proprio modello matematico che

esprime la probabilità o la densità della variabile casuale che descrive l’esito della singola prova di

un esperimento. In entrambi i casi, useremo il simbolo 𝑓𝑋 (𝑥).

➢ Campione Casuale → Per campione casuale di ampiezza n intendiamo la n-upla di variabili

casuali.

(𝑋1, 𝑋2 , … , 𝑋𝑛 )

indipendenti e identicamente distribuite come la variabile casuale X oggetto di studio.

➢ Spazio Campionario → Consideriamo:

▪ Il campione casuale (𝑋1, 𝑋2 , … , 𝑋𝑛 ) composto da n variabili casuali indipendenti e

identicamente distribuite.

▪ Denominiamo campione osservabile una specifica realizzazione del campione casuale,

ossia una n-upla di numeri che indichiamo con (𝑥1, 𝑥2 , … , 𝑥𝑛 ).

▪ Tutti i possibili campioni osservabili costituiscono lo spazio campionario.

➢ Distribuzione di probabilità del campione casuale

▪ Se la popolazione di riferimento è finita, l’insieme dei possibili campioni osservabili (spazio

campionario) è costituito da un numero finito di campioni.

▪ A ciascuno di questi è possibile associare un livello di probabilità, 𝑓(𝑥1, 𝑥2 , … , 𝑥𝑛 ), dato da:

𝑓(𝑥1, 𝑥2 , … , 𝑥𝑛 ) = 𝑓𝑋 (𝑥1 ) ∙ 𝑓𝑋 (𝑥2 ) … 𝑓𝑋 (𝑥𝑛 )

dove 𝑓𝑋 (𝑥𝑖 ) = 𝑃(𝑋 = 𝑥𝑖 ) è la probabilità che, nell’estrazione i-esima, la variabile di

interesse assuma il valore 𝑥𝑖 .

▪ L’espressione di 𝑓(𝑥1, 𝑥2 , … , 𝑥𝑛 ), si deduce dal fatto che le variabili casuali componenti il

campione sono indipendenti e hanno tutte la stessa distribuzione di probabilità 𝑓𝑋 ( ∙ ).

Statistiche Campionarie

↓

Si chiama statistica campionaria o variabile casuale campionaria una qualsiasi funzione delle

variabili casuali 𝑋1, 𝑋2 , … , 𝑋𝑛 che compongono il campione casuale.

Ogni statistica campionaria, quale funzione di variabili casuali, è una variabile casuale.

Si chiama distribuzione campionaria di una statistica la distribuzione di probabilità della statistica.

➢ Media campionaria

𝑋1, + 𝑋2 + ⋯ + 𝑋𝑛 ∑𝑛𝑖=1 𝑋𝑖

̅

𝑋=

=

𝑛

𝑛

➢ Varianza campionaria

𝑆2 =

(𝑋1 − 𝑋̅)2 + (𝑋2 − 𝑋̅)2 + ⋯ + (𝑋𝑛 − 𝑋̅)2 ∑𝑛𝑖=1(𝑋𝑖 − 𝑋̅)2

=

𝑛−1

𝑛−1

➢ Distribuzione di probabilità delle statistiche campionarie

Indicata con:

𝑇 = 𝑡(𝑋1 , 𝑋2 , … , 𝑋𝑛 )

una generica statistica campionaria, la distribuzione di probabilità di T, espressa con la

funzione di ripartizione, è data formalmente da:

𝐹(𝑡) = 𝑃(𝑇 ≤ 𝑡) = 𝑃(𝑋1 , 𝑋2 , … , 𝑋𝑛 ) ∈ 𝐼𝑡

dove 𝐼𝑡 è l’insieme dei campioni dello spazio campionario per i quali vale la disuguaglianza

𝑇 ≤ 𝑡. 𝐹(𝑡) è dunque la probabilità di osservare un campione in cui 𝑇 ≤ 𝑡.

Quando la variabile d’interesse è continua, la distribuzione di probabilità di una statistica

campionaria, espressa dalla funzione di ripartizione 𝐹(𝑡) = 𝑃(𝑇 ≤ 𝑡), è una somma nel continuo

(fatta tramite gli integrali) delle densità di probabilità associate ai campioni appartenenti

all’insieme 𝐼𝑡 , cioè ai campioni in cui la statistica campionaria assume un valore minore o uguale a

t.

➢ Valore atteso e Varianza di una statistica campionaria

▪ Il valore atteso, 𝜇 𝑇 = 𝔼[𝑇], della statistica campionaria T è dato dalla somma

(dall’integrale) dei prodotti tra i valori che T può assumere e le rispettive probabilità

(densità di probabilità).

▪ La varianza di una statistica campionaria T è il valore atteso di (𝑇 − 𝜇 𝑇 )2 :

𝑉𝑎𝑟[𝑇] = 𝔼[(𝑇 − 𝜇 𝑇 )2 ]

Si può dimostrare che il valore atteso e la varianza della media campionaria sono uguali a:

𝔼[𝑋̅] = 𝜇𝑋̅ = 𝜇

𝜎2

𝑛

Essendo μ e 𝜎 2 la media e la varianza della popolazione generatrice.

𝑉𝑎𝑟[𝑋̅] = 𝜎 2𝑋̅ =

➢ Media e Varianza della media campionaria

▪ Il valore atteso della media campionaria coincide con la media della popolazione.

▪ La varianza della media campionaria, interpretabile come la media delle oscillazioni

(date dagli scarti al quadrato) che essa presenta rispetto alla sua media, è data dalla

varianza della popolazione divisa per n.

➢ Media e Varianza della Media campionaria per una popolazione Bernoulliana

Sia 𝑃̂ la statistica “proporzione campionaria di successi”, si può dimostrare che il valore atteso

e la varianza 𝑃̂ sono dati da:

𝔼[𝑃̂] = 𝜇𝑝̂ = 𝑝

𝑉𝑎𝑟[𝑃̂] = 𝜎 2 𝑝̂ =

𝑝(1 − 𝑝)

𝑛

➢ Distribuzione della Media campionaria per una popolazione Normale

𝜎2

Se 𝑋~𝑁(𝜇, 𝜎 2 ), si può dimostrare che 𝑋̅~𝑁(𝜇, )

𝑛

➢ Distribuzione campionaria della Varianza

Il valore atteso e la varianza di 𝑆 2 sono dati, da:

𝔼[𝑆

2]

=𝜎

2

𝕍[𝑆

2]

𝜎4

𝑛

=

(𝛾 + 2

)

𝑛

𝑛−1

Dove γ è un misura del grado di distanza tra la forma della popolazione generatrice e la normale, che è

pari a 0 se la popolazione generatrice è normale.

Consideriamo una popolazione generatrice normale con media μ e 𝜎 2 varianza.

Sia 𝑆 2 la varianza di un campione casuale di ampiezza n proveniente da tale popolazione.

Allora, il rapporto:

(𝑛 − 1)𝑆 2

2

𝑉=

~ 𝑥𝑛−1

𝜎2

➢ Distribuzione campionaria della Media

▪ Variazione Nota

Se la popolazione generatrice è normale, la variabile casuale media campionaria 𝑋̅ ha

distribuzione 𝑁(𝜇,

𝜎2

). Pertanto, la variabile casuale standardizzata:

𝑋̅ − 𝜇

𝑍 = 𝜎 ~ 𝑁(0,1)

√𝑛

Se la popolazione non è normale, la variabile casuale precedente si distribuisce in modo

approssimato come una normale standard, purché n sia grande.

√𝑛

▪ Variazione NON nota

Sia data una popolazione generatrice normale con media µ. Siano 𝑋̅ e 𝑆 2 la media e la

varianza di un campione casuale di ampiezza n. Allora, il rapporto:

𝑋̅ − 𝜇

𝑇=

~ 𝑇𝑛−1

𝑆

√𝑛

➢ Successione di variabili casuali

La successione delle medie aritmetiche fatte sulle prime 1, 2, . . . variabili casuali:

𝑋̅𝑛 = {

𝑋1 + 𝑋2 + ⋯ + 𝑋𝑛

},

𝑛

𝑛 = 1,2, …

Legge dei grandi numeri

Sia {𝑋1 , 𝑋2 , … } una successione di variabili aleatorie indipendenti e aventi tutte la stessa

distribuzione di probabilità con valore atteso 𝔼[𝑋𝑖 ] = 𝜇 e varianza 𝕍[𝑋𝑖 ] = 𝜎 2 , 𝑖 = 1,2, … ;

Sia:

∑𝑛𝑖=1.

̅

{𝑋𝑛 =

} 𝑛 = 1,2, …

𝑛

la successione delle medie aritmetiche fatte sulle prime 1, 2, . . . variabili casuali. Allora, per ogni

∈ > 0 piccolo a piacere, vale la relazione:

lim 𝑃(|𝑋̅𝑛 − 𝜇| < 𝜖) = 1

𝑛→∞

La probabilità dell’evento |𝑋̅𝑛 − 𝜇| < 𝜖 può essere scritta nella forma → (𝜇 − 𝜖 < 𝑋̅𝑛 < 𝜇 + 𝜖)

➢ Formulazione di Bernoulli

▪ Quando la generica variabile casuale della successione {𝑋1 + 𝑋2 + ⋯ } è una Bernoulliana

con media p, 𝑋𝑖 assume il valore 1 (successo) con probabilità p e 0 (insuccesso) con

probabilità 1 − p.

𝑋

▪ Il rapporto 𝑋̅𝑛 = ∑𝑛𝑖=1 𝑛𝑖 è interpretabile come frequenza relativa di successo in n prove

indipendenti su un esperimento Bernoulliano, in cui la probabilità di successo è p.

In questo caso:

lim 𝑃(|𝑋̅𝑛 − 𝑝| < 𝜖) = 1

𝑛→∞

▪ In questa formulazione, la legge dei grandi numeri ci dice che, all’aumentare del numero

delle prove, la distribuzione di probabilità della frequenza relativa dei successi tende

sempre più a concentrarsi intorno al valore di p, probabilità dell’evento successo nella

singola prova.

➢ Teorema del Limite Centrale (TLC)

Sia {𝑋1 , 𝑋2 , … } una successione di variabili casuali indipendenti e aventi tutte la stessa

distribuzione con valore atteso 𝔼[𝑋𝑖 ] = 𝜇 e varianza 𝕍[𝑋𝑖 ] = 𝜎 2 , 𝑖 = 1,2, … ;

Sia:

∑𝑛𝑖=1.

{𝑋̅𝑛 =

} 𝑛 = 1,2, …

𝑛

la successione delle medie aritmetiche fatte sulle prime 1, 2, . . . variabili casuali. Allora, , definita

la variabile scarto standardizzato:

𝑋̅𝑛 − 𝜇

𝑍𝑛 =

𝜎

√𝑛

Per ogni z ϵ ℝ, si ha:

lim 𝑃(𝑍𝑛 ≤ 𝑧) = lim 𝑃 (

𝑛→∞

𝑛→∞

𝑧

𝑋̅𝑛 − 𝜇

1 −𝑢2 /2

≤

𝑧)

=

∫

𝑒

𝑑𝑢 = Φ(z)

𝜎

−∞ √2𝜋

√𝑛

Quando il campione ha un’ampiezza sufficientemente elevata, la distribuzione di probabilità di 𝑋̅

può essere approssimata con una normale, qualunque sia la forma della distribuzione della

variabile casuale oggetto di studio.

Il campione casuale è per definizione costituito da n variabili casuali indipendenti aventi tutte la

stessa distribuzione, e ciò consente di fare ricorso al teorema del limite centrale. (ES: pag8)

𝑋̅ è assimilabile alla variabile casuale 𝑋̅𝑛 protagonista del teorema

➢ Approssimazione della Binomiale con la Normale

▪ Quando la generica variabile casuale 𝑋𝑖 della successione {𝑋1 , 𝑋2 , … } è una Bernoulliana

con media p,

𝑛

𝑆𝑛 = ∑ 𝑋𝑖

𝑖=1

è il numero di successi in n prove indipendenti su un esperimento Bernoulliano.

▪ La distribuzione di probabilità di 𝑆𝑛 è allora una Binomiale

𝑆𝑛 ~𝐵𝑖𝑛𝑜𝑚𝑖𝑎𝑙𝑒(𝑛, 𝑛𝑝)

▪

▪

Se n è sufficientemente grande, 𝑛𝑝 > 5, 𝑛(1 − 𝑝) > 5, tale distribuzione può essere

approssimata con una normale con media np e varianza np(1 − p).

Ponendo 𝑋 = 𝑆𝑛 , ciò consente di scrivere:

𝑃(𝑎 ≤ 𝑋 ≤ 𝑏) ≈ Φ (

▪

𝑏 + 𝟎. 𝟓 − 𝑛𝑝

𝑏 − 𝟎. 𝟓 − 𝑛𝑝

) − Φ(

)

√𝑛𝑝(1 − 𝑝)

√𝑛𝑝(1 − 𝑝)

L’approssimazione migliora adottando la correzione per continuità.

Statistica Inferenziale

È l’insieme dei metodi e delle tecniche con cui “si fa luce” su uno o più parametri della

popolazione generatrice, utilizzando i dati di un campione casuale.

Attraverso la conoscenza del campione dobbiamo riuscire a determinare i parametri incogniti

della popolazione.

Tre sono le procedure tipiche dell’inferenza statistica:

1) La stima puntuale: si cerca di determinare valori puntuali dei parametri incogniti della

popolazione mediante i valori del campione.

2) La stima intervallare: si cercano degli intervalli contenenti con una certa fiducia i parametri

della popolazione.

3) La verifica (test) d’ipotesi: si usa il campione per controllare la validità di ipotesi riguardanti i

parametri della popolazione.

➢ Stimatore

Dato un campione casuale (𝑋1 , 𝑋2 , … , 𝑋𝑛 ) per stimatore del parametro θ si intende la statistica

campionaria

𝑇 = 𝑡(𝑋1 , 𝑋2 , … , 𝑋𝑛 )

utilizzata per stimare il parametro θ.

❖ Si chiama, invece, stima la singola determinazione dello stimatore, il valore,

𝑡 = 𝑡(𝑥1 , 𝑥2 , … , 𝑥𝑛 ) che esso assume nel campione osservato, (𝑥1 , 𝑥2 , … , 𝑥𝑛 ), inteso come

una n-upla di numeri effettivamente osservati.

❖ Si parla di stima puntuale per distinguere questo problema dalla stima per intervallo, con

cui ci si pone l’obiettivo di individuare un intervallo che contenga al suo interno il

parametro θ.

➢ Proprietà degli stimatori:

▪ Dato un campione casuale (𝑋1 , 𝑋2 , … , 𝑋𝑛 ), sia 𝑇 = 𝑡(𝑋1 , 𝑋2 , … , 𝑋𝑛 ) uno stimatore del

parametro θ.

▪ Per stabilire se lo stimatore T è più o meno adeguato per la soluzione del nostro problema

di stima è cruciale studiare la variabile casuale

𝑇−𝜃

Che denomineremo errore di stima.

Due questioni sono basilari per emettere un giudizio sullo stimatore:

• La media degli errori di stima 𝔼[𝑇 − 𝜃] è desiderabile che sia nulla;

• La media dei quadrati degli errori di stima:

𝑀𝑆𝐸 (𝑇) = 𝔼[(𝑇 − 𝜃)2 ]

denominata, errore quadratico medio, è desiderabile che sia “la più piccola possibile”.

➢ Distorsione

Se il valore atteso dell’errore di stima è uguale a 0, cioè se

𝔼[𝑇 − 𝜃 ] = 0

∀𝜃

lo stimatore è non distorto.

L’equazione precedente può essere scritta in modo equivalente come:

𝔼[𝑇 ] = 0

∀𝜃

La differenza 𝐷(𝑇) = 𝔼[𝑇] − 𝜃 è denominata distorsione.

➢ Stimatori non distorti per μ, p e con 𝝈𝟐

La media, la proporzione e la varianza nella popolazione, sappiamo che valgono le relazioni:

𝔼[𝑋̅ ] = 𝜇

𝔼[𝑃̂] = 𝑝

𝔼[𝑆 2 ] = 𝜎 2

La media campionaria, la proporzione campionaria e la varianza campionaria sono stimatori non

distorti dei rispettivi parametri di riferimento. (ES: pag9)

➢ Errore Quadratico Medio

L’errore quadratico medio dello stimatore T di θ:

𝑀𝑆𝐸 (𝑇) = 𝔼[(𝑇 − 𝜃)2 ]

▪

MSE(T) può essere interpretato come una misura della “distanza” media o,

equivalentemente, della “vicinanza” media delle stime fornite da T e il valore reale di θ.

▪

L’errore quadratico medio dello stimatore T di θ può essere scritto nella forma:

𝑀𝑆𝐸 (𝑇) = 𝕍[𝑇] + (𝔼[𝑇] − 𝜃)2

Dove 𝕍[𝑇] = 𝔼[(𝑇 − 𝜃)2 ] è la varianza dello stimatore.

▪ Se lo stimatore è non distorto, l’errore quadratico medio coincide con la varianza:

𝑀𝑆𝐸 (𝑇) = 𝕍[𝑇]

➢ MSE degli stimatori non distorti per μ, p e con 𝝈𝟐

La media, la proporzione e la varianza nella popolazione, sappiamo che i corrispondenti

stimatori sono non distorti, dunque:

𝜎2

𝑛

𝑝(1 − 𝑝)

𝑀𝑆𝐸(𝑃̂) = 𝕍[𝑃̂] =

𝑛

4

𝜎

𝑛

(𝛾 + 2

)

𝑀𝑆𝐸 (𝑆 2 ) = 𝕍[𝑆 2 ] =

𝑛

𝑛−1

𝑀𝑆𝐸 (𝑋̅ ) = 𝕍[𝑋̅ ] =

La distanza media dal parametro delle stime (𝑥̅ , 𝑝̂ , 𝜎 2 ) decresce con l’ampiezza del campione.

o Proprietà:

➢ Efficienza

L’efficienza è una proprietà che si manifesta nel confronto di due o più stimatori impiegabili

per stimare uno stesso parametro. Dati due stimatori dello stesso parametro 𝜃, 𝑇1 e 𝑇2 si dice

che 𝑇1 è più efficiente di 𝑇2 se:

𝑀𝑆𝐸 (𝑇1 ) = 𝔼[(𝑇1 − 𝜃)2 ] ≤ 𝑀𝑆𝐸 (𝑇2 ) = 𝔼[(𝑇2 − 𝜃)2 ]

∀𝜃

Utilizzare lo stimatore più efficiente, in quanto garantisce a priori una maggiore precisione delle

stime.

➢ Margine di errore nella stima della media

Supponendo che la popolazione sia normale, possiamo scrivere:

𝑃 (−𝑧1−𝛼/2

𝜎

√𝑛

< 𝑋̅ − 𝜇 < −𝑧1−𝛼/2

𝜎

√𝑛

)=1−𝛼

Ciò significa che con probabilità 1 − 𝛼 l’errore che si commette stimando μ con 𝑋̅ è minore, in

valore assoluto, di:

𝜎

√𝑛

𝑑 = 𝑧1−𝛼/2

quantità denominata margine di errore.

↓

dipende da α, da σ e da n

➢ Margine di errore nella stima di una proporzione

Il margine di errore dello stimatore 𝑃̂ della proporzione p di una popolazione Bernoulliana è

dato da:

𝑝(1 − 𝑝)

𝑛

𝑑 = 𝑧1−𝛼/2 √

quantità che dipende dalla proporzione p non nota.

Considerando che:

max (𝑝(1 − 𝑝) = 0.5 ∙ 0.5 = 0.25

possiamo dire che il margine di errore è al massimo uguale a

0.25

𝑛

𝑑 = 𝑧1−𝛼/2 √

➢ Dimensione del campione per un assegnato livello del margine di errore

Dall’equazione:

𝑑 = 𝑧1−𝛼/2

𝜎

√𝑛

risolviamo rispetto ad n, ricavando:

𝑛≥

Quando la popolazione è Bernoulliana:

𝑛≥

2

𝑧1−𝛼/2

𝜎2

𝑑2

2

𝑧1−𝛼/2

0.25

𝑑2

Stima Intervallare

➢ Statistica Ancillare

Sia (𝑋1 , 𝑋2 , … , 𝑋𝑛 ) un campione casuale proveniente dalla popolazione generatrice della quale

interessa stimare il parametro θ incognito. È detta statistica ancillare una funzione del

campione 𝑡(𝑋1 , … , 𝑋𝑛 ; 𝜃) che include tra i suoi argomenti anche il parametro θ e ha una

funzione di probabilità nota e non dipendente da θ

Possiamo calcolare la probabilità:

𝑃(𝑞𝛼 < 𝑡(𝑋1 , … , 𝑋𝑛 ; 𝜃) < 𝑞1−𝛼 ) = 1 − 𝛼

2

2

➢ Stima Intervallare

Sia (𝑋1 , 𝑋2 , … , 𝑋𝑛 ) un campione casuale proveniente dalla popolazione generatrice della quale

interessa stimare il parametro θ. Siano:

𝐿1 = 𝑙1 (𝑋1 , 𝑋2 , … , 𝑋𝑛 )

e

𝐿2 = 𝑙2 (𝑋1 , 𝑋2 , … , 𝑋𝑛 )

Con 𝐿1 < 𝐿2 , due statistiche campionarie tali che:

𝑃(𝐿1 < 𝜃 < 𝐿2 ) = 1 − 𝛼

dove α è un numero molto piccolo (solitamente 0.1, 0.05, 0.01, 0.001) che non dipende da θ.

L’intervallo (𝐿1 , 𝐿2 ) si chiama stimatore intervallare del parametro θ.

Sia (𝑥1 , 𝑥2 , … , 𝑥𝑛 ) un campione casuale osservato e siano 𝑙1 ed 𝑙2 i valori assunti in esso dalle

statistiche campionarie 𝐿1 ed 𝐿2 .

Allora, l’intervallo (𝑙1, 𝑙2 ) è un intervallo di confidenza per θ con coefficiente di fiducia

pari a 1 − α.

Stima per intervallo della media di una popolazione normale con varianza nota

➢ Intervallo di confidenza per 𝛍 con 𝝈𝟐 nota

Sia (𝑋1 , 𝑋2 , … , 𝑋𝑛 ) un campione casuale proveniente dalla popolazione normale 𝑁(𝜇, 𝜎 2 ).

Allora, fissato un livello di probabilità 1 − α, si trova che uno stimatore per intervallo di µ ha

estremi dati da:

𝜎

𝜎

𝐿1 = 𝑋̅ − 𝑧1−𝛼

𝐿2 = 𝑋̅ − 𝑧1−𝛼

2 √𝑛

2 √𝑛

dove 𝑧1−𝛼 è il quantile corrispondente alla probabilità 1 − 𝛼/2 della distribuzione Normale

2

standard.

Pertanto un intervallo di confidenza di livello 1 − α, per il parametro µ è dato da:

𝜎

𝜎

𝑙1 = 𝑥̅ − 𝑧1−𝛼

𝑙2 = 𝑥̅ − 𝑧1−𝛼

2 √𝑛

2 √𝑛

essendo 𝑥̅ la media del campione osservato.

➢ Ampiezza dell’intervallo di confidenza

L’ampiezza dell’intervallo di confidenza, differenza tra estremo destro ed estremo sinistro

dello stimatore per intervallo, è data da:

𝜎

𝐴 = 𝐿2 − 𝐿1 = 2𝑧1−𝛼

2 √𝑛

Esso è funzione di α, di n e di σ:

▪ Cresce al diminuire di α

▪ Decresce all’aumentare di n

▪ Cresce all’aumentare di σ

Stima per intervallo della media di una popolazione normale con varianza NON nota

➢ Intervallo di confidenza per 𝛍 con 𝝈𝟐 NON nota

Sia (𝑋1 , 𝑋2 , … , 𝑋𝑛 ) un campione casuale proveniente dalla popolazione normale 𝑁(𝜇, 𝜎 2 ).

Allora, fissato un livello di probabilità 1 − α, si trova che uno stimatore per intervallo di µ ha

estremi dati da:

𝑆

𝑆

𝐿1 = 𝑋̅ − 𝑡1−𝛼

𝐿2 = 𝑋̅ − 𝑡1−𝛼

2 √𝑛

2 √𝑛

Dove 𝑡1−𝛼 è il quantile corrispondente alla probabilità 1 − α/2 della distribuzione T di student

2

con n − 1 gradi di libertà.

Pertanto un intervallo di confidenza di livello 1 − α, per il parametro µ è dato da:

𝑠

𝑠

𝑙1 = 𝑥̅ − 𝑡1−𝛼

𝑙2 = 𝑥̅ − 𝑡1−𝛼

2 √𝑛

2 √𝑛

Essendo la media del campione osservato.

➢ Stima intervallare della media nel caso di grandi campioni

Se la dimensione del campione è sufficientemente elevata, possiamo riferirci alla statistica:

𝑍=

𝑋̂ − 𝜇

𝑆

√𝑛

la cui distribuzione di probabilità è prossima alla normale standard qualunque sia la

popolazione generatrice.

Ne segue che:

𝑆

𝑆

𝐿1 = 𝑋̅ − 𝑧1−𝛼

𝐿2 = 𝑋̅ − 𝑧1−𝛼

2 √𝑛

2 √𝑛

Gli estremi dell’intervallo di confidenza sono dati da:

𝑙1 = 𝑥̅ − 𝑧1−𝛼

2

𝜎

√𝑛

𝑙2 = 𝑥̅ − 𝑧1−𝛼

2

𝜎

√𝑛

➢ Stima intervallare della proporzione nel caso di grandi campioni

La statistica da utilizzare è:

𝒁=

𝑃̂ − 𝑝

̂

̂

√𝑃(1 − 𝑃)

𝑛

Dove 𝑃̂, stimatore di p, è la v.a. proporzione o frequenza relativa dei successi nel campione.

➢ Intervallo di confidenza per p

Sia (𝑋1 , 𝑋2 , … , 𝑋𝑛 ) un campione casuale proveniente da una popolazione Bernoulliana. Allora,

fissato un livello di probabilità 1 − α, si trova che uno stimatore per intervallo di p ha estremi

dati da:

𝐿1 = 𝑃̂ − 𝑧1−𝛼 √

2

𝑃̂(1 − 𝑃̂)

𝑛

𝐿2 = 𝑃̂ − 𝑧1−𝛼 √

2

𝑃̂(1 − 𝑃̂)

𝑛

dove 𝑧1−𝛼 è il quantile corrispondente alla probabilità 1 − α/2 della distribuzione Normale

2

standard.

Pertanto un intervallo di confidenza di livello 1 − α, per il parametro p è dato da:

𝑙1 = 𝑝̂ − 𝑧1−𝛼 √

2

𝑝̂ (1 − 𝑝̂ )

𝑛

𝑙2 = 𝑝̂ − 𝑧1−𝛼 √

2

𝑝̂ (1 − 𝑝̂ )

𝑛

essendo pˆ la proporzione del campione osservato.

➢

Stima intervallare della varianza di una popolazione normale

Se la popolazione è normale, sappiamo che la v.a.

(𝑛 − 1)𝑆 2

𝑉=

𝜎2

ha distribuzione chi-quadrato χ 2 con 𝑛 − 1 gradi di libertà.

➢ Intervallo di confidenza per σ 2

Sia (𝑋1 , 𝑋2 , … , 𝑋𝑛 ) un campione casuale proveniente dalla popolazione normale 𝑁(𝜇, 𝜎 2 ).

Allora, fissato un livello di probabilità 1 − α, si trova che uno stimatore per stimatore di 𝜎 2 ha

estremi dati da:

(𝑛 − 1)𝑆 2

(𝑛 − 1)𝑆 2

𝐿1 =

𝐿

=

2

2

χ1−𝛼/2

χ2𝛼/2

2

dove χ2𝛼/2 e χ1−𝛼/2

sono i quantili di livello α/2 e 1 − α/2 della Chi-quadrato con n − 1 gradi di

libertà.

Pertanto un intervallo di confidenza di livello 1 − α, per il parametro 𝜎 2 è dato da:

𝑙1 =

(𝑛 − 1)𝑠 2

2

χ1−𝛼/2

𝑙2 =

(𝑛 − 1)𝑠 2

χ2𝛼/2

essendo 𝑠 2 il valore della varianza 𝑆 2 nel campione osservato.

Verifica delle ipotesi

Un metodo alternativo agli intervalli di confidenza è la verifica d’ipotesi.

La verifica d’ipotesi è un metodo analitico per verificare se i dati campionari sono compatibili con

la nostra ipotesi

➢ Ipotesi statistica → è una affermazione o una congettura che riguarda il parametro θ.

L’ipotesi sottoposta a verifica va sotto il nome di ipotesi nulla, essa può essere definita come:

▪ Ipotesi Semplice → se specifica completamente la distribuzione di probabilità della v.c.

oggetto di studio, ad esempio:

p = 0.6 (pop. Bernoulli)

µ = 177 (pop. Normale con σ 2 nota)

λ = 3.2 (pop. Poisson)

▪ Ipotesi Composta → se specifica, non una sola distribuzione di probabilità della v.c.

oggetto di studio, ma una famiglia di possibili distribuzioni, ad esempio:

p ≤ 0.5

µ > 175

▪ Ipotesi Nulla 𝐻0 → in genere rappresenta lo stato attuale delle cose o l’attuale convinzione

riguardo a una situazione.

▪ Ipotesi Alternativa 𝐻1 → rappresenta la conclusione inferenziale che si è interessati a

dimostrare quando il campione osservato fornisce sufficiente evidenza del fatto che

l’ipotesi nulla sia falsa.

Si assume che le due ipotesi 𝐻0 e 𝐻1 siano esaustive (una delle due è necessariamente vera) e

mutuamente esclusive (non possono essere vere contemporaneamente).

I possibili sistemi di ipotesi sono:

{

𝐻0 ∶ 𝜃 = 𝜃0

𝐻1 ∶ 𝜃 ≠ 𝜃0

{

𝐻0 ∶ 𝜃 = 𝜃0

𝐻1 ∶ 𝜃 < 𝜃0

{

𝐻0 ∶ 𝜃 = 𝜃0

𝐻1 ∶ 𝜃 > 𝜃0

{

𝐻0 ∶ 𝜃 ≤ 𝜃0

𝐻1 ∶ 𝜃 > 𝜃0

{

𝐻0 ∶ 𝜃 ≥ 𝜃0

𝐻1 ∶ 𝜃 < 𝜃0

I test di ipotesi possono essere classificati in due gruppi:

o Test a una cosa (test unilaterale) → nell’ipotesi alternativa compare uno dei segni > oppure <

o Test a due code (test bilaterale) → nell’ipotesi alternativa compare il segno ≠

▪

▪

▪

▪

La distribuzione campionaria della statistica test spesso è una distribuzione statistica nota,

come la Normale o la T, e quindi possiamo ricorrere a queste distribuzioni per decidere se

rifiutare o meno a un’ipotesi nulla.

La distribuzione campionaria della statistica test viene divisa in due regioni: una regione di

rifiuto (chiamata anche regione critica) e una regione di accettazione.

Per prendere una decisione sull’ipotesi nulla, dobbiamo in primo luogo definire le regioni di

rifiuto e di accettazione e questo viene fatto determinando il cosiddetto valore critico della

statistica test.

La determinazione di questo valore dipende dall’ampiezza della regione di rifiuto, che è legata

al rischio comportato dal prendere una decisione sul parametro alla luce delle sole

informazioni campionari.

La teoria dei test consente di determinare una regola di decisione che limiti il più possibile il

rischio di decisioni sbagliate. I Quando si applica un procedimento di verifica di ipotesi, dunque nel

decidere se rifiutare o meno l’ipotesi nulla, si possono commettere due tipi di errori:

➢ L’errore di prima specie (detto anche livello di significatività) si verifica se si rifiuta l’ipotesi

nulla quando è vera e quindi non dovrebbe essere rifiutata.

P(errore I specie) = P(Rifiutare 𝐻0 | 𝐻0 vera) = 𝛼

➢ L’errore di seconda specie si verifica se si accetta l’ipotesi nulla quando è falsa e quindi

dovrebbe essere rifiutata.

P(errore II specie) = P(Non Rifiutare 𝐻0 | 𝐻0 falsa) = 𝛽

In genere, si controlla l’errore di prima specie fissando il livello del rischio α che si è disposti a

tollerare. La scelta di α dipende fondamentalmente dai costi che derivano dal commettere un

errore di prima specie.

➢ Il livello di confidenza di un test di ipotesi è dato da (1 − α)% e rappresenta la probabilità che

l’ipotesi nulla non sia rifiutata quando è vera (quindi non dovrebbe essere rifiutata).

P(Non Rifiutare 𝐻0 | 𝐻0 vera) = 1 − 𝛼

➢ La potenza del test, indicata con (1 − β) rappresenta la probabilità di rifiutare l’ipotesi nulla

quando è falsa (e quindi dovrebbe essere rifiutata).

P(Rifiutare 𝐻0 |𝐻0 falsa) = 1 − 𝛽

A differenza dell’errore di prima specie, che controlliamo fissando α, la probabilità di commettere

un errore di seconda specie dipende dal campione osservato.

➢ Le fasi della verifica di ipotesi utilizzando l’approccio del valore critico

1. Specificare l’ipotesi nulla e l’ipotesi alternativa.

2. Scegliere il livello di significatività α e l’ampiezza campionaria n. Il livello di significatività

viene fissato in base all’importanza relativa che si accorda ai rischi derivanti dal

commettere un errore di prima specie e dal commettere un errore di seconda specie.

3. Individuare la tecnica statistica a cui fare riferimento e la corrispondente distribuzione

campionaria.

4. Calcolare i valori critici che separano la regione di rifiuto da quella di accettazione.

5. Raccogliere i dati e calcolare il valore campionario della statistica test.

6. Prendere la decisione statistica.

Se la statistica test cade nella regione di accettazione, l’ipotesi nulla 𝐻0 non può essere

rifiutata.

Se la statistica test cade nella regione di rifiuto, l’ipotesi nulla 𝐻0 viene rifiutata.

Esprimere la decisione statistica con riferimento al problema che si sta affrontando.

➢ Verifica di ipotesi utilizzando l’approccio del P-value

Il p-value → rappresenta la probabilità di osservare un valore della statistica test uguale o più

estremo del valore che si calcola a partire dal campione, quando l’ipotesi 𝐻0 è vera.

𝛼𝑜𝑠𝑠 = 𝑃(Z assuma un valore più estremo rispetto a quello campionario | 𝐻0 )

Il p-value è anche chiamato livello di significatività osservato e viene indicato con 𝛼𝑜𝑠𝑠 .

In base all’approccio del p-value, la regola decisionale per rifiutare H0 è la seguente:

▪ Se 𝛼𝑜𝑠𝑠 ≥ 𝛼, l’ipotesi nulla non è rifiutata.

▪ Se𝛼𝑜𝑠𝑠 < 𝛼, l’ipotesi nulla è rifiutata.

𝛼𝑜𝑠𝑠 = 𝑃(𝑍 > 𝑧𝑥̅ | 𝜇 = 𝜇0

➢ Legame tra intervalli di confidenza e verifica di ipotesi

o Gli intervalli di confidenza sono stati usati per stimare i parametri della popolazione.

o La verifica di ipotesi viene impiegata per poter prendere delle decisioni che dipendono dai

valori dei parametri.

Ogni test a due code ha un intervallo di confidenza equivalente. Pertanto se si è già calcolato un IC

per un parametro θ si può usare quell’intervallo per fare un test a due code su θ senza dover

ripetere i calcoli

{

𝐻0 ∶ 𝜃 = 𝜃0

𝐻1 ∶ 𝜃 ≠ 𝜃0

⟺

𝐼𝐶1−𝛼% (𝜃)

➢ Verifica di ipotesi sulla media di una popolazione normale con 𝝈𝟐 nota

▪

Sistemi di ipotesi:

{

▪

𝐻0 ∶ 𝜇 = 𝜇0

𝐻1 ∶ 𝜇 > 𝜇0

Regola di decisione:

Si rifiuta l’ipotesi nulla se il valore assunto dalla statistica test nel campione osservato fa

parte dell’insieme, detto regione di rifiuto:

𝑅 = {𝑧 ∶ 𝑧 > 𝑧1−𝛼 }

Equivalente a:

𝑅𝑥 = {𝑥̅ ∶ 𝑥̅ > 𝜇0 + 𝑧1−𝛼

Ammesso che 𝐻0 sia vera, la probabilità che:

𝑋̅ > 𝜇0 + 𝑧1−𝛼

𝜎

√𝑛

}

𝜎

√𝑛

cioè la probabilità di rifiutare l’ipotesi nulla, è uguale al livello di significatività α.

L’ipotesi nulla viene rifiutata quando 𝑋̅ assume un valore molto più grande di 𝜇0 , ovvero per valori

che, sotto 𝐻0 , sono poco credibili di 𝜇0 . (ES: pag24)

Espressioni equivalenti sono:

- La media campionaria differisce significativamente da 𝜇0 ,;

- La differenza 𝑥̅ − 𝜇0 , è significativamente diversa da 0;

- Vi è sufficiente evidenza empirica contro l’ipotesi nulla.

▪

Sistemi di ipotesi:

{

▪

Regola di decisione:

Si rifiuta l’ipotesi nulla se il valore assunto dalla statistica test nel campione osservato fa

parte dell’insieme, detto regione di rifiuto:

𝑅 = {𝑧 ∶ 𝑧 > 𝑧1−𝛼 }

▪

√𝑛

}

𝐻0 ∶ 𝜇 = 𝜇0

𝐻1 ∶ 𝜇 < 𝜇0

⟺ 𝑅𝑥 = {𝑥̅ ∶ 𝑥̅ < 𝜇0 − 𝑧1−𝛼

𝜎

√𝑛

}

Sistemi di ipotesi:

{

▪

𝜎

Regola di decisione:

In questo caso, si rifiuta l’ipotesi nulla per valori di Z minori di −𝑧1−𝛼 , ossia:

𝑅 = {𝑧 ∶ 𝑧 < −𝑧1−𝛼 }

▪

⟺ 𝑅𝑥 = {𝑥̅ ∶ 𝑥̅ > 𝜇0 + 𝑧1−𝛼

Sistemi di ipotesi:

{

▪

𝐻0 ∶ 𝜇 ≤ 𝜇0

𝐻1 ∶ 𝜇 > 𝜇0

𝐻0 ∶ 𝜇 = 𝜇0

𝐻1 ∶ 𝜇 ≠ 𝜇0

Regola di decisione:

In questo caso, la regione di rifiuto è bidirezionale, ovvero considera entrambe le code

della distribuzione:

𝑅 = {𝑧 ∶ |𝑧| > 𝑧1−𝛼/2 }

⟺ 𝑅𝑥 = {𝑥̅ ∶ |𝑥̅ | ∉ [𝜇0 − 𝑧1−𝛼

2

𝜎

√𝑛

; 𝜇0 + 𝑧1−𝛼

➢ Verifica di ipotesi sulla media di una popolazione normale con 𝝈𝟐 incognita

2

𝜎

√𝑛

]}

➢ Verifica di ipotesi sulla media nel caso di grandi campioni

➢ Verifica di ipotesi sulla media nel caso di grandi campioni e popolazione Bernoulli

➢

Verifica di ipotesi sulla varianza di una popolazione normale

Regressione Lineare

➢ Analisi delle distribuzioni doppie

La distribuzione doppia di frequenza è il risultato di un processo di classificazione:

1. si individuano le I · J classi formate dalla coppia di modalità (𝑥𝑖 , 𝑦𝑗 )

2. si attribuisce ciascuna delle N unità statistiche alla classe corrispondente alla coppia

di modalità osservata su quella unità;

3. si contano le unità che sono state assegnate ad ogni classe (𝑛𝑖 , 𝑗).

Distribuzione doppia → (𝑥𝑖 , 𝑦𝑗 , 𝑛𝑖 , j) con i = 1, … , I e j = 1, … , J

Distribuzione marginale di X → (𝑥𝑖 , 𝑛𝑖 , . ) con i = 1, … , I

Distribuzione marginale di Y → (𝑦𝑖 , 𝑛. , 𝑗) con j = 1, … , J

{ Distribuzione condizionale di Y dato X → (𝑦𝑖 , 𝑛𝑖,𝑗 )con j = 1, … , J con 𝑖 fissato

➢ Associazione tra variabili quantitative

Lo scatterplot (grafico a dispersione) ci fa capire se esiste una associazione statistica fra due

caratteri quantitativi.

Quando:

▪ All’aumentare di una variabile, l’altra tende a diminuire si parla di associazione

discordante.

▪ All’aumentare di una variabile, l’altra tende ad aumentare, si parla di associazione

concordante.

▪ Al variare di una l’altra tende a non variare si parla di assenza di associazione.

L’indice di variabilità per un variabile quantitativa è la varianza.

𝑁

𝜎𝑋2

1

= ∑(𝑥𝑖 − 𝜇𝑋 ) (𝑥𝑖 − 𝜇𝑋 )

𝑁

𝑖=1

Per misurare l’associazione fra la variabile x e la variabile y si usa la Covarianza.

𝑁

𝜎𝑋𝑌

1

= ∑(𝑥𝑖 − 𝜇𝑋 ) (𝑦𝑖 − 𝜇𝑌 )

𝑁

𝑖=1

➢ Associazione tra caratteri quantitativi

Data una distribuzione doppia in forma disaggregata, si dice che tra le due variabili X e Y vi è

correlazione positiva o concordanza quando esse tendono a crescere (decrescere) insieme.

Si ha correlazione negativa o discordanza quando al crescere di una variabile l’altra tende a

decrescere.

L’indice di correlazione lineare si calcola:

𝑁

∑𝑁

1

𝑥𝑖 − 𝜇𝑋 𝑦𝑖 − 𝜇𝑌

𝑖=1(𝑥𝑖 − 𝜇𝑌 ) (𝑦𝑖 − 𝜇𝑌 )

)(

)= 𝑁

𝑟 = ∑(

2

∑𝑖=1(𝑥𝑖 − 𝜇𝑋 )2 ∑𝑁

𝑁

𝜎𝑋

𝜎𝑌

𝑖=1(𝑦𝑖 − 𝜇𝑌 )

𝑖=1

➢ Correlazione lineare

Ne segue che i prodotti sono in prevalenza positivi nel primo caso e prevalentemente negativi

nel secondo.

𝑥𝑖 − 𝜇𝑋 𝑦𝑖 − 𝜇𝑌

(

)(

)

𝜎𝑋

𝜎𝑌

La quantità sarà:

𝑁

1

𝑥𝑖 − 𝜇𝑋 𝑦𝑖 − 𝜇𝑌

)(

)

𝑟 = ∑(

𝑁

𝜎𝑋

𝜎𝑌

𝑖=1

è positiva nel primo caso e negativa nel secondo.

o Caratteristiche:

▪ Varia nell’intervallo [−1, 1].

▪ È pari a 1 quando tutti i punti osservati si trovano su una retta con coefficiente angolare

positivo, al contrario è uguale a -1 quando tutti punti osservati si trovano su una retta

con coefficiente angolare negativo.

▪ Non cambia se le modalità della singola variabile vengono moltiplicate per una costante

o aumentate (diminuite) di una costante positiva.

▪ Non possono essere date regole fisse per l’interpretazione del coefficiente di

correlazione, che dipende da una serie di considerazioni. Possiamo dire che in genere,

nel settore biomedico ed in epidemiologia, vengono considerati “buoni” valori attorno

a 0.7 (nel caso di una correlazione positiva) oppure a -0.7 (per una correlazione

negativa).

➢ Massima concordanza e massima discordanza

▪

La massima concordanza è definita come la situazione in cui, ordinando le coppie (𝑥𝑖 , 𝑦𝑖 )

secondo l’ordine non decrescente delle modalità di X, si trova che anche le modalità di Y

risultano ordinate in senso non decrescente.

▪

Si definisce come situazione di massima discordanza quella in cui, ordinando le coppie

(𝑥𝑖 , 𝑦𝑖 ) secondo l’ordine non decrescente delle modalità di X, si trova che le modalità di Y

risultano ordinate in senso non crescente.

▪

La correlazione è indice della relazione lineare tra due variabili. Tuttavia, lo sviluppo di due

variabili in parallelo non significa necessariamente che una sia la causa dell’altra. Ecco

perché si dice che la correlazione non è necessariamente indice di causalità.

➢ Dipendenza statistica

Si dispone spesso di dati multivariati in cui si può individuare una variabile Y che può ritenersi

dipendente da più variabili indipendenti, 𝑥1 , 𝑥2 , … , 𝑥𝑘 .

Un problema consiste nel valutare la relazione tra tali variabili, ad esempio la forza di tale

legame.

➢ Errore casuale

Di solito si assume che ϵ sia una v.a. a media nulla e varianza costante:

𝔼[𝜖] = 0

𝕍[𝜖] = 𝜎 2

Spesso si ipotizza anche che la v.a. ϵ sia distribuita secondo un modello Gaussiano:

𝜖 ~ 𝑁(0, 𝜎 2 )

➢ Modello statistico

Un modello che contiene una componente deterministica ed una componente aleatoria viene

detto modello statistico:

𝑌 = 𝑓(𝑥1 , 𝑥2 , … , 𝑥𝑘 ) + 𝜖

Dove 𝑓(𝑥1 , 𝑥2 , … , 𝑥𝑘 ) è la componente deterministica ed ϵ la componente aleatoria.

Quando k > 1 parliamo di modello di regressione lineare multipla.

Durante il corso tratteremo solo il caso con k = 1, ovvero la regressione lineare semplice.

➢ Regressione lineare

(𝑥1 , 𝑦1 ), (𝑥2 , 𝑦2 ), … , (𝑥𝑁 , 𝑦𝑁 ) sono le coppie di valori osservati su N unità statistiche, dette

punti osservati o nuvola di punti.

Il problema è quello di assegnare ai parametri 𝛽0 e 𝛽1 della retta

𝑦 = 𝛽0 + 𝛽1 𝑥 + 𝜖

i valori che consentano di approssimare nel miglior modo possibile la nuvola dei punti. In altri

termini, dobbiamo determinare quella retta, tra le infinte del piano, che meglio si adatta alla

nuvola di punti.

➢ Regressione lineare semplice

Fissata la variabile deterministica ad un generico valore x, la risposta che ci aspettiamo in

assenza di errore è:

𝑦 = 𝛽0 + 𝛽1 𝑥

Ma se l’errore casuale si manifesta, il valore osservato sarà:

𝑦 = 𝛽0 + 𝛽1 𝑥 + 𝜖

dove ϵ è la v.a. che descrive l’errore casuale in corrispondenza di x .

➢ Metodo dei minimi quadrati

Il nostro obiettivo sarà stimare i parametri 𝛽0 e 𝛽1 dai dati disponibili, in modo da trovare la

retta che si adatta meglio ad essi.

La soluzione viene trovata utilizzando il metodo dei minimi quadrati e la retta identificata viene

denominata retta di regressione.

Indicati con 𝑏0 e 𝑏1 due particolari valori di 𝛽0 e 𝛽1, siano:

𝑦̂𝑖 = 𝑏0 + 𝑏1 𝑥𝑖

𝑖 = 1,2, … , 𝑁

i valori teorici o predizioni di Y.

Con il metodo dei minimi quadrati si assegnano a 𝑏0 e 𝑏1 i valori che rendono minima la

quantità S, data da:

𝑁

𝑆 = ∑(𝑦𝑖 − 𝑏0 − 𝑏1 𝑥𝑖 )2 = (𝑦𝑖 − 𝑏0 − 𝑏1 𝑥𝑖 )2 + (𝑦𝑖 − 𝑏0 − 𝑏1 𝑥𝑖 )2 + ⋯ + (𝑦𝑁 − 𝑏0 − 𝑏1 𝑥𝑁 )2

𝑖=1

Si tratta della somma dei quadrati delle differenze tra i valori effettivi e i valori teorici di Y, una

misura del grado di approssimazione dei valori osservati tramite le predizioni.

➢ Stima dei parametri

In presenza di un valore anomalo, la retta di regressione stimata col metodo dei minimi

quadrati ne viene influenzata.

Per una funzione di una sola variabile possiamo trovare il minimo del problema precedente

ponendo la sua derivata prima pari a zero. Inoltre, Ponendo le derivate prime parziali della

funzione S rispetto a 𝛽0 e 𝛽1uguali a zero si ottengono gli stimatori dei minimi quadrati:

𝑏0 = 𝜇𝑌 − 𝑏1 𝜇𝑋

∑𝑁

𝑖=1(𝑥𝑖 − 𝜇𝑋 ) (𝑦𝑖 − 𝜇𝑌 )

𝑏1 =

2

∑𝑁

𝑖=1(𝑥𝑖 − 𝜇𝑋 )

Dove 𝜇𝑋 e 𝜇𝑌 sono le medie delle distribuzioni di X e Y, rispettivamente.

Nel termine 𝑏1 , denoteremo il numeratore come codevianza ed il denominatore come

devianza.

➢ Retta di regressione

Una volta calcolati 𝑏0 e 𝑏1 l’equazione che ne risulta:

𝑦̂𝑖 = 𝑏0 + 𝑏1 𝑥𝑖

rappresenta la retta di regressione stimata di Y su X.

▪ Il significato da attribuire al coefficiente angolare 𝑏1 è il seguente: poiché la retta rispecchia

l’andamento medio dei dati osservati, 𝑏1 indica la variazione media che subisce Y quando X

aumenta di una unità.

▪ La retta di regressione passa per il baricentro della distribuzione doppia, cioè per il punto

(𝜇𝑋 + 𝜇𝑌 ).

▪ Le differenze tra i valori effettivi e i valori teorici di Y, sono dette residui:

𝑒𝑖 = 𝑦𝑖 − 𝑝̂𝑖

▪

𝑖 = 1,2, … , 𝑁

La somma dei residui sarà sempre uguale a zero, ∑𝑁

𝑖=1 𝑒𝑖 = 0

➢ Adattamento della regressione ai dati

Data una distribuzione doppia disaggregata, la devianza della variabile Y può essere scomposta:

𝑁

𝑁

2

𝑁

2

̂𝑖 − 𝜇𝑌 ) + ∑( 𝑦𝑖 − 𝑦

̂𝑖 )

∑( 𝑦𝑖 − 𝜇𝑌 ) = ∑( 𝑦

𝑖=1

𝑖=1

2

𝑖=1

dove 𝑦̂𝑖 sono i valori teorici forniti dalla retta di regressione.

Similmente, possiamo scrivere:

𝑆𝑆𝑇 = 𝑆𝑆𝑅 + 𝑆𝑆𝐸

dove SST, SSR e SSE definiscono le somme dei quadrati degli scarti (Sum of Squares) totali, della

regressione e degli errori, rispettivamente.

Una misura dell’adattamento della retta ai punti osservati, denominata indice di determinazione, è

rappresentata dal rapporto:

2

𝑅 =

2

∑𝑁

̂𝑖 − 𝜇𝑌 )

𝑖=1(𝑝

∑𝑁

𝑖=1(𝑦𝑖 − 𝜇𝑌 )

2

=

𝑆𝑆𝑅

𝑆𝑆𝐸

=1−

𝑆𝑆𝑇

𝑆𝑆𝑇

tale misura 𝑅 2 𝜖 [0; 1], dove 𝑅 2 = 0 quando 𝑆𝑆𝑅 = 0, dunque se e solo se la retta di regressione è

parallela all’asse delle ascisse, mentre 𝑅 2 = 1 quando 𝑆𝑆𝐸 = 0, quindi se e solo se i punti

osservati giacciono su una retta.