caricato da

ursula.cavalca

Lezioni di algebra lineare - Politecnico di Milano 2017/2018

Politecnico di Milano

A. A. 2017/2018

Lezioni di algebra lineare

a cura di Prof. Elena Beretta

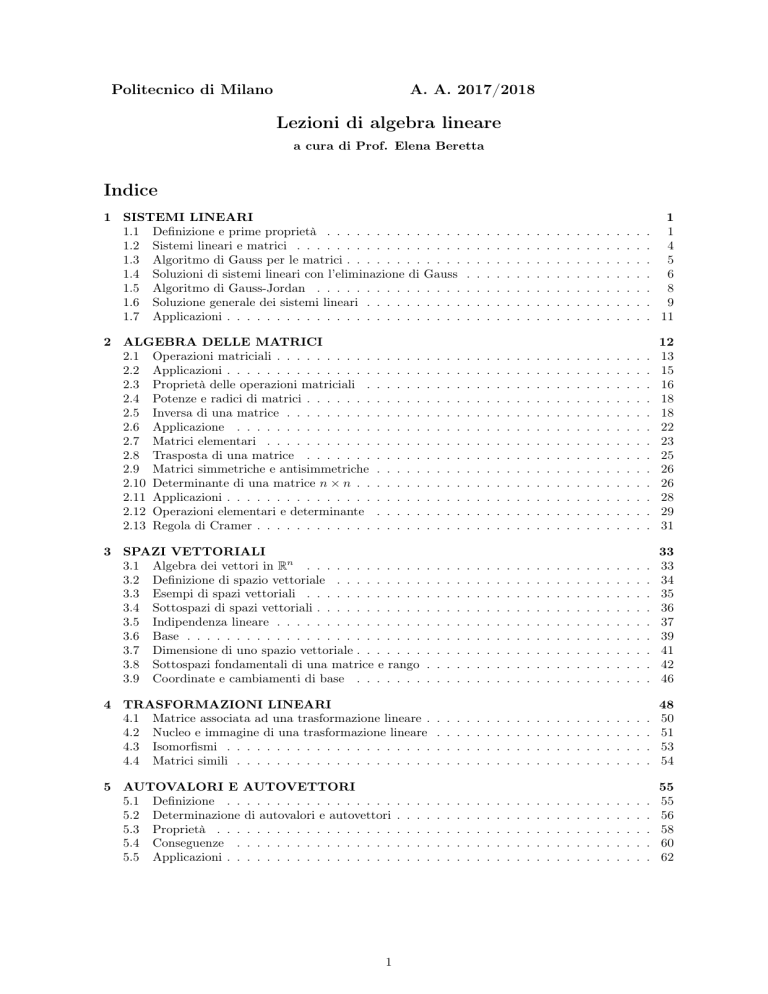

Indice

1 SISTEMI LINEARI

1.1 Definizione e prime proprietà . . . . . . . . . . . . . .

1.2 Sistemi lineari e matrici . . . . . . . . . . . . . . . . .

1.3 Algoritmo di Gauss per le matrici . . . . . . . . . . . .

1.4 Soluzioni di sistemi lineari con l’eliminazione di Gauss

1.5 Algoritmo di Gauss-Jordan . . . . . . . . . . . . . . .

1.6 Soluzione generale dei sistemi lineari . . . . . . . . . .

1.7 Applicazioni . . . . . . . . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

1

. 1

. 4

. 5

. 6

. 8

. 9

. 11

2 ALGEBRA DELLE MATRICI

2.1 Operazioni matriciali . . . . . . . . . .

2.2 Applicazioni . . . . . . . . . . . . . . .

2.3 Proprietà delle operazioni matriciali .

2.4 Potenze e radici di matrici . . . . . . .

2.5 Inversa di una matrice . . . . . . . . .

2.6 Applicazione . . . . . . . . . . . . . .

2.7 Matrici elementari . . . . . . . . . . .

2.8 Trasposta di una matrice . . . . . . .

2.9 Matrici simmetriche e antisimmetriche

2.10 Determinante di una matrice n × n . .

2.11 Applicazioni . . . . . . . . . . . . . . .

2.12 Operazioni elementari e determinante

2.13 Regola di Cramer . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

12

13

15

16

18

18

22

23

25

26

26

28

29

31

3 SPAZI VETTORIALI

3.1 Algebra dei vettori in Rn . . . . . . . . . . . .

3.2 Definizione di spazio vettoriale . . . . . . . . .

3.3 Esempi di spazi vettoriali . . . . . . . . . . . .

3.4 Sottospazi di spazi vettoriali . . . . . . . . . . .

3.5 Indipendenza lineare . . . . . . . . . . . . . . .

3.6 Base . . . . . . . . . . . . . . . . . . . . . . . .

3.7 Dimensione di uno spazio vettoriale . . . . . . .

3.8 Sottospazi fondamentali di una matrice e rango

3.9 Coordinate e cambiamenti di base . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

33

33

34

35

36

37

39

41

42

46

4 TRASFORMAZIONI LINEARI

4.1 Matrice associata ad una trasformazione lineare .

4.2 Nucleo e immagine di una trasformazione lineare

4.3 Isomorfismi . . . . . . . . . . . . . . . . . . . . .

4.4 Matrici simili . . . . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

48

50

51

53

54

5 AUTOVALORI E AUTOVETTORI

5.1 Definizione . . . . . . . . . . . . . . . . .

5.2 Determinazione di autovalori e autovettori

5.3 Proprietà . . . . . . . . . . . . . . . . . .

5.4 Conseguenze . . . . . . . . . . . . . . . .

5.5 Applicazioni . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

55

55

56

58

60

62

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

1

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

1

1.1

SISTEMI LINEARI

Definizione e prime proprietà

In questo primo paragrafo introdurremo i sistemi lineari. Il caso più semplice, che già conoscete tutti,

è quello di un’equazione lineare.

Definizione 1.1. Un’equazione lineare in n variabili x1 , . . . , xn è un’equazione della forma

a1 x1 + a2 x2 + · · · + an xn = b

(1)

dove a1 , . . . , an ∈ R sono i coefficienti , b ∈ R è il termine noto, a1 è detto coefficiente principale e x1

variabile principale.

Definizione 1.2. Una soluzione del sistema lineare (1) è una n-pla s1 , . . . , sn di numeri reali tale che

a1 s1 + a2 s2 + · · · + an sn = b

Esempio 1.1. L’equazione lineare di una variabile

3x1 = 2

ha un’unica soluzione x1 = 32 .

Esempio 1.2. L’equazione lineare di una variabile

0x1 = 2

non ha soluzione.

Notiamo comunque che di solito, se ai = 0, il corrispondente termine viene omesso.

Esempio 1.3. L’equazione lineare

2x1 − x2 = 1

è un’equazione lineare in due variabili. Per trovare eventuali soluzioni si può procedere così :

(

x1 = s variabile libera

x2 = 2s − 1, s ∈ R

Ci sono quindi infinite soluzioni, che geometricamente rappresentano i punti della retta di equazione

cartesiana 2x1 − x2 = 1. In questo caso diciamo che l’equazione ha ∞1 soluzioni, ossia infinite

dipendenti da un parametro reale.

Esempio 1.4. L’equazione lineare

3x1 − 2x2 − x3 = 0

è un’equazione lineare in tre variabili che ammette infinite soluzioni che si possono rappresentare nella

forma

x 1 = s

x2 = t

x3 = 3s − 2t s, t ∈ R

Geometricamente sono tutti i punti appartenenti al piano di equazione cartesiana

3x1 − 2x2 − x3 = 0

In questo caso diciamo che il sistema ha ∞2 soluzioni.

In realtà è più interessante, sia matematicamente che per le applicazioni, il caso in cui ci sono più

equazioni lineari.

Definizione 1.3. Definiamo sistema lineare di m equazioni in n variabili x1 , x2 . . . , xn un sistema

della forma

a11 x1 + a12 x2 + · · · + a1n xn = b1

a21 x1 + a22 x2 + · · · + a2n xn = b2

(2)

..

..

..

..

.

.

.

.

am1 x1 + am2 x2 + · · · + amn xn = bm

aij , i = 1, . . . , n, j = 1, . . . , m sono detti coefficienti, b1 , b2 , . . . , bm termini noti.

2

Definizione 1.4. Chiameremo soluzione del sistema (2) una n-pla s1 , s2 , . . . , sn che è simultaneamente

soluzione di tutte le equazioni del sistema.

Osserviamo che per il fatto di richiedere la soluzione simultanea di tutte le equazioni del sistema, le

soluzioni di sistemi lineari sono praticamente imprevedibili senza l’ausilio del calcolo.

Esempio 1.5.

(

x+y =3

x − y = −1

Il sistema è di due equazioni in due variabili x e y e può essere risolto per sostituzione

(

(

(

y =3−x

y =3−x

y=2

x − 3 − x = −1 ⇒

x=1 ⇒

x=1

Quindi il sistema ha un’unica soluzione. Geometricamente tale soluzione può essere interpretata

come il punto di intersezione tra le due rette di equazioni cartesiane x + y = 3 e x − y = −1.

Esempio 1.6. Si consideri

(

(

x+y =3

x+y =3

2x + 2y = 6 ⇒

0=0

In questo caso otteniamo infinite soluzioni rappresentate da

(

x=s

y = 3 − s, s ∈ R

Infine consideriamo

Esempio 1.7.

(

x+y =3

x+y =1

⇒1=3

Quindi in questo caso il sistema non ha soluzione.

Quindi abbiamo visto che anche nel caso di sistemi ci sono tre situazioni possibili:

(a) Esiste un’ unica soluzione

(b) Esistono infinite soluzioni

(c) Non esiste alcuna soluzione (questo caso è più naturale che nel caso di una sola equazione)

Vedremo più avanti che queste sono le sole tre situazioni possibili per qualsiasi sistema lineare della

forma (2). Nel caso (a) diremo che il sistema è determinato. Nel caso (b) diremo che il sistema è

indeterminato. Nel caso (c) diremo che il sistema è impossibile. Ovviamente più il sistema cresce

in dimensione e più è difficile verificare (a), (b) e (c). Consideriamo il seguente sistema

3x1 + 2x2 − 5x3 + x4 = 2

9x − 4x + 5x + 4x = −4

1

2

3

4

(3)

3x

−

8x

+

25x

+

2x

1

2

3

4 = −8

−6x1 + 8x2 − 10x3 + 7x4 = 8

Come risolvere questo sistema di quattro equazioni in quattro variabili? Il matematico Gauss (17771855) ebbe la seguente idea:

(i) Se il sistema (3) fosse ad esempio nella forma

x1 + 2x2 − x3 + x4 = ...

x2 − 5x3 + ... =

x3 + x4 = ...

x4 = ....

(4)

allora sarebbe molto semplice calcolare la soluzione (se questa esiste) mediante sostituzione

all’indietro. Vediamo un’altro esempio

3

Esempio 1.8.

x1 + x2 + x3 = 1

x2 + x3 = 2

x3 = 1

e quindi

x1 = 1 − 1 − 1 = −1

x2 = 2 − 1 = 1

x3 = 1

Un sistema in questa forma è detto a scala. (Il primo elemento diverso da zero di una riga deve

essere più a destra del primo elemento diverso da zero della riga precedente). Il primo coefficiente

diverso da zero su ogni riga (quando c’è ) è detto pivot (capiremo più tardi il significato del

nome). Una volta che il sistema è in questa forma lo si può risolvere sostituendo all’indietro come

visto nell’esempio precedente. In particolare, un sistema a scala in cui il numero di equazioni

coincide con il numero di variabili è detto triangolare.

(ii) Se il sistema non è nella forma di un sistema a scala allora si eseguono delle operazioni dette

mosse di Gauss che lo riducono ad un sistema a scala con lo stesso insieme di soluzioni. Vale il

seguente

Lemma 1.1. * Le seguenti operazioni sulle righe di un sistema lineare di m equazioni in n

variabili non alterano l’insieme delle soluzioni

(I) Sommare ad un’equazione un multiplo di un’altra equazione

(II) Moltiplicare un’equazione per una costante diversa da zero

(III) Scambiare due equazioni

Diciamo che due sistemi sono equivalenti se hanno lo stesso insieme di soluzioni. Quindi due

sistemi ottenuti uno dall’altro mediante queste operazioni sono equivalenti.

Dimostrazione. Sia s1 , . . . , sn la soluzione del sistema lineare quindi tale che

n

X

aij sj = bi

i = 1, . . . , m

(5)

j=1

e consideriamo il nuovo sistema ottenuto sostituendo alla h-esima riga la somma tra la h-esima

riga e λ volte la k-esima riga . Otteniamo

(P

n

(ahj + λakj )sj = bh + λbk

(6)

Pj=1

n

j=1 aij sj = bi ∀i 6= h

e quindi s1 , . . . , sn è soluzione del nuovo sistema (6). Viceversa, se s1 , . . . , sn è soluzione di (6)

si ha che

(P

Pn

n

ahj sj = bh − λ j=1 akj sj + λbk = bh

Pj=1

n

j=1 aij sj = bi ∀i 6= h

e quindi si ha che s1 , . . . , sn risolve (5). Analogamente si può dimostrare l’equivalenza dei sistemi

ottenuti tramite (II) e (III).

Possiamo quindi applicare le operazioni (I), (II) e (III) per ridurre un sistema lineare qualsiasi

alla forma di sistema a scala e per risolverlo (se possibile) con sostituzioni all’indietro. Applichiamo il Lemma (1.1) in modo non molto sistematico per ora. Più avanti individueremo un

algoritmo preciso detto metodo di eliminazione gaussiana valido in generale. Vediamo ora

un’ applicazione del teorema nel caso di un sistema di tre equazioni in tre variabili.

Esempio 1.9.

x − 2y + 3z = 9

−x + 3y = −4

2x − 5y + 5z = 17

4

Indichiamo ora con ri l’equazione i-esima del sistema e operiamo la mossa r2 + r1 → r2 .

Otteniamo il sistema equivalente

x − 2y + 3z = 9

y + 3z = 5

2x − 5y + 5z = 17

Quindi operando −2r1 + r3 → r3 si ricava

x − 2y + 3z = 9

y + 3z = 5

−y − z = −1

e ponendo r2 + r3 → r3 si ricava

x − 2y + 3z = 9

y + 3z = 5

2z = 4

Infine con l’operazione r3 /2 → r3 si ricava

x − 2y + 3z = 9

y + 3z = 5

z=2

che è un sistema triangolare. Sostituendo all’indietro si ottiene

x = 1

y = −1

z =2

e in questo caso il sistema ha un’unica soluzione. (Verificare che la soluzione trovata è effettivamente soluzione del sistema di partenza!)

1.2

Sistemi lineari e matrici

Per dare una descrizione matematica più precisa del metodo di eliminazione gaussiana introduciamo il concetto di matrice, che consiste nel focalizzarci sui coefficienti del sistema opportunatamente organizzati spazialmente. Come vedremo le matrici appaiono non solo nella soluzione

dei sistemi lineari ma in moltissime altre situazioni: ancora più che con i sistemi la formulazione

spaziale delle matrici apre orizzonti usualmente inaccessibili alla mente umana.

Definizione 1.5. Dati m, n interi positivi una matrice m × n è una tabella rettangolare di

numeri

a11 a12 . . . a1n

a21 a22 . . . a2n

A= .

..

..

.. = [aij ]i=1,...,m,j=1,...,n

..

.

.

.

am1

am2

...

amn

– Le righe orizzontali della matrice sono dette righe, mentre quelle verticali colonne

– aij indica l’ elemento all’incrocio tra la i-esima riga e la j-esima colonna. Quindi i e’ l’indice

di riga e j l’indice di colonna.

– se n = m diremo che la matrice è quadrata.

– m × n indica la dimensione della matrice.

– se n = m gli elementi aii sono detti elementi della diagonale principale della matrice.

L’idea è ora di reinterpretare il metodo di eliminazione gaussiana utilizzando le matrici seguendo

il seguente schema

5

/ matrice

sistema lineare

eliminazione di Gauss

eliminazione di Gauss sul sistema

matrice a scala

sistema a scala o

eliminazione di Gauss Jordan

sostituzione all’indietro

matrice a scala ridotta

soluzione o

1. Si identificano delle matrici collegate al sistema

2. Si eseguono operazioni elementari (mosse di Gauss) sulle righe delle matrici

3. Si ritorna al sistema e si trova la soluzione se questa esiste (eventualmente con ulteriori

passaggi)

Il punto che può confondere è che si può ritornare al sistema in vari momenti e si è più o meno

vicini alla soluzione. Sebbene sia intuitivo tornare presto al sistema, è numericamente e matematicamente più efficiente tornarvi solo all’ultimo con la soluzione già completa. Descriveremo

entrambe le strade, chiamate eliminazione di Gauss per matrici e eliminazione di Gauss-Jordan.

Un’ultima osservazione sull’utilizzo delle matrici: i passaggi dal sistema lineare alla matrice associata e viceversa può essere descritto a parole (in modo complicato) oppure tramite prodotti

di matrici (vedi matrici elementari). Per ora omettiamo le dimostrazioni e tutto verrà reso

formalmente rigoroso dopo aver introdotto le operazioni tra matrici nel prossimo capitolo.

Definizione 1.6. Dato un sistema lineare

a11 x1 + a12 x2 + · · · + a1n xn = b1

a21 x1 + a22 x2 + · · · + a2n xn = b2

(7)

..

..

..

...

.

.

.

am1 x1 + a22 x2 + · · · + amn xn = bm

si dice matrice dei coefficienti la matrice A, m × n, in cui l’elemento aij è il coefficiente della

variabile xj nella i -esima equazione. Chiameremo matrice completa la matrice B = (A b)

m × (n + 1) data da

a11 a12 . . . a1n b1

a21 a22 . . . a2n b2

B= .

..

..

..

..

.

.

.

am1

1.3

am2

...

amn

bm

Algoritmo di Gauss per le matrici

E’ arrivato il momento di descrivere l’algoritmo di eliminazione di Gauss nel dettaglio.

Definizione 1.7. Chiameremo pivot di una riga di una matrice il primo elemento non nullo

da sinistra, se esiste.

Definizione 1.8. Chiameremo matrice a scala una matrice m × n tale che se i2 > i1 il pivot

della riga i2 (se esiste) è strettamente a destra del pivot della riga i1 , ossia se ai1 j1 e ai2 j2 sono

i pivot allora i2 > i1 ⇒ j2 > j1 .

Esempio 1.10.

1 0 2

1 0 2

0 0

A1 = 0 0 1 , A2 =

, A3 = 0 0 1

0 0

0 0 0

0 2 1

Osserviamo che A1 è una matrice a scala e l’ultima riga non ha pivot. La matrice A2 è a scala

mentre A3 non è a scala.

6

Il prossimo teorema descrive in dettaglio l’algoritmo di eliminazione di Gauss.

Teorema 1.1. * Data una matrice A, m × n, il seguente algoritmo produce una matrice a scala.

(0) Porre A(1) = A

(1) Scambiare la prima riga di A(1) con la più in alto delle righe che hanno il pivot più a

sinistra. Se nessuna riga ha il pivot la matrice è costituita da soli zeri e abbiamo concluso.

Altrimenti indichiamo con a1j1 il pivot della prima riga dopo lo scambio

(2) Moltiplicare la prima riga per

1

a1j1

(3) Sommare alla riga i-esima la prima riga moltiplicata per −aij1 per ogni i > 1. Tutti gli

elementi della colonna j1 eccetto il primo sono ora nulli.

(4) Se A(1) ha più di una riga ridefinire A(1) come matrice ottenuta trascurando la prima riga

della precedente matrice A(1) continuando a riportare le righe trascurate. Se A(1) ha una

sola riga concludere.

(5) Ripetere (1)-(4) fino alla conclusione.

Vediamo ora un esempio in cui applichiamo l’algoritmo

Esempio 1.11. Sia A la seguente matrice

1

3 12 −6

0 0

2

0

0 0

3 12 −6

2

→

→

A=

1

1 3

1 3

2

2

0

0 3

1

0 3

1

Ignoriamo ora la prima

nuova matrice

1 4

0 0

0 −1

0 3

appena descritto

4

0

3

3

1

−2

0

2

→

0

2

0

1

4 −2

0

2

−1 4

3

1

riga (che però continuiamo a riportare) e ripetiamo la procedura sulla

1

−2

0

2

→

0

4

0

1

Ignoriamo la prima riga e la

1

0

0

0

4

−1

0

3

1

−2

0

4

→

0

2

0

1

4

1

0

3

1

−2

0

−4

→

0

2

0

1

4

1

0

0

−2

−4

2

13

seconda riga continuando a riportarle e ripetiamo la procedura

1 4 −2

1 4 −2

4 −2

1 −4

→ 0 1 −4 → 0 1 −4

0 0 1

0 0 1

0 2

0 0 0

0 13

0 0 13

Ignoriamo la prima riga, la seconda riga e la

procedura

1

0

0

0

terza riga continuando a riportarle e ripetiamo la

4

1

0

0

−2

−4

1

0

Poichè nella matrice A1 è rimasta una sola riga di zeri abbiamo concluso.

Abbiamo descritto l’ algoritmo di Gauss nel dettaglio; chiaramente nella pratica si possono

combinare mentalmente vari passaggi come vedremo nei prossimi esempi.

1.4

Soluzioni di sistemi lineari con l’eliminazione di Gauss

Combinando il Lemma 1.1 e il Teorema 1.1 si ottiene il seguente

Corollario 1.1. Dato un sistema lineare con matrice completa (A b). Se (A0 b0 ) è la matrice a

scala ottenuta con l’algoritmo del Teorema (1.1) da (A b), allora il sistema associato ad (A0 b0 )

ha le stesse soluzioni del sistema iniziale e può essere risolto per sostituzione all’indietro.

Dal punto di vista pratico, questo modo di risolvere i sistemi lineari è il più conveniente per

risolvere a mano sistemi lineari (con qualche eccezione che vedremo più avanti). Dal punto

di vista teorico, da quello pratico (e poichè sarà utile in seguito per calcolare l’inversa di una

matrice) invece, conviene non tornare subito alle soluzioni come descritto nel prossimo paragrafo

7

sull’eliminazione di Gauss-Jordan. Vediamo ora alcuni esempi di come applicare l’algoritmo di

Gauss appena descritto alla soluzione di sistemi

Esempio 1.12. Riprendiamo il sistema dell’esempio (1.5).

(

x+y =3

x − y = −1

In tal caso la matrice dei coefficienti è

1

A=

1

1

−1

mentre la matrice completa

1

B=

1

1

−1

3

−1

Operiamo ora le operazioni elementari di riga sulla matrice B. Operando r2 − r1 → r2 e

successivamente −r2 /2 → r2 si ha

1 1

3

1 1 3

B → B1 =

→ B2 =

0 −2 −4

0 1 2

ottenendo il sistema a scala equivalente a quello di partenza

(

x+y =3

y=2

e sostituendo all’indietro si ottiene x = 1, y = 2.

Esempio 1.13. Vediamo ora l’esempio (1.6). In tal caso la matrice completa è

1 1 3

B=

2 2 6

Eseguendo r2 − 2r1 si ottiene

1

B → B1 =

0

1

0

(

x+y =3

3

⇒

0

0=0

che quindi dà luogo al sistema indeterminato risolto nell’esempio (1.6) .

Esempio 1.14. Vediamo ora l’esempio (1.7). In tal caso la matrice completa è

1 1 3

B=

1 1 1

Eseguendo r2 − r1 si ottiene

1

B → B1 =

0

(

x+y =3

3

⇒

−2

0 = −2

1

0

che dà luogo a un sistema a scala impossibile .

Esempio 1.15. Riprendiamo il sistema dell’esempio (1.9). Consideriamo la matrice completa

B

1 −2 3 9

−1 3 0 −4 .

2 −5 5 17

ed eseguiamo le mosse di Gauss sulle righe della matrice analoghe a quelle fatte precedentemente

sul sistema. Cominciamo con r2 + r1 → r2

1 −2 3 9

B → B1 = 0 1 3 5

2 −5 5 17

8

Ora eseguiamo r3 − 2r1 → r3 ottenendo

1

B1 → B2 = 0

0

−2

1

−1

3

3

−1

9

5

−1

Eseguendo r2 + r3 → r3

1

B2 → B3 = 0

0

−2

1

0

3 9

3 5

2 4

Infine con r3 /2 → r3 si ha

1

B3 → B4 = 0

0

x − 2y + 3z = 9

3 9

3 5 ⇒

y + 3z = 5

1 2

z=2

−2

1

0

Abbiamo così ottenuto la matrice corrispondente al sistema a scala risolto in precedenza.

1.5

Algoritmo di Gauss-Jordan

Come abbiamo detto è possibile proseguire con le operazioni sulle righe della matrice fino alla

determinazione della soluzione. Infatti dopo aver ridotto una matrice a scala è possibile usare

l’algoritmo cosiddetto di Gauss-Jordan che permette di trasformare la matrice in una matrice

che, in ogni colonna contenente un pivot, abbia solo il pivot come elemento non nullo. In questo

caso diremo che la matrice è a scala in forma ridotta.

Esempio 1.16.

1 0 1

1 0 0 1

A1 = 0 1 3 A2 = 0 1 0 0

0 0 1

0 0 1 2

A1 non è a scala ridotta mentre A2 lo è .

Descriviamo ora nel dettaglio l’algoritmo di Gauss-Jordan.

Teorema 1.2. Data una matrice A m × n, il seguente algoritmo produce una matrice a scala

ridotta.

(0) Effettuare l’eliminazione di Gauss (algoritmo del teorema (1.1)) e indicare con A(1) la

matrice a scala che ne risulta.

(1) Se A(1) è costituita da soli zeri concludere altrimenti supponiamo ci siano k pivot e indichiamo con (ik , jk ) la posizione del pivot più in basso (o,equivalentemente, più a destra).

(2) Per tutti gli i < ik sommare alla i-esima riga la riga ik moltiplicata per −aijk . Tutti gli

elementi della colonna jk eccetto il ik -esimo sono zero.

(3) Se k ≥ 2 ridefinire A(1) come la matrice ottenuta trascurando la ik -esima riga dalla precedente matrice A(1) . Se k = 1 concludere.

(4) Ripetere (1)-(3) fino a conclusione.

Esempio 1.17. Nell’esempio (1.15) abbiamo ridotto la matrice completa alla matrice a scala

1 −2 3 9

B4 = 0 1 3 5

0 0 1 2

Procediamo ora a ridurla alla forma ridotta. Eseguiamo r2 − 3r3 → r2

1 −2 3 9

B4 → B5 = 0 1 0 −1

0 0 1 2

Quindi r1 − 3r3 → r1

1

B5 → B6 = 0

0

9

−2

1

0

0 3

0 −1

1 2

Infine r1 + 2r2 → r1

1

B6 → B7 = 0

0

0

1

0

0

0

1

1

x

−1 ⇒ y

2

z

=1

= −1

=2

quindi abbiamo direttamente la soluzione del sistema senza dover procedere con la sostituzione

all’indietro.

1.6

Soluzione generale dei sistemi lineari

Abbiamo visto che una volta ridotta la matrice completa ad una matrice a scala ridotta è possibile

trovare la soluzione del sistema. In generale vale il seguente risultato

Corollario 1.2. Dato un sistema lineare con matrice completa (A b). Se (A00 b00 ) è la matrice

a scala ridotta ottenuta con l’algoritmo del teorema (1.2) da (A b), allora il sistema associato ad

(A00 b00 ) ha le stesse soluzioni del sistema iniziale.

Ecco tre esempi:

Esempio 1.18. Supponiamo che la matrice completa del sistema sia

1 0 2 0 1

0 1 1 0 2

0 0 0 1 3

che e’ a scala ridotta. Osserviamo ore che la terza colonna e l’ultima colonna dei termini noti

non hanno un pivot. Torniamo quindi al sistema associato.

x1 + 2x3 = 1

x2 + x3

=2

x4

=3

La soluzione è immediata osservando che x3 può essere scelta in maniera arbitraria e quindi ha

il ruolo di un parametro libero. Ponendo x3 = t otteniamo le infinite soluzioni

x1 = 1 − 2t

x = 2 − t

2

x3 = t

x4 = 3

Osserviamo che la terza colonna (senza pivot) corrisponde alla variabile x3 che è quella libera.

Esempio 1.19. Ancora più semplice è trovare la soluzione con la matrice a scala ridotta ottenuta

nell’esempio (1.15):

1 0 0 1

B7 = 0 1 0 −1

0 0 1 2

In questo caso tutte le colonne hanno un pivot

è

x

y

z

tranne l’ultima. Tornando al sistema la soluzione

=1

= −1

=2

Esempio 1.20. Se invece la matrice completa a scala ridotta è

1 1 2

0 0 1

In questo caso l’ultima colonna ha un pivot e non ci sono soluzioni poichè 0 6= 1.

Sulla base di questi esempi e di tutta la teoria fatta sinora diventa naturale descrivere tutte le

soluzioni di un sistema lineare, con un teorema di struttura delle soluzioni.

10

Osservazione 1.1. Nel risolvere i sistemi precedenti abbiamo scelto delle variabili come parametri; questa scelta è stata fatta implicitamente sulla base di un’osservazione fondamentale: i

pivot sono definiti riga per riga, ma appartengono anche ad una colonna. Quindi ci sono delle

colonne con pivot e colonne senza pivot: in particolare abbiamo visto che le variabili utilizzate

come parametri corrispondono alle colonne senza pivot. E’ questa l’osservazione fondamentale

che ci permette di descrivere il seguente teorema.

Teorema 1.3. Si consideri il sistema lineare (2). Sia (A b) la matrice completa associata e

(A00 b00 ) la matrice a scala ridotta ottenuta dall’eliminazione di Gauss-Jordan. Allora

(i) Se l’ultima colonna di (A00 b00 ) contiene un pivot il sistema è impossibile

(ii) Altrimenti, supponiamo ci siano k colonne senza pivot con 0 ≤ k ≤ n ed n − k colonne

con pivot e siano j1 , . . . , jk gli indici delle colonne senza pivot e jk+1 , . . . , jn gli indici delle

colonne con pivot . Le soluzioni del sistema sono esattamente quelle della forma

(

tl , se i = jl , l ∈ {1, . . . , k}

(8)

xi =

Pk

b00p − l=1 a00pjl tl se i = jk+p , p ∈ {1, . . . , n − k}

dove t1 , . . . , tk sono dette variabili libere ossia parametri scelti arbitrariamente in R.

Dimostrazione. Dall’ultimo corollario sappiamo che il sistema associato alla matrice a scala ridotta (A00 b00 ) ha le stesse soluzioni del sistema originale.

(i) Nel sistema associato a (A00 b00 ) appare un’equazione della forma 0 = 1 nella riga che ha determinato il pivot trovato sull’ultima colonna. Quindi in questo caso il sistema non ha soluzione.

(ii) Mostriamo che se alle variabili xi si assegnano i valori dati in (ii) allora si ottiene una soluzione del sistema. Infatti, la i-esima equazione non nulla del sistema associato alla matrice (A00 b00 )

è della forma

xjk+p + a00pj1 x1 + . . . a00pjk xk = b00p

(9)

se (i, ji ) è la posizione del pivot nella i-esima riga; si noti che essendo (A00 b00 ) in forma ridotta,

sono uguali a zero tutti i coefficienti aij j 6= ji corrispondenti a colonne con pivot. Sostituendo i

valori di (8) in (9) si ha

k

k

X

X

00

00

bp −

apjl tl +

a00pjl tl = b00p

l=1

l=1

Viceversa, se xi , i = 1, . . . , n sono una soluzione del sistema associato a (A00 b00 ), alle variabili

xi , i = 1, . . . , n relative a colonne senza pivot saranno assegnati dei valori numerici, che siamo

liberi di chiamare t1 . . . , tk . Per le righe in cui appare un pivot, le equazioni saranno della forma

(9), ognuna con la sola variabile xjk+p non ancora assegnata. Sostituendo i simboli t1 . . . , tk in

(9) si ha

k

X

xjk+p +

a00pjl tl = b00p

l=1

da cui si deduce la tesi.

Osservazione 1.2. Questo uso degli indici ha un aspetto non intuitivo: mentre j1 , . . . , jk e

jk+1 , . . . , jn conviene prenderli ognuno in ordine crescente, in generale non sarà jk < jk+1 .

Nell’esempio 1.18 k = 1, j1 = 3, j2 = 1, j3 = 2, j4 = 4.

Osservazione 1.3. Nell’interpretare ed usare l’algoritmo occorre prestare molta attenzione al

continuo scambio di ruolo tra indici delle righe e delle colonne:

i pivot sono determinati dalle righe, ma poi si considerano le colonne con i pivot;

le colonne senza pivot corrispondono alle variabili libere, ma per le altre variabili, che corrispondono alle colonne con pivot il valore di tali variabili viene determinato dalla riga;

non ha senso chiedersi quali termini noti corrispondono alla variabili libere: le variabili sono in

relazione alle colonne e i termini noti alle righe, quindi a priori non c’è nessuna corrispondenza.

E’ in parte fortuita la corrispondenza tra le variabili non libere e i termini noti: più precisamente,

questa corrispondenza è dovuta al fatto che il pivot (che in inglese vuol dire appunto perno) fa

da perno per lo scambio riga colonna e permette di attribuire ad ogni variabile non libera (con

indice di colonna) un termine noto (con corrispondente indice di riga). Alle variabili libere, che

non hanno pivot, non si attribuisce alcun termine noto.

Si possono ora contare le soluzioni del sistema

11

Teorema 1.4. * Un sistema lineare può avere

– nessuna soluzione nel caso (i) del teorema 1.3 (ossia l’ultima colonna contiene un pivot)

quindi il sistema è impossibile,

– una sola soluzione nel caso (ii) del teorema 1.3 se k = 0 (ossia tutte le colonne eccettuata

l’ultima hanno un pivot) e quindi il sistema è determinato

– infinite soluzioni nel caso (ii) del teorema se k > 0; in questo caso ci sono k parametri liberi

e quindi ∞k soluzioni e quindi il sistema è indeterminato

Dimostrazione. La dimostrazione si ottiene immediatamente dal teorema precedente. Infatti nel

caso (i) nel sistema associato a (A00 b00 ) appare un’equazione della forma 0 = 1 nella riga che

ha determinato il pivot trovato sull’ultima colonna. Quindi in questo caso il sistema non ha

soluzione. Nel caso (ii) si ha che se non vi sono variabili libere, dal teorema precedente, l’unica

soluzione è data da

xi = b00i , i = 1, . . . , n

Se invece k > 0 la soluzione dipende da k variabili libere e quindi il sistema ha ∞k soluzioni

rappresentate da (8).

Osserviamo ora che in particolare nel caso di sistemi lineari omogenei

a11 x1 + a12 x2 + · · · + a1n xn = 0

a21 x1 + a22 x2 + · · · + a2n xn = 0

..

..

..

...

.

.

.

am1 x1 + a22 x2 + · · · + amn xn = 0

poichè l’ultima colonna non può mai avere pivot e non ci possono essere più pivot del numero di

righe si ha il seguente

Corollario 1.3. Un sistema lineare omogeneo ammette sempre soluzione. Inoltre se il sistema

ha meno equazioni di incognite il sistema e’ indeterminato.

1.7

Applicazioni

Esempio 1.21. Una società di software ha chiesto un prestito di 500.000 euro per acquistare

nuovi prodotti. Ha avuto una parte di denaro con interesse al 9%, una parte con interesse al 10%

e una al 12%. E’ possibile scrivere un opportuno sistema lineare per determinare quanto denaro

ha avuto la società per ciascun tasso se l’interesse totale annuale che ha pagato è di 52.000 euro

e il totale di denaro avuto al 10% è 2, 5 quello avuto al tasso del 9%. Il sistema da risolvere è il

seguente

= 500.000

x 1 + x 2 + x 3

0.09x1 + 0, 1x2 + 1, 2x3 = 52.000

−2.5x1 + x2

=0

Costruiamo la matrice completa associata

1

0.09

−2, 5

al sistema

1

0.1

1

1

1.2

0

500.000

52.000

0

e applicando il metodo di Gauss-Jordan e’ facile vedere che la soluzione del problema è 100.000

euro al 9%, 250.000 euro al 10% e 150.000 euro al 12%.

Esempio 1.22. Consideriamo un flusso di traffico (descritto da numero di veicoli all’ora) su

alcune strade a senso unico. Determinare i valori di flusso della rete data.

12

x3

100

x4

B

300

C

x2

x5

A

300

400

D

600

x1

500

Come prima cosa scriviamo le equazioni che descrivono il flusso e poi troviamo la soluzione

generale del sistema. Ad ogni incrocio il flusso di veicoli uscente deve coincidere con quello

entrante. Inoltre il flusso totale che entra nella rete cioè 300 + 500 + 400 + 100 deve coincidere

con il flusso totale uscente 300 + 600 + x3 . Quindi si ottiene il sistema

300 + 500 + 400 + 100 = 300 + 600 + x3

x2 + x4 = 300 + x3

x1 + x2 = 800

x1 + x5 = 600

x4 + x5 = 500

Stabilire quale è il flusso massimo di veicoli lungo la strada con il flusso interno x5 . Quale è

il minimo flusso di veicoli lungo la strada con flusso interno x2 ? Risolviamo il sistema con il

metodo di Gauss. Otteniamo il sistema equivalente

x1 + x5 = 600

x − x = 200

2

5

x3 = 400

x4 + x5 = 500

e quindi il sistema generale è descritto da

x1

x2

x3

x4

x5

= 600 − t

= 200 + t

= 400

= 500 − t

= t, t ∈ R

Un flusso negativo corrisponde ad un flusso nella direzione opposta a quella descritta nel modello.

Poichè nel modello tutte le strade sono a senso unico le variabili sono tutte non negative. Quindi

il minimo flusso è ottenuto per x5 = 0 e il massimo è ottenuto per x5 = 500.

2

ALGEBRA DELLE MATRICI

Ricordiamo la definizione di matrice data nel capitolo precedente

Definizione 2.1. Dati m, n interi positivi una matrice m × n è una tabella rettangolare di

numeri

a11 a12 . . . a1n

a21 a22 . . . a2n

A= .

..

..

.. = [aij ]i=1,...,m,j=1,...,n

..

.

.

.

am1

am2

...

amn

13

– Le righe orizzontali della matrice sono dette righe, mentre quelle verticali colonne

– aij indica l’ elemento all’incrocio tra la i-esima riga e la j-esima colonna. Quindi i e’ l’indice

di riga e j l’indice di colonna.

– se n = m diremo che la matrice è quadrata.

– m × n indica la dimensione della matrice.

– Se m = 1, n > 0 A = [a11 . . . a1n ] si riduce a un vettore riga

a11

– Se m > 0, n = 1 A = ... si riduce ad un vettore colonna.

am1

– n = m Gli elementi aii sono detti elementi della diagonale principale della matrice

Possiamo ora considerare operazioni algebriche tra matrici: per esempio, possiamo pensare le

matrici 1 × 1 come numeri reali e per ogni coppia fissata m e n , l’insieme Mm,n delle matrici

m×n come una struttura analoga dei numeri reali (R = M1,1 ). Analogamente le matrici possono

essere considerate estensioni dei vettori. Tutto questo suggerisce varie operazioni, alcune naturali

altre meno ovvie.

2.1

Operazioni matriciali

In realtà per cominciare occorre chiarire il senso di uguaglianza tra matrici (che verrà scelta in

modo ovvio)

1. Uguaglianza: Due matrice A e B sono uguali se hanno la stessa dimensione m × n,

m, n ∈ N e

aij = bij , i = 1, . . . , m, j = 1, . . . , n

Altrettando ovvia e’ la definizione di somma

2. Somma: Date due matrici m × n A = [aij ] e B = [bij ] con i = 1, . . . , m, j = 1, . . . , n la

matrice A + B la matrice m × n di elementi

A + B = [aij + bij ],

i = 1, . . . , m, j = 1, . . . , n

Esempio 2.1.

3 2

−3 −1

A=

B=

−1 1

1

2

3−3 2−1

0 1

A+B =

=

−1 + 1 1 + 2

0 3

In analogia con operazioni tra vettori si introduce l’ovvia definizione di moltiplicazione

scalare.

3. Moltiplicazione per uno scalare: Sia A = [aij ], i = 1, . . . , m, j = 1, . . . , n una matrice

m × n e sia λ ∈ R. Allora λA è la matrice m × n

λA = [λaij ], i = 1, . . . , m, j = 1, . . . , n

Osservazione 2.1. A partire da 1 e 2 possiamo definire la differenza tra matrici

A − B = [aij − bij ], i = 1, . . . , m, j = 1, . . . , n

Esempio 2.2. Date le matrici

1

A = −1

2

2 4

2

0 1 , B = 1

1 1

3

Calcolare A − B e 21 A + 2B.

14

1

−1

2

0

1

1

4. Prodotto tra matrici: La definizione di prodotto è tutt’altro che ovvia. Per questo

partiamo da un’applicazione

Esempio 2.3. Consideriamo la seguente tabella

Tennis

3

0

1

1

Anna

Paola

Carlo

Marco

Golf

5

1

1

0

Calcio

0

0

1

6

Può essere interpretata come una matrice A di dimensione 4 × 3 dove l’elemento aij indica

il numero di ore che lo studente della riga i dedica allo sport corrispondente alla colonna j.

Osserviamo intanto che la somma degli elementi di ciascuna riga ci dice quante sono le ore

complessive che ciascuno studente dedica ai tre sport mentre la somma degli elementi lungo

ciascuna colonna ci dice quante sono le ore totali dedicato dal gruppo di studenti a ciascuno

sport. Consideriamo ora una nuova tabella

Tennis

Golf

Calcio

Cuore

3

1

3

Polmoni

2

2

3

Gambe

3

3

3

che può essere interpretata come una matrice B di dimensione 3 × 3 dove l’elemento bij

indica il beneficio orario (espresso in punti/h) che lo sport i-esimo ha sull’organo j-esimo.

Vorremmo ora sapere l’effetto che ha lo sport sul cuore per Anna. E’ chiaro che questo

sarà 3 punti/h per tre ore dal tennis più 1punto/h per cinque ore dal golf più 3 punti/h per

zero ore per il calcio con un totale di 14 punti. Abbiamo fatto una strana operazione (un

prodotto scalare) tra la prima riga della prima matrice e la prima colonna della seconda

matrice. Questo suggerisce la seguente definizione:

Definizione 2.2. Consideriamo una matrice A = [aij ] di dimensione m × p e una matrice

B = [bij ] di dimensione p × n. Allora la matrice prodotto C = AB è una matrice m × n e i

suoi elementi cij si calcolano nel seguente modo

cij =

p

X

aik bkj = ai1 b1j + ai2 b2j + · · · + aip bpj ,

i = 1, . . . , m, j = 1, . . . , n

k=1

Vediamo più da vicino come è fatto quest’elemento;

è il prodotto scalare tra il vettore riga

b1j

[ai1 . . . aip ] della matrice A e il vettore colonna ...

bpj

Esempio 2.4. Siano

−1

A= 4

5

3

−2 ,

0

B=

−3

−4

2

1

Poichè A ha dimensione 3 × 2 e B ha dimensione 2 × 2 la matrice prodotto AB avrà

dimensione 3 × 2

3 − 12 −2 + 3

−9 1

AB = −12 + 8 8 − 2 = −4 6

−15

10

−15 10

Osservazione 2.2. Ci sono modi diversi di esprimere il prodotto tra matrici. Infatti sia A

matrice m × n e B matrice n × l. Osserviamo, per cominciare che

Bx = x1 b1 + · · · + xl bl

dove

b1i

bi = ...

bni

Utilizzando le proprieta’ delle operazioni matriciali

(AB)x = A(Bx) = A(x1 b1 + · · · + xl bl ) = A(x1 b1 ) + · · · + A(xl bl ) = x1 Ab1 + · · · + xl Abl

15

e quindi

(AB)x = [Ab1 . . . Abl ]x

da cui si ricava

AB = A[b1 . . . bl ] = [Ab1 . . . Abl ]

Esempio 2.5. Calcolare AB utilizzando la formula per il prodotto appena ricavata.

2 3

4 3 6

A=

B=

1 −5

1 −2 3

Calcoliamo quindi

2 3

4

11

2

Ab1 =

=

Ab2 =

1 −5 1

−1

1

3

3

0

2

=

Ab3 =

−5 −2

13

1

3

6

21

=

−5 3

−9

Quindi

AB =

11

−1

0

13

21

−9

Osserviamo che ogni colonna di AB è una combinazione lineare di colonne di A con coefficienti

nelle corrispondenti colonne di B. Osserviamo anche che è possibile esprimere il prodotto AB in

termini di vettori riga. Infatti scrivendo

b1

..

B= .

bn

osserviamo che

[a11 . . . a1n ]B = a11 b1 + · · · + a1n bn

Quindi si ha

r1 B

AB = ...

rn B

dove r1 , . . . , rn sono i vettori riga della matrice A.

2.2

Applicazioni

Esempio 2.6. Riprendiamo ora l’esempio (2.3) visto in precedenza e consideriamo la matrice

prodotto AB di dimensione 4 × 3 che puo’ essere rappresentata con la seguente tabella

Anna

Paola

Carlo

Marco

Cuore

14

1

7

21

Polmoni

16

2

7

20

Gambe

24

3

9

21

in cui l’elemento cij indica il beneficio riportato all’organo j dallo studente i dall’attività praticata.

Esempio 2.7. Un sistema lineare di m equazioni in n incognite può essere scritto in forma

compatta usando il prodotto di matrici. Infatti considerato il sistema

a11 x1 + a12 x2 + · · · + a1n xn = b1

a21 x1 + a22 x2 + · · · + a2n xn = b2

..

..

..

...

.

.

.

am1 x1 + a22 x2 + · · · + amn xn = bm

indicando con x il vettore colonna n × 1 delle variabili

x1

x2

x= .

..

xn

16

e con b il vettore colonna m × 1 dei termini noti

b1

b2

b= .

..

bm

e infine indicando con A la matrice m × n dei coefficienti possiamo riscrivere il sistema nella

forma matriciale utilizzando la definizione di prodotto tra matrici

Ax = b.

Anche la soluzione generale (8) può essere scritta tramite matrici e vettori utilizzando la formula

del teorema 1.3

Esempio 2.8. Nell’esempio 1.17 si ha k = 1 e j1 = 3. Quindi la soluzione può essere scritta

come

1

−2

2

−1

x = + t1

0

1

3

0

Esempio 2.9. Se ora la matrice [A0 b0 ] ha

1

[A0 b0 ] = 0

0

la forma

2

0

0

0

1

0

−1

2

0

0 −2

0 3

1 1

si ha che k = 2 e j1 = 2 e j2 = 4. Quindi la soluzione può essere scritta come

1

−2

−2

0

1

0

x=

3 + t1 0 + t2 −2

1

0

0

0

0

1

2.3

Proprietà delle operazioni matriciali

– Somma e moltiplicazione per uno scalare Date le matrici A, B, C di dimensioni m × n

e fissati λ, µ ∈ R si ha

(1) A + B = B + A (proprietà commutativa)

(2) A + (B + C) = (A + B) + C (proprietà associativa)

(3) (λµ)A = λ(µA) (proprietà associativa del prodotto per uno scalare)

(4) 1A = A

(5) λ(A + B) = λA + λB (proprietà distributiva)

(6) (λ + µ)A = λA + µA (proprietà distributiva)

(7) Sia Om,n la matrice nulla di dimensione m × n

A + Om,n = A

(8) A + (−A) = Om,n

(9) λA = Om,n se λ = 0 oppure A = Om,n

La dimostrazione di (1)-(9) è ovvia e si basa sulle proprietà dei numeri reali ed è quindi

lasciata come esercizio al lettore.

– Prodotto tra matrici Per il prodotto tra matrici le cose non sono ovvie come vedremo

tra poco. Una domanda naturale che possiamo porci a questo punto è se valga la proprietà

commutativa del prodotto. La risposta è no. In generale

AB 6= BA

17

Esempio 2.10. Siano

A=

1

1

Si ha che

1

,

1

B=

3

AB =

3

mentre

BA =

1

2

−1

−1

1

1

0

−1

1

1

Quindi

AB 6= BA

Vediamo ora quali proprietà sono invece vere. Siano A, B, C matrici di dimensioni opportune

e sia λ ∈ R

(1) A(BC) = (AB)C (proprietà associativa del prodotto)

(2) A(B + C) = AB + AC (proprietà distributiva del prodotto rispetto alla somma)

(3) (A + B)C = AC + BC (proprietà distributiva del prodotto rispetto alla somma)

(4) λ(AB) = (λA)B = A(λB) ( proprietà associativa)

(5) A matrice m × n. AIn = Im A = A dove Ik indica la matrice k × k detta identità cioè

in cui tutti gli elementi sulla diagonale principale sono 1 mentre i restanti sono 0.

Dimostrazione. Dimostriamo (1).

X

X

XX

XX

[A(BC)]il =

aij

bjk ckl =

aij bjk ckl =

aij bjk ckl = [(AB)C]il, ∀i, l

j

j

k

k

k

j

Dimostriamo ora (2).

[A(B + C)]il =

X

aij (bjl + cjl ) =

j

X

aij bjl +

X

j

aij cjl = [AB + AC]il , ∀i, l

j

Per dimostrare (3) si procede in maniera analoga. Per (4) osserviamo che

X

X

X

[λ(AB)]il = λ

aij bjl =

λaij bjl = [(λA)B]il =

aij λbjl = [A(λB)]il , ∀i, l

j

j

j

Infine (5) si ottiene osservano che

[AIn ]il =

X

aij δjl

j

dove δjl = 1 se j = l mentre δjl = 0 se j 6= l. Quindi

[AIn ]il = ail = [A]il

Analogamente si mostra che

Im A = A

Un’altra proprietà falsa è la regola di cancellazione del prodotto. Questo rende le equazioni

matriciali più complicate di quelle di variabile reale. Infatti

AX = BA ⇒ X = B?

AX = AB ⇒ X = B?

In generale la risposta è no come mostra il seguente esempio

18

Esempio 2.11. Sia

A=

e siano

AX =

3

2

1

X=

−1

1

−1

0

B=

0

0

0

e

Si ha

3

2

0

0

0

0

AB =

0

0

0

0

Quindi

AX = AB

ma chiaramente

2.4

0

X=

6

0

0

0

Potenze e radici di matrici

Sia A una matrice n × n. Chiameremo potenza k-esima di A la matrice ottenuta eseguendo il

prodotto di A con se stessa k-volte

Ak = A . . . A

ben definito per l’associatività e chiameremo radice k-esima di A la matrice

√

k

A = B se B k = A

2.5

Inversa di una matrice

In questo paragrafo ci concentriamo sulle matrici quadrate.

Definizione 2.3. Una matrice A m×n tale che aij = 0 per ogni i 6= j è detta matrice diagonale.

Osserviamo che la matrice identità è una matrice diagonale con tutti gli elementi sulla diagonale

principale uguali a uno.

Definizione 2.4. Chiameremo matrice identità la matrice diagonale In di dimesione n × n

data da

1

0

..

In =

.

0

1

Definizione 2.5. Una matrice A n × n è invertibile (non singolare) se esiste una matrice n × n

B tale che

AB = BA = In

Esempio 2.12. Verificare, applicando la definizione, che

−2 −3 −1

−3 −3 −1

−2 −4 −1

è la matrice inversa di

1

1

−6

−1

0

2

0

−1

3

Vale il seguente

Teorema 2.1. * La matrice inversa di una matrice n × n, A, se esiste è unica e verrà indicata

con il simbolo A−1 .

19

Dimostrazione. Supponiamo che esistano due matrici B, C tali che

AB = BA = In

AC = CA = In

Allora

AB = In ⇒ C(AB) = CIn = C ma C(AB) = (CA)B = In B = B quindi B = C

Siamo arrivati qui ad una delle difficoltà nello sviluppo logico dell’algebra lineare: l’inversa di una

matrice è stata definita come una matrice che è contemporaneamente inversa a destra e inversa

a sinistra. Se troviamo l’inversa a destra sarà anche inversa a sinistra? La risposta è affermativa,

ma non di immediata dimostrazione. Quindi enunciamo il seguente

Teorema 2.2.

AB = In ⇒ BA = In

Vediamo ora un esempio di come calcolare l’inversa di una matrice 2 × 2

Esempio 2.13. Calcoliamo la matrice inversa di

1

4

A=

−1 −3

Per determinare la matrice inversa di A verifichiamo che esiste una matrice X soluzione di

AX = I2

(10)

Indichiamo con xij i, j = 1, 2 le componenti di X. L’equazione (10) equivale a

1

4

x11 x12

1 0

=

−1 −3 x21 x22

0 1

cioè eseguendo il prodotto tra matrici a sinistra e eguagliando le matrici equivale a risolvere il

seguente sistema

x11 + 4x21

=1

x + 4x

=0

12

22

−x11 − 3x21 = 0

−x12 − 3x22 = 1

da cui si ricava

X = A−1 =

−3

1

−4

1

Sostanzialmente per trovare l’inversa abbiamo risolto i due sistemi

(

(

x11 + 4x21

=1

x12 + 4x22

=0

−x11 − 3x21 = 0

−x12 − 3x22 = 1

Osserviamo ora che la matrice dei coefficienti è la stessa per entrambi i sistemi. Quindi, invece di risolverli separatamente, possiamo risolverli simultaneamente completando la matrice dei

coefficienti nel modo seguente

1

4 1 0

B=

= [A I2 ]

−1 −3 0 1

Applicando il metodo di Gauss-Jordan si ricava ponendo r1 + r2 → r2

1 4 1 0

B → B1 =

0 1 1 1

e eseguendo r1 + (−4r2 ) → r1

1

B1 → B2 =

0

0

1

−3

1

−4

= [I2 A−1 ]

1

Infatti è come

se

avessimo risolto Axi = ei , i = 1, 2 dove e1 , e2 sono i versori fondamentali di

x1i

2

V e xi =

e trovato xi = A−1 ei che per i = 1, 2 rappresentano le colonne della matrice

x2i

A−1 .

20

Osservazione 2.3. Data una matrice A di dimensione 2 × 2

a b

A=

c d

A e’ invertibile se e solo se ad − cb 6= 0 e

A

−1

1

d −b

=

ad − bc −c a

Quanto visto nell’esempio precedente è vero in generale. Vale infatti il seguente teorema

Teorema 2.3. Data una matrice A di dimensione n × n

1. Formiamo la matrice n × 2n [A In ]

2. Se è possibile ridurre la matrice A all’identità eseguendo le operazioni elementari sulla

matrice [A In ] cioè ottenendo [In B] allora la matrice A è invertibile e B = A−1 . Se ciò

non è possibile allora la matrice A non è invertibile (singolare)

Vediamo ora un altro esempio:

Esempio 2.14. Consideriamo la matrice

1

A= 1

−6

e consideriamo

1

[A I3 ] = 1

−6

−1

0

2

−1

0

2

0

−1

3

0

−1

3

1 0 0

0 1 0

0 0 1

a cui applichiamo il metodo di Gauss-Jordan. Iniziamo con l’operazione r2 − r1 → r2

1 −1 0

1 0 0

1 −1 −1 1 0

[A I3 ] → B1 = 0

−6 2

3

0 0 1

Quindi applichiamo r3 + 6r1 → r3

1

B1 → B2 = 0

0

−1

1

−4

0

−1

3

1

−1

6

0 0

1 0

0 1

Eseguendo quindi nell’ordine −r3 → r3 , r2 + r3 → r3 , r1 + r2 → r1 si giunge alla matrice

1 0 0 −2 −3 −1

0 1 0 −3 −3 −1

0 0 1 −2 −4 −1

quindi

A−1

−2

= −3

−2

−3

−3

−4

−1

−1

−1

Vediamo ora le proprietà della matrice inversa

Teorema 2.4. * Sia A una matrice n × n invertibile, k ∈ N, λ ∈ R. Allora A−1 e Ak sono

matrici invertibili e

(1) (A−1 )−1 = A

(2) (Ak )−1 = (A−1 )k

(3) (λA)−1 = λ1 A−1

(4) Se B è una matrice n × n invertibile (AB)−1 = B −1 A−1

21

Dimostrazione. Cominciamo da (1). Osserviamo che

A−1 A = AA−1 = In

che significa che A e’ inversa di A−1 cioè (A−1 )−1 = A. Per dimostrare (2) utilizziamo la

proprietà associativa del prodotto

Ak (A−1 )k = (A · · · A)(A−1 · · · A−1 ) = A · · · (AA−1 ) · · · A−1 = In

Per dimostrare (3) scriviamo

λA

1 −1

A

λ

=

1

λ

λ

(AA−1 ) = In

dove abbiamo utilizzato le proprietà associative del prodotto scalare e del prodotto di matrici.

Infine

(AB)(A−1 B −1 ) = A(BB −1 )A−1 = AIn A−1 = In

Ritorniamo ora alle proprietà di cancellazione, che vale per matrici quadrate:

Corollario 2.1. Sia A una matrice n × n invertibile. Allora

AX = AB ⇒ X = B

XA = BA ⇒ X = B

Dimostrazione. Considero AX = AB e moltiplico a sinistra per A−1 . Si ha

A−1 (AX) = A−1 (AB)

e usando la propietà associativa del prodotto di matrici si ricava

(A−1 A)X = (A−1 A)B

e quindi

In X = In B ⇒ X = B

Le matrici quadrate invertibili hanno quindi lo stesso ruolo dei numeri reali non nulli. E si

possono risolvere equazioni matriciali:

Esempio 2.15. Risolvere l’equazione matriciale

3AX + B = C

assumendo che A sia invertibile. Applicando le operazioni matriciali viste in precedenza si ha

AX =

1

(C − B)

3

e moltiplicando l’equazione a sinistra per A−1

1

1

1

X = A−1 ( (C − B)) = A−1 C − A−1 B

3

3

3

Vediamo ora che per alcune matrici speciali il calcolo della matrice inversa è immediato.

Teorema 2.5. Se A è una matrice n × n diagonale allora A è invertibile se aii 6= 0 per ogni

i = 1, . . . , n e in tal caso

1/a11

0

...

0

0

1/a22 . . .

0

A−1 = .

.

.

..

..

..

..

.

0

0

...

1/ann

Dimostrazione. Consideriamo la matrice completa [A In ]. Per ridurre tale matrice con il metodo

di Gauss-Jordan ad una matrice a scala ridotta basta semplicemente dividere per 1/aii per

i = 1, . . . , n. Se aii = 0 per qualche i ciò significa che c’è un pivot in una colonna k > n e quindi

il sistema associato AX = In non ha soluzione

22

2.6

Applicazione

Consideriamo un sistema di n equazioni in n variabili x1 , . . . , xn che possiamo scrivere nella forma

matriciale

Ax = b

dove

x1

x2

x= .

..

xn

b1

b2

b=.

..

bn

e dove A è la matrice dei coefficienti del sistema. Vale il seguente

Teorema 2.6. Se A è invertibile allora l’equazione Ax = b ha un’ unica soluzione

x = A−1 b

Dimostrazione. Se la matrice A è invertibile allora moltiplicando l’equazione

Ax = b

a sinistra per A−1 ricaviamo

x = A−1 b

Dimostriamo ora che tale soluzione è unica. Supponiamo esista y tale che

Ay = b

Si ha

A(x − y) = 0 ⇒ x − y = A−1 0 = 0 ⇒ x = y

Osservazione 2.4. Benchè questo metodo di soluzione sembri più veloce dell’eliminazione di

Gauss o di Gauss-Jordan, in realtà per calcolare l’inversa abbiamo l’eliminazione su [A I] che

richiede più operazioni dell’eliminazione su [A b]. Naturalmente è più rapida se A−1 è nota per

qualche motivo.

Esempio 2.16. Consideriamo il sistema

(

3x1 + 2x2 = 1

x1 − x2

=2

La matrice dei coefficienti è

3

A=

1

2

−1

Poichè −3 − 2 = −5 6= 0 la matrice A è invertibile e l’inversa è data da

1 −1 −2

A−1 = −

5 −1 3

Quindi la soluzione del sistema è data da

1 −1

1

x = A−1

=−

2

5 −1

−2

3

1

−1

=

2

1

Esempio 2.17. Dato il sistema

2x + 3y + z

3x + 3y + z

32 + 4y + z

= −1

=1

= −2

calcolare l’inversa A−1 della matrice dei coefficienti A e quindi calcolare la soluzione

x

−1

y = A−1 1

z

−2

23

2.7

Matrici elementari

Negli scorsi paragrafi abbiamo visto le operazioni elementari su righe e abbiamo introdotto il

prodotto di matrici. Ora vedremo come utilizzare il prodotto per eseguire le operazioni sulle

righe. E qui succede qualcosa di magico: per eseguire un’operazione elementare su una riga di

una matrice B, m × n, si esegue tale operazione sulla corrispondente riga della matrice identità

Im ottenendo una matrice che chiameremo E e quindi si moltiplica la matrice B a sinistra per

E.

Definizione 2.6. Una matrice E ottenuta dalla matrice identità Im eseguendo una operazione

elementare di riga è detta matrice elementare.

Esempio 2.18. Quali tra queste matrici è elementare?

1 0 0

1 0 0

1 0 0

1 0

E1 =

E2 = 0 0 1 E3 = 0 1 0 E4 = 0 0 1

0 2

0 1 0

−3 0 1

1 1 1

E1 è elementare perchè è ottenuta dall’identità eseguendo 2r2 → r2 , E2 è elementare perchè è ottenuta dall’identità eseguendo r3 → r2 , E3 è elementare perchè è ottenuta dall’identità eseguendo

r3 − 3r1 → r3 . La matrice E4 non è elementare.

Verifichiamo ora con un esempio la proprietà

prodotto di matrici con matrici elementari.

Esempio 2.19.

1 0 0

2

0 0 1 −1

0 1 0

5

descritta all’inizio del paragrafo utilizzando il

3

2

2 = 5

4

−1

3

4

2

Quindi abbiamo scambiato la seconda con la terza riga moltiplicando a sinistra la matrice per

una matrice elementare ottenuta scambiando la seconda con la terza riga. Mentre

1 0 0

2 3

2

3

0 0 1 −1 2 = −1 2

−3 0 1

5 4

−1 −5

In questo caso abbiamo eseguito r3 − 3r1 → r3 .

Osservazione 2.5. Operazioni riga elelmentari che riducono una matrice B a scala ridotta si

possono rappresentare come prodotti di matrici elementari con B cioè nella forma

Ek Ek−1 · · · E1 B

Esempio 2.20. Consideriamo la matrice

1

A=

0

1

−2

3

−4

Vogliamo ridurla a scala ridotta usando matrici elementari.

1 −1 1

0

1 1

3

1 −1 1

=

0 1

0 −1/2 0 −2 −4

0 1

0

1

1

3

1

=

2

0

0

1

1

2

Definizione 2.7. Due matrici A, B sono equivalenti per righe se esistono un numero finito

di matrici elementari E1 , . . . , Ek tali che

A = Ek Ek−1 · · · E1 B

Teorema 2.7. Una matrice elementare è invertibile e l’inversa è una matrice elementare.

Dimostrazione. Una matrice elementare E si ottiene dall’identità I applicando un’operazione

elementare di riga. Quindi è possibile eseguire un’operazione elementare di riga che riporta E in

I cioè esiste una matrice F elementare tale che

FE = I

e anche

EF = I

e quindi F = E −1 .

24

Esempio 2.21. Determinare l’inversa di

1

E1 = 0

−4

0 0

1 0

0 1

Per trasformare E1 in I3 serve eseguire l’operazione 4r1 + r3 → r3 . Quindi la matrice inversa di

E1 è

1 0 0

E1−1 = 0 1 0

4 0 1

Teorema 2.8. Sia A una matrice n × n. Allora A è invertibile se e solo se può essere espressa

come prodotto di matrici elementari.

Dimostrazione. Se A è invertibile allora la matrice [A On ] è riducibile mediante operazioni di

riga elementari alla matrice [In On ] poichè il sistema Ax = 0 ha un’unica soluzione. Quindi

Ek · · · E1 A = In ⇒ A = (Ek · · · E1 )−1 = E1−1 · · · Ek−1 .

Viceversa se A = E1 · · · Ek allora A è invertibile in quanto prodotto di matrici invertibili.

A questo punto ci chiediamo: a che cosa serve tutto questo? Per implementare le operazioni

di riga su una matrice. Inoltre vedremo più avanti che quanto detto è anche utile per trovare

un’espressione algebrica dell’inversa di una matrice.

Riassumendo possiamo dire che le seguenti condizioni sono equivalenti:

A matrice n × n

1. A è invertibile.

2. Ax = b ha un’unica soluzione ∀b.

3. Ax = 0 ha la sola soluzione nulla.

4. A è equivalente alla matrice identità In .

5. A può essere scritta come prodotto di matrici elementari.

2.8

Trasposta di una matrice

Definizione 2.8. Data una matrice m×n A = [aij ] la sua trasposta è la matrice n×m AT = [a0ij ]

che si ottiene scambiando righe con colonne ossia tale che

a0ij = aji ,

i = 1, . . . , n, j = 1, . . . , m

Più esplicitamente se

a11

a21

A= .

..

a12

a22

..

.

...

...

..

.

a1n

a2n

..

.

am1

am2

...

amn

a11

a12

AT = .

..

a21

a22

..

.

...

...

..

.

am1

am2

..

.

a1n

am2

...

amn

allora

Esempio 2.22. Riprendiamo l’esempio (2.3). In esso consideravamo la tabella A 4 × 3

Anna

Paola

Carlo

Marco

Tennis

3

0

1

1

25

Golf

5

1

1

0

Calcio

0

0

1

6

che ci indica quante ore pratica ciascun studente giocando a tennis, golf e calcio. Se adesso

consideriamo la matrice trasposta AT 3 × 4 otteniamo la tabella

Anna

3

5

0

Tennis

Golf

Calcio

Paola

0

1

0

Carlo

1

1

1

Marco

1

0

6

che ci indica per ogni sport quali studenti lo praticano e per quante ore.

Vediamo ora altri esempi

Esempio 2.23.

2 3

A= 0 1

−1 1

2 0

AT = 3 1

1 1

2

A=

8

1

1

1

−1

1

1

AT = [2 8]

0 1

A = 2 4

1 −1

0 2 1

T

A =

1 4 −1

Vediamo ora alcune proprietà della trasposizione

Teorema 2.9. Siano A, B matrici di dimensioni opportune, λ ∈ R. Valgono le seguenti proprietà

1. (AT )T = A

2. (A + B)T = AT + B T

3. (λA)T = λAT

4. (AB)T = B T AT

5. (AT )−1 = (A−1 )T se A è invertibile

Dimostrazione. Le proprietà 1-3 sono ovvie. Dimostriamo 4.

X

X

X

[(AB)T ]ij = [AB]ji =

ajk bki =

bki ajk =

[B T ]ik [AT ]kj = B T AT

k

k

k

Concludiamo dimostrando 5. Si ha

(A−1 )T AT = (AA−1 )T = I

Esempio 2.24. Calcolare la soluzione di

(AB − X T )T = B T AT

Si ha

(AB − X T )T = (AB)T − (X T )T = (AB)T − X = B T AT − X

Quindi

B T AT − X = B T AT

da cui

−X = O ⇒ X = O

26

2.9

Matrici simmetriche e antisimmetriche

Definizione 2.9. Una matrice n × n A è simmetrica se A = AT .

Definizione 2.10. Una matrice n × n A è antisimmetrica se AT = −A.

Vediamo alcuni esempi

Esempio 2.25. Consideriamo la matrice dell’amicizia dove l’elemento aij è uno o zero a seconda

che la persona i sia o meno amica/o della persona j

Anna

Paola

Carlo

Anna

1

0

1

Paola

0

1

1

Carlo

1

1

1

Chiaramente tale matrice è simmetrica. Purtroppo quella dell’amore spesso non è simmetrica!

Esempio 2.26. Consideriamo la matrice in cui nella posizione ij c’è l’importo di cui i è creditore

verso j se positivo o debitore verso j se negativo. In questo caso si ottiene una matrice A che

ovviamente è antisimmetrica. Ad esempio se A è la matrice

Anna

Paola

Carlo

Anna

0

-10

5

Paola

10

0

15

Carlo

-5

-15

0

si ricava facilmente che −A = AT che implica che A è antisimmetrica.

2.10

Determinante di una matrice n × n

Il determinante è un numero magico che, come vedremo, ci dà un sacco di informazioni utili sulla

matrice. Cominciamo con il caso di matrici 2 × 2.

Definizione 2.11. Data la matrice

a b

A=

c d

Chiameremo determinante di A il numero

detA = ad − bc

Osserviamo che se detA 6= 0 la matrice A è invertibile.

Esempio 2.27.

2 2

A=

1 4

In questo caso detA = 8 − 2 = 6. Mentre se

A=

1

−3

−2

6

detA = 6 − 6 = 0.

Estendiamo ora il concetto di determinante ricorsivamente a matrici di dimensione arbitraria

n × n. Per fare ciò servono delle definizioni preliminari.

Definizione 2.12. Data una matrice n × n A indichiamo con Mij la matrice (n − 1) × (n − 1)

ottenuta da A cancellando la i-esima riga e la j-esima colonna.

Esempio 2.28. Data la matrice

3 2 3

A = 1 4 1

2 −1 5

Calcoliamo ad esempio M23 matrice 2 × 2 ottenuta da A cancellando la seconda riga e la terza

colonna. Quindi

3 2

M23 =

2 −1

mentre M12 è data da

M12 =

27

1

2

1

5

Ora vogliamo definire il determinante di una matrice n × n supponendo di saper calcolare il

determinante di una matrice (n − 1) × (n − 1).

Definizione 2.13. Data una matrice n × n A chiameremo complemento algebrico dell’elemento aij il numero

Cij = (−1)i+j detMij

Il complemento algebrico Cij è quindi il determinante della matrice (n − 1) × (n − 1) ottenuta cancellando la i-esima riga e la j-esima colonna di A cambiato di segno se i + j è dispari

Nell’esempio precedente possiamo calcolare

3 2

5

C23 = (−1) det

=7

2 −1

e

C12 = (−1)3 det

1

2

1

= −3

5

Siamo ora pronti per dare la definizione di determinante

Definizione 2.14. Data una matrice n × n A il suo determinante è quel numero che si ottiene

sommando gli elementi della prima riga per i corrispondenti complementi algebrici. In formule

detA =

n

X

a1i C1i

i=1

La formula è consistente con la definizione di determinante di matrice 2 × 2.

Esempio 2.29.

a

a12

A = 11

a21 a22

Si ha detA = a11 a22 − a12 a21 .

Esempio 2.30. Consideriamo la matrice 3 × 3

0 2

A = 1 0

1 −1

2

1

1

In questo caso

0

detA = 0det

−1

1

1

− 2det

1

1

Osserviamo che per il calcolo del determinante

a11

A = a21

a31

1

1

+ 2det

1

1

0

= −2

−1

di una matrice 3 × 3 è la formula di Sarrus. Se

a12 a13

a22 a23

a32 a33

si ha che

detA = a11 a22 a33 + a12 a23 a31 + a13 a21 a32 − a13 a22 a31 − a11 a23 a32 − a12 a21 a33

Osserviamo che in realtà il determinante può essere calcolato a partire da una qualsiasi riga o

colonna. Vediamo un esempio

Esempio 2.31. Sia

3 0 −3

2

A = 1 4

2 −1 3

Sviluppando rispetto alla prima riga si ottiene

4 2

1 4

detA = 3det

− 3det

= 3(12 + 2) − 3(−1 − 8) = 42 + 27 = 69

−1 3

2 −1

Sviluppiamo ora secondo la seconda colonna

1 2

3 −3

3

detA = 0det

+ 4det

+

2 3

2 3

1

28

−3

= 4(9 + 6) + 6 + 3 = 69

2

Vediamo un altro caso in cui è semplice calcolare il determinante

Definizione 2.15. Una matrice n × n si dice triangolare alta (bassa) se ha tutti gli elementi

sotto (sopra) la diagonale principale nulli.

Vale il seguente

Teorema 2.10. Il determinante di una matrice triangolare è il prodotto degli elementi sulla

diagonale.

Dimostrazione. Dimostriamo il teorema (2.10). Procediamo per induzione. Consideriamo il caso

di una matrice 1 × 1.

A = [a11 ] detA = a11

Supponiamo che il teorema sia vero per una matrice triangolare alta (k − 1) × (k − 1) c e

consideriamo una matrice k × k. Espandiamo il determinante rispetto alla k-esima riga della

matrice. Si ha

detA = 0Ck1 + . . . 0Ckk−1 + akk Ckk

e dall’ipotesi di induzione

Ckk = a11 a22 · · · ak−1k−1

Quindi si ha

detA = a11 a22 · · · ak−1k−1 akk

2.11

Applicazioni

Esempio 2.32. Dati due vettori u = (u1 , u2 u3 ), v = (v1 , v2 , v3 ) ∈ R3 il prodotto vettoriale di u

per v (u × v) è dato da

i

j

k

u2 u3

u1 u3

u1 u2

u × v = det u1 u2 u3 = idet

− jdet

+ kdet

v2 v3

v1 v3

v1 v2

v1 v2 v3

Esempio 2.33. Consideriamo tre vettori u, v, w ∈ R3 . Calcoliamo il volume del parallelepipedo

P formato dai tre vettori. Indicando con α l’ ampiezza dell’angolo formato tra u × v e w si ha

w1 w2 w3

volP = ku × vkkwk|cosα| = | < u × v, w > | = det u1 u2 u3

v1 v2 v3

2.12

Operazioni elementari e determinante

Esempio 2.34. Calcoliamo il determinante della matrice

3 2 1

A = 1 0 3

1 1 2

Sviluppando il determinante rispetto alla seconda riga si ottiene

2 1

3 2

detA = −det

− 3det

= −(4 − 1) − 3(3 − 2) = −6

1 2

1 1

Ora calcoliamo il

2

det 1

1

determinante della matrice ottenuta da A sostituendo alla prima riga r1 − r2

2 −2

2 −2

2 2

0 3 = −det

− 3det

= −(4 + 2) − 3(2 − 2) = −6

1 2

1 1

1 2