UniFI - Notiziario

Le frontiere della visione computazionale

Visite virtuali dei fondali marini toscani in 3D, strumenti e interfacce a sostegno

degli utenti con ridotta mobilità e ipovedenti. Sono alcuni dei progetti di cui si

occupa il Computational Vision Group dell'Ateneo - guidato da Carlo Colombo,

associato di Sistemi di elaborazione delle informazioni alla Facoltà di

Ingegneria - un team in cui il ruolo dei giovani collaboratori per realizzare

nuovi progetti è di primo piano.

"Nel nostro gruppo di ricerca il contributo dato dai componenti più giovani è

molto importante e incentivato perché in questo campo occorre curiosità e un

aggiornamento sugli sviluppi più recenti - spiega Colombo, - Le idee a cui poi

lavoriamo per dare un'applicazione spesso vengono dai giovani laureandi e

dagli studenti del mio corso di Visione Computazionale alla laurea magistrale

in Ingegneria informatica. Attualmente alle attività del CVG partecipano, oltre

ai docenti, una decina tra dottorandi, assegnisti di ricerca e laureandi, ma durante le mie lezioni cerco

di coinvolgere anche i miei allievi, stimolandoli al pensiero creativo, che è l'ingrediente essenziale per

fare ricerca. Il mio obiettivo è ampliare il gruppo, per poter far fronte al meglio ai molti progetti in corso e

a quelli che verranno. Per finanziare le nostre ricerche cerchiamo di cogliere tutte le opportunità, dai

fondi ministeriali, locali ed europei, alle collaborazioni con le aziende del territorio, con le quali da tempo

lavoriamo su programmi di innovazione d'impresa. La visione computazionale è infatti uno degli

argomenti di punta della moderna Information Technology."

Che cos'è la visione computazionale, quali sono le sue

applicazioni?

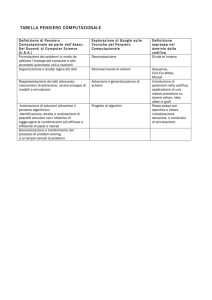

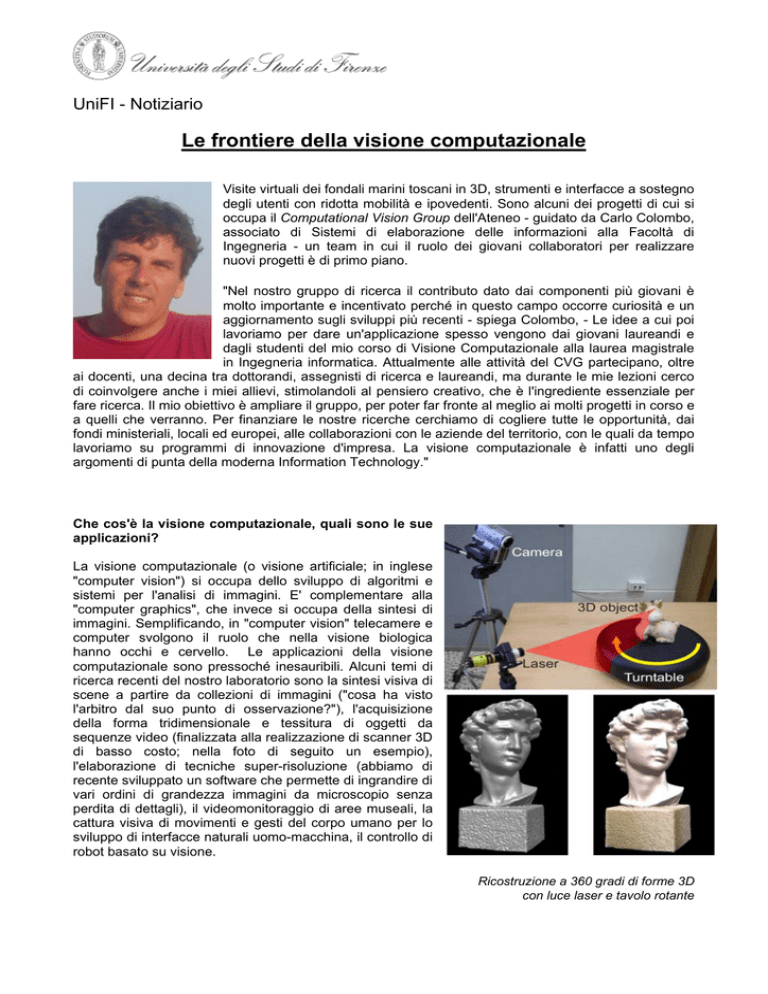

La visione computazionale (o visione artificiale; in inglese

"computer vision") si occupa dello sviluppo di algoritmi e

sistemi per l'analisi di immagini. E' complementare alla

"computer graphics", che invece si occupa della sintesi di

immagini. Semplificando, in "computer vision" telecamere e

computer svolgono il ruolo che nella visione biologica

hanno occhi e cervello. Le applicazioni della visione

computazionale sono pressoché inesauribili. Alcuni temi di

ricerca recenti del nostro laboratorio sono la sintesi visiva di

scene a partire da collezioni di immagini ("cosa ha visto

l'arbitro dal suo punto di osservazione?"), l'acquisizione

della forma tridimensionale e tessitura di oggetti da

sequenze video (finalizzata alla realizzazione di scanner 3D

di basso costo; nella foto di seguito un esempio),

l'elaborazione di tecniche super-risoluzione (abbiamo di

recente sviluppato un software che permette di ingrandire di

vari ordini di grandezza immagini da microscopio senza

perdita di dettagli), il videomonitoraggio di aree museali, la

cattura visiva di movimenti e gesti del corpo umano per lo

sviluppo di interfacce naturali uomo-macchina, il controllo di

robot basato su visione.

Ricostruzione a 360 gradi di forme 3D

con luce laser e tavolo rotante

Qual è il progetto più importante al

quale state lavorando?

Uno dei più importanti è THESAURUS

(acronimo di TecnicHe per l'Esplorazione

Sottomarina

Archeologica

mediante

l'Utilizzo di Robot aUtonomi in Sciami). E'

un progetto biennale, partito ufficialmente il

1° marzo di quest'anno, e finanziato

completamente dalla Regione Toscana con

un contributo pari a circa 1.800.000 euro,

che mira a individuare, censire e

documentare relitti subacquei di valore

archeologico ed etnoantropologico. Entro il

2013, metteremo in acqua tre piccoli veicoli

sottomarini autonomi che navigheranno

come un branco di pesci, e metri di

profondità, effettuando una scansione 3D

Il veicolo AUV in fase di progetto per Thesaurus

del fondale. La registrazione renderà

possibile una visita virtuale dei fondali marini della Toscana, fruibile in modo simile a quanto oggi si fa

fuori dall'acqua con Google Maps e Street View. Un secondo obiettivo del progetto è il rilevamento,

grazie alla "computer vision", di oggetti fatti dall'uomo, relitti antichi e recenti che si sono depositati nei

nostri fondali. Da qui l'evocativo nome del progetto. Diversamente dalla tipologia di veicoli di questo tipo

realizzati fin qui (ROV, per "Remotely Operated Vehicles"), che sono legati tramite una sorta di

"cordone ombelicale" alla nave appoggio, i ‘nostri' saranno del tipo AUV ("Autonomous Underwater

Vehicles"), ossia saranno completamente autonomi, avranno una visione 3D ed altri sensori a bordo,

parleranno tra loro attraverso modem a ultrasuoni e sapranno tornare alla base da soli dopo una

missione di circa 8 ore. Gli altri partner del progetto sono la Scuola Normale Superiore di Pisa, che

curerà la parte archeologica, l'ISTI-CNR (Istituto di Scienza e Tecnologie dell'Informazione) di Pisa, con

il coordinamento del Centro Piaggio, sempre di Pisa. Mentre il nostro gruppo di occuperà degli aspetti

di visione, il gruppo capitanato dal mio amico e collega Benedetto Allotta, del Dipartimento di

Energetica, si occuperà del progetto meccanico dei tre veicoli, che verranno testati nel nostro

laboratorio di Modellazione Dinamica e Meccatronica di Pistoia.

Ci

può

fare

qualche

altro

esempio

di

applicazione

della

visione

computazionale?

Con la Toshiba Research Europe (con sede a Cambridge) stiamo conducendo uno studio sulla resa

tridimensionale di film e immagini per la fruizione sui nuovi schermi 3D. Uno dei nostri ricercatori, Dario

Comanducci, è tornato in Italia di recente dopo un soggiorno di 9 mesi in Inghilterra. L'obiettivo è

ricampionare il materiale video "mono" per renderlo "stereo", consentendo così la fruizione 3D anche di

film d'epoca come "Star Wars". Abbiamo lavorato anche con realtà più piccole, nel nostro territorio. Ad

esempio, negli anni passati abbiamo realizzato un software per acquisire in digitale in modo veloce e

automatico i cartamodelli impiegati nelle industrie del settore della moda per la produzione delle nuove

collezioni. In collaborazione con un'altra azienda di moda stiamo progettando uno scanner 3D per

ottenere una resa quasi tattile dei nuovi pellami high-tech molto apprezzati dagli stilisti.

Ancora, nel 2008, in collaborazione con l'Associazione Famiglie SMA di Roma, che riunisce i genitori

dei bambini affetti da sclerosi laterale amiotrofica, abbiamo progettato EyeMouse, un sistema basato su

singola telecamera, che consente di

utilizzare il movimento oculare per dare

a un computer dei comandi come se

arrivassero dalla mano che non

funziona più. Una telecamera installata

sul computer cattura i movimenti

dell'occhio dell'utente, che funge da

mouse, e i suoi movimenti rendono lo

spostamento del cursore sullo schermo,

mentre un battito delle palpebre funge

da comando di selezione ("click"). In

pratica, si tratta di una tecnologia che

permette di catturare e interpretare i

gesti e i movimenti e ne fornisce

un'interpretazione semantica.

Trascinamento e selezione con il sistema EyeMouse

Non è il solo ambito di utilizzo della tecnologia al servizio dei bisogni delle persone...

Stiamo lavorando a un progetto, che abbiamo chiamato MEDUSA (Mixed Environment Device for

Unknown Scene Assessment), per creare un sistema hardware/software per i disabili visivi (ciechi e

ipovedenti), che permetta di semplificare e riunire le svariate funzionalità di vari sistemi stand alone in

un unico strumento. L'idea è di uno dei miei allievi, oggi mio collaboratore, Claudio Guida, che ha

dotato un telefono cellulare di un software, denominato BusAlert, che riconosce l'arrivo di un autobus

alla fermata, ne legge il numero, e lo comunica via audio al disabile. E' il primo passo per un progetto

che potrebbe essere sviluppato anche grazie al sostegno di chi, nel nostro territorio, si occupa di

politiche sociali. Un altro progetto estremamente interessante, per il quale siamo alla ricerca di partner

e finanziamenti, è quello dell'impiego della visione computazionale per la costruzione di mappe

annotate di ambienti, a supporto della mobilità autonoma dei disabili visivi. Un esempio tipico è quello

del supermercato. E' noto che, ad oggi, persone con gravi disabilità visive non riescono a fare la spesa

da sole, ma devono essere accompagnate ed assistite durante la visita. La ricerca avrà l'obiettivo di

eliminare l'esigenza di un accompagnatore, dotando il disabile di una maggiore autonomia.

La visione computazionale può essere utilizzata anche per la gestione e la valorizzazione dei

beni culturali.

Anche in questo ambito le applicazioni della computer vision sono numerosissime. Ad esempio, nel

2002, con il MICC - Media Integration and Communication Center, coordinato da Alberto Del Bimbo nell'ambito di un progetto finanziato dalla Provincia di Firenze, abbiamo studiato e realizzato un sistema

di interazione avanzata uomo-macchina basato su visione per la fruizione di dipinti e affreschi di grandi

dimensioni. Attraverso questo sistema, denominato PointAt e installato a Palazzo Medici-Riccardi e già

utilizzato da migliaia di turisti, è possibile catturare movimenti e gesti degli utenti, consentendo così di

puntare le varie parti degli affreschi con la mano come se stessimo utilizzando un mouse.

Un altro progetto, su cui ho di recente curato

una tesi di laurea, è la realizzazione di un

software che permette, attraverso l'analisi di

dipinti, immagini e foto scattate in epoche

diverse, di rilevare automaticamente e

visualizzare in 3D i cambiamenti verificatisi nel

tempo in un dato contesto urbano.

Un'applicazione

che

potrebbe

essere

utilizzabile dai turisti che orientando il proprio

telefonino potrebbero vedere la Firenze dei

secoli scorsi resa tridimensionalmente.

Ancora, in collaborazione con la Scuola

Normale

Superiore

di

Pisa

abbiamo

presentato un progetto per la valorizzazione

dei beni culturali minori della Toscana. Il

progetto punta alla realizzazione di strumenti

che permettano agli stessi operatori delle

piccole realtà museali di creare contenuti

multimediali utilizzando le nostre tecnologie

per realizzare autonomamente rendering e

visite virtuali. I risultati di queste e altre

ricerche sono stati pubblicati sulle principali

riviste internazionali e presentati alla

conferenze

internazionali

di

settore.

Fortunatamente,

abbiamo

una

buona

reputazione internazionale, grazie alla quale ci

è stata affidata l'organizzazione della

dodicesima

European

Conference

on

Computer vision (ECCV 2012), che si svolgerà

Interazione basata su gesti con schermi di grandi

al Palazzo dei Congressi di Firenze dal 7 al 13

dimensioni con il sistema PointAt

ottobre 2012. E' un appuntamento biennale, il

terzo per importanza nel mondo, a cui parteciperanno tutti i "guru" della disciplina e assieme a loro un

migliaio di studiosi da tutti i continenti, metà dei quali hanno meno di trent'anni.

Si è laureato a pieni voti con lode nel

dicembre 2010 al corso di laurea

magistrale in Ingegneria informatica, e la

sua tesi è la premessa di un lavoro di

ricerca

da

sviluppare

nell'ambito

Computational Vision Group. E' Claudio

Guida, l'ideatore di BusAlert, l'applicazione

che permette il riconoscimento degli

autobus grazie al telefonino.

Come è nata l'idea?

Per la mia tesi ero interessato ad

approfondire un tema legato alla visione

artificiale, ed essendo ipovedente volevo

Alcuni membri del CVG. Fra questi, al centro, Claudio Guida

dare al lavoro di ricerca un obiettivo che

e, accucciato, Benedetto Allotta

avesse

una

valenza

sociale.

Il

riconoscimento del numero dell'autobus in arrivo alla fermata è una delle principali esigenze sentite

dalle persone non vedenti. La computer vision ci permette di sostituire o potenziare la funzione

dell'occhio, e io l'ho utilizzata per sviluppare un software in grado di leggere le immagini e riconoscere

un autobus e il suo numero. Il software installato su un dispositivo - in questo caso un telefonino iphone che soddisfa i requisiti di accessibilità - può localizzare il mezzo, elaborare le immagini

eliminandone distrattori come le ombre, i riflessi e le persone che si frappongono, ed infine localizzare

la porzione dell'immagine contenente il numero, che viene letto e restituito all'utente via audio. Il

BusAlert è però solo uno dei tasselli di un progetto più ampio che abbiamo denominato MEDUSA.

Di che si tratta?

Vogliamo fare confluire tante funzionalità in un singolo

strumento, come i tentacoli di una medusa appunto.

Attualmente infatti l'utente con disabilità visive ha a

disposizione una serie di dispositivi che permettono

per esempio di scansionare immagini di testi e darne

una lettura vocale, o di riconoscere i colori degli oggetti

(utile per vestirsi). Ma per essere completamente

autonoma,

la

persona

dovrebbe

portarli

contemporaneamente tutti con sé. La mia idea dunque

è sviluppare una serie di software da poter installare in

un unico dispositivo, più maneggevole e anche,

dettaglio non secondario, più economico. Il BusAlert,

per esempio, potrebbe essere esteso anche al

riconoscimento di insegne e numeri civici, nomi delle

vie, rilevamento delle strisce pedonali, dei semafori e

dei loro colori, degli ostacoli.

Altre funzionalità?

Localizzazione

automatica

del

di autobus con il sistema BusAlert

numero

La realtà aumentata. Mi spiego: posso inquadrare un monumento per ricavarne delle informazioni, che

integrate magari con altri strumenti, mi permettano di riconoscere dalla foto la via dove il monumento si

trova. Una guida - in stile street view - che arrivi là dove si fermano le funzionalità di un navigatore

GPS, guidando l'utente precisamente nel luogo che vuole raggiungere, ad esempio un negozio o un

numero civico in particolare. Uno strumento che permetta, sia in casa che all'esterno, di riconoscere

una scena e darne un'interpretazione, una ricostruzione precisa all'utente, assicurandogli quindi una

maggiore autonomia. (sd)

2011 © UniFI - Notiziario

- progetto e idea grafica CSIAF - contenuti e gestione a cura di Ufficio stampa e Ufficio redazione web -